04_machine-learning

Created by yamamoto.kosuke on Monday, August 24th, 2020機械学習による雨量推定

yamamoto.kosukeMonday, August 24th, 2020 at 5:06:06 PM GMT+09:00

@yamamoto.kosukeさんがチャンネルに参加しました

kobayashi_yusukeMonday, August 24th, 2020 at 5:30:54 PM GMT+09:00

@kobayashi_yusukeさんがチャンネルに参加しました

uwatokoMonday, August 24th, 2020 at 5:37:04 PM GMT+09:00

@uwatokoさんがチャンネルに参加しました

takao-yMonday, August 24th, 2020 at 5:45:38 PM GMT+09:00

@takao-yさんがチャンネルに参加しました

keiyoshi08Monday, August 24th, 2020 at 6:00:22 PM GMT+09:00

@keiyoshi08さんがチャンネルに参加しました

kobayashi_yusukeTuesday, August 25th, 2020 at 6:03:37 PM GMT+09:00

@takao-y

吉兼先生

先日の打合せではありがとうございました。

打合せでお話しのございました1点ではなく7x7の49点 で計測した結果をお伝えいたします。

-----

RをPythonに変換したプログラムでの全体の処理時間計測

環境: EORCの計算機(zico-n)

処理時間:8時間46分10秒

(auto.shの開始時間から終了時間まで)

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: RESTECで全国を5つに分けて作成したMSM,解析雨量データセット

サイト:siteC(西日本・九州)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

また、吉兼先生のRでの時間も別途計測しました。こちらは吉兼先生のデータを用いて行っております。

-----

Rでの全体の処理時間計測

環境: EORCの計算機(zico-n)

処理時間:18時間18分2秒

(auto.shの開始時間から終了時間まで)

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: 吉兼先生のサンプルデータデータセット(MSM,レーダ)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

計算は2台で並行して行いますが、1つあたりの時間がかかりすぎておりますので、時間がかかりすぎていることに対する対応は検討させてください。

以上、よろしくお願いいたします。

吉兼先生

先日の打合せではありがとうございました。

打合せでお話しのございました1点ではなく7x7の49点 で計測した結果をお伝えいたします。

-----

RをPythonに変換したプログラムでの全体の処理時間計測

環境: EORCの計算機(zico-n)

処理時間:8時間46分10秒

(auto.shの開始時間から終了時間まで)

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: RESTECで全国を5つに分けて作成したMSM,解析雨量データセット

サイト:siteC(西日本・九州)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

また、吉兼先生のRでの時間も別途計測しました。こちらは吉兼先生のデータを用いて行っております。

-----

Rでの全体の処理時間計測

環境: EORCの計算機(zico-n)

処理時間:18時間18分2秒

(auto.shの開始時間から終了時間まで)

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: 吉兼先生のサンプルデータデータセット(MSM,レーダ)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

計算は2台で並行して行いますが、1つあたりの時間がかかりすぎておりますので、時間がかかりすぎていることに対する対応は検討させてください。

以上、よろしくお願いいたします。

takao-yWednesday, August 26th, 2020 at 9:29:36 AM GMT+09:00

@kobayashi_yusuke 小林様

takao-yWednesday, August 26th, 2020 at 9:32:51 AM GMT+09:00

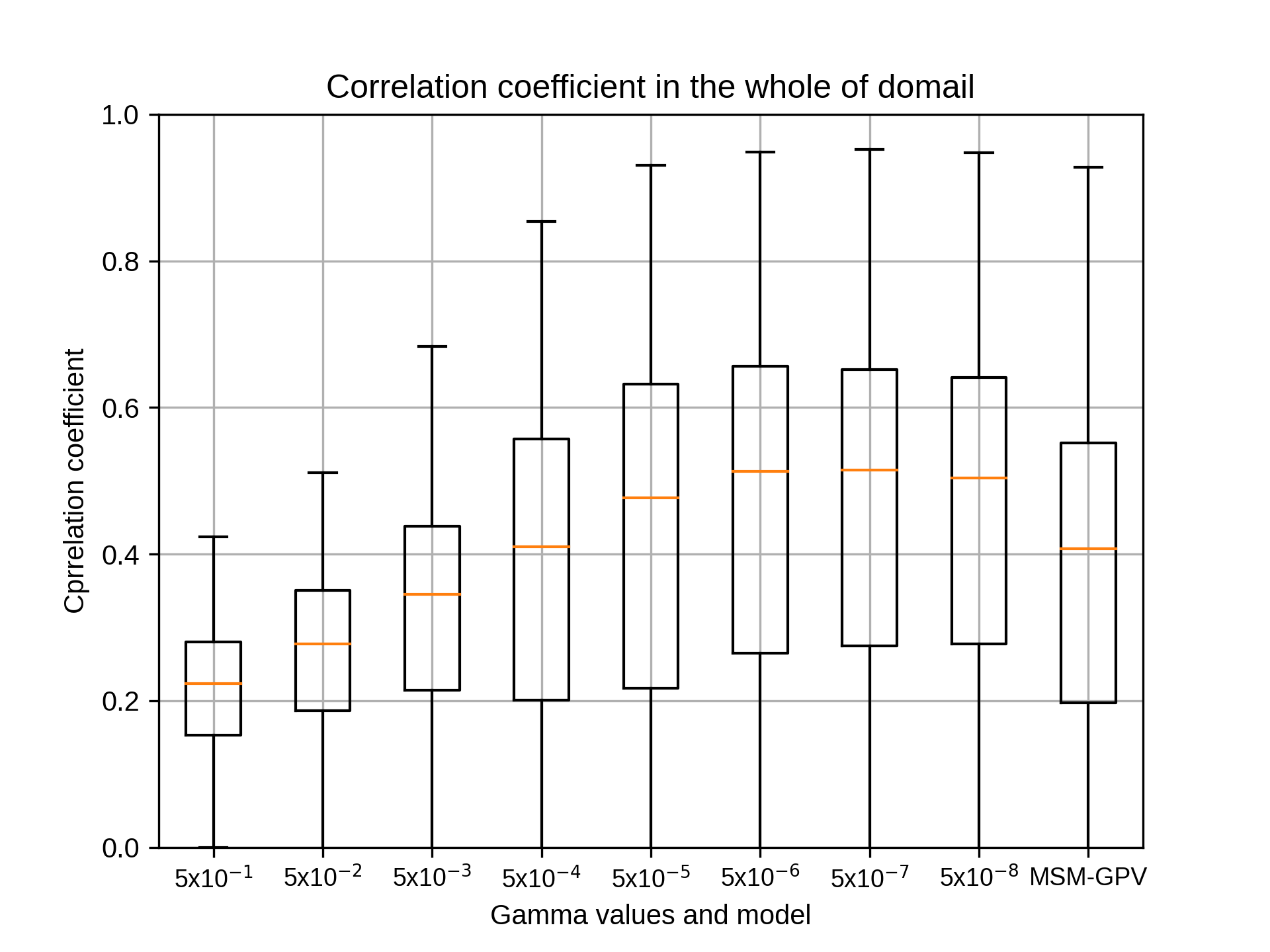

ありがとうございます。少し遅い気もしますが、12年間全てをデータ変換から実施するとそのくらいはかかるのかもしれません。もしよろしければ、結果の図を添付してもらえますでしょうか。

kobayashi_yusukeWednesday, August 26th, 2020 at 10:05:51 AM GMT+09:00

@takao-y

吉兼先生

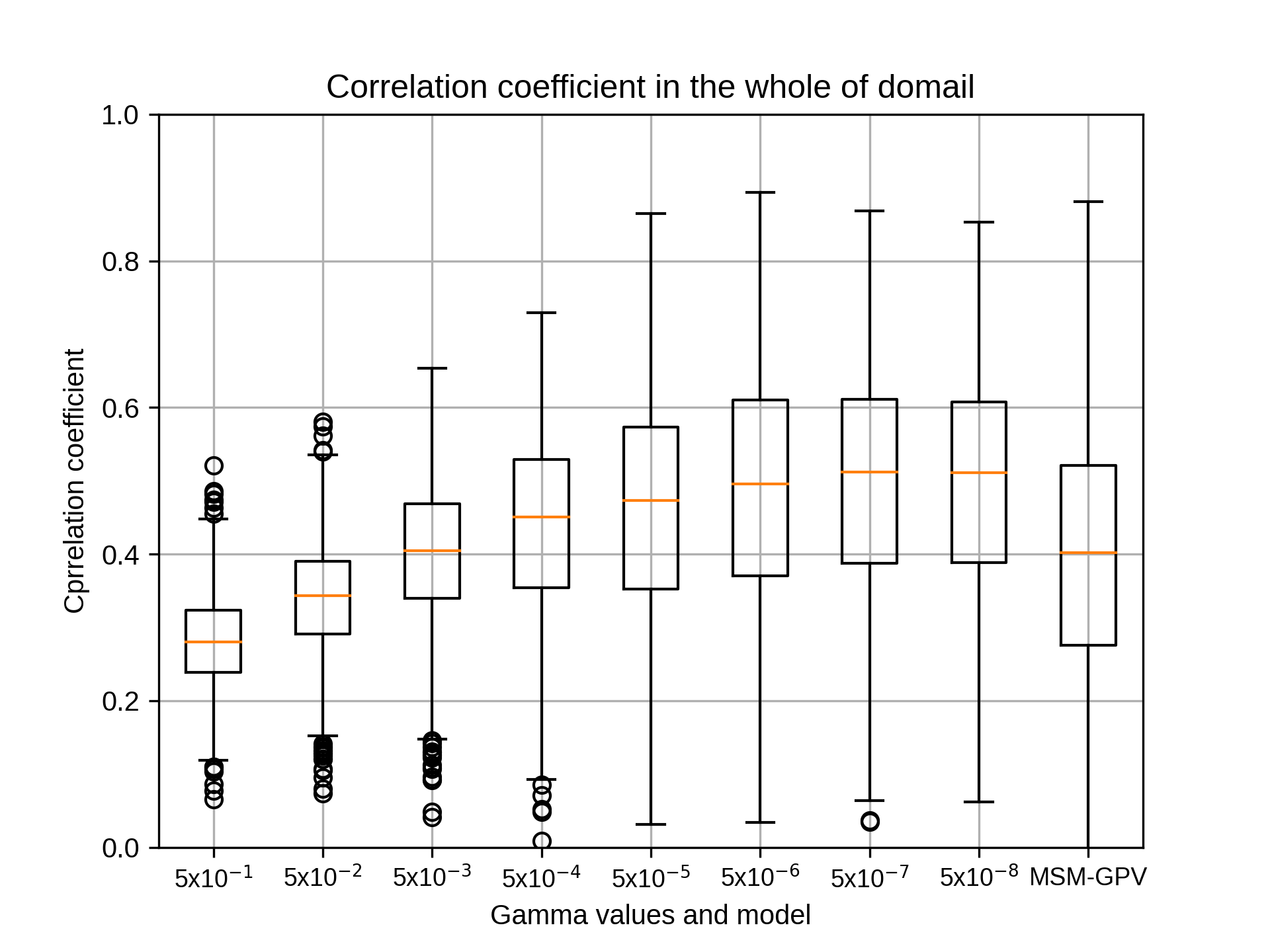

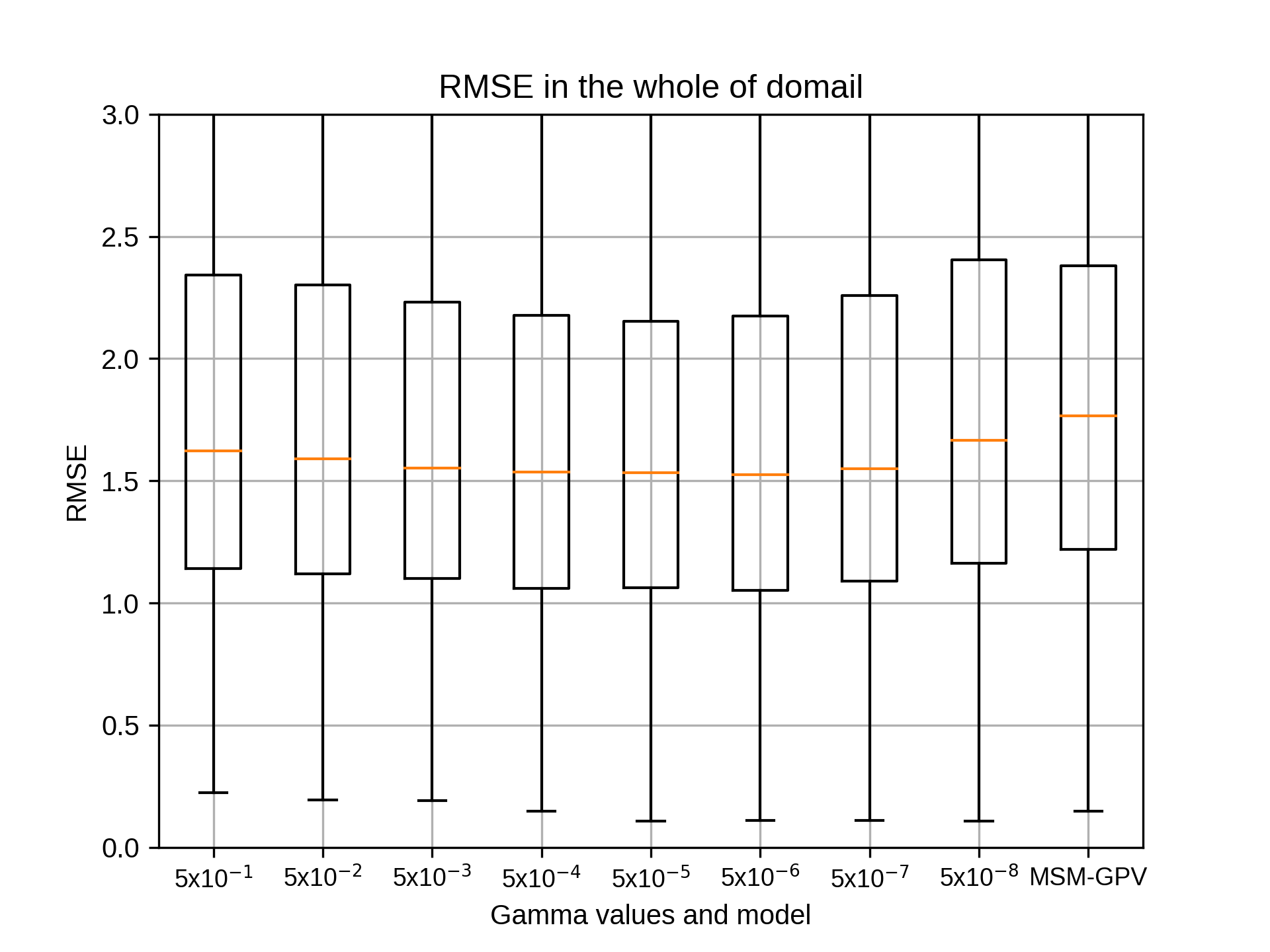

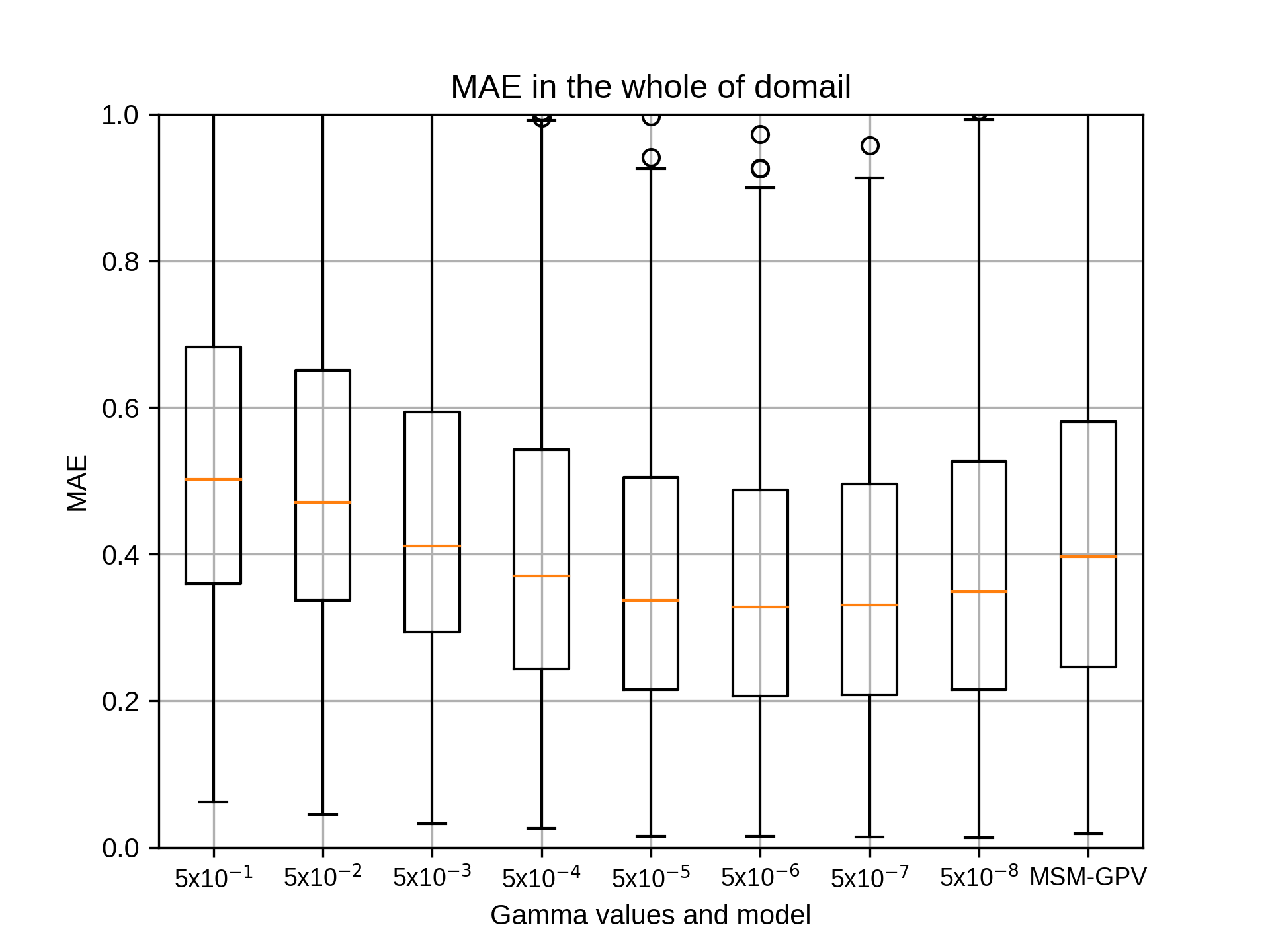

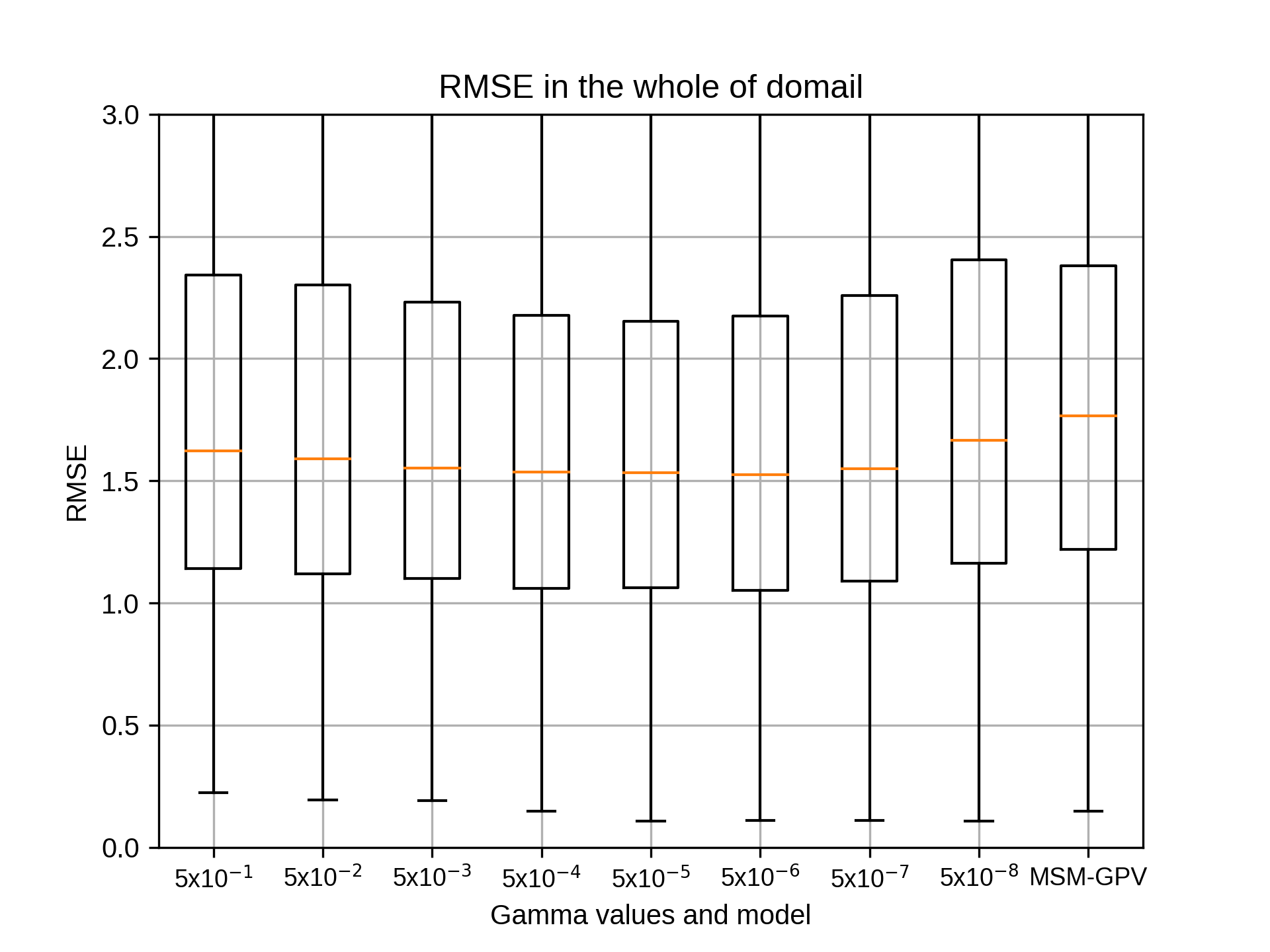

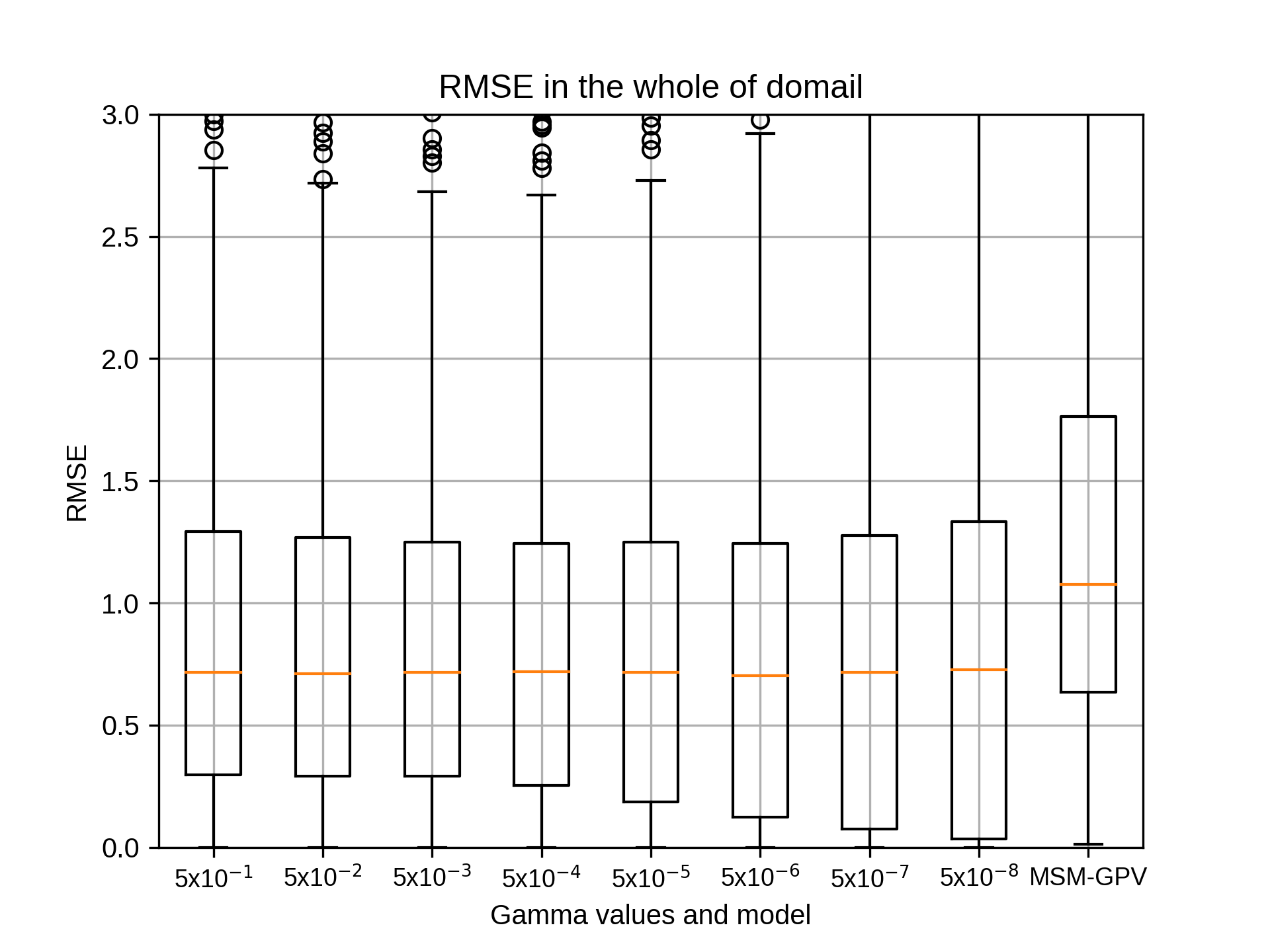

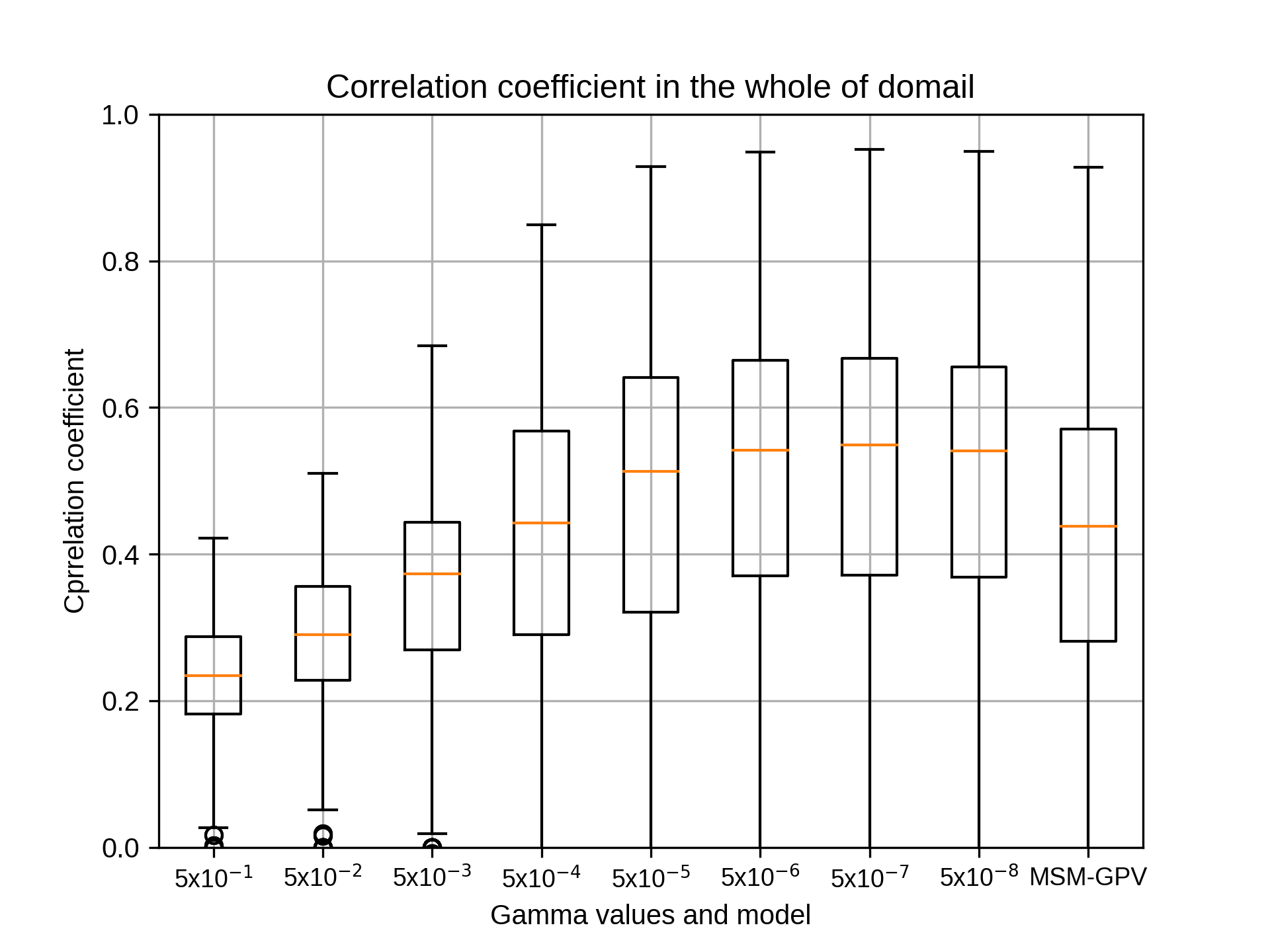

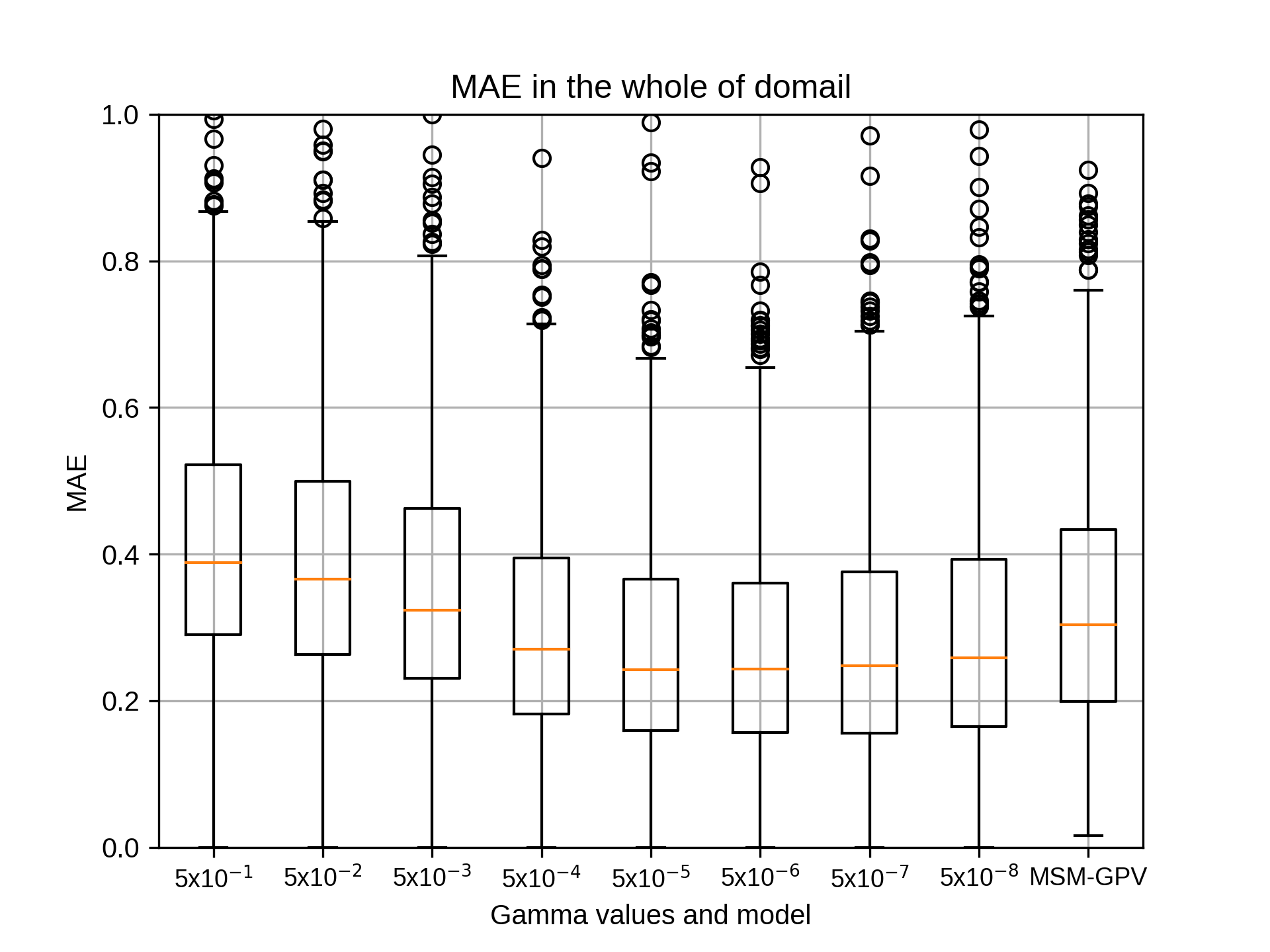

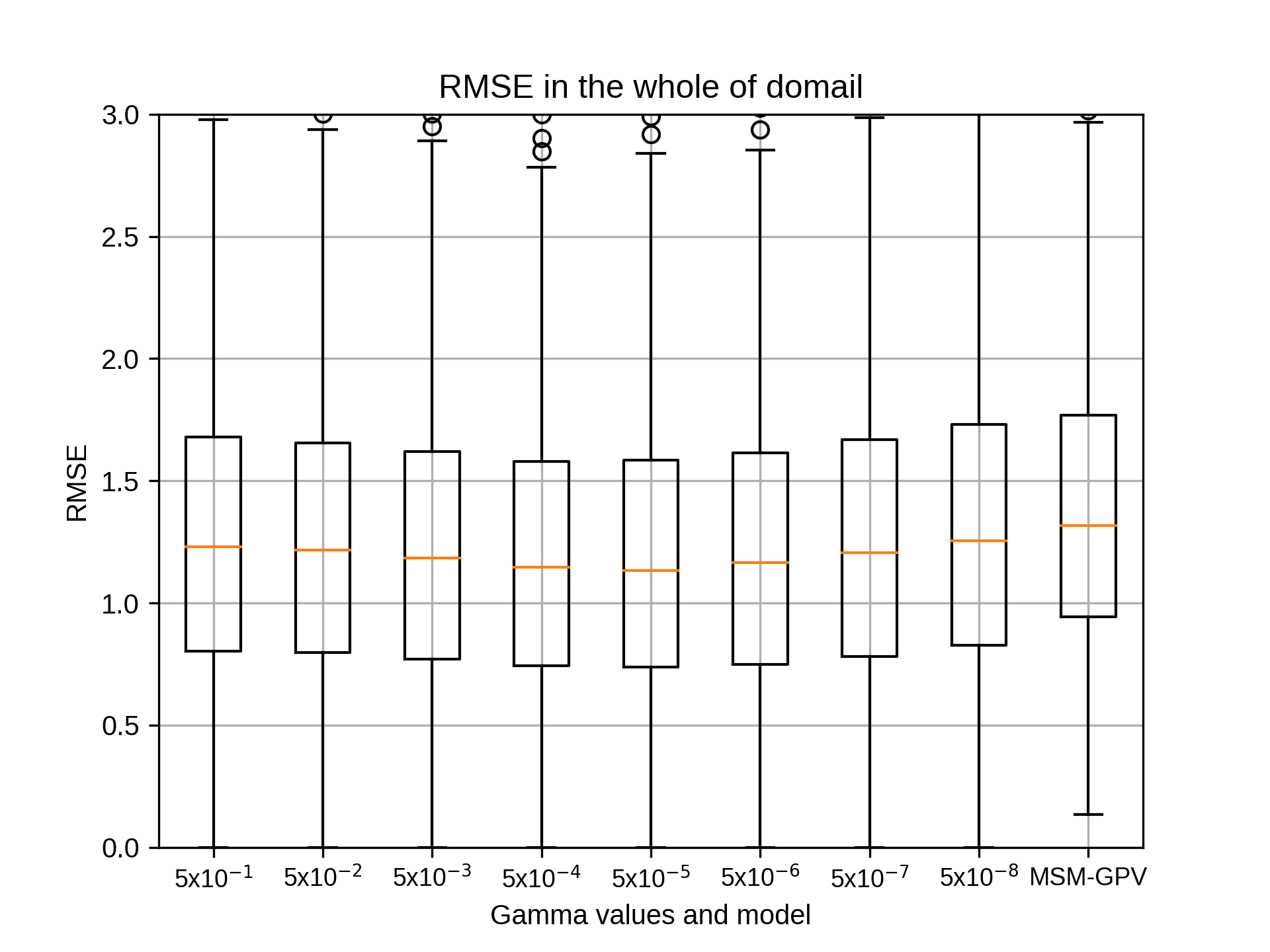

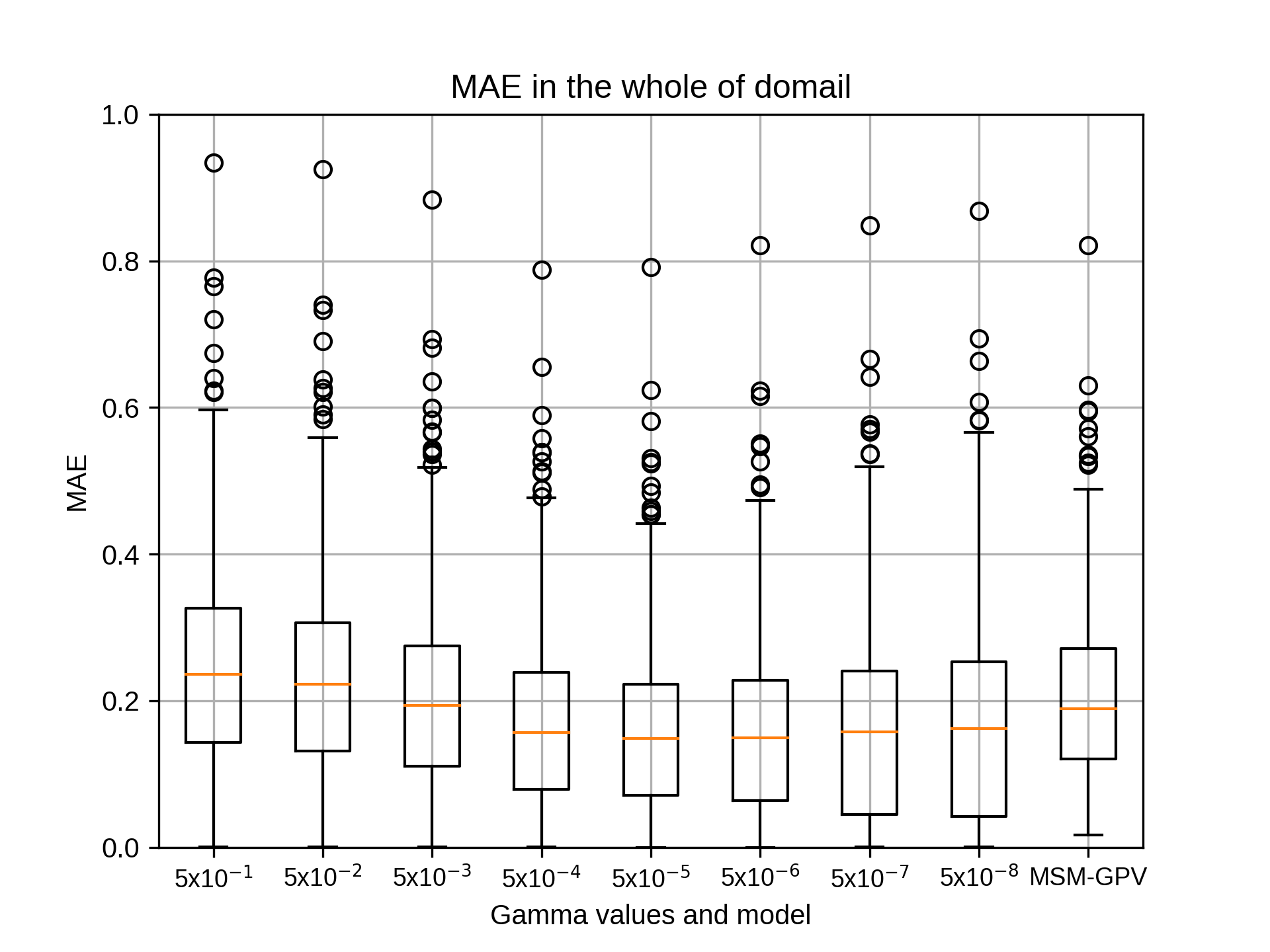

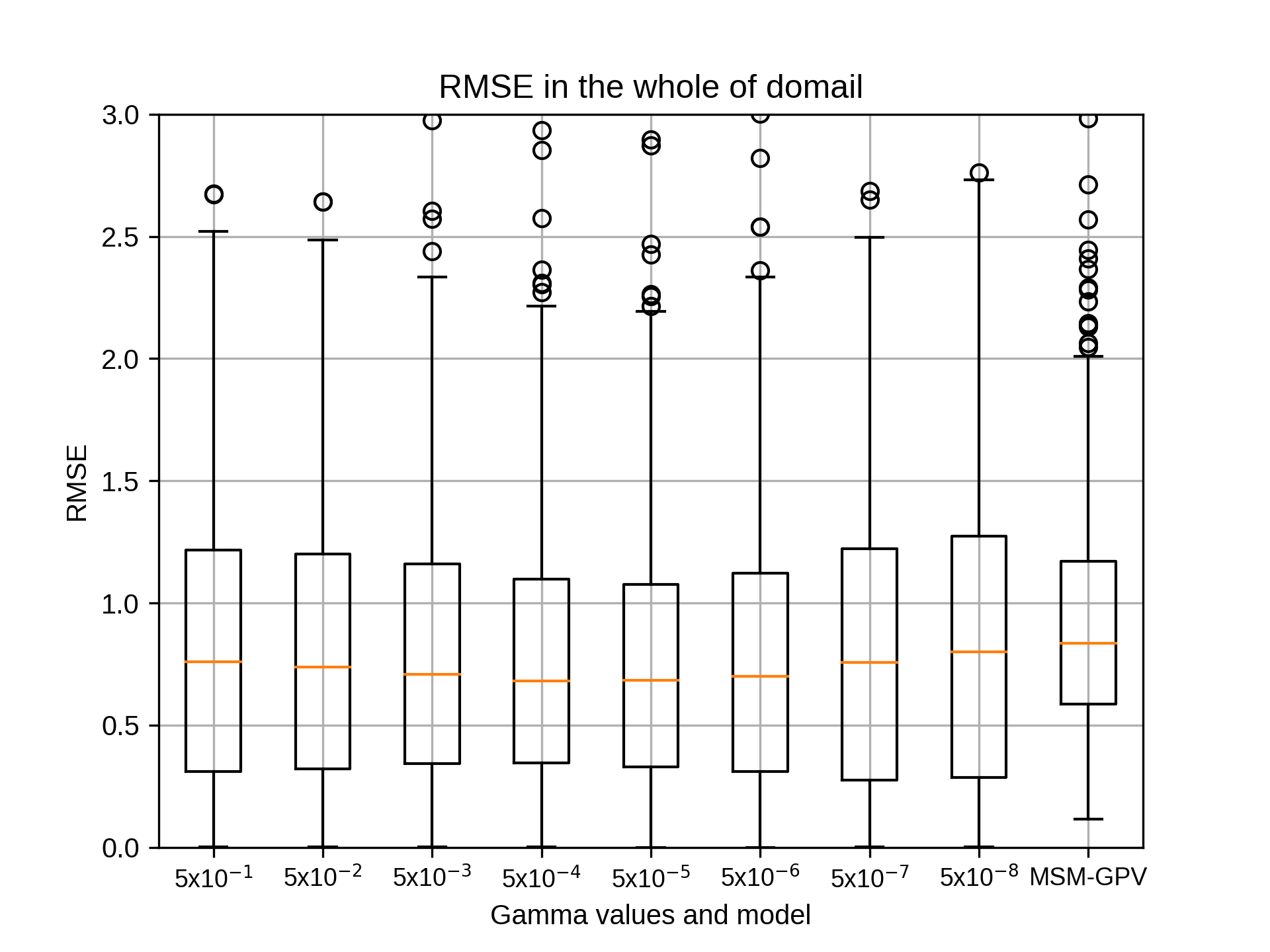

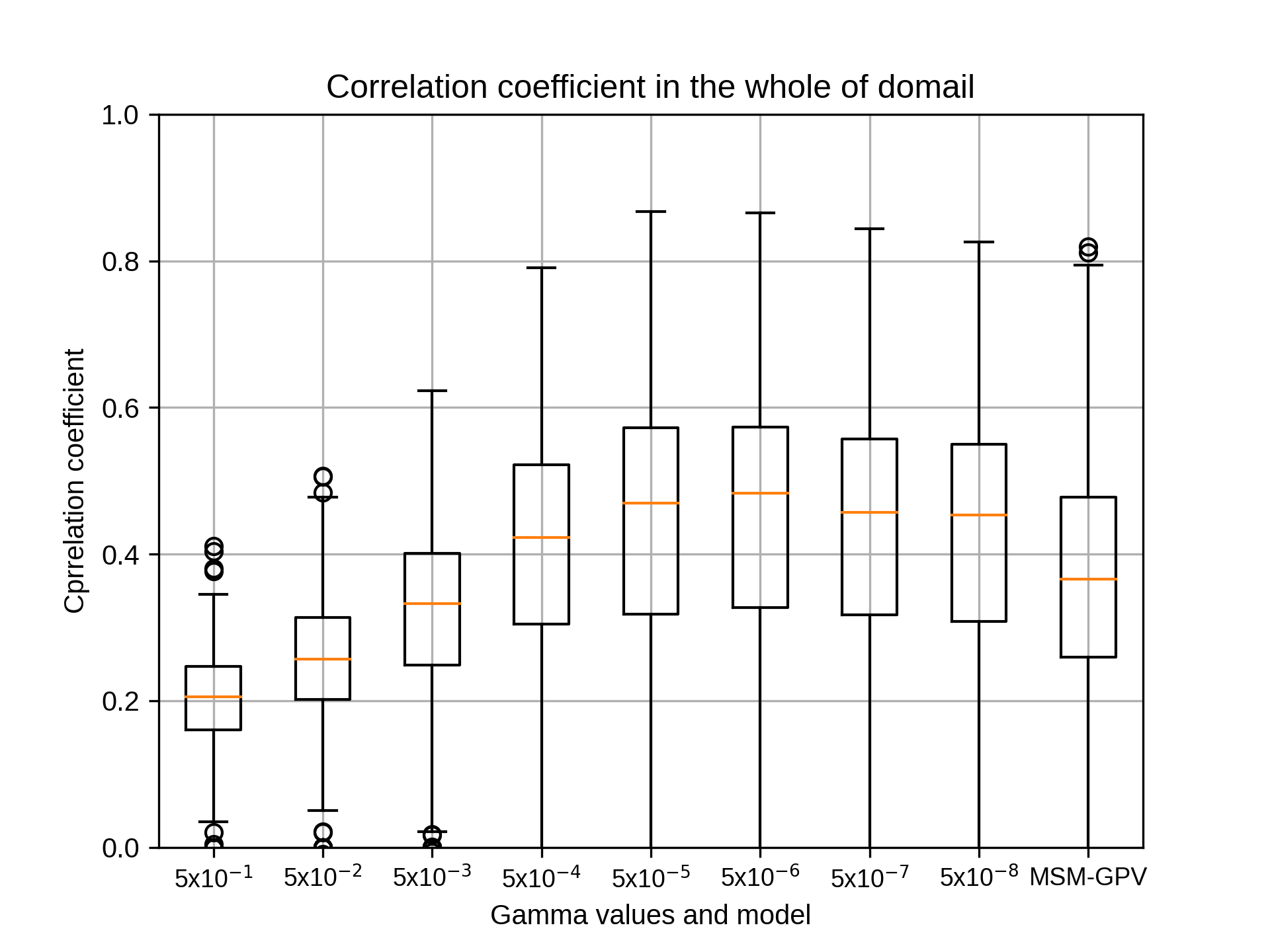

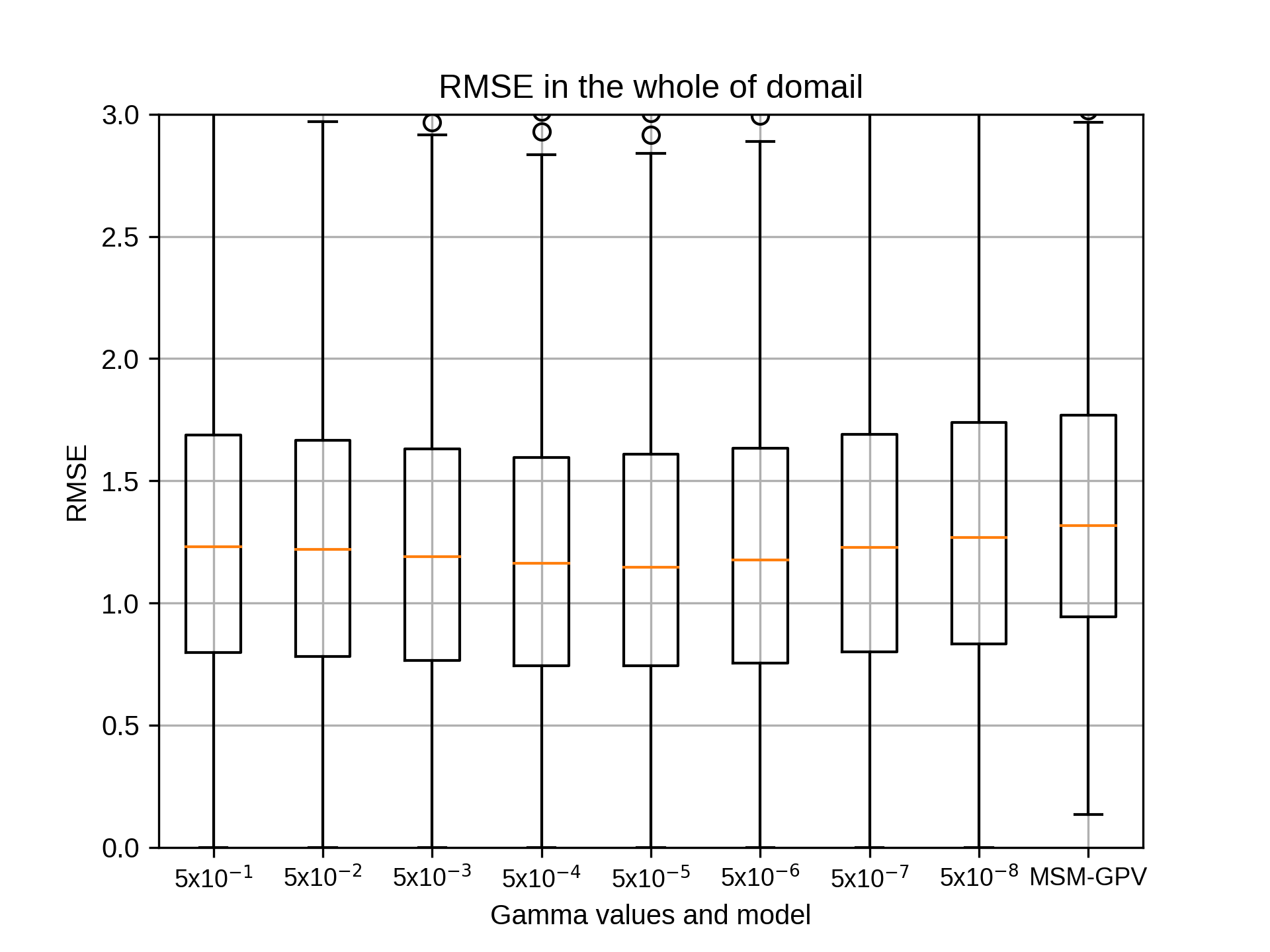

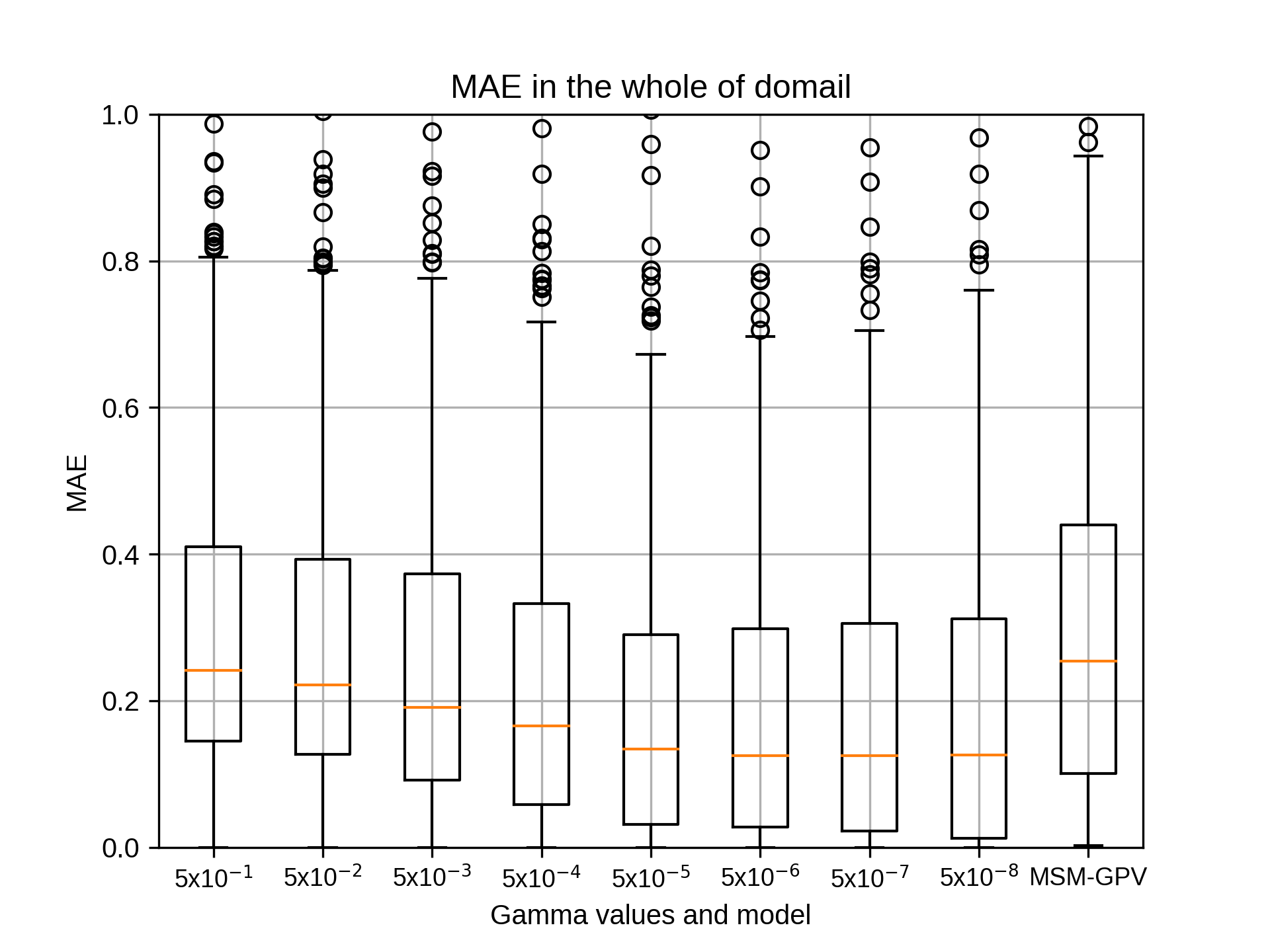

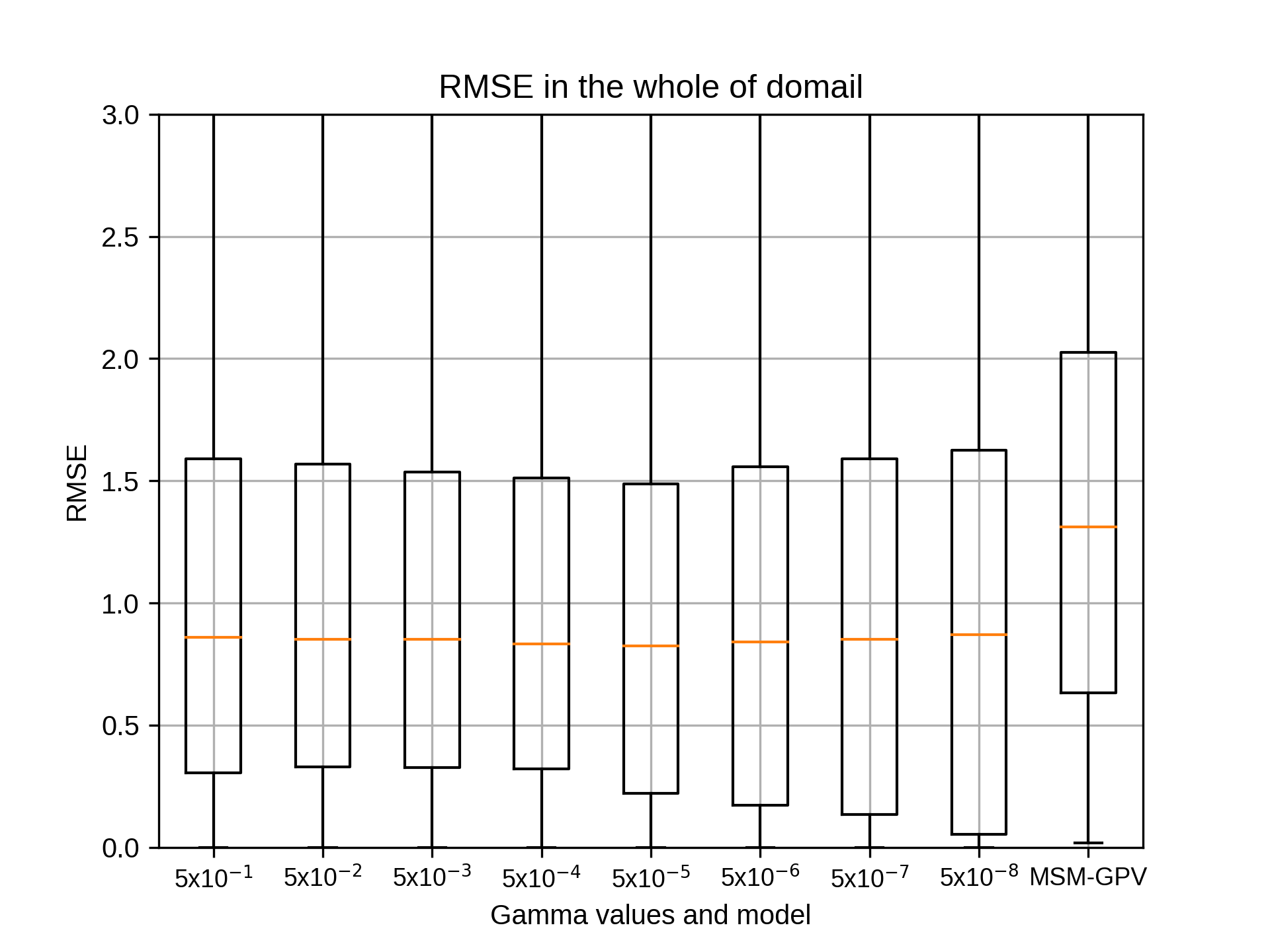

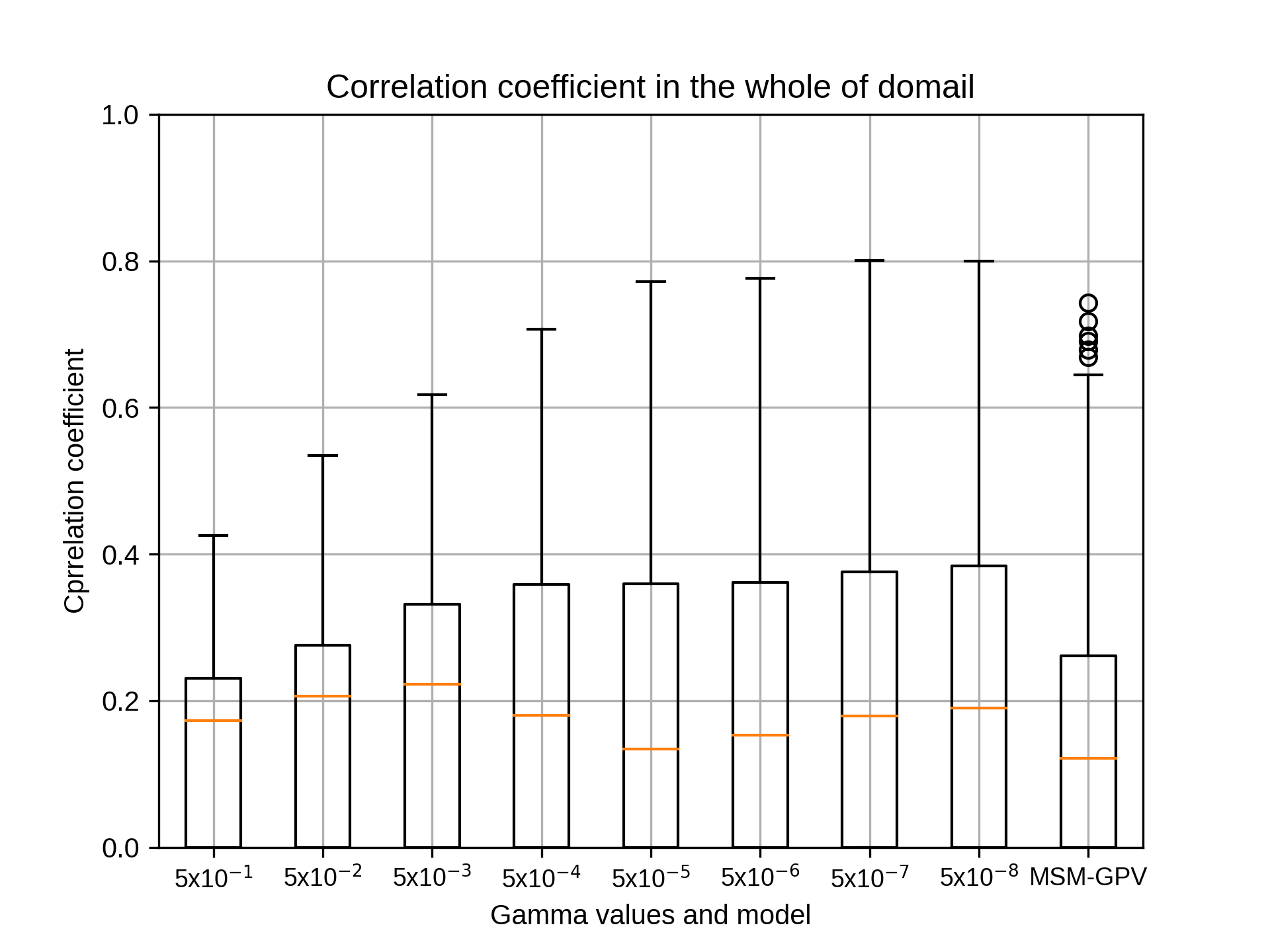

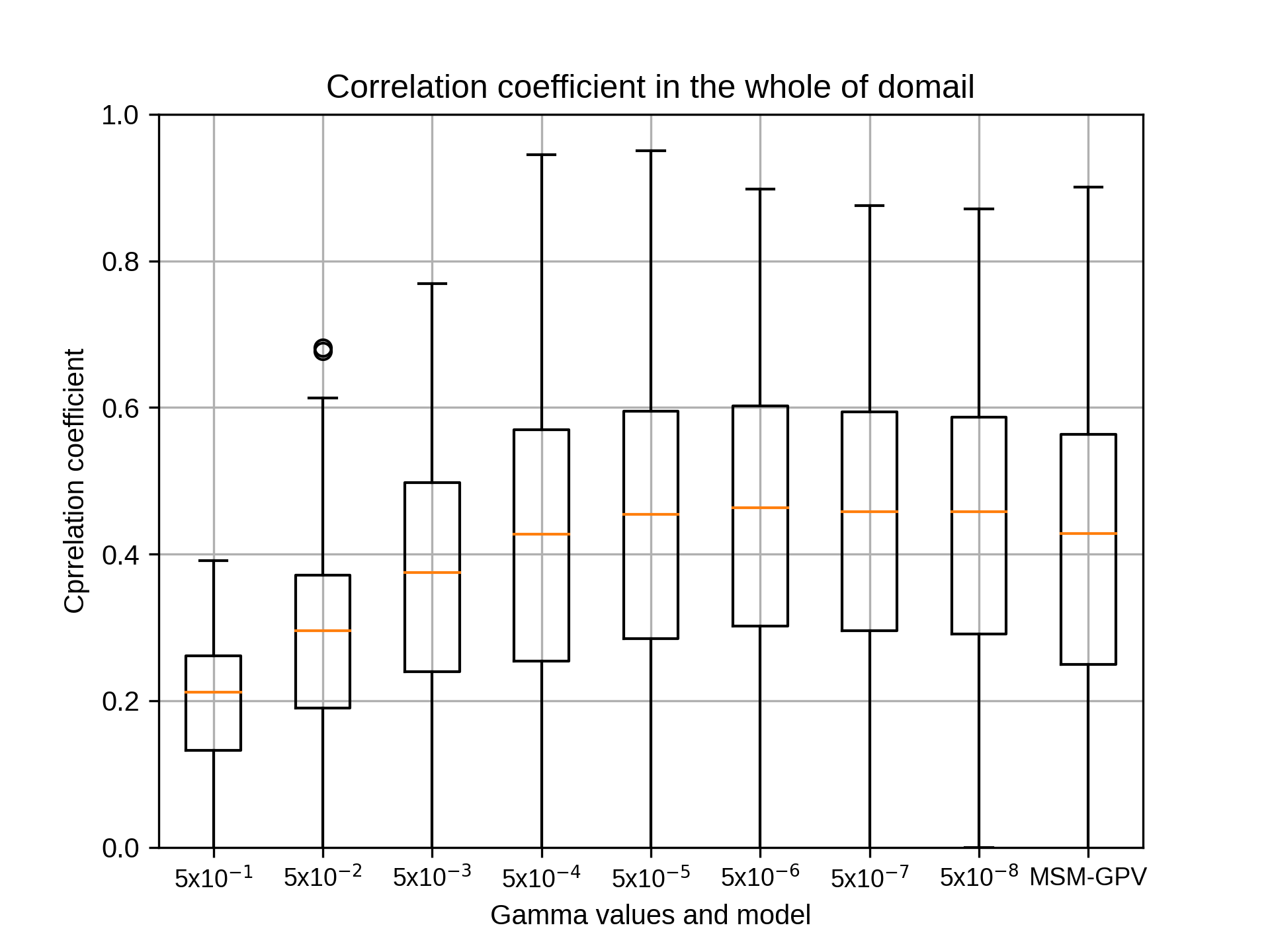

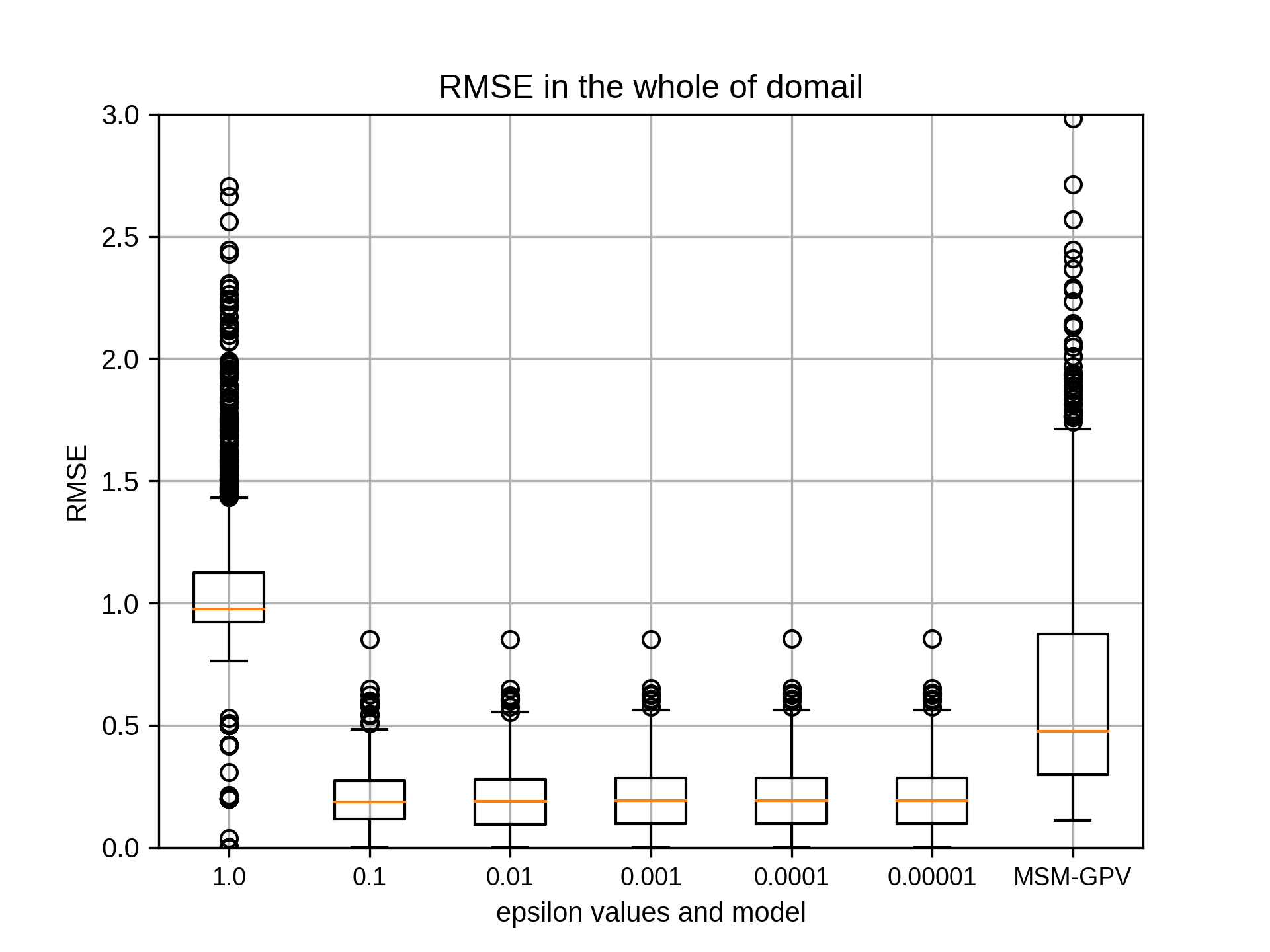

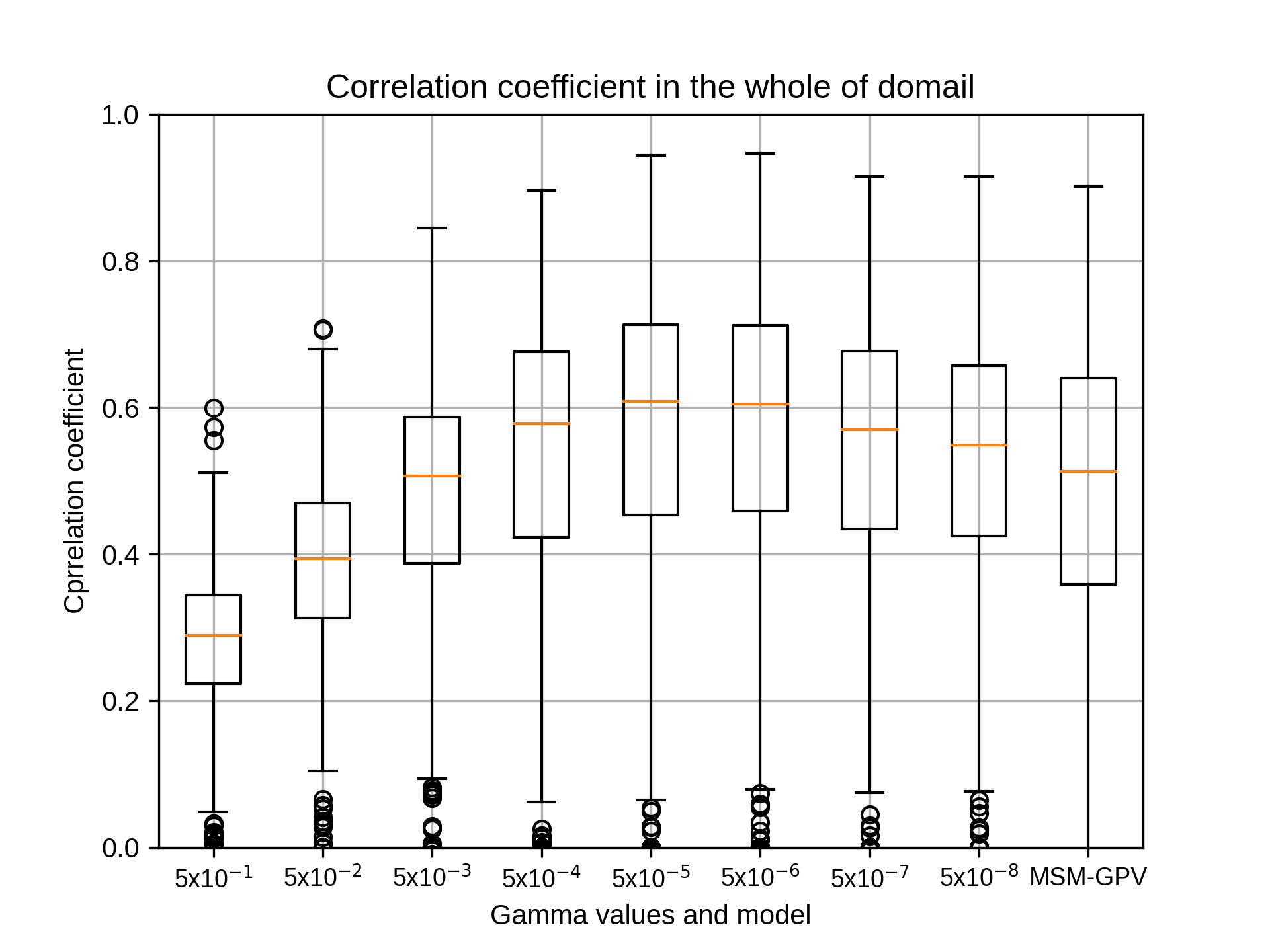

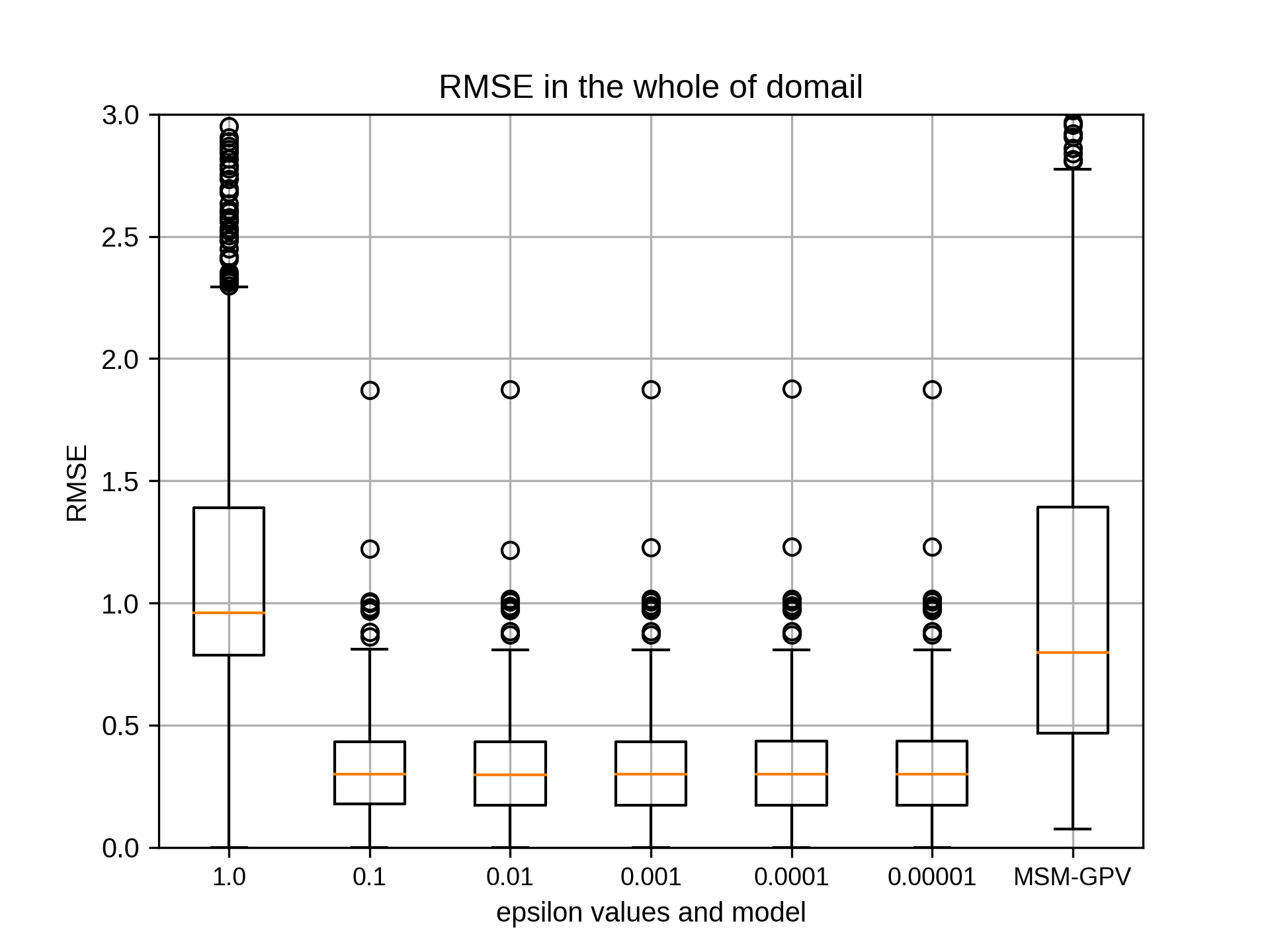

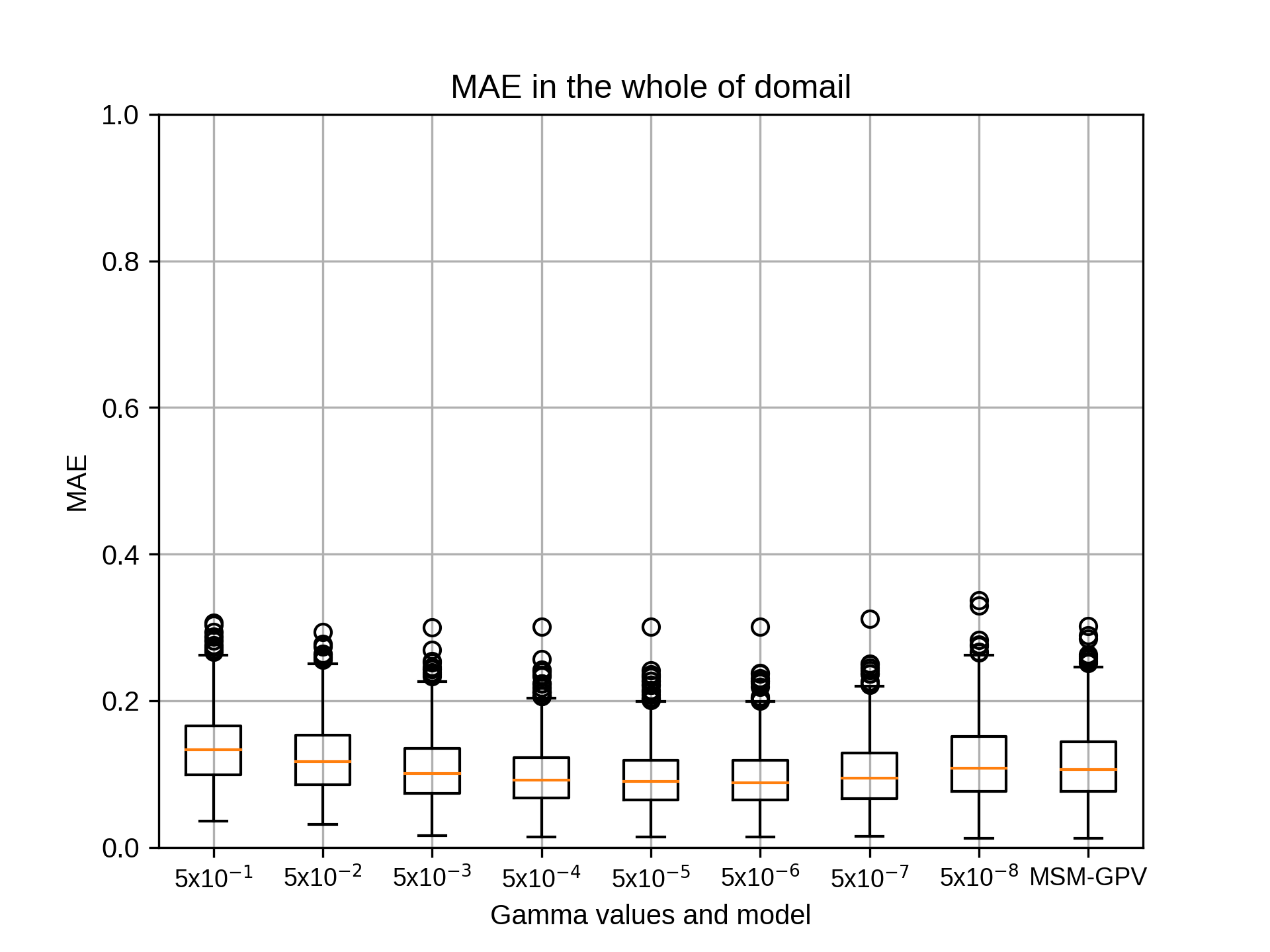

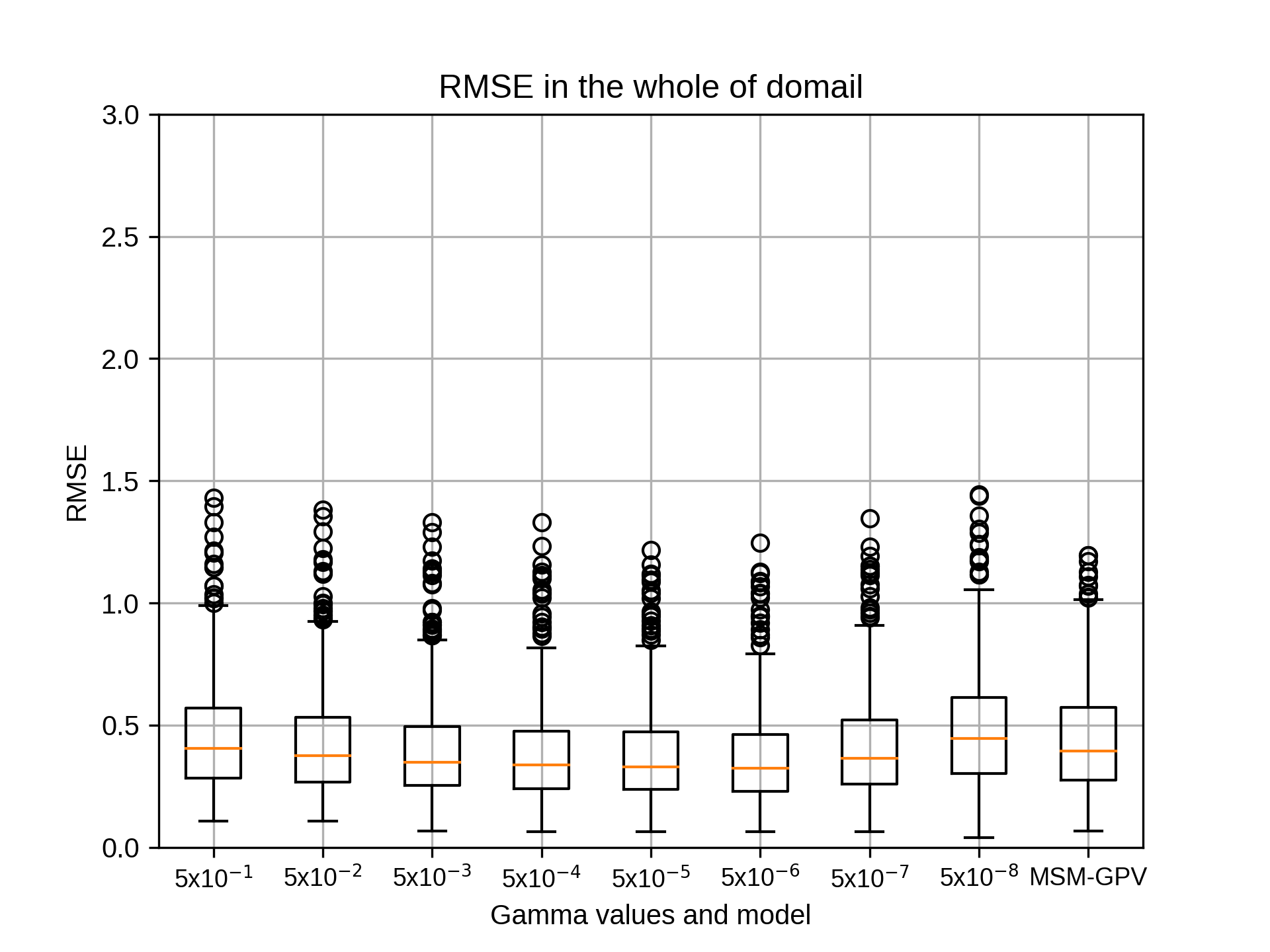

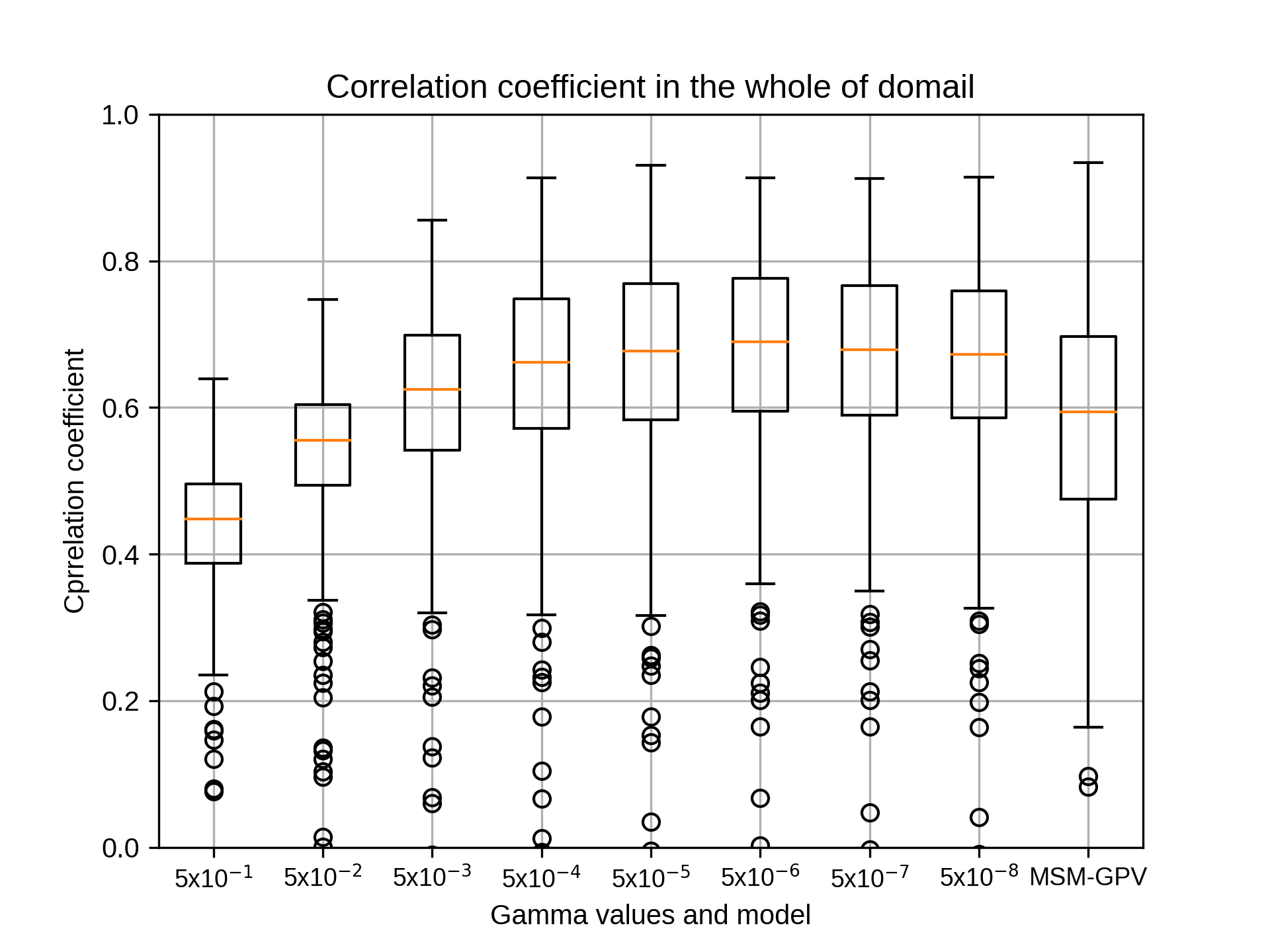

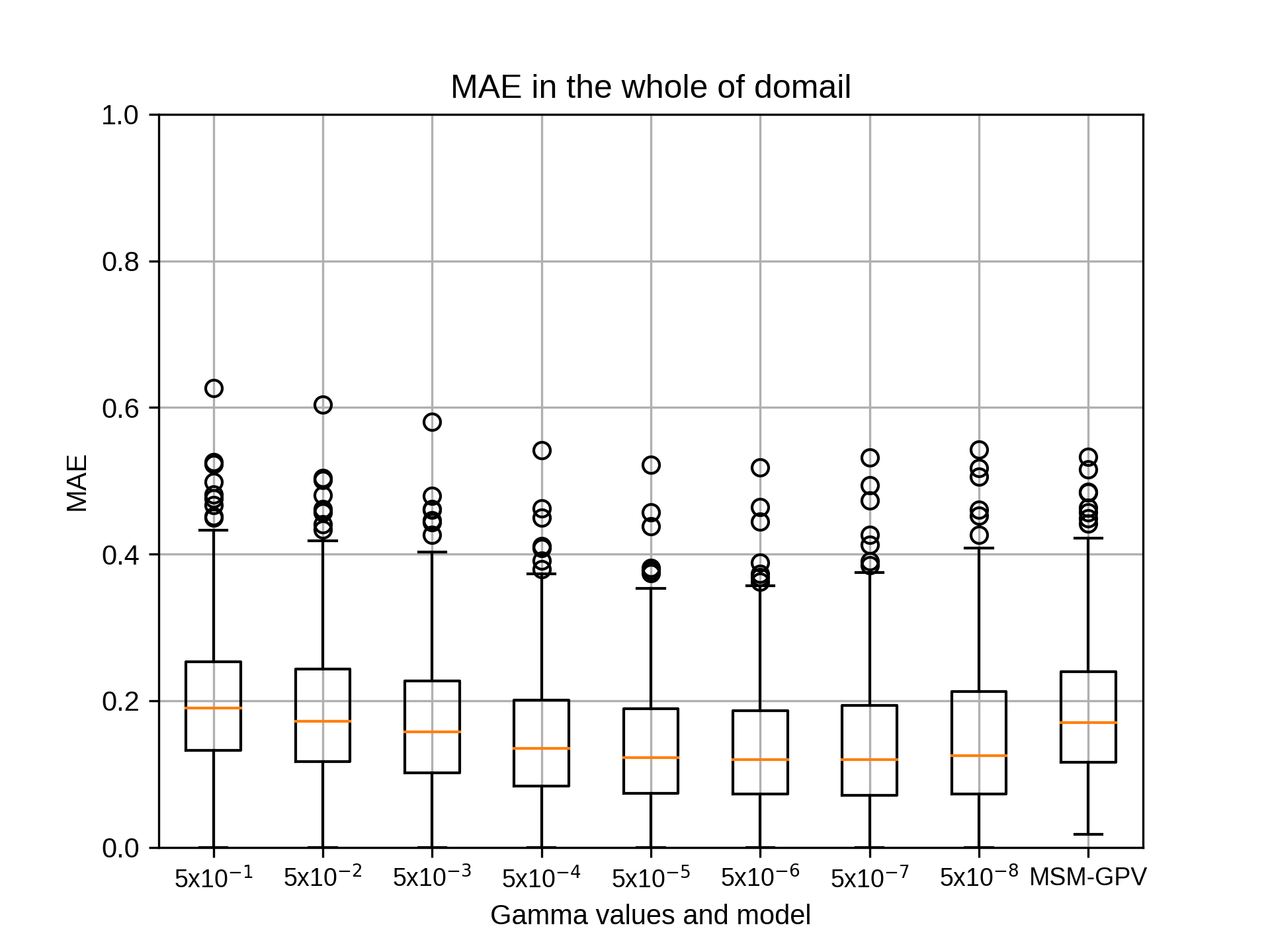

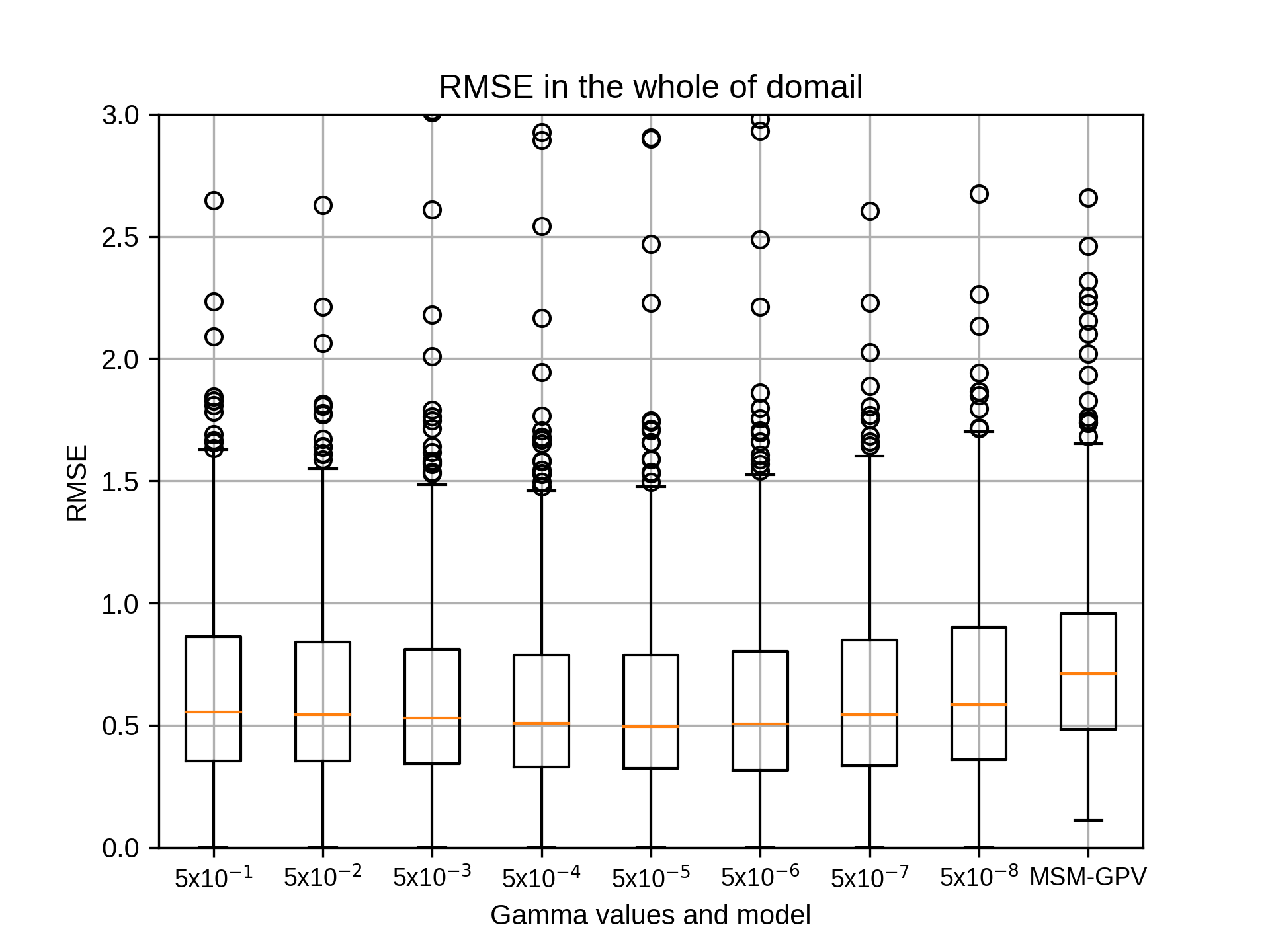

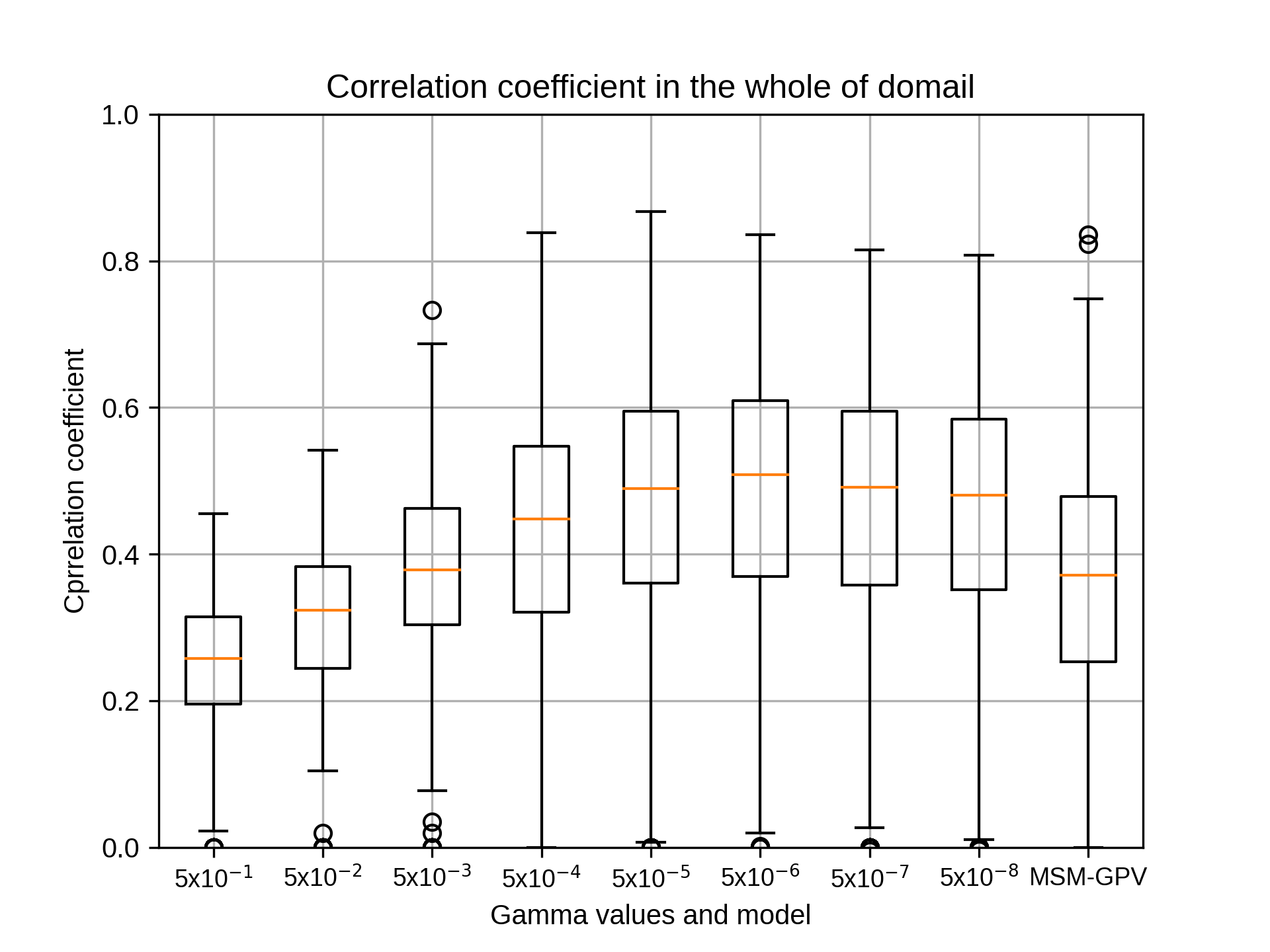

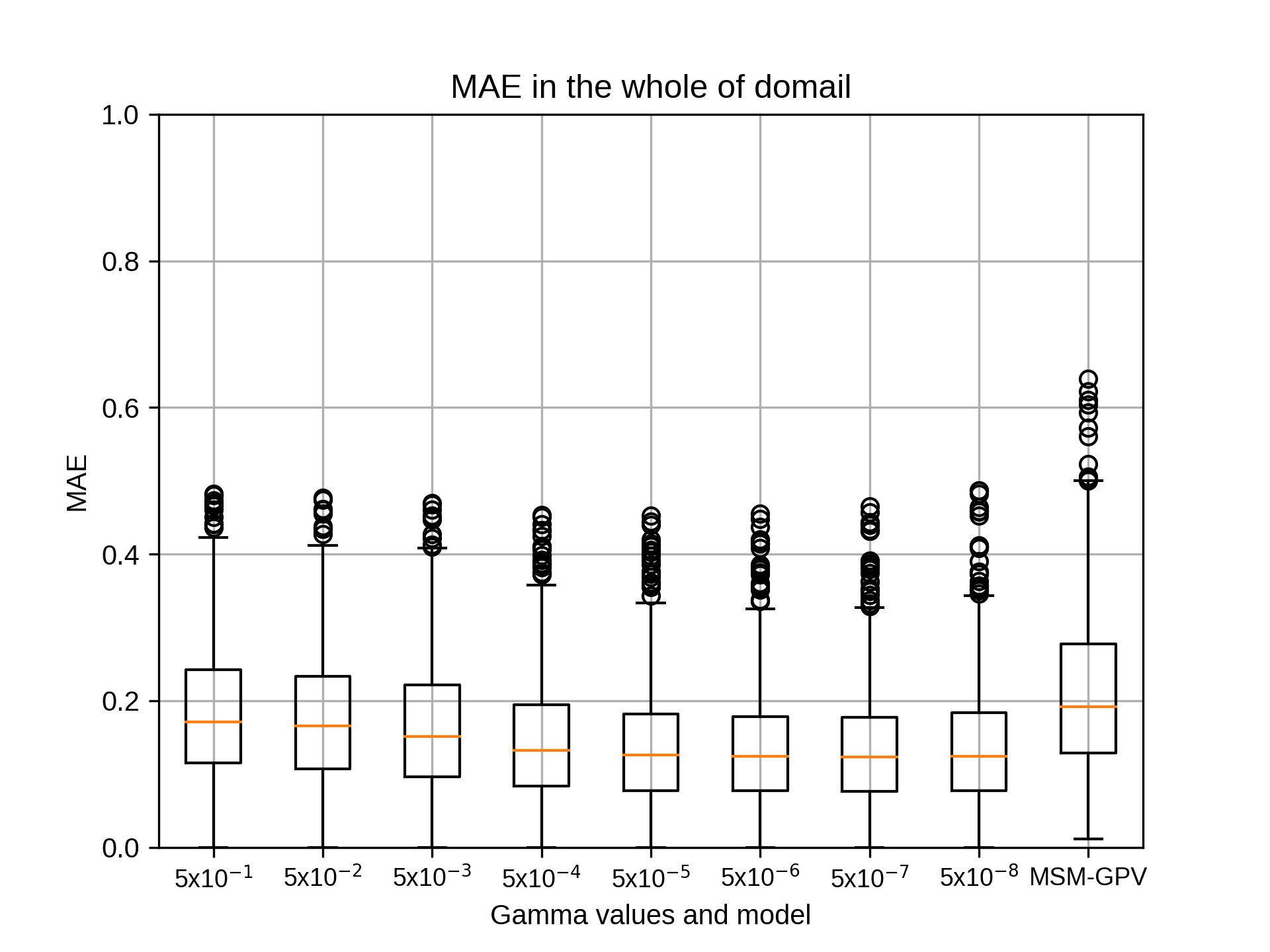

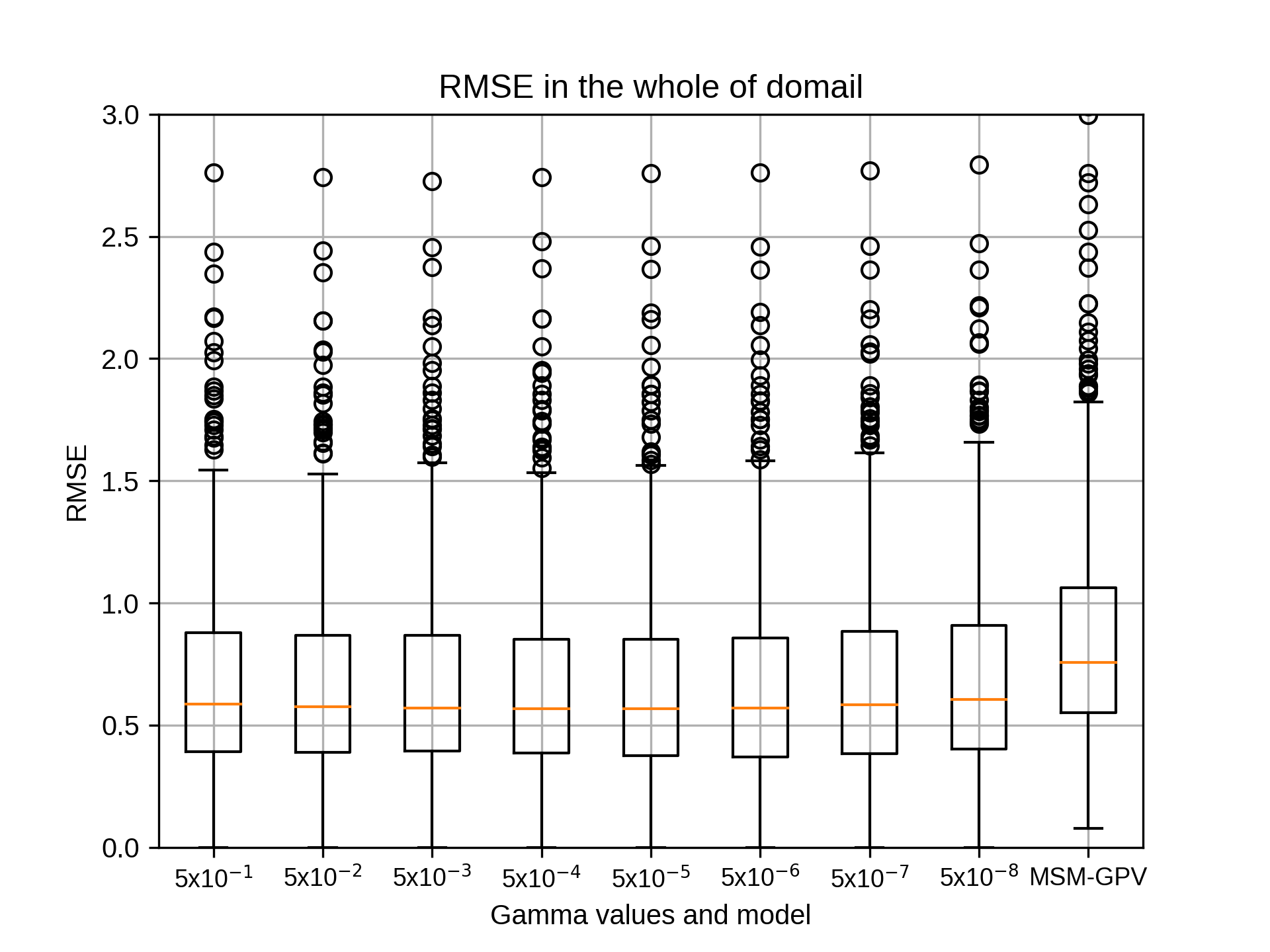

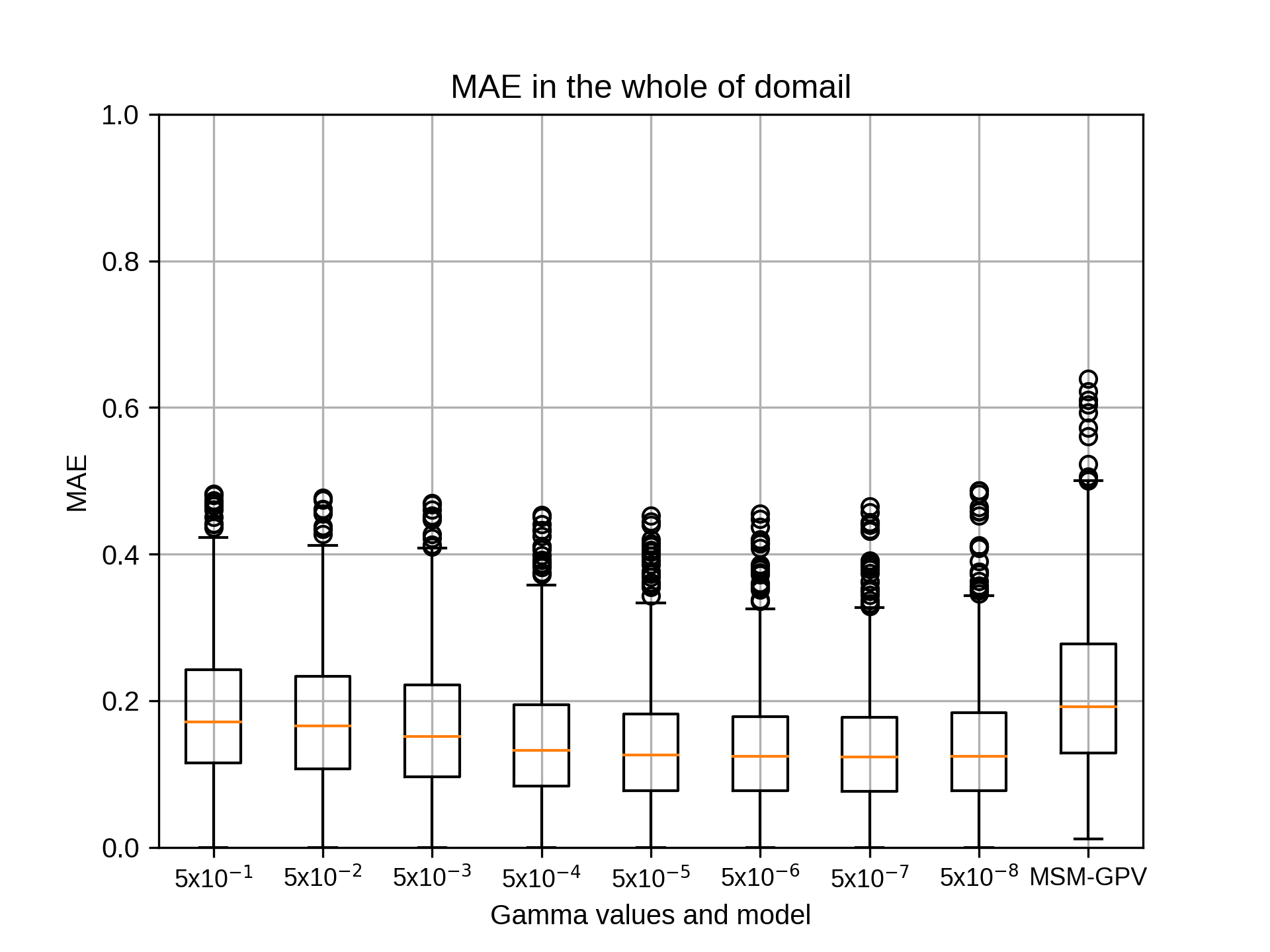

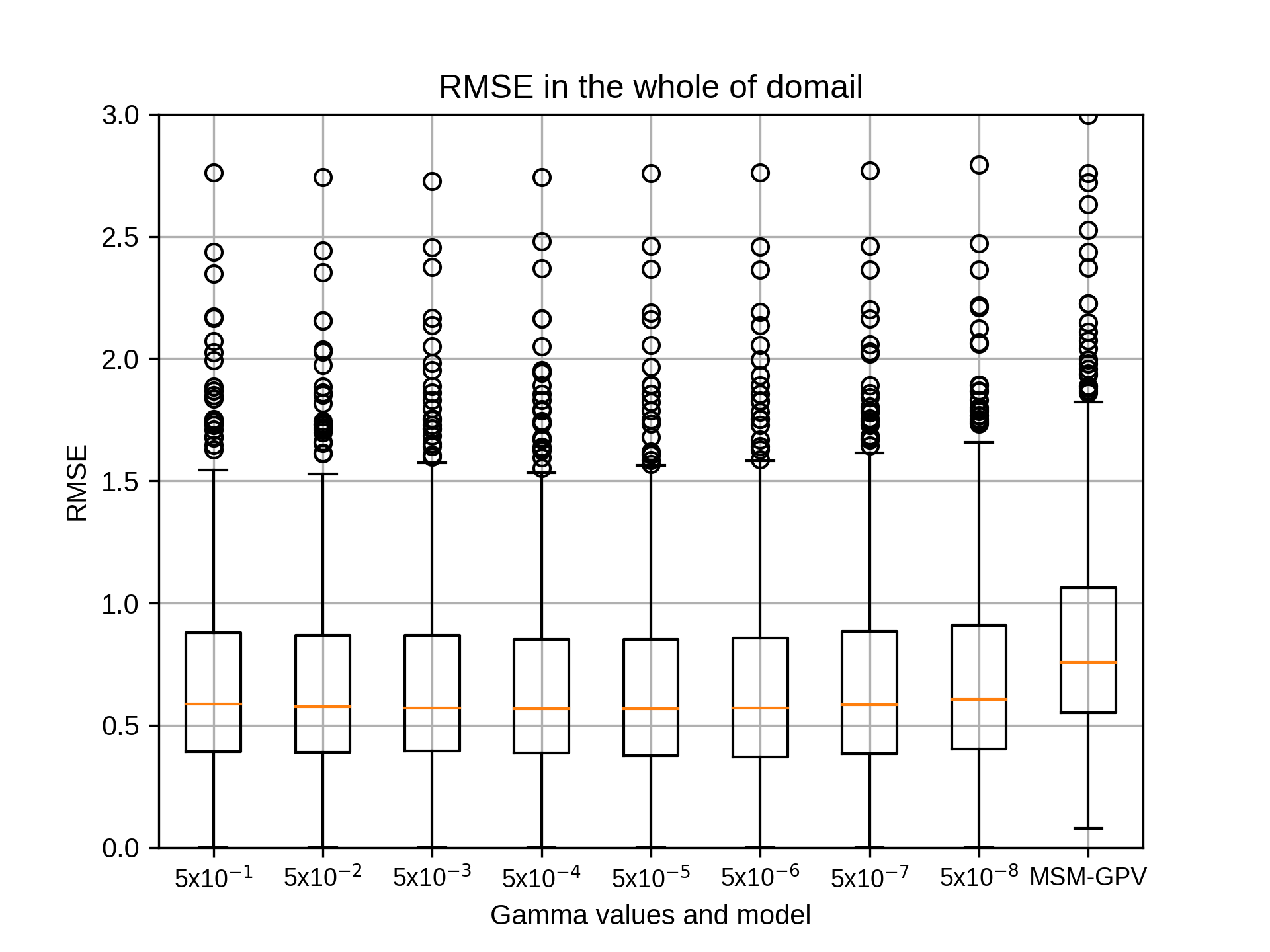

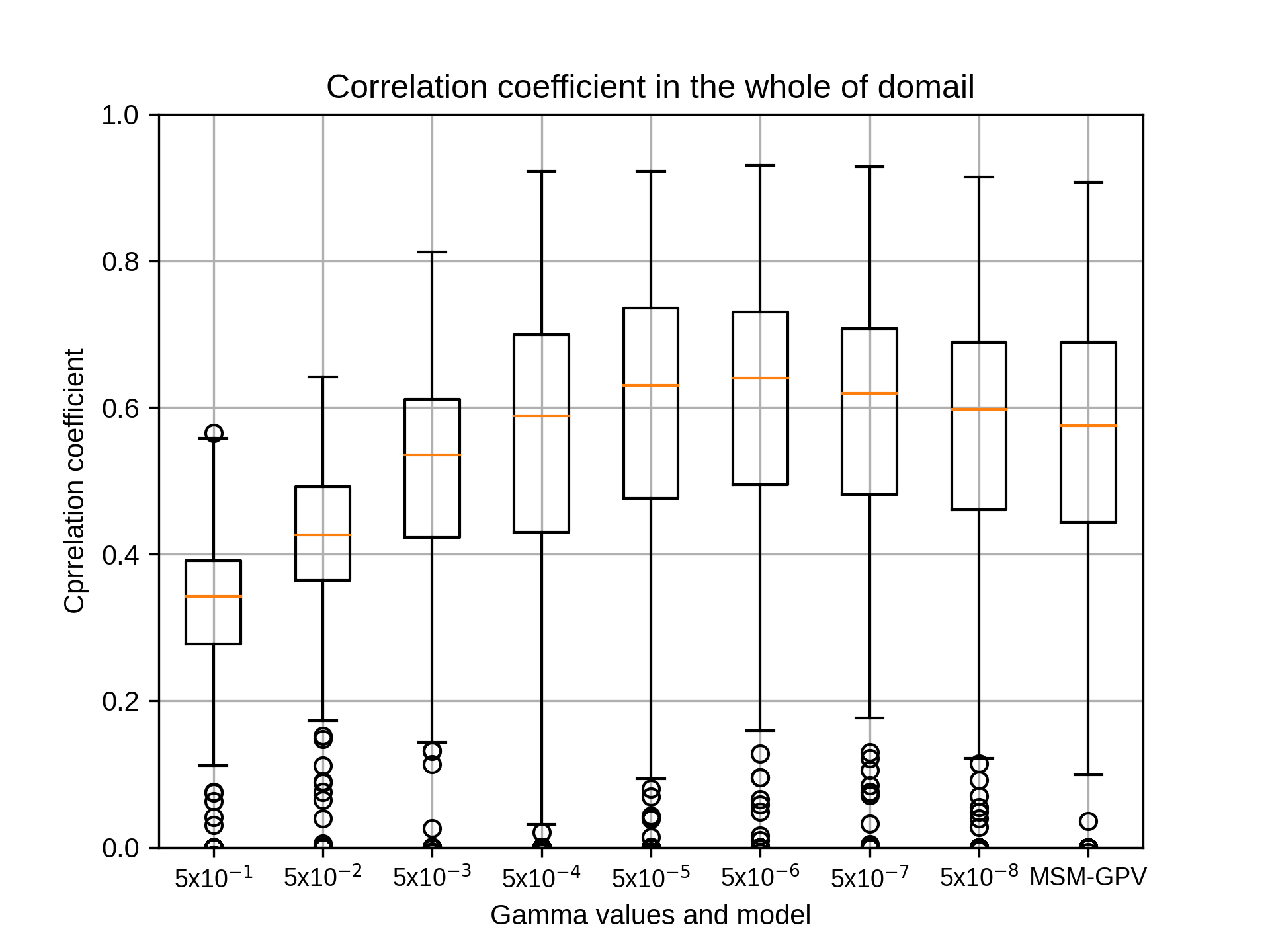

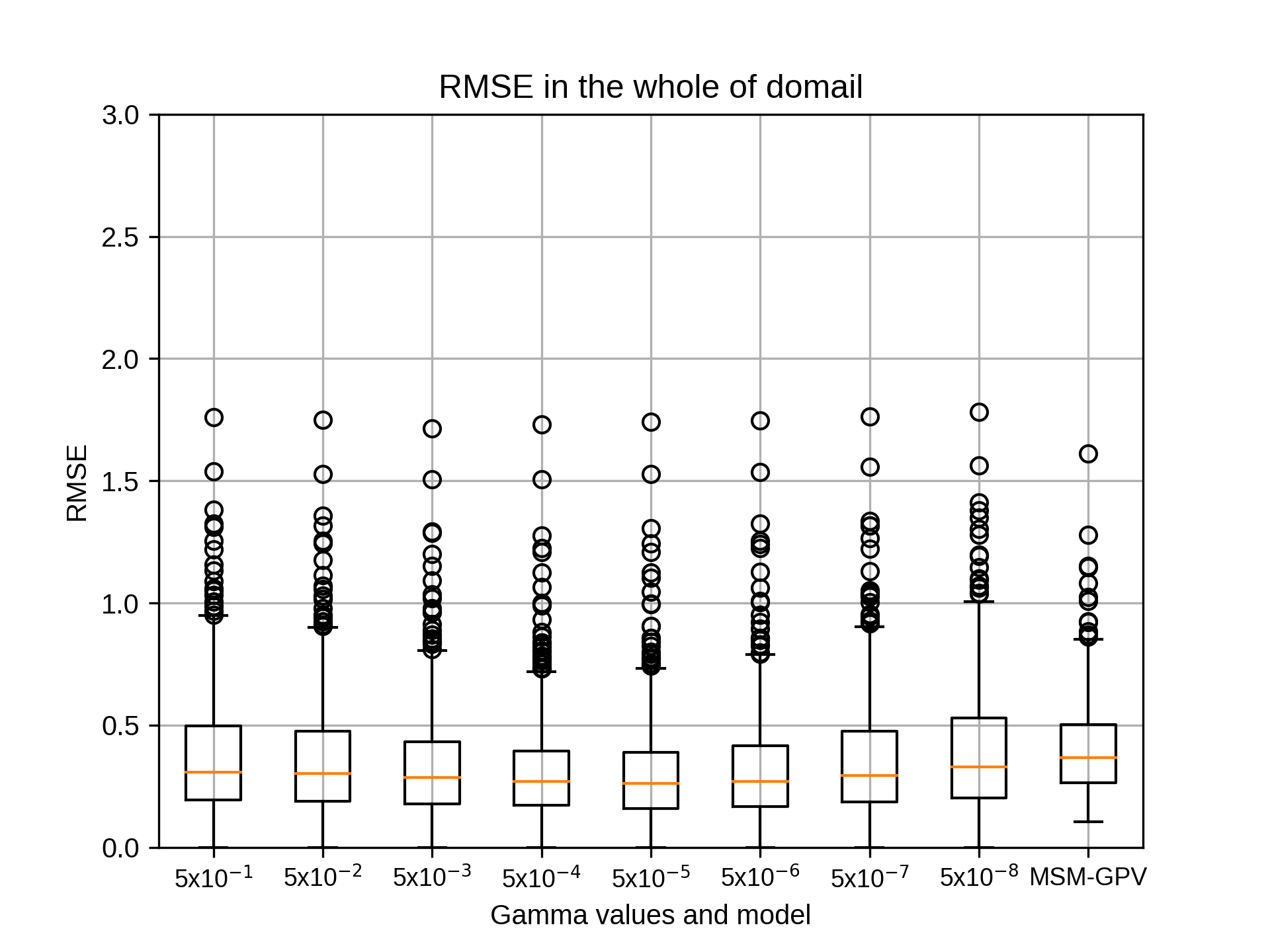

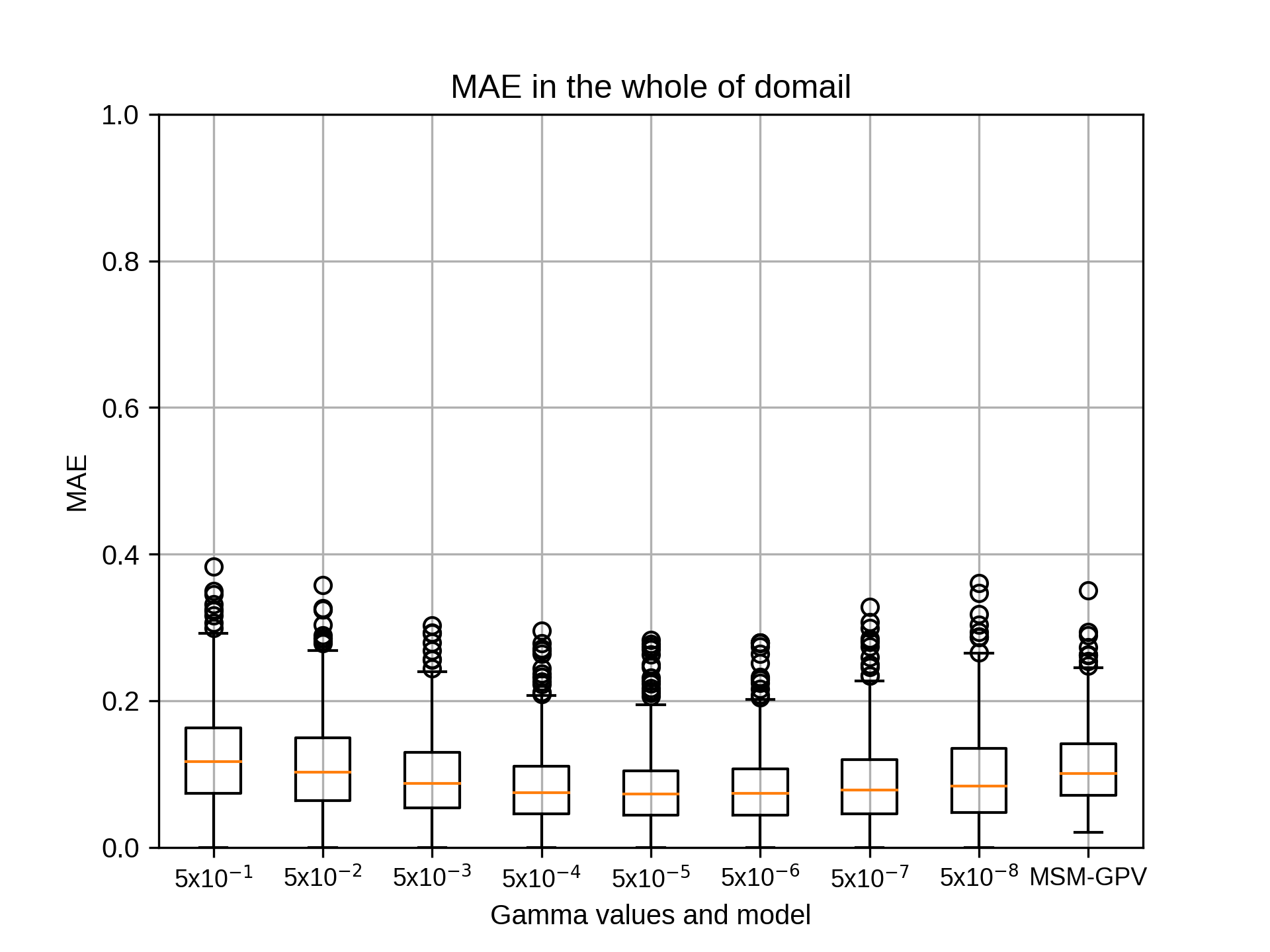

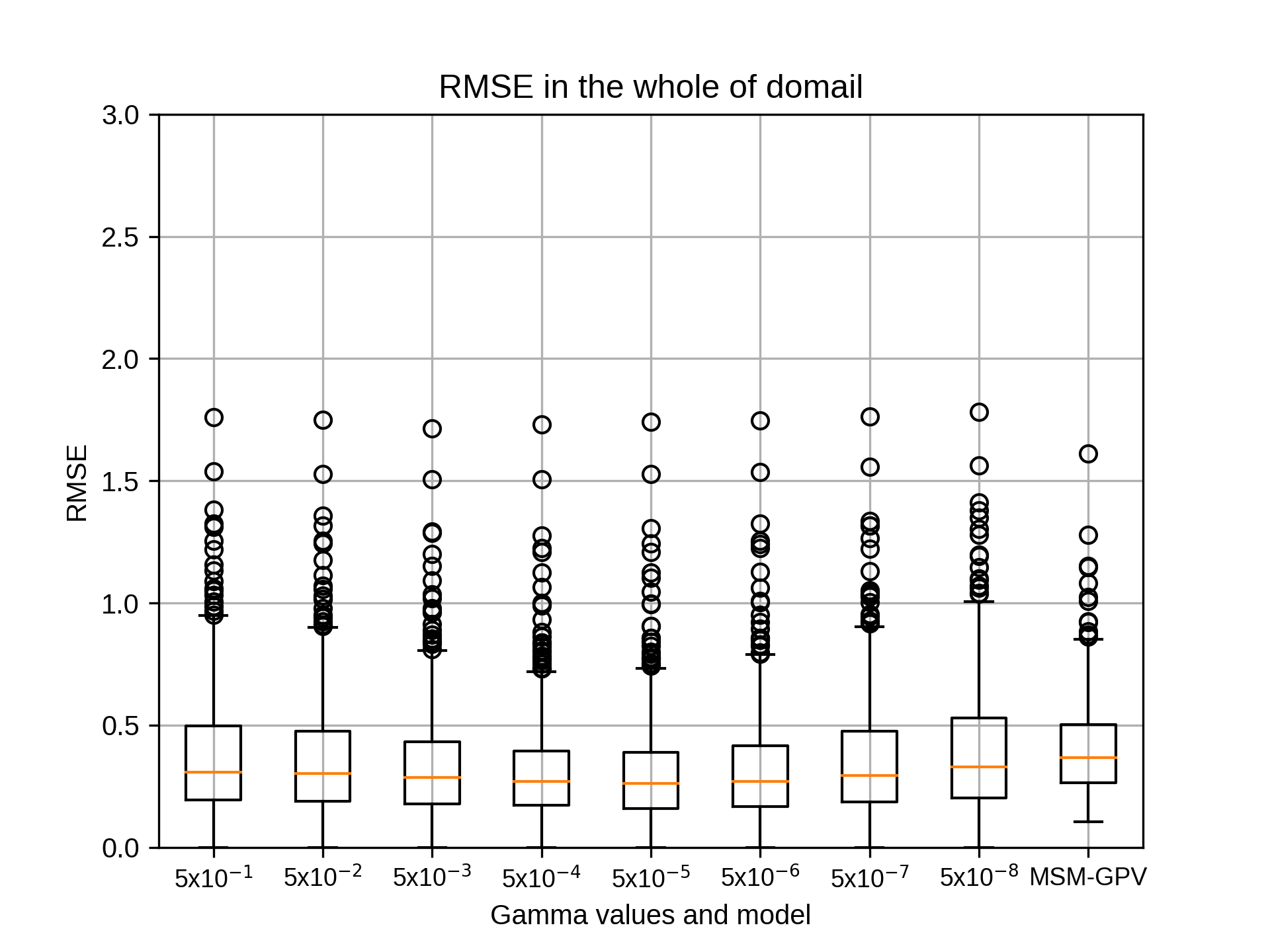

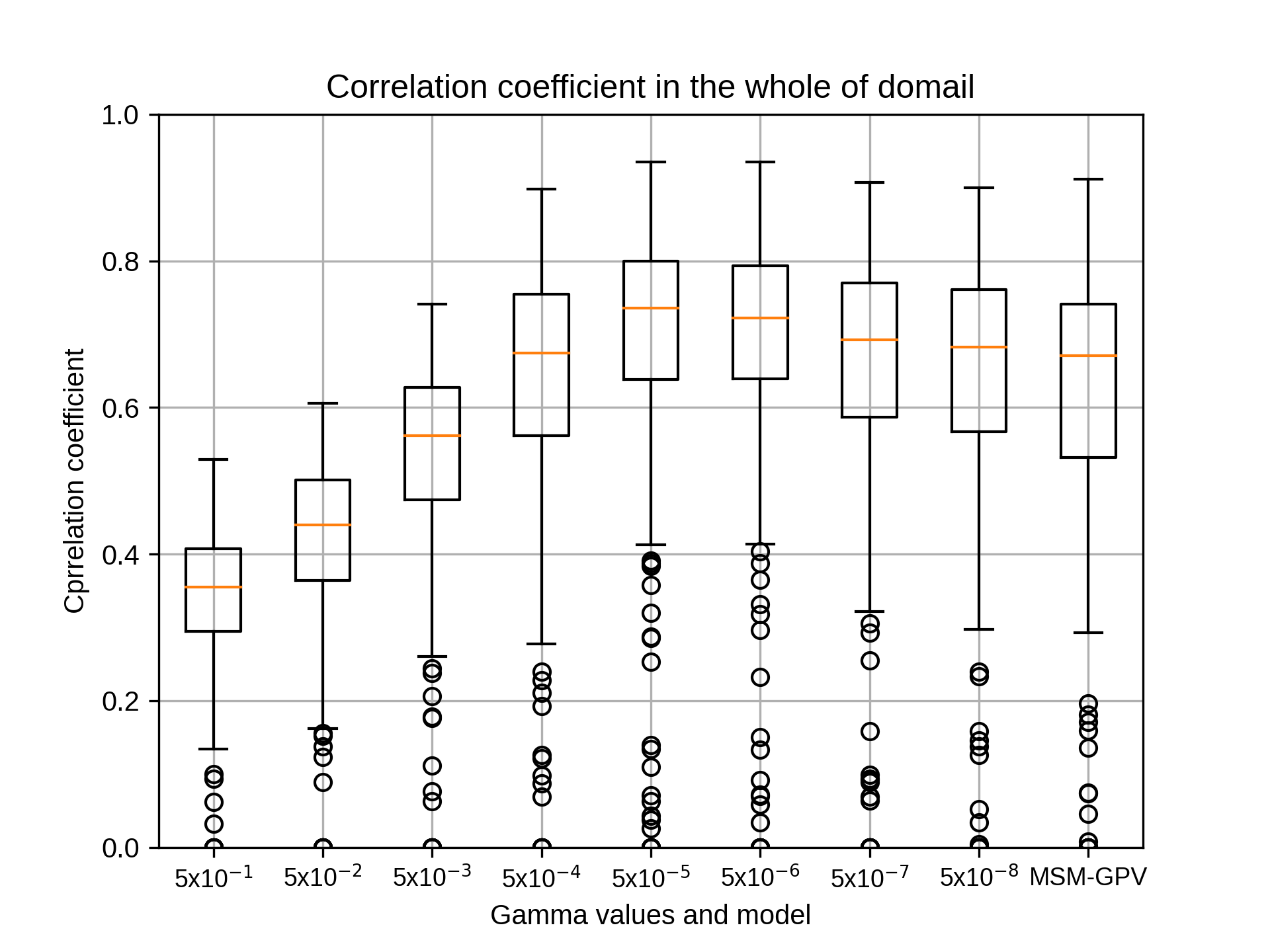

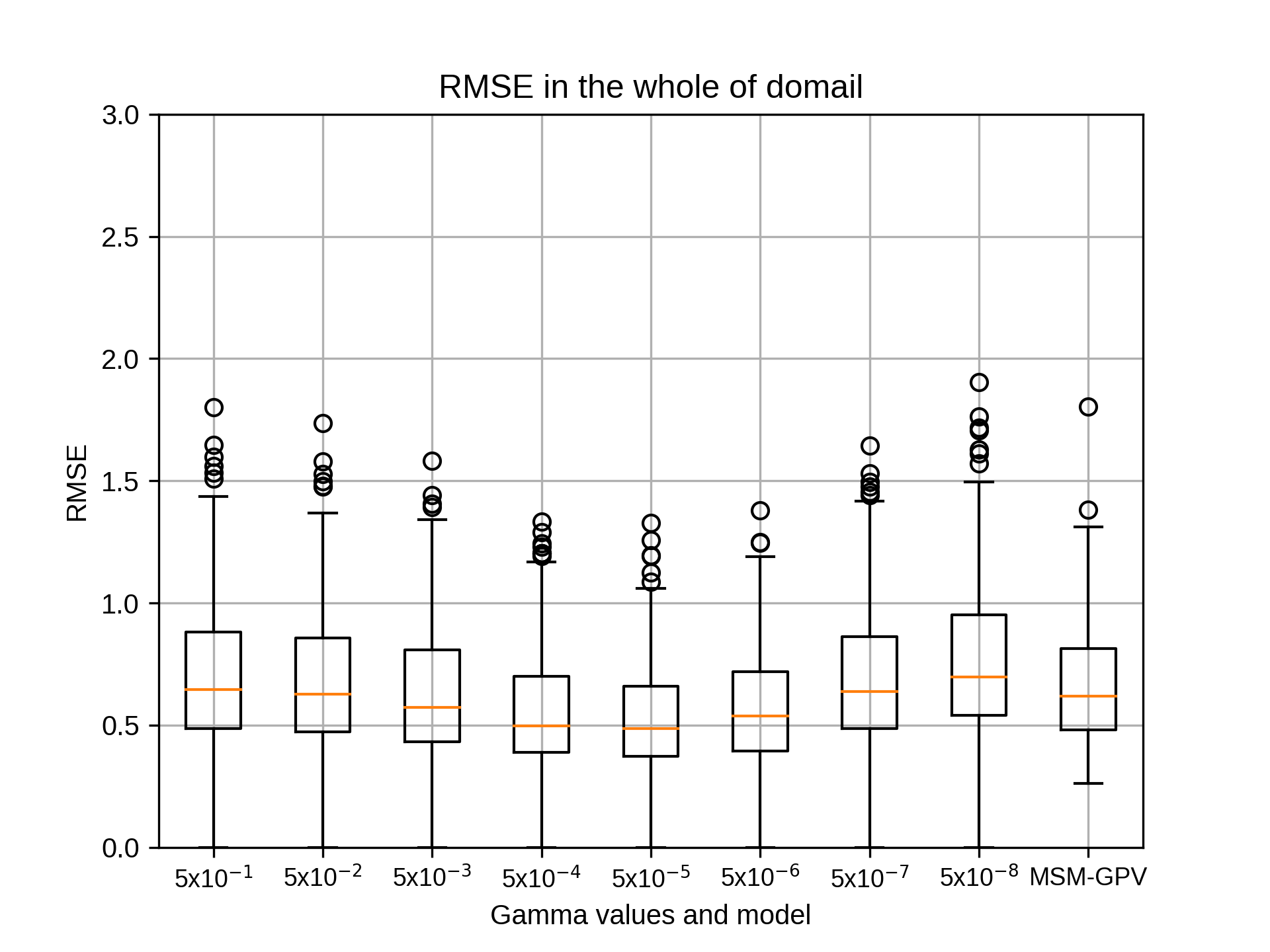

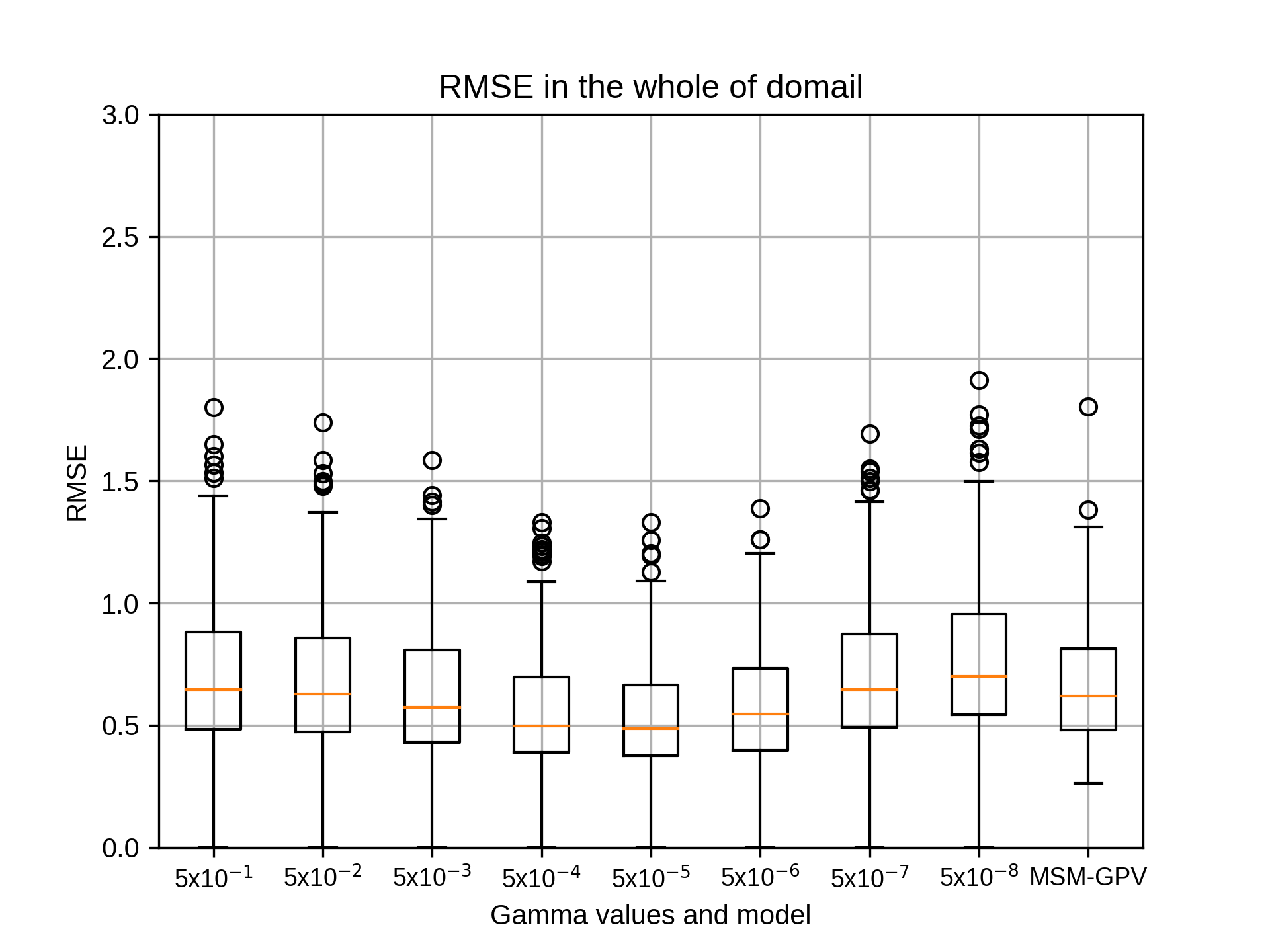

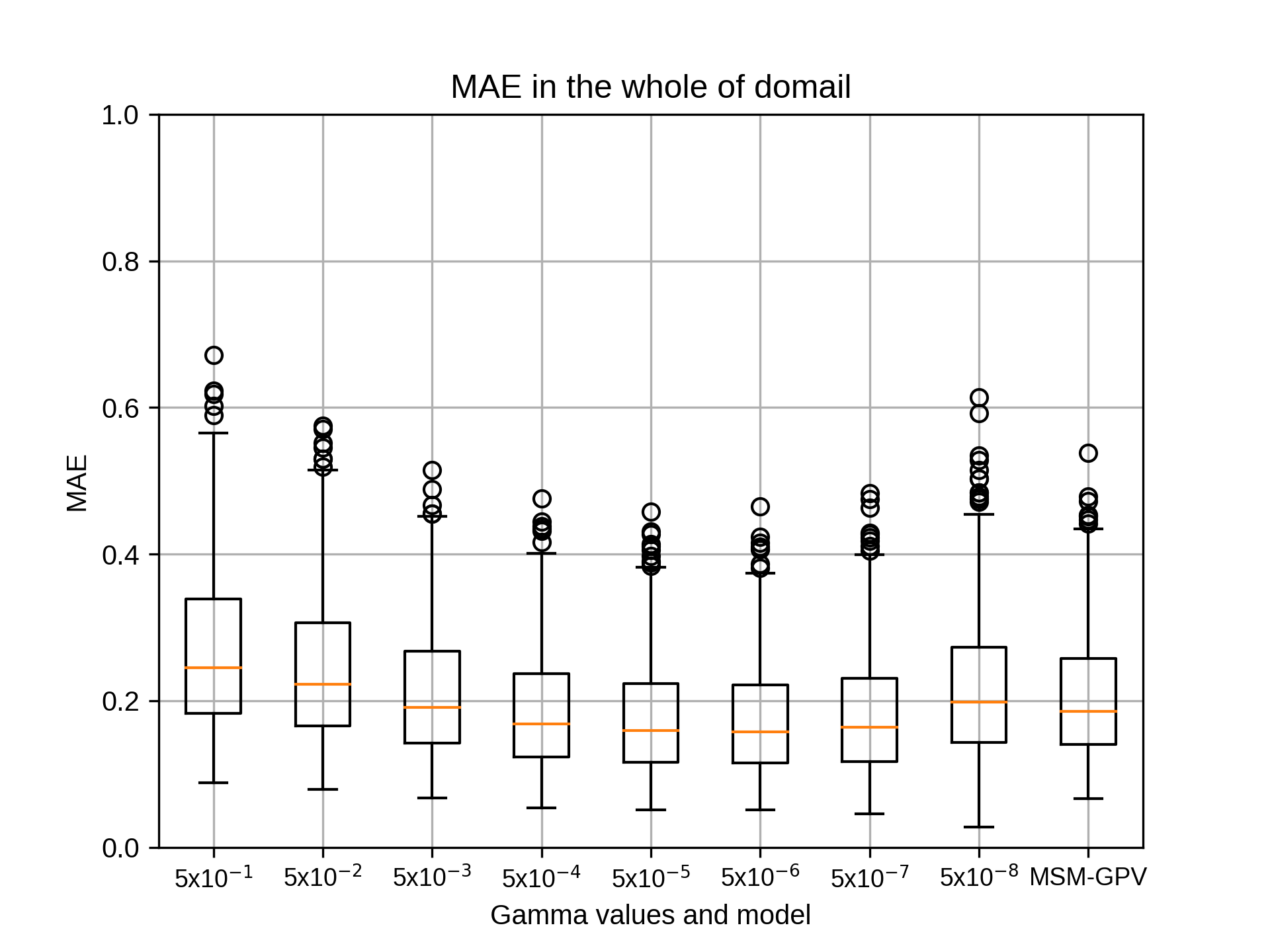

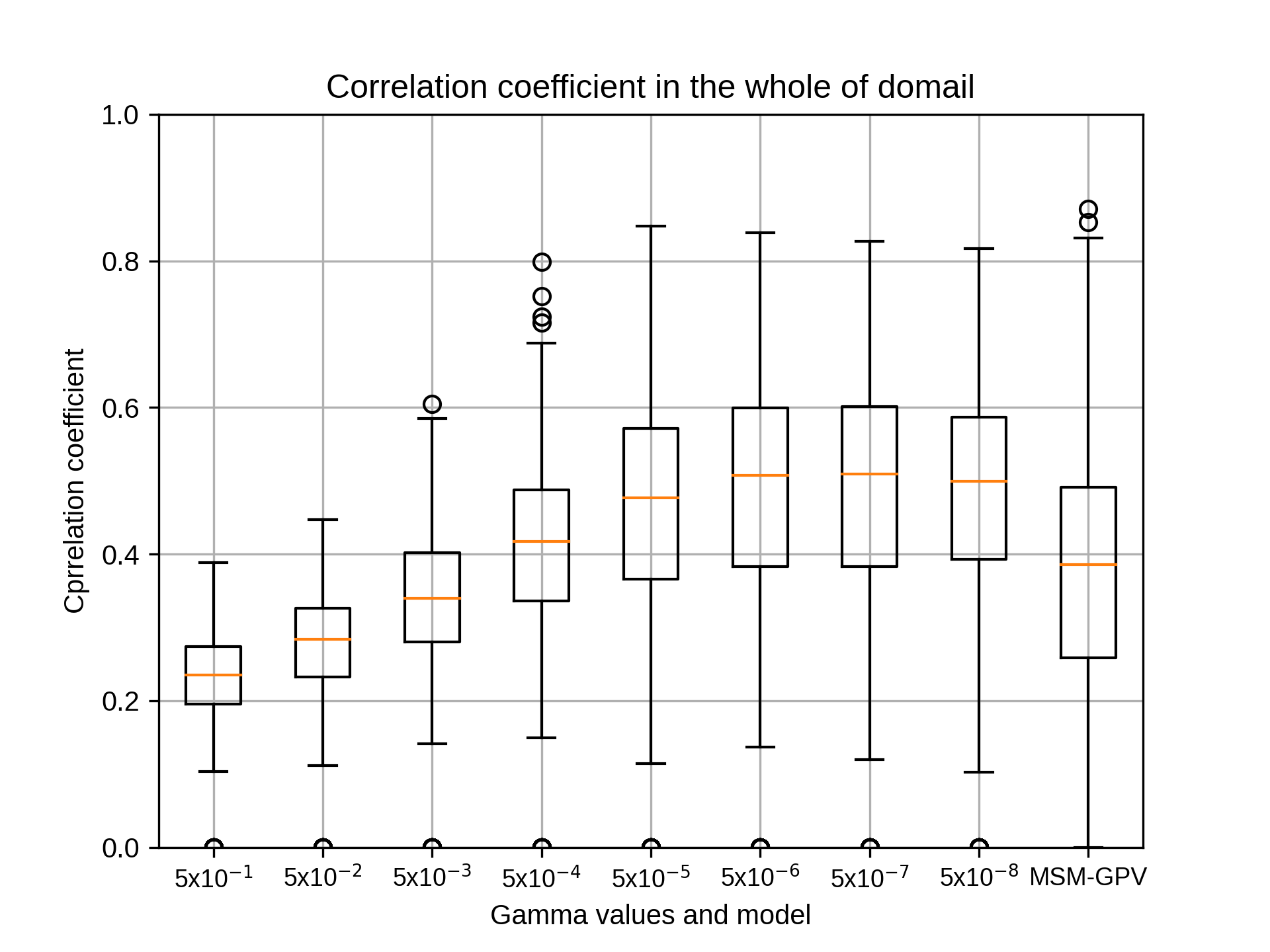

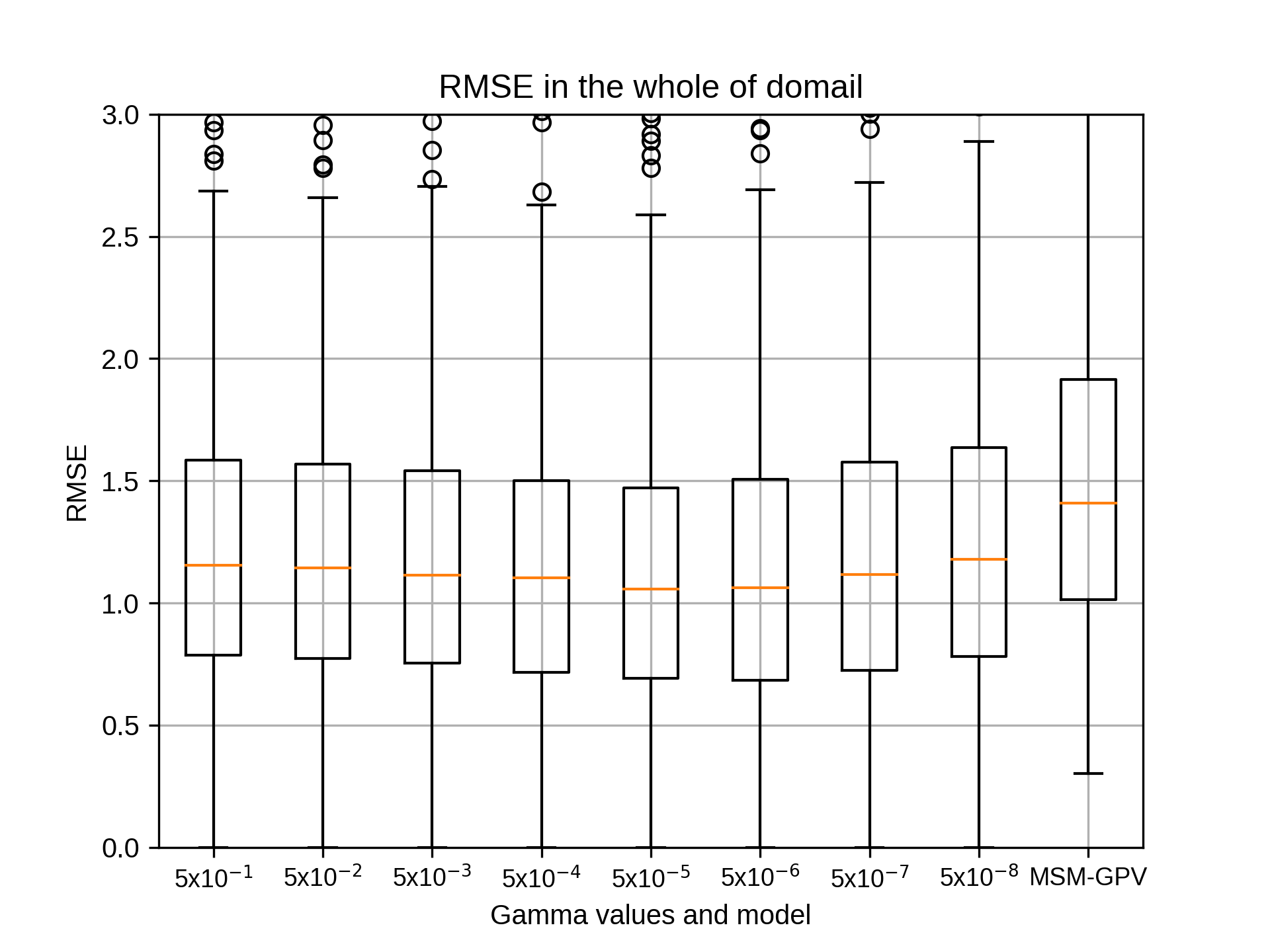

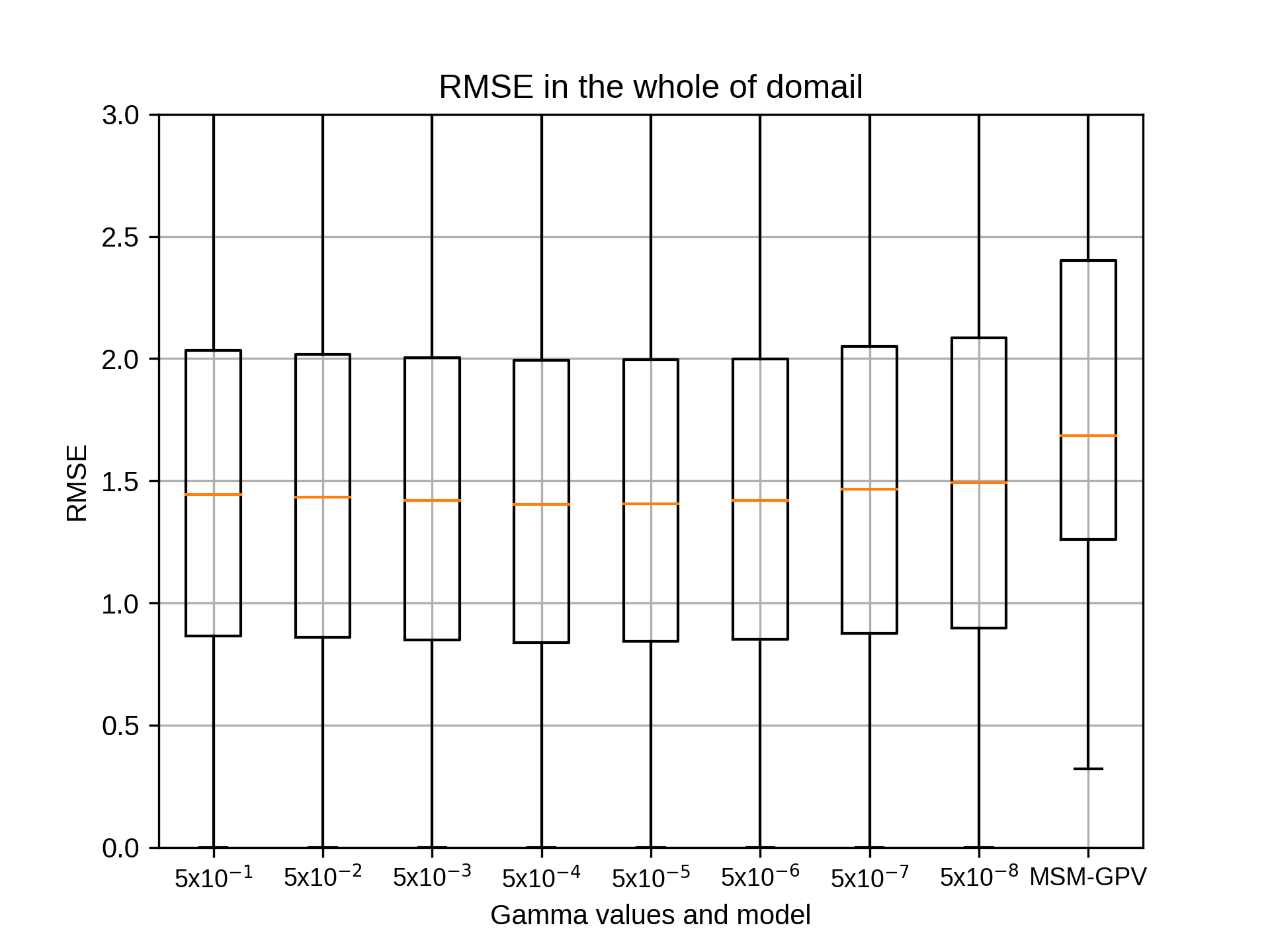

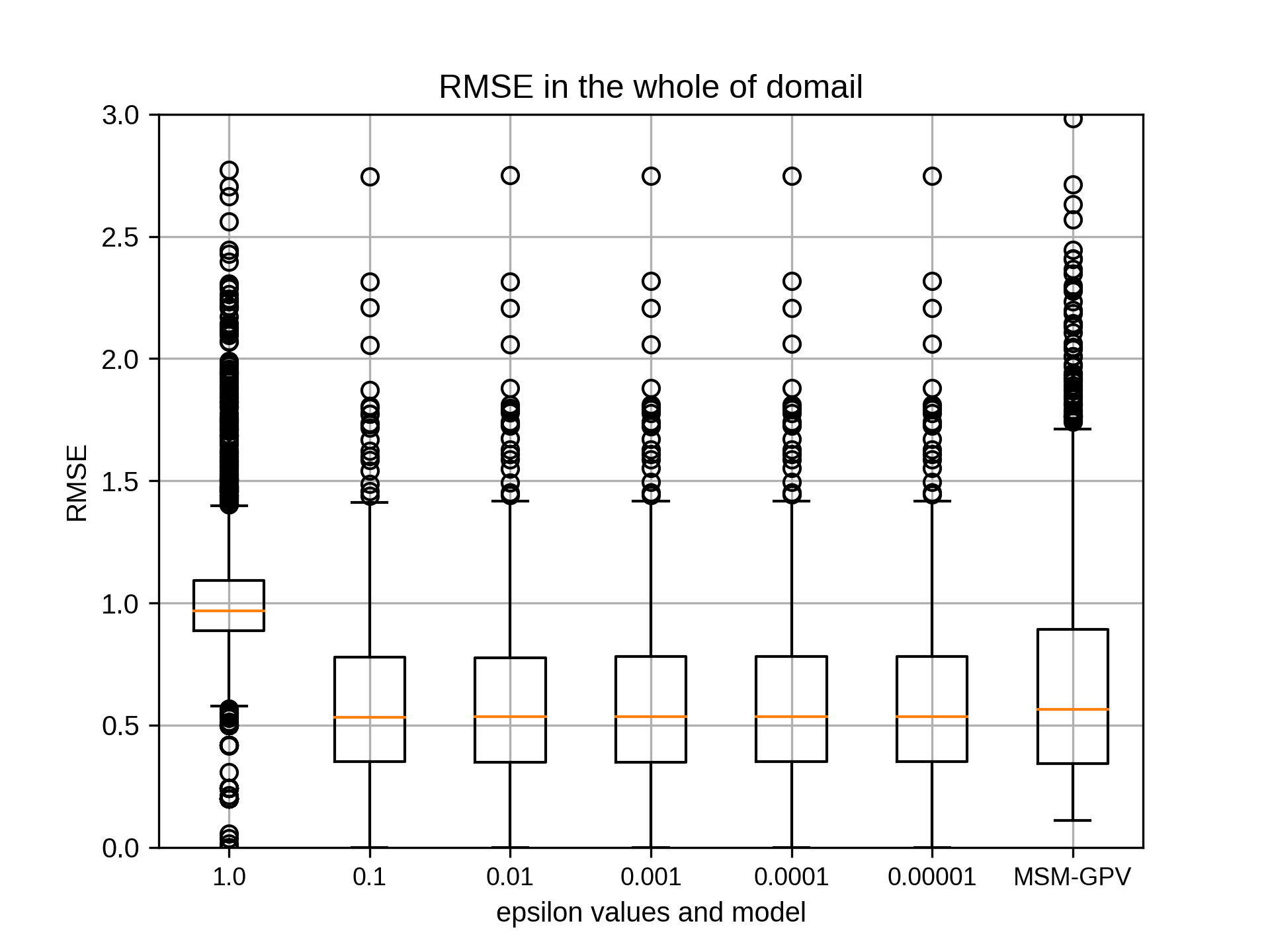

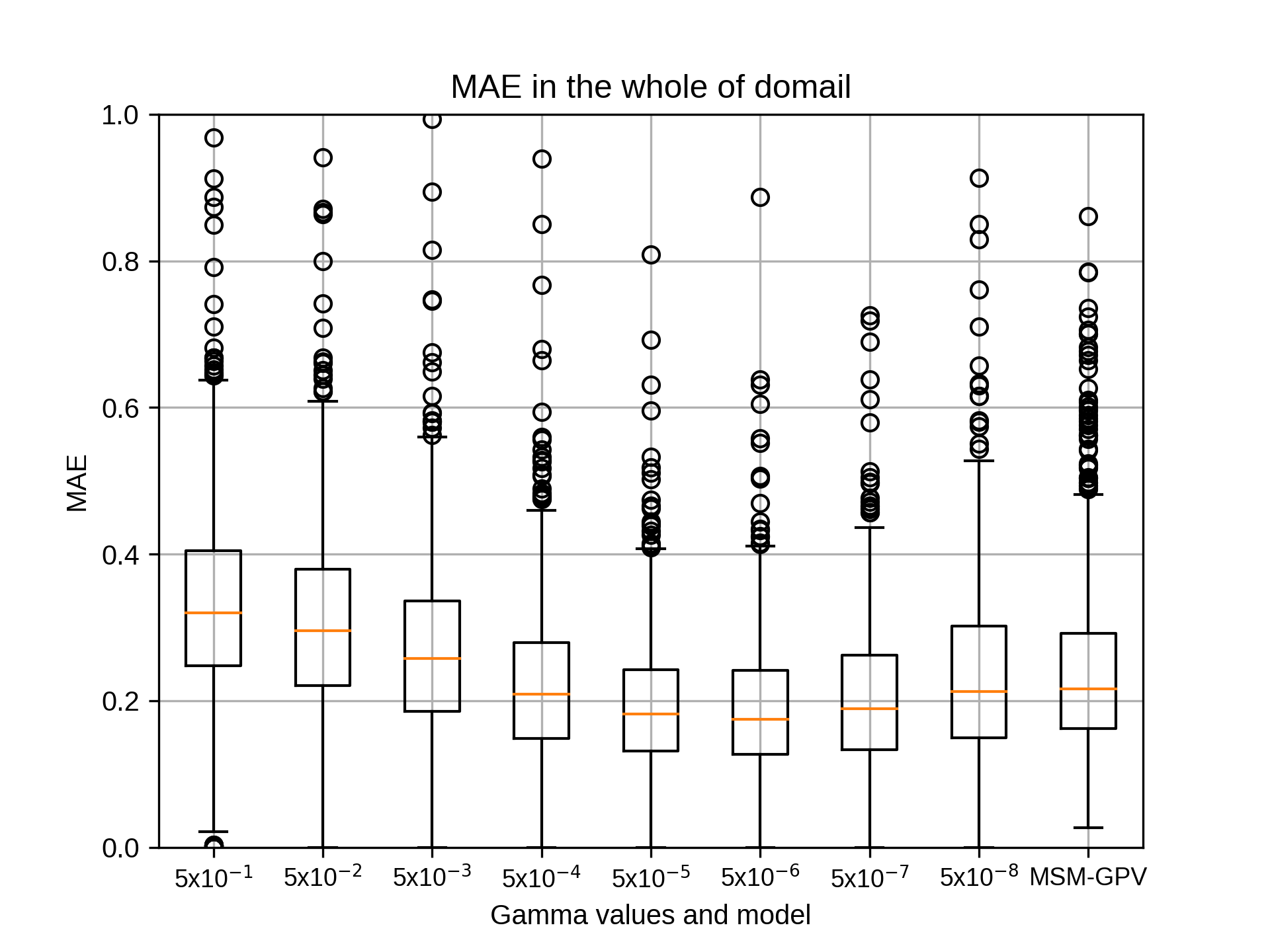

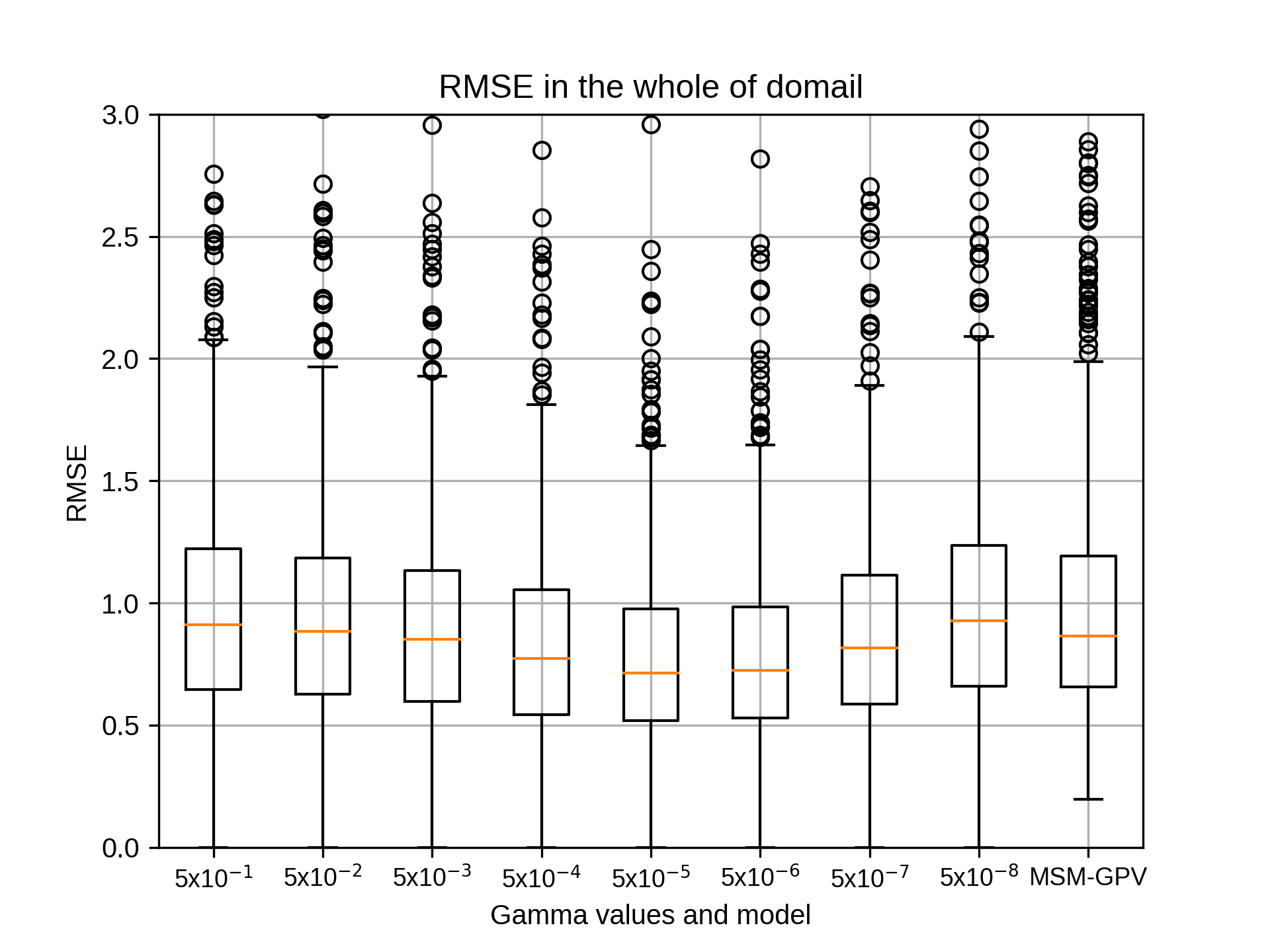

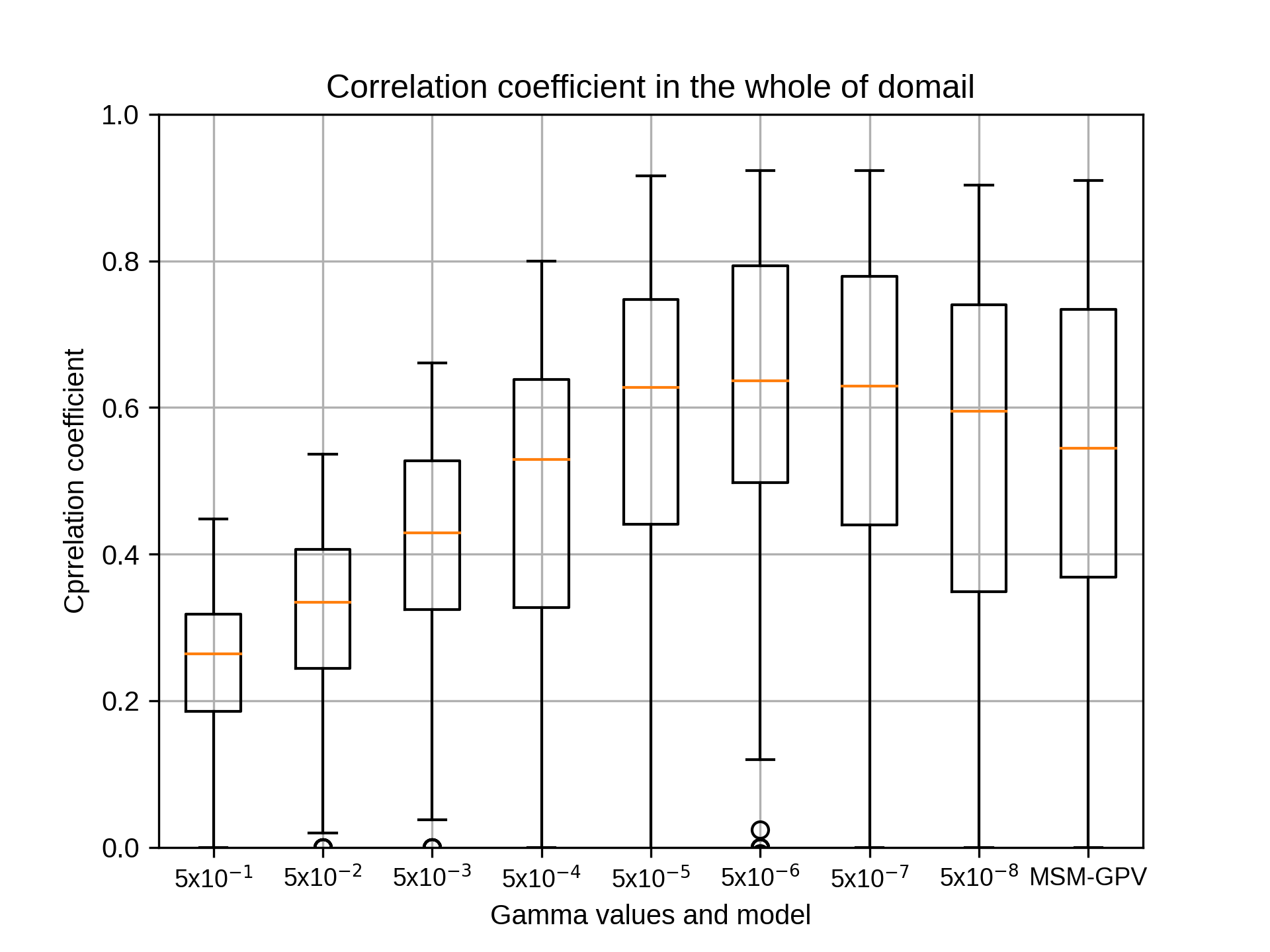

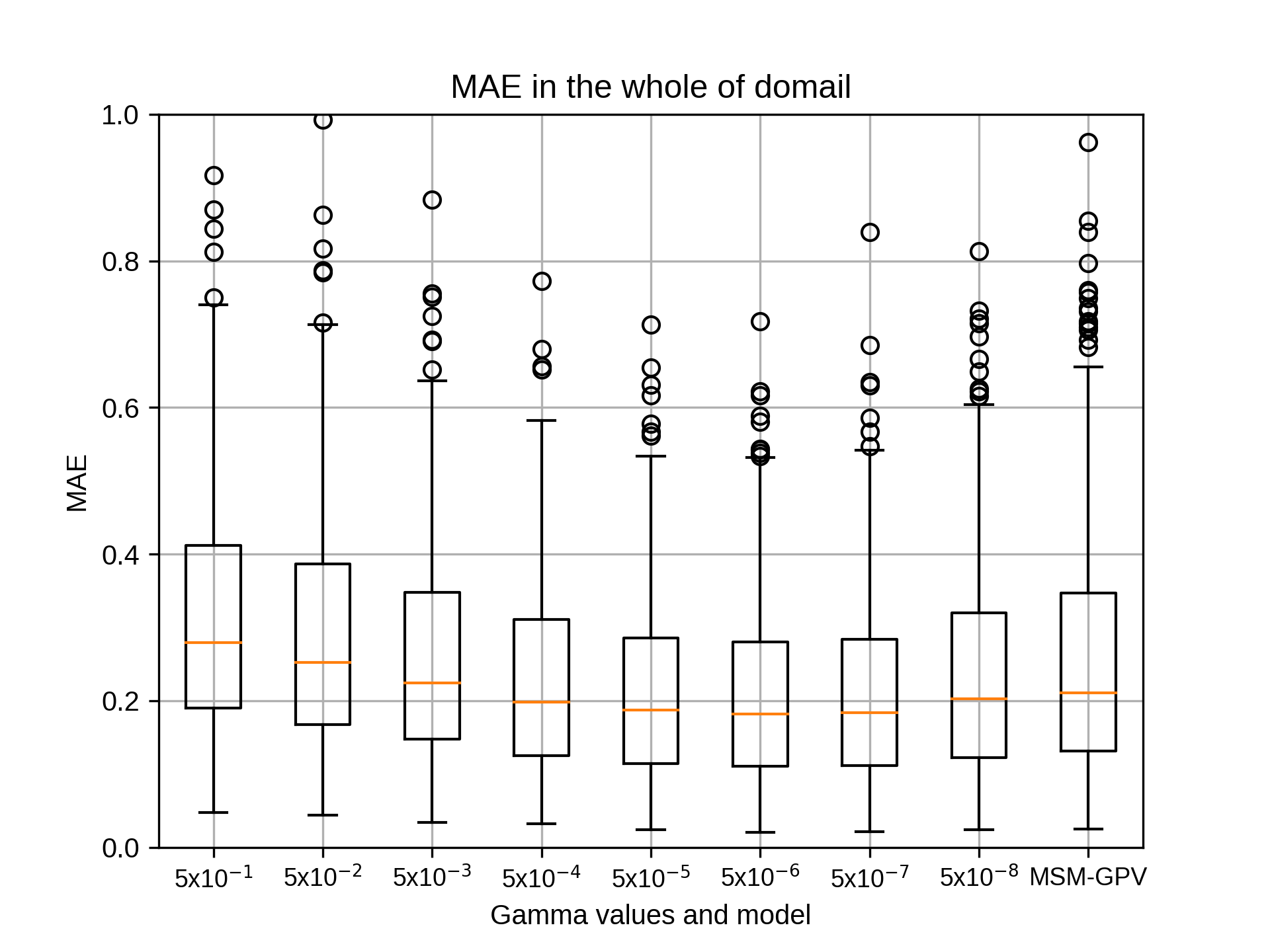

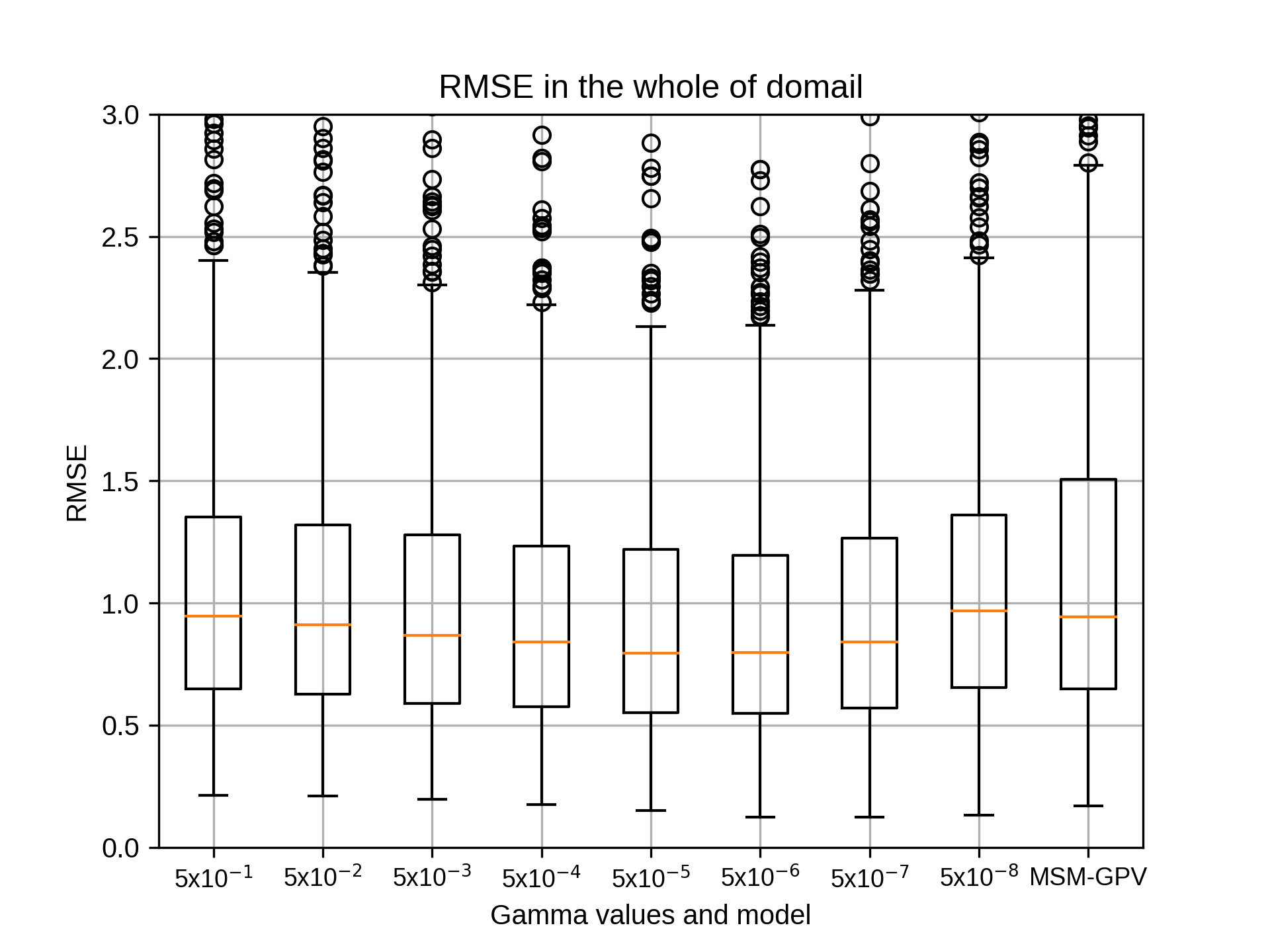

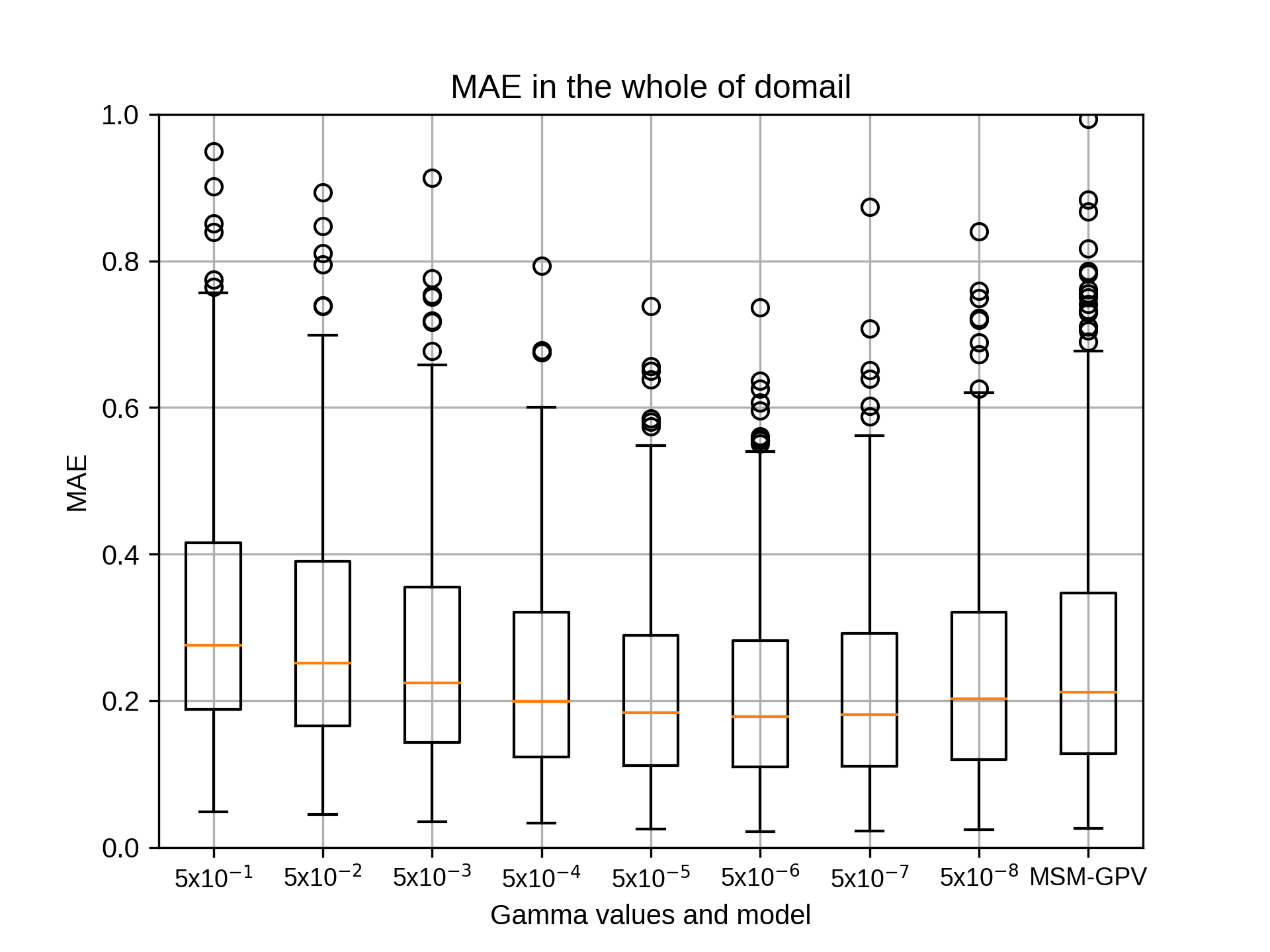

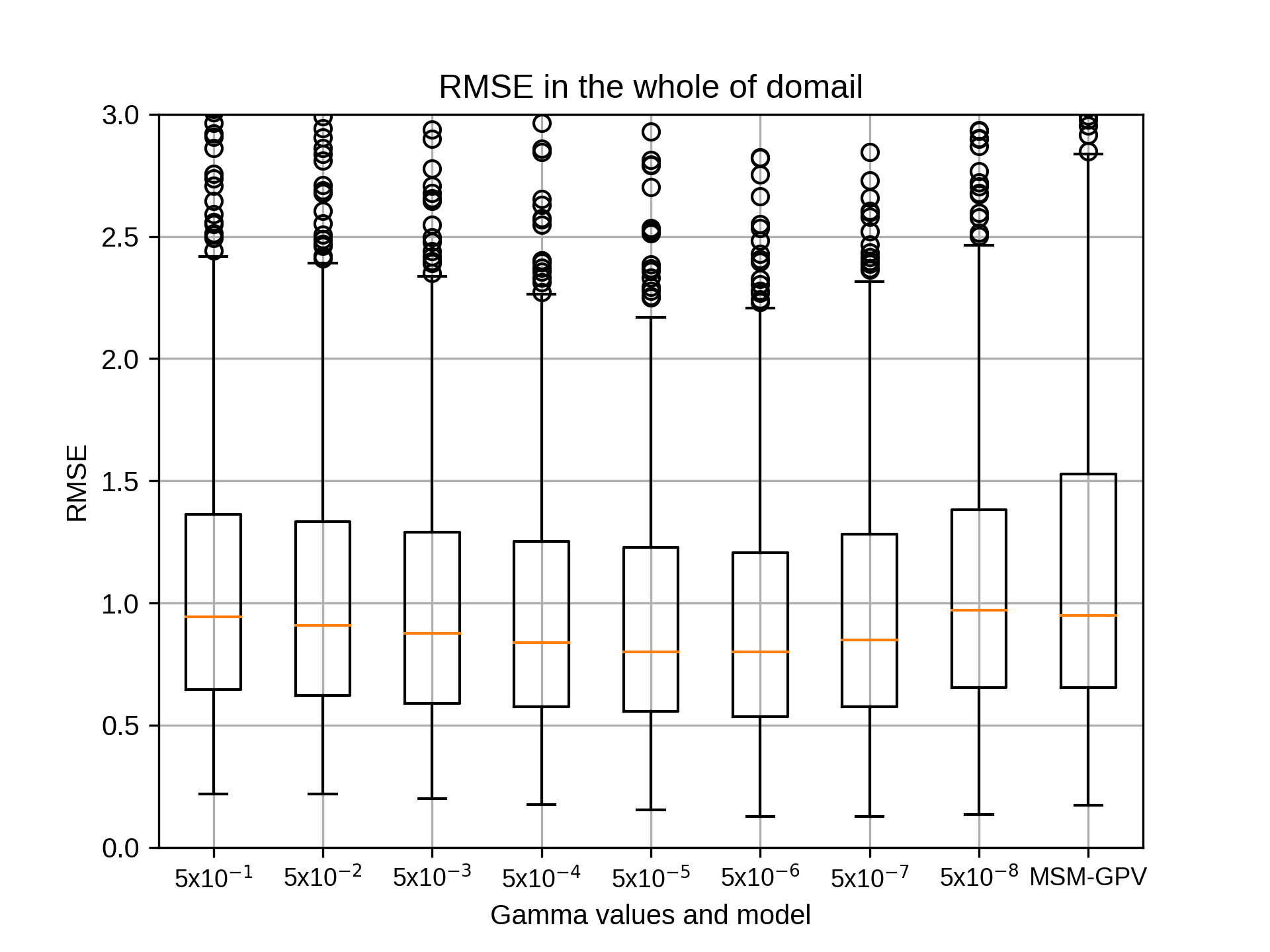

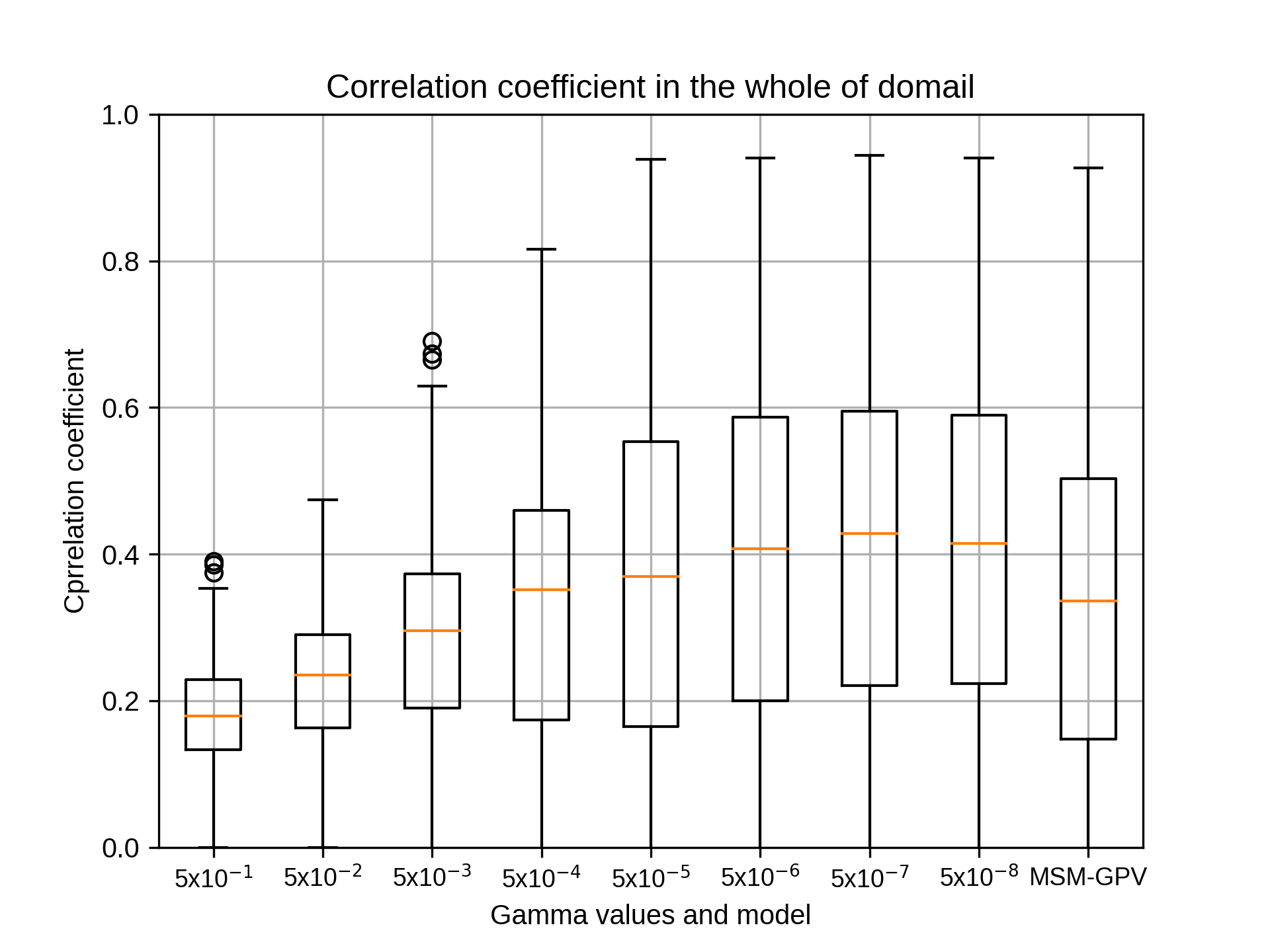

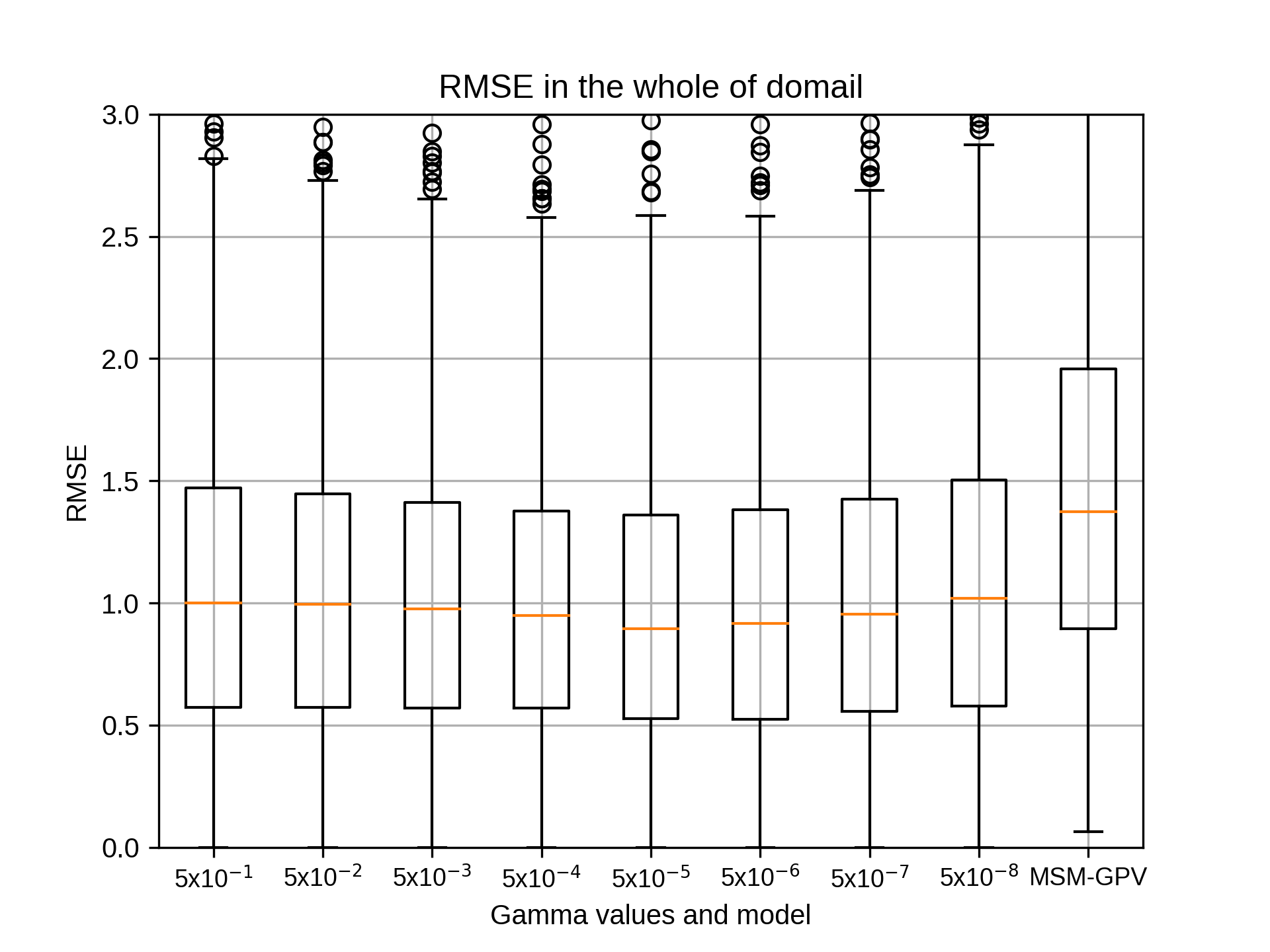

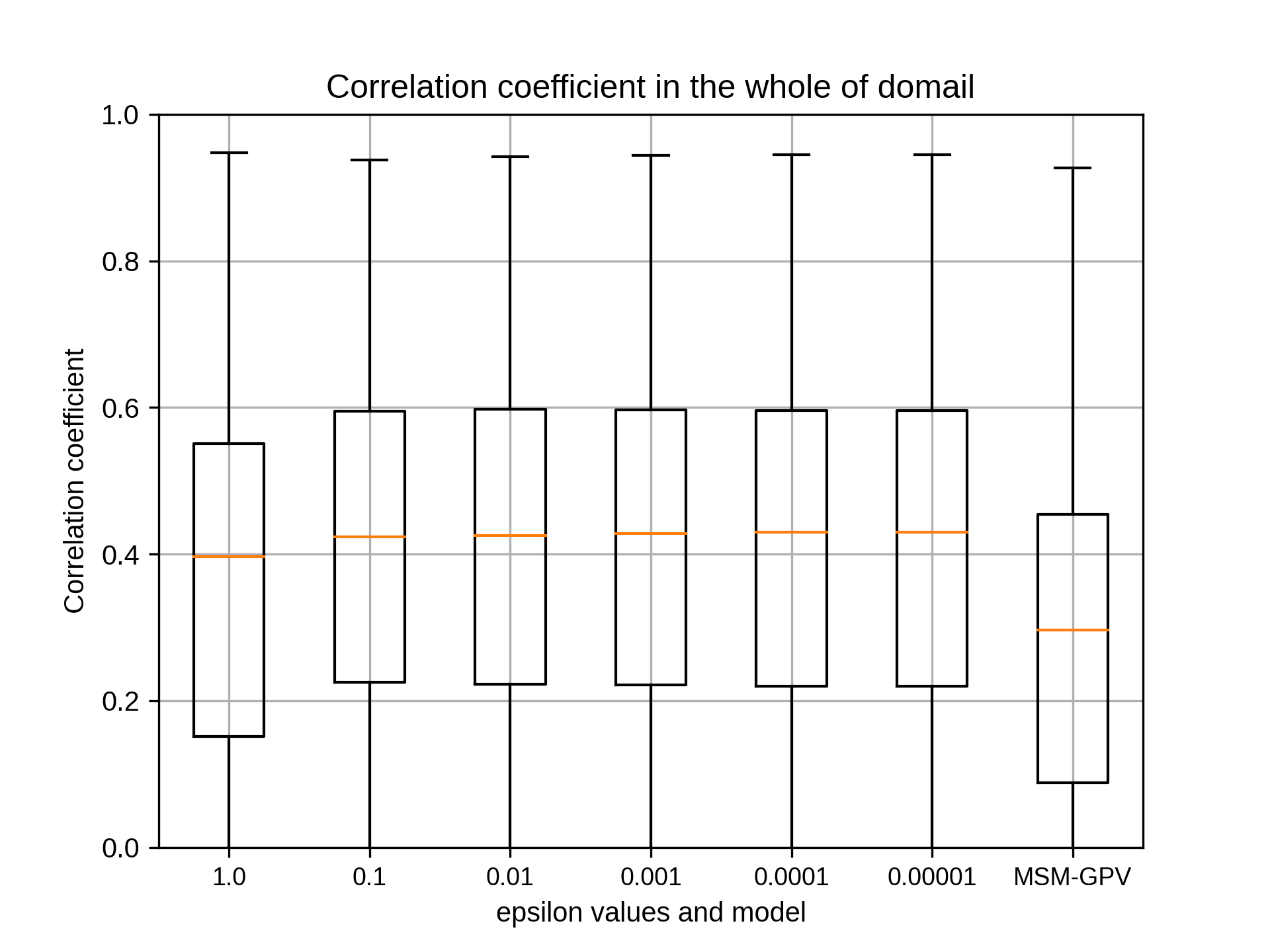

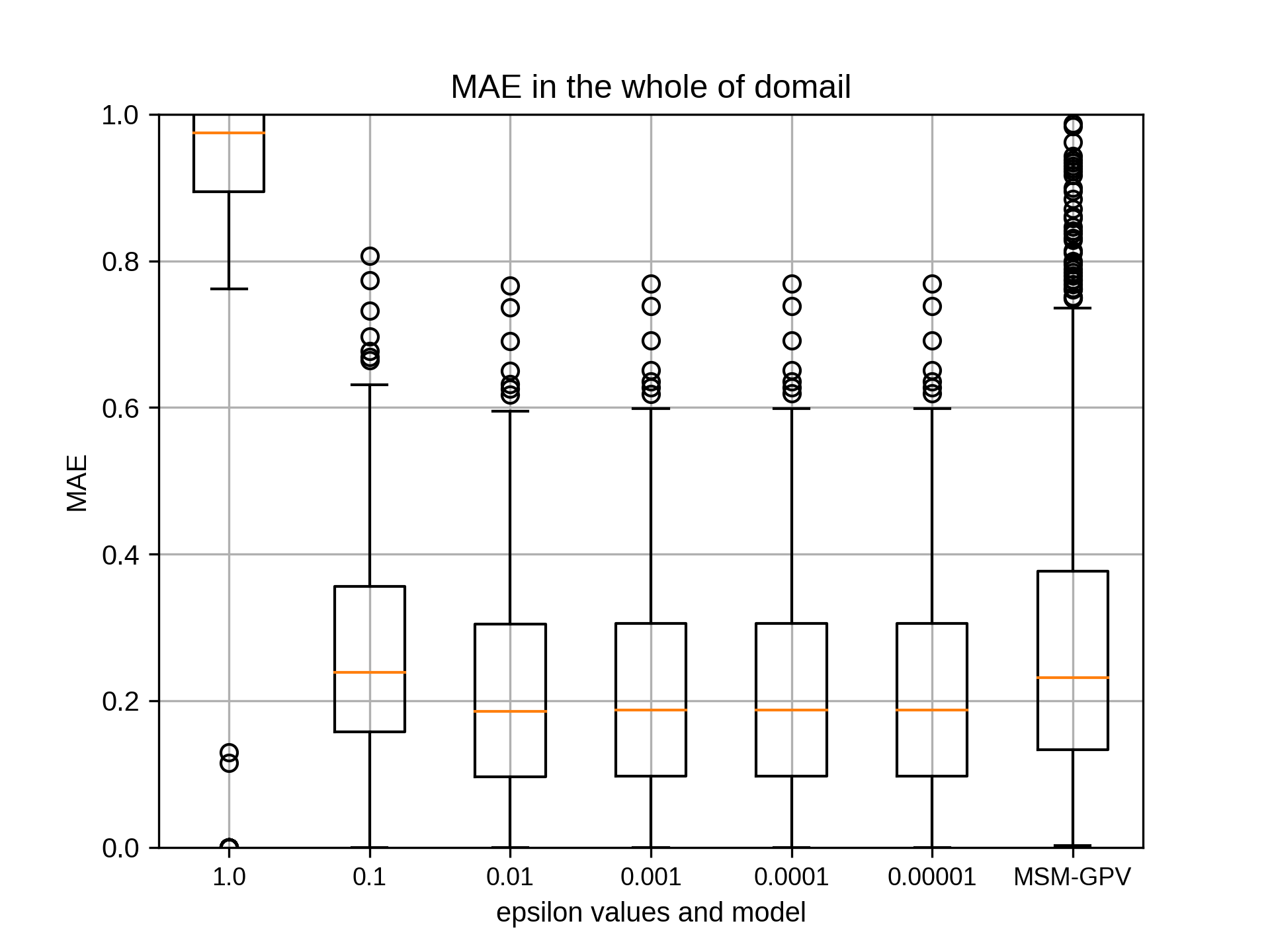

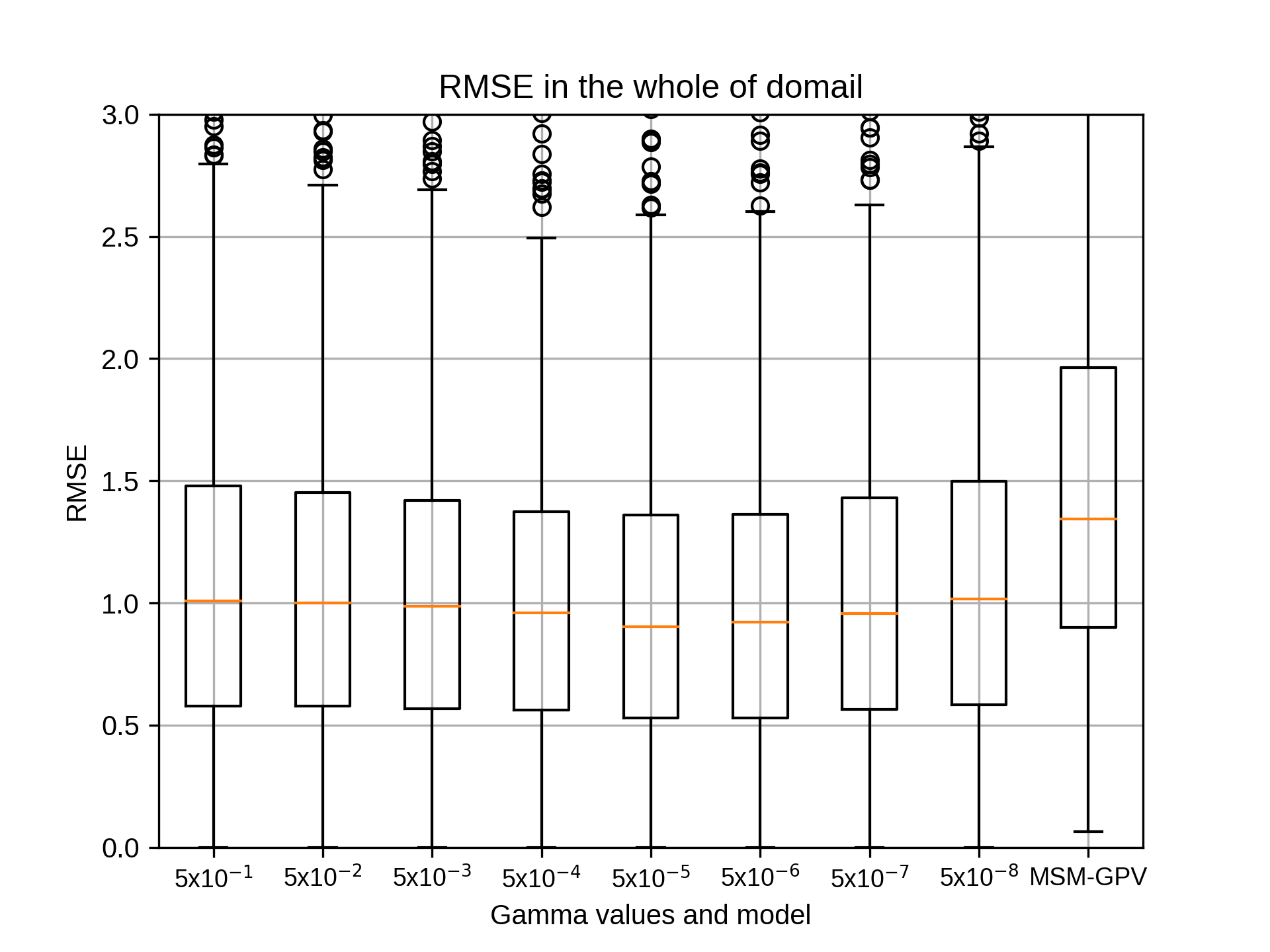

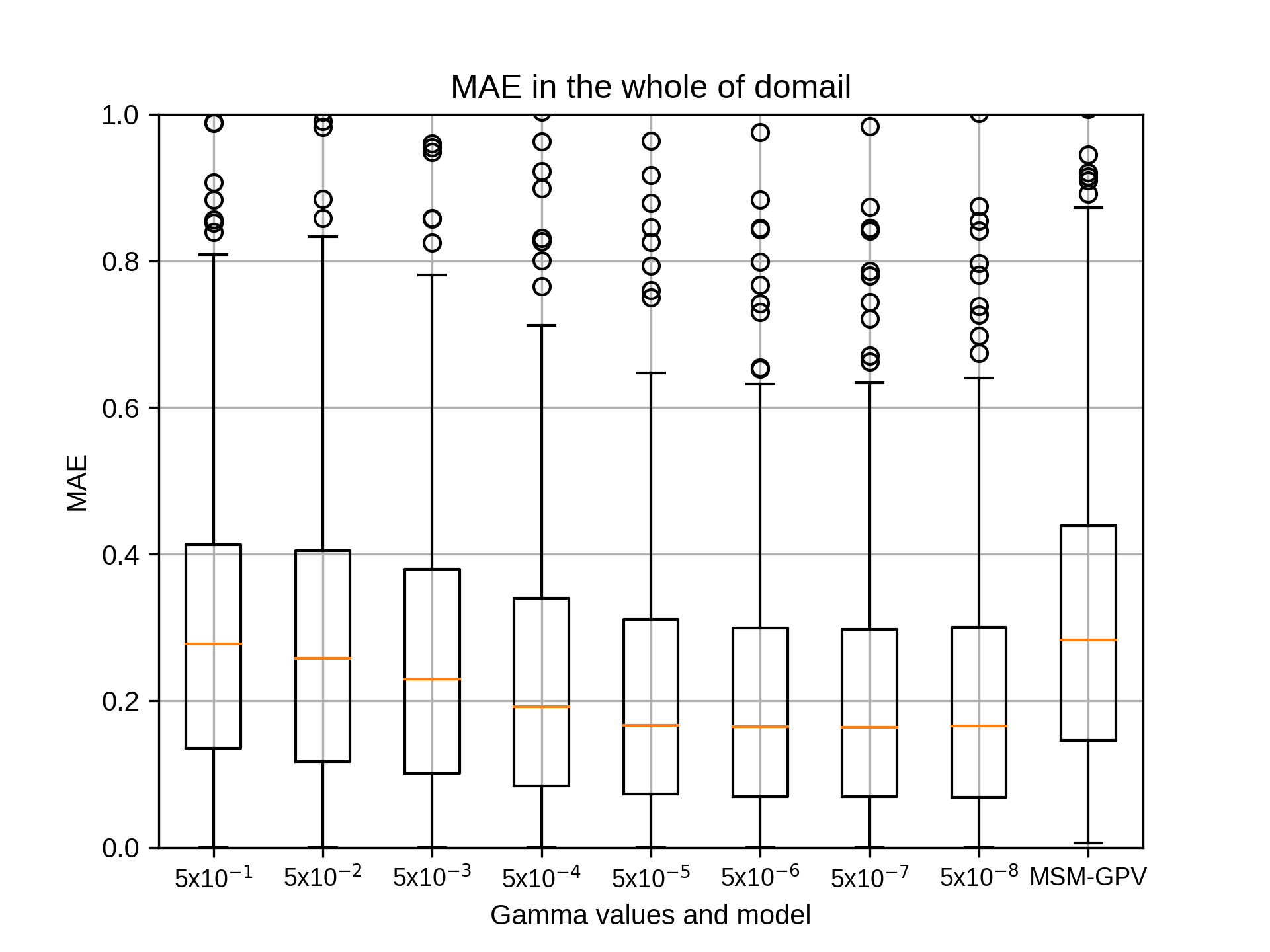

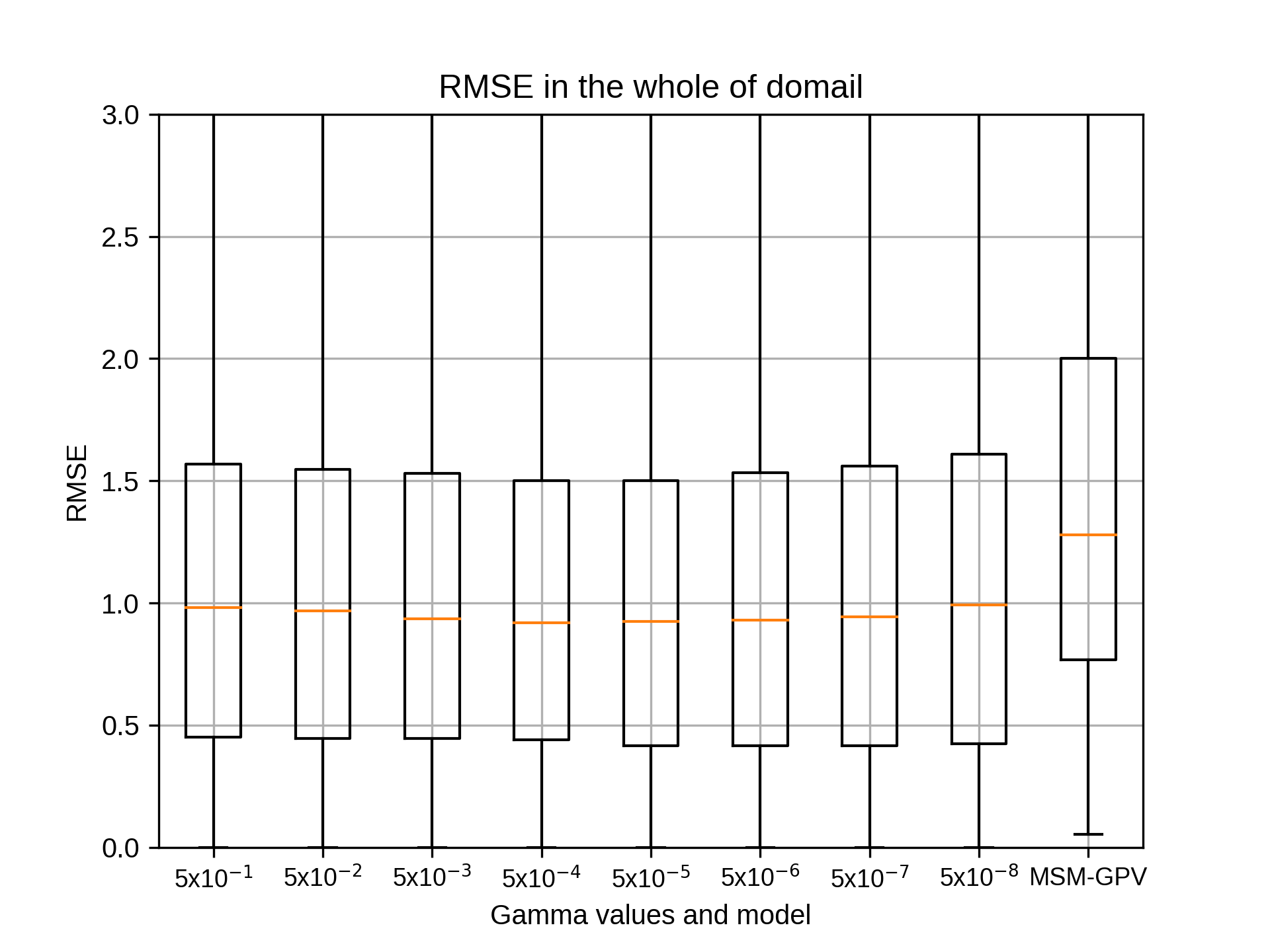

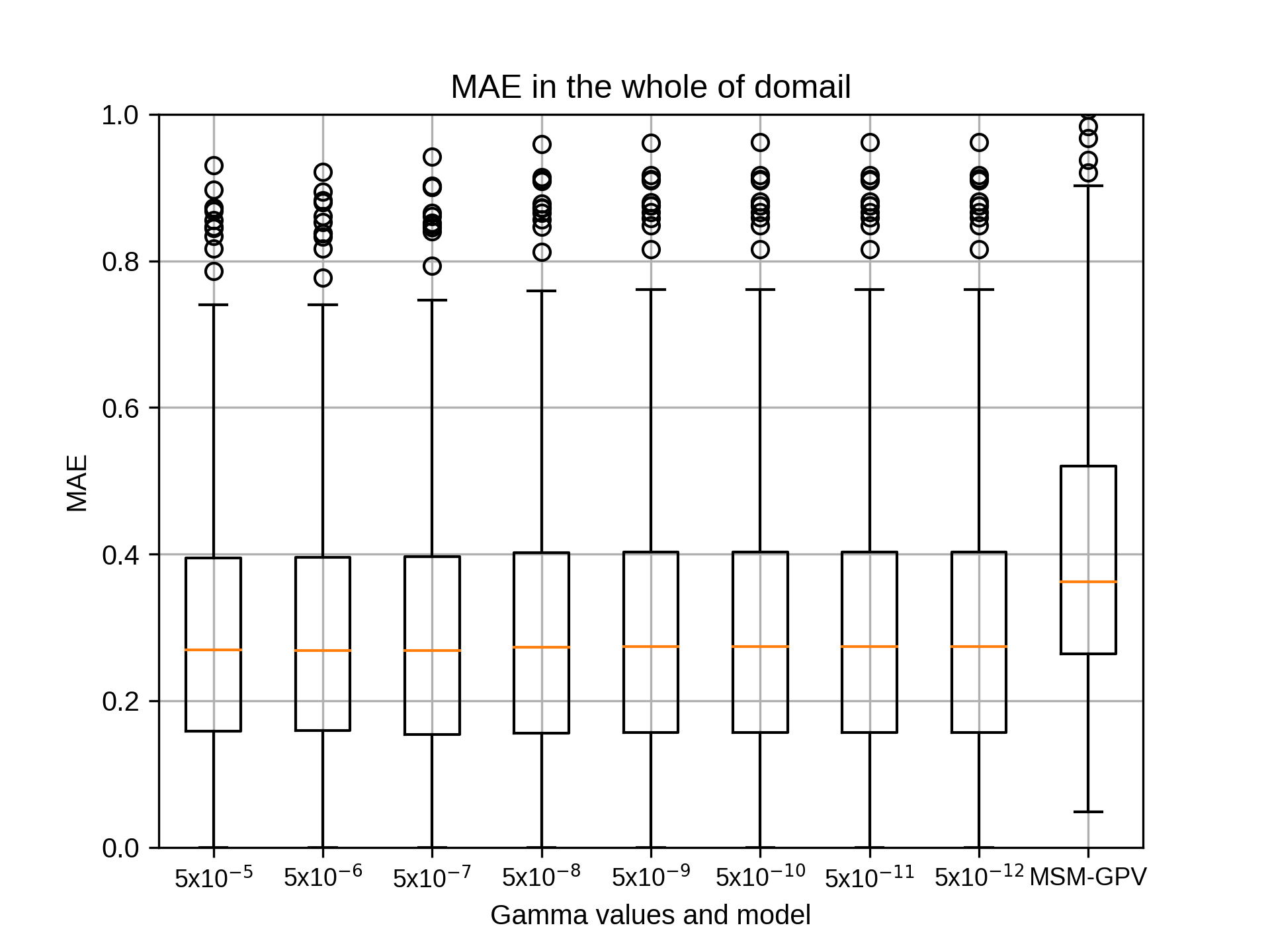

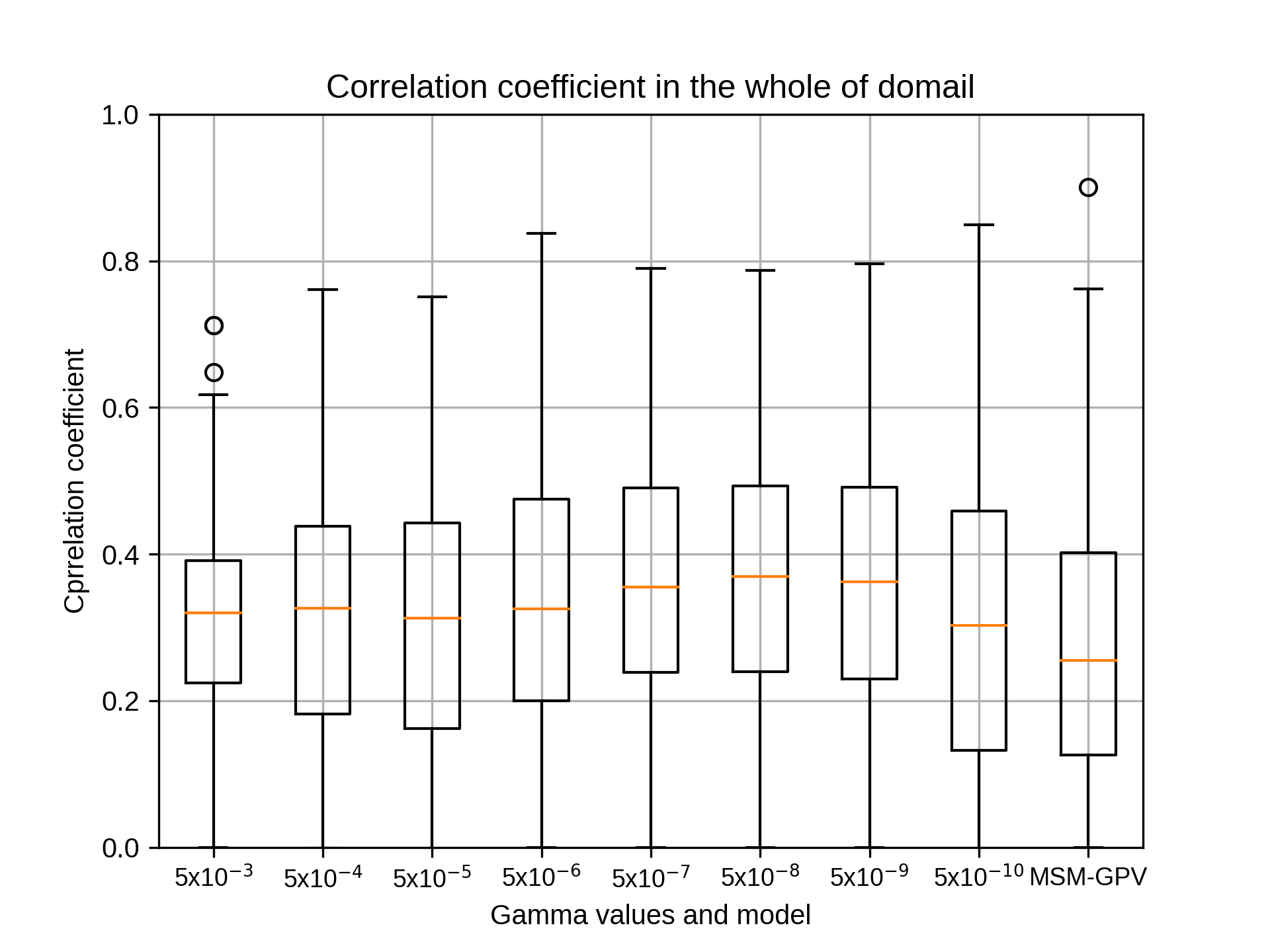

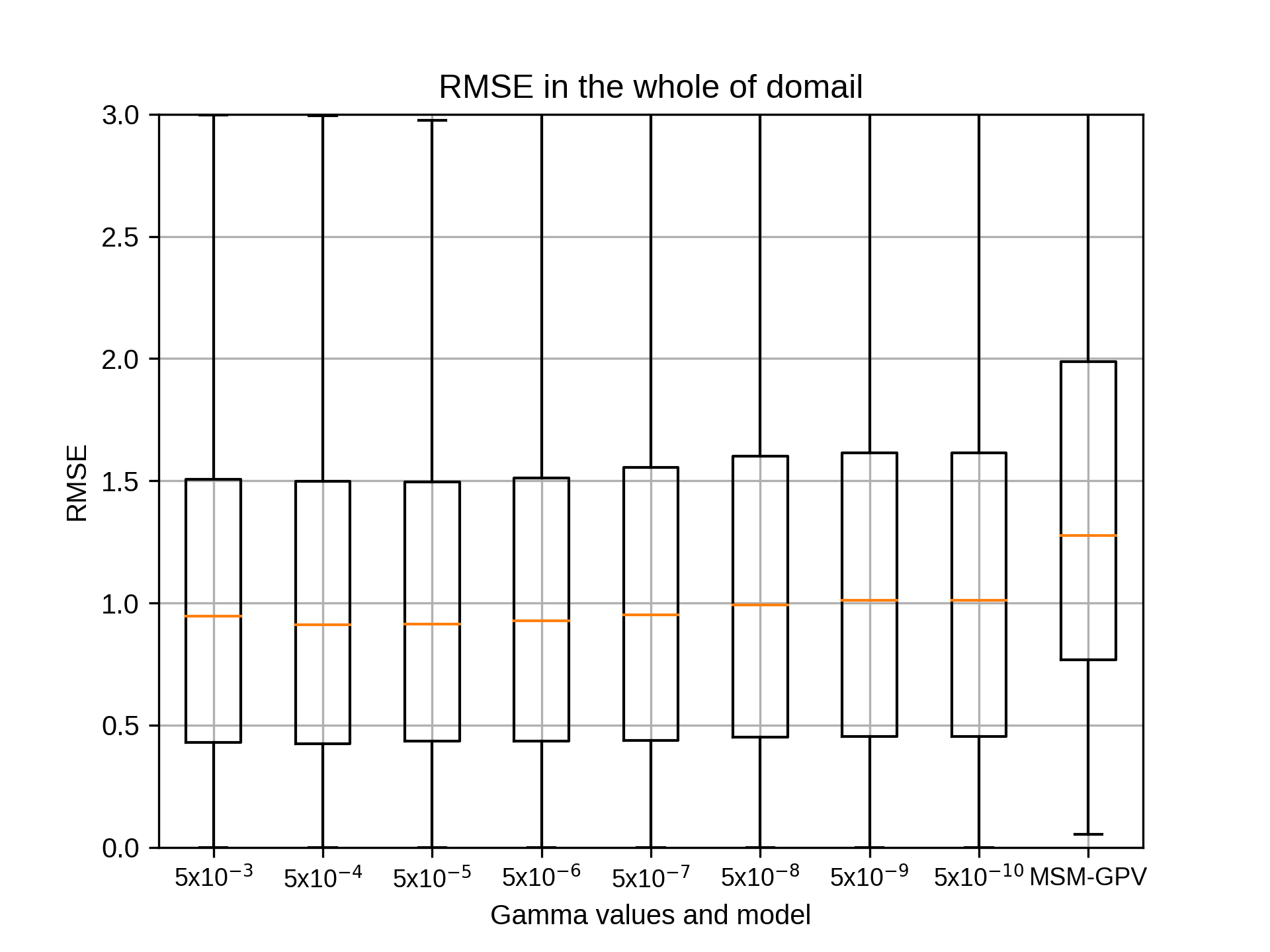

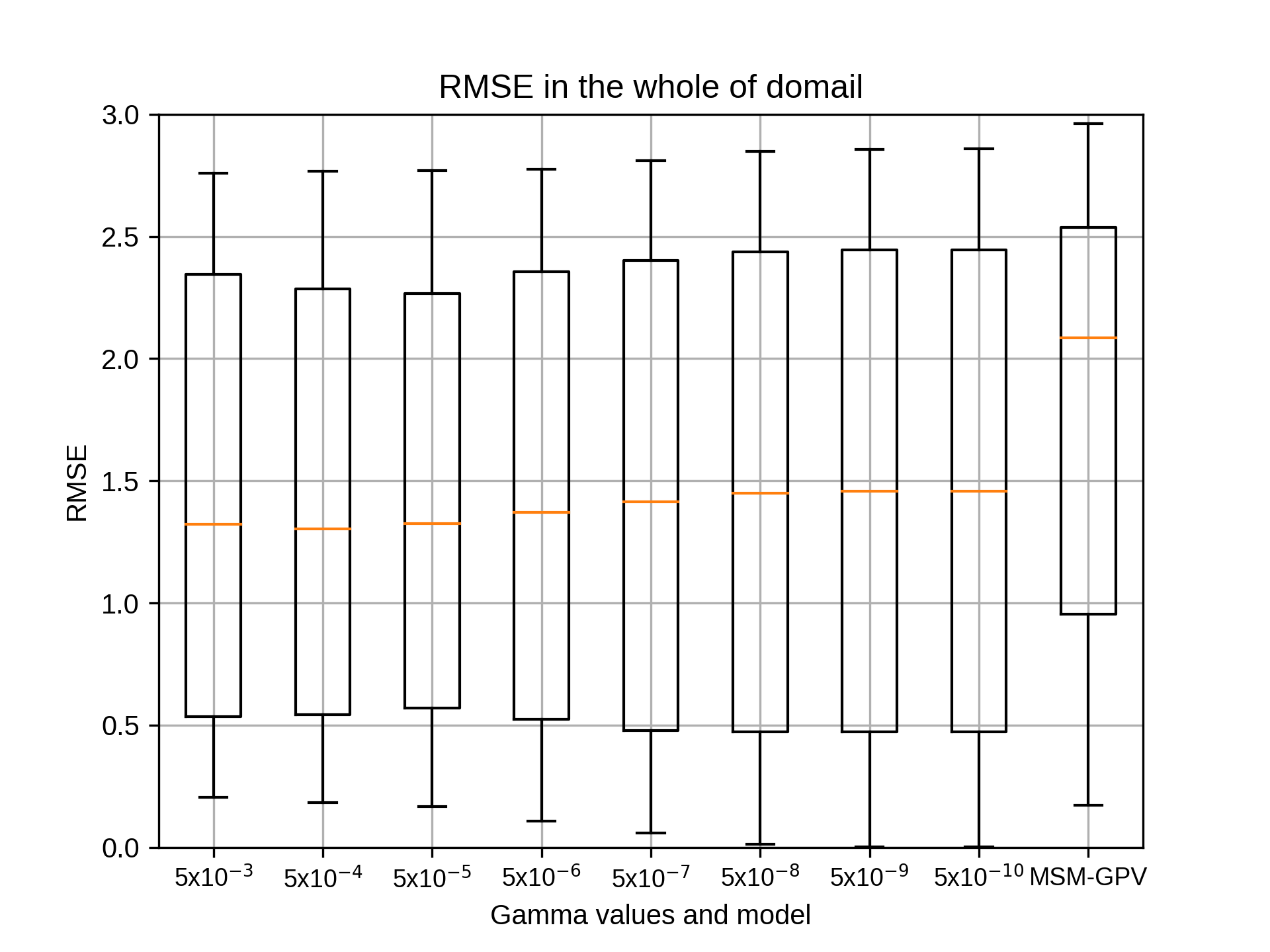

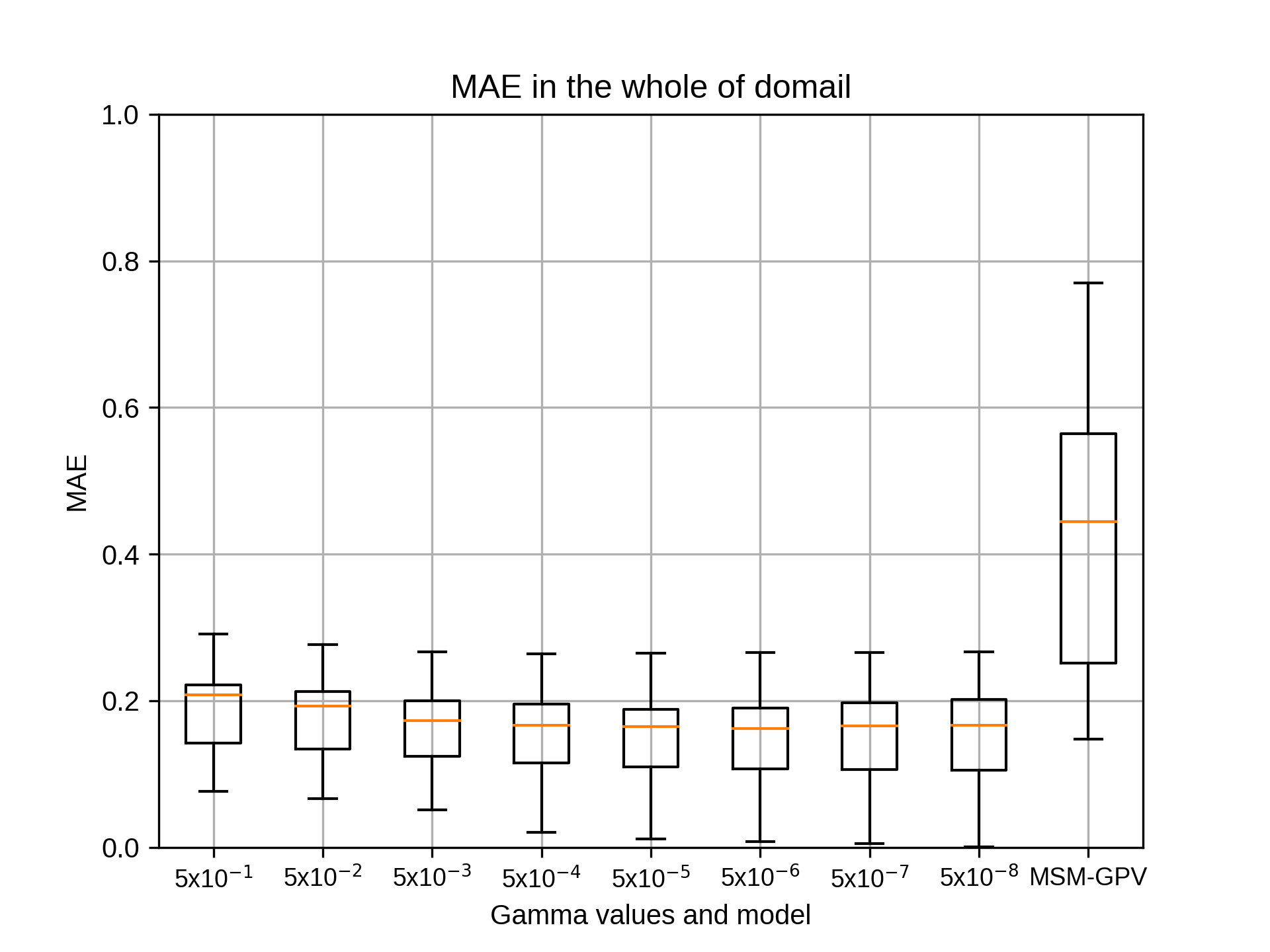

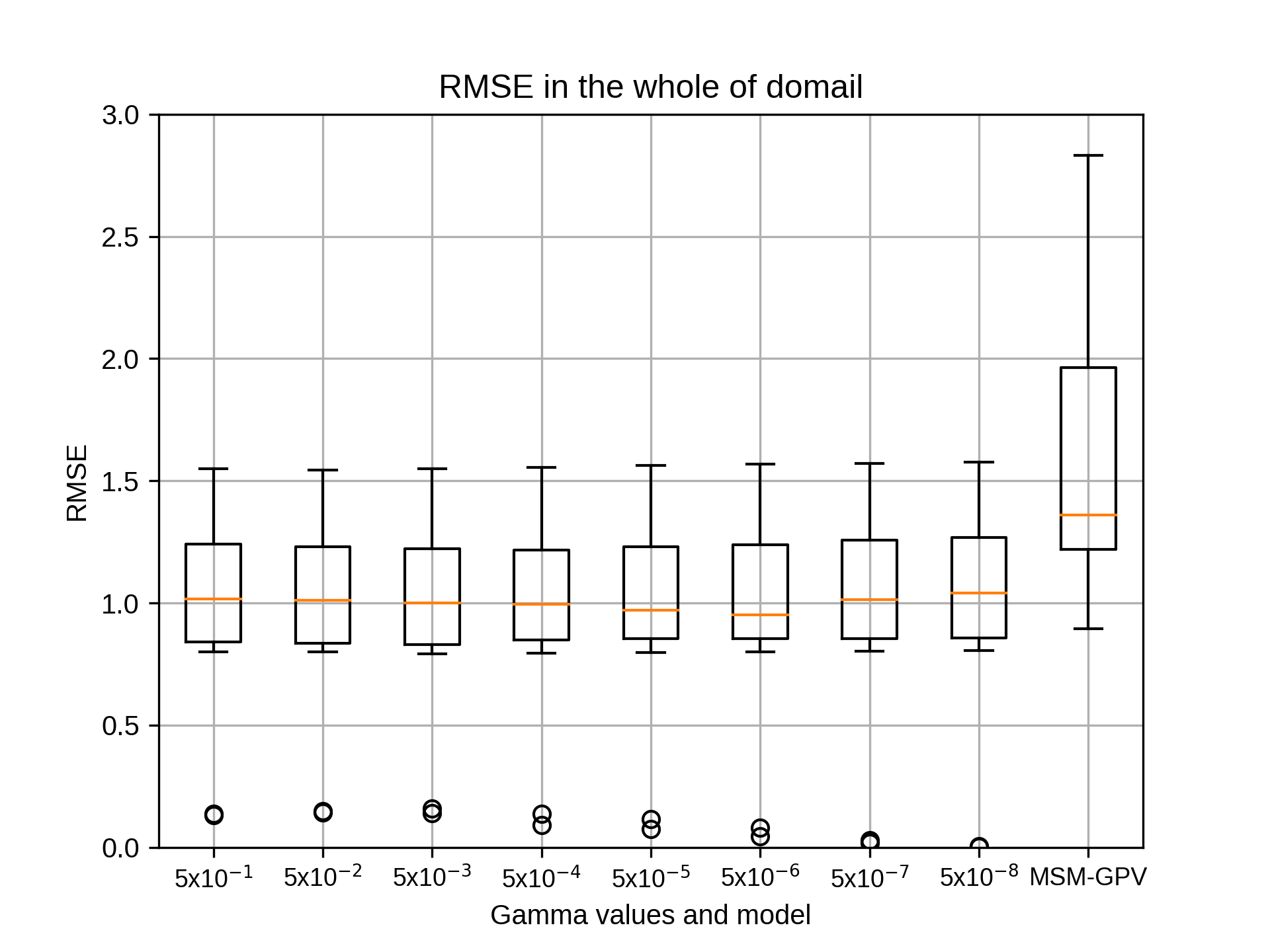

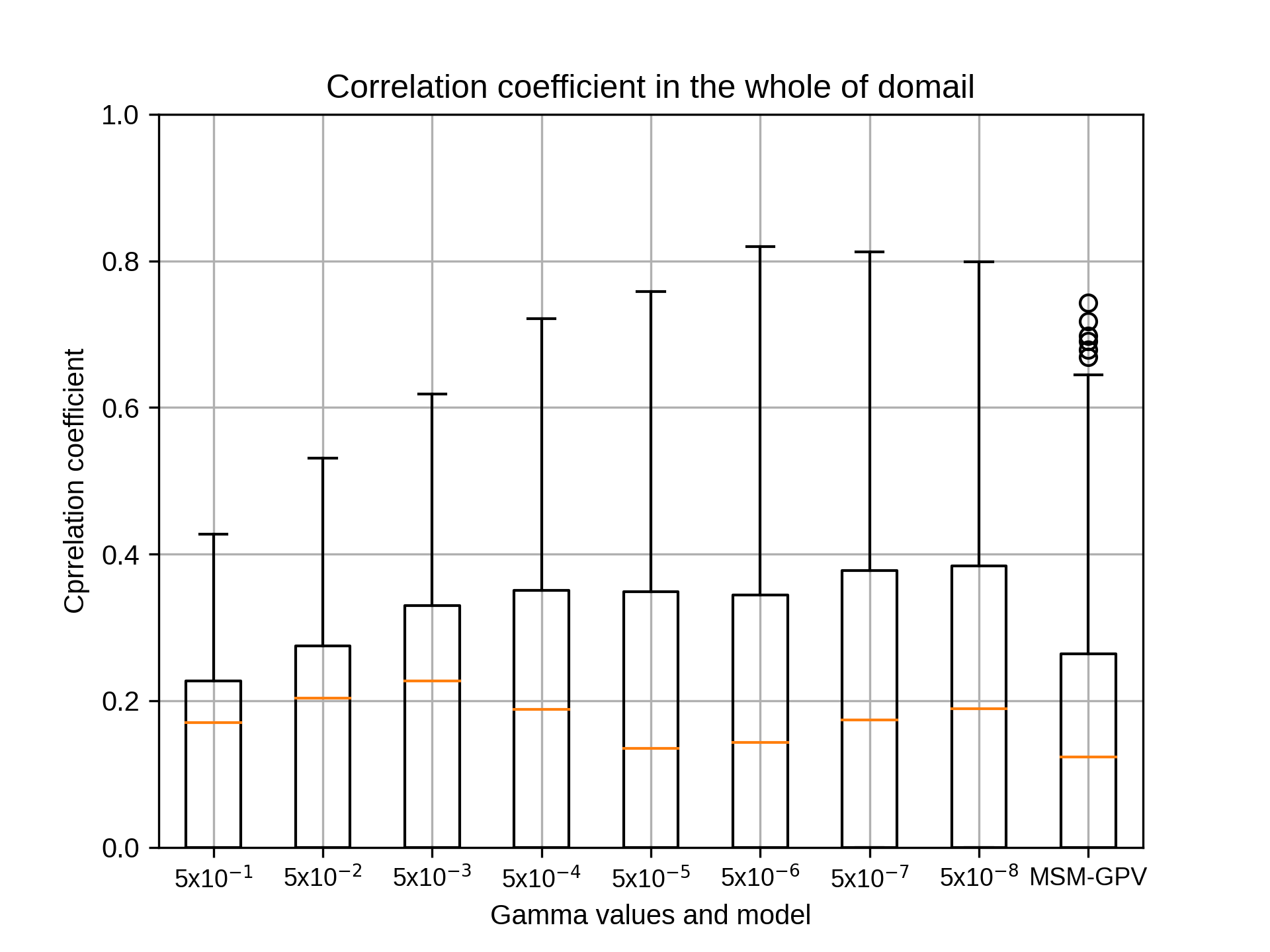

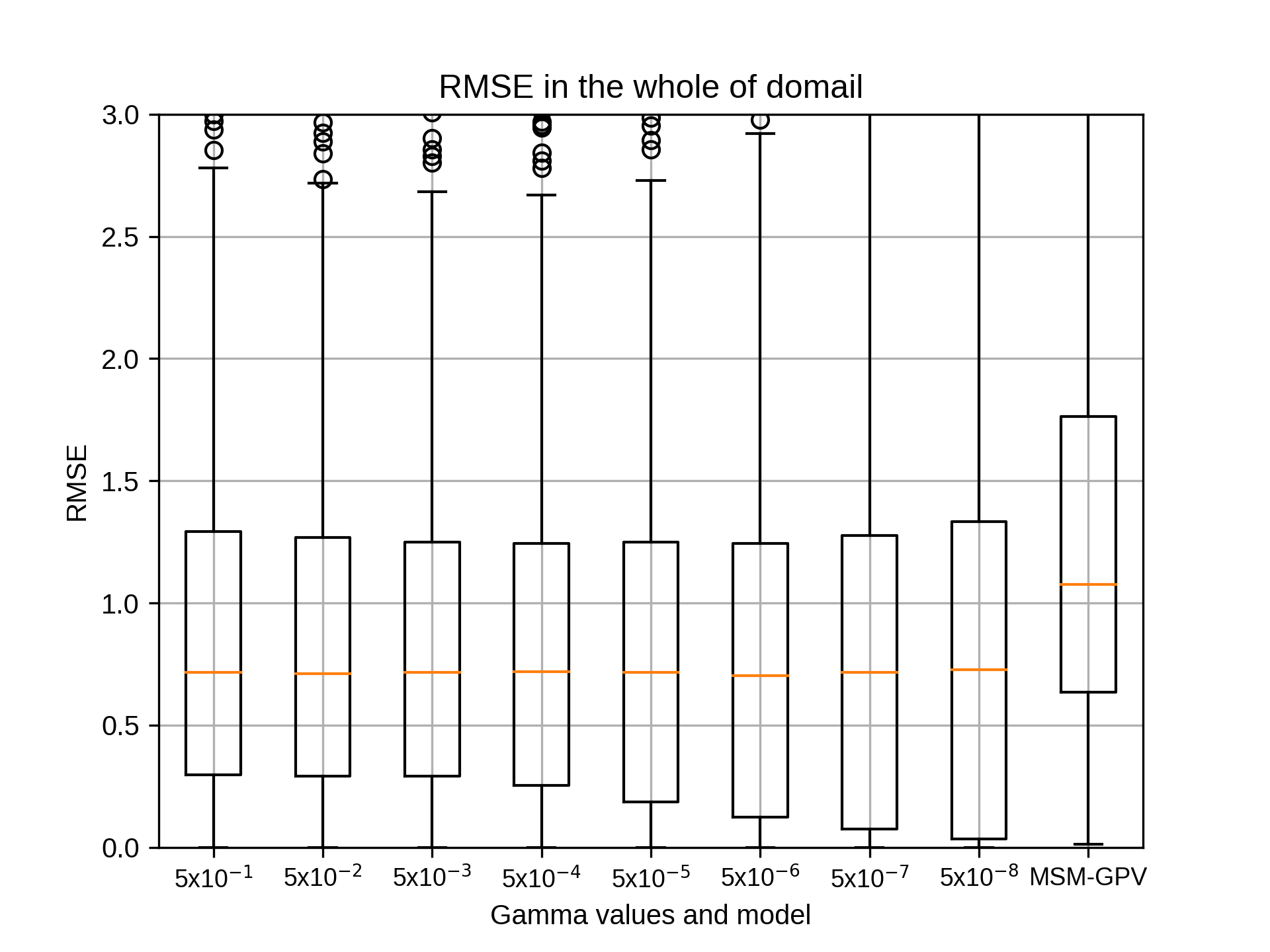

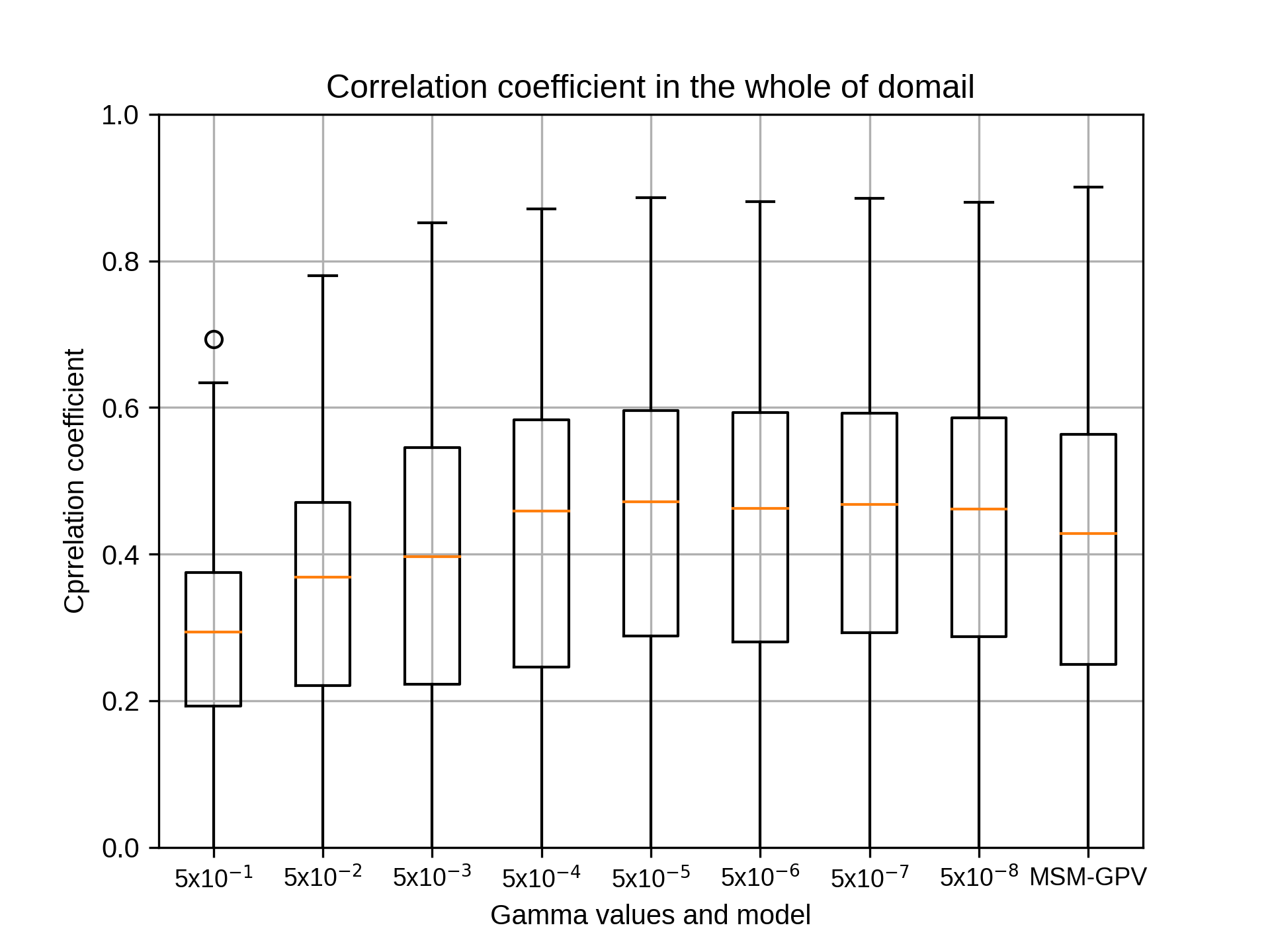

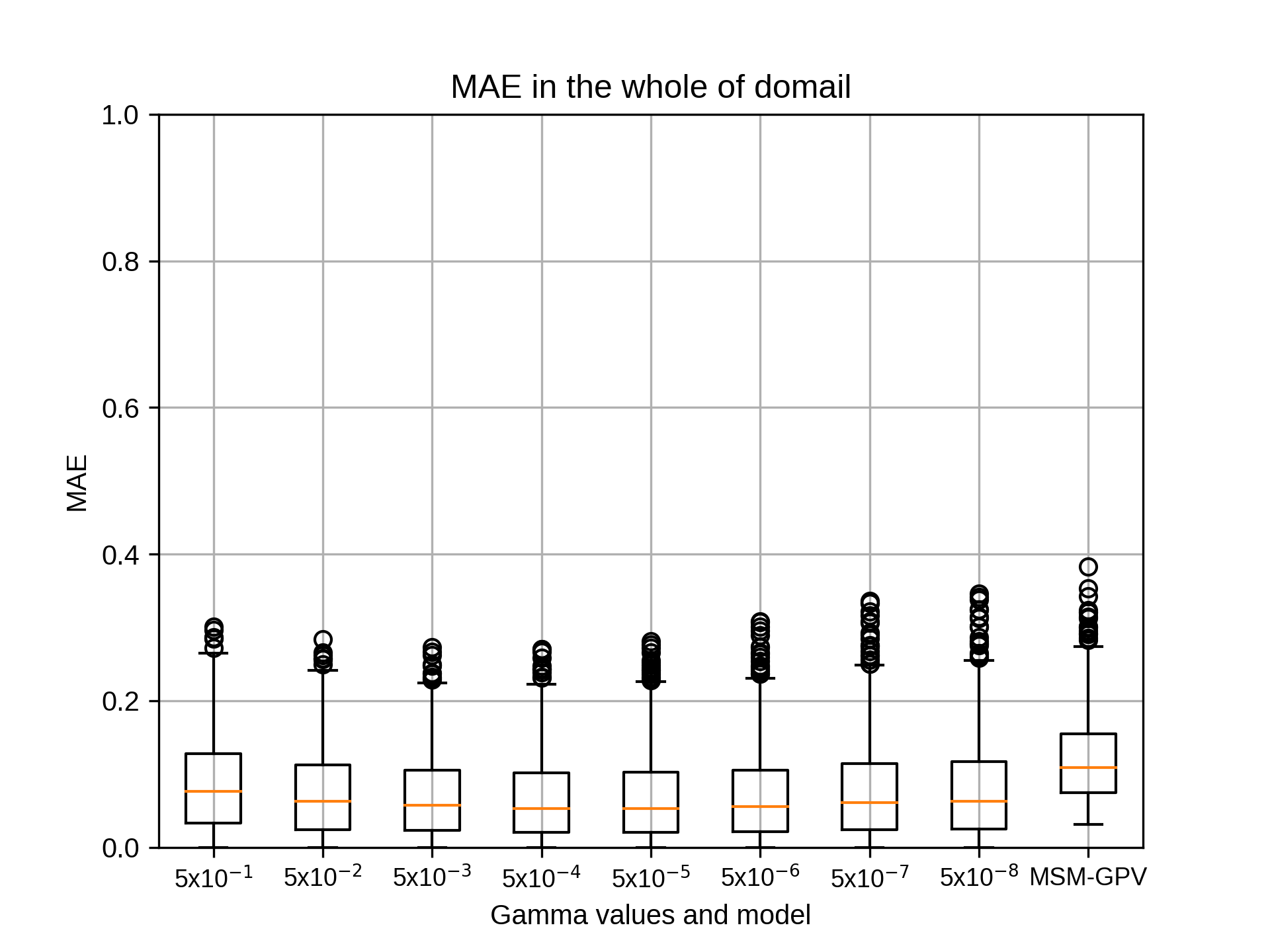

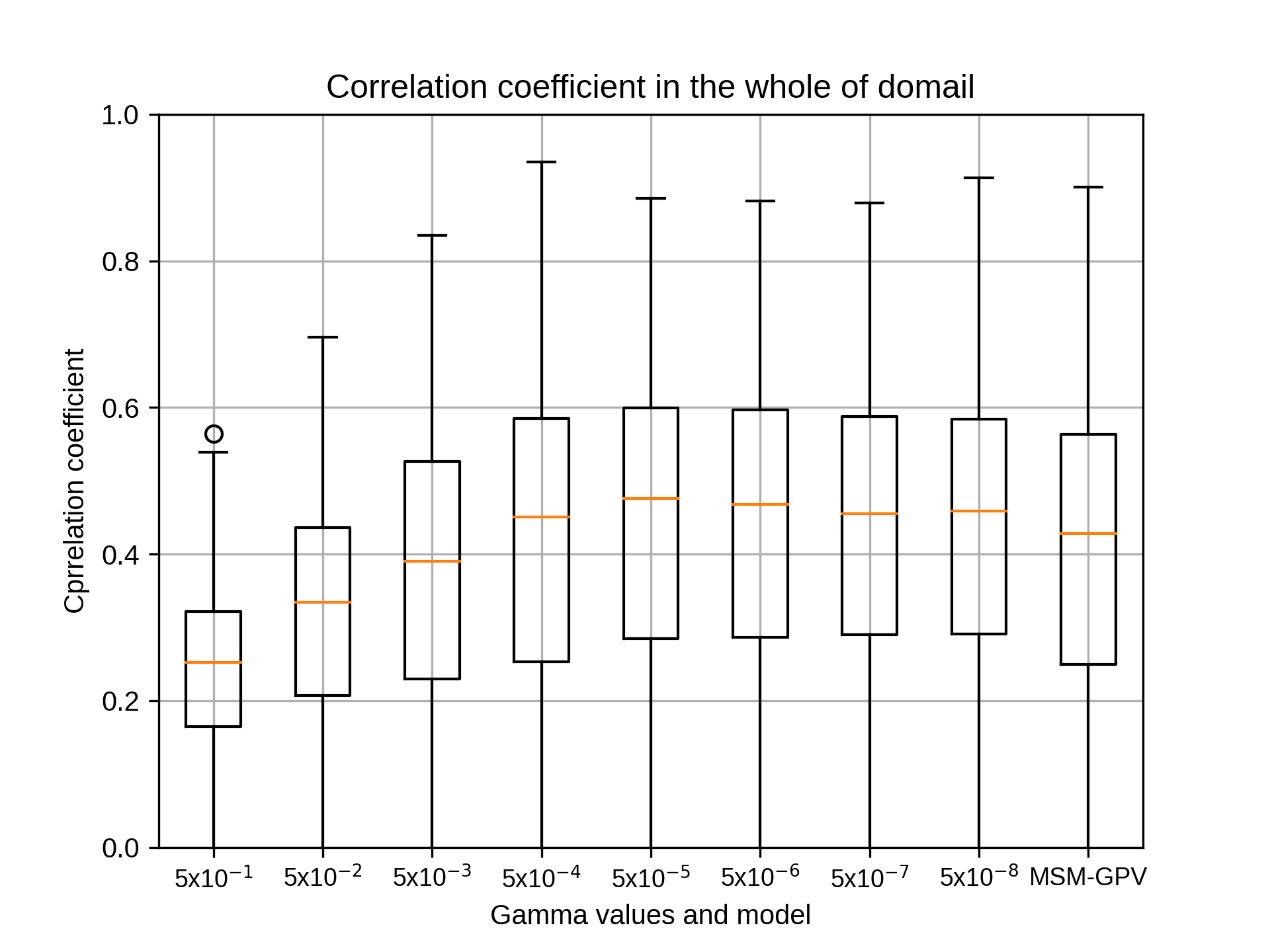

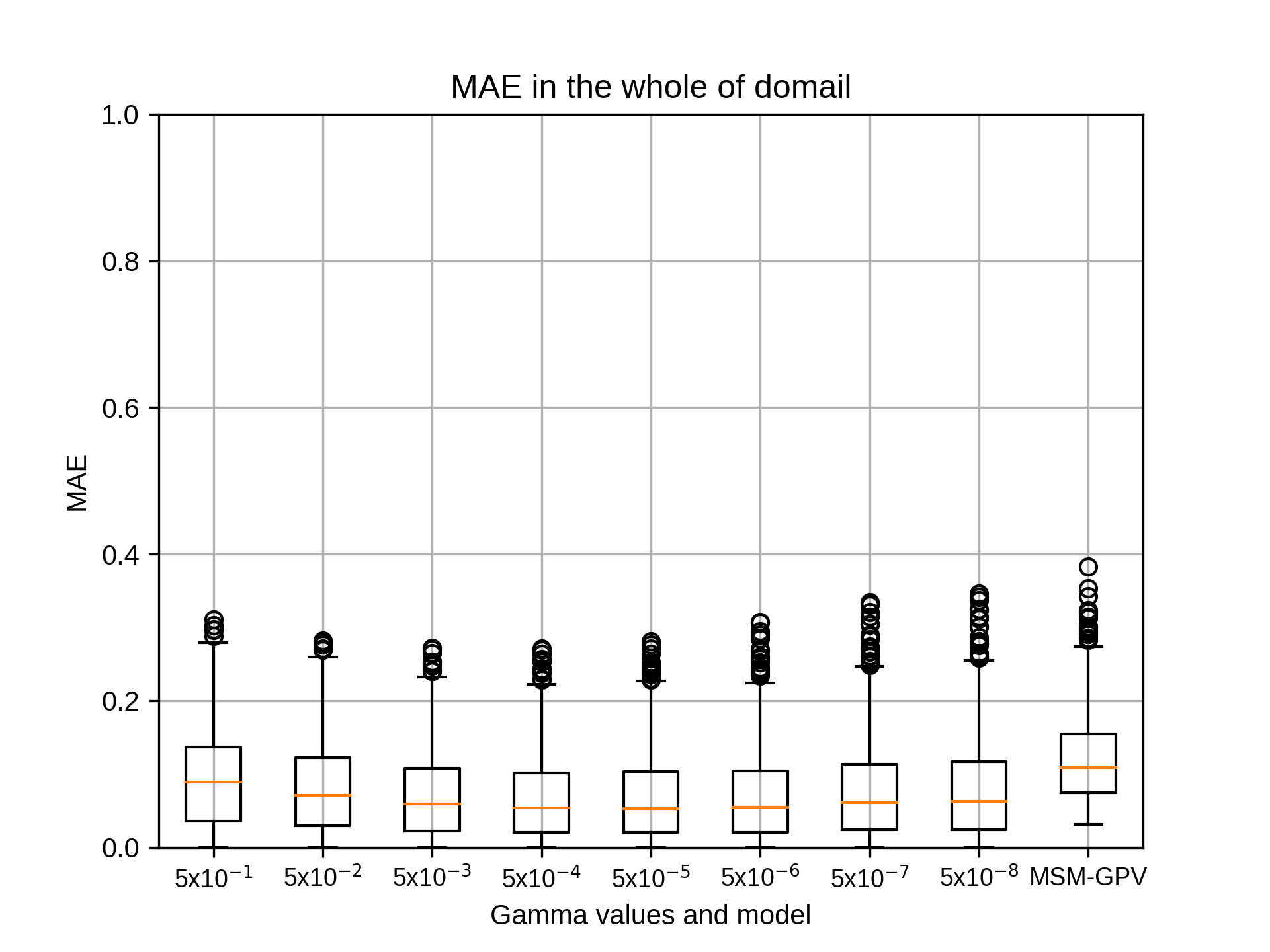

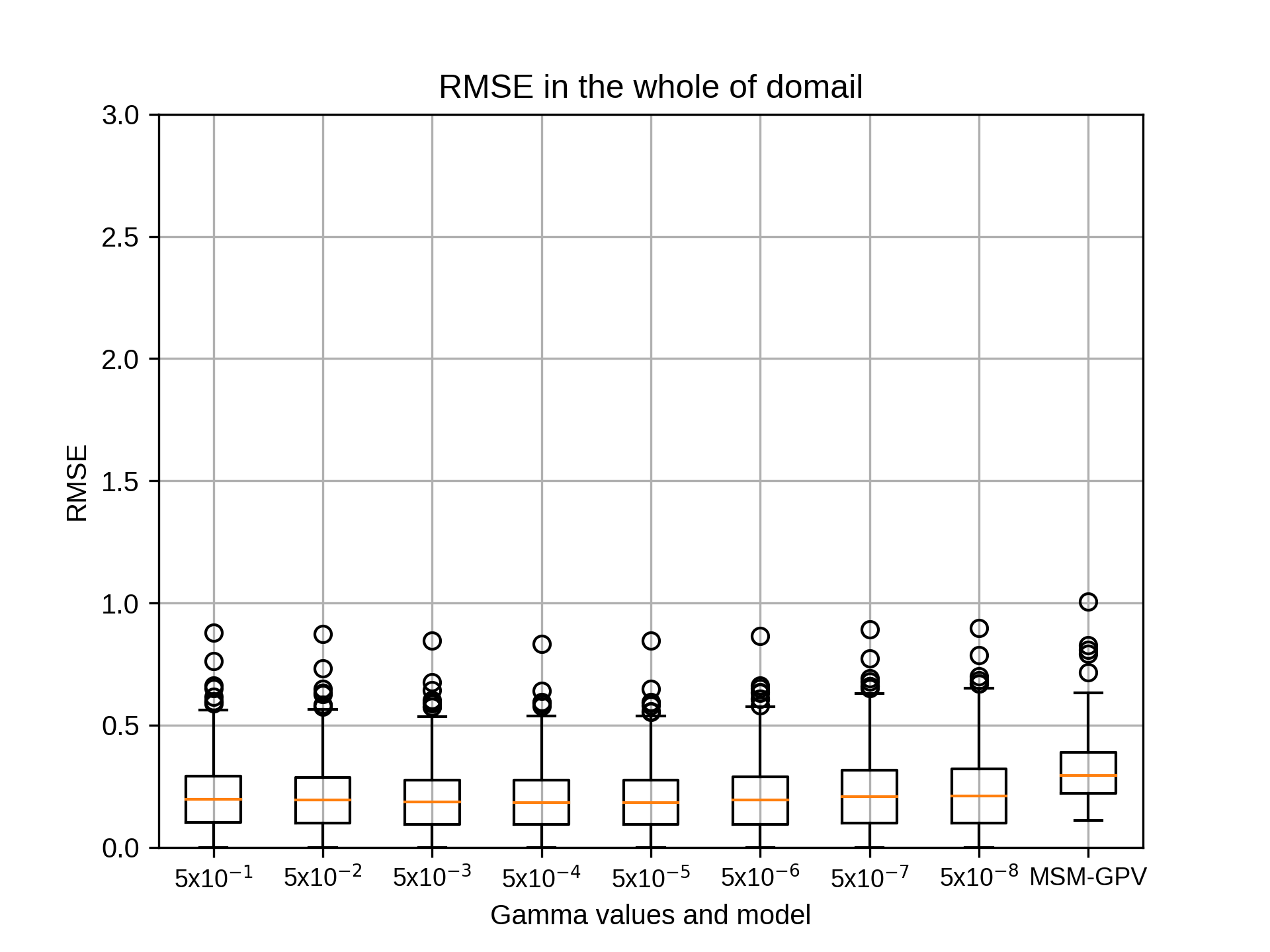

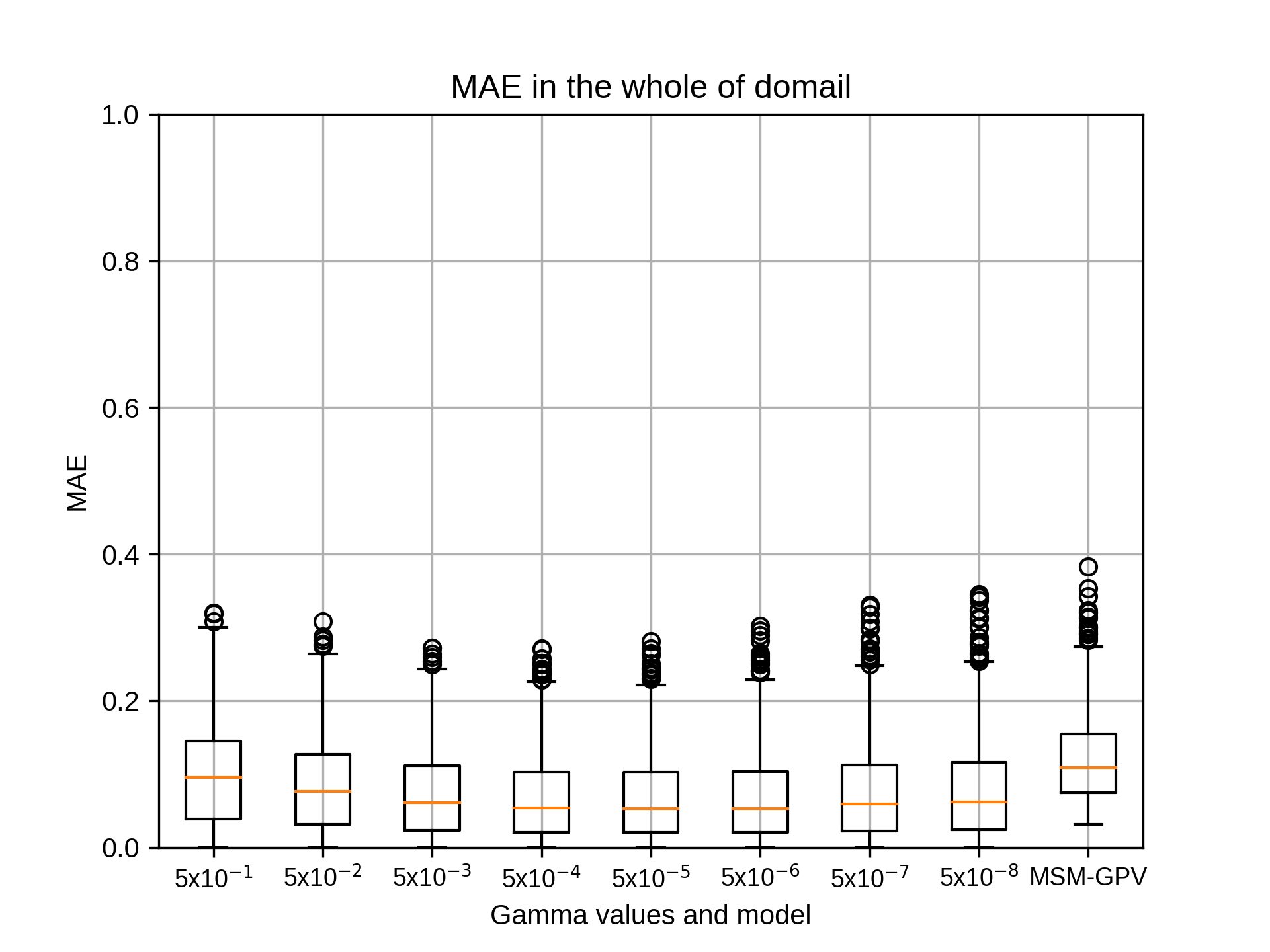

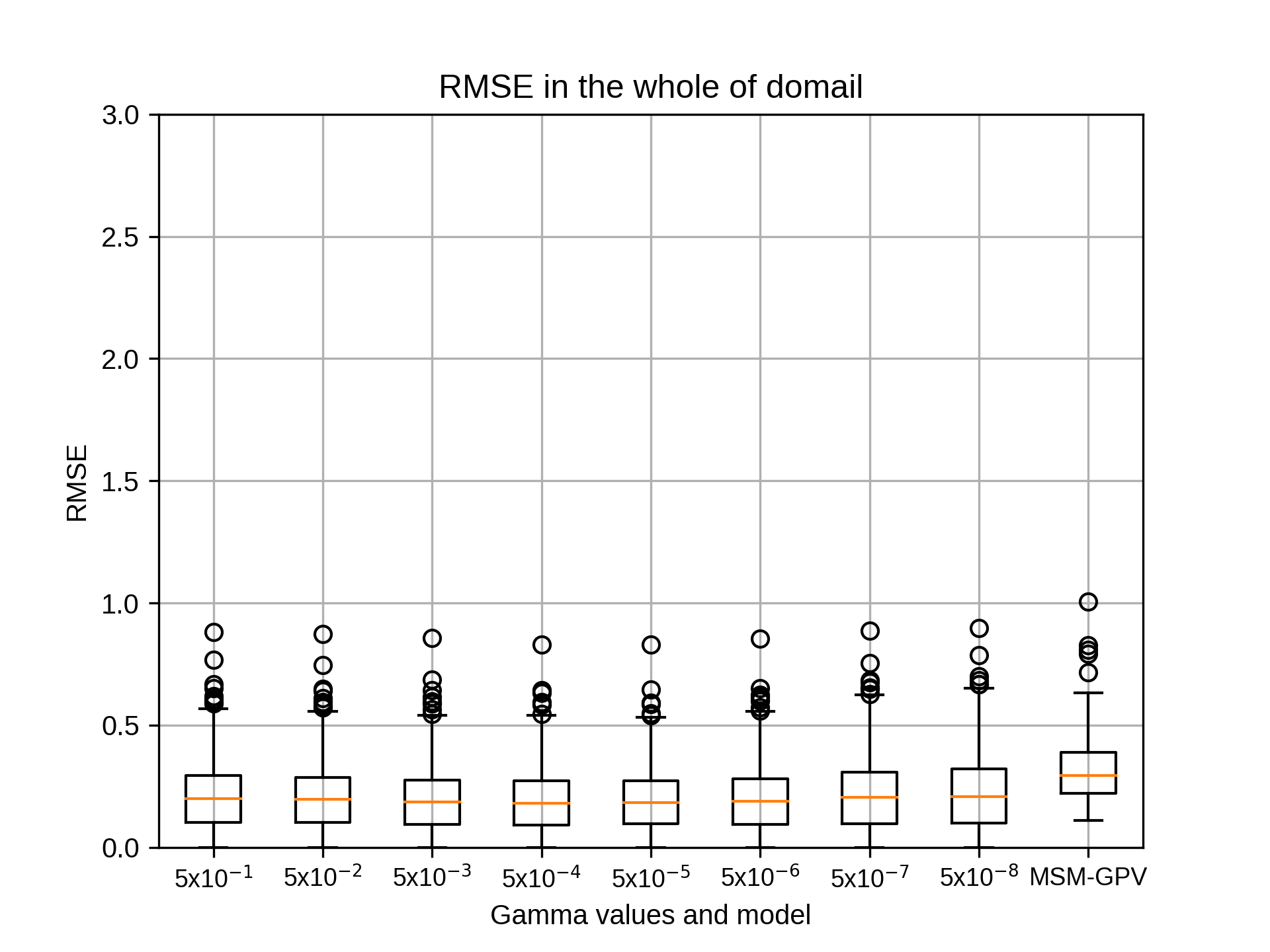

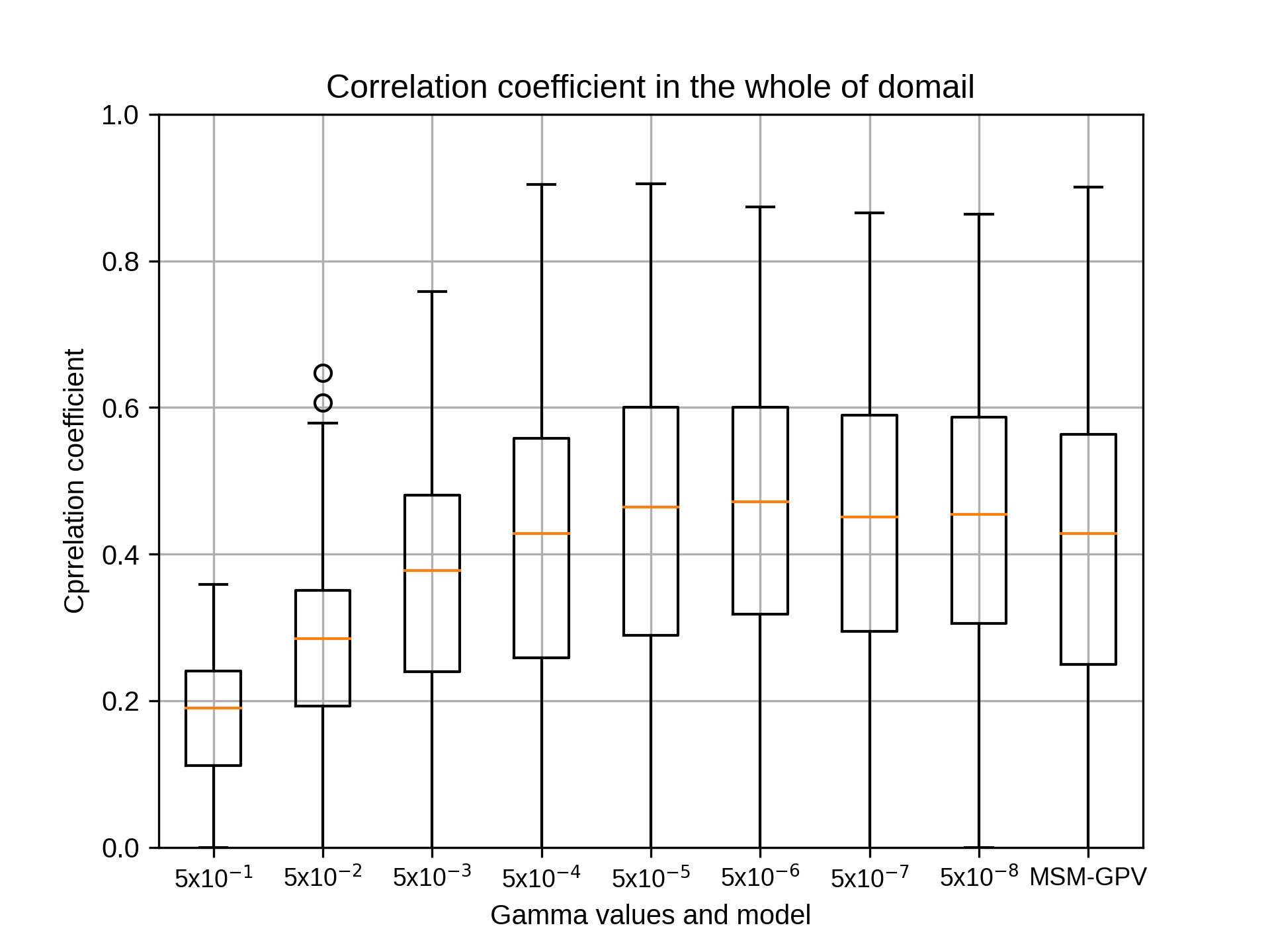

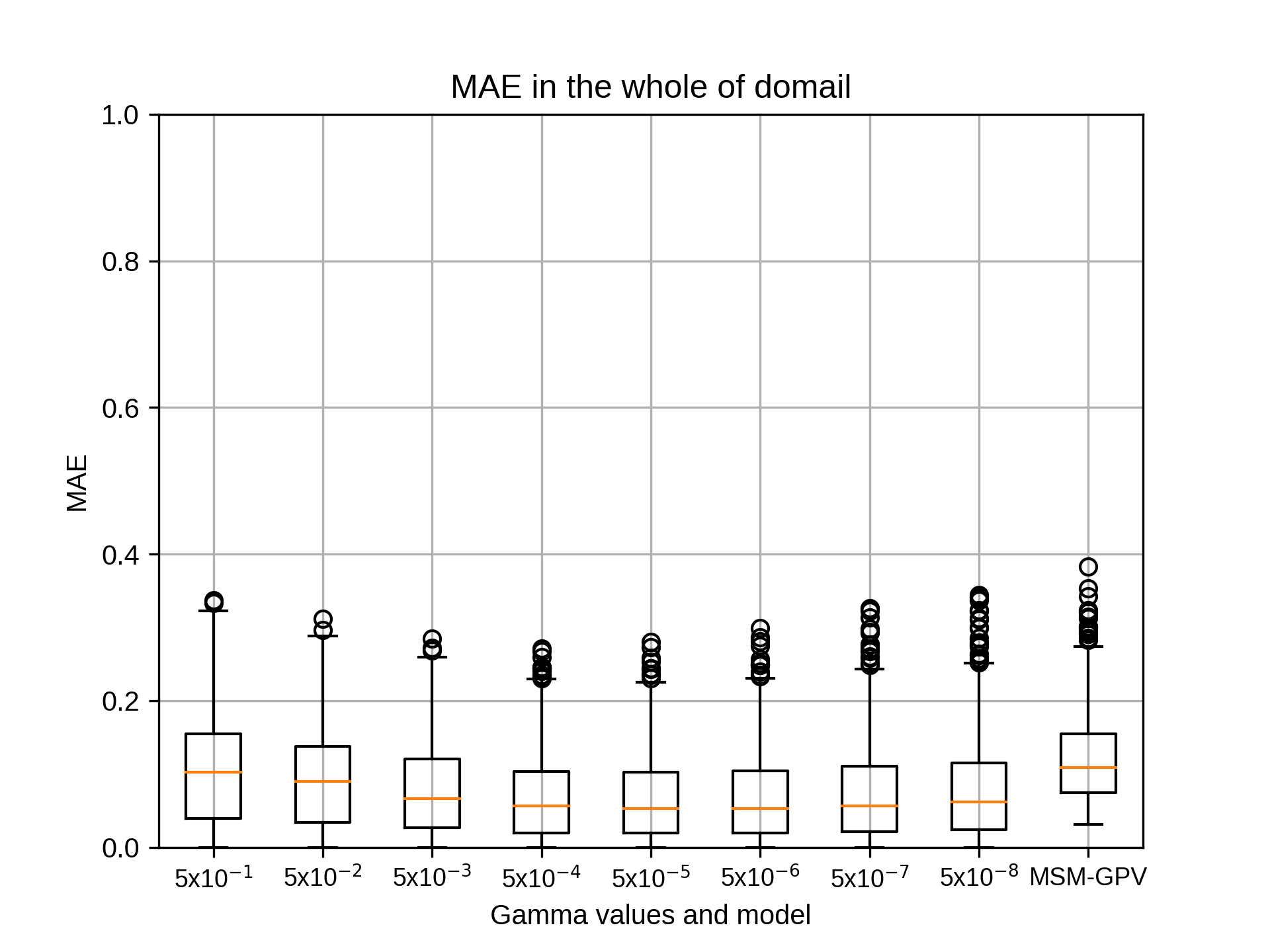

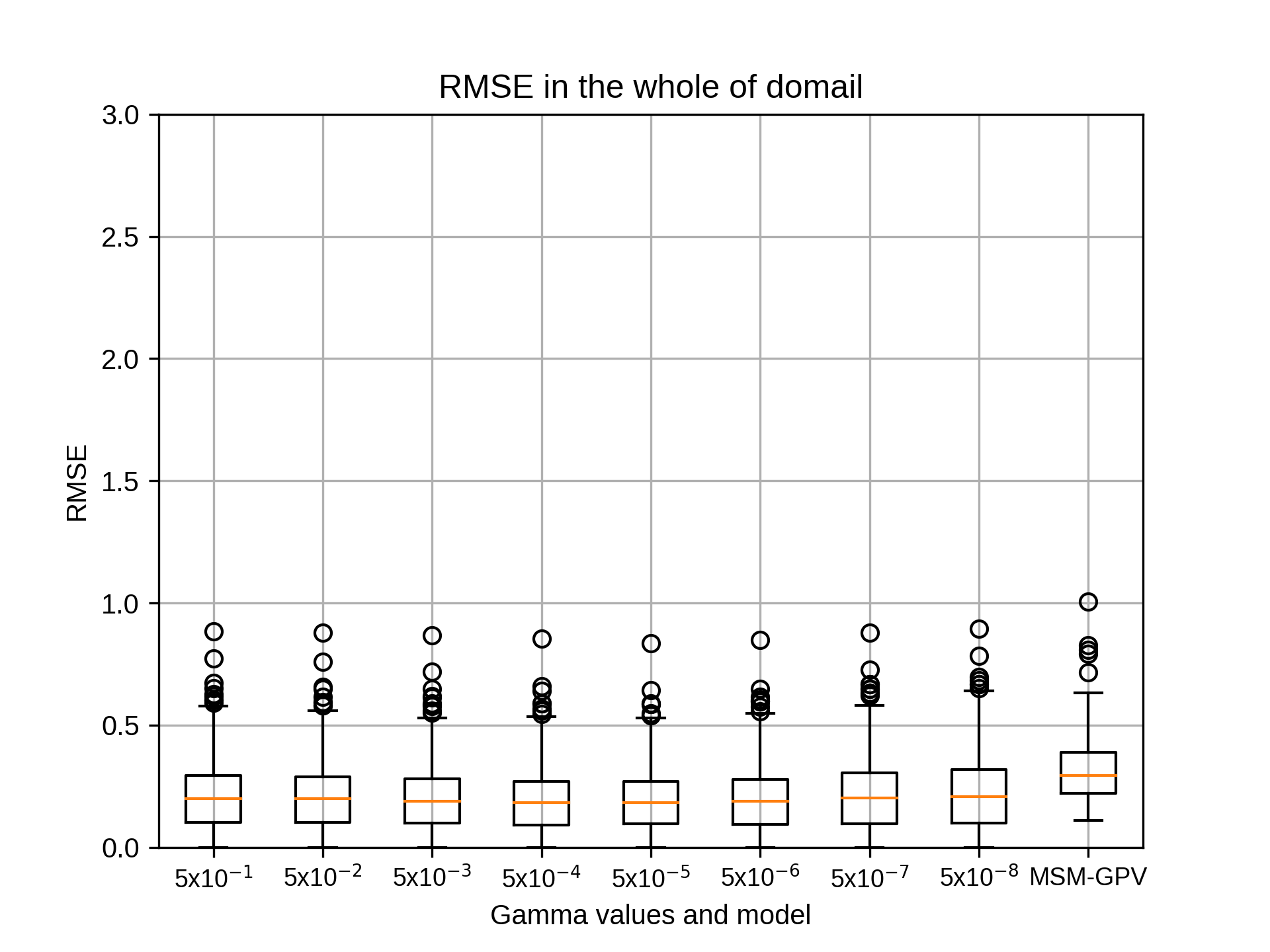

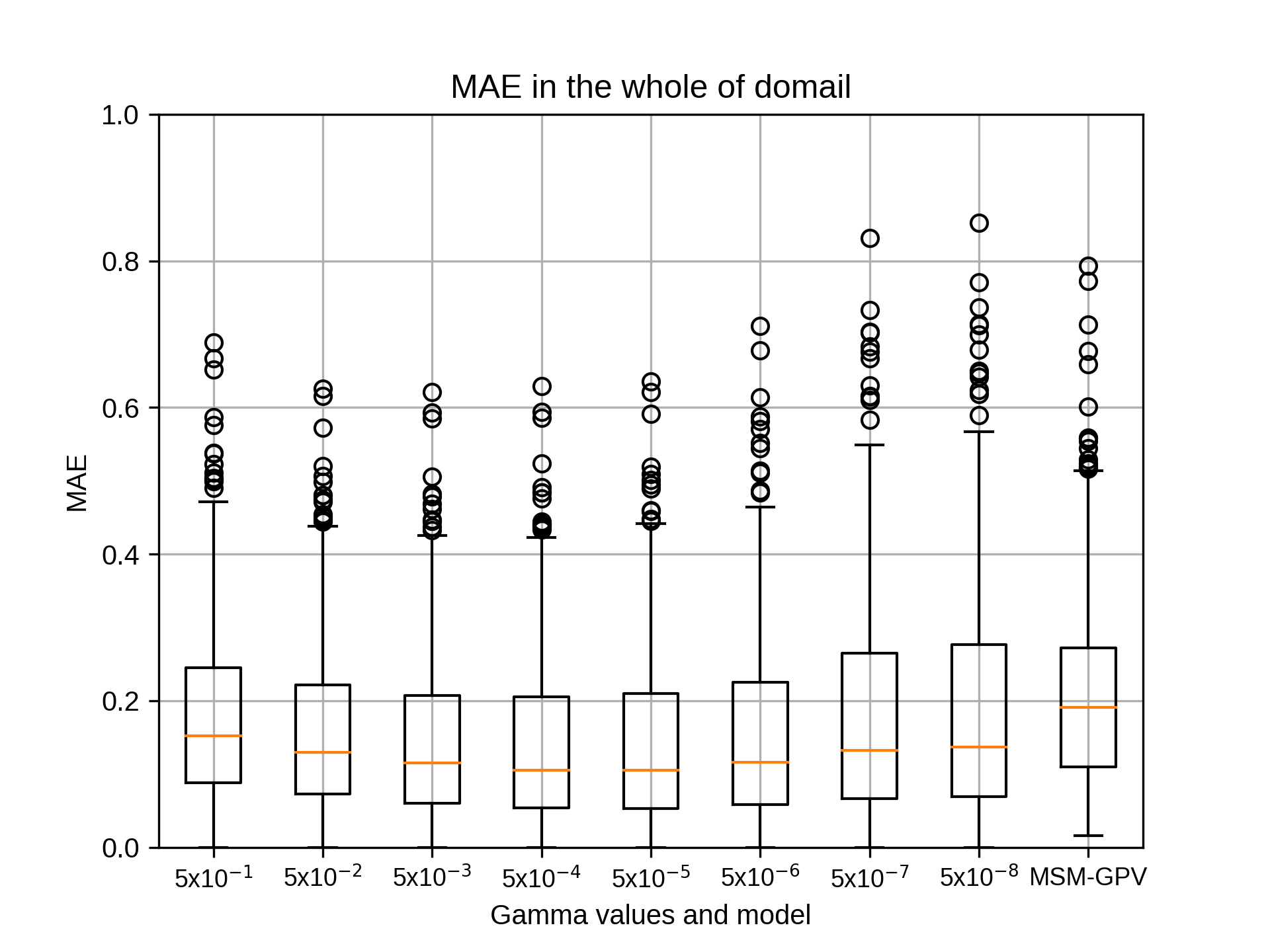

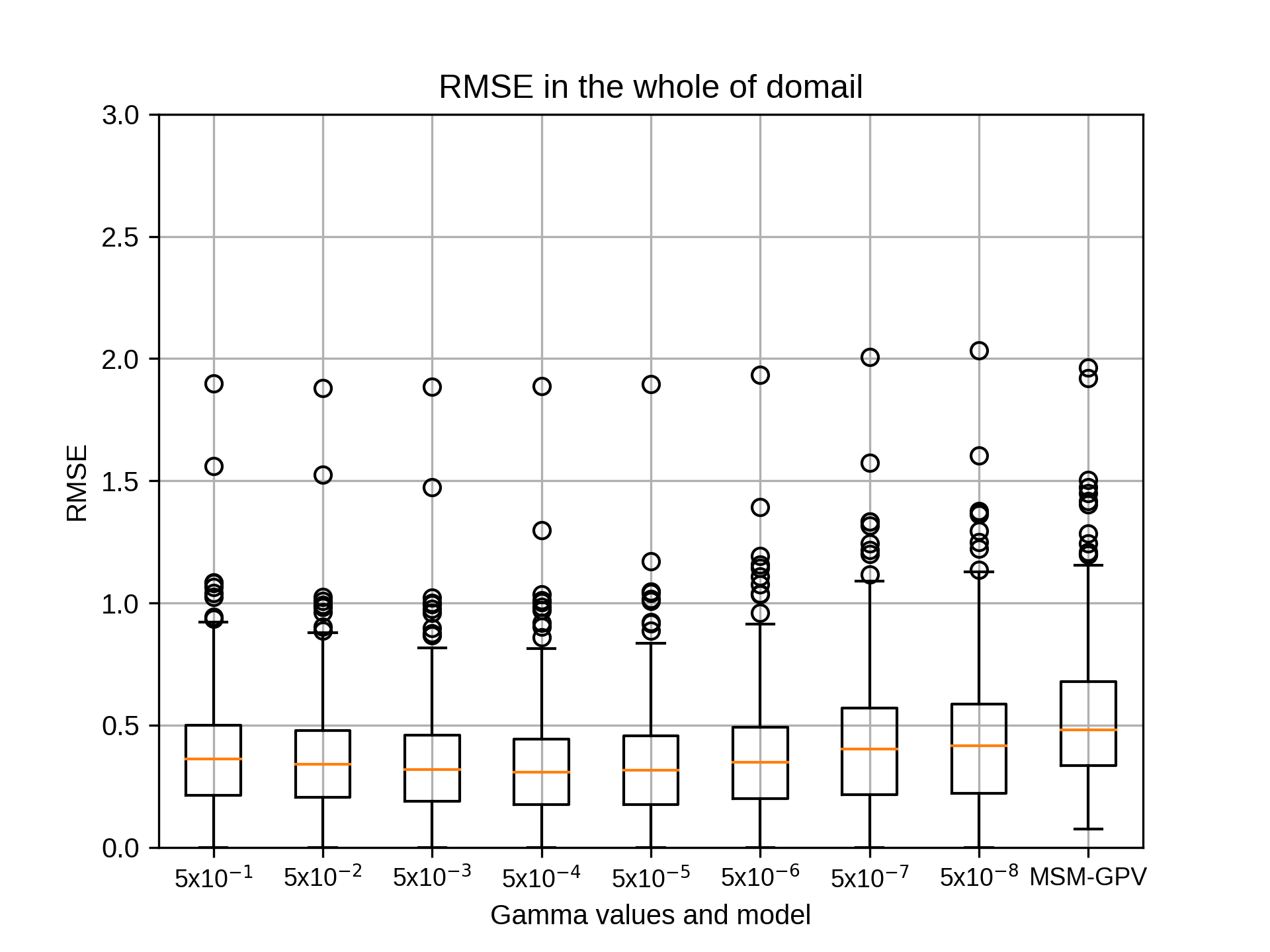

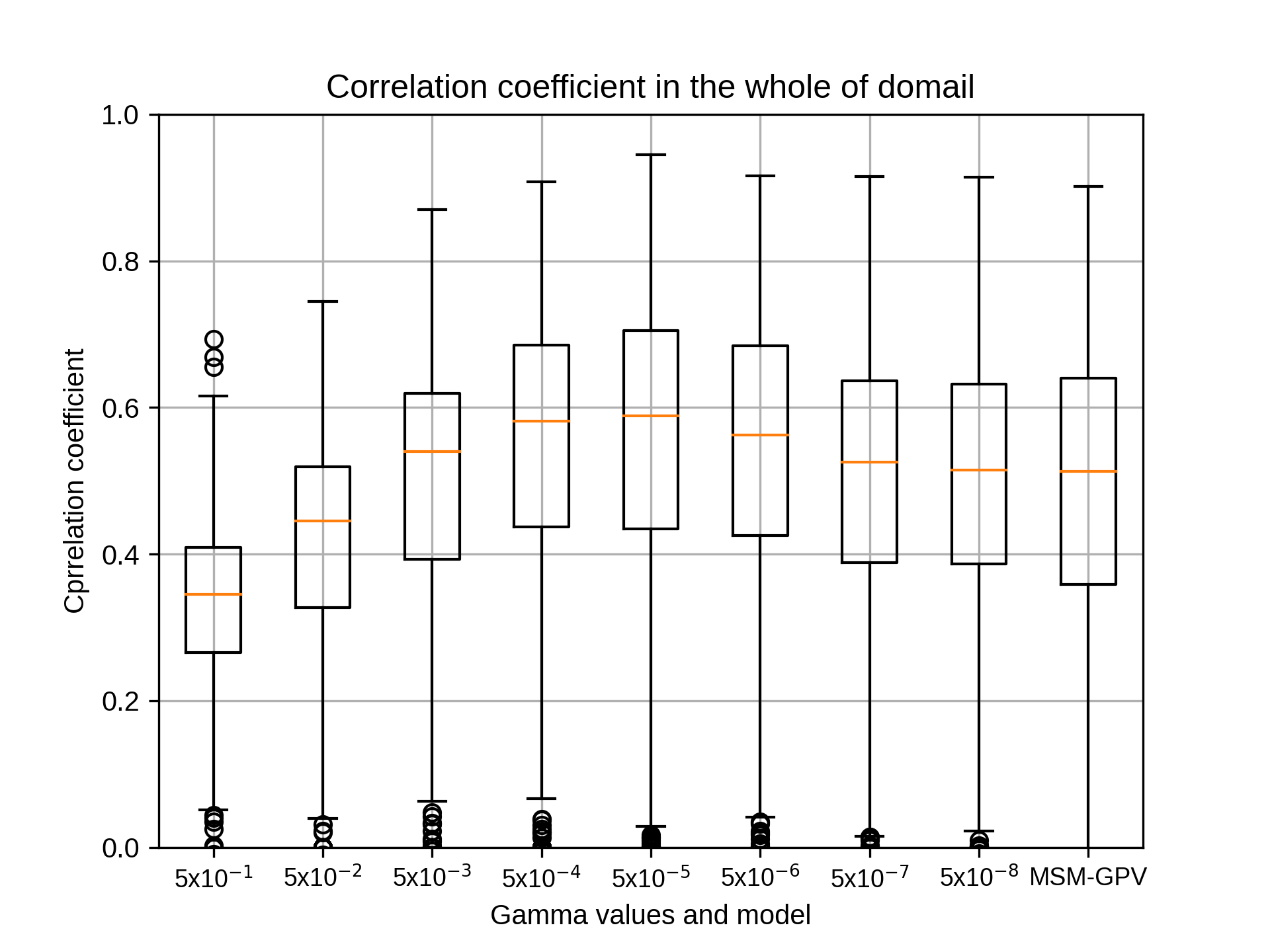

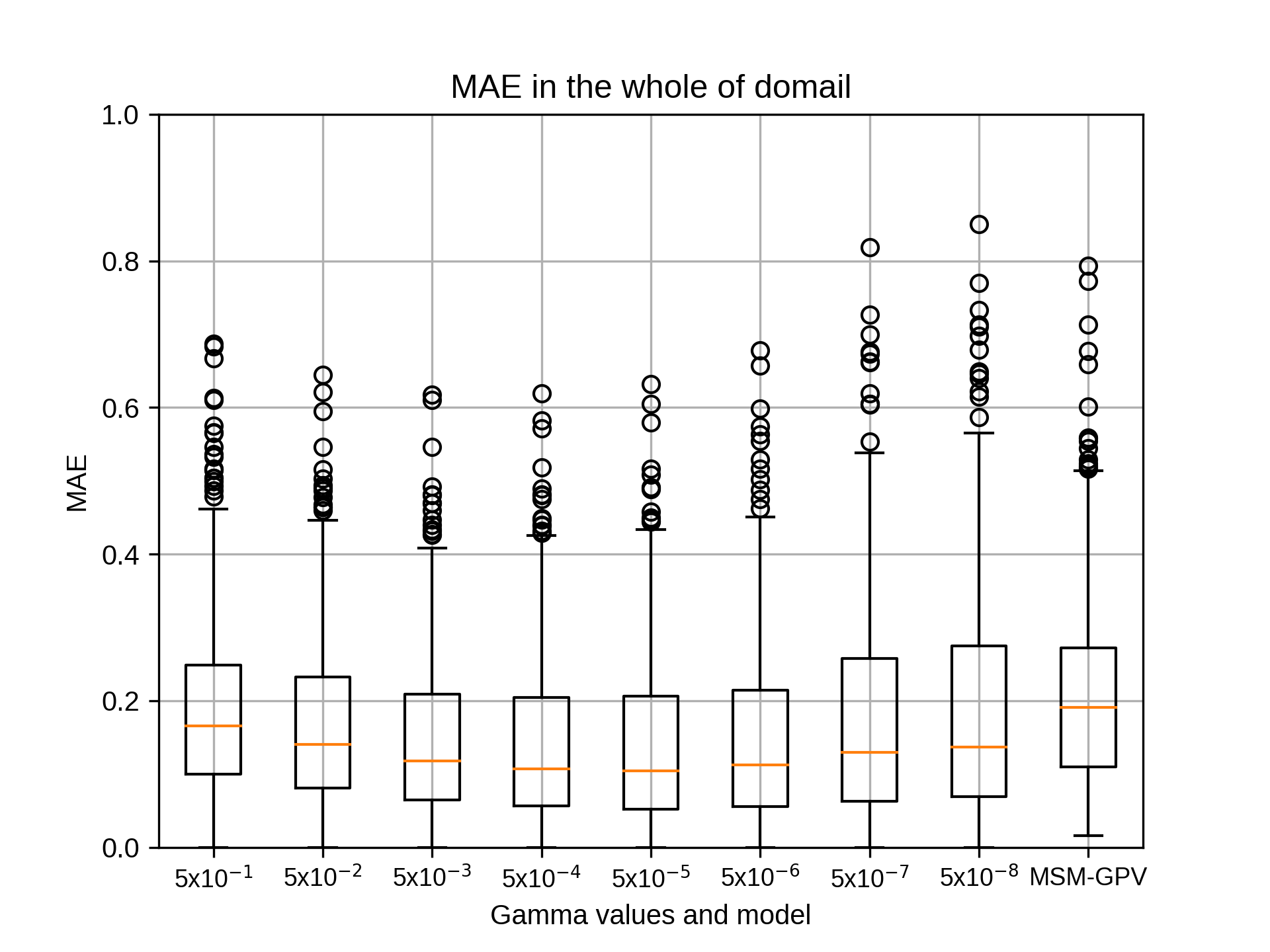

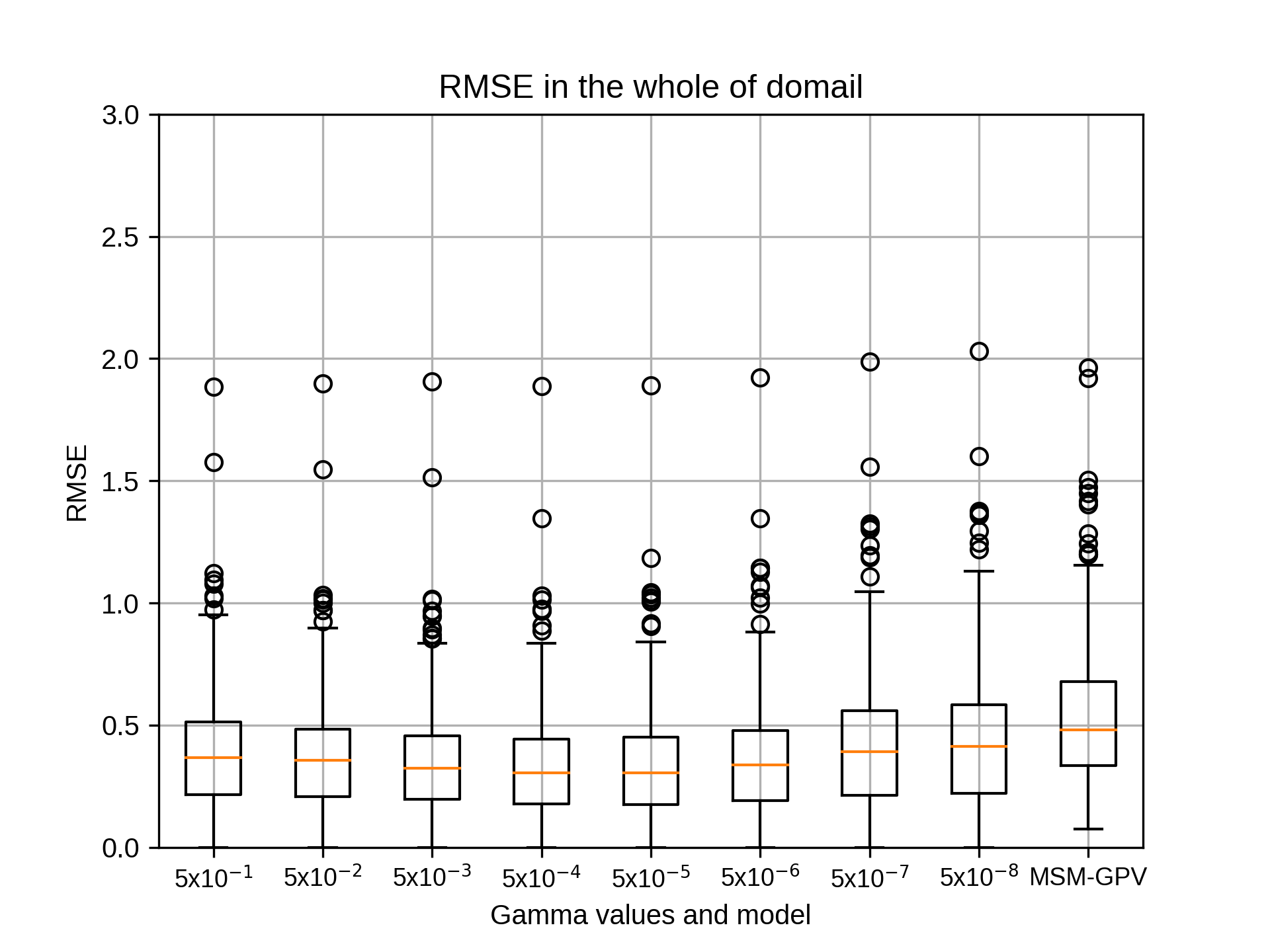

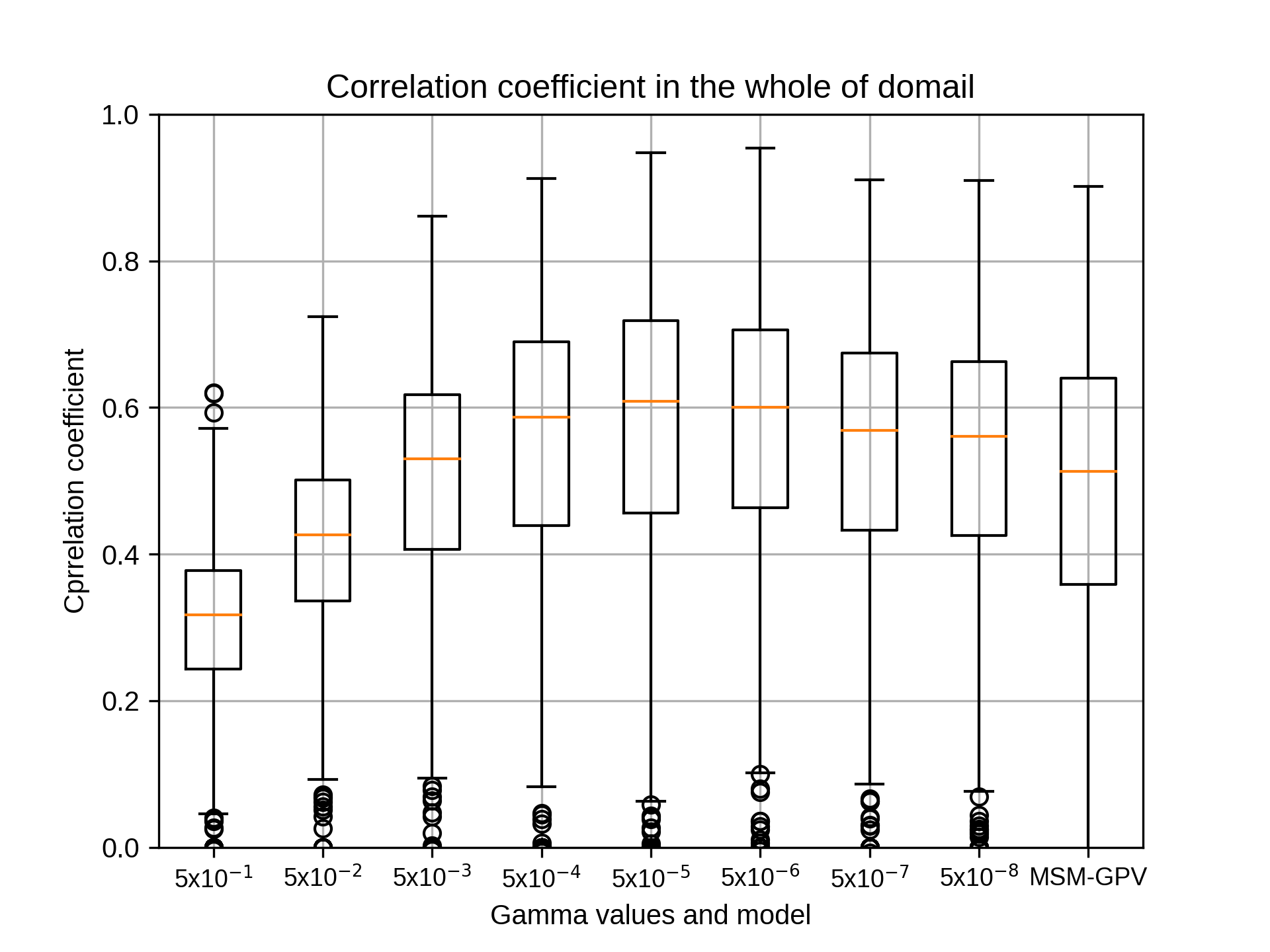

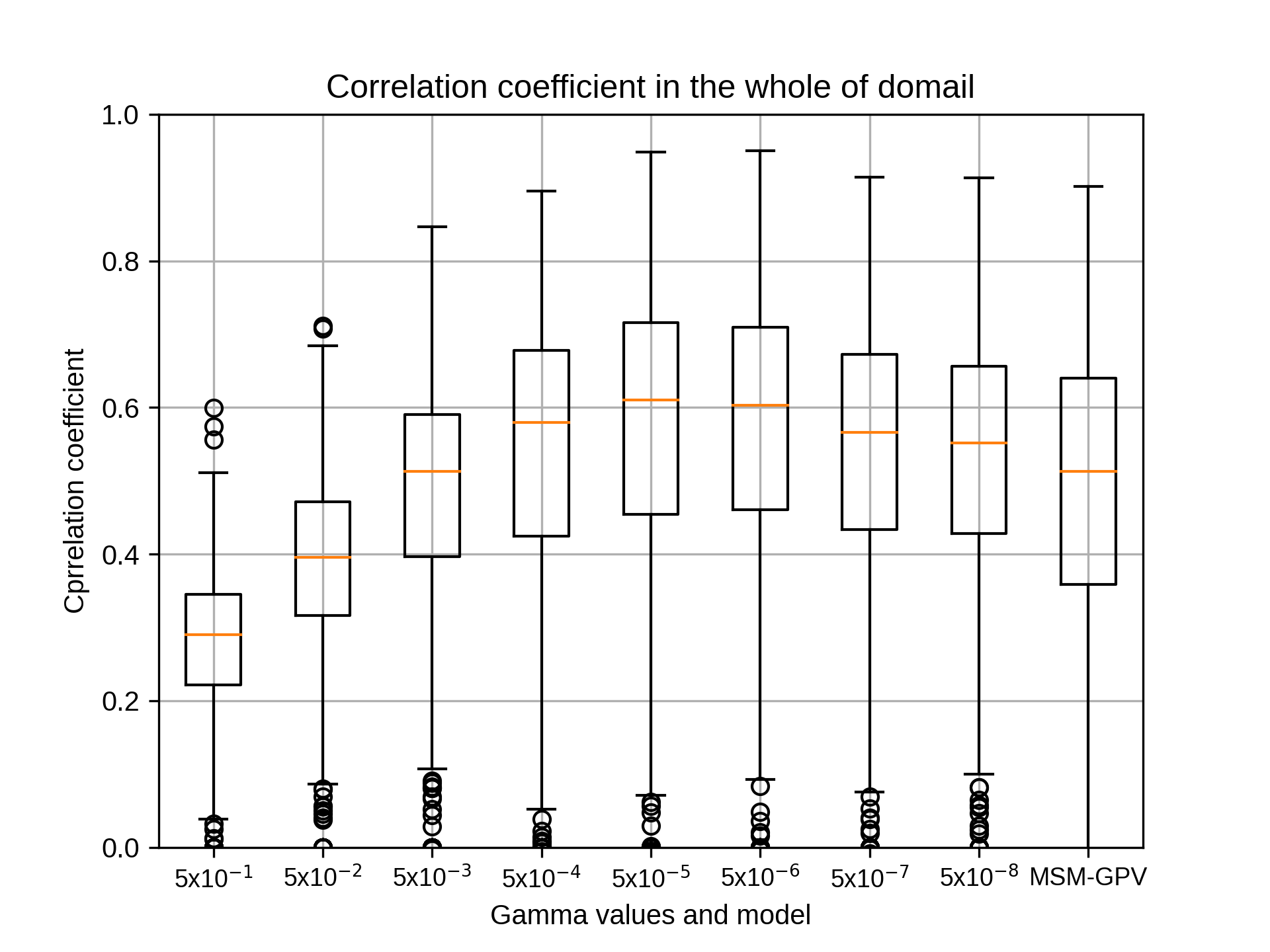

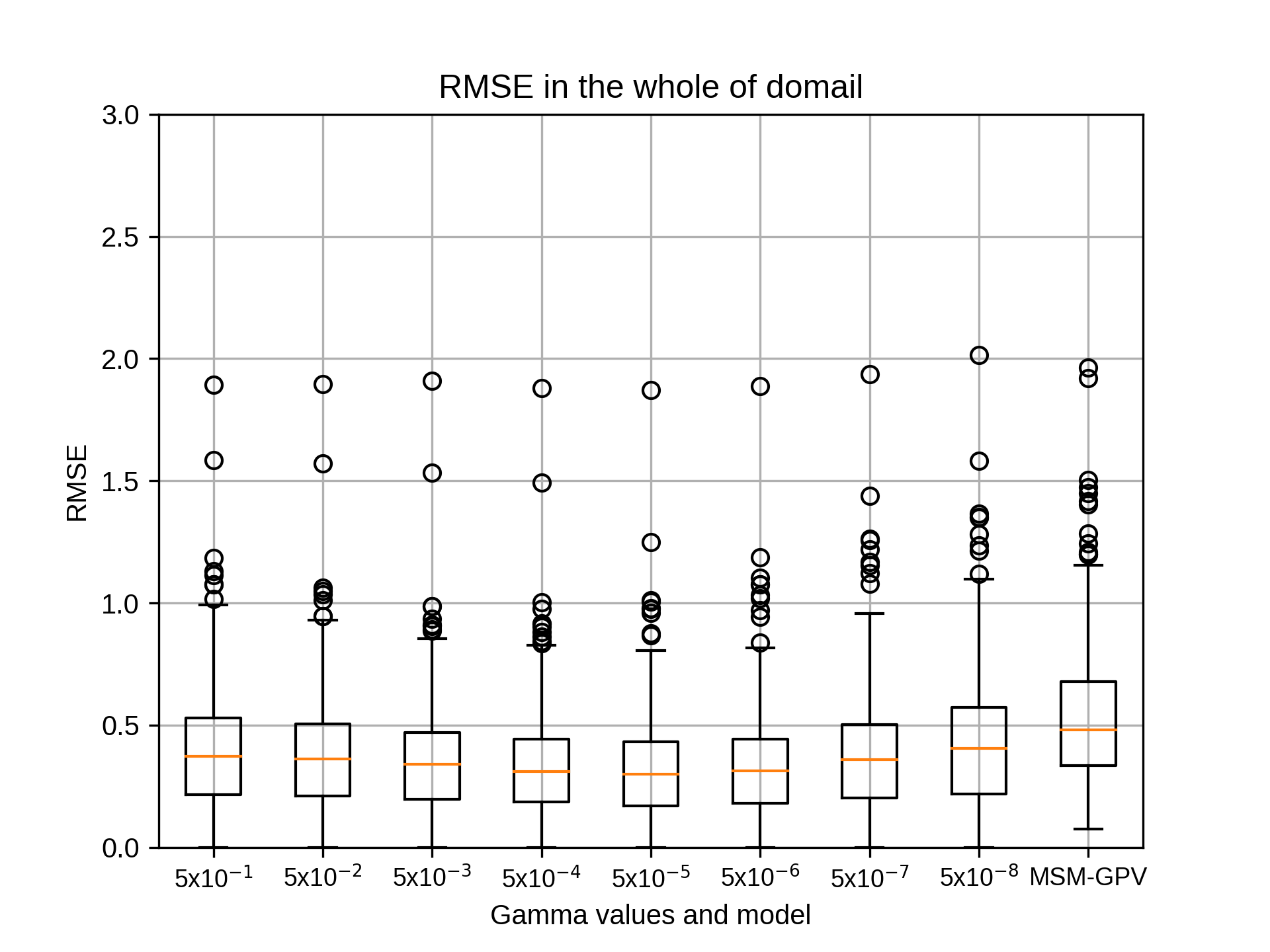

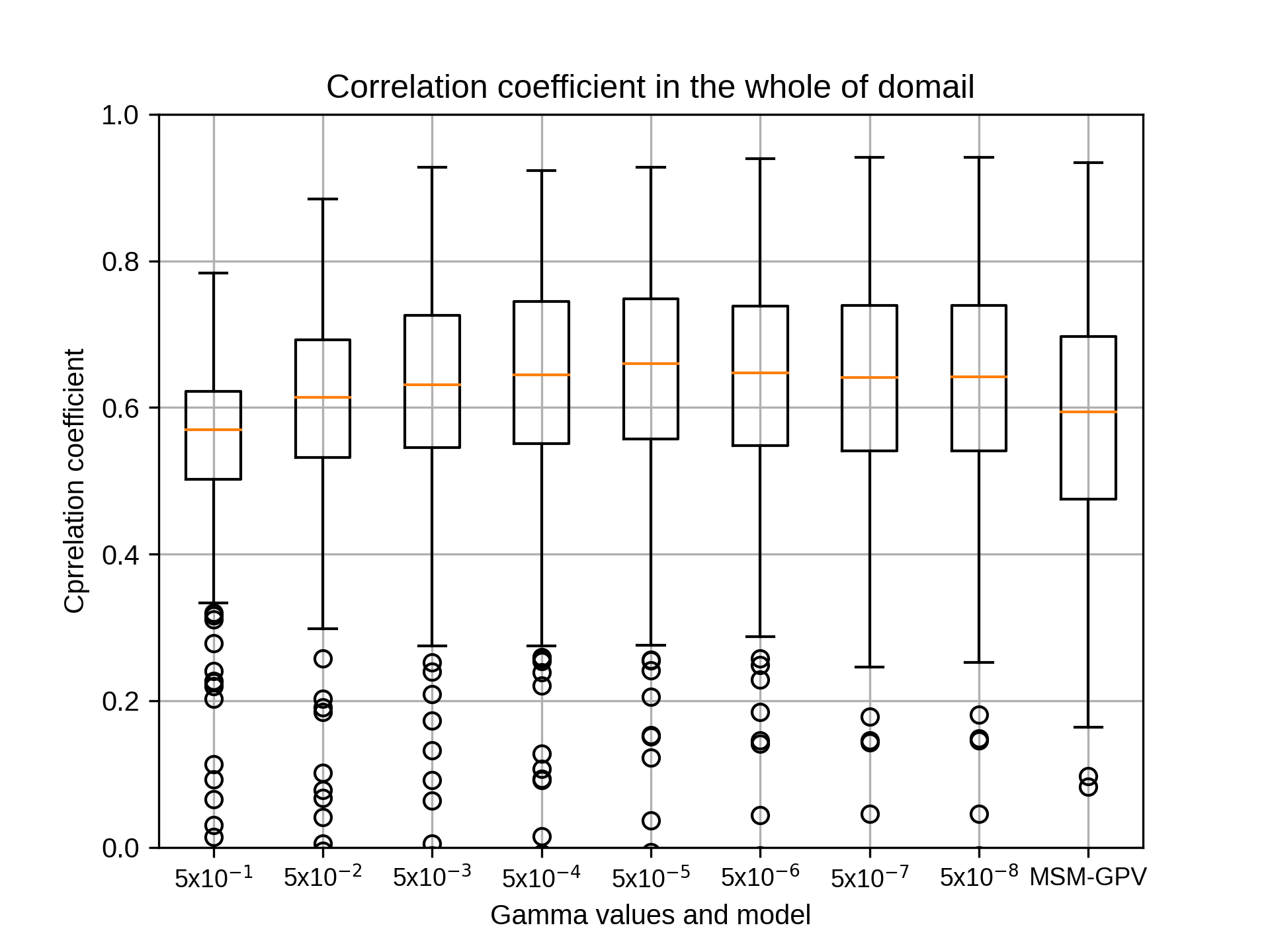

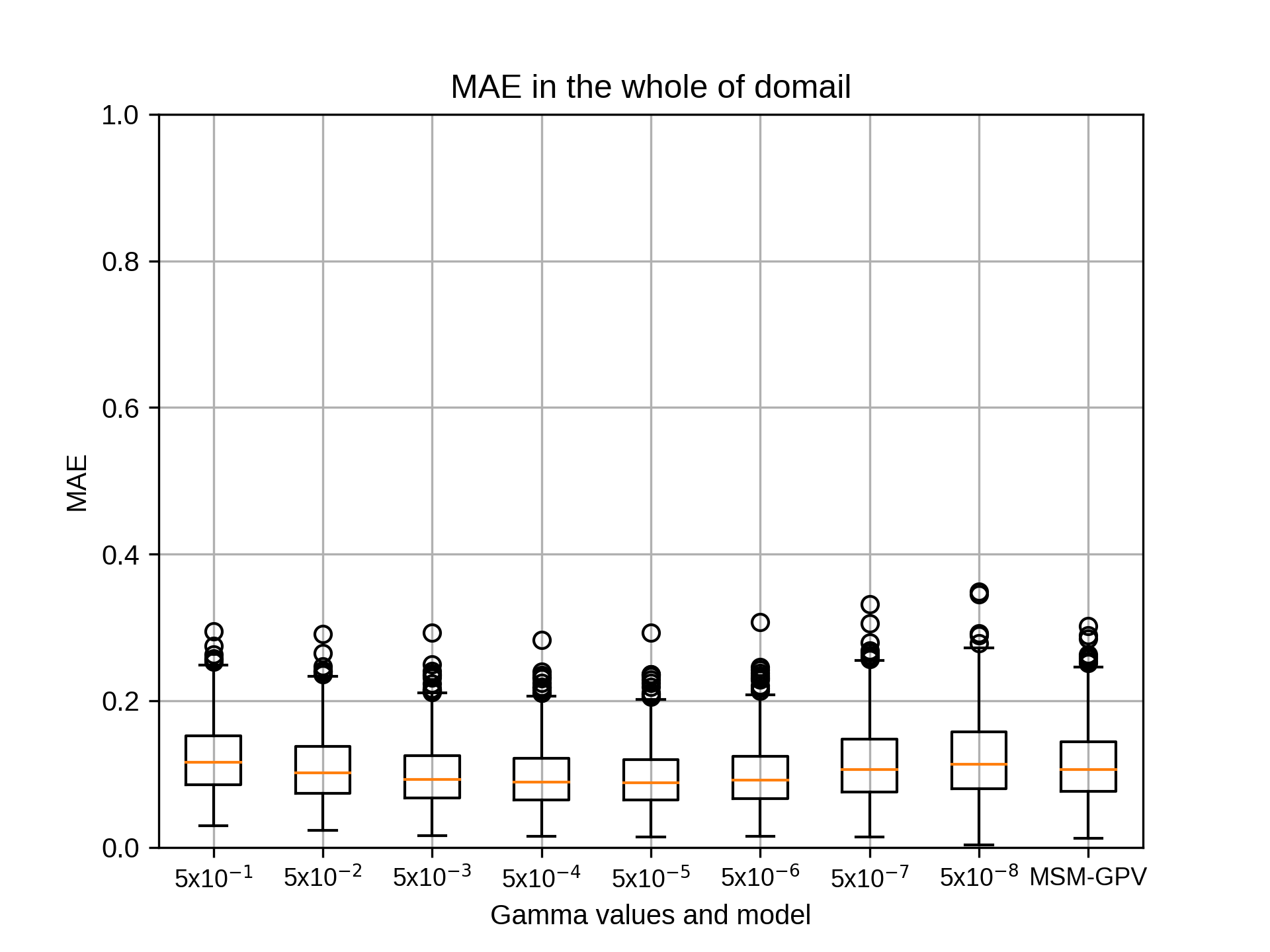

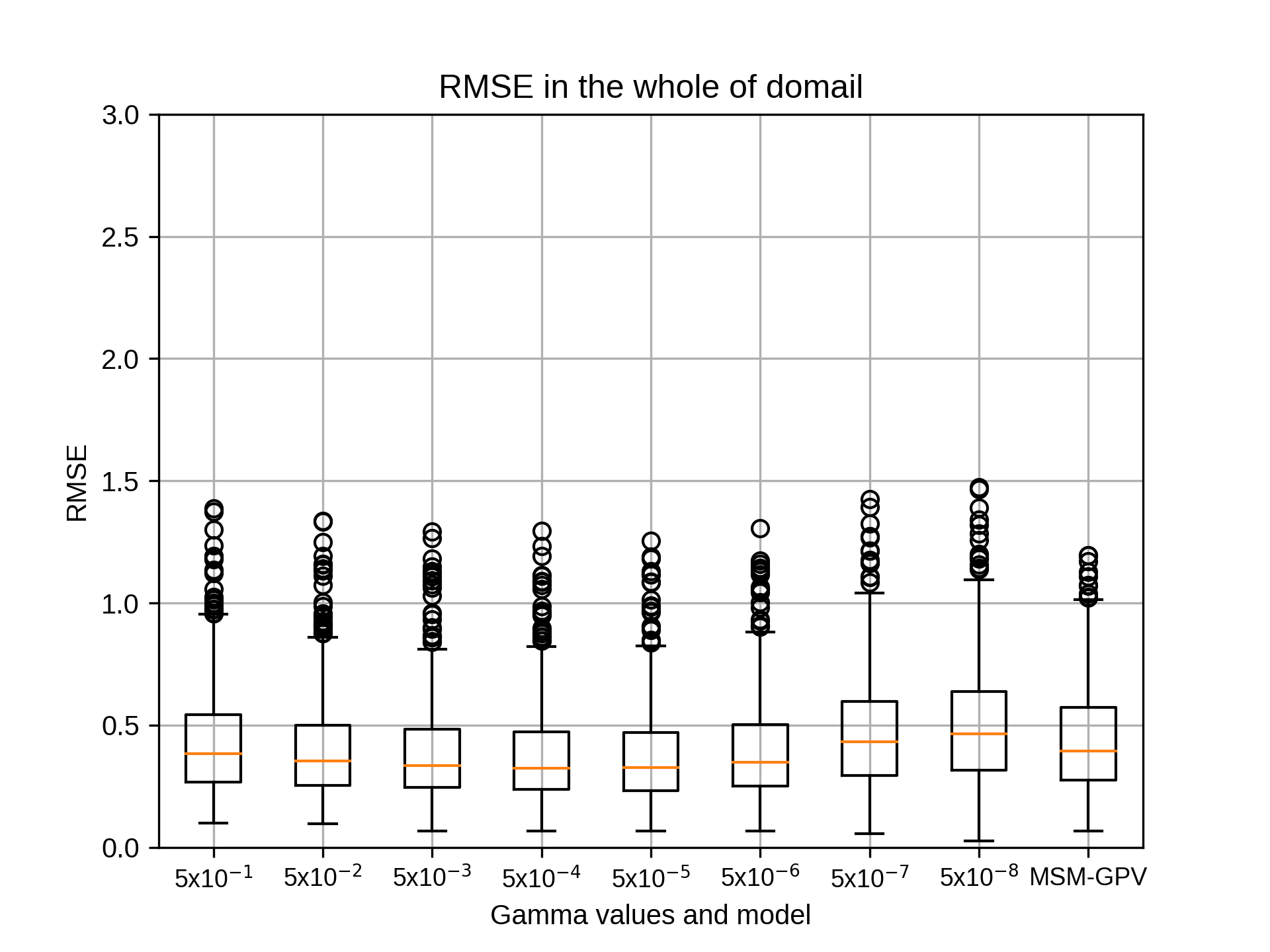

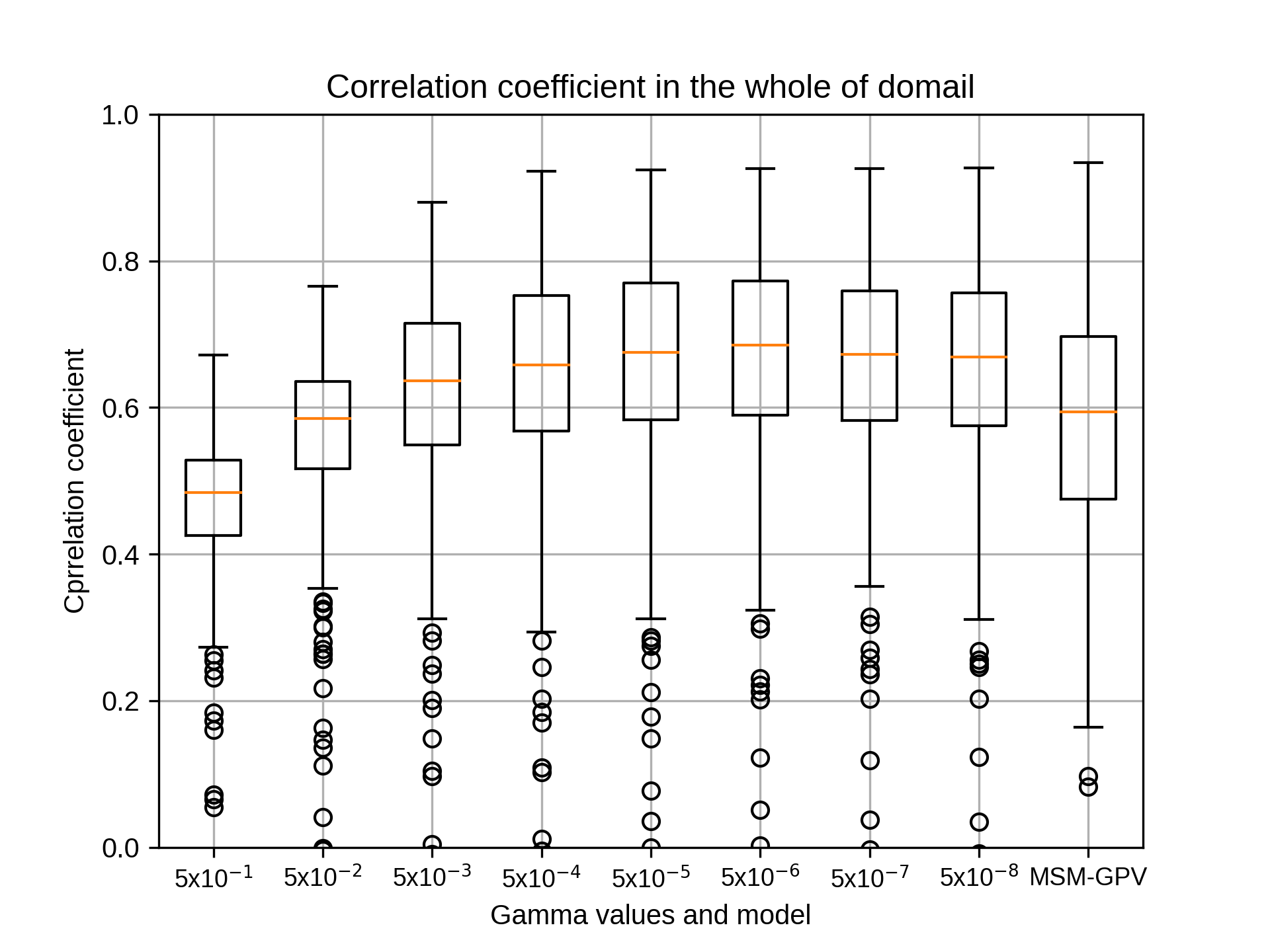

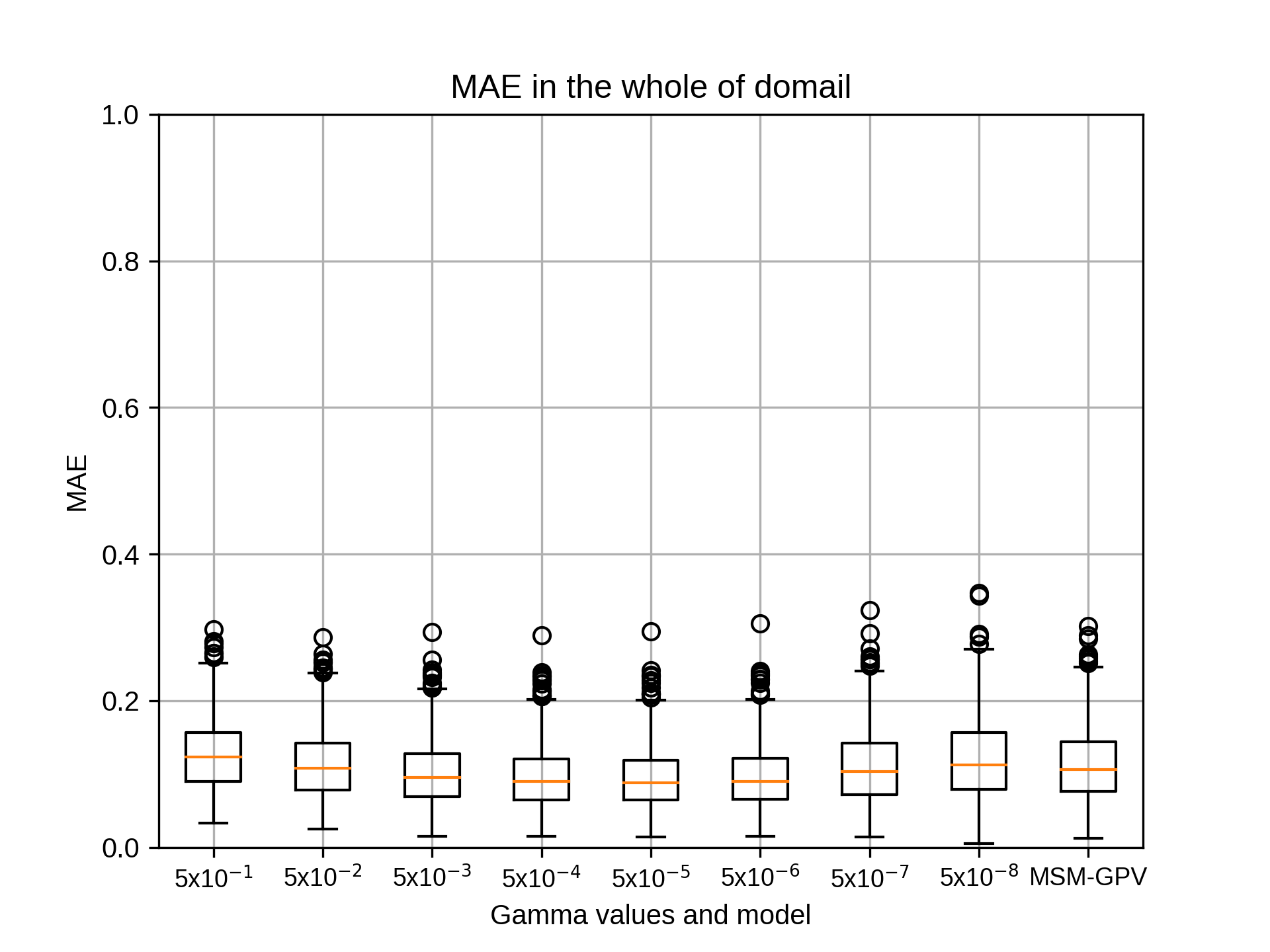

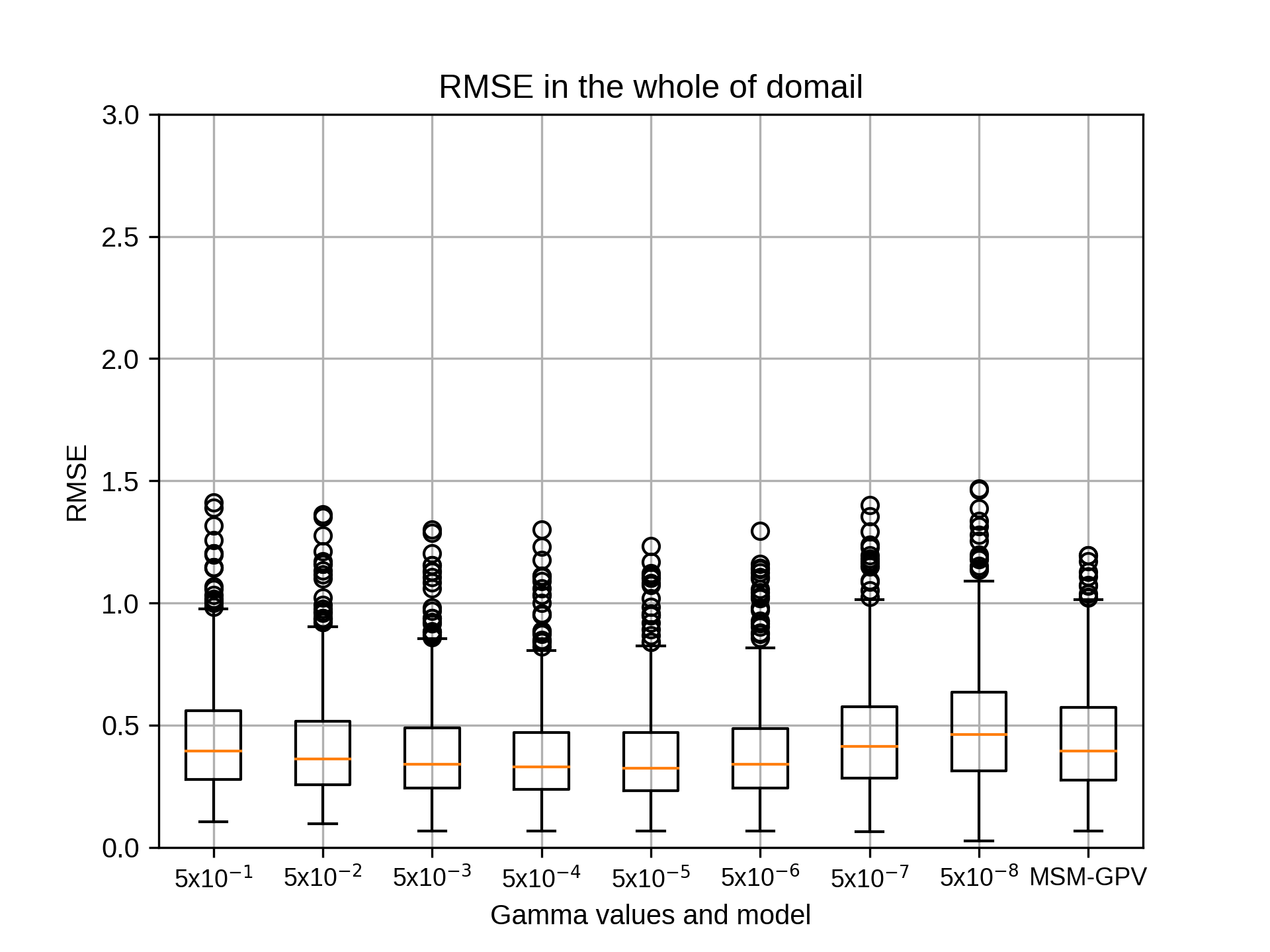

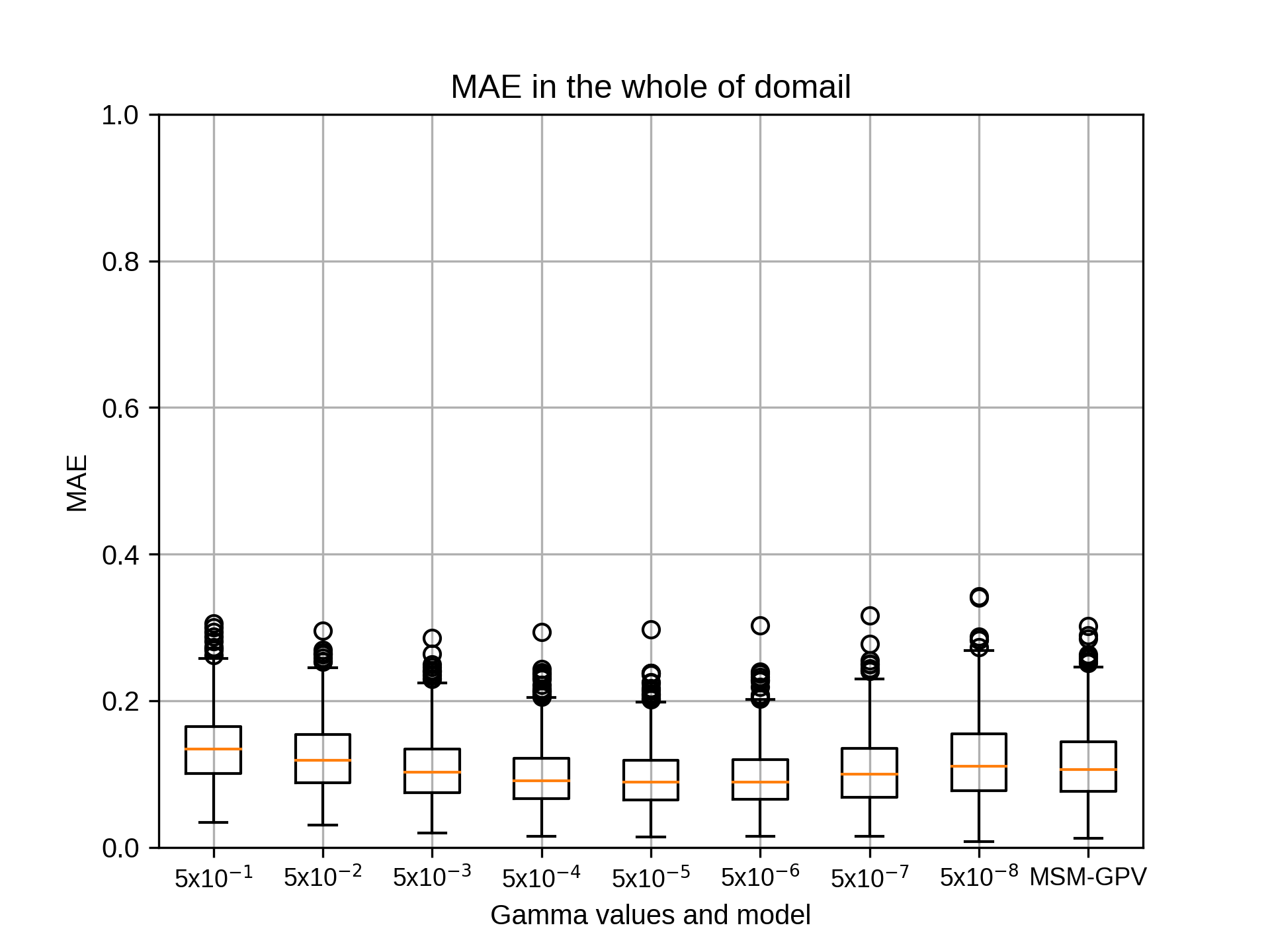

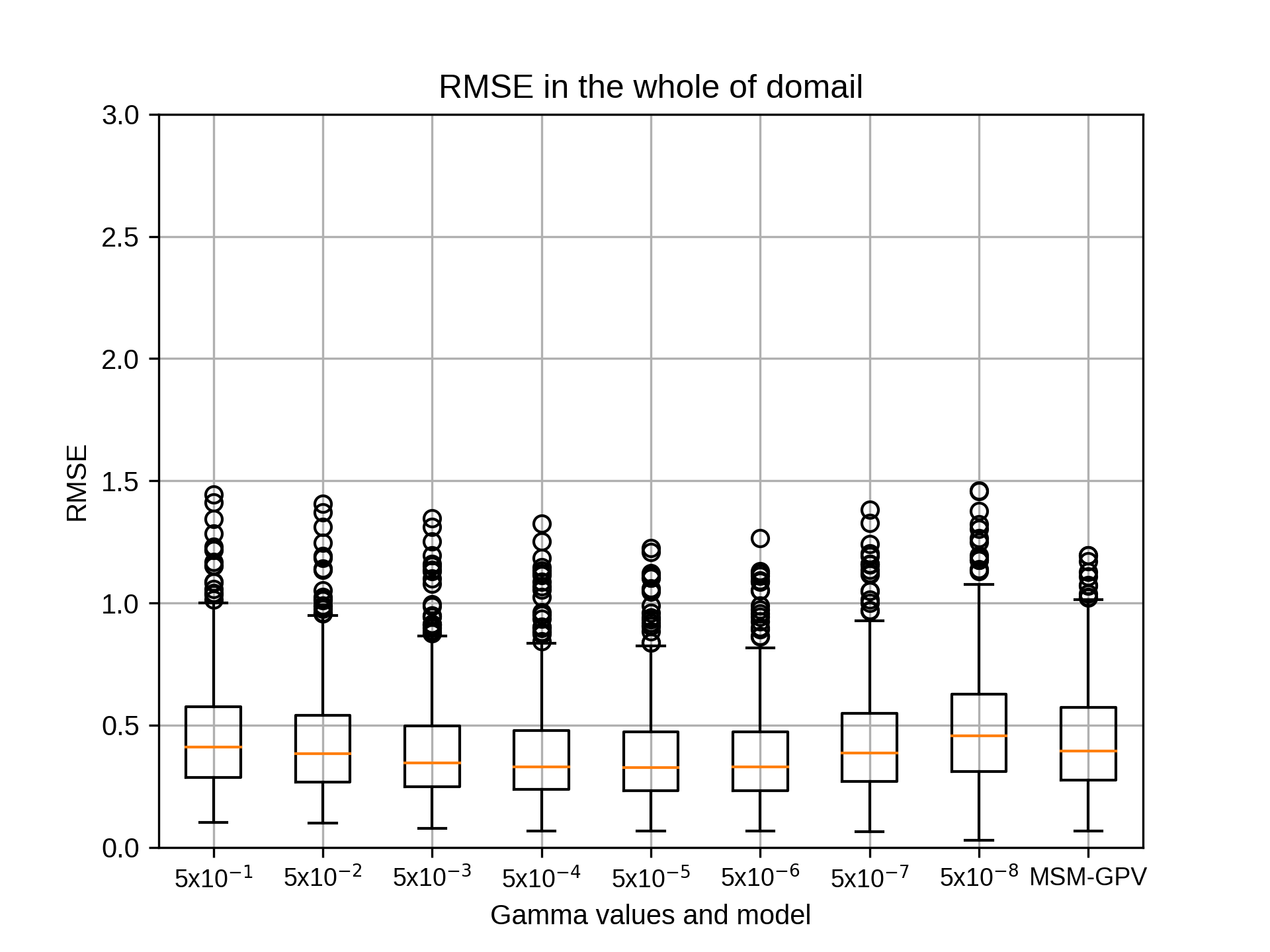

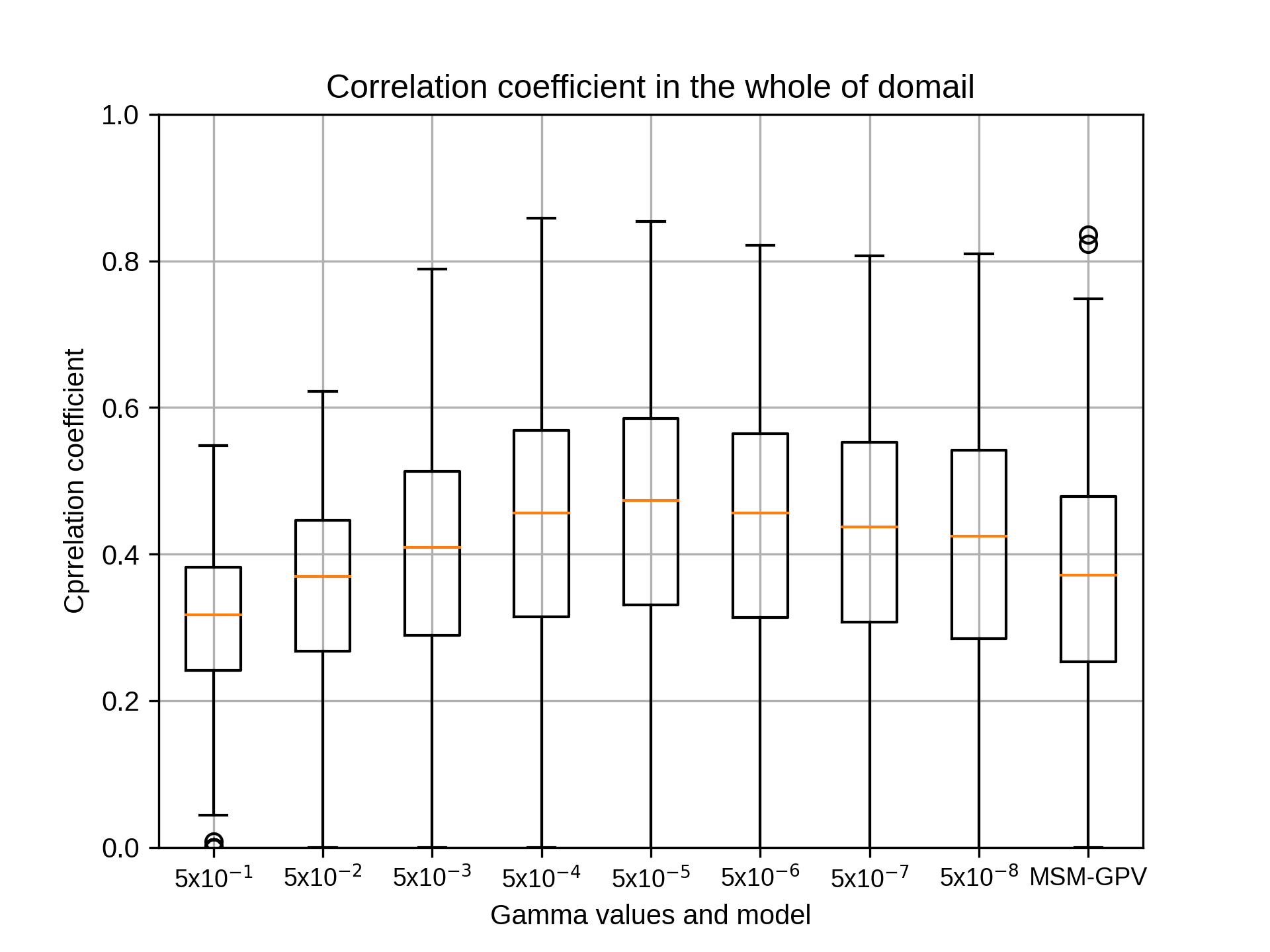

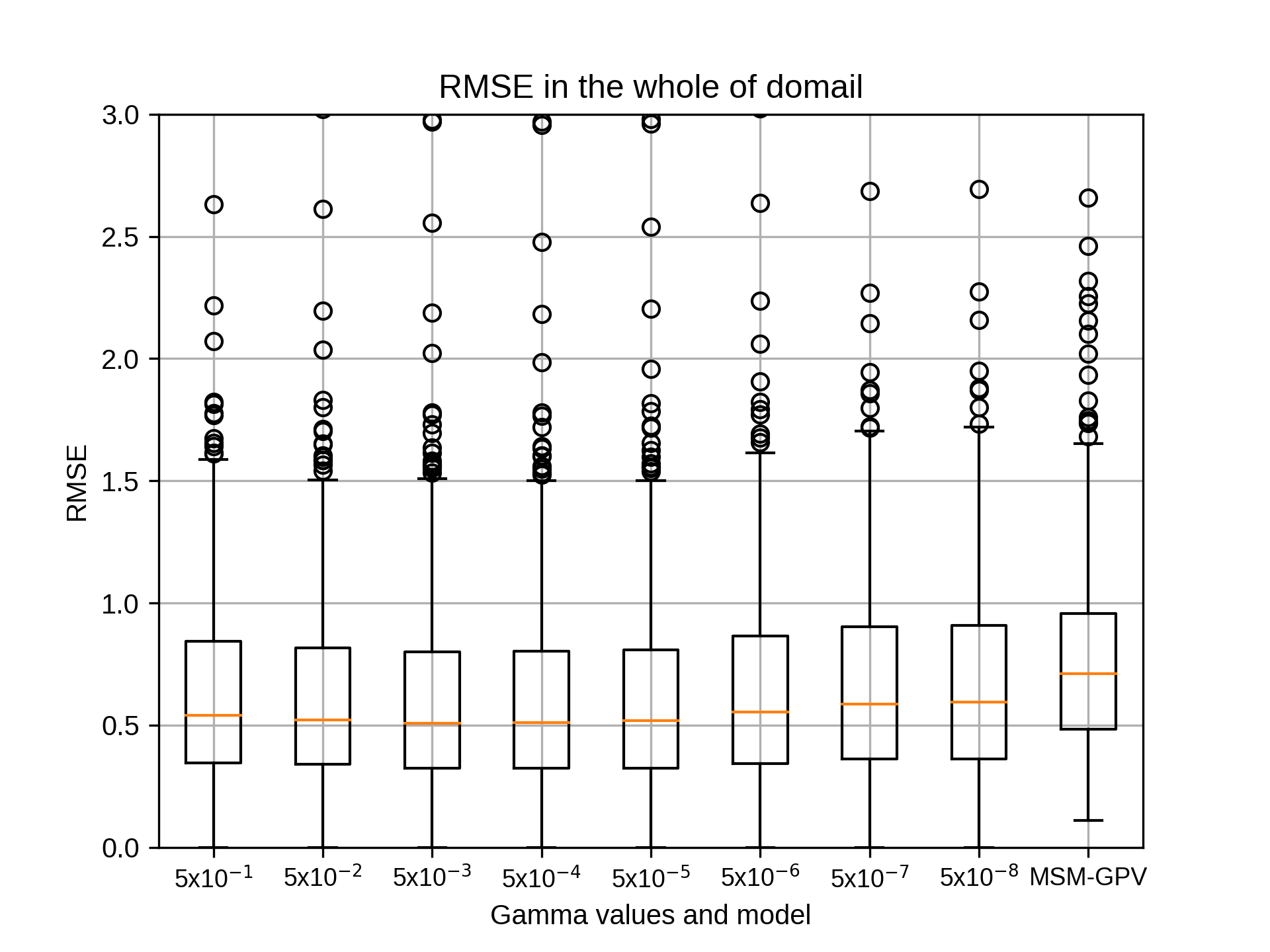

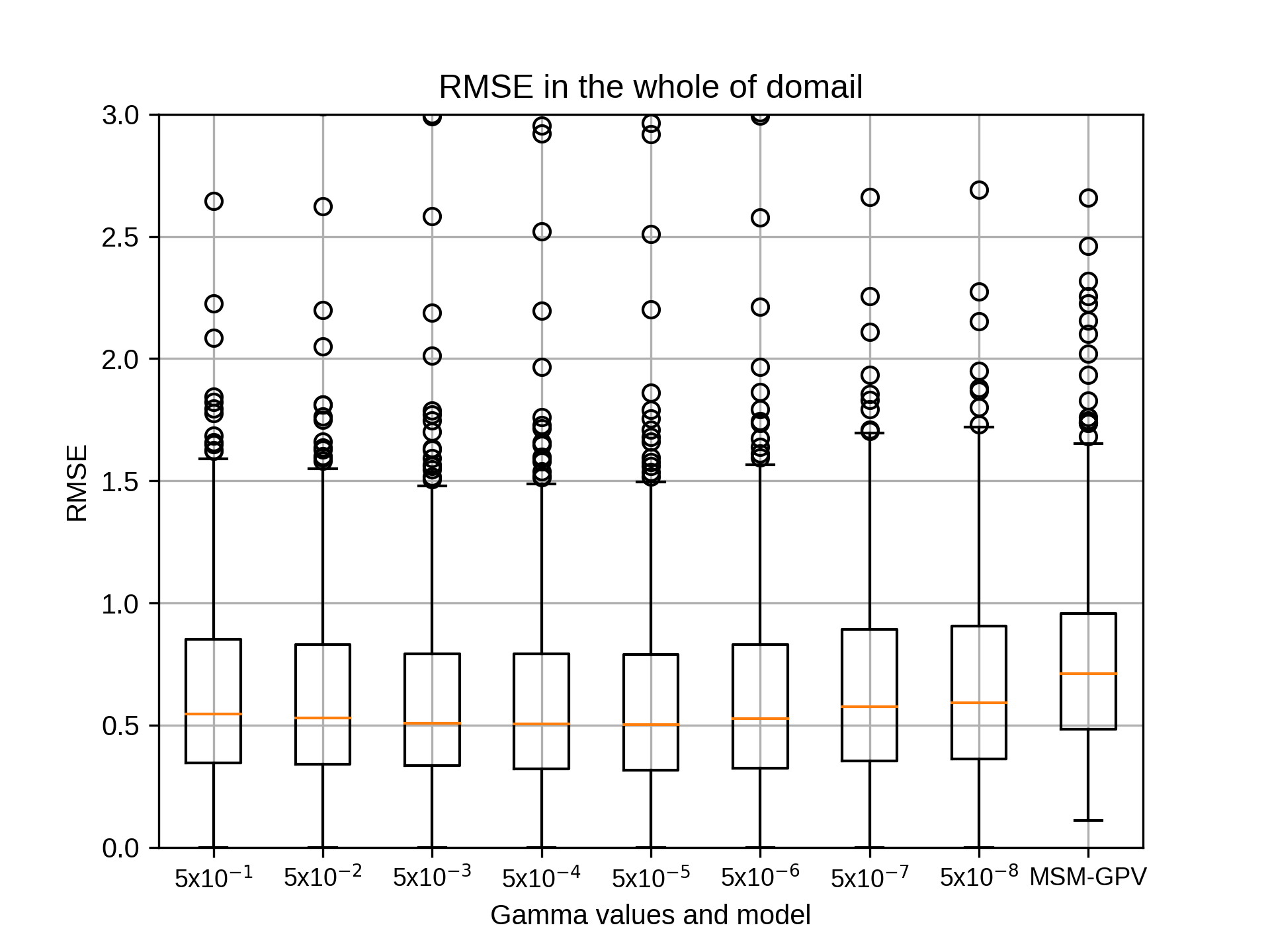

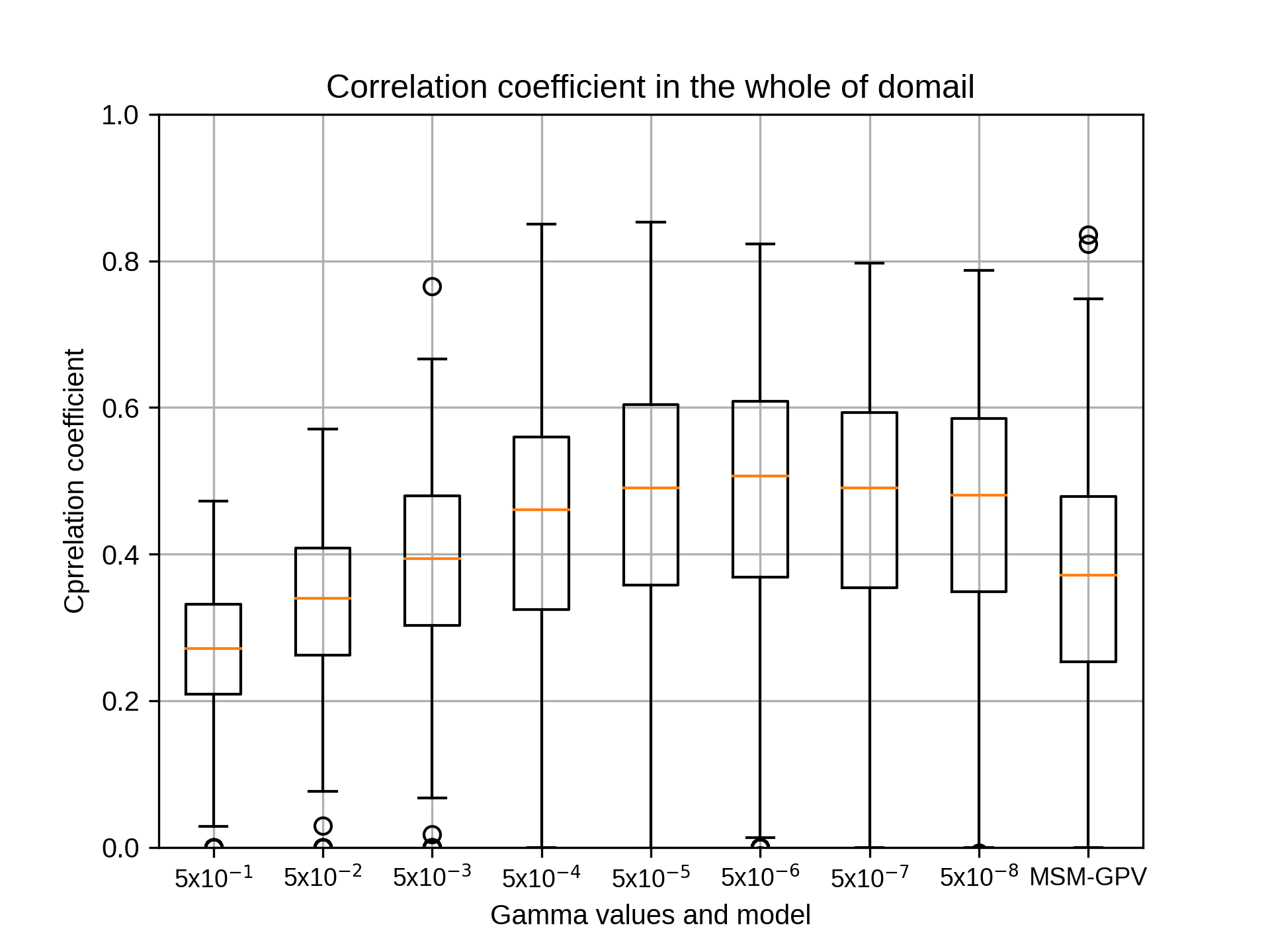

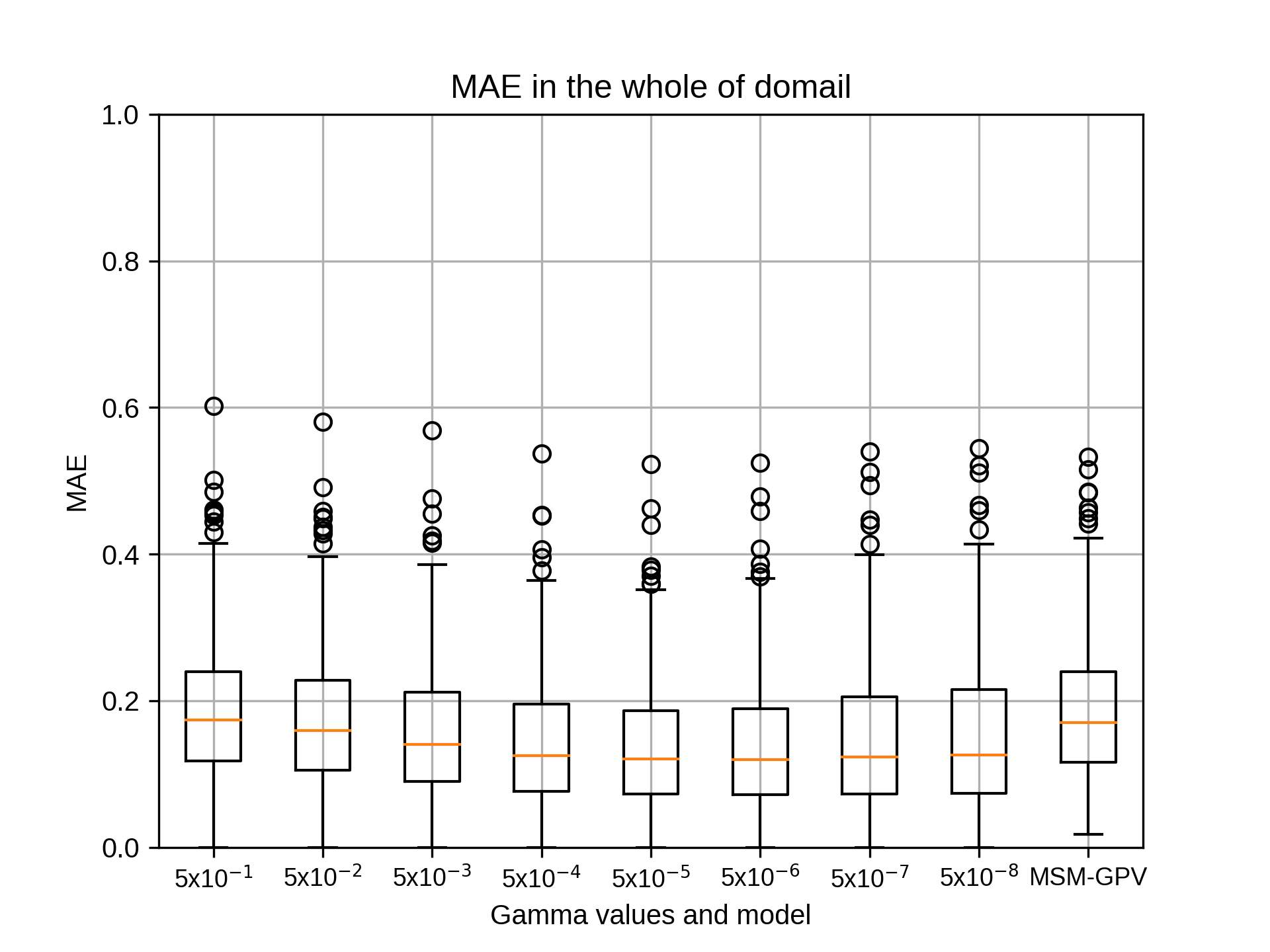

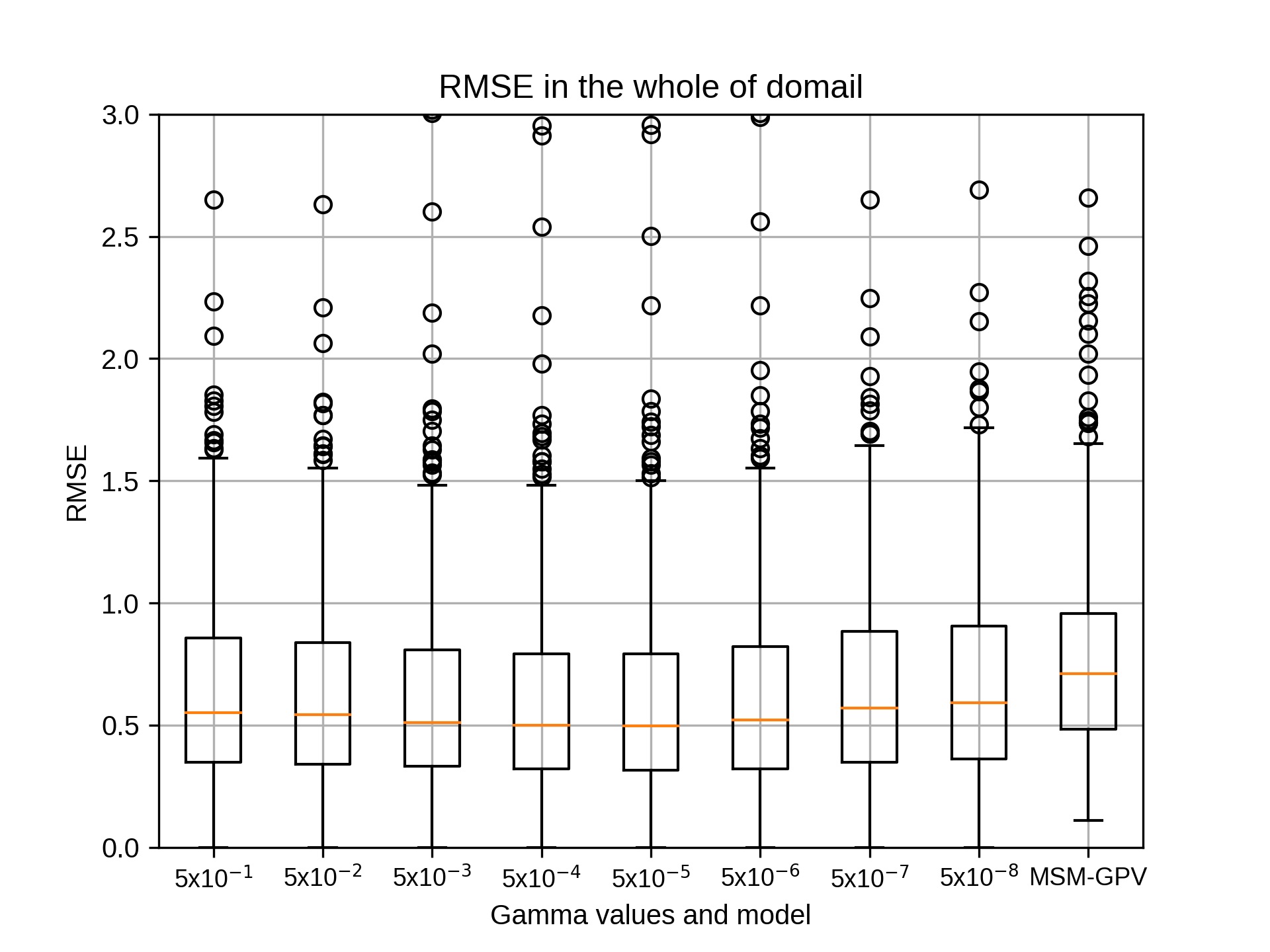

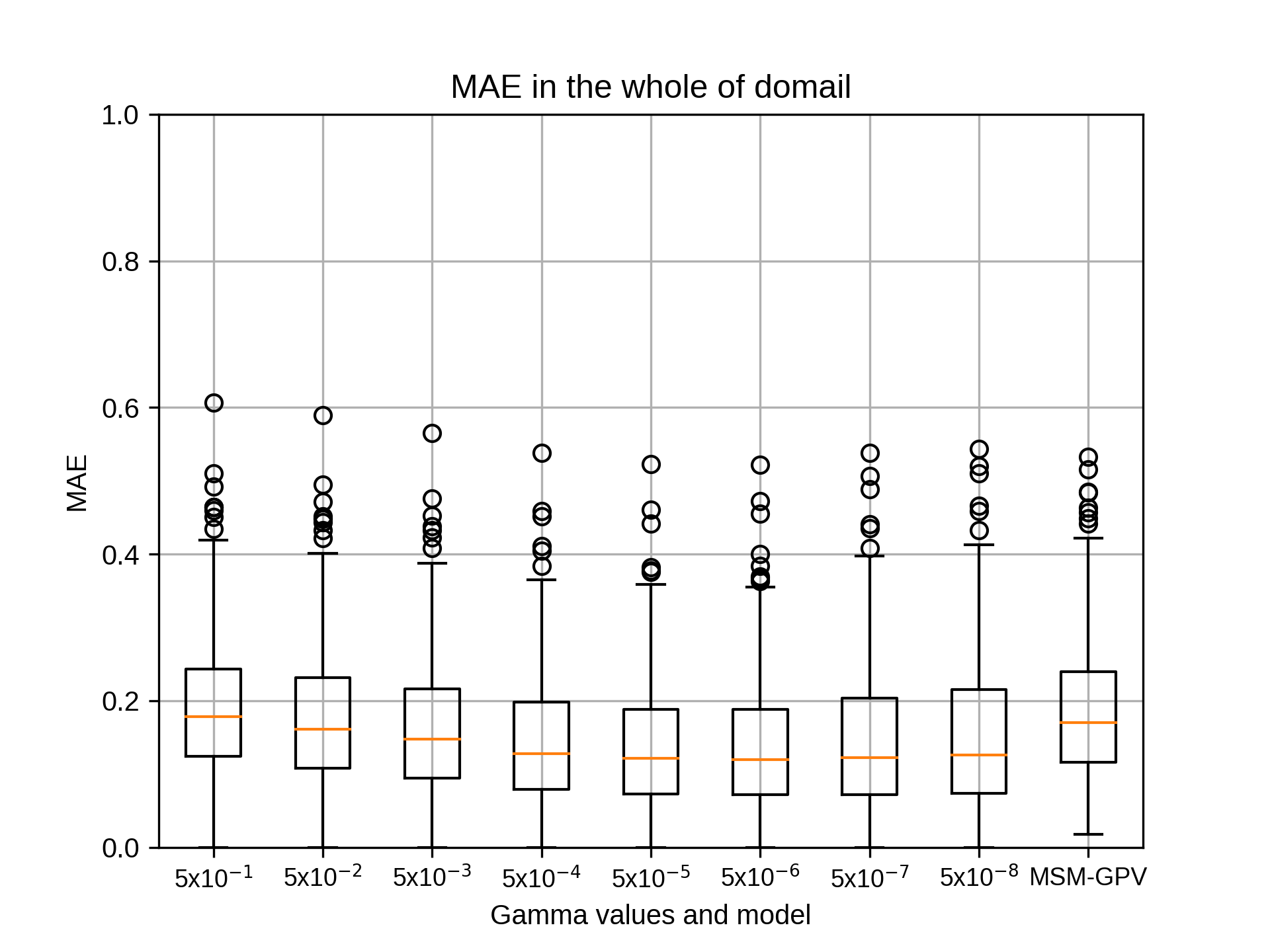

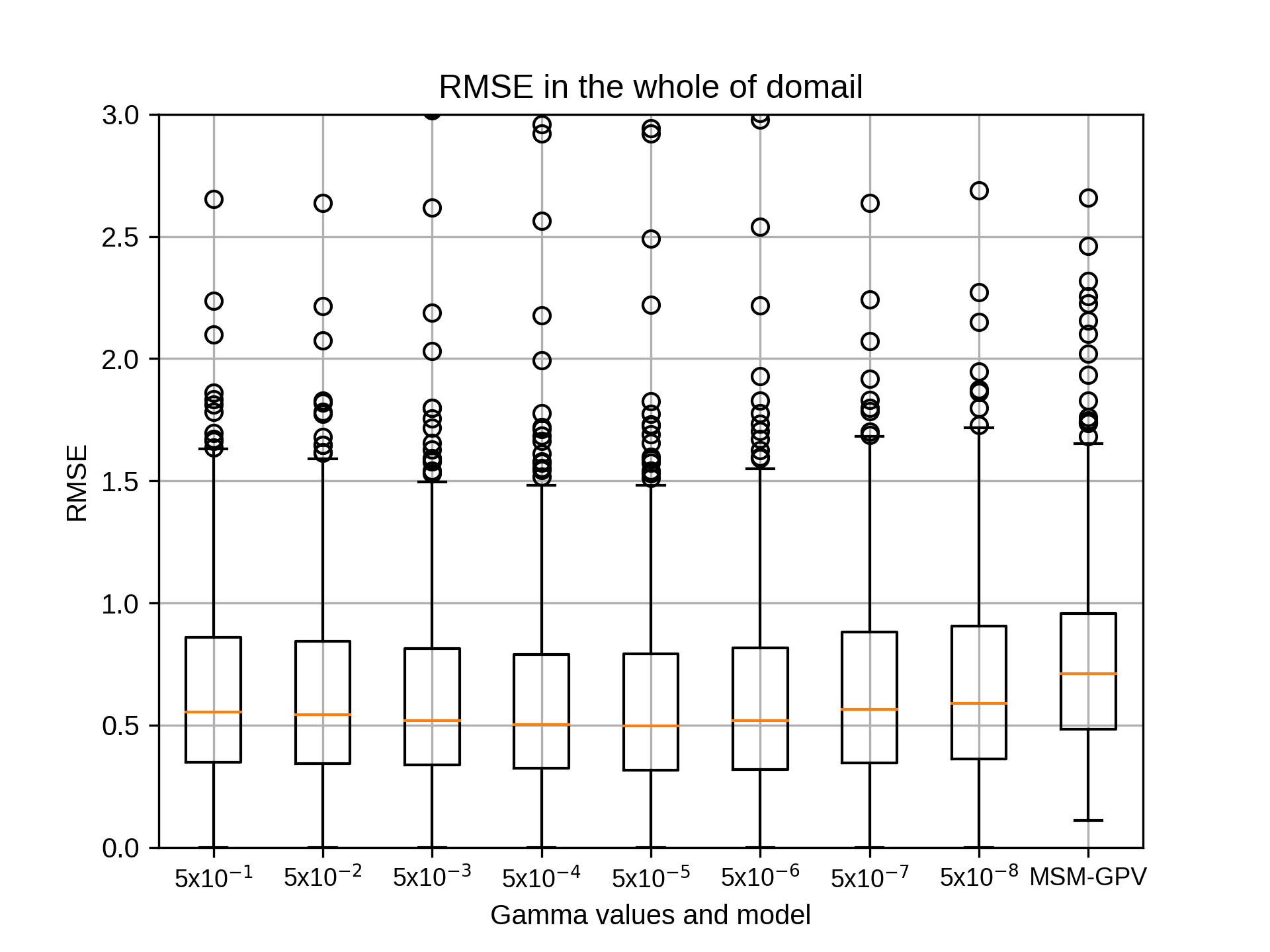

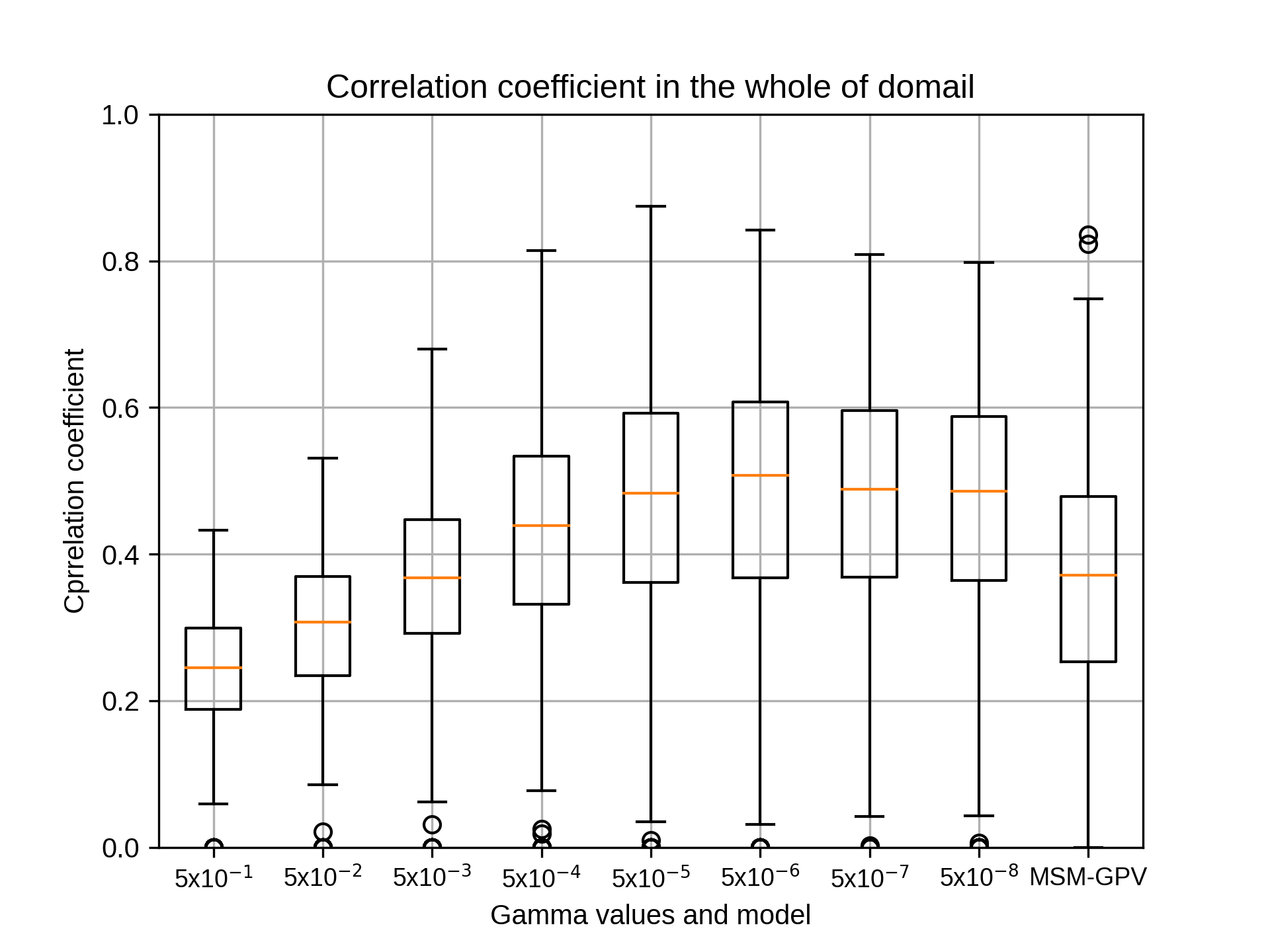

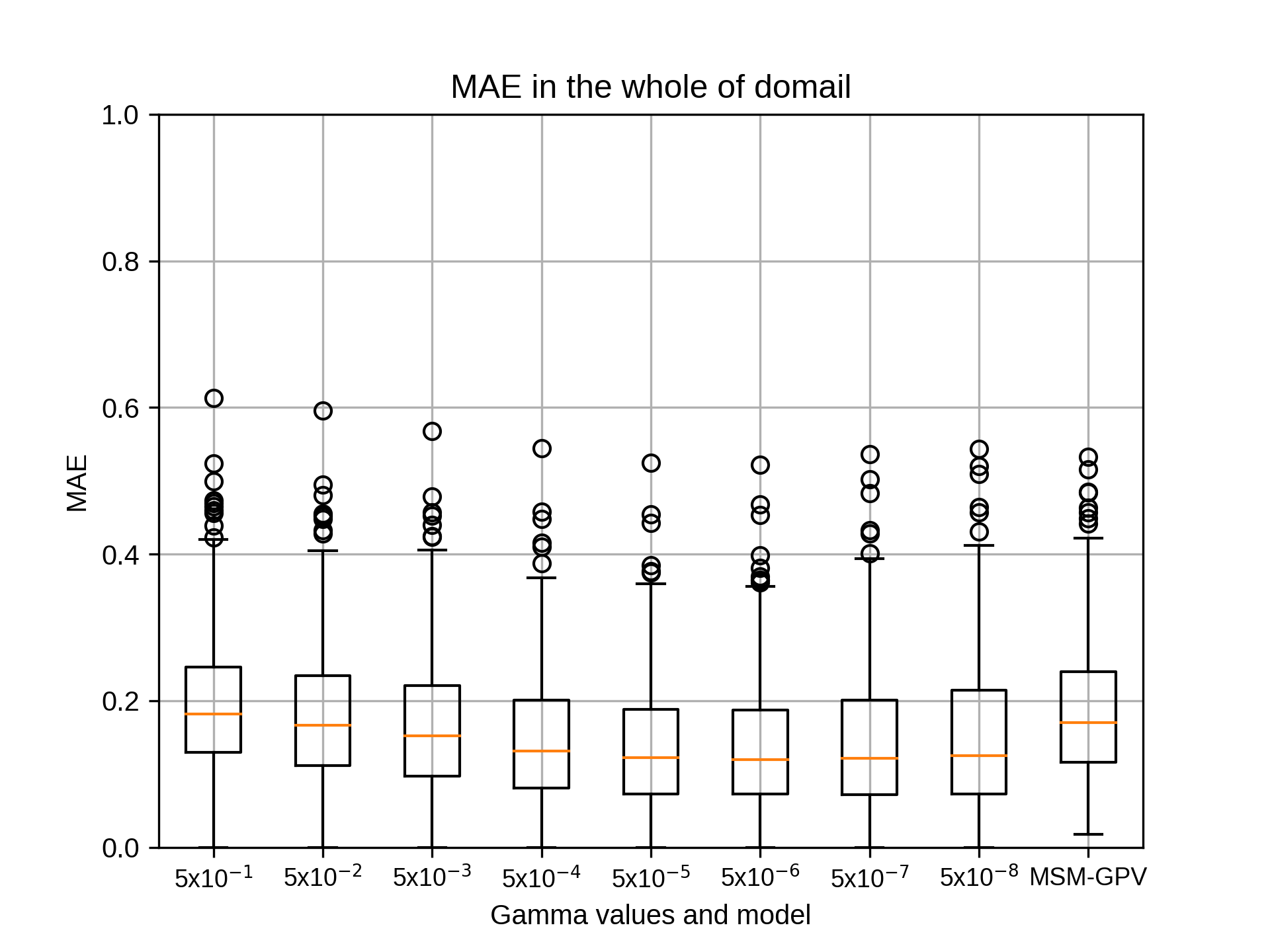

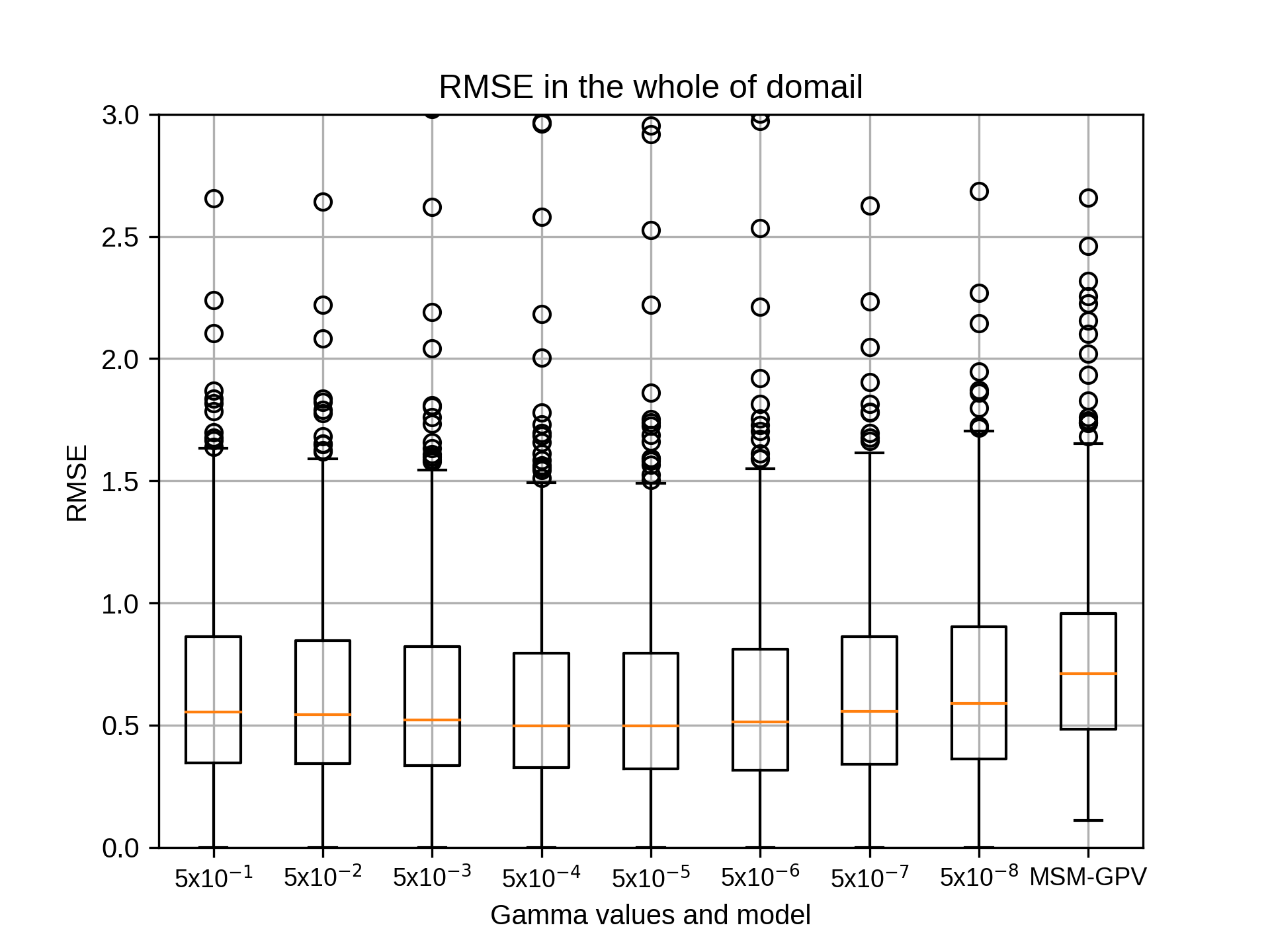

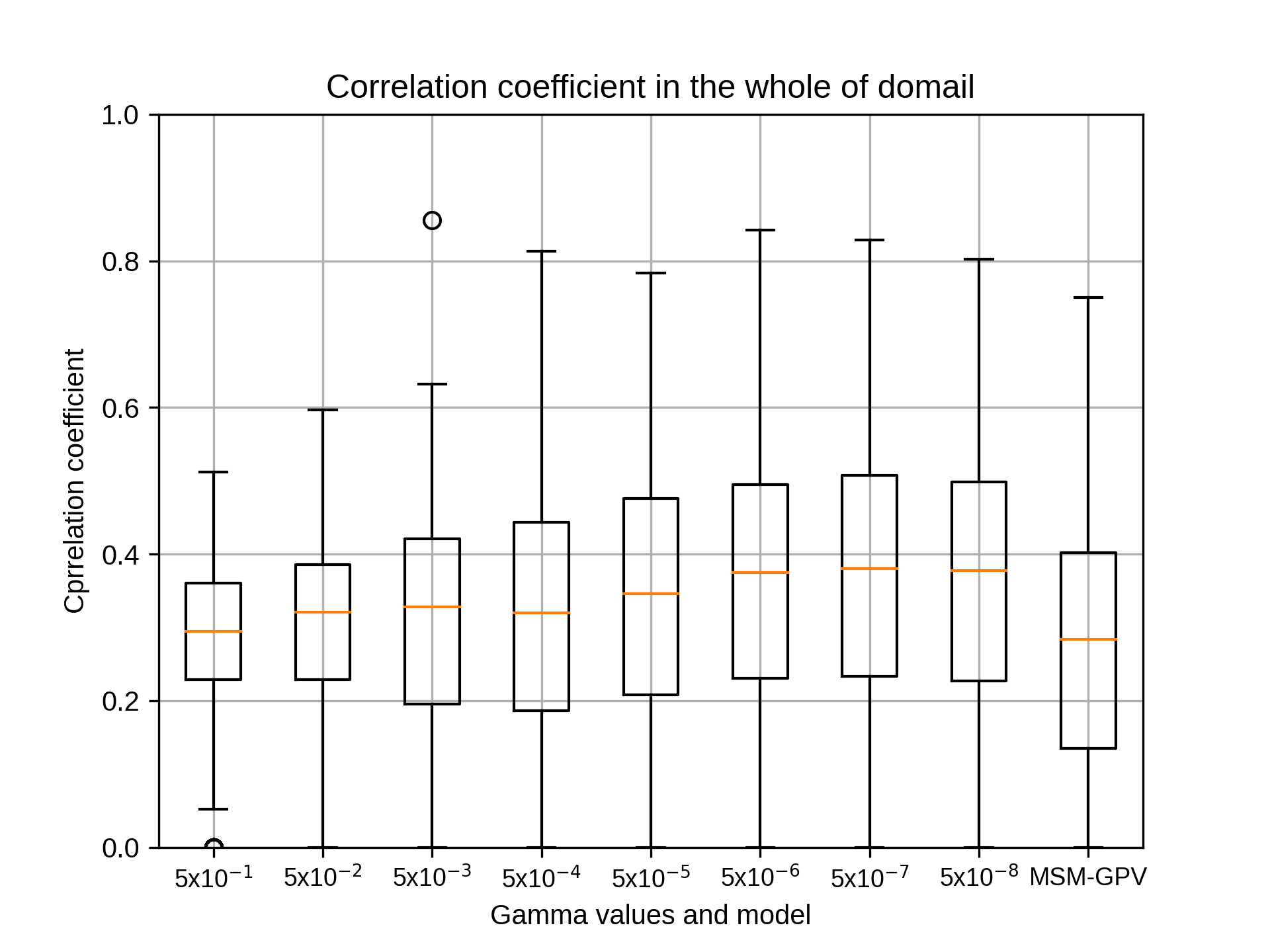

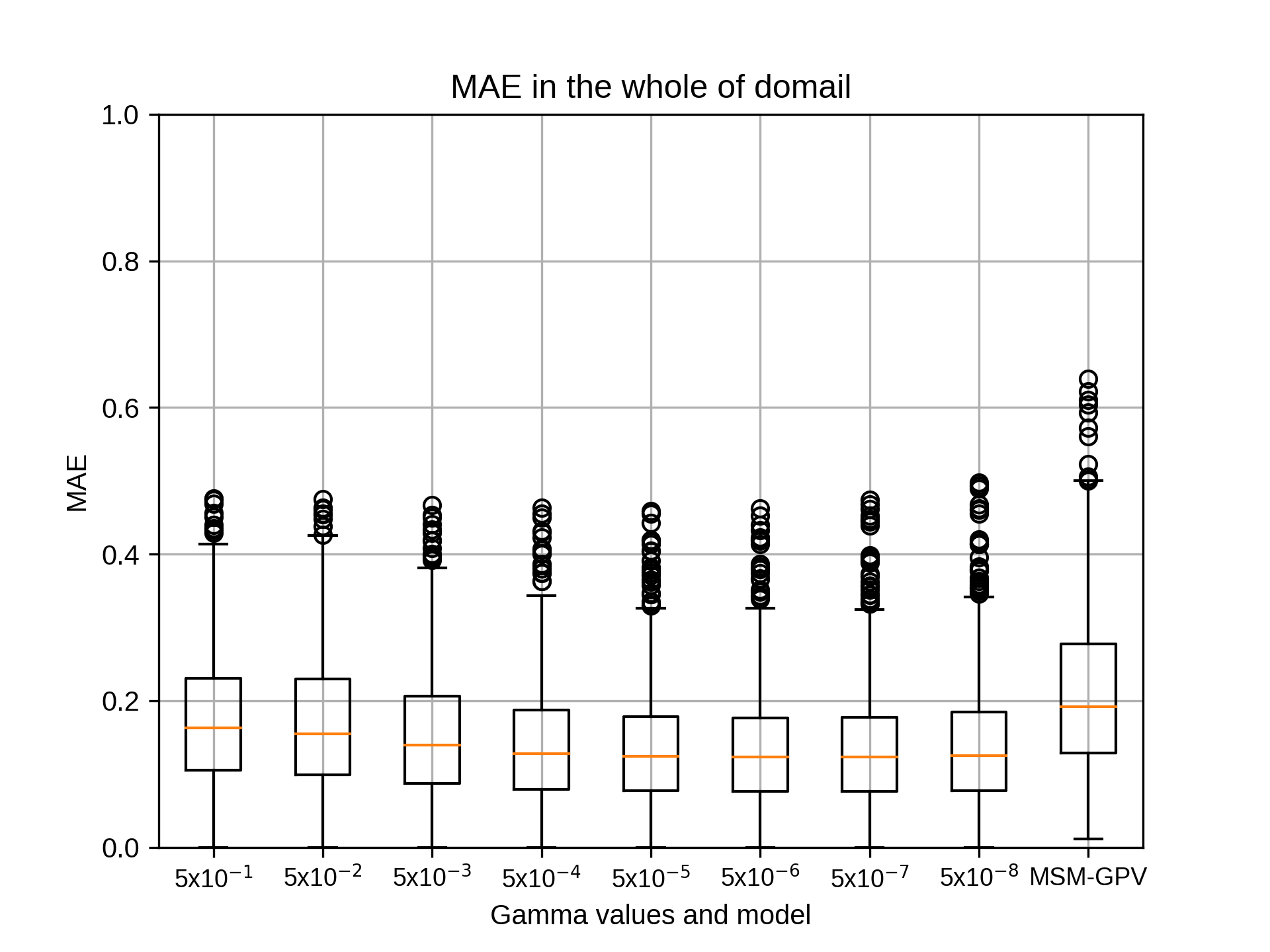

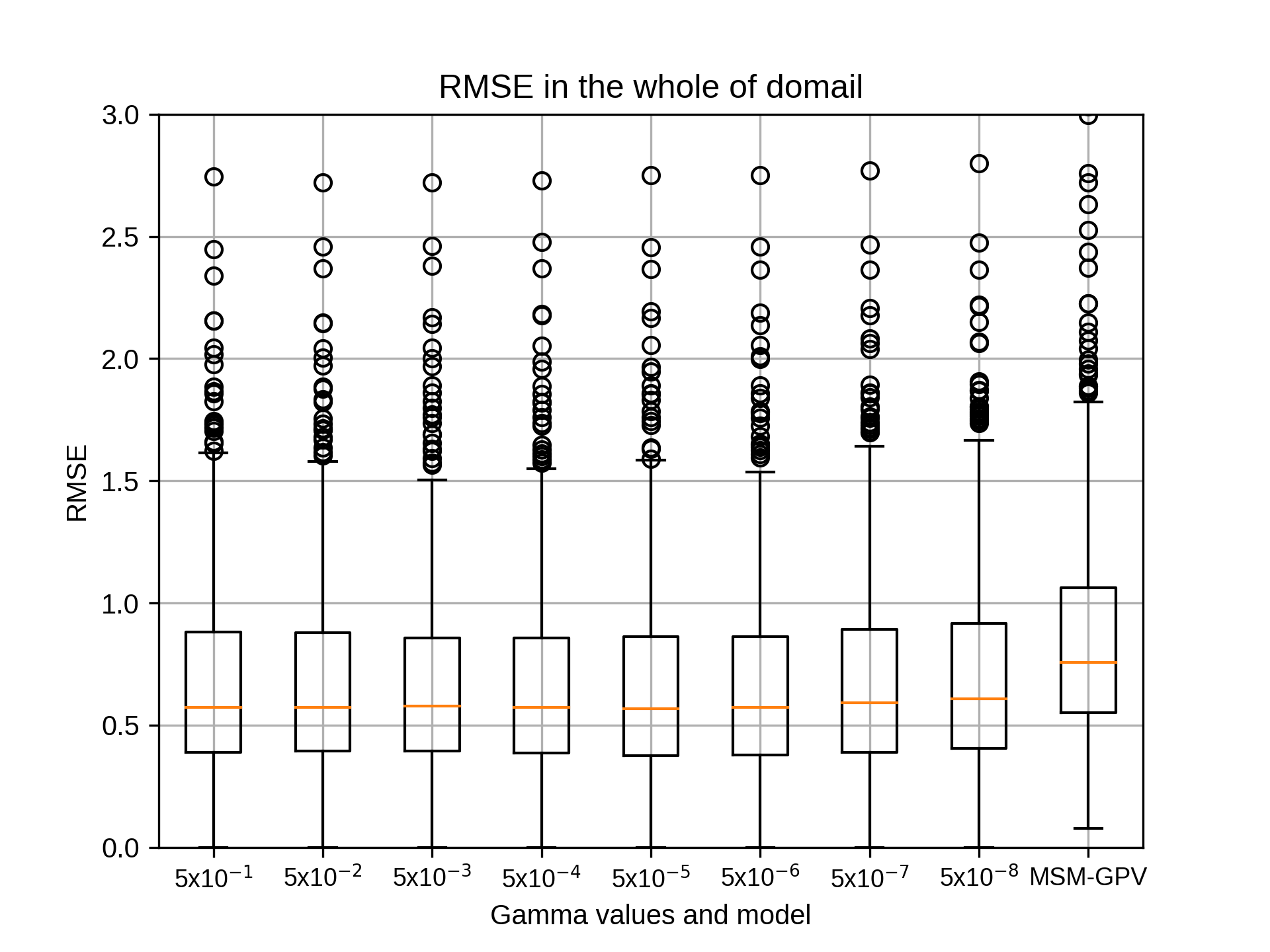

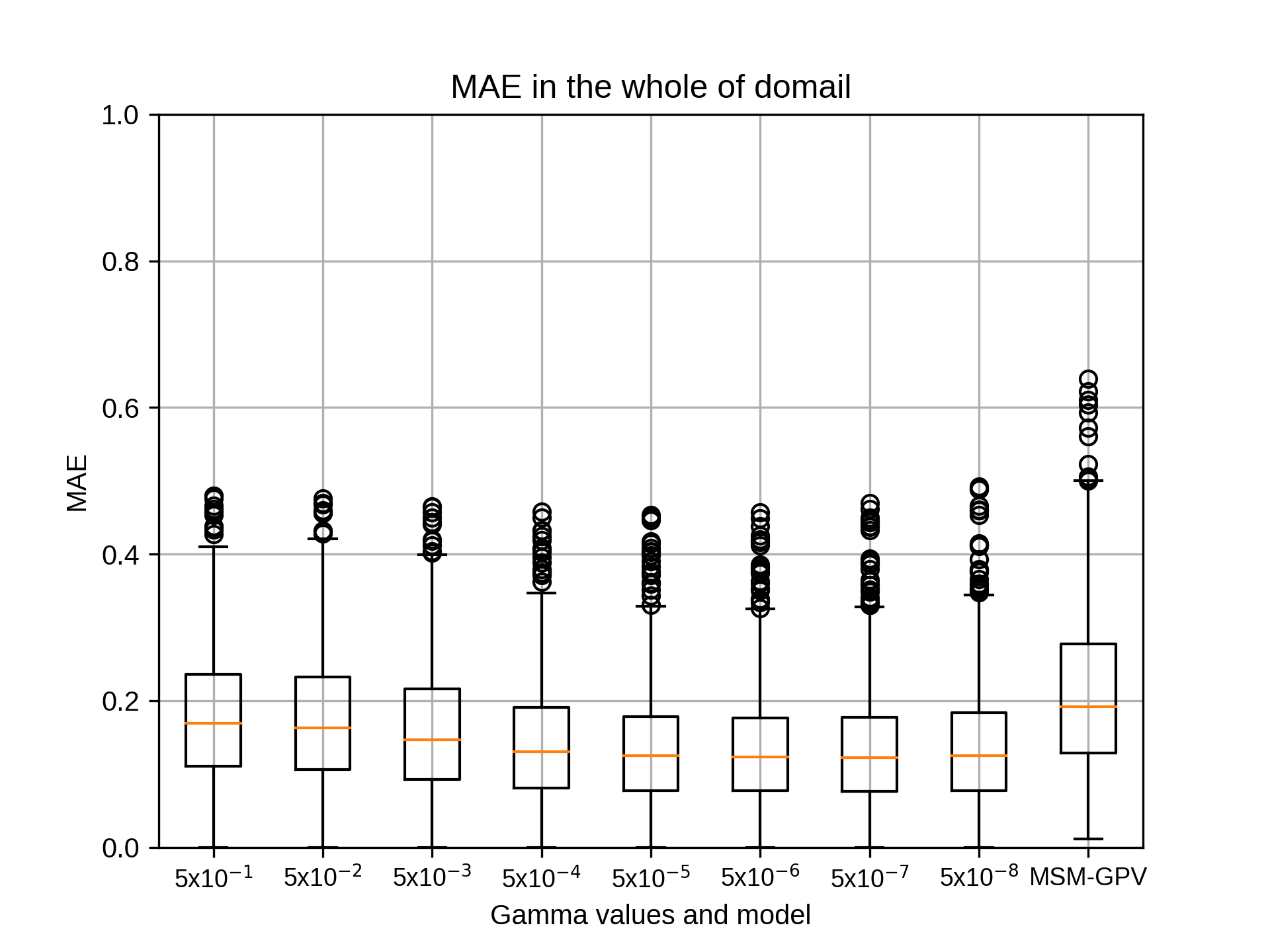

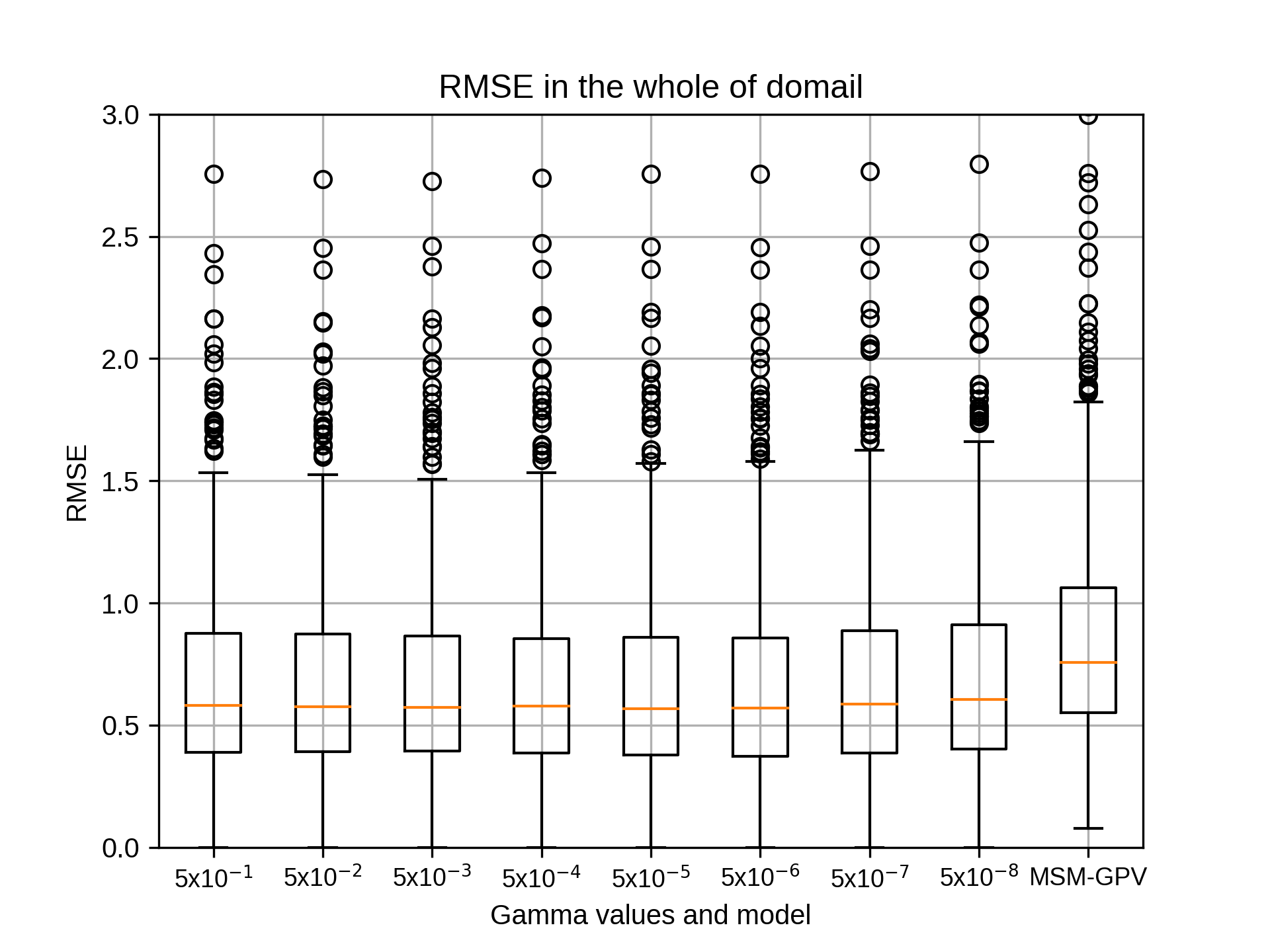

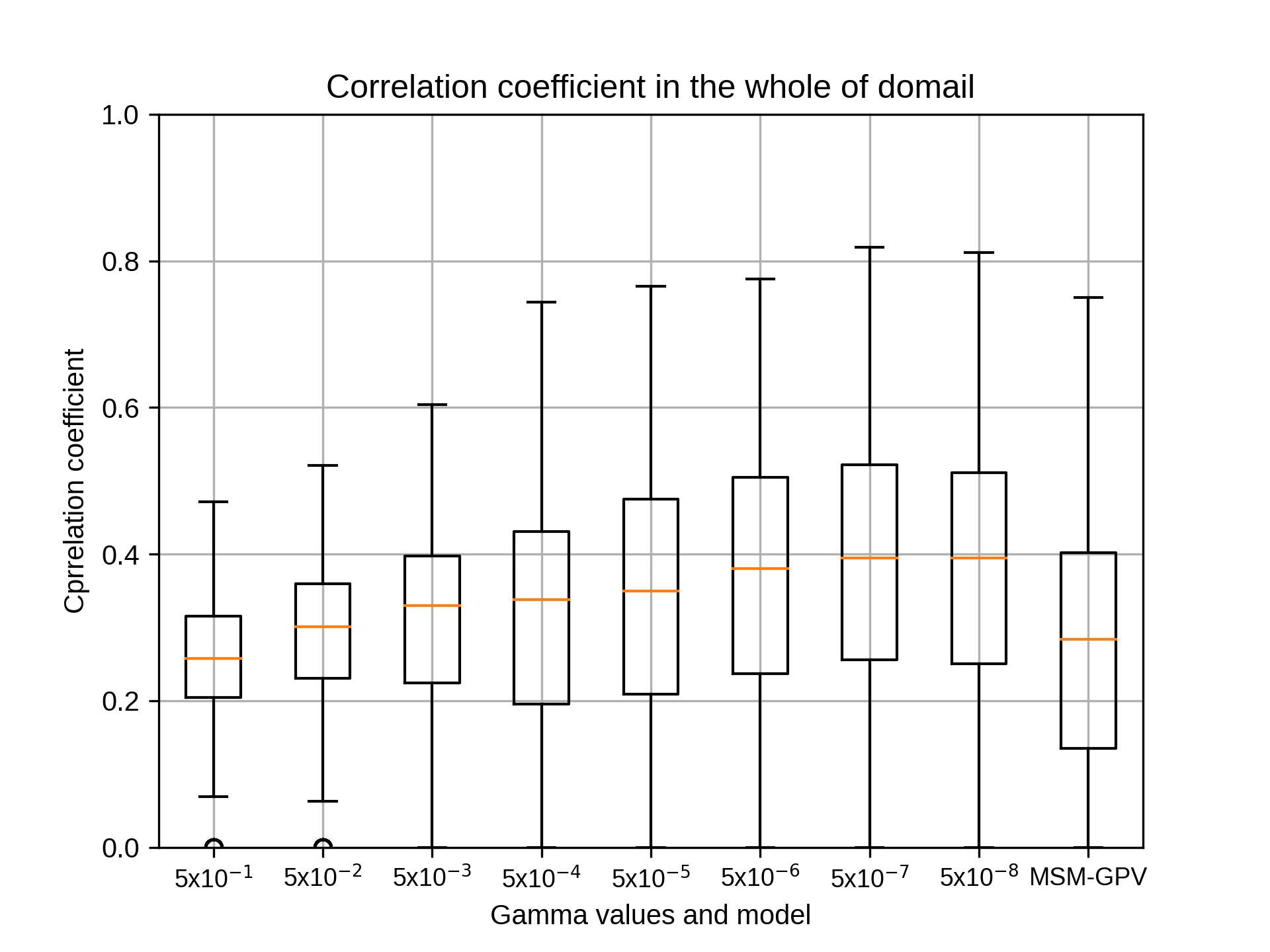

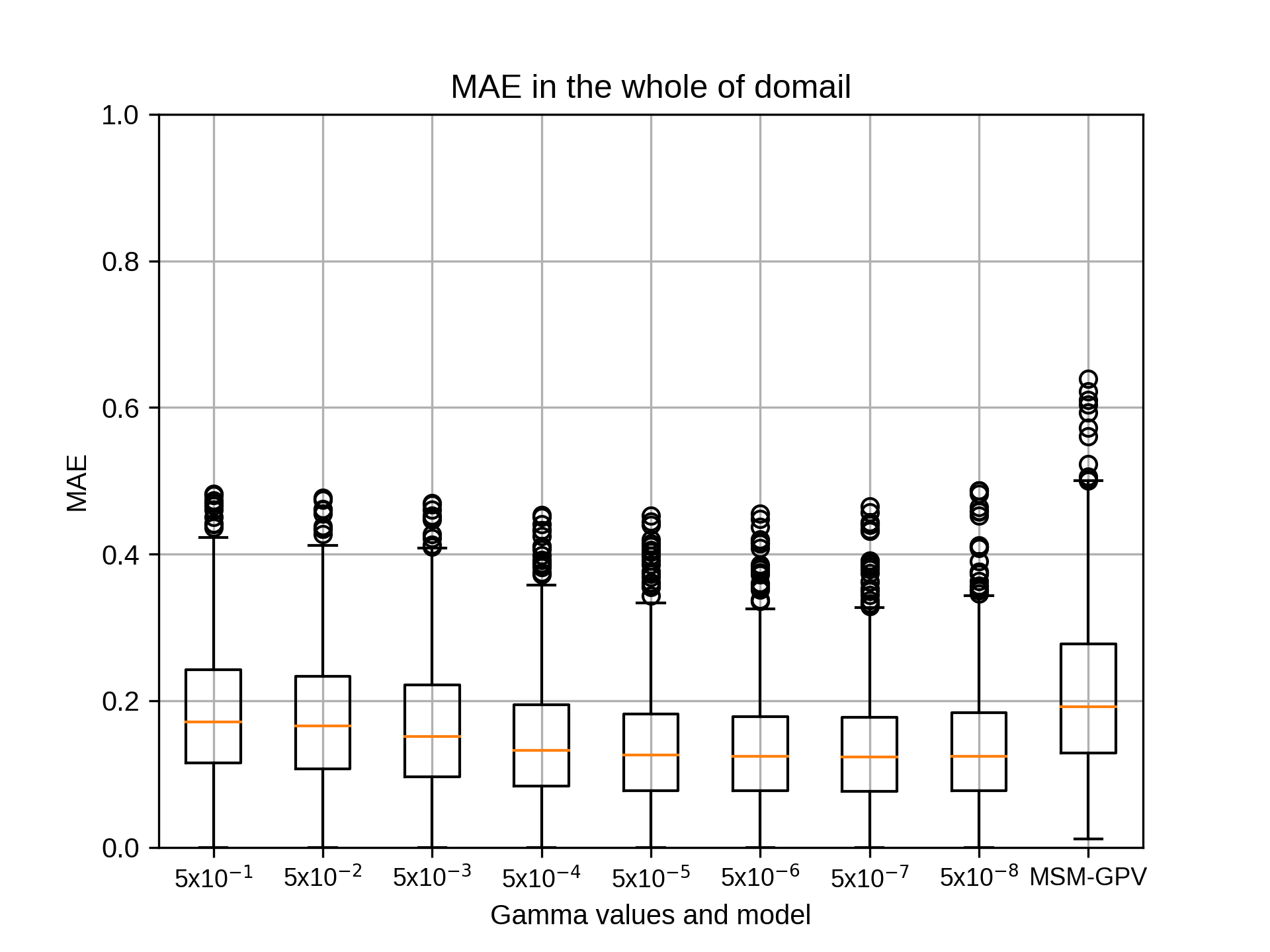

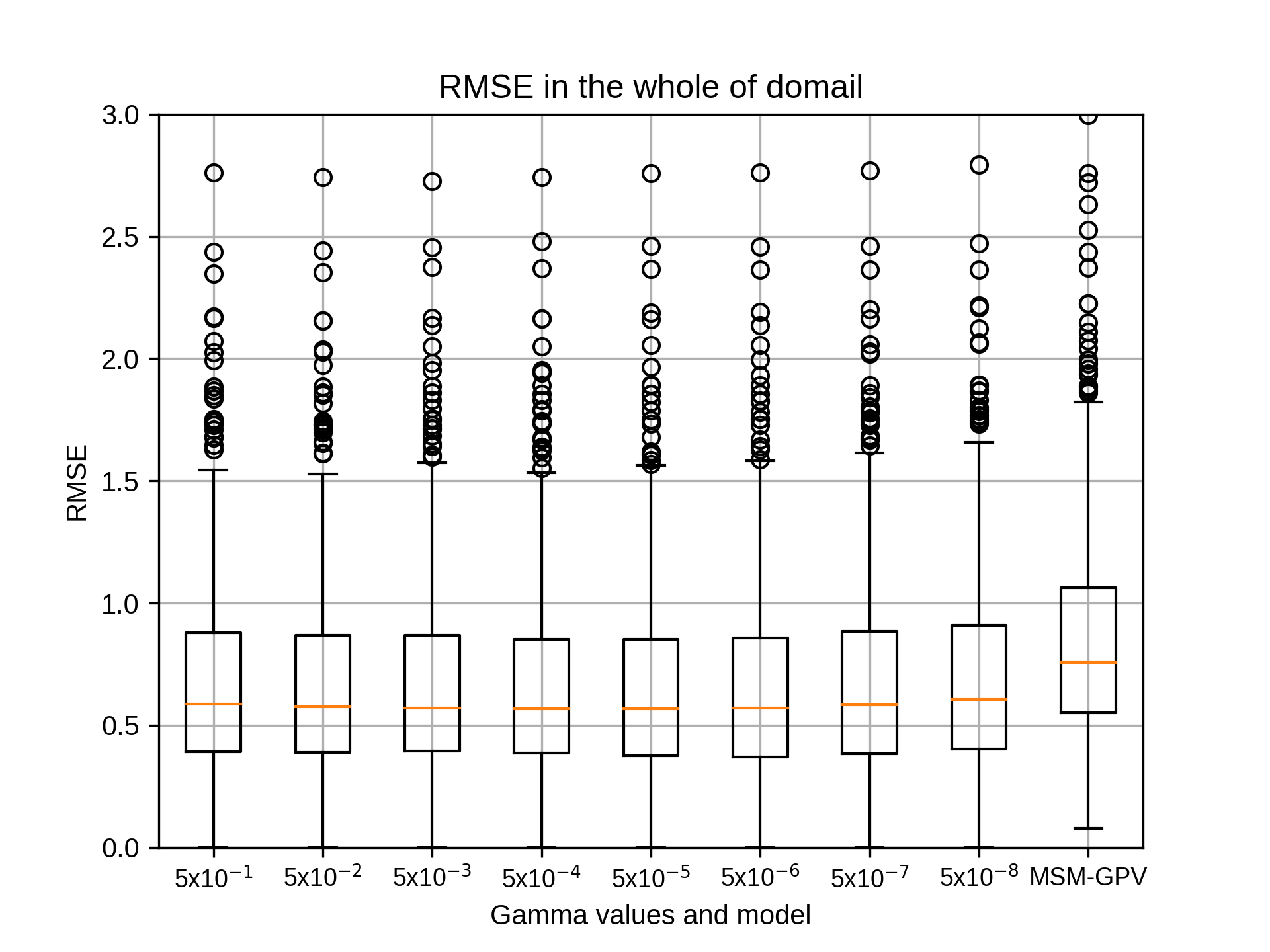

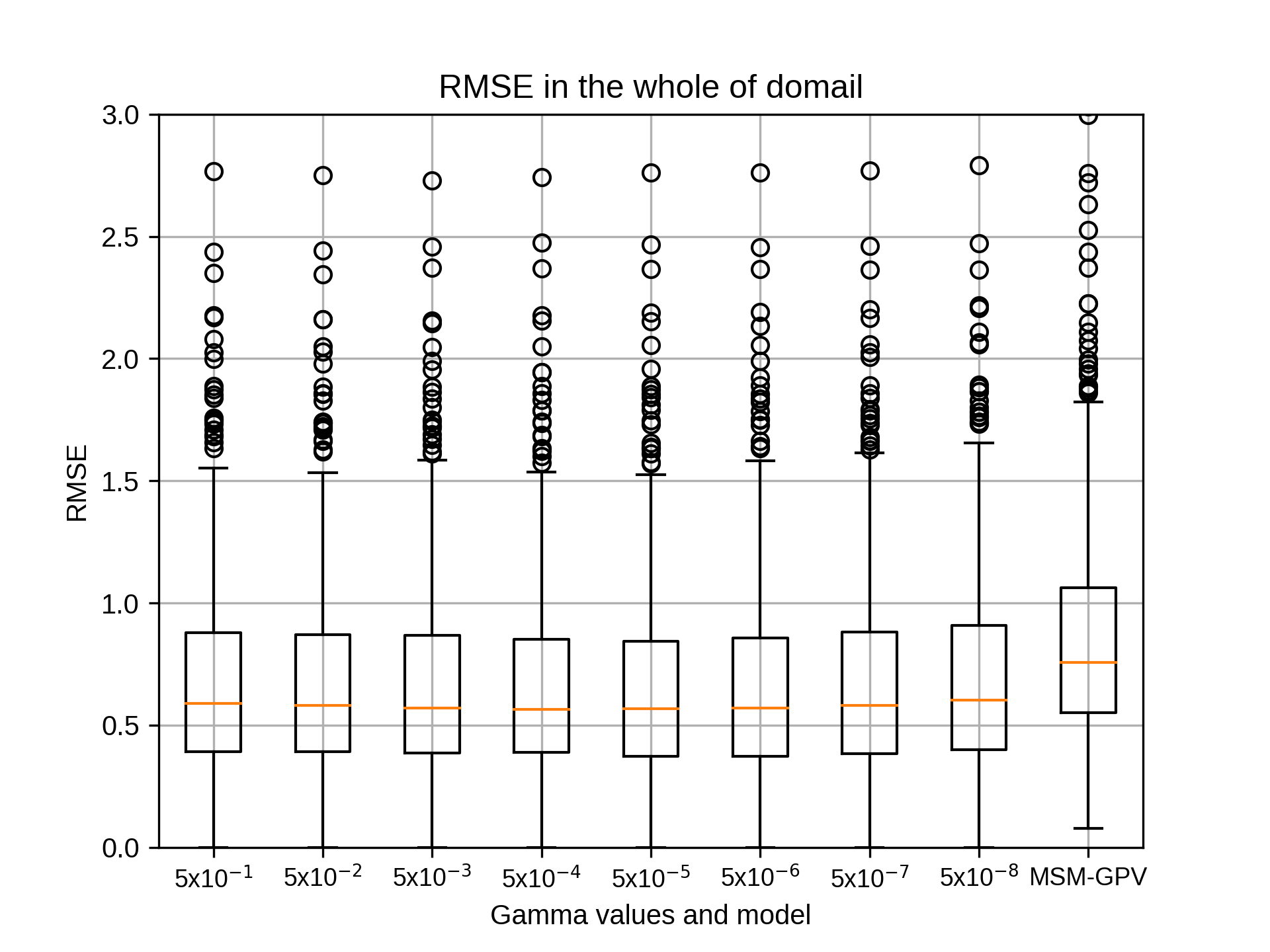

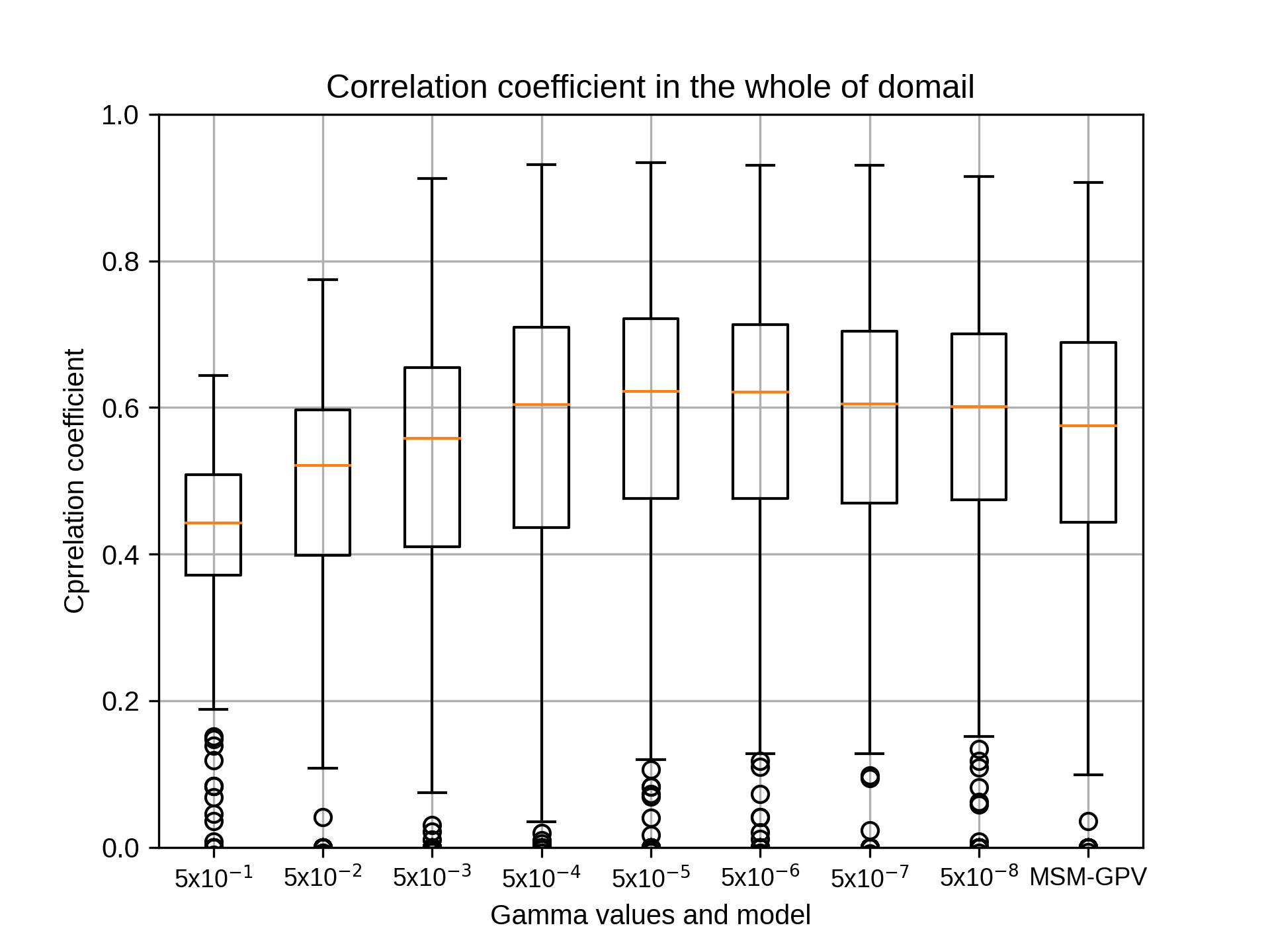

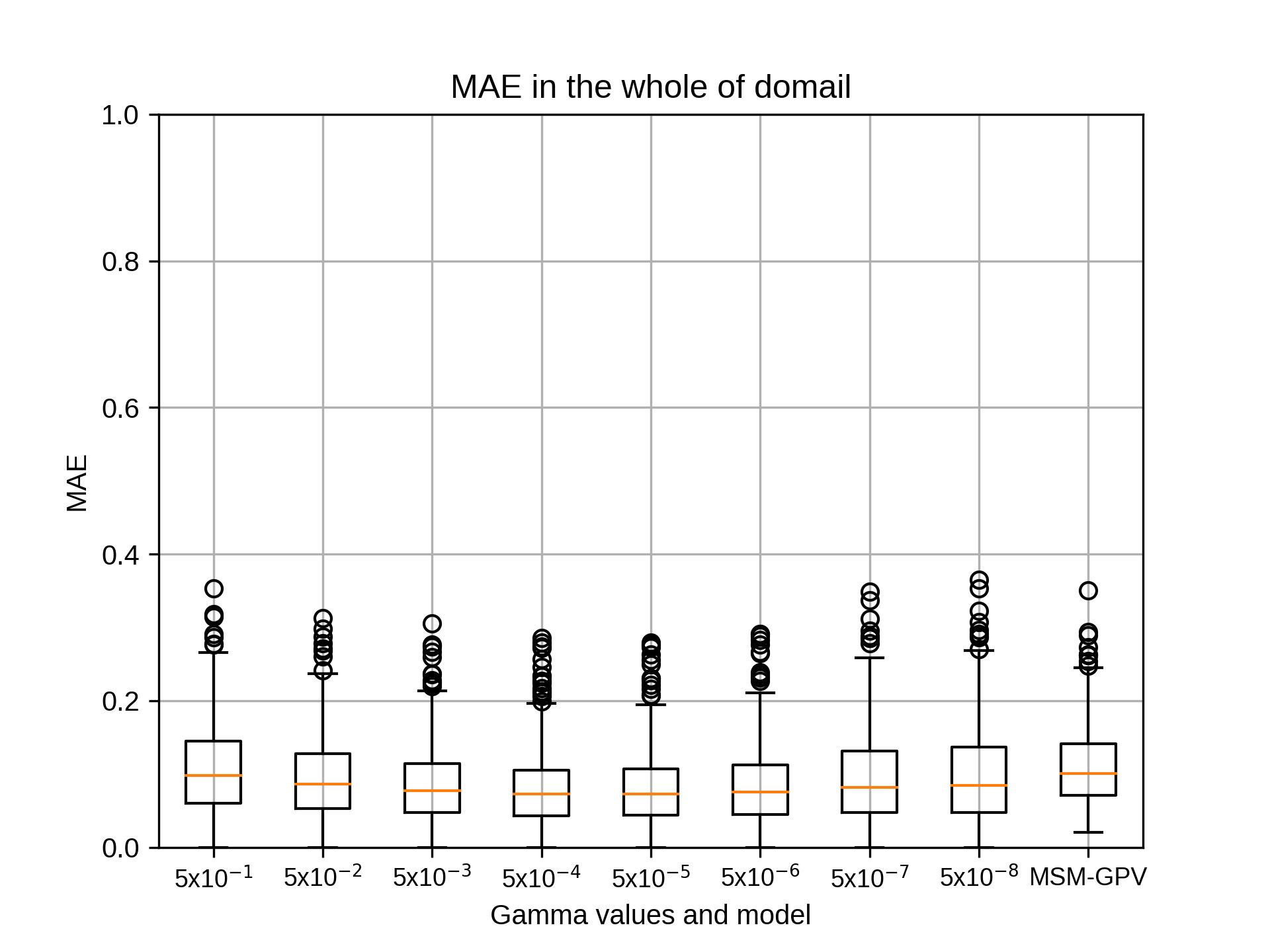

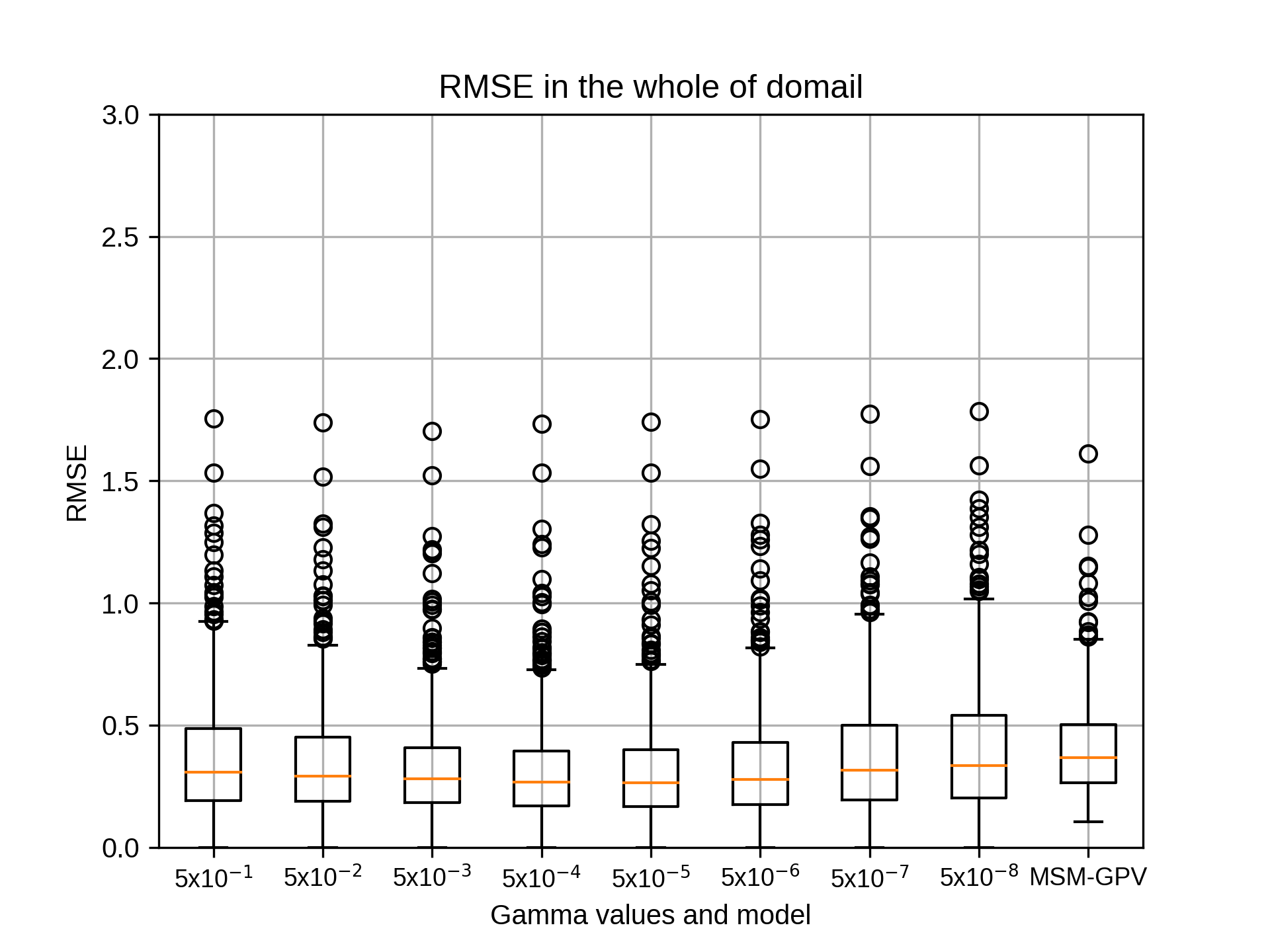

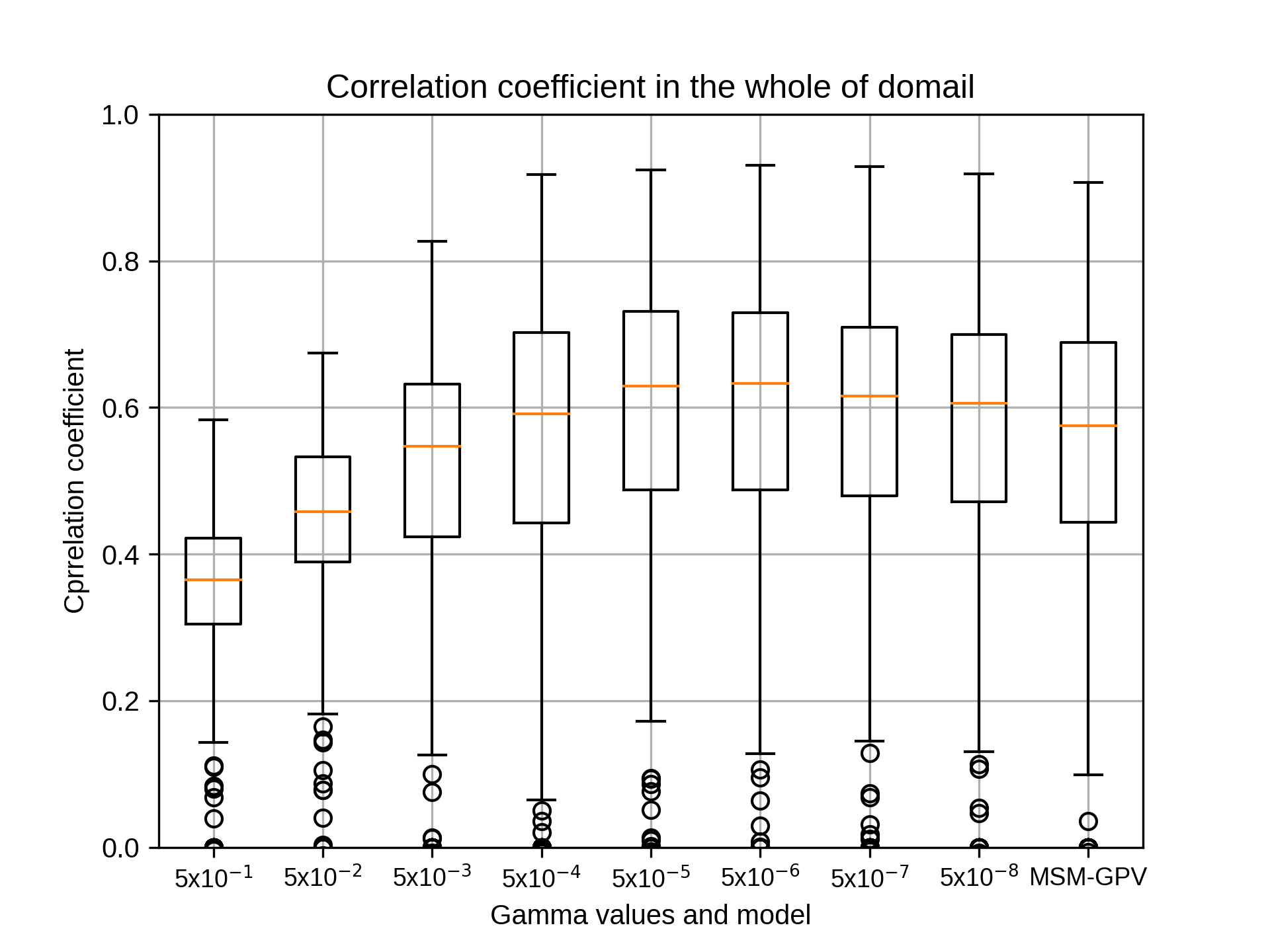

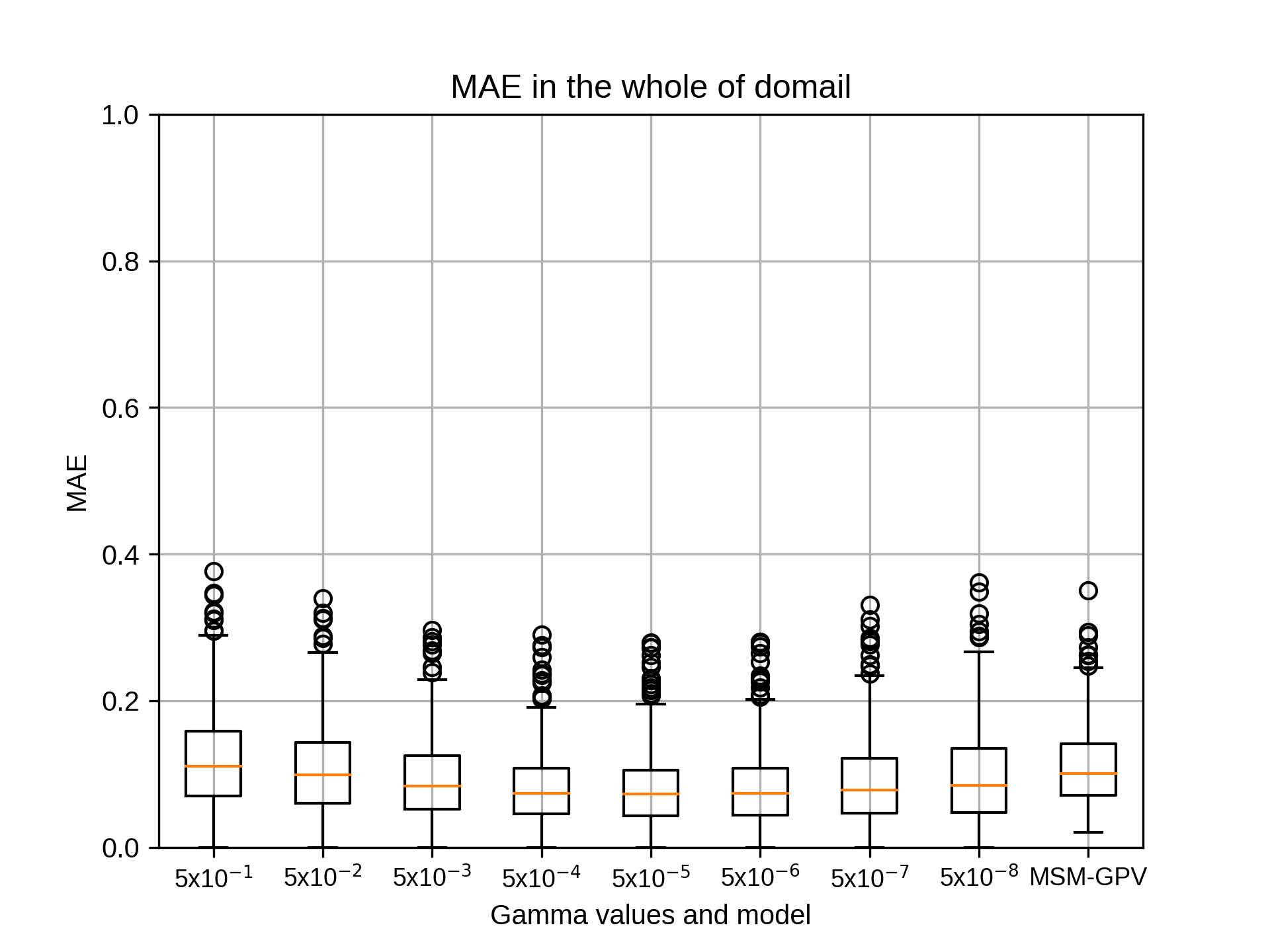

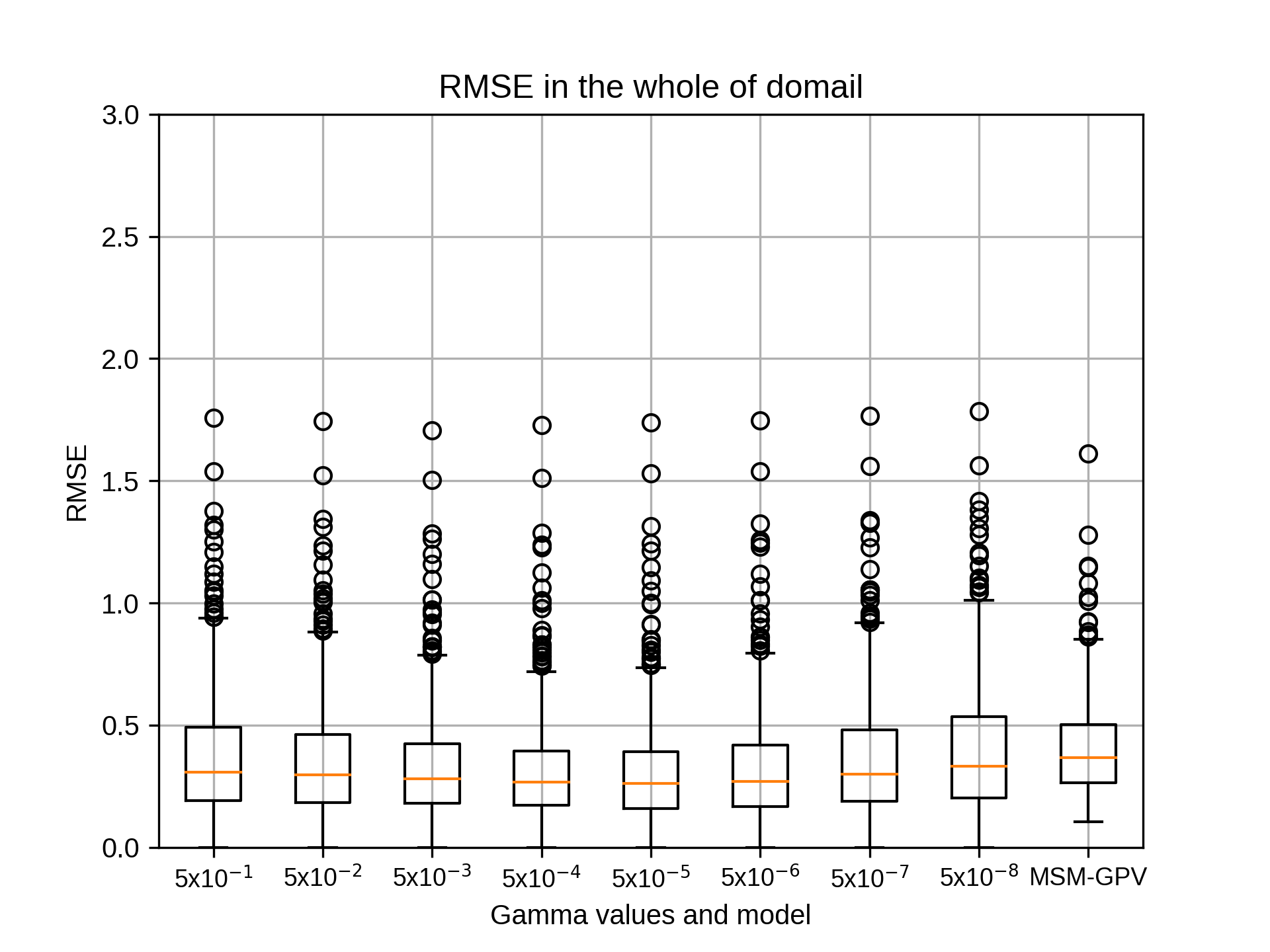

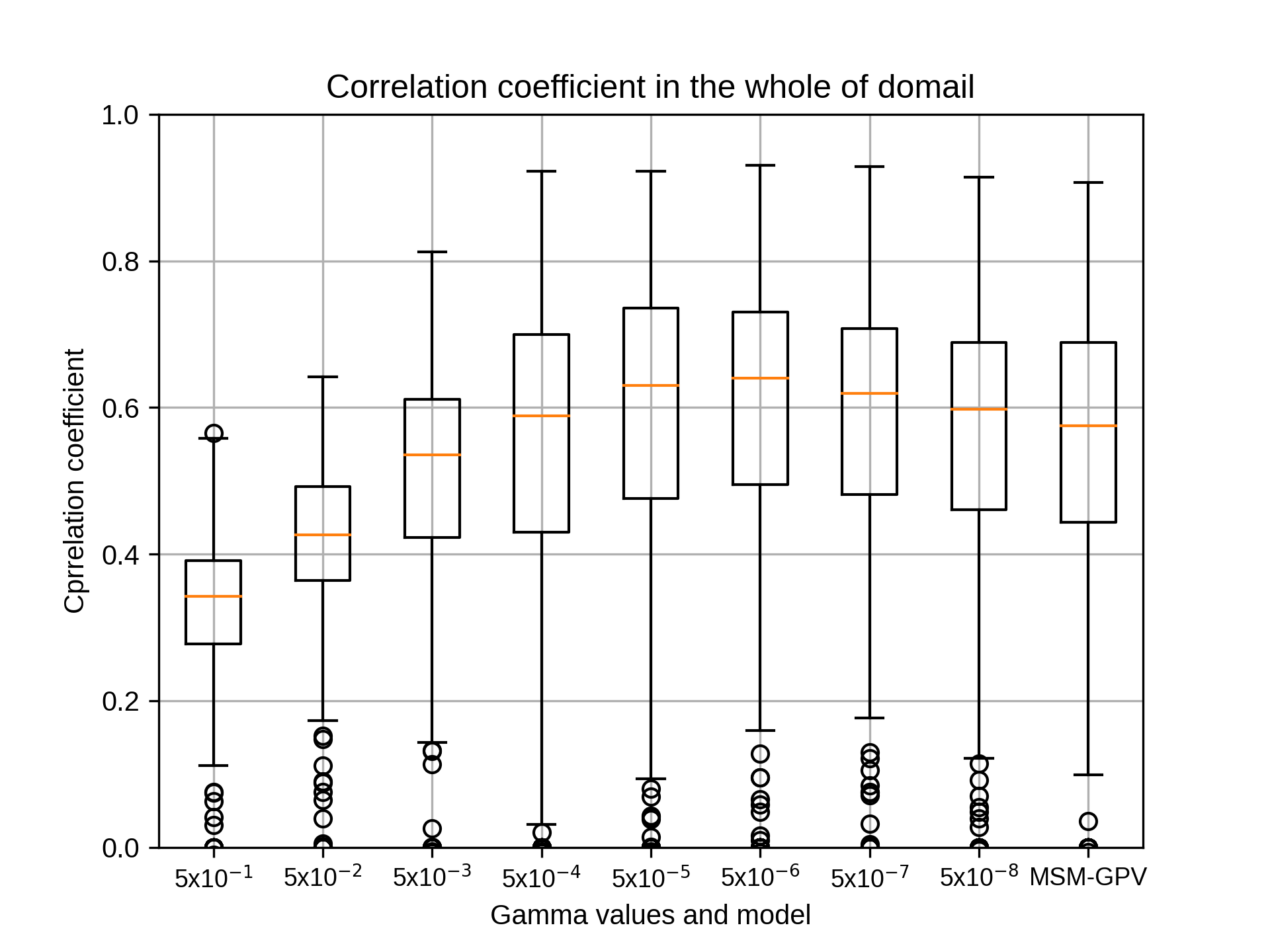

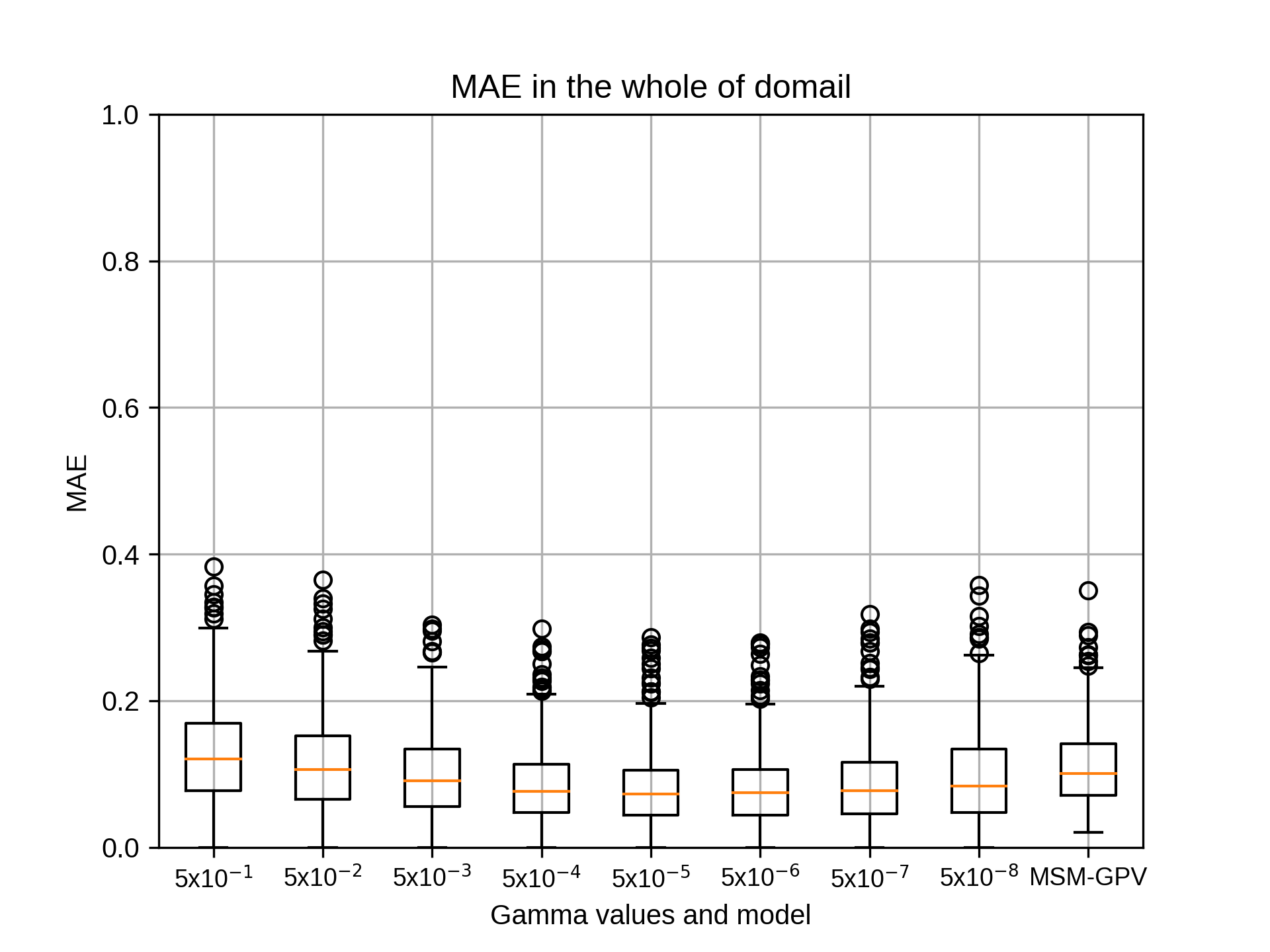

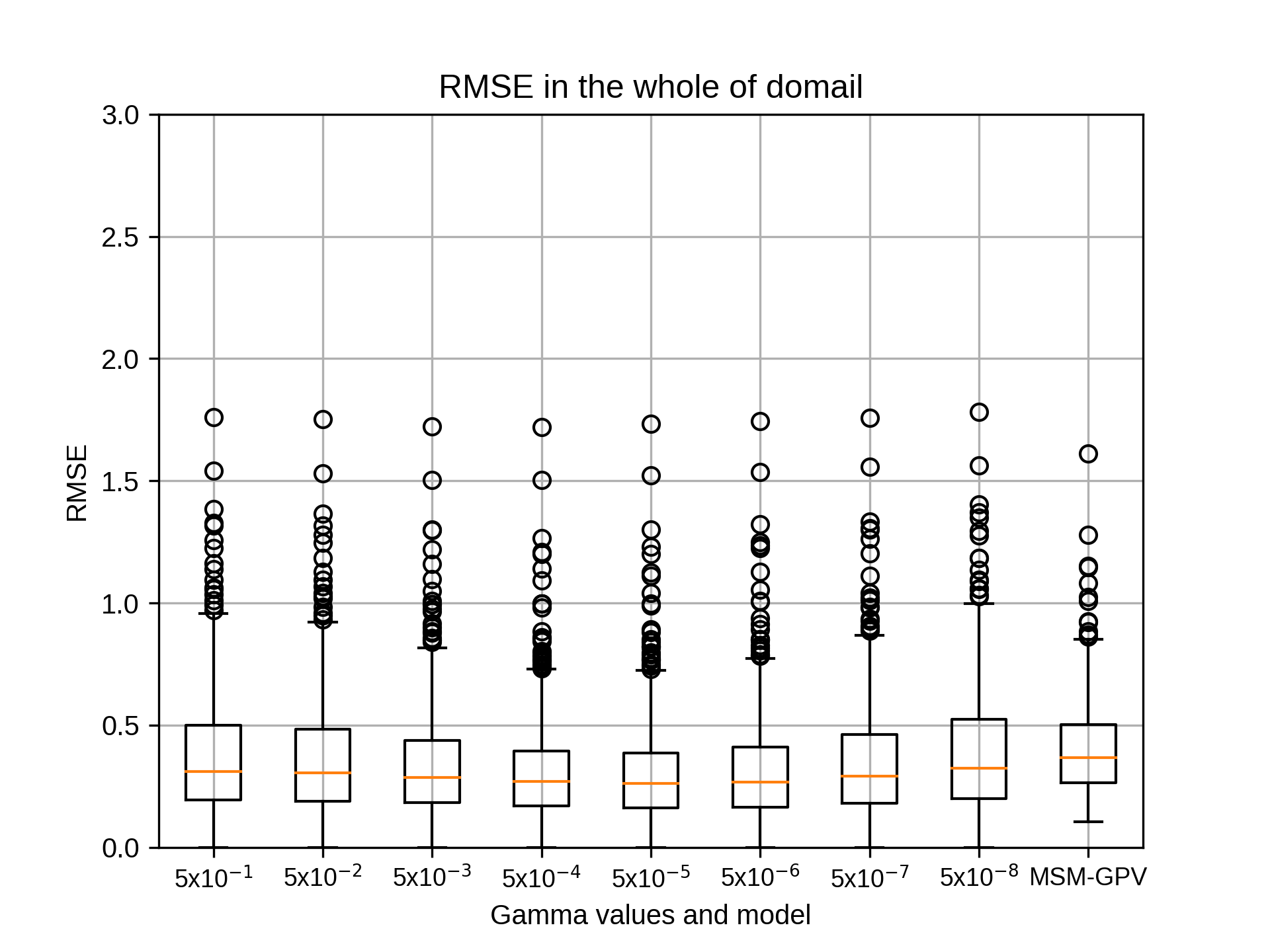

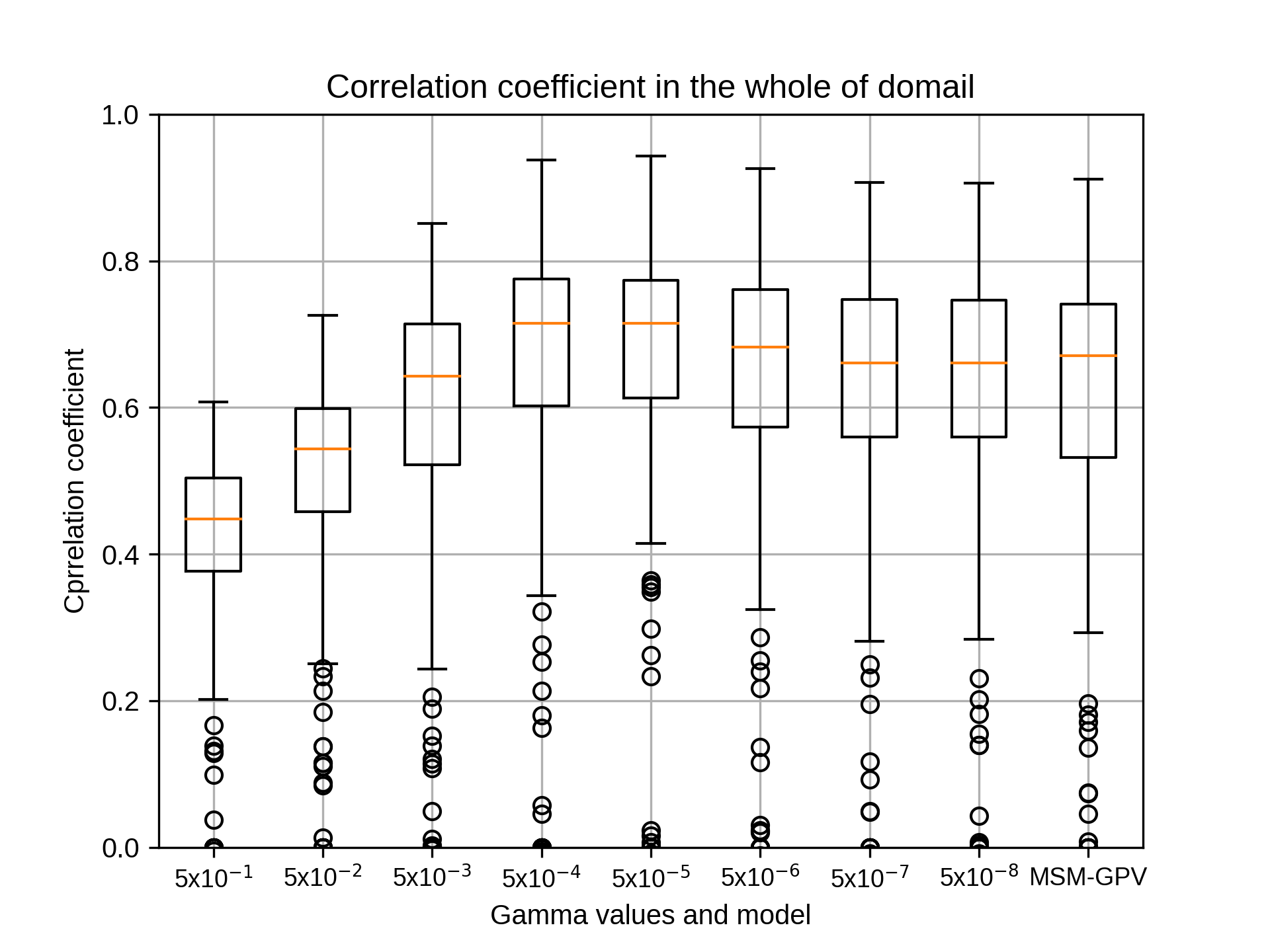

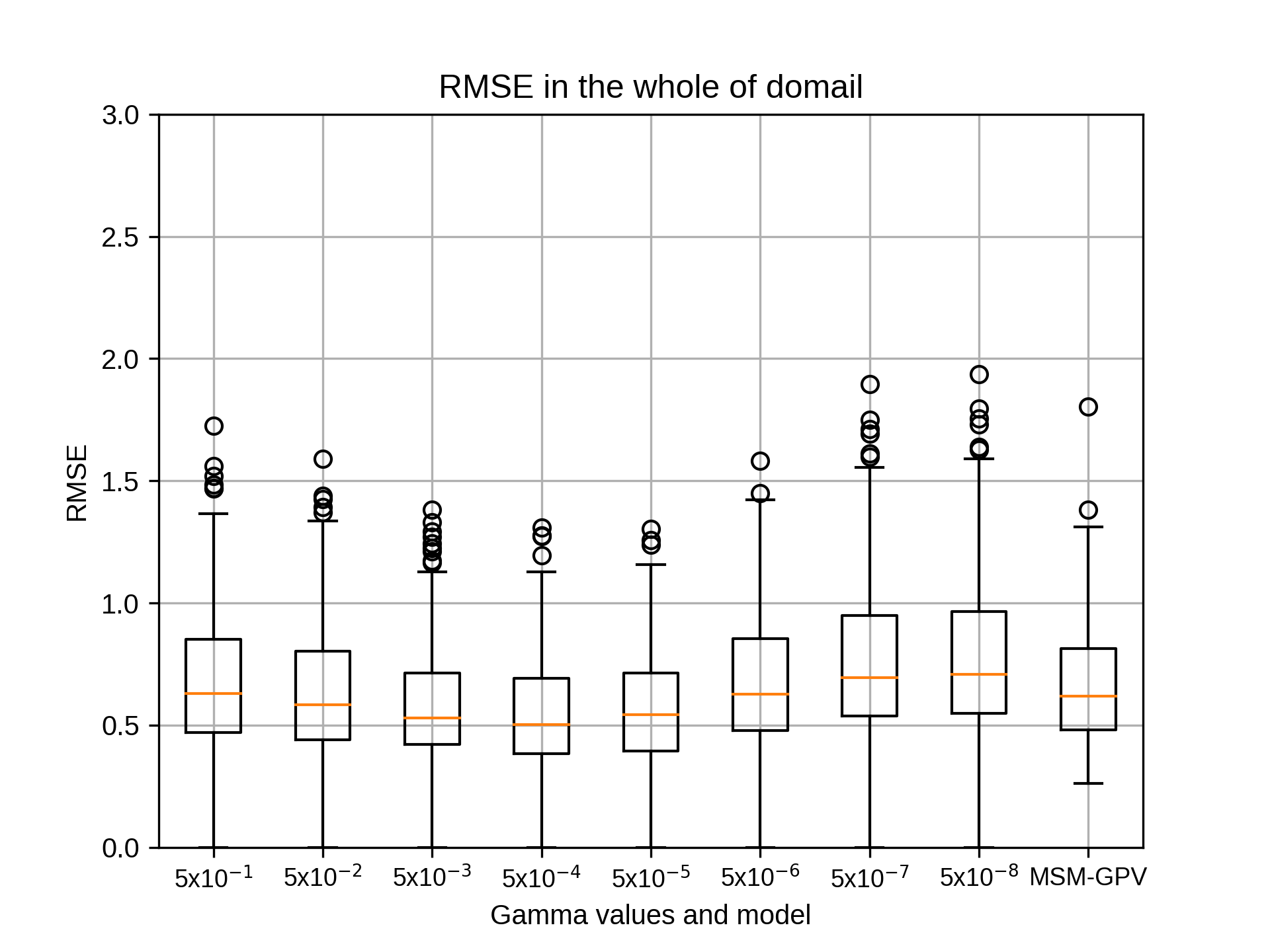

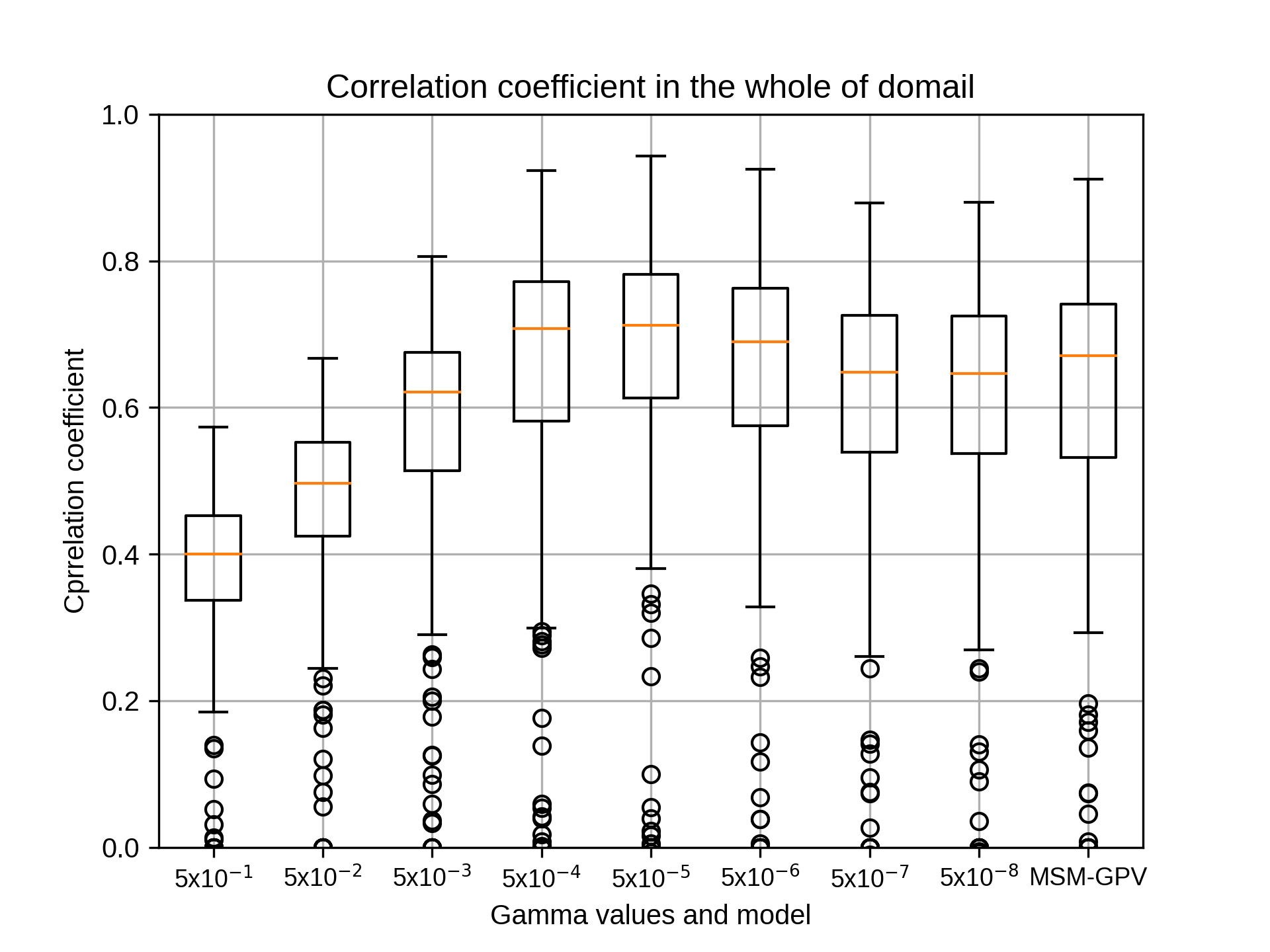

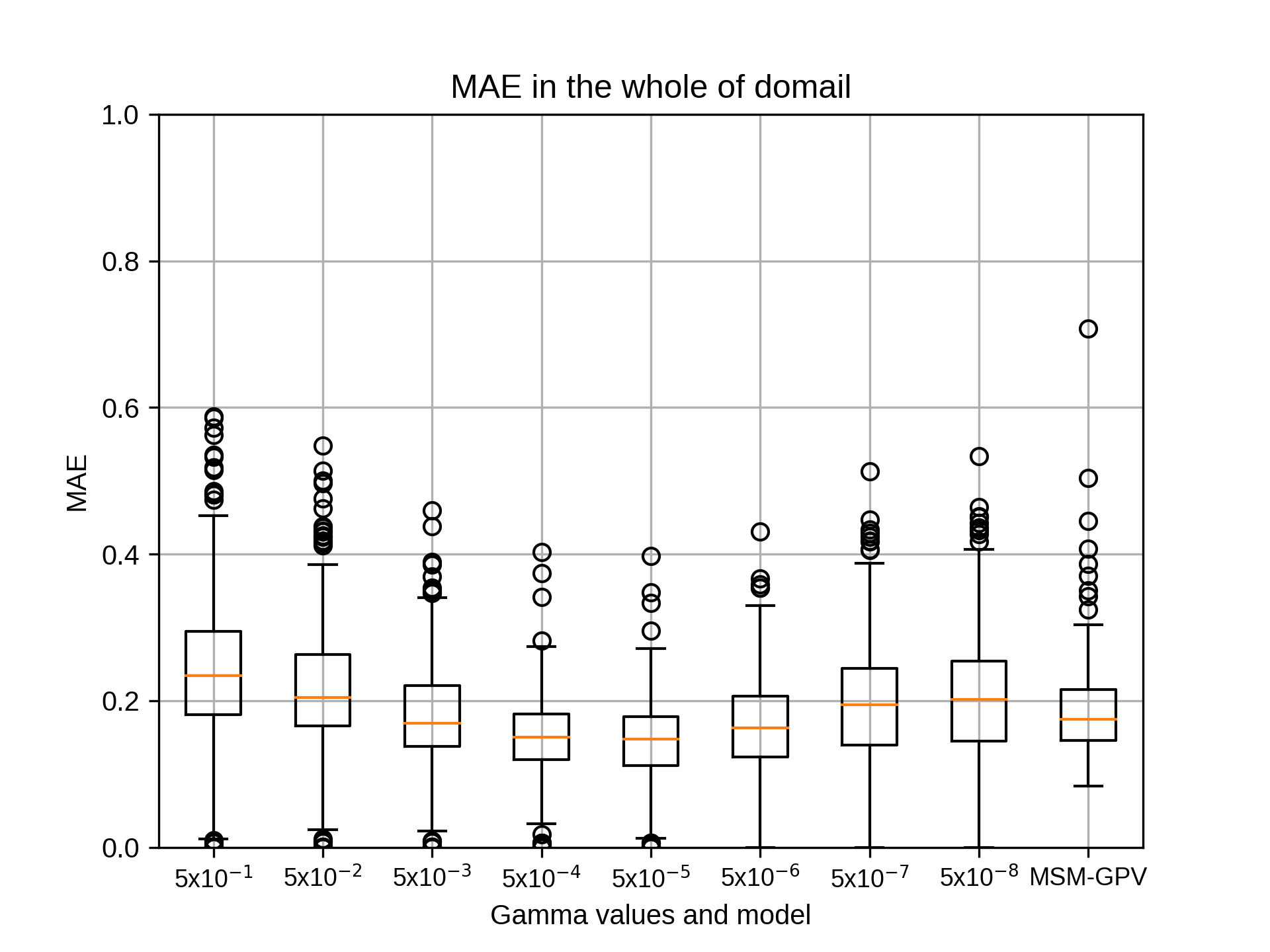

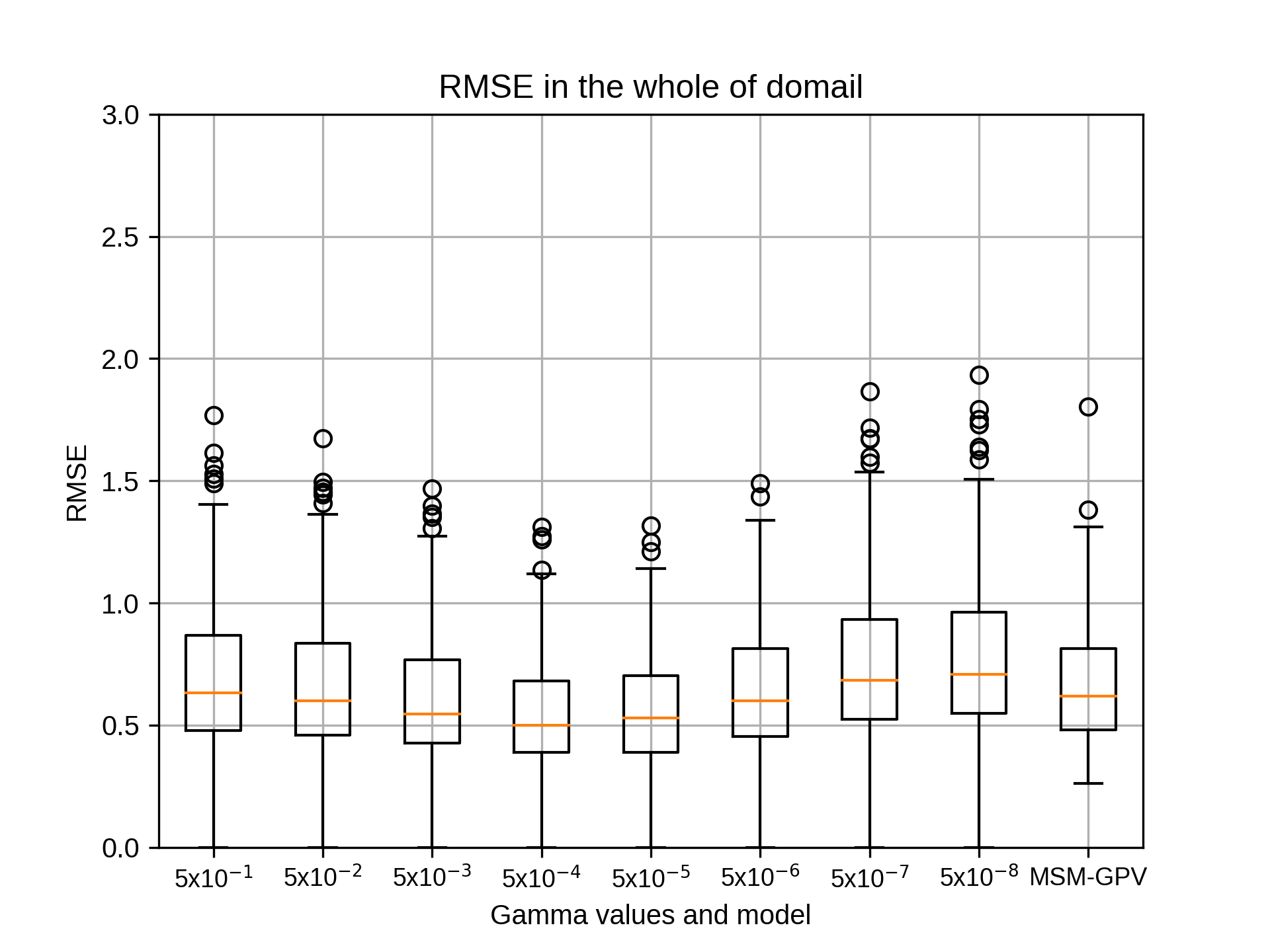

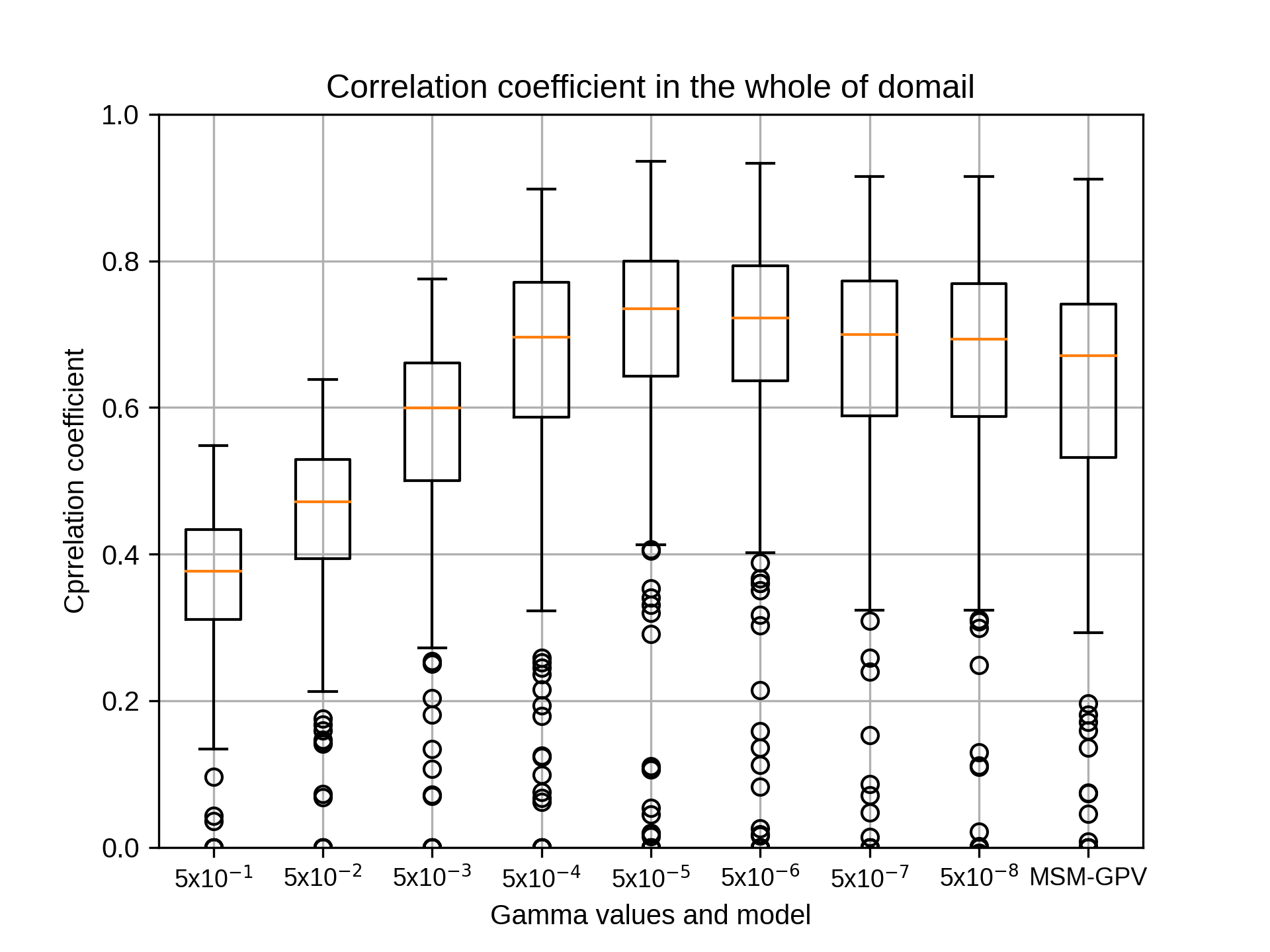

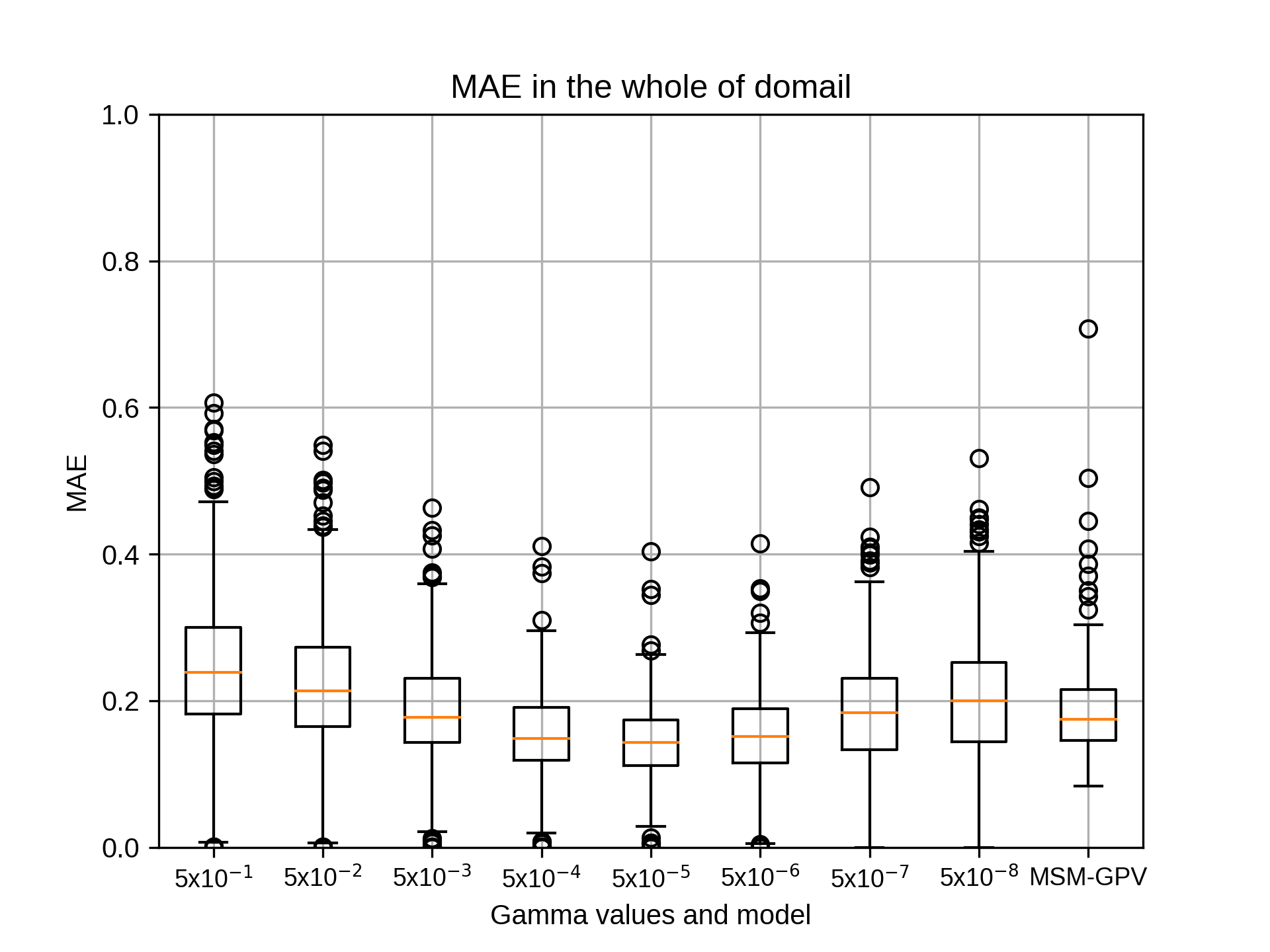

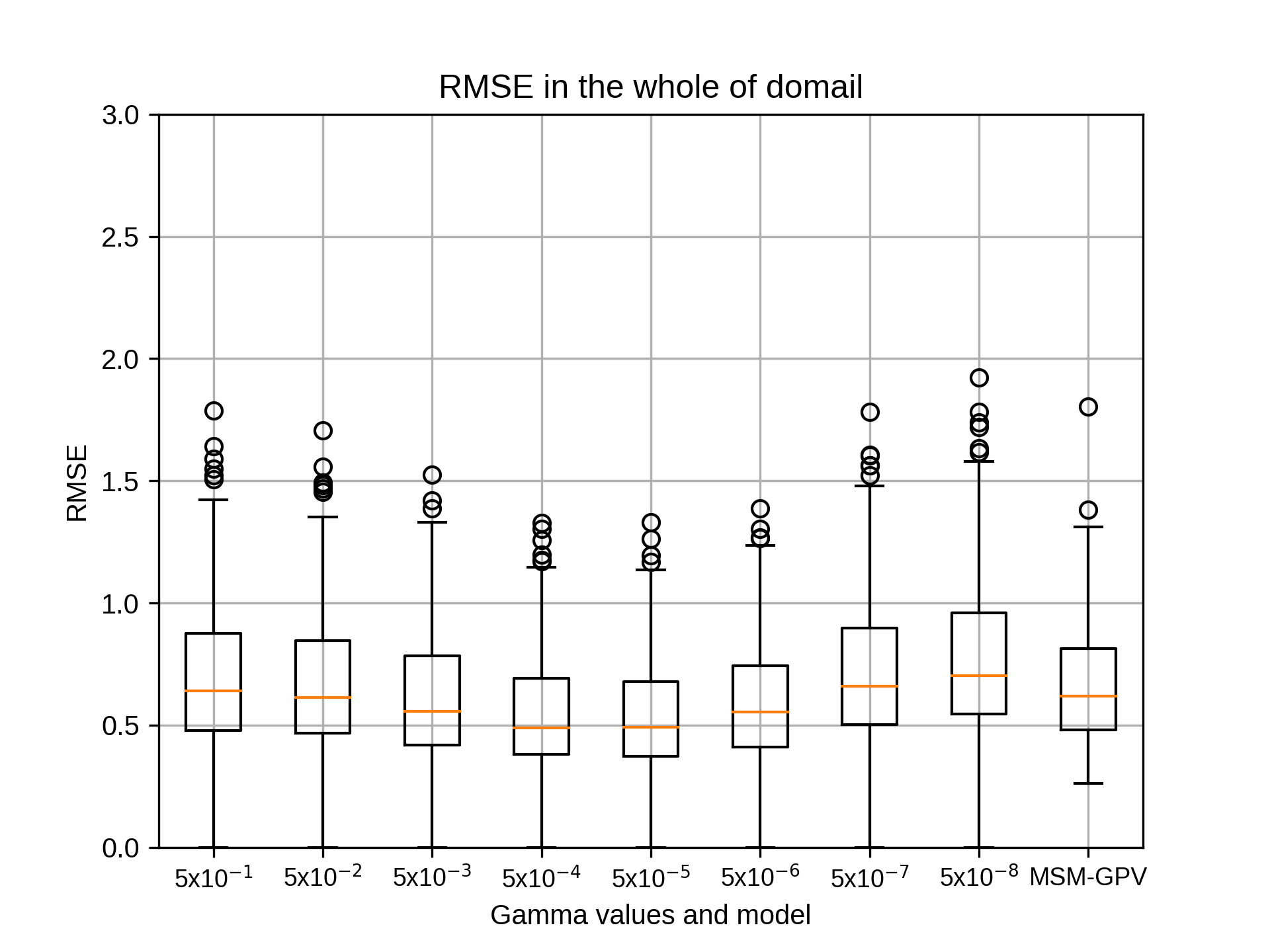

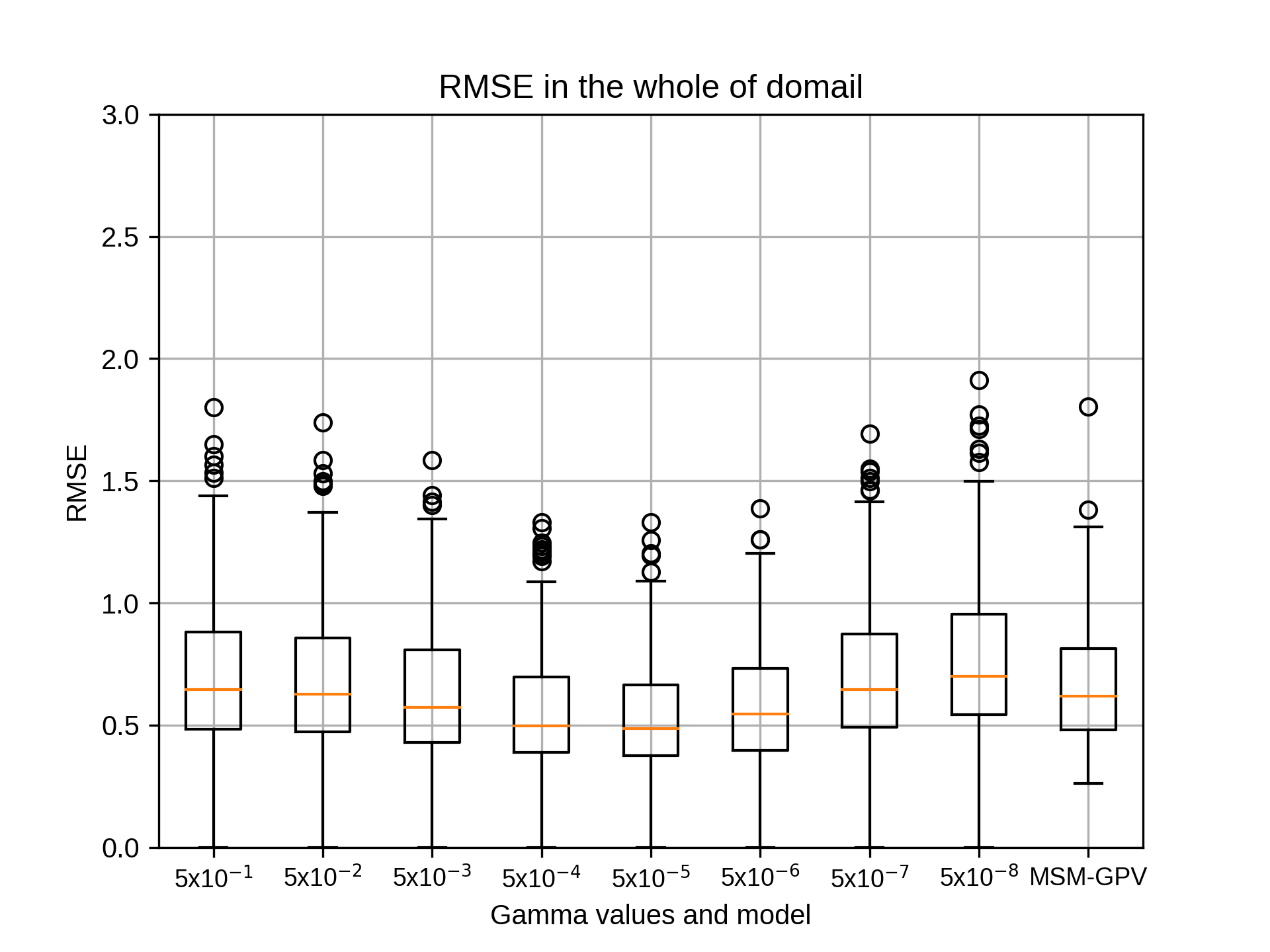

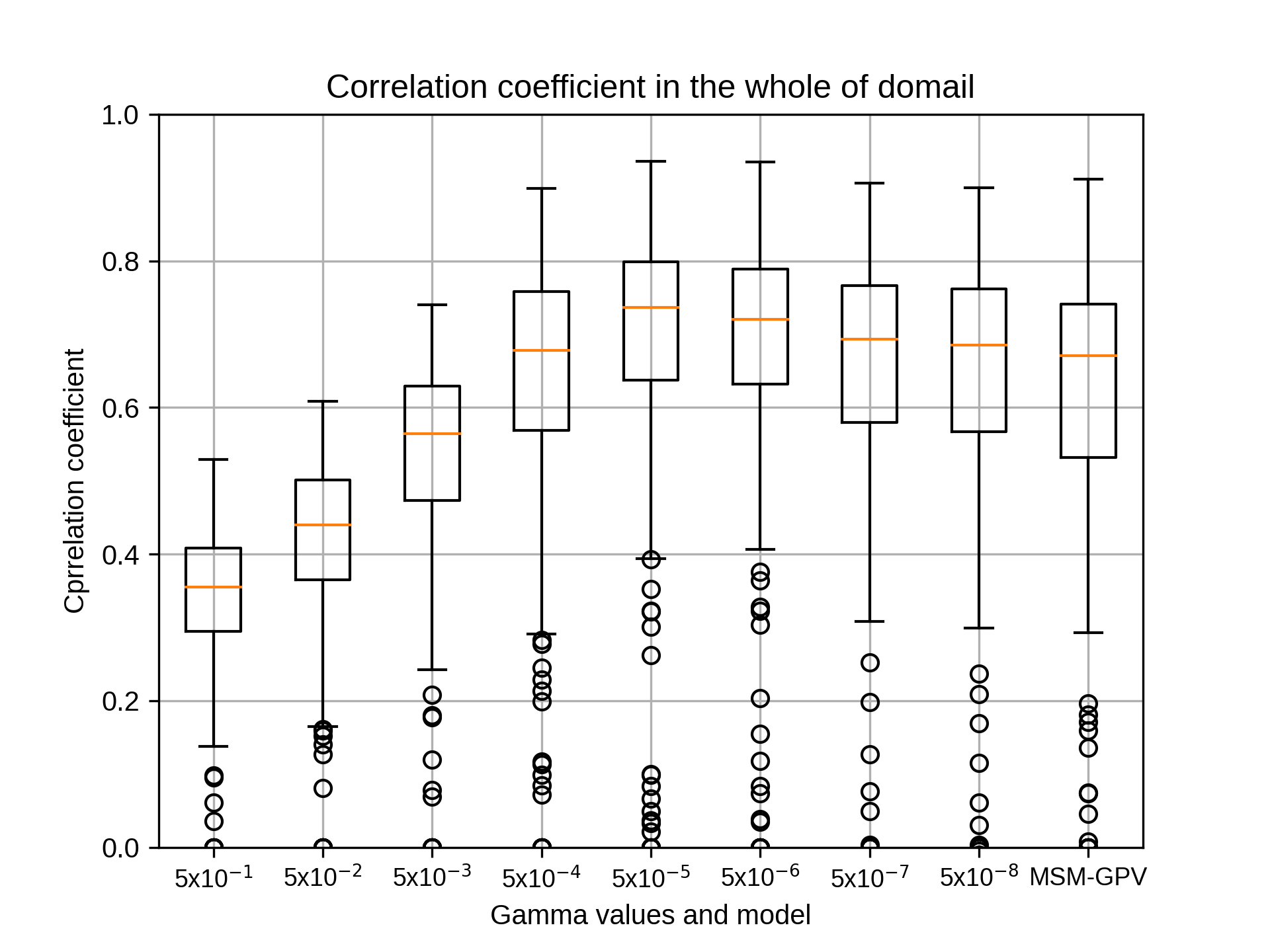

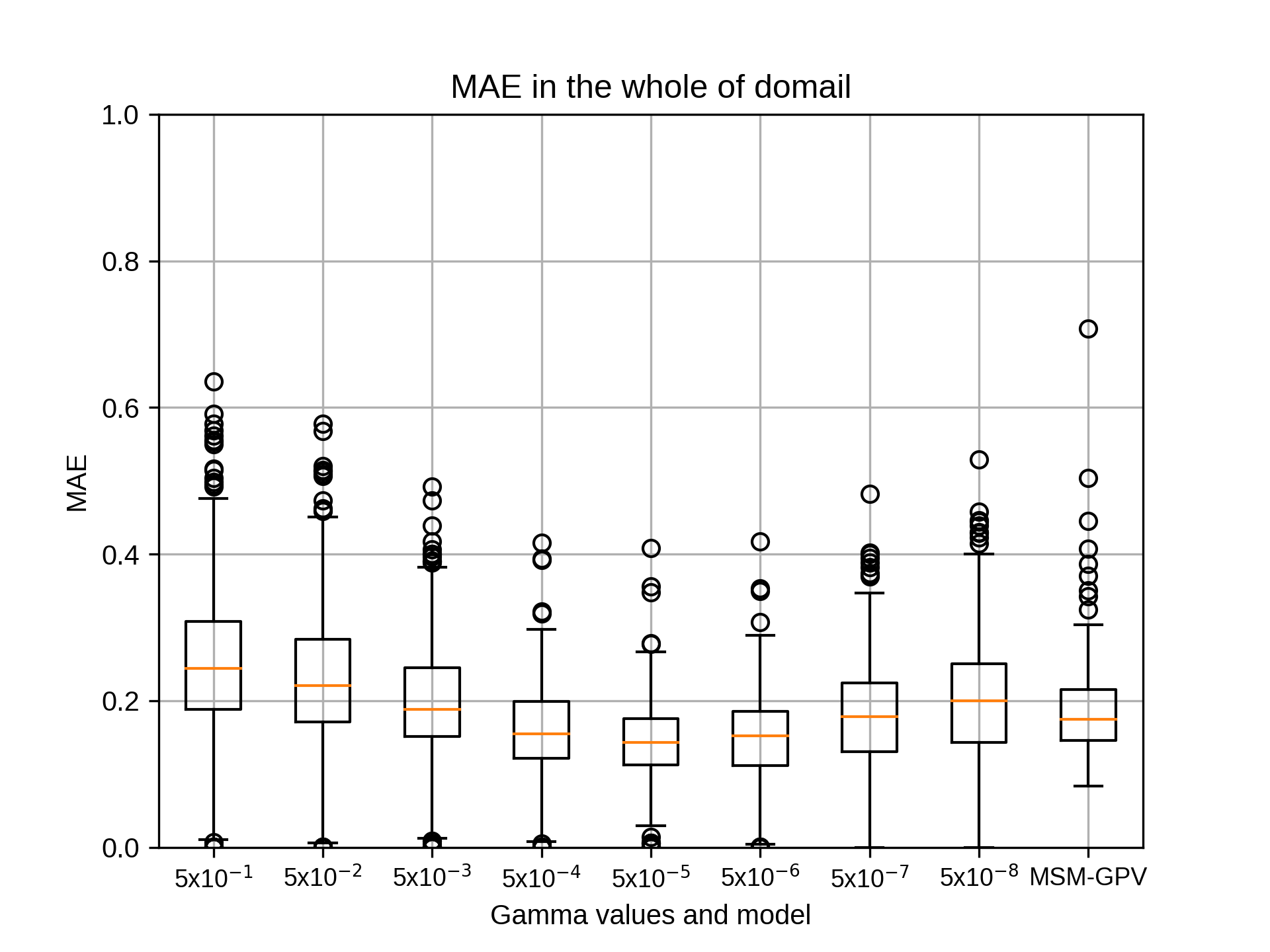

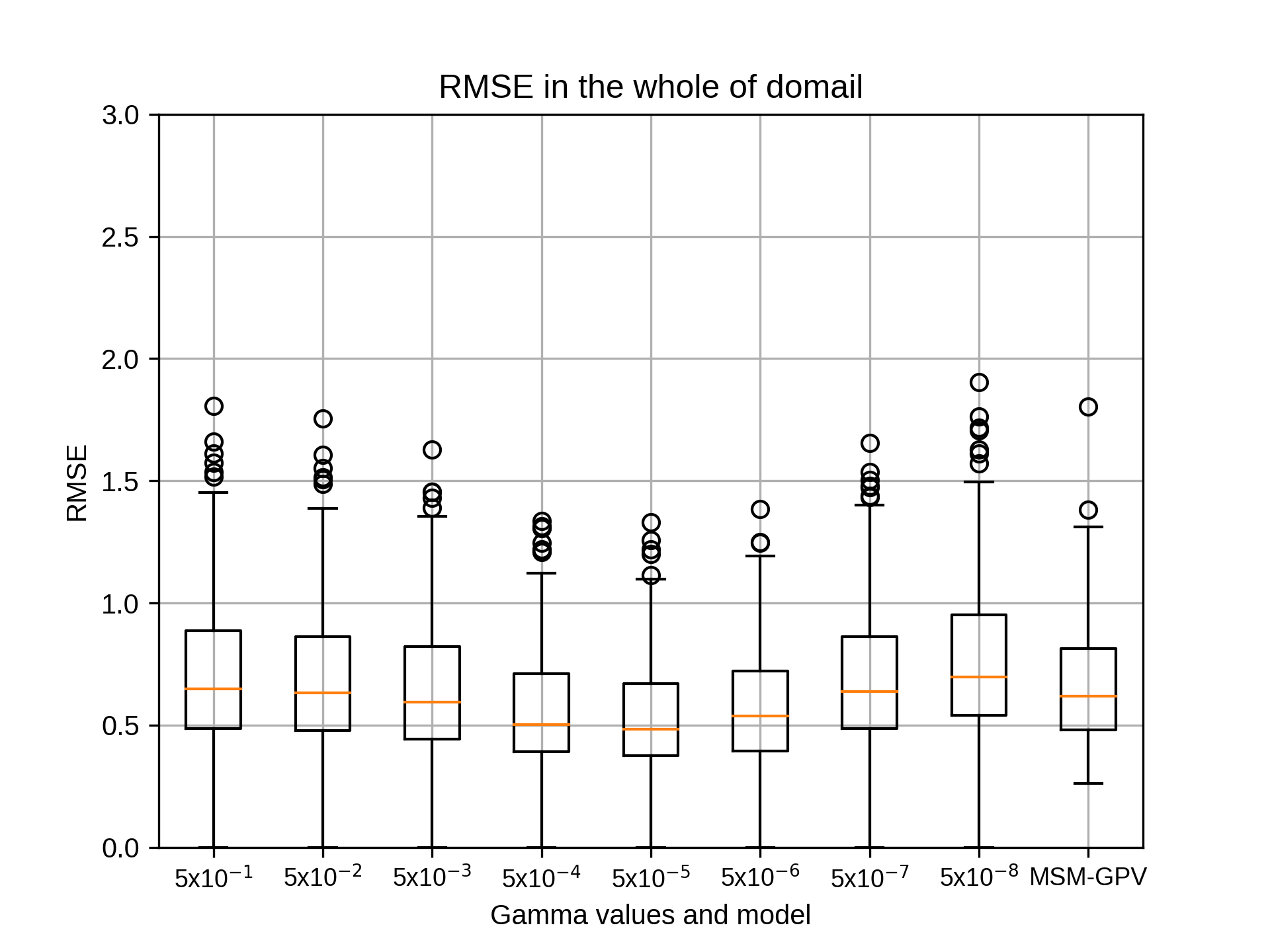

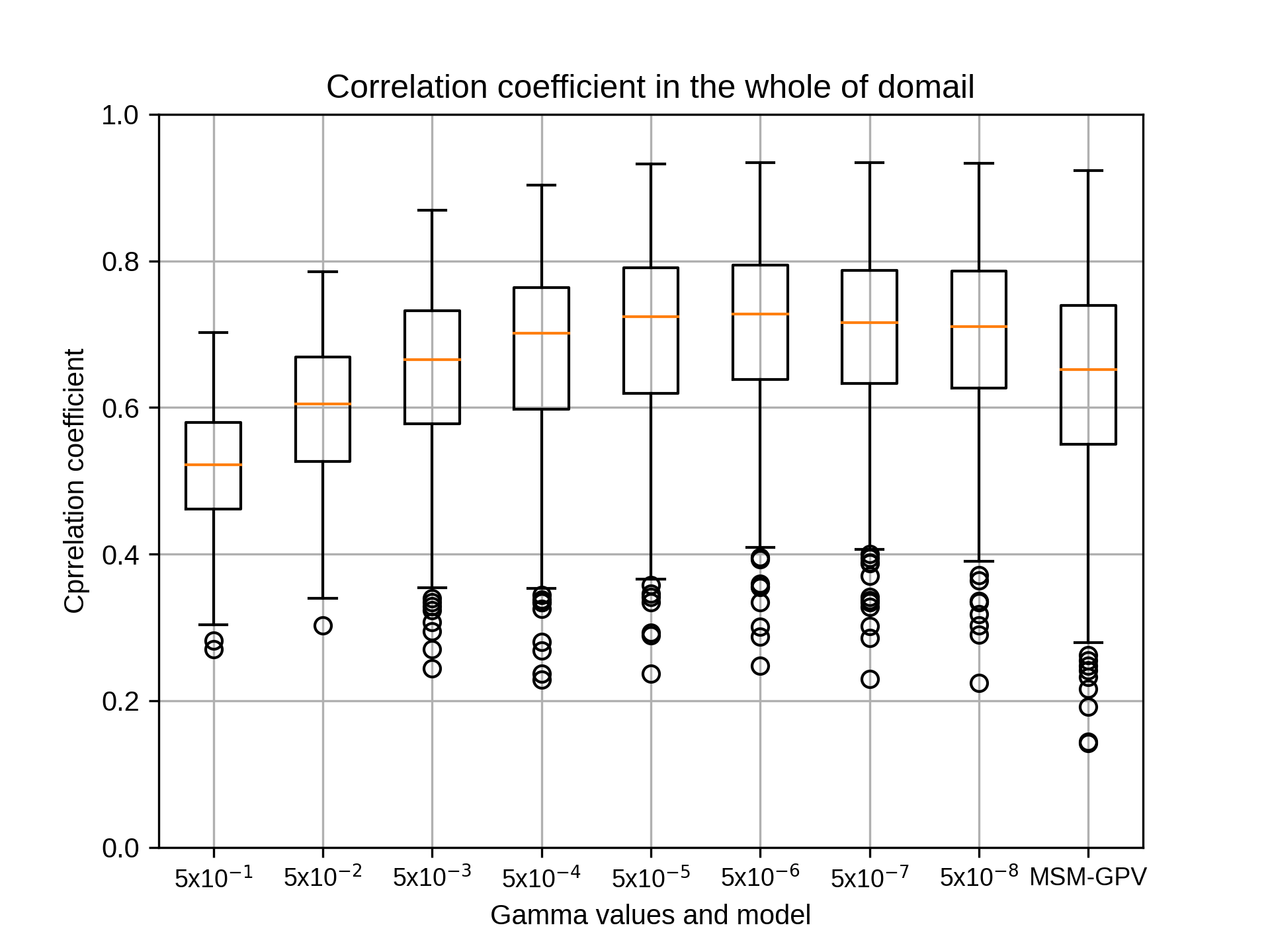

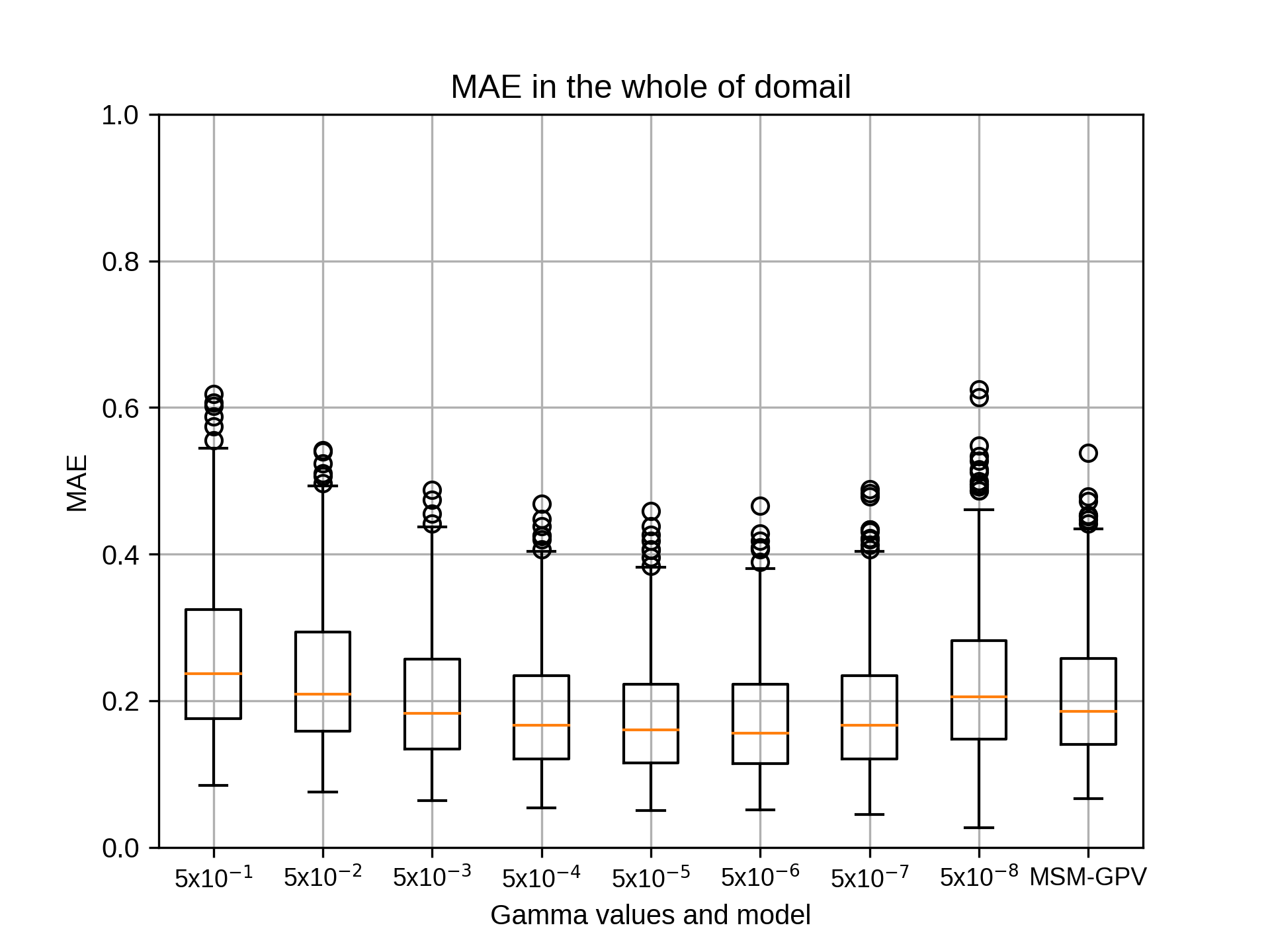

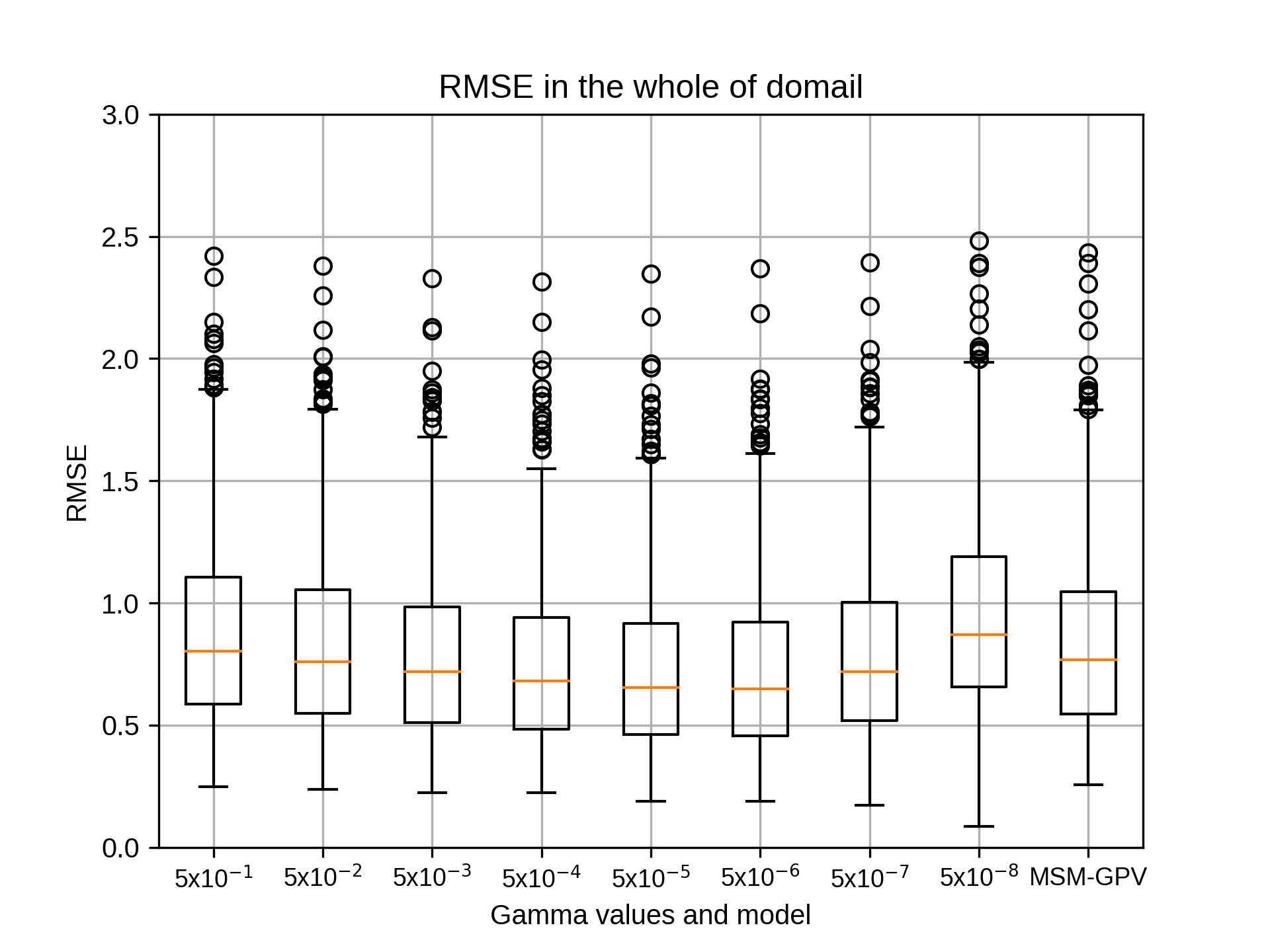

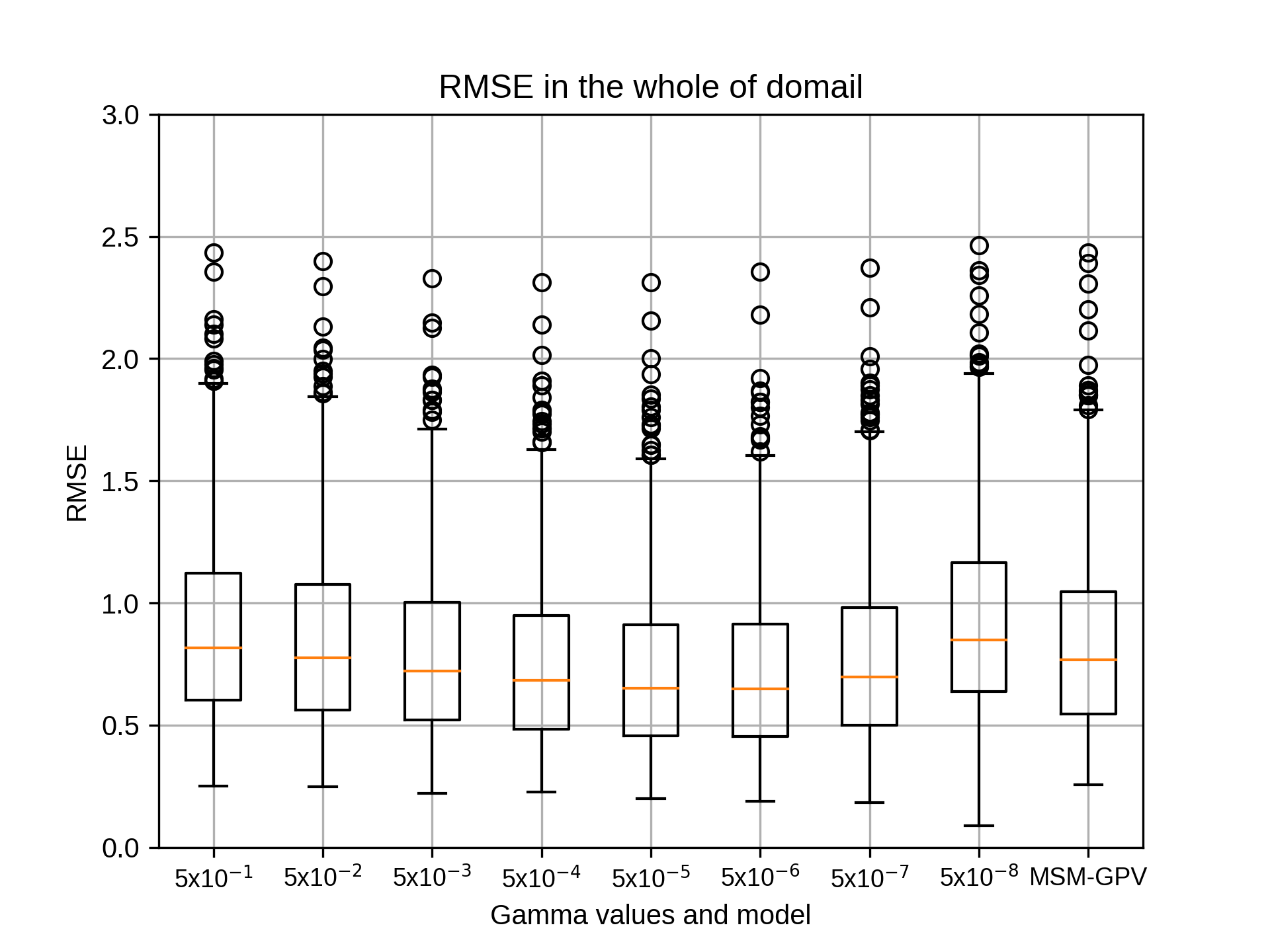

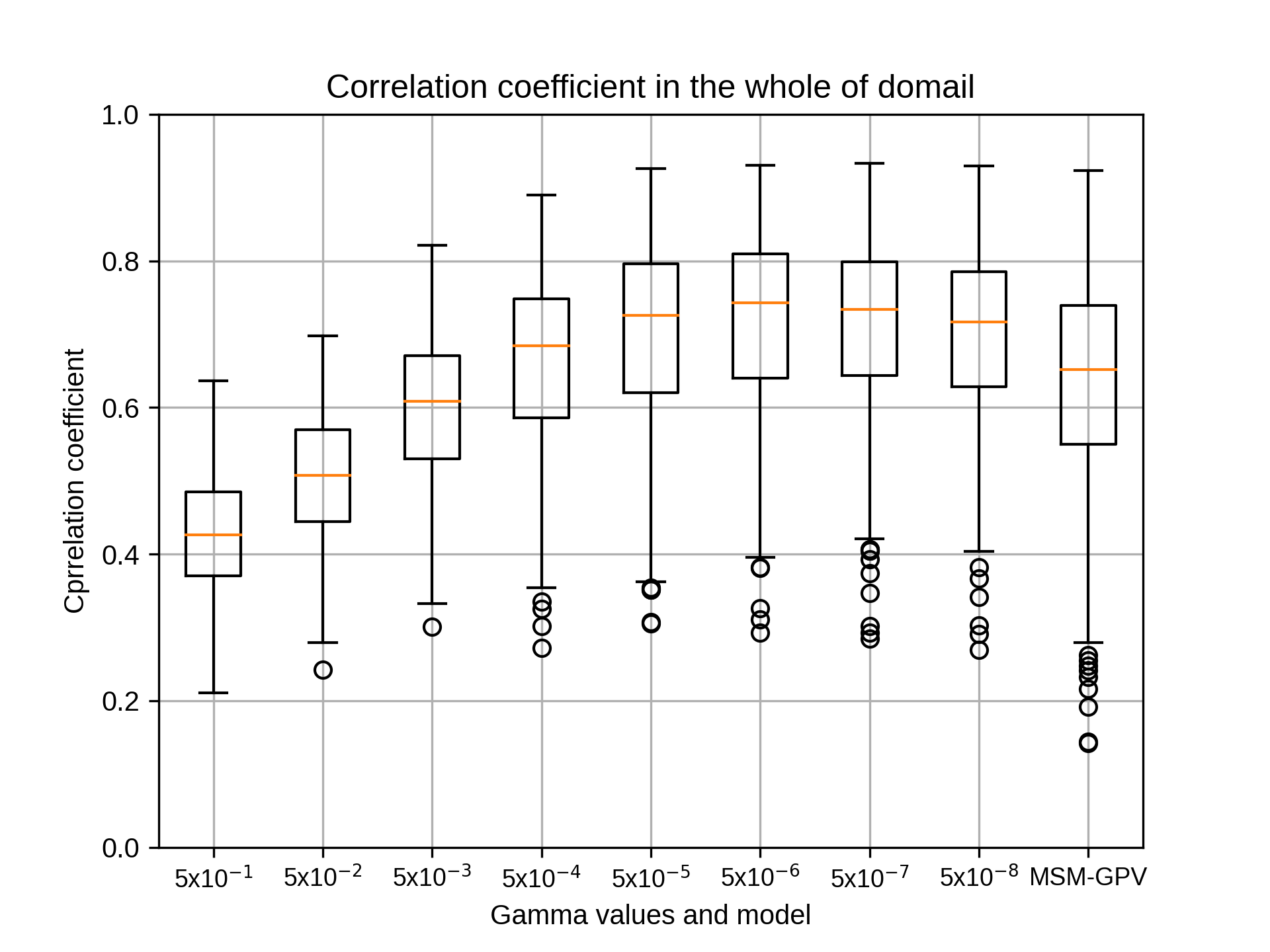

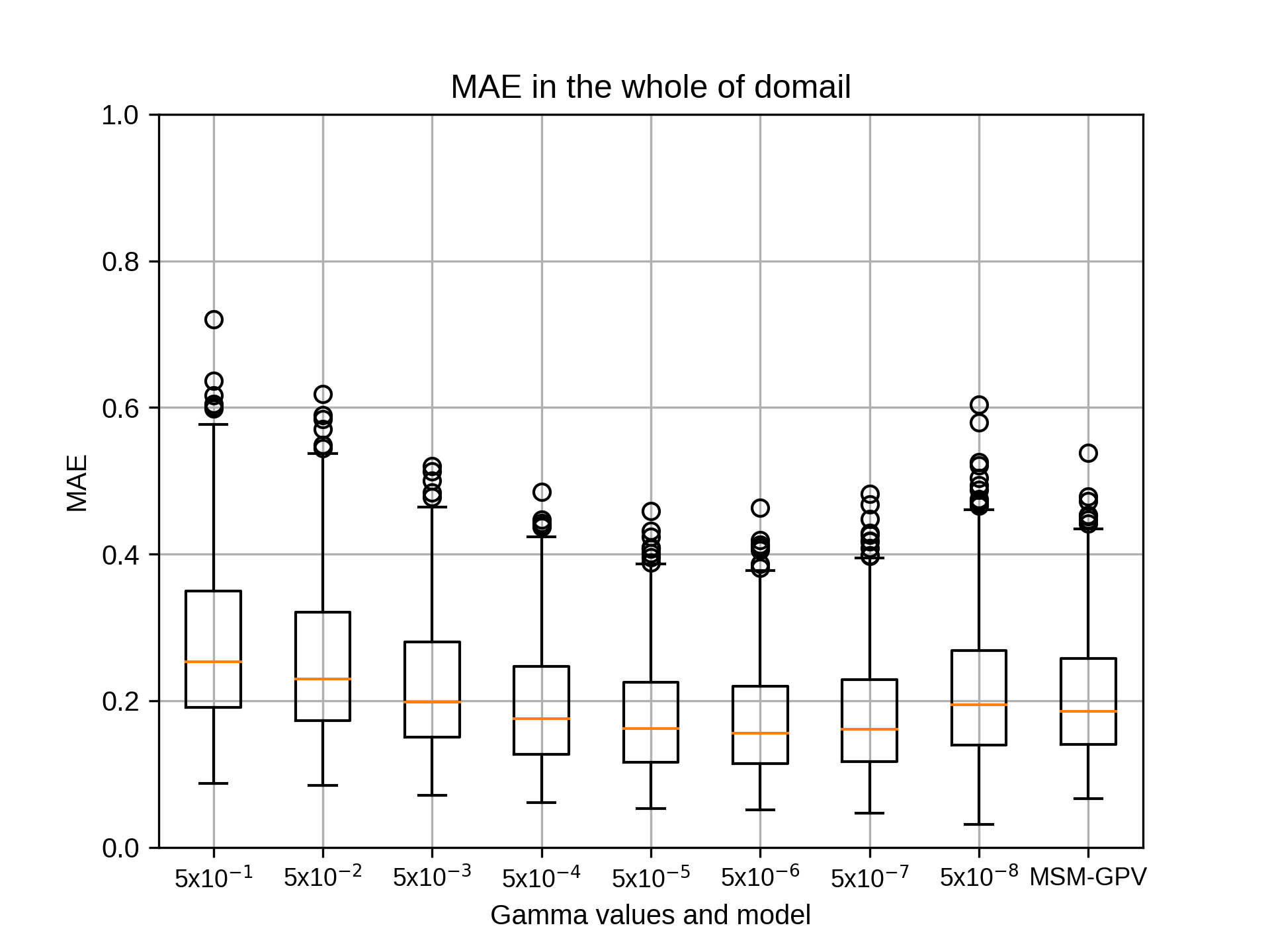

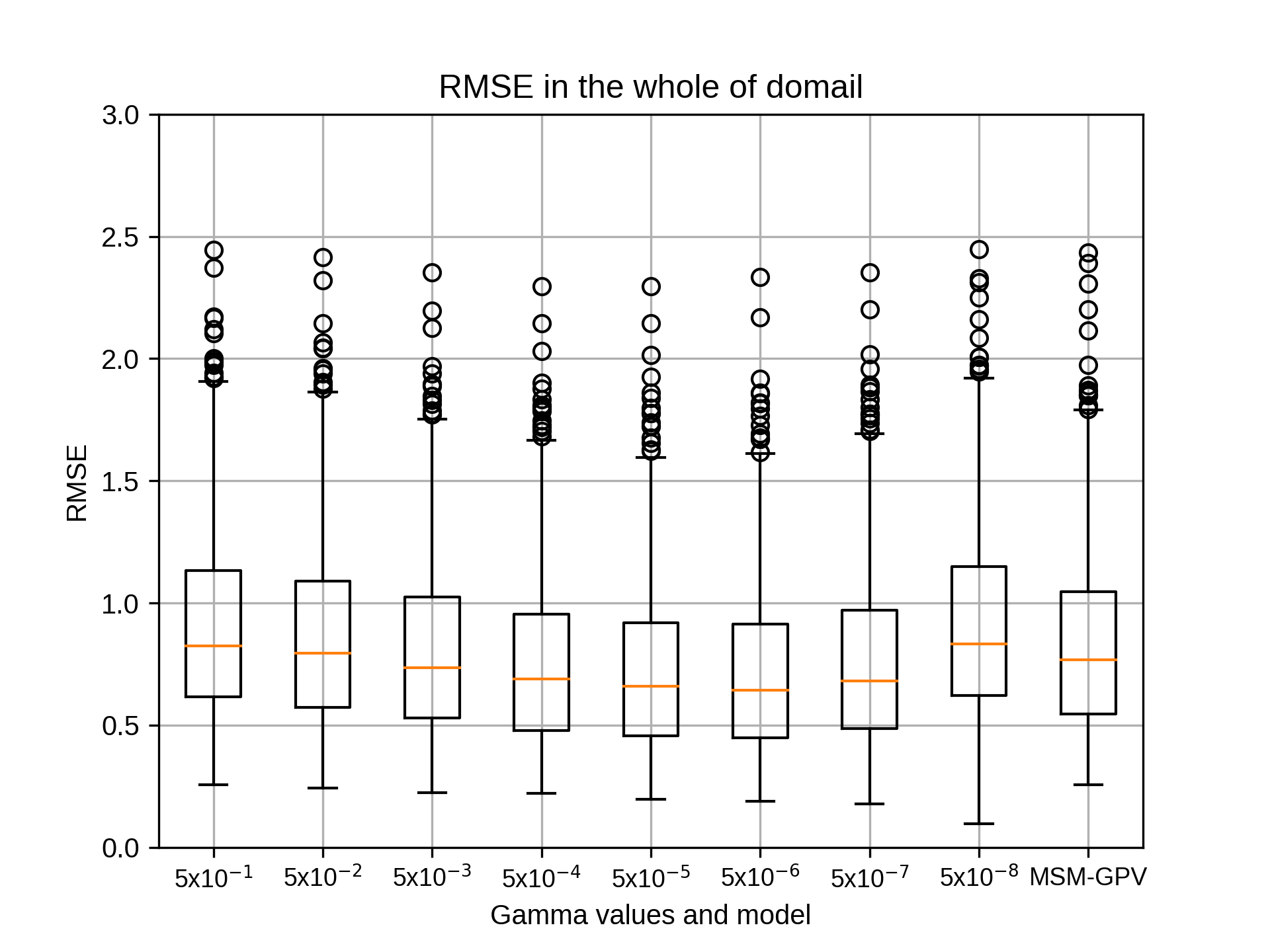

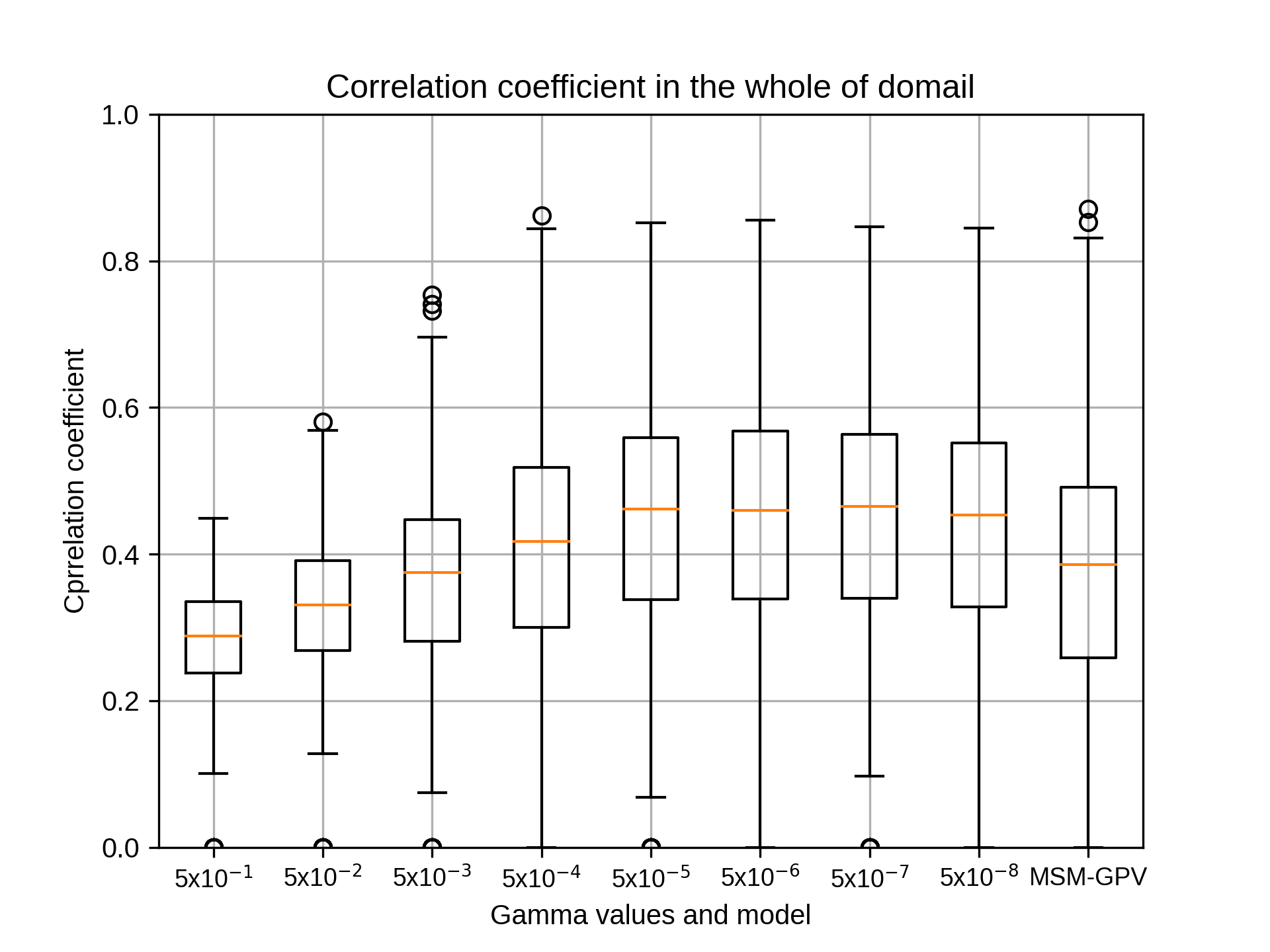

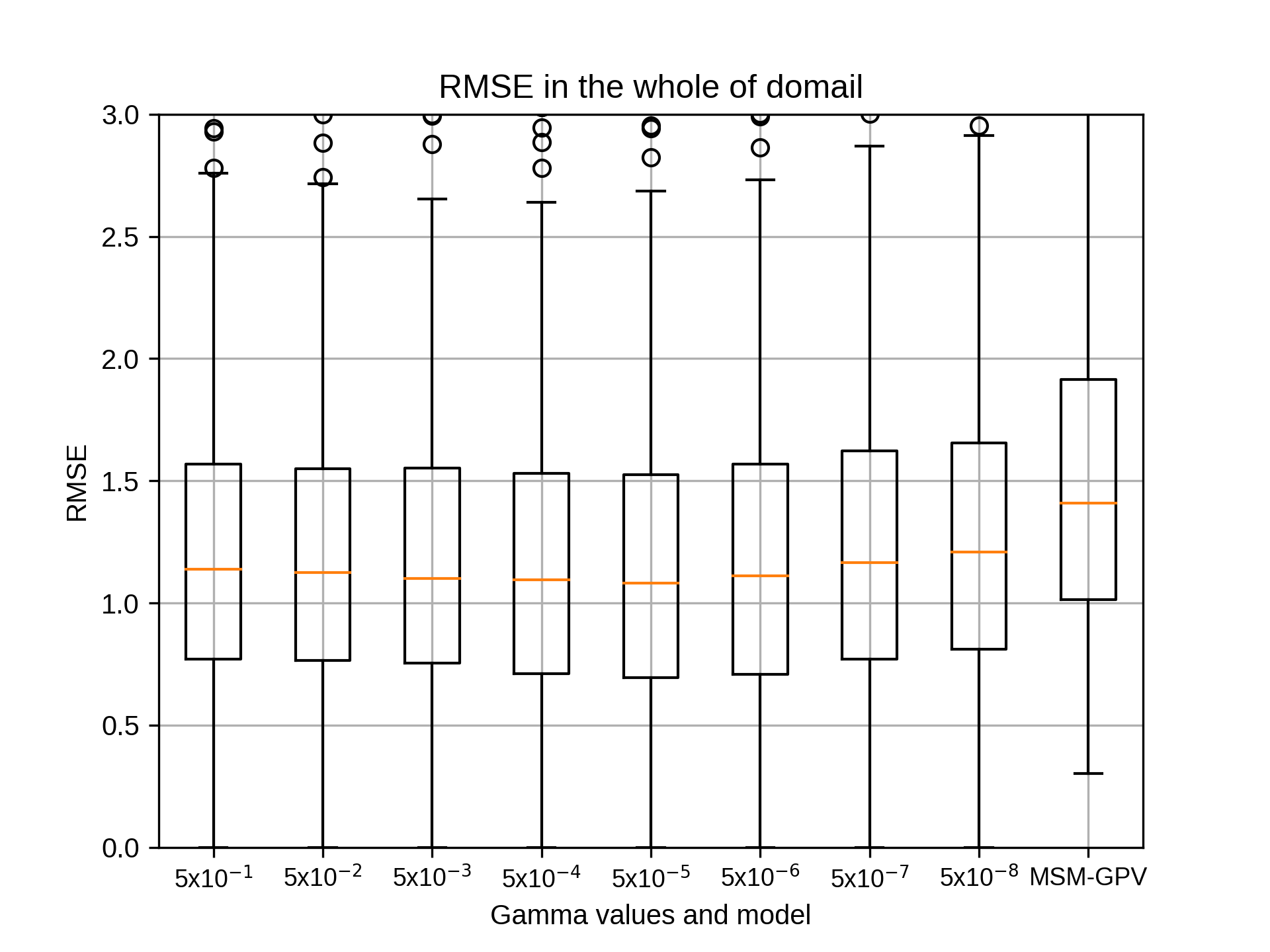

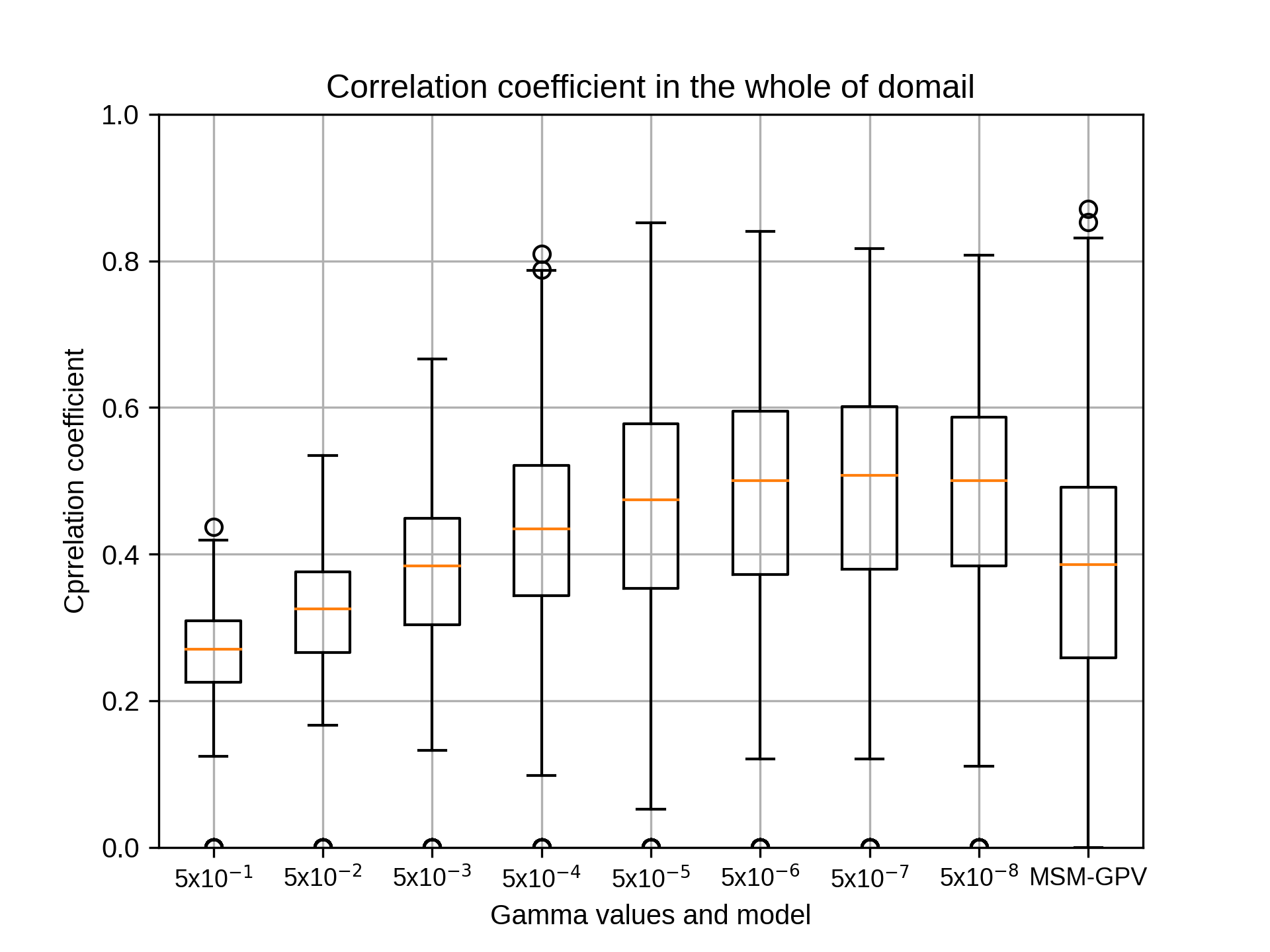

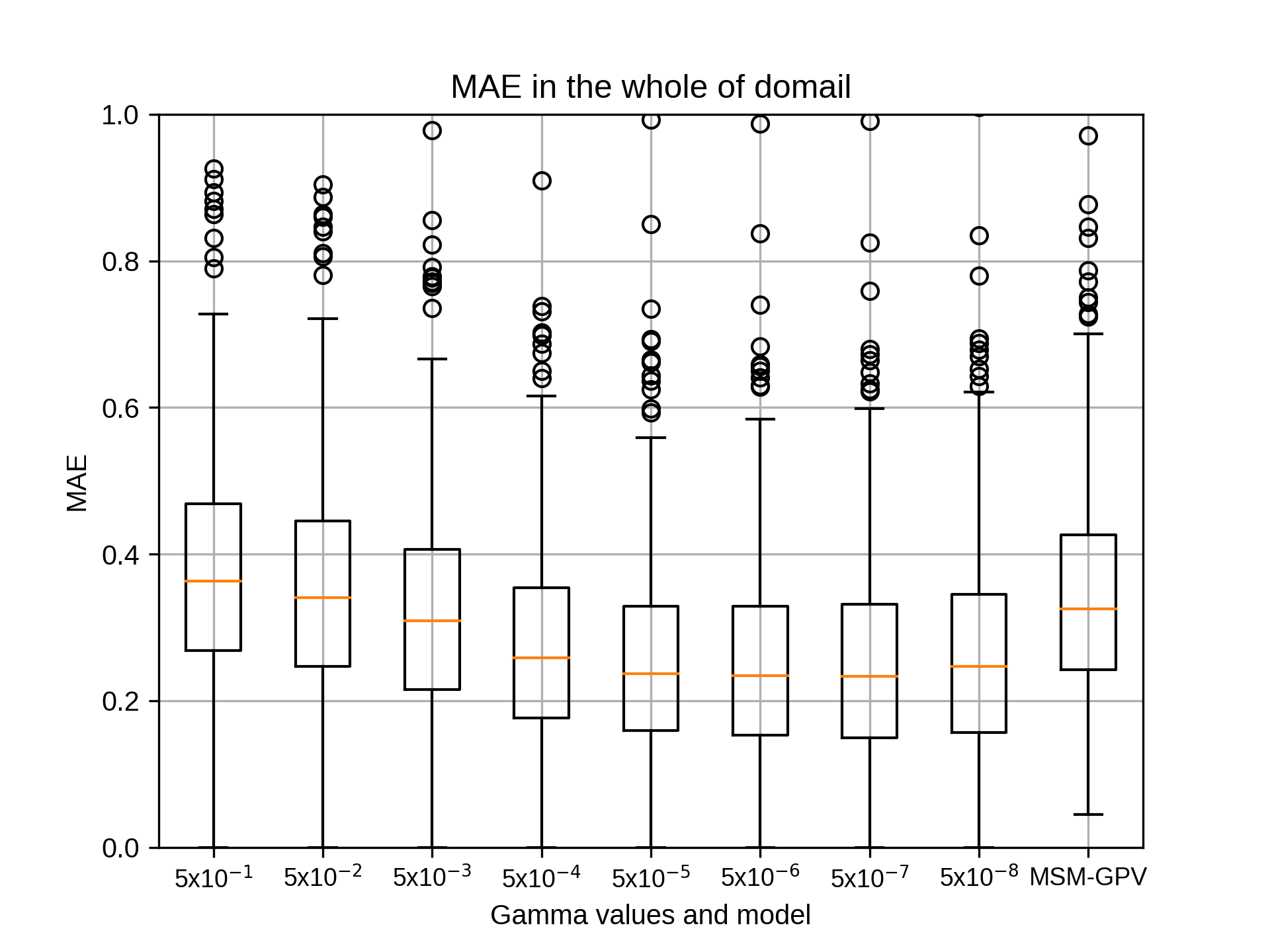

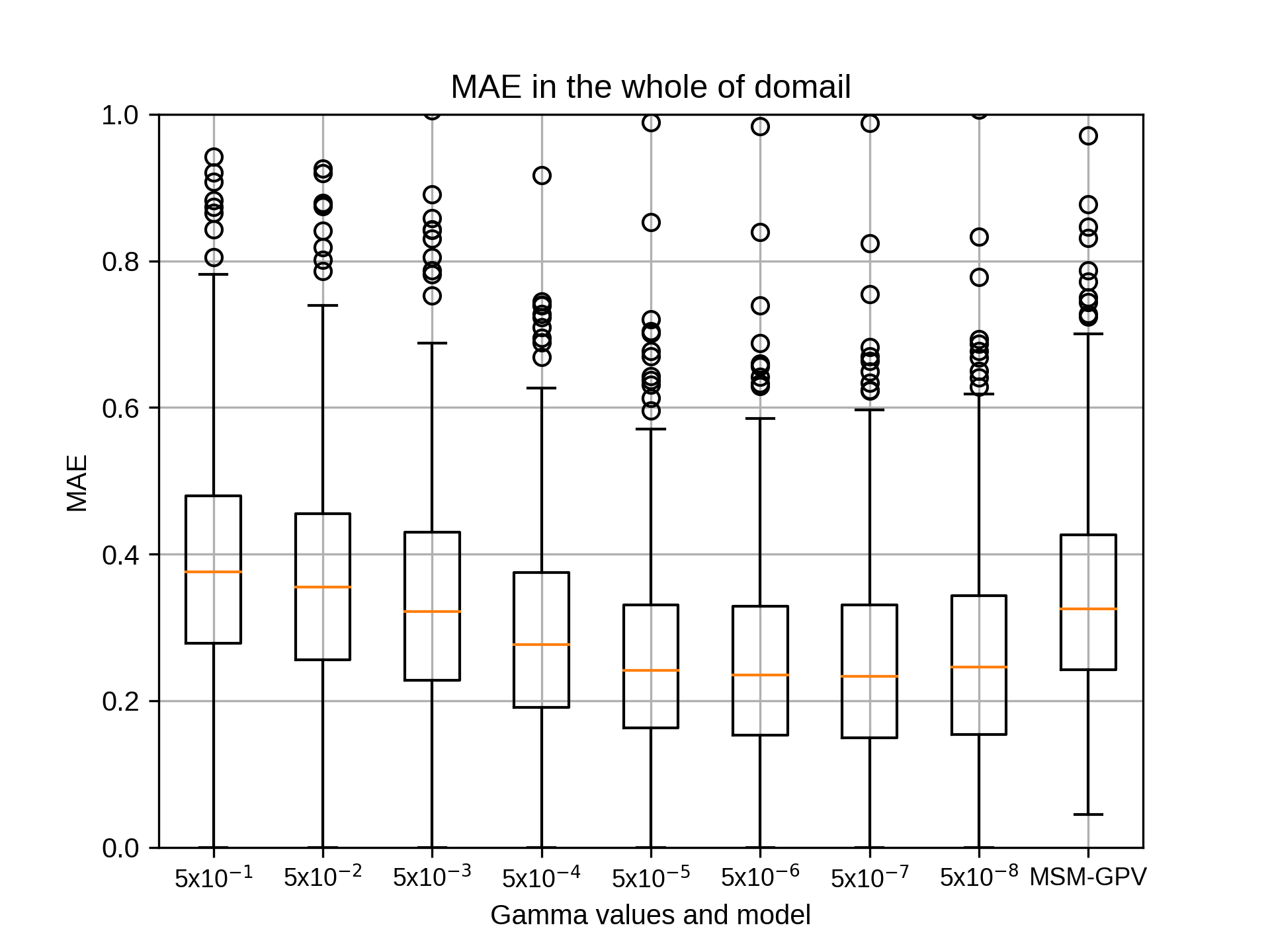

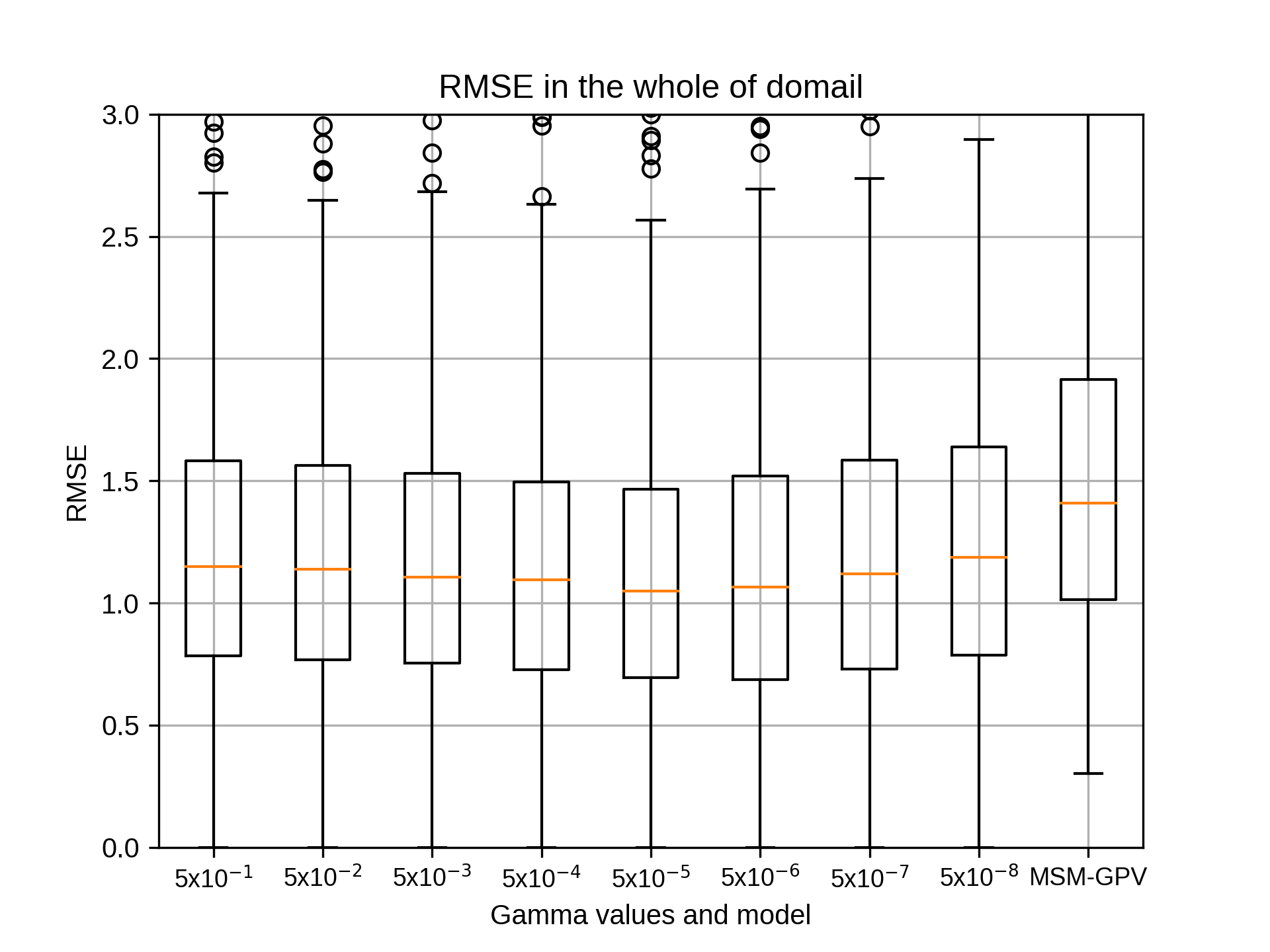

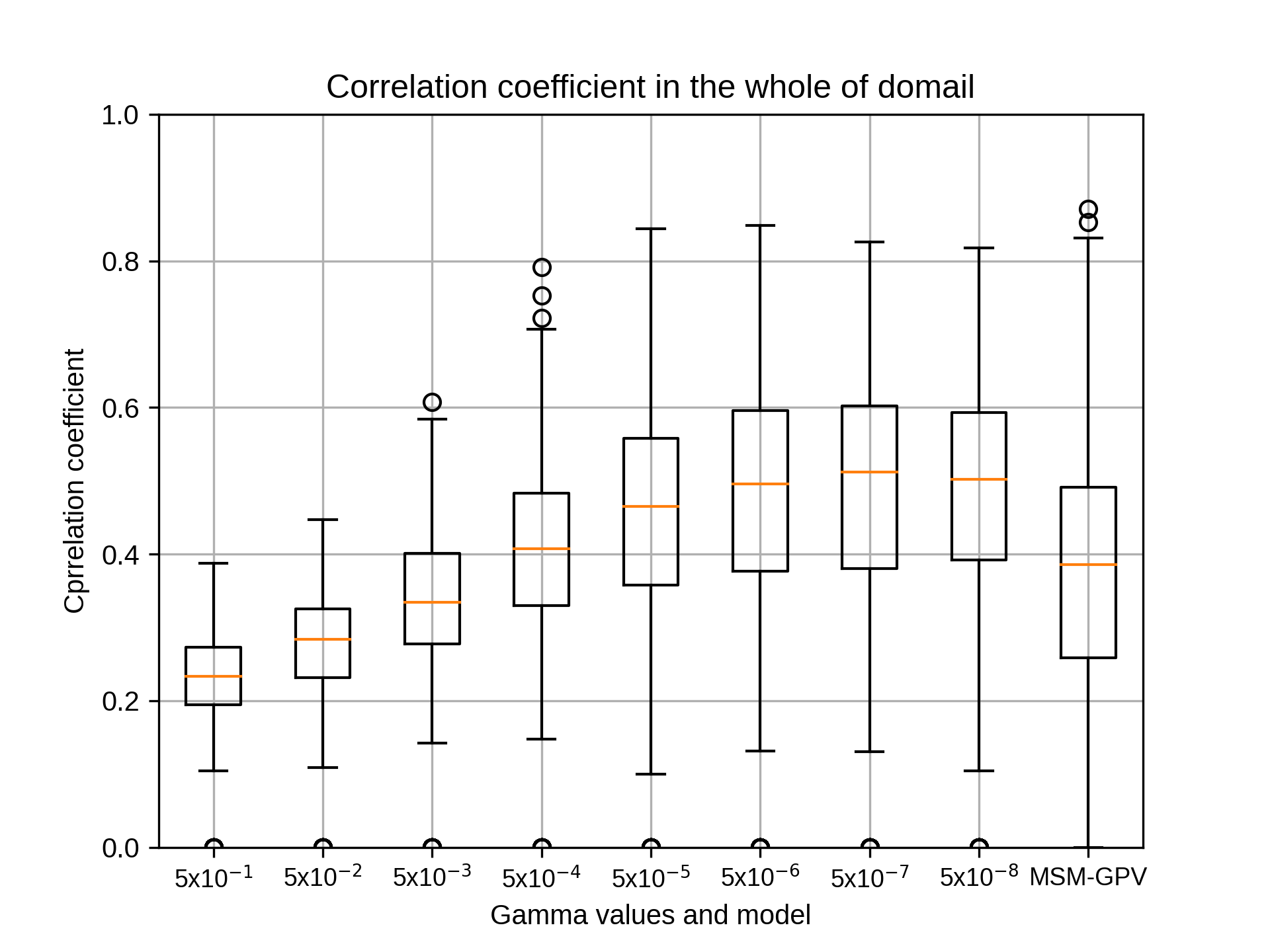

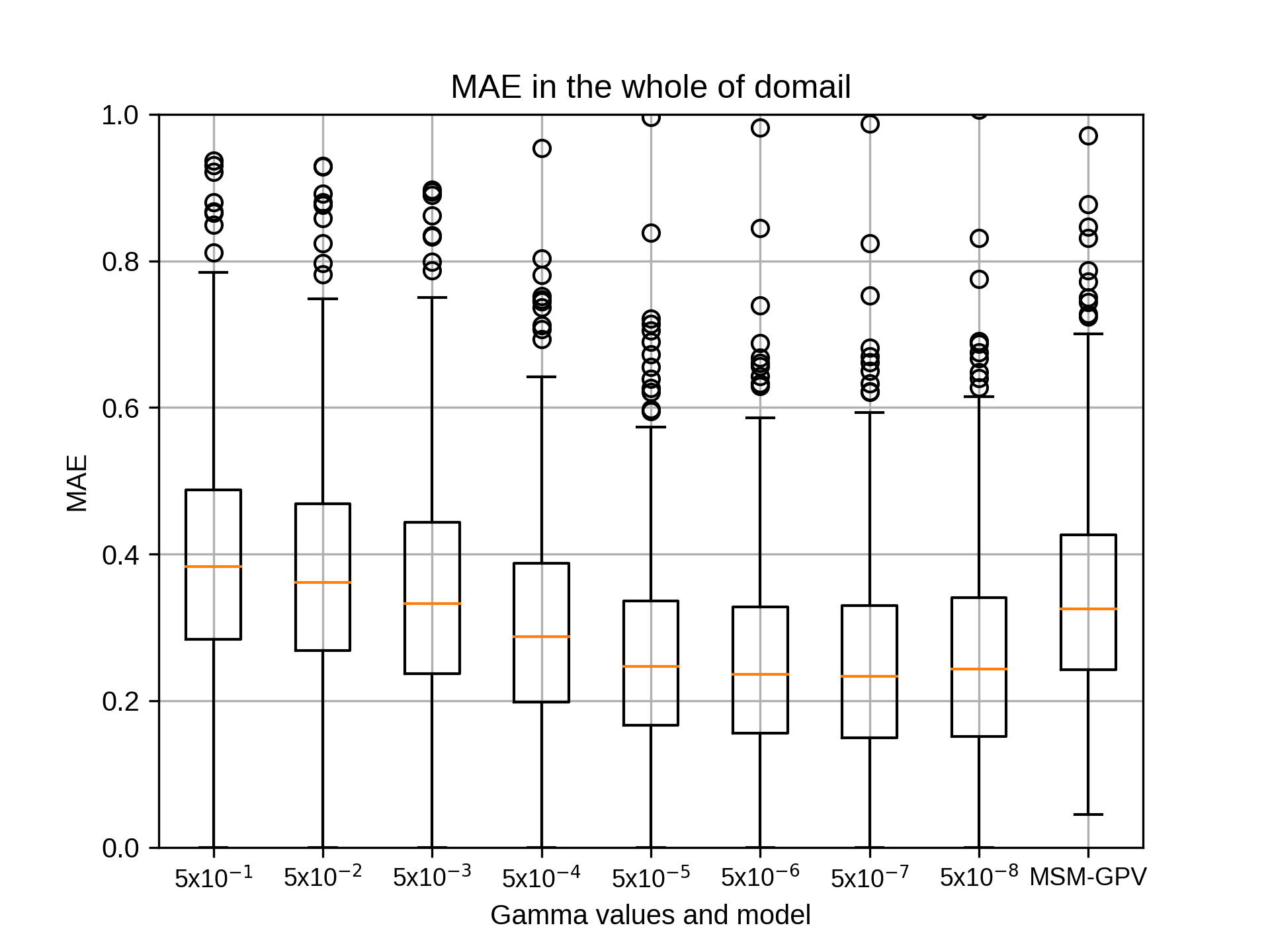

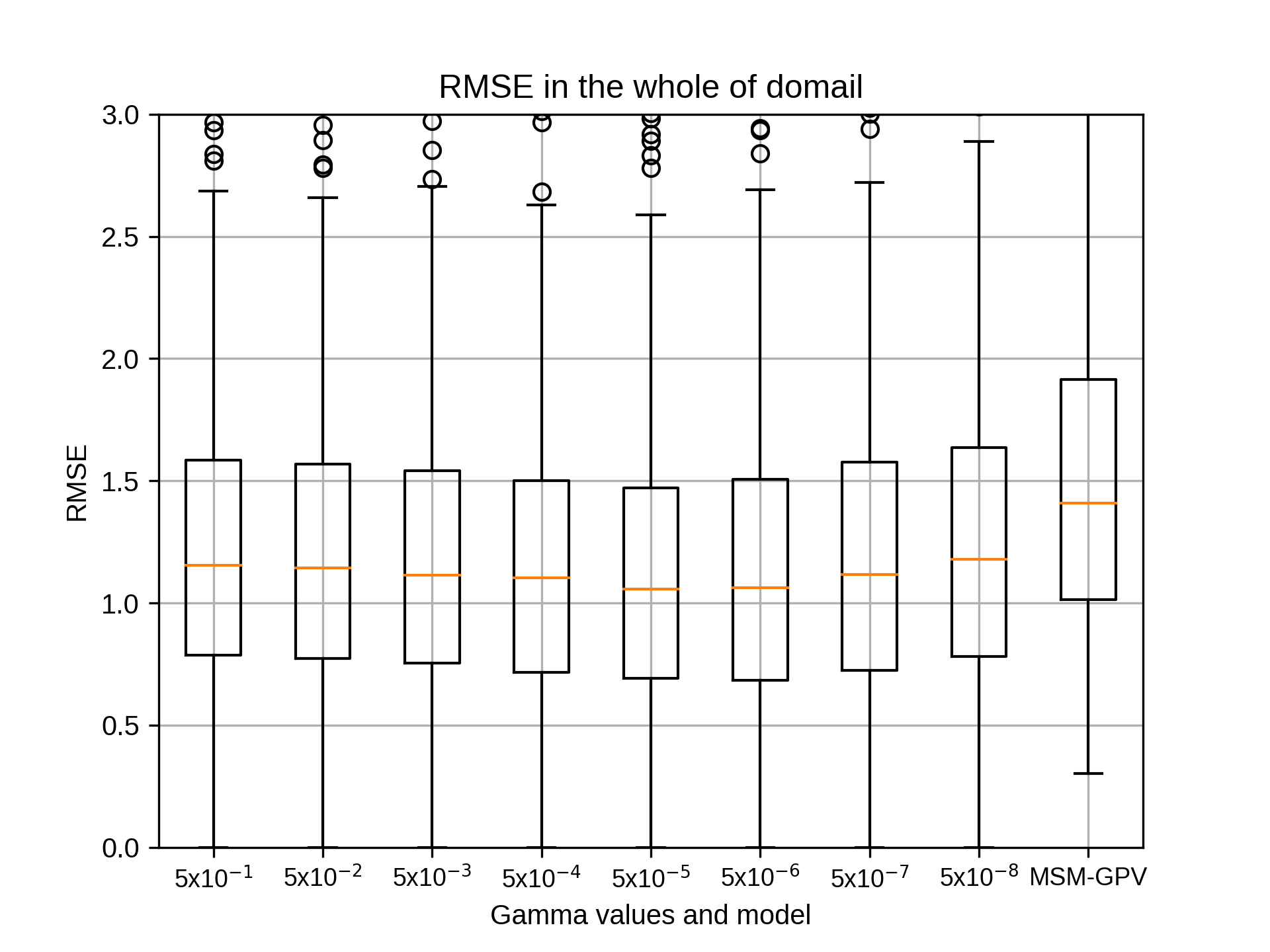

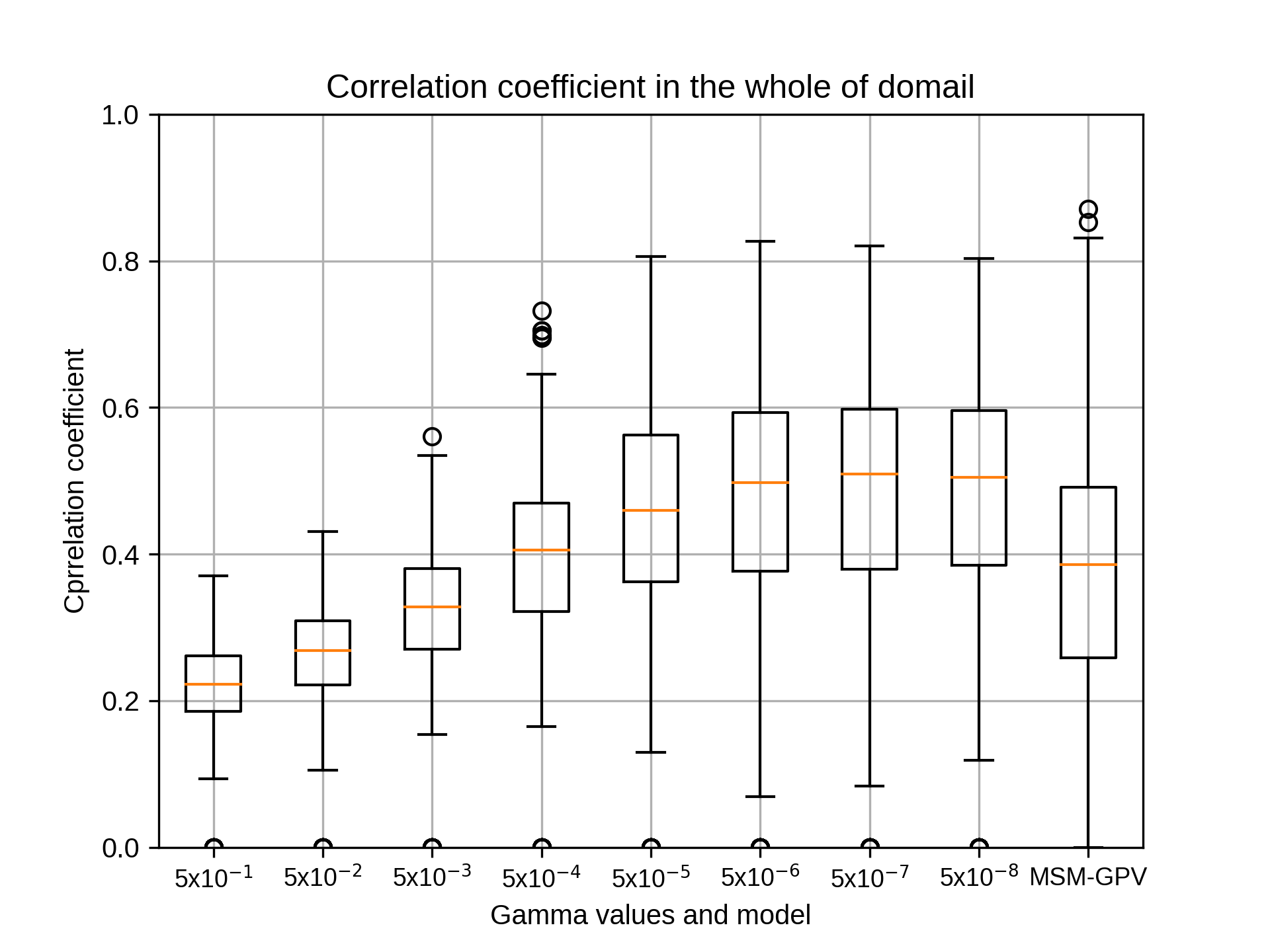

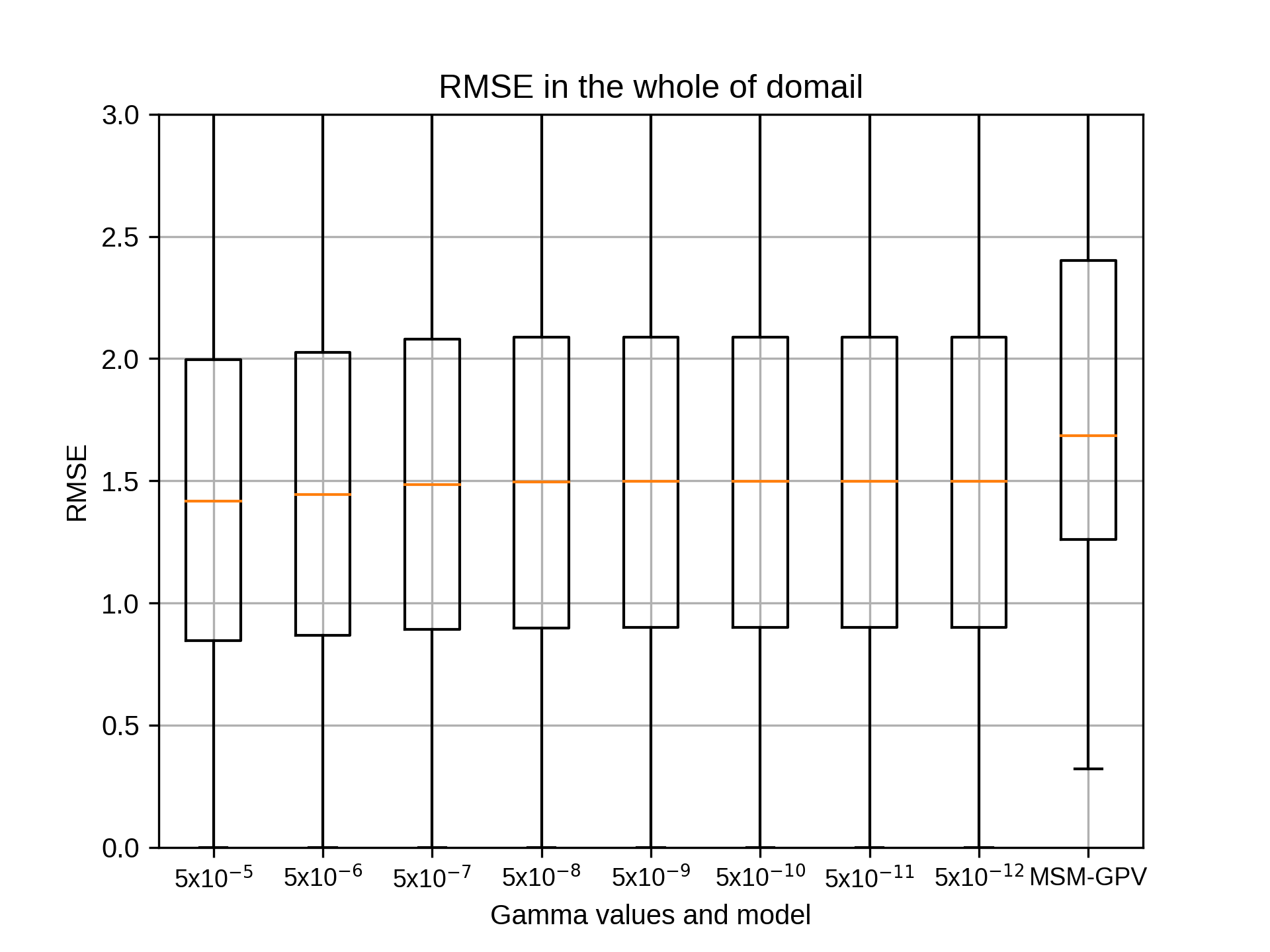

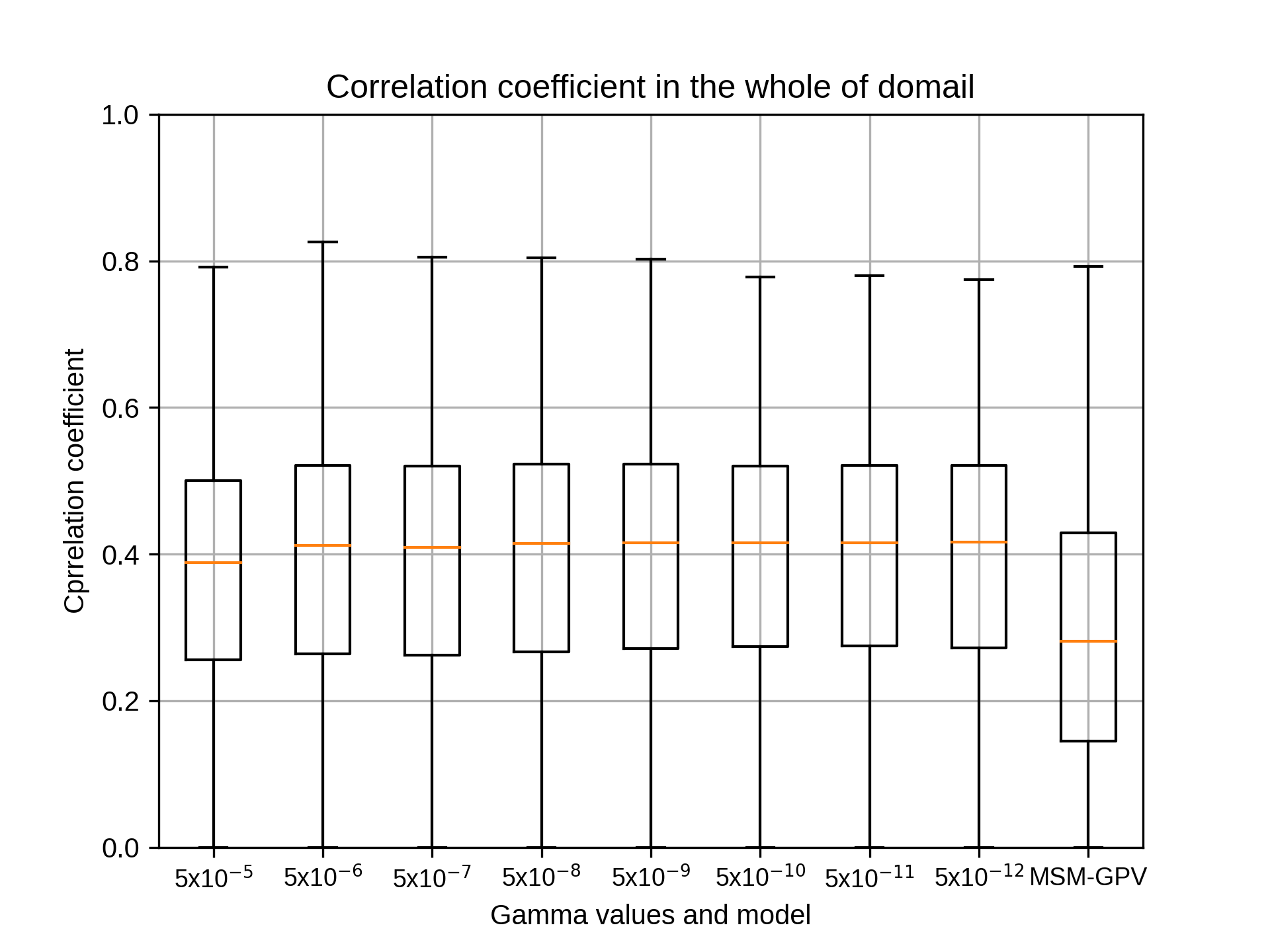

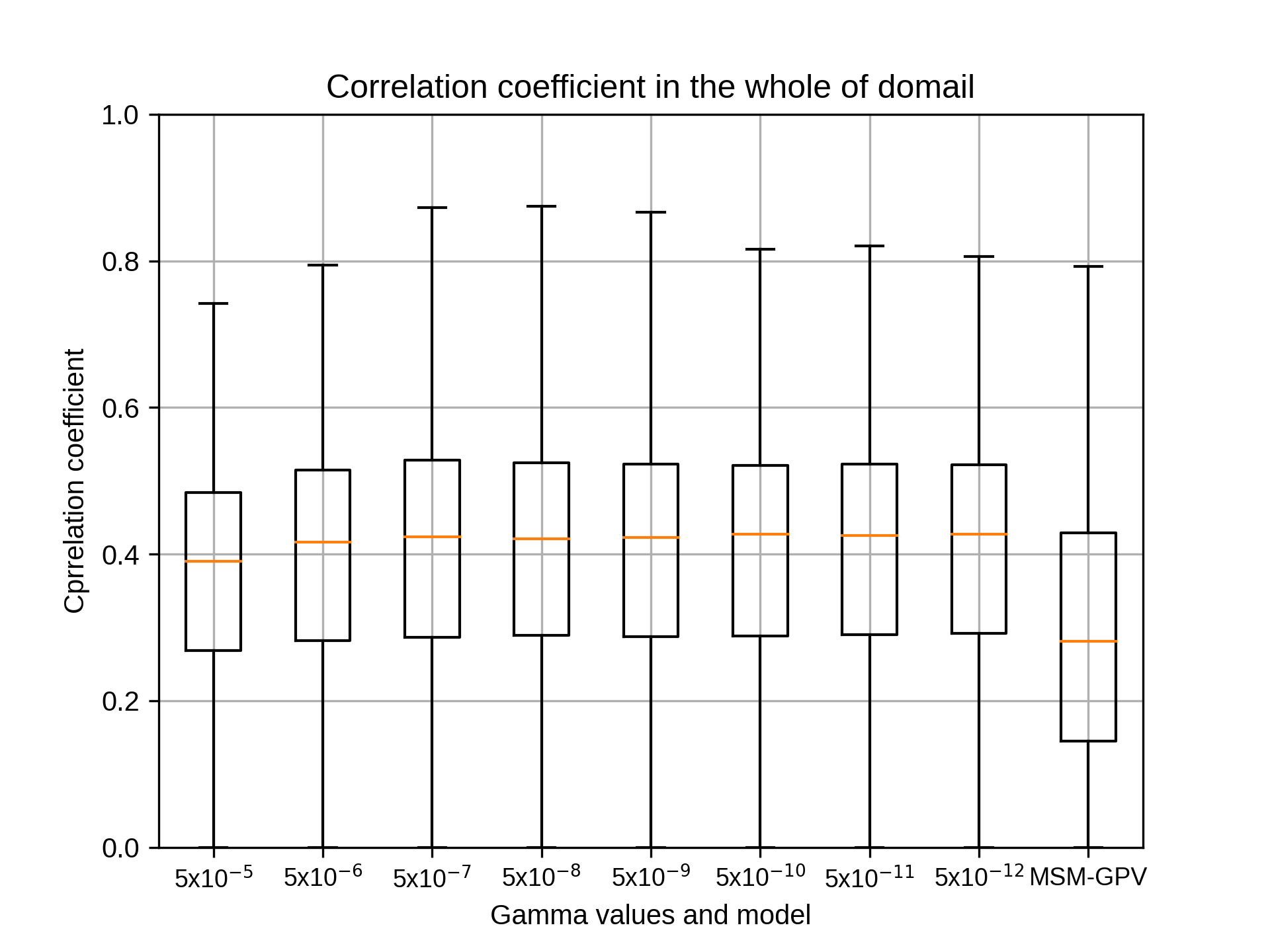

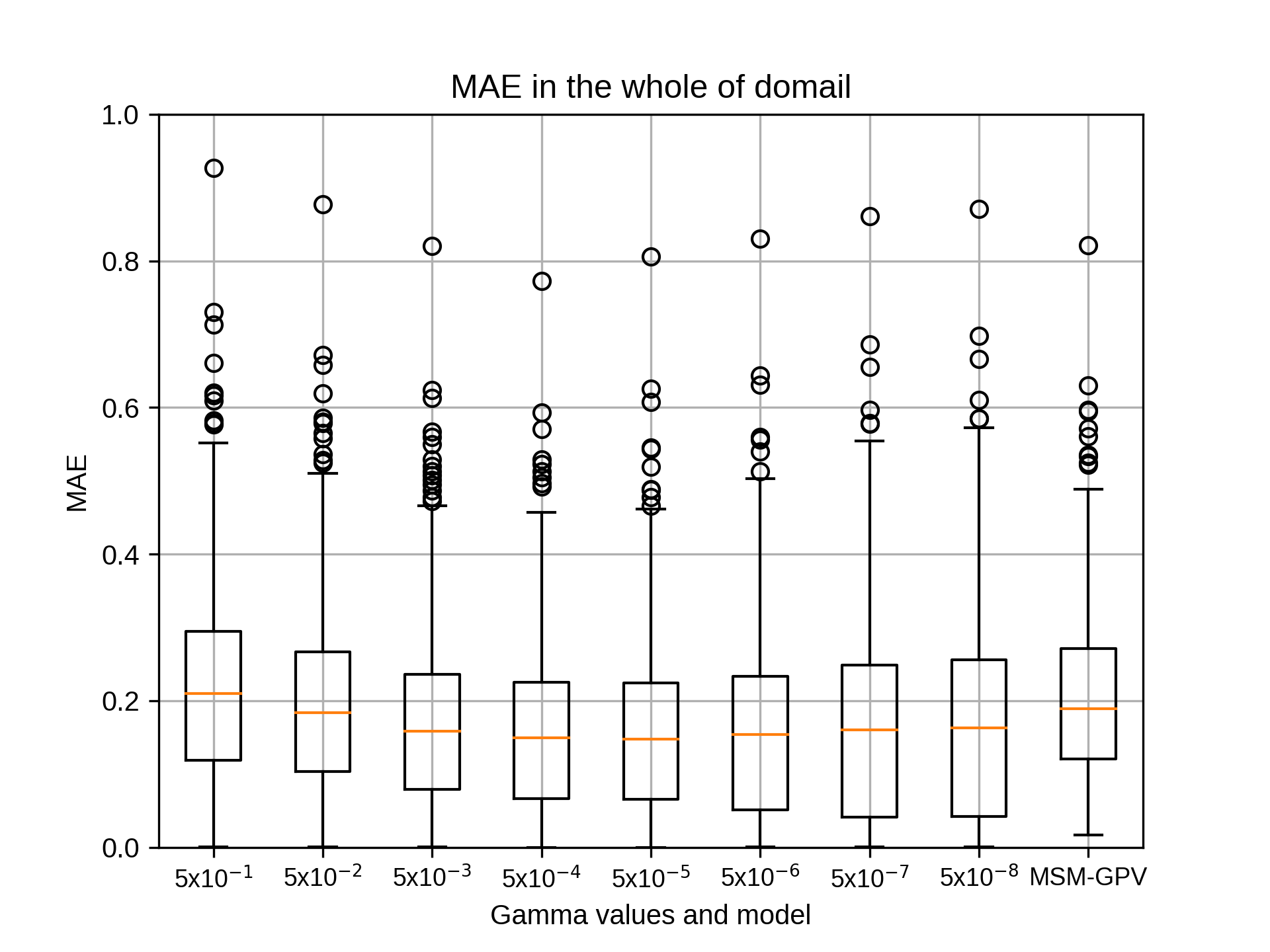

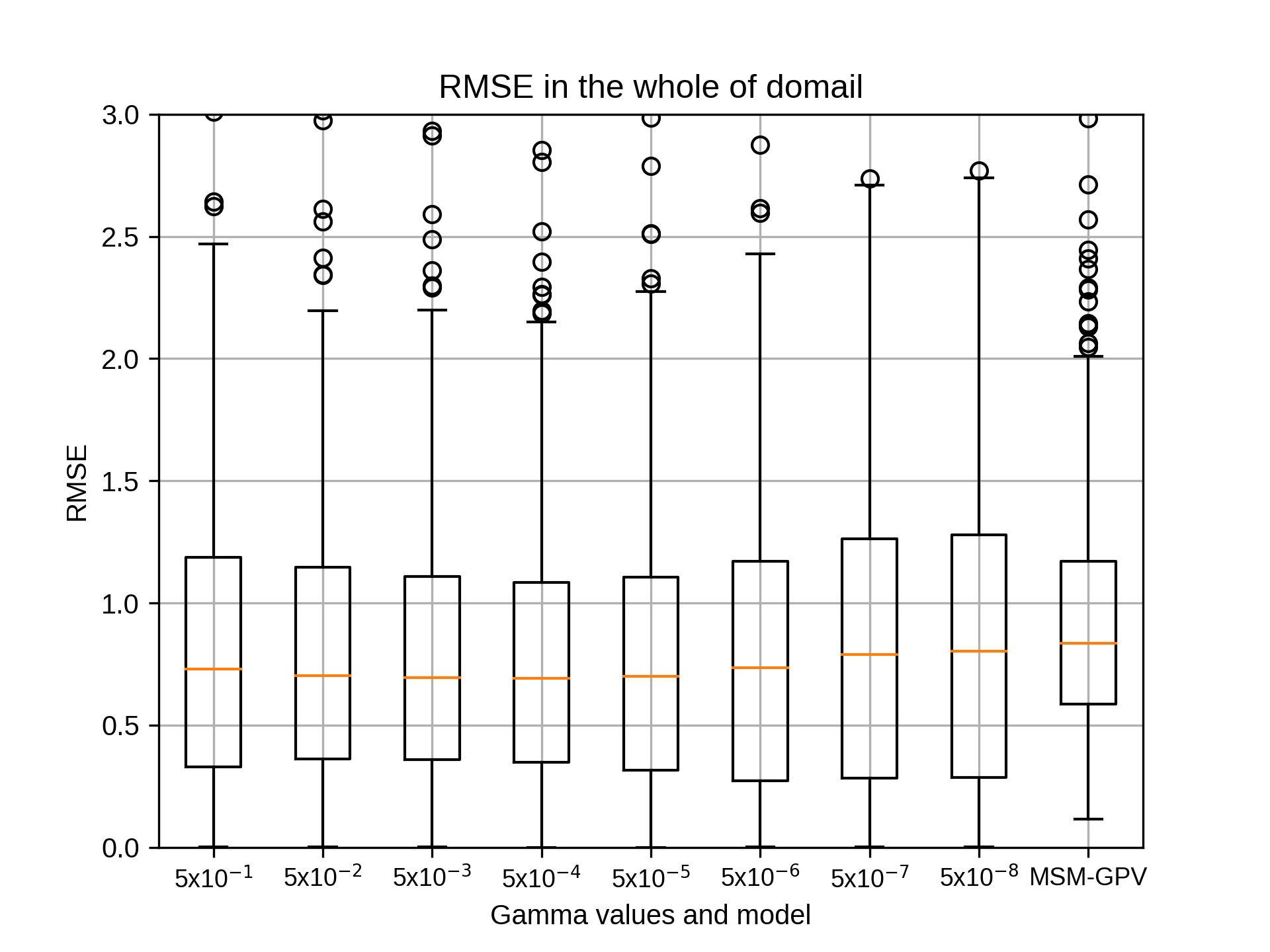

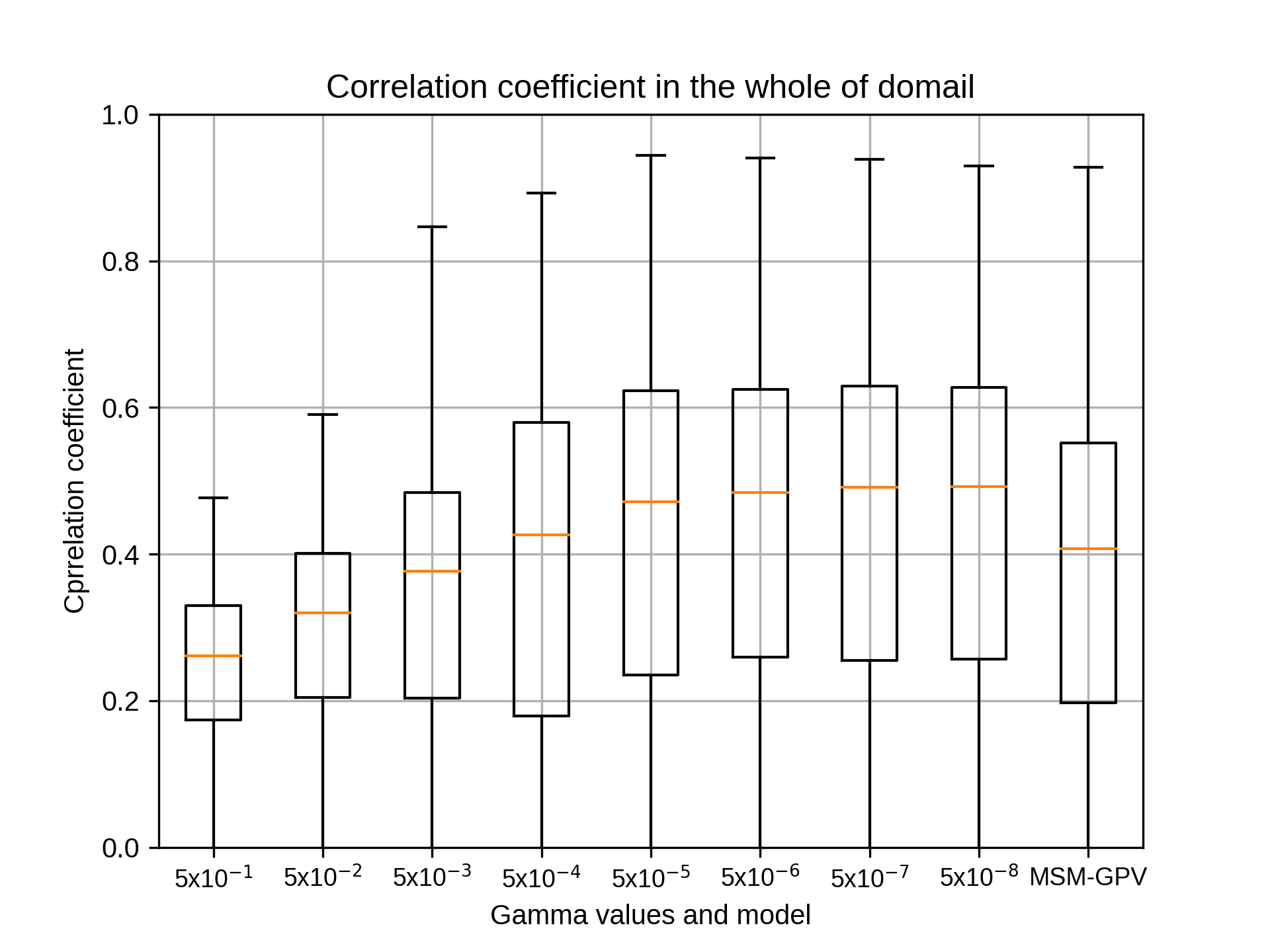

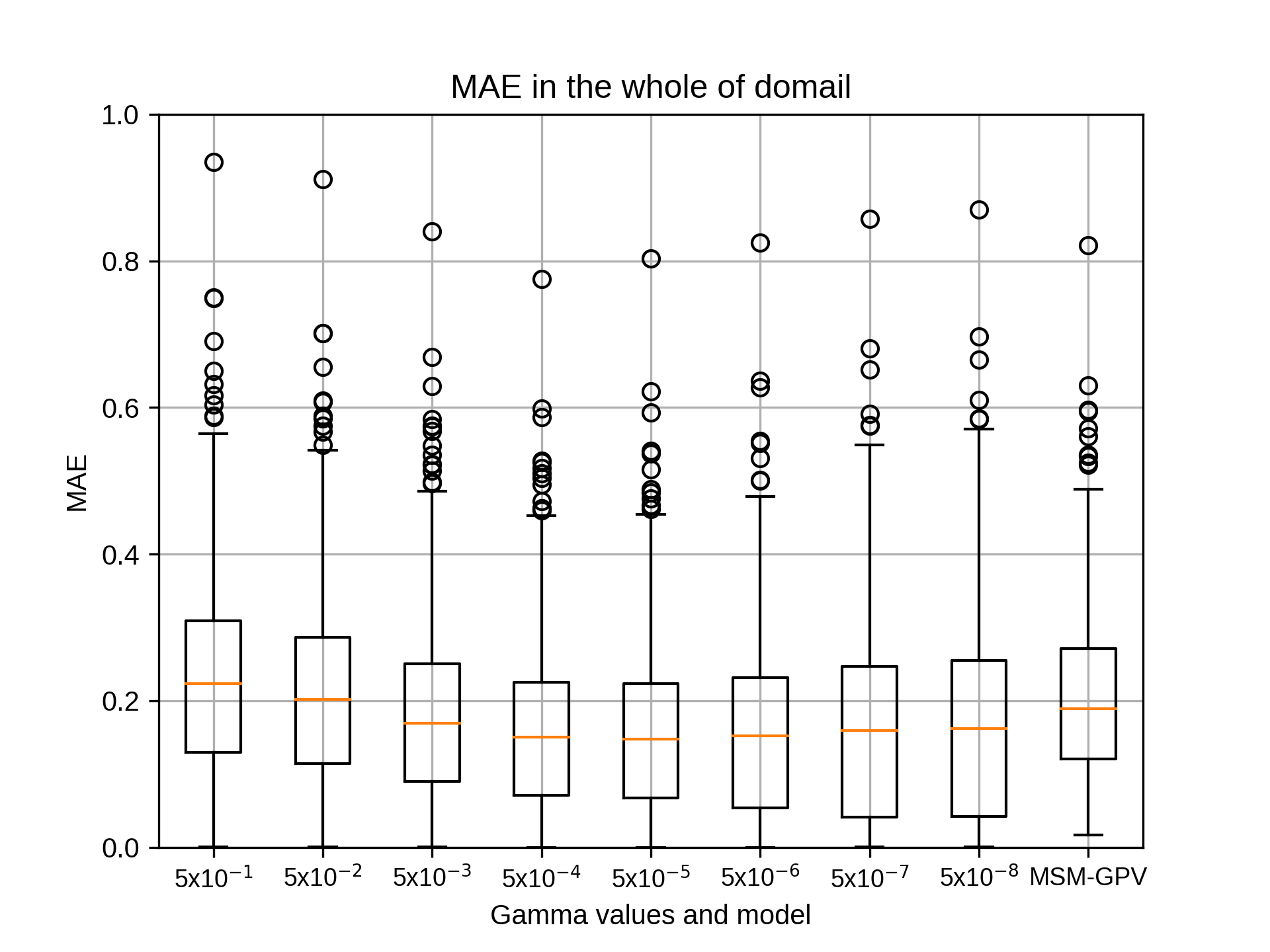

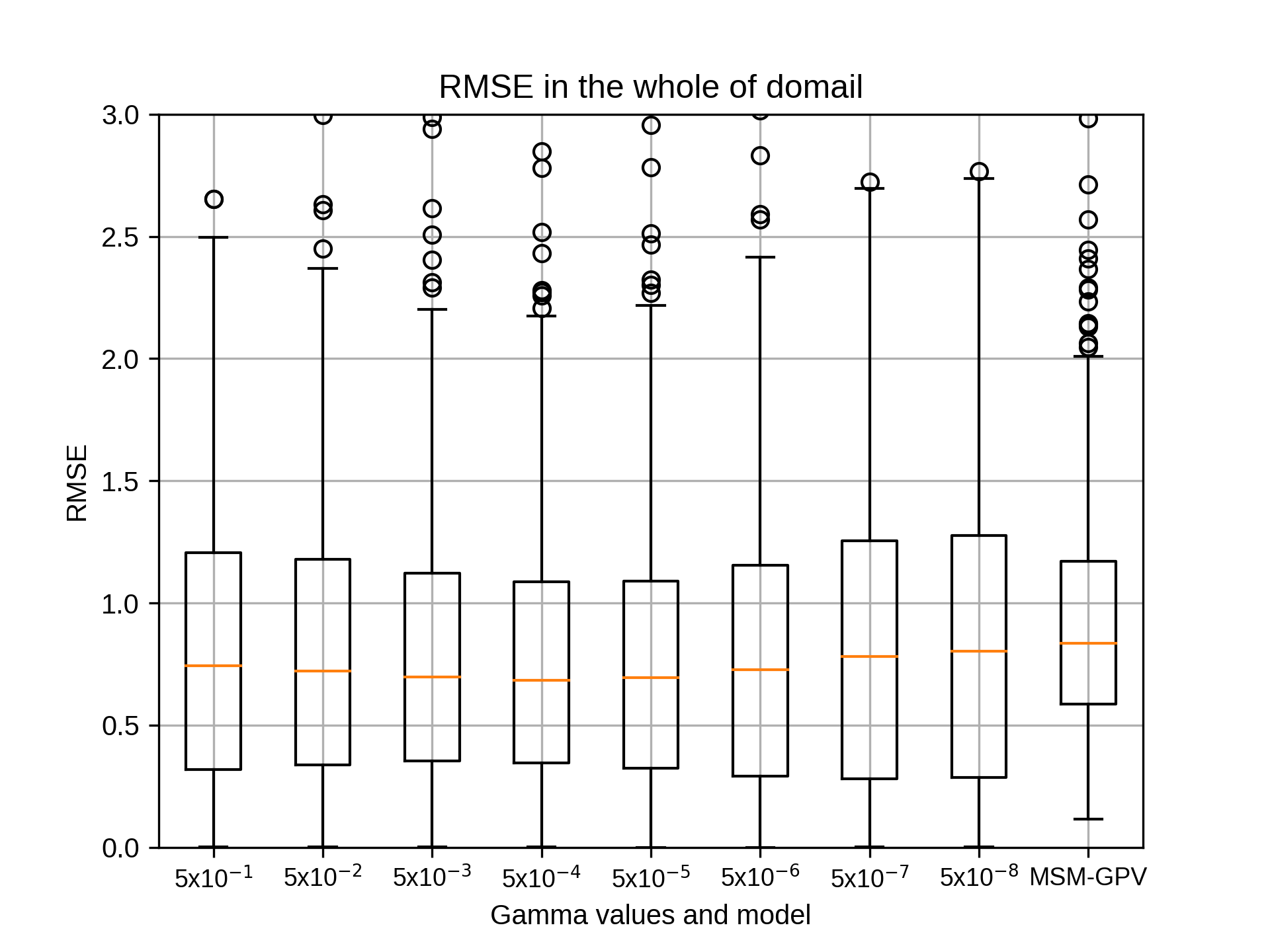

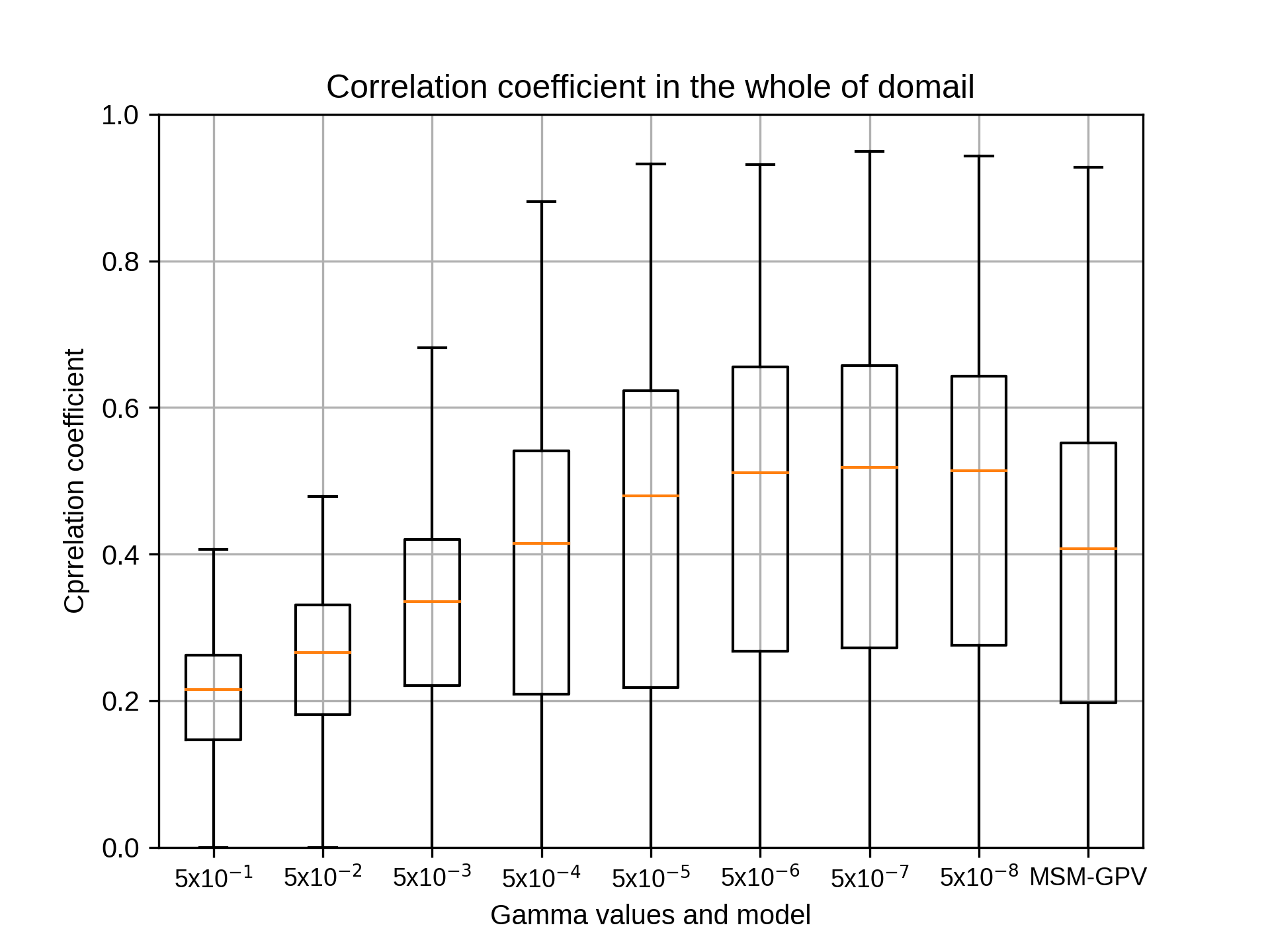

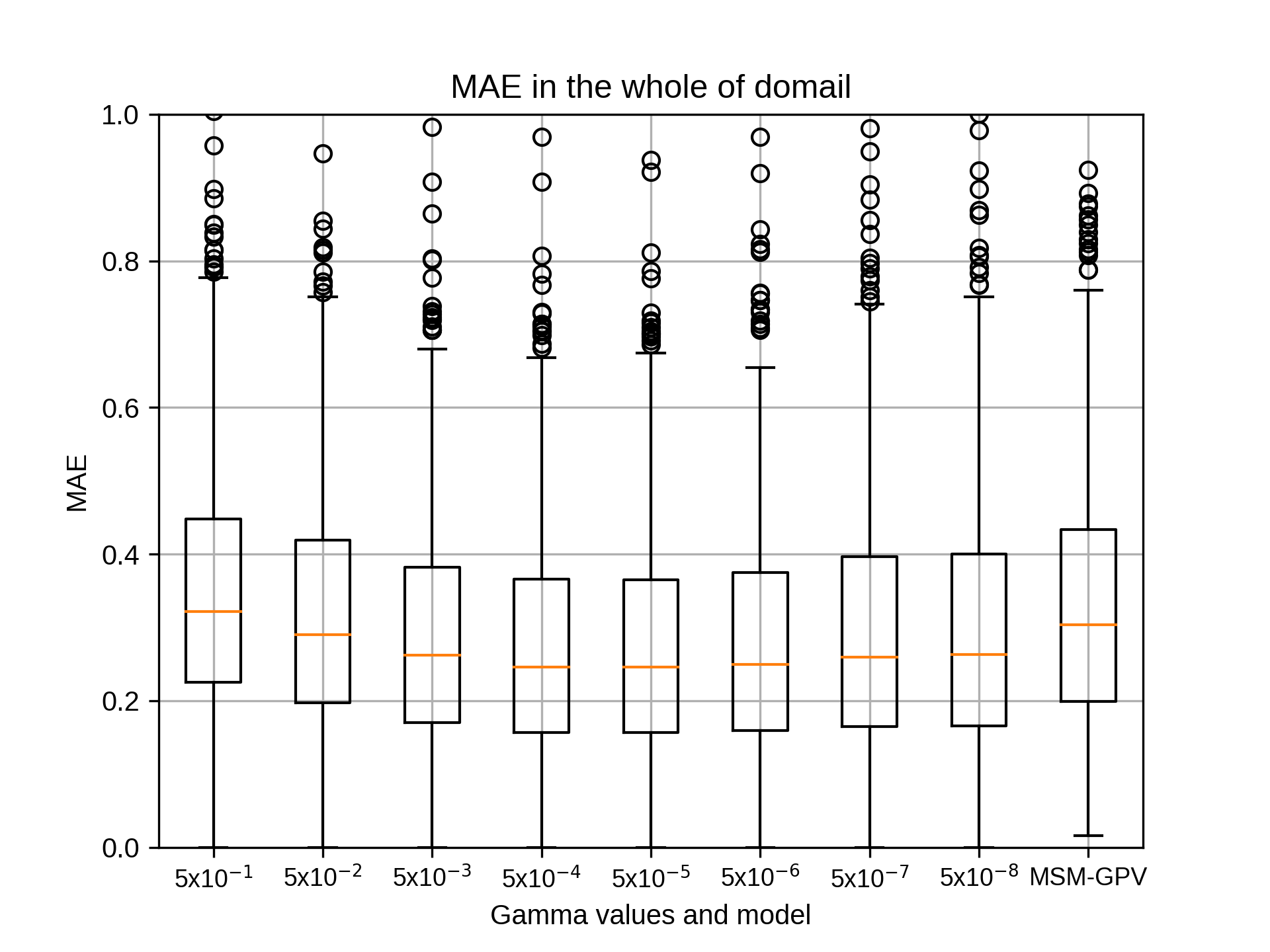

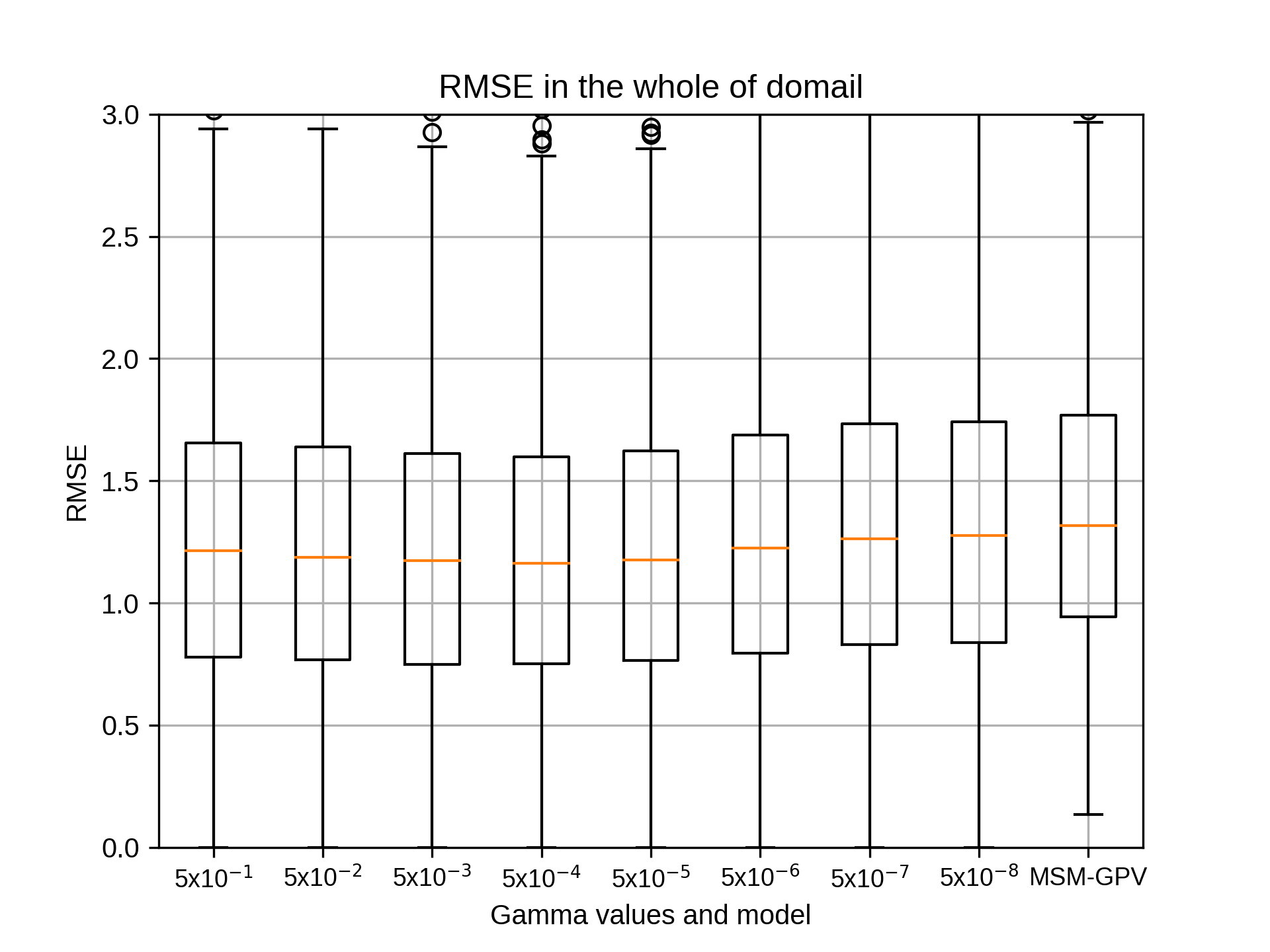

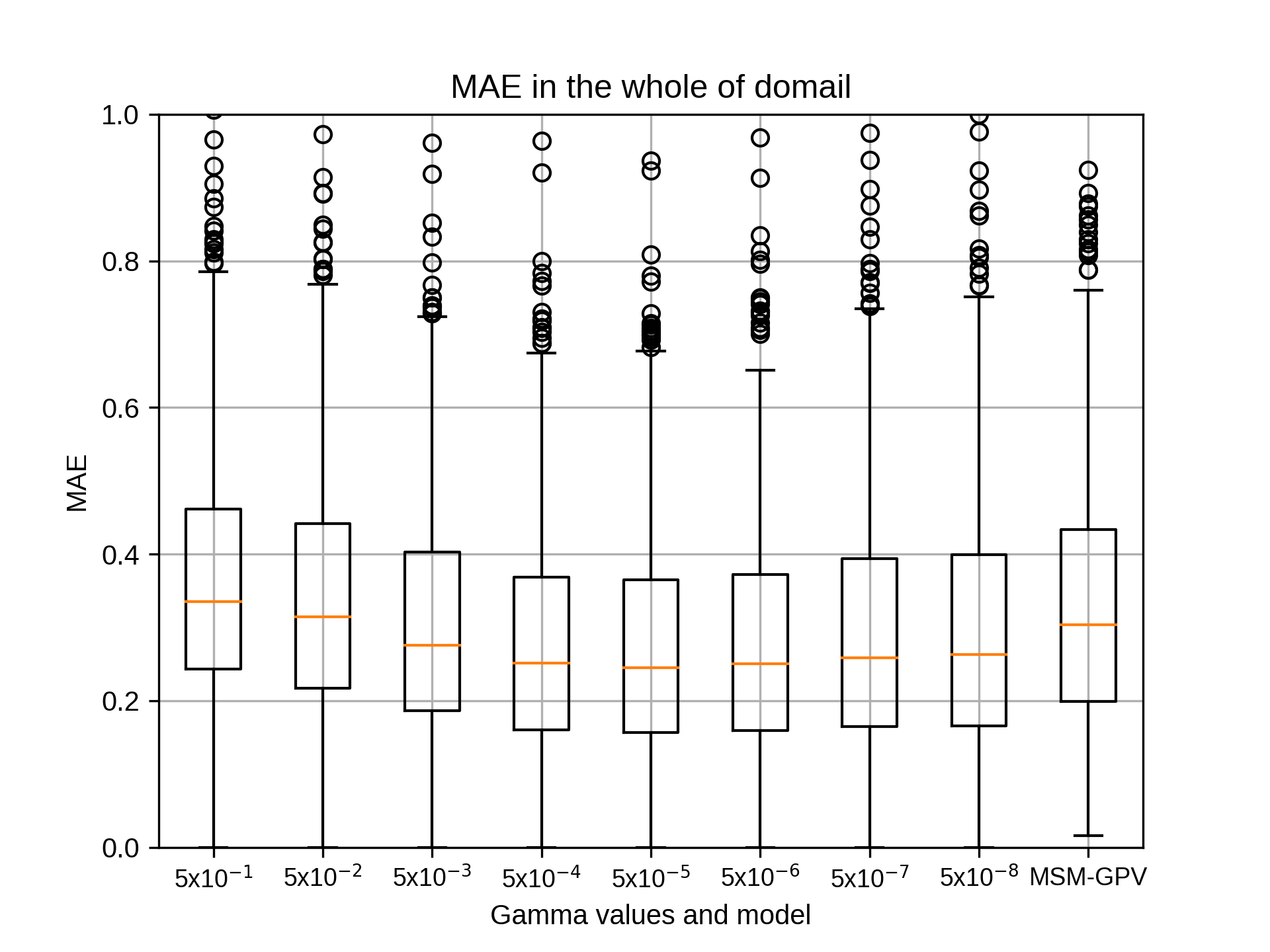

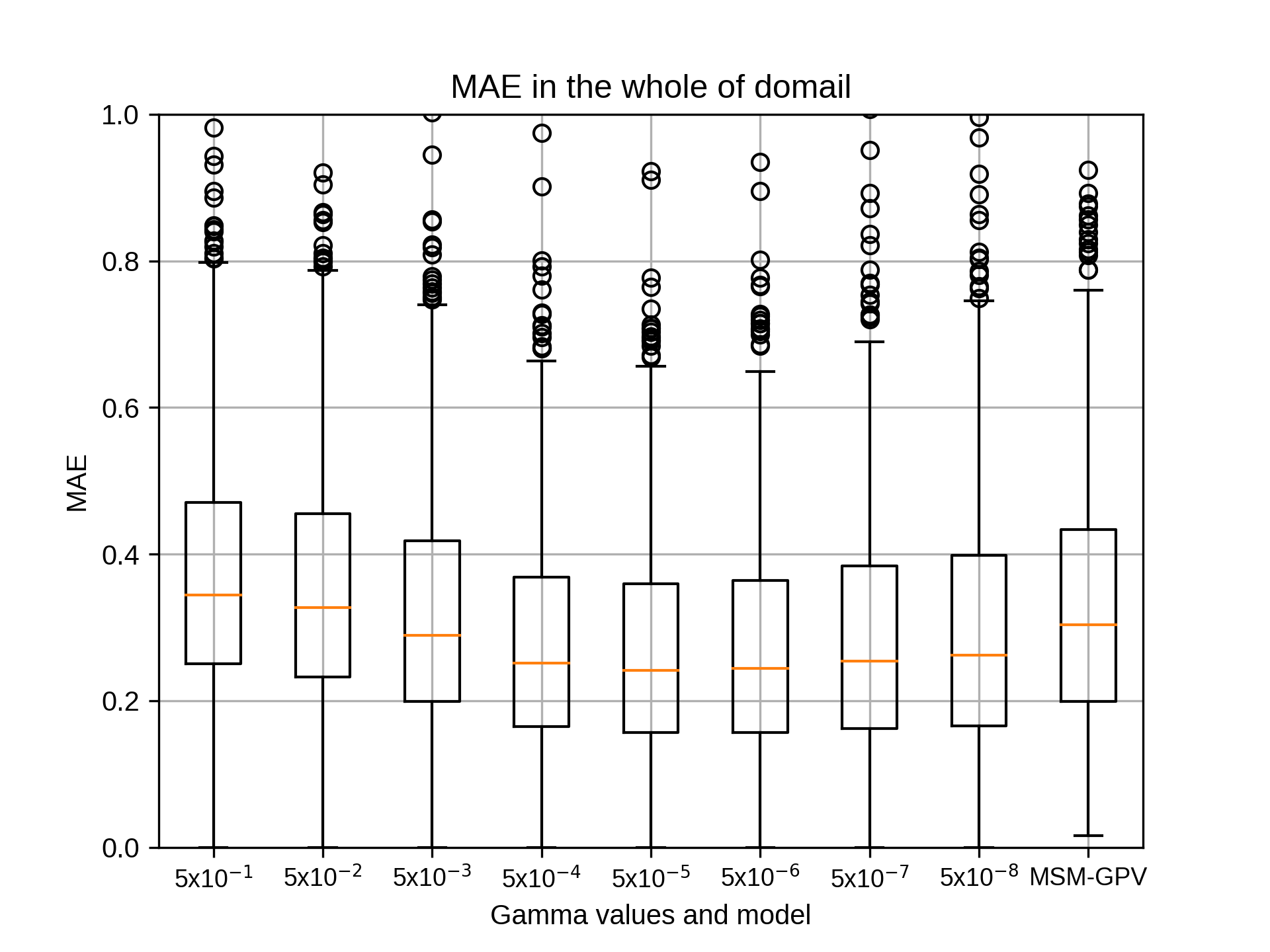

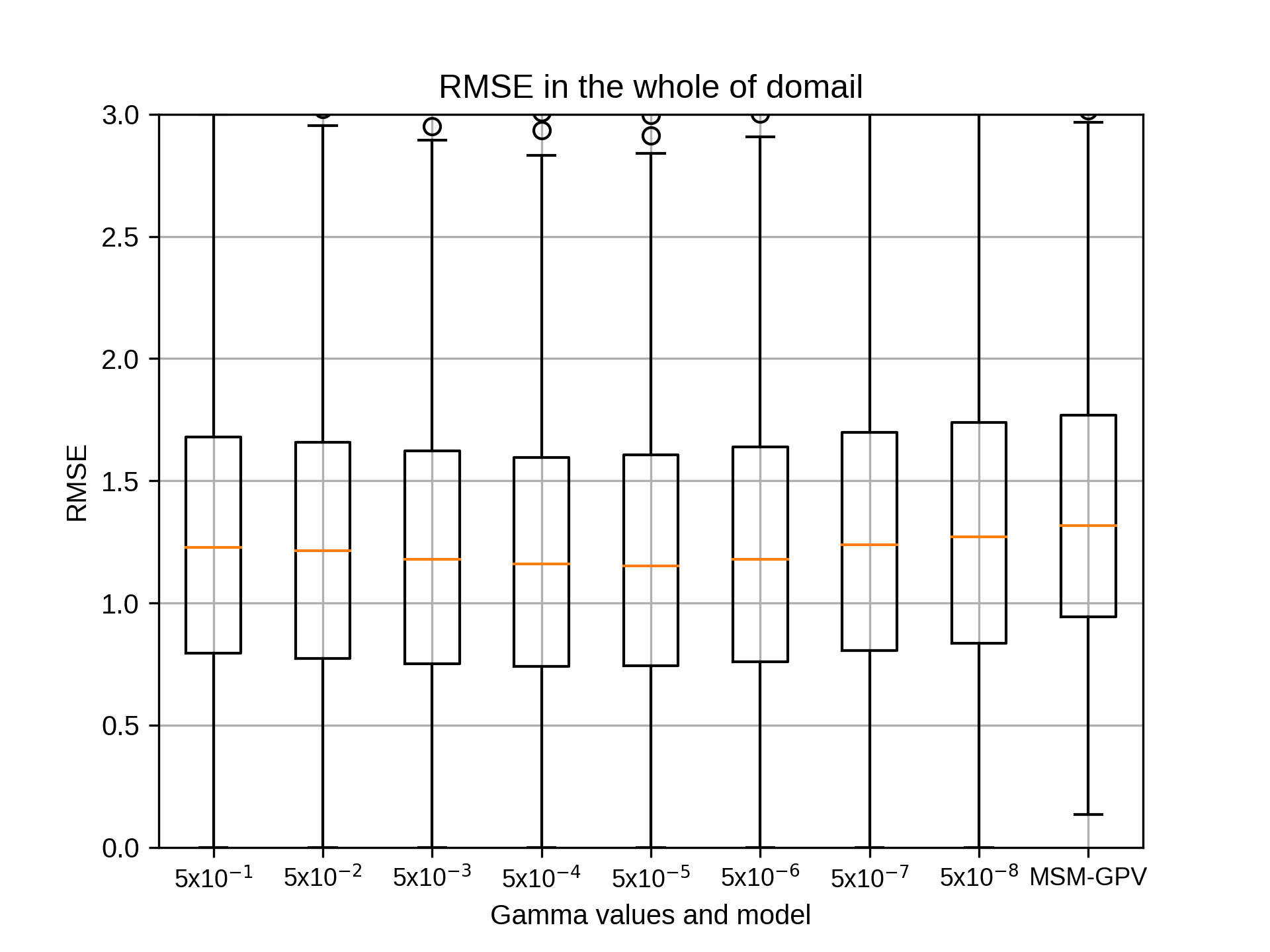

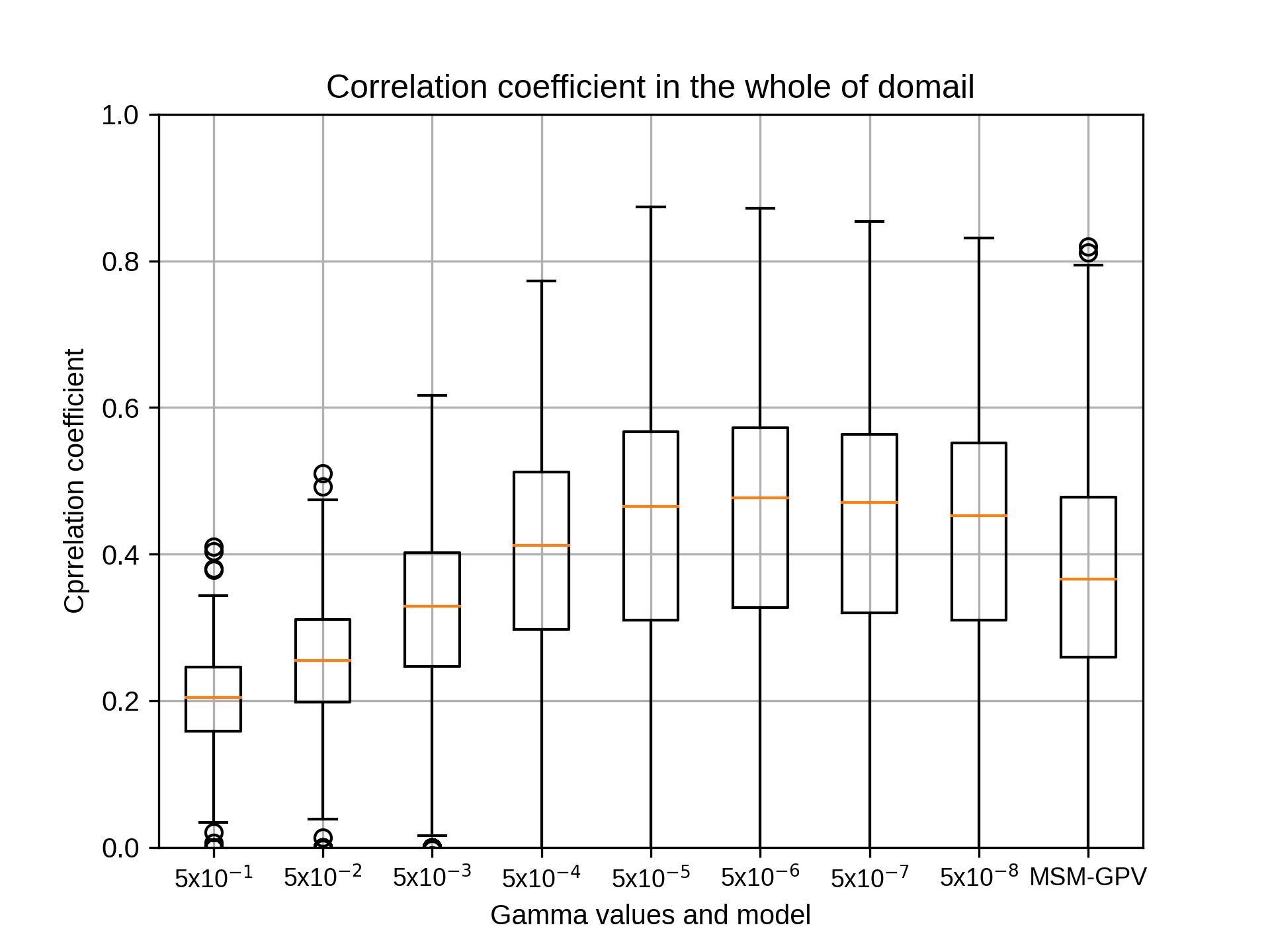

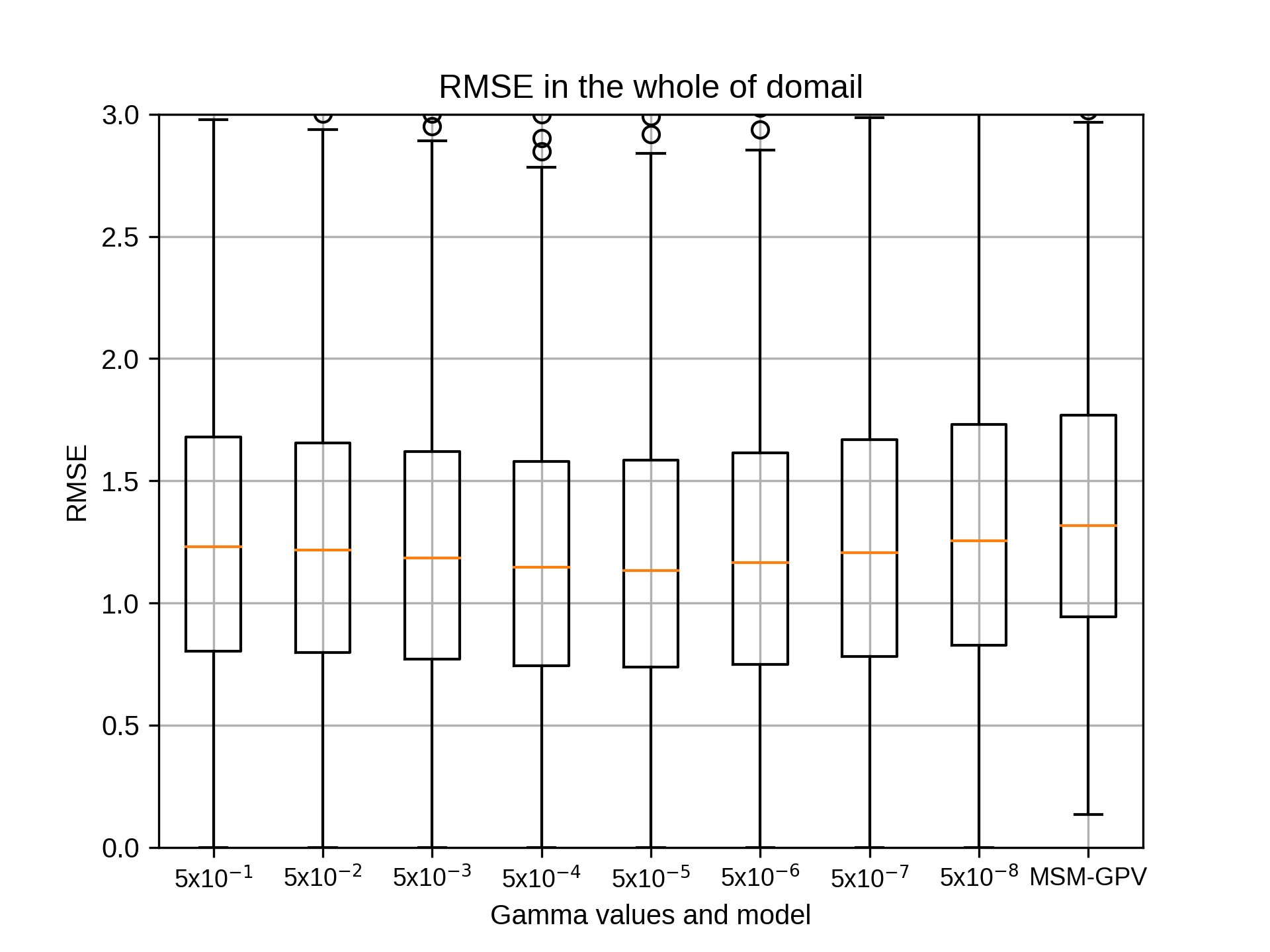

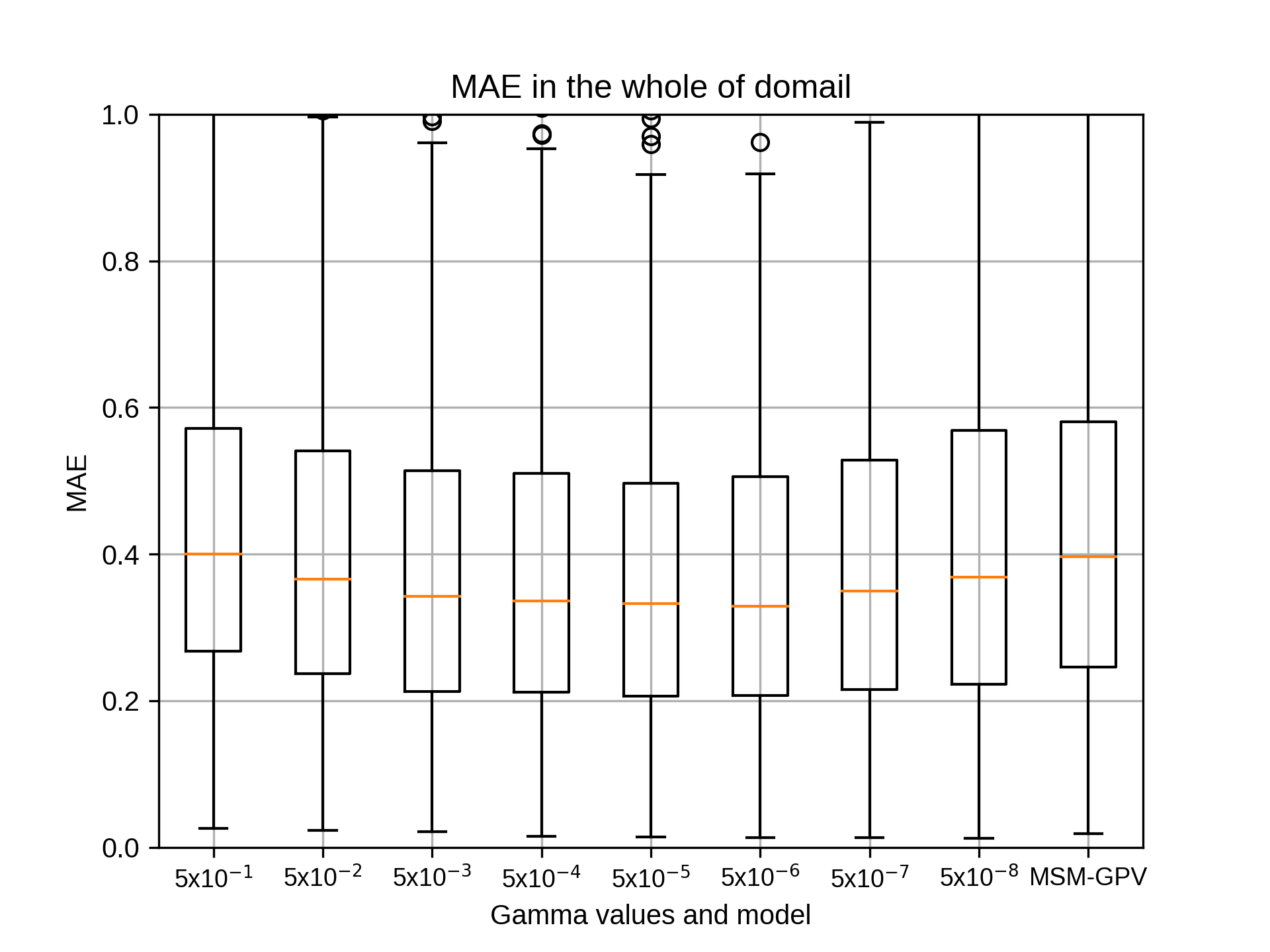

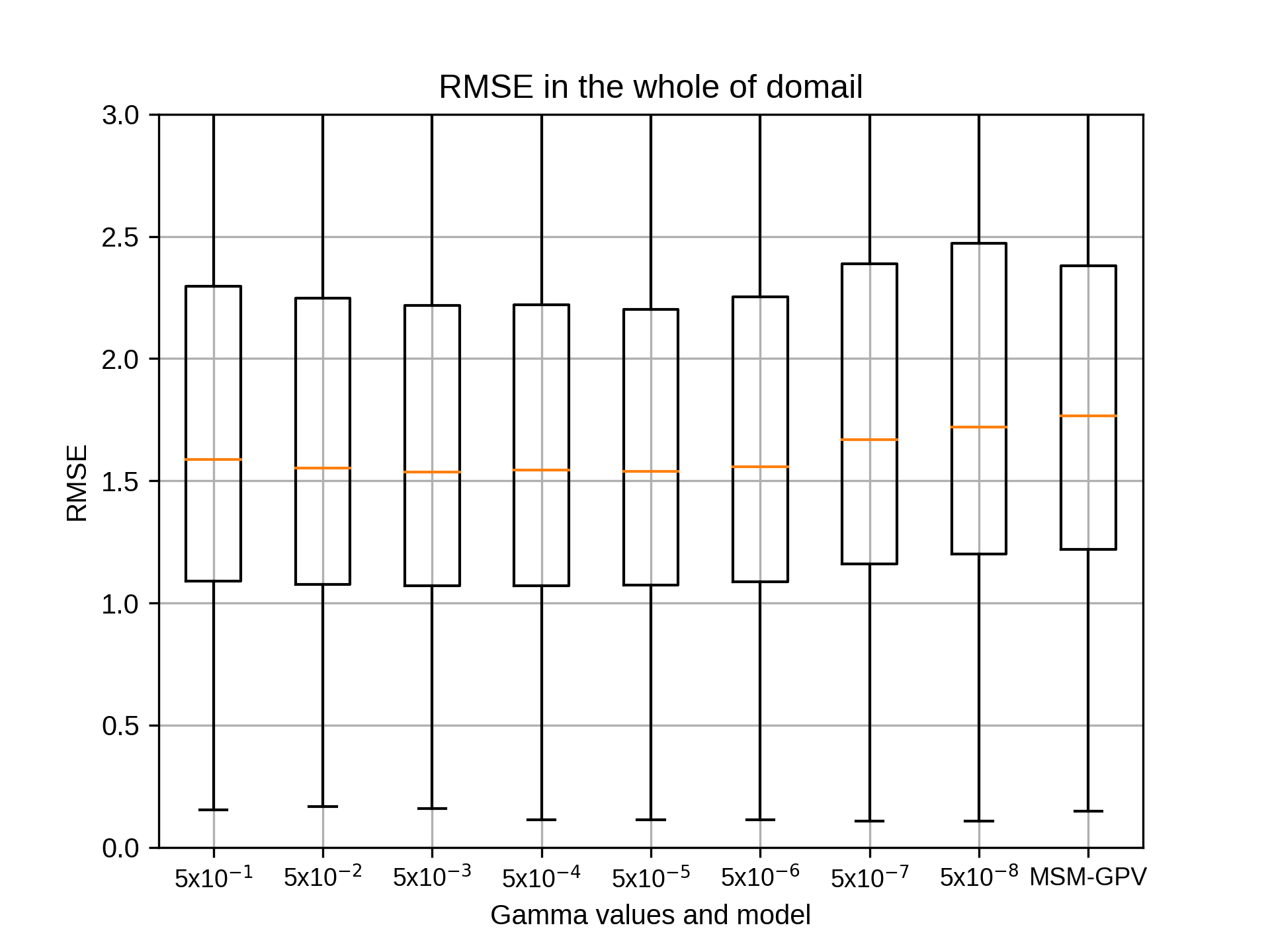

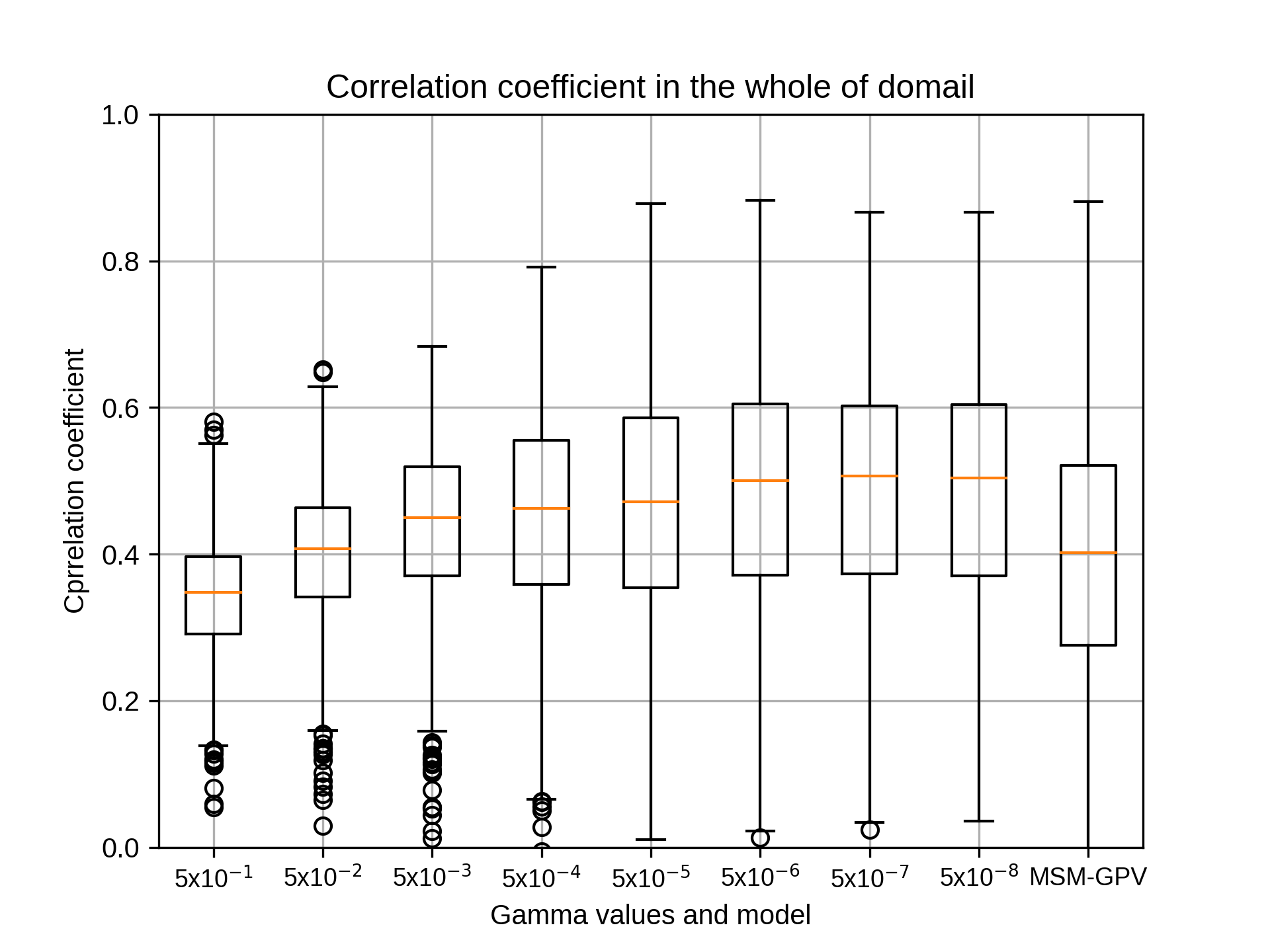

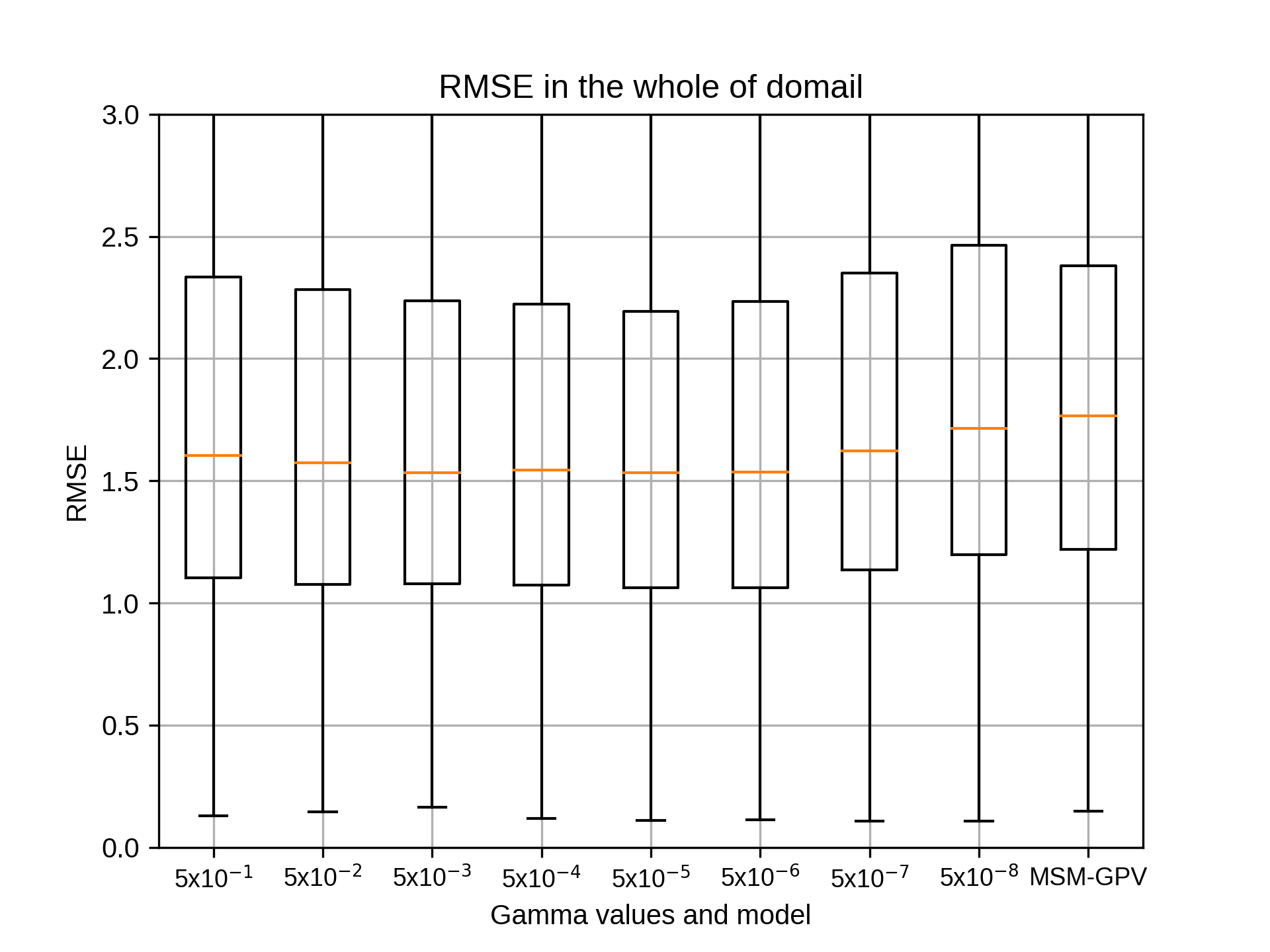

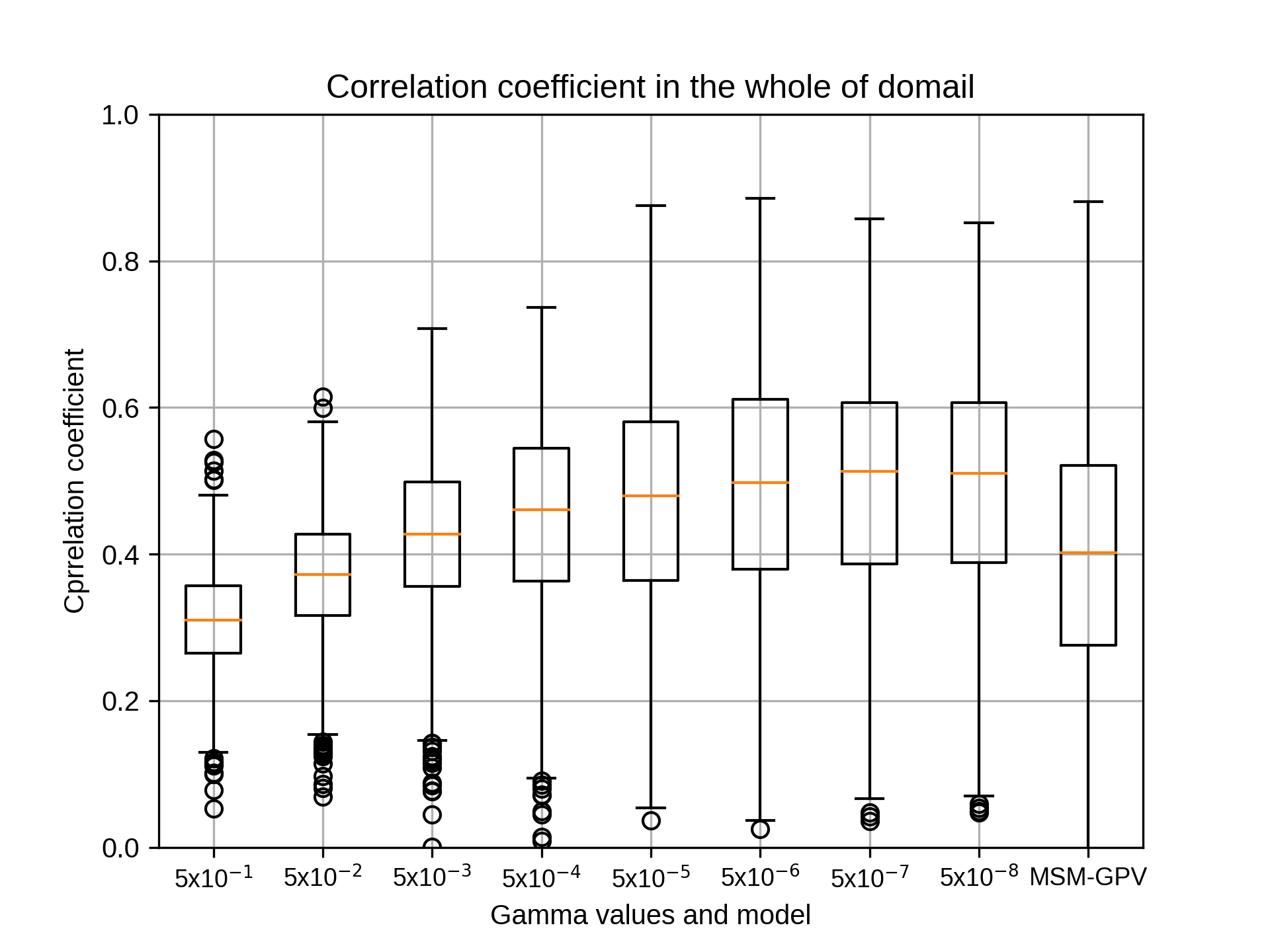

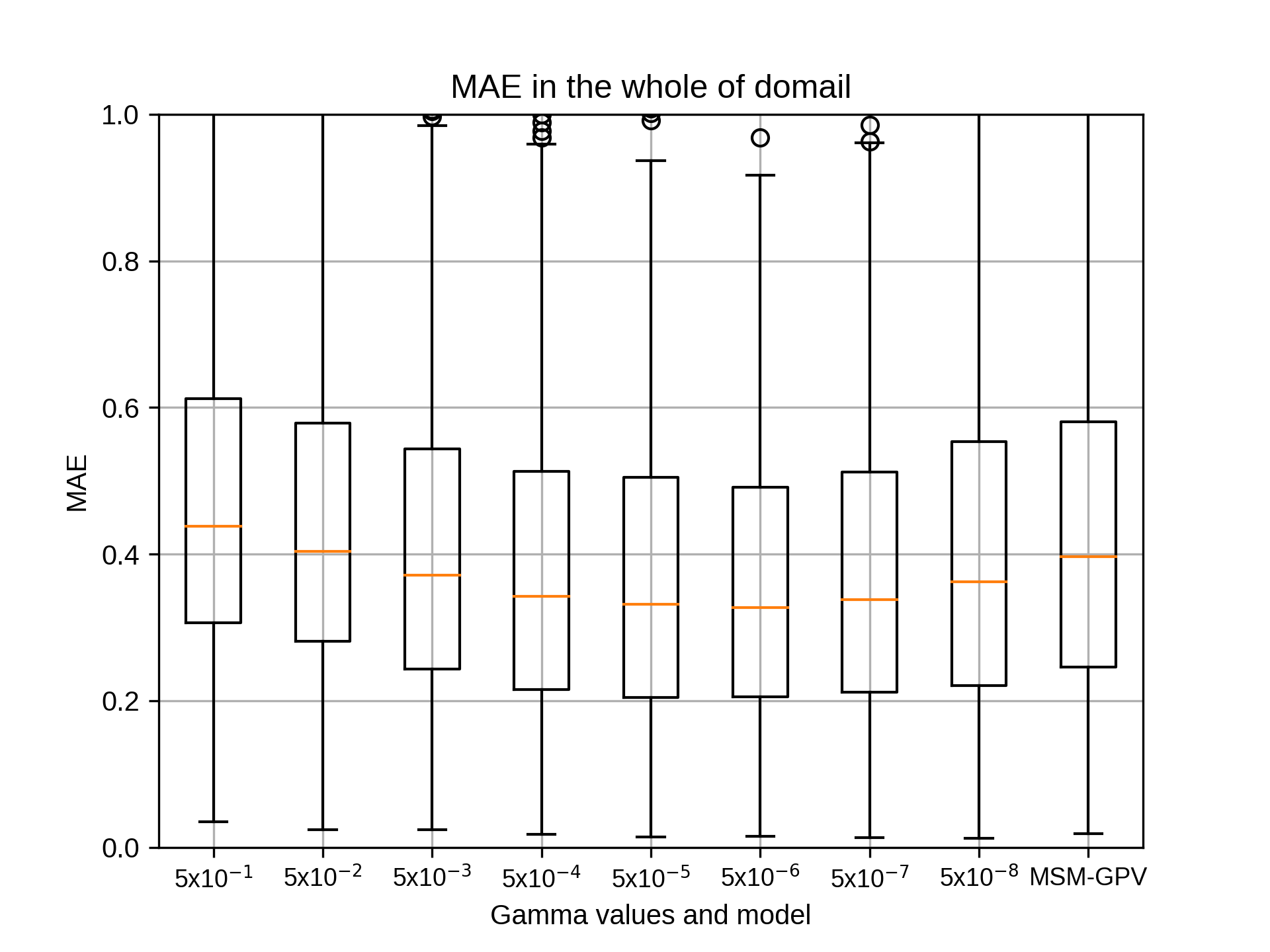

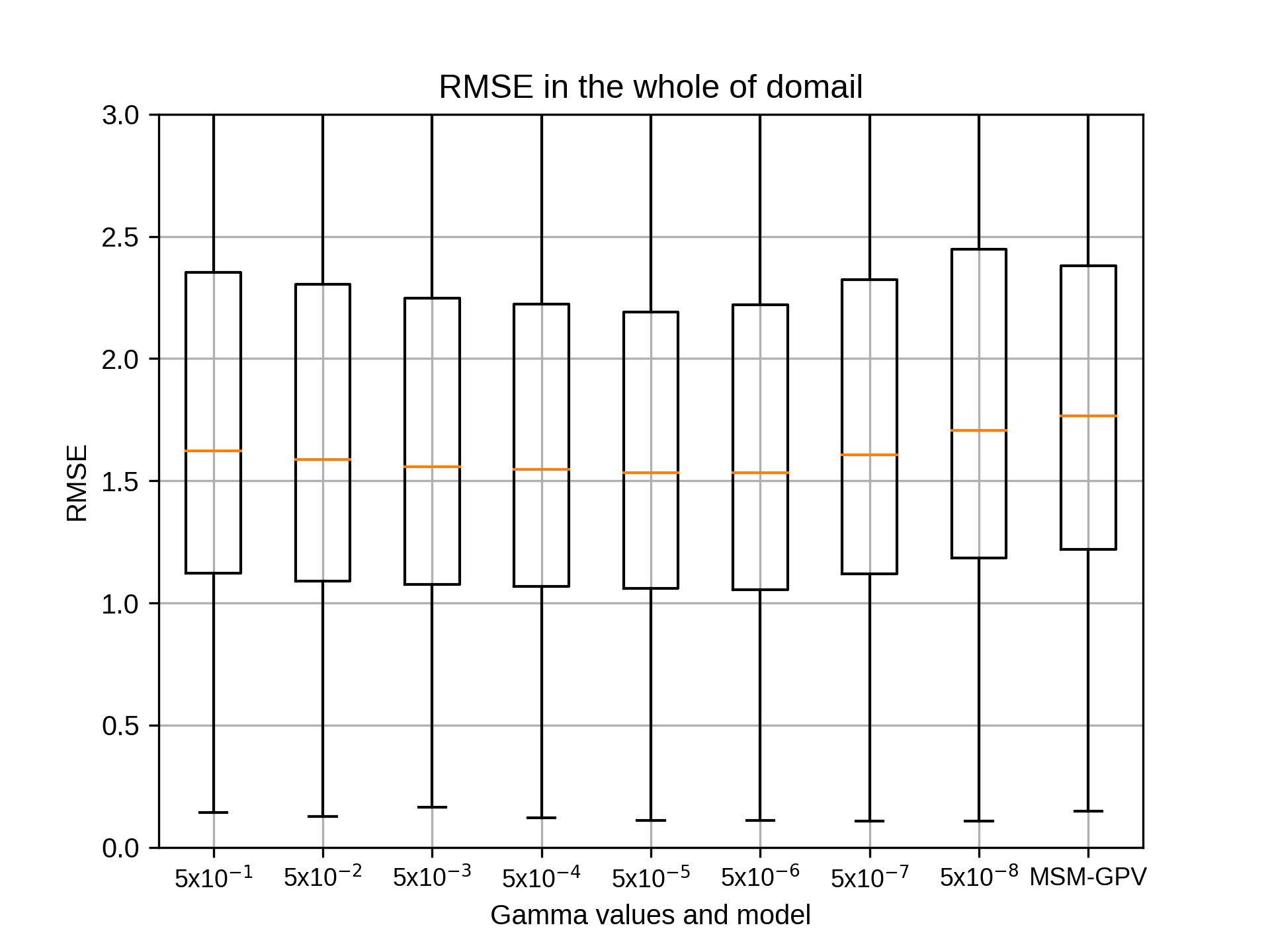

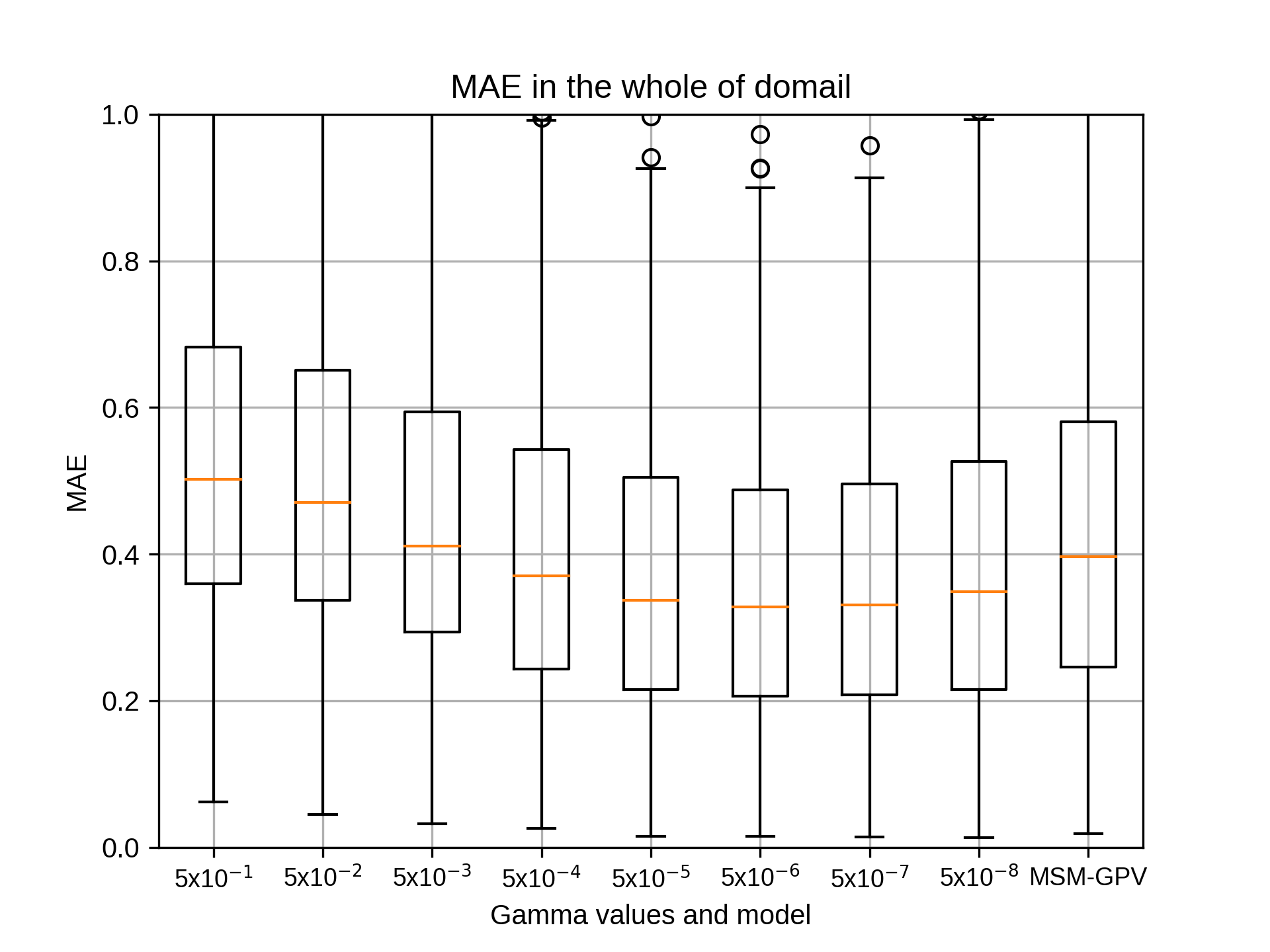

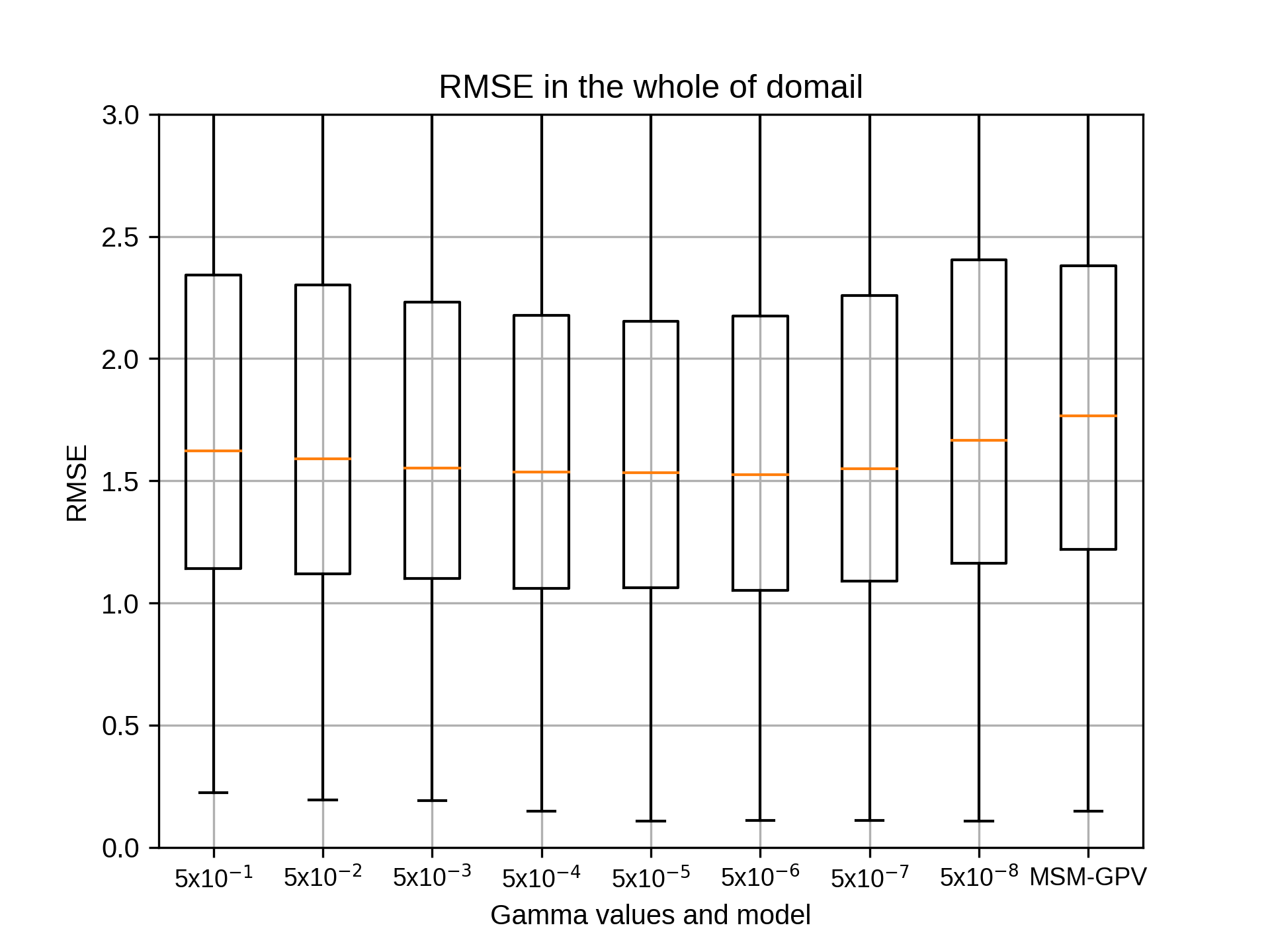

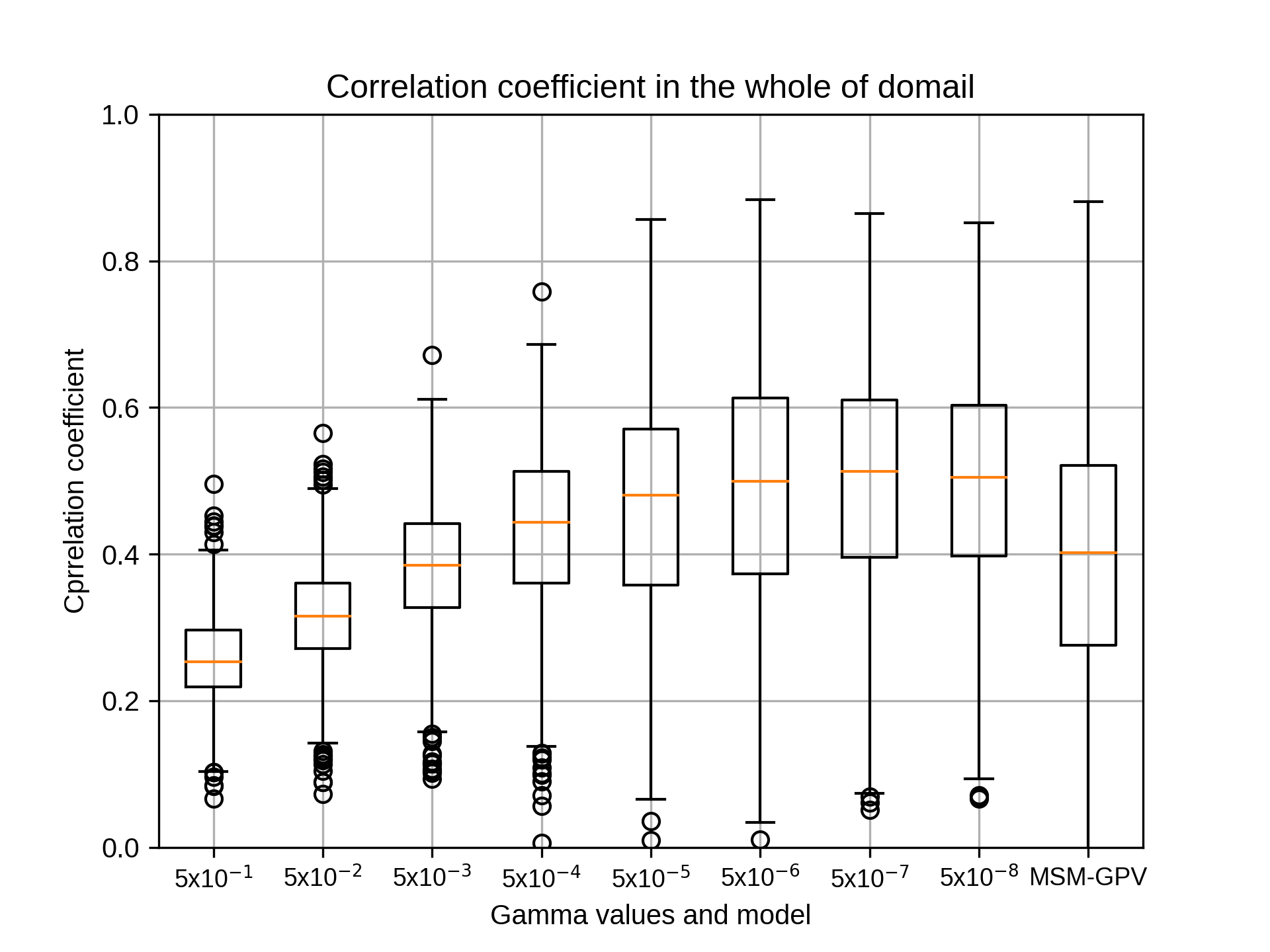

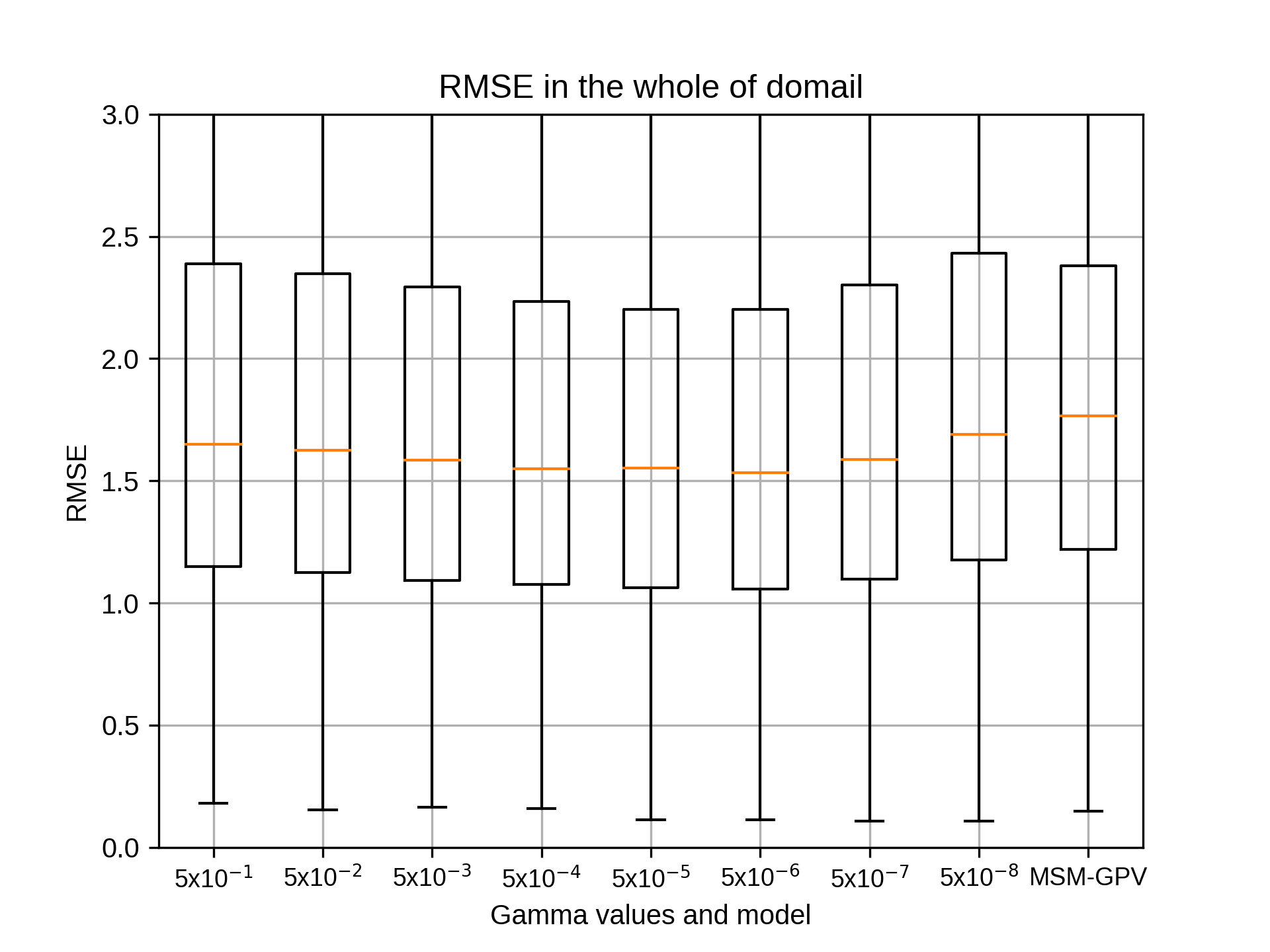

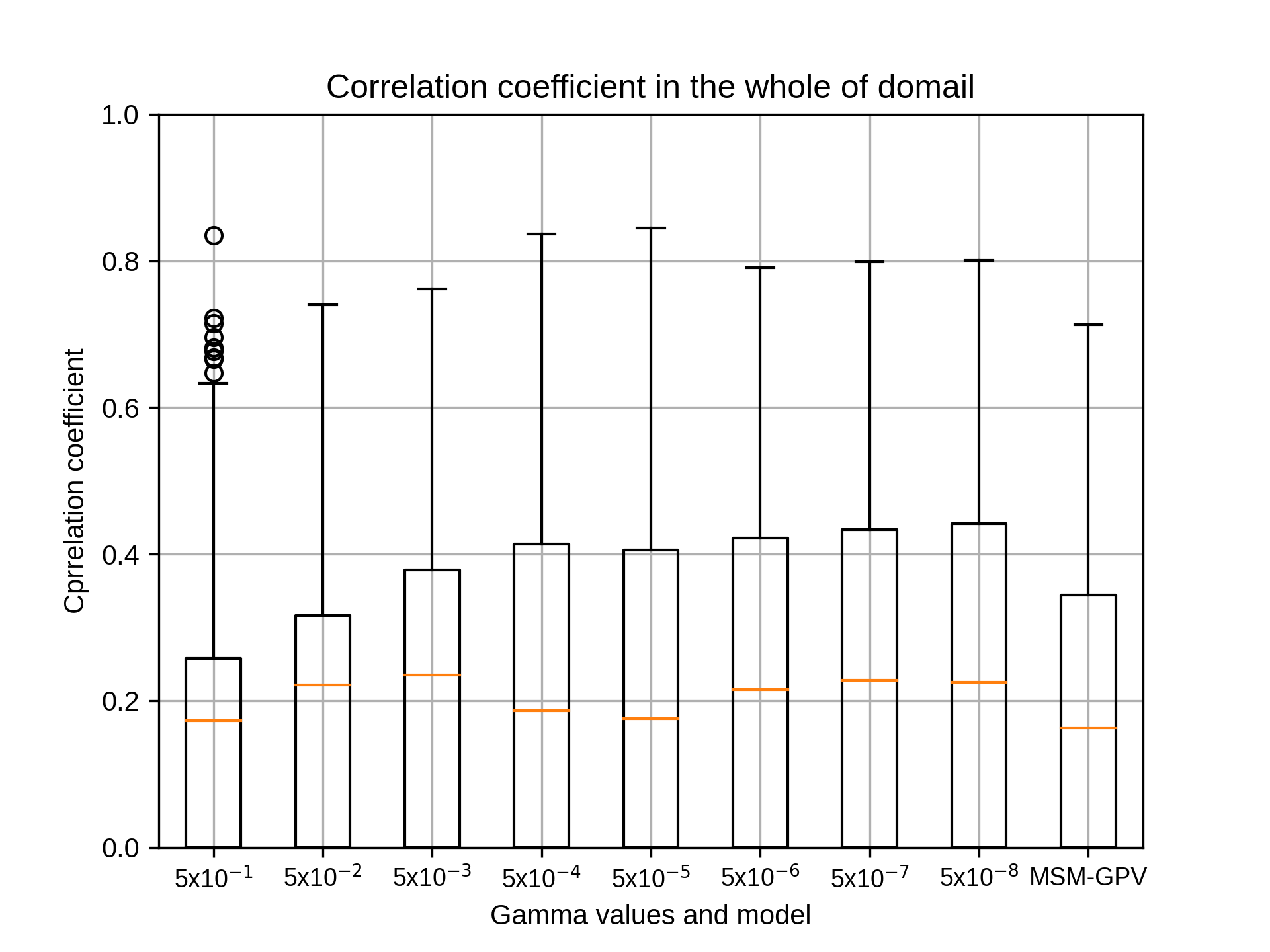

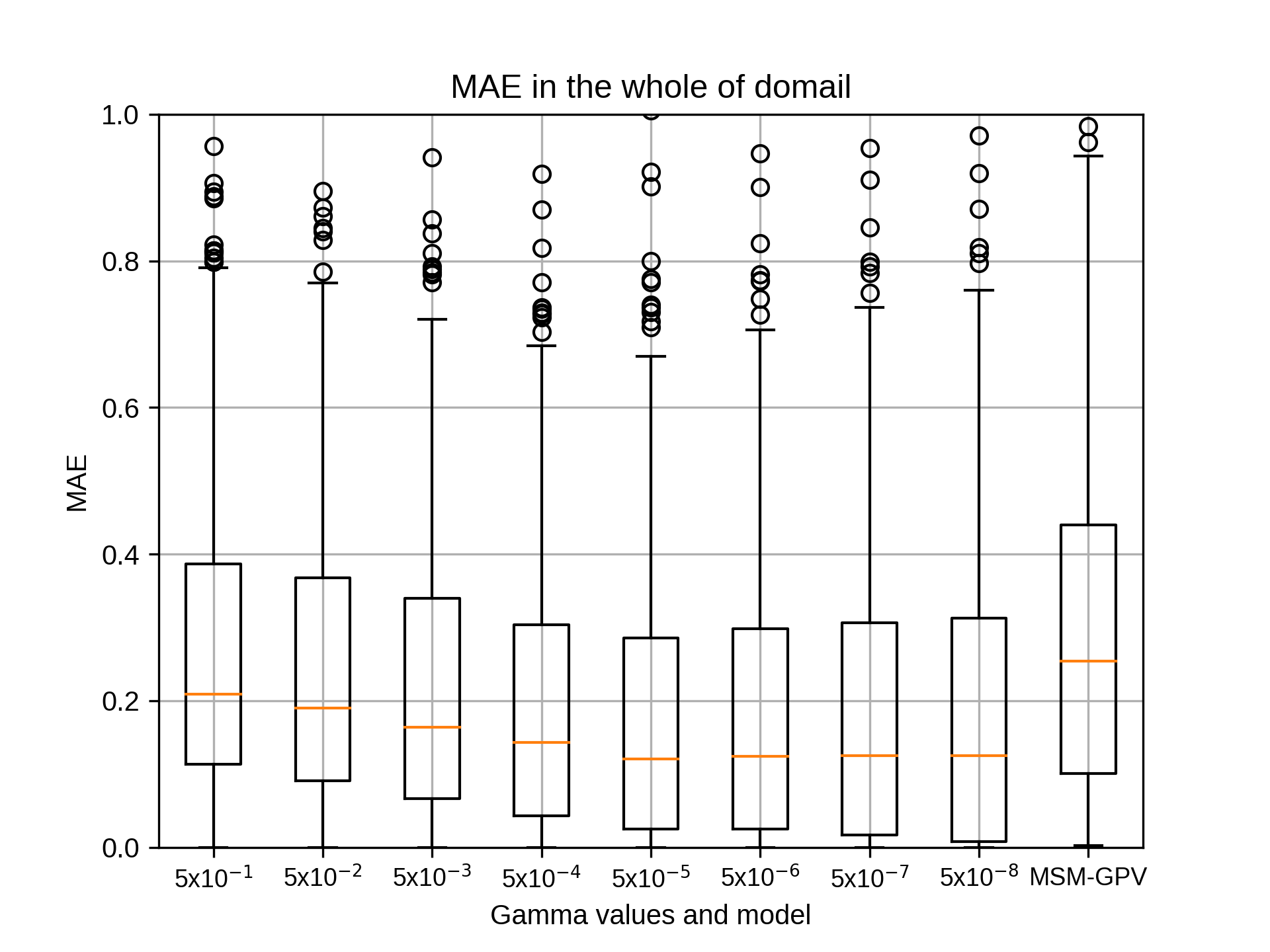

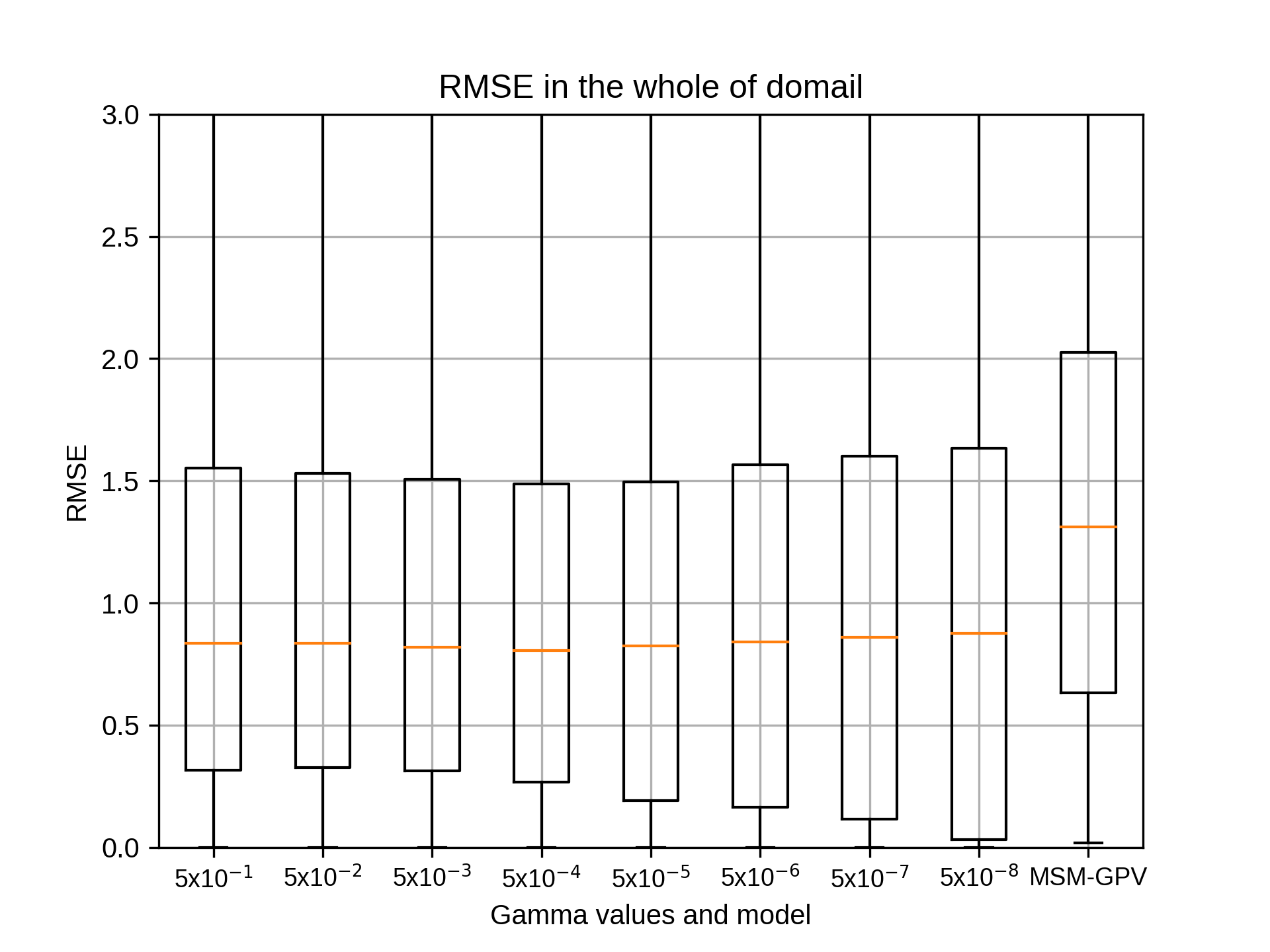

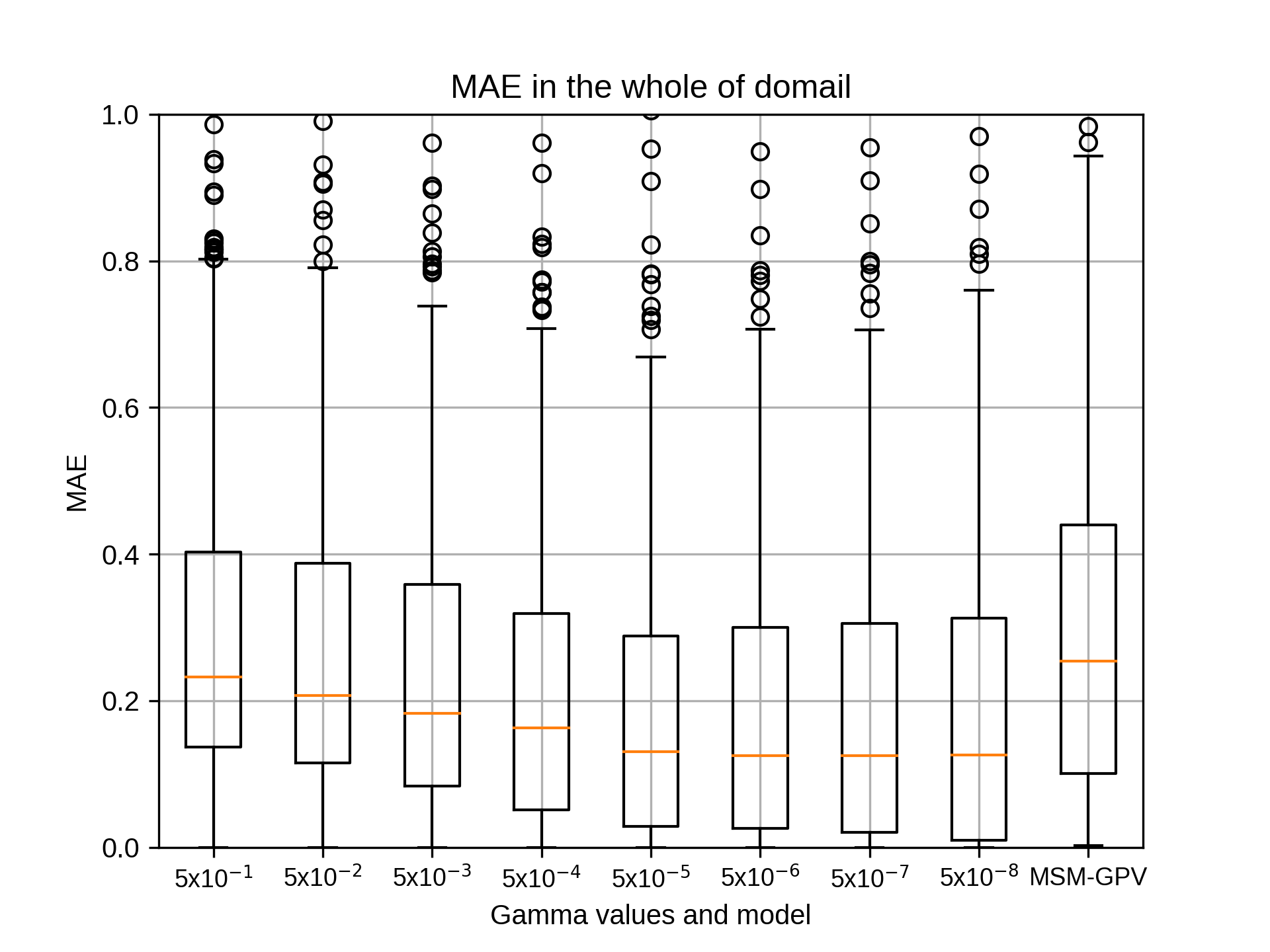

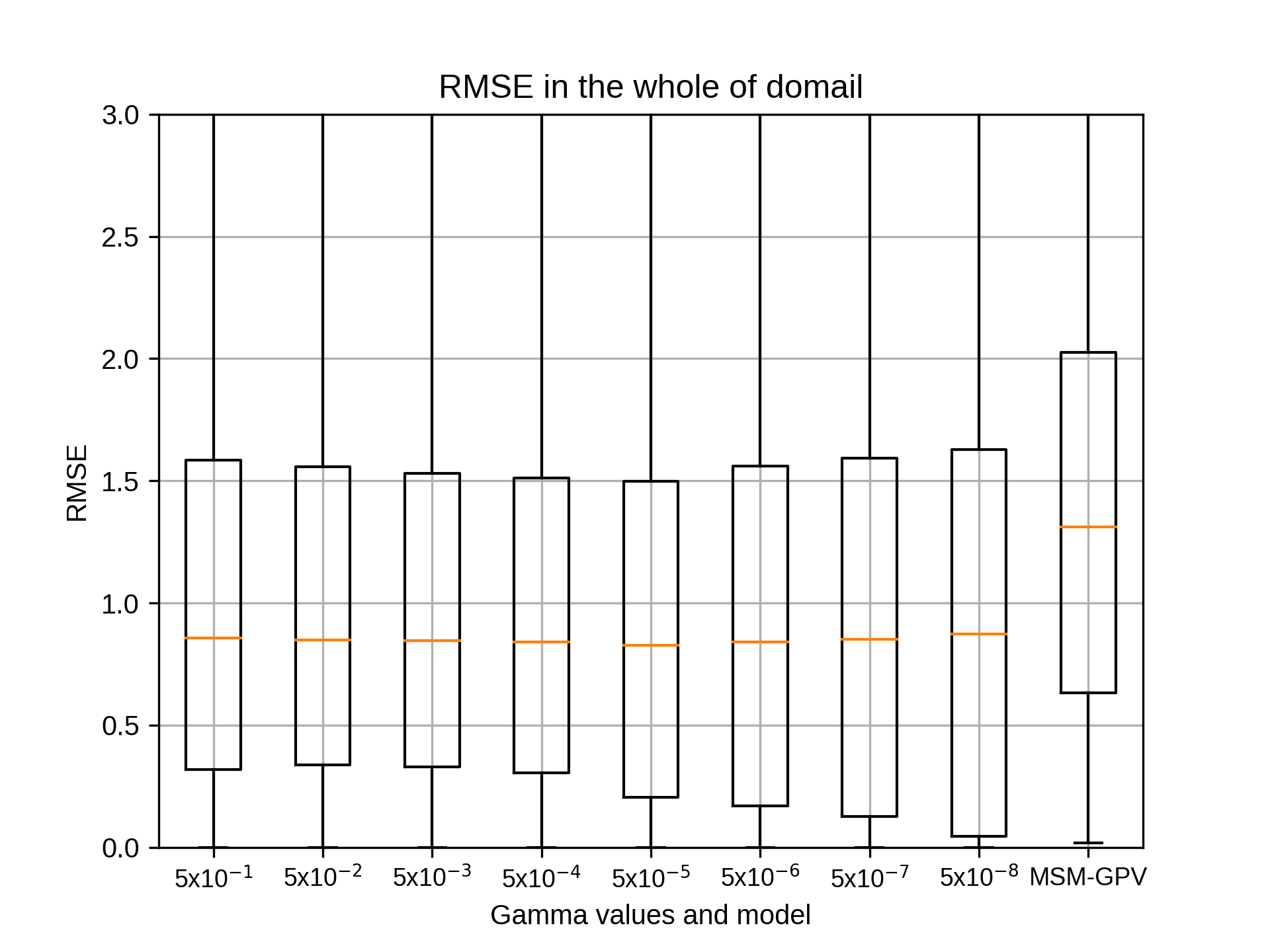

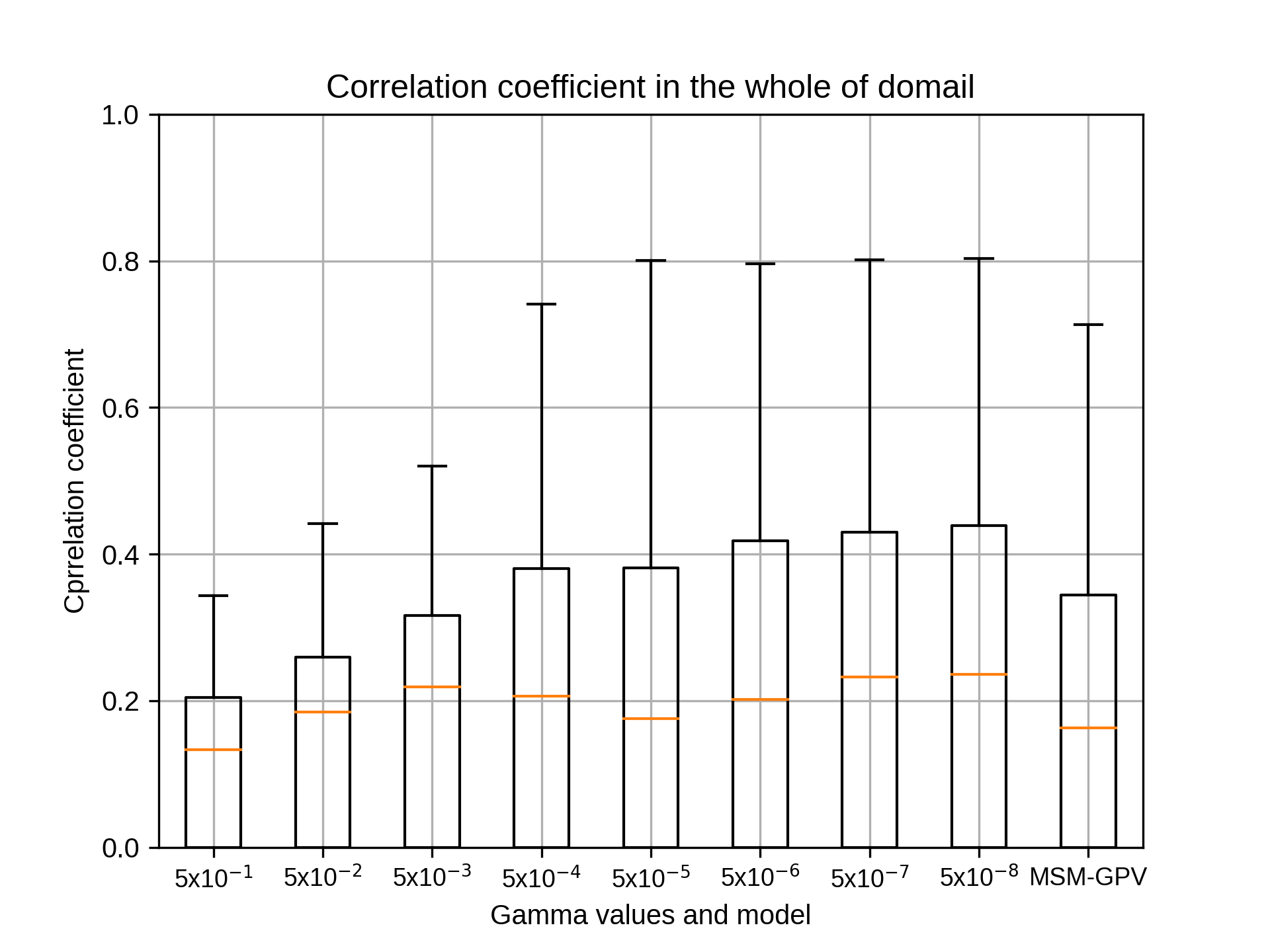

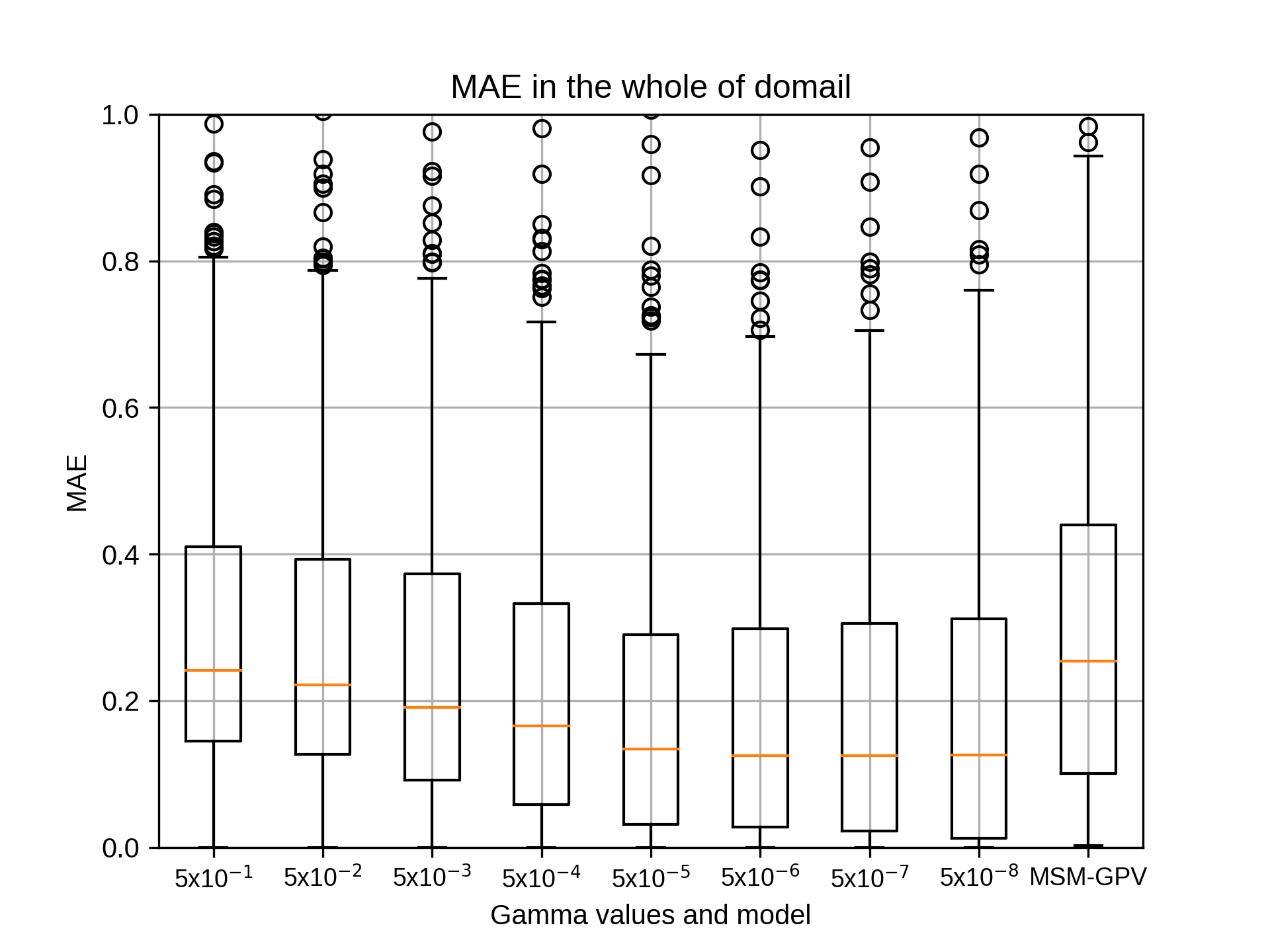

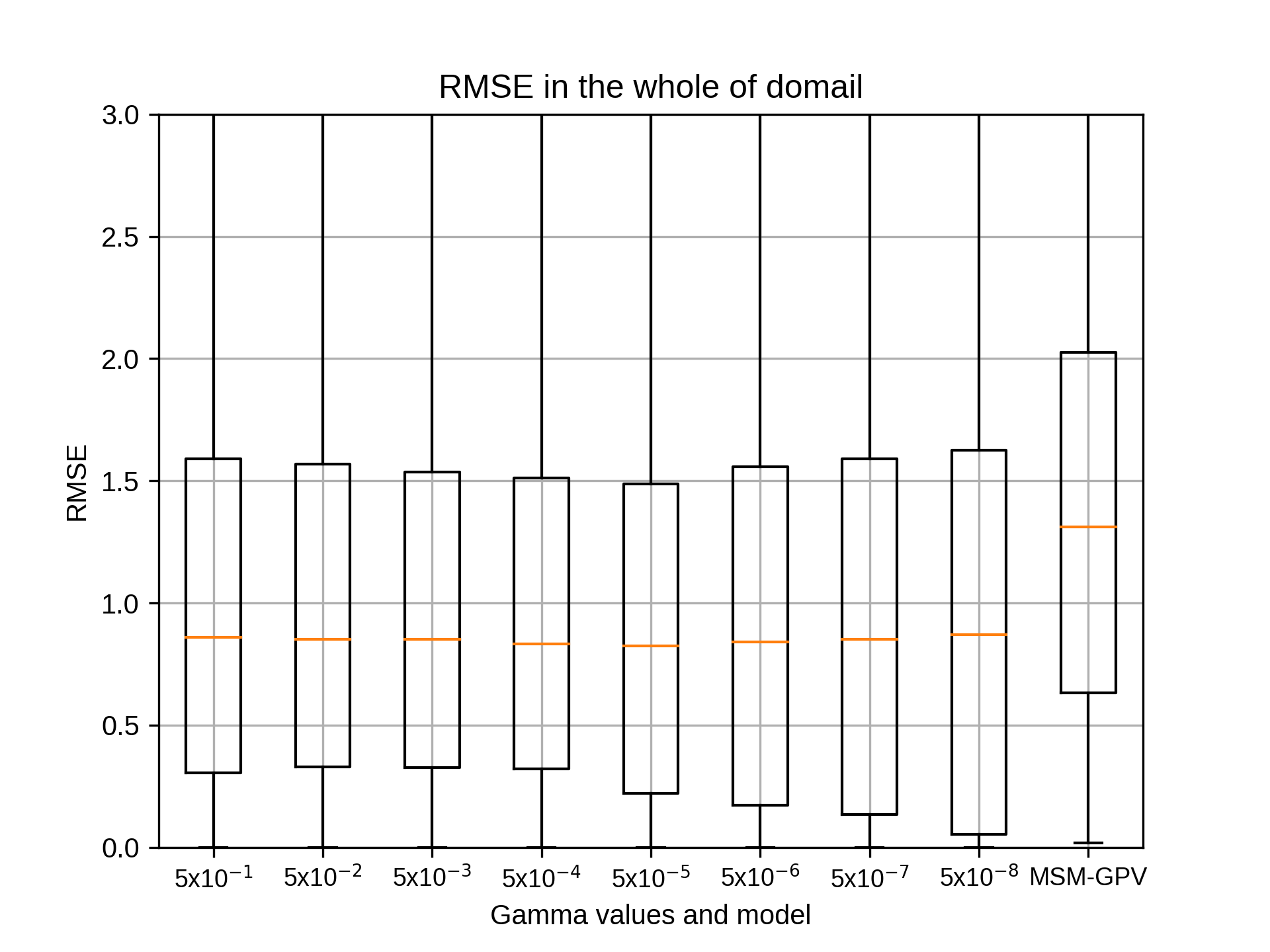

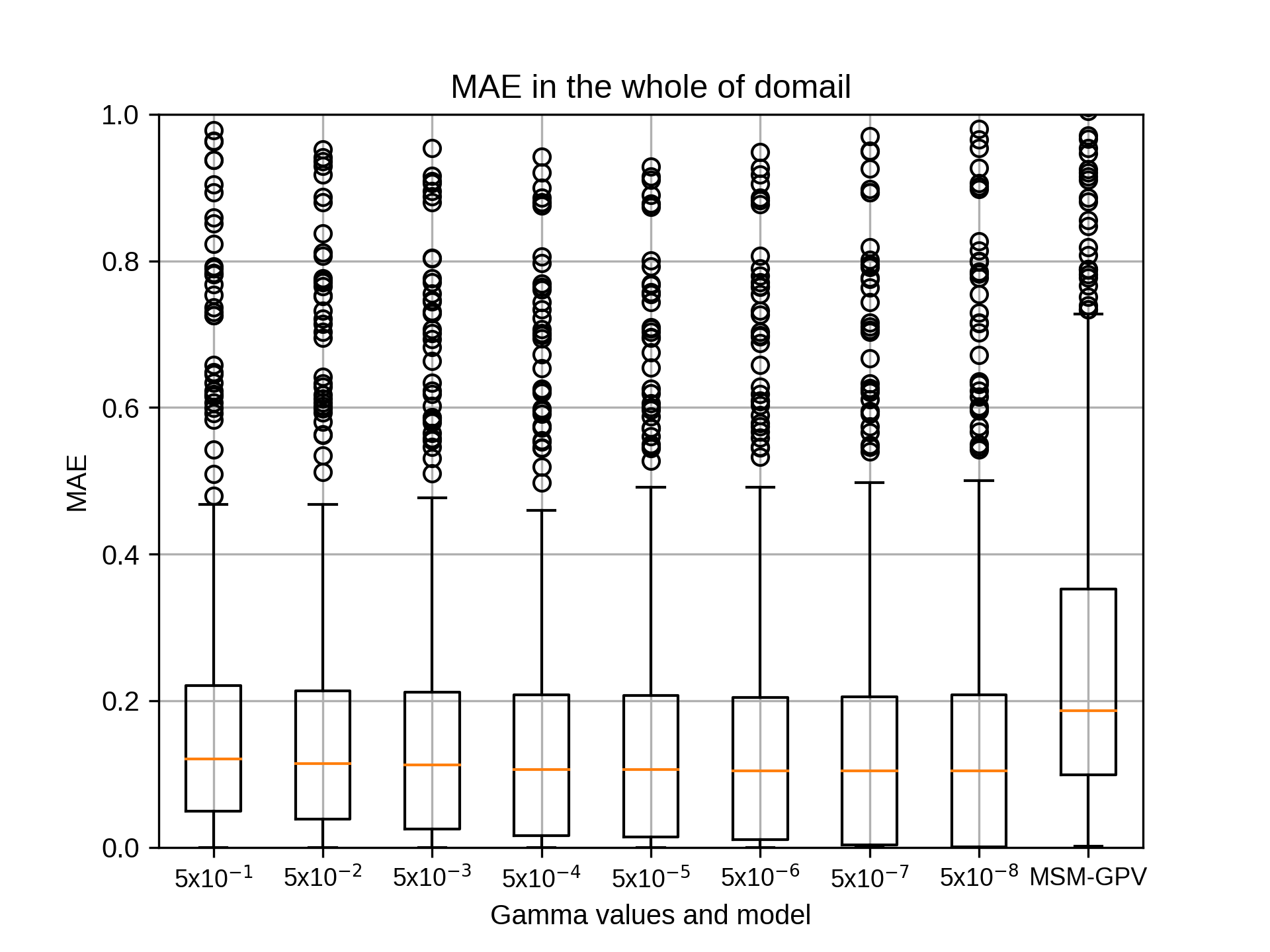

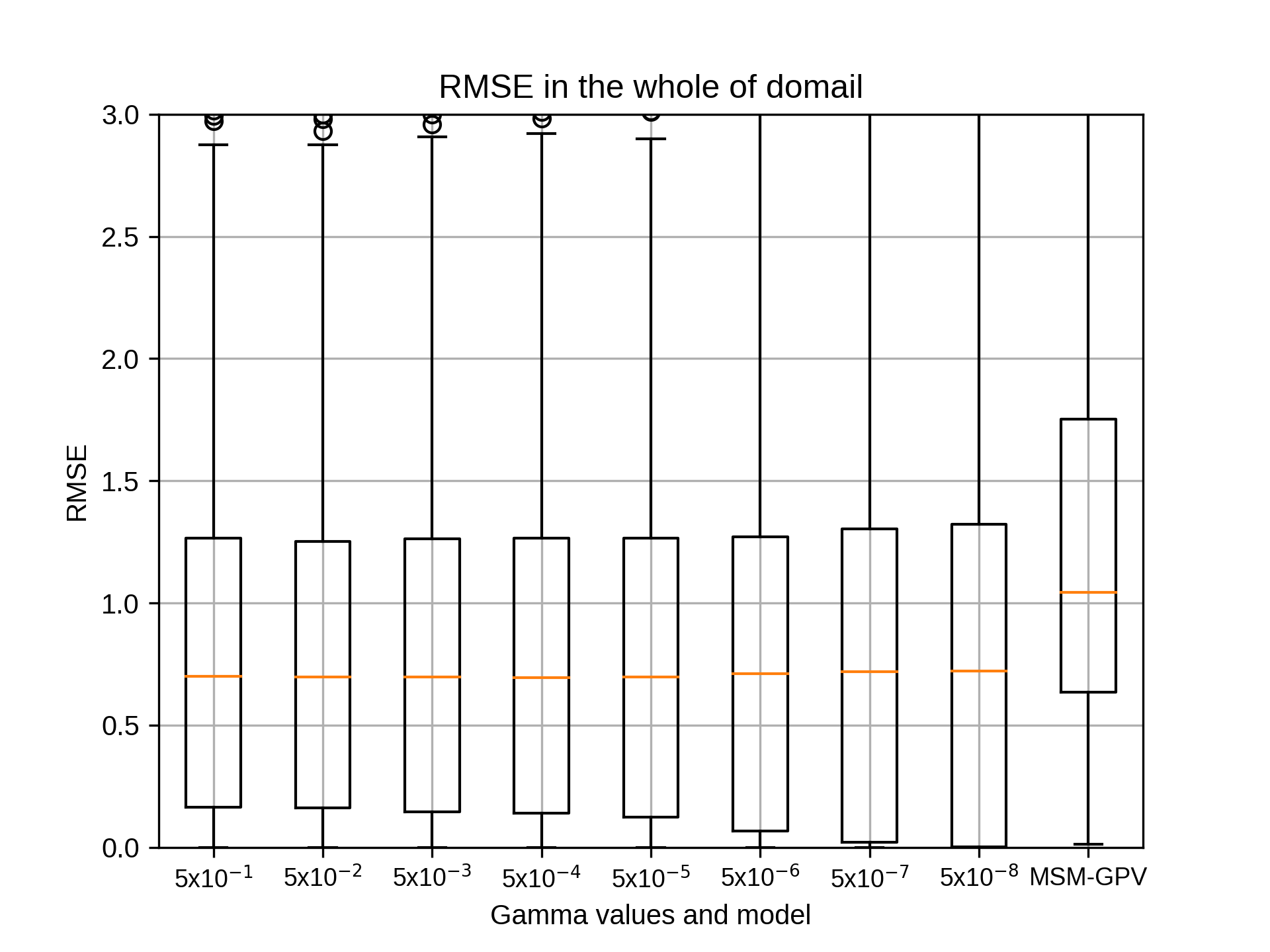

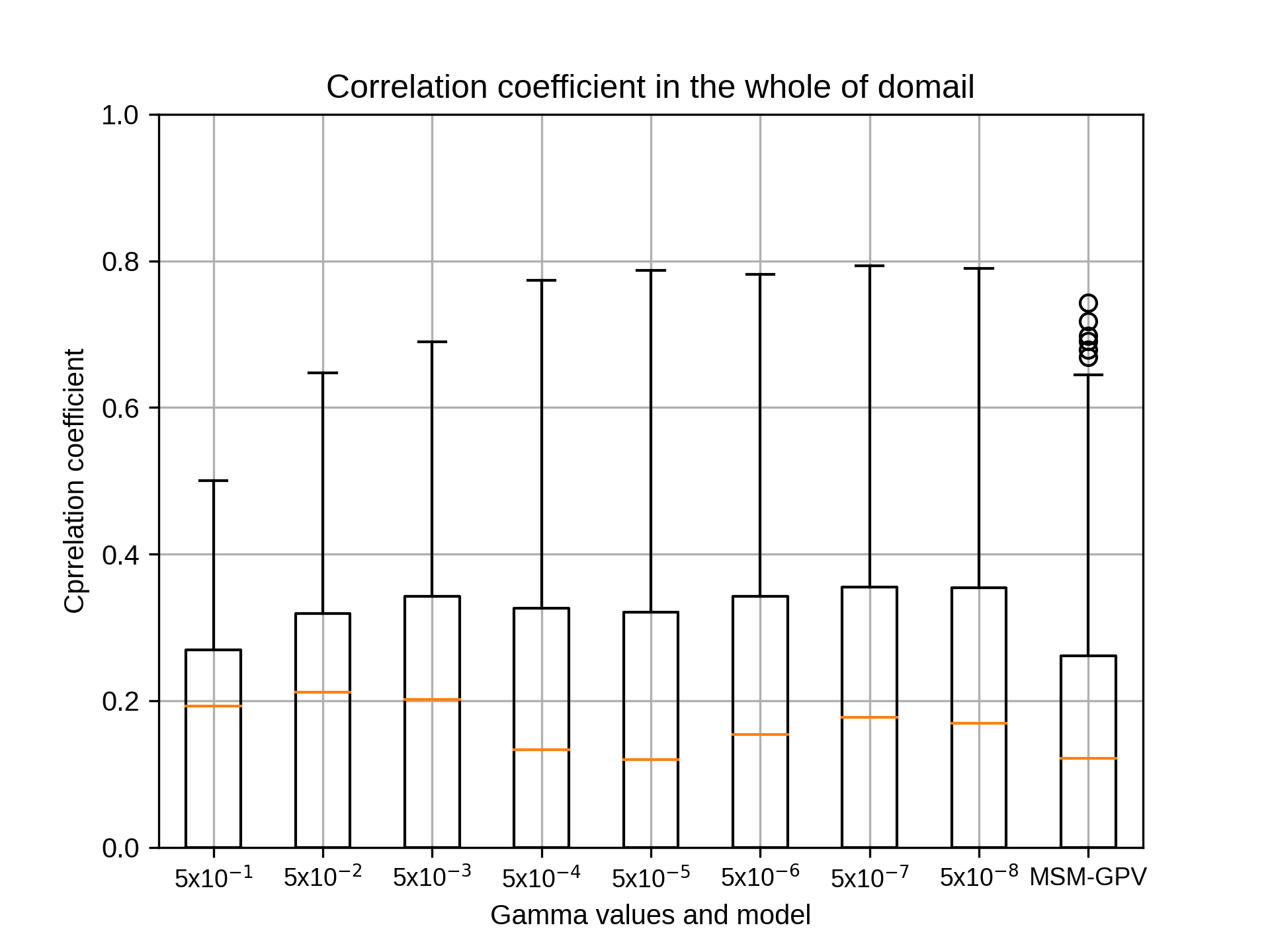

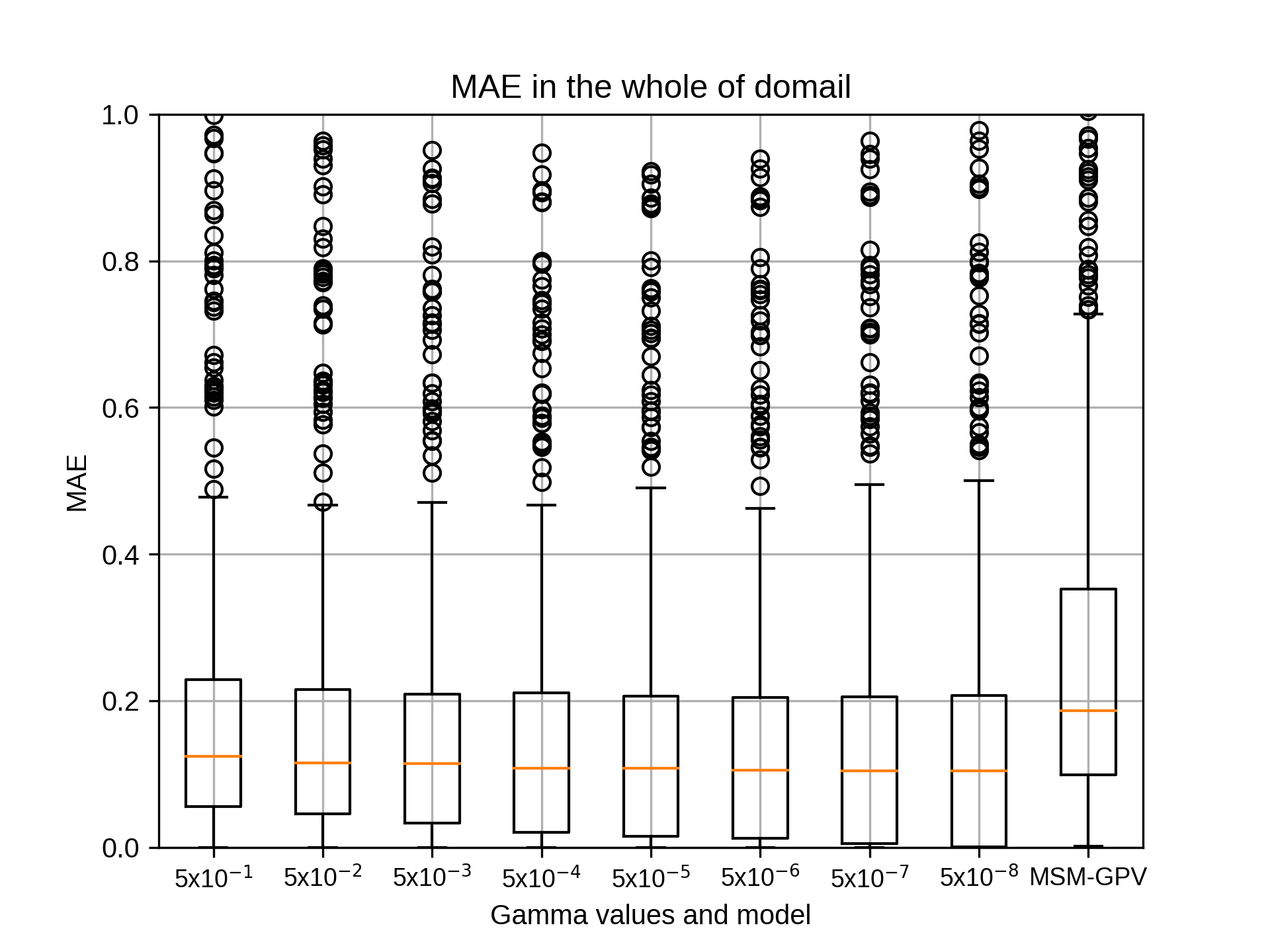

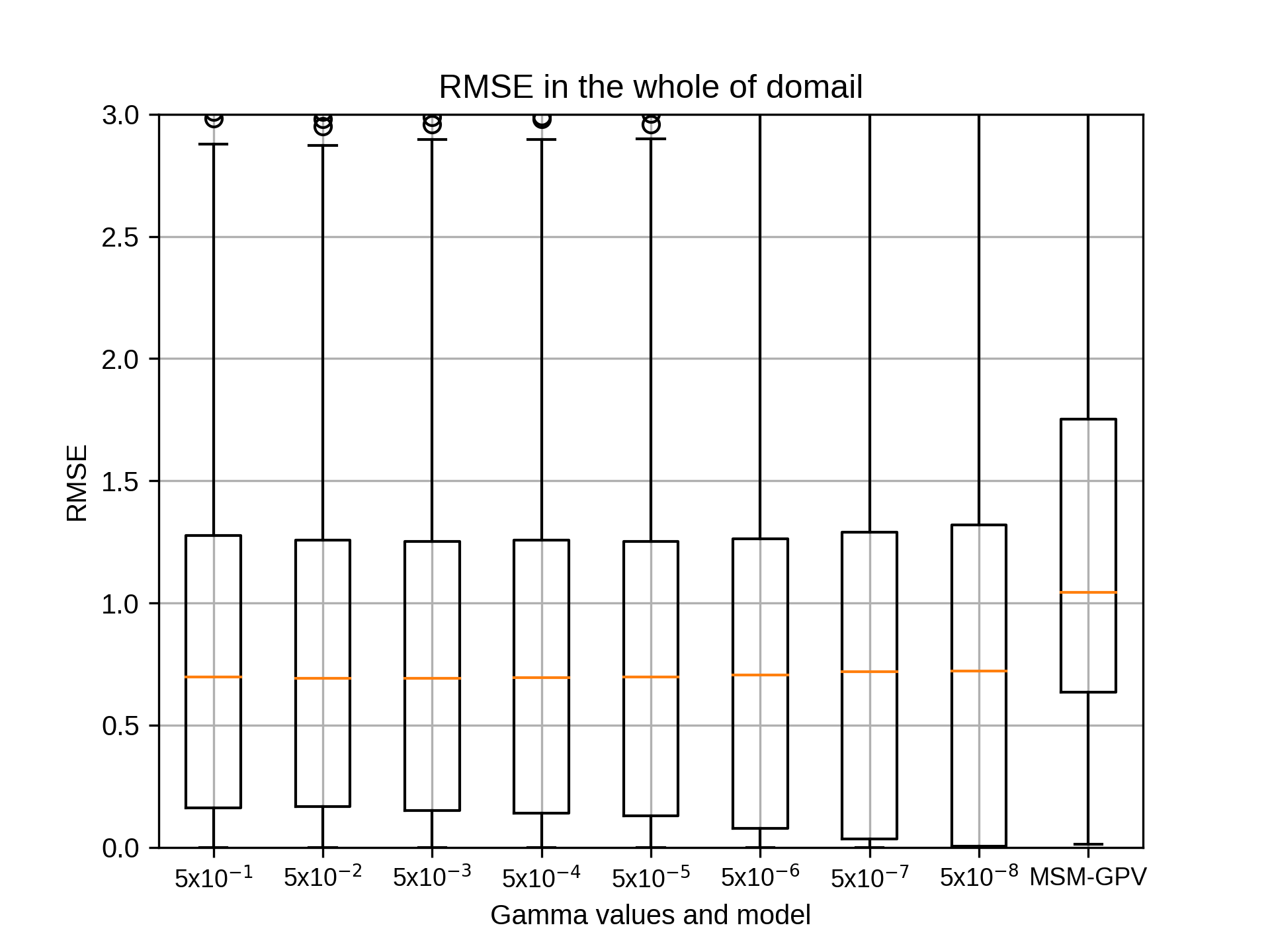

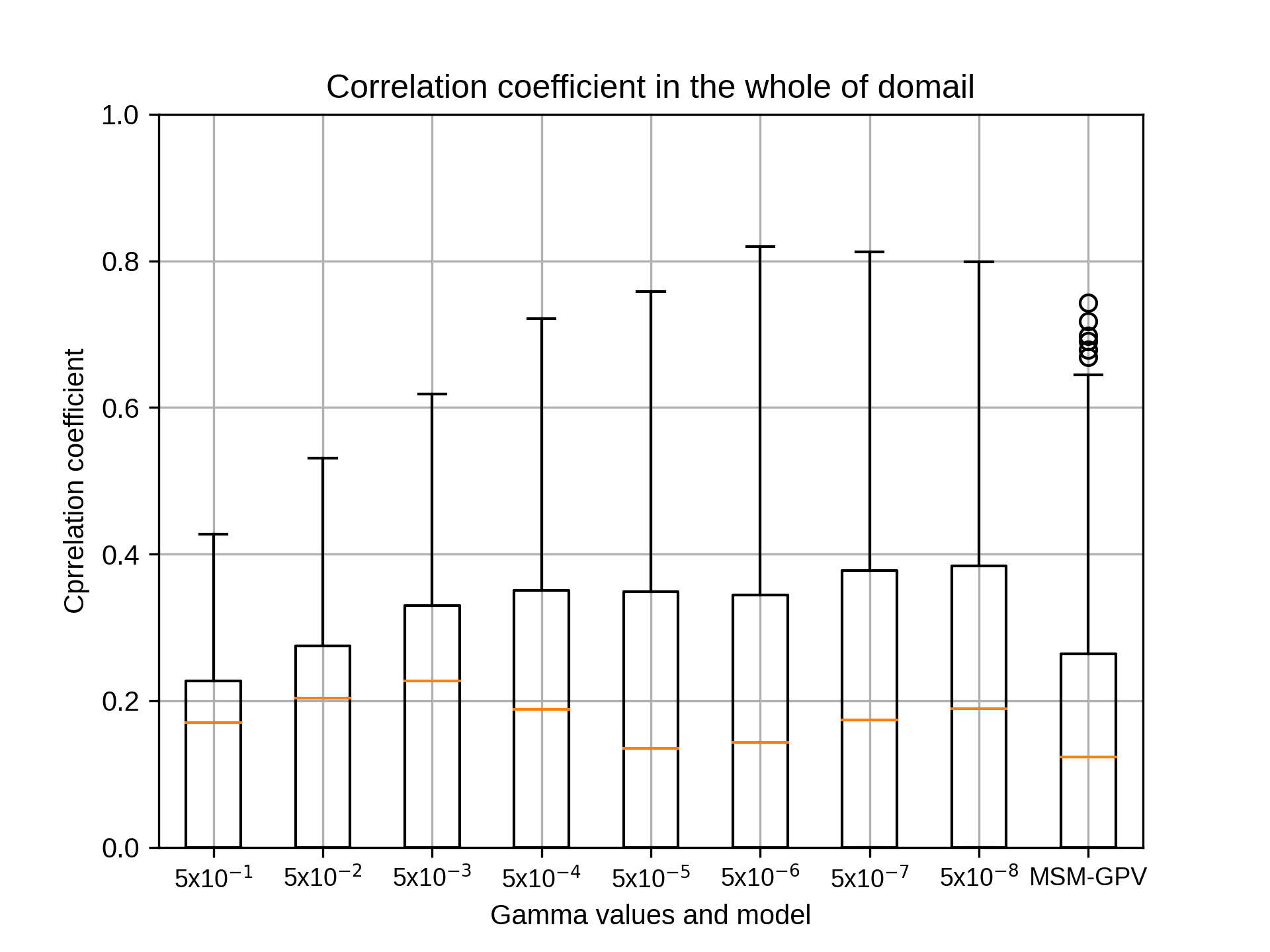

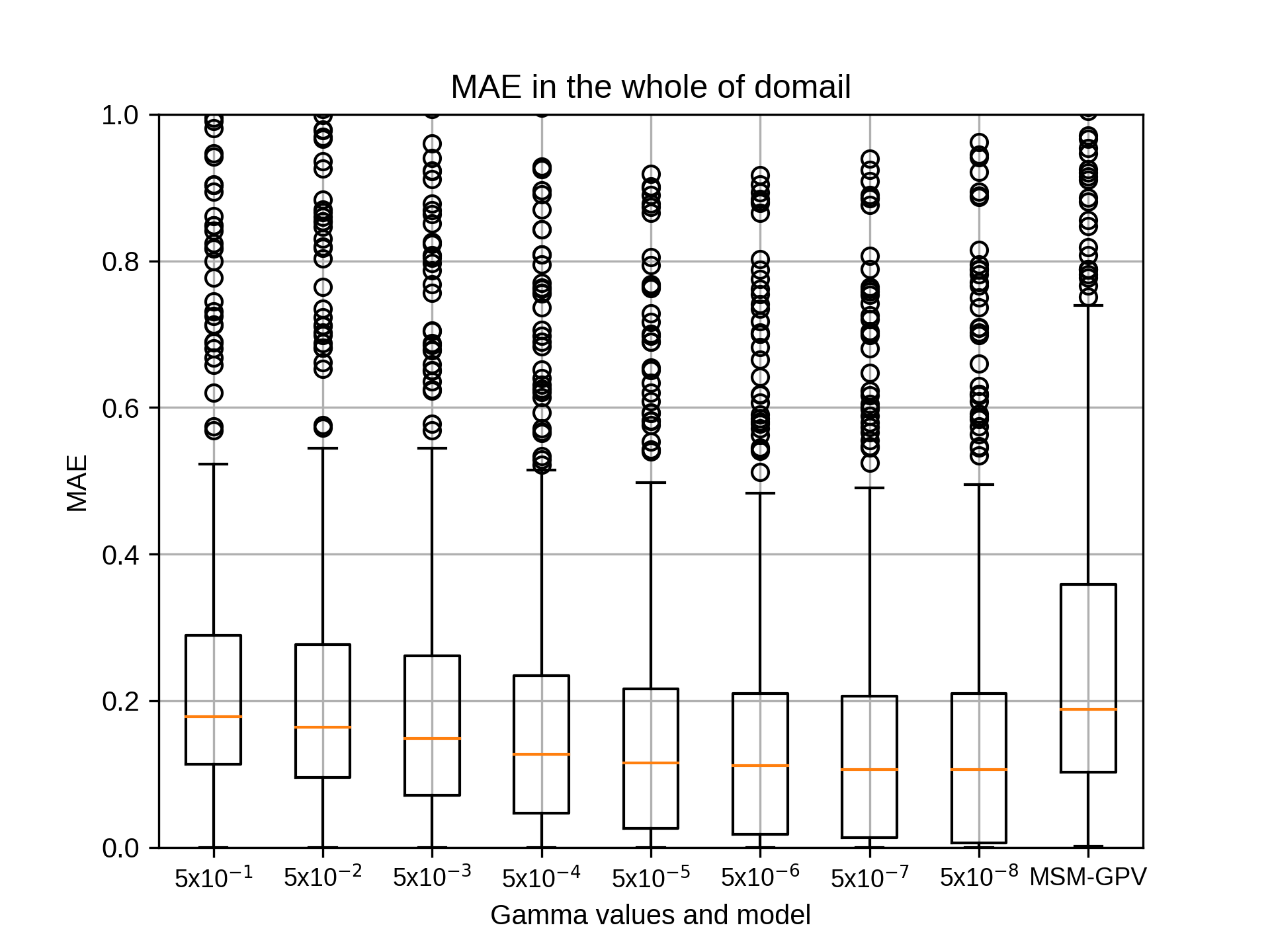

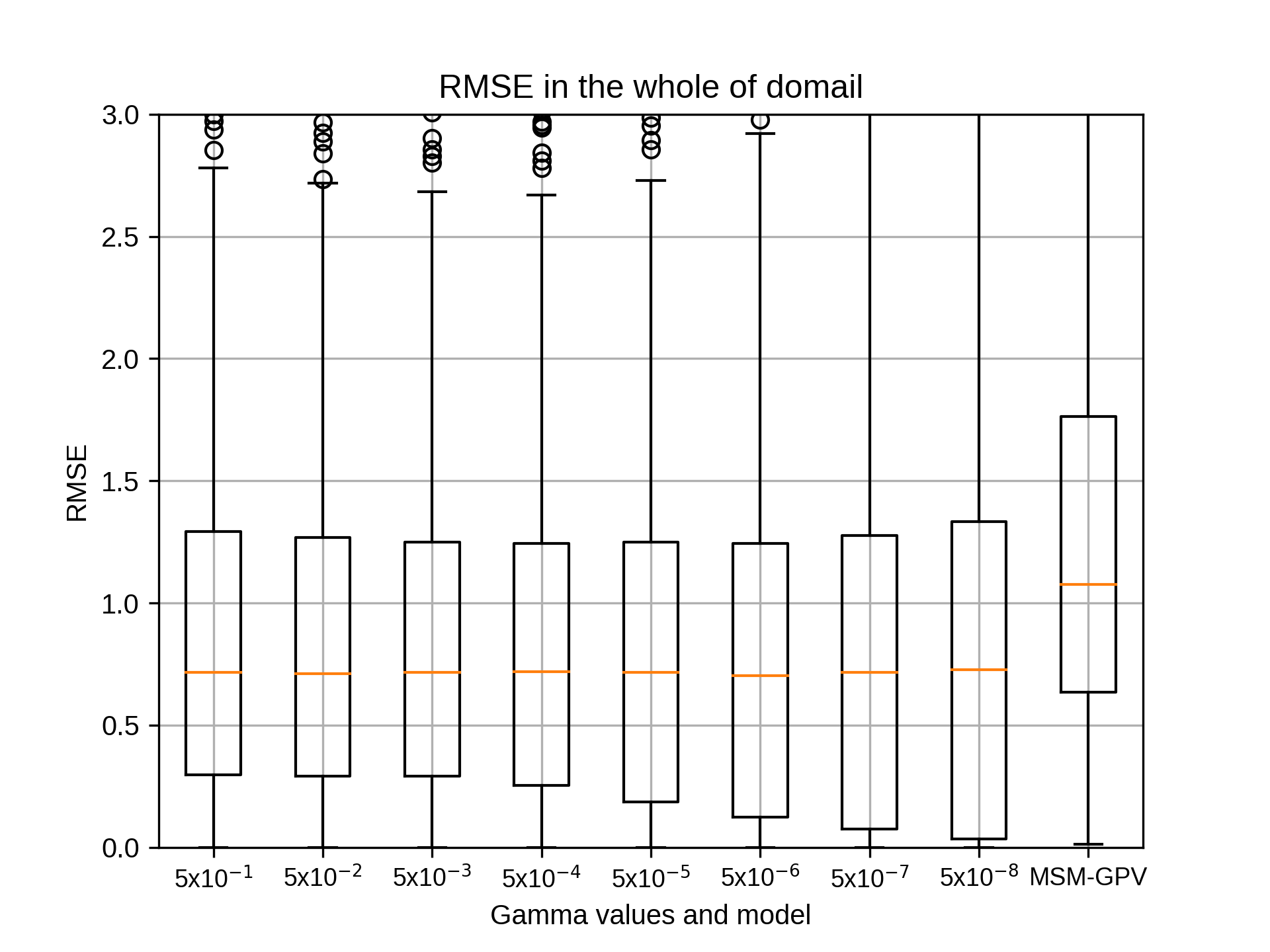

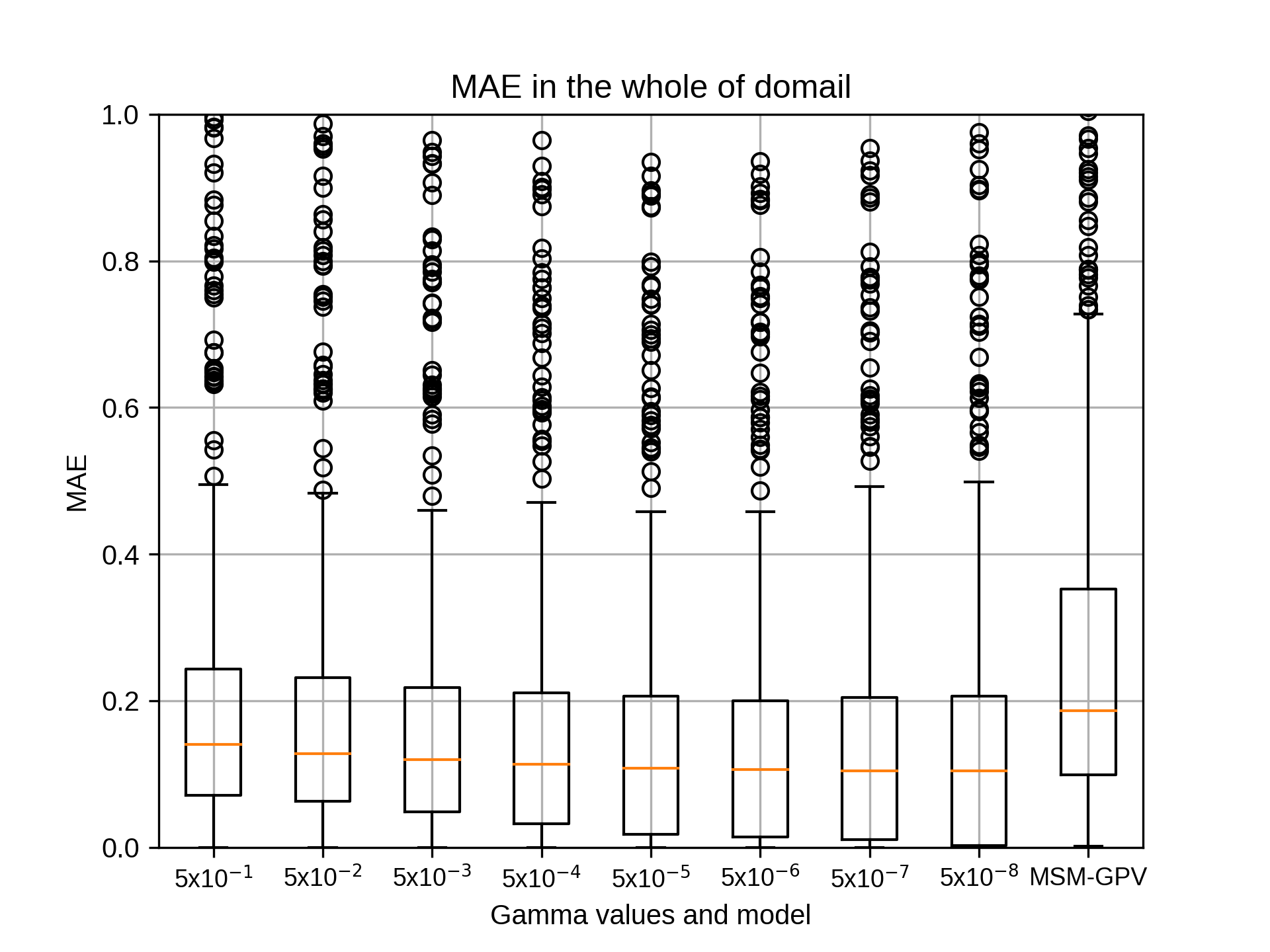

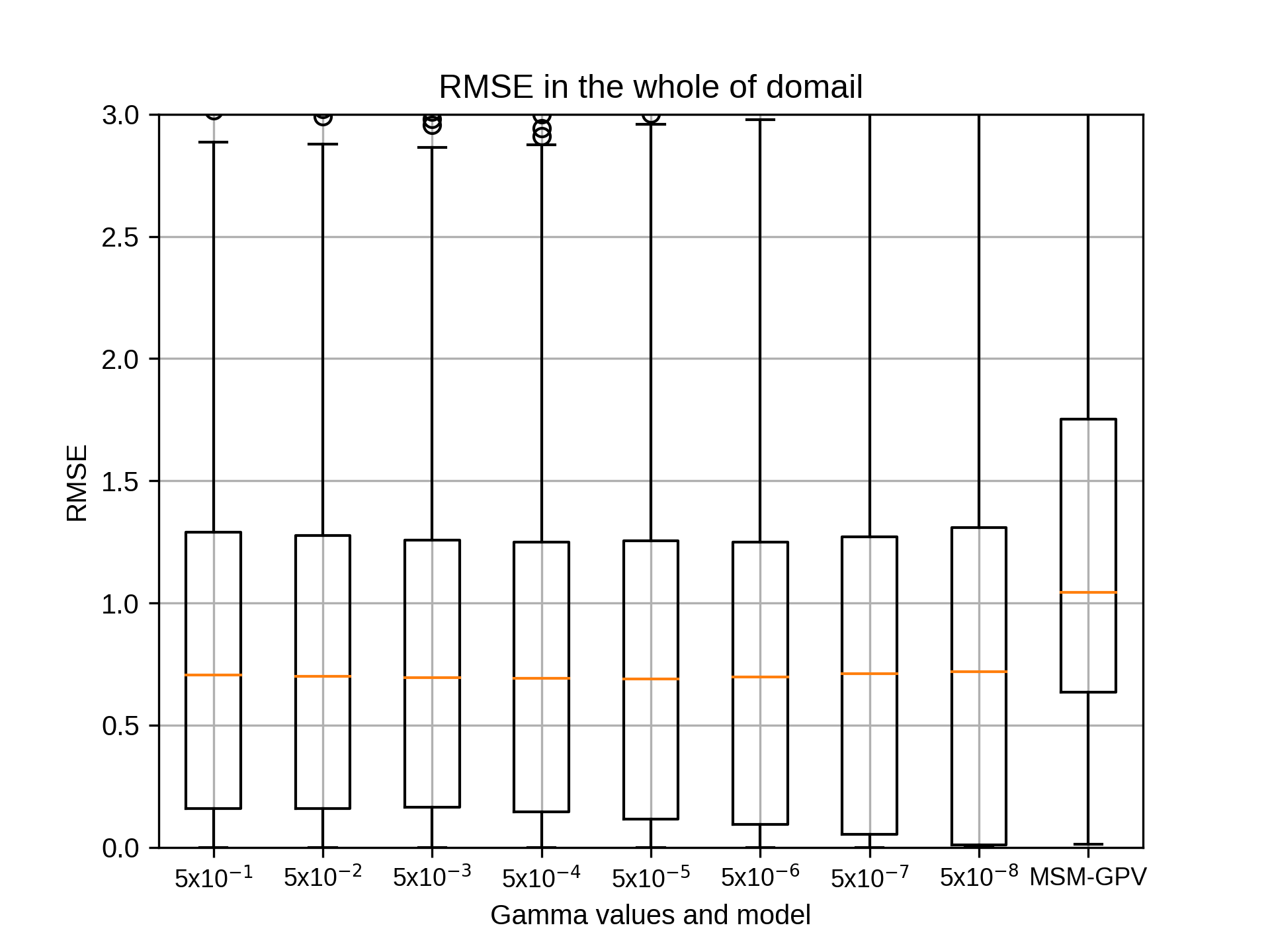

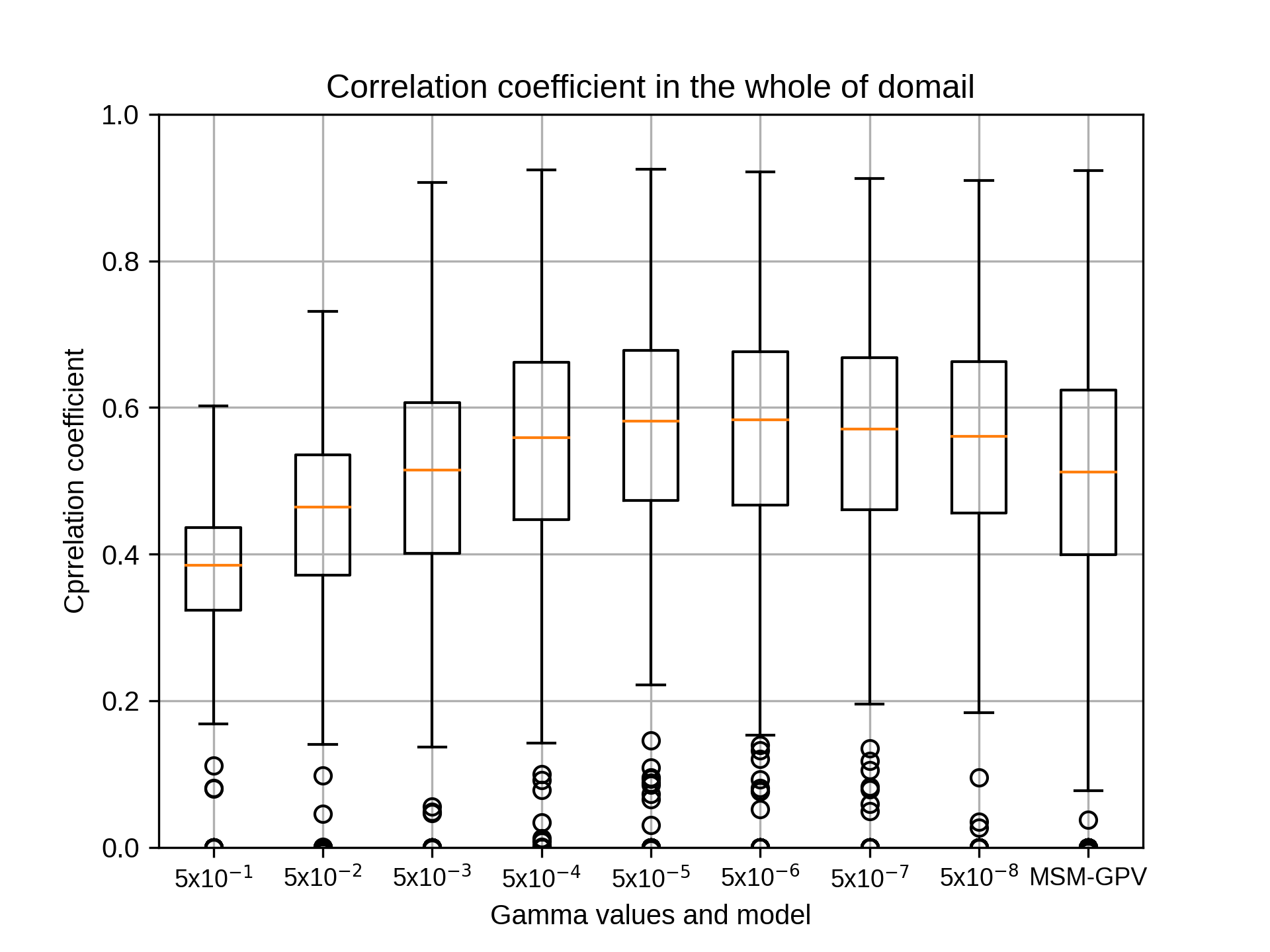

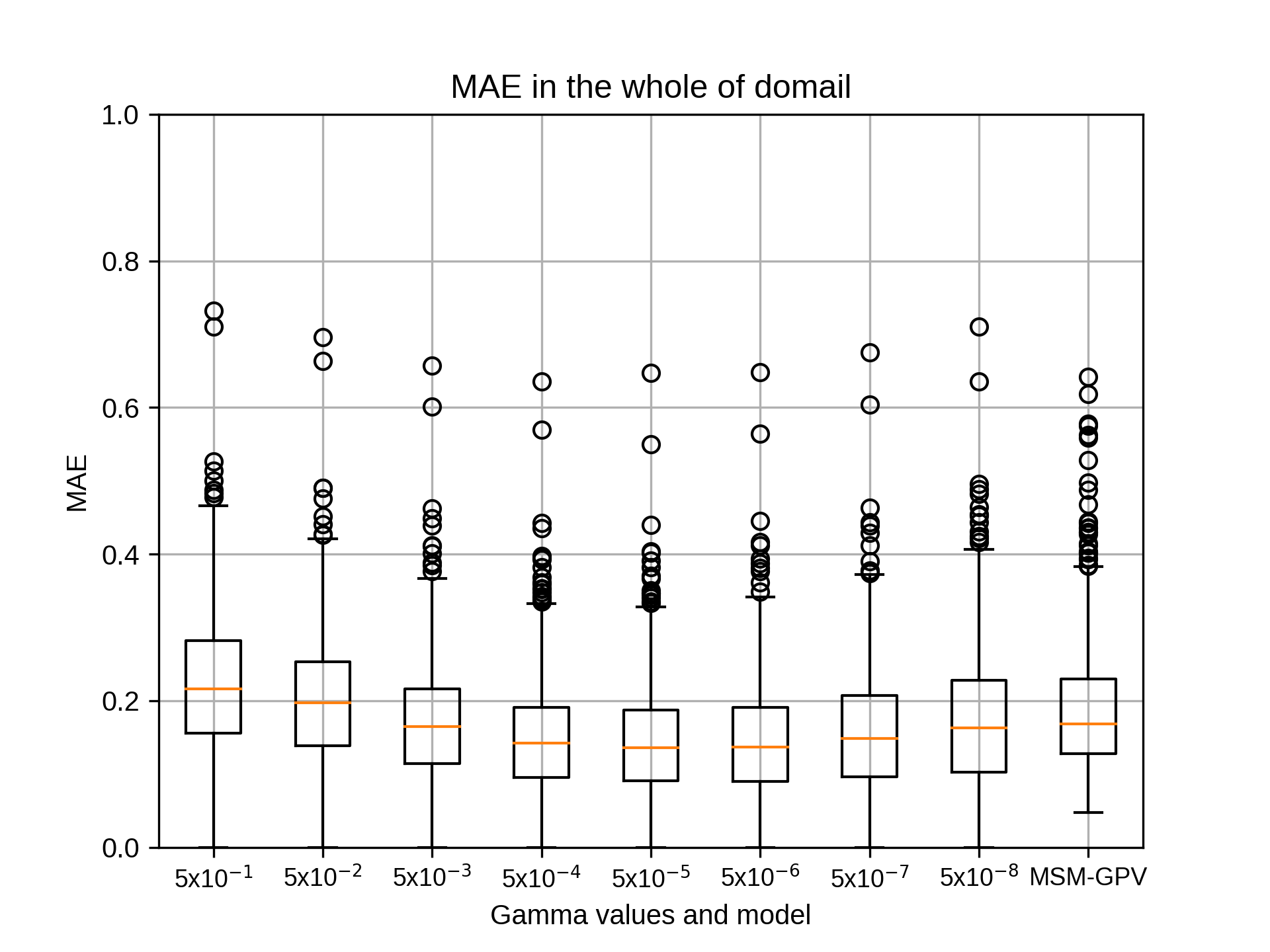

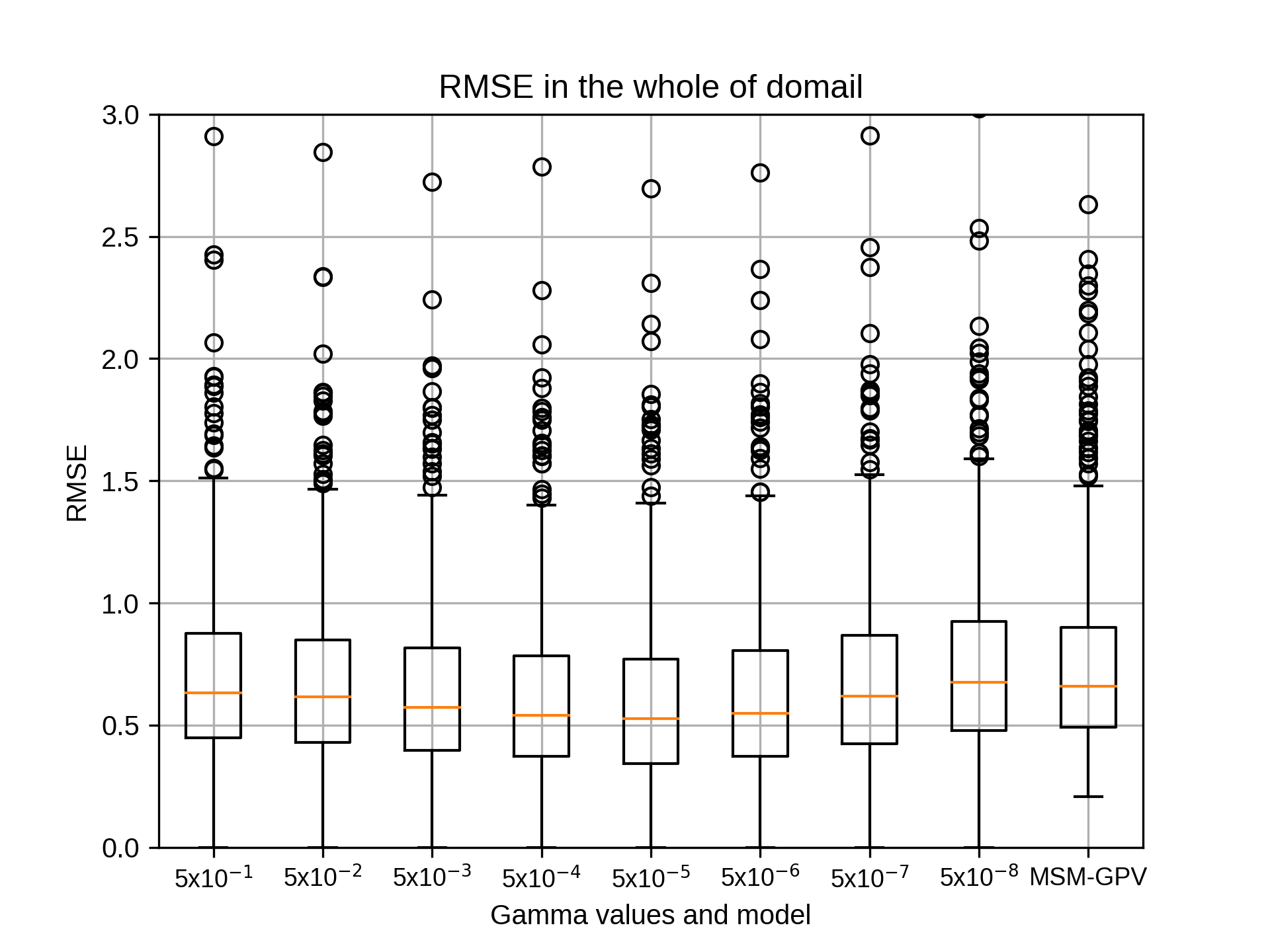

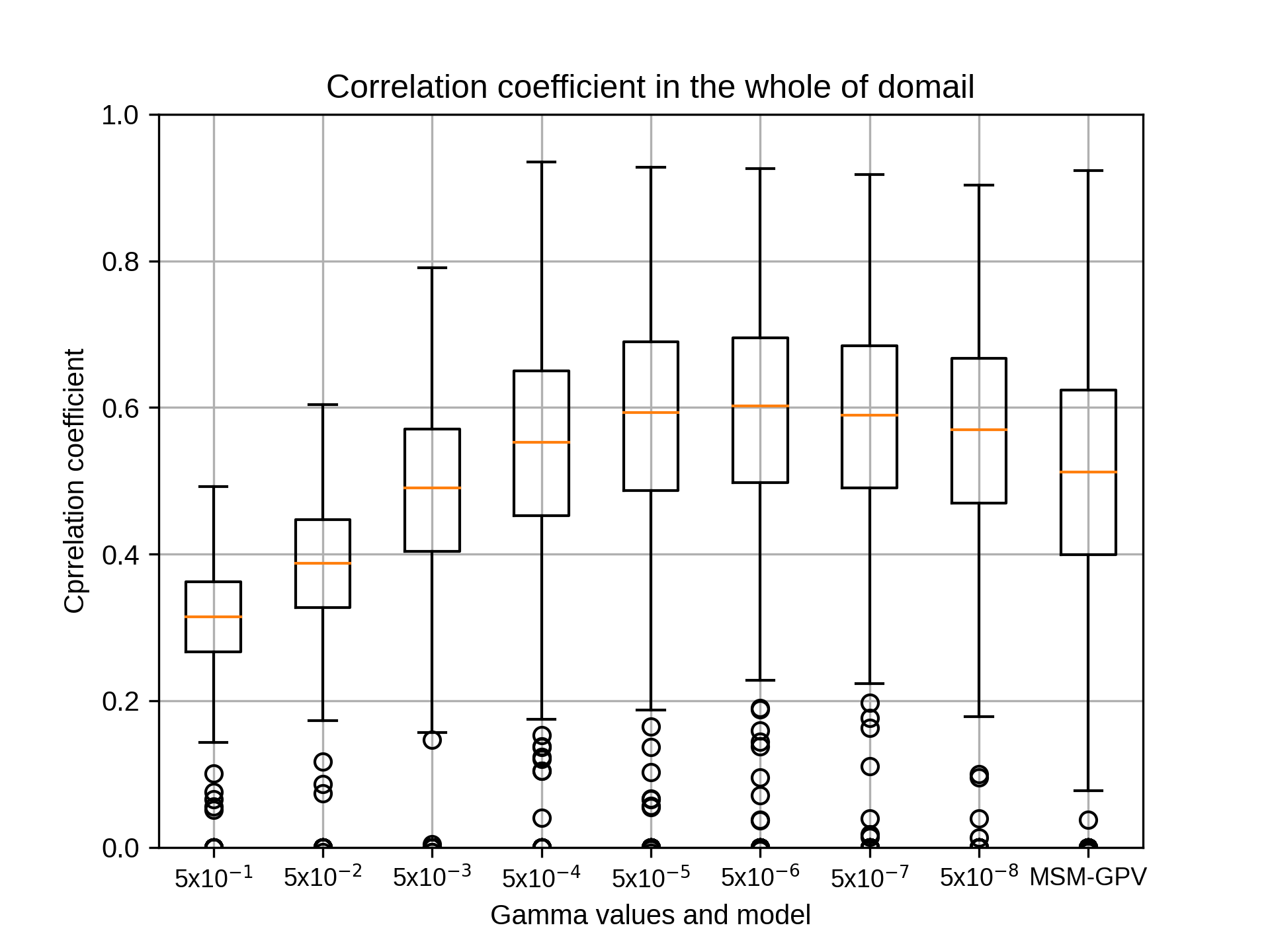

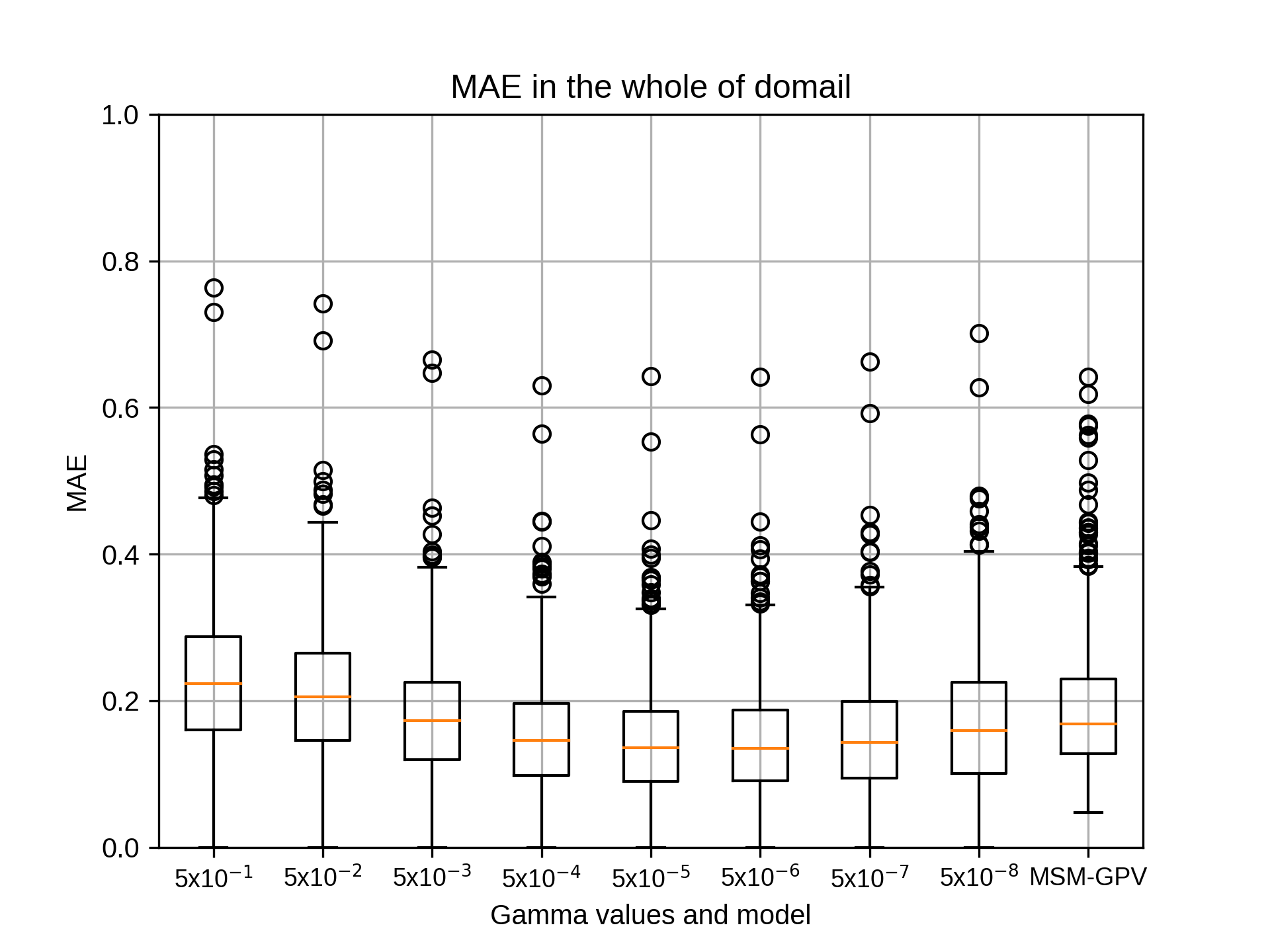

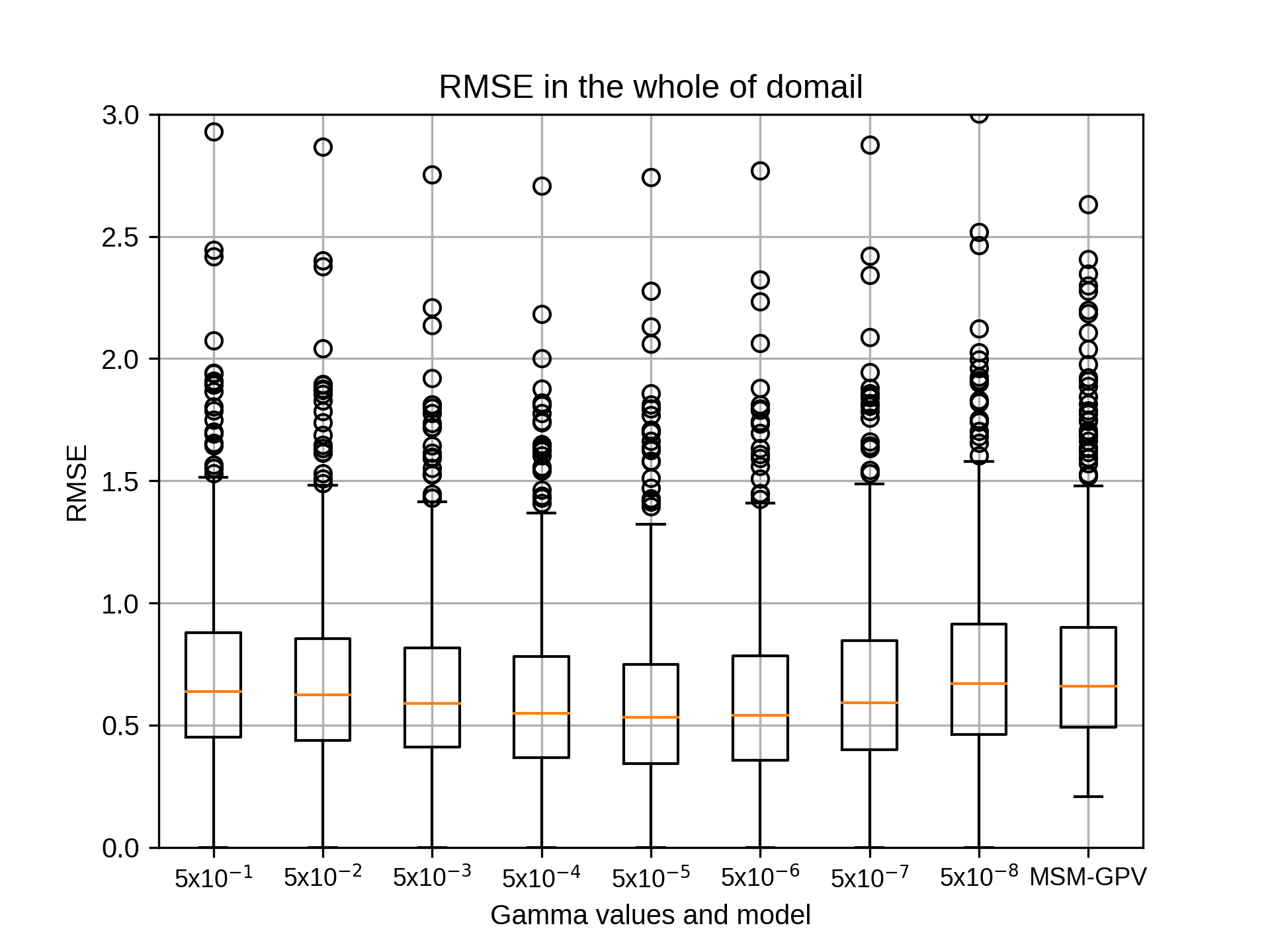

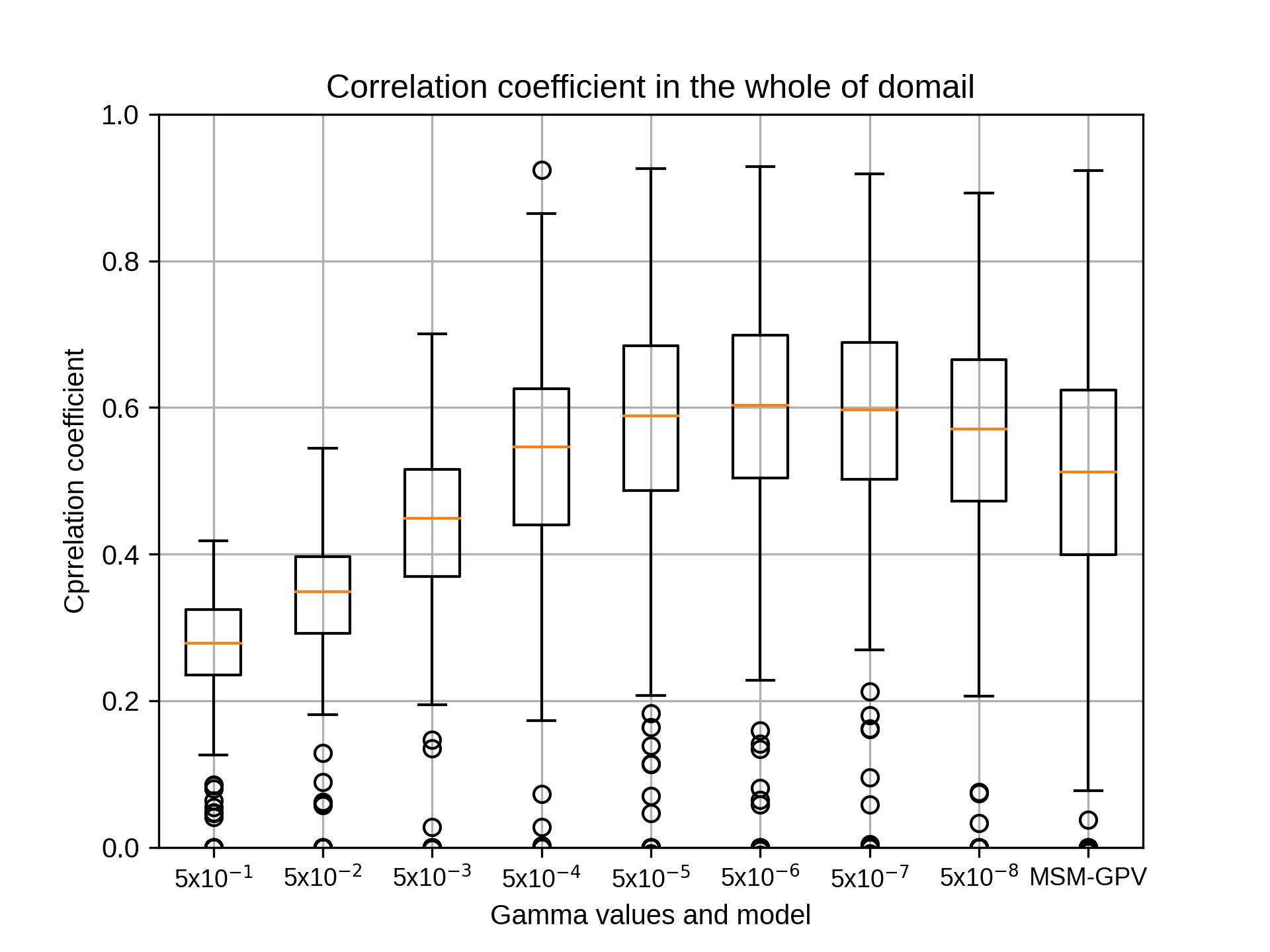

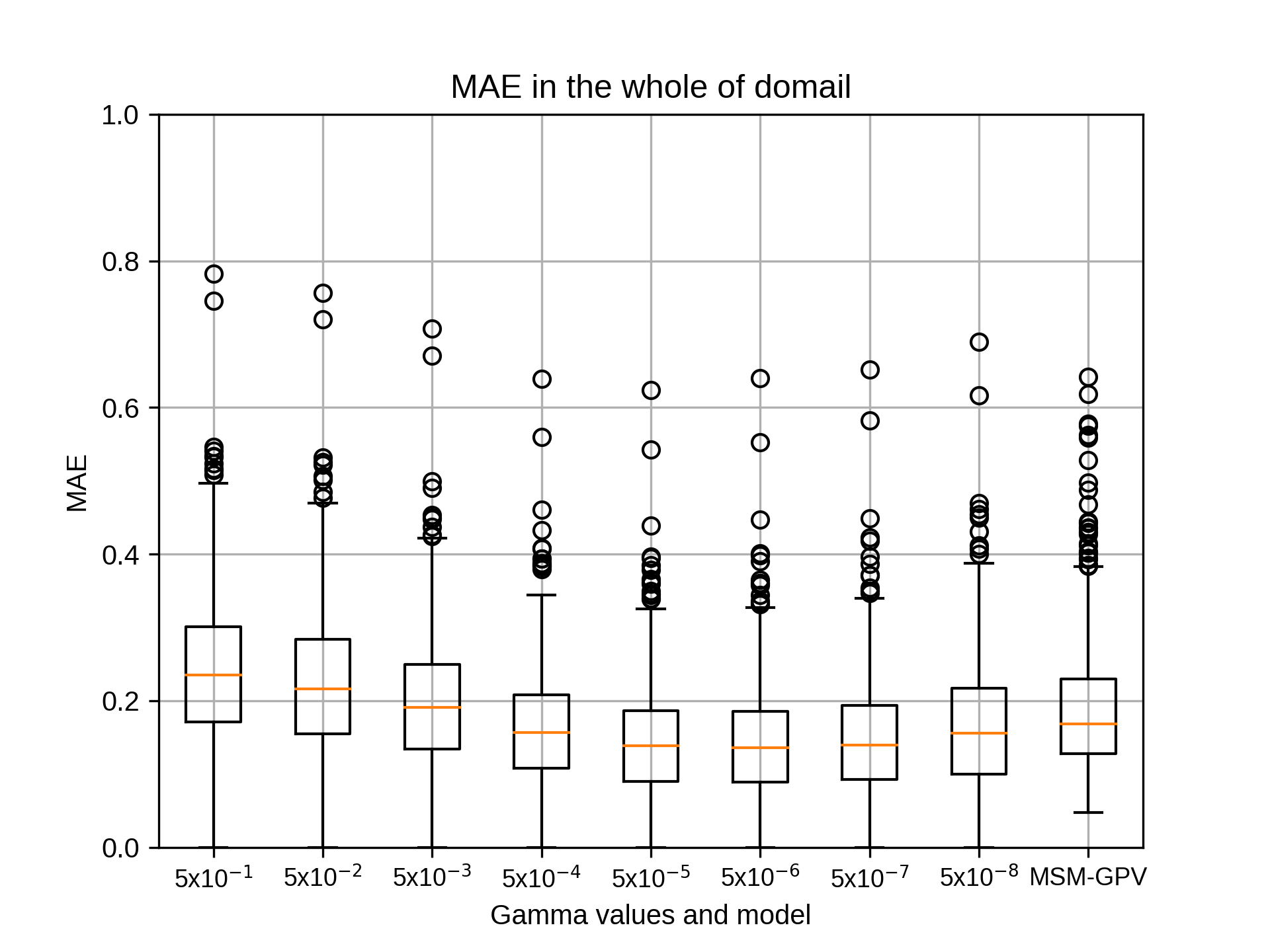

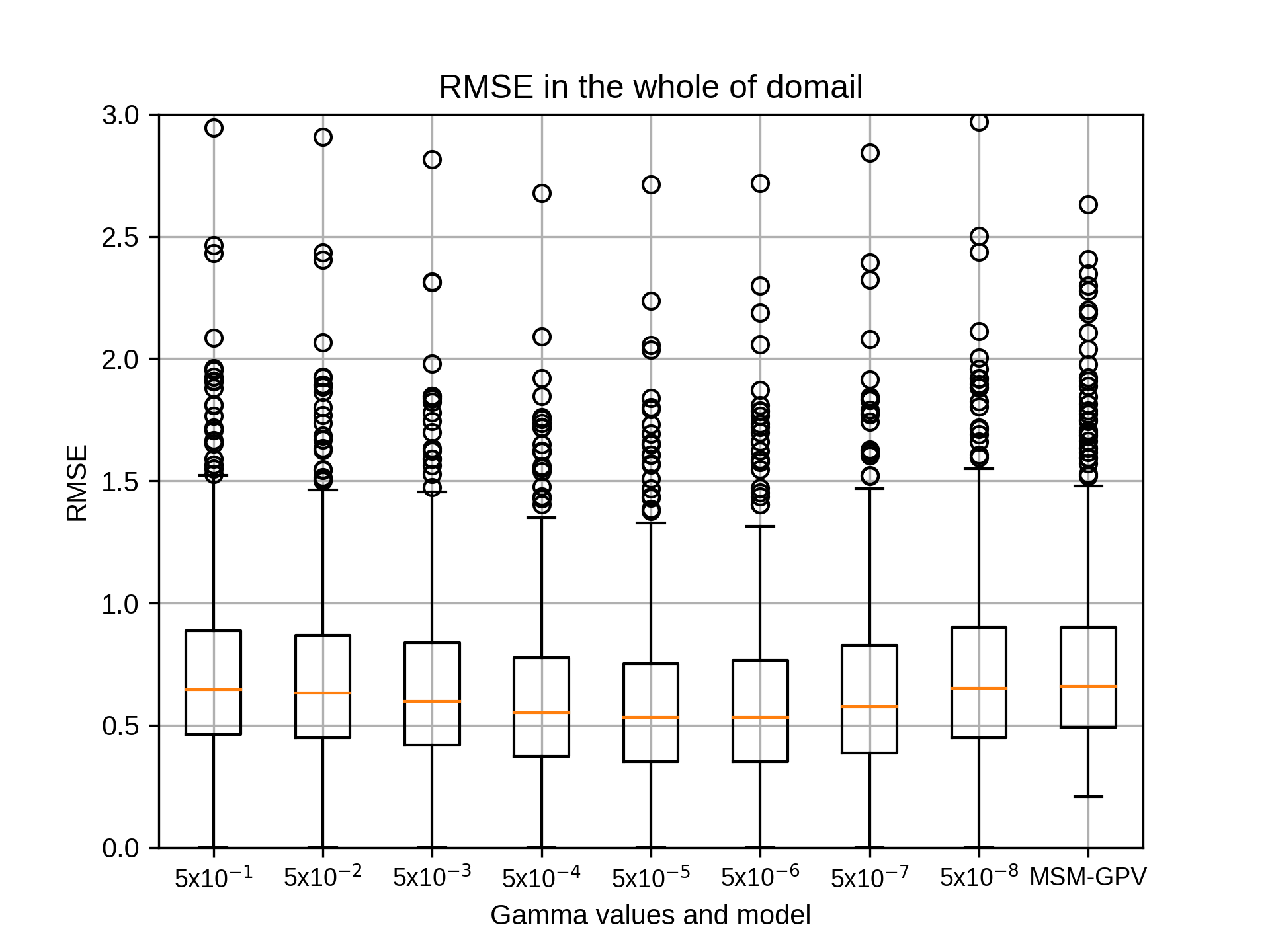

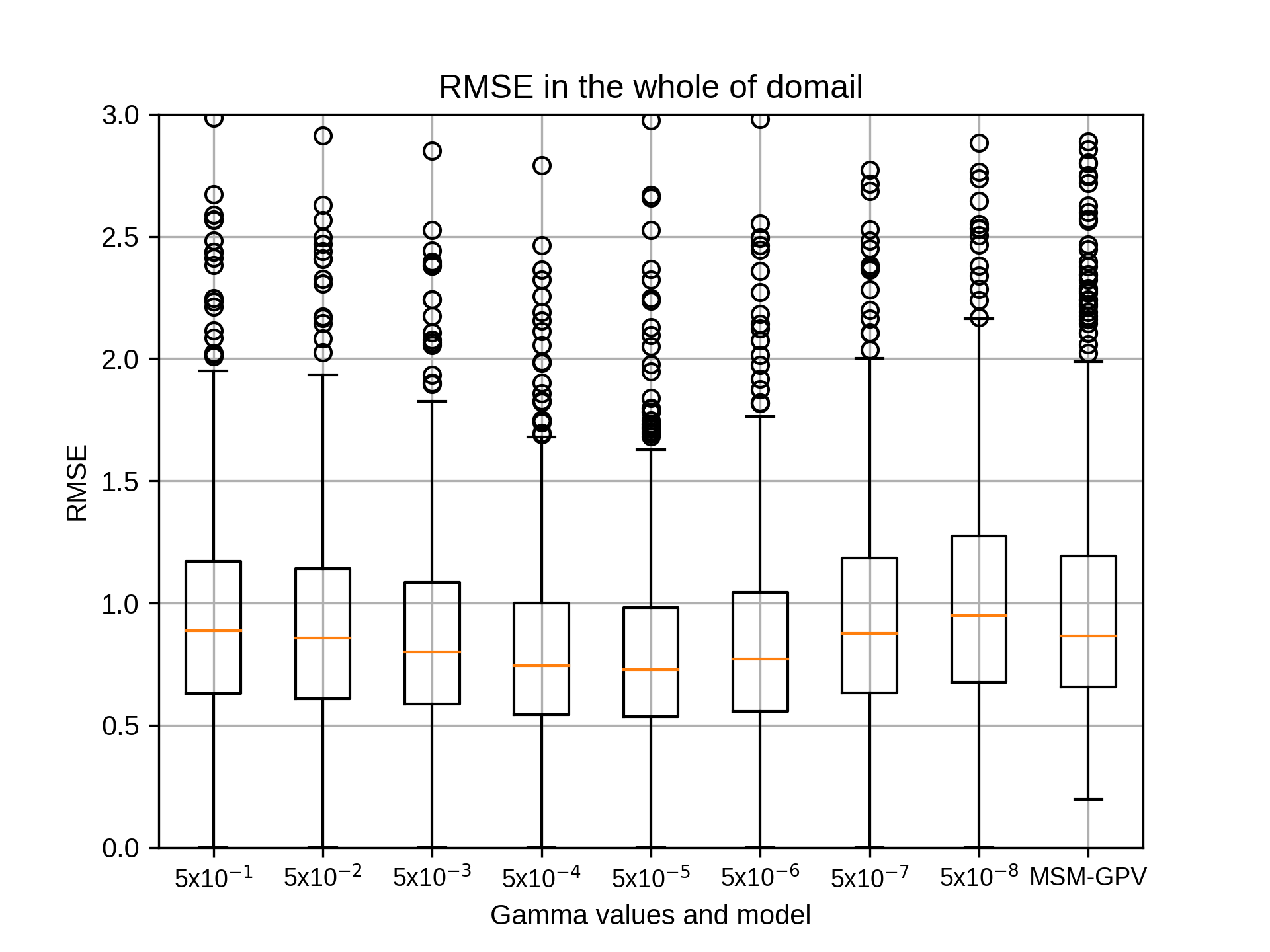

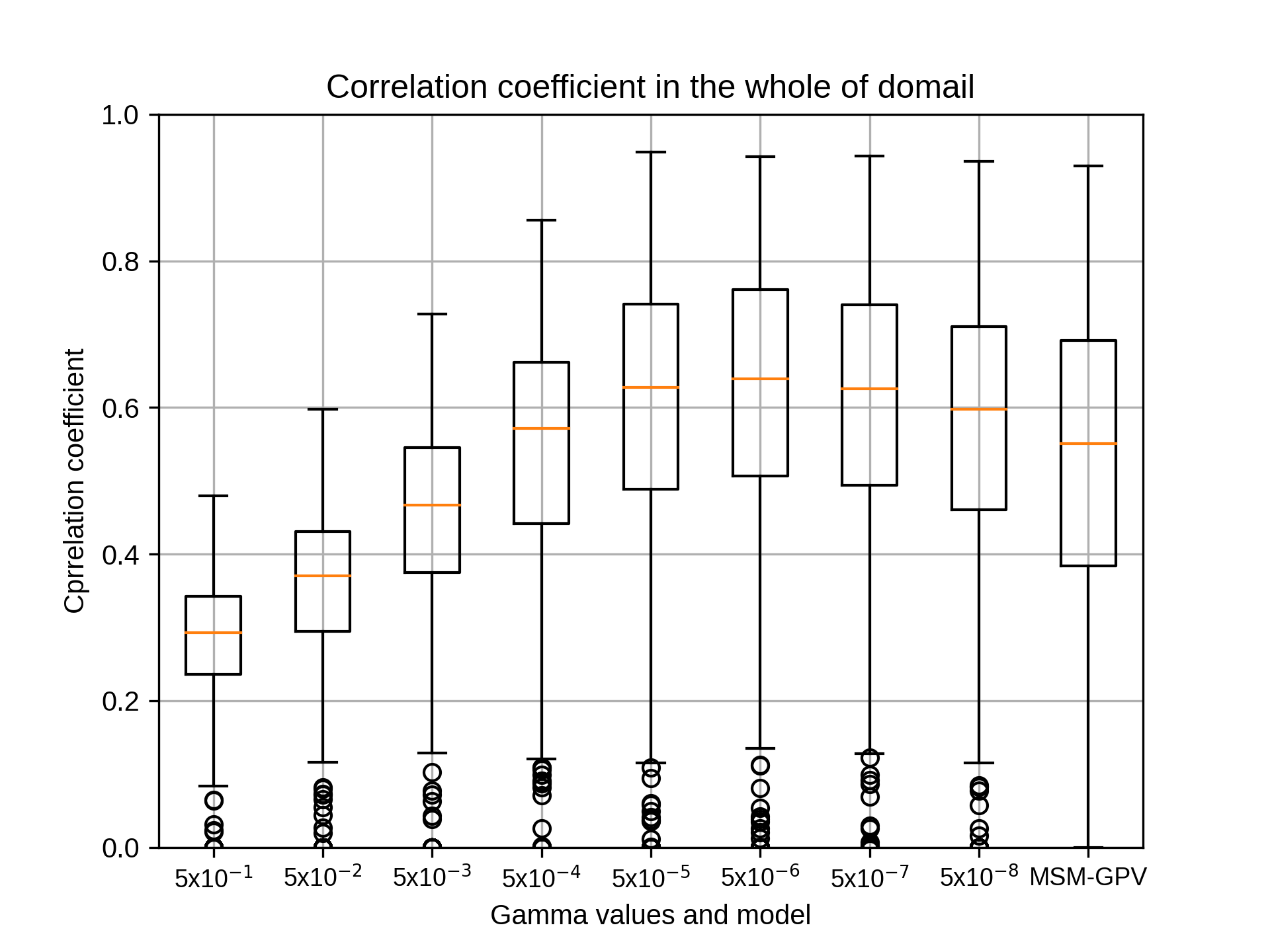

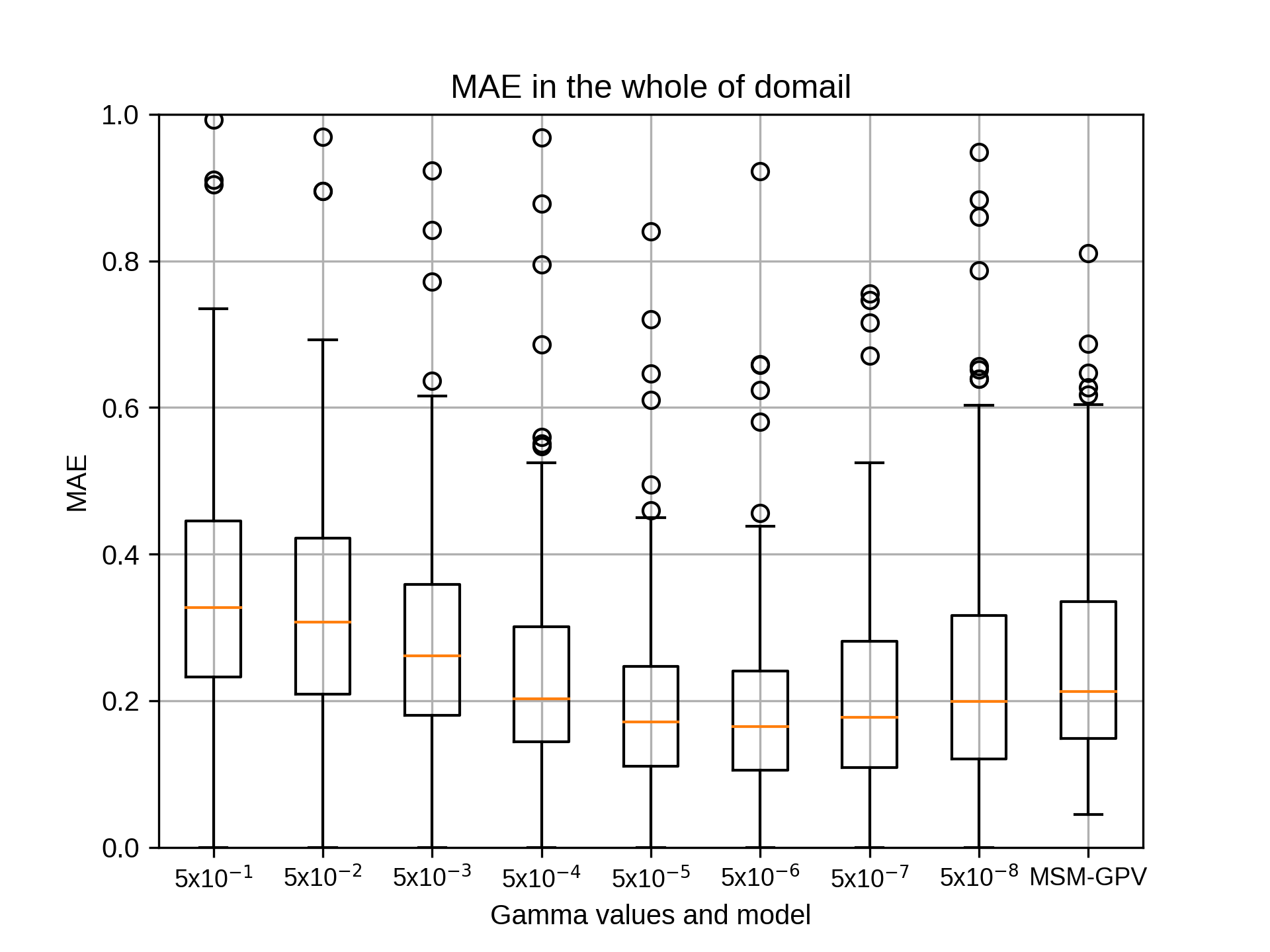

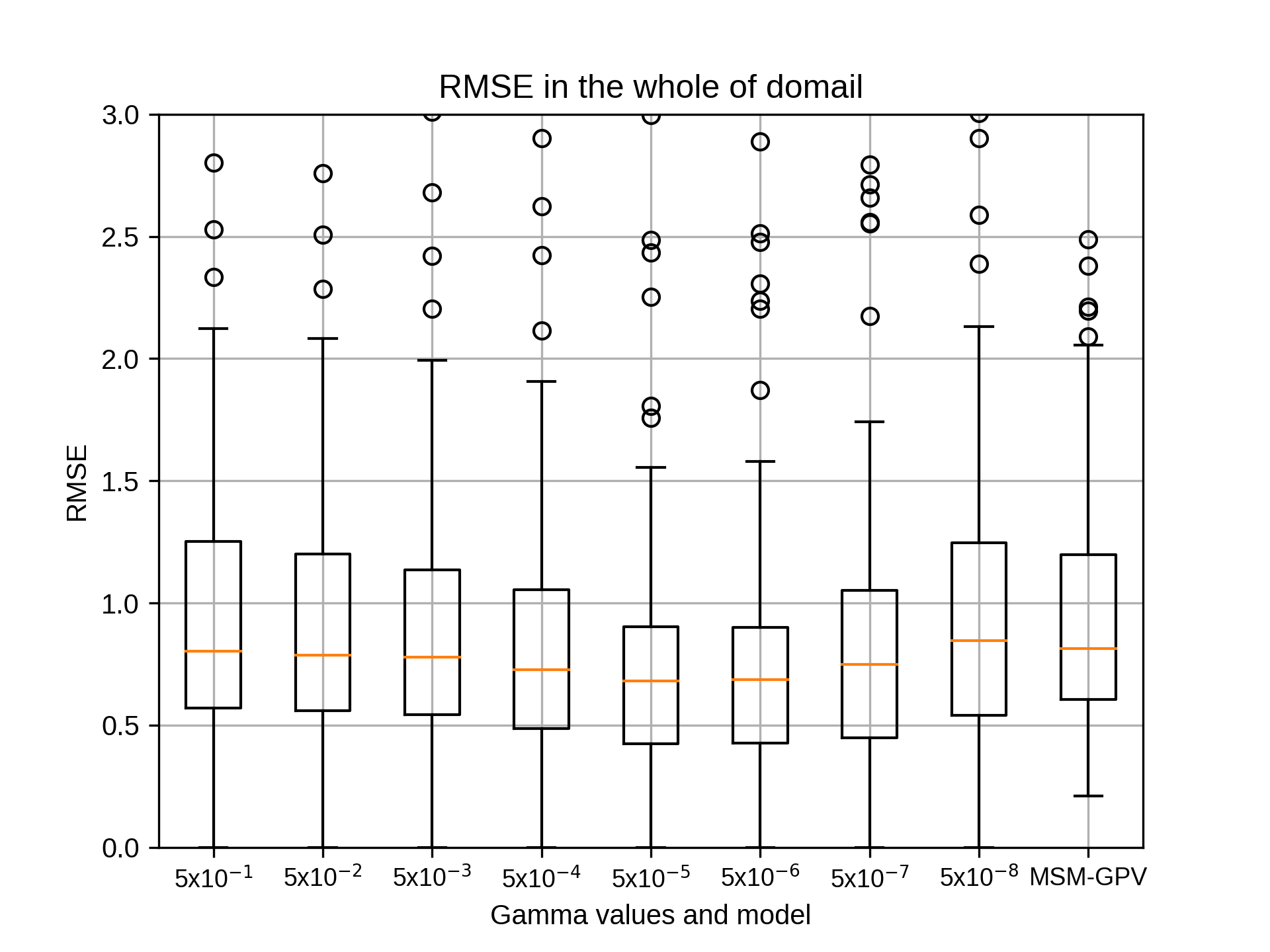

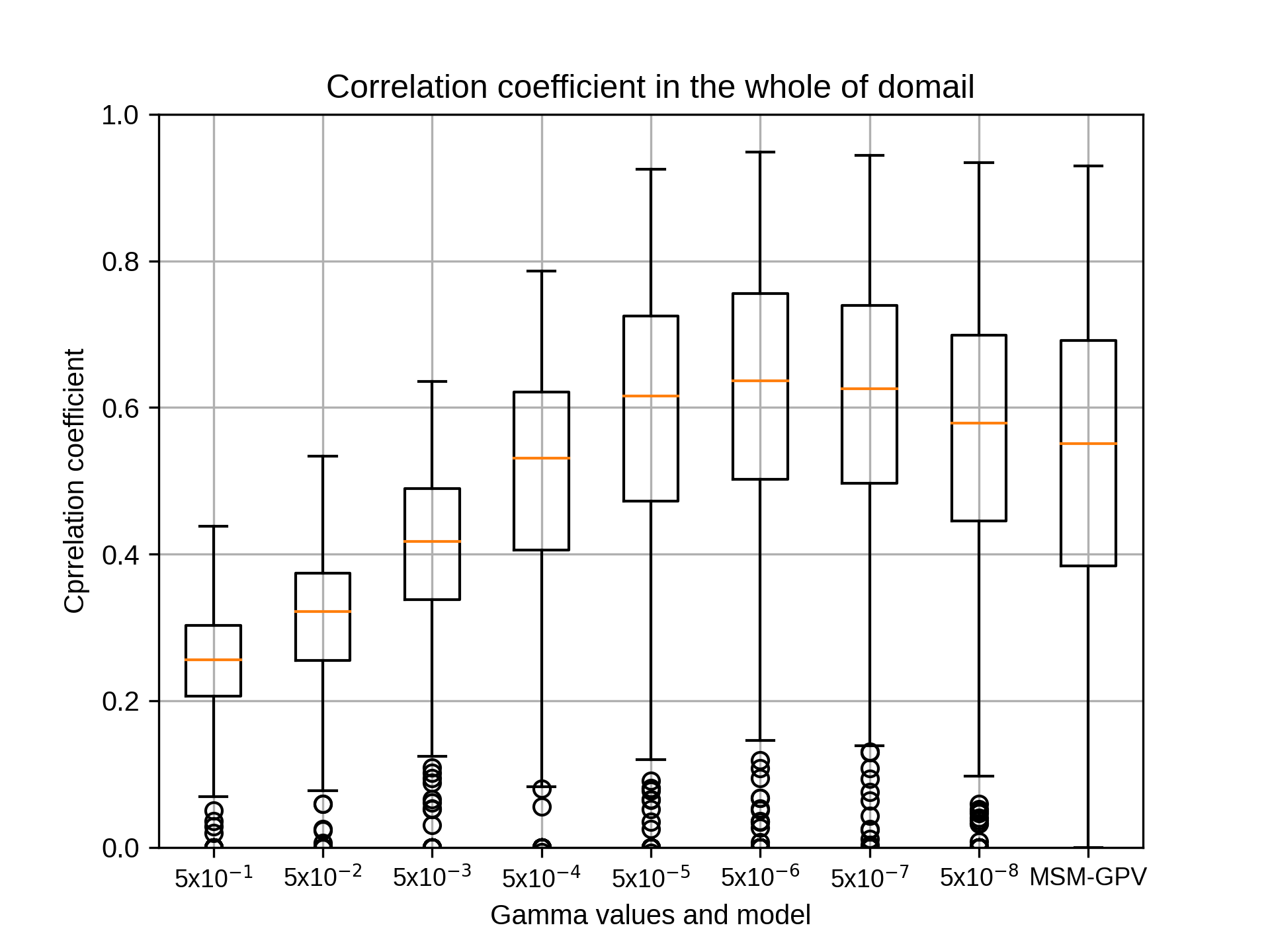

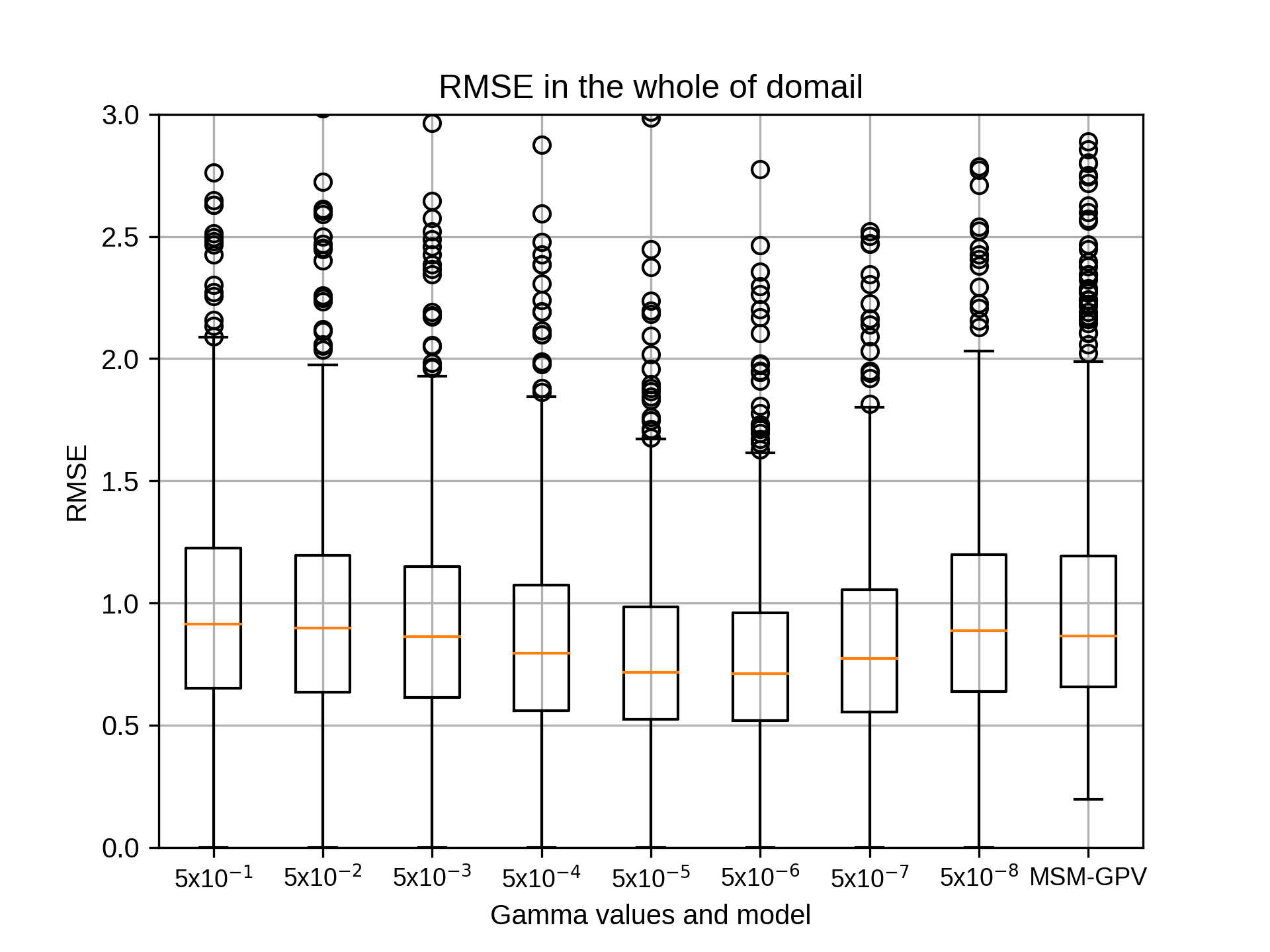

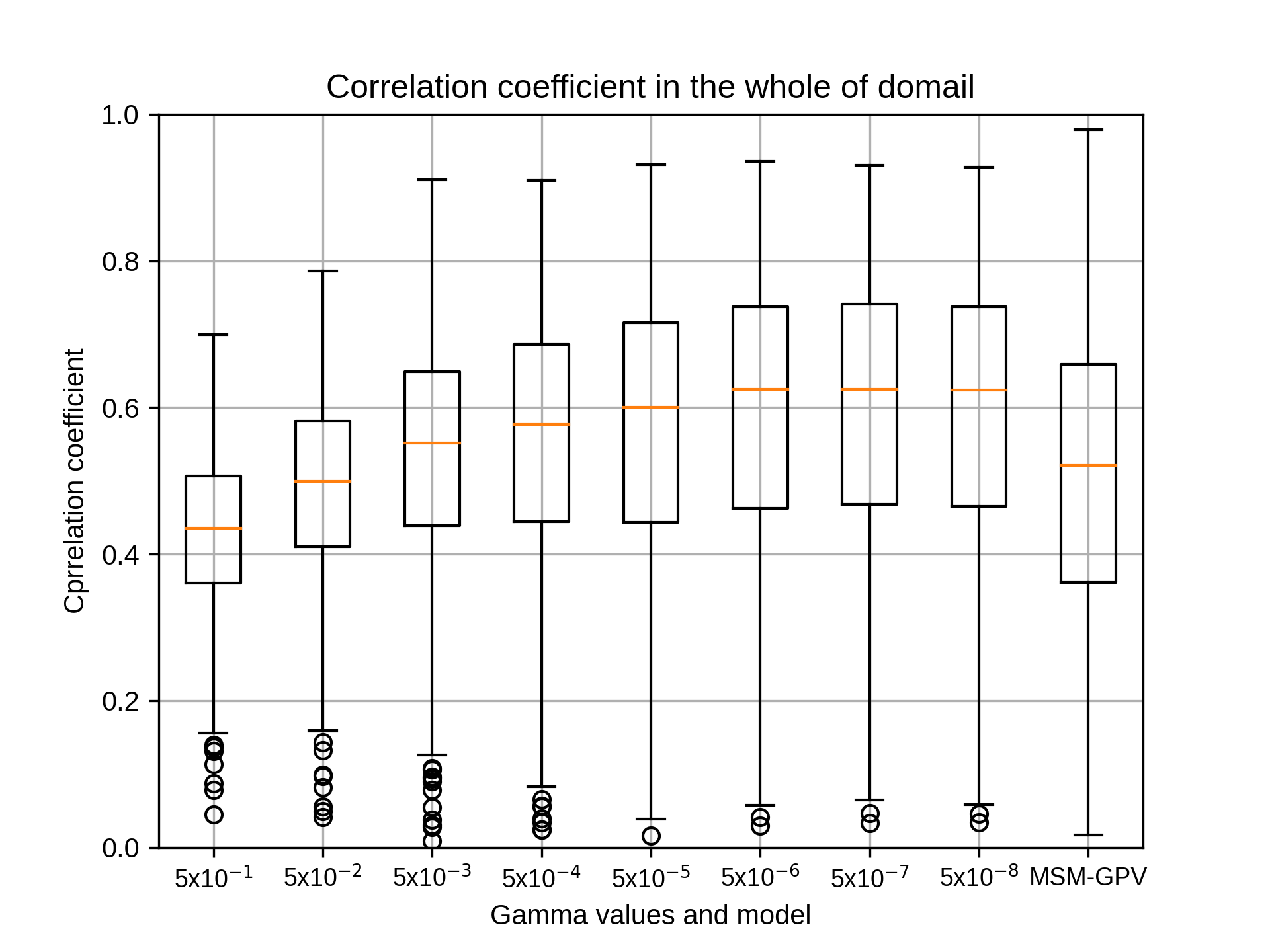

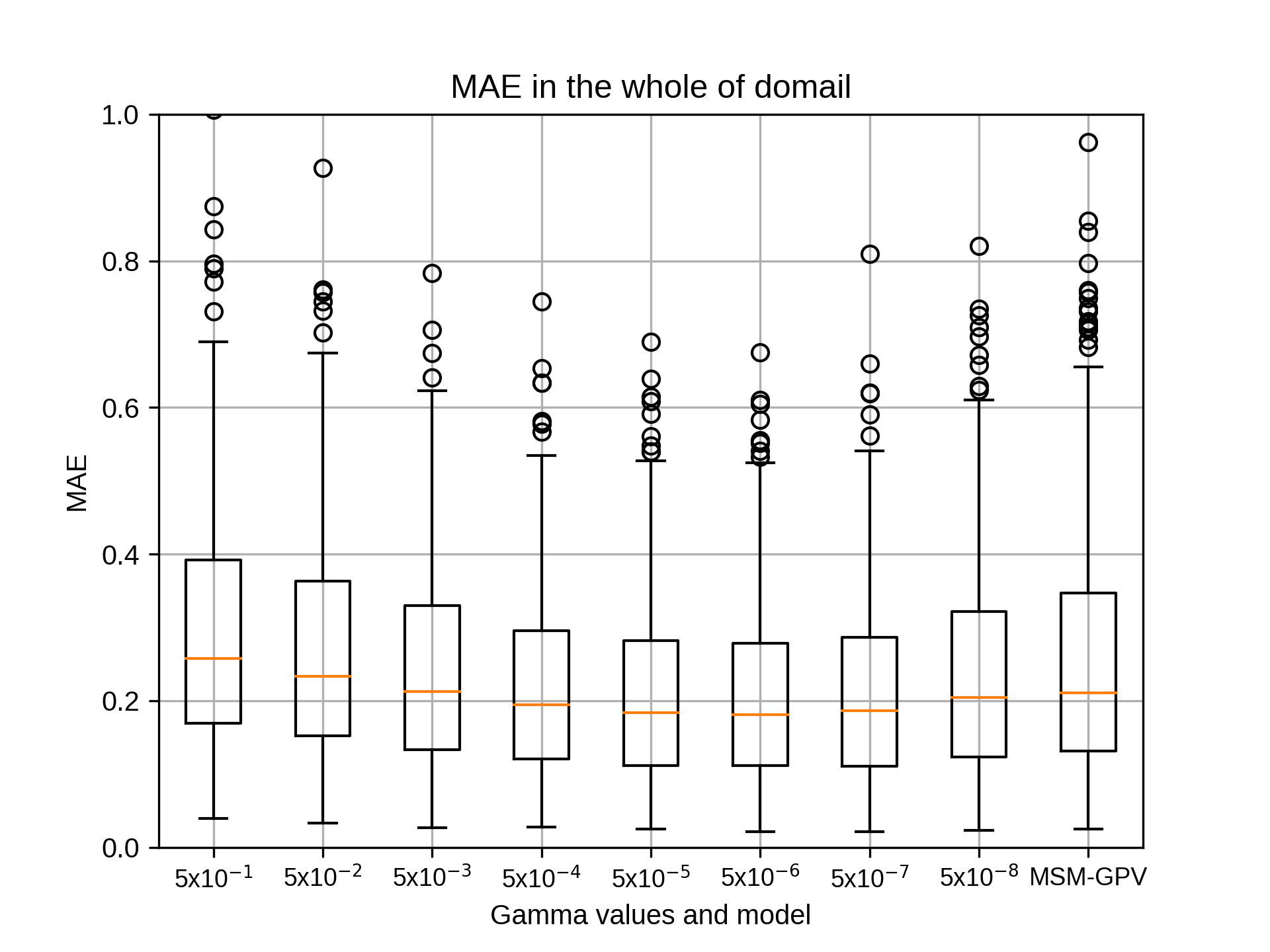

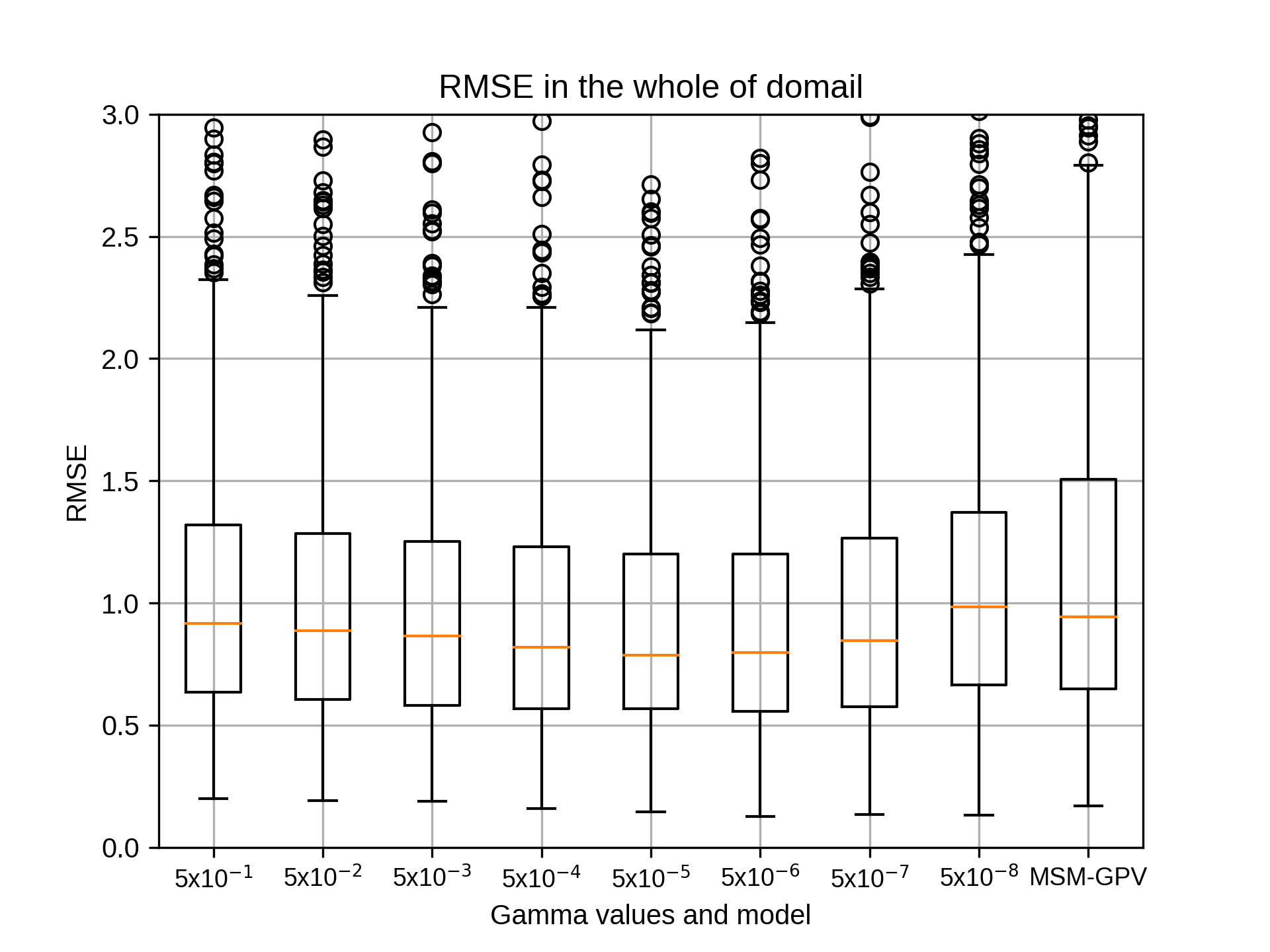

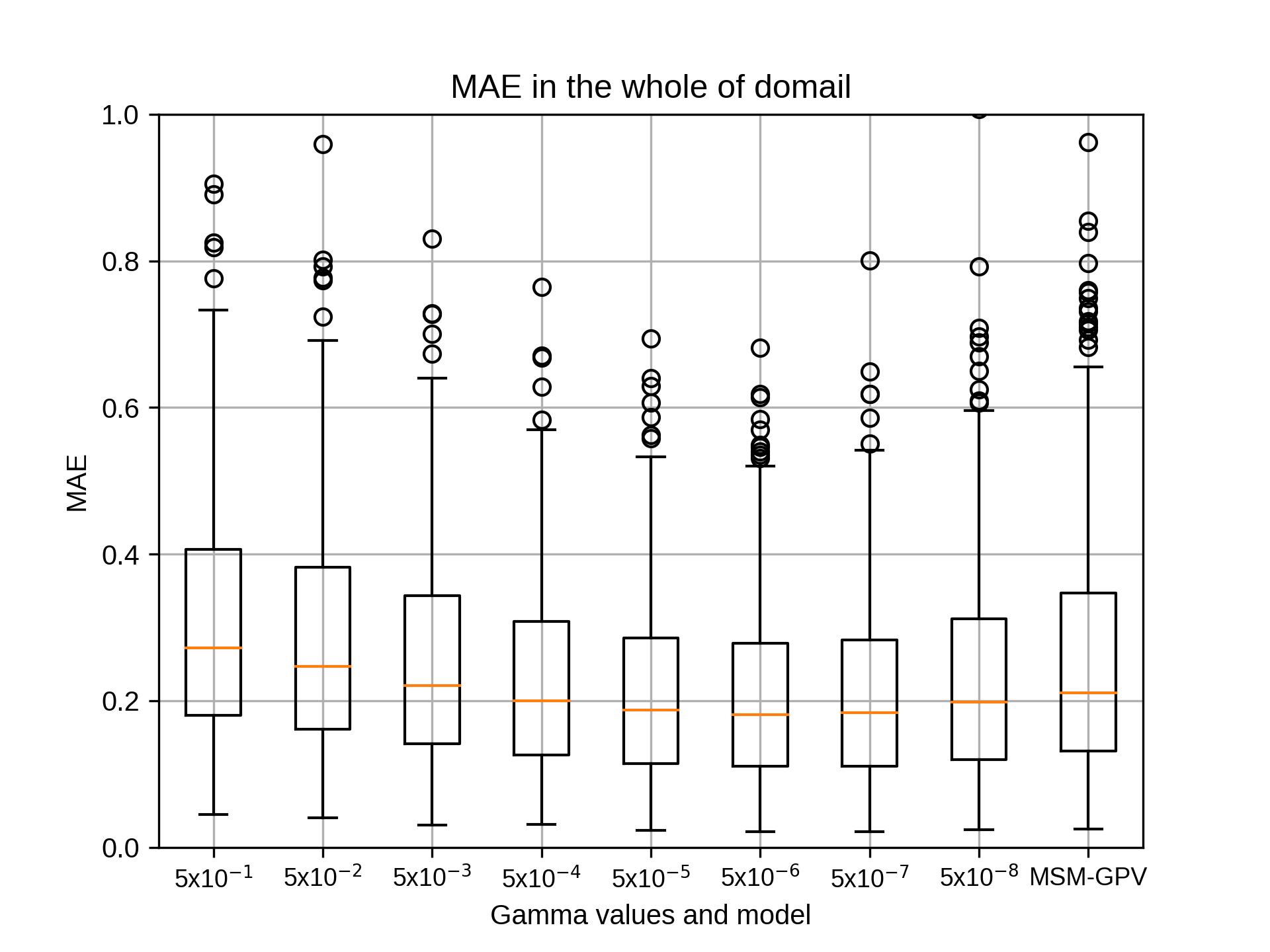

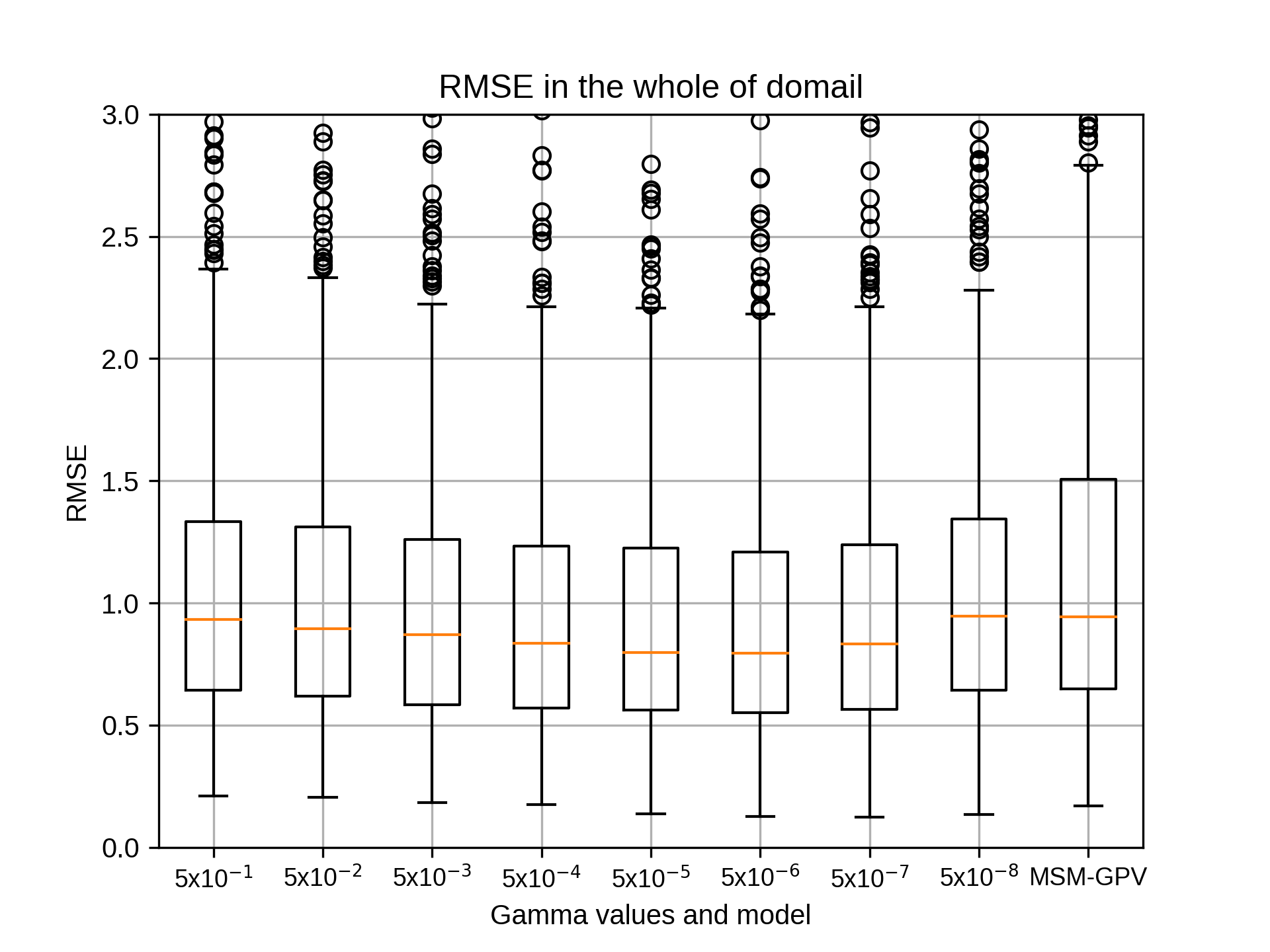

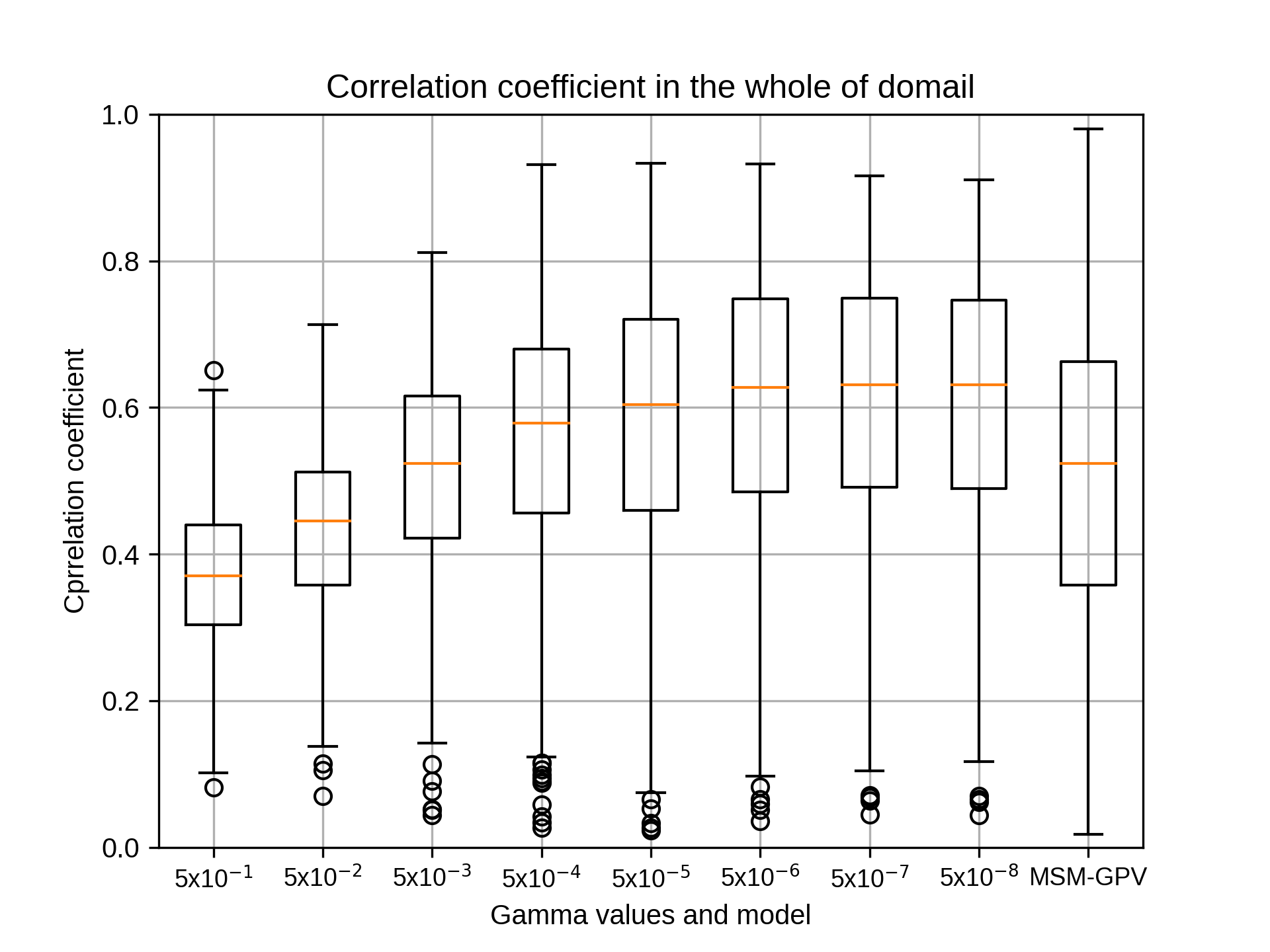

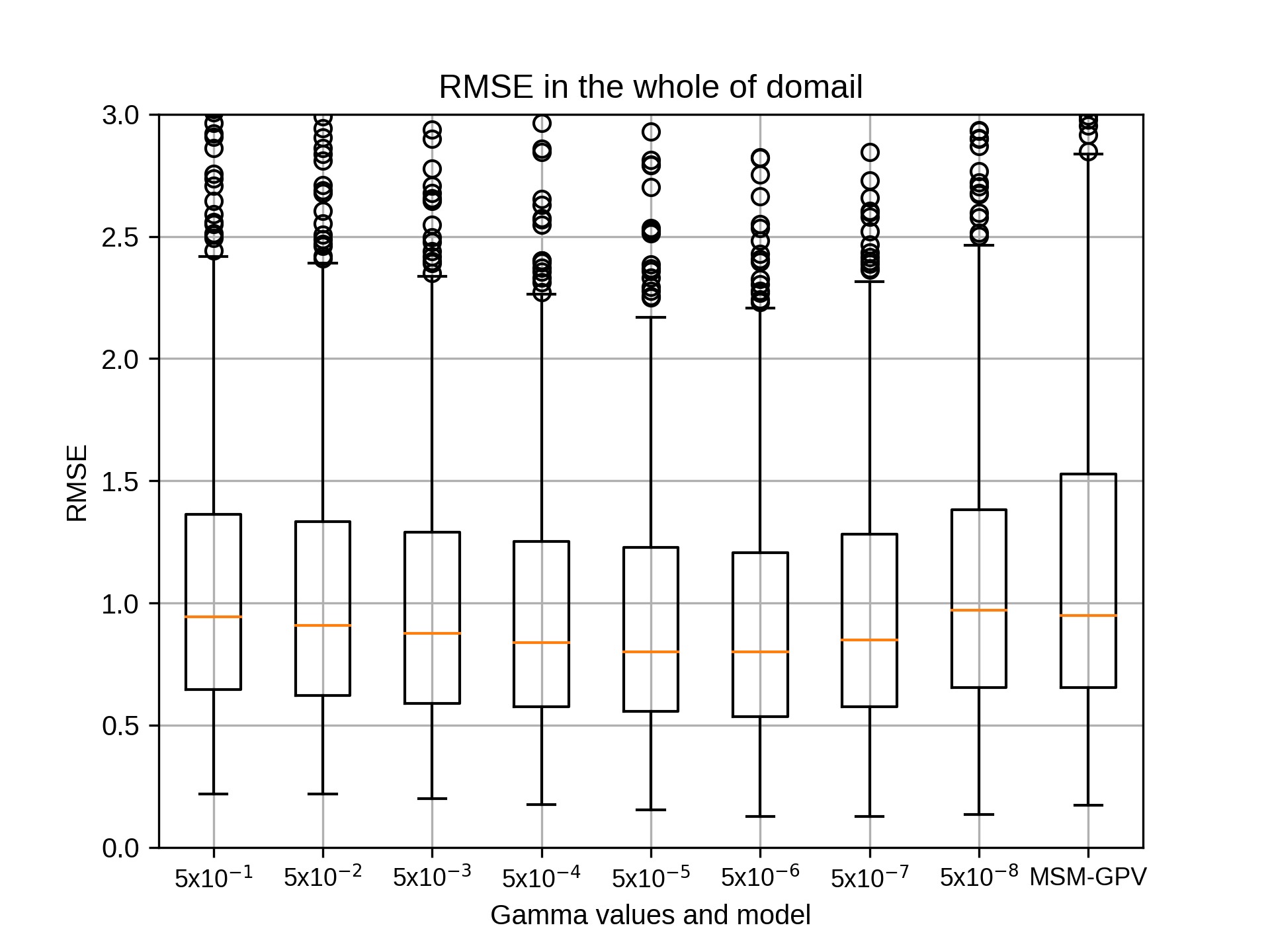

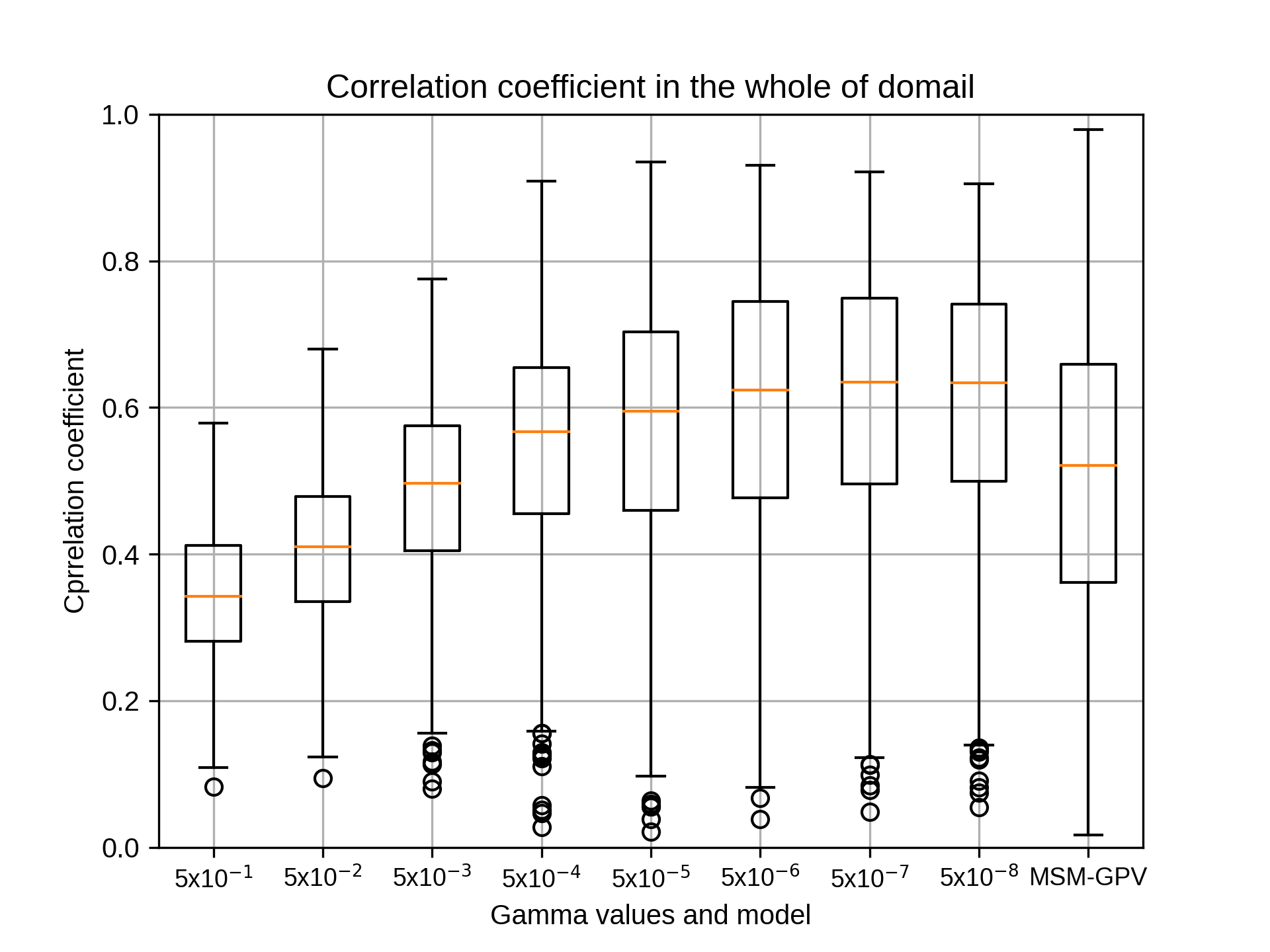

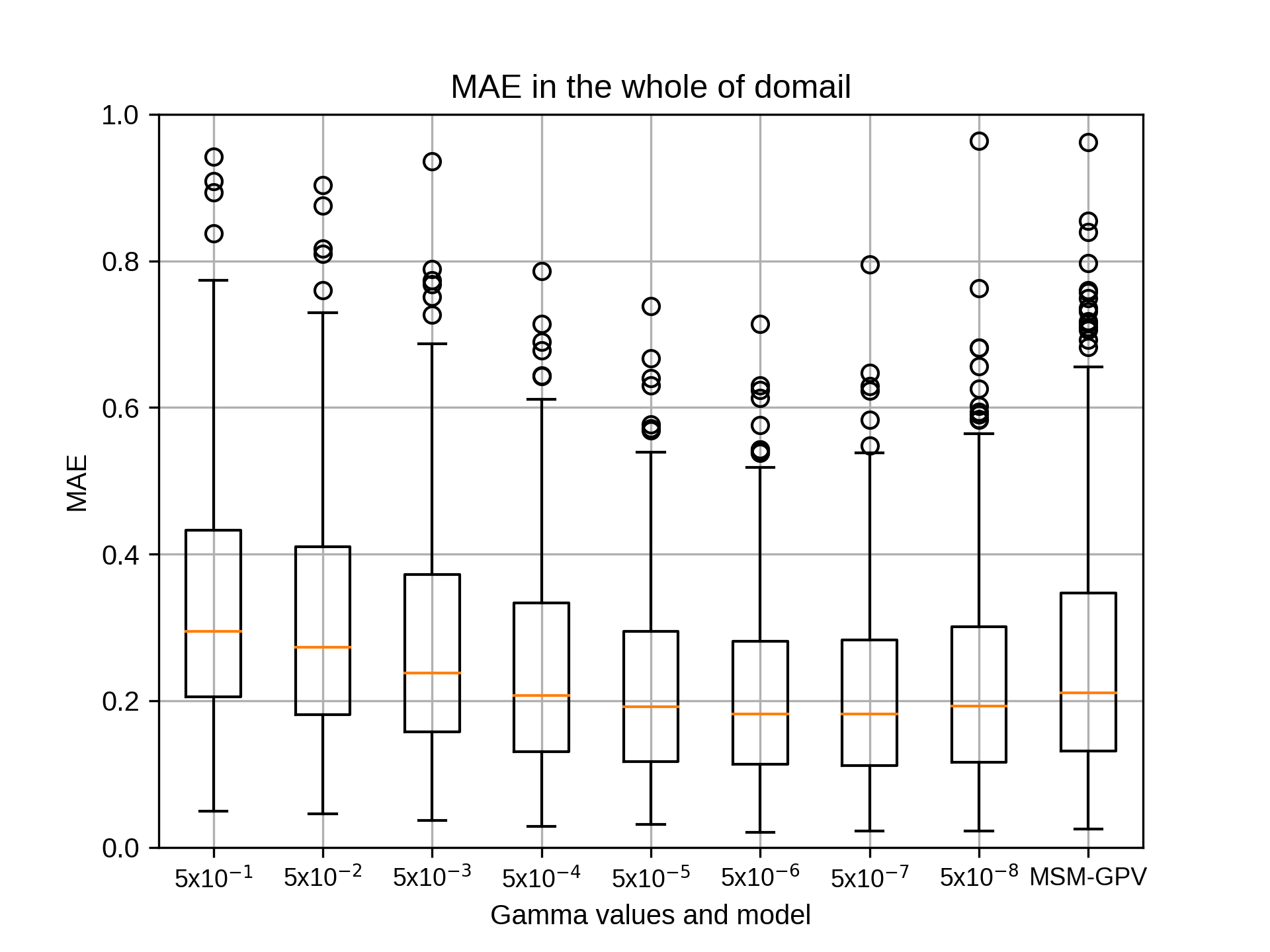

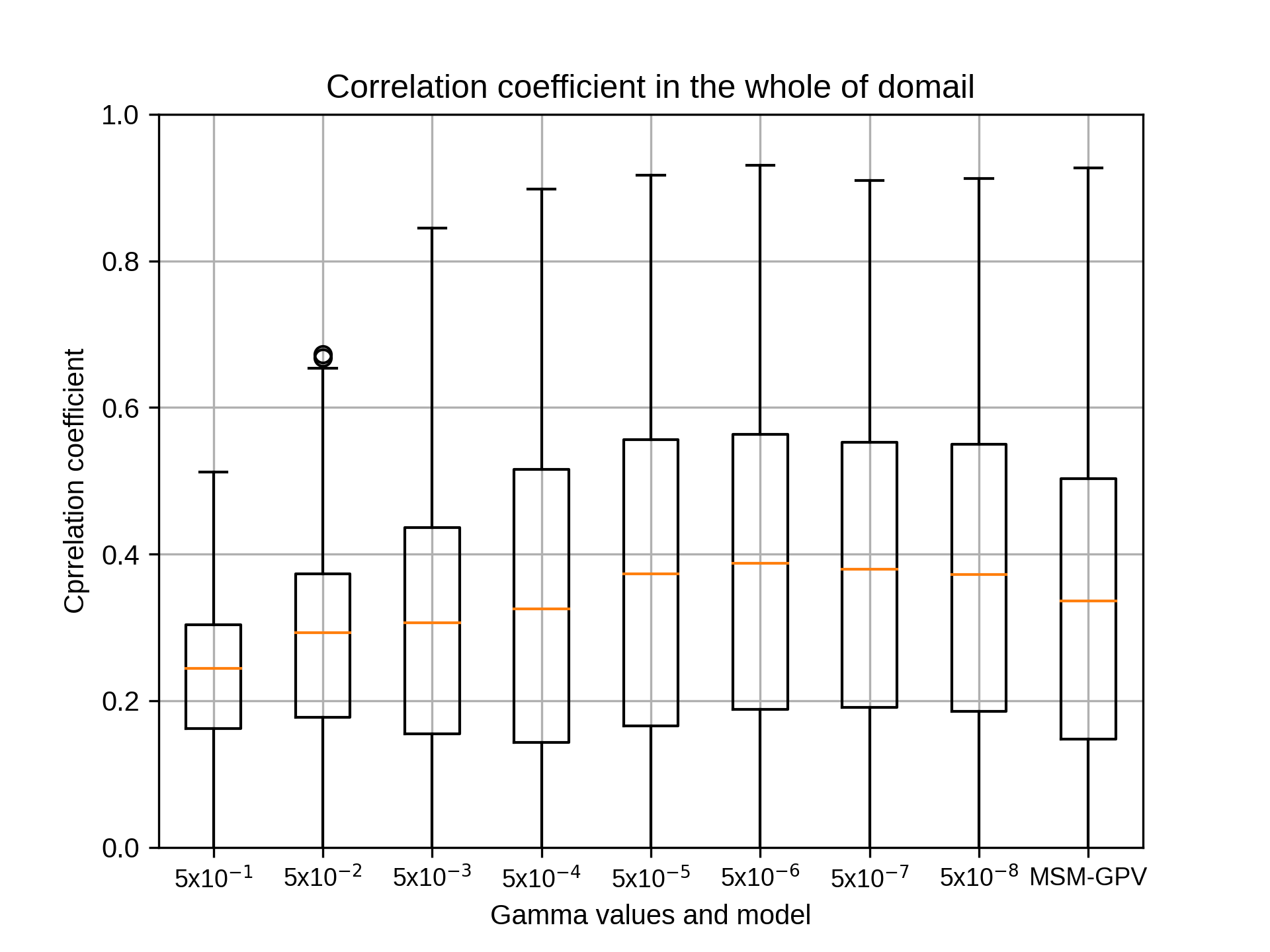

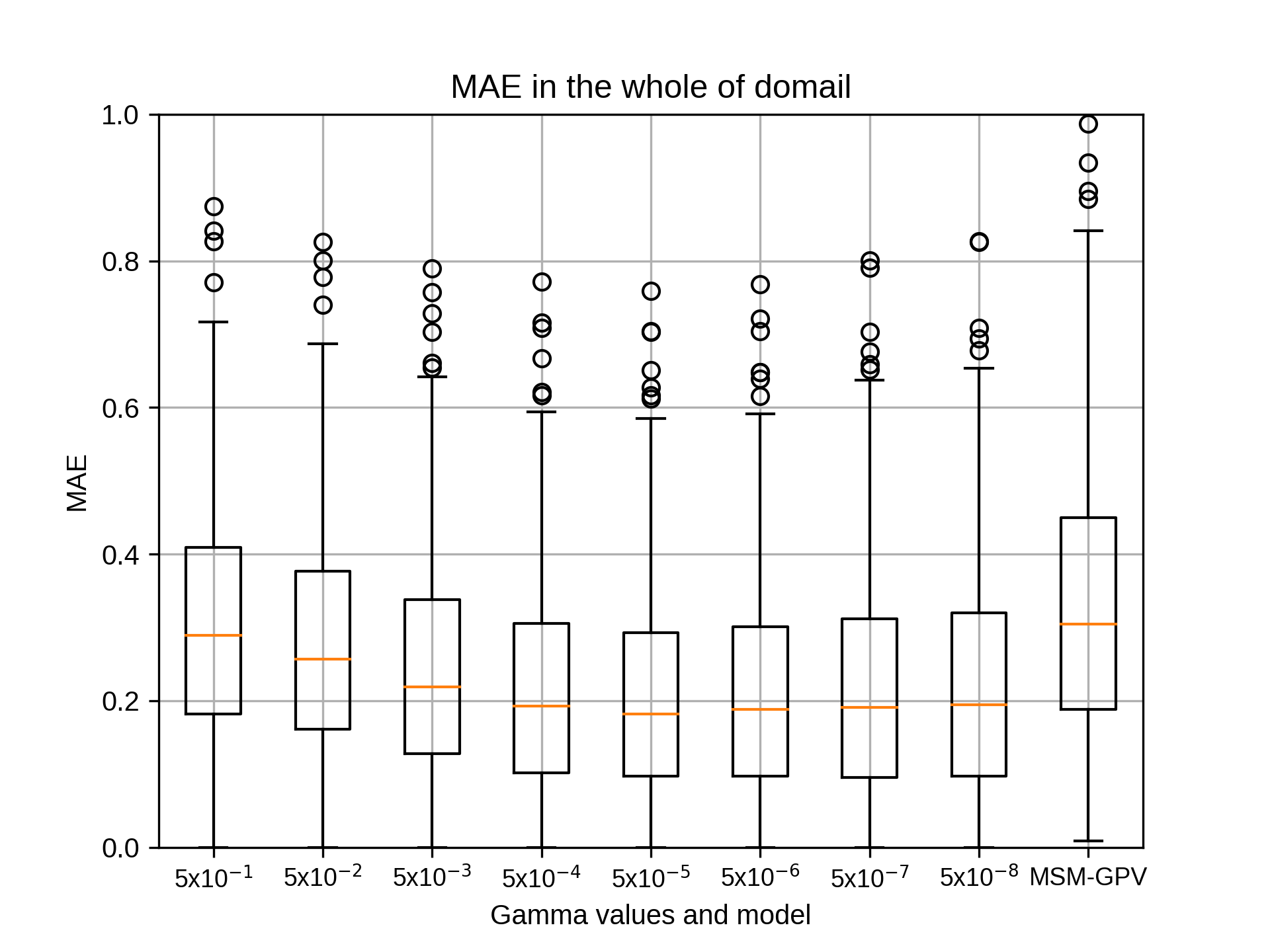

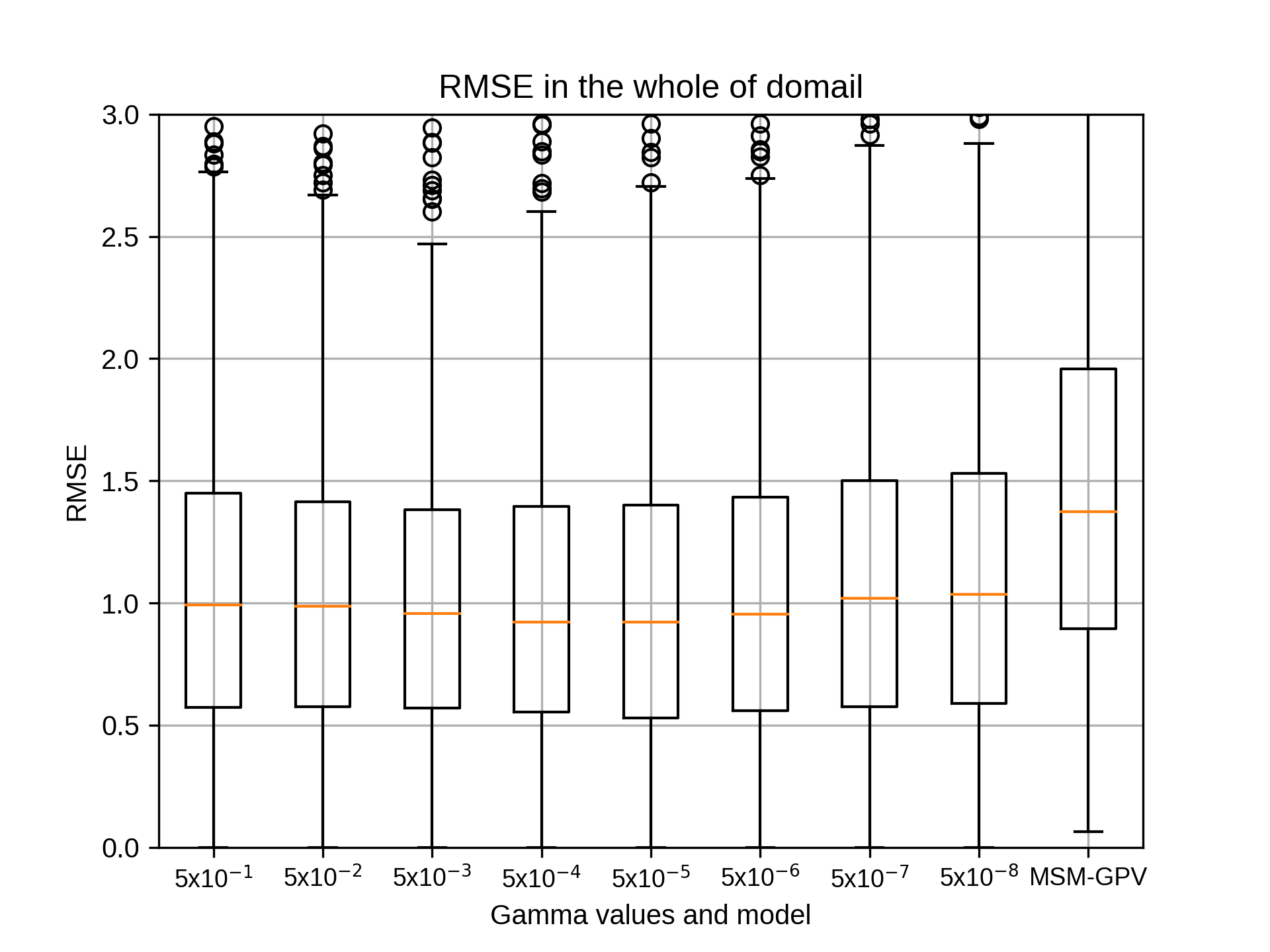

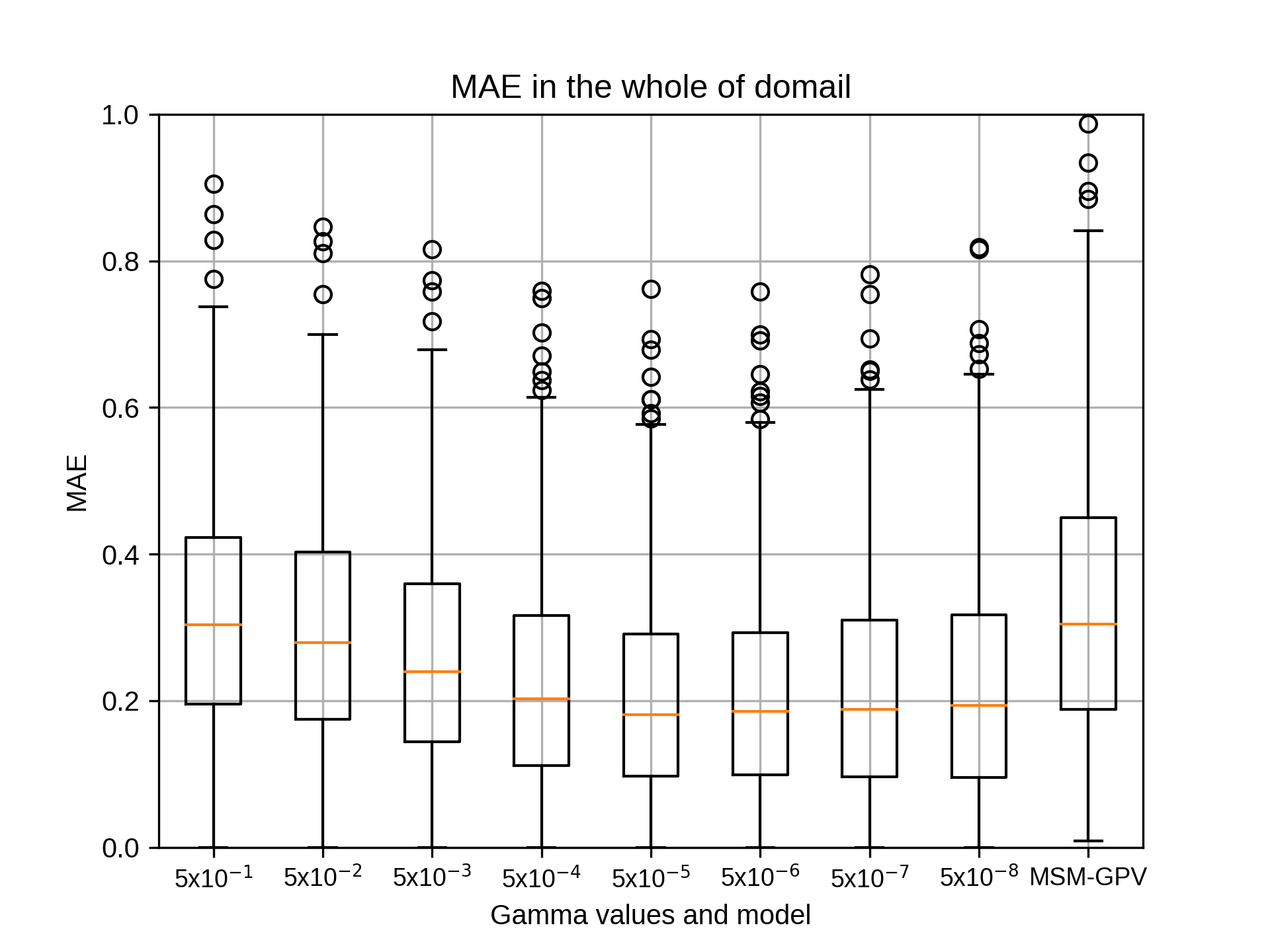

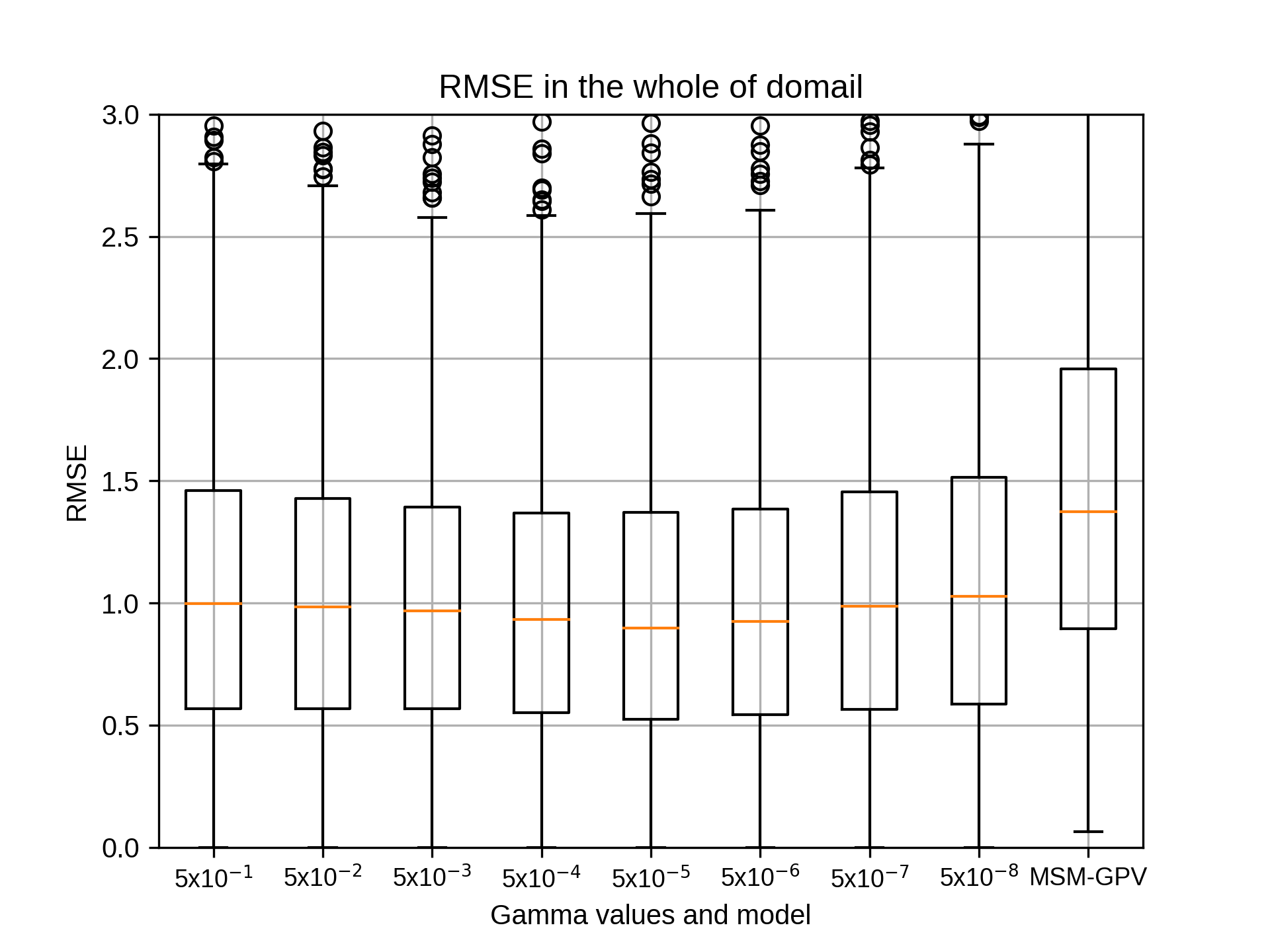

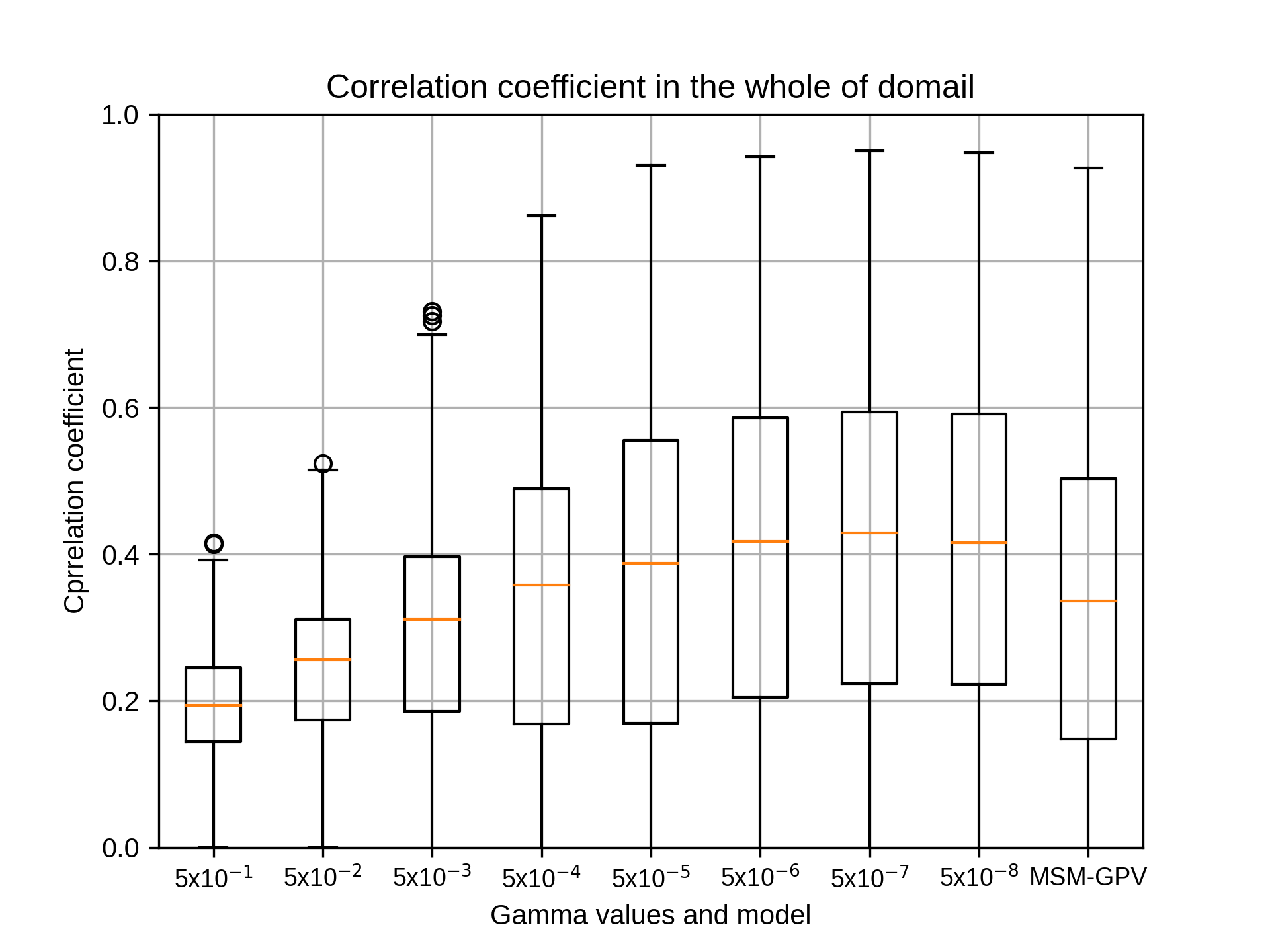

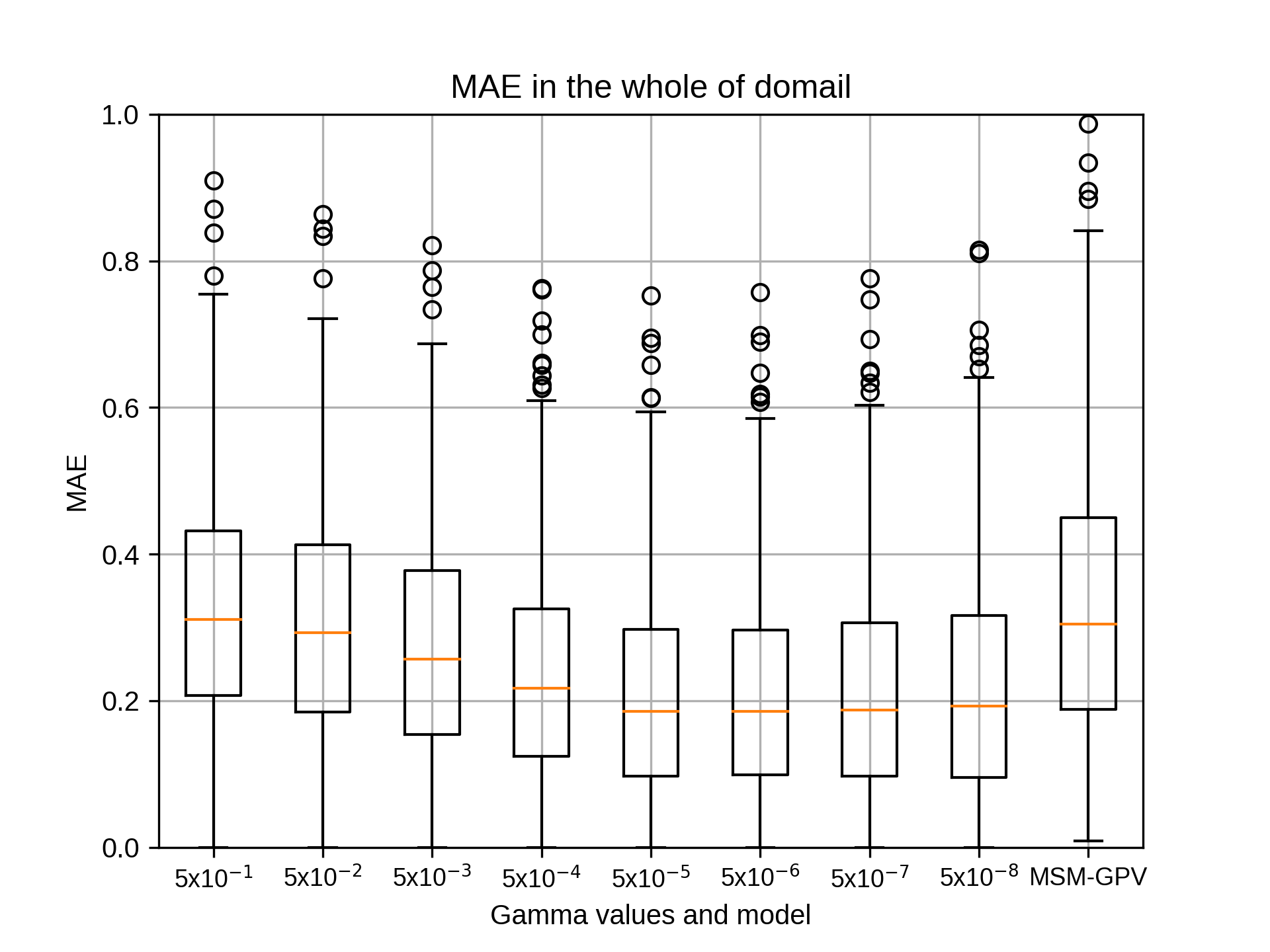

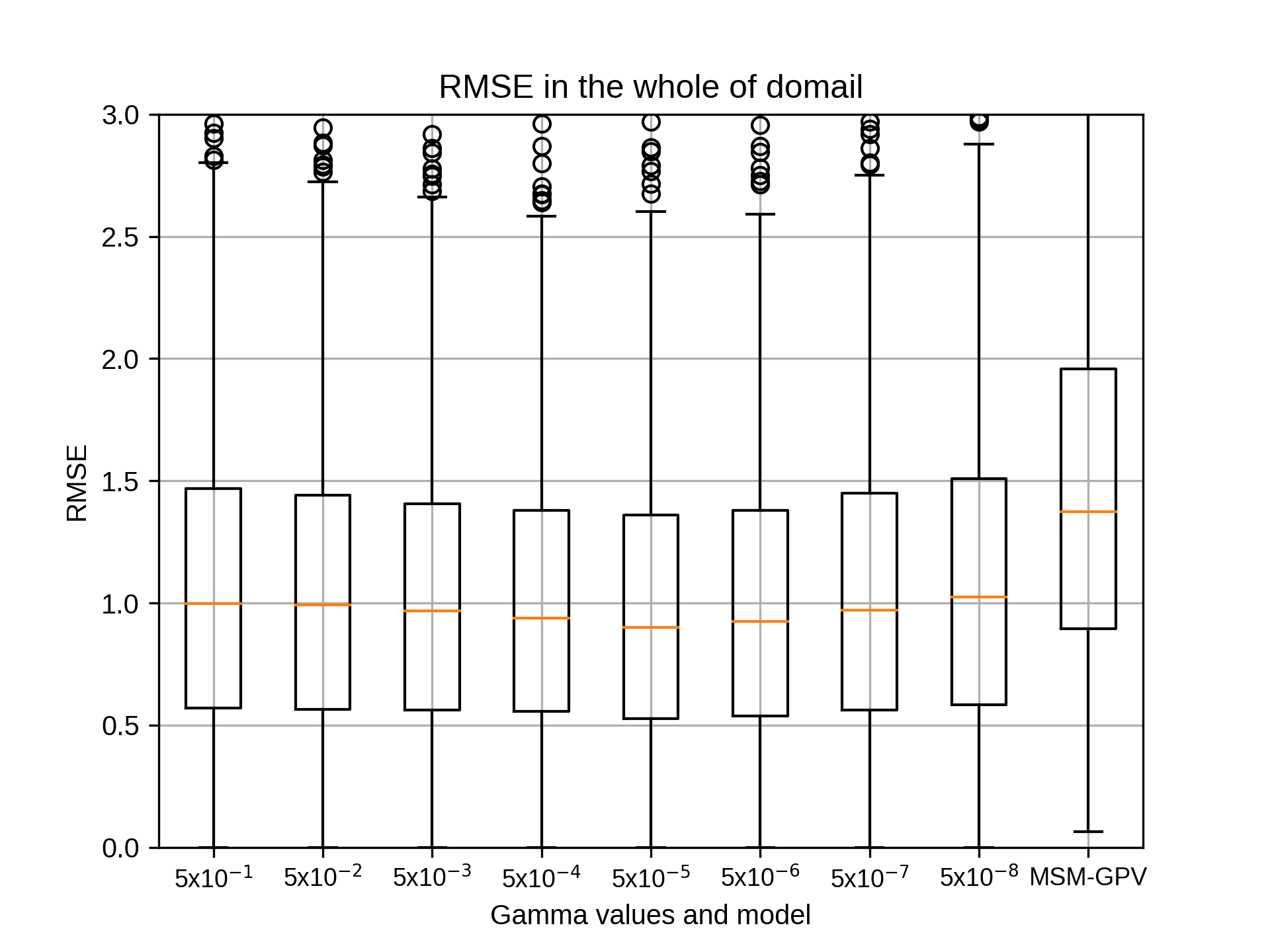

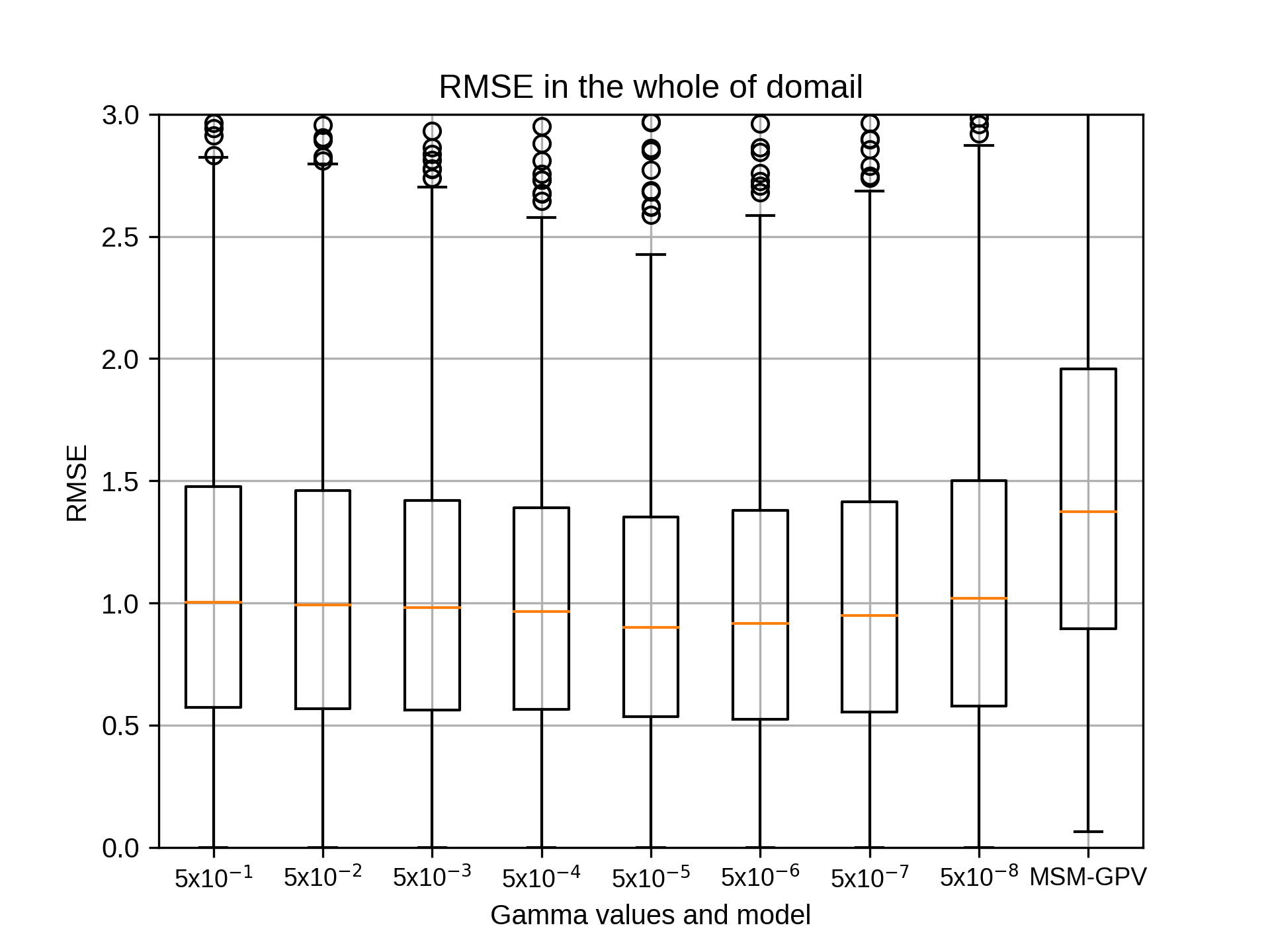

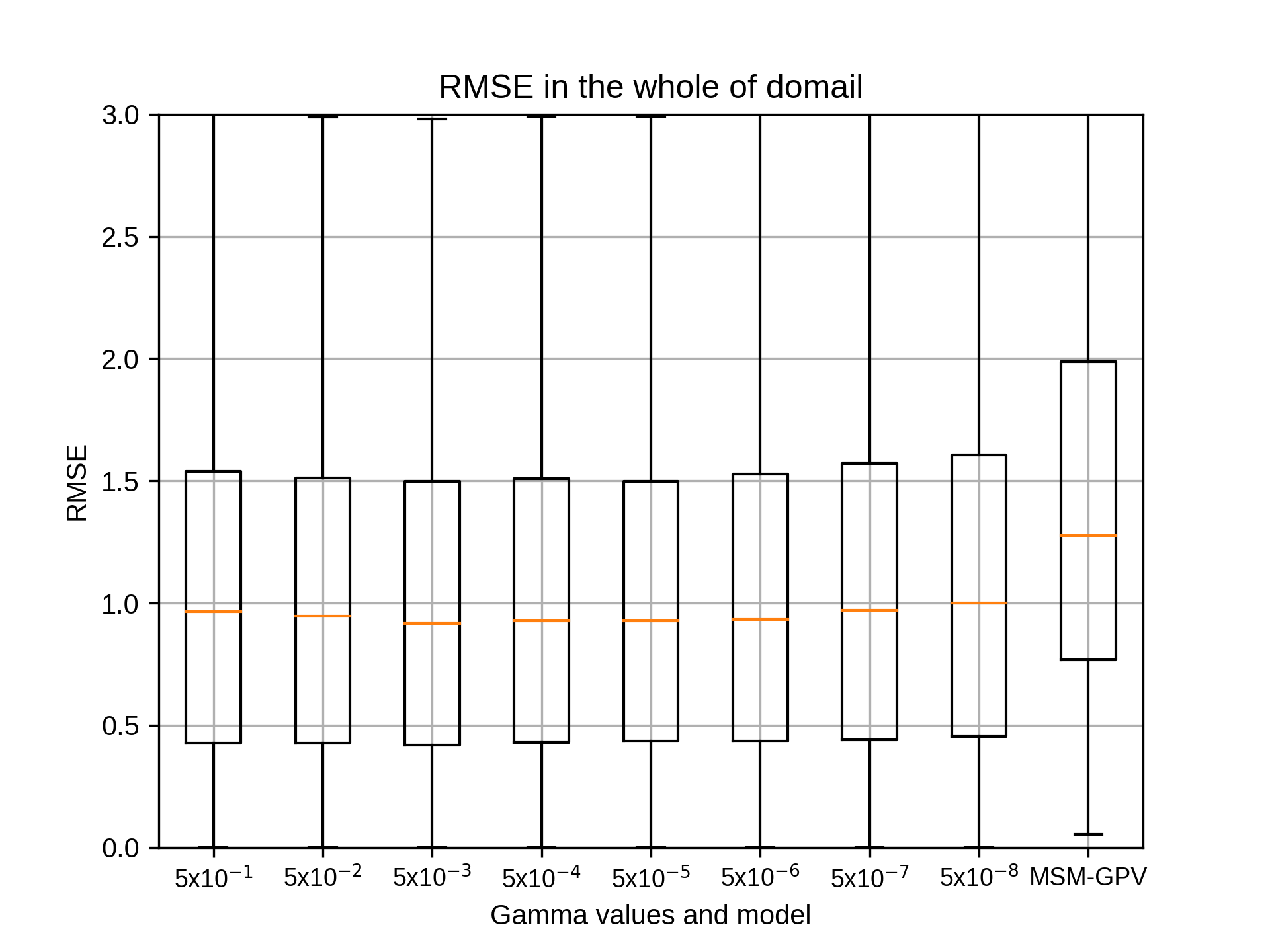

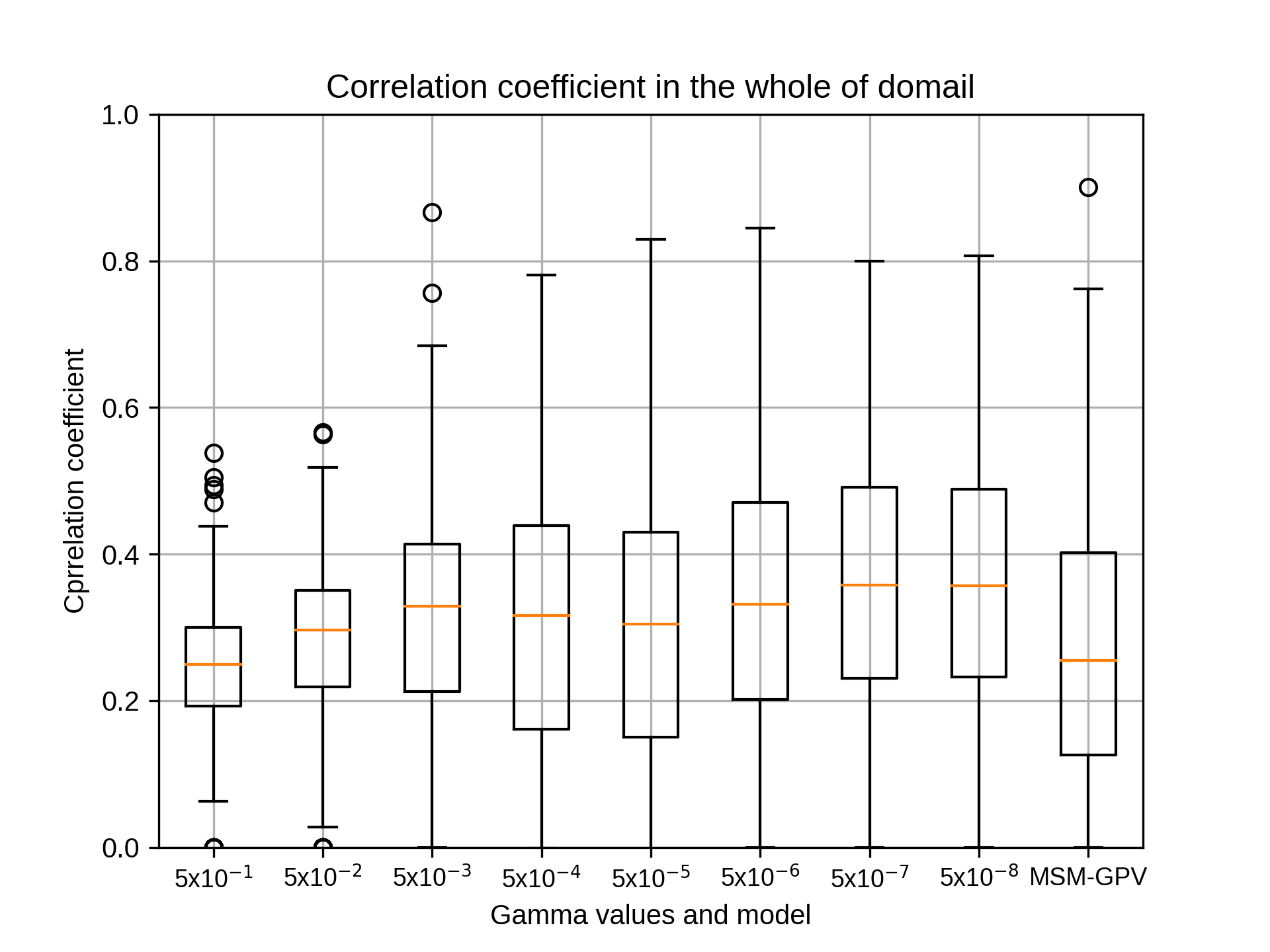

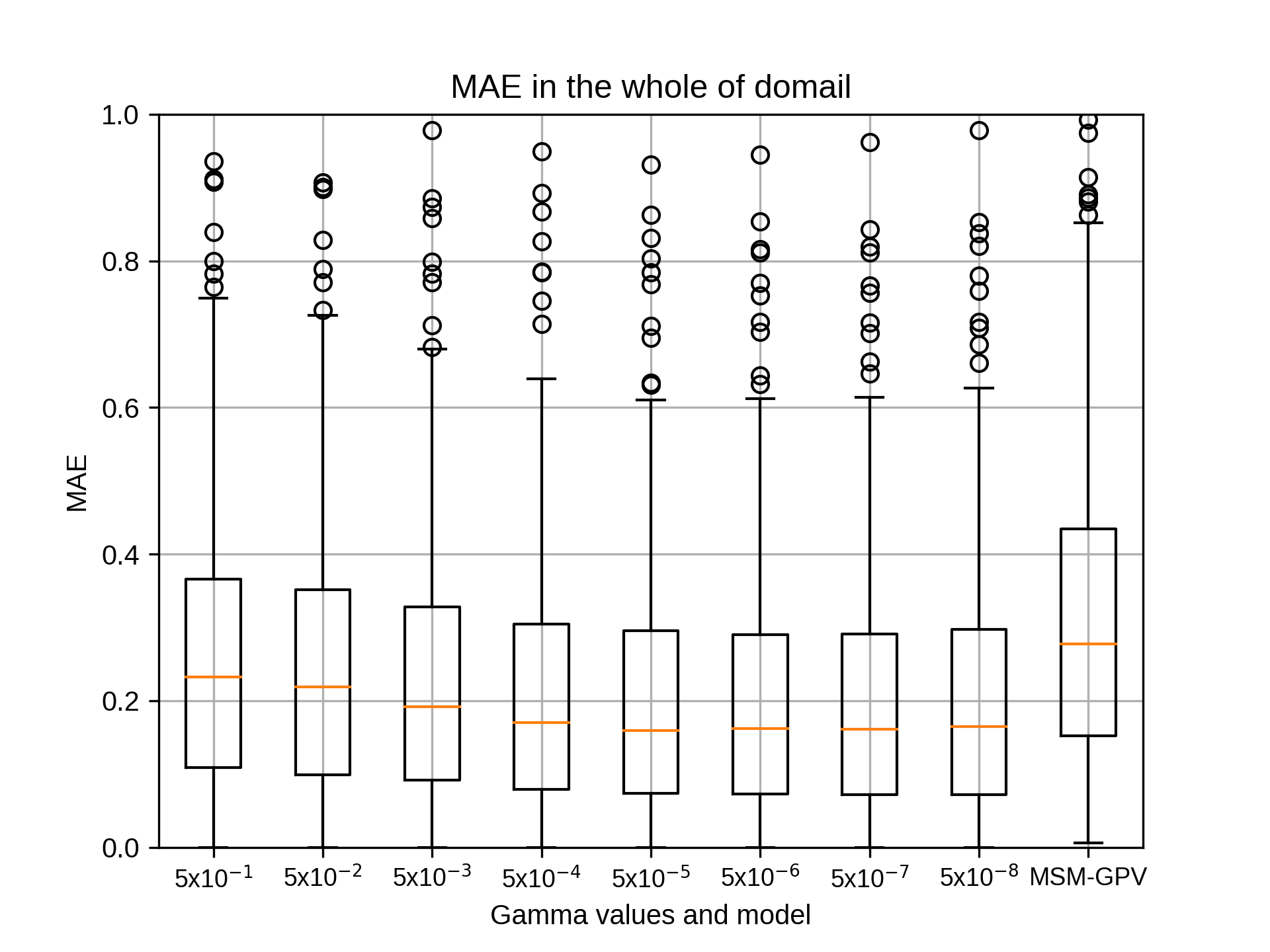

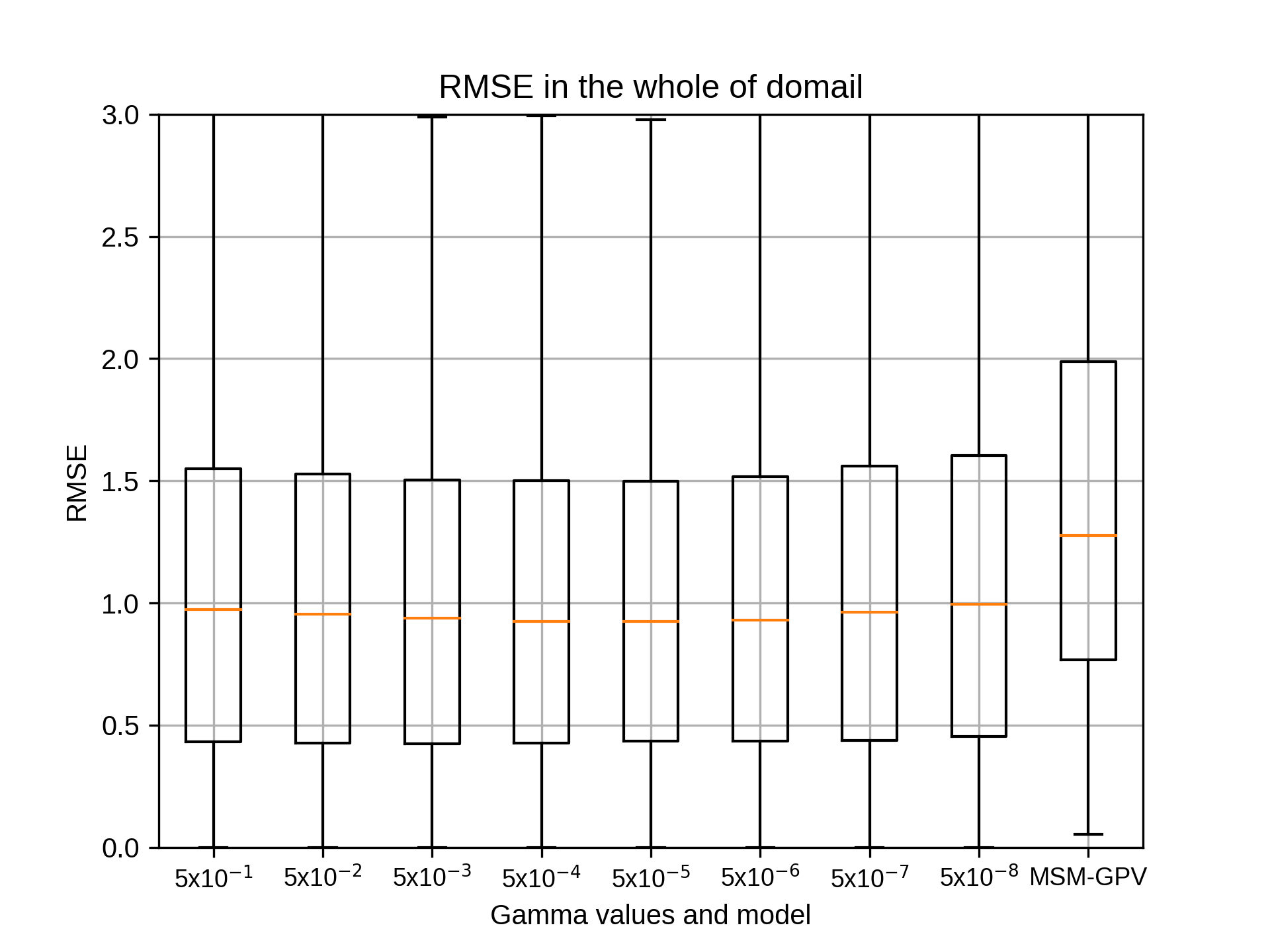

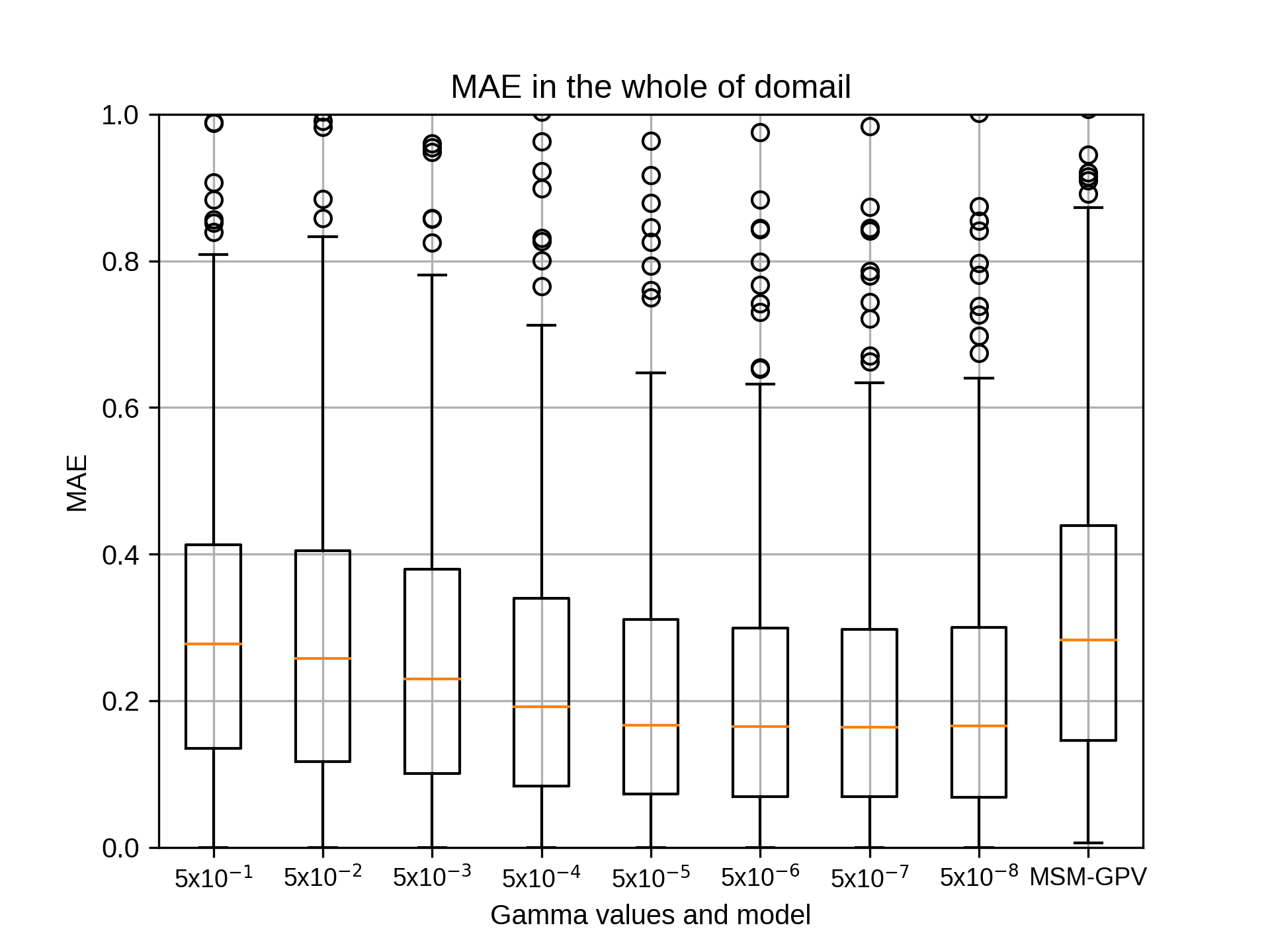

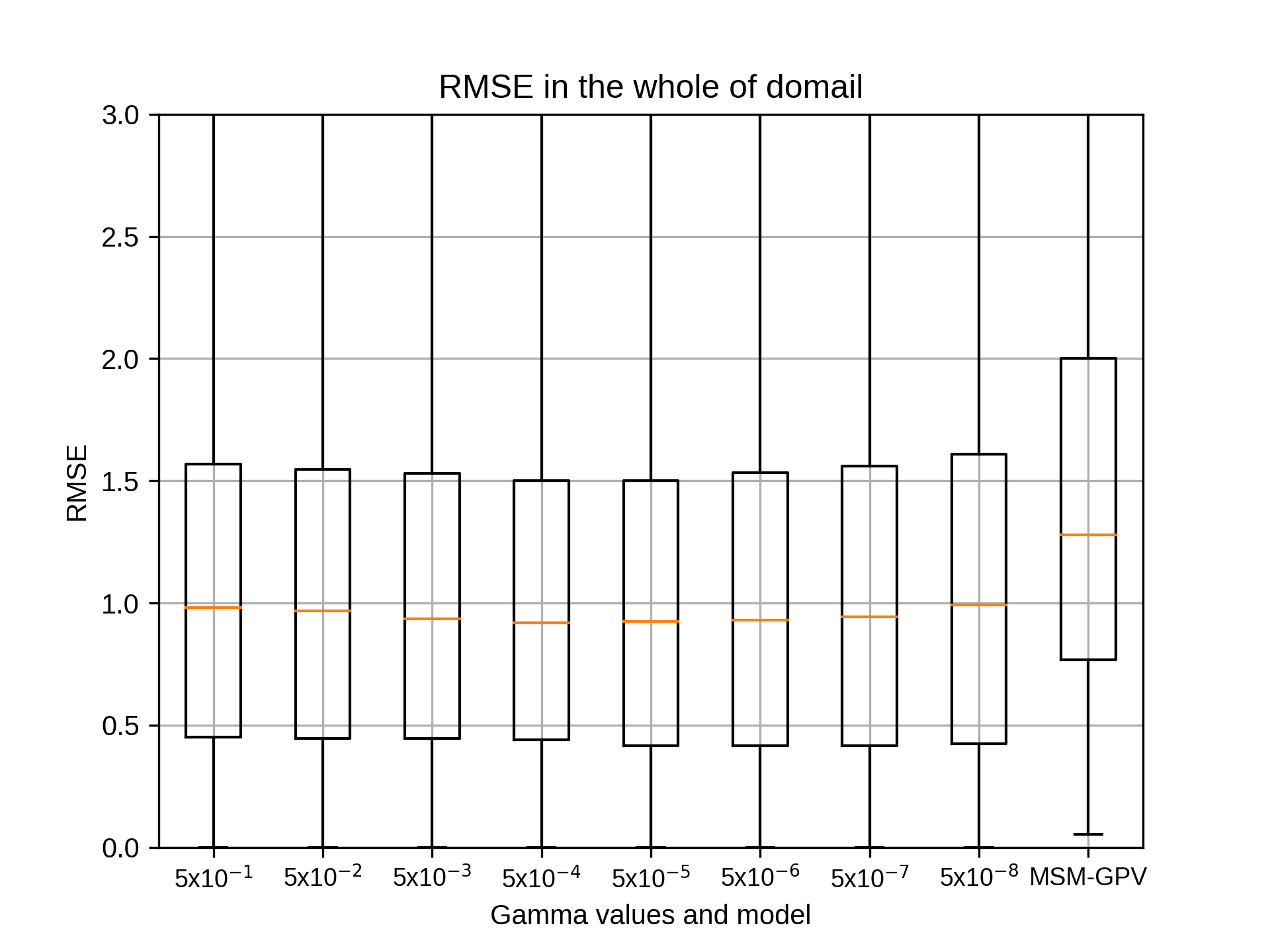

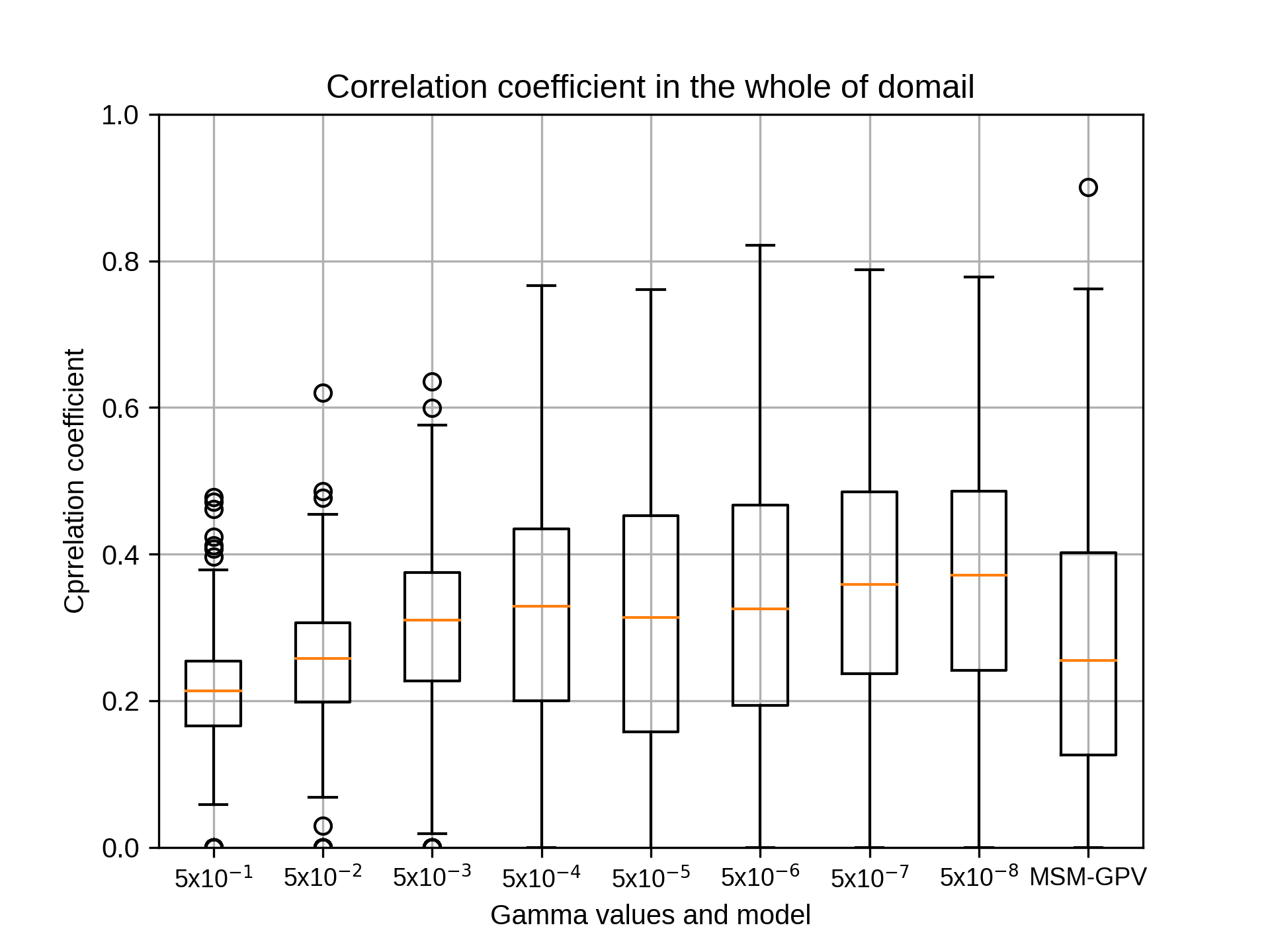

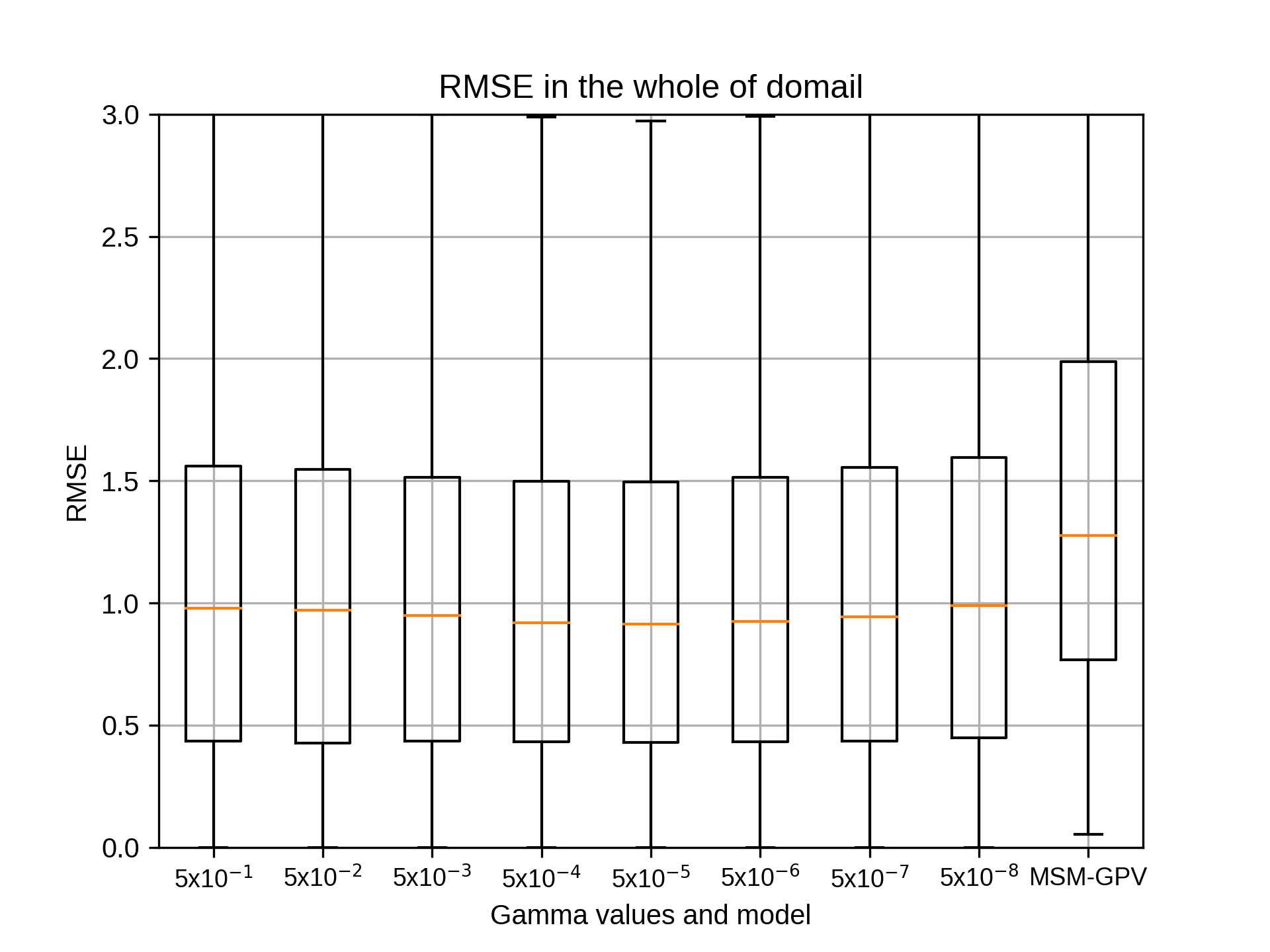

RをPythonに変換したプログラムでのグラフを添付します。

パラメータは以下のとおりです。

また、現在RとPythonでのstep別の処理時間を計算しております。

よろしくお願いします。

全体の処理時間計測

環境: EORCの計算機(zico-n)

処理時間:8時間46分10秒

(auto.shの開始時間から終了時間まで)

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: RESTECで全国を5つに分けて作成したMSM,解析雨量データセット

サイト:siteC(西日本・九州)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

吉兼先生

RをPythonに変換したプログラムでのグラフを添付します。

パラメータは以下のとおりです。

また、現在RとPythonでのstep別の処理時間を計算しております。

よろしくお願いします。

全体の処理時間計測

環境: EORCの計算機(zico-n)

処理時間:8時間46分10秒

(auto.shの開始時間から終了時間まで)

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: RESTECで全国を5つに分けて作成したMSM,解析雨量データセット

サイト:siteC(西日本・九州)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

takao-yWednesday, August 26th, 2020 at 10:22:14 AM GMT+09:00

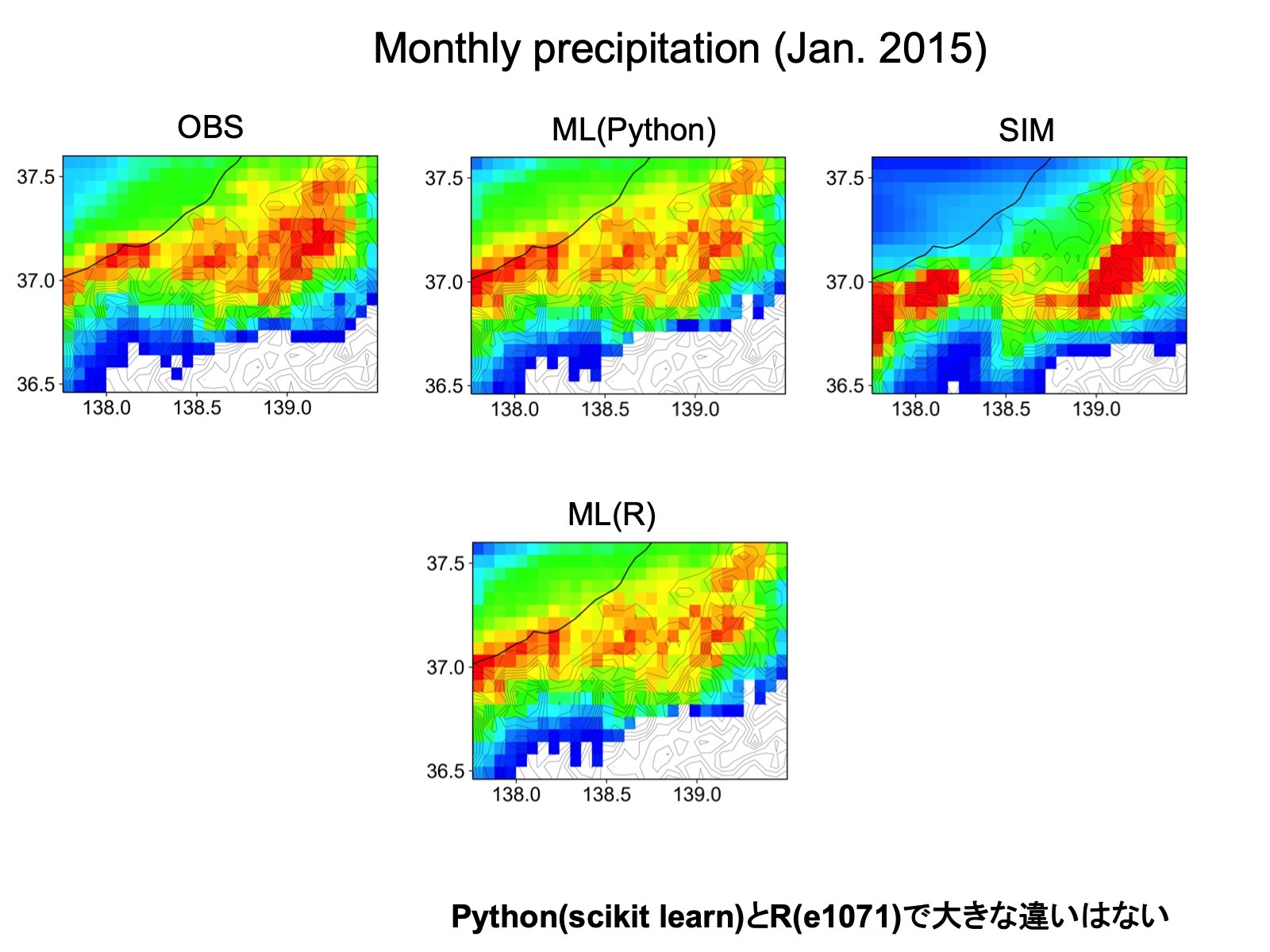

@kobayashi_yusuke 小林様。ありがとうございます。図を見る限り正常に作動しているように思います。それでは、同様にしてRegion AからEまで同様に実施していただけますでしょうか。領域の広さの違いと欠損値に注意する必要がありますが、基本的には、それぞれの領域に対してauto.shを変更すれば大丈夫だと思います。

kobayashi_yusukeWednesday, August 26th, 2020 at 4:15:25 PM GMT+09:00

@takao-y

吉兼先生

お返事ありがとうございます。正常に作動しているように思えるとのご意見をいただき、ありがたく思います。

同様にしてsiteAからsiteEまで処理するにあたり、領域の大きさや形が異なりますが、xnumとynumは20から80までの10ごとでよろしいでしょうか。siteごとに変える必要がございましたらご教授ください。

まずは欠損値の処理の対応を行い、次にsiteごとにガンマ値を変えたグラフを出力したいと考えております。

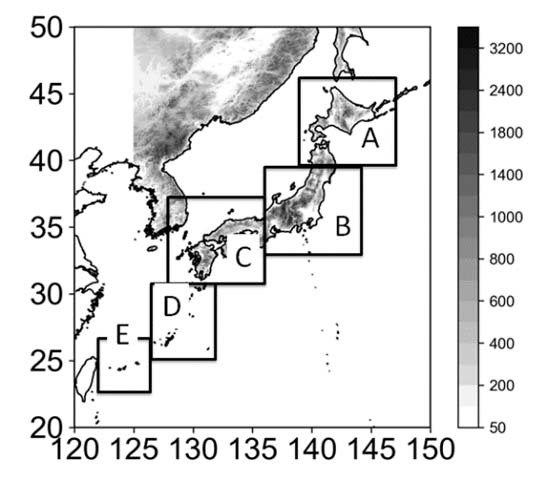

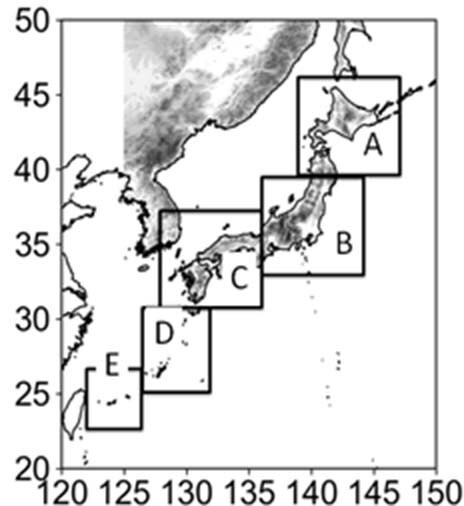

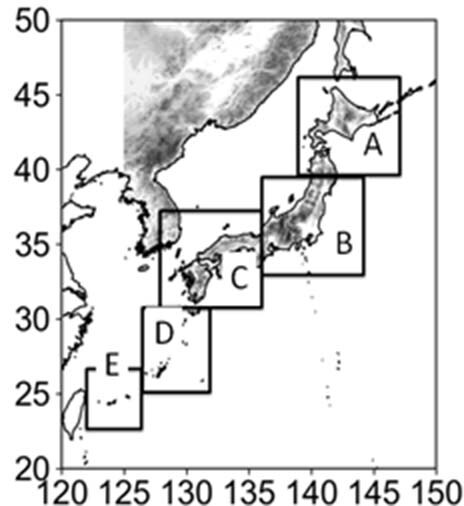

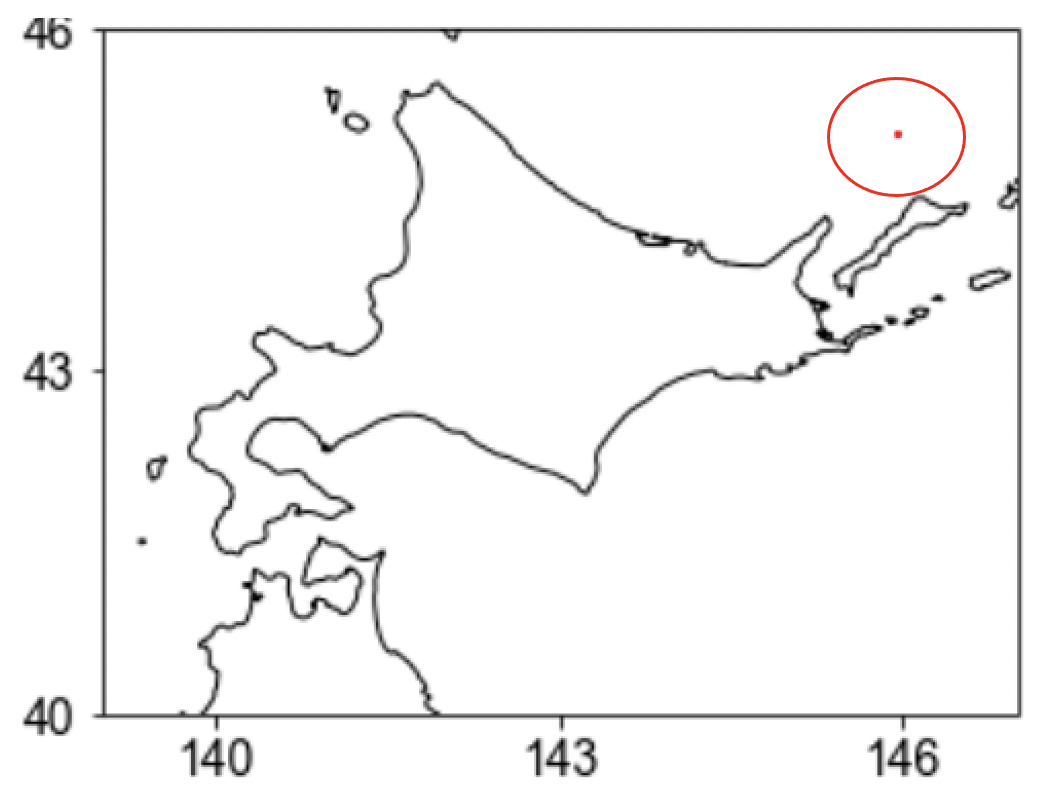

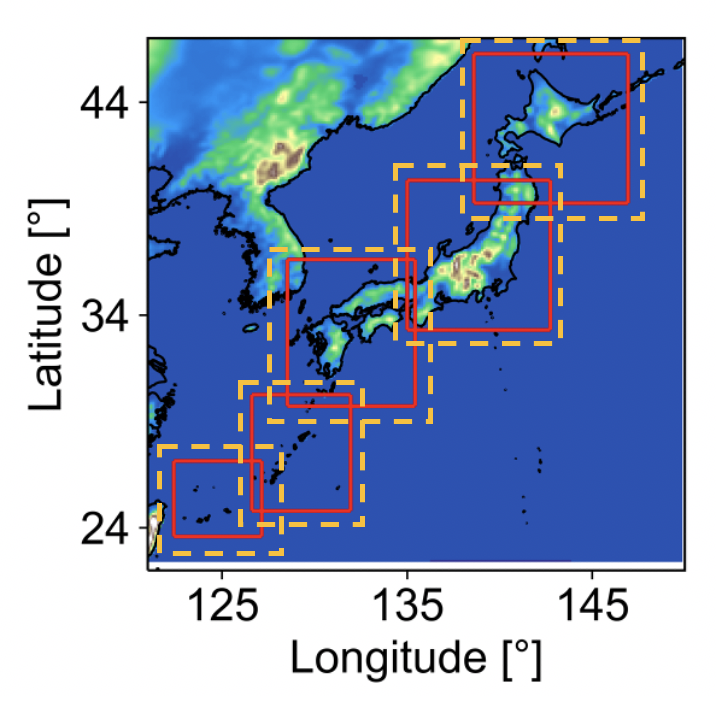

siteAからsiteEの位置は以下のとおりです。

X:東経、Y:北緯

(X,Yともに0.06度ごと。南西を原点に北東へ正)

siteA X:139-147 Y:40-46

siteB X:135-143 Y:33-40

siteC X:129-135 Y:30-36

siteD X:126-131 Y:24-30

siteE X:122-127 Y:23-28

パラメータは以下のとおりです。これでよろしければこのままsiteAからsiteEまで計算します。

------

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months='07’

## Grids

xnums='20 30 40 50 60 70 80'

ynums='20 30 40 50 60 70 80'

nums='441'

rg2='10'

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

------

よろしくお願いいたします。

吉兼先生

お返事ありがとうございます。正常に作動しているように思えるとのご意見をいただき、ありがたく思います。

同様にしてsiteAからsiteEまで処理するにあたり、領域の大きさや形が異なりますが、xnumとynumは20から80までの10ごとでよろしいでしょうか。siteごとに変える必要がございましたらご教授ください。

まずは欠損値の処理の対応を行い、次にsiteごとにガンマ値を変えたグラフを出力したいと考えております。

siteAからsiteEの位置は以下のとおりです。

X:東経、Y:北緯

(X,Yともに0.06度ごと。南西を原点に北東へ正)

siteA X:139-147 Y:40-46

siteB X:135-143 Y:33-40

siteC X:129-135 Y:30-36

siteD X:126-131 Y:24-30

siteE X:122-127 Y:23-28

パラメータは以下のとおりです。これでよろしければこのままsiteAからsiteEまで計算します。

------

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months='07’

## Grids

xnums='20 30 40 50 60 70 80'

ynums='20 30 40 50 60 70 80'

nums='441'

rg2='10'

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

------

よろしくお願いいたします。

kobayashi_yusukeWednesday, August 26th, 2020 at 5:17:06 PM GMT+09:00

@takao-y

吉兼先生

お世話になっております。

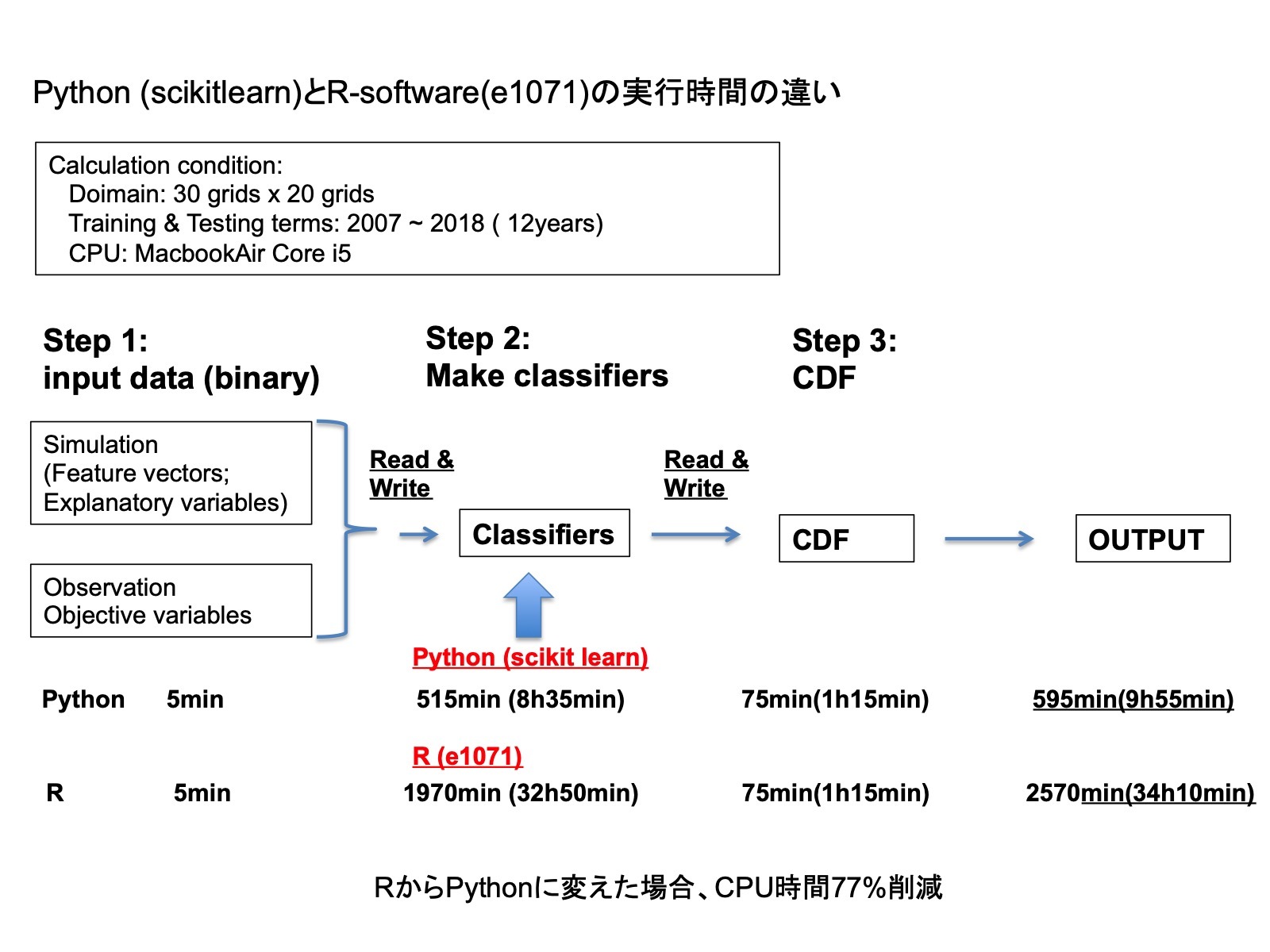

PythonとRによるstepごとの時間計測を行いましたのでお知らせします。

変更したのはstep02のためこの時間がRよりPythonのほうが短くなっておりますが、やはりstep02で時間はかかっております。

2台で並行して処理できますので、まずは欠損値の処理の対応を行い、次にこのままsiteごとにガンマ値等パラメータを変えて結果を出したいと考えております。

よろしくお願いいたします。

---

Python:

step01:5分

step02:8時間23分43秒

step03:46分55秒

step04,終了:1分10秒

全体:9時間16分48秒

---

R:

step01:4分48秒

step02:14時間13分23秒

step03:52分59秒

step04,終了:4秒

全体:15時間11分14秒

※step04,終了の時間でRが極端に短いのはstep04のRのほうのプログラムをLinuxの環境に調整しておらず、プログラムが動かない箇所があるためで、動けばPythonと同様1分程度かかると考えられます。

-----

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: RESTECで全国を5つに分けて作成したMSM,解析雨量データセット

サイト:siteC(西日本・九州)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

吉兼先生

お世話になっております。

PythonとRによるstepごとの時間計測を行いましたのでお知らせします。

変更したのはstep02のためこの時間がRよりPythonのほうが短くなっておりますが、やはりstep02で時間はかかっております。

2台で並行して処理できますので、まずは欠損値の処理の対応を行い、次にこのままsiteごとにガンマ値等パラメータを変えて結果を出したいと考えております。

よろしくお願いいたします。

---

Python:

step01:5分

step02:8時間23分43秒

step03:46分55秒

step04,終了:1分10秒

全体:9時間16分48秒

---

R:

step01:4分48秒

step02:14時間13分23秒

step03:52分59秒

step04,終了:4秒

全体:15時間11分14秒

※step04,終了の時間でRが極端に短いのはstep04のRのほうのプログラムをLinuxの環境に調整しておらず、プログラムが動かない箇所があるためで、動けばPythonと同様1分程度かかると考えられます。

-----

パラメータ:

テスト年:2007~2018年の7月

学習年:2007~2018年の7月(テスト年を除く)

データ: RESTECで全国を5つに分けて作成したMSM,解析雨量データセット

サイト:siteC(西日本・九州)

地点(x,y) 7x7の49点

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

ガンマ: 0.5,0.05,0.005,0.0005,0.00005,0.000005,0.0000005,0.00000005の8通り

コスト:10

エプシロン:0.001

-----

takao-yWednesday, August 26th, 2020 at 7:17:00 PM GMT+09:00

@kobayashi_yusuke 小林様。ご報告ありがとうございます。「siteAからsiteEまで処理するにあたり、領域の大きさや形が異なりますが、xnumとynumは20から80までの10ごと」は領域の大きさに合わせて適宜調整してもらえますでしょうか。計算量が多くなるようでしたら、15グリッドごとのようにグリッド数を減らしても大丈夫です。よろしくお願いいたします。

kobayashi_yusukeWednesday, August 26th, 2020 at 8:06:06 PM GMT+09:00

@takao-y

吉兼先生

お返事ありがとうございます。吉兼先生のご意見を踏まえ、領域の大きさにあわせ以下のように設定しました。134グリッドある場合につきましては15グリッドごとにし、領域が100より小さい場合にはそれに合わせて減らしました。

siteAのメッシュ数 (x,y)= (100,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95 110'

siteBのメッシュ数 (x,y)= (117,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95 110'

siteCのメッシュ数 (x,y)= (100,100)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

siteDのメッシュ数 (x,y)= (100,84)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70'

siteEのメッシュ数 (x,y)= (84,84)

パラメータ

x='20 30 40 50 60 70'

y='20 30 40 50 60 70'

こちらで行いたいと考えております。

以上、よろしくお願いいたします。

吉兼先生

お返事ありがとうございます。吉兼先生のご意見を踏まえ、領域の大きさにあわせ以下のように設定しました。134グリッドある場合につきましては15グリッドごとにし、領域が100より小さい場合にはそれに合わせて減らしました。

siteAのメッシュ数 (x,y)= (100,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95 110'

siteBのメッシュ数 (x,y)= (117,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95 110'

siteCのメッシュ数 (x,y)= (100,100)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

siteDのメッシュ数 (x,y)= (100,84)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70'

siteEのメッシュ数 (x,y)= (84,84)

パラメータ

x='20 30 40 50 60 70'

y='20 30 40 50 60 70'

こちらで行いたいと考えております。

以上、よろしくお願いいたします。

kobayashi_yusukeFriday, August 28th, 2020 at 4:45:04 PM GMT+09:00

@takao-y

吉兼先生

現状のご報告をいたします。

上記のパラメータでそれぞれのsiteで動かしたところ不具合が発生し、その対応を行っております。不具合が解消し、ガンマの結果が出た時点で、結果が出たところから吉兼先生にその結果のグラフをご報告いたします。そしてその時点で、ガンマのパラメータの決定と次のパラメータにつきましてご相談させてください。

よろしくお願いいたします。

吉兼先生

現状のご報告をいたします。

上記のパラメータでそれぞれのsiteで動かしたところ不具合が発生し、その対応を行っております。不具合が解消し、ガンマの結果が出た時点で、結果が出たところから吉兼先生にその結果のグラフをご報告いたします。そしてその時点で、ガンマのパラメータの決定と次のパラメータにつきましてご相談させてください。

よろしくお願いいたします。

takao-yTuesday, September 1st, 2020 at 9:30:26 AM GMT+09:00

@kobayashi_yusuke

小林様

もしよろしければ、不具合の内容を共有していただけますでしょうか。

小林様

もしよろしければ、不具合の内容を共有していただけますでしょうか。

kobayashi_yusukeTuesday, September 1st, 2020 at 1:56:42 PM GMT+09:00

@takao-y

吉兼先生

ご連絡ありがとうございます。

弊財団で作成したMSM,解析雨量のデータセットから指定された位置での学習、そしてパラメータごとの精度を出すことを行っております。

その作業におきまして、現在の不具合は、MSM,解析雨量のデータセットから読み込む場所および指定された位置の値の抽出のところで発生しております。現在、Fortranでセグメンテーションフォルトが起きる場合がありその対応を行っております。

このFortranの不具合は弊財団でFortranに詳しいものが修正を行っております。

引き続きよろしくお願いいたします。

吉兼先生

ご連絡ありがとうございます。

弊財団で作成したMSM,解析雨量のデータセットから指定された位置での学習、そしてパラメータごとの精度を出すことを行っております。

その作業におきまして、現在の不具合は、MSM,解析雨量のデータセットから読み込む場所および指定された位置の値の抽出のところで発生しております。現在、Fortranでセグメンテーションフォルトが起きる場合がありその対応を行っております。

このFortranの不具合は弊財団でFortranに詳しいものが修正を行っております。

引き続きよろしくお願いいたします。

takao-yWednesday, September 2nd, 2020 at 8:56:27 AM GMT+09:00

@kobayashi_yusuke

小林様

ありがとうございます。セグメンテーションエラーの多くは、定義した変数の次元が一致していなかったり、ファイル指定が適切でなかったりします。もしよろしければ、フォートランのエラーメッセージを添付してもらえますでしょうか。

小林様

ありがとうございます。セグメンテーションエラーの多くは、定義した変数の次元が一致していなかったり、ファイル指定が適切でなかったりします。もしよろしければ、フォートランのエラーメッセージを添付してもらえますでしょうか。

kobayashi_yusukeWednesday, September 2nd, 2020 at 10:23:51 AM GMT+09:00

@takao-y

吉兼先生

お返事ありがとうございます。フォートランのエラーメッセージを添付します。またエラー発生箇所であるstep01-make_training_data.shも添付します。

直接ご覧になりたい場合には、

/goemon_disk2/trmmauto/AI_GSMaP/tool/ml-region3/ml-region3-check-CUI-siteA/

においておりますのでご覧ください。

siteAはセグメンテーションフォルトの原因となっている配列はmrain2(m,kk)で、kkの値が248の場合に発生します。

しかし必ず発生するわけではなくiyという変数の値が95または110の場合にkkが248になると発生します。

kkの範囲は(1~248),iyは(20,35,50,65,80,95,110)サンプルのynumの座標です。ynumはsiteAの大きさに応じて変更しております。

kk,iyの値はいずれも必ず処理する値で、なぜこの組み合わせになった場合だけセグメンテーションフォルトになるのかは分かっておりません。

auto-check.shのynumは以下のように修正しております。

xnums='020 030 040 050 060 070 080'

ynums='020 035 050 065 080 095 110'

原因がわかりましたらご教授いただけると大変ありがたく思います。

以上、よろしくお願いいたします。

吉兼先生

お返事ありがとうございます。フォートランのエラーメッセージを添付します。またエラー発生箇所であるstep01-make_training_data.shも添付します。

直接ご覧になりたい場合には、

/goemon_disk2/trmmauto/AI_GSMaP/tool/ml-region3/ml-region3-check-CUI-siteA/

においておりますのでご覧ください。

siteAはセグメンテーションフォルトの原因となっている配列はmrain2(m,kk)で、kkの値が248の場合に発生します。

しかし必ず発生するわけではなくiyという変数の値が95または110の場合にkkが248になると発生します。

kkの範囲は(1~248),iyは(20,35,50,65,80,95,110)サンプルのynumの座標です。ynumはsiteAの大きさに応じて変更しております。

kk,iyの値はいずれも必ず処理する値で、なぜこの組み合わせになった場合だけセグメンテーションフォルトになるのかは分かっておりません。

auto-check.shのynumは以下のように修正しております。

xnums='020 030 040 050 060 070 080'

ynums='020 035 050 065 080 095 110'

原因がわかりましたらご教授いただけると大変ありがたく思います。

以上、よろしくお願いいたします。

takao-yWednesday, September 2nd, 2020 at 11:22:20 AM GMT+09:00

@kobayashi_yusuke

小林様。ynums=110の時にセグメンエラーになっているので、恐らくこれは選択した領域の外側になっていると思われます。確認をお願いいたします。

小林様。ynums=110の時にセグメンエラーになっているので、恐らくこれは選択した領域の外側になっていると思われます。確認をお願いいたします。

kobayashi_yusukeWednesday, September 2nd, 2020 at 11:27:09 AM GMT+09:00

@takao-y

吉兼先生

ありがとうございます。確認いたします。

吉兼先生

ありがとうございます。確認いたします。

takao-yThursday, September 3rd, 2020 at 10:17:18 AM GMT+09:00

@kobayashi_yusuke

小林様。確認の結果はいかがでしょうか。例えば、ynums の110を削除する、もしくは96などに変更して試してみると手っ取り早いかと思います。それから、フォートランのwarningが多くて見にくいので、warningをoffにした方が良いかもしれません。

小林様。確認の結果はいかがでしょうか。例えば、ynums の110を削除する、もしくは96などに変更して試してみると手っ取り早いかと思います。それから、フォートランのwarningが多くて見にくいので、warningをoffにした方が良いかもしれません。

kobayashi_yusukeThursday, September 3rd, 2020 at 10:38:20 AM GMT+09:00

@takao-y

吉兼先生

ご連絡ありがとうございます。今回の修正はFortranとshellに詳しいものが担当しているのですが、全国を5領域に分けたMSM,解析雨量を読み込むための修正(大きさが異なる、ハイパーパラメター解析対象地点の変更等)により、このセグメンテーションフォルトだけでなく、全体的に修正が必要になってくると考えております。今、その確認をお願いしておりますので、その進捗を随時ご報告いたします。

よろしくお願いいたします。

吉兼先生

ご連絡ありがとうございます。今回の修正はFortranとshellに詳しいものが担当しているのですが、全国を5領域に分けたMSM,解析雨量を読み込むための修正(大きさが異なる、ハイパーパラメター解析対象地点の変更等)により、このセグメンテーションフォルトだけでなく、全体的に修正が必要になってくると考えております。今、その確認をお願いしておりますので、その進捗を随時ご報告いたします。

よろしくお願いいたします。

takao-yThursday, September 3rd, 2020 at 10:57:52 AM GMT+09:00

@kobayashi_yusuke

小林様。現時点の作業はハイパーパラメータを決めるための過程ですので、あまり難しく考えずにそれぞれの領域で臨機応変に対応していただければ問題ないかと思います。基本的にはxnums,ynumsを調整すれば済むと思います。あるいは何か別の問題があるのでしょうか。詳細に教えていただけますでしょうか。

小林様。現時点の作業はハイパーパラメータを決めるための過程ですので、あまり難しく考えずにそれぞれの領域で臨機応変に対応していただければ問題ないかと思います。基本的にはxnums,ynumsを調整すれば済むと思います。あるいは何か別の問題があるのでしょうか。詳細に教えていただけますでしょうか。

kobayashi_yusukeThursday, September 3rd, 2020 at 11:18:29 AM GMT+09:00

@takao-y

吉兼先生

お返事ありがとうございます。臨機応変の対応承知しました。現在問題は、吉兼先生からいただいたサンプルのMSM、レーダのデータを弊財団で作成した全国5領域に区切ったMSM、解析雨量に切り替えて結果を出すというところです。もちろん、セグメンテーションフォールトのようにxnum,ynumで不具合を起こしているというのもございます。

y=110で選択した領域の外側とのことでしたので、一旦これを外した以下のパラメータで動かしてみたいと思います。

アドアイスありがとうございます。

siteAのメッシュ数 (x,y)= (100,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95'

siteBのメッシュ数 (x,y)= (117,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95'

siteCのメッシュ数 (x,y)= (100,100)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

siteDのメッシュ数 (x,y)= (100,84)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70'

siteEのメッシュ数 (x,y)= (84,84)

パラメータ

x='20 30 40 50 60 70'

y='20 30 40 50 60 70'

吉兼先生

お返事ありがとうございます。臨機応変の対応承知しました。現在問題は、吉兼先生からいただいたサンプルのMSM、レーダのデータを弊財団で作成した全国5領域に区切ったMSM、解析雨量に切り替えて結果を出すというところです。もちろん、セグメンテーションフォールトのようにxnum,ynumで不具合を起こしているというのもございます。

y=110で選択した領域の外側とのことでしたので、一旦これを外した以下のパラメータで動かしてみたいと思います。

アドアイスありがとうございます。

siteAのメッシュ数 (x,y)= (100,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95'

siteBのメッシュ数 (x,y)= (117,134)

パラメータ

x='20 30 40 50 60 70 80'

y='20 35 50 65 80 95'

siteCのメッシュ数 (x,y)= (100,100)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70 80'

siteDのメッシュ数 (x,y)= (100,84)

パラメータ

x='20 30 40 50 60 70 80'

y='20 30 40 50 60 70'

siteEのメッシュ数 (x,y)= (84,84)

パラメータ

x='20 30 40 50 60 70'

y='20 30 40 50 60 70'

takao-yThursday, September 3rd, 2020 at 4:23:20 PM GMT+09:00

@kobayashi_yusuke

小林様。ありがとうございます。承知いたしました。5つの領域について、同時平行RUNができれば短時間で終わると思いますが、そちらの環境では可能でしょうか。同じファイルシステム内で、4RUN程度であれば問題なく作動すると思います。よろしくお願いいたします。

小林様。ありがとうございます。承知いたしました。5つの領域について、同時平行RUNができれば短時間で終わると思いますが、そちらの環境では可能でしょうか。同じファイルシステム内で、4RUN程度であれば問題なく作動すると思います。よろしくお願いいたします。

kobayashi_yusukeThursday, September 3rd, 2020 at 5:07:47 PM GMT+09:00

@takao-y

吉兼先生

ご連絡ありがとうございます。弊財団で作成した5つの領域のMSMと解析雨量を用いたプログラムが正常に動くようにしましたら上記パラメータで結果を出します。

そしてその際の解析についてですが、2台のマシンを同時に動かせますのでまずそこで分散させます。そしてそれぞれで複数プロセスで動かすことで同時に処理をしたいと考えております。よろしくお願いいたします。

吉兼先生

ご連絡ありがとうございます。弊財団で作成した5つの領域のMSMと解析雨量を用いたプログラムが正常に動くようにしましたら上記パラメータで結果を出します。

そしてその際の解析についてですが、2台のマシンを同時に動かせますのでまずそこで分散させます。そしてそれぞれで複数プロセスで動かすことで同時に処理をしたいと考えております。よろしくお願いいたします。

takao-yFriday, September 4th, 2020 at 1:41:44 PM GMT+09:00

@kobayashi_yusuke

小林様。もし不都合がなければ、終了したものから図を添付していただけますでしょうか。

よろしくお願いいたします。

小林様。もし不都合がなければ、終了したものから図を添付していただけますでしょうか。

よろしくお願いいたします。

kobayashi_yusukeFriday, September 4th, 2020 at 6:13:10 PM GMT+09:00

@takao-y

吉兼先生

ご連絡ありがとうございます。不具合の解消を弊財団でFortranに詳しいものが行っておりました。

プログラムを確認したところ、吉兼先生から頂いたプログラムにおきましてx,yの定義が逆であった箇所があったとのことです。

step01-make_training_data.sh / step01-make_testing_data.sh

のfortranプログラムの最初のところで定義している

parameter (idem2=${ydim},jdim2=${xdim},nn2=249,nn2b=248)

parameter (idem3=${ydim},jdim3=${xdim})

のxdimとydimを逆にして

parameter (idem2=${xdim},jdim2=${ydim},nn2=249,nn2b=248)

parameter (idem3=${xdim},jdim3=${ydim})

としたところ、セグメンテーションフォールトは発生しなくなりました。

これでsiteAを計算をさせており、他に不具合が出ずに結果が出ましたらご連絡いたします。

以上、よろしくお願いいたします。

吉兼先生

ご連絡ありがとうございます。不具合の解消を弊財団でFortranに詳しいものが行っておりました。

プログラムを確認したところ、吉兼先生から頂いたプログラムにおきましてx,yの定義が逆であった箇所があったとのことです。

step01-make_training_data.sh / step01-make_testing_data.sh

のfortranプログラムの最初のところで定義している

parameter (idem2=${ydim},jdim2=${xdim},nn2=249,nn2b=248)

parameter (idem3=${ydim},jdim3=${xdim})

のxdimとydimを逆にして

parameter (idem2=${xdim},jdim2=${ydim},nn2=249,nn2b=248)

parameter (idem3=${xdim},jdim3=${ydim})

としたところ、セグメンテーションフォールトは発生しなくなりました。

これでsiteAを計算をさせており、他に不具合が出ずに結果が出ましたらご連絡いたします。

以上、よろしくお願いいたします。

kobayashi_yusukeFriday, September 4th, 2020 at 6:26:53 PM GMT+09:00

siteD,siteEにつきましては別途計算させておりましたが、Fortranのセグメンテーションフォールトは発生しませんでしたが、

RuntimeWarning: invalid value encountered in true_divide

とどこかで0で割っているためエラーが発生しております。

こちらも別途原因を探り、不具合を修正したいと考えております。

RuntimeWarning: invalid value encountered in true_divide

とどこかで0で割っているためエラーが発生しております。

こちらも別途原因を探り、不具合を修正したいと考えております。

kobayashi_yusukeMonday, September 7th, 2020 at 11:12:07 AM GMT+09:00

@takao-y

吉兼先生

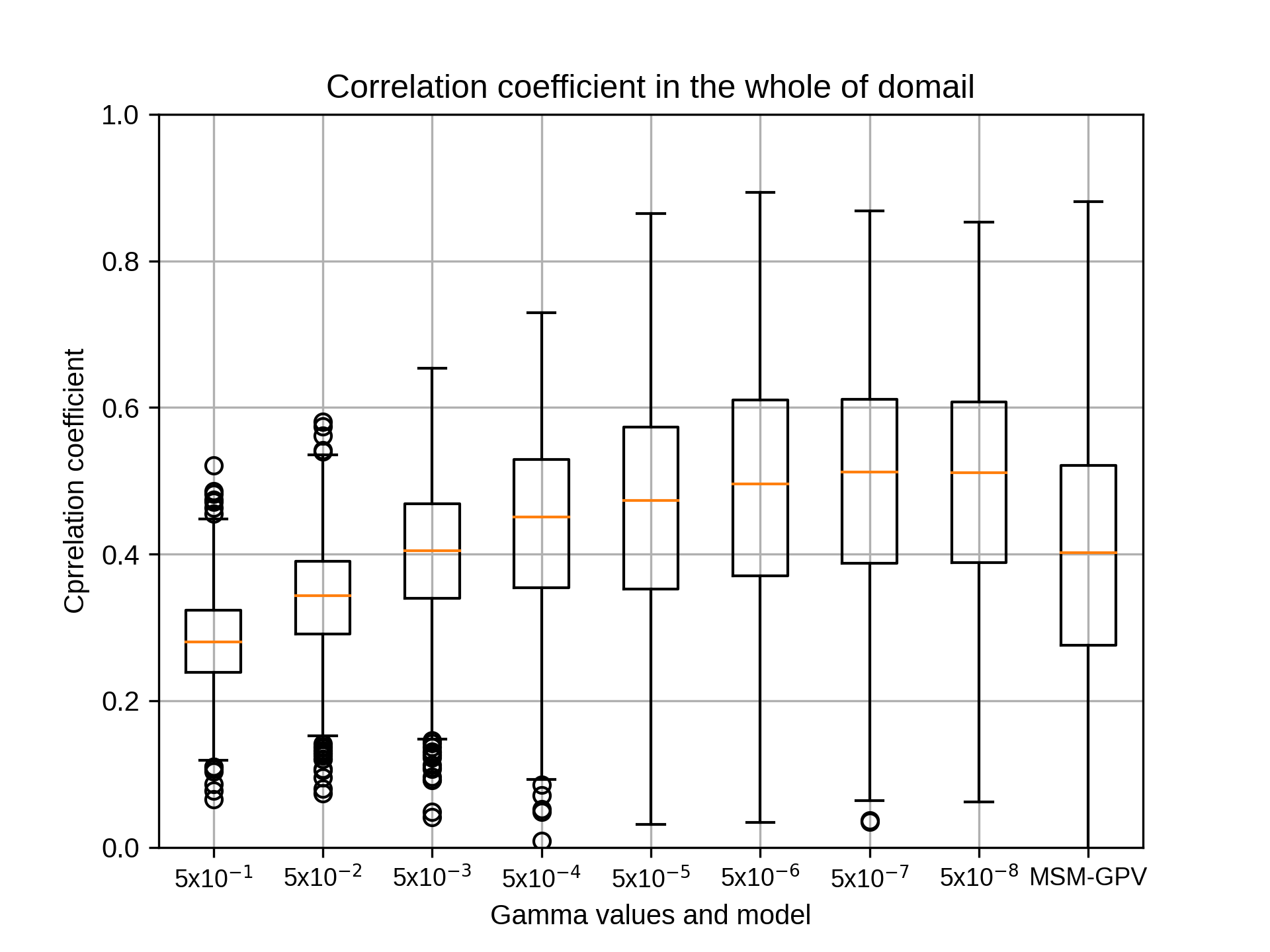

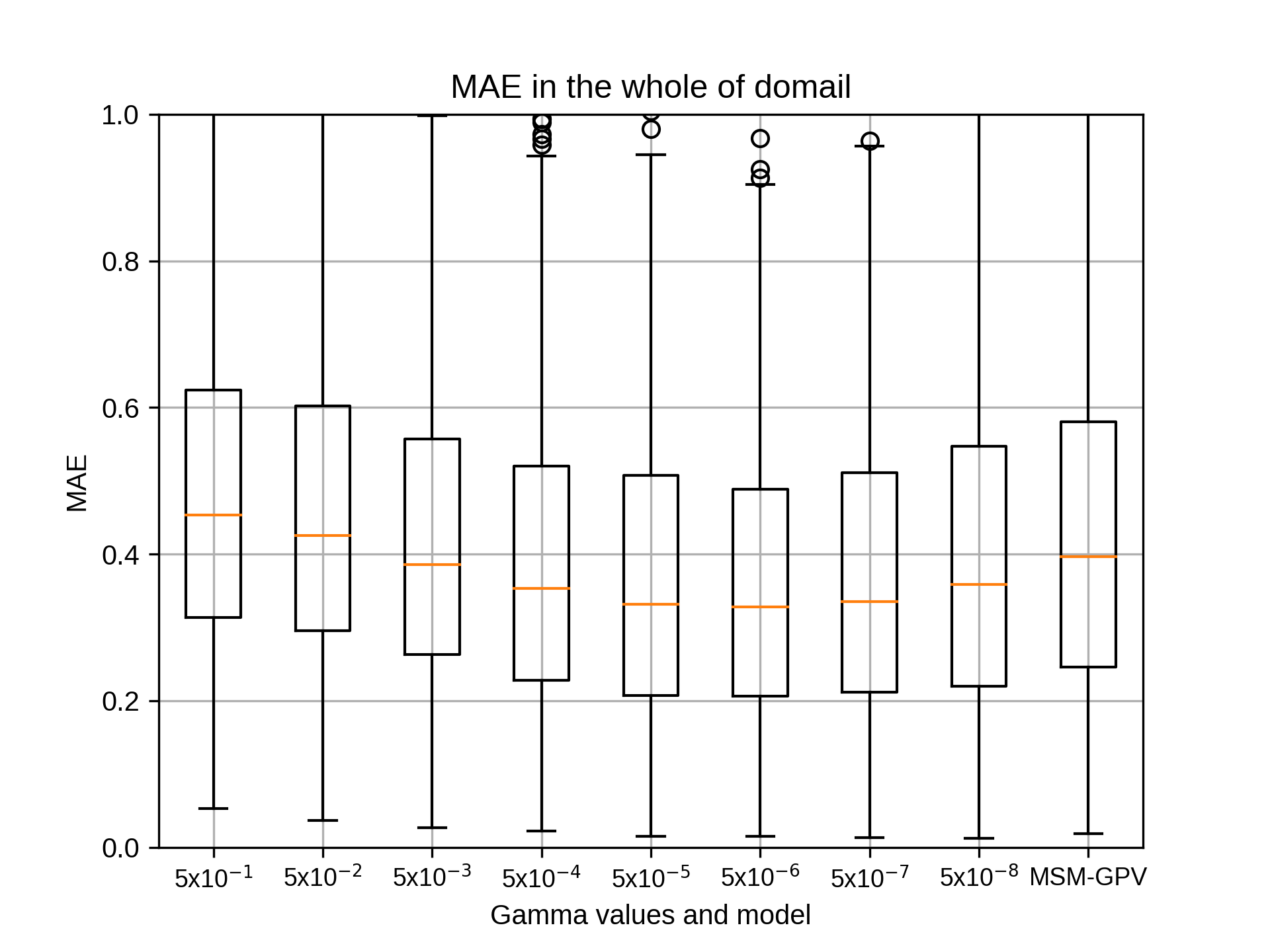

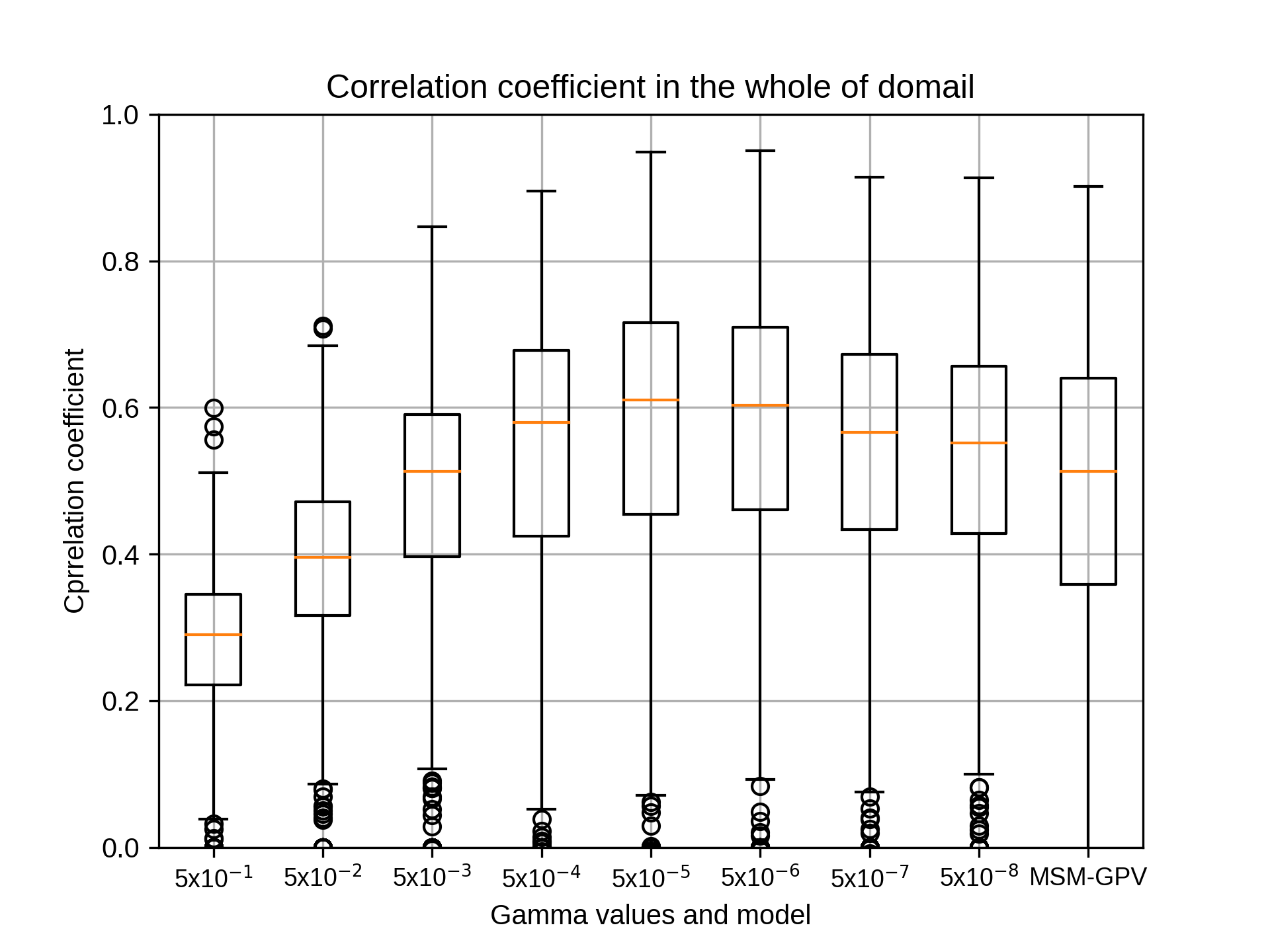

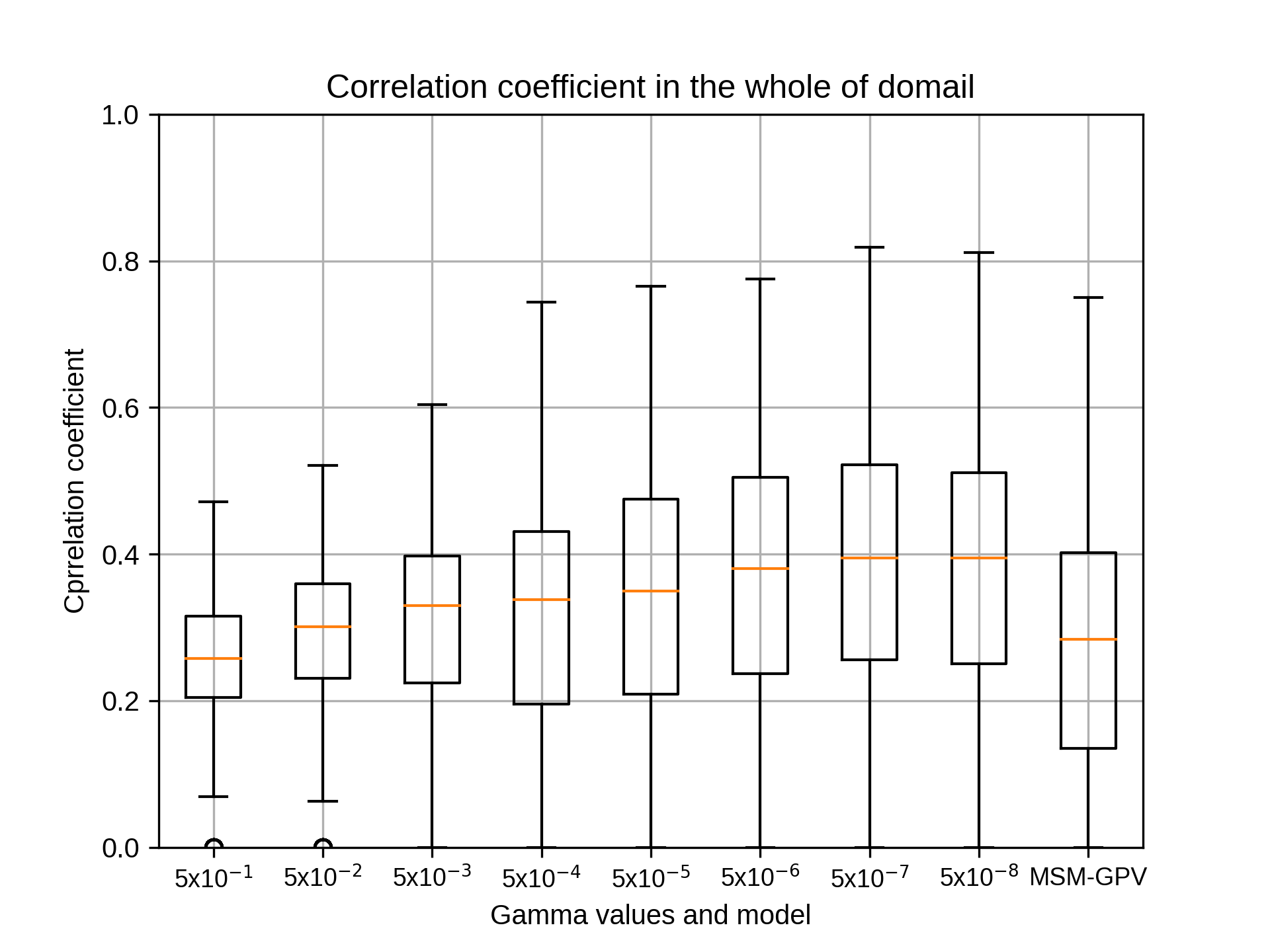

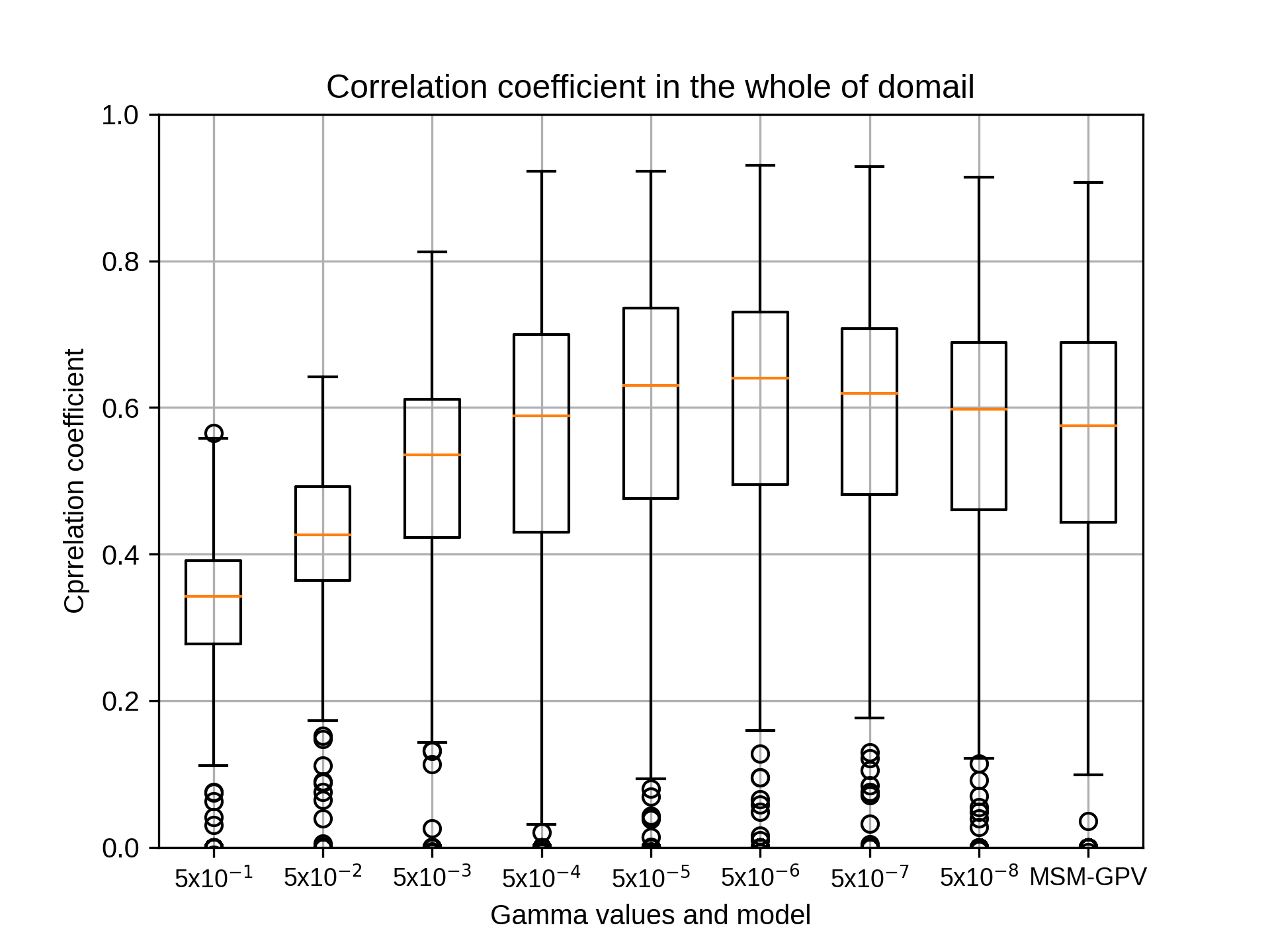

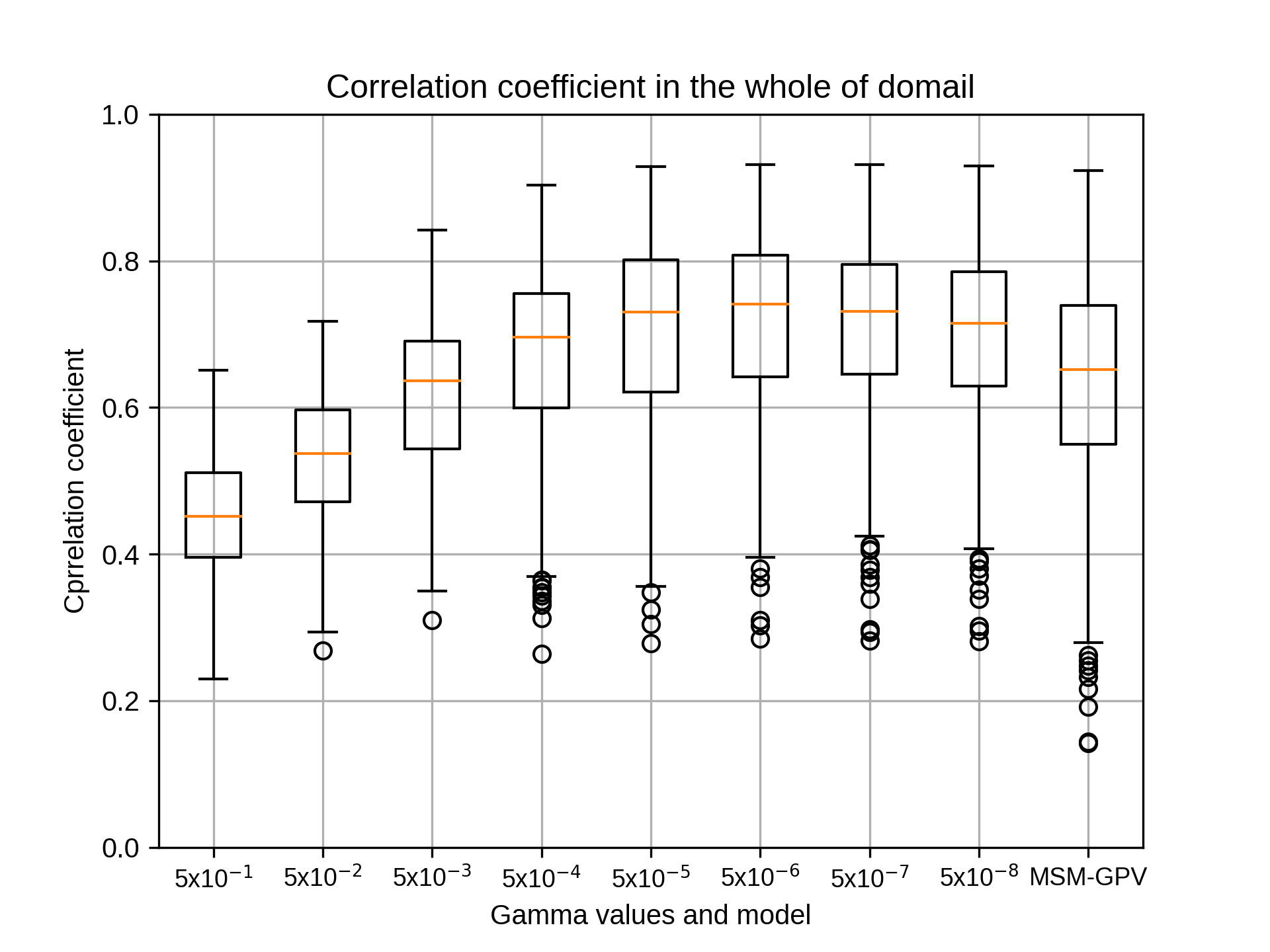

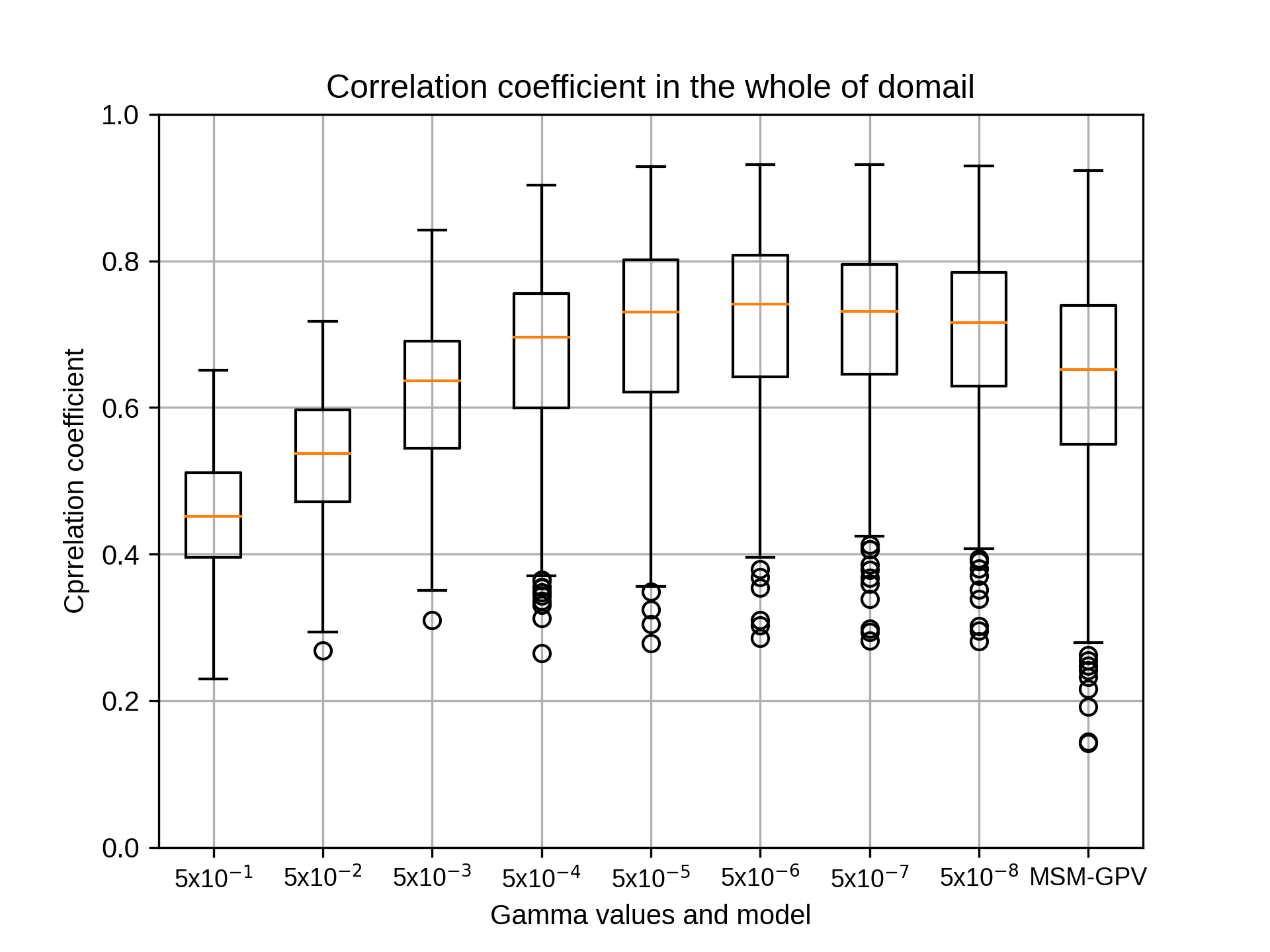

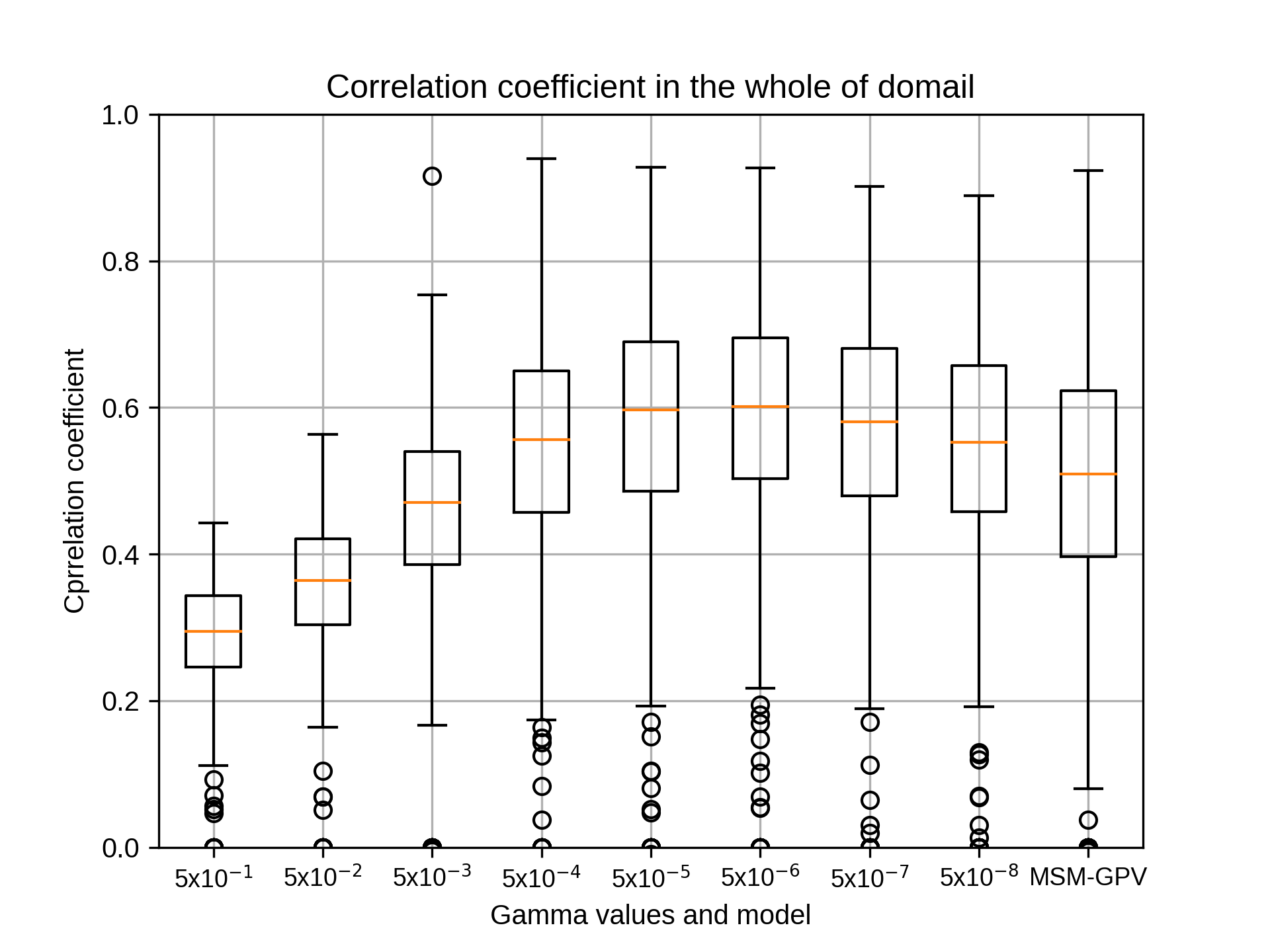

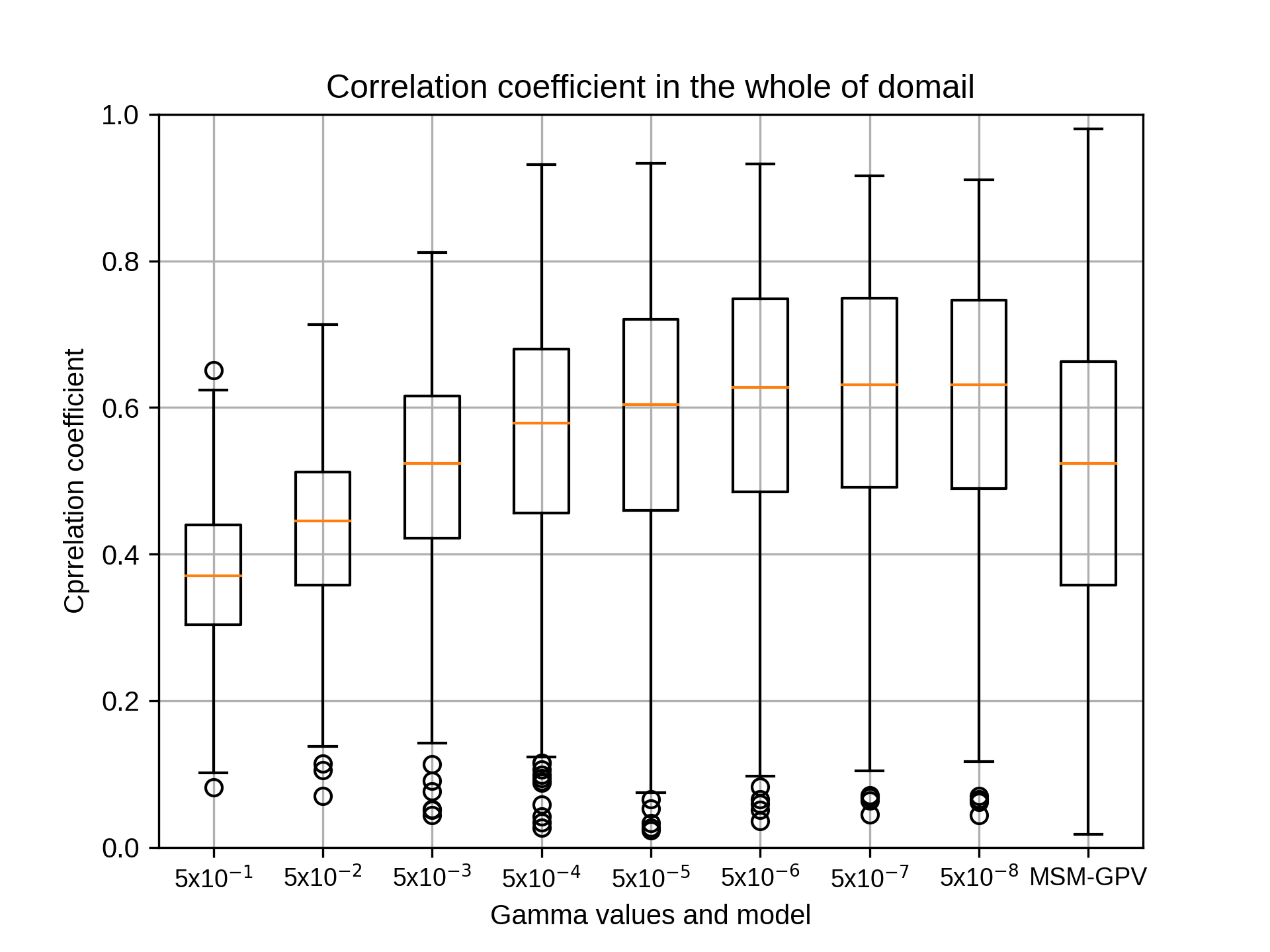

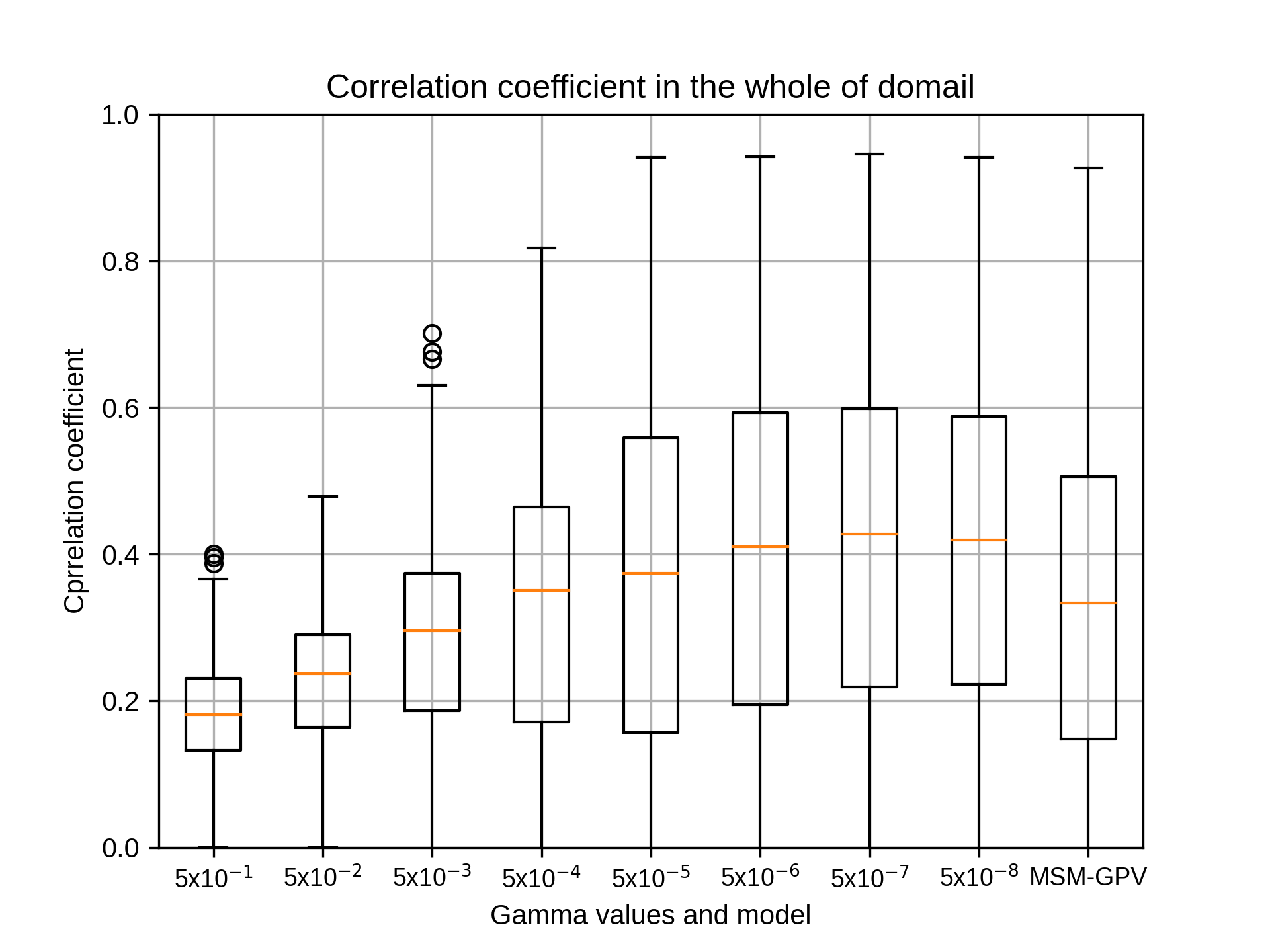

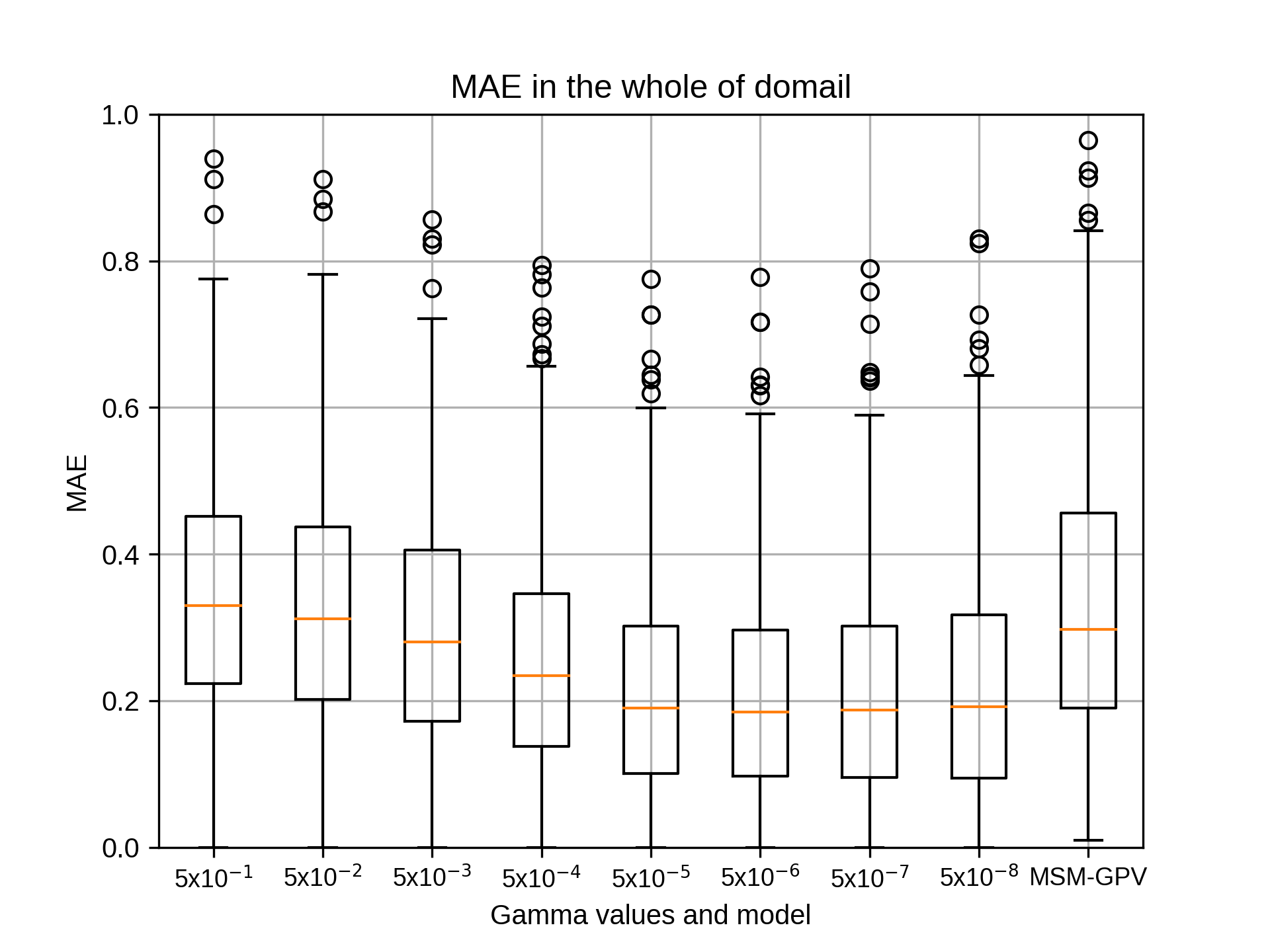

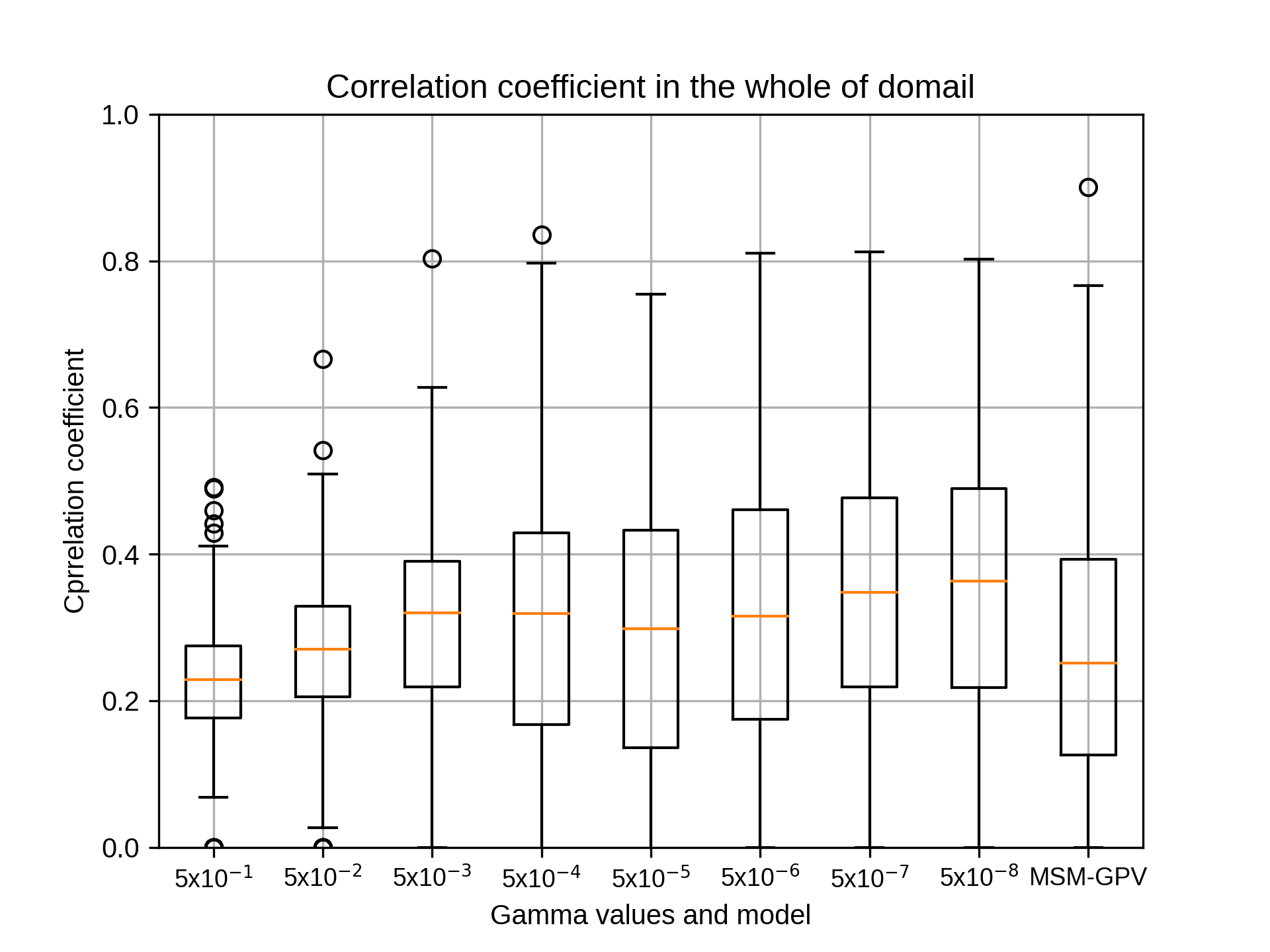

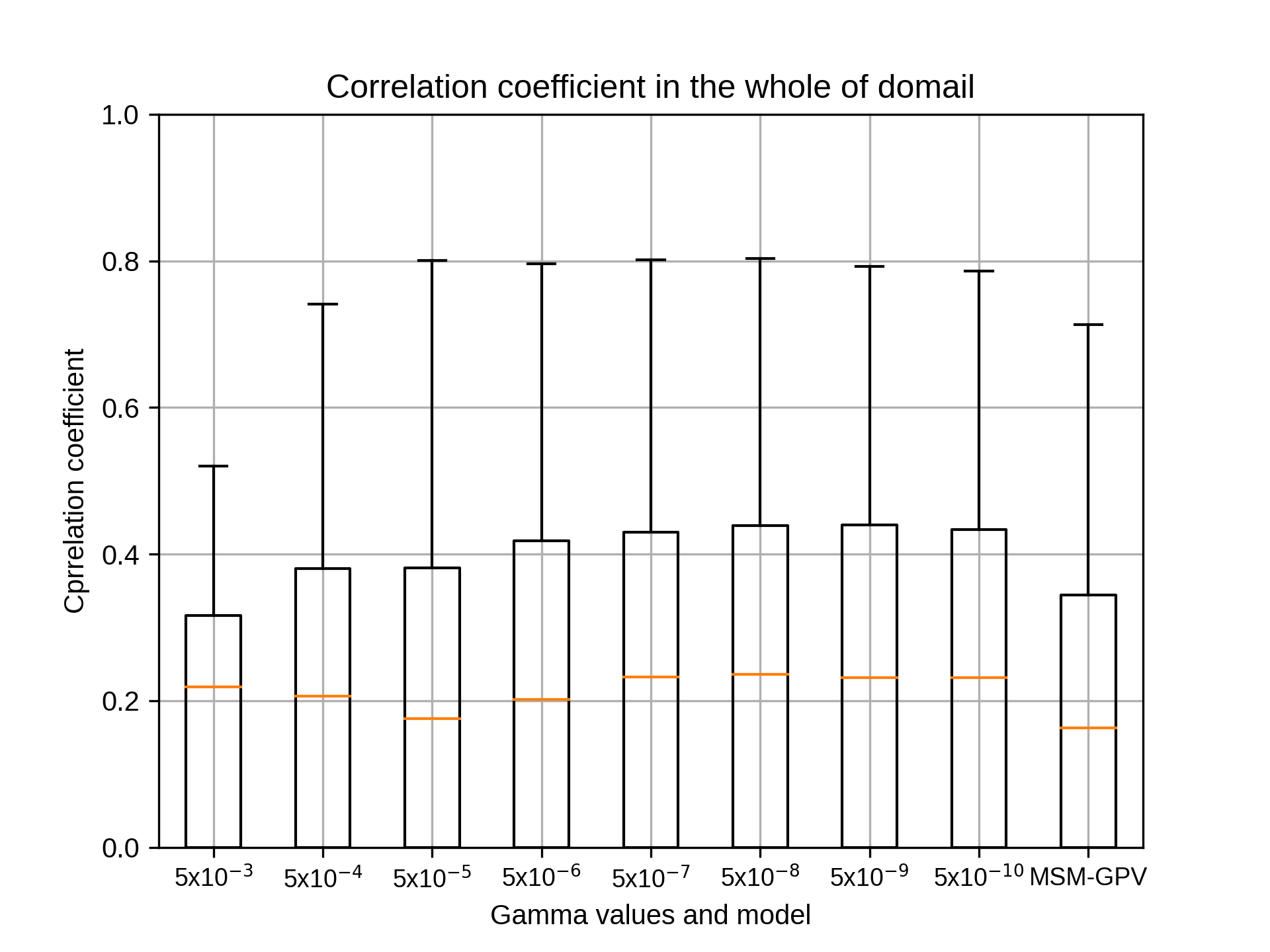

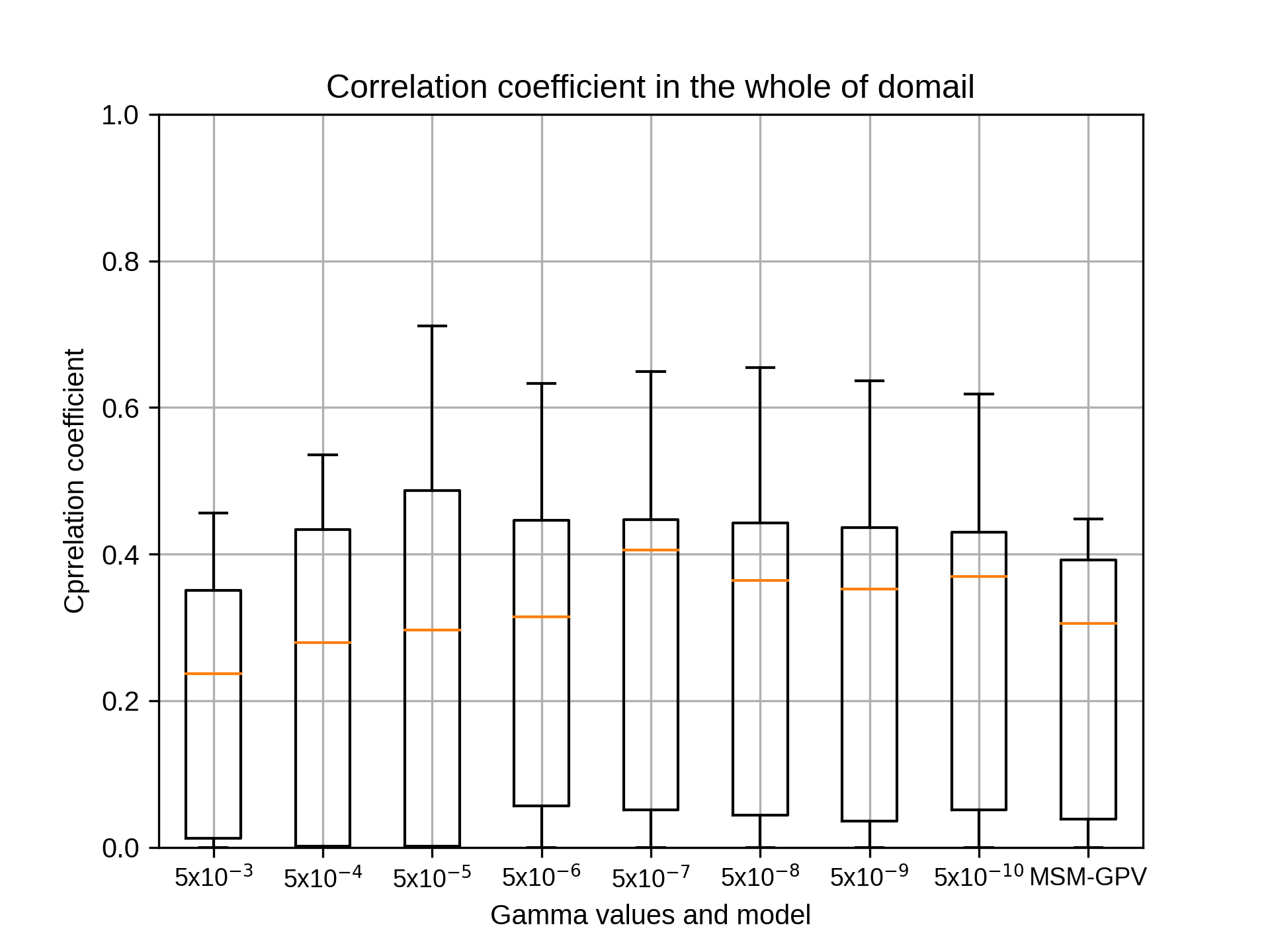

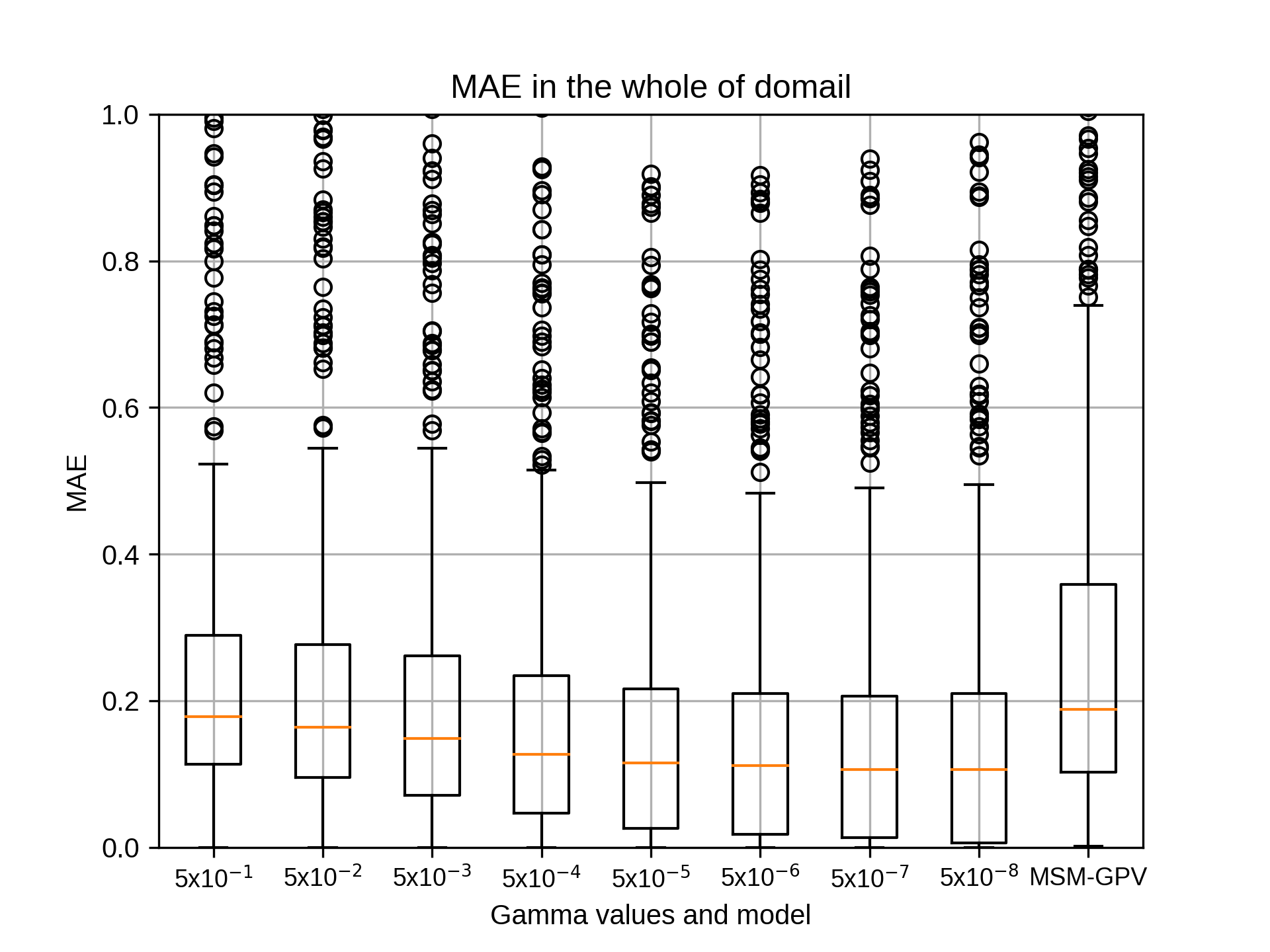

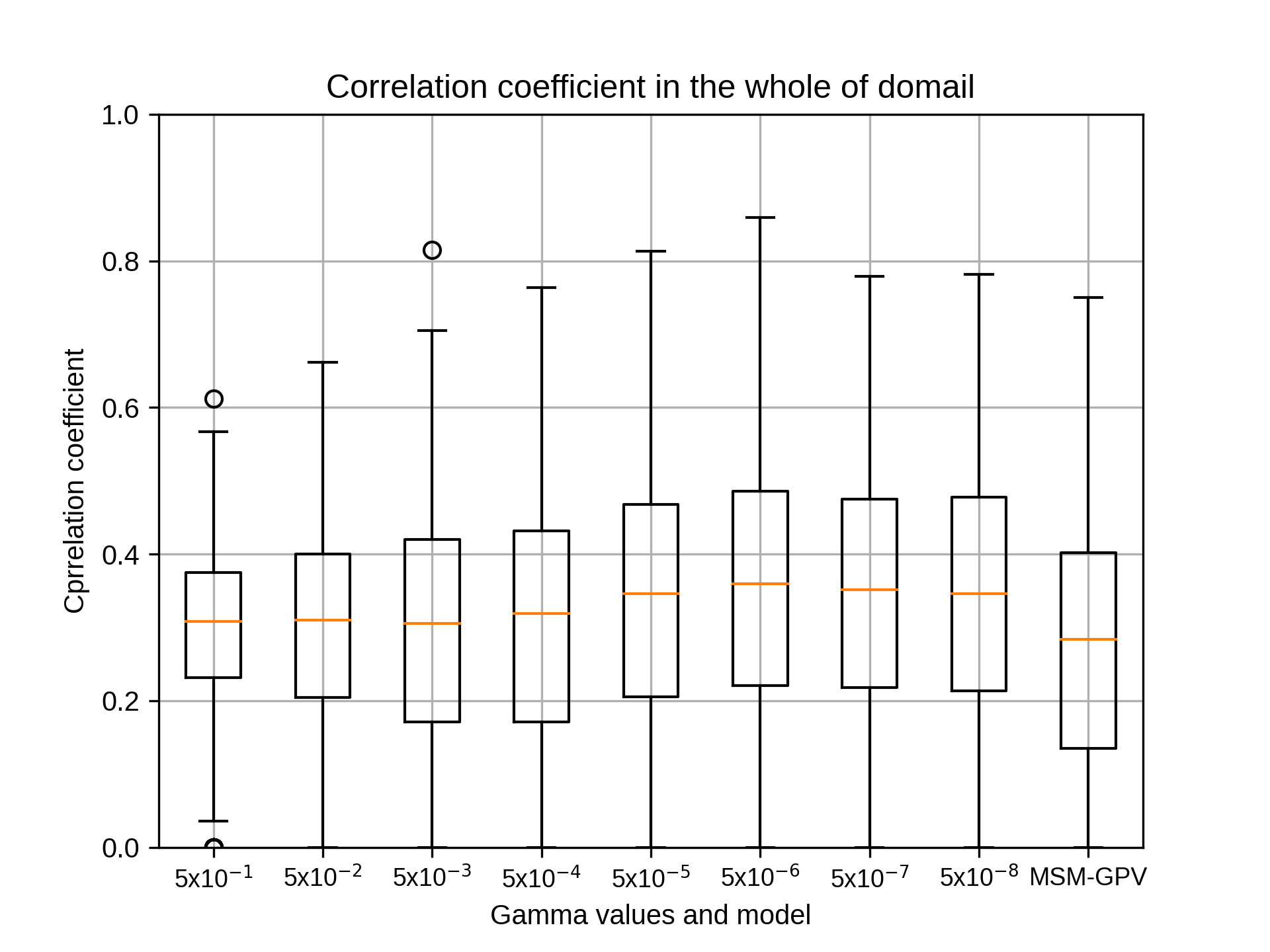

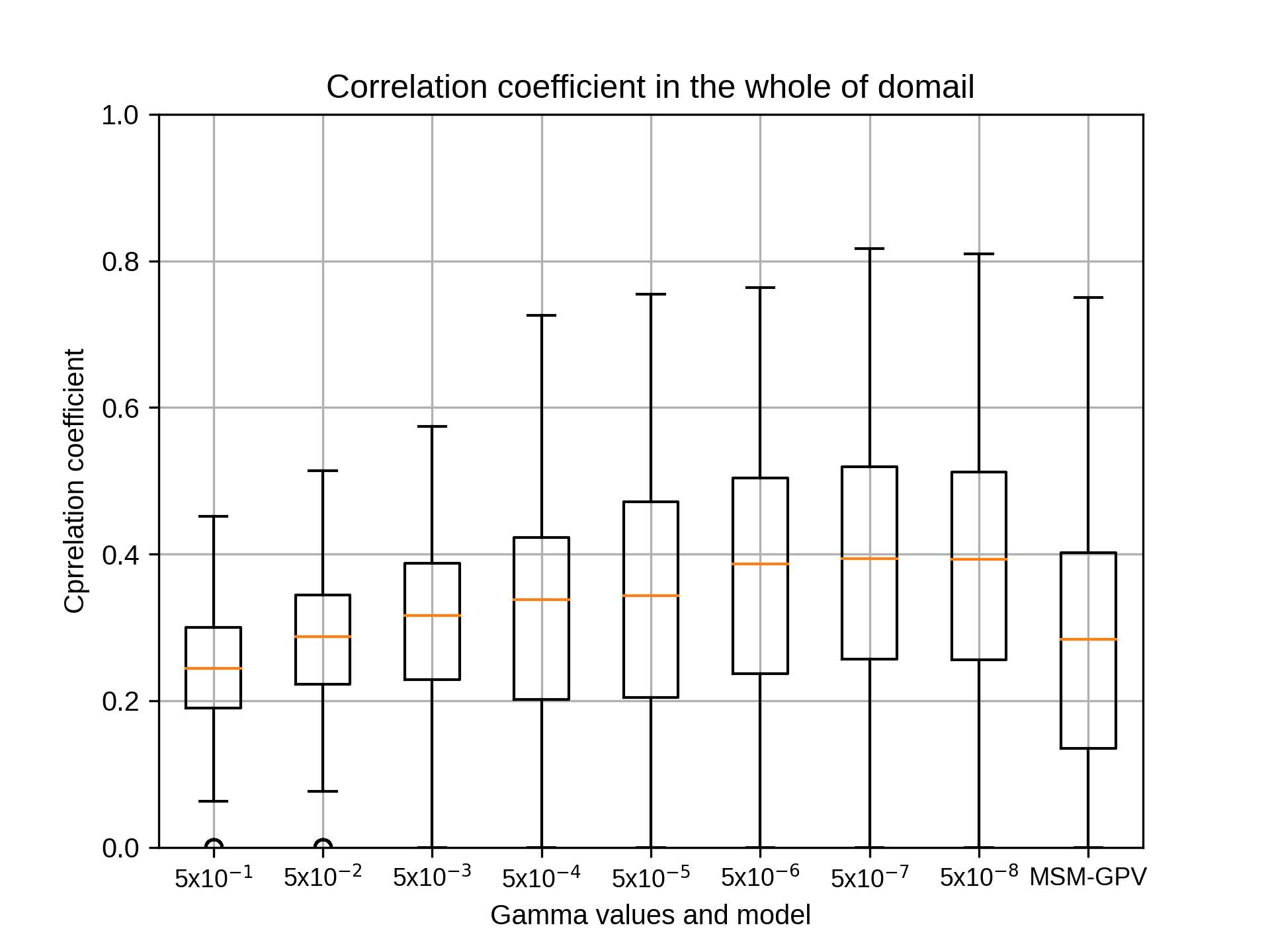

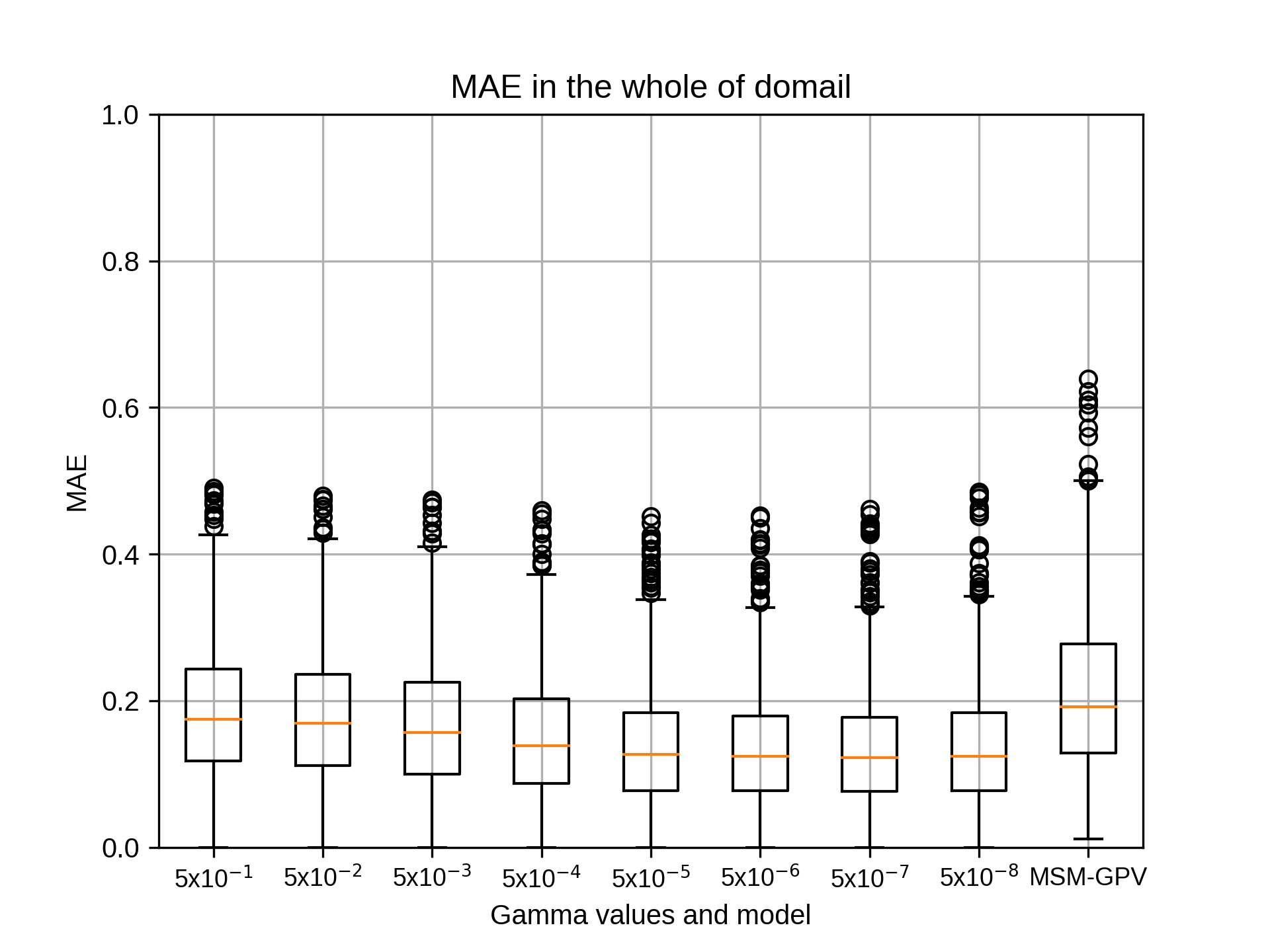

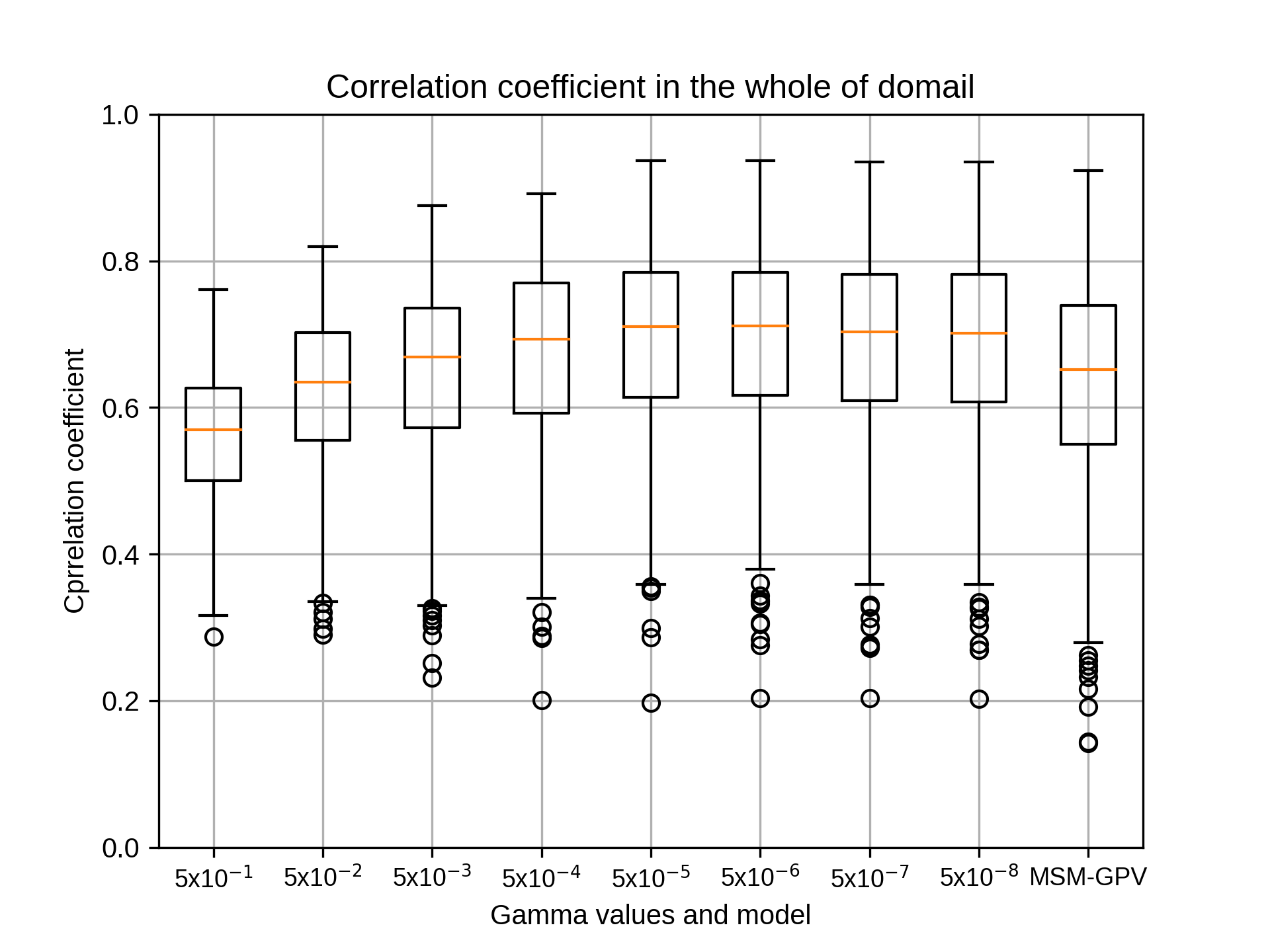

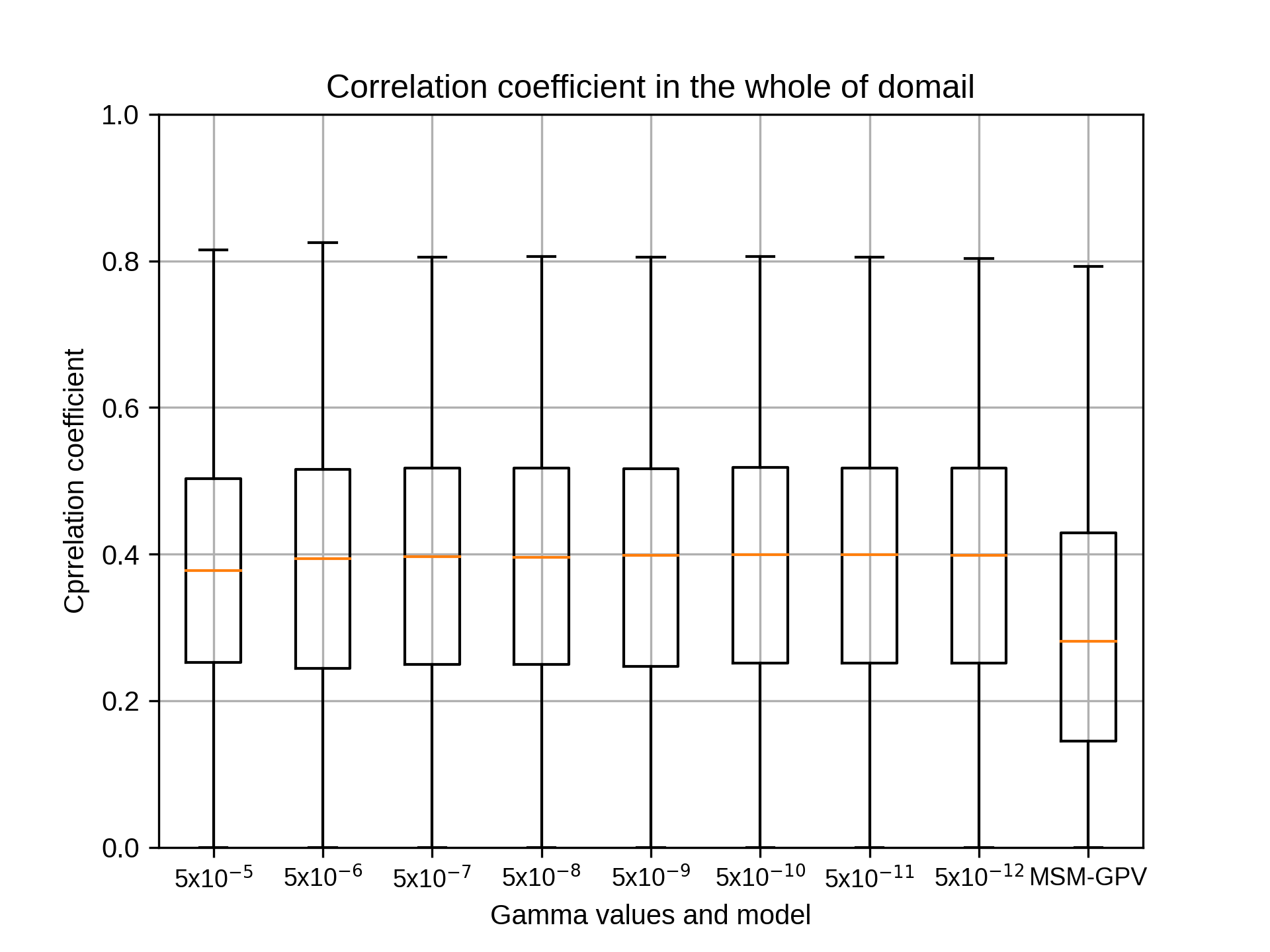

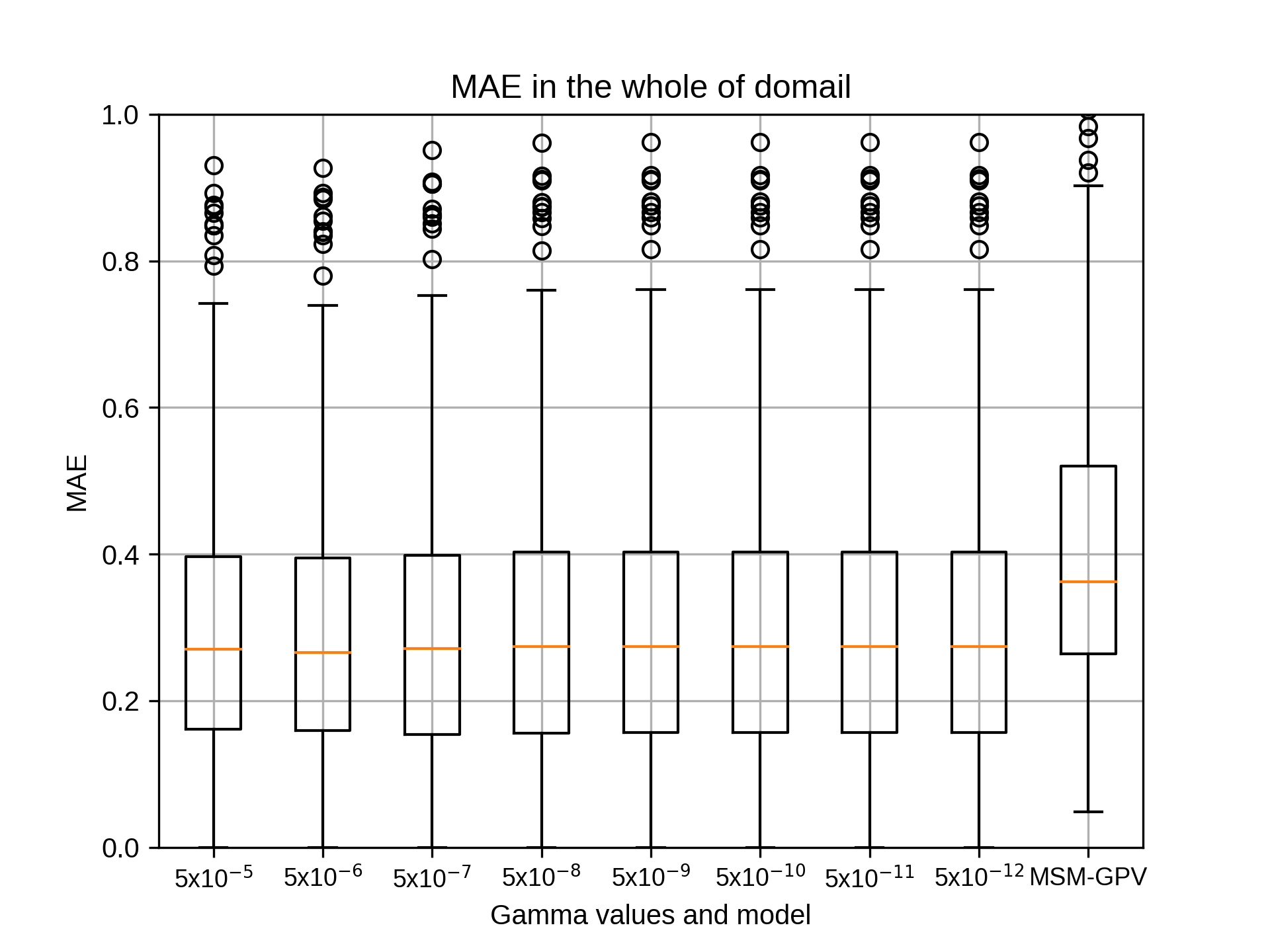

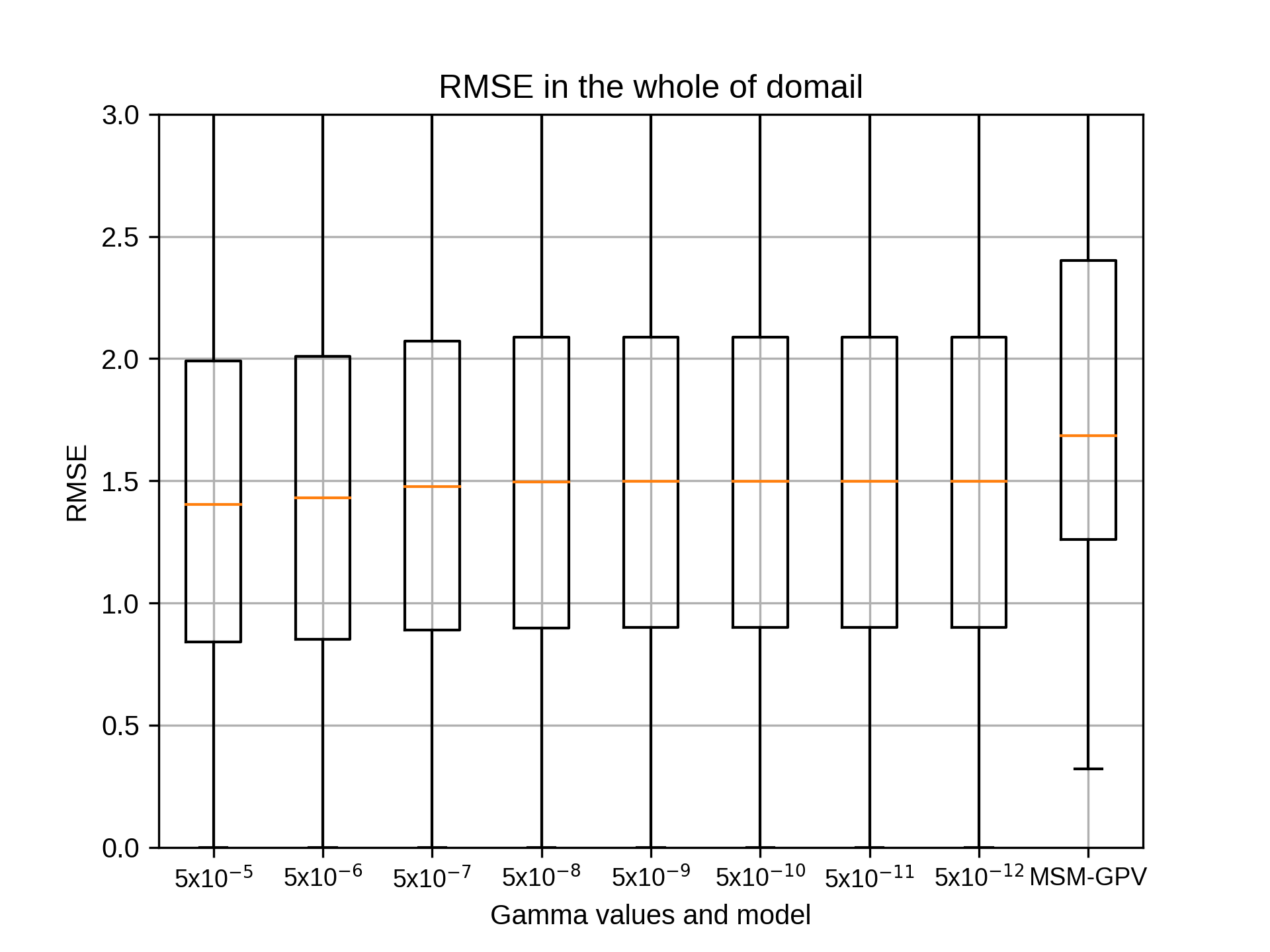

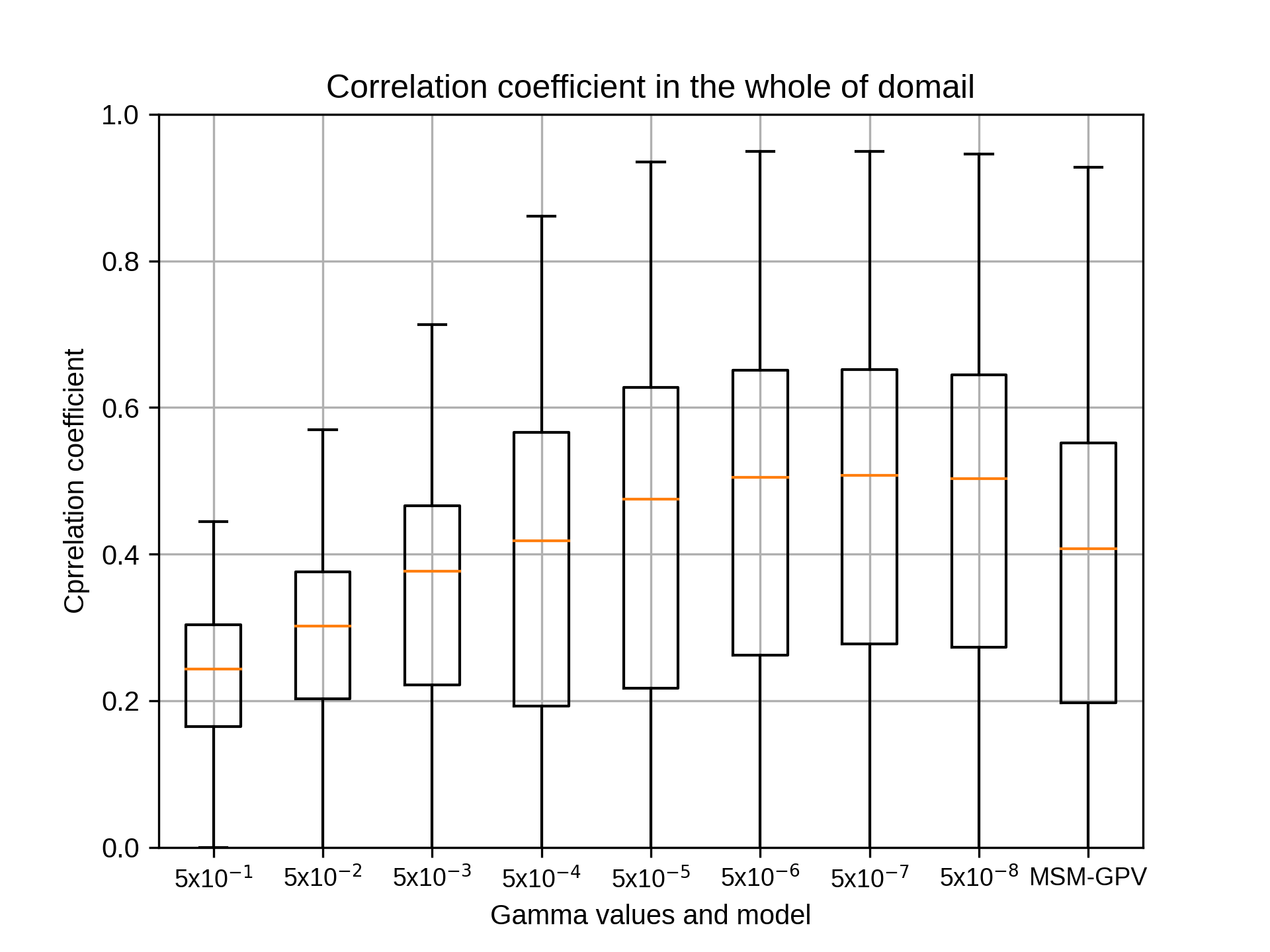

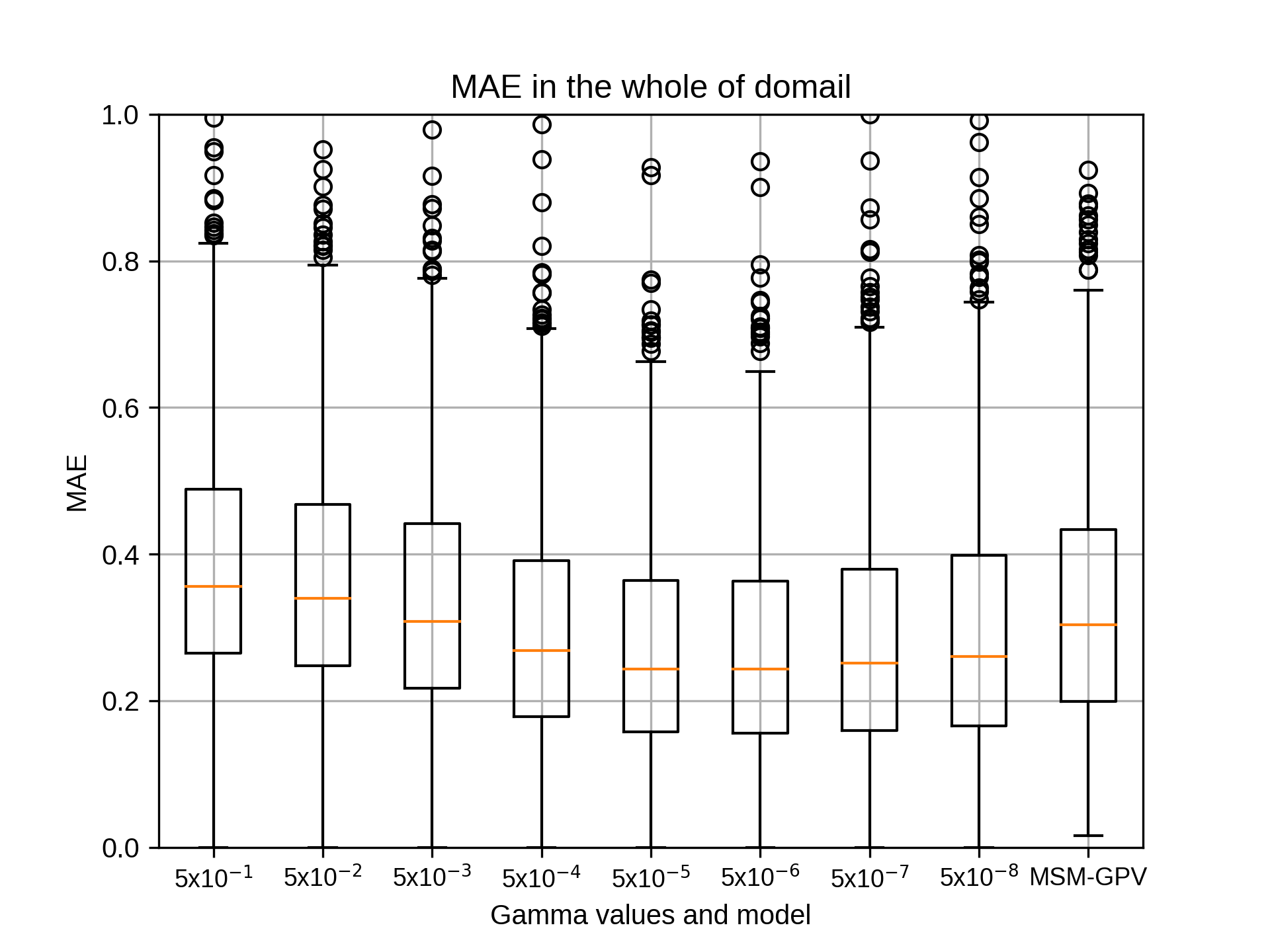

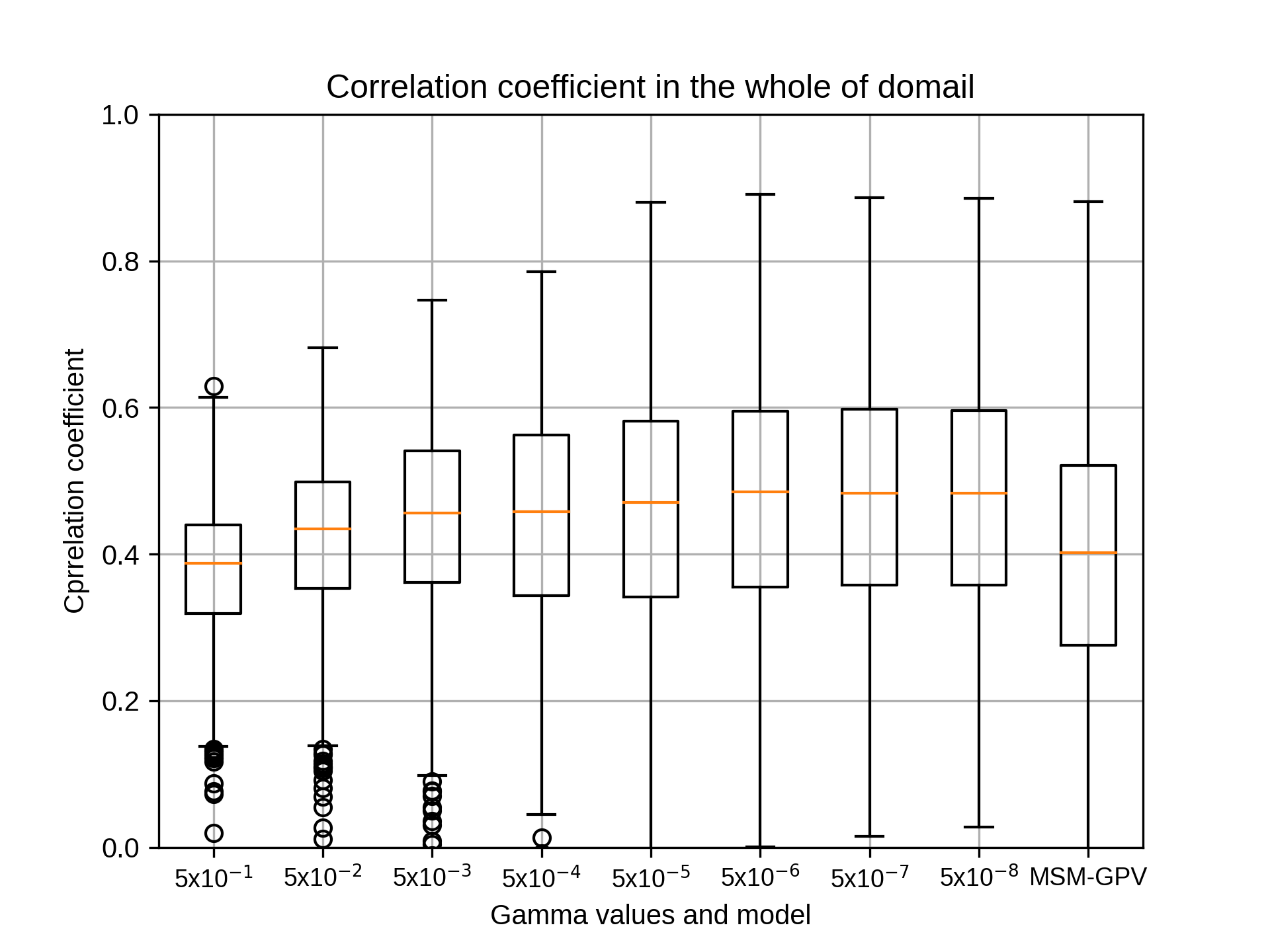

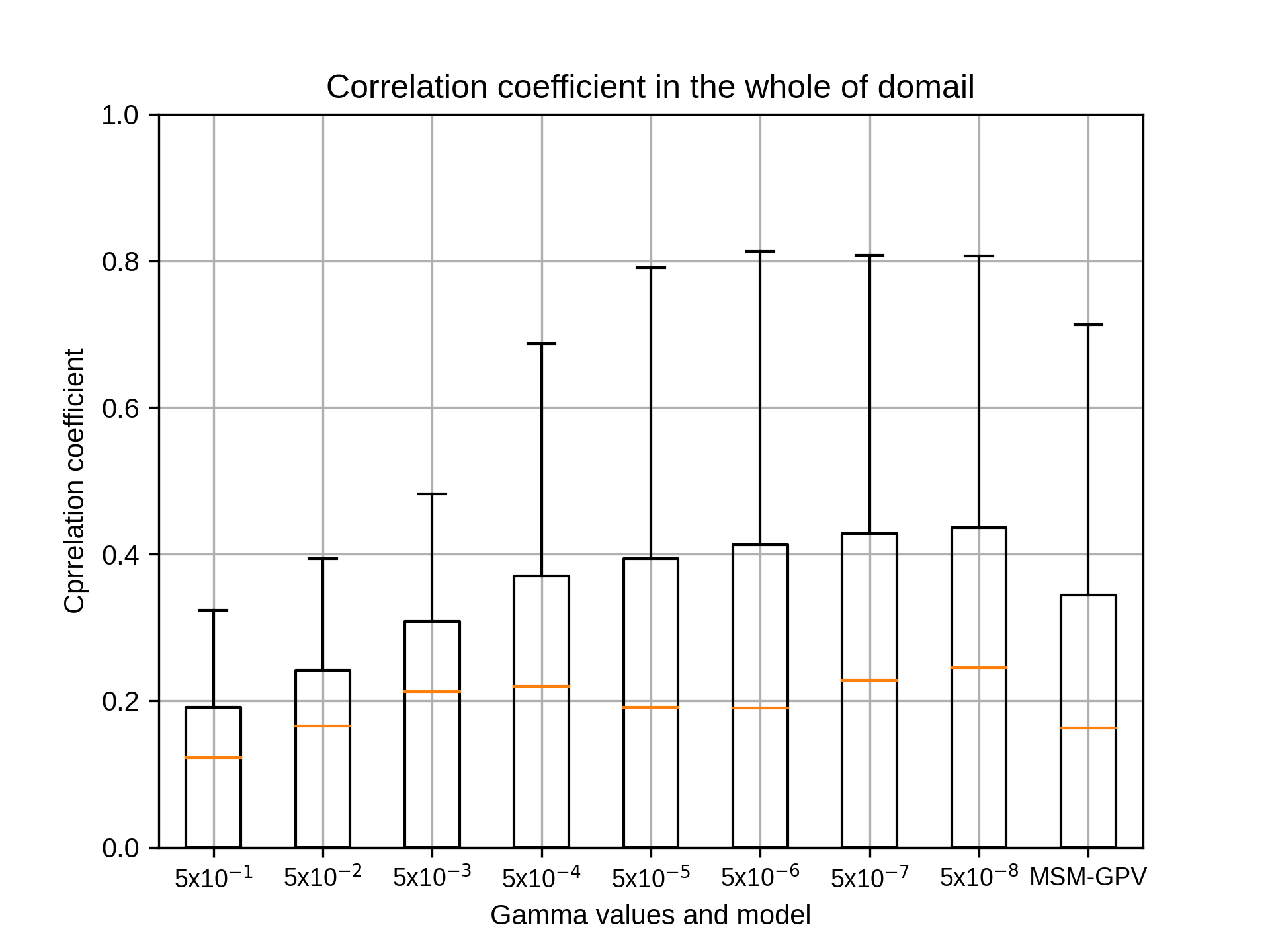

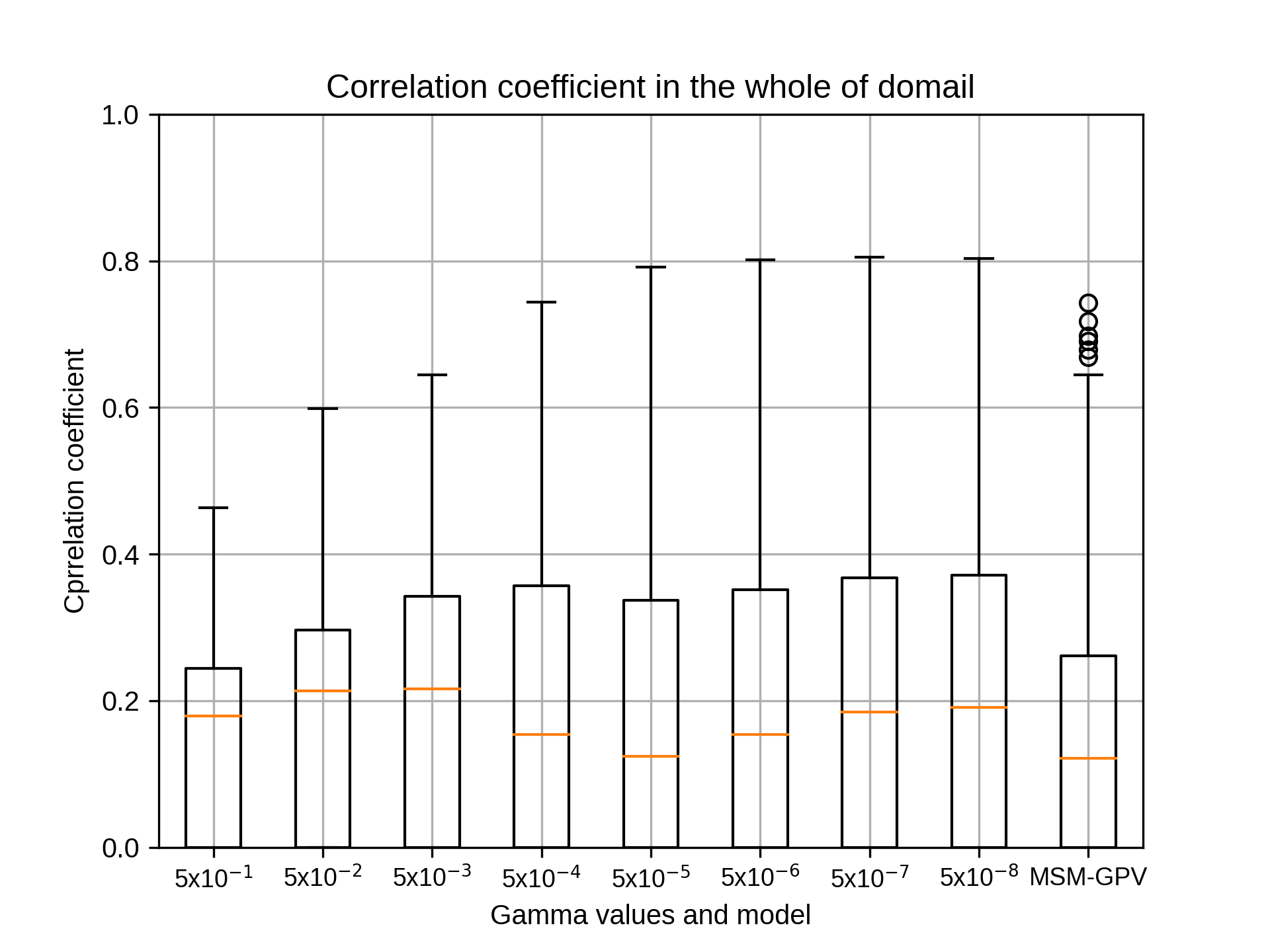

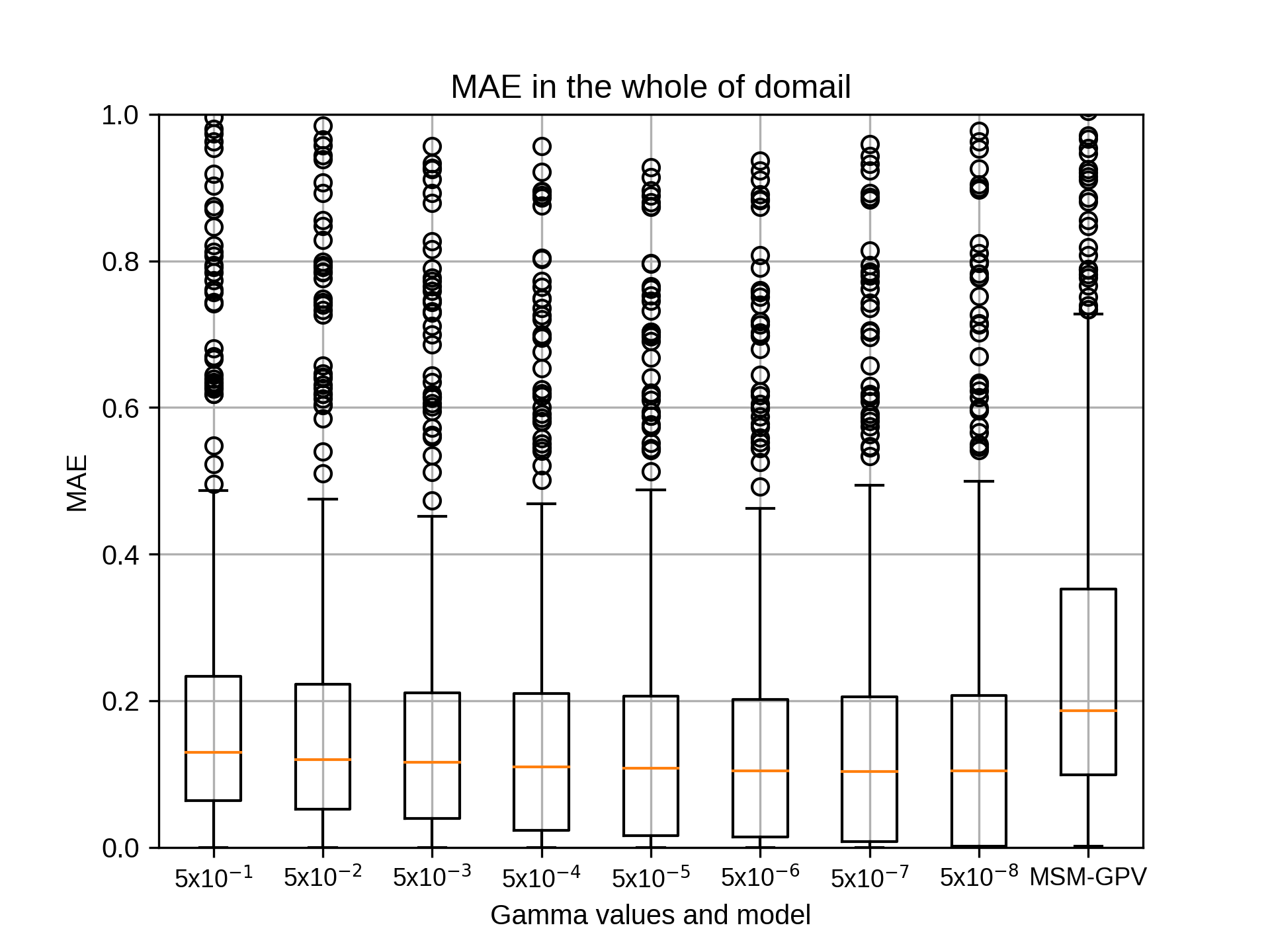

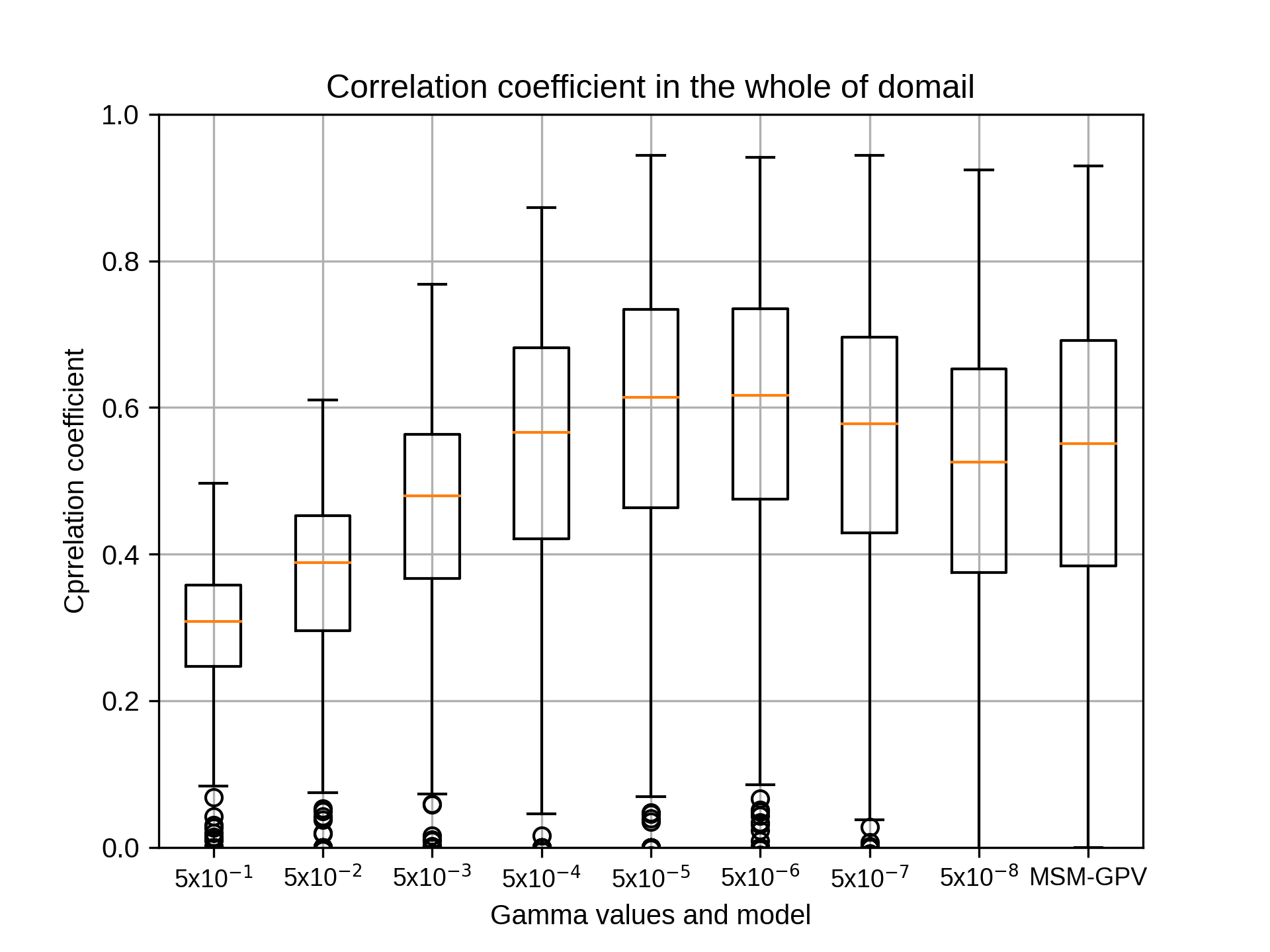

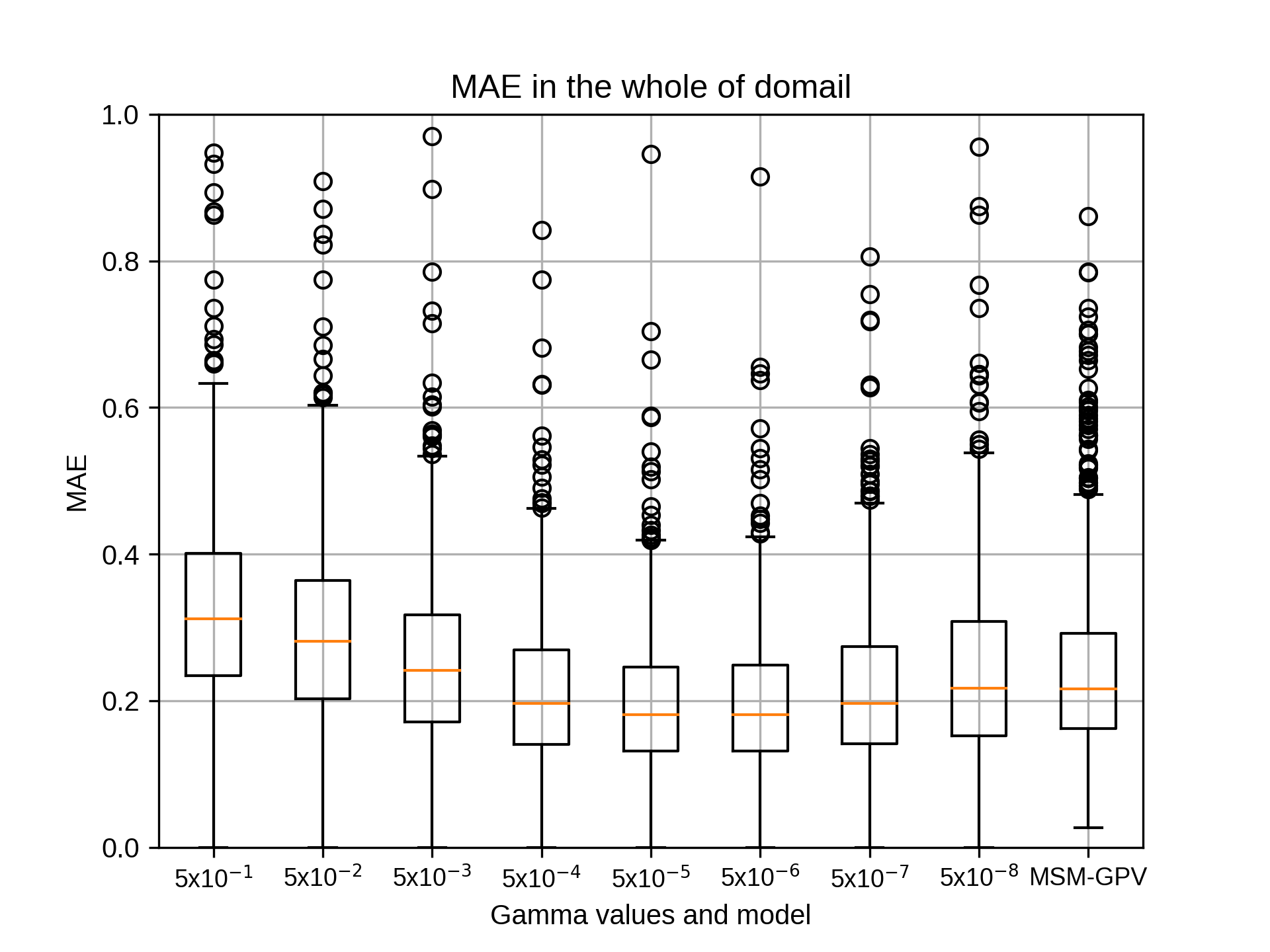

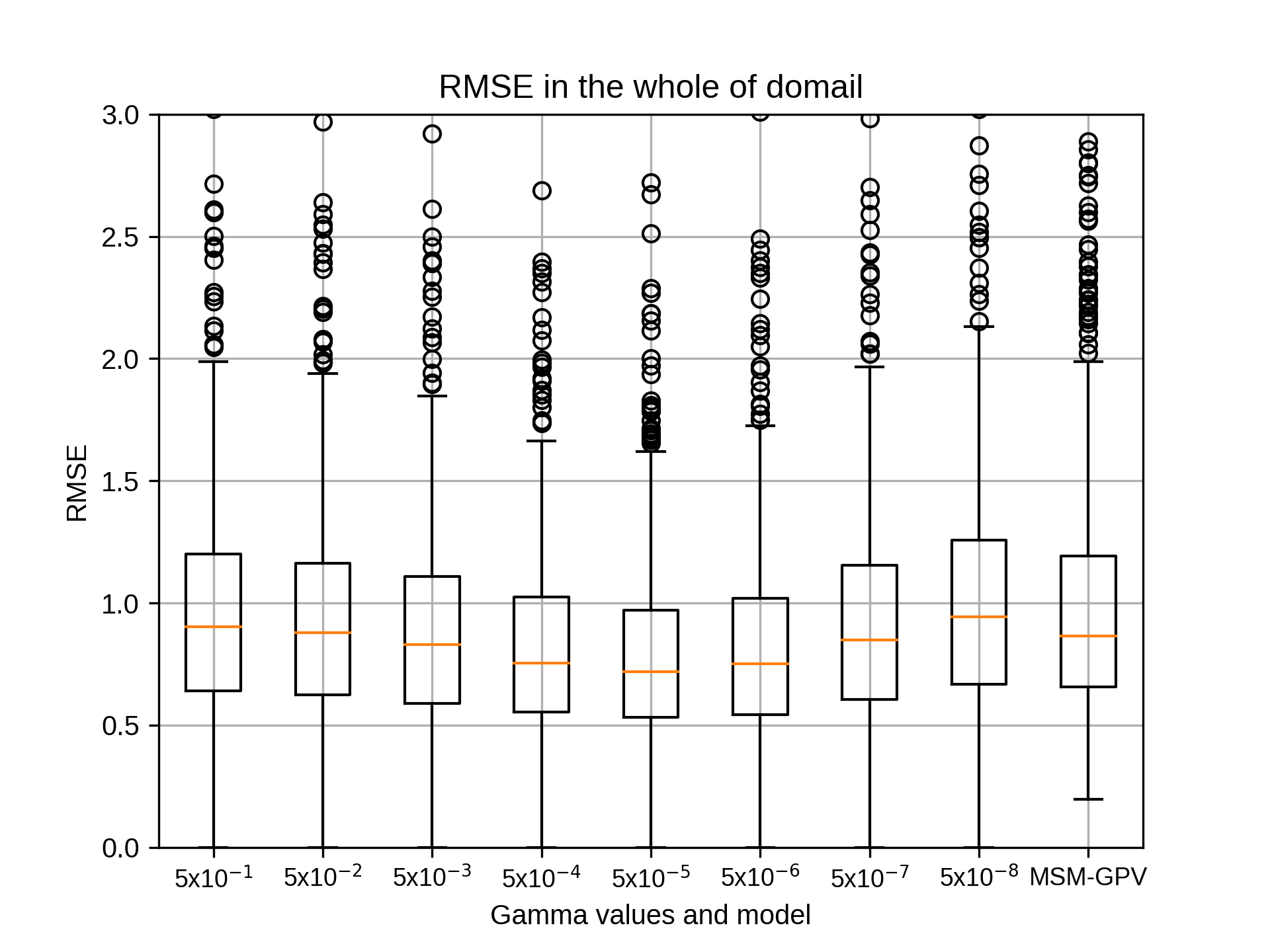

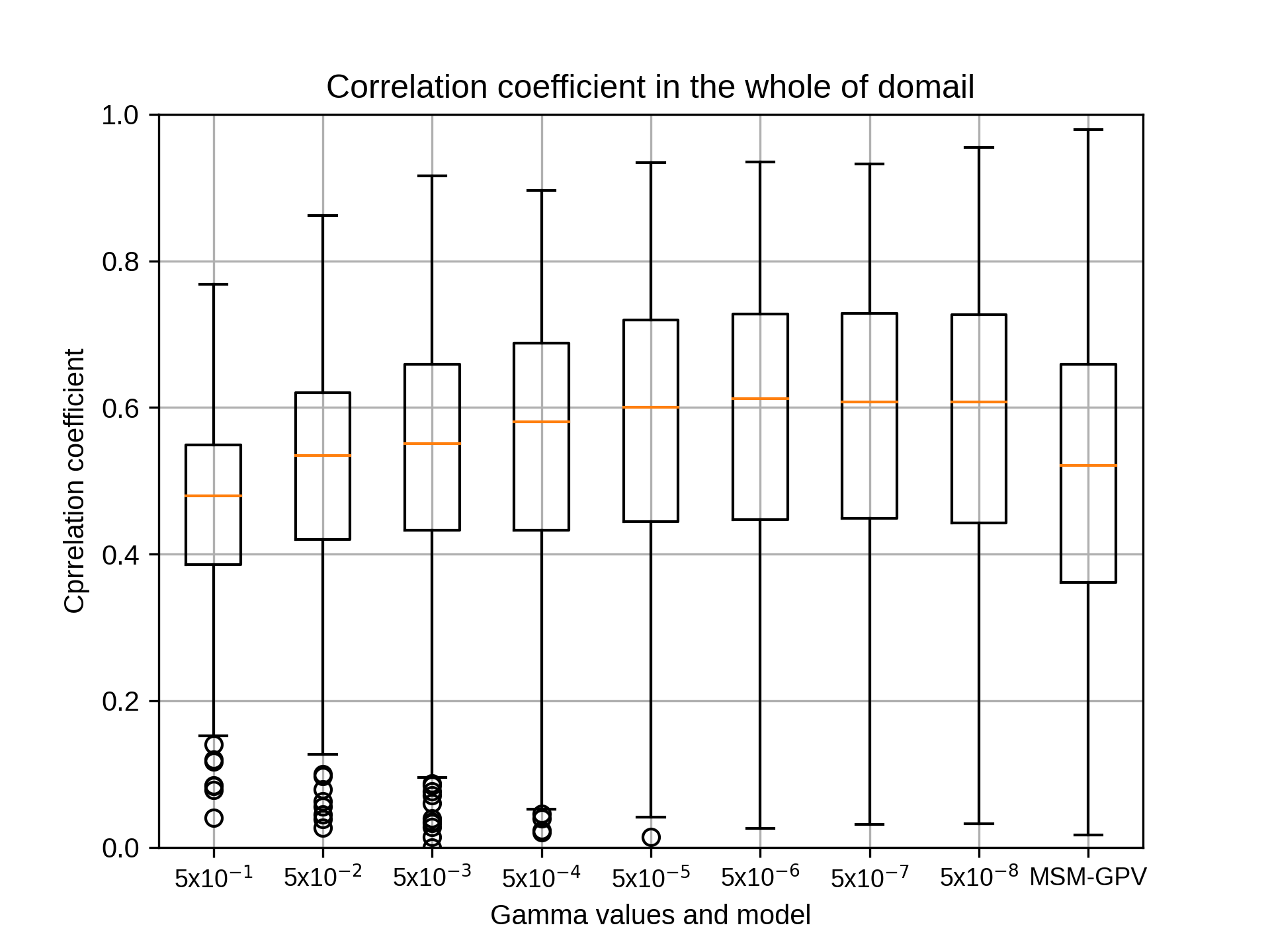

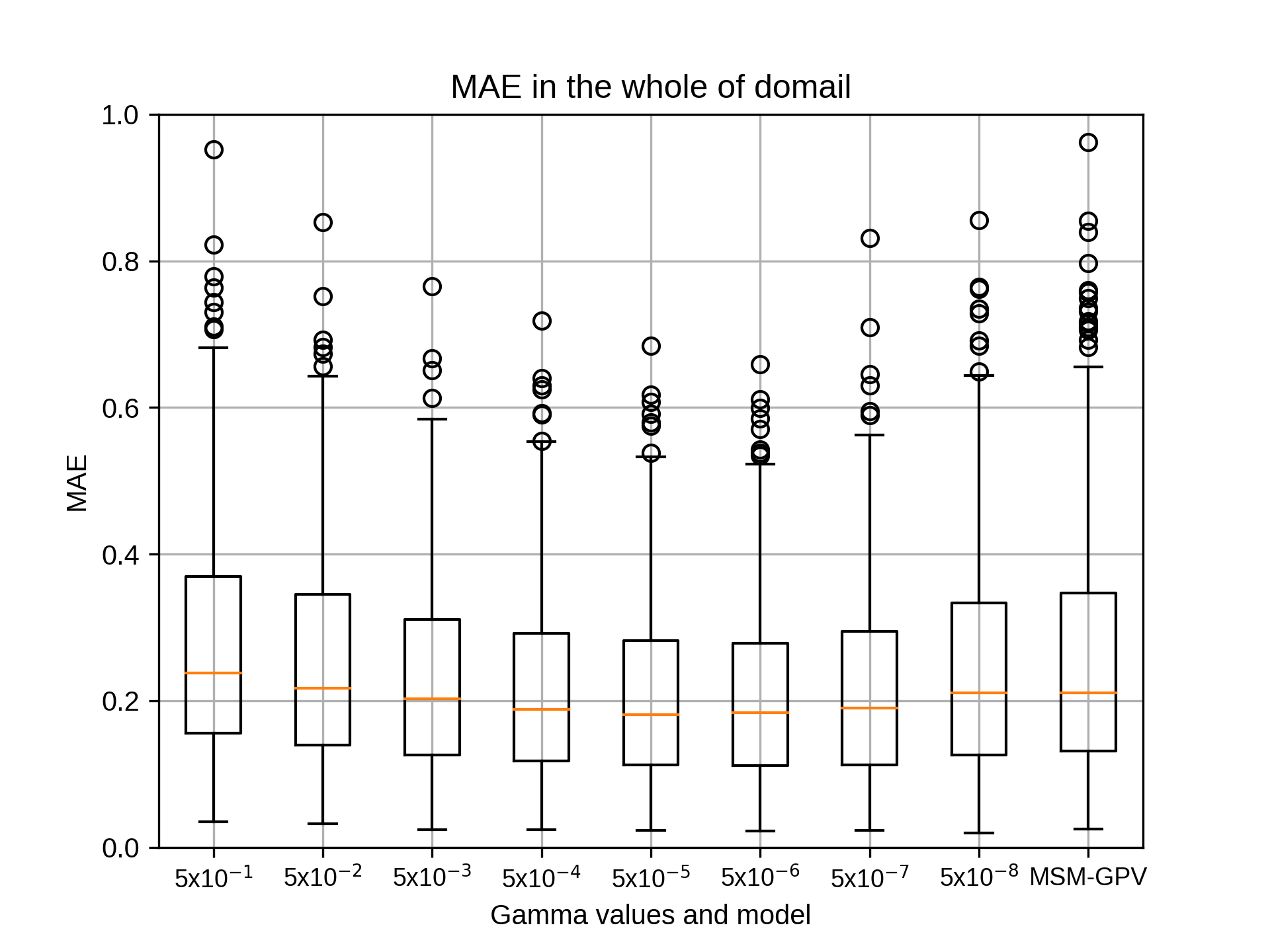

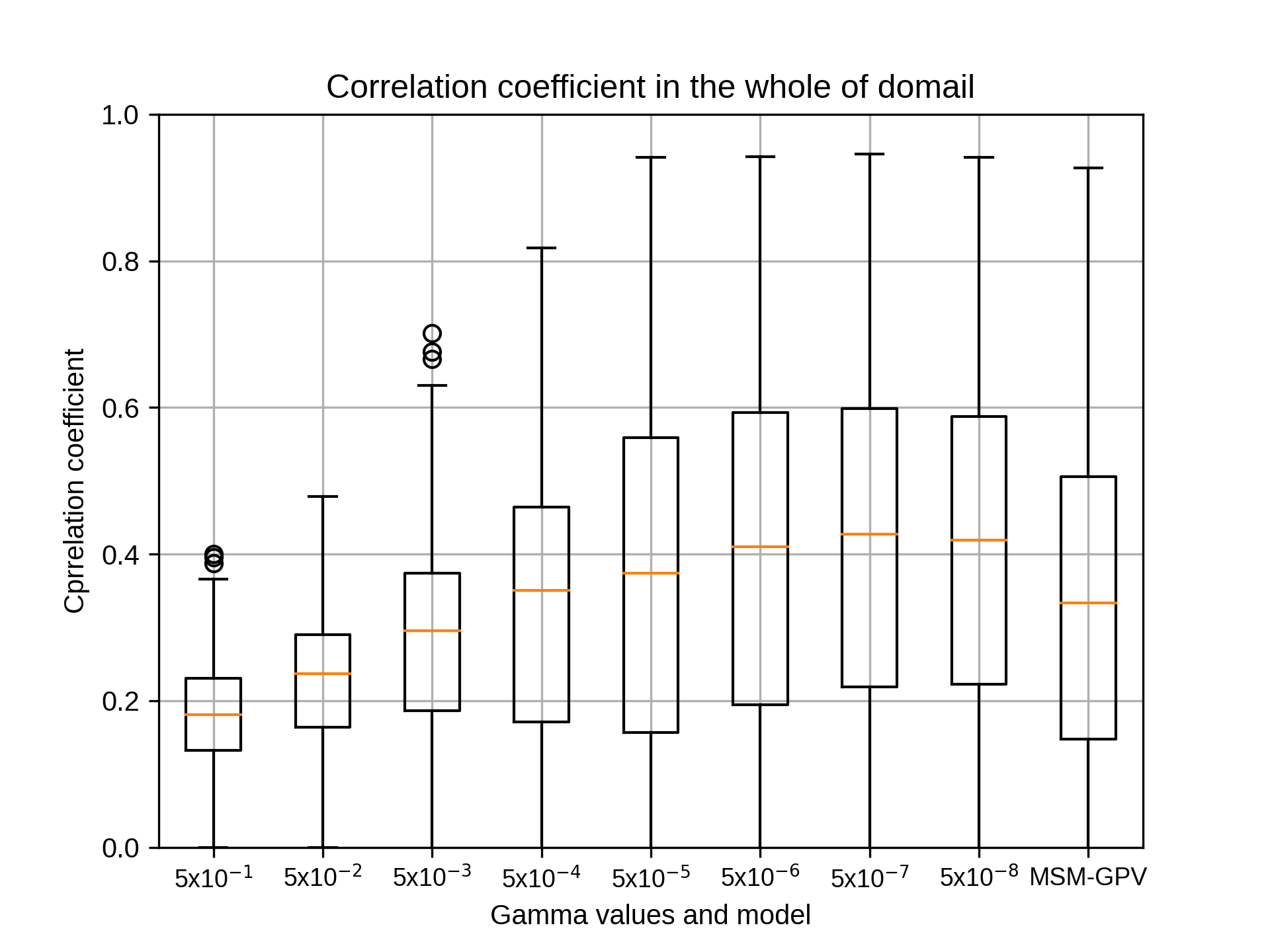

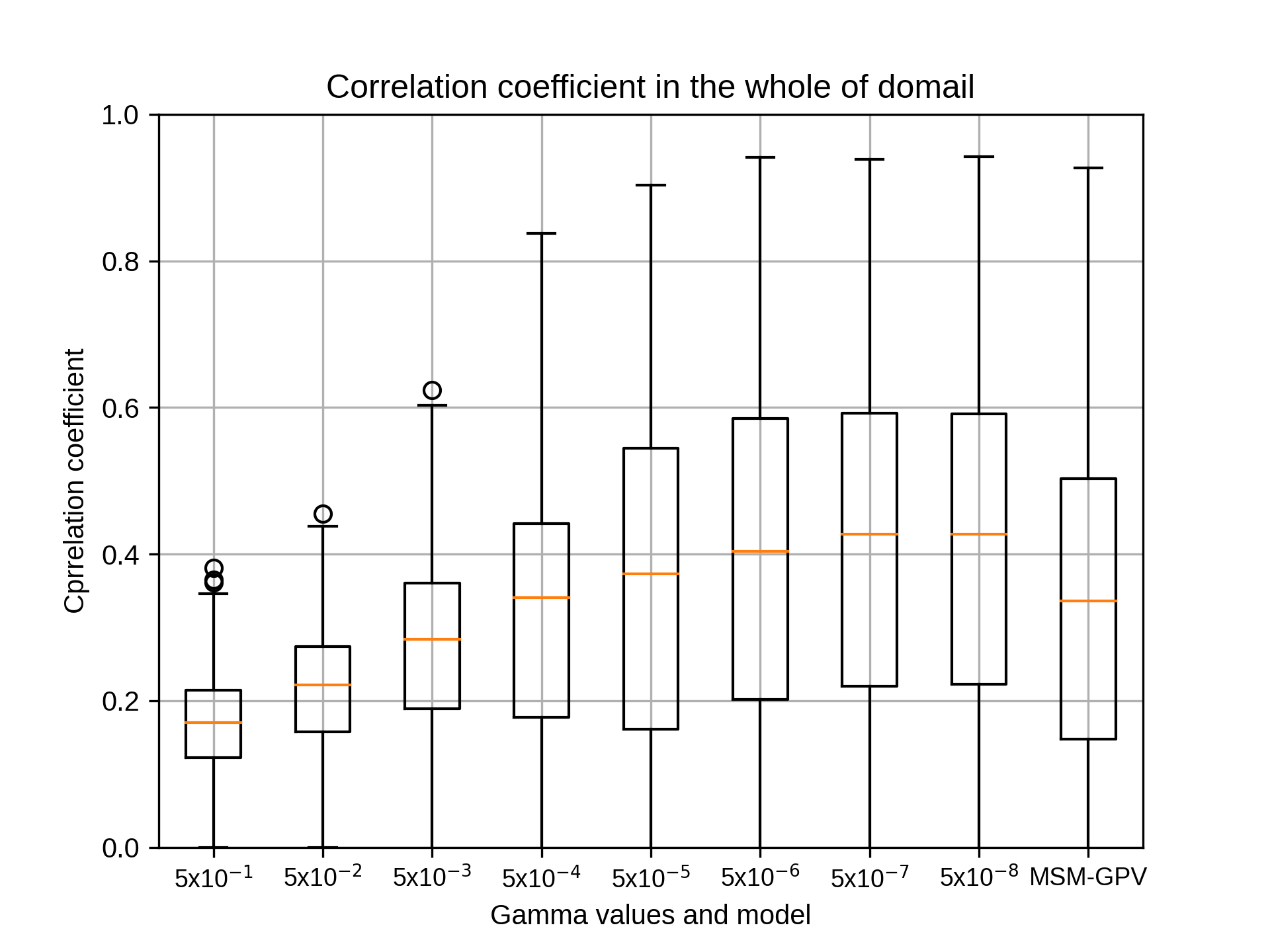

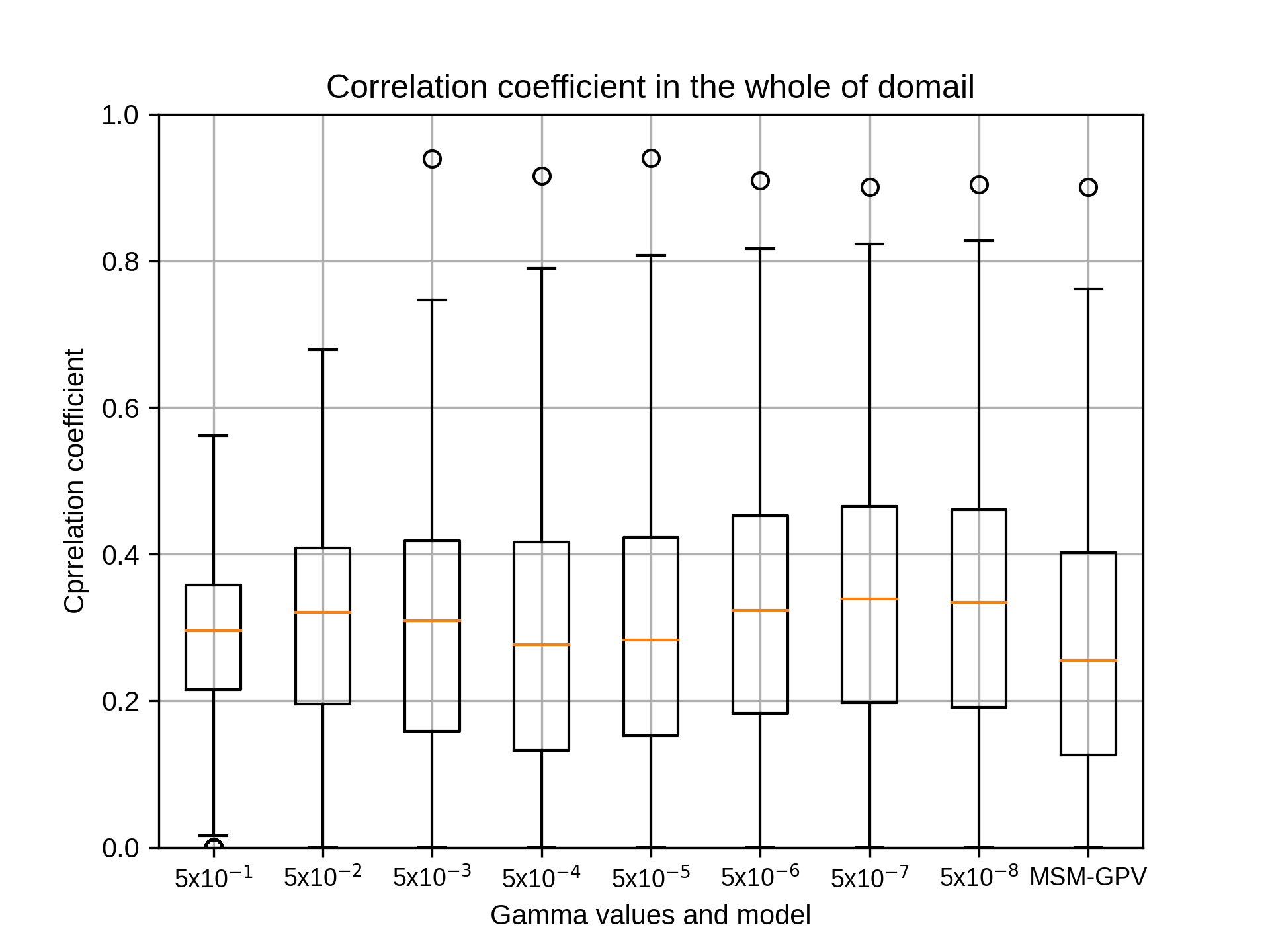

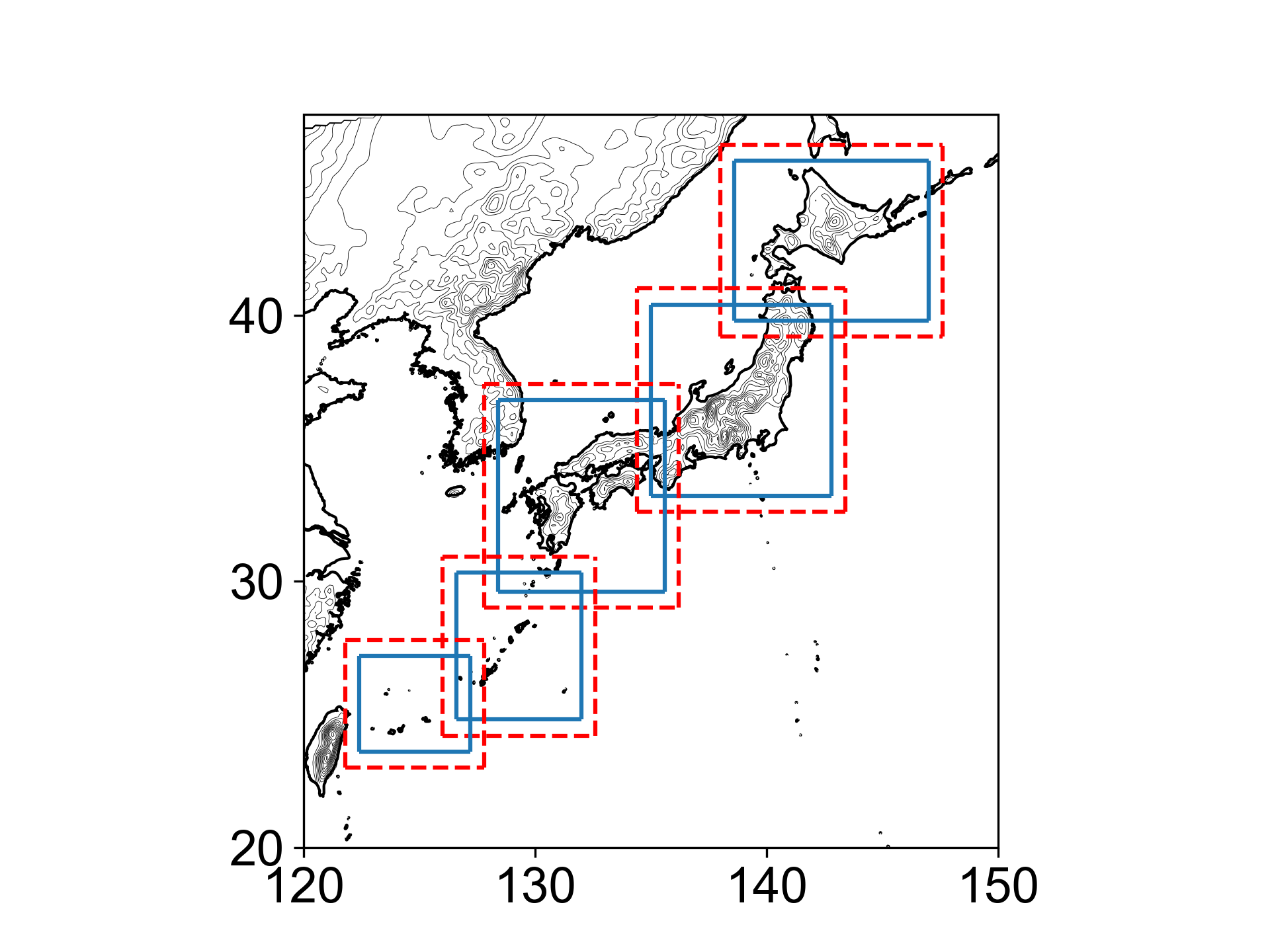

siteC,siteEにつきましてガンマの違いによる結果が出ましたのでお伝えいたします。

あわせて領域図も添付します。

siteCのパラメータは以下のとおりです。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon} #07

## Grids

xnums='20 30 40 50 60 70 80'

ynums='20 30 40 50 60 70 80'

nums='441'

rg2='10'

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

また、siteEのパラメータは以下のとおりです。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon} #07

## Grids

xnums='20 30 40 50 60 70'

ynums='20 30 40 50 60 70'

nums='441'

rg2='10'

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

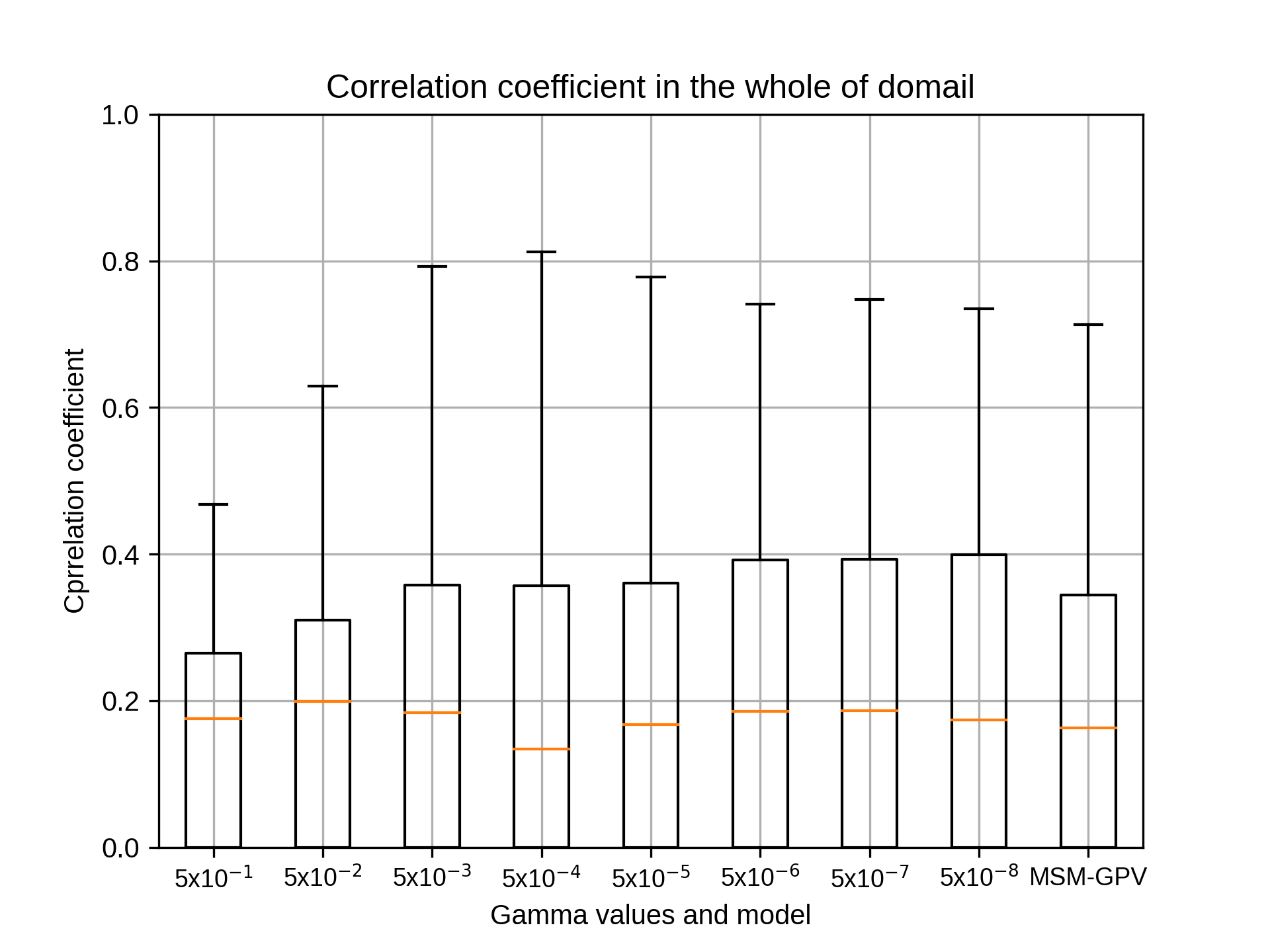

なお、siteAについてはうまくpointに出力されず、siteC,siteDは相関係数がうまく出力されないエラーが発生しておりますので確認の上、修正いたします。

吉兼先生

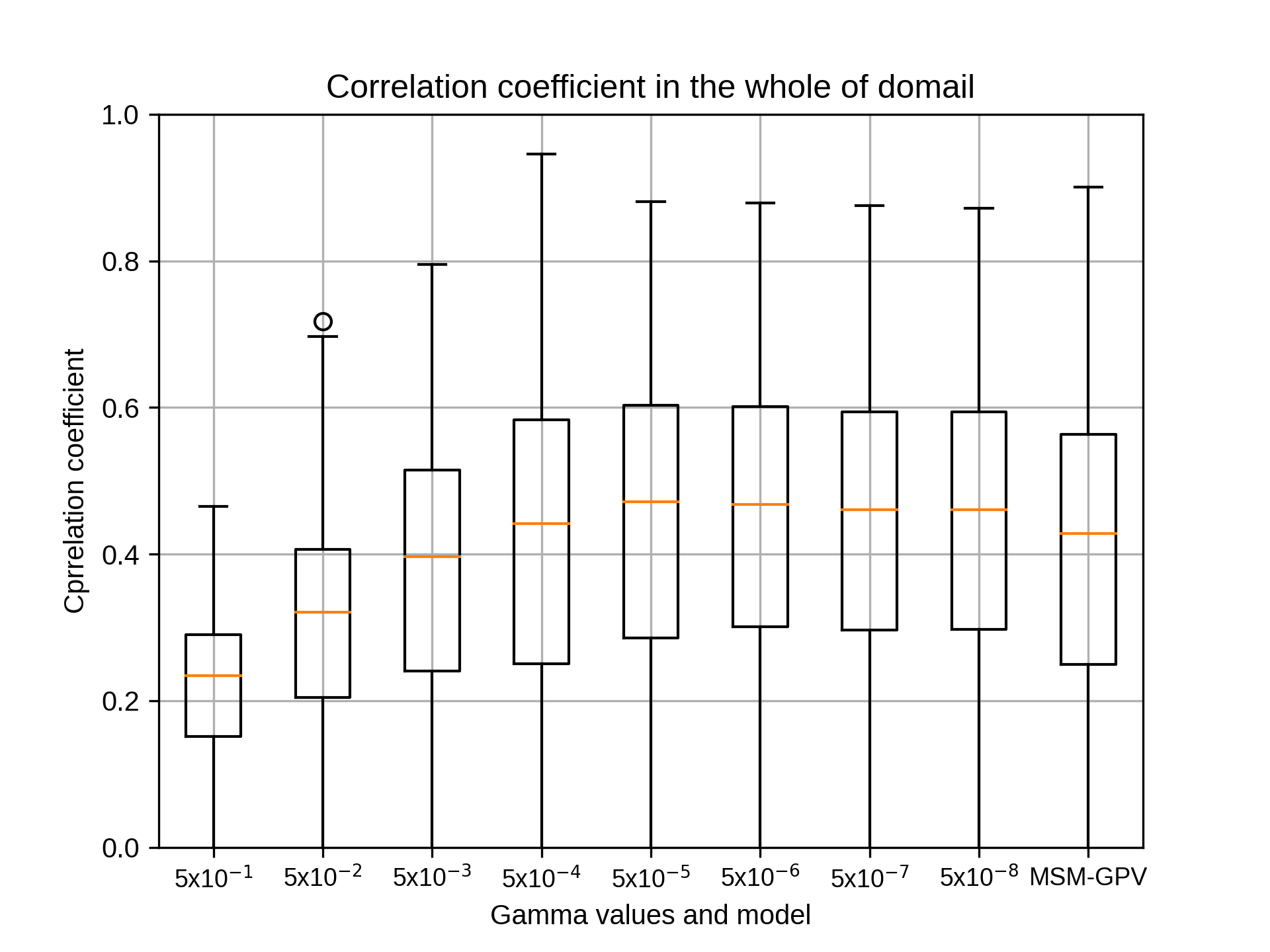

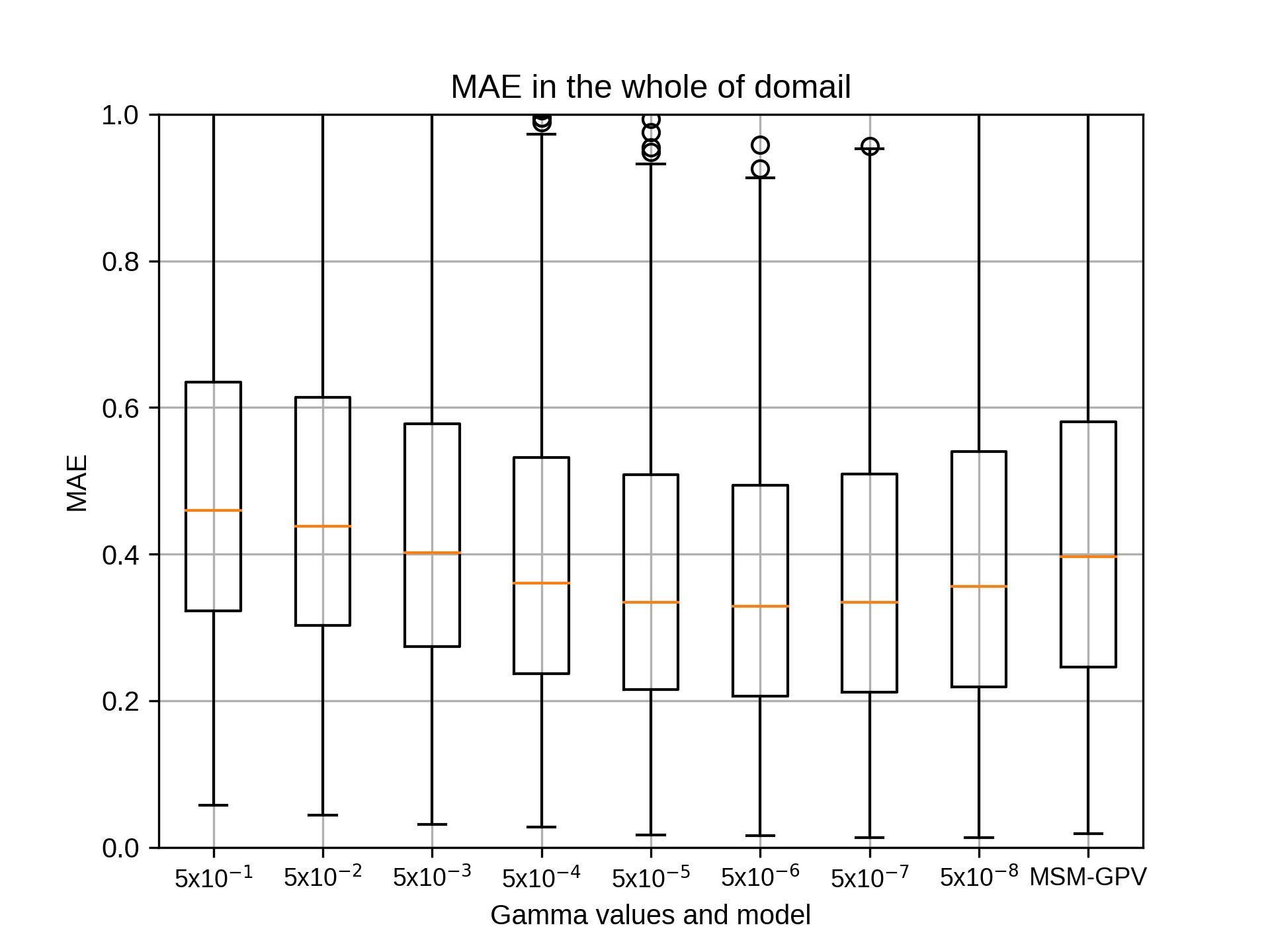

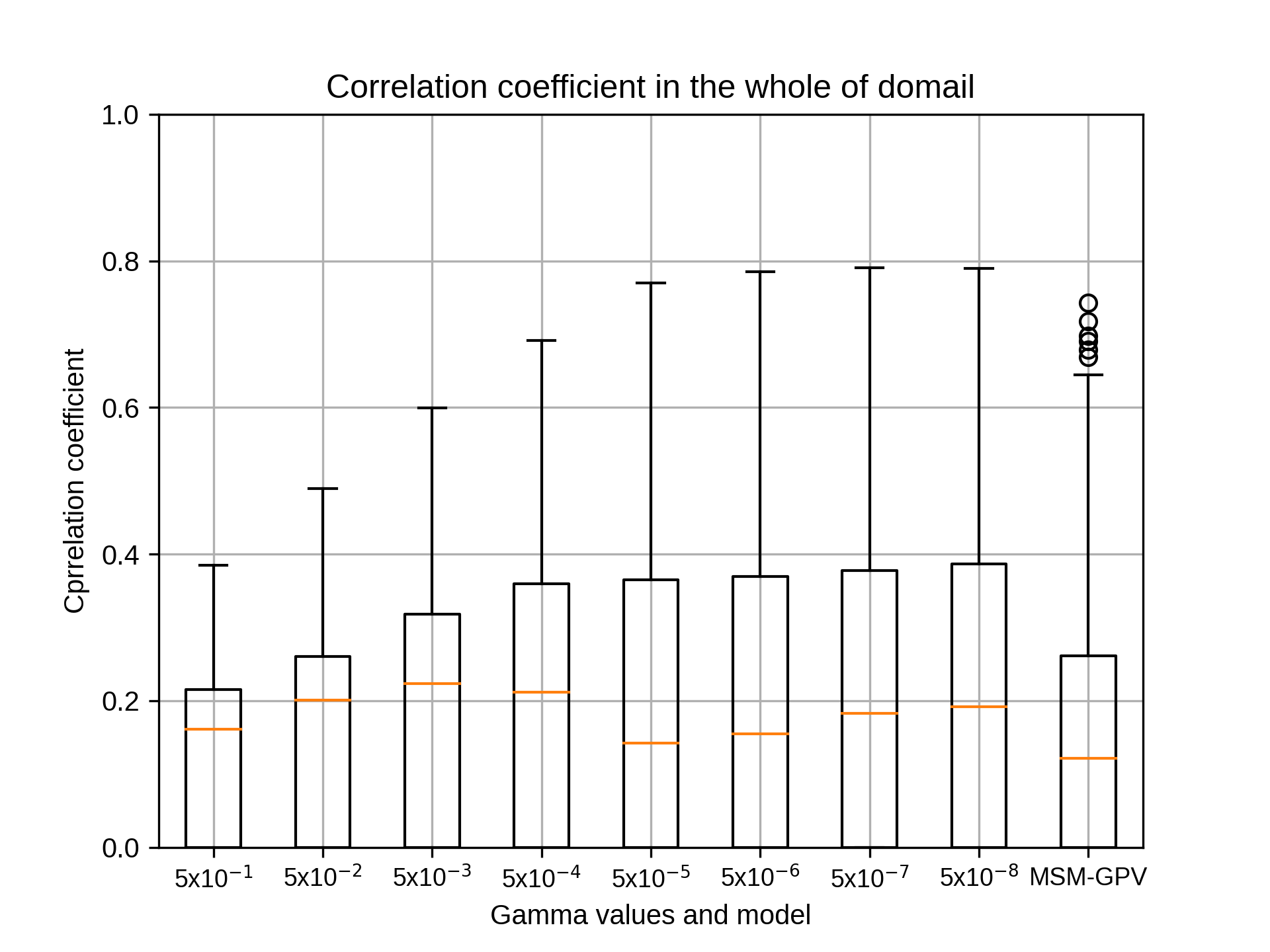

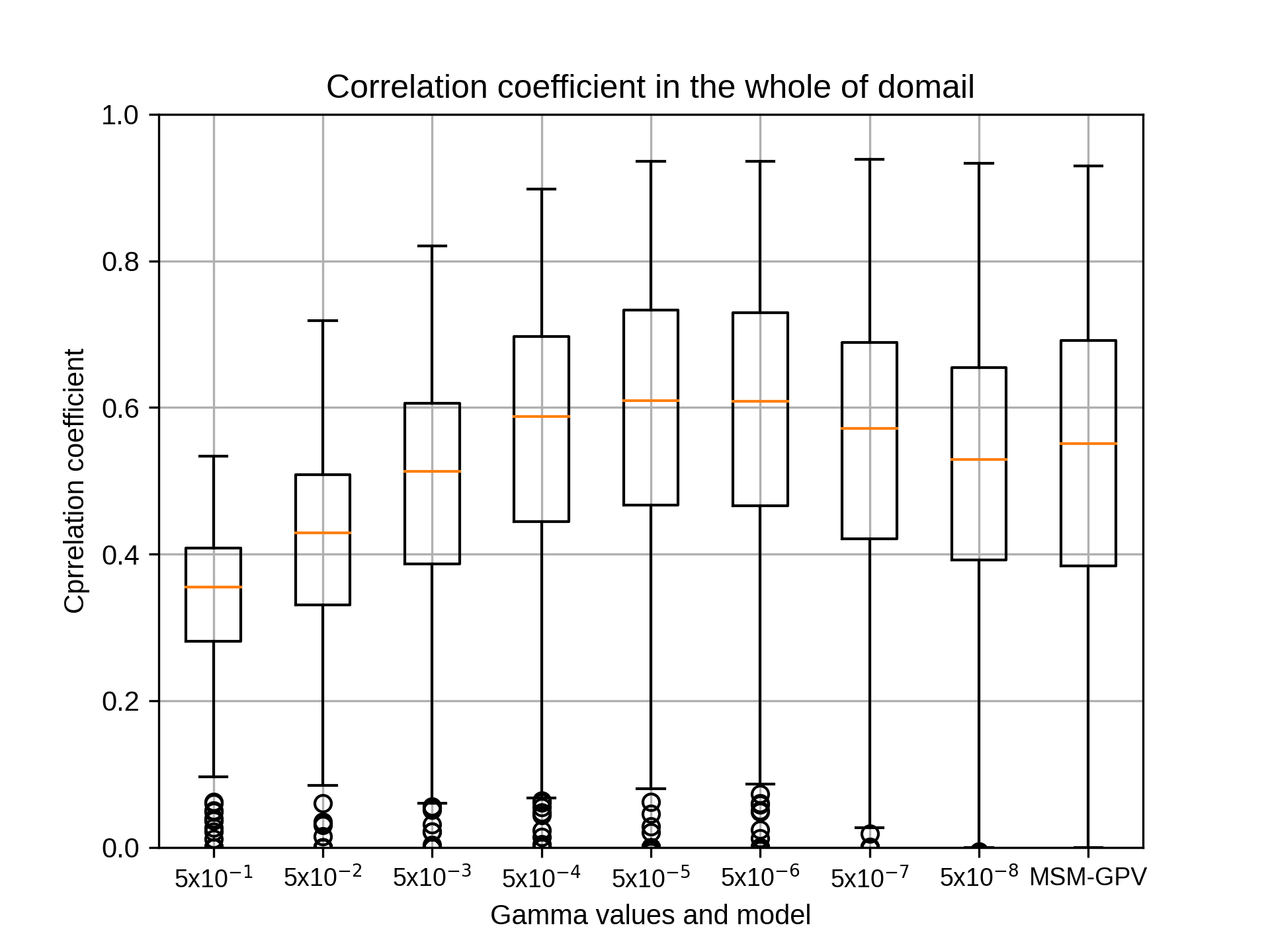

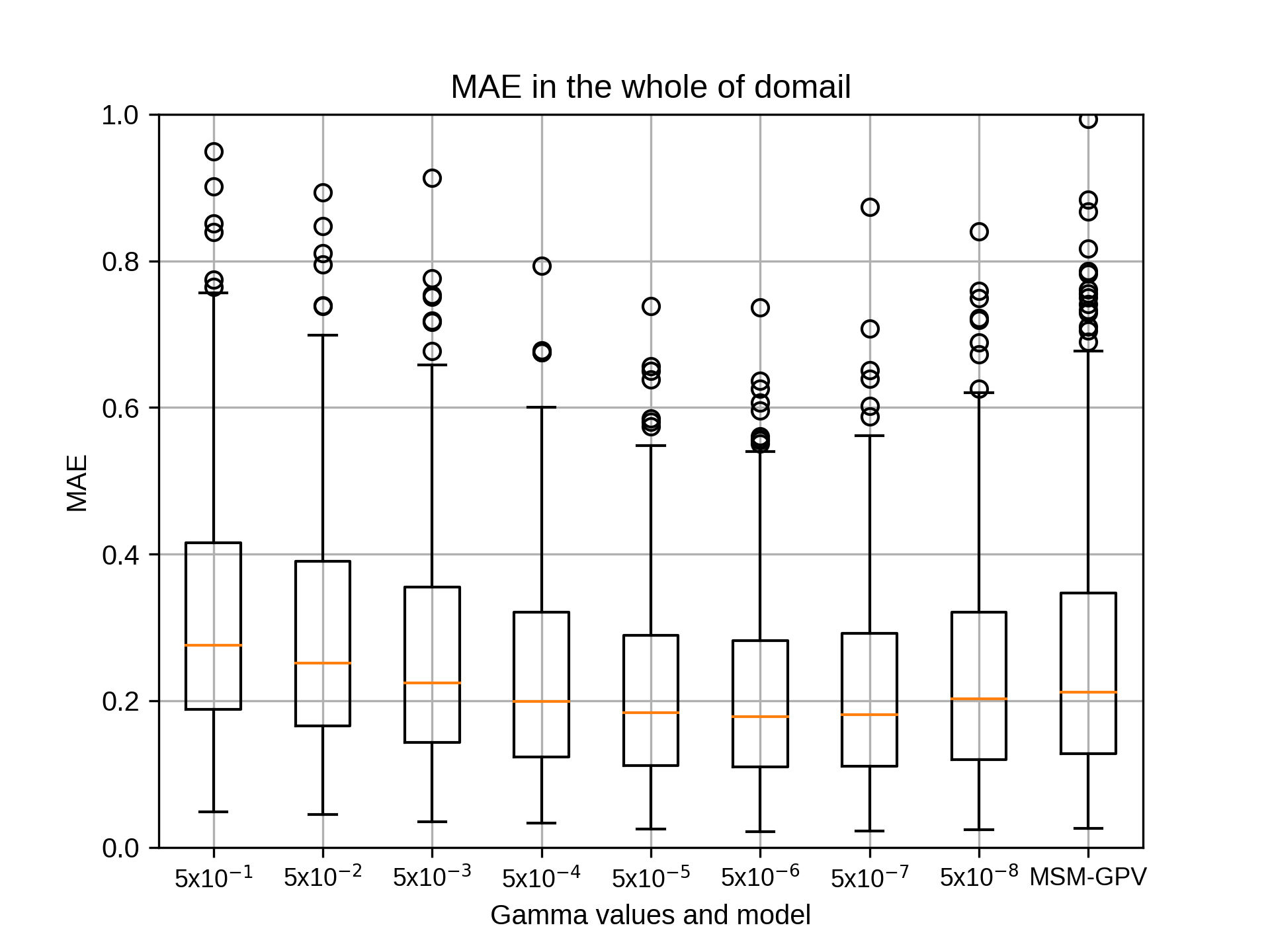

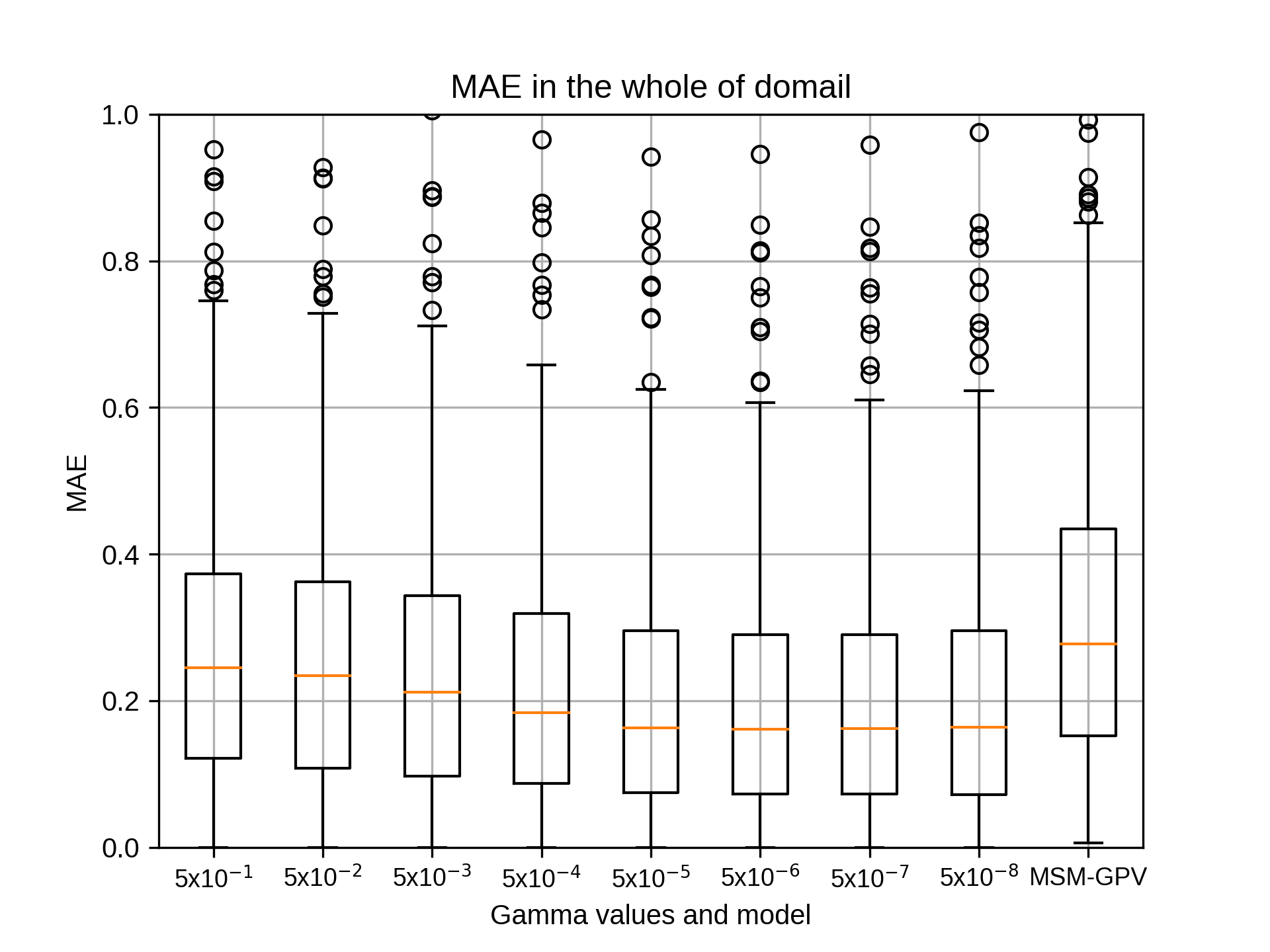

siteC,siteEにつきましてガンマの違いによる結果が出ましたのでお伝えいたします。

あわせて領域図も添付します。

siteCのパラメータは以下のとおりです。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon} #07

## Grids

xnums='20 30 40 50 60 70 80'

ynums='20 30 40 50 60 70 80'

nums='441'

rg2='10'

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

また、siteEのパラメータは以下のとおりです。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon} #07

## Grids

xnums='20 30 40 50 60 70'

ynums='20 30 40 50 60 70'

nums='441'

rg2='10'

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

なお、siteAについてはうまくpointに出力されず、siteC,siteDは相関係数がうまく出力されないエラーが発生しておりますので確認の上、修正いたします。

takao-yMonday, September 7th, 2020 at 12:28:42 PM GMT+09:00

@kobayashi_yusuke

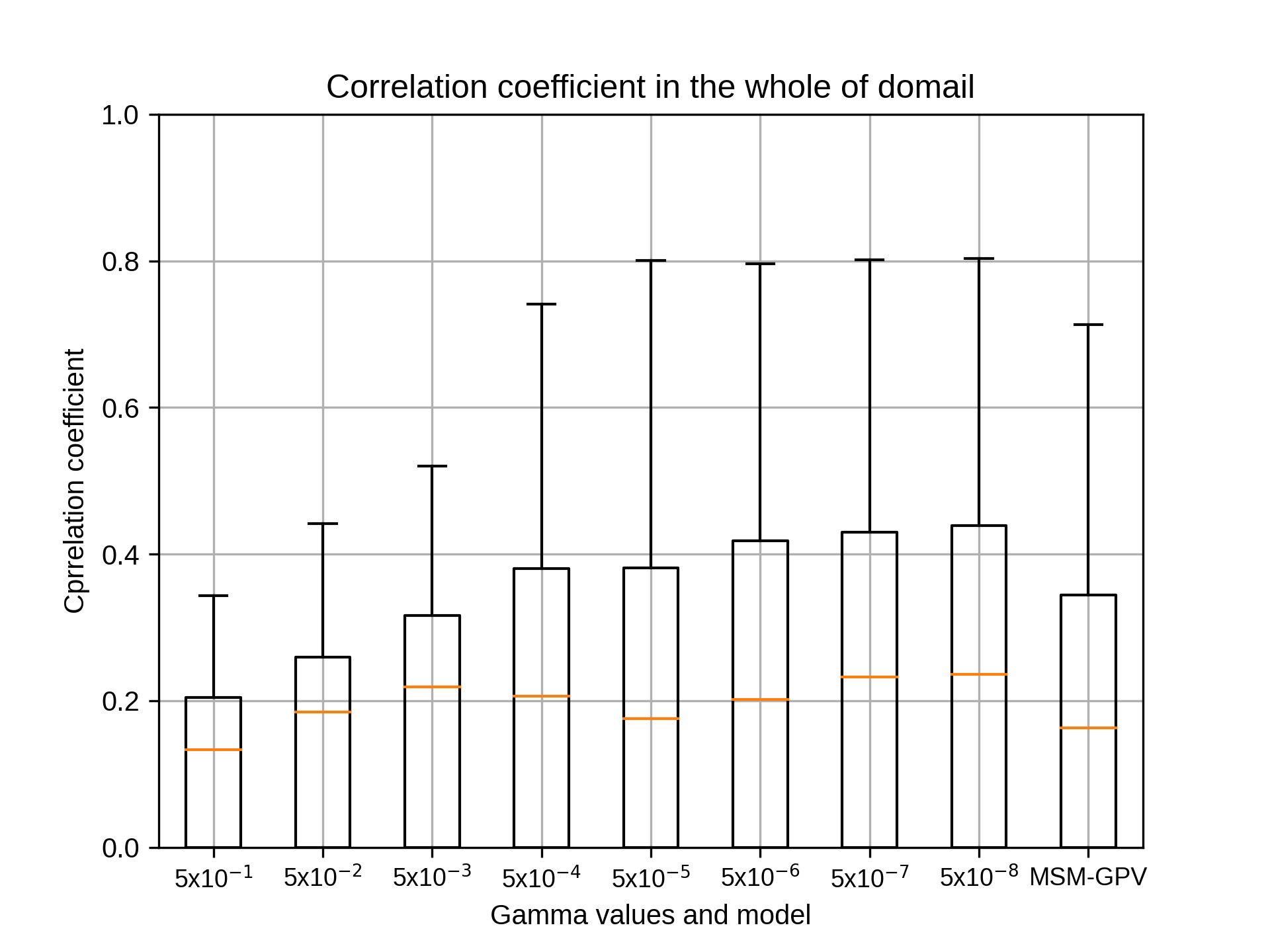

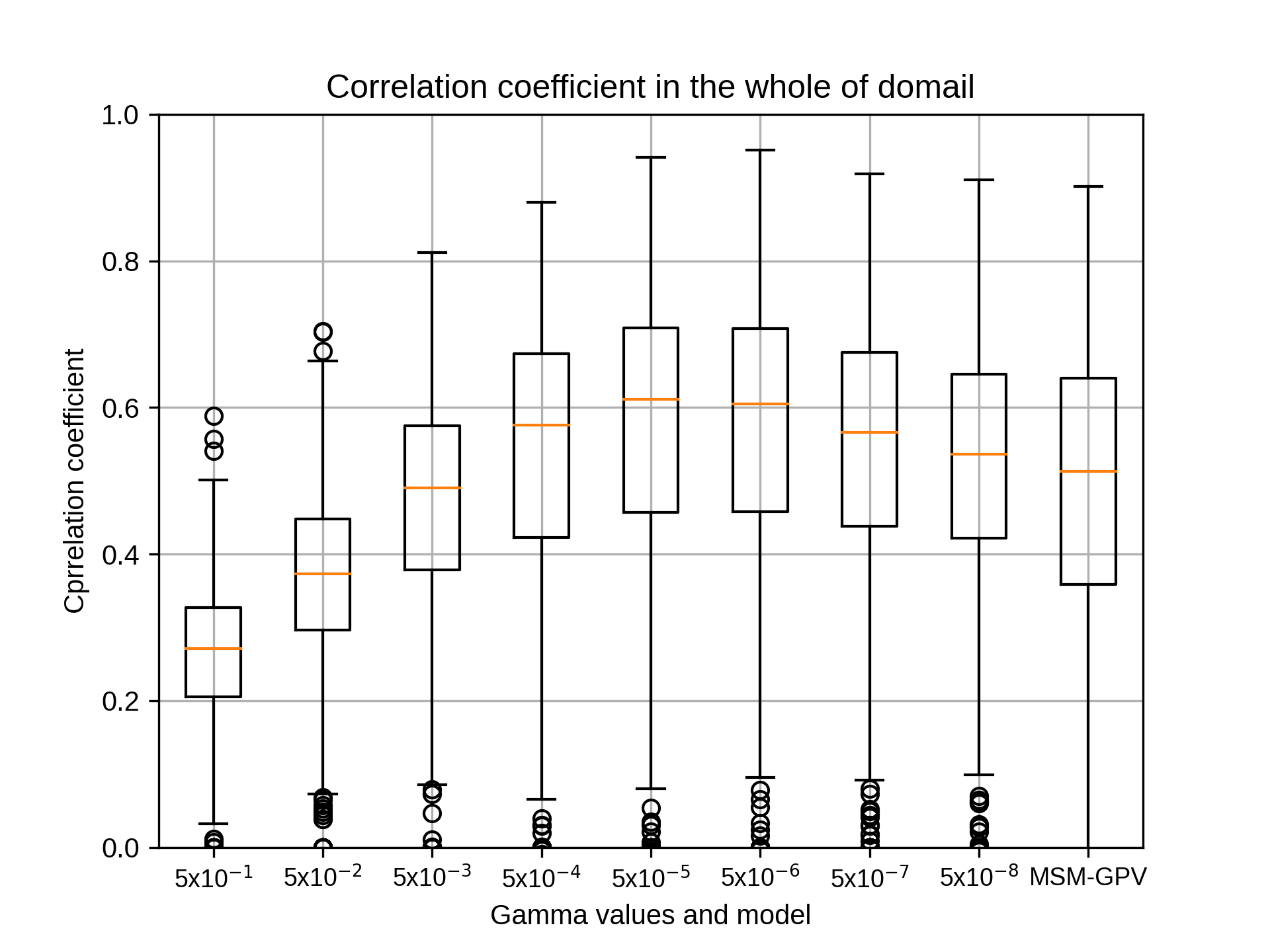

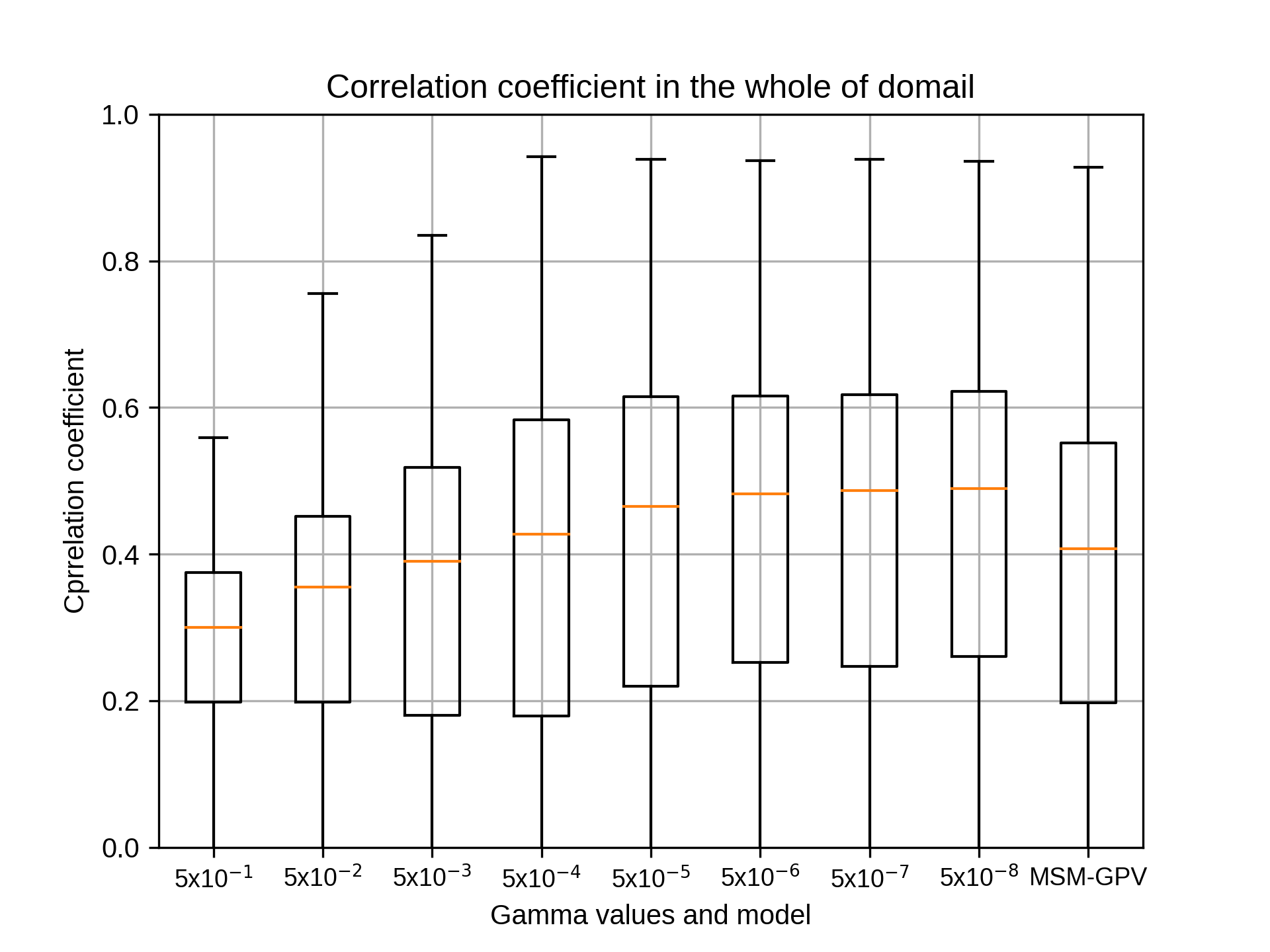

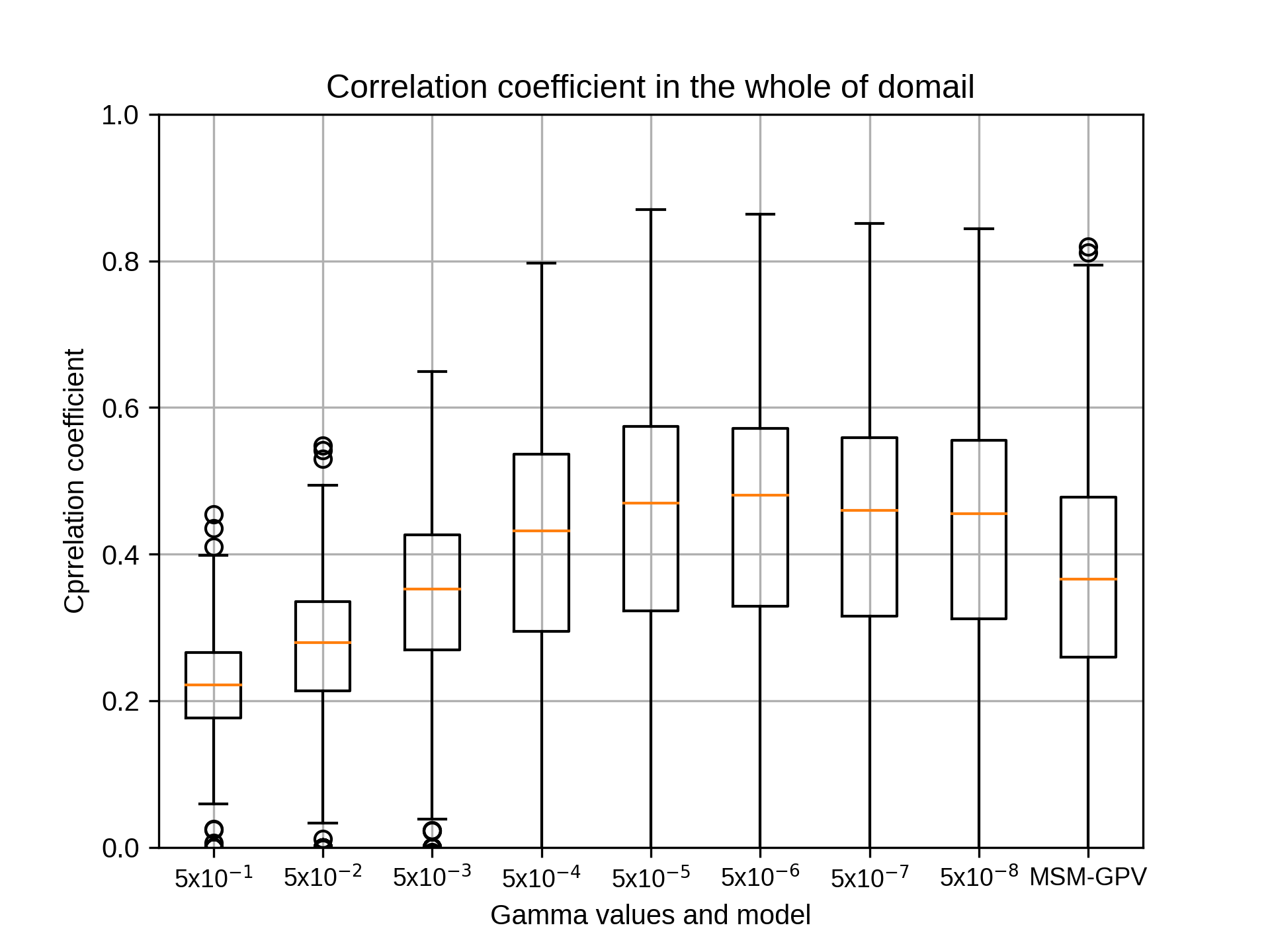

小林様。ありがとうございます。

図を見る限り、他の領域でも最適値はほとんど変わらないように思われます。相関係数が出力されないのは、データ欠損値の処理などで0割を起こしている可能性が高いと思います。もしフォートランをあまり得意とされていないのであれば、他の言語で変換していただいても構いません。もしpythonに慣れている場合は、pythonを使って変換された方が簡単かもしれません。

よろしくお願いいたします。

小林様。ありがとうございます。

図を見る限り、他の領域でも最適値はほとんど変わらないように思われます。相関係数が出力されないのは、データ欠損値の処理などで0割を起こしている可能性が高いと思います。もしフォートランをあまり得意とされていないのであれば、他の言語で変換していただいても構いません。もしpythonに慣れている場合は、pythonを使って変換された方が簡単かもしれません。

よろしくお願いいたします。

kobayashi_yusukeMonday, September 7th, 2020 at 1:14:51 PM GMT+09:00

@takao-y

吉兼先生 お返事ありがとうございます。

相関係数が出力されない点を調べたところ、吉兼先生がおっしゃるとおり欠損値処理の問題のようで、欠損値を除外してグラフ出力の部分だけ動かしましたらグラフが出ました。そのため、欠損値除外するコードを入れたうえで現在siteBとsiteDでプログラム全体を動かしております。

フォートランは社内の別の者が担当しており、その者が修正を行っております。フォートランからpythonへの変換には時間を要すると考えられるため、このまま社内の者がフォートランの修正を行いたいと考えております。

以上、よろしくお願いいたします。

吉兼先生 お返事ありがとうございます。

相関係数が出力されない点を調べたところ、吉兼先生がおっしゃるとおり欠損値処理の問題のようで、欠損値を除外してグラフ出力の部分だけ動かしましたらグラフが出ました。そのため、欠損値除外するコードを入れたうえで現在siteBとsiteDでプログラム全体を動かしております。

フォートランは社内の別の者が担当しており、その者が修正を行っております。フォートランからpythonへの変換には時間を要すると考えられるため、このまま社内の者がフォートランの修正を行いたいと考えております。

以上、よろしくお願いいたします。

kobayashi_yusukeMonday, September 7th, 2020 at 8:44:47 PM GMT+09:00

@takao-y

吉兼先生

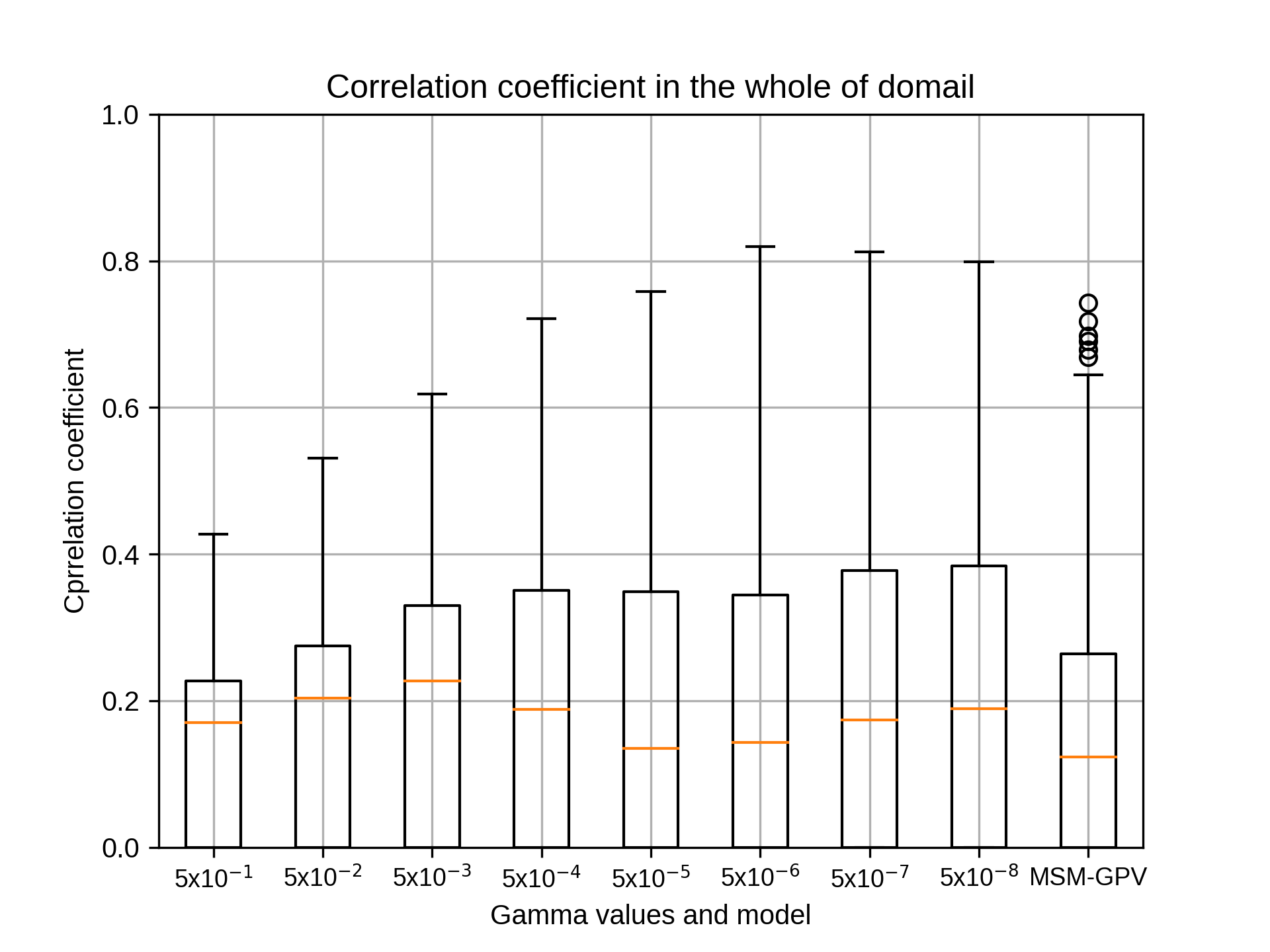

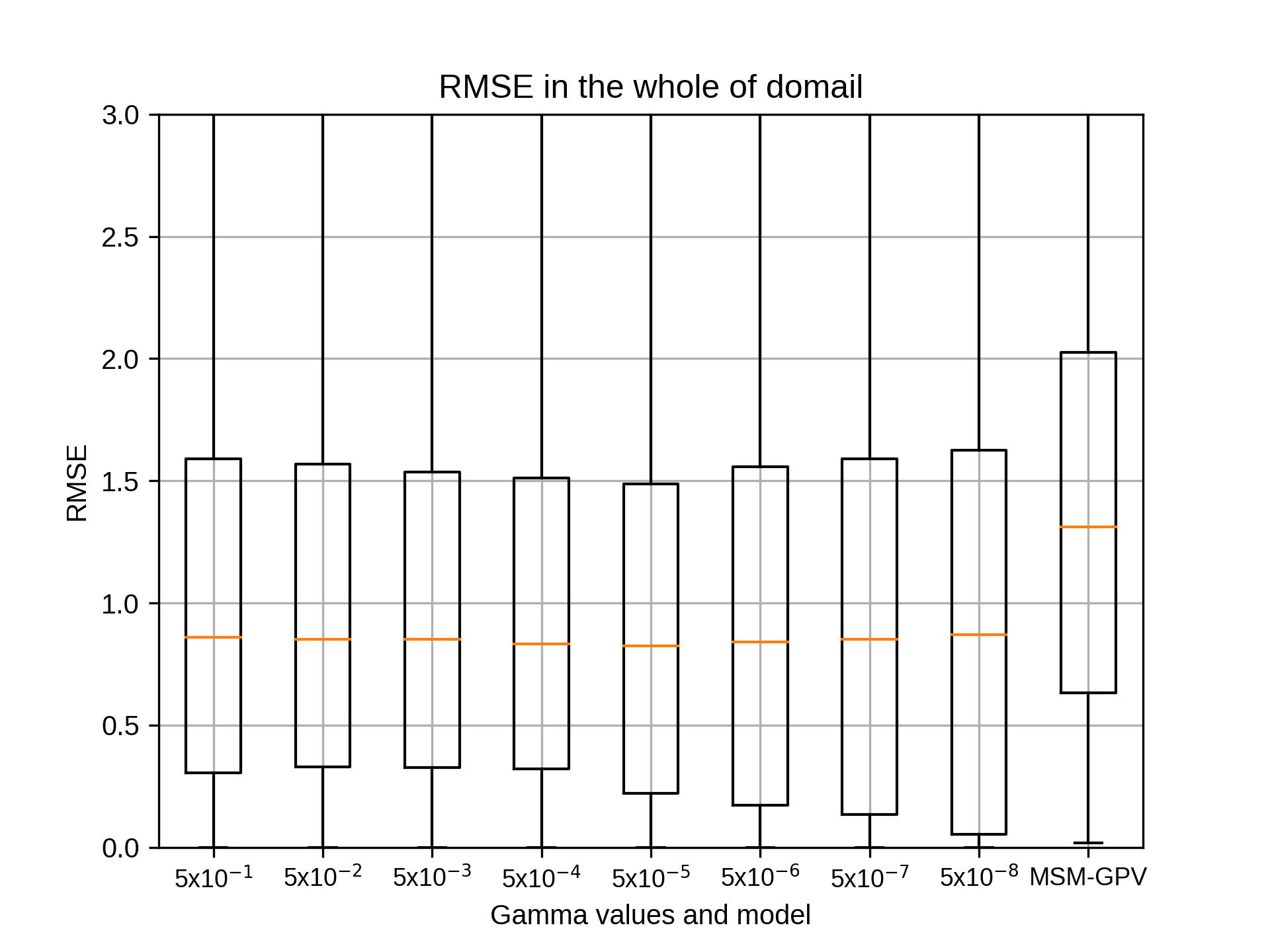

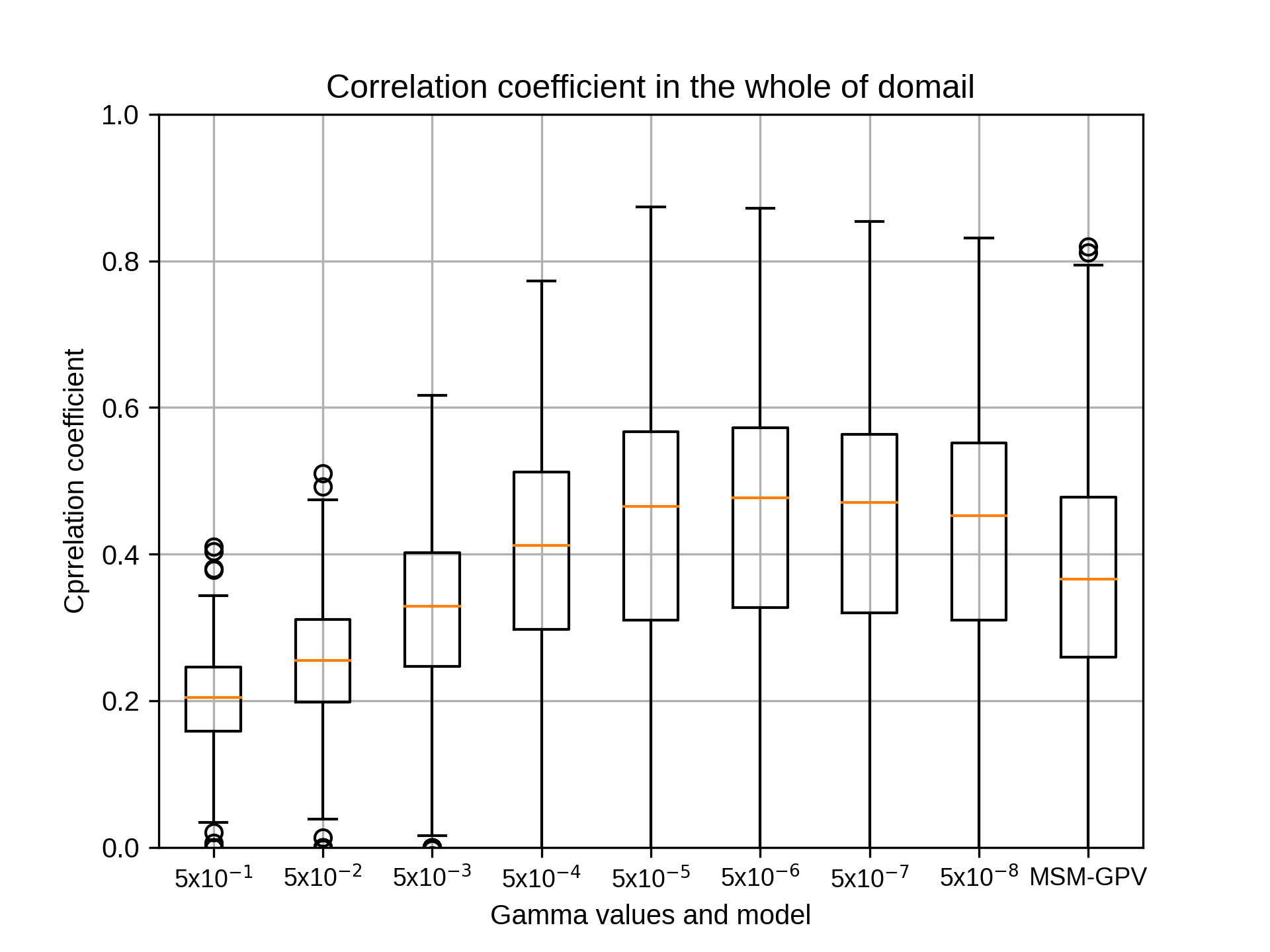

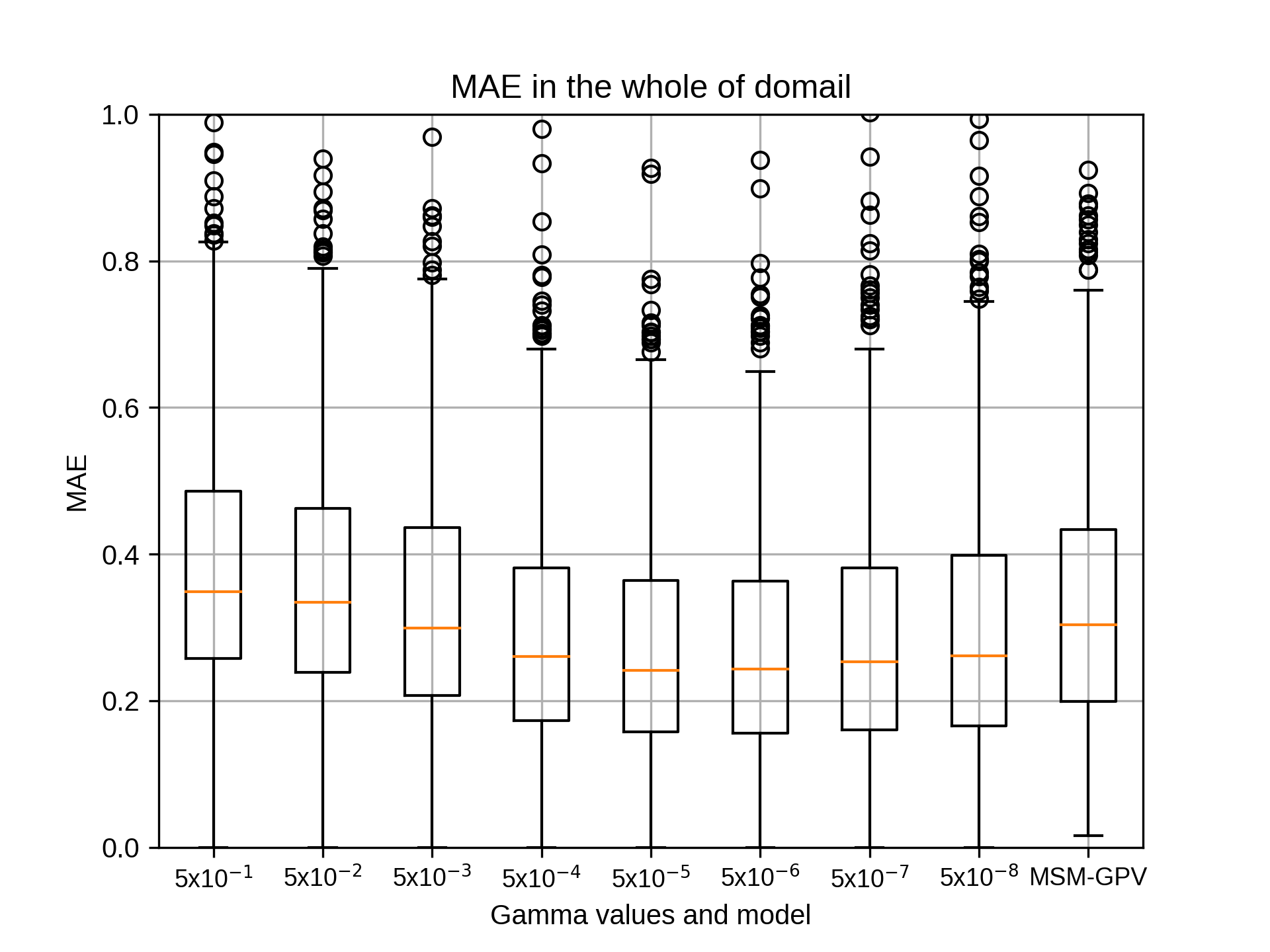

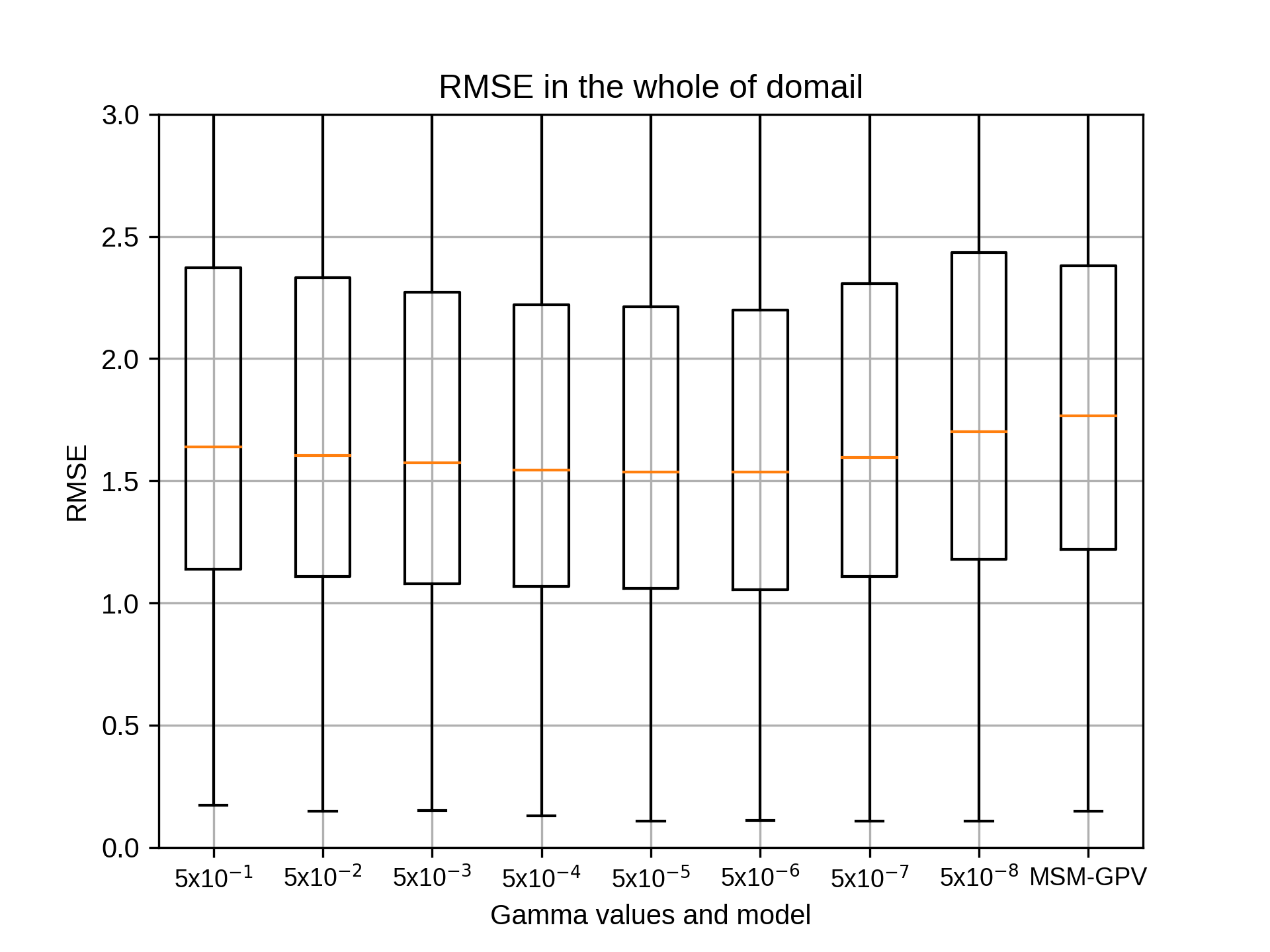

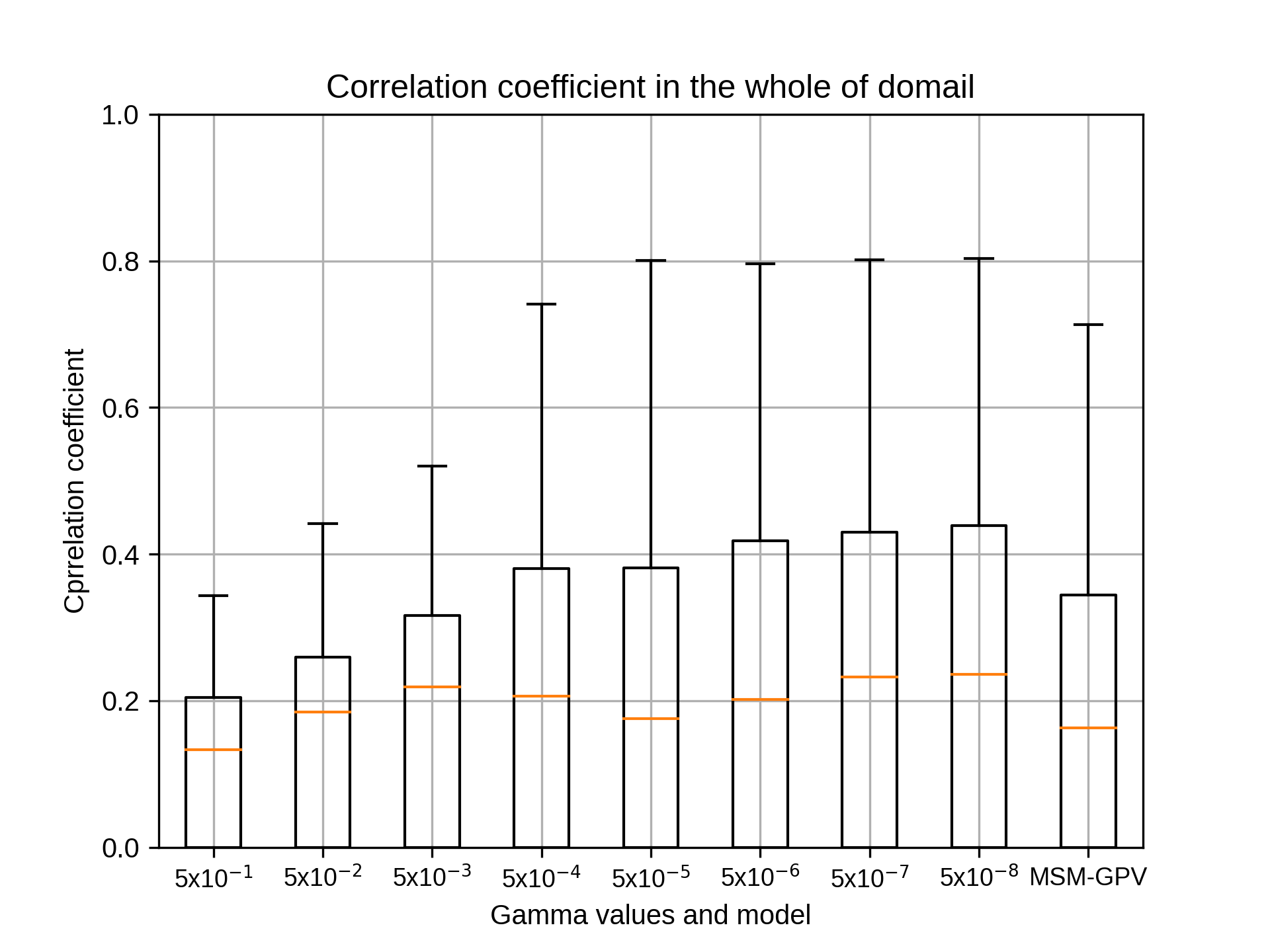

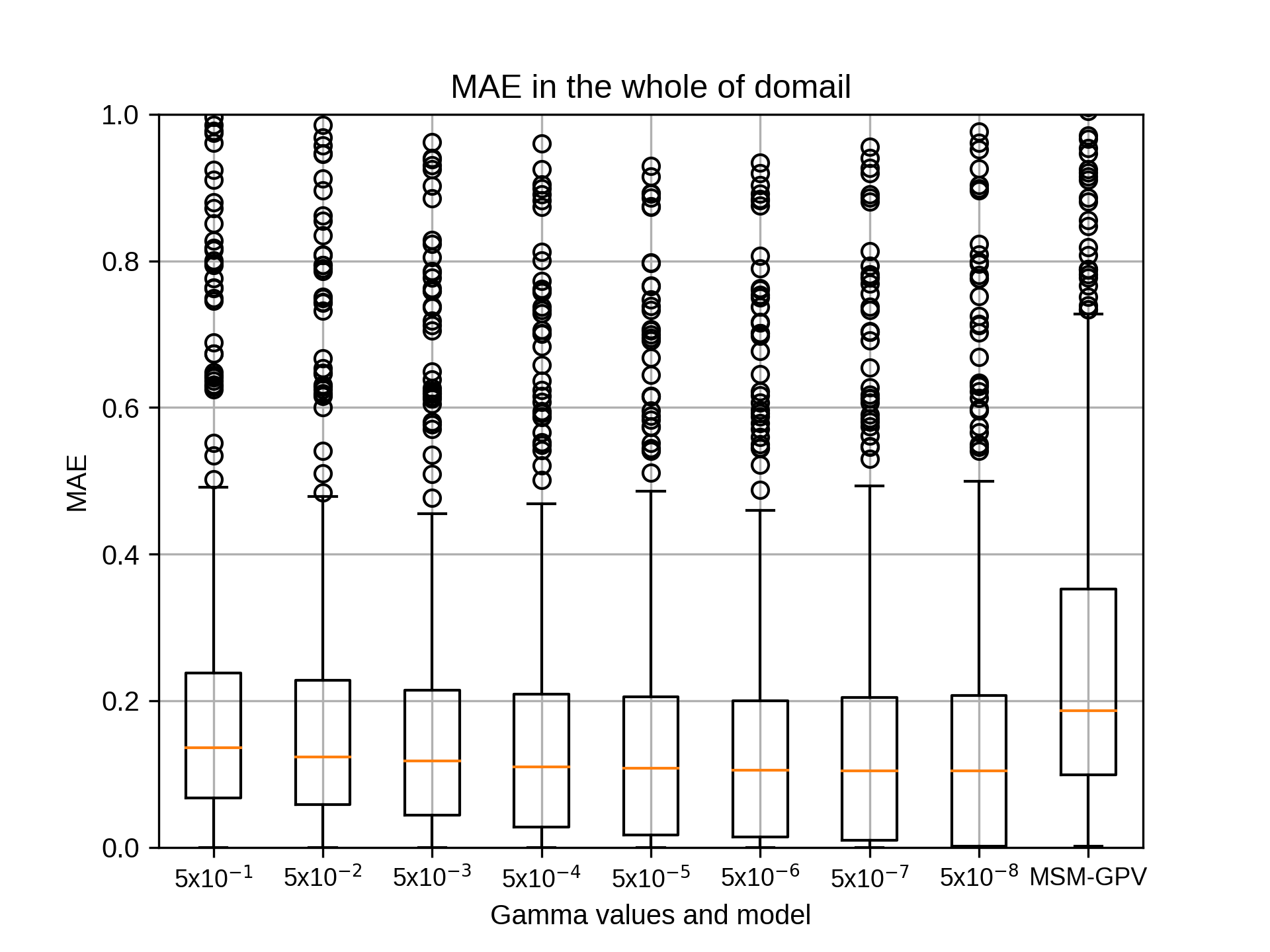

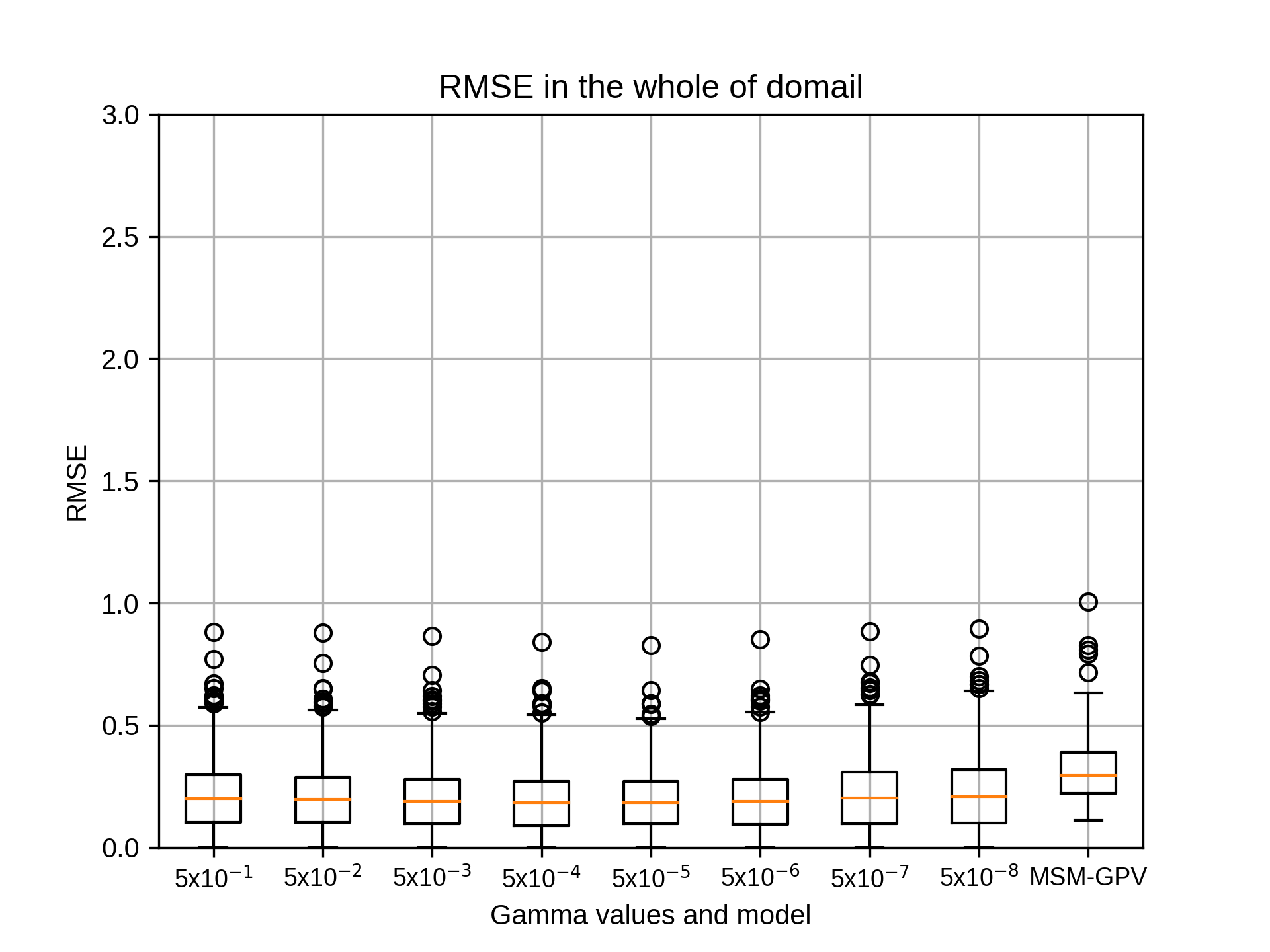

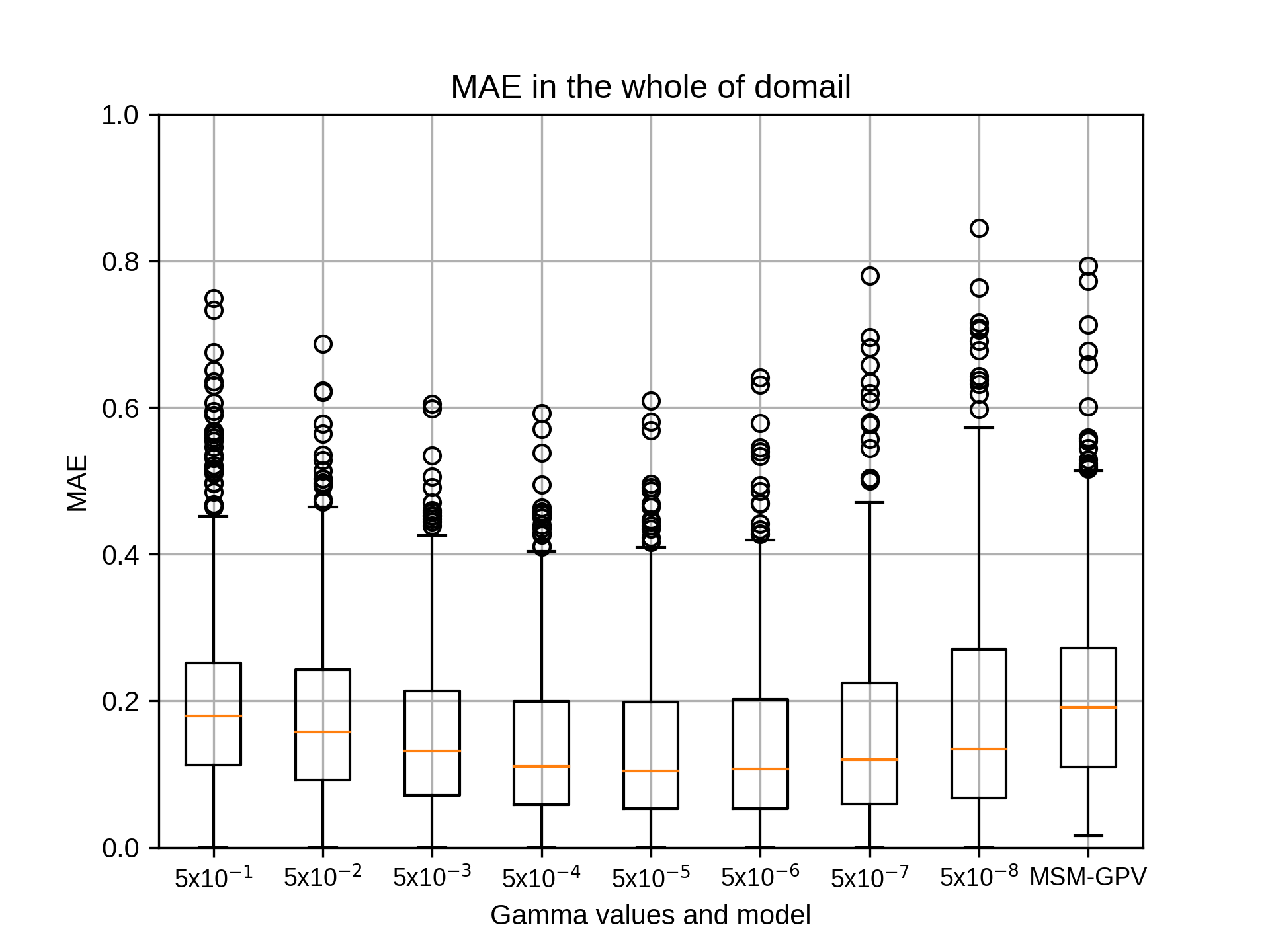

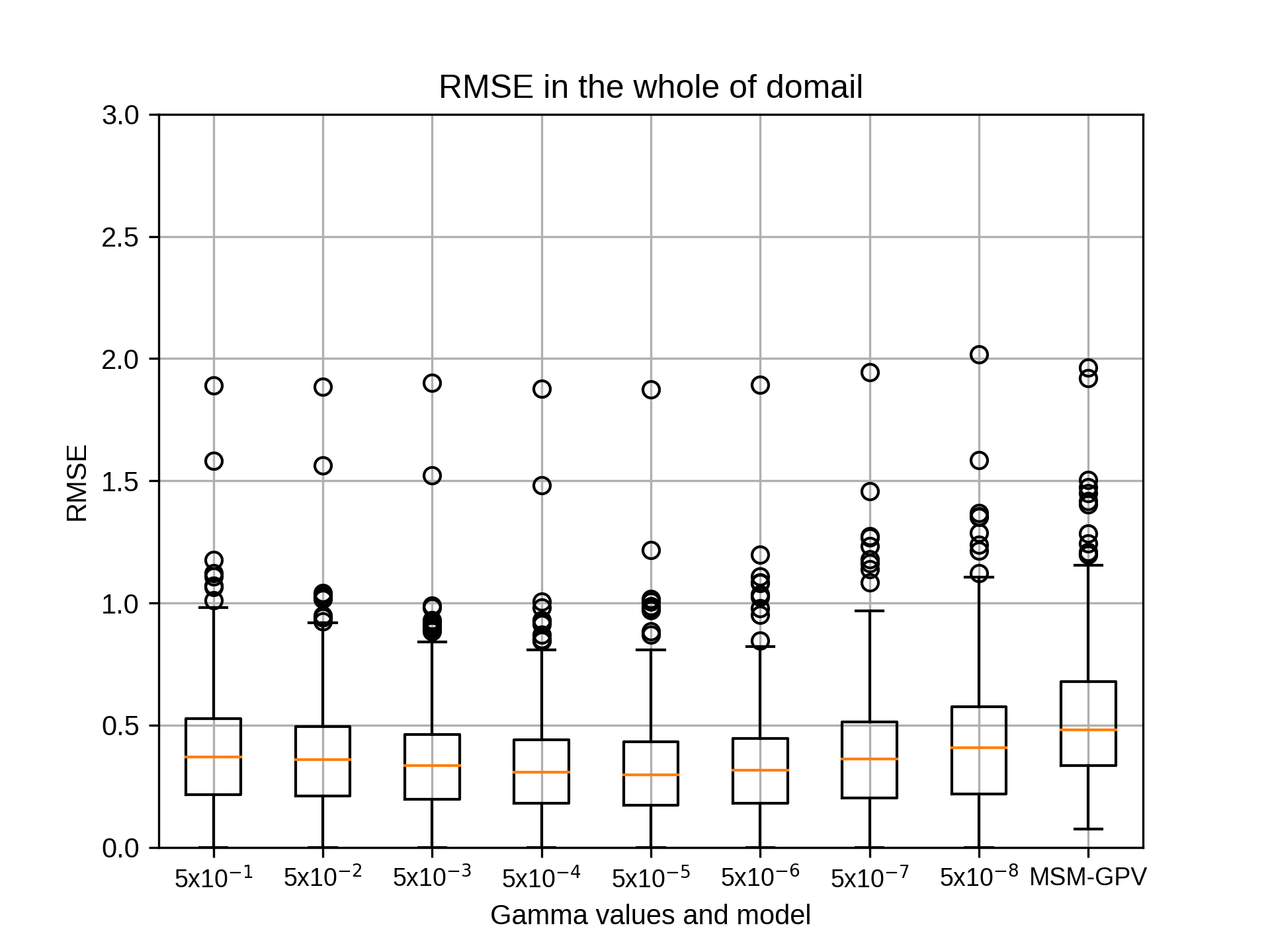

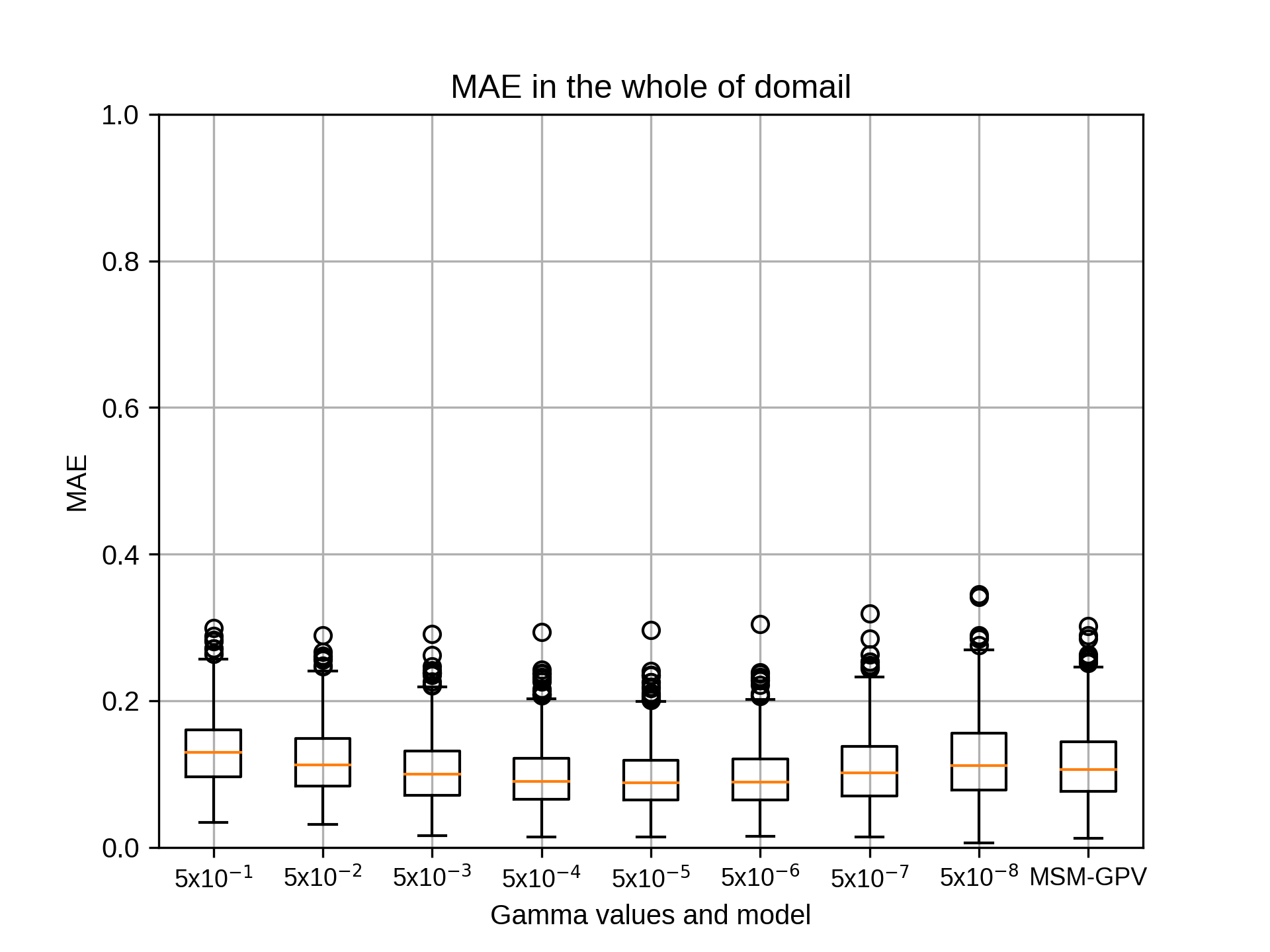

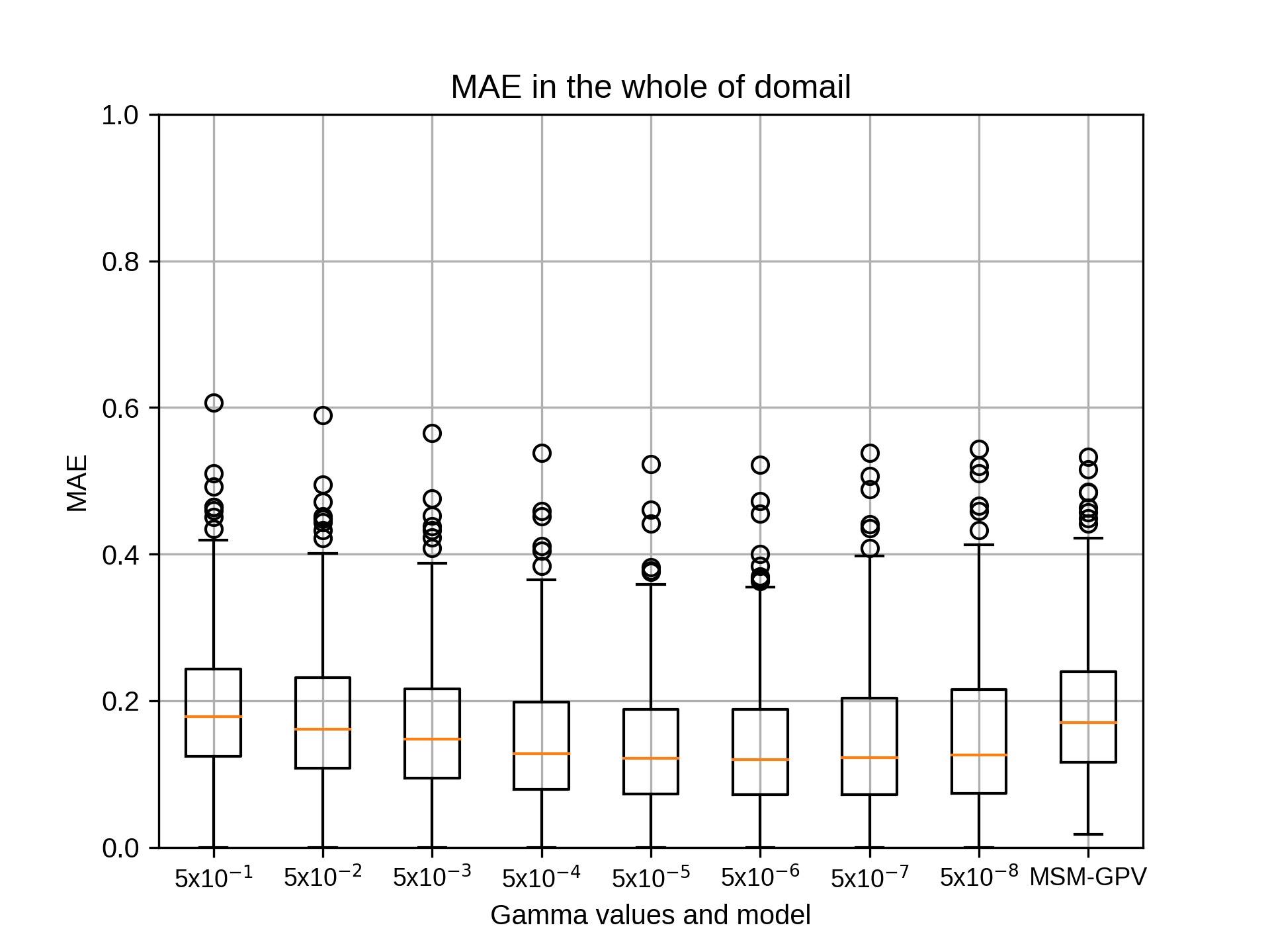

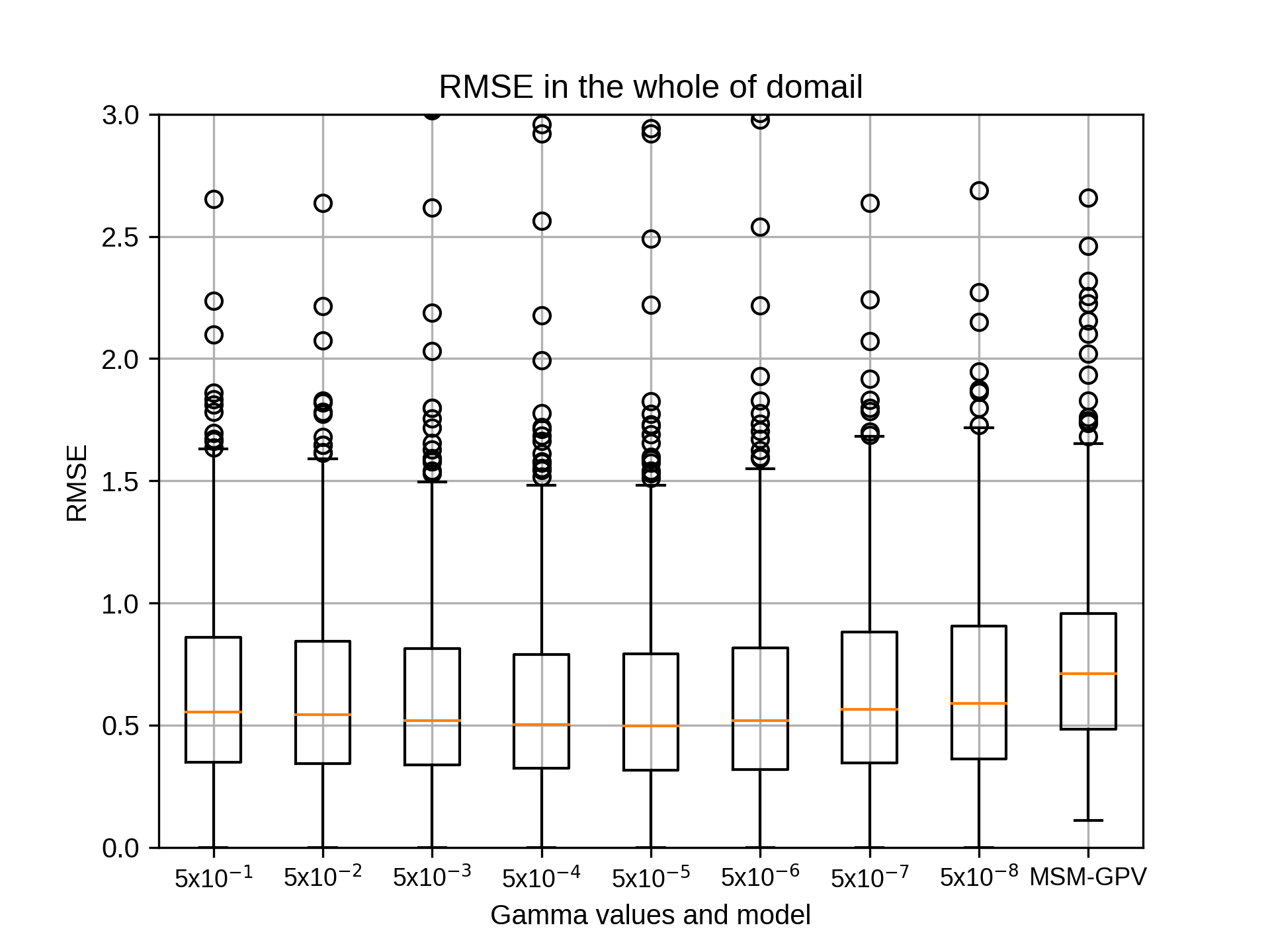

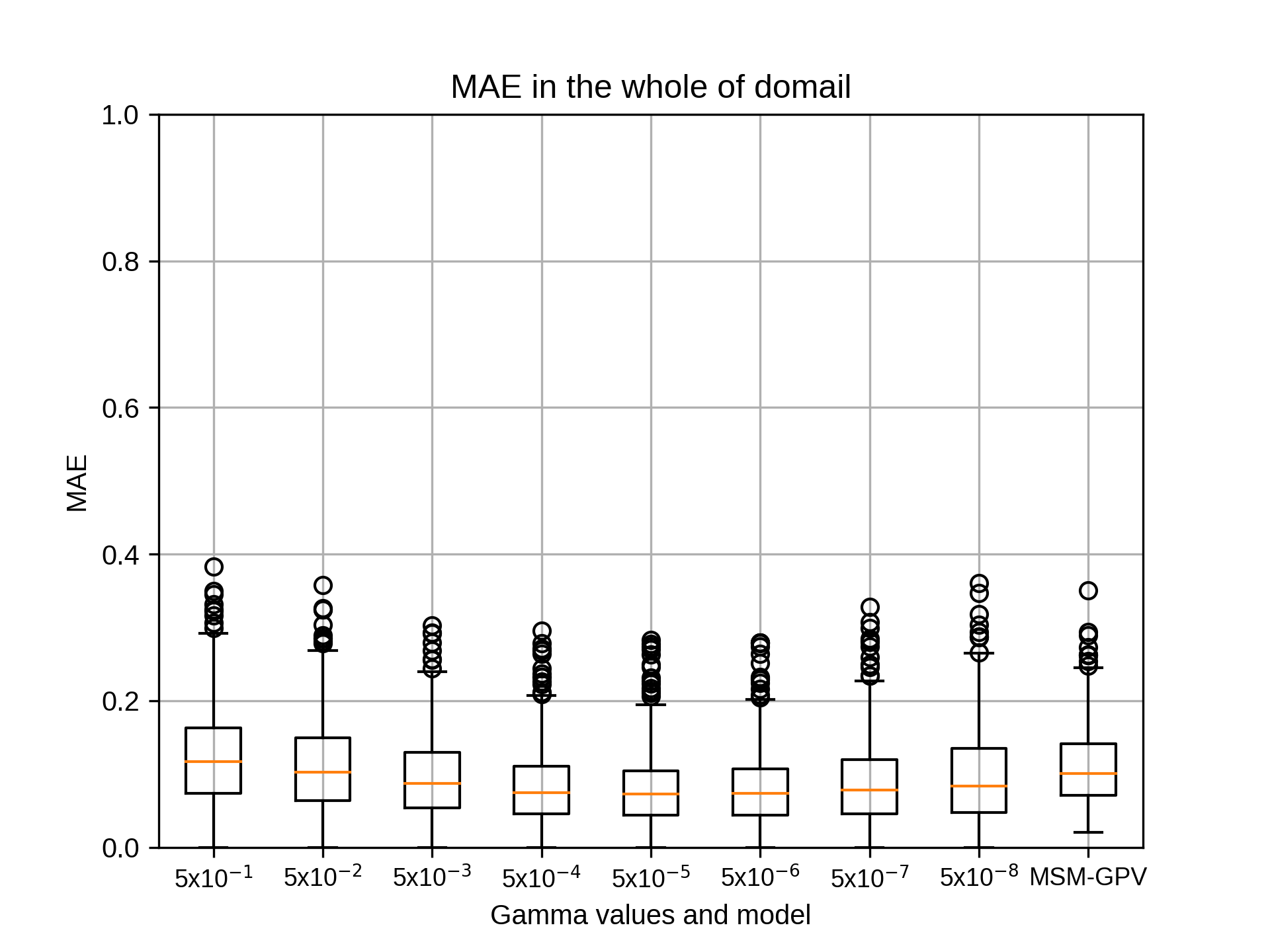

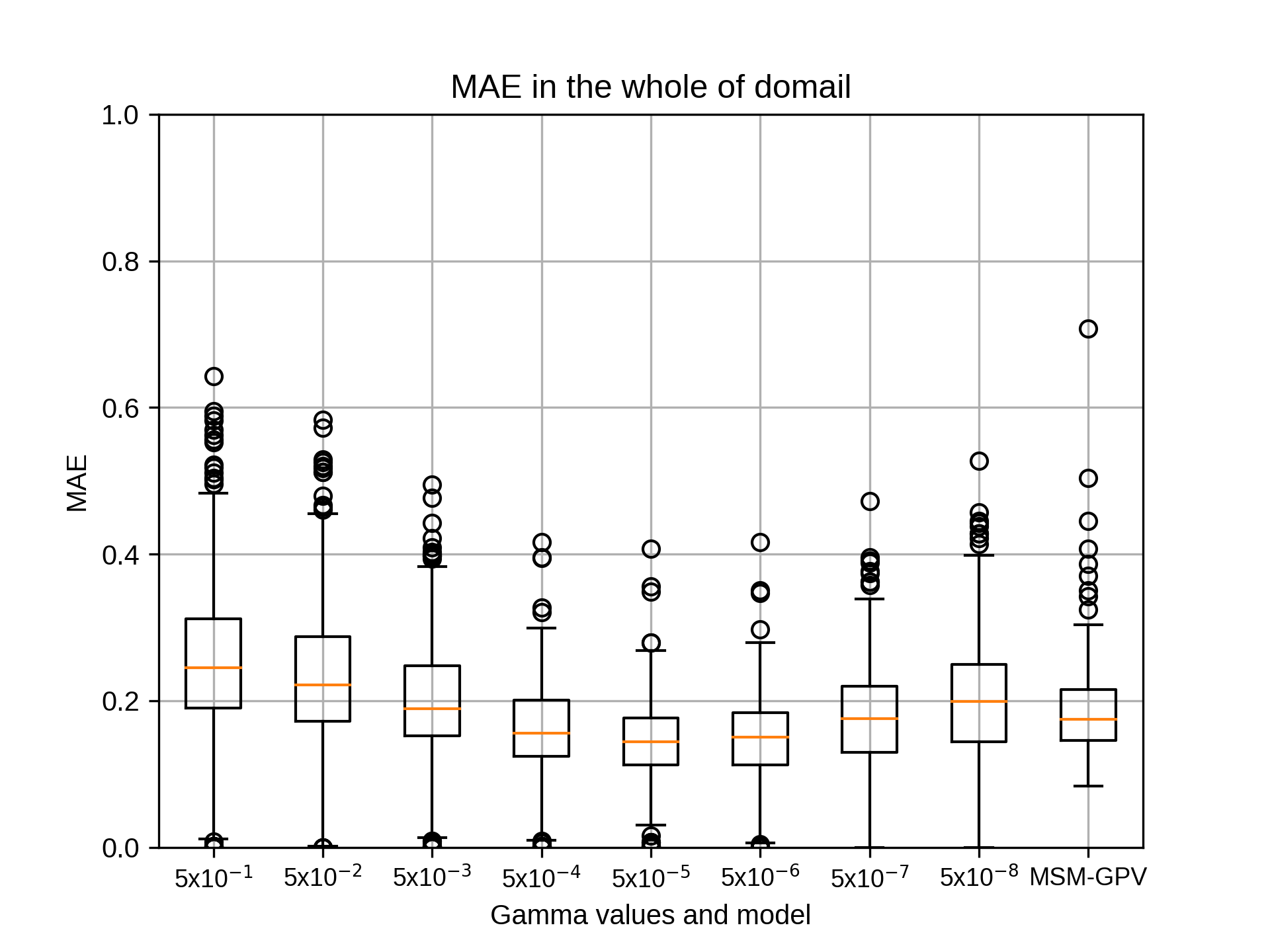

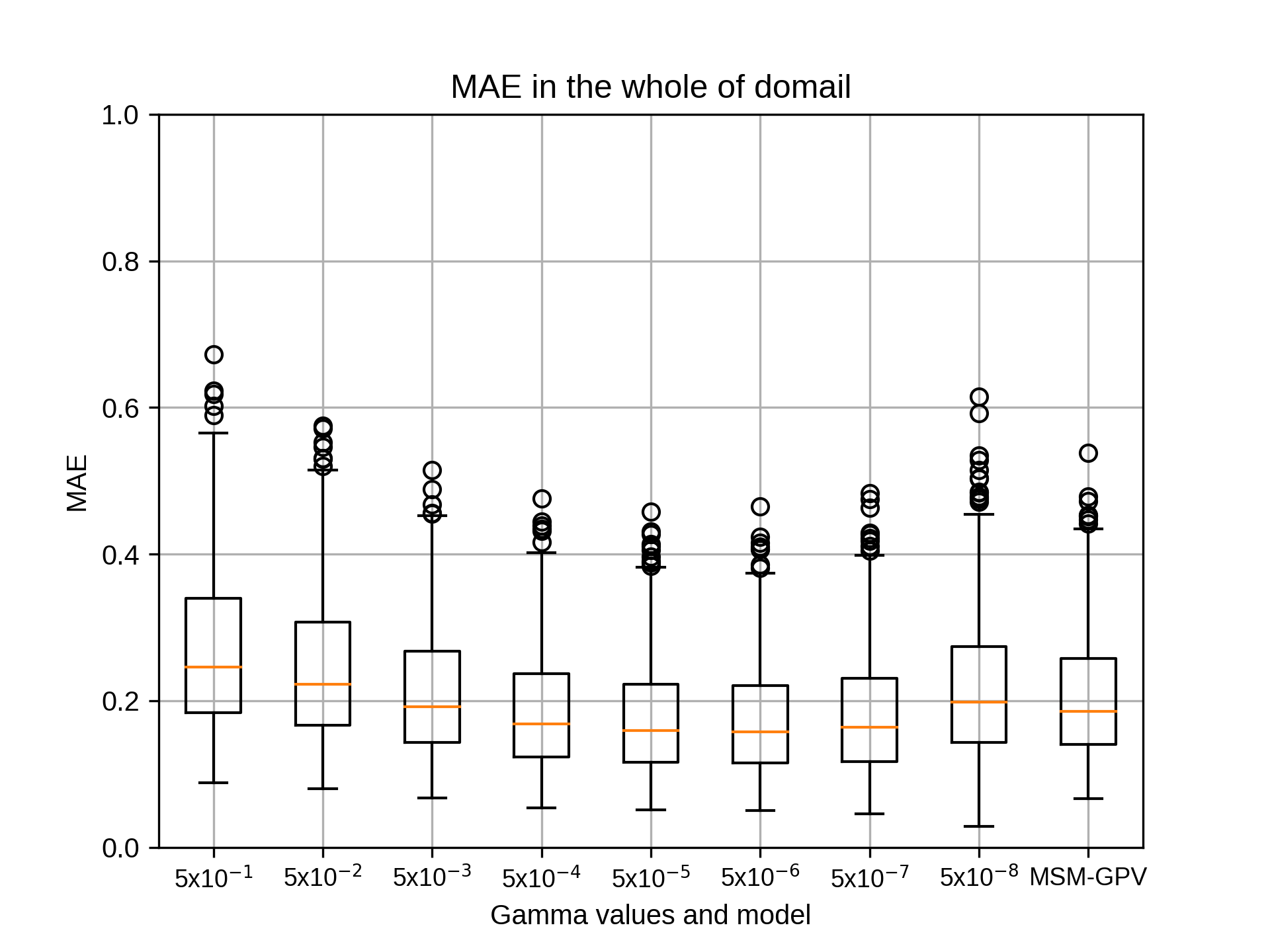

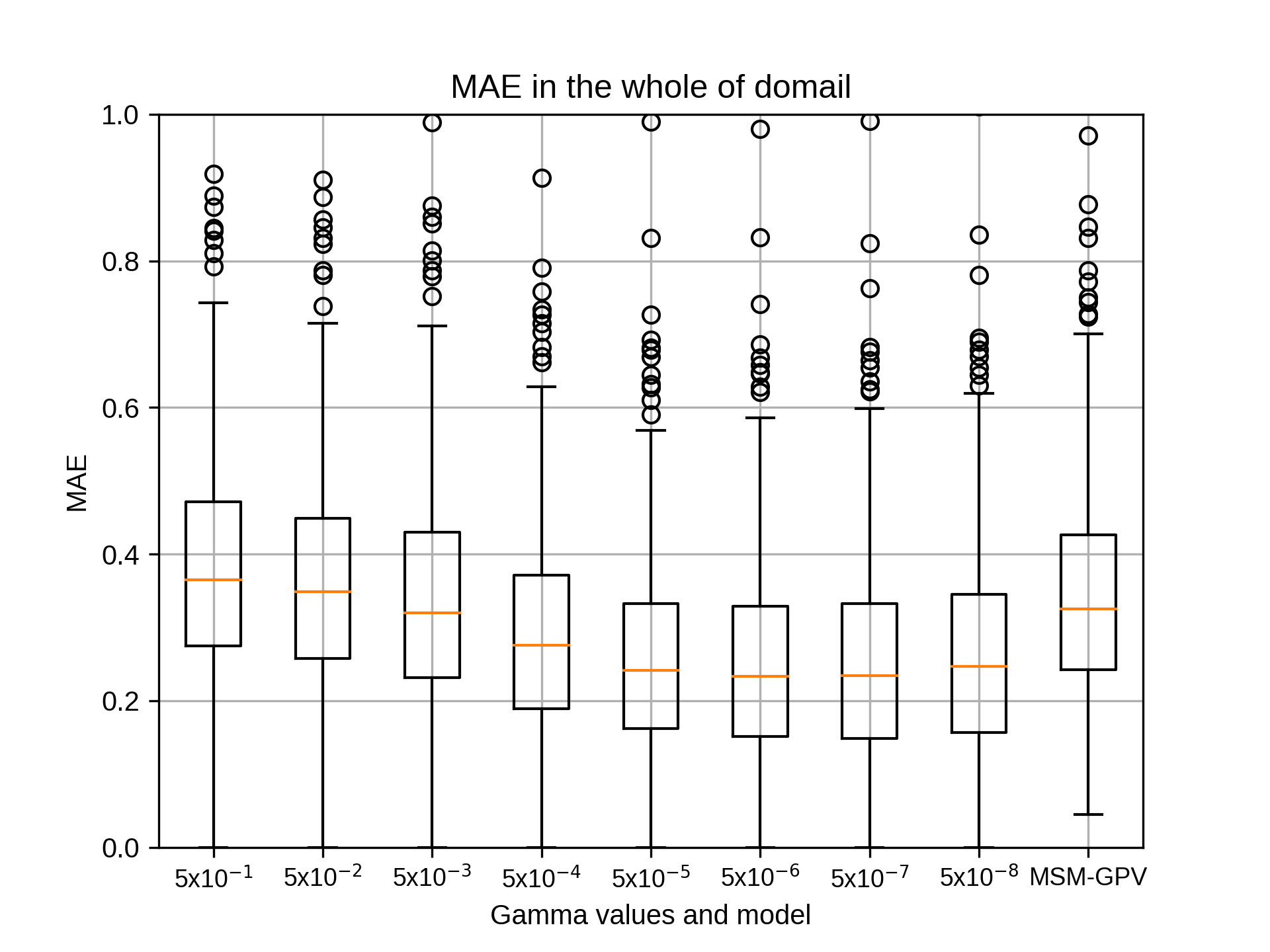

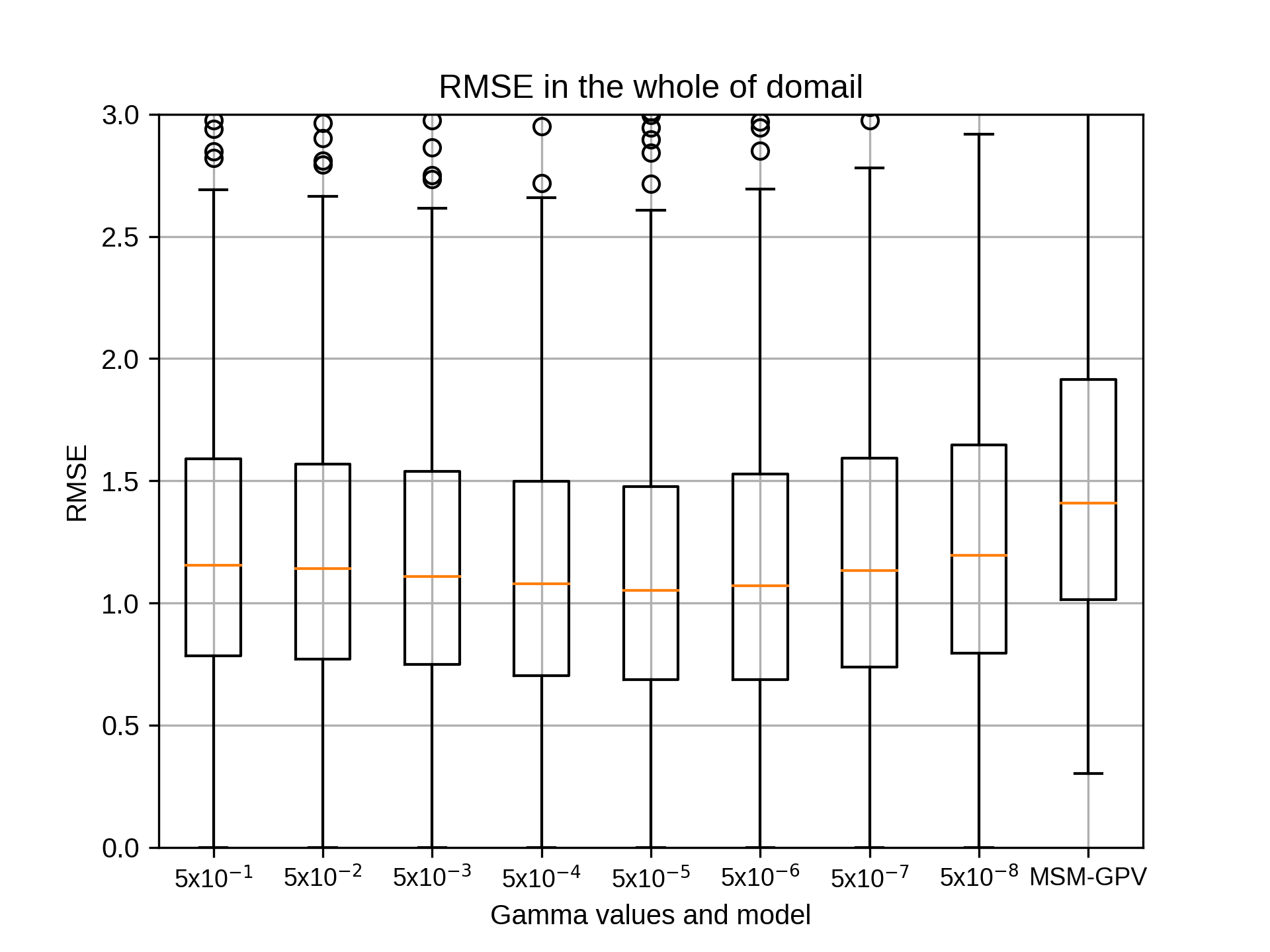

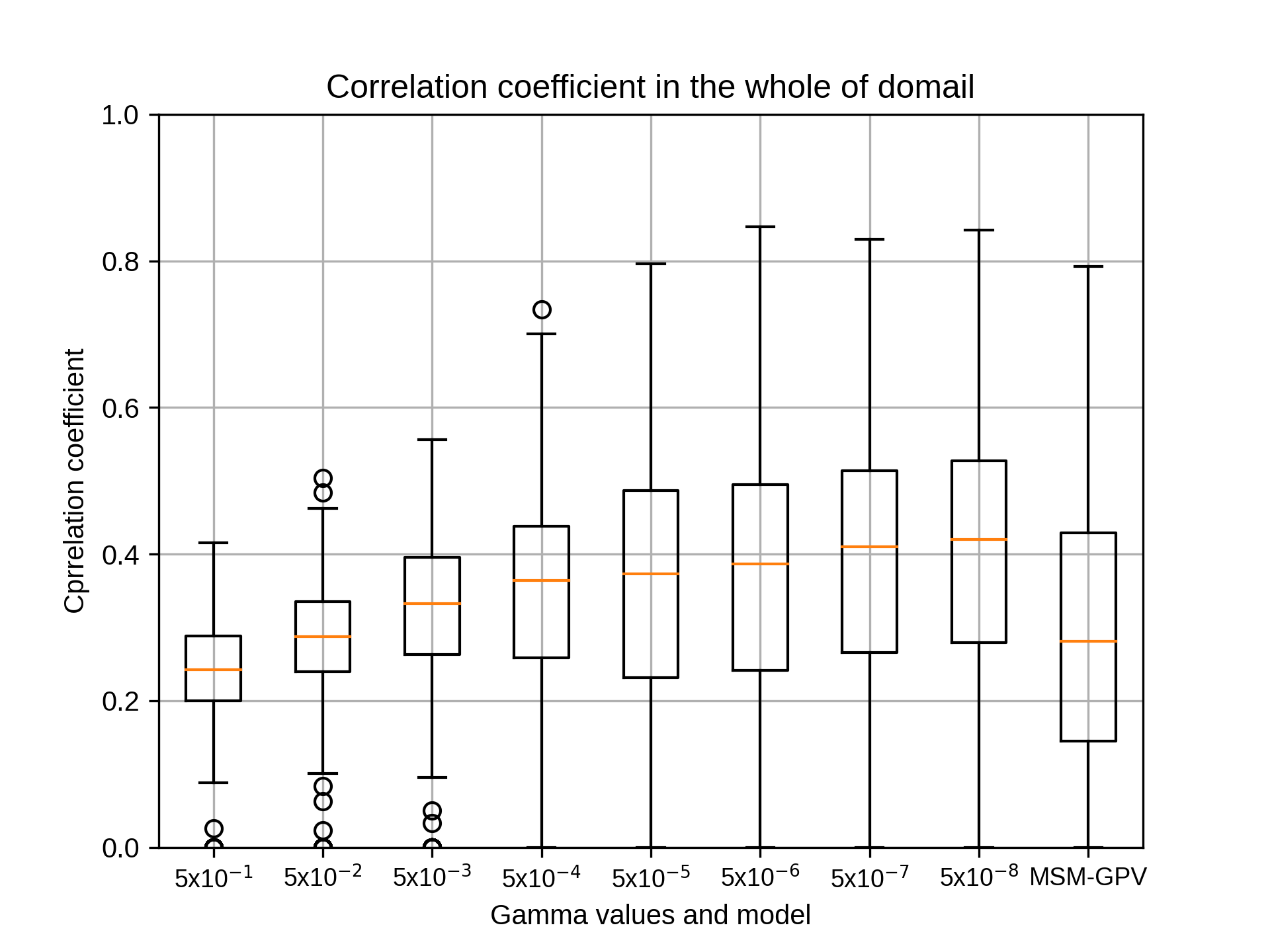

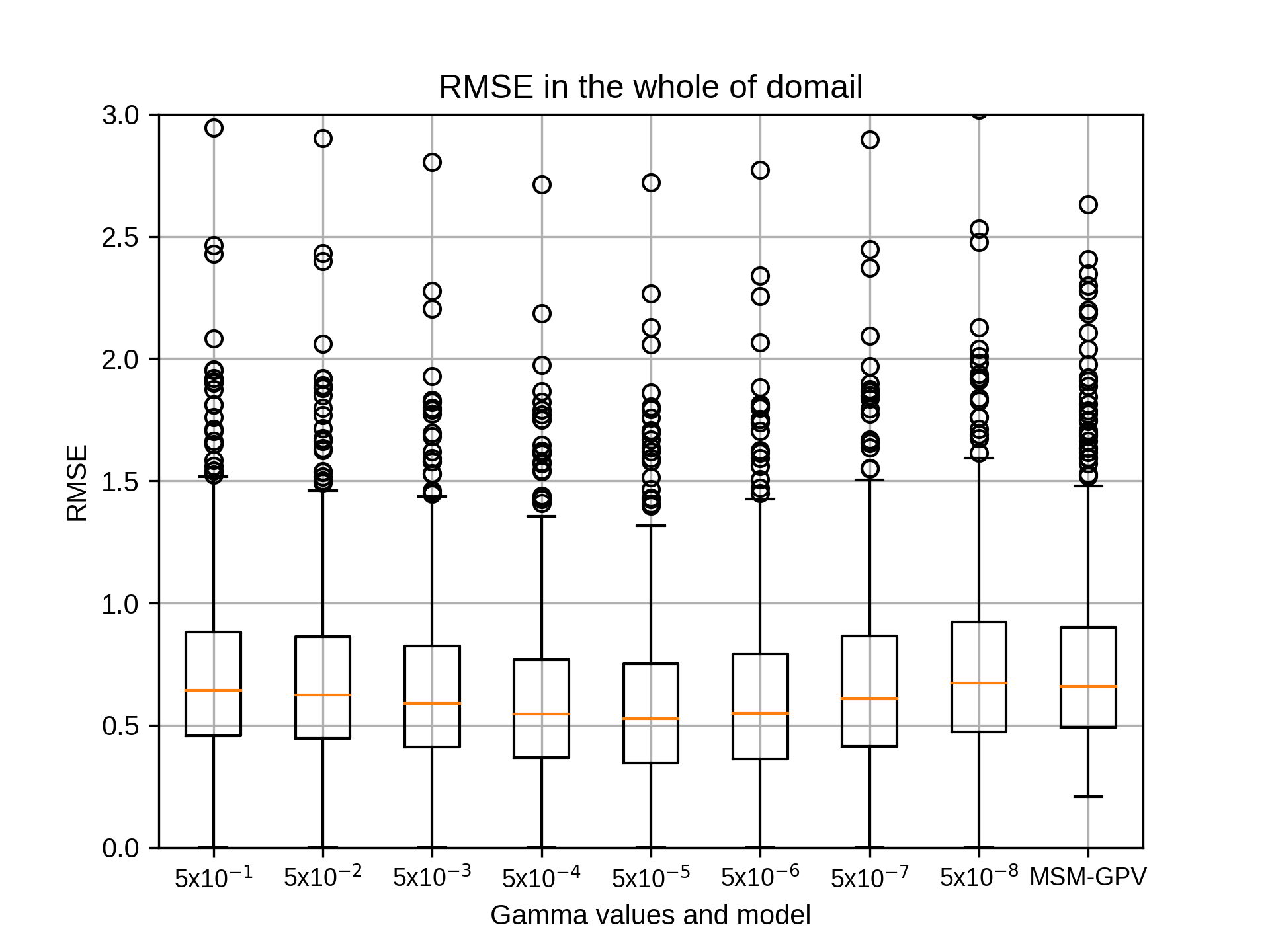

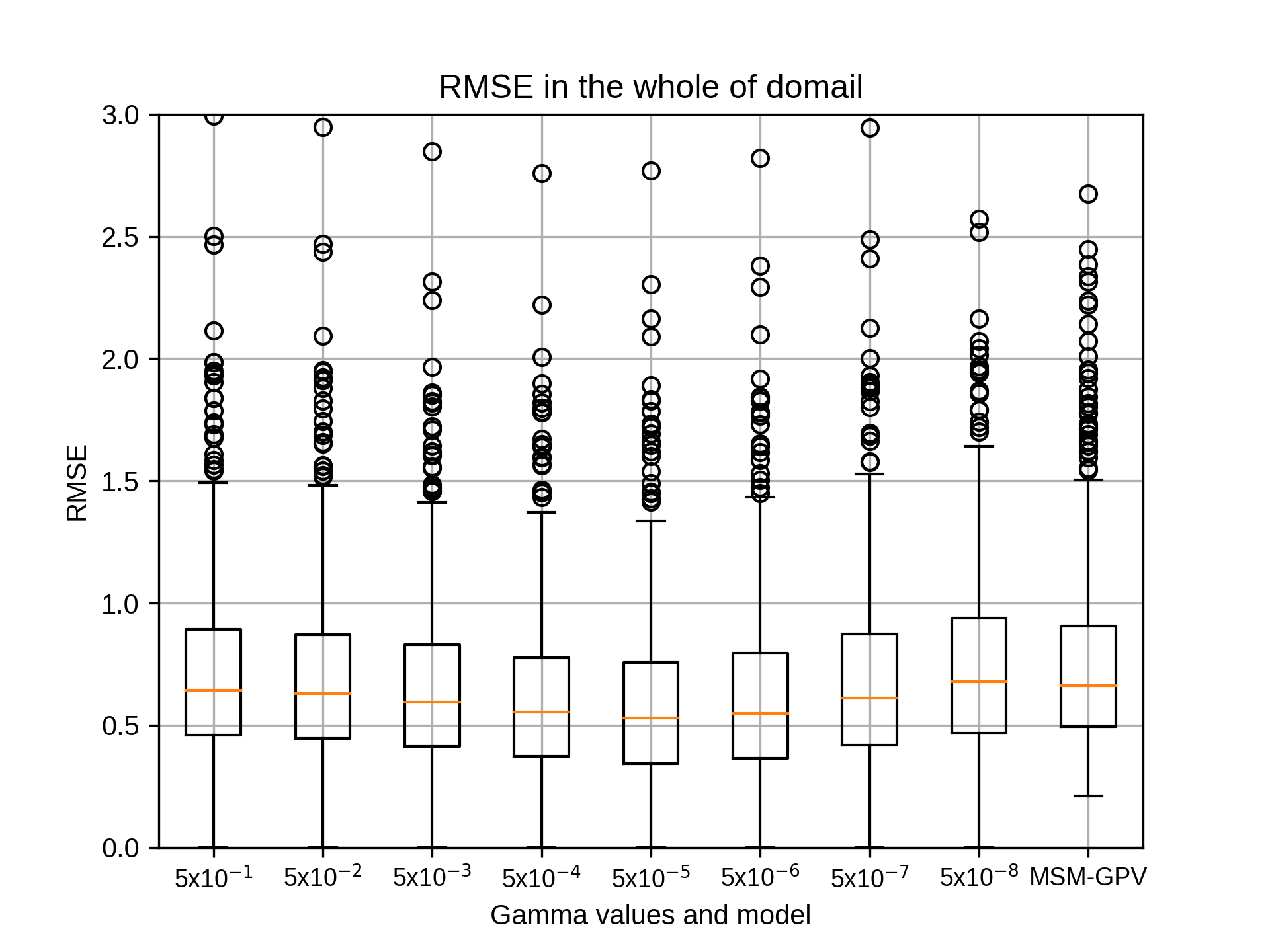

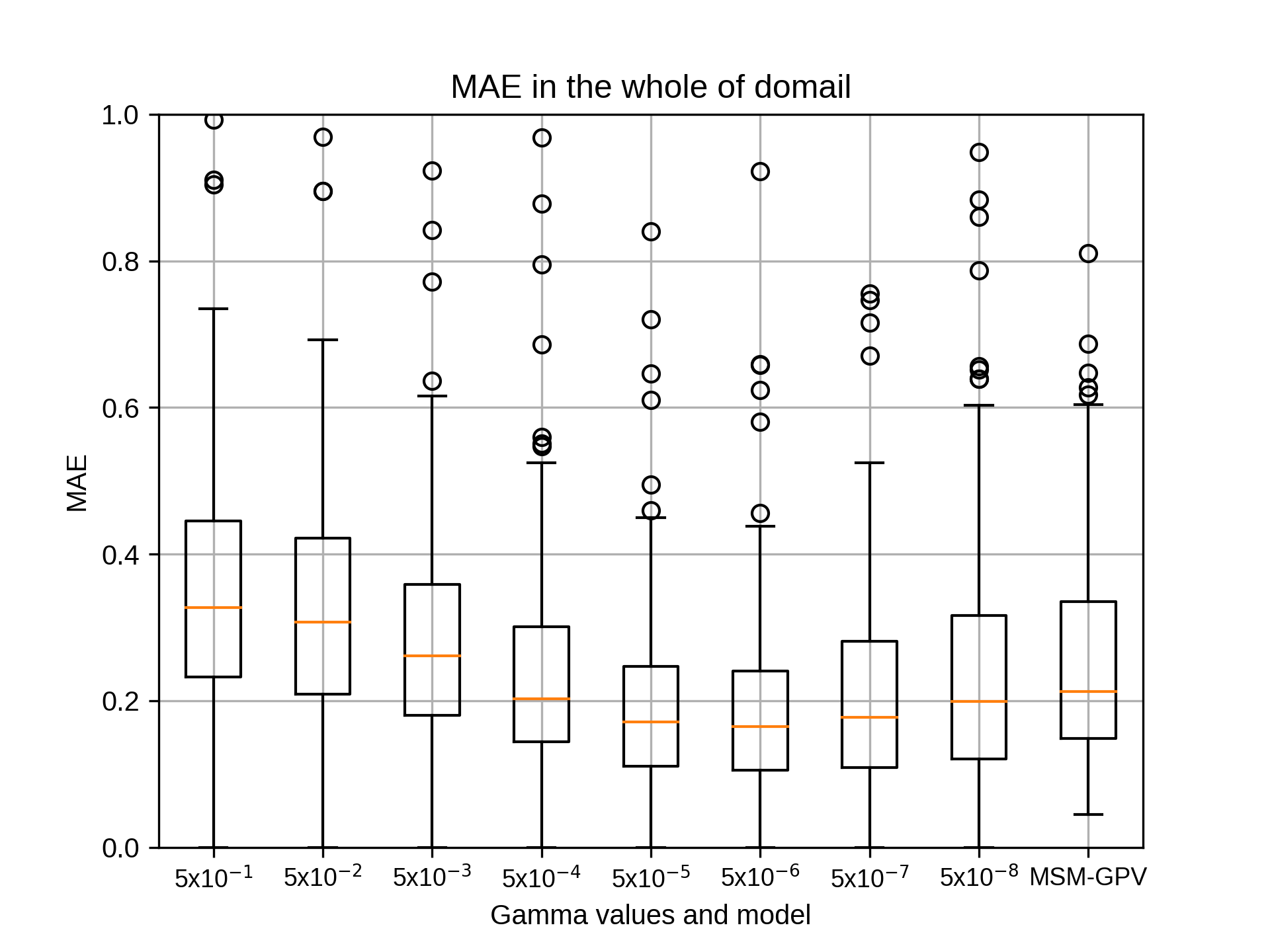

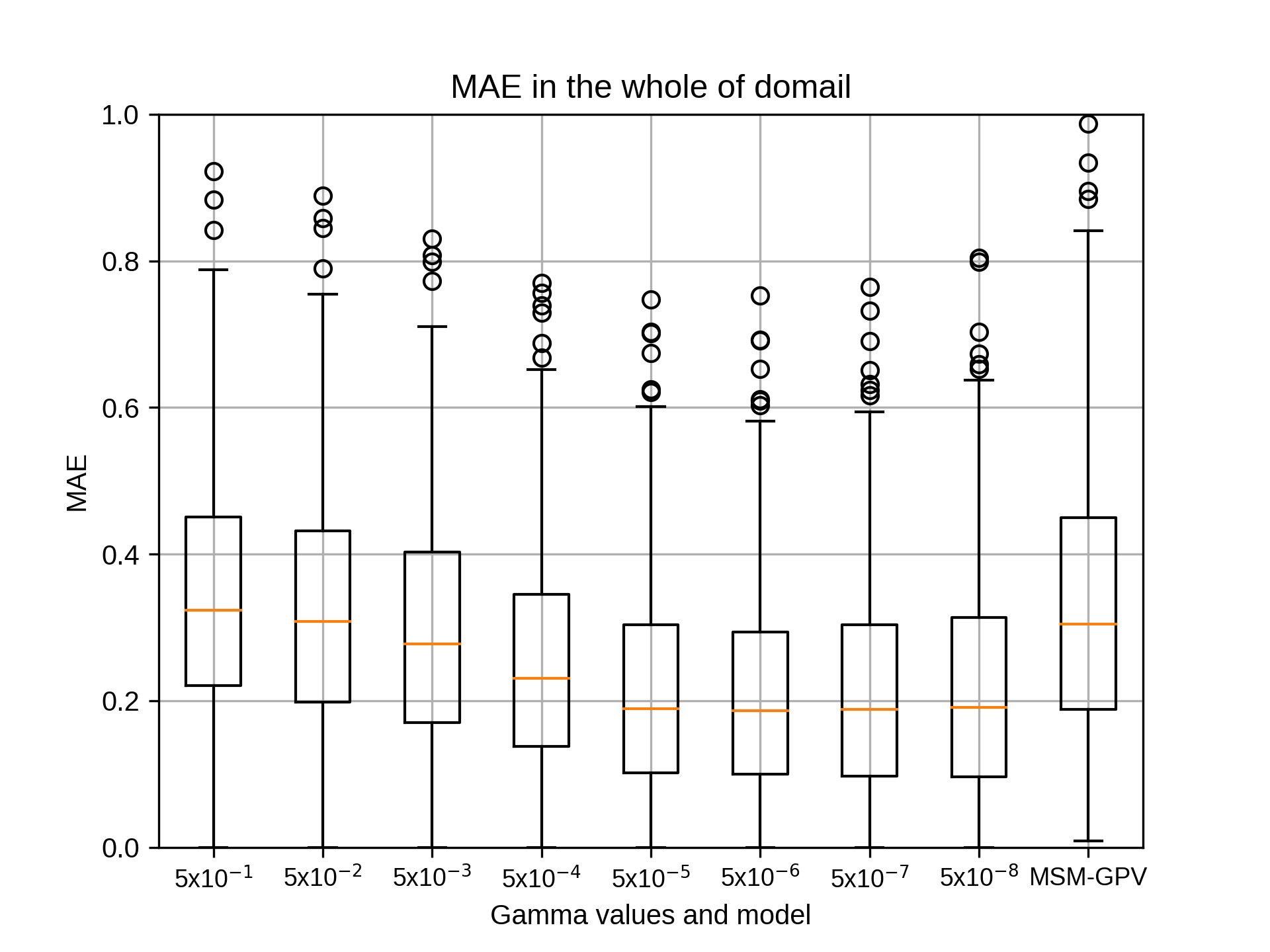

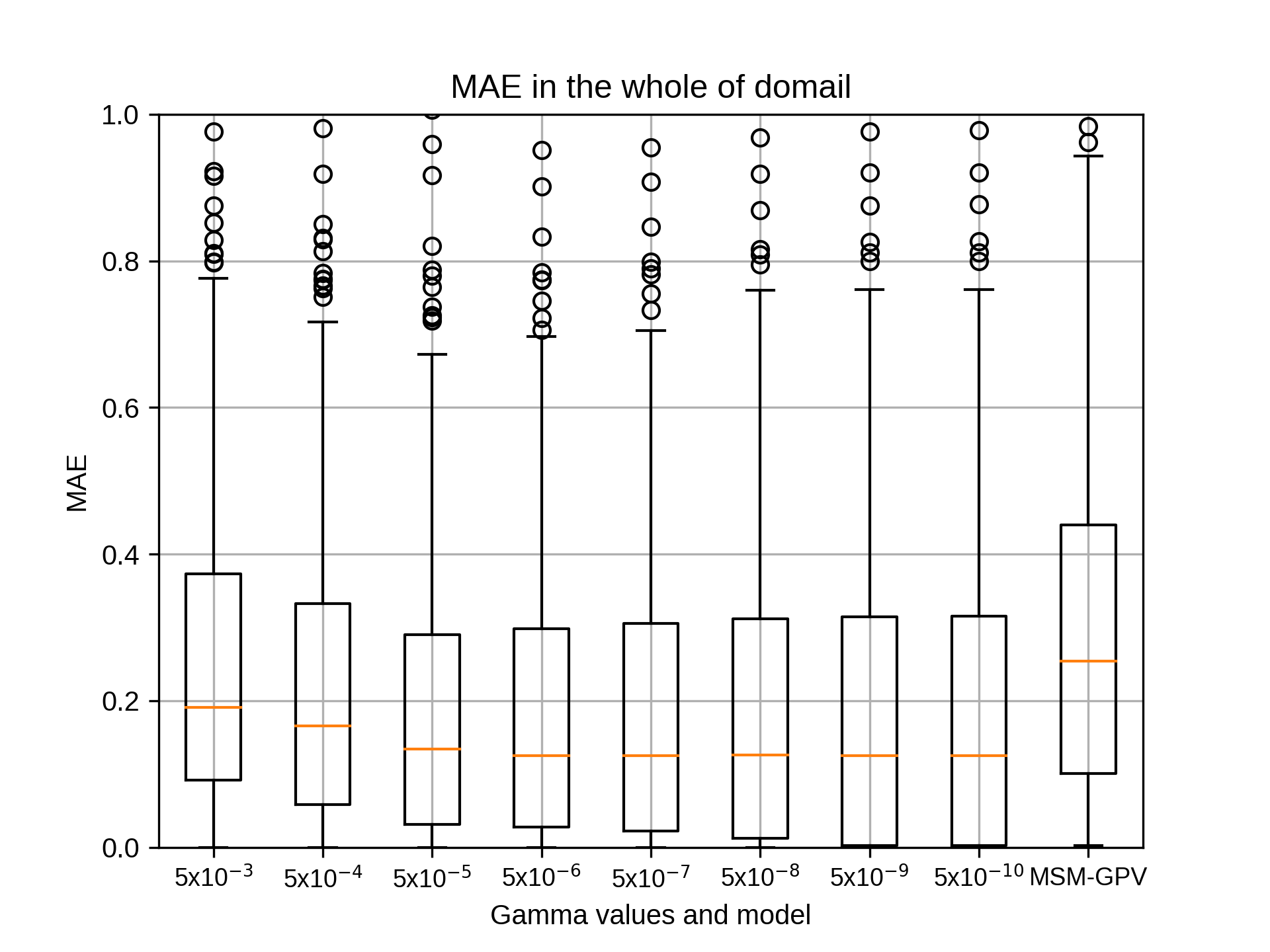

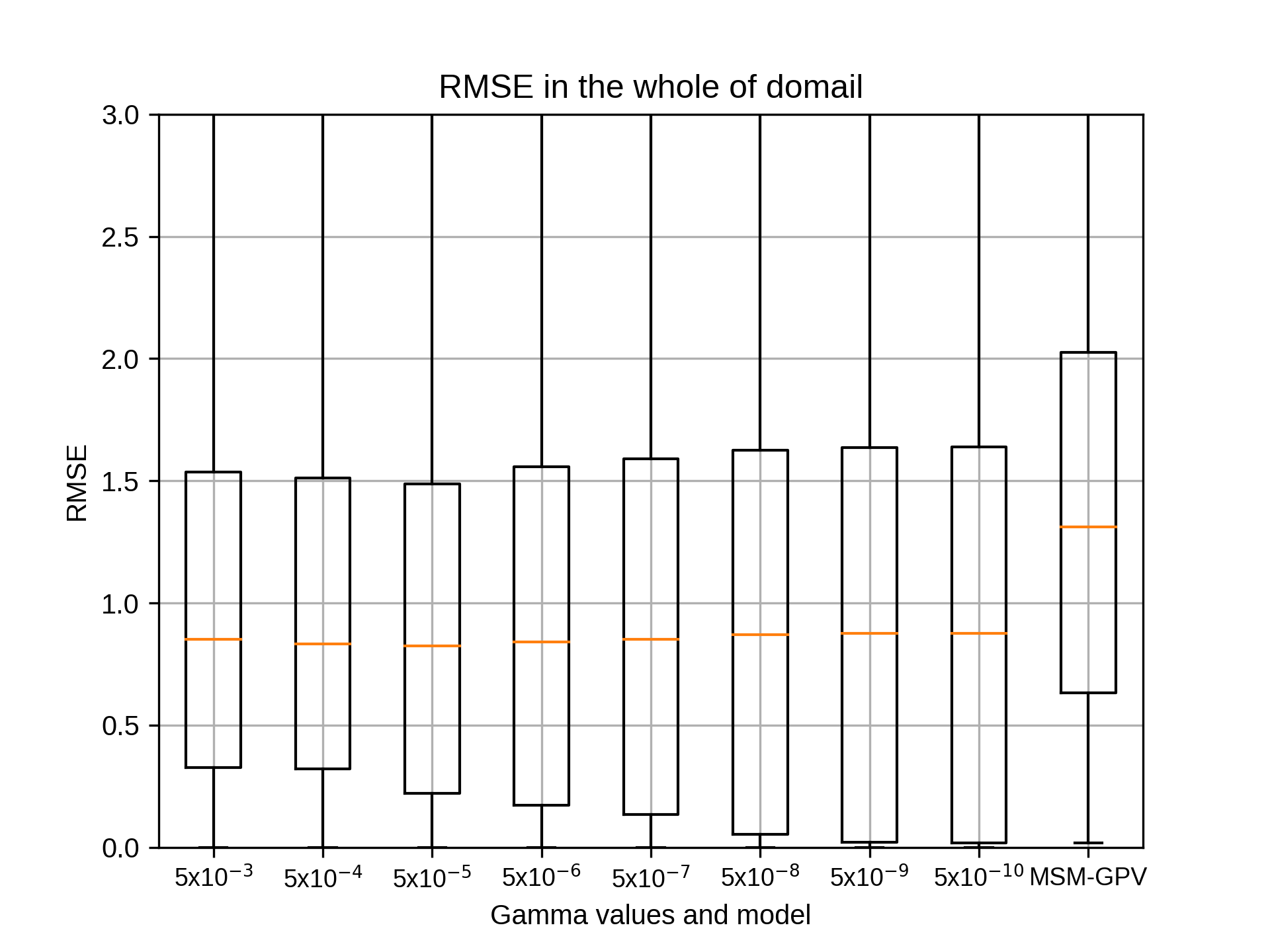

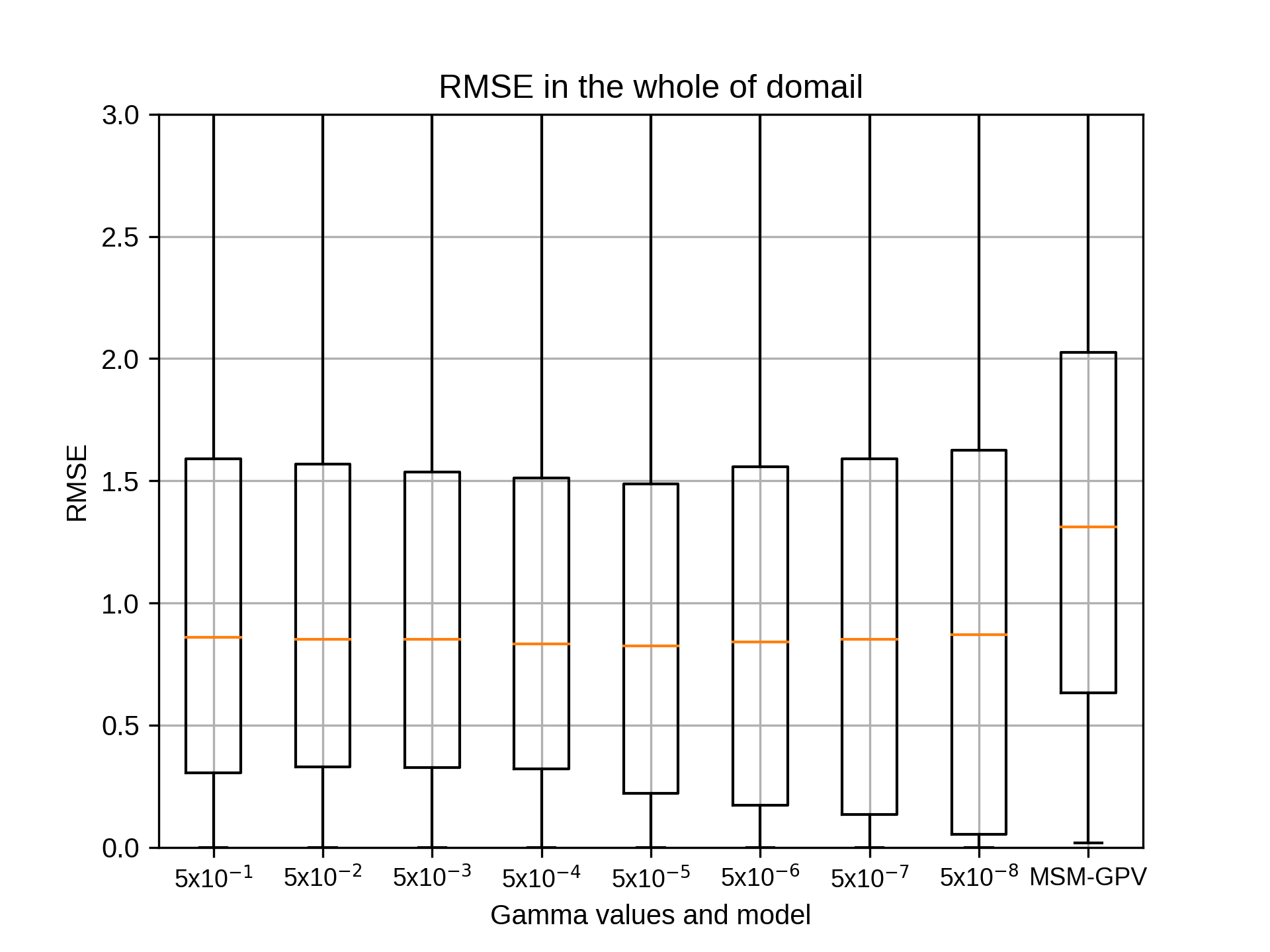

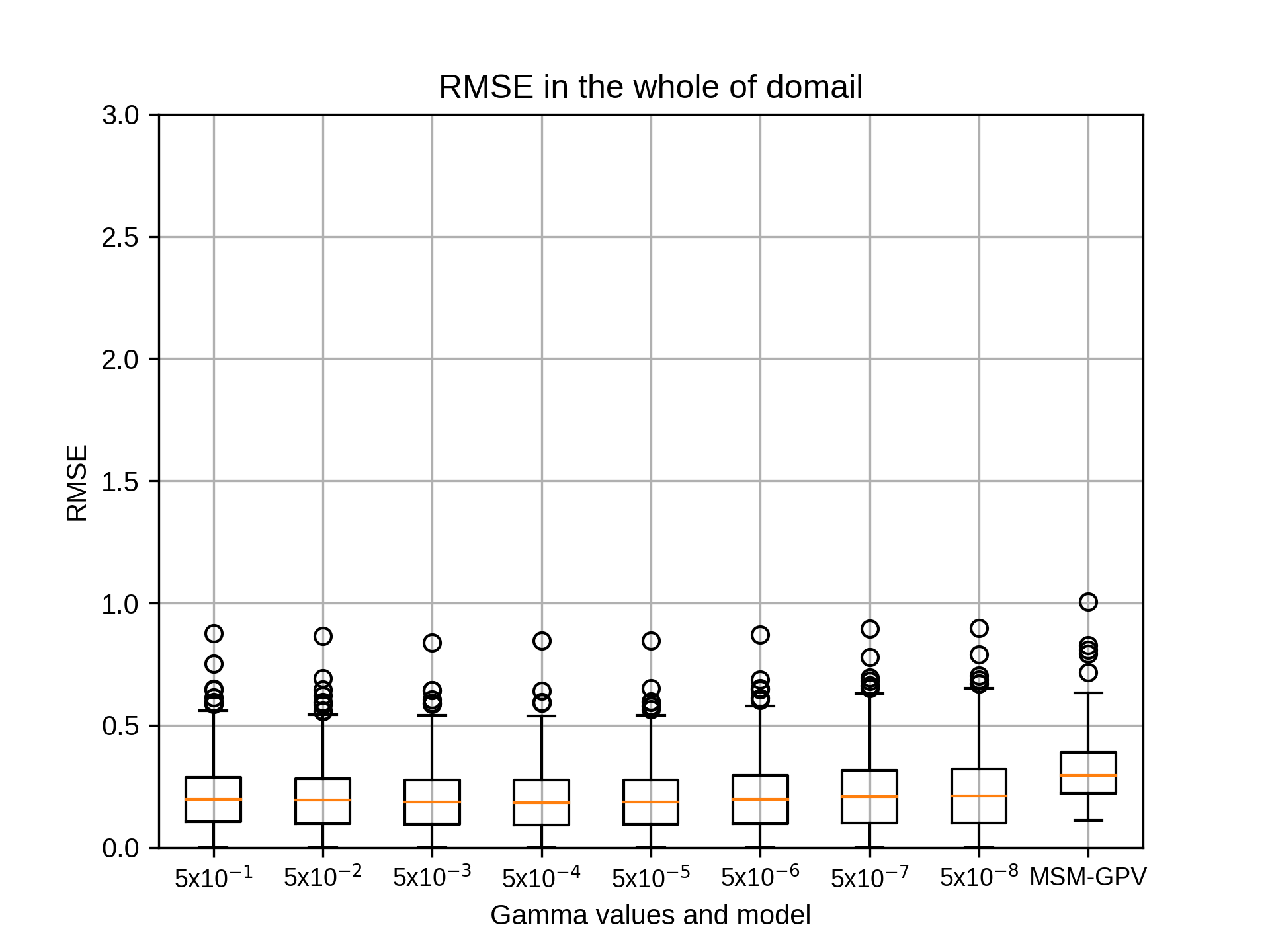

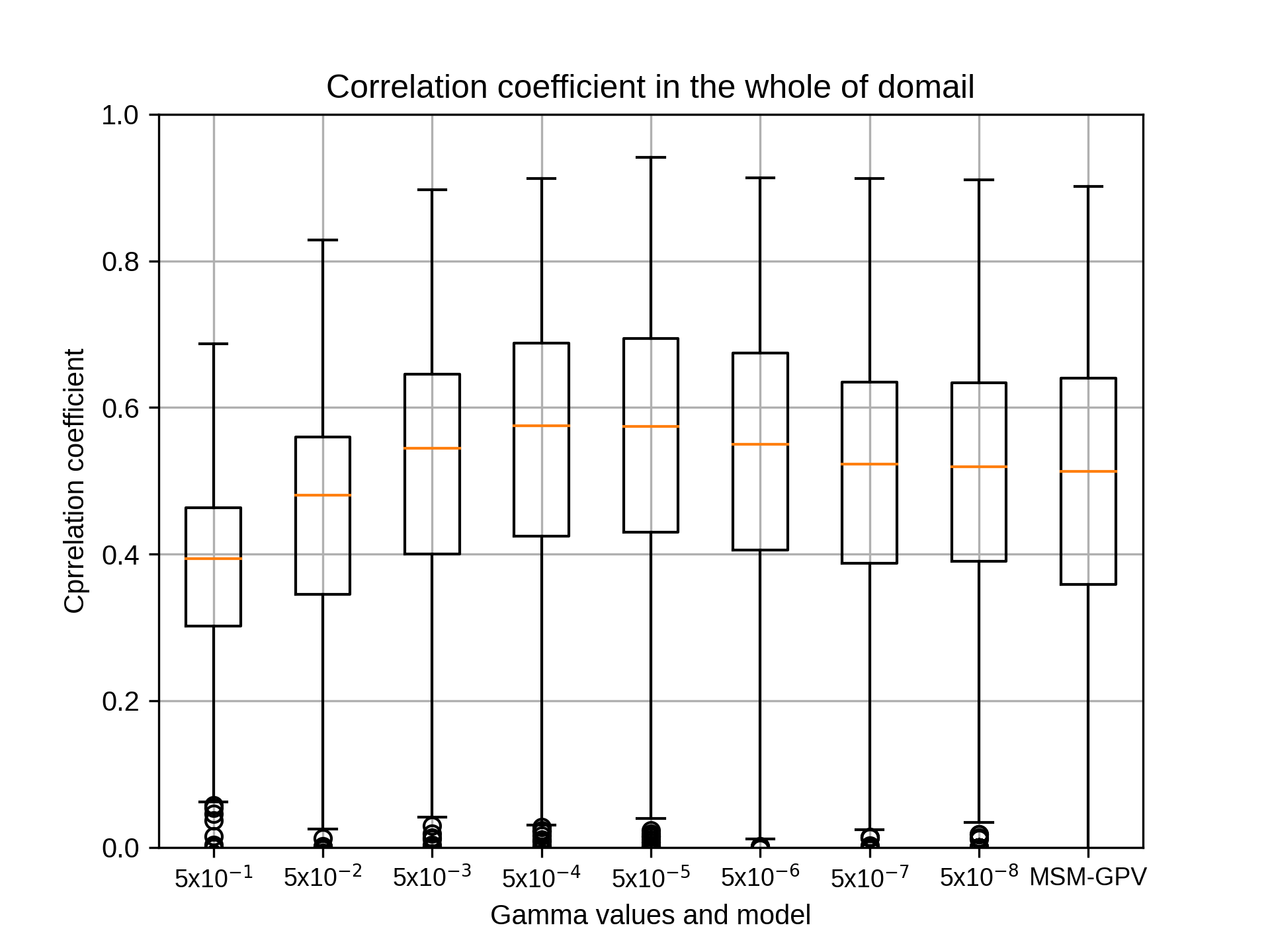

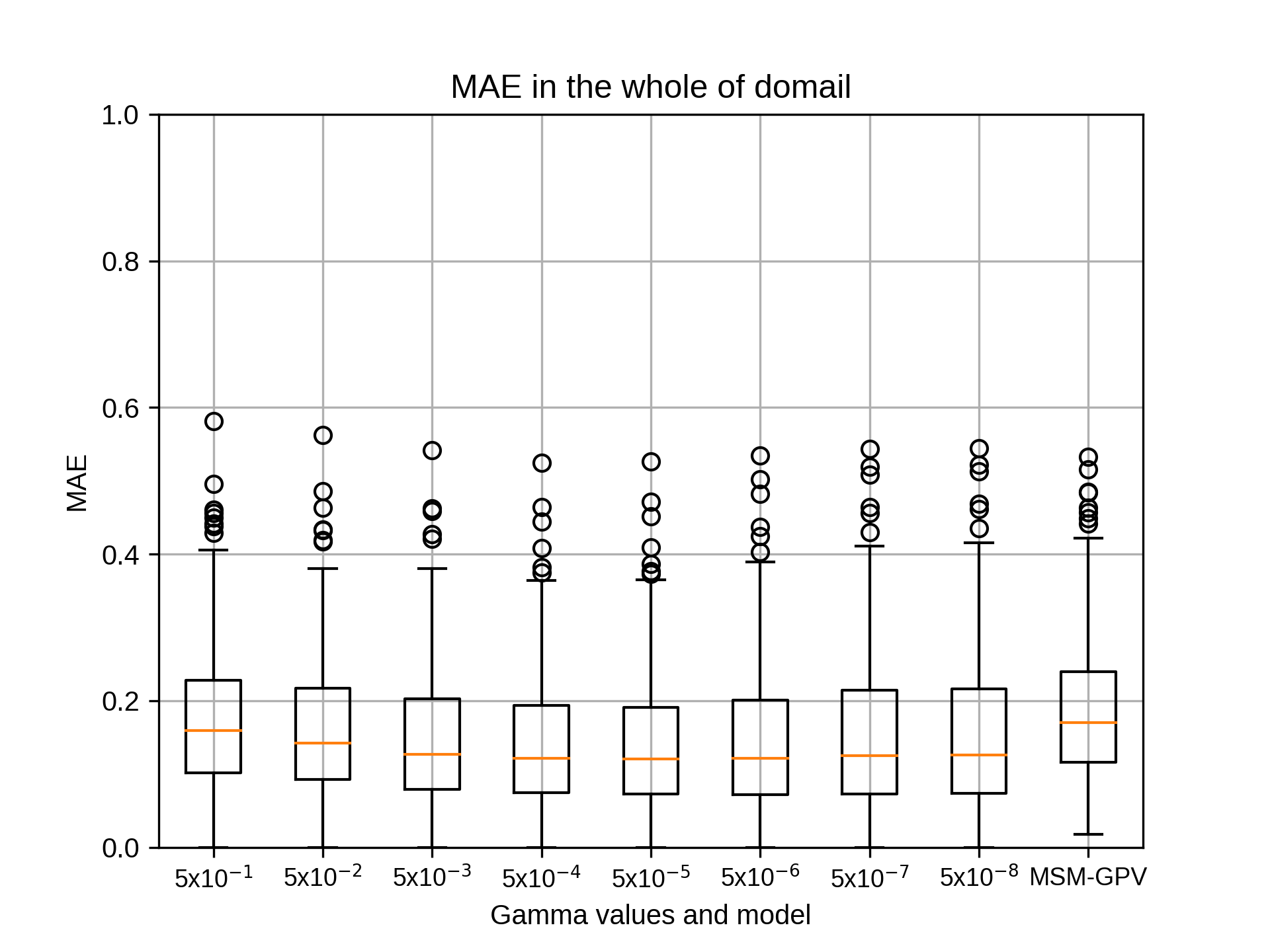

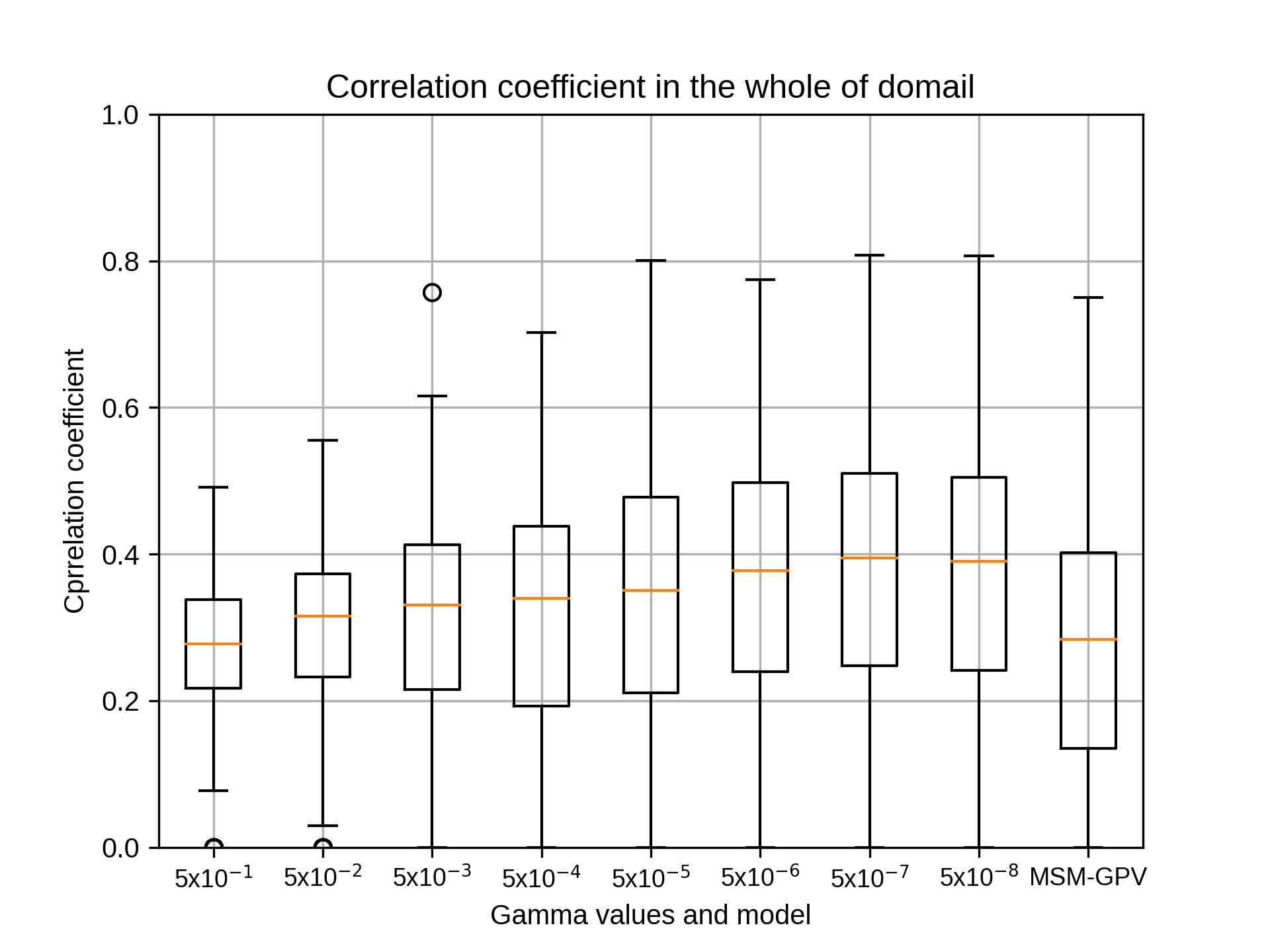

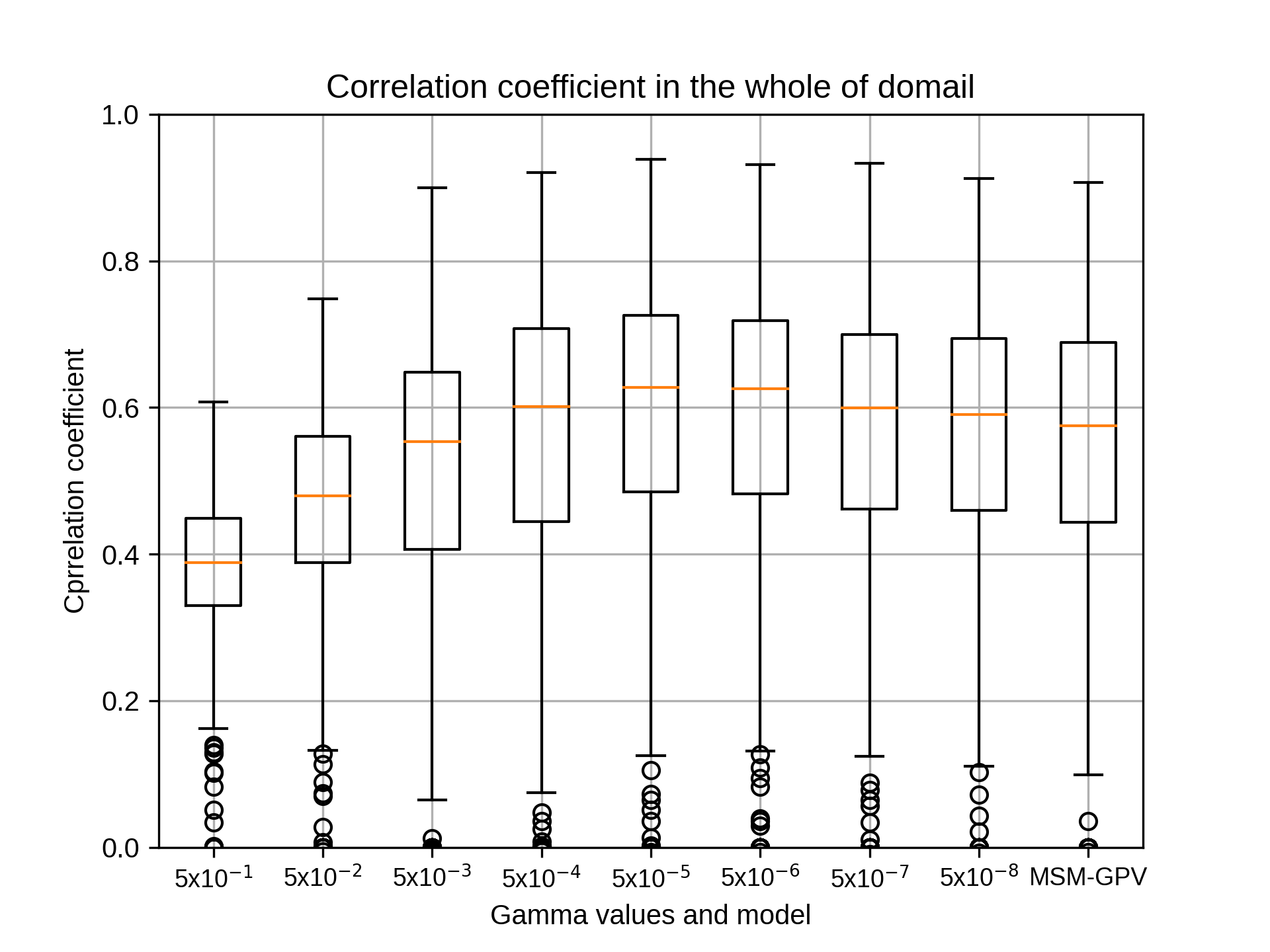

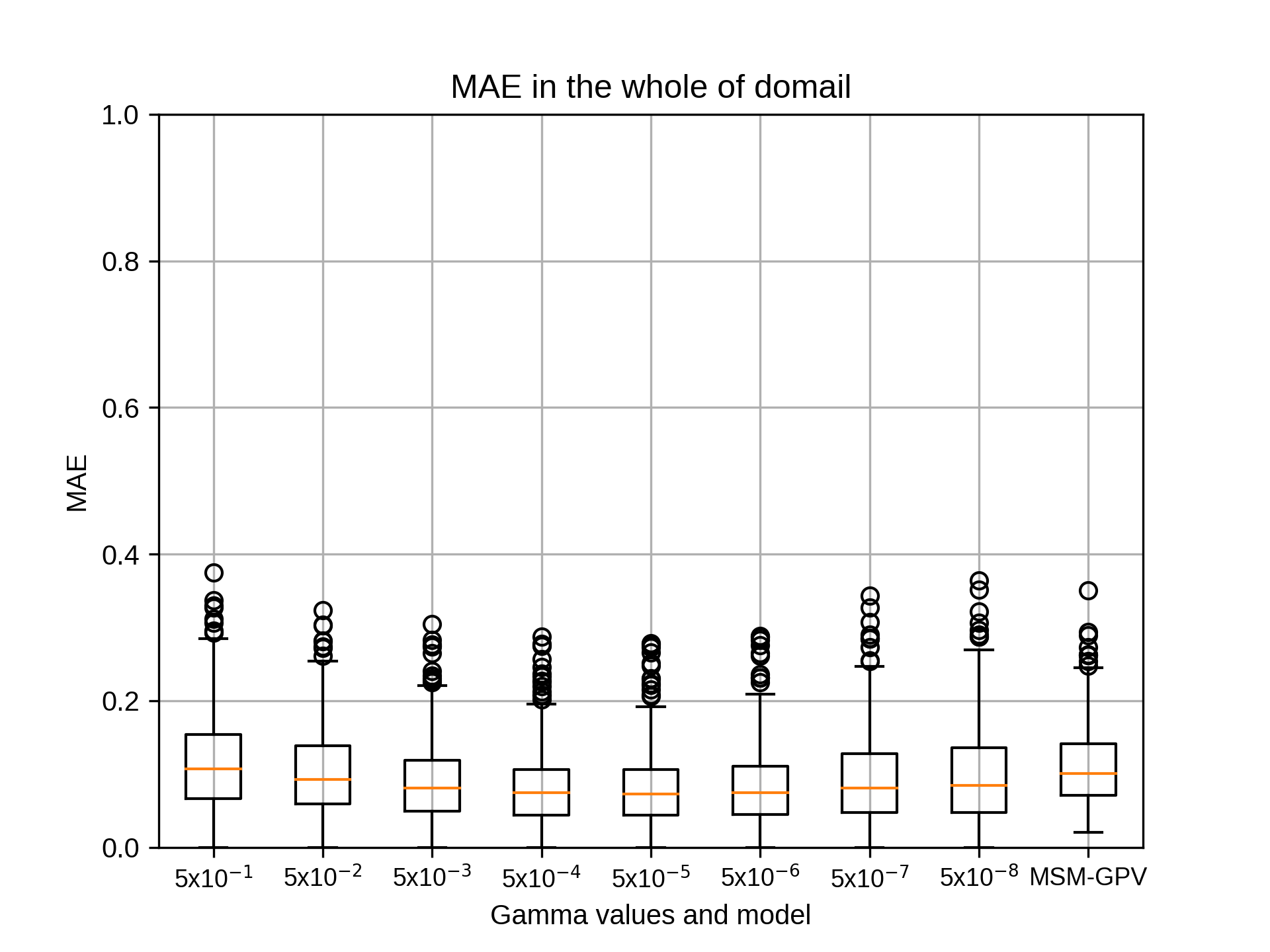

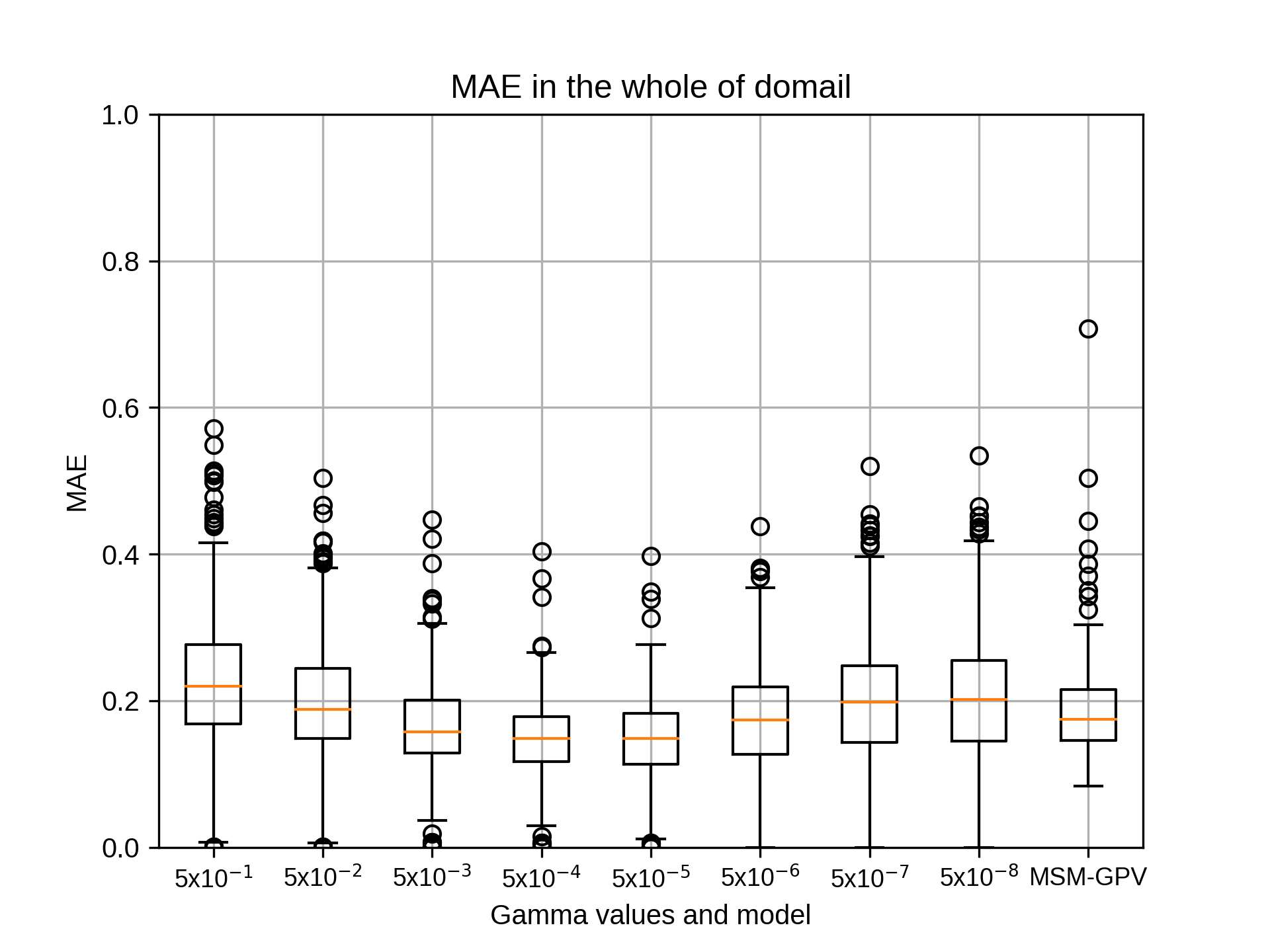

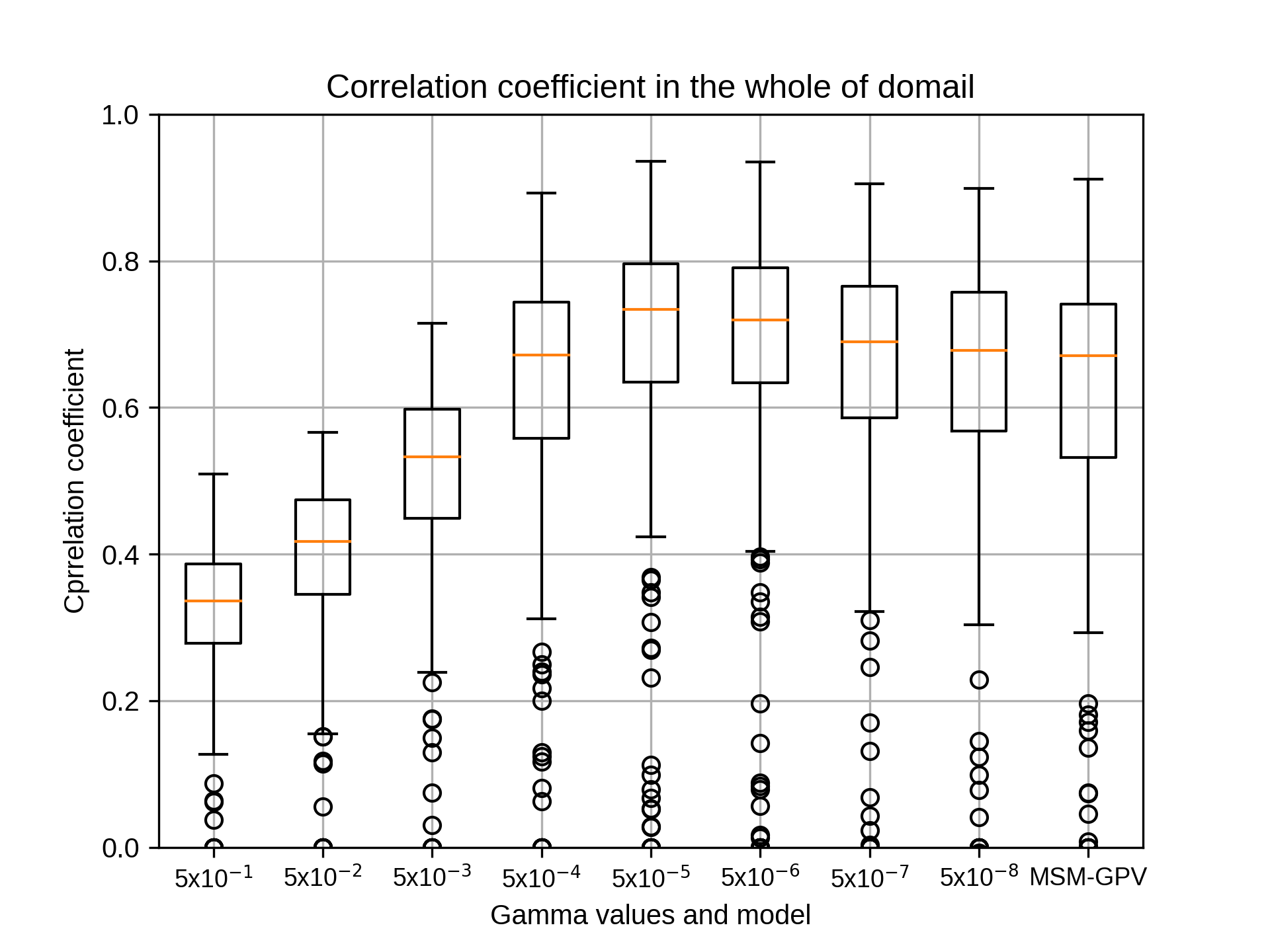

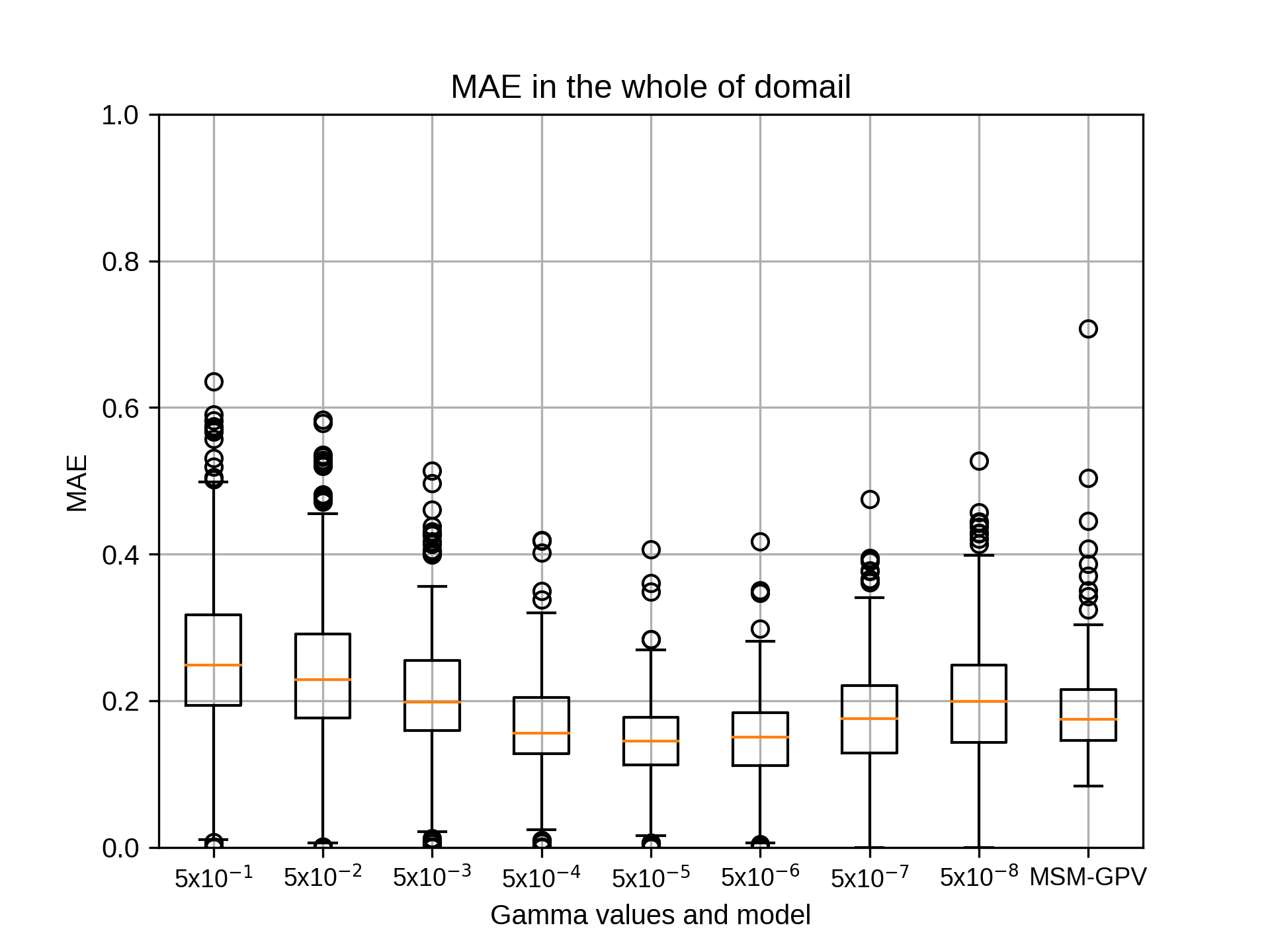

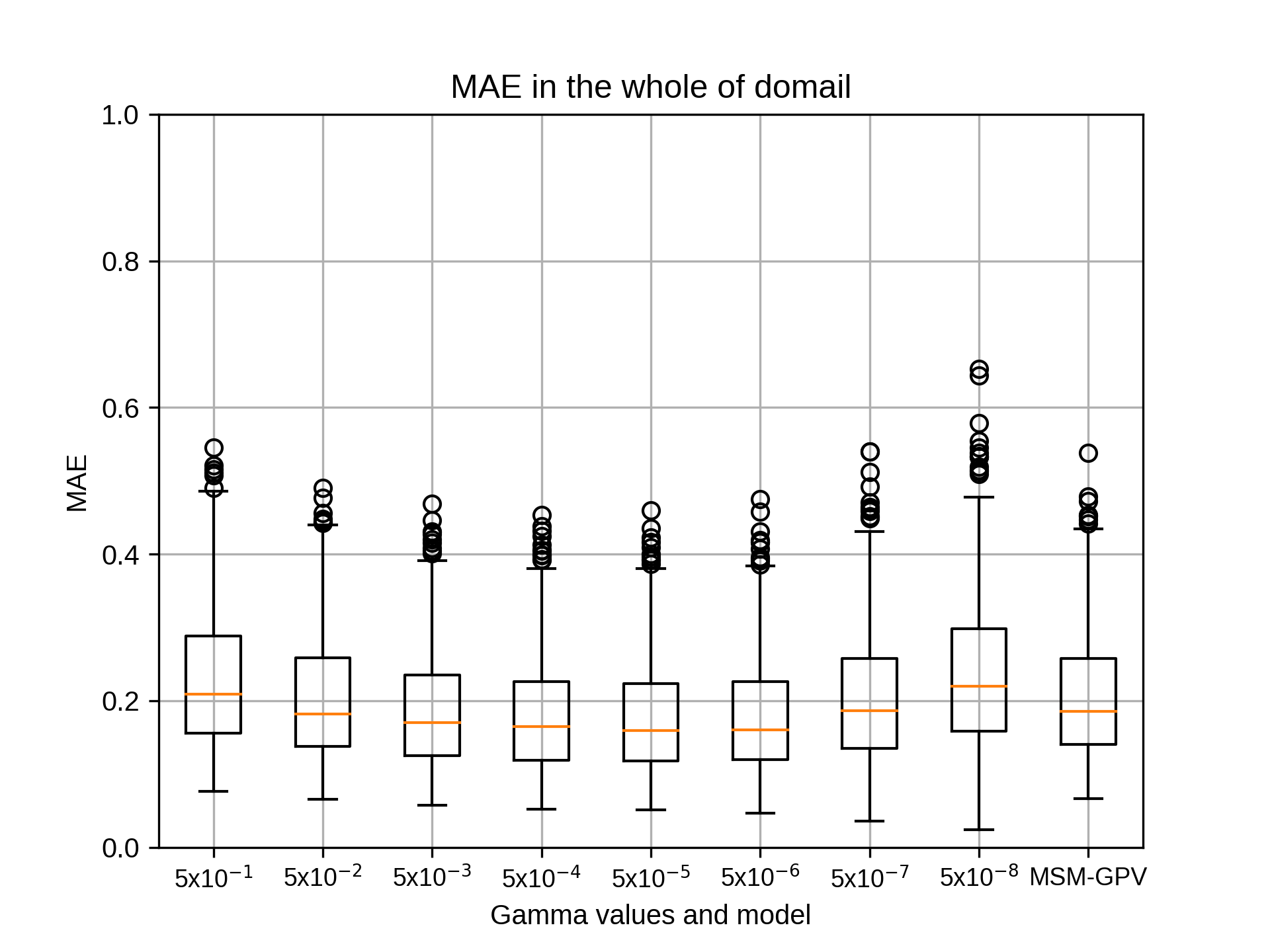

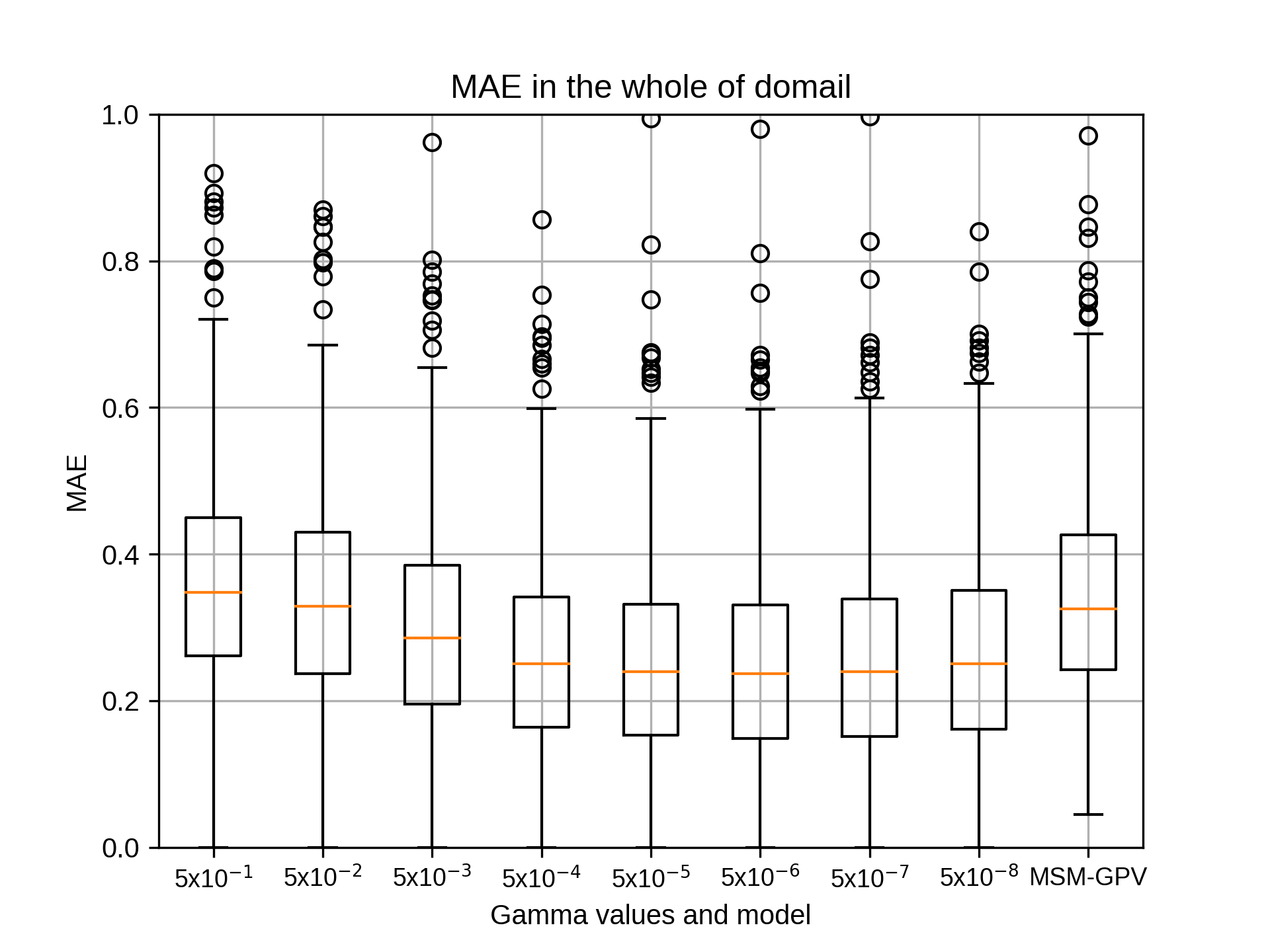

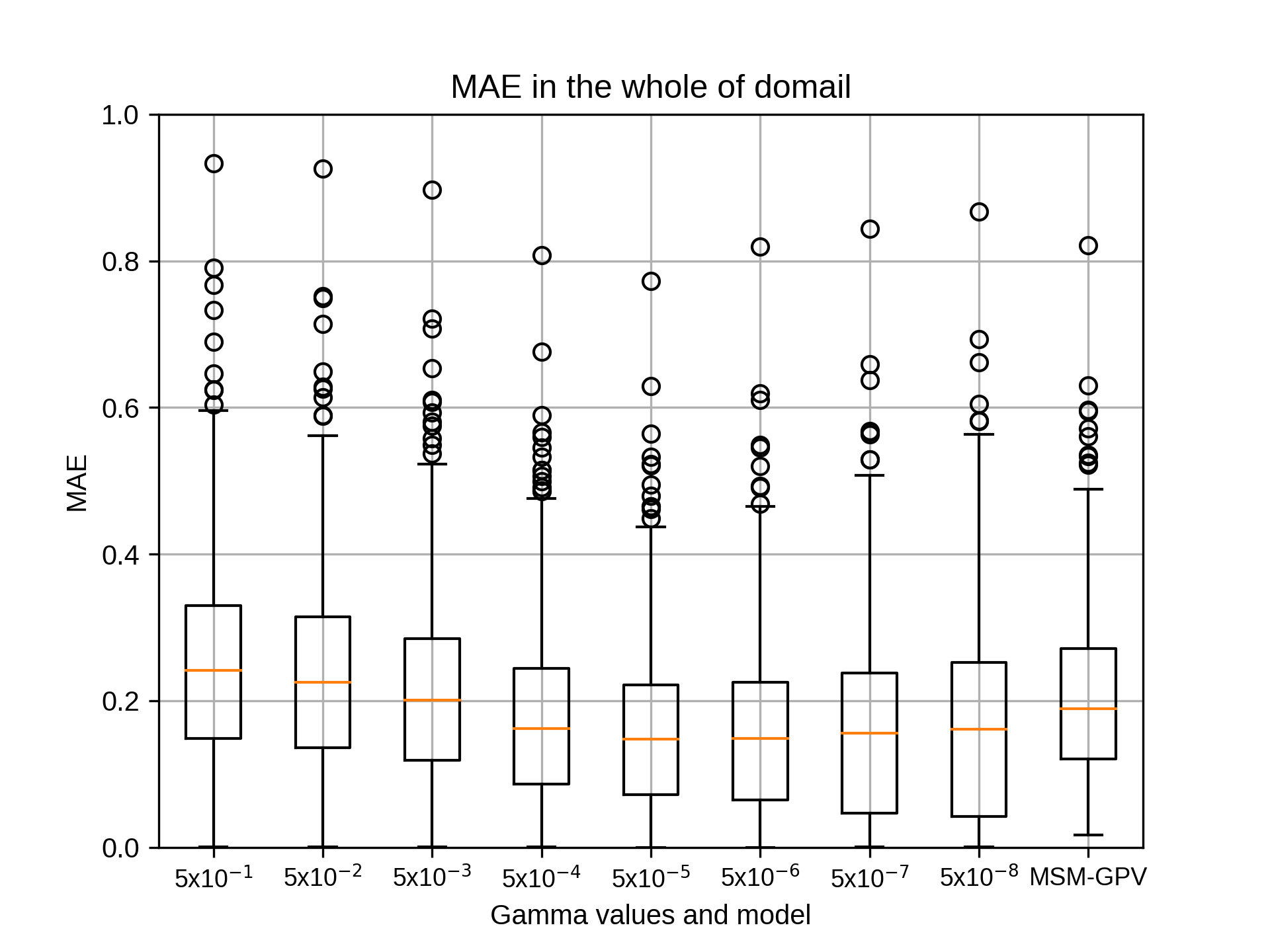

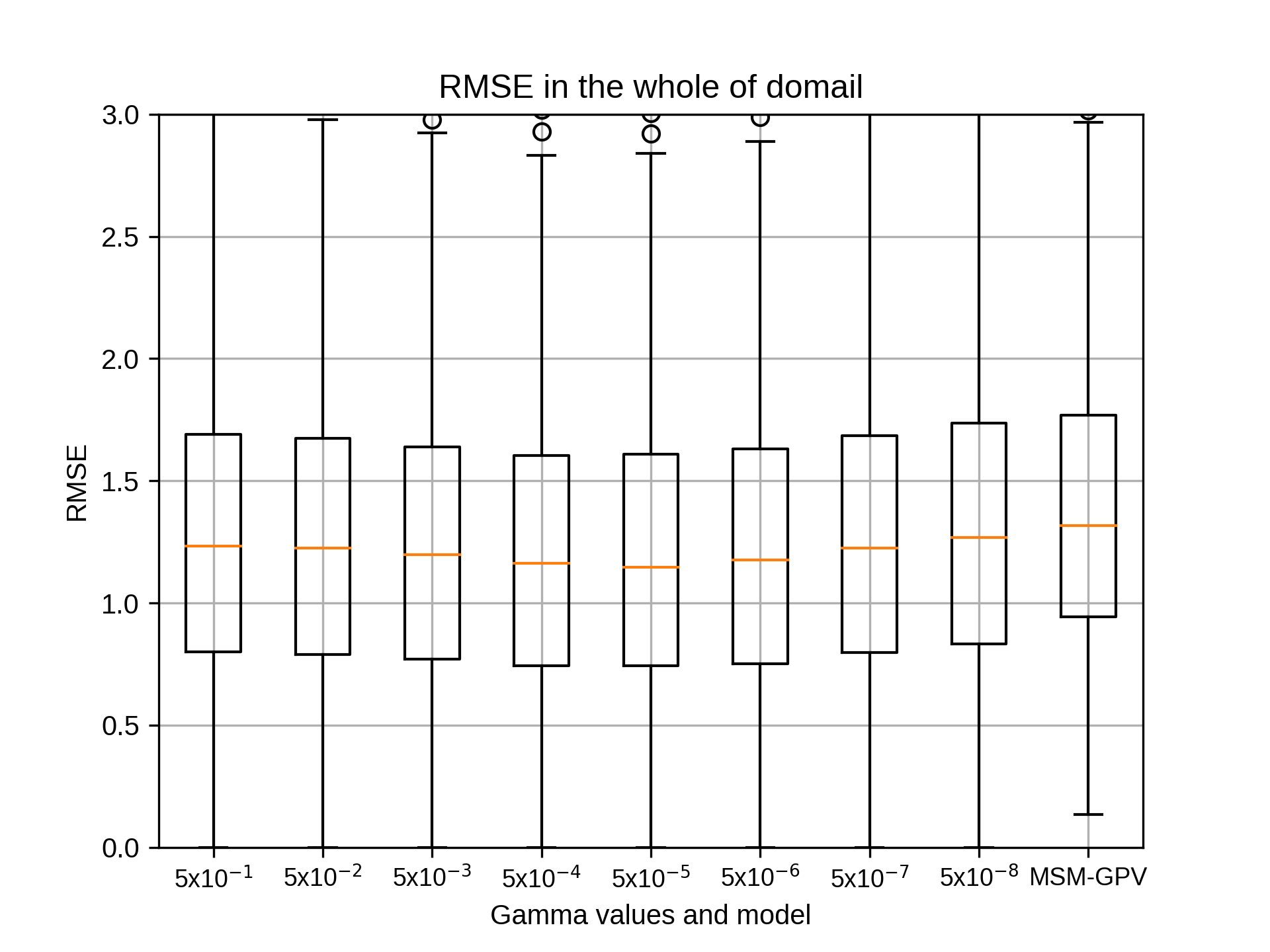

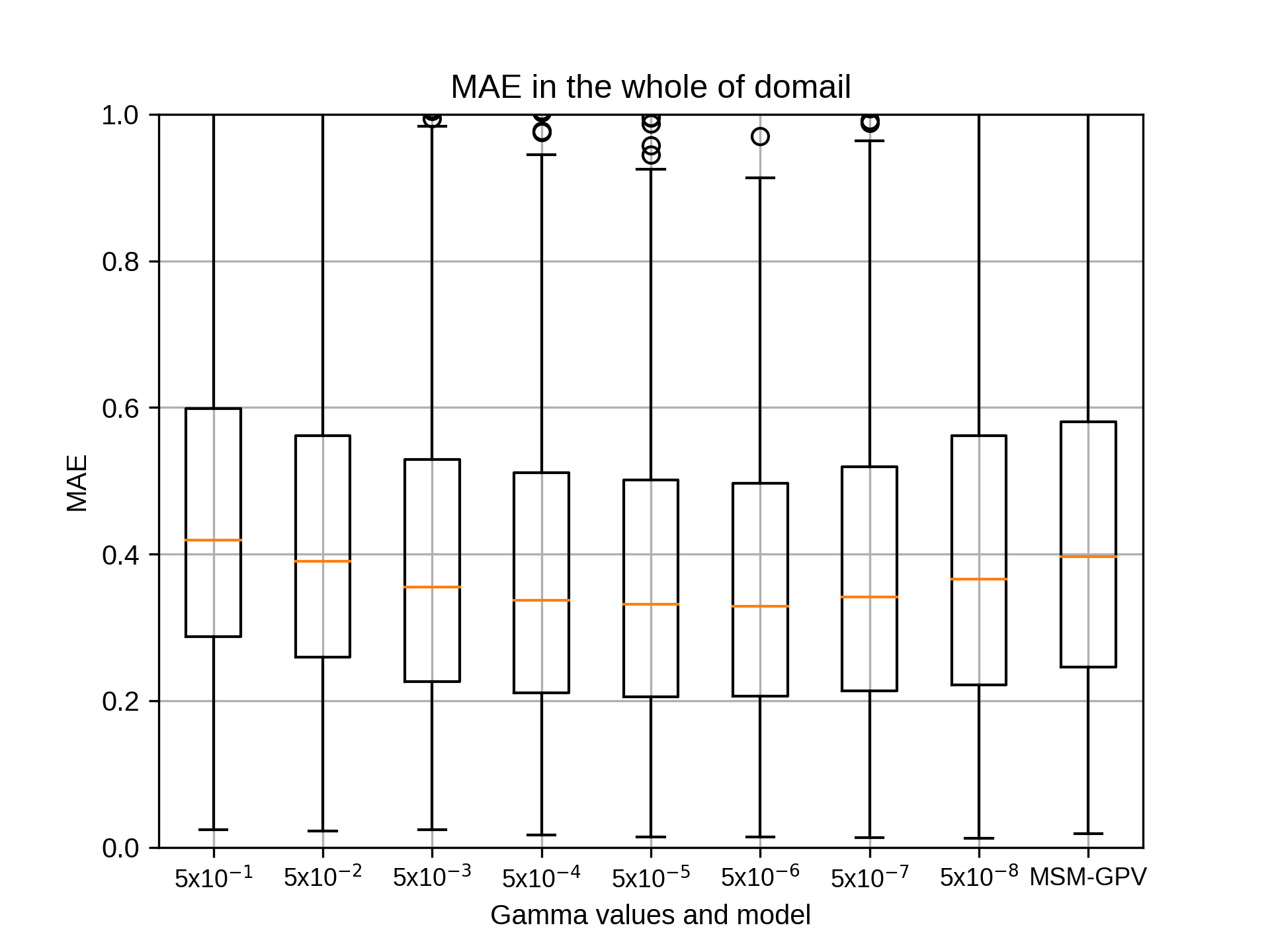

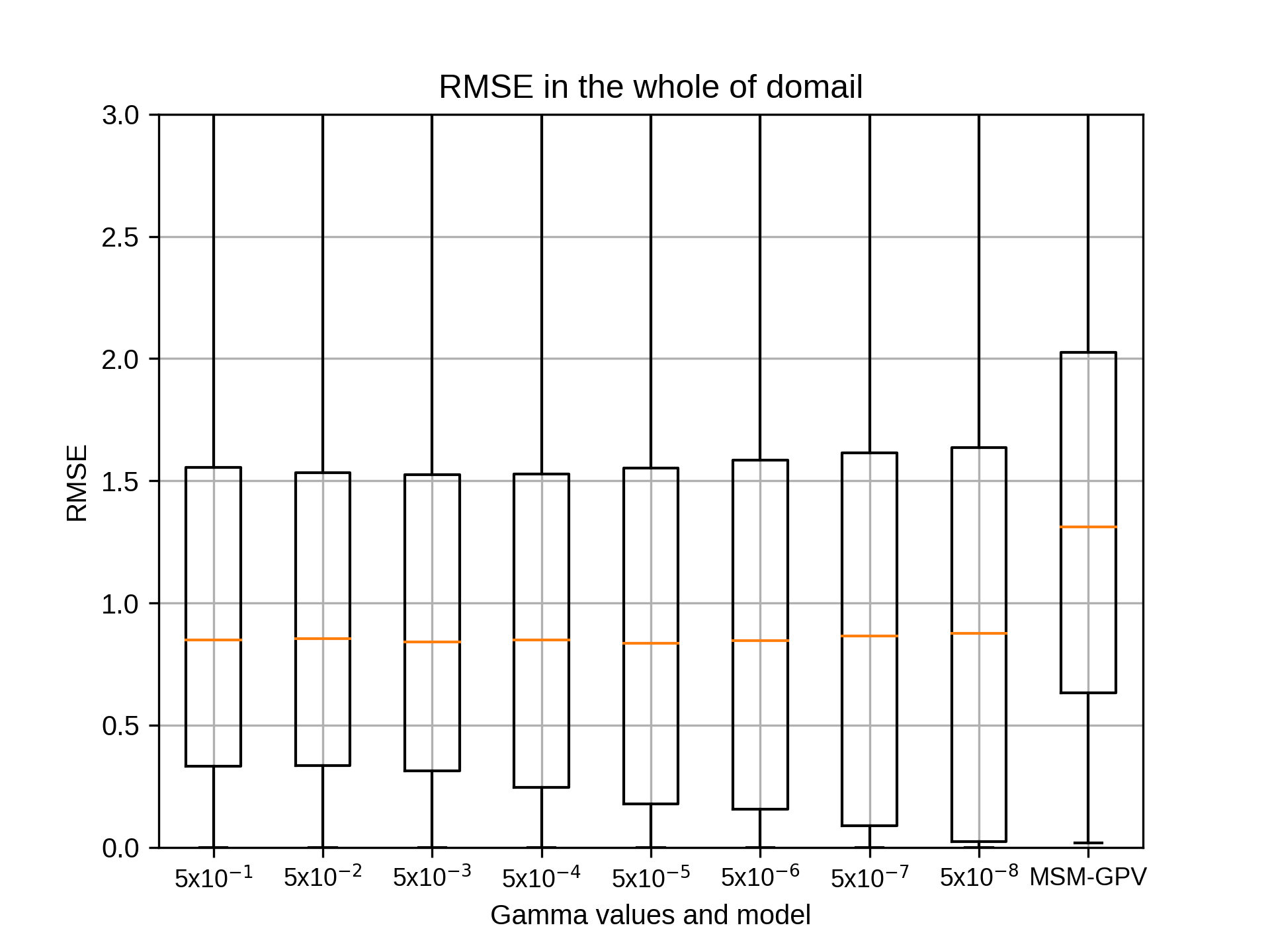

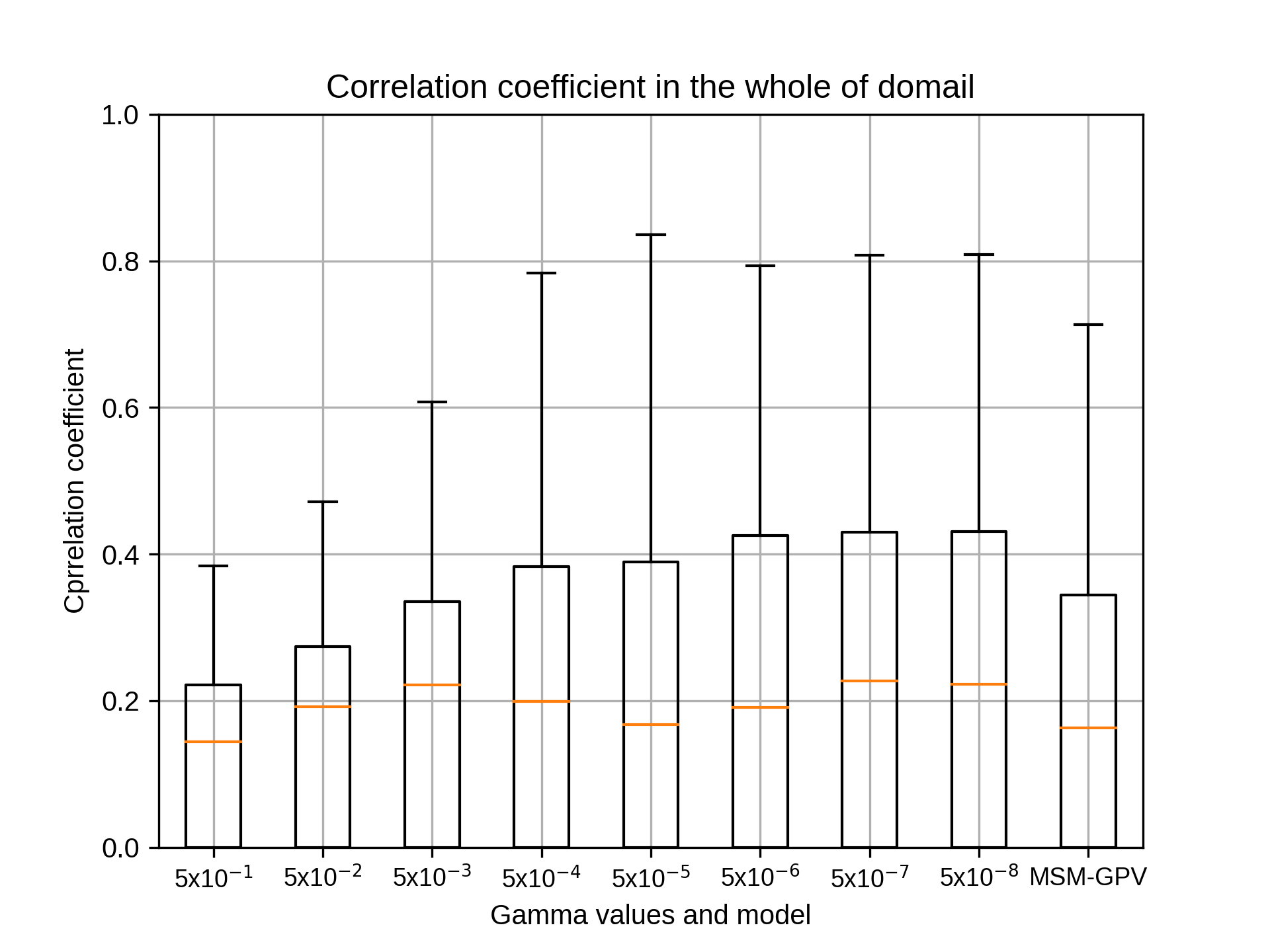

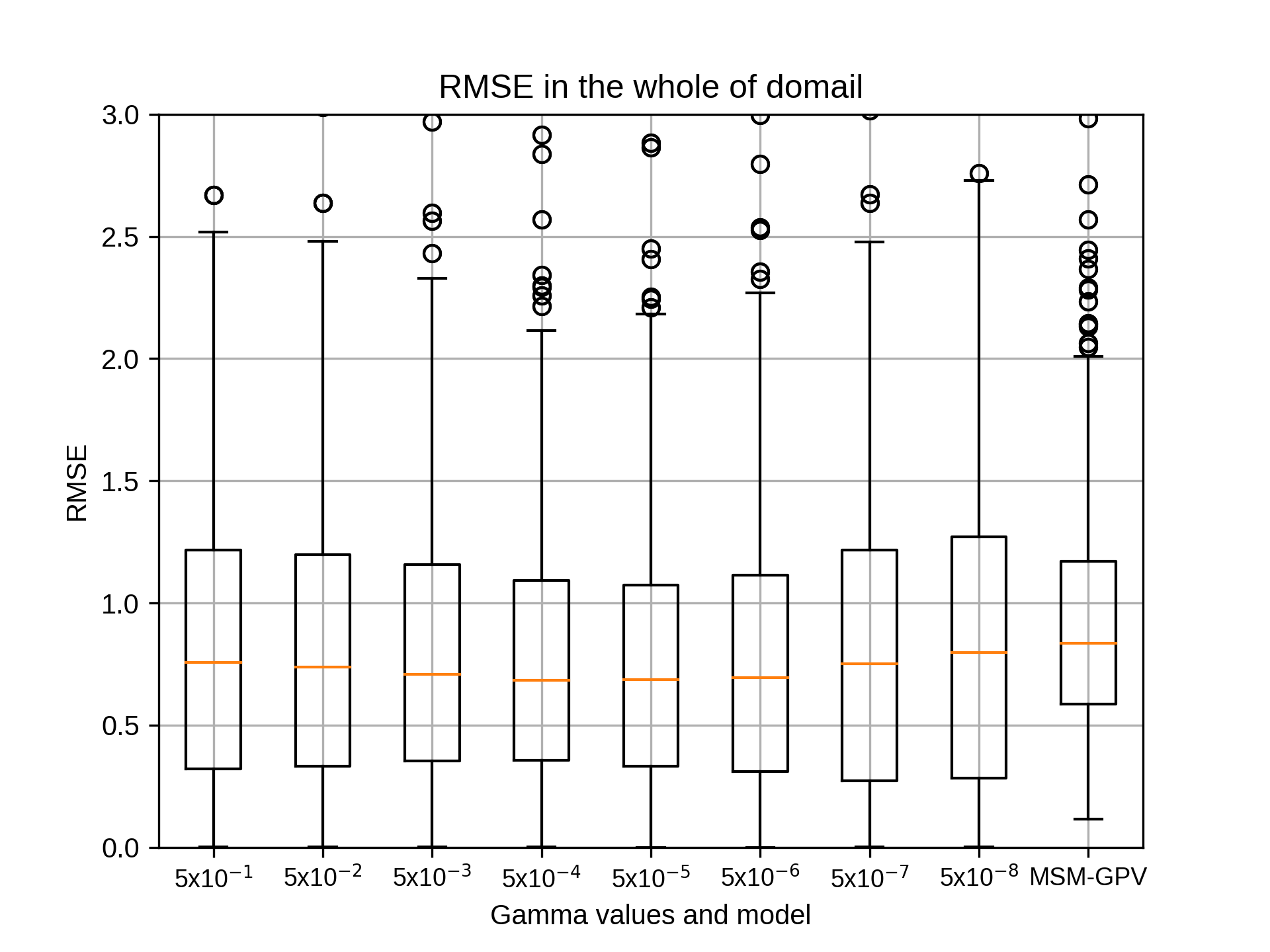

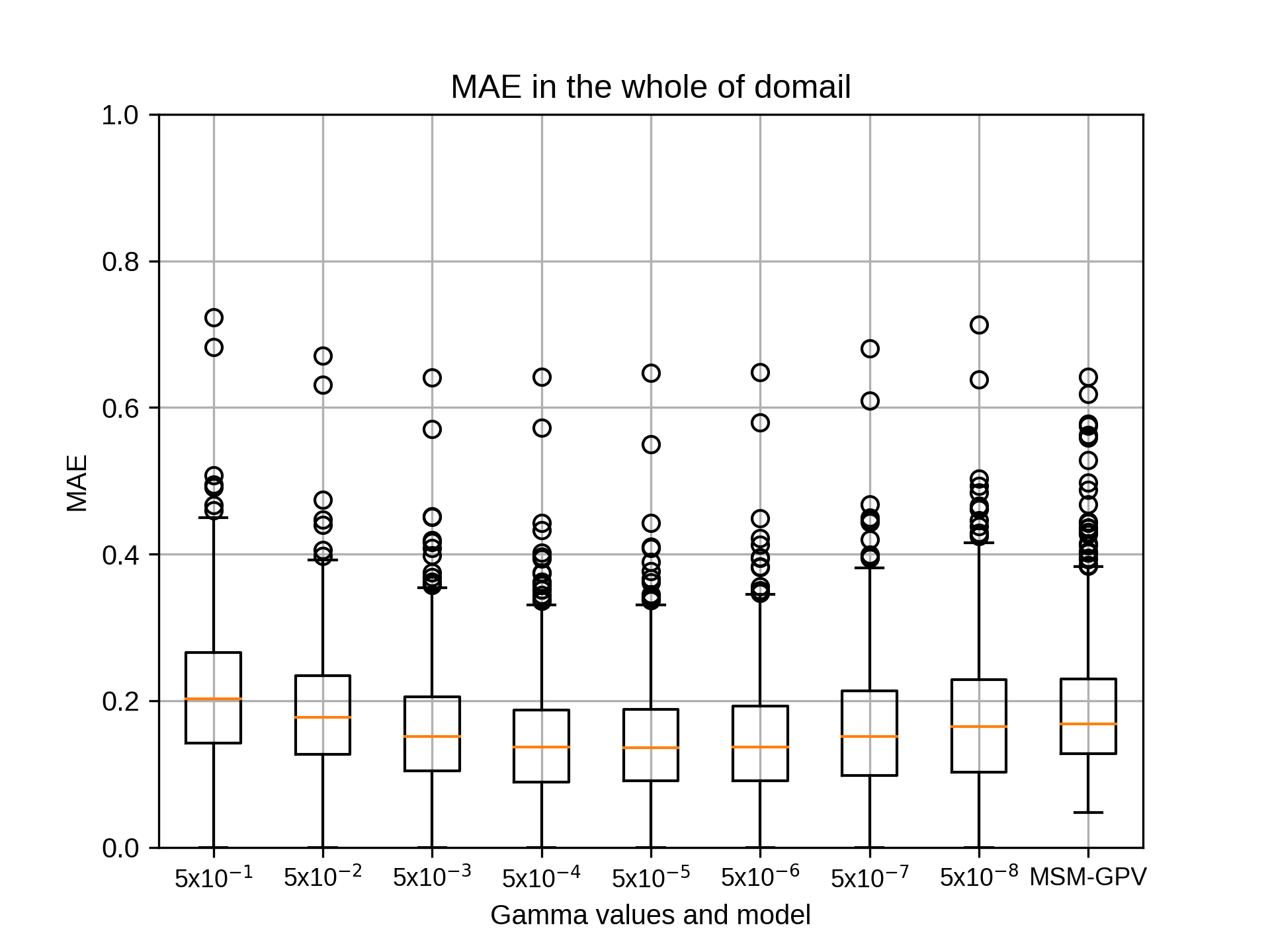

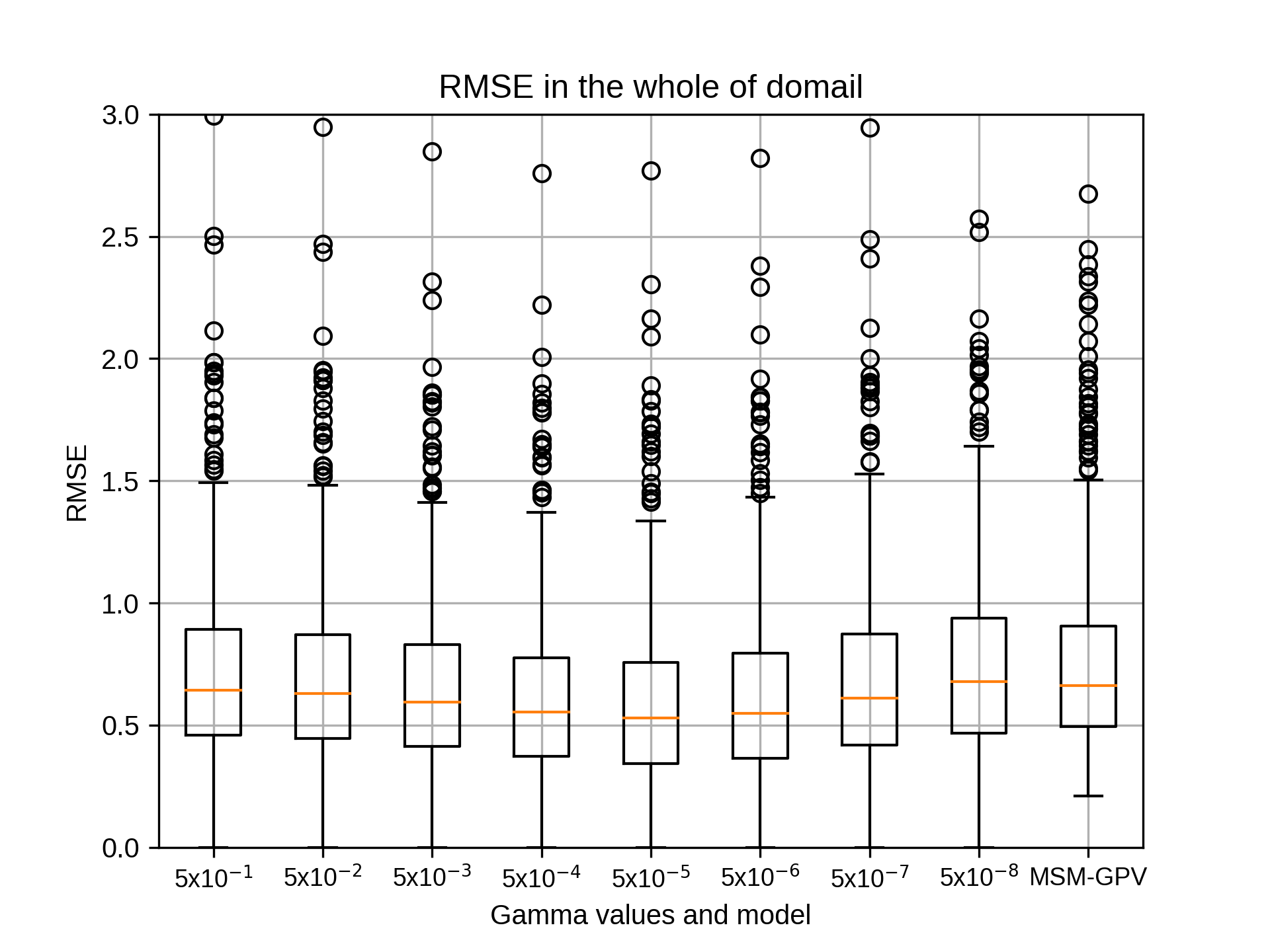

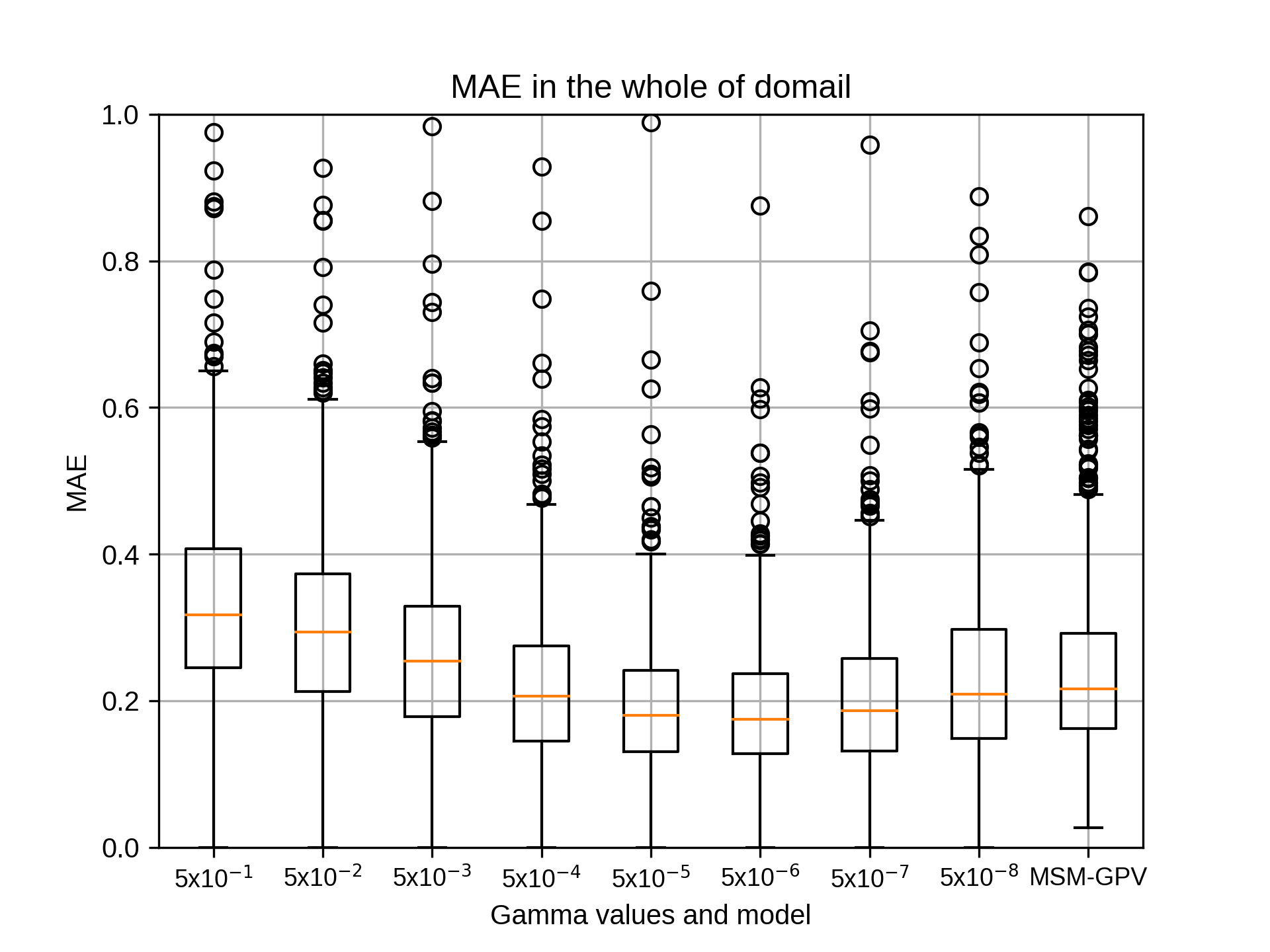

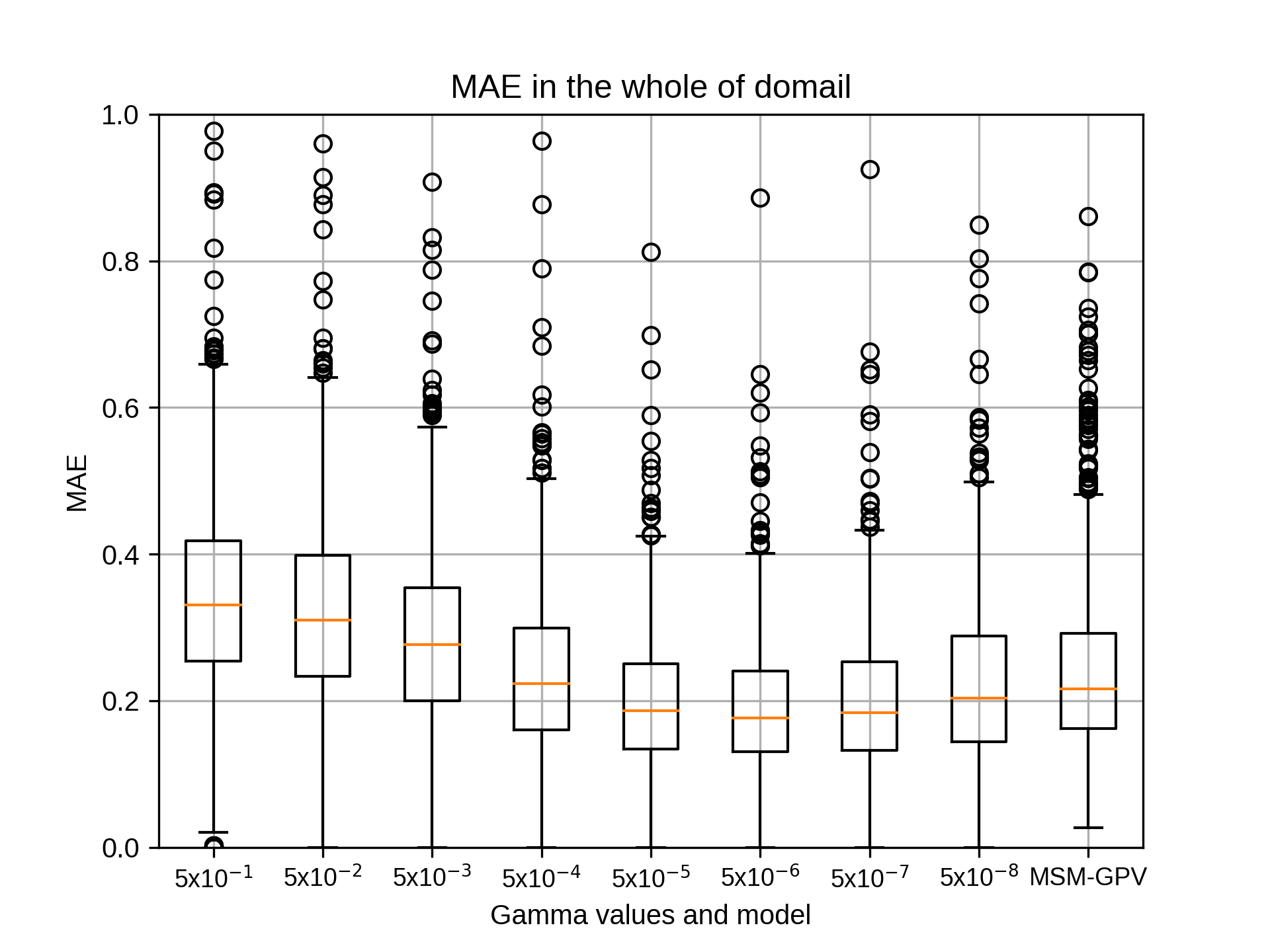

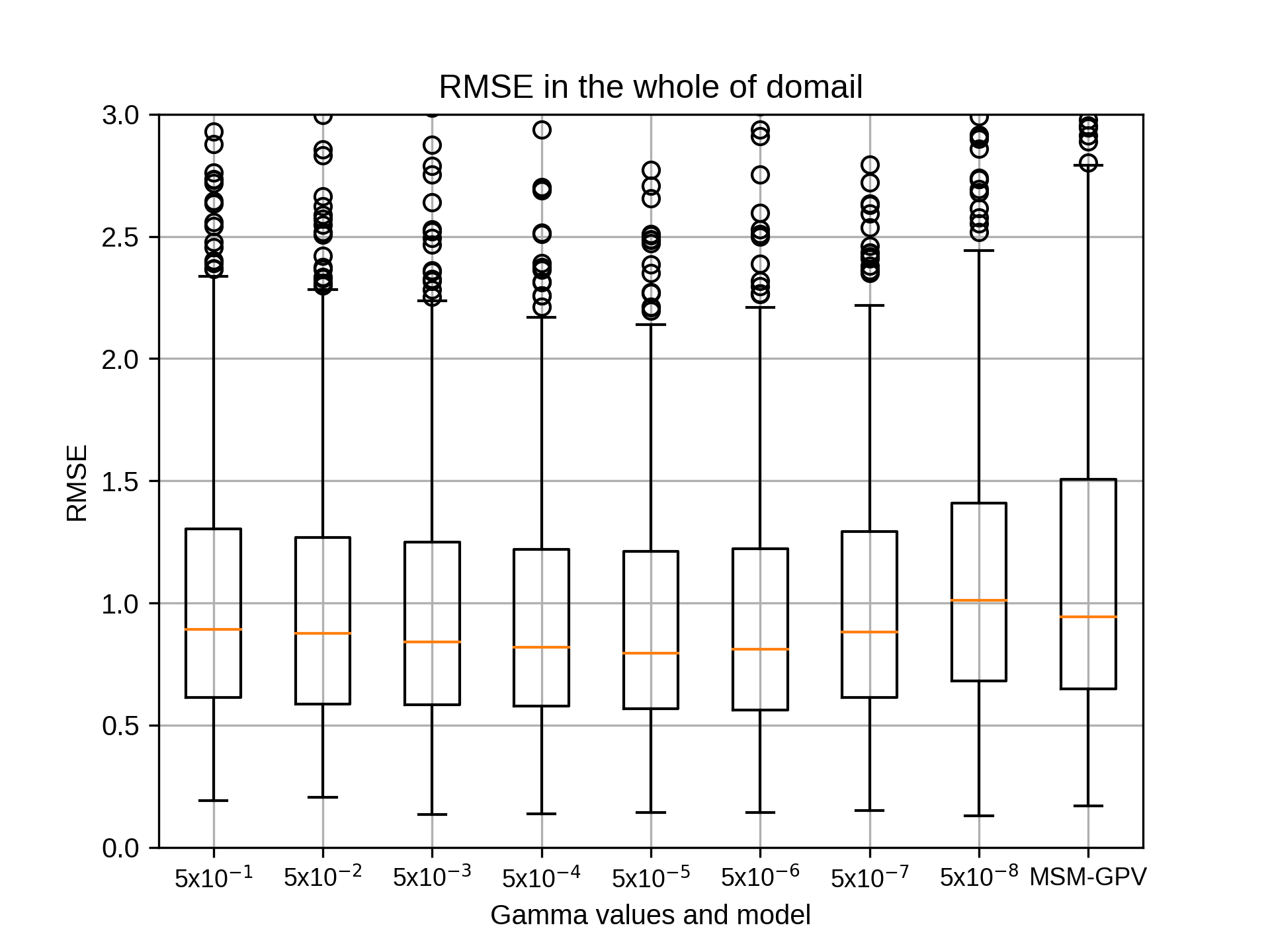

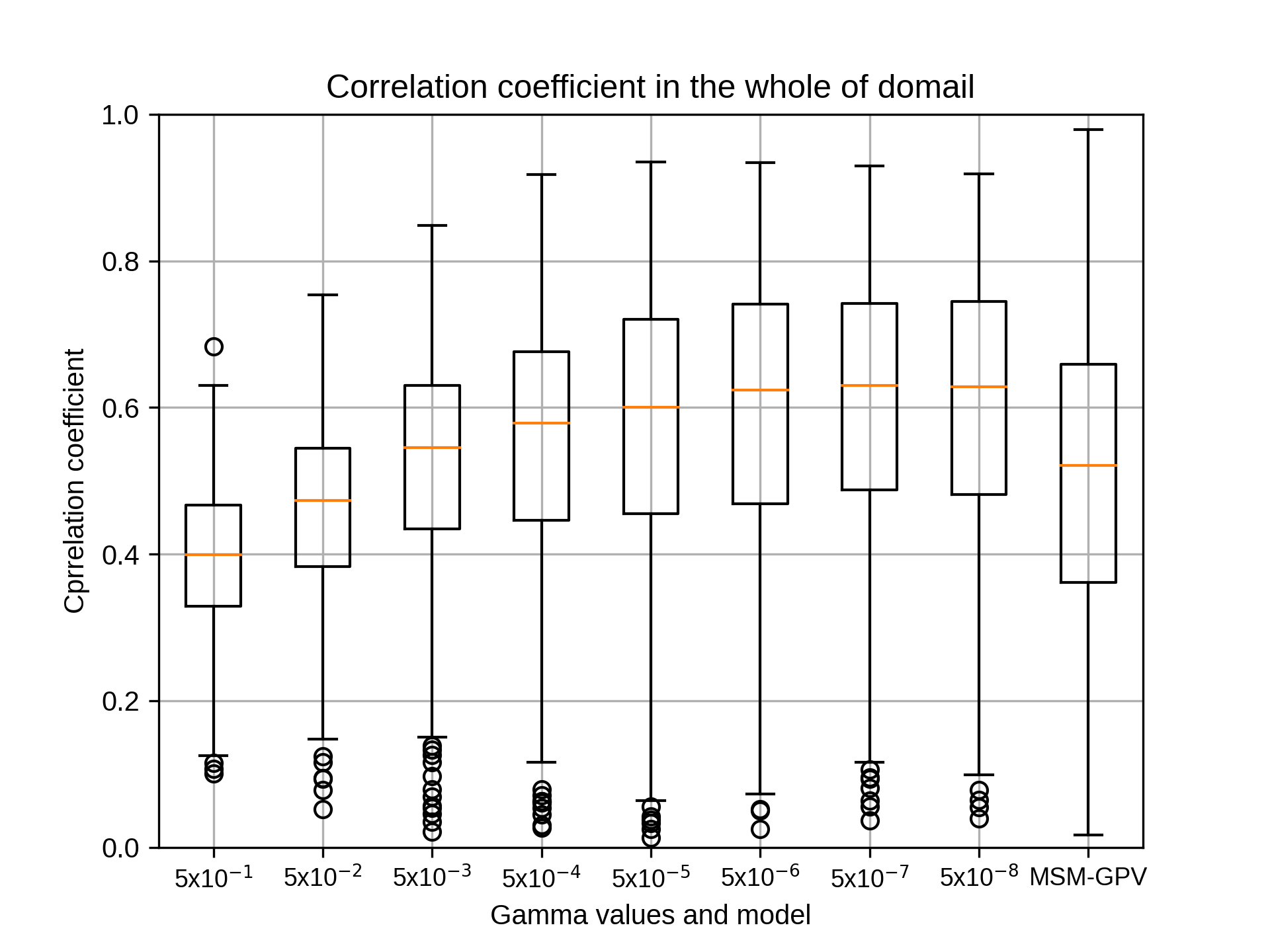

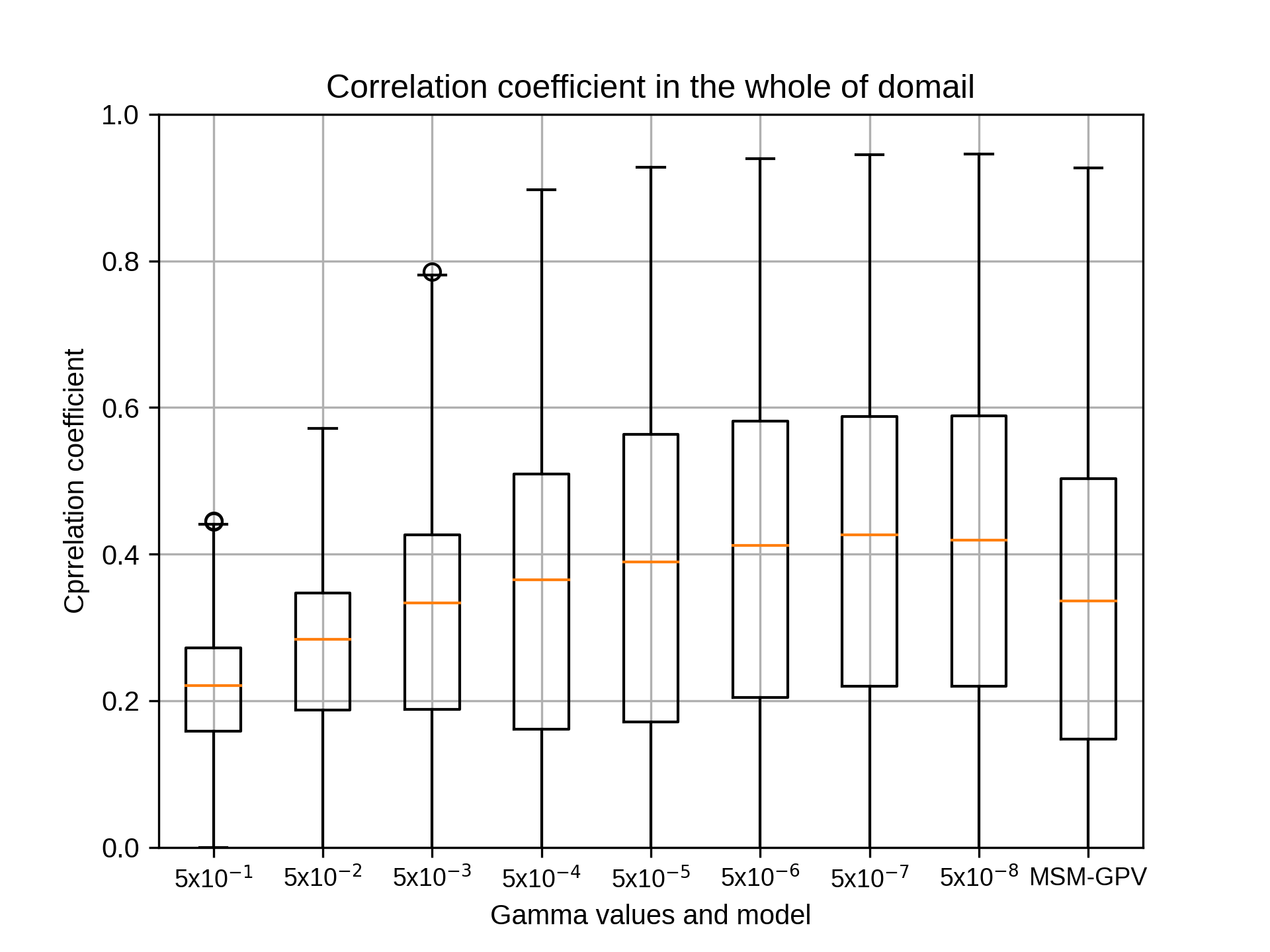

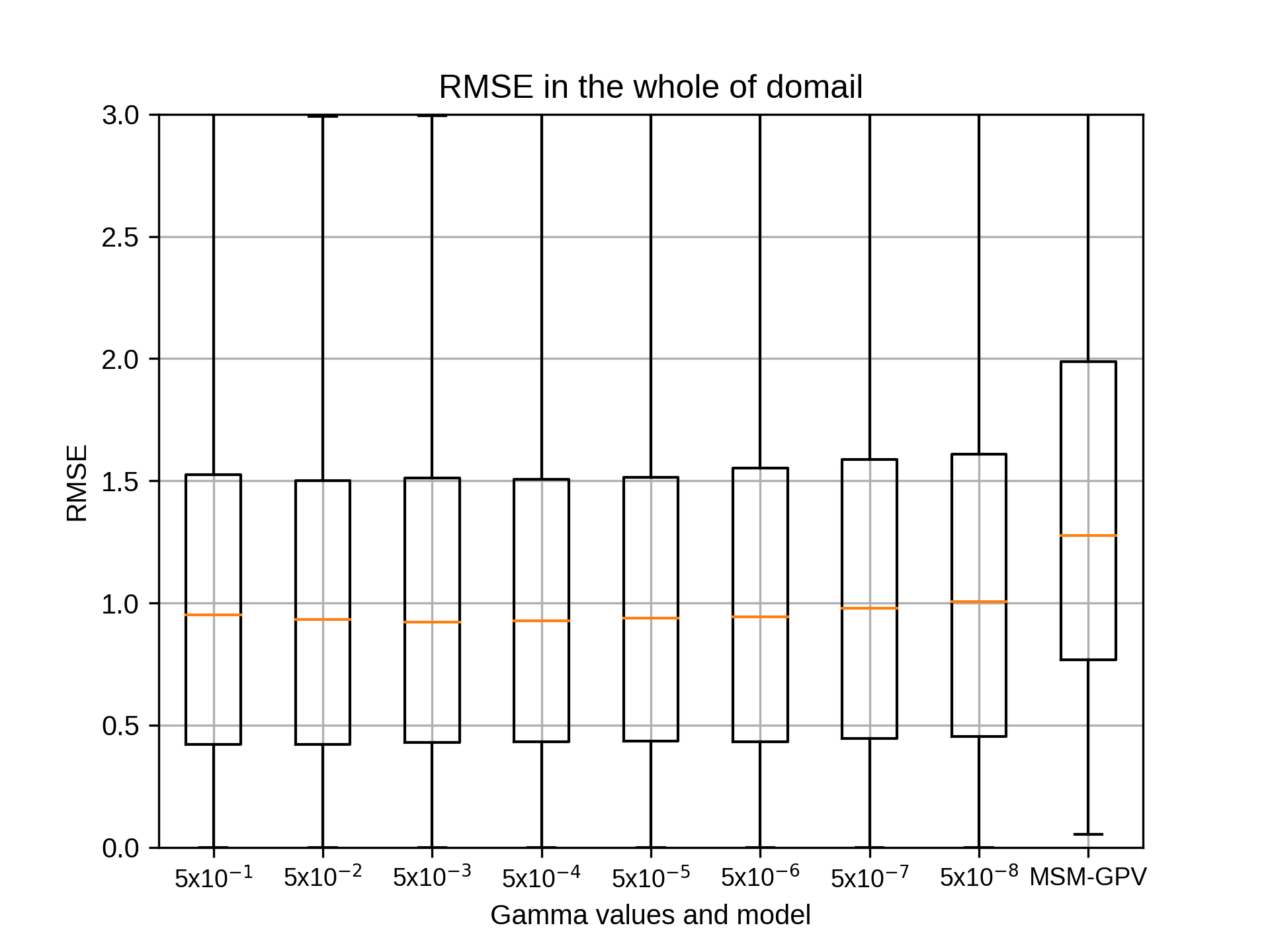

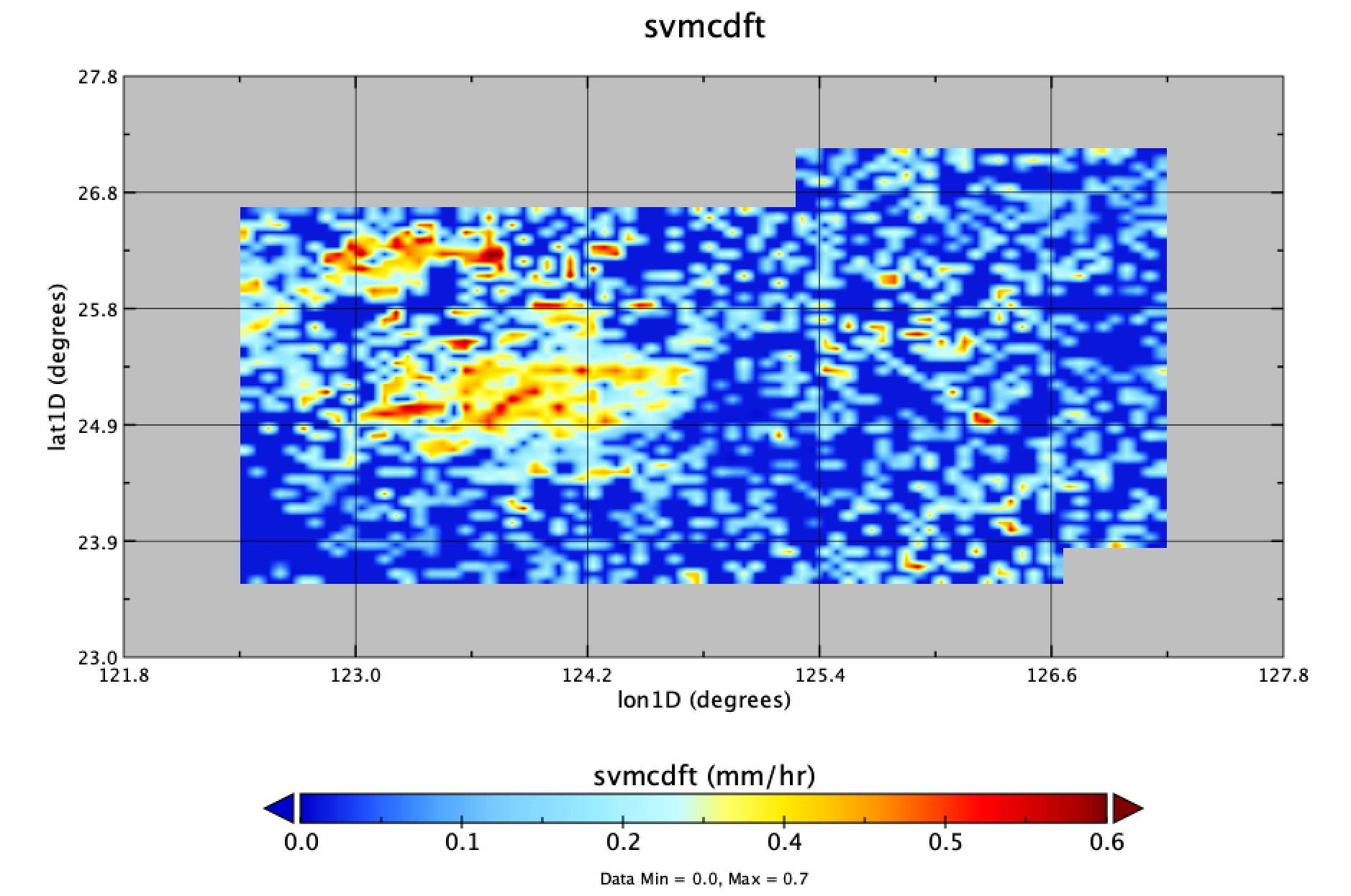

siteD(南西諸島)につきましてガンマの違いによる結果が出ましたのでお伝えいたします。

エラーを修正し、グラフが出るようにいたしました。ご確認ください。

siteAは計算中、siteBは途中でエラーがでましたので修正いたします。

よろしくお願いいたします。

siteDのパラメータは以下のとおりです。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon} #07

## Grids

xnums='20 30 40 50 60 70 80'

ynums='20 30 40 50 60 70'

nums='441'

rg2='10'

##

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

吉兼先生

siteD(南西諸島)につきましてガンマの違いによる結果が出ましたのでお伝えいたします。

エラーを修正し、グラフが出るようにいたしました。ご確認ください。

siteAは計算中、siteBは途中でエラーがでましたので修正いたします。

よろしくお願いいたします。

siteDのパラメータは以下のとおりです。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon} #07

## Grids

xnums='20 30 40 50 60 70 80'

ynums='20 30 40 50 60 70'

nums='441'

rg2='10'

##

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

kobayashi_yusukeTuesday, September 8th, 2020 at 1:17:03 PM GMT+09:00

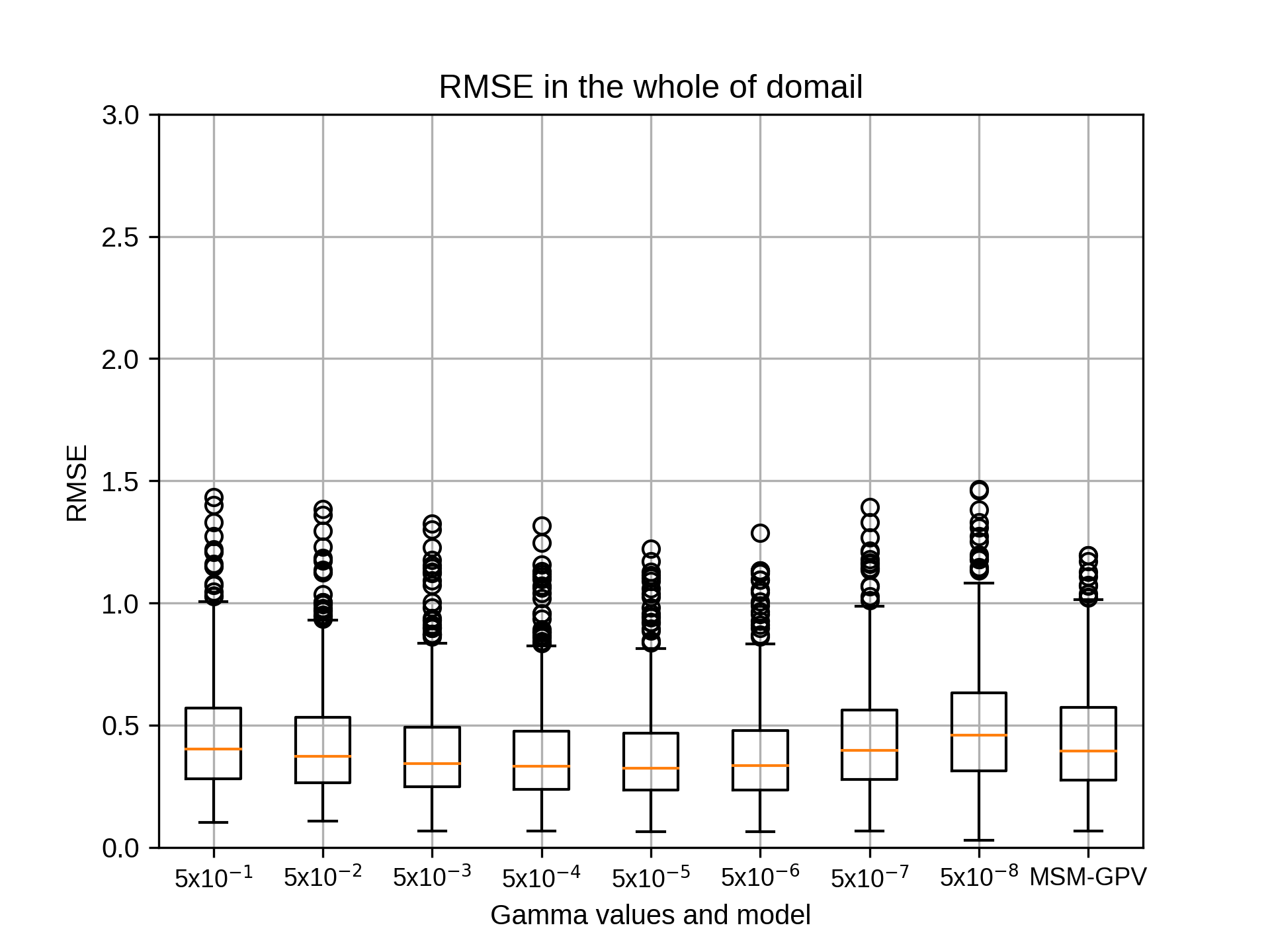

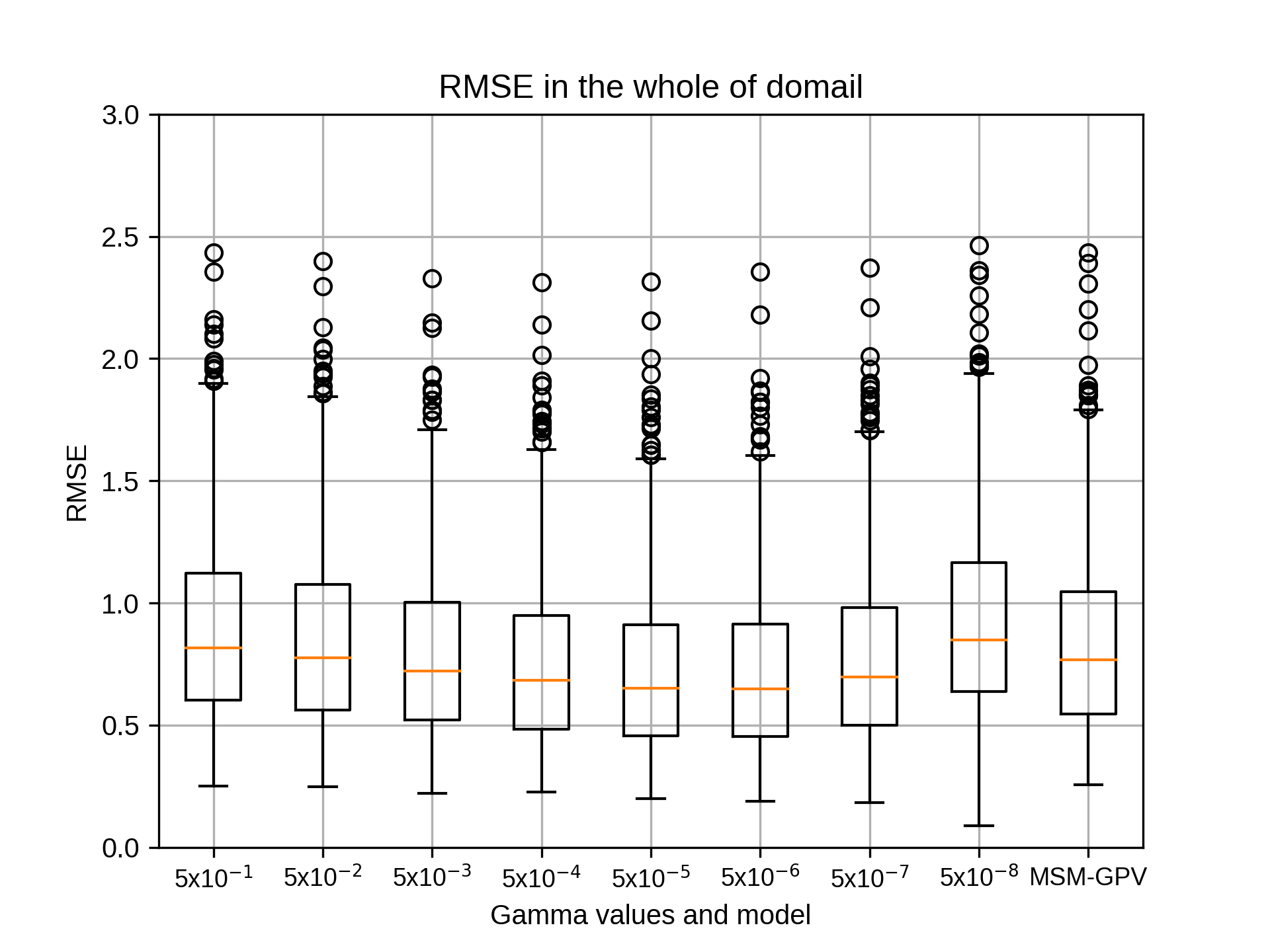

@takao-y

吉兼先生

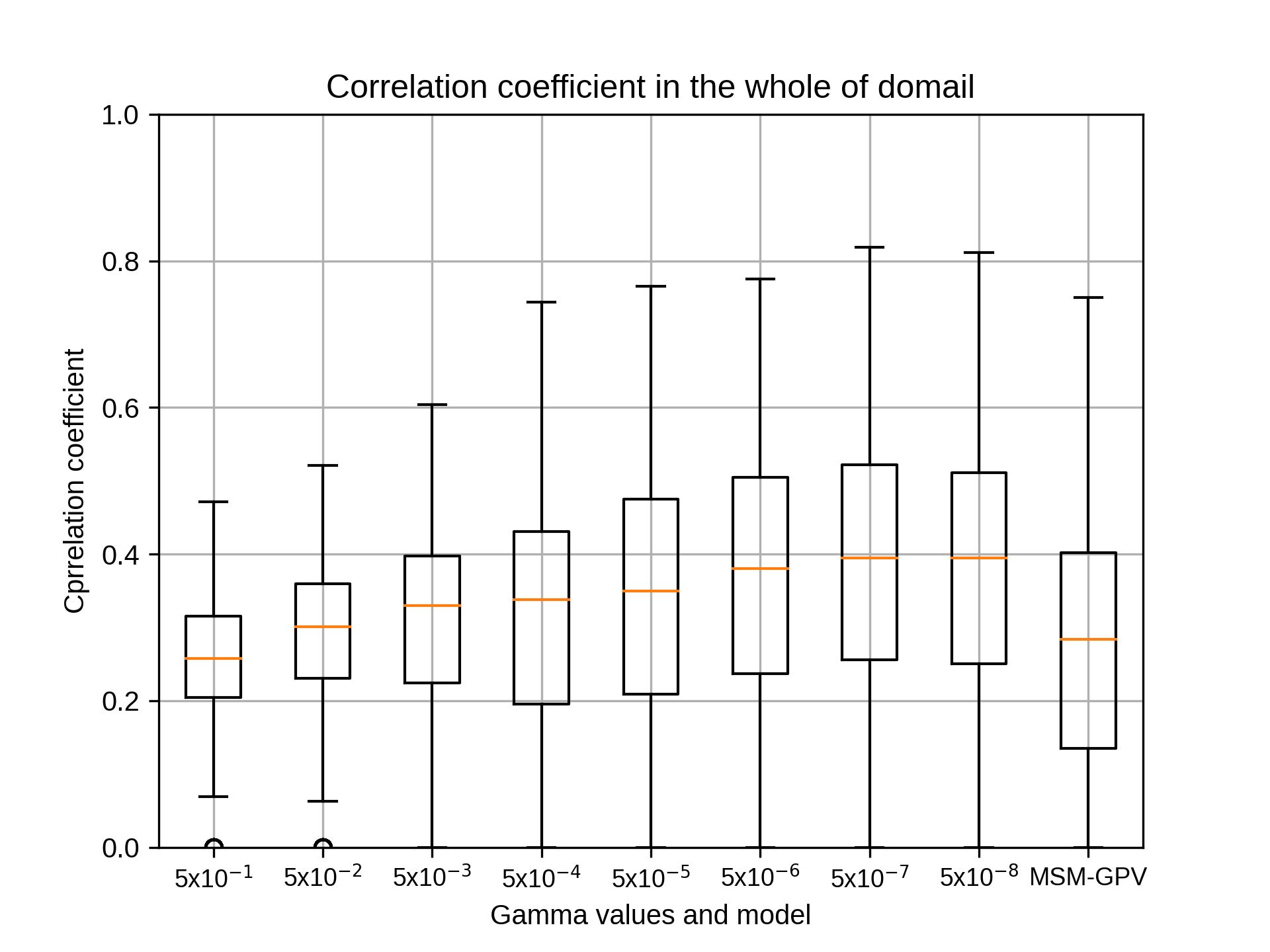

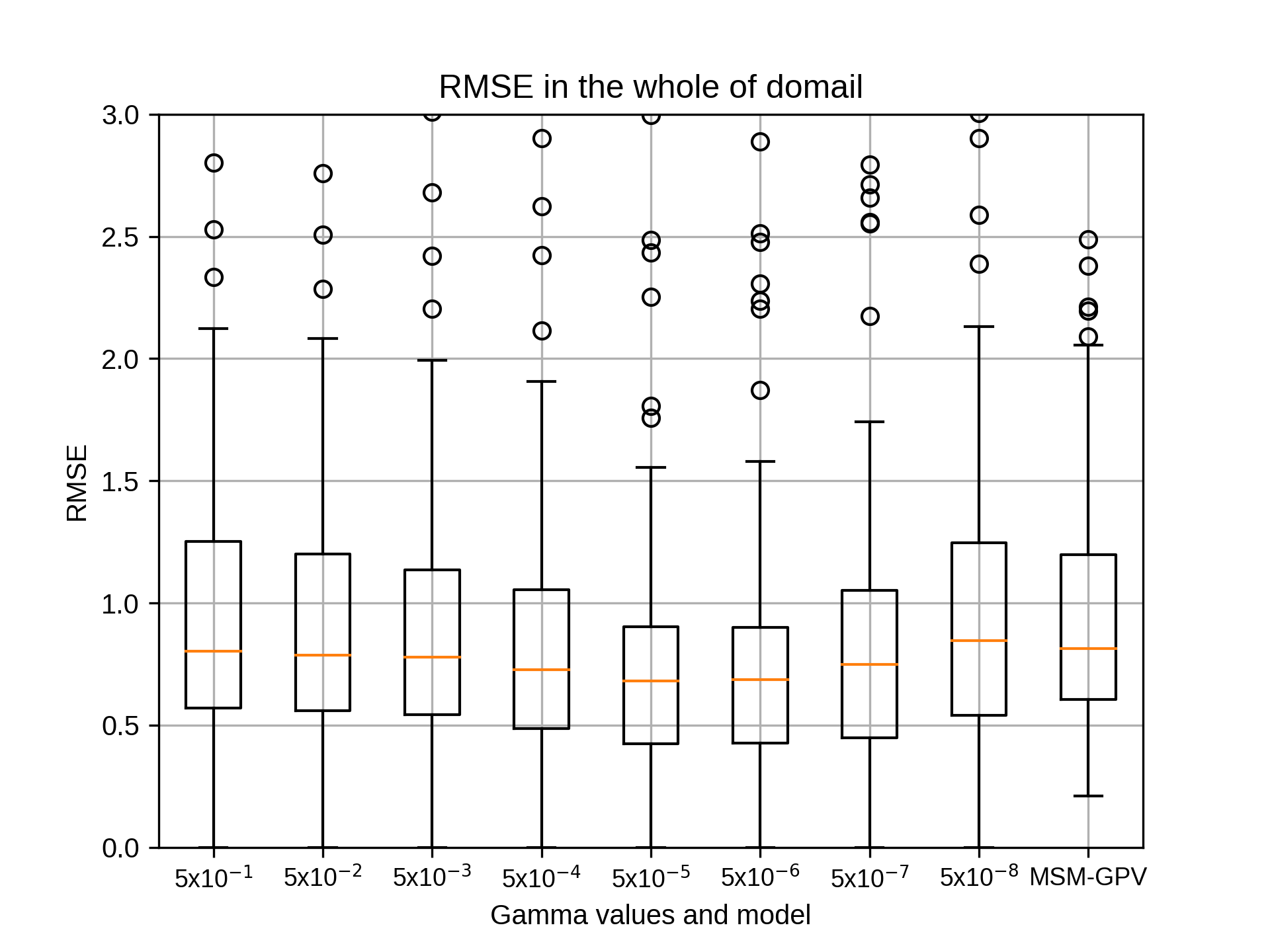

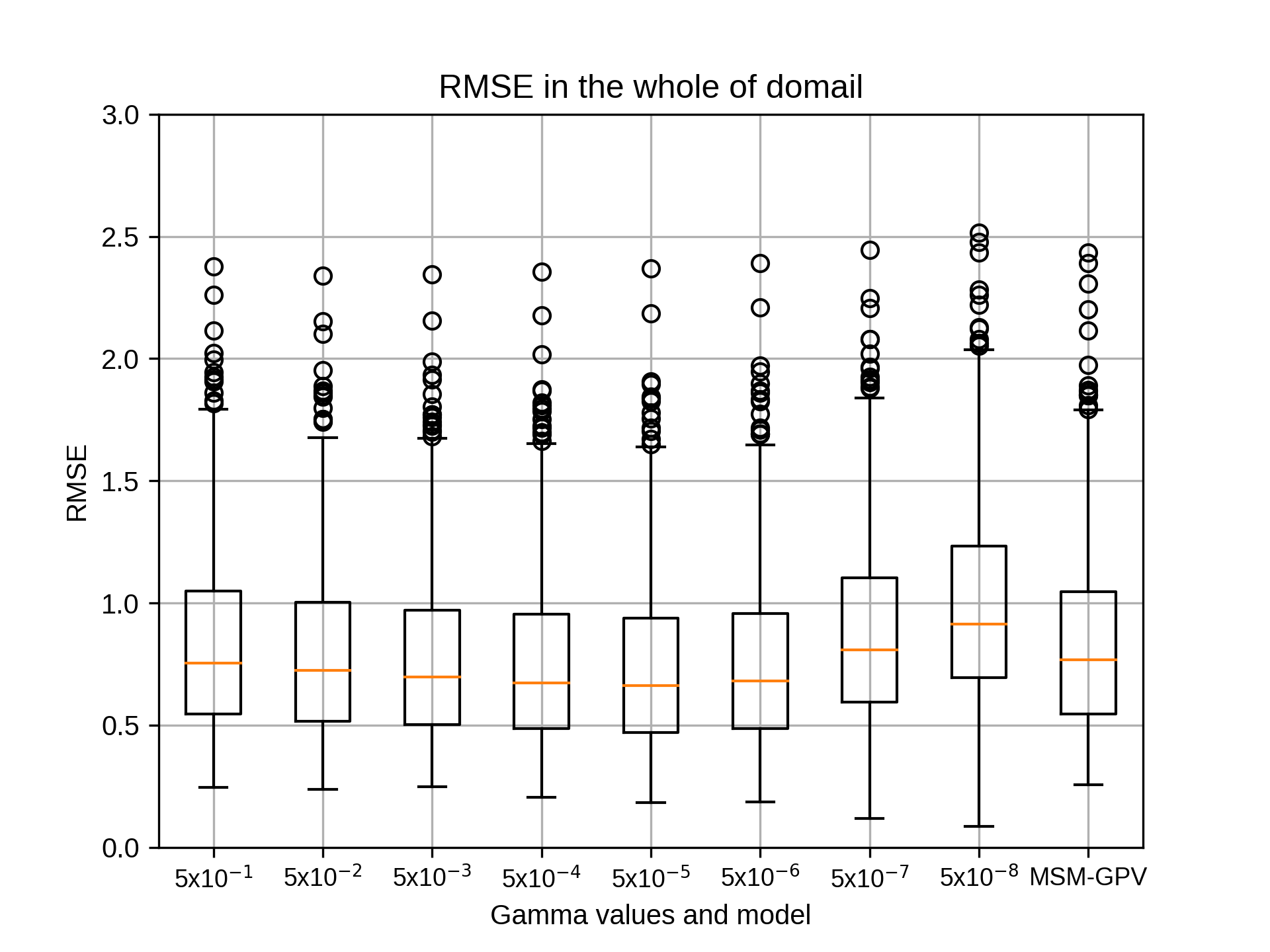

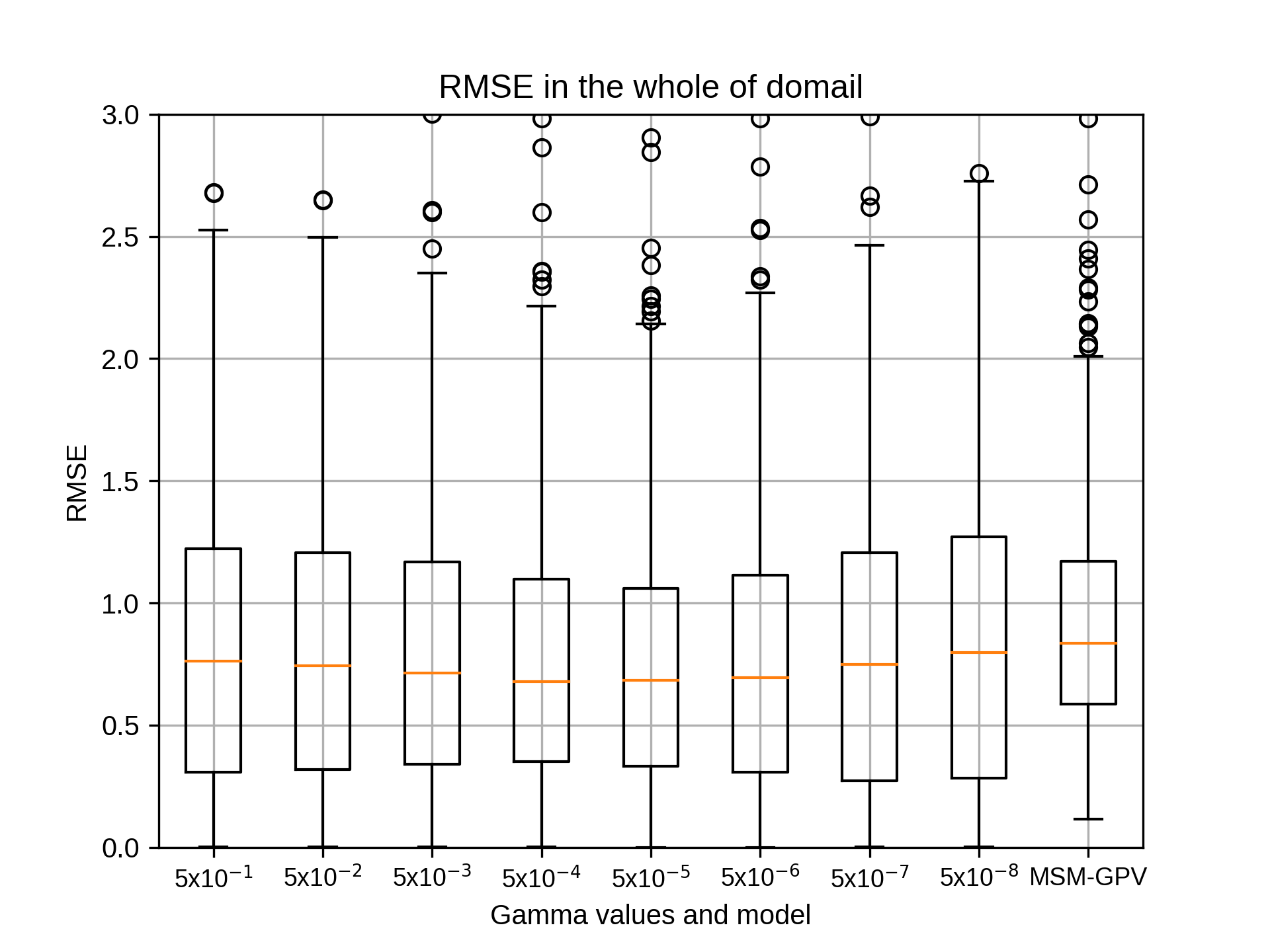

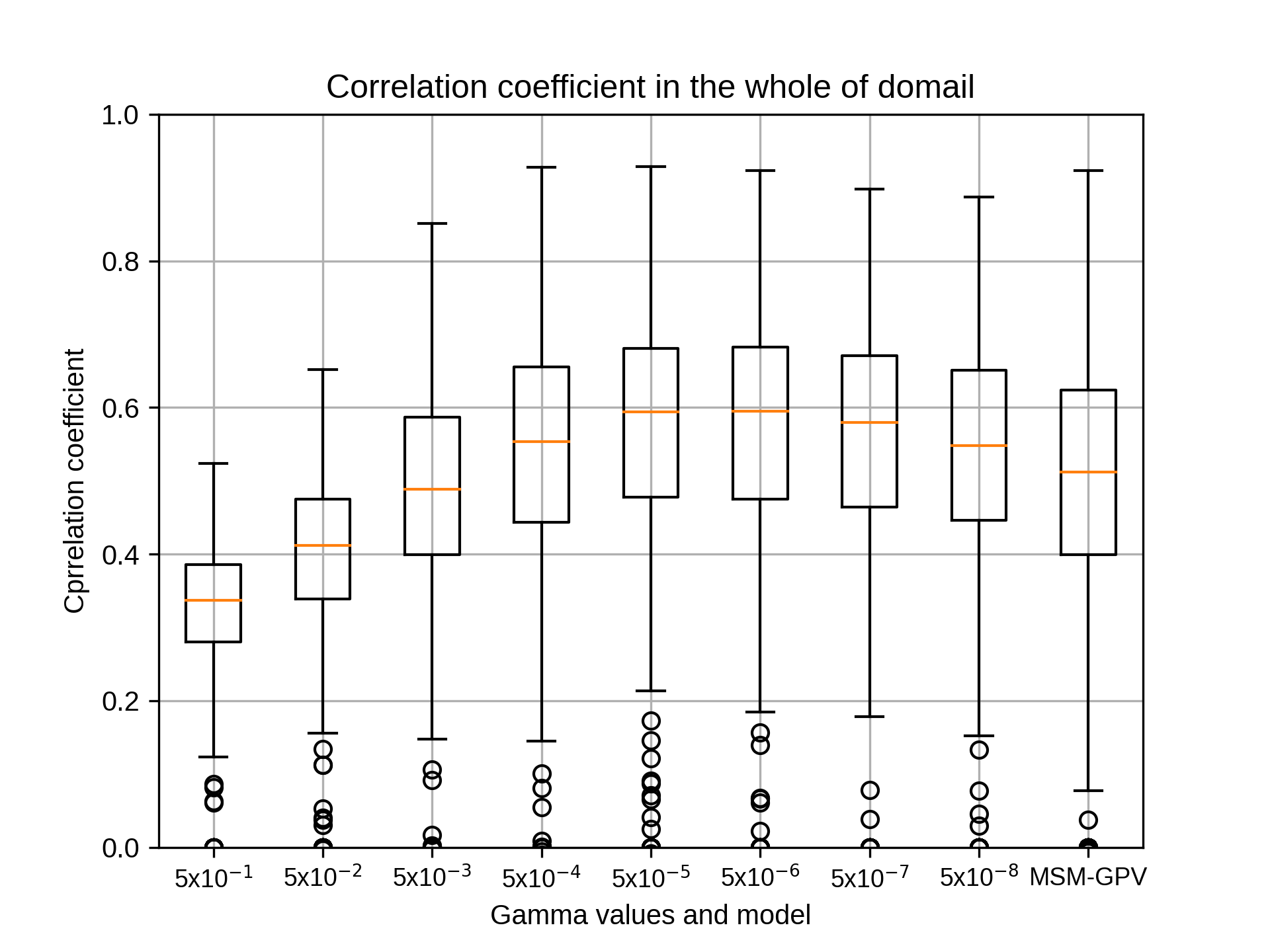

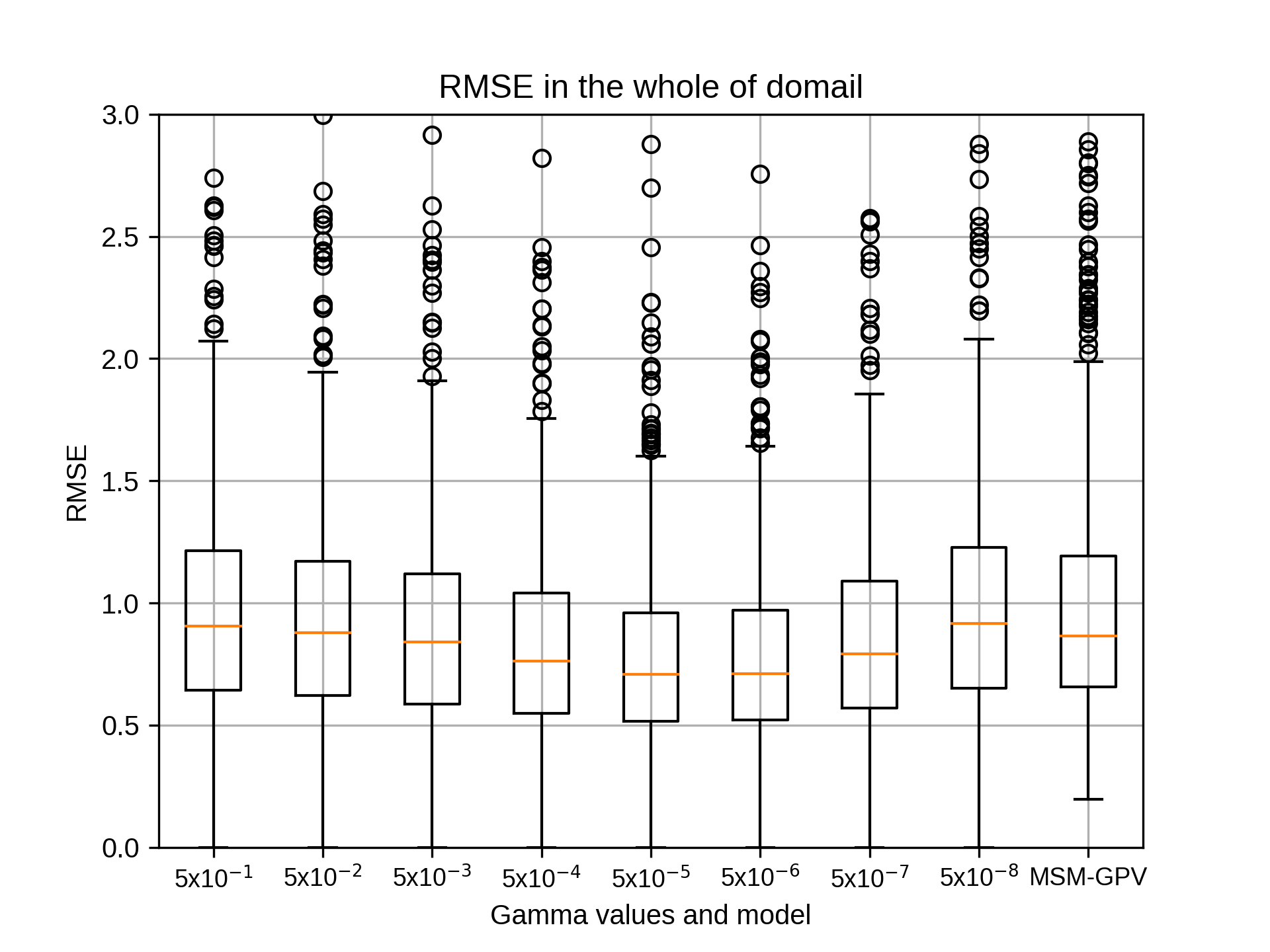

siteA(北海道)につきましてガンマの違いによる結果が出ましたのでお伝えいたします。

エラーを修正し、グラフが出るようにいたしました。ご確認ください。

残っているsiteBは途中でエラーが出ておりますので修正いたします。

siteAのパラメータは以下のとおりです。3桁に修正しております。

以上、よろしくお願いいたします。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

#testyears='2015'

months=${mon} #07

## Grids

xnums='020 030 040 050 060 070 080'

ynums='020 035 050 065 080 095 110'

nums='441'

rg2='10'

##

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

吉兼先生

siteA(北海道)につきましてガンマの違いによる結果が出ましたのでお伝えいたします。

エラーを修正し、グラフが出るようにいたしました。ご確認ください。

残っているsiteBは途中でエラーが出ておりますので修正いたします。

siteAのパラメータは以下のとおりです。3桁に修正しております。

以上、よろしくお願いいたします。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

#testyears='2015'

months=${mon} #07

## Grids

xnums='020 030 040 050 060 070 080'

ynums='020 035 050 065 080 095 110'

nums='441'

rg2='10'

##

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

takao-yWednesday, September 9th, 2020 at 10:18:59 AM GMT+09:00

@kobayashi_yusuke

小林様。ありがとうございます。siteBについて、エラーメッセージを添付していただけますでしょうか。

小林様。ありがとうございます。siteBについて、エラーメッセージを添付していただけますでしょうか。

kobayashi_yusukeWednesday, September 9th, 2020 at 10:24:42 AM GMT+09:00

@takao-y

吉兼先生

siteBにつきましてもグラフを出力することができました。後ほどお伝えいたします。

吉兼先生

siteBにつきましてもグラフを出力することができました。後ほどお伝えいたします。

kobayashi_yusukeWednesday, September 9th, 2020 at 10:30:58 AM GMT+09:00

@takao-y

吉兼先生

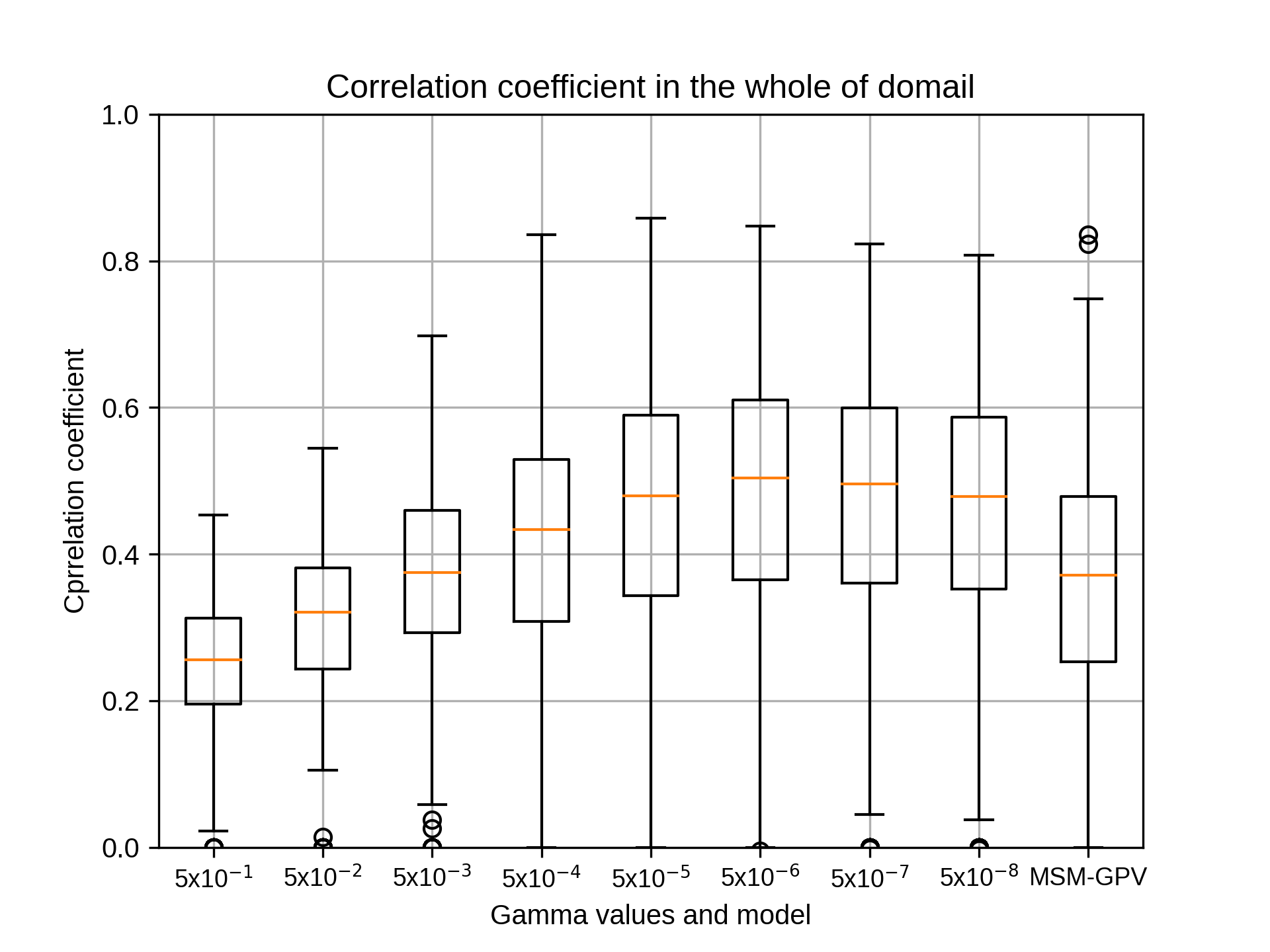

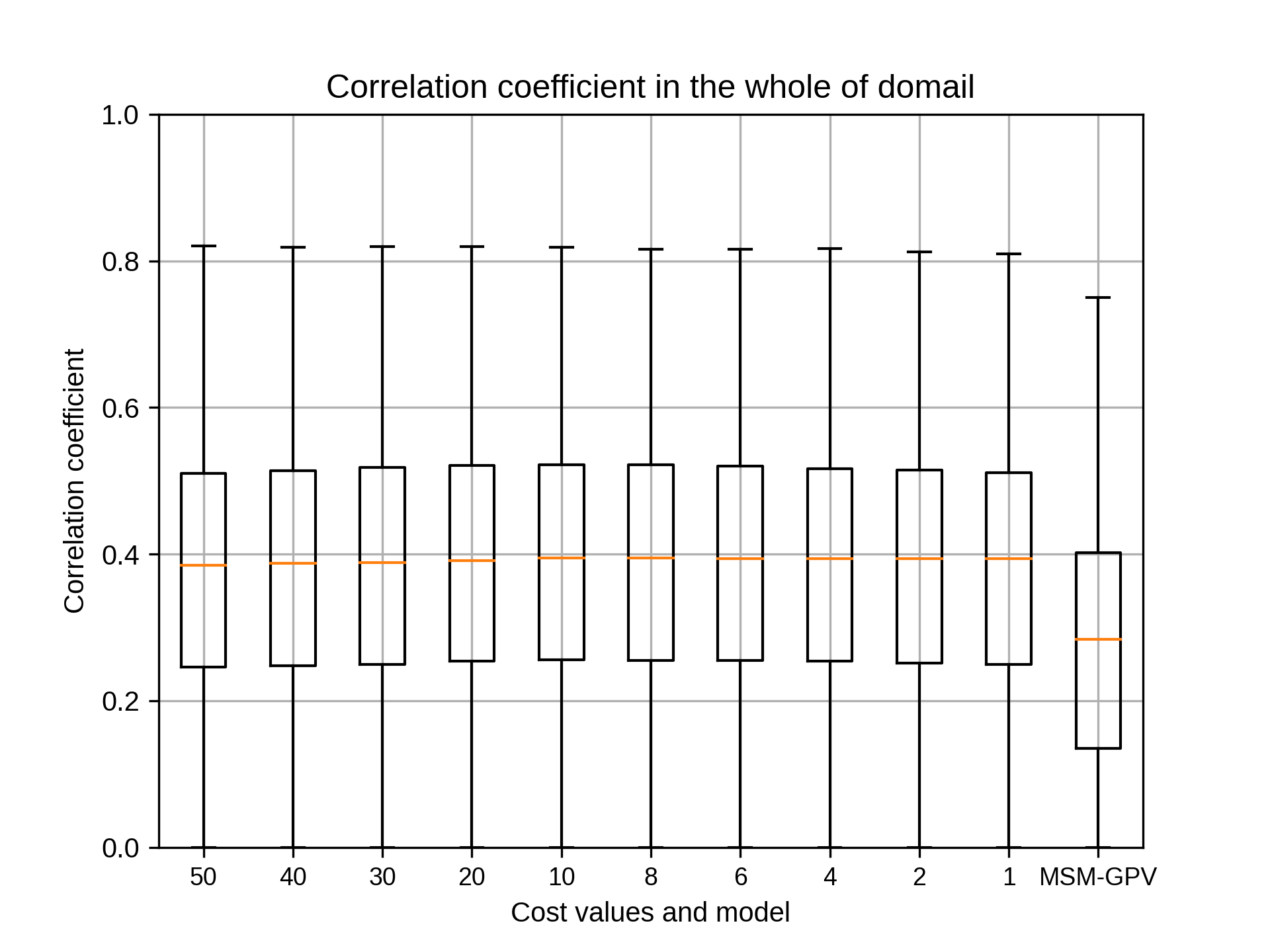

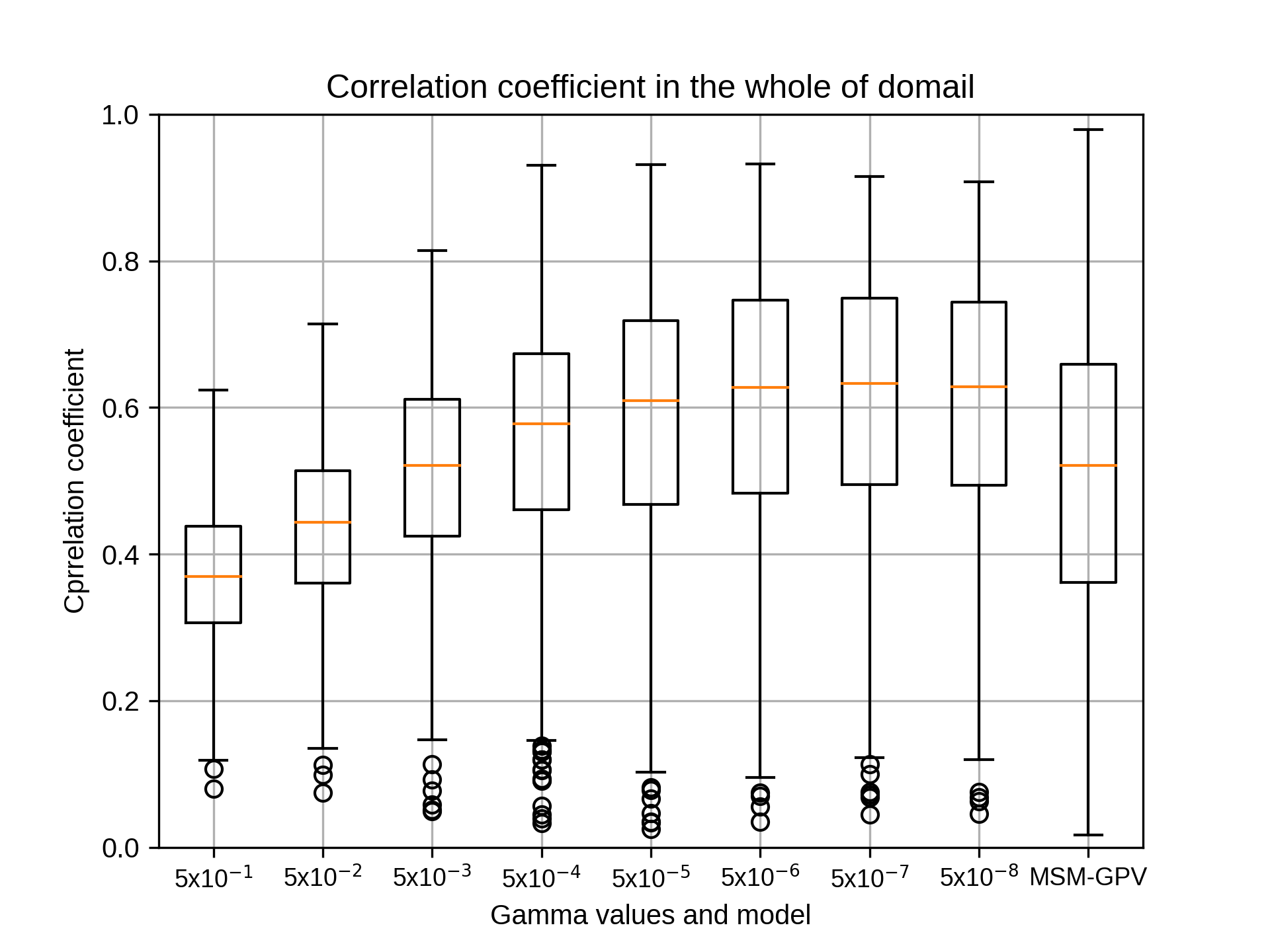

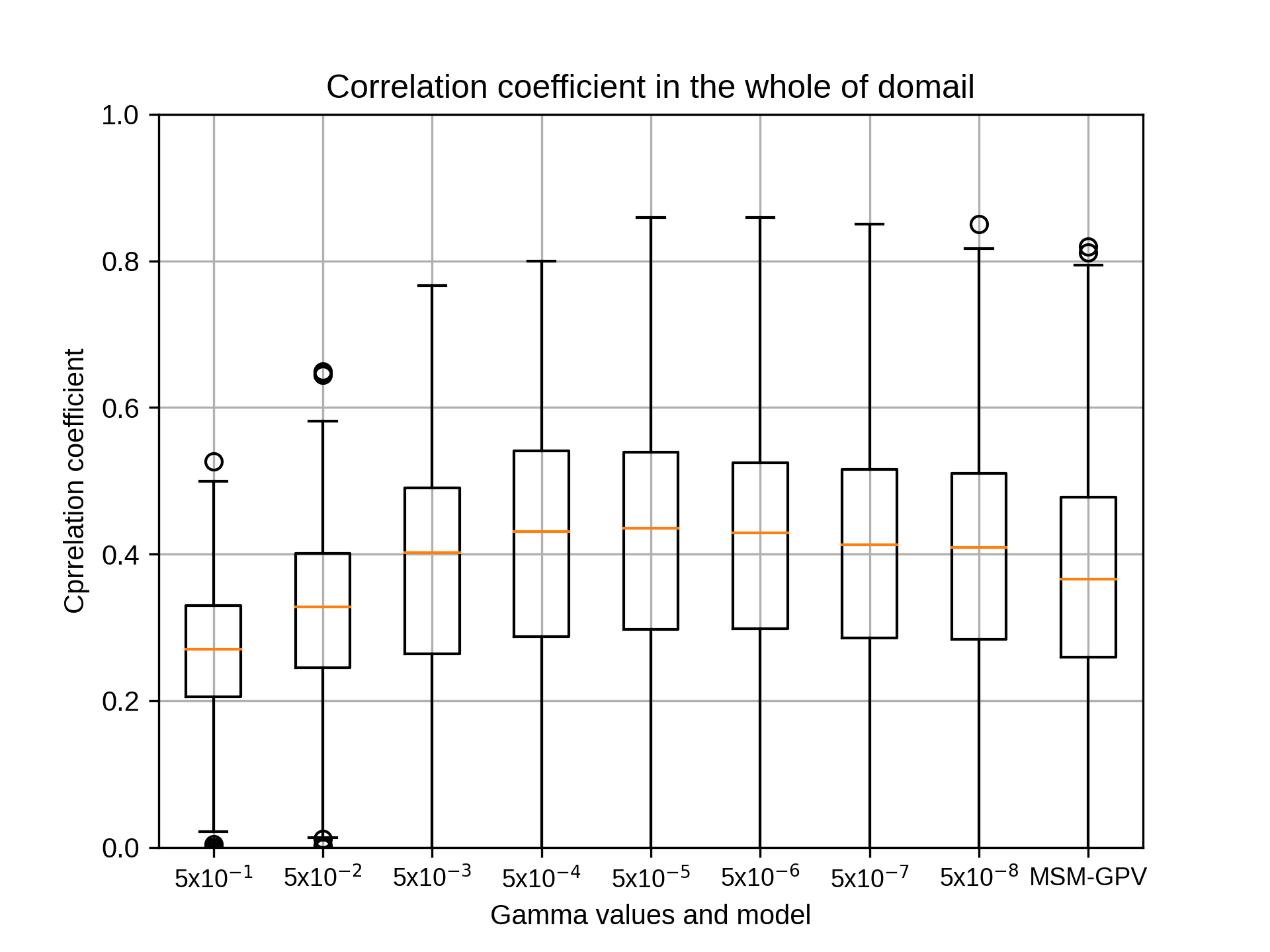

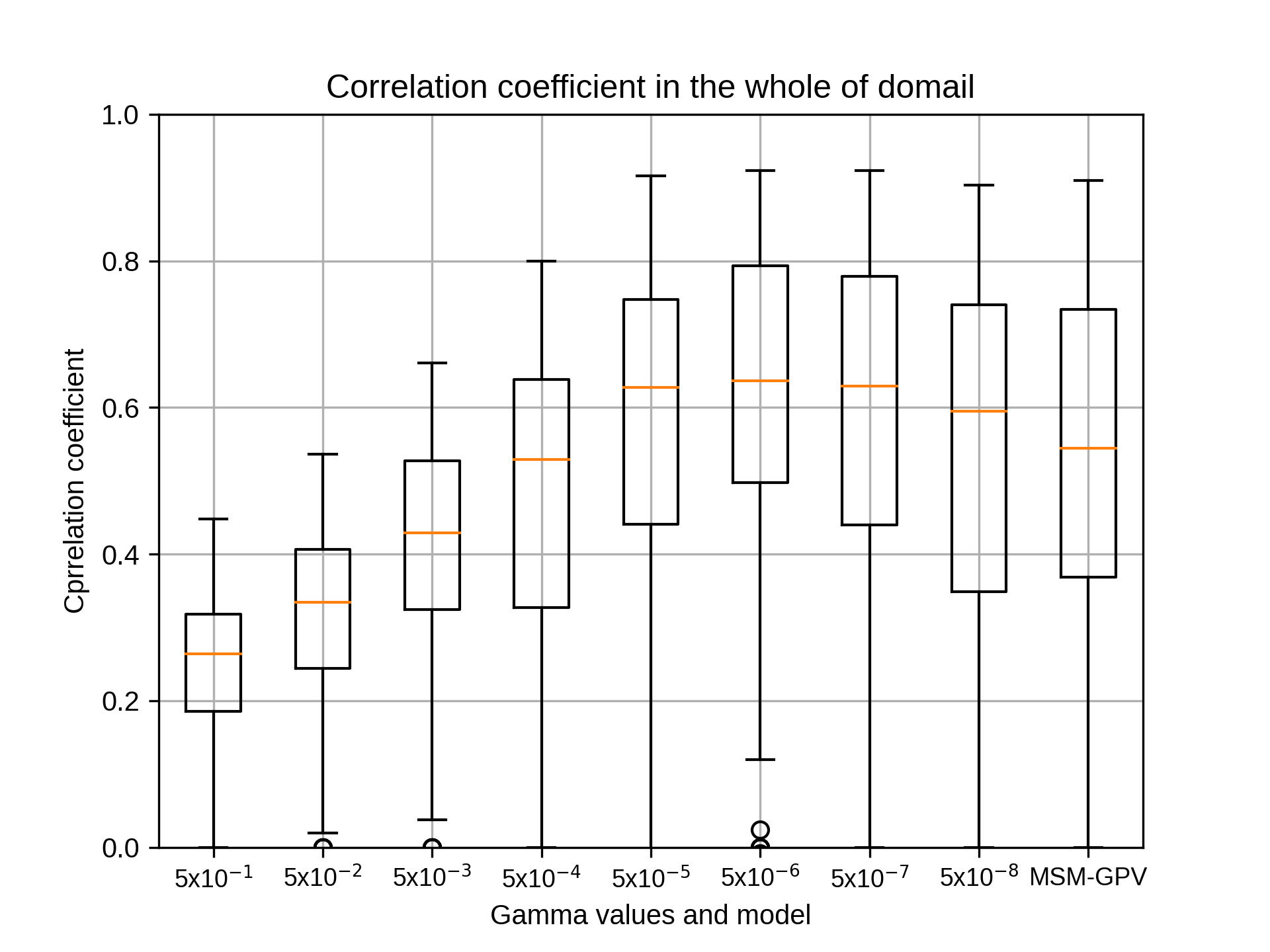

siteB(東日本)につきましてガンマの違いによる結果が出ましたのでお伝えいたします。

エラーを修正し、グラフが出るようにいたしました。ご確認ください。

これでsiteA~siteEすべて出力できるようになりました。

ご確認いただいてsiteA~siteEそれぞれでのガンマのパラメータを確定させ、次のコストやエプシロンのパラメータのご指示をいただけると幸いです。

なお、コメントアウトされているコストとエプシロンのパラメータは以下のとおりです。

## Hyper-parameter (Cost)

#c2='50 40 30 20 10 8 6 4 2 1'

## Hyper-parameter (Epsilon)

#ep='1.0 0.1 0.01 0.001 0.0001 0.00001'

また、今回作成したグラフのsiteBのパラメータは以下のとおりです。

以上、よろしくお願いいたします。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon}

## Grids

xnums='020 030 040 050 060 070 080'

ynums='020 035 050 065 080 095 110'

nums='441'

rg2='10'

##

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

吉兼先生

siteB(東日本)につきましてガンマの違いによる結果が出ましたのでお伝えいたします。

エラーを修正し、グラフが出るようにいたしました。ご確認ください。

これでsiteA~siteEすべて出力できるようになりました。

ご確認いただいてsiteA~siteEそれぞれでのガンマのパラメータを確定させ、次のコストやエプシロンのパラメータのご指示をいただけると幸いです。

なお、コメントアウトされているコストとエプシロンのパラメータは以下のとおりです。

## Hyper-parameter (Cost)

#c2='50 40 30 20 10 8 6 4 2 1'

## Hyper-parameter (Epsilon)

#ep='1.0 0.1 0.01 0.001 0.0001 0.00001'

また、今回作成したグラフのsiteBのパラメータは以下のとおりです。

以上、よろしくお願いいたします。

allyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

testyears='2007 2008 2009 2010 2011 2012 2013 2014 2015 2016 2017 2018'

months=${mon}

## Grids

xnums='020 030 040 050 060 070 080'

ynums='020 035 050 065 080 095 110'

nums='441'

rg2='10'

##

## Hyper-parameter (Gamma)

gm='0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'

## Hyper-parameter (Cost)

c2='10'

## Hyper-parameter (Epsilon)

ep='0.001'

takao-yWednesday, September 9th, 2020 at 10:35:05 AM GMT+09:00

@kobayashi_yusuke

小林様。ありがとうございます。早速で申し訳ないのですが、次は7月についてお願いできますでしょうか。

小林様。ありがとうございます。早速で申し訳ないのですが、次は7月についてお願いできますでしょうか。

kobayashi_yusukeWednesday, September 9th, 2020 at 10:37:04 AM GMT+09:00

@takao-y

吉兼先生

お返事ありがとうございます。今回の計算対象はsiteA~Eまですべて7月で行っております。グラフをご確認いただき、ご意見をいただけると幸いです。

吉兼先生

お返事ありがとうございます。今回の計算対象はsiteA~Eまですべて7月で行っております。グラフをご確認いただき、ご意見をいただけると幸いです。

takao-yWednesday, September 9th, 2020 at 10:40:34 AM GMT+09:00

@kobayashi_yusuke

小林様。ありがとうございます。すみません。よく確認していませんでした。それでは、1月をお願いできますでしょうか。その後で、4月,10月も同様に実施していただけますでしょうか。

小林様。ありがとうございます。すみません。よく確認していませんでした。それでは、1月をお願いできますでしょうか。その後で、4月,10月も同様に実施していただけますでしょうか。

kobayashi_yusukeWednesday, September 9th, 2020 at 1:13:38 PM GMT+09:00

@takao-y

吉兼先生

承知しました。

ガンマにつきまして1月を行い、その後4月、10月も同様に行います。

結果が出ましたら改めてご連絡いたします。よろしくお願いします。

吉兼先生

承知しました。

ガンマにつきまして1月を行い、その後4月、10月も同様に行います。

結果が出ましたら改めてご連絡いたします。よろしくお願いします。

takao-yWednesday, September 9th, 2020 at 4:25:05 PM GMT+09:00

@kobayashi_yusuke

小林様。すみません。勘違いしていました。今はガンマだけだったのですね。それでは、CとEpsilonについても同様にお願いできますでしょうか。まずは7月ですね。

小林様。すみません。勘違いしていました。今はガンマだけだったのですね。それでは、CとEpsilonについても同様にお願いできますでしょうか。まずは7月ですね。

kobayashi_yusukeWednesday, September 9th, 2020 at 5:23:05 PM GMT+09:00

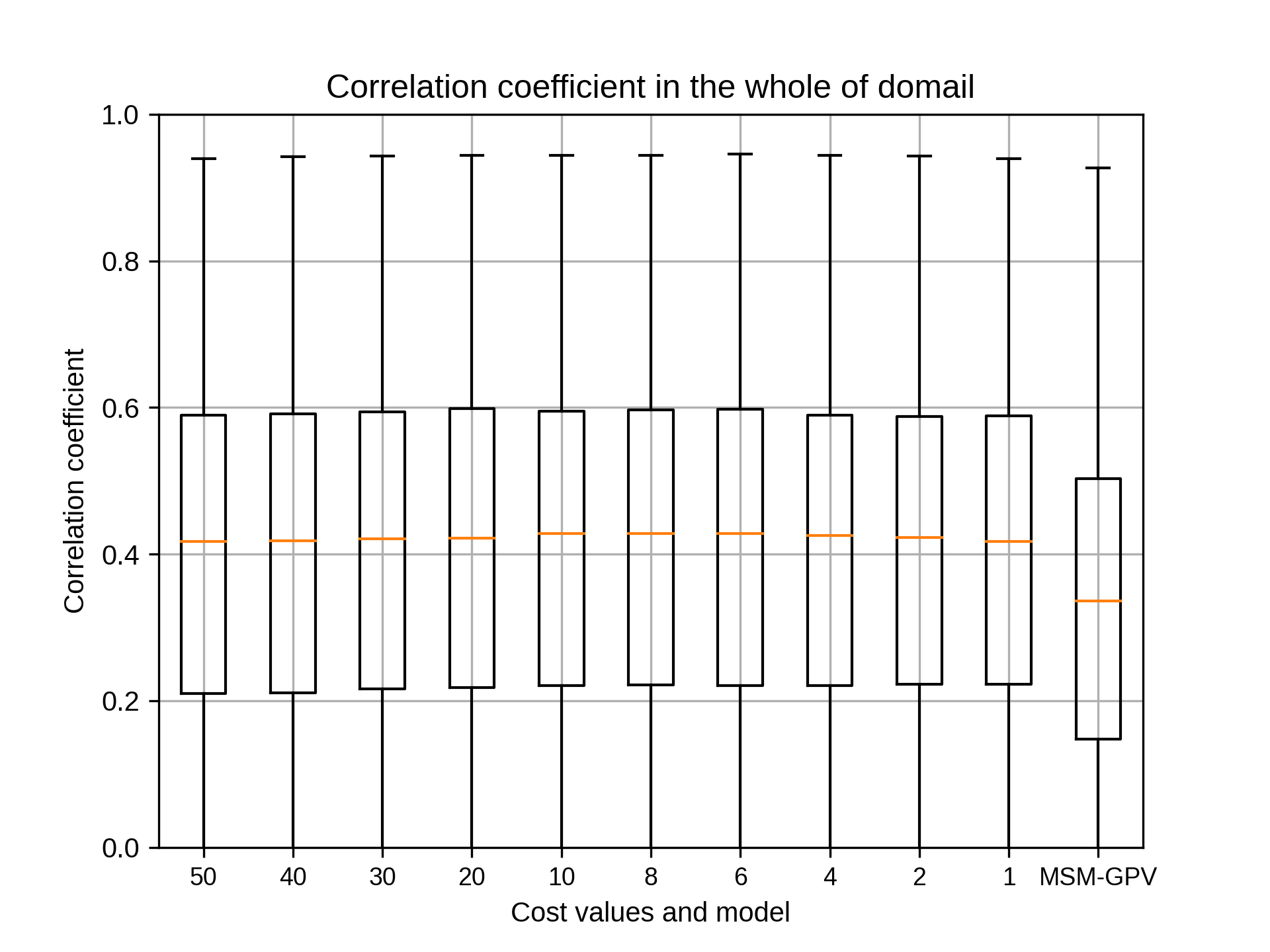

@takao-y

吉兼先生

ご連絡ありがとうございます。

7月につきましてsiteAからsiteEのコストとエプシロンを出すようにいたします。

まず、コストを決めるにあたってガンマを固定する必要がございますが、ガンマの値はいくつにすればよろしいでしょうか。

これまでご提示しましたグラフをもとにsiteA・siteB・siteC・siteD・siteEそれぞれのガンマ値をご教授くださると大変ありがたく思います。

またコストにつきまして、以下でよろしいでしょうか。

## Hyper-parameter (Cost)

#c2='50 40 30 20 10 8 6 4 2 1'

コストのグラフを出力するにあたって、プログラムの改修が必要ですのでそちらに着手いたします。

以上、よろしくお願いいたします。

吉兼先生

ご連絡ありがとうございます。

7月につきましてsiteAからsiteEのコストとエプシロンを出すようにいたします。

まず、コストを決めるにあたってガンマを固定する必要がございますが、ガンマの値はいくつにすればよろしいでしょうか。

これまでご提示しましたグラフをもとにsiteA・siteB・siteC・siteD・siteEそれぞれのガンマ値をご教授くださると大変ありがたく思います。

またコストにつきまして、以下でよろしいでしょうか。

## Hyper-parameter (Cost)

#c2='50 40 30 20 10 8 6 4 2 1'

コストのグラフを出力するにあたって、プログラムの改修が必要ですのでそちらに着手いたします。

以上、よろしくお願いいたします。

takao-yWednesday, September 9th, 2020 at 5:40:49 PM GMT+09:00

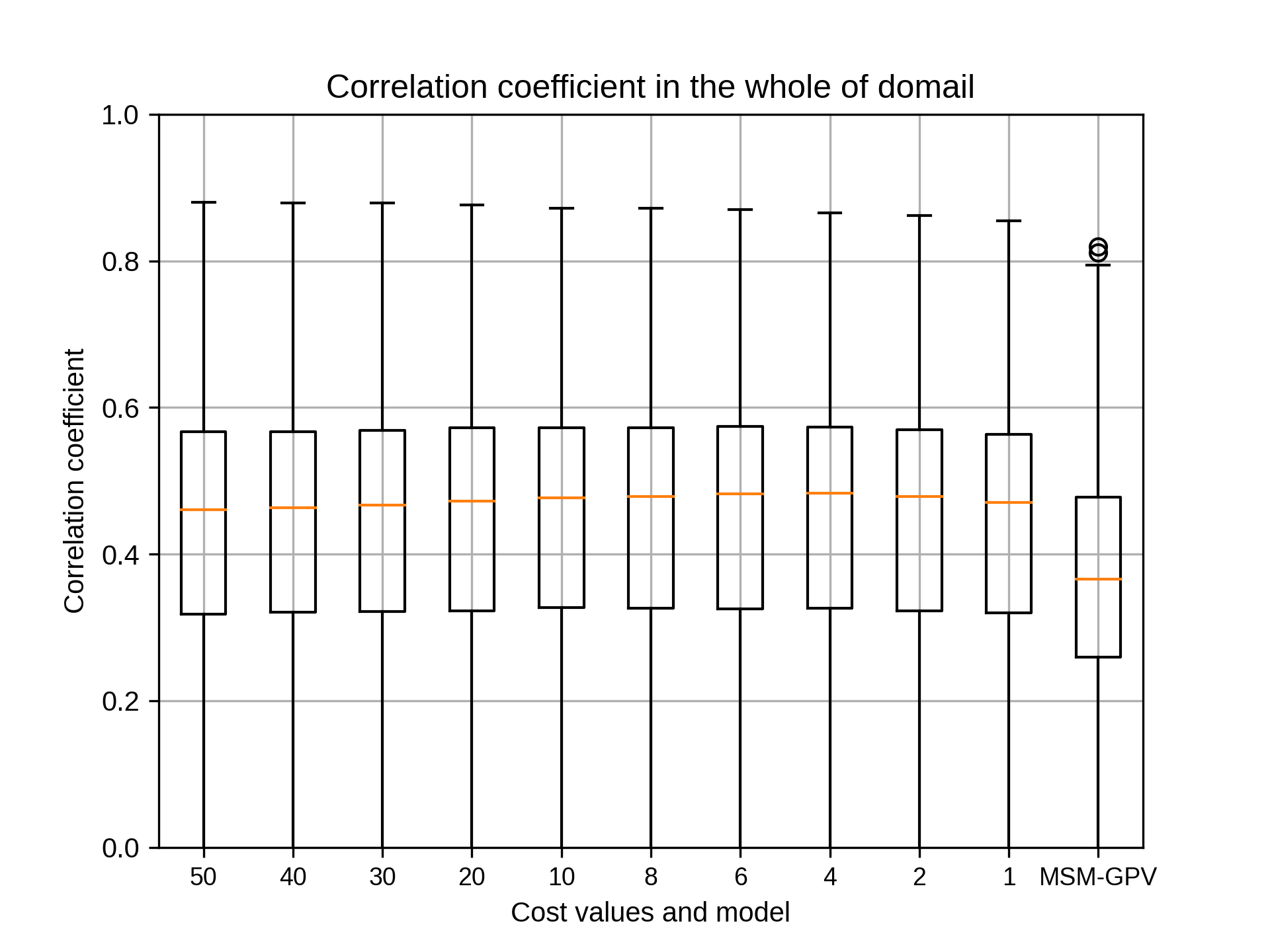

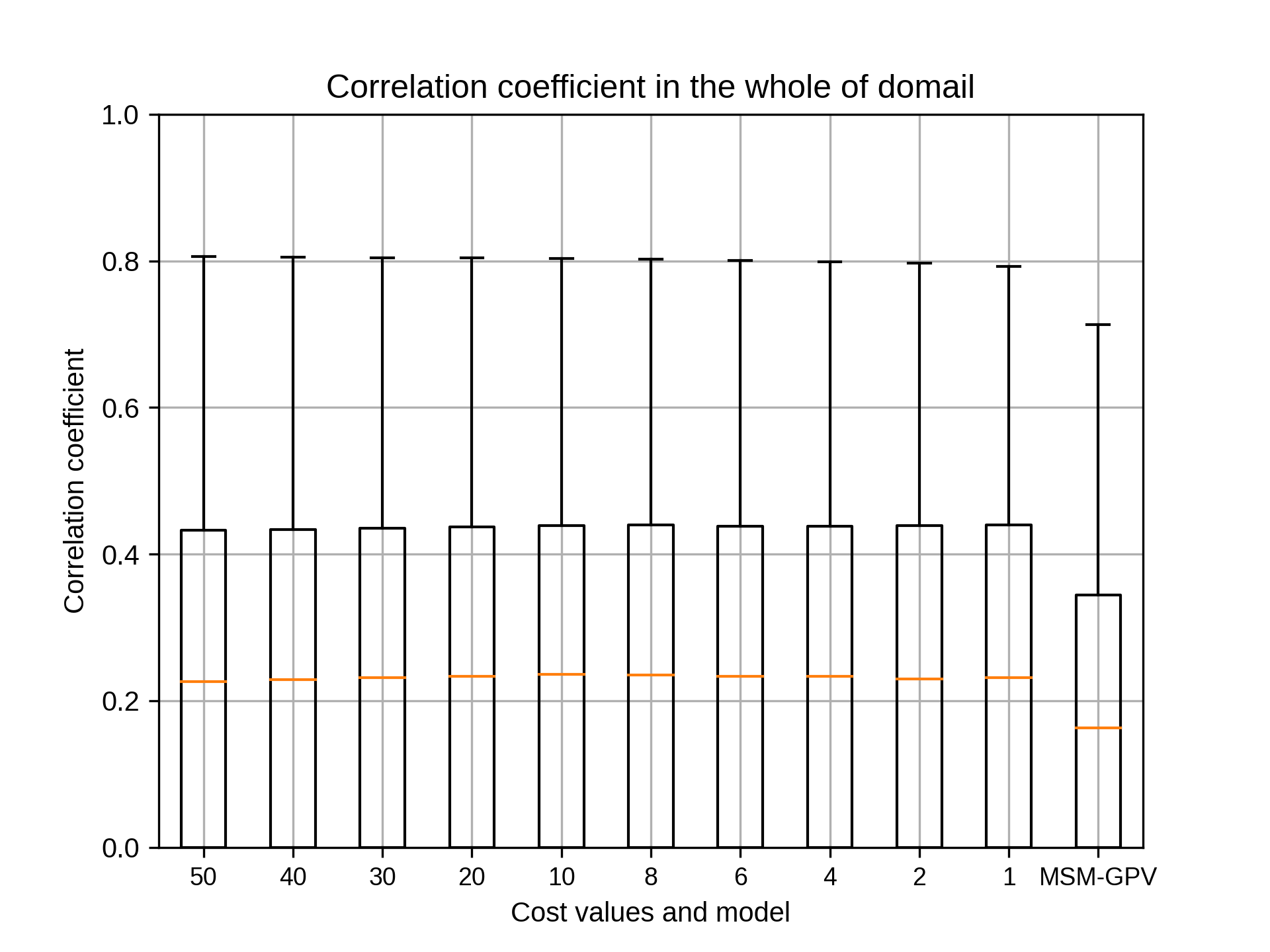

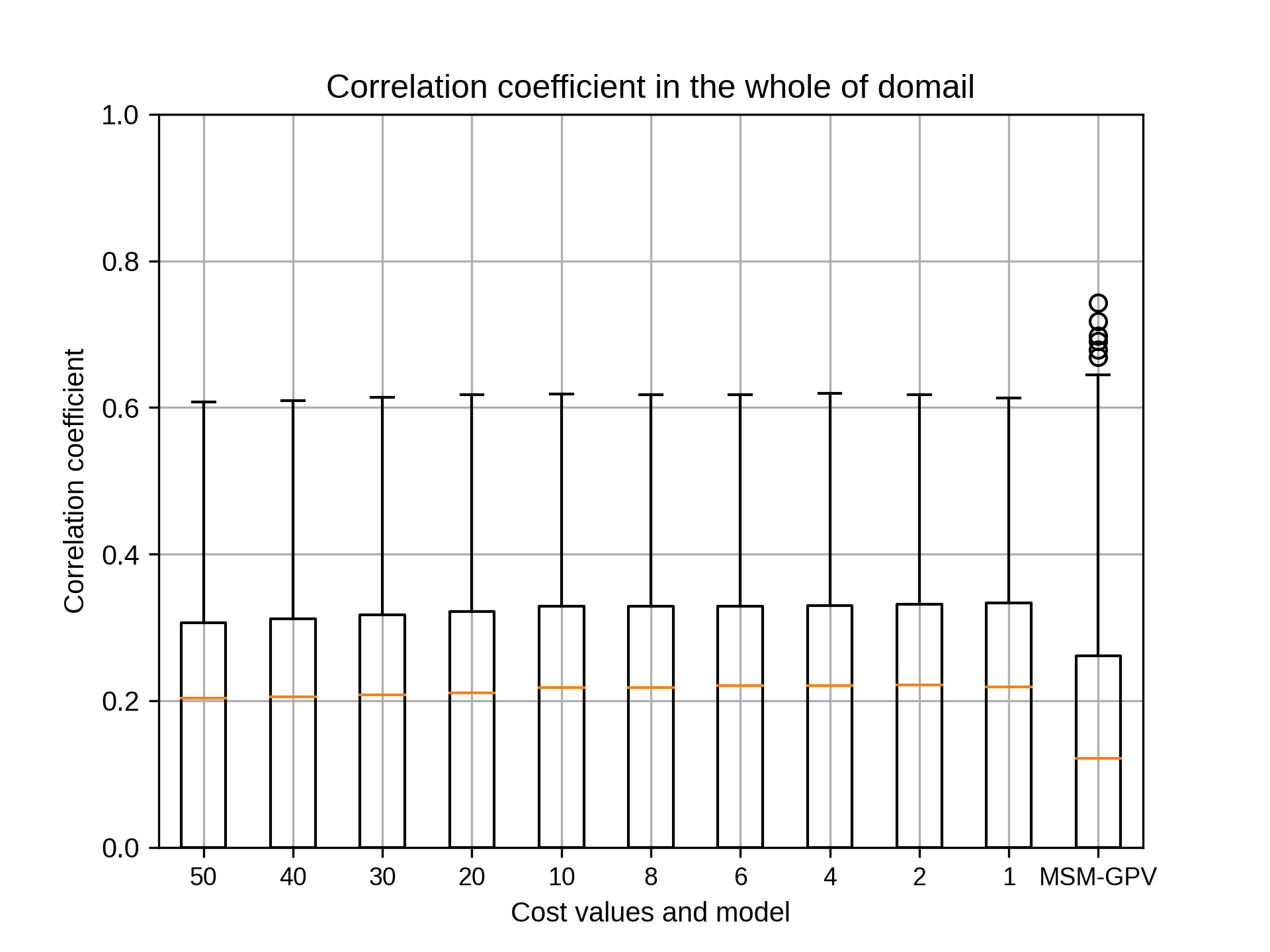

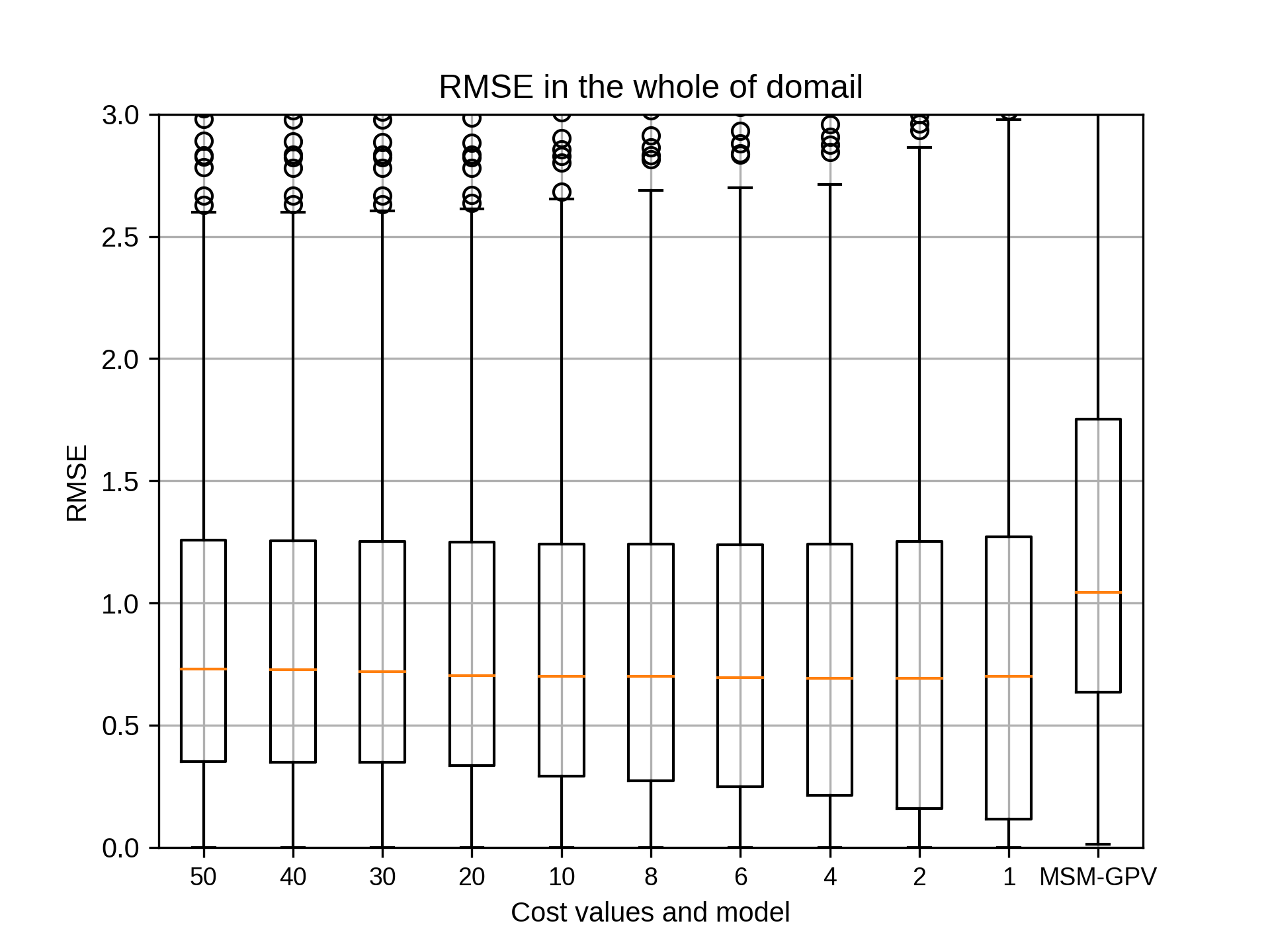

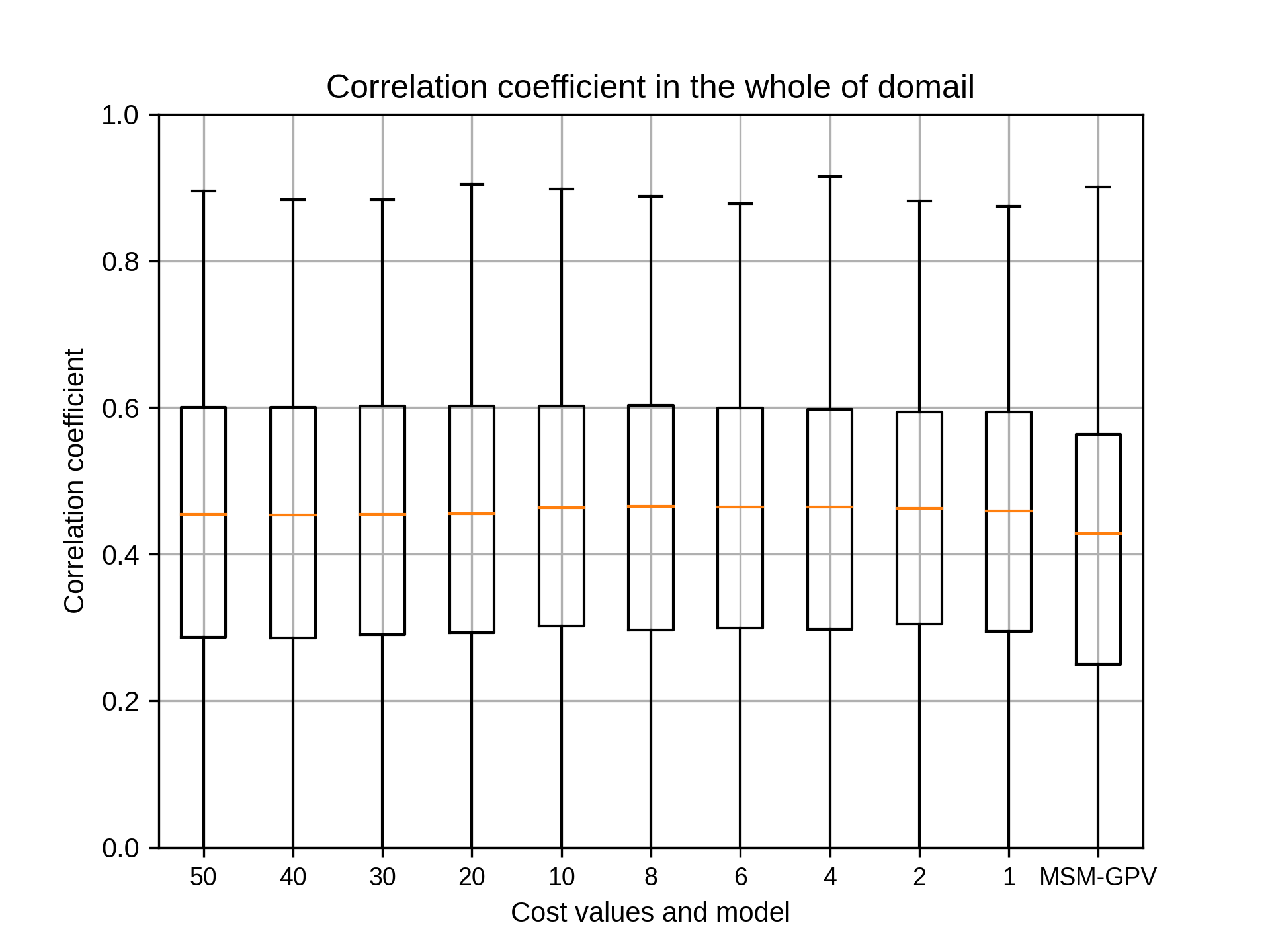

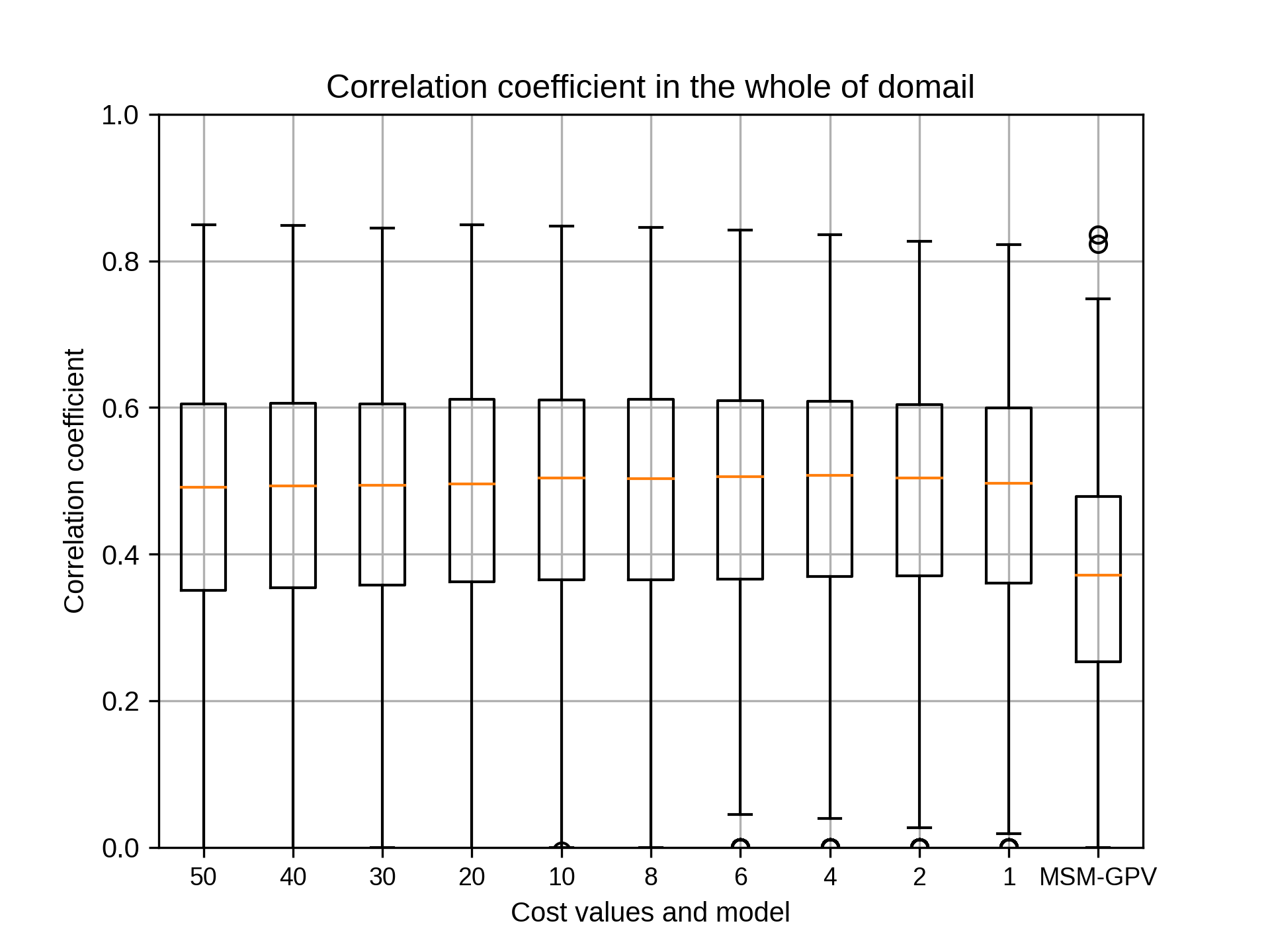

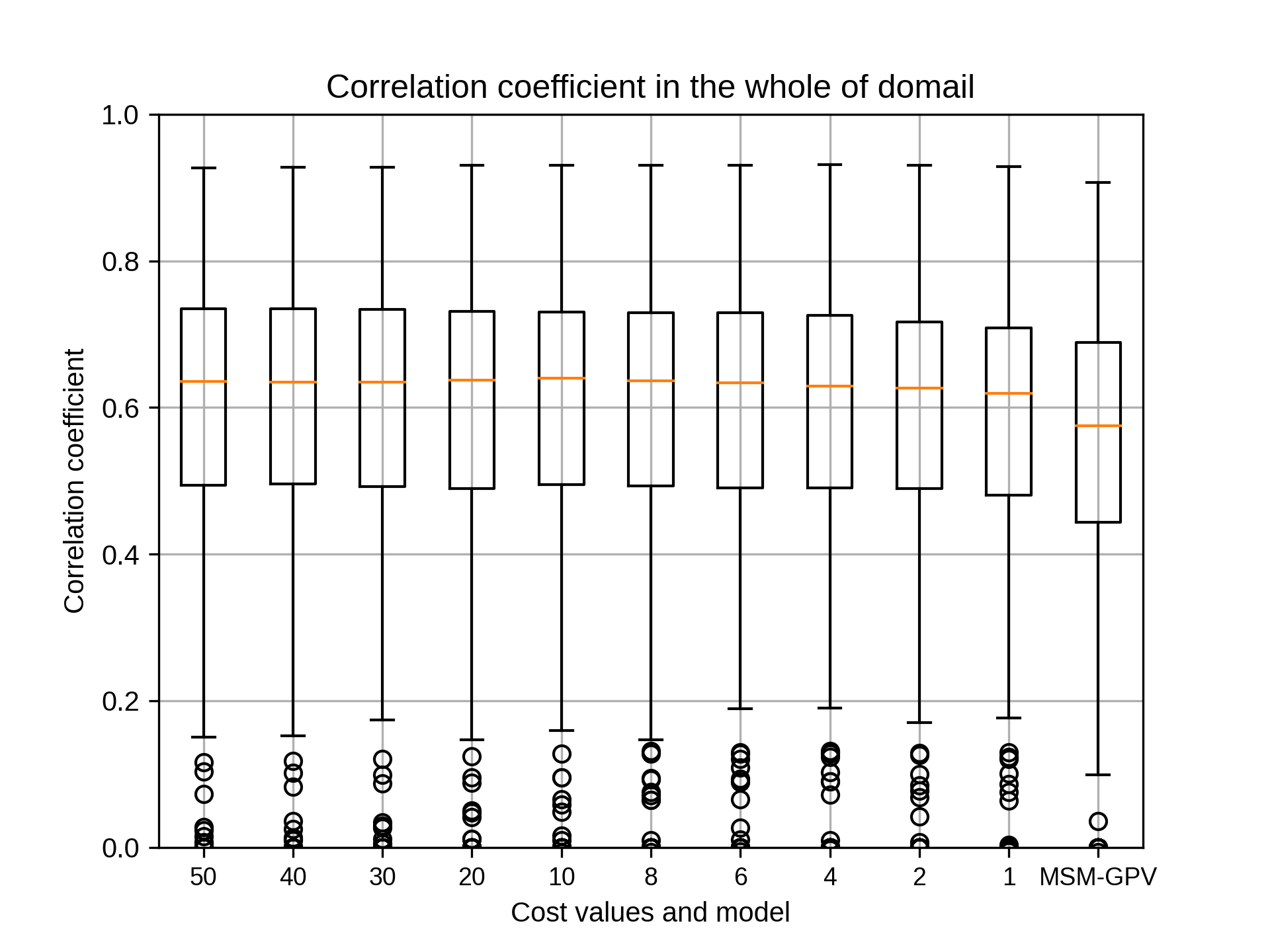

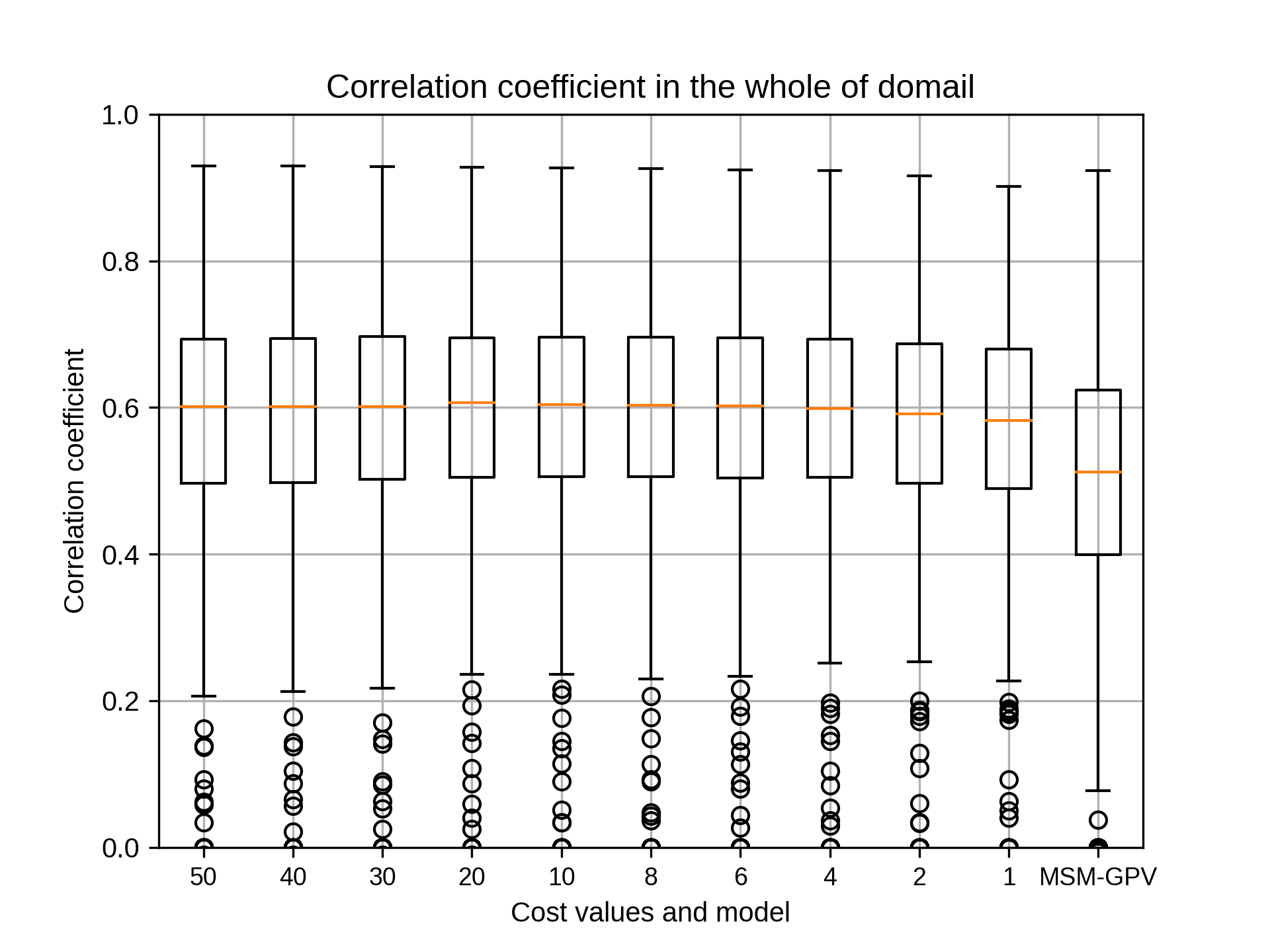

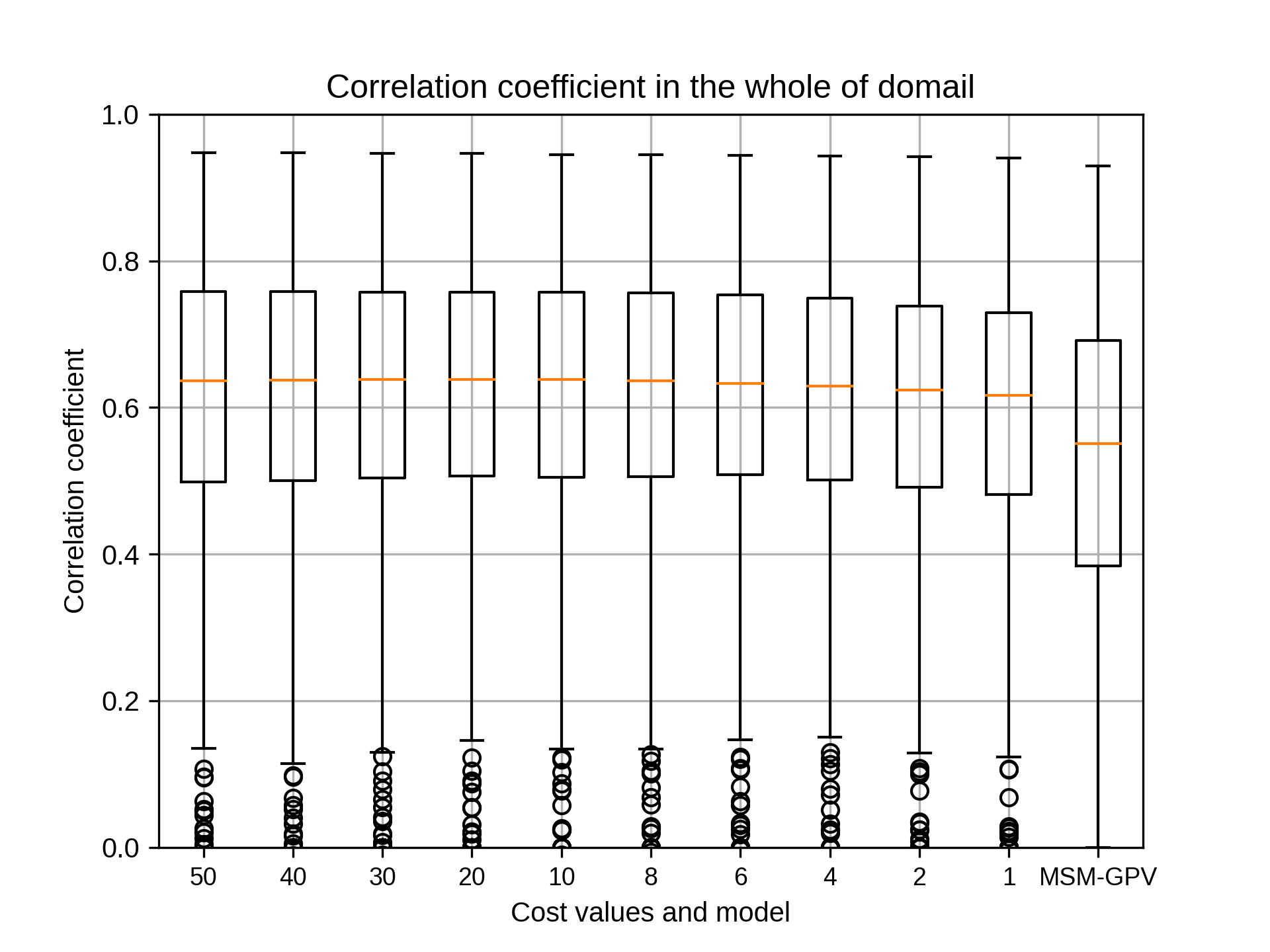

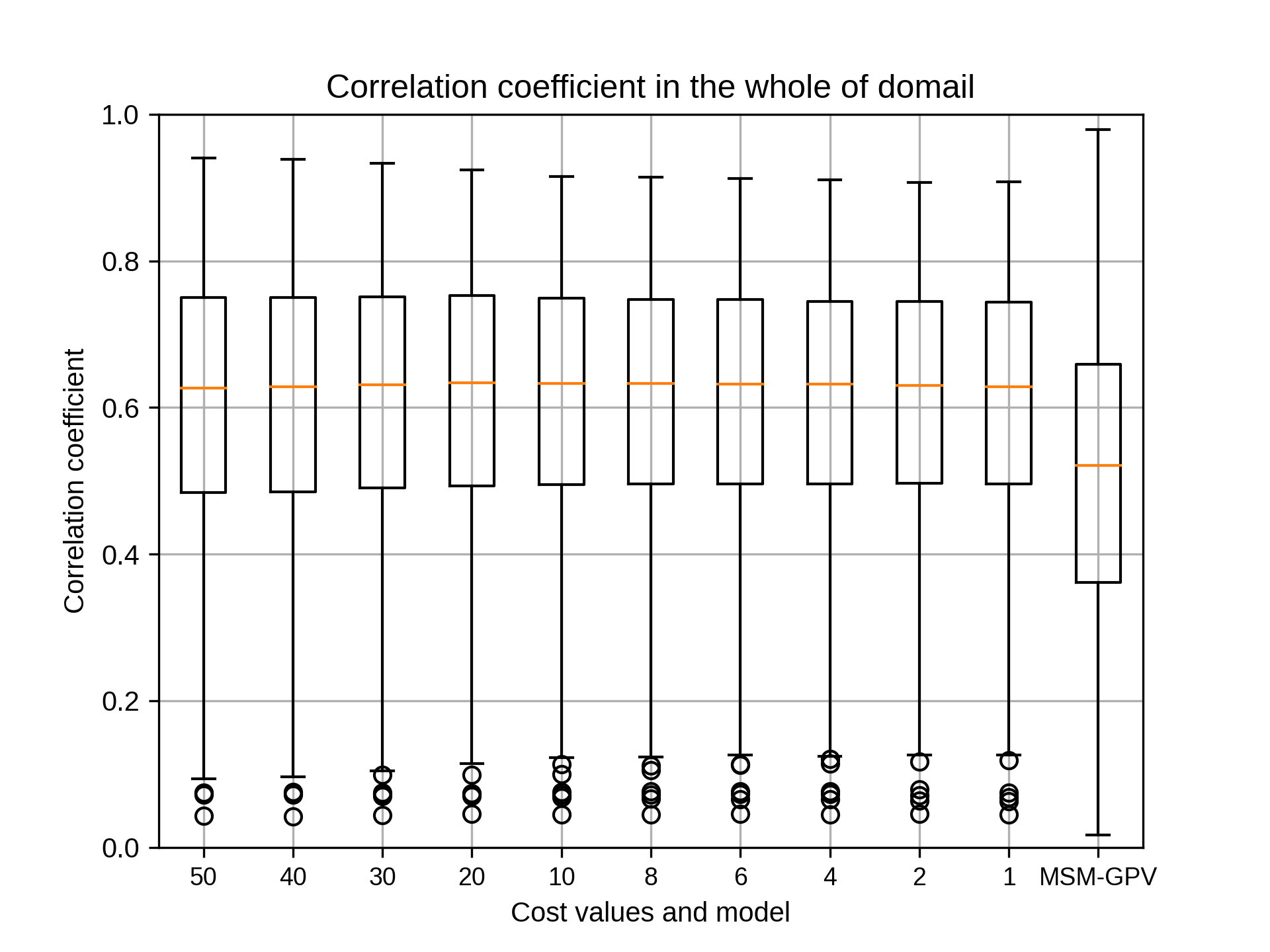

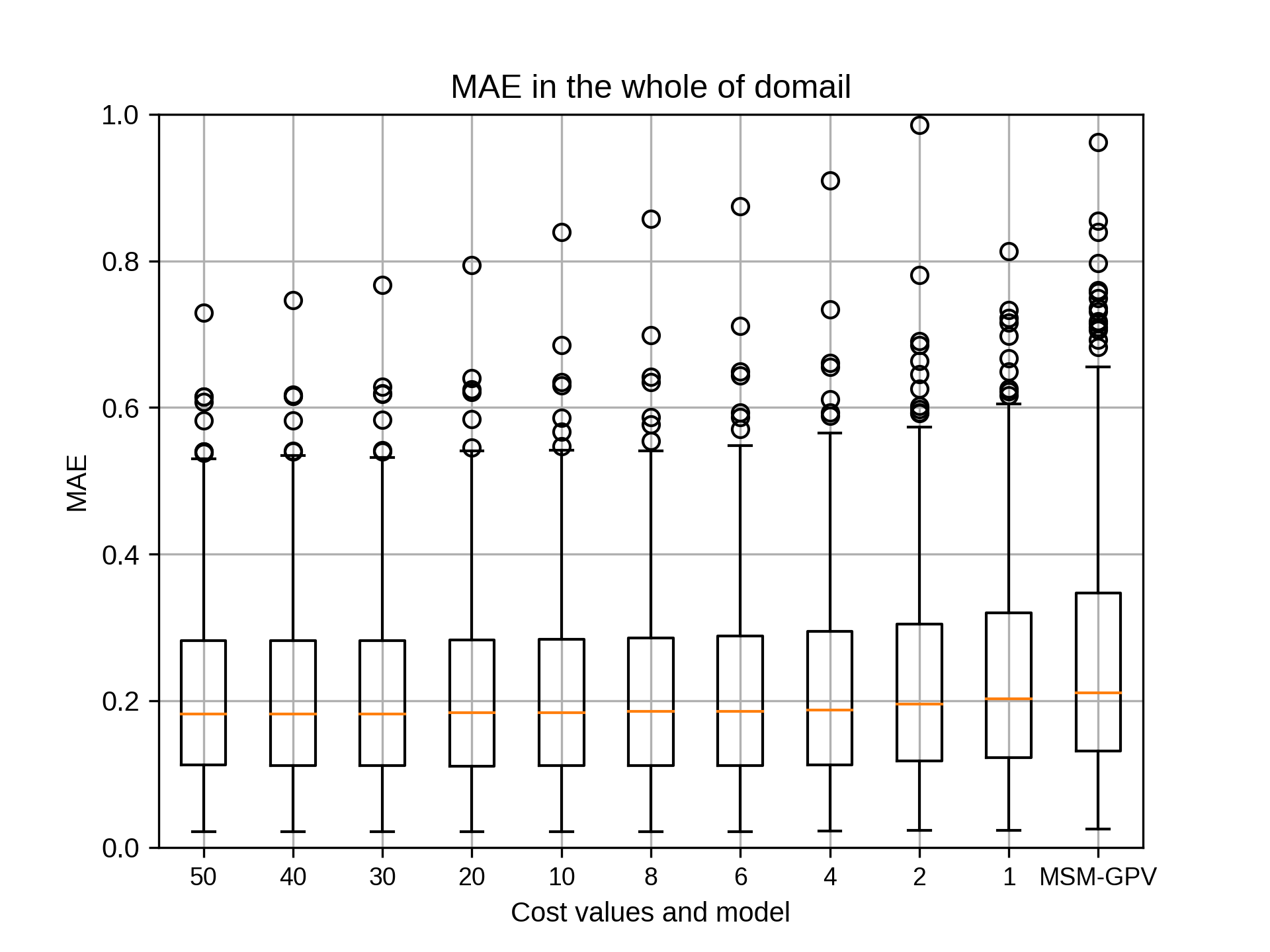

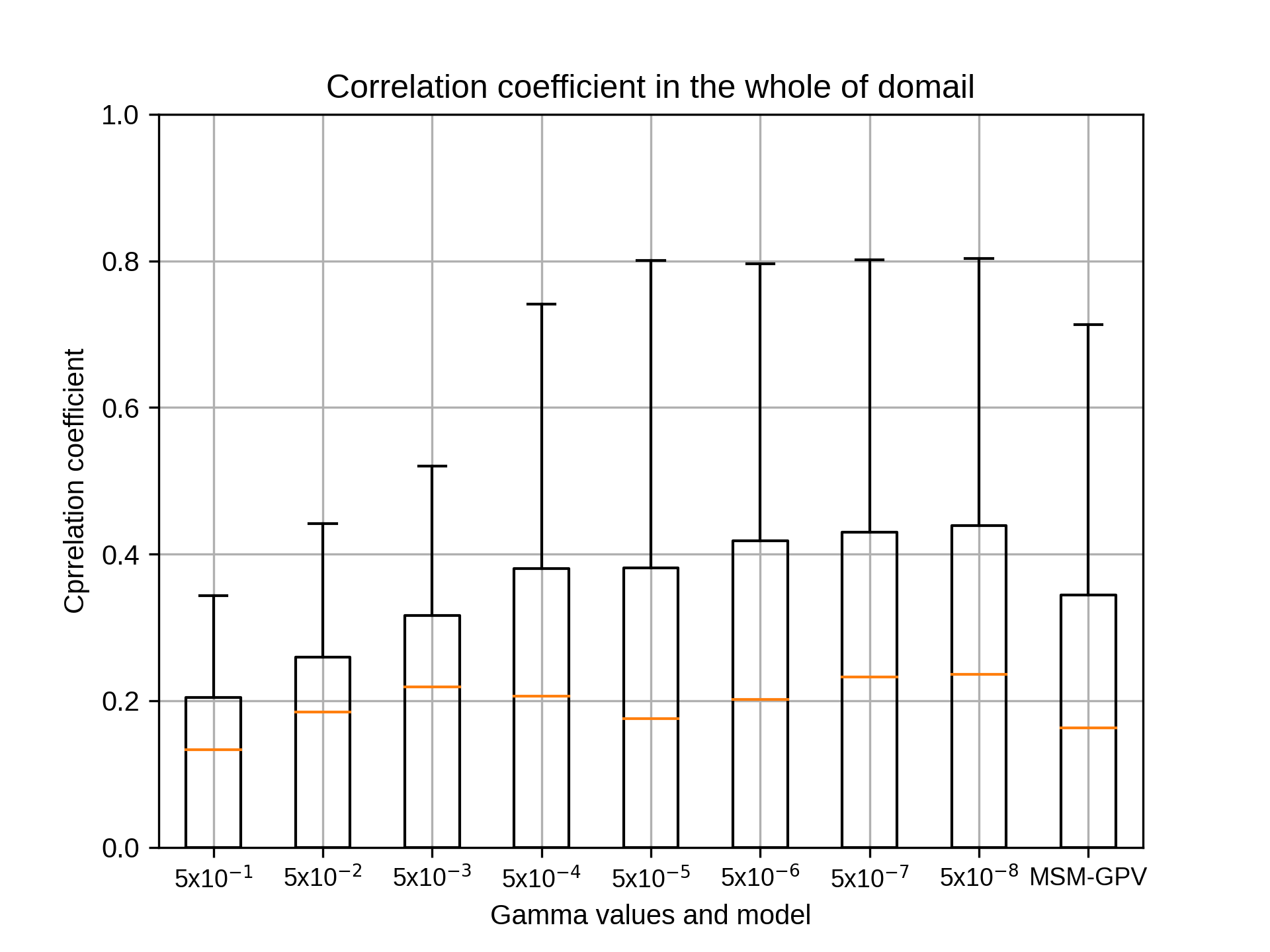

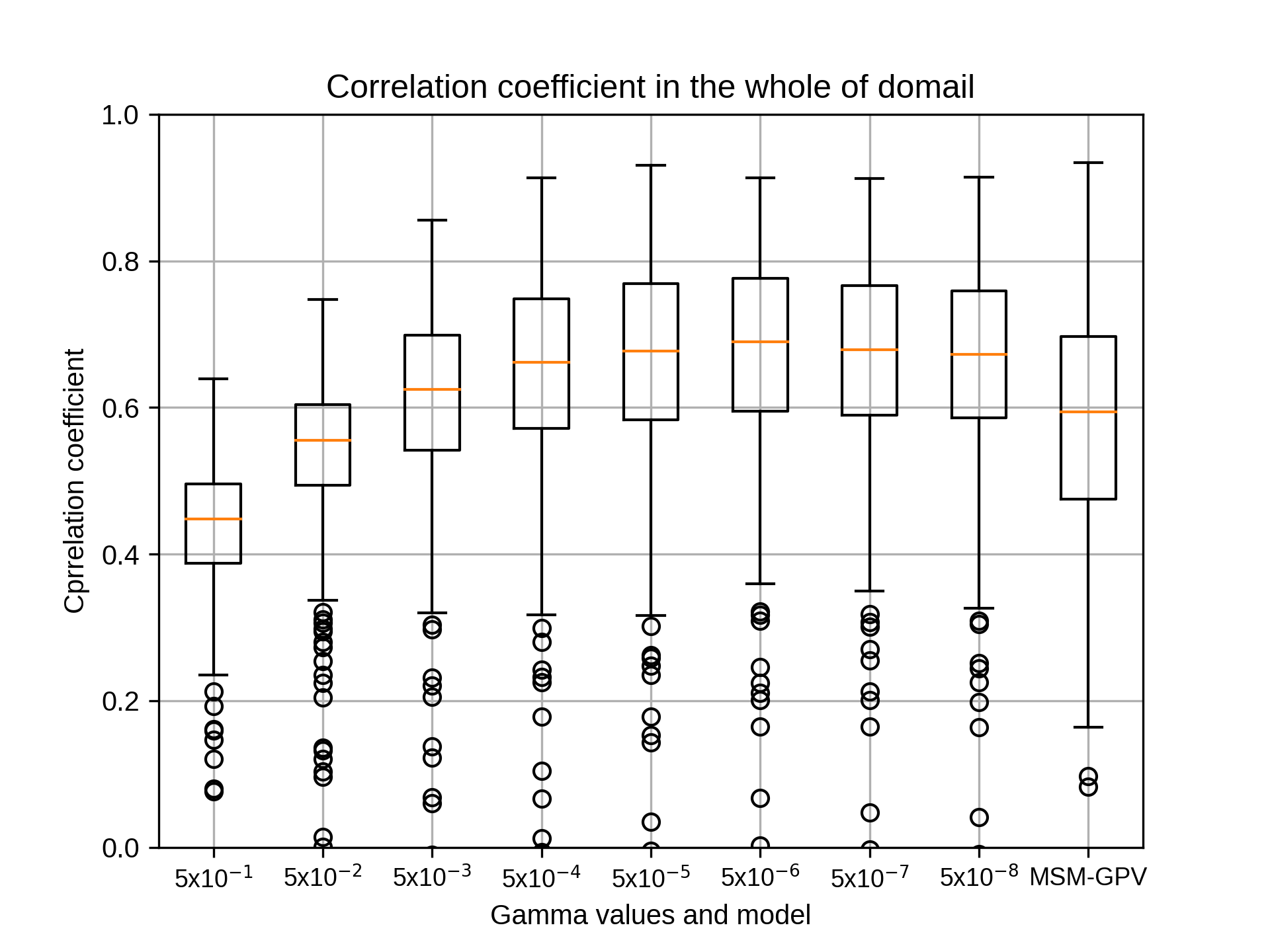

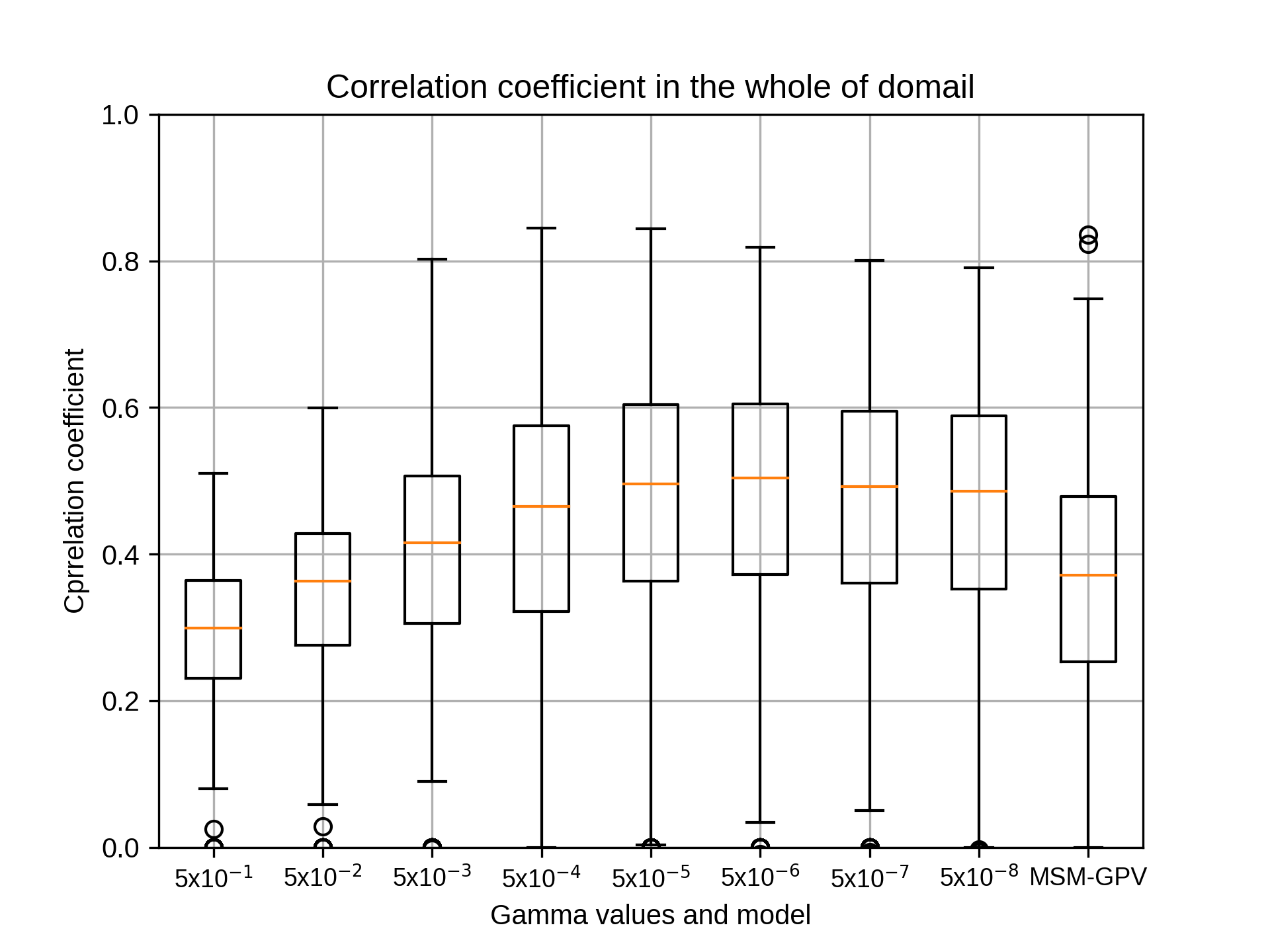

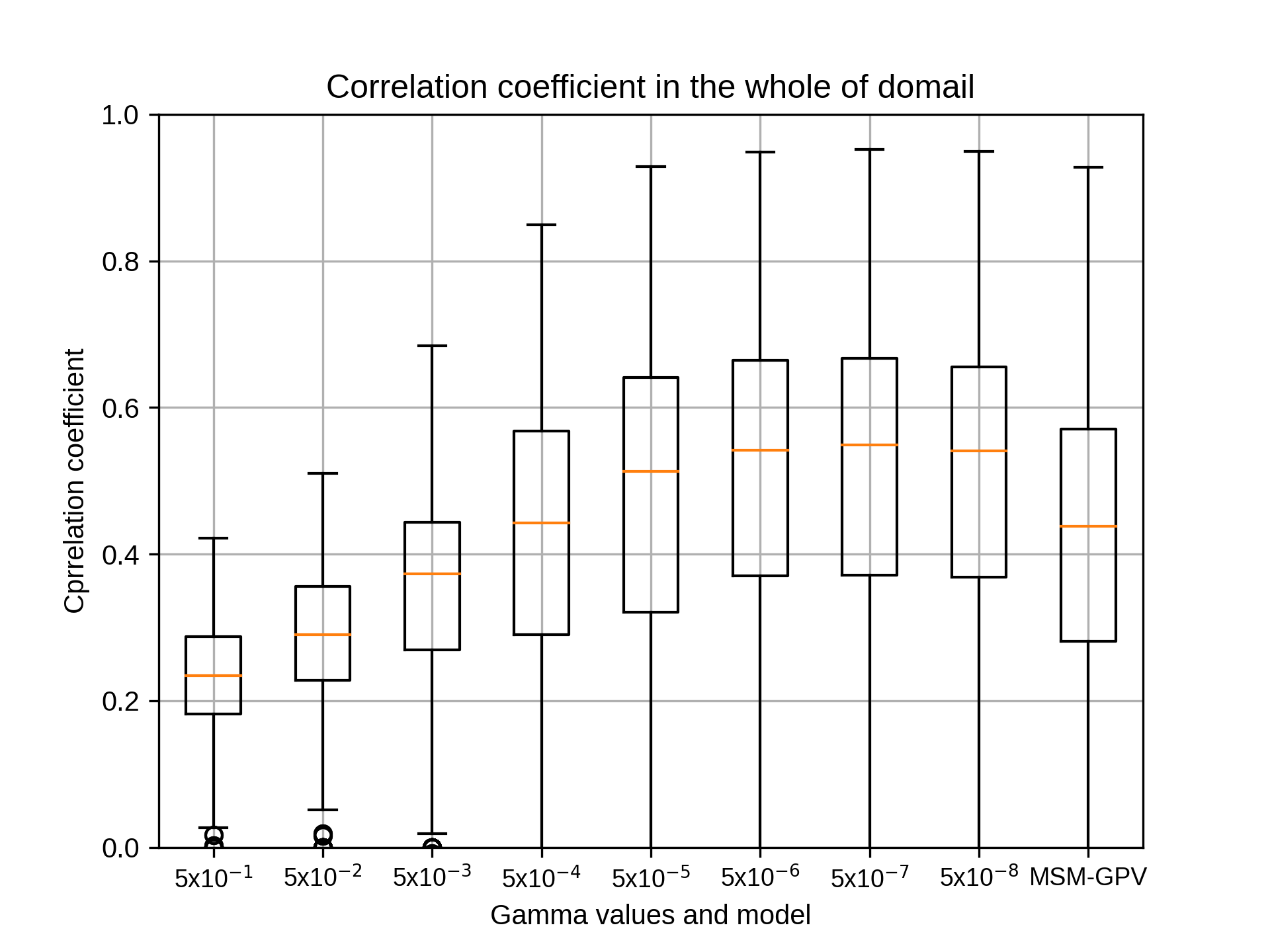

@kobayashi_yusuke

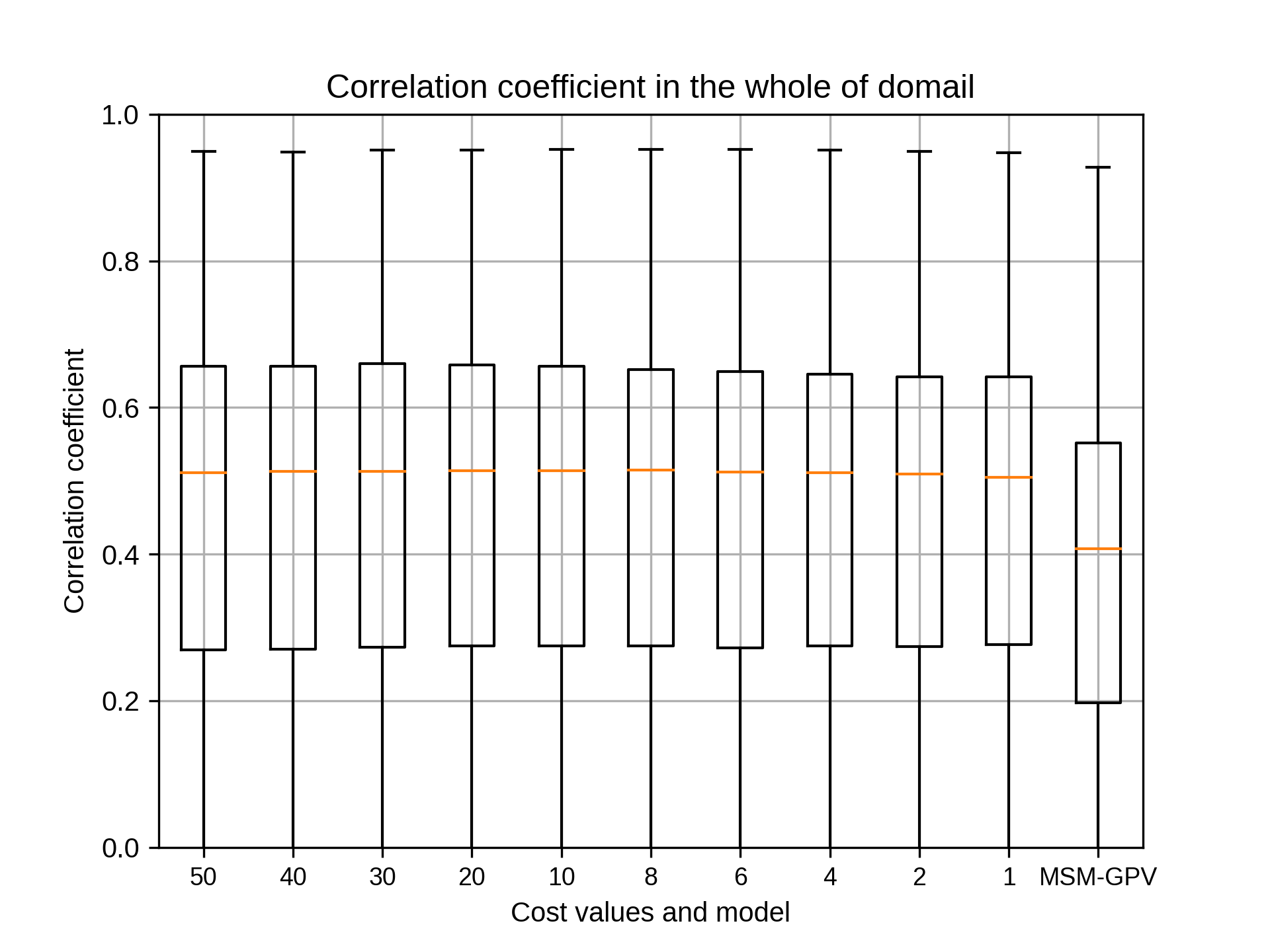

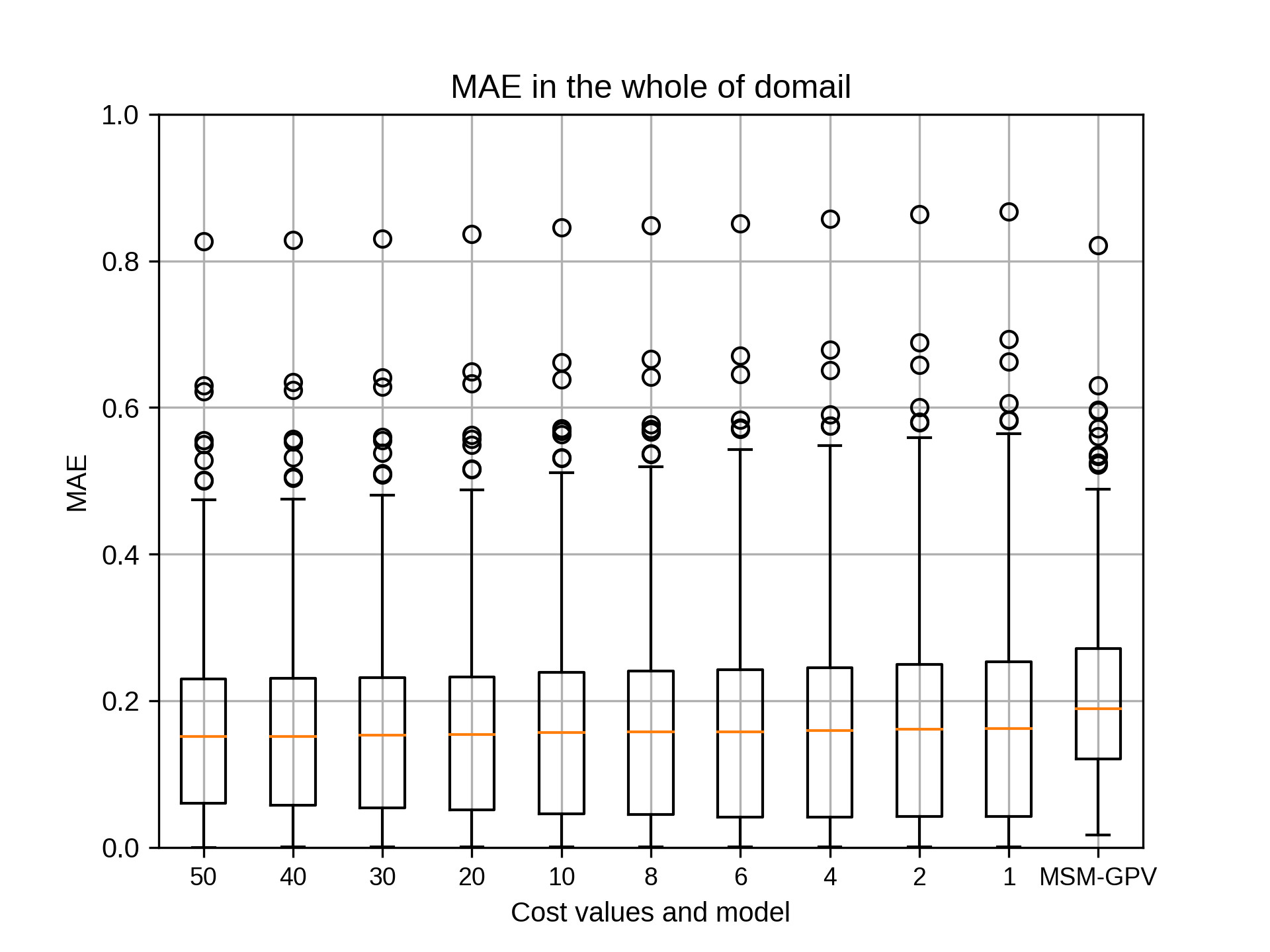

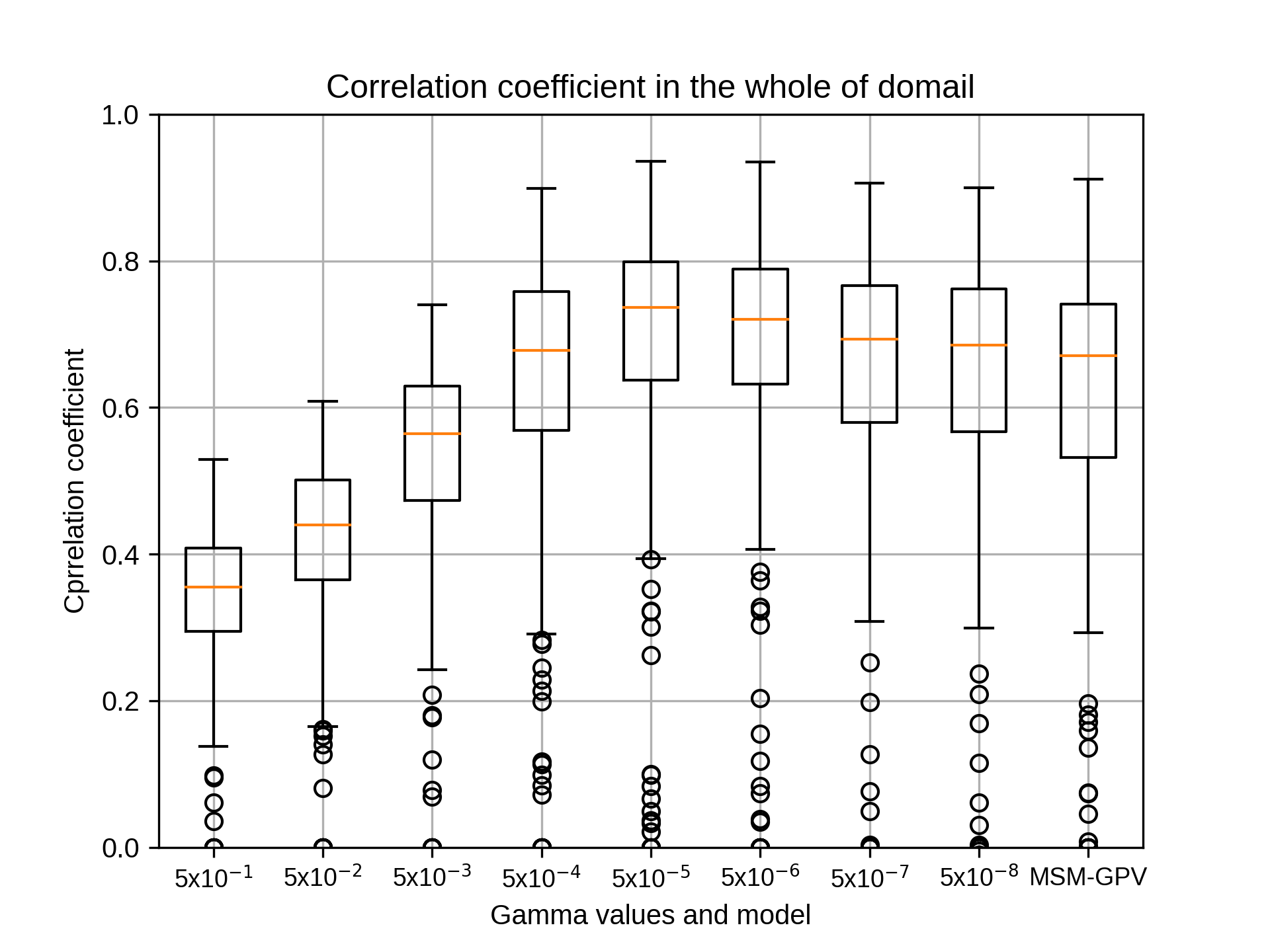

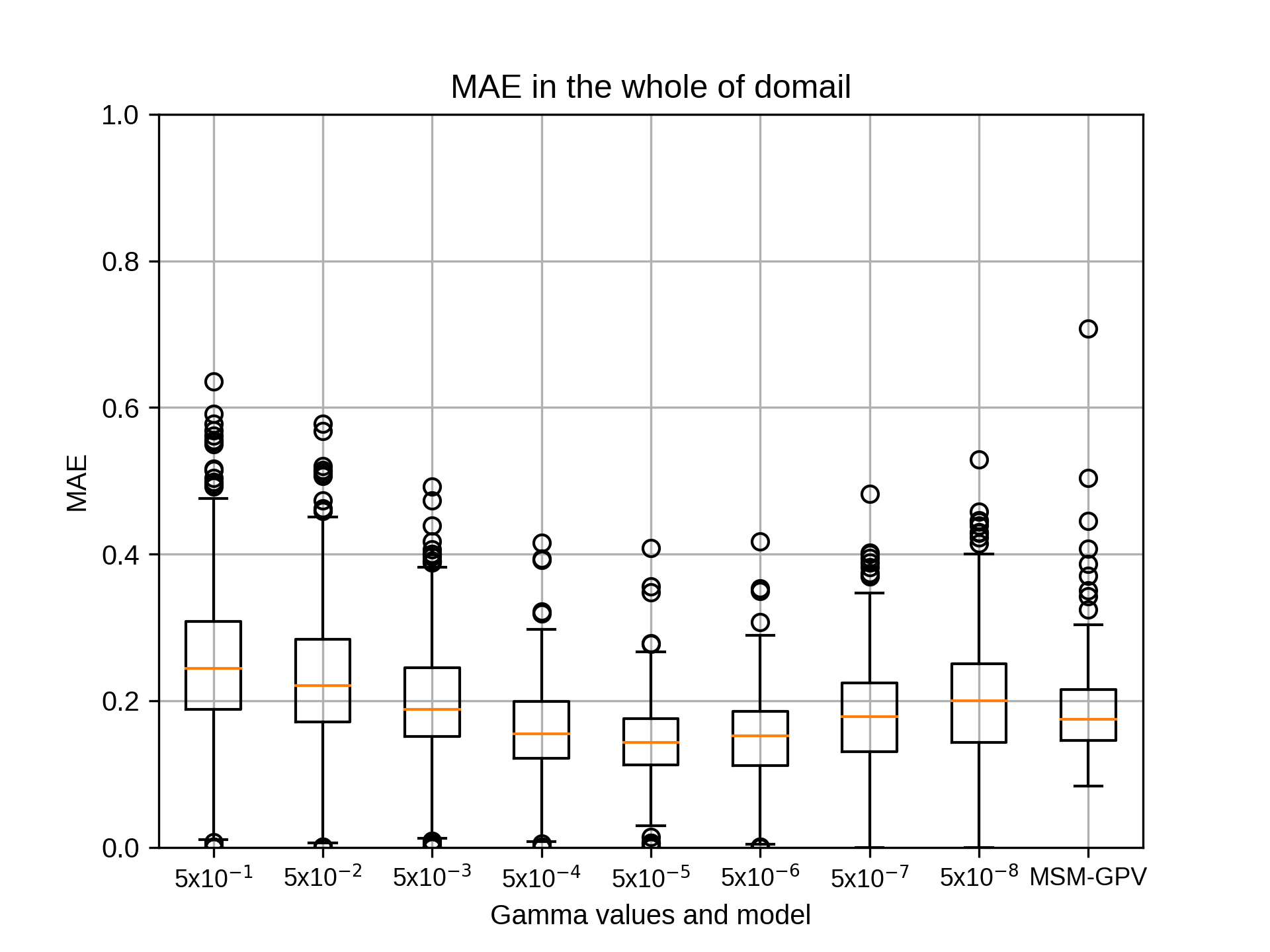

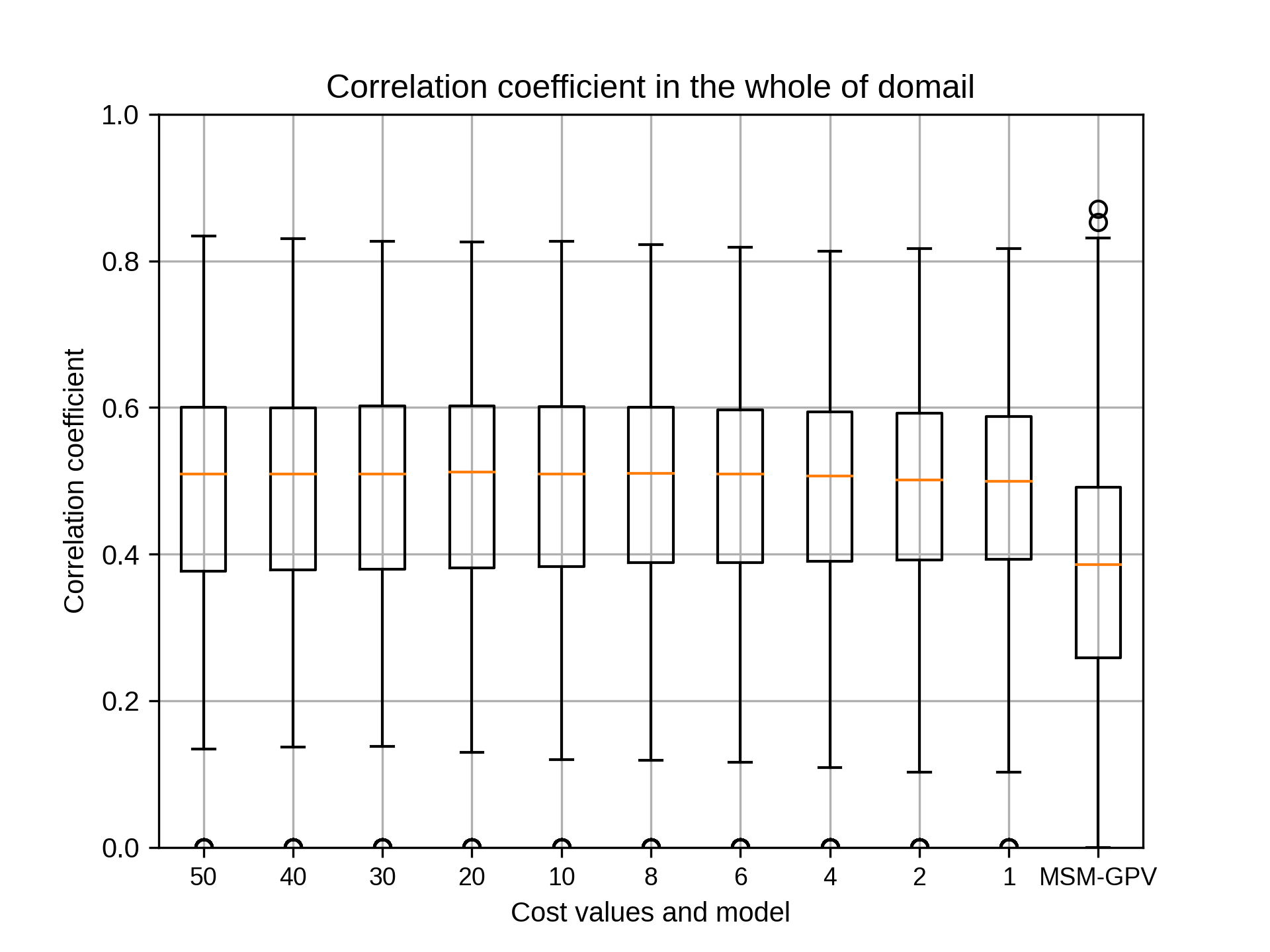

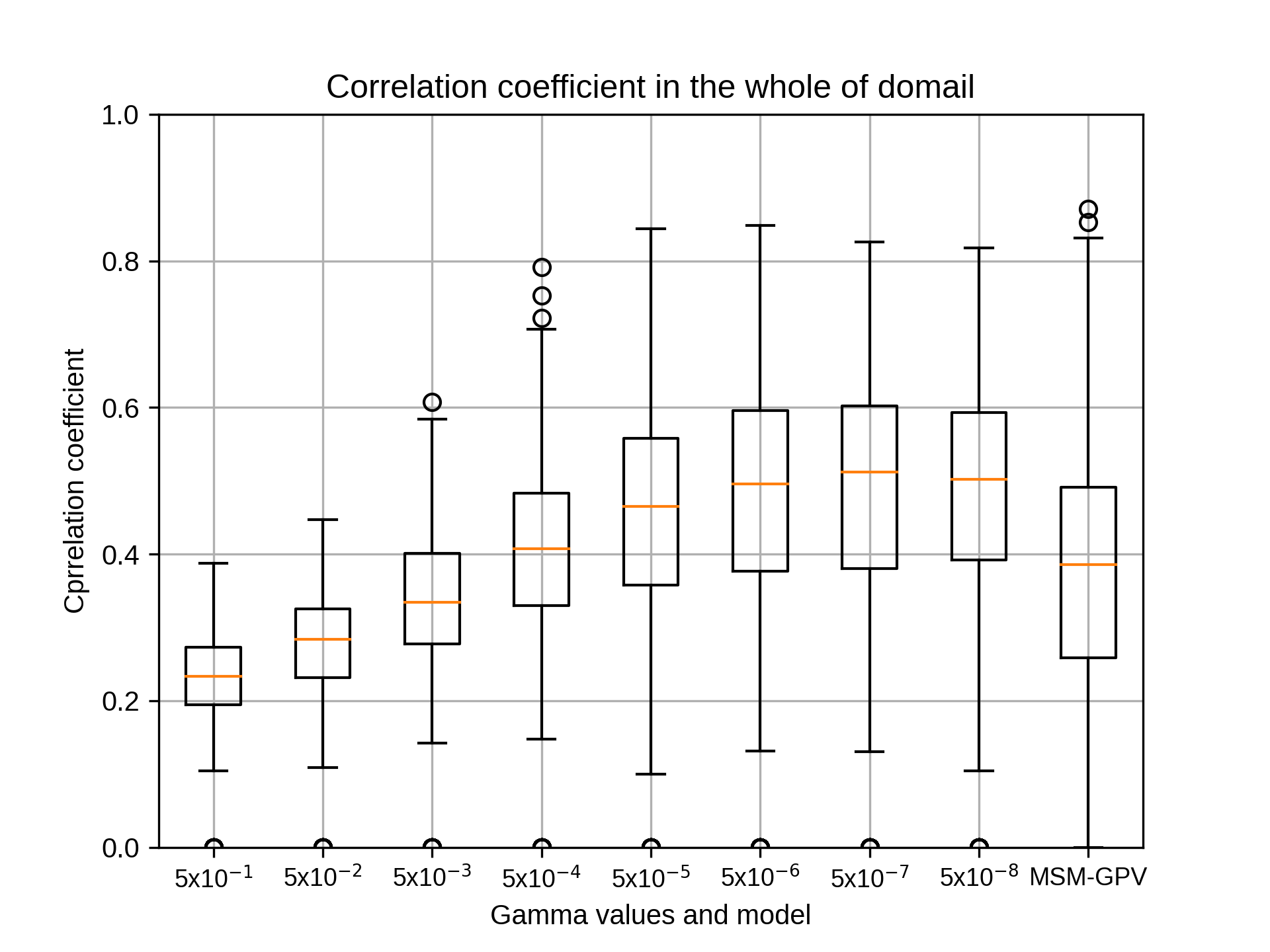

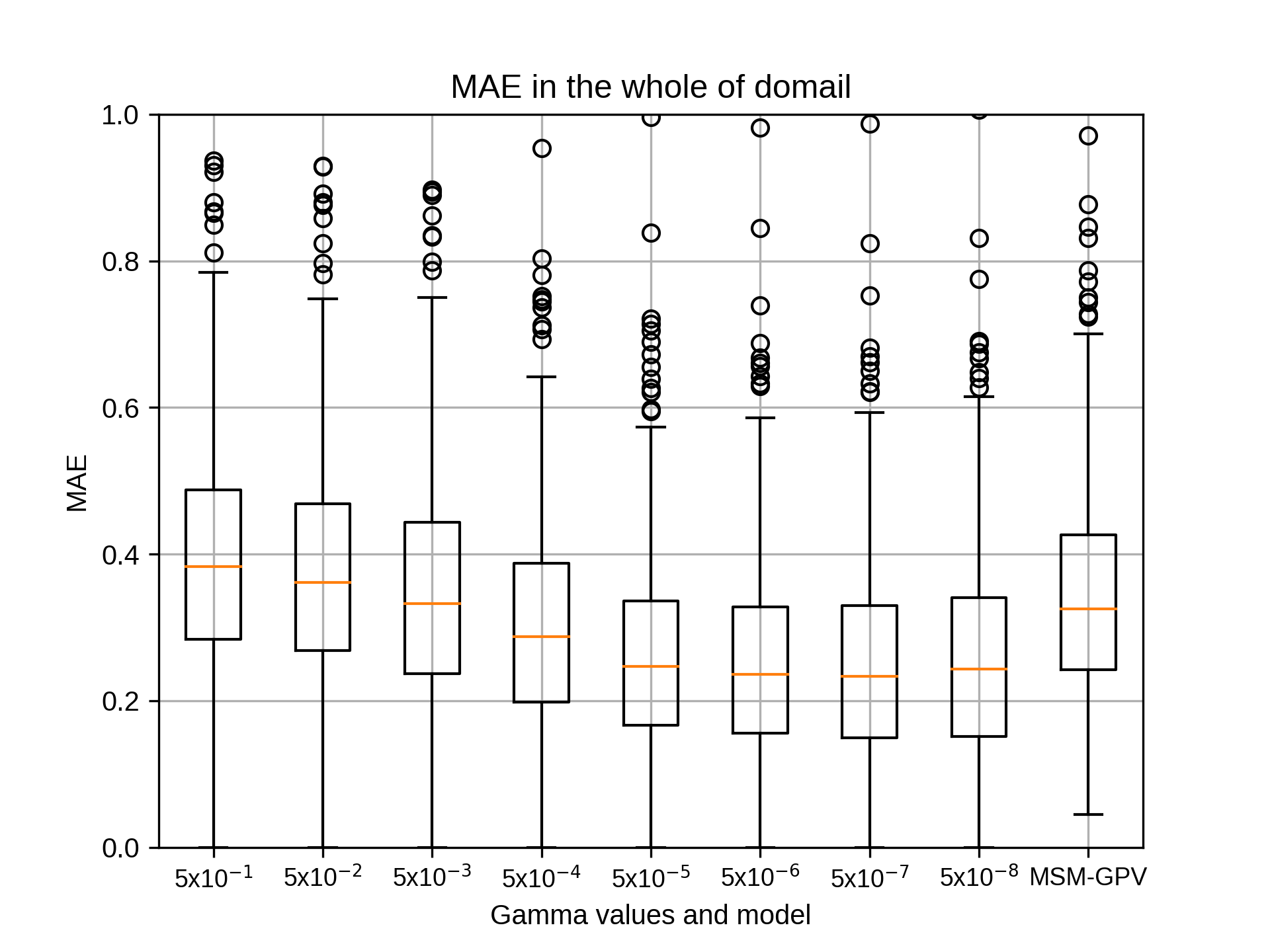

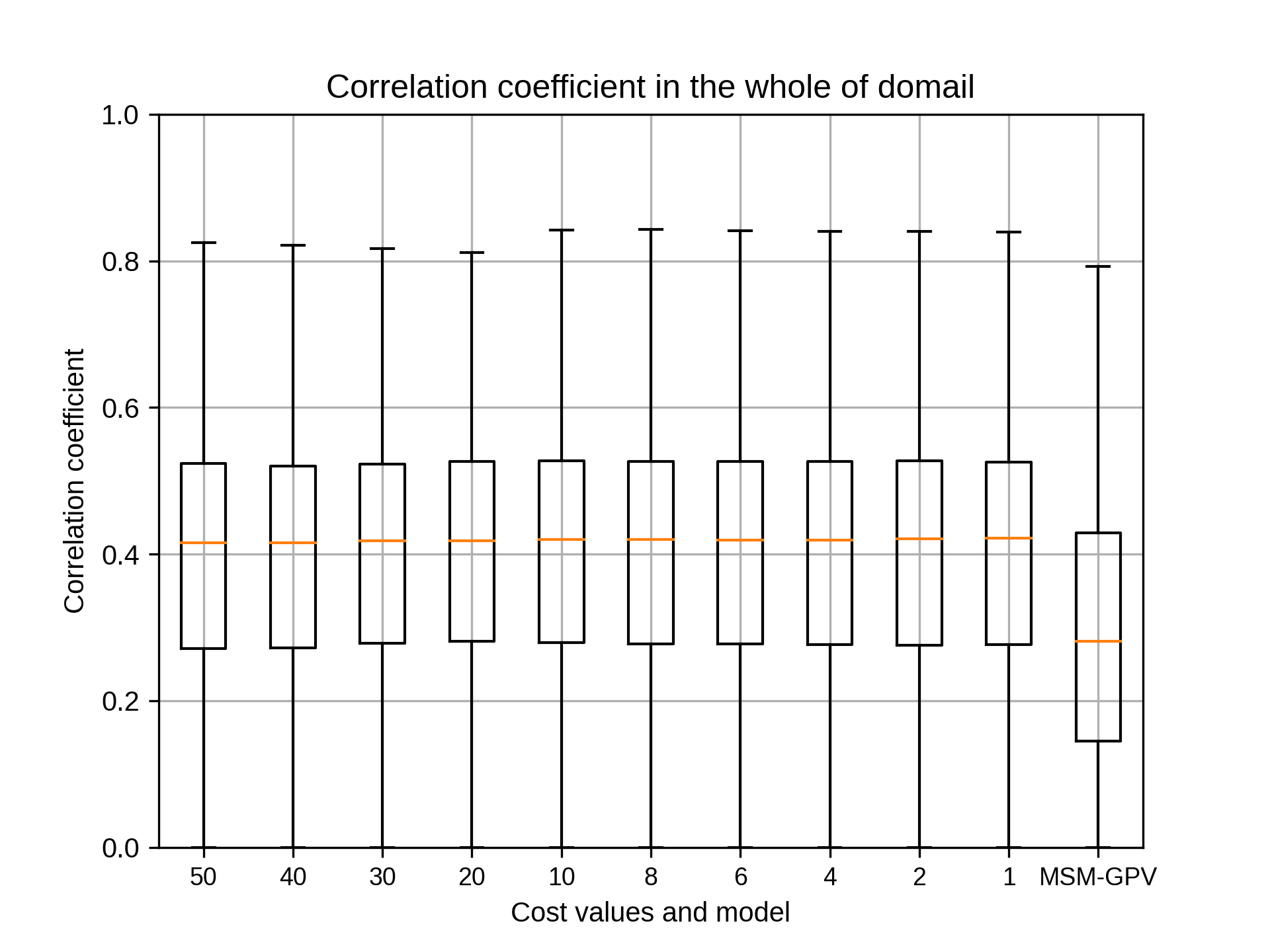

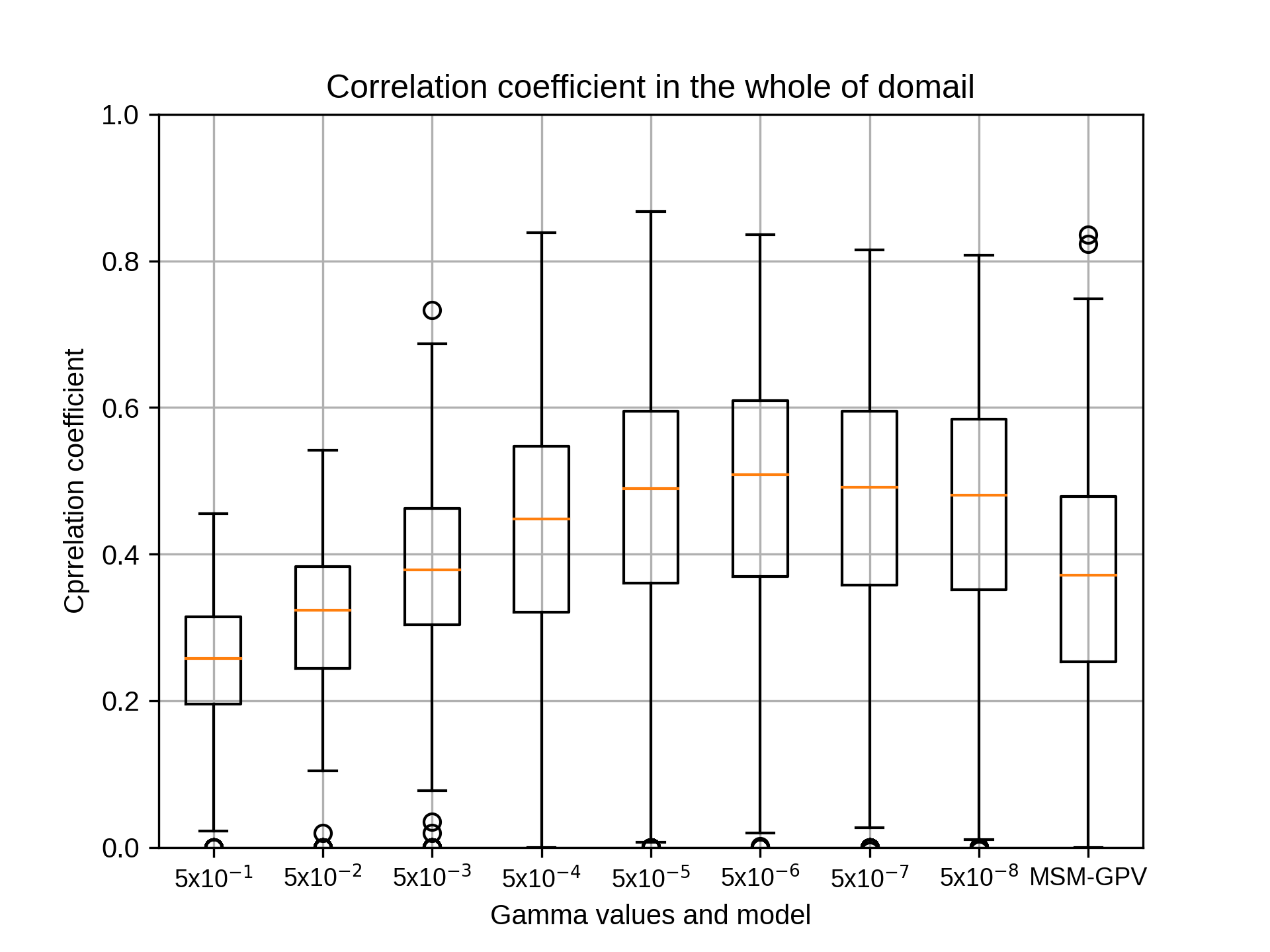

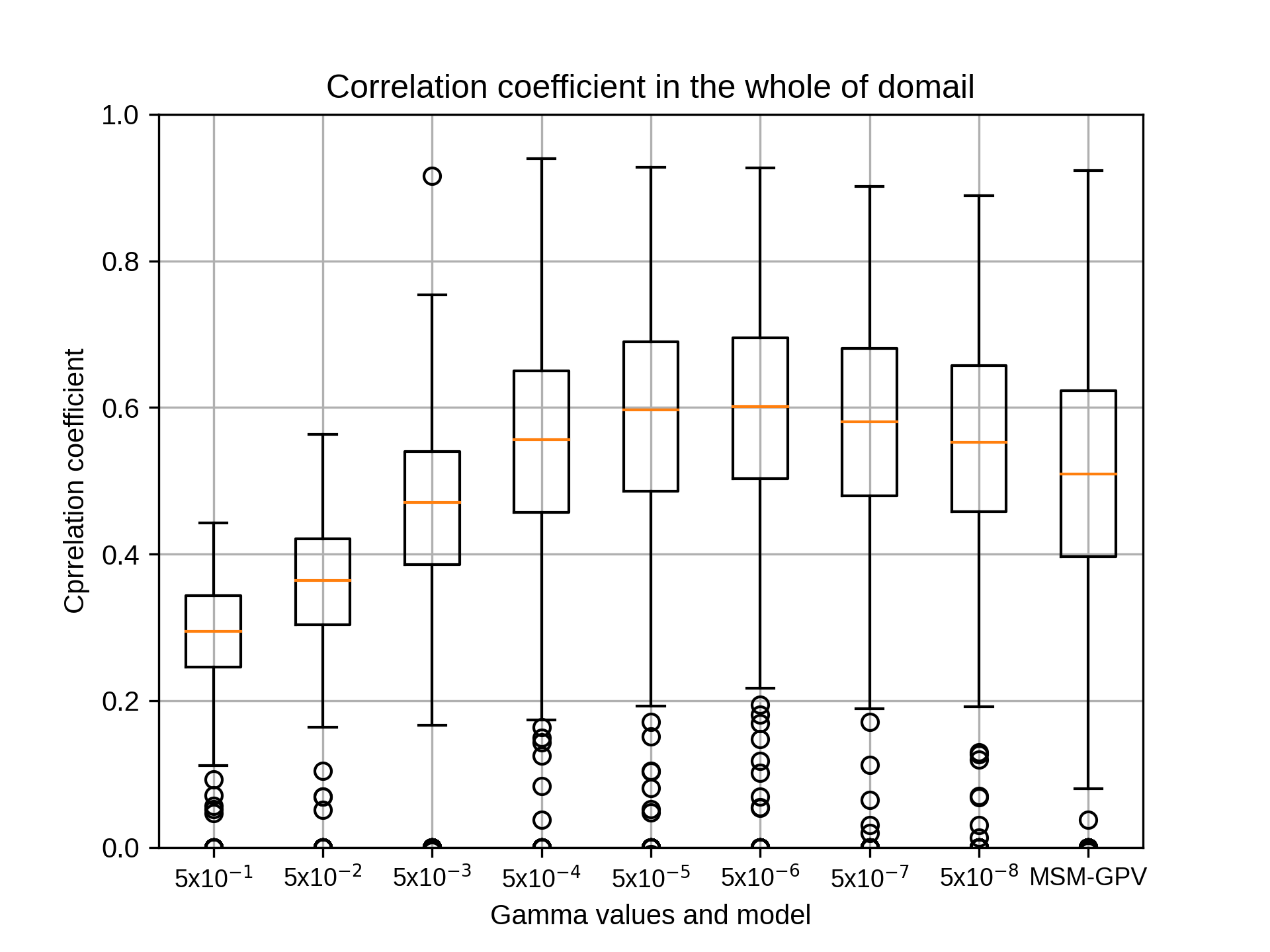

小林様。ありがとうございます。基本的には相関係数の中央値でみてもっともパフォーマンスの良い値を選択していただけますでしょうか。Cについてはとりあえずそれで問題ないと思います。Cが終了しましたら、同様にepsilonをお願いいたします。

小林様。ありがとうございます。基本的には相関係数の中央値でみてもっともパフォーマンスの良い値を選択していただけますでしょうか。Cについてはとりあえずそれで問題ないと思います。Cが終了しましたら、同様にepsilonをお願いいたします。

kobayashi_yusukeWednesday, September 9th, 2020 at 8:43:59 PM GMT+09:00

@takao-y

吉兼先生

承知いたしました。まずはコストのグラフ出力ができるようプログラム改修を行います。その後にsiteA~siteEまでガンマを相関係数の中央値で最大値として、7月を対象にグラフ出力をいたします。引き続きよろしくお願いいたします。

吉兼先生

承知いたしました。まずはコストのグラフ出力ができるようプログラム改修を行います。その後にsiteA~siteEまでガンマを相関係数の中央値で最大値として、7月を対象にグラフ出力をいたします。引き続きよろしくお願いいたします。

takao-yThursday, September 10th, 2020 at 11:05:35 AM GMT+09:00

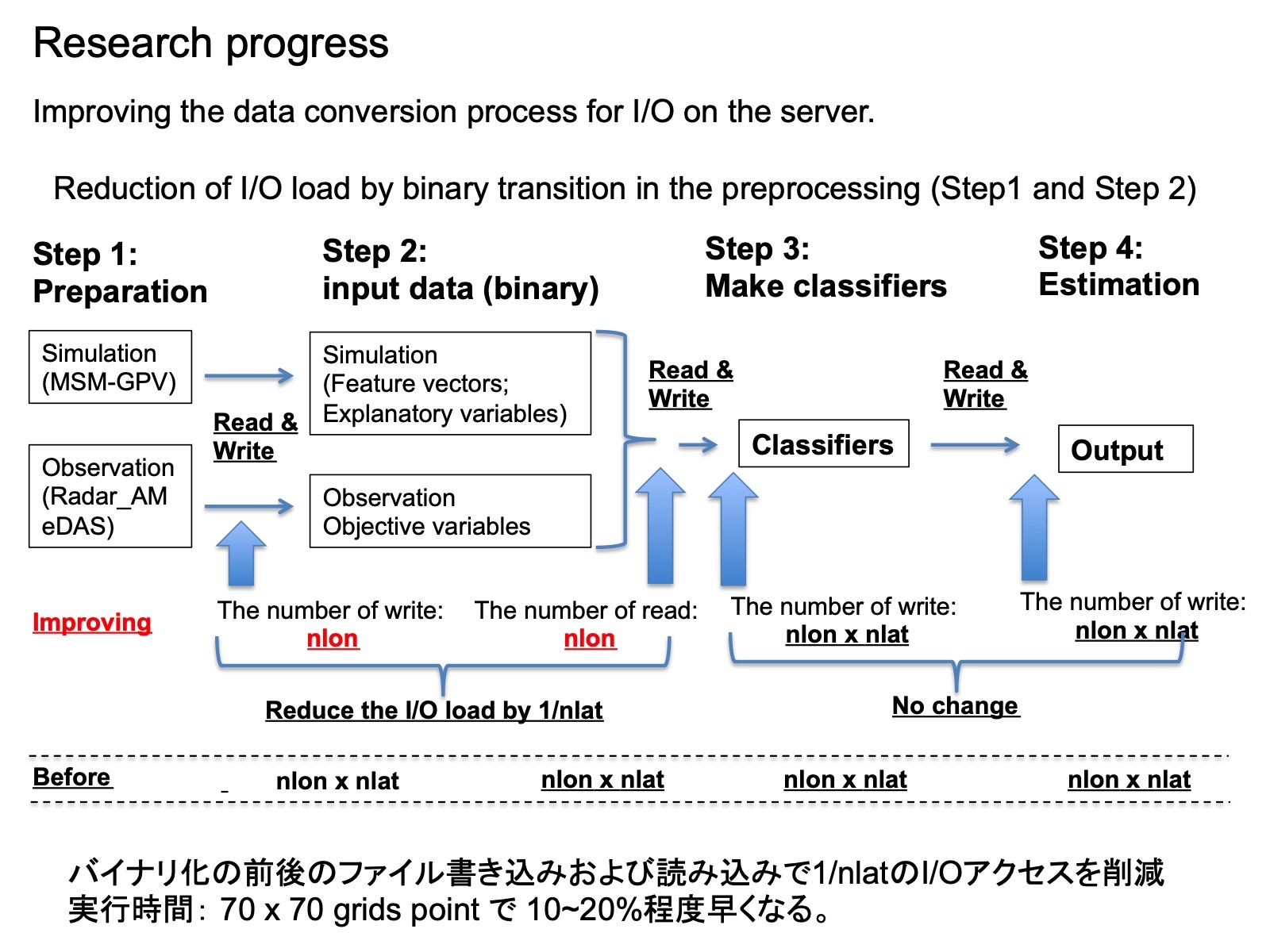

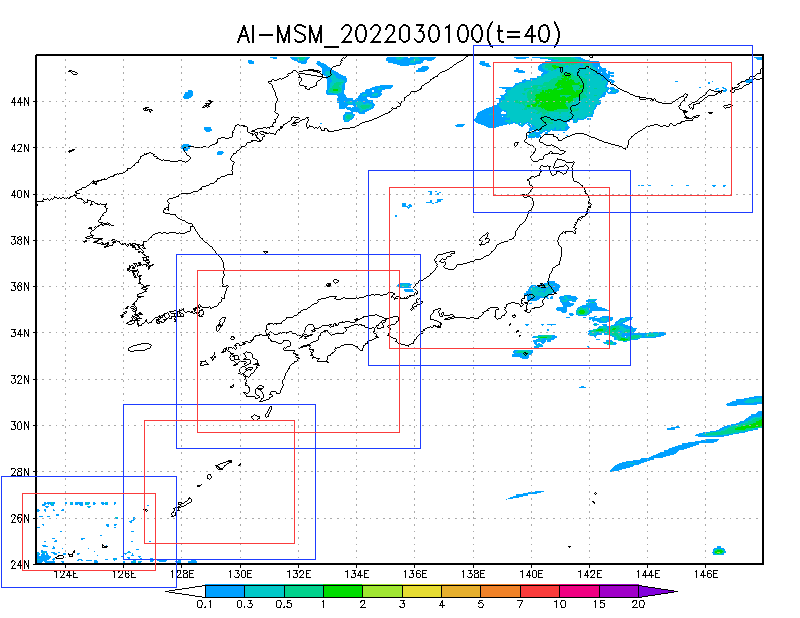

機械学習の入出力のバイナリ化ですが、経度方向で一括してバイナリ化することにより、I/Oへの負担を大幅に低減(1/経度方向のグリッド数)できました。これに伴い、識別器ファイルの生成も高速化し、今までの1/2以下の時間で終了できるようになりました。近日中に整備して皆様に使っていただけるようにいたします。

1kmへのダウンスケール実験もI/Oへの負荷をかけずに高速に処理できるようになると考えています。(当初は、全グリッドを一括で読み込むことを考えていたのですが、思った以上に行列計算にかなり時間がかかることから、データを小分けにして対処しています。計算効率的には小分けの範囲を少し拡大しても良いかもしれませんが、今後1kmダウンスケーリングを実施する際に処理する格子点数が多くなることを考慮すると、この方法が効率的かなと考えています。)

I/Oが大幅に軽減できたことにより、書き込み遅延などサーバーのトラブルのリスクが小さくなり、複数CPUによる並行処理も可能になると考えています。今は5つの領域に分けていますが、たとえば30領域に分けて並行処理をすることにより、全国1kmリアルタイムダウンスケーリングも現実的になると想定しています。

報告まで。

1kmへのダウンスケール実験もI/Oへの負荷をかけずに高速に処理できるようになると考えています。(当初は、全グリッドを一括で読み込むことを考えていたのですが、思った以上に行列計算にかなり時間がかかることから、データを小分けにして対処しています。計算効率的には小分けの範囲を少し拡大しても良いかもしれませんが、今後1kmダウンスケーリングを実施する際に処理する格子点数が多くなることを考慮すると、この方法が効率的かなと考えています。)

I/Oが大幅に軽減できたことにより、書き込み遅延などサーバーのトラブルのリスクが小さくなり、複数CPUによる並行処理も可能になると考えています。今は5つの領域に分けていますが、たとえば30領域に分けて並行処理をすることにより、全国1kmリアルタイムダウンスケーリングも現実的になると想定しています。

報告まで。

keiyoshi08Thursday, September 10th, 2020 at 11:06:22 AM GMT+09:00

すばらしいです!詳細ぜひ教えて下さい。

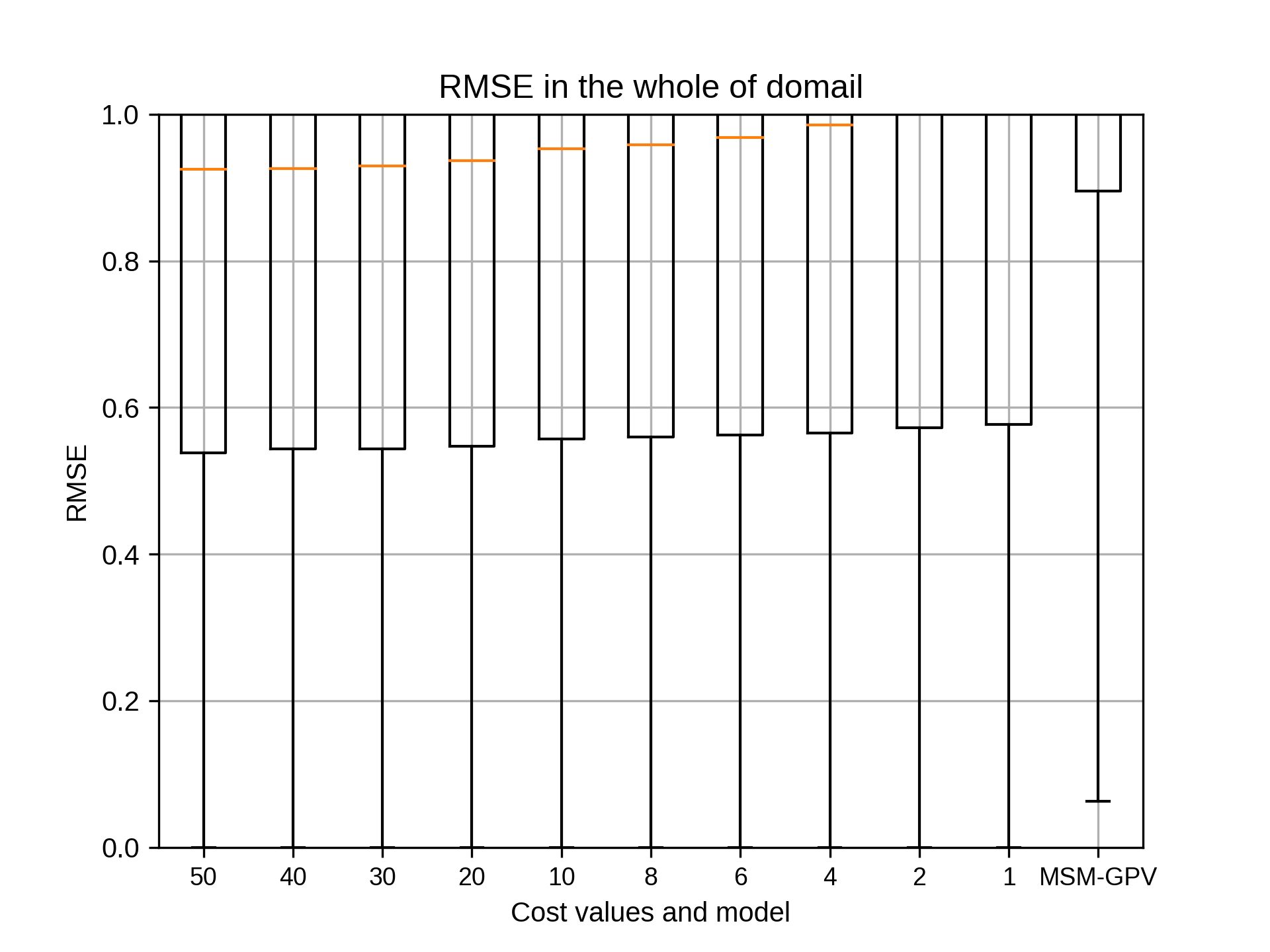

kobayashi_yusukeFriday, September 11th, 2020 at 6:04:33 PM GMT+09:00

@takao-y

吉兼先生

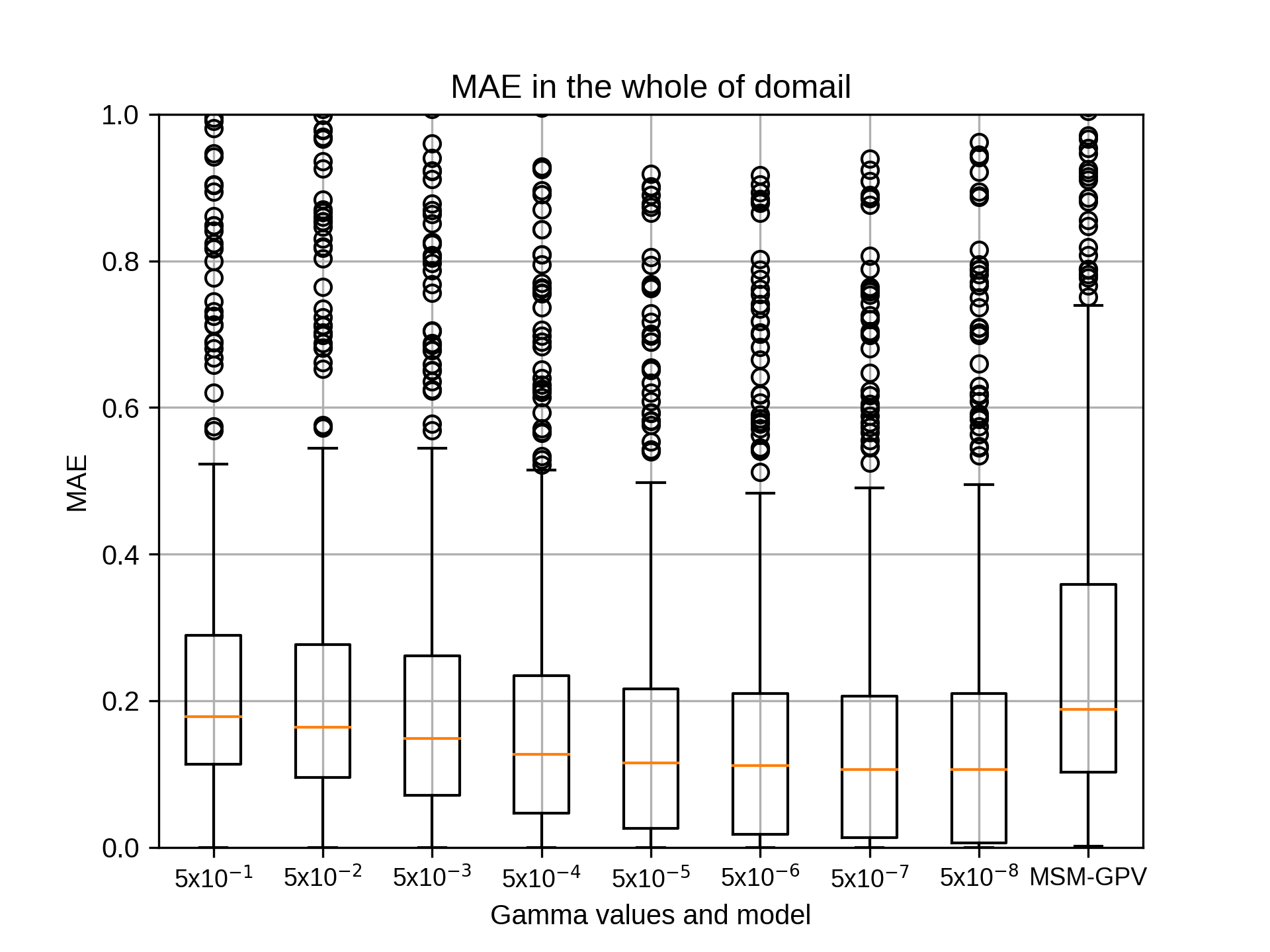

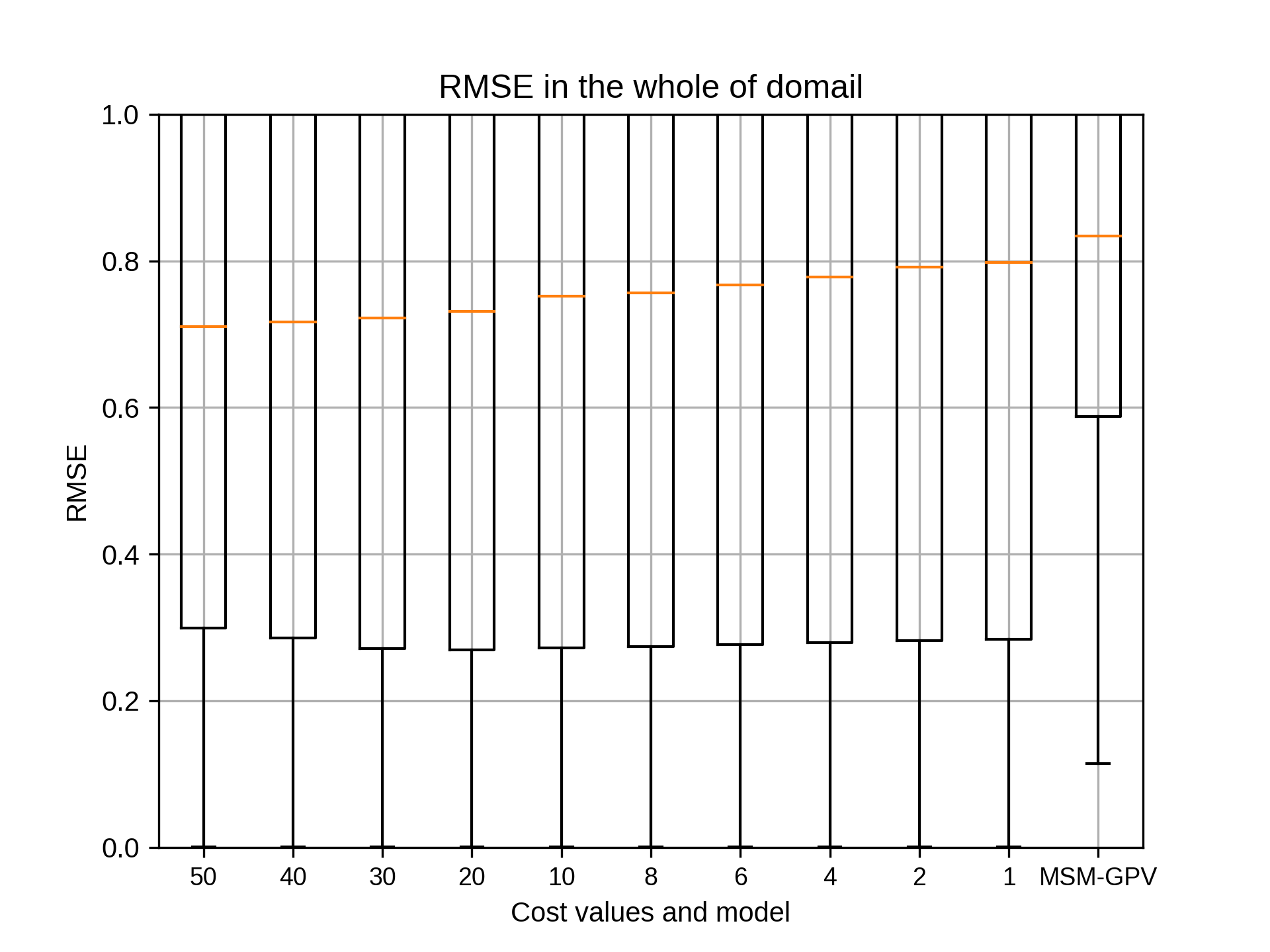

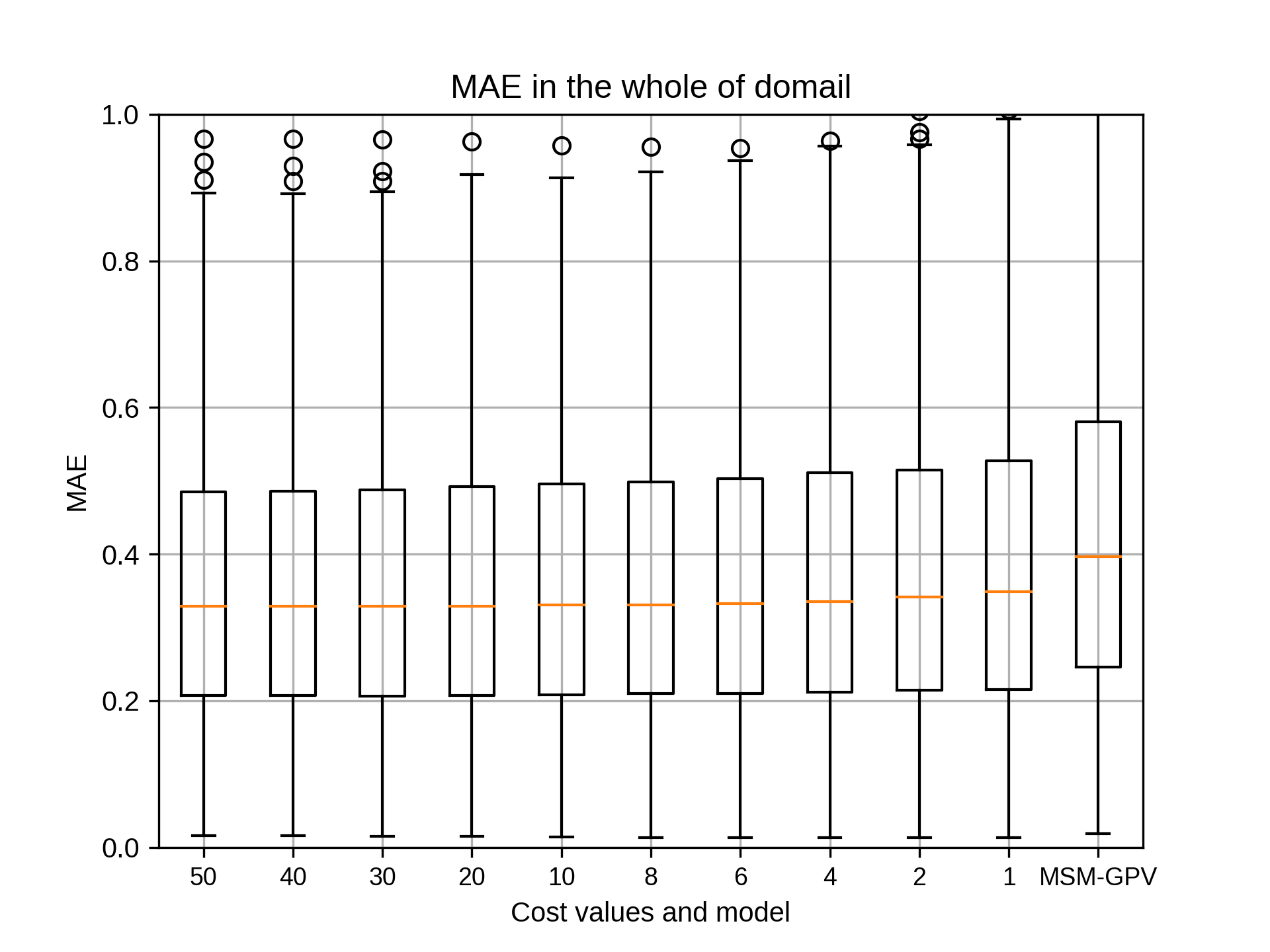

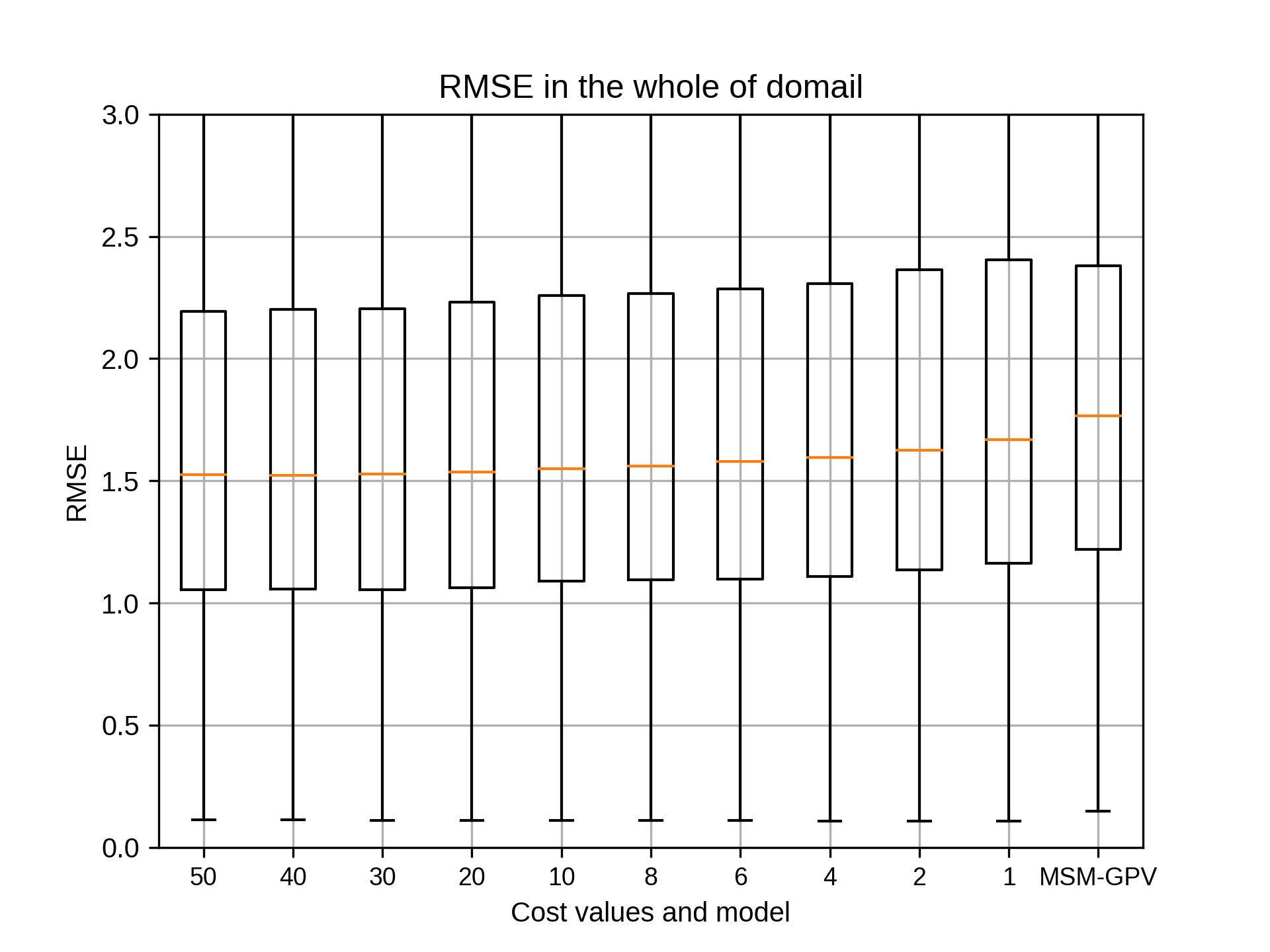

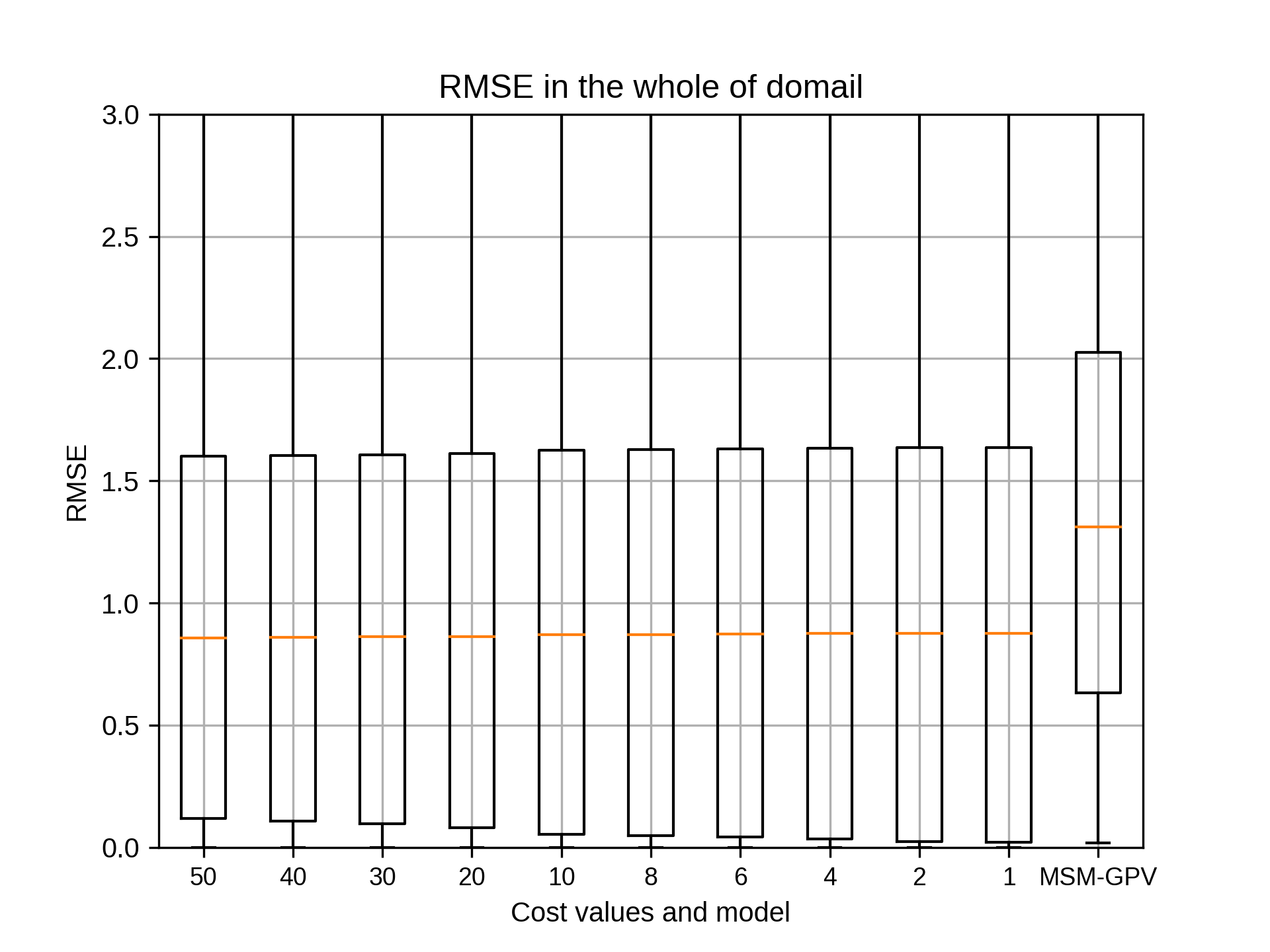

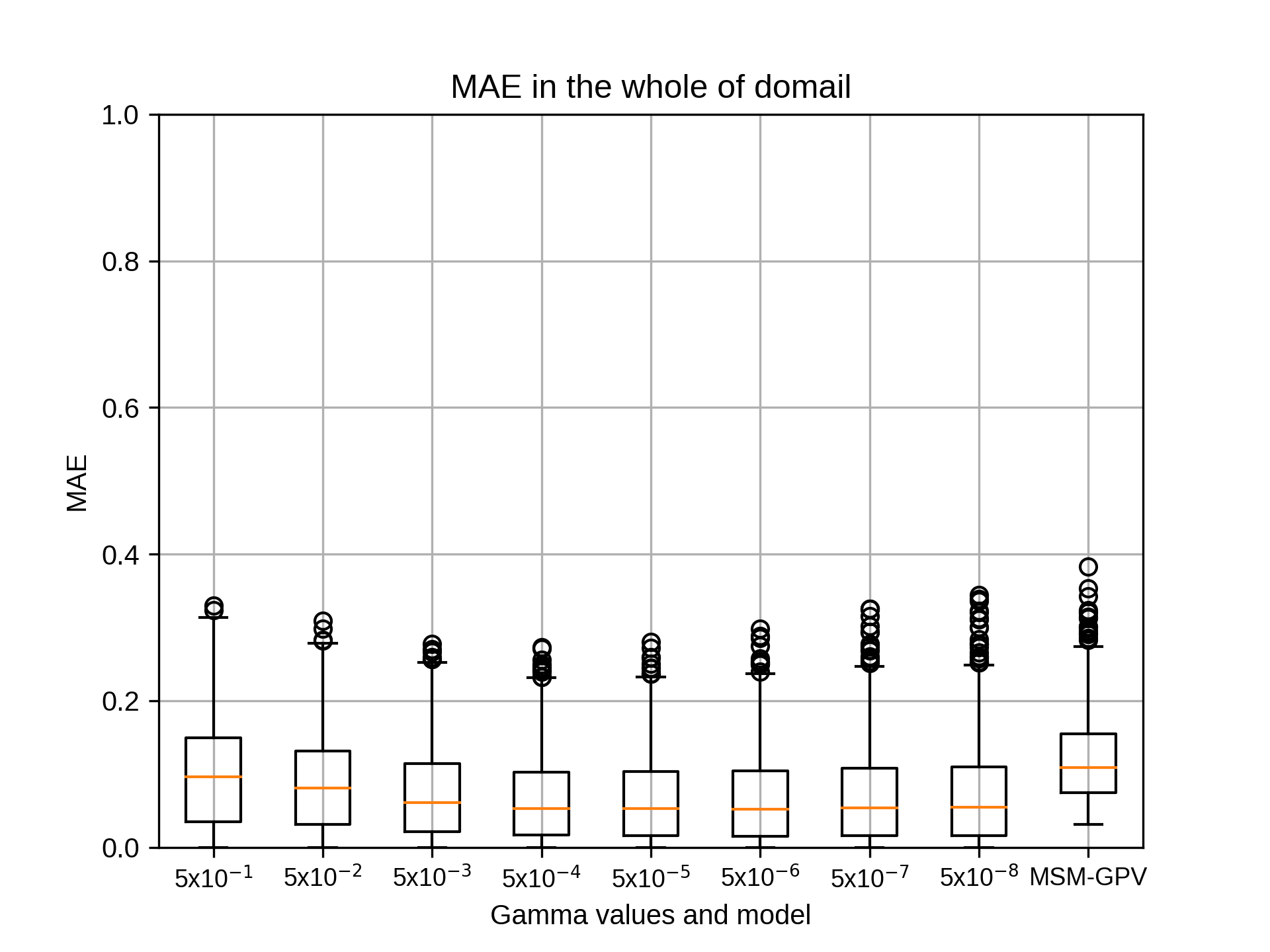

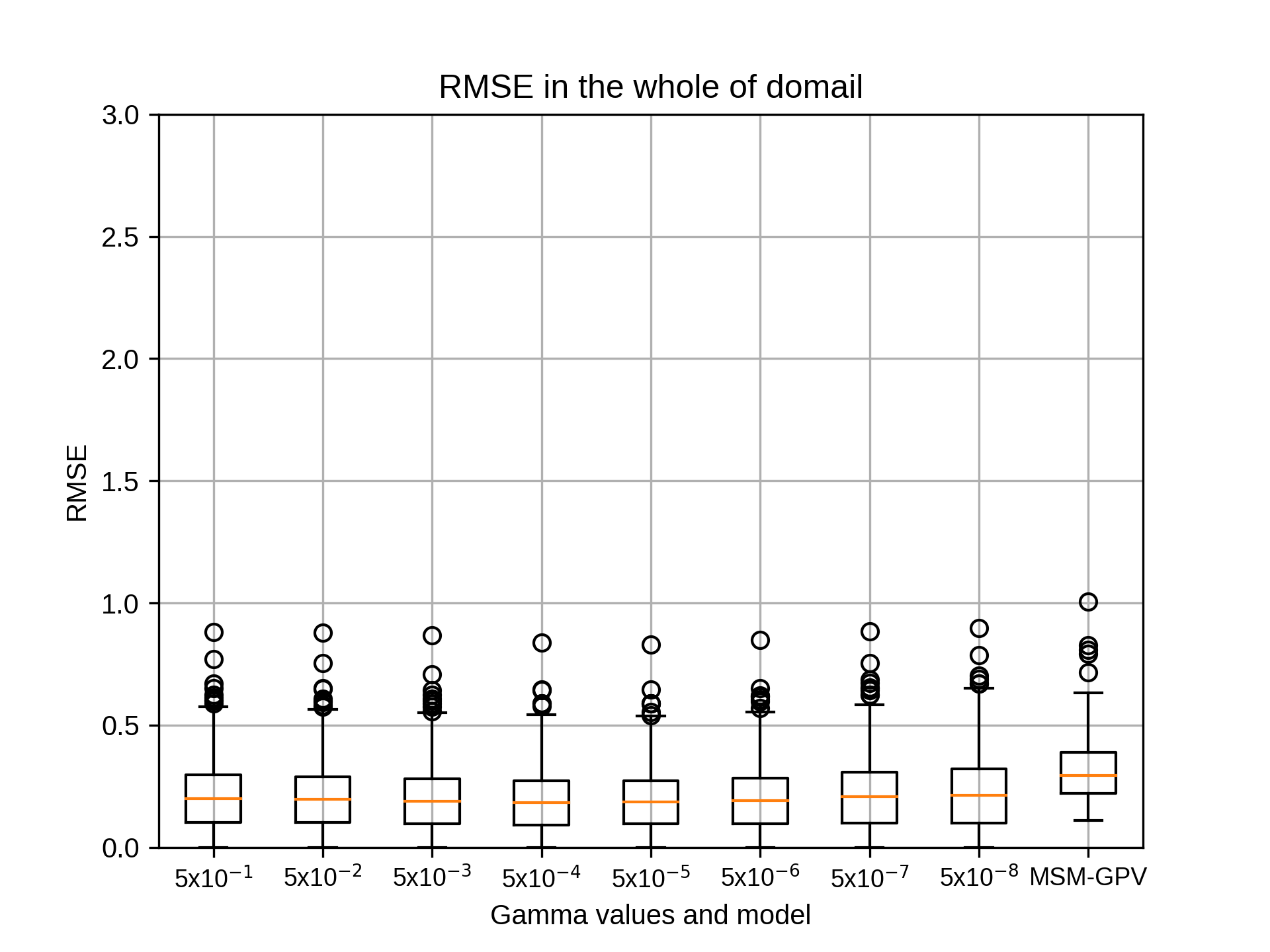

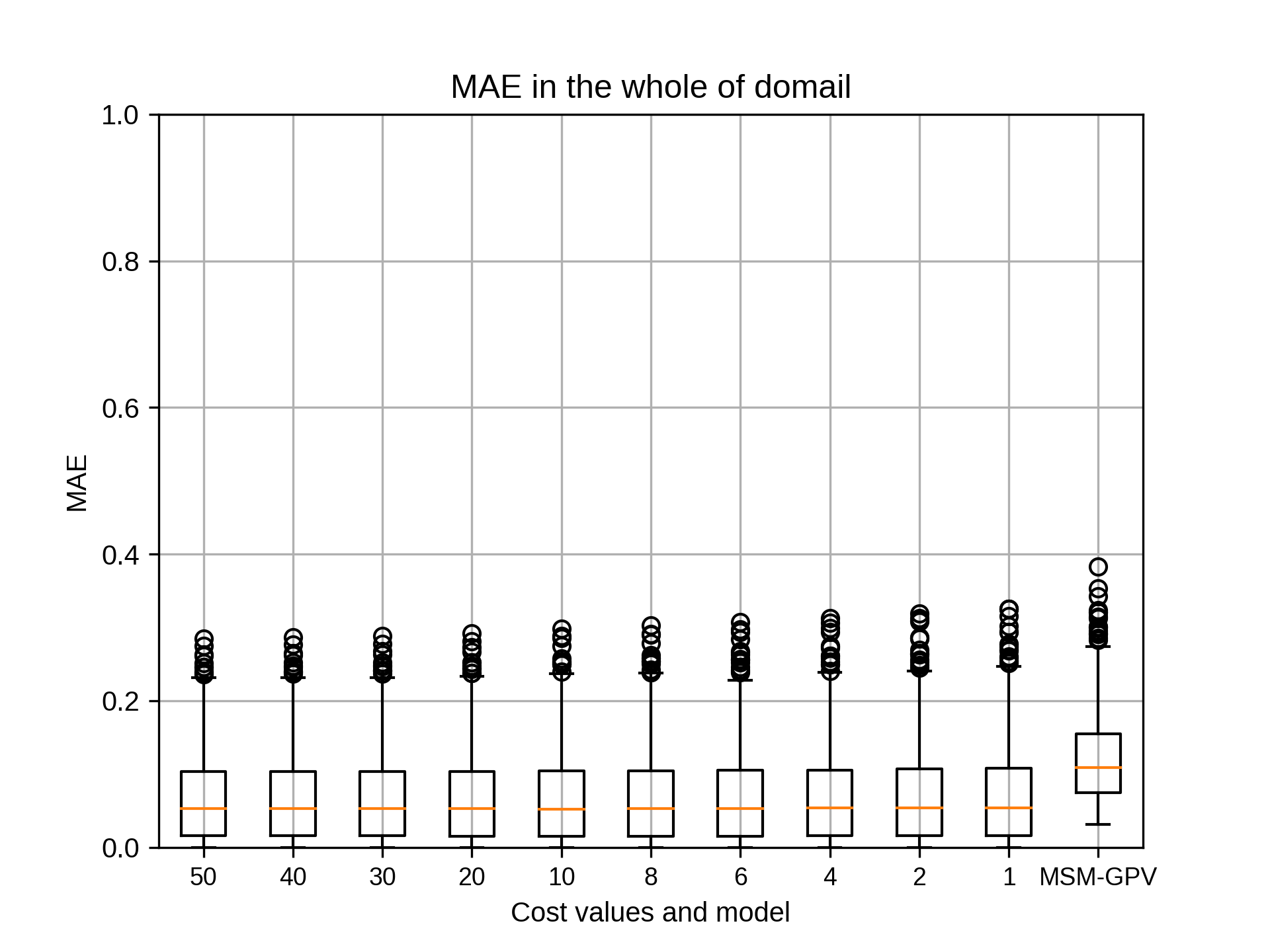

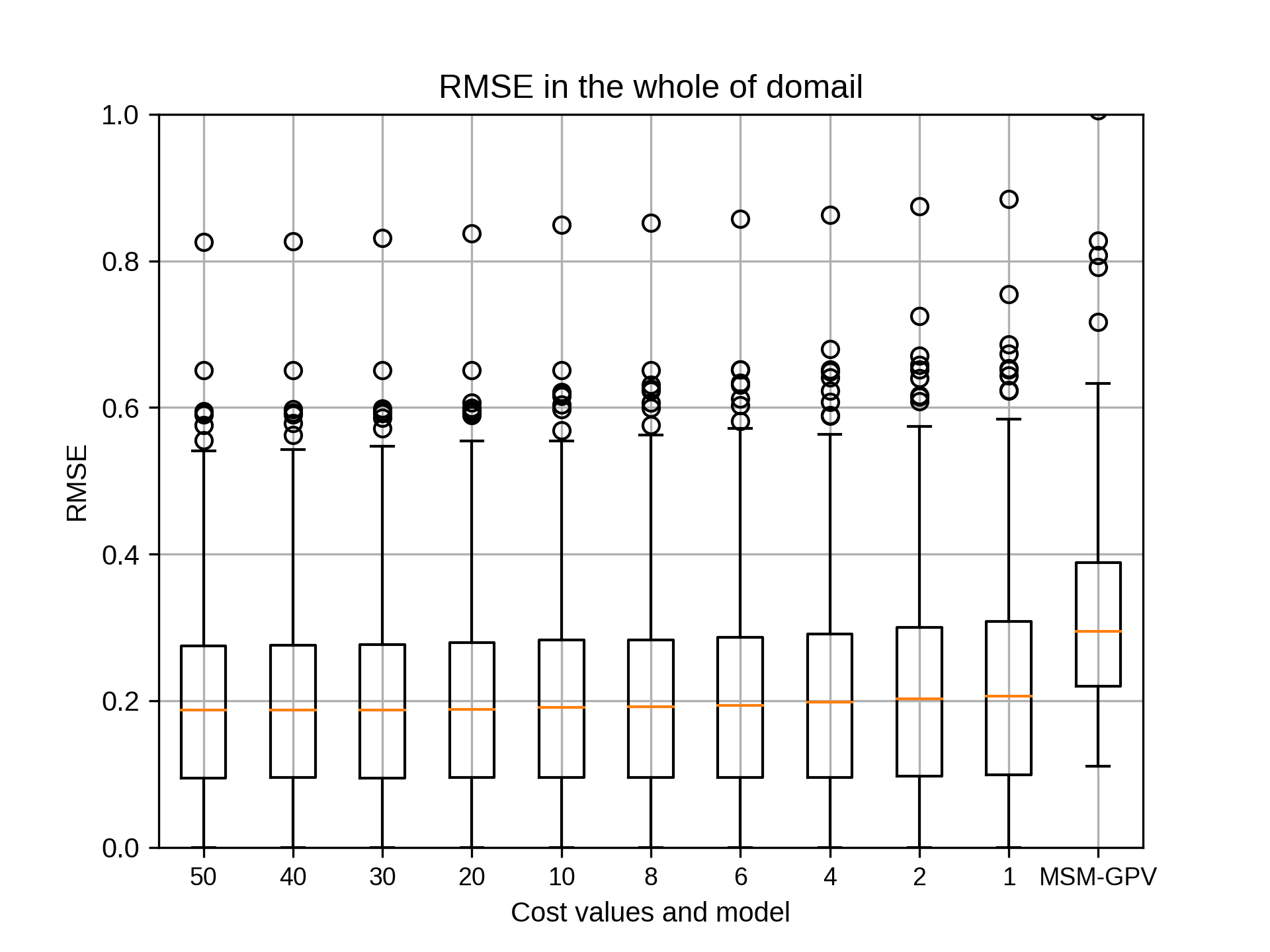

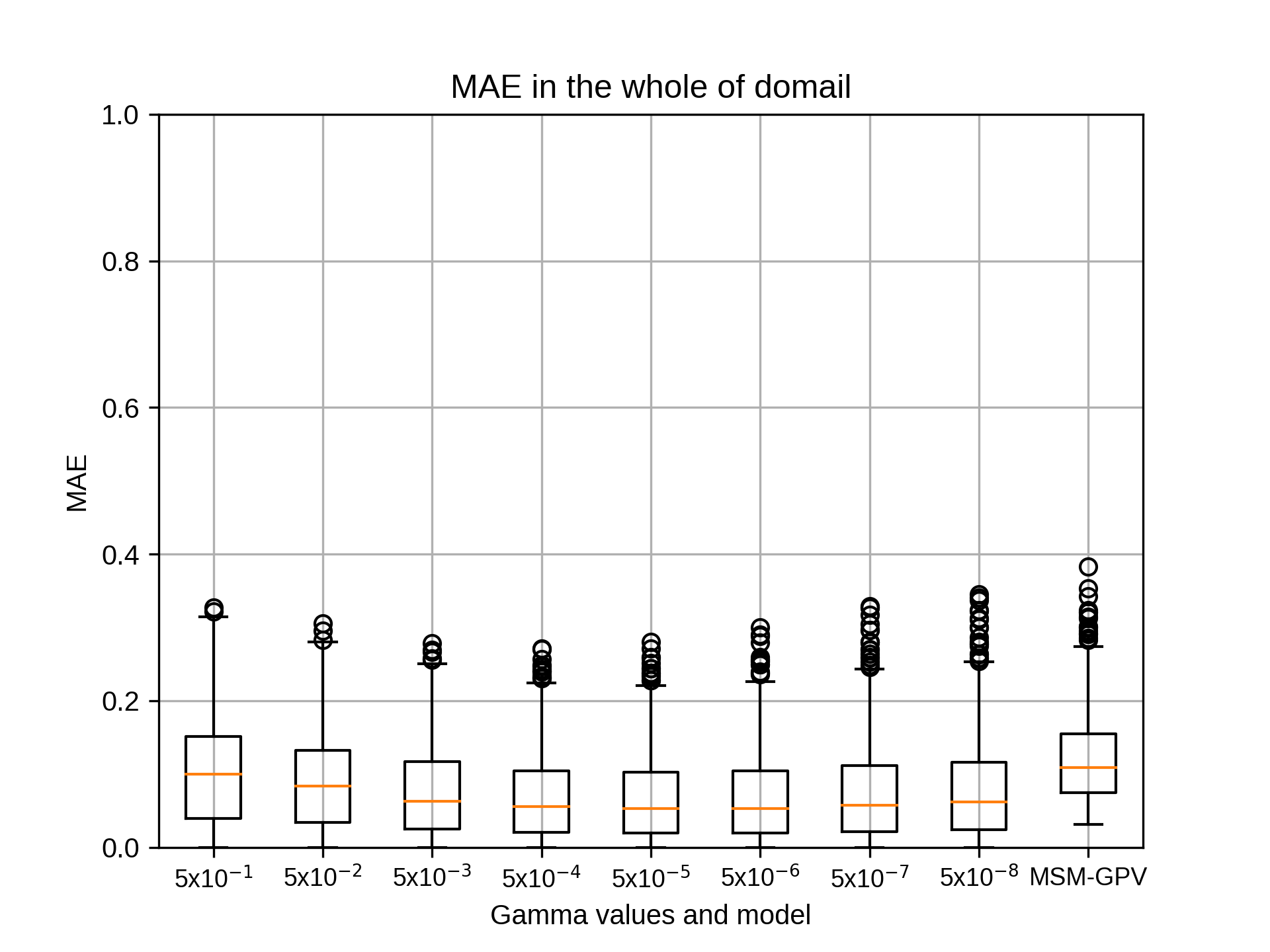

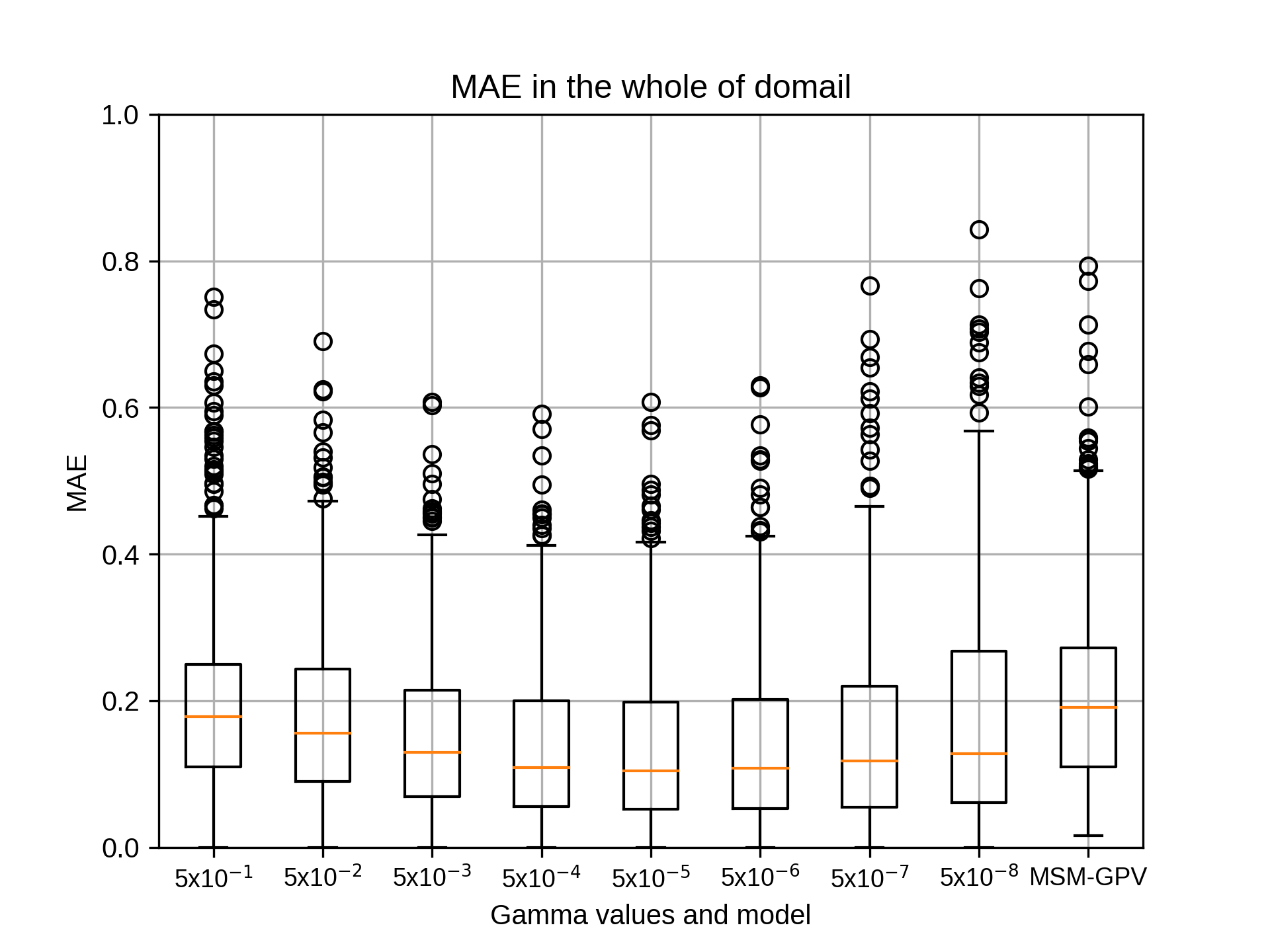

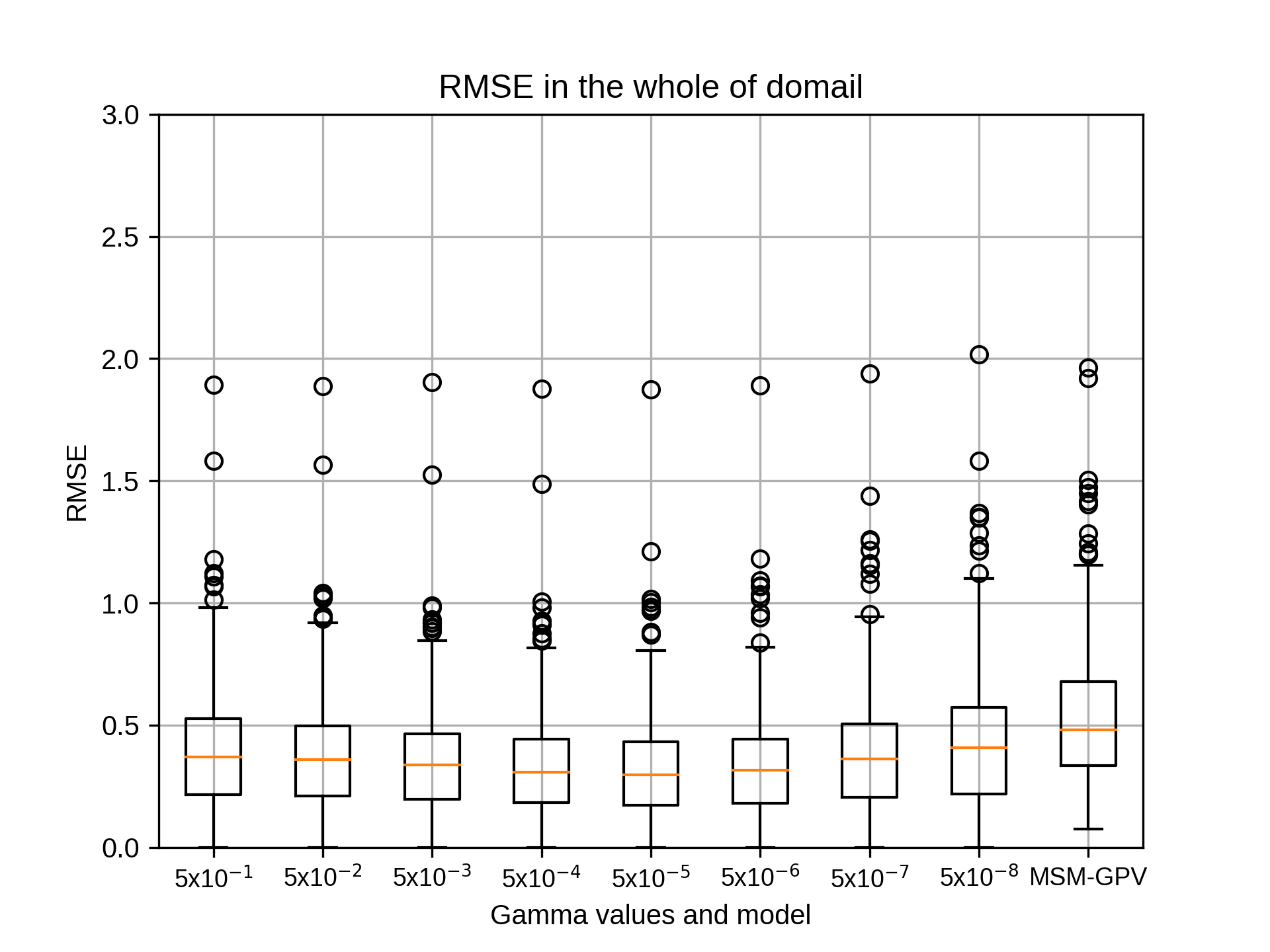

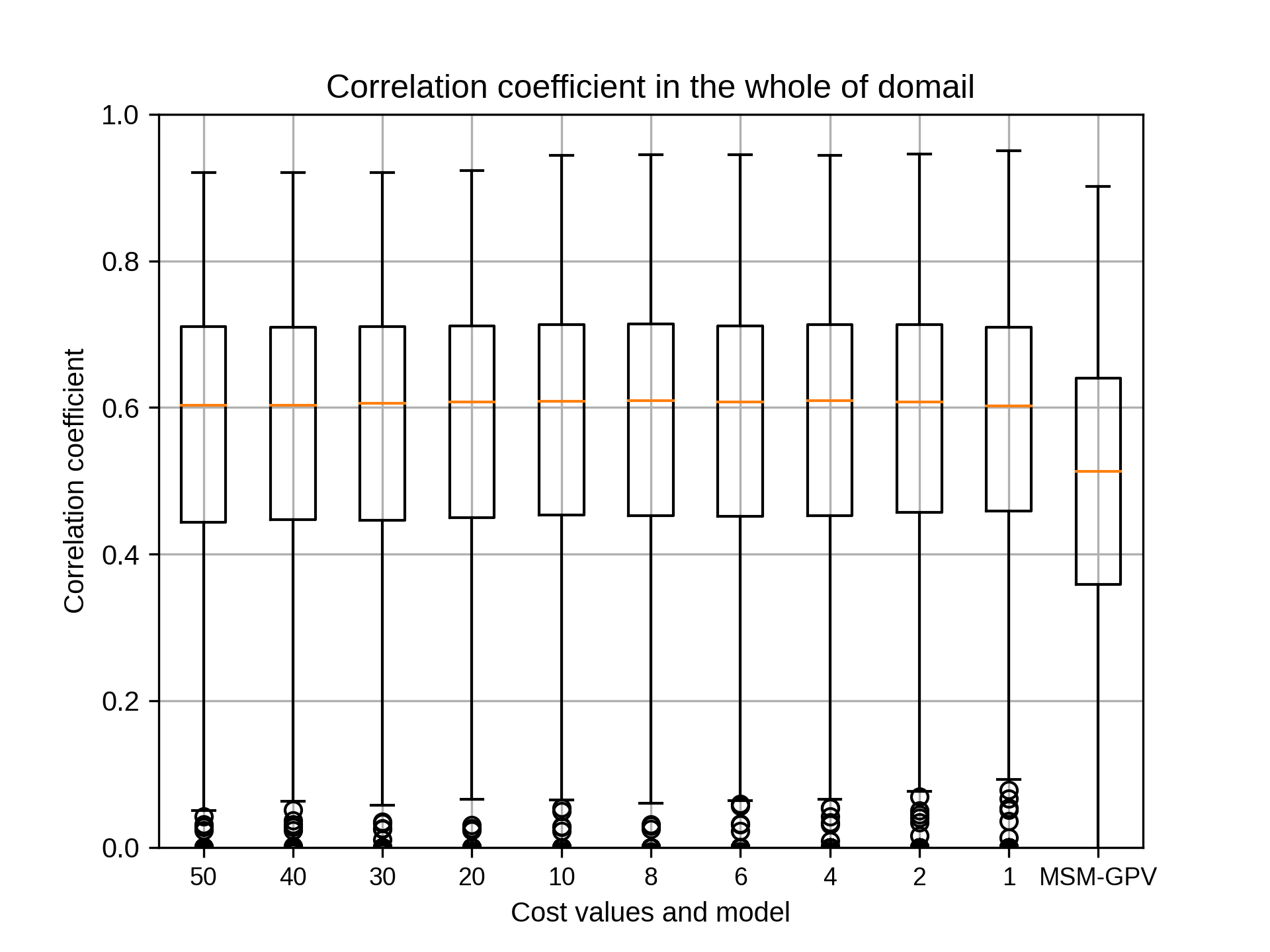

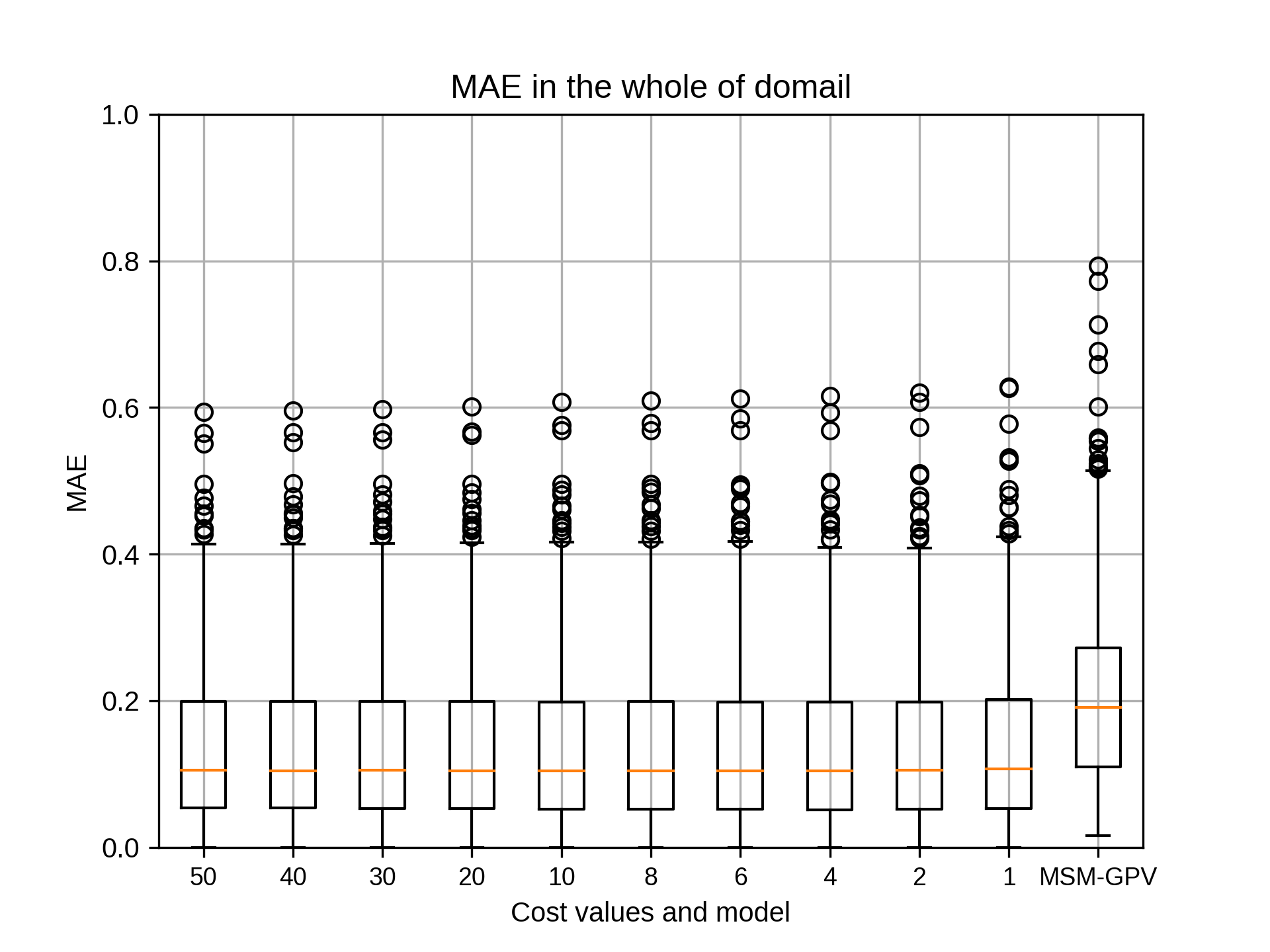

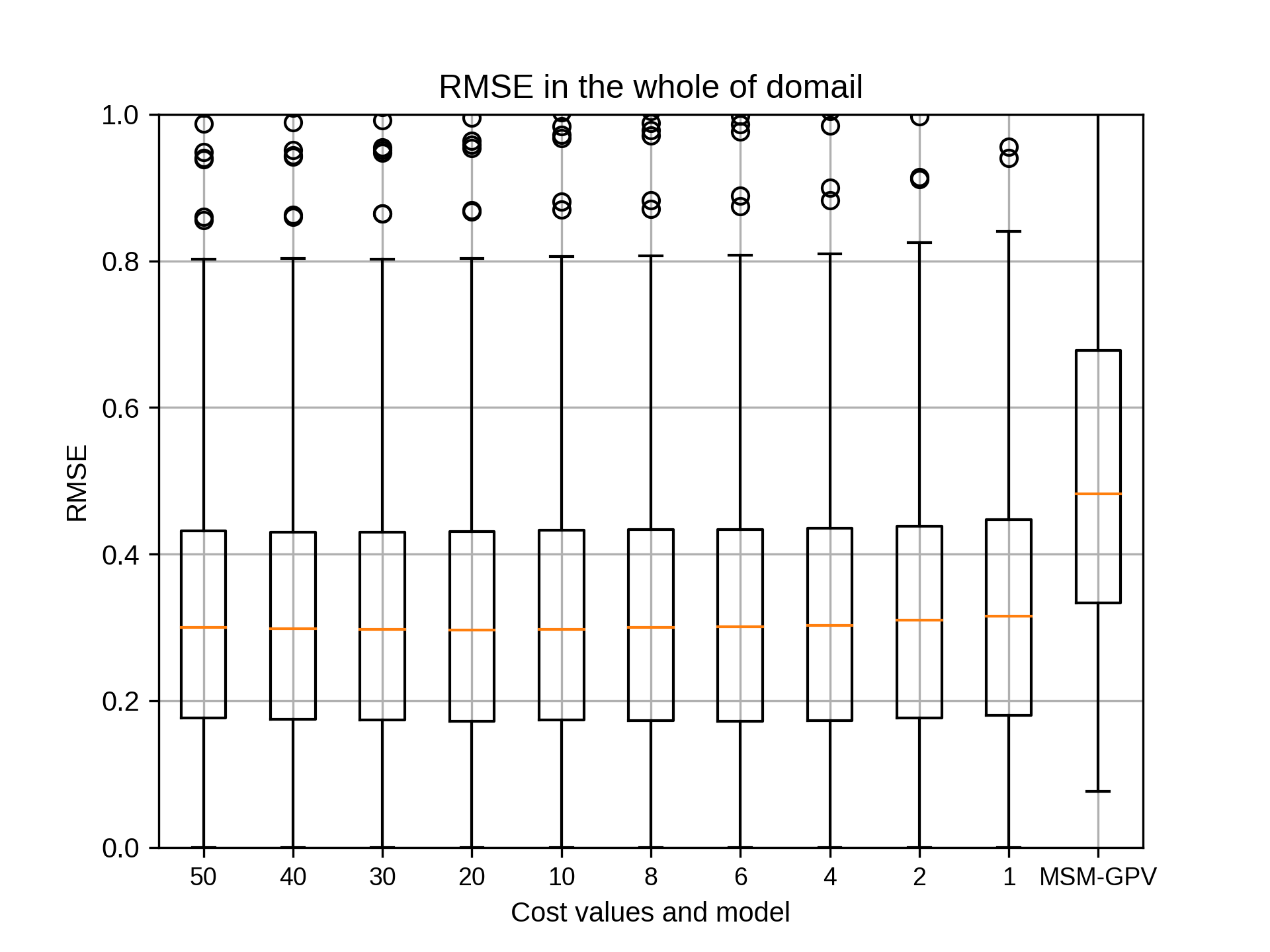

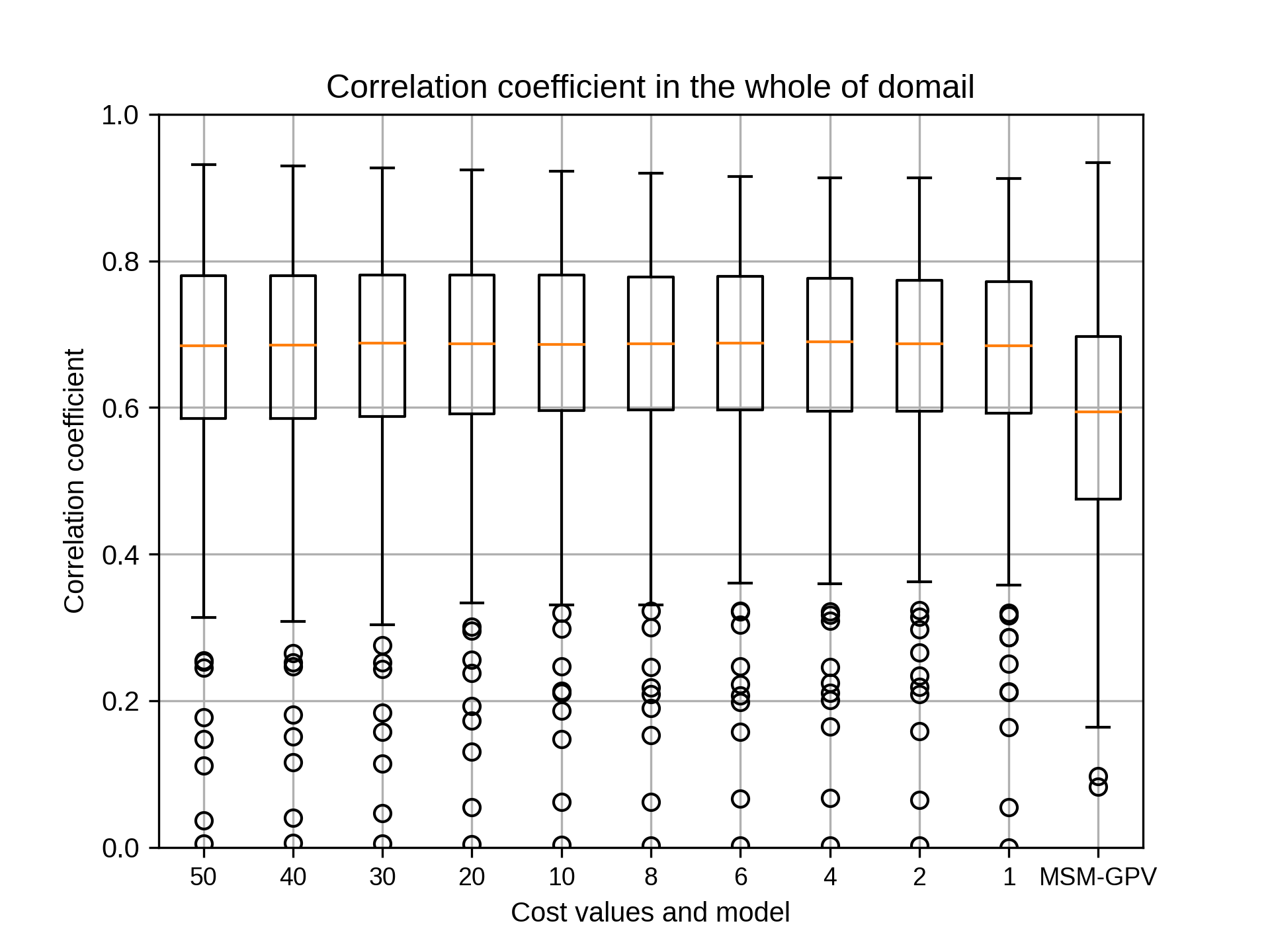

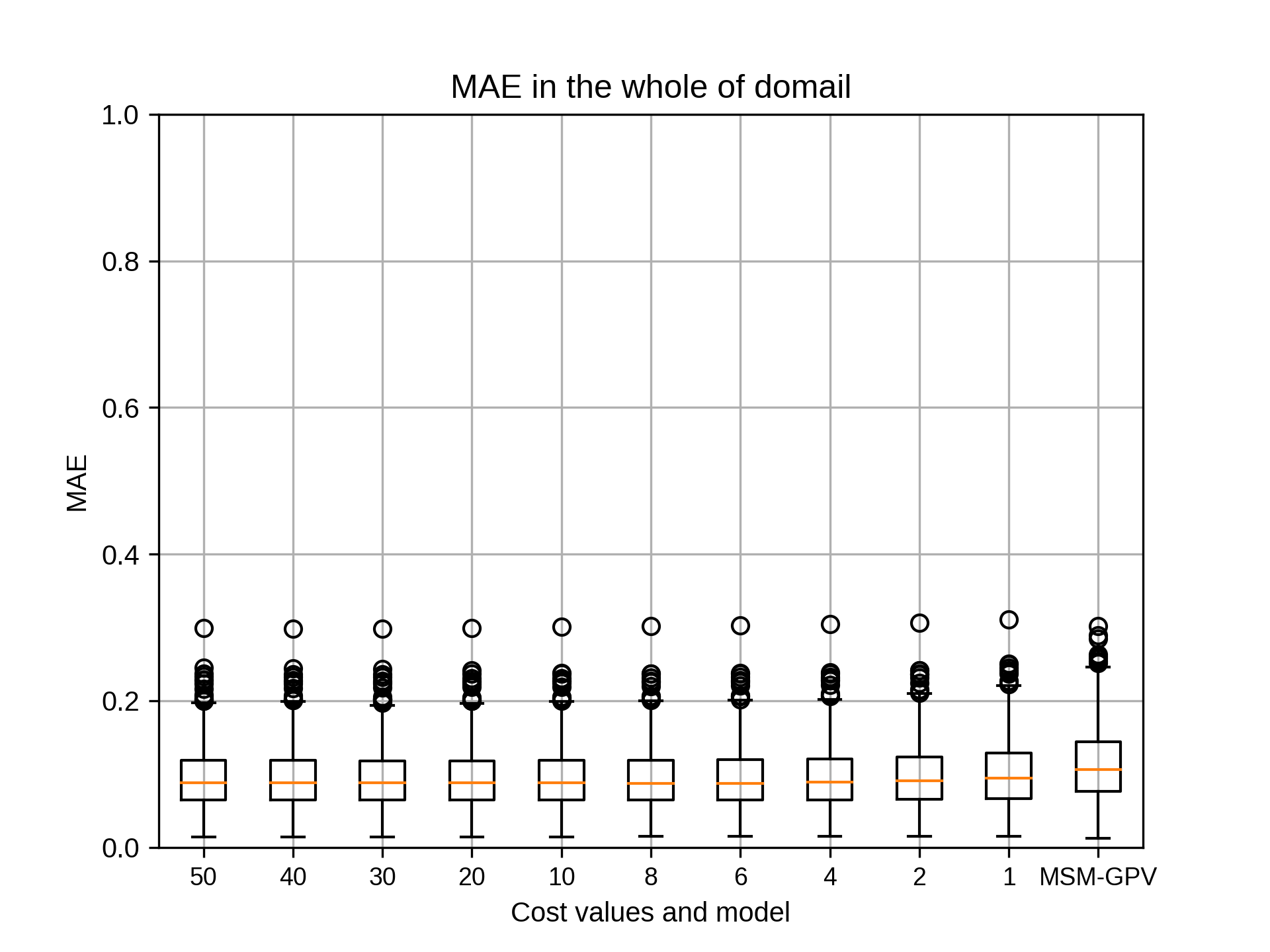

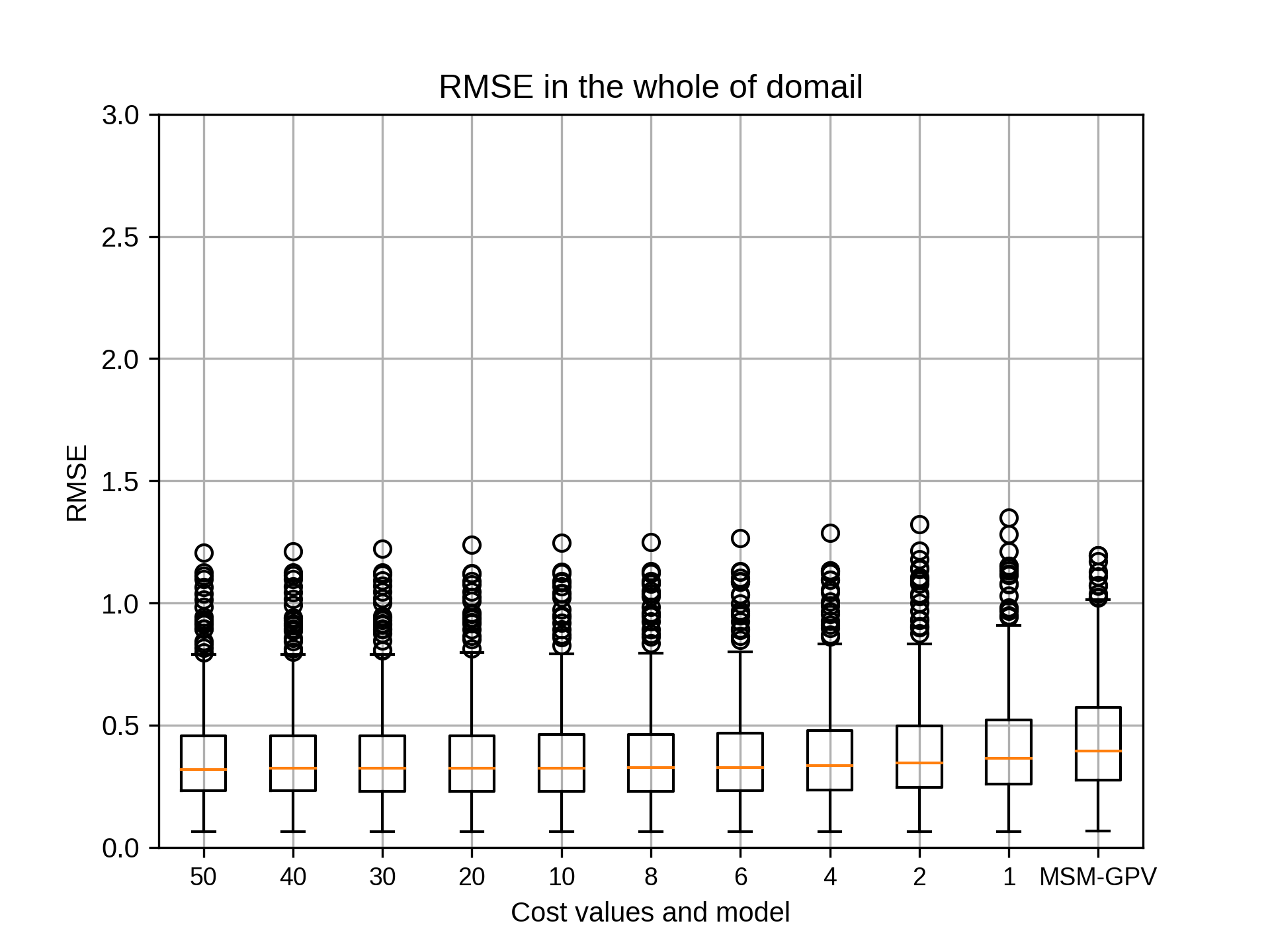

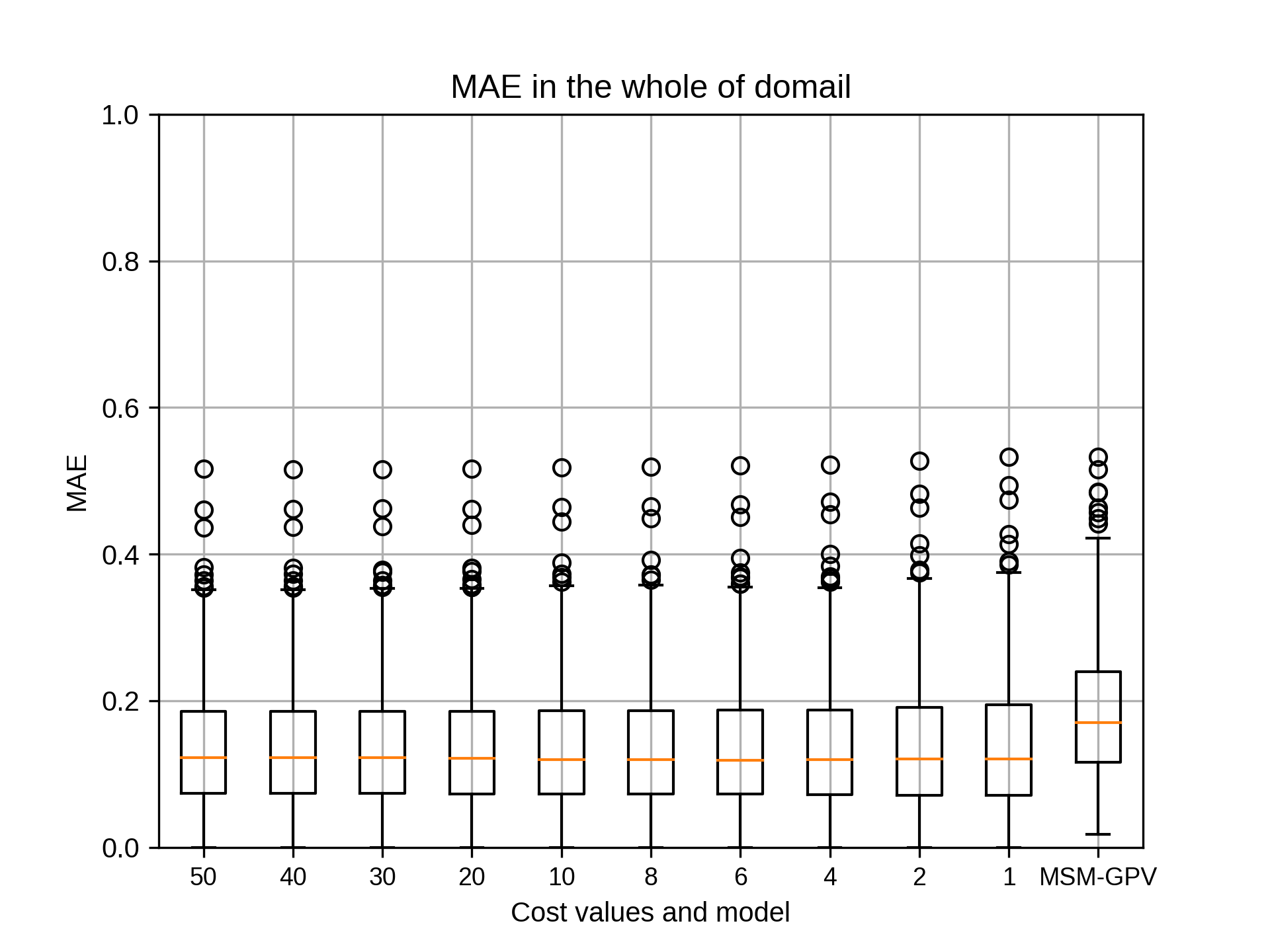

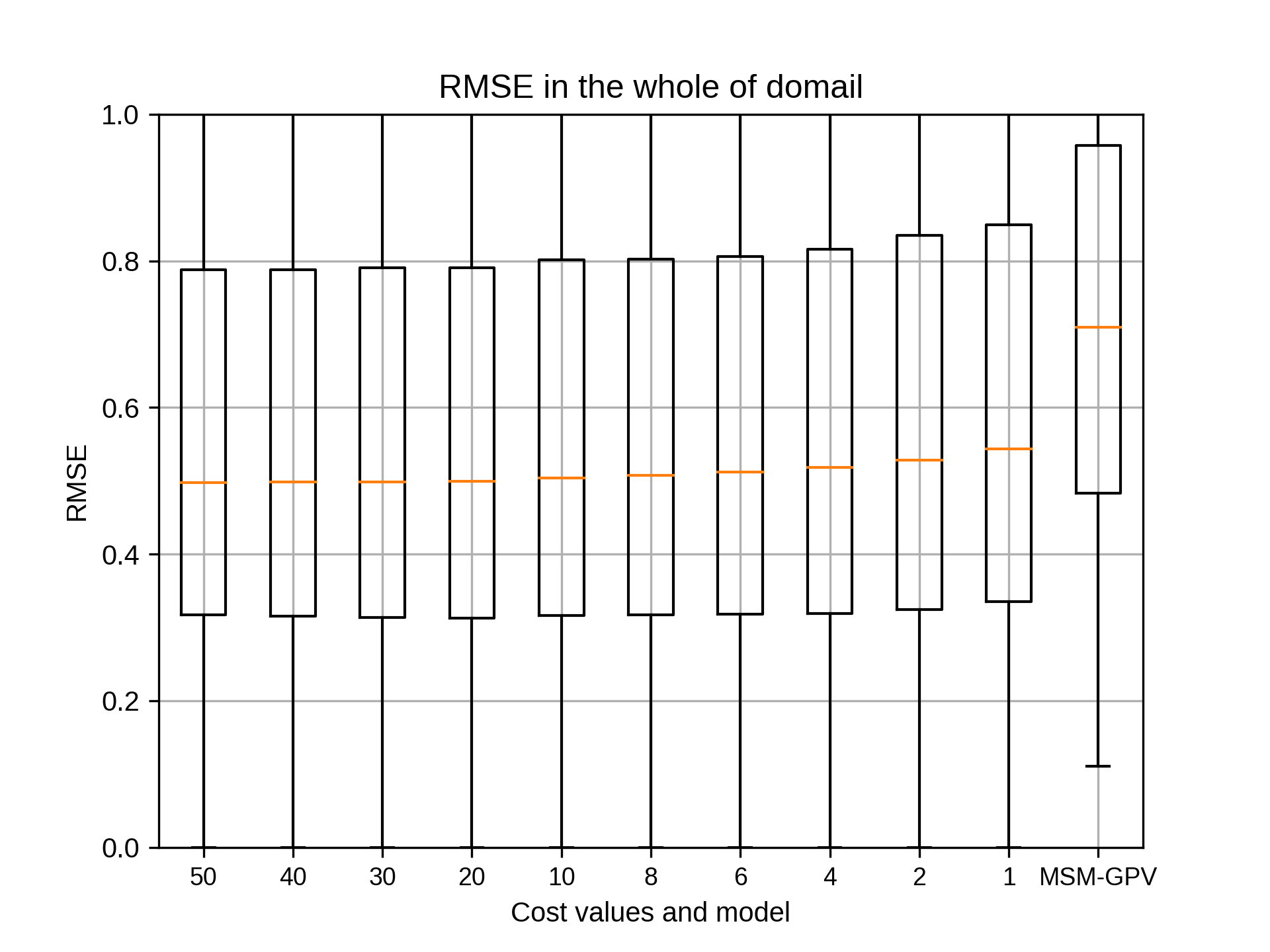

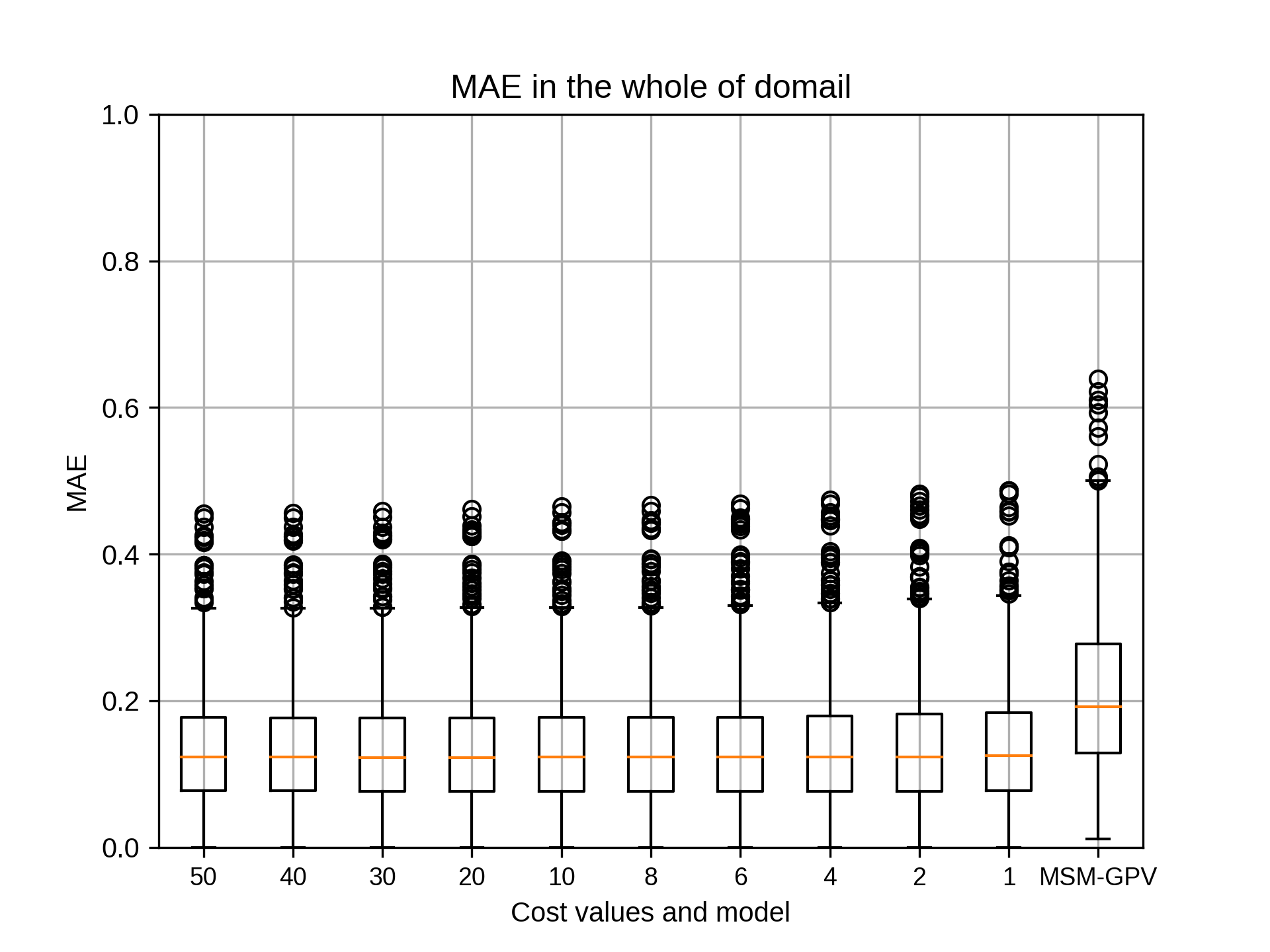

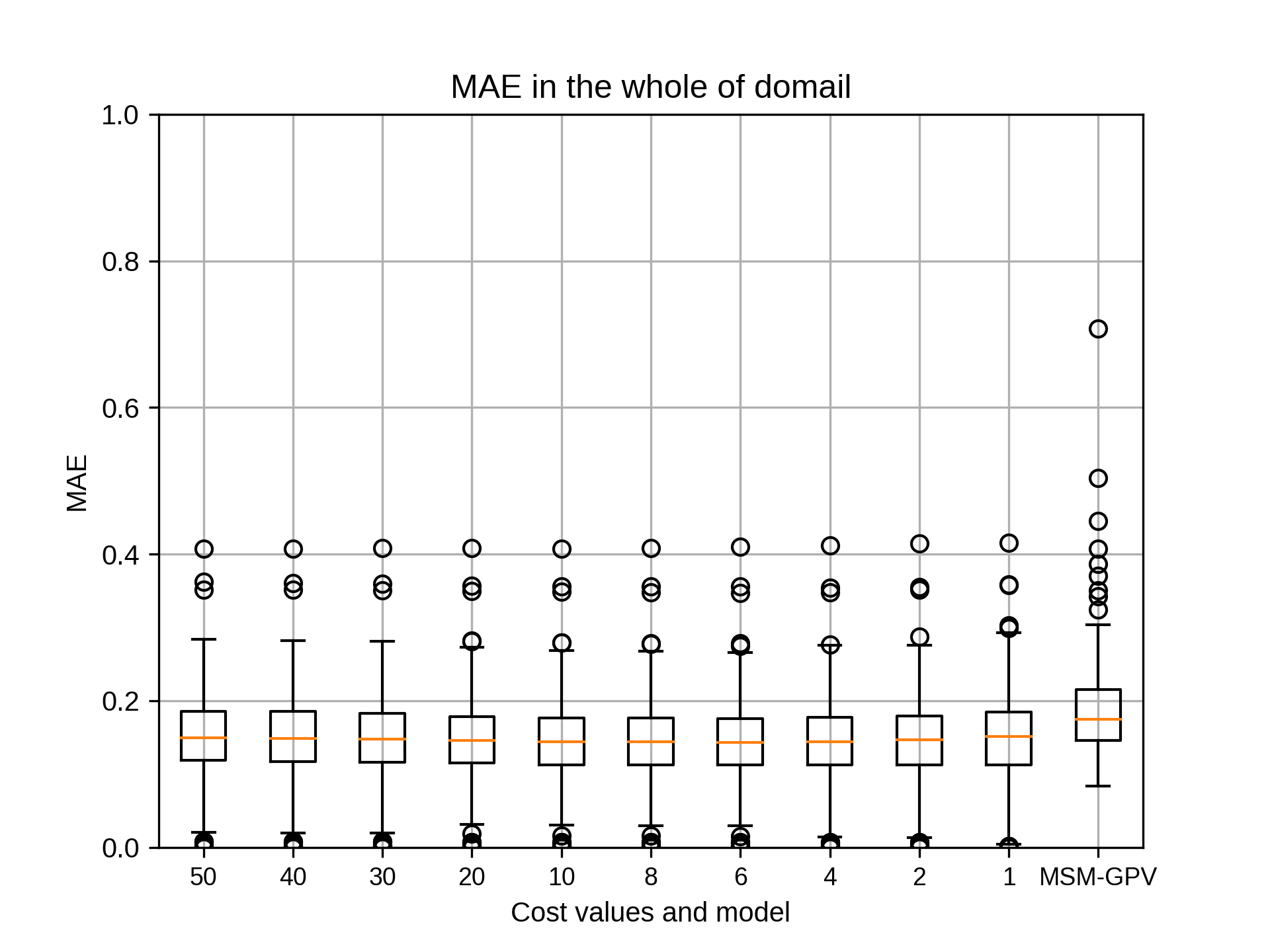

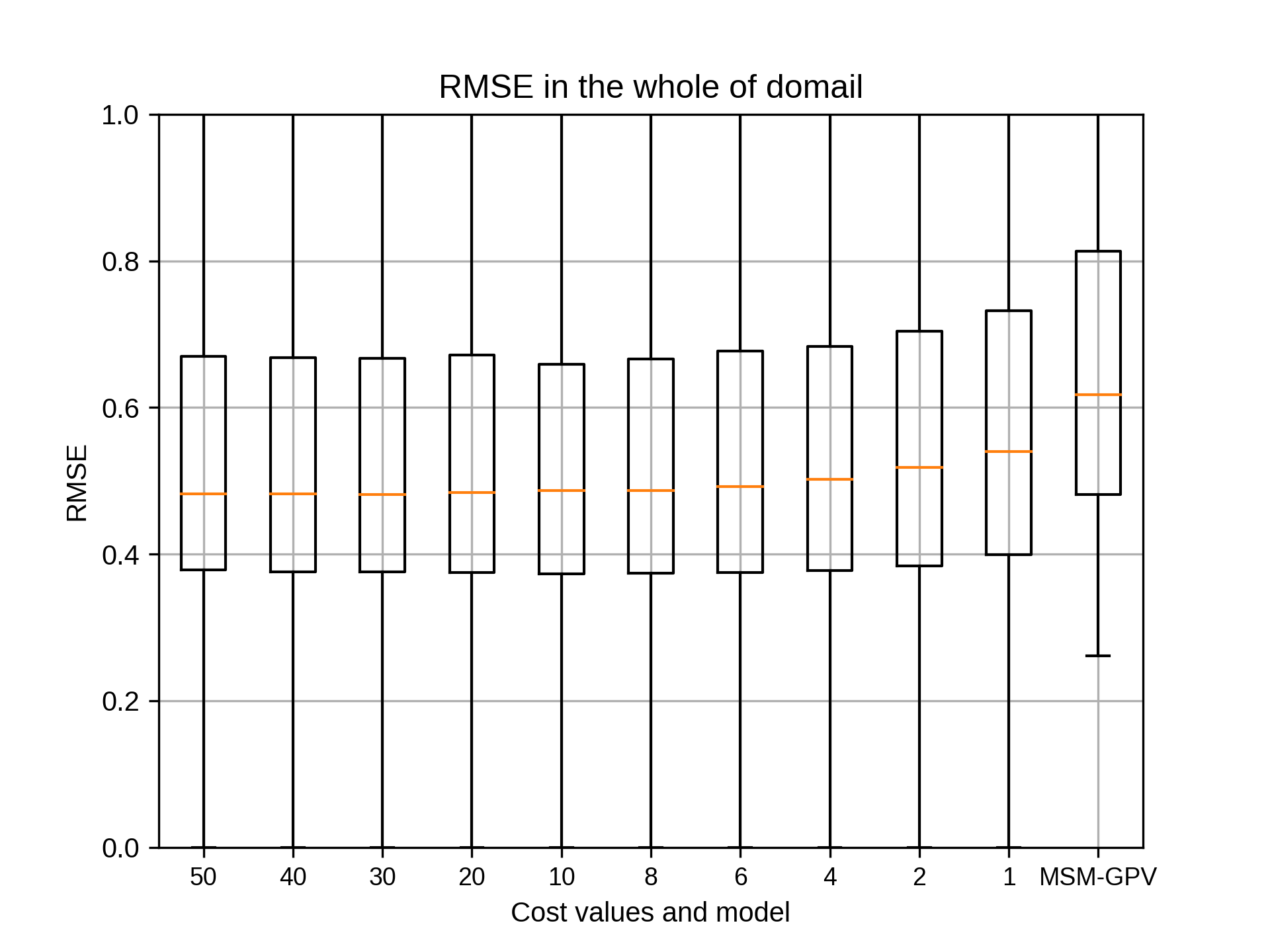

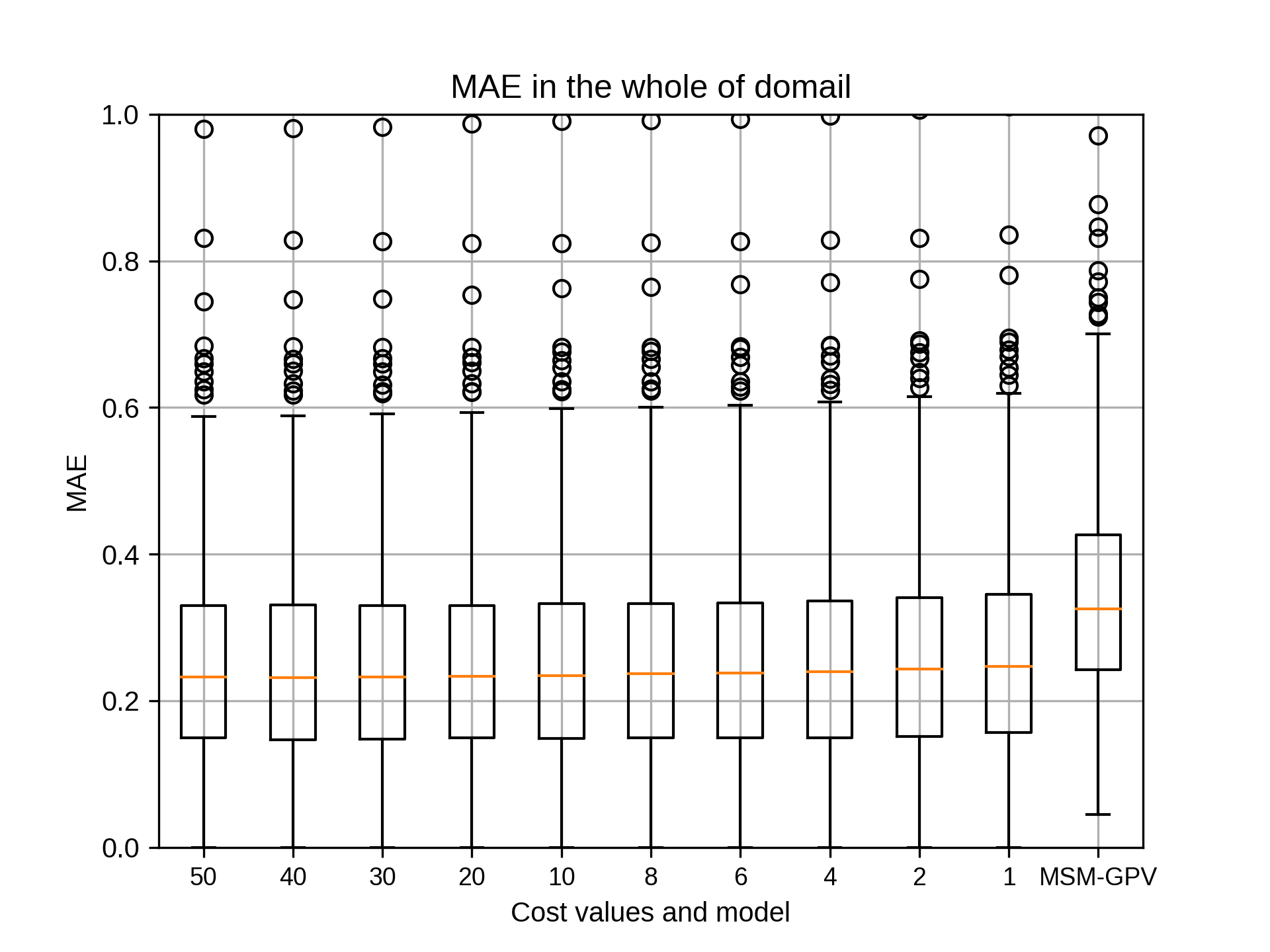

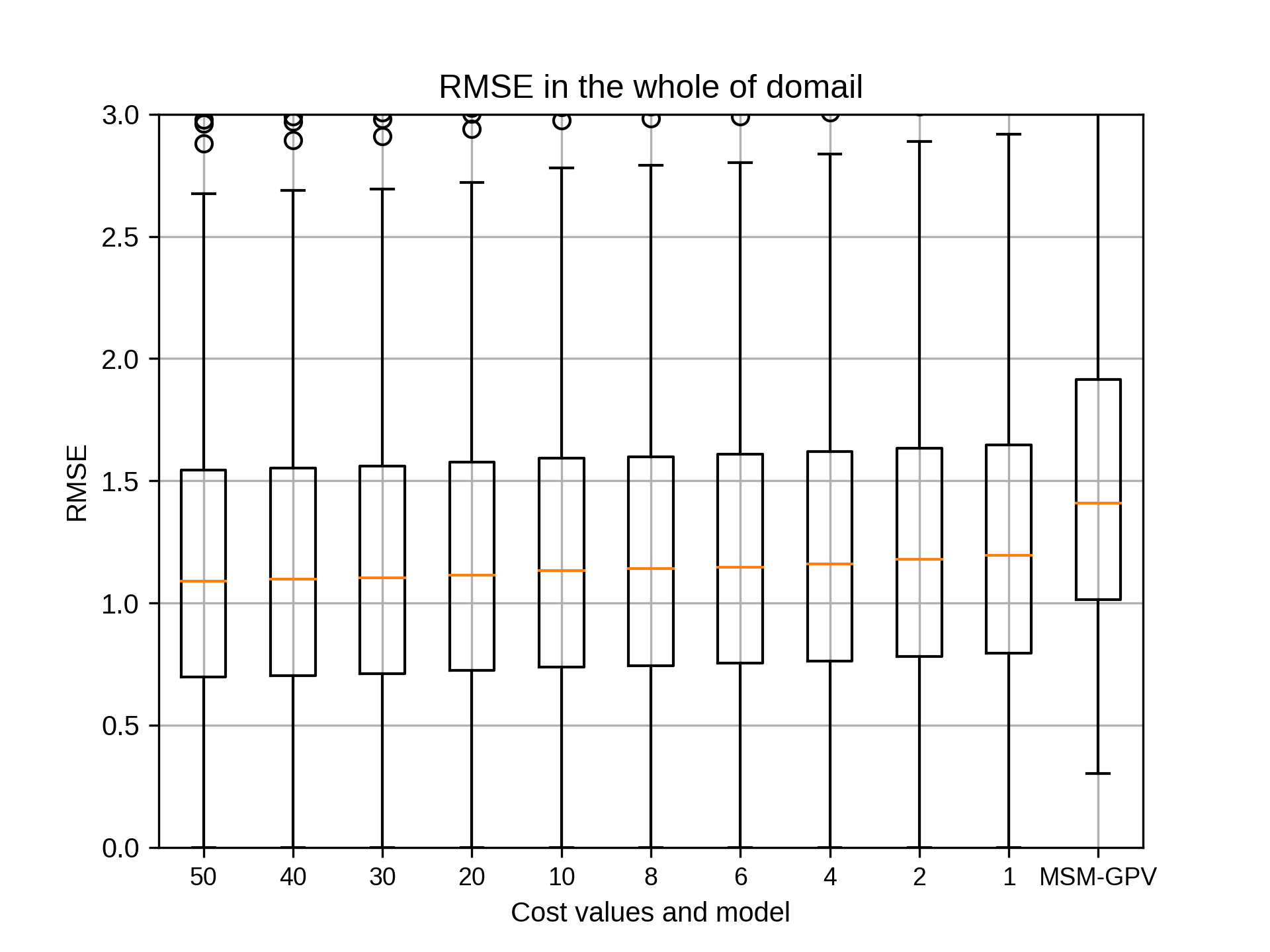

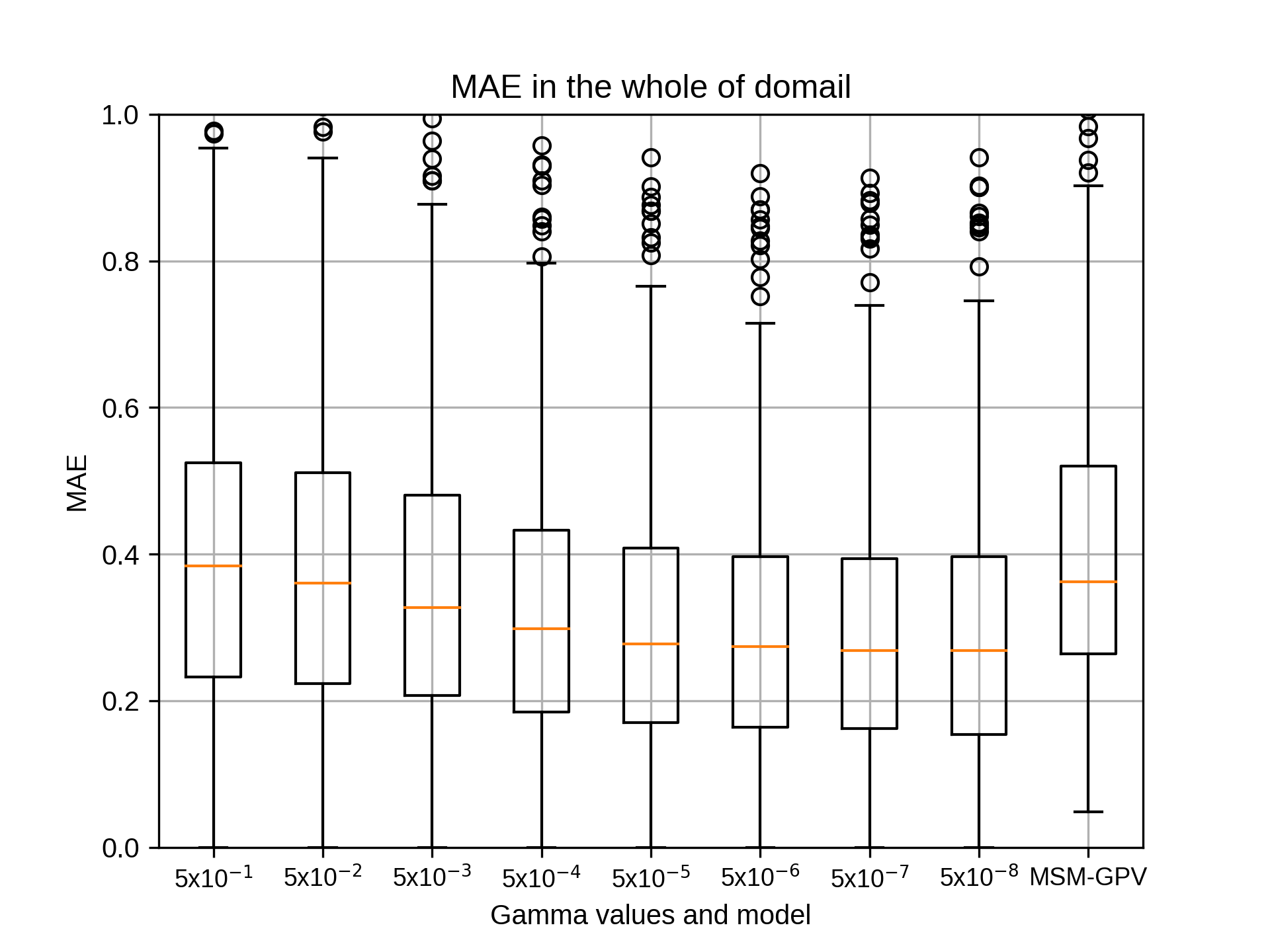

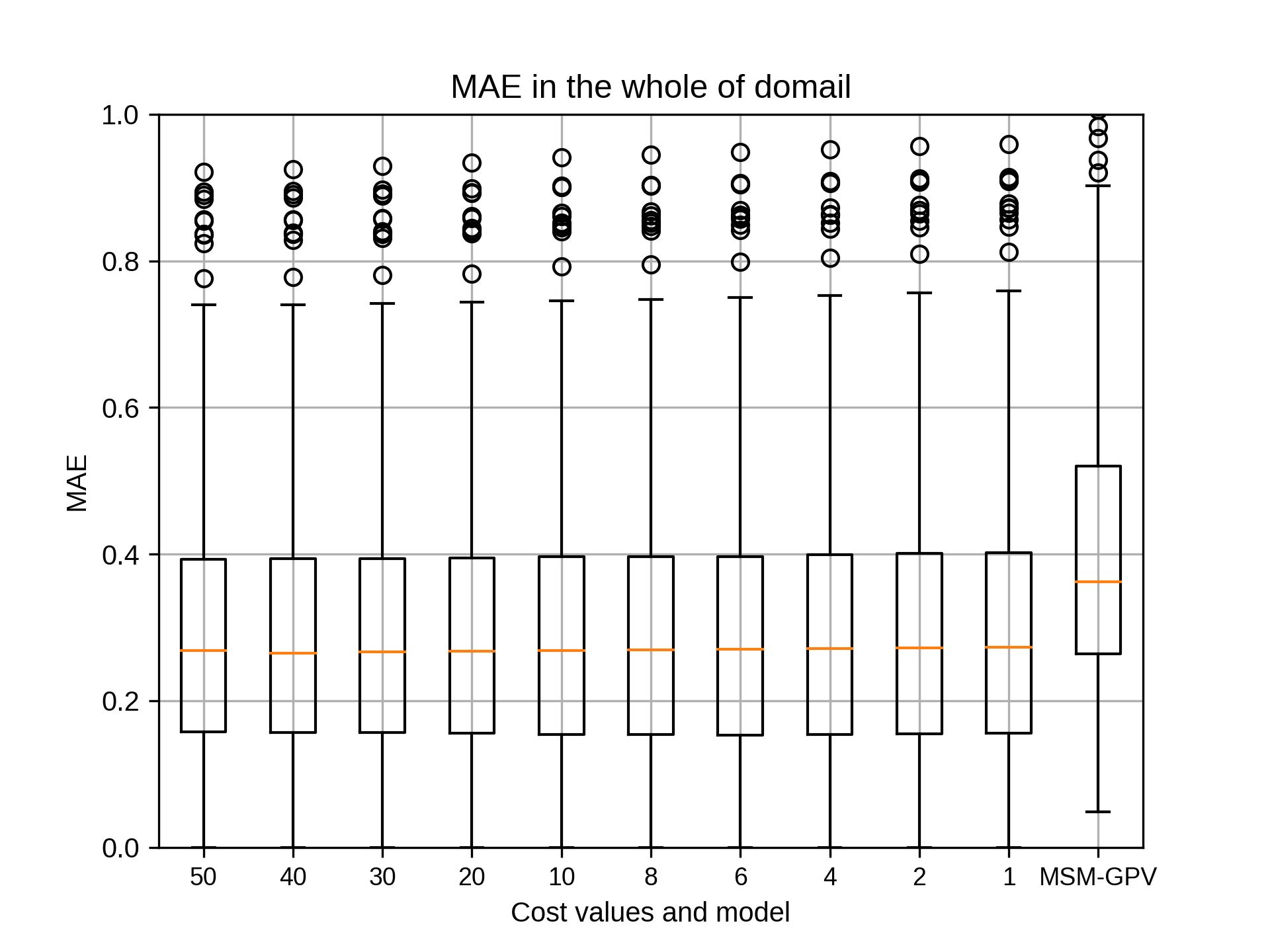

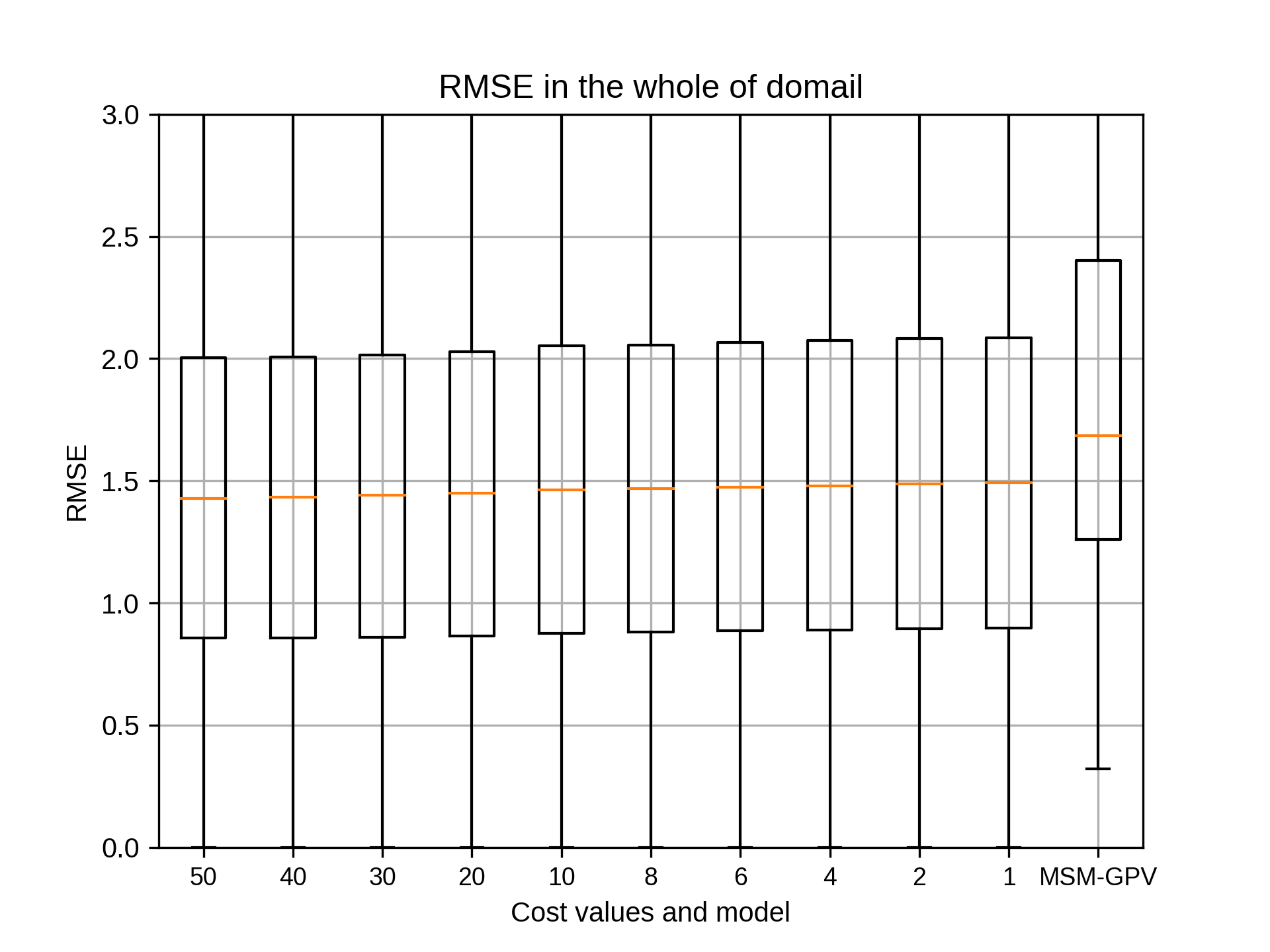

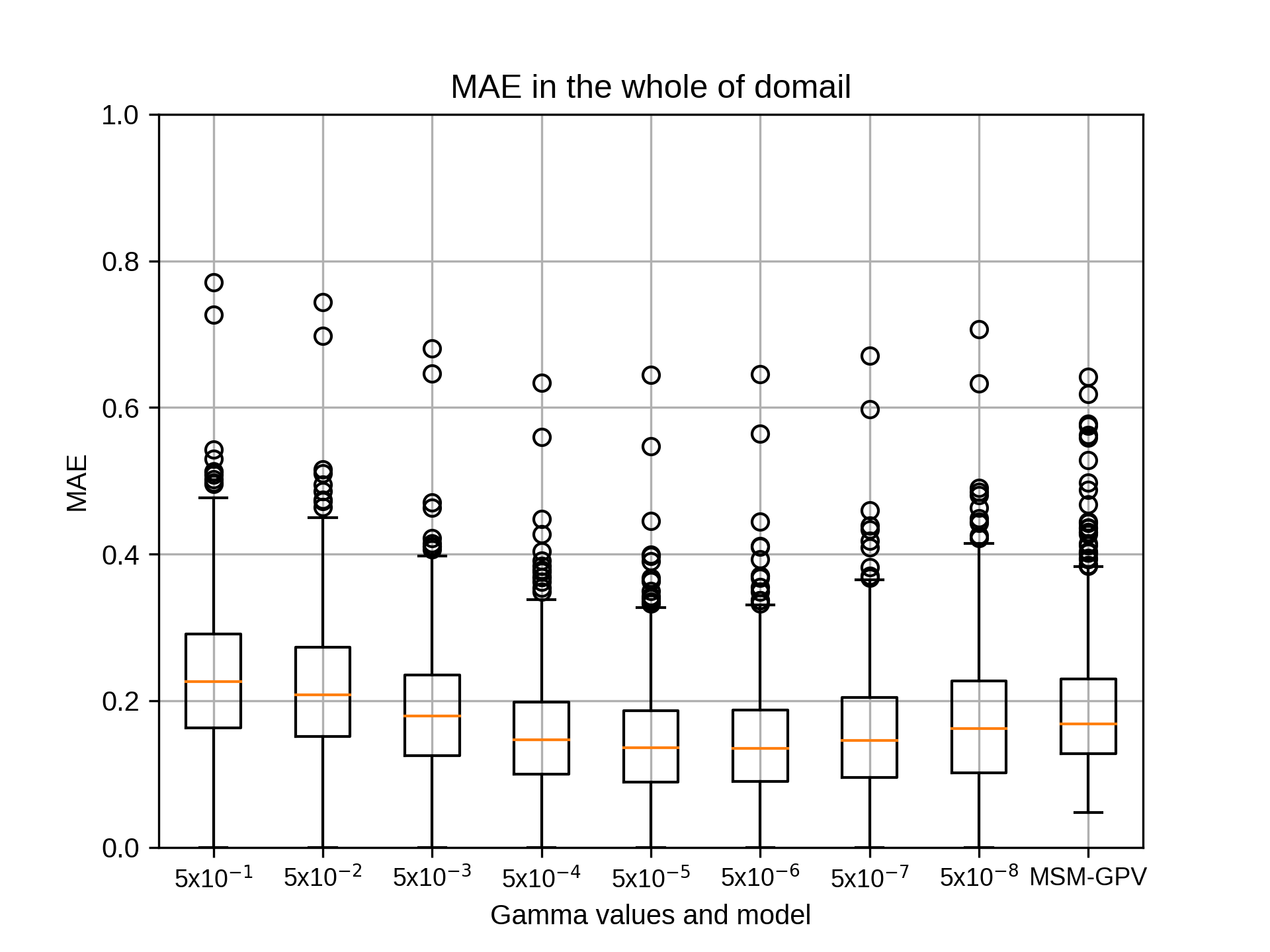

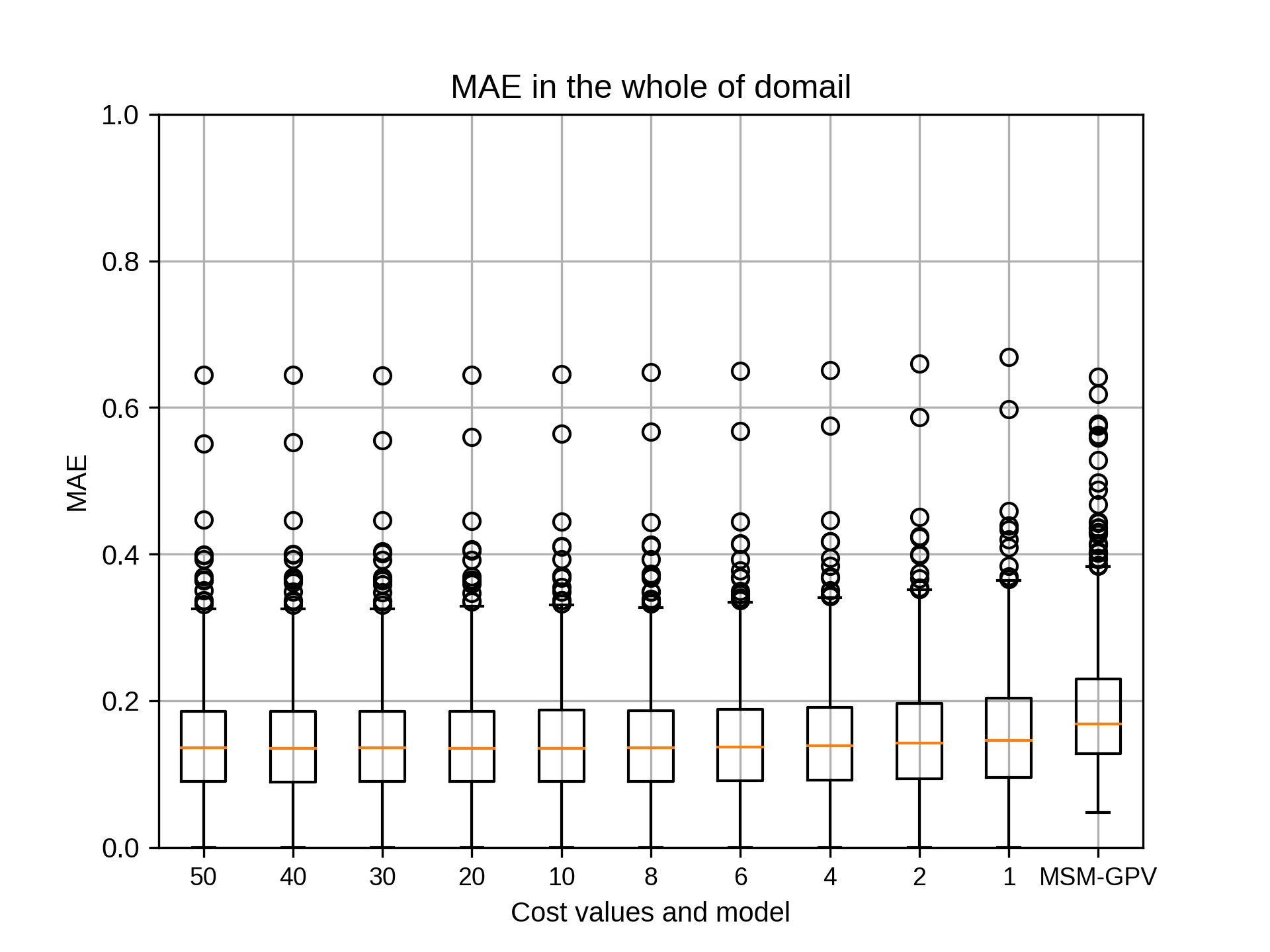

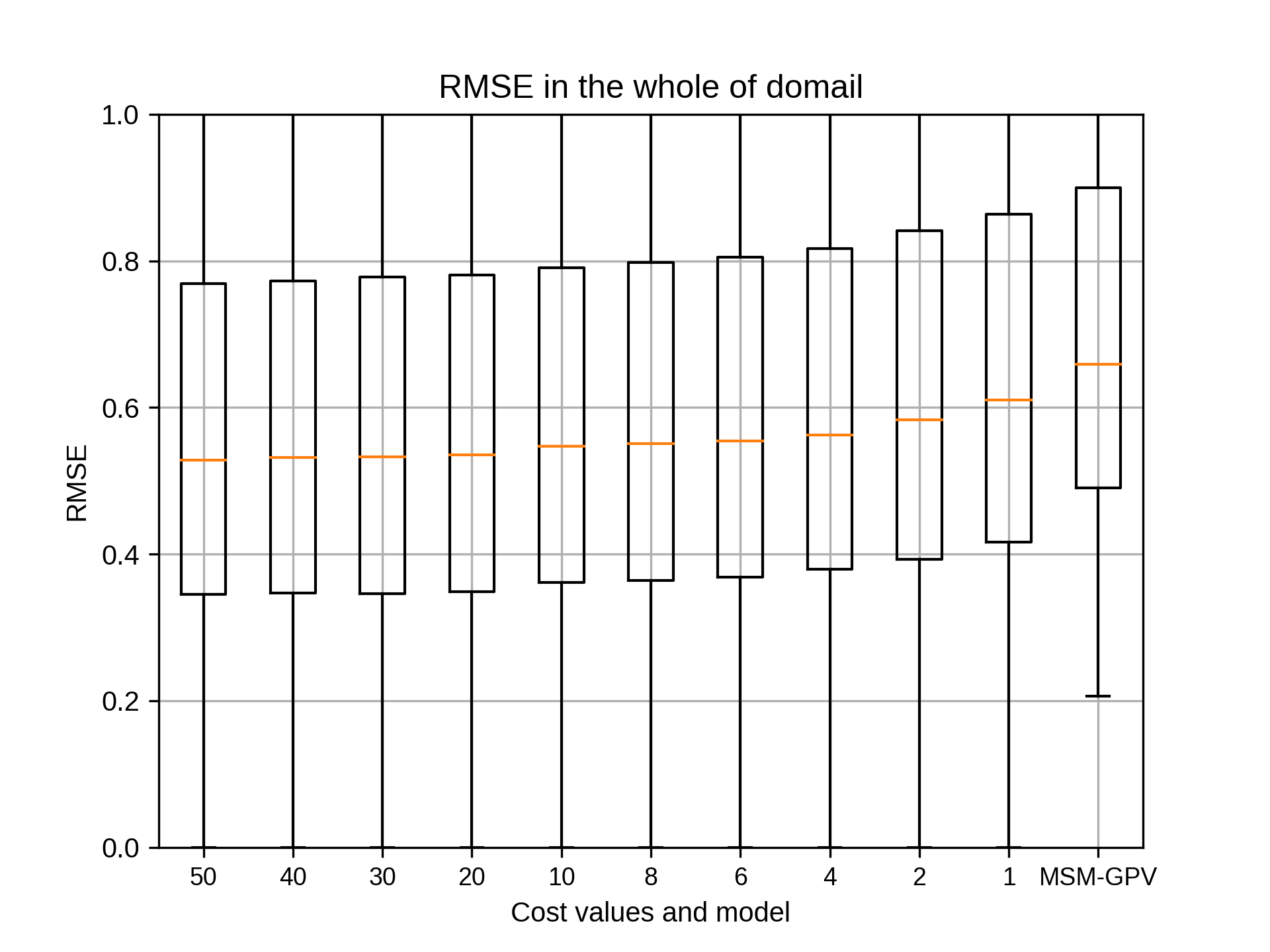

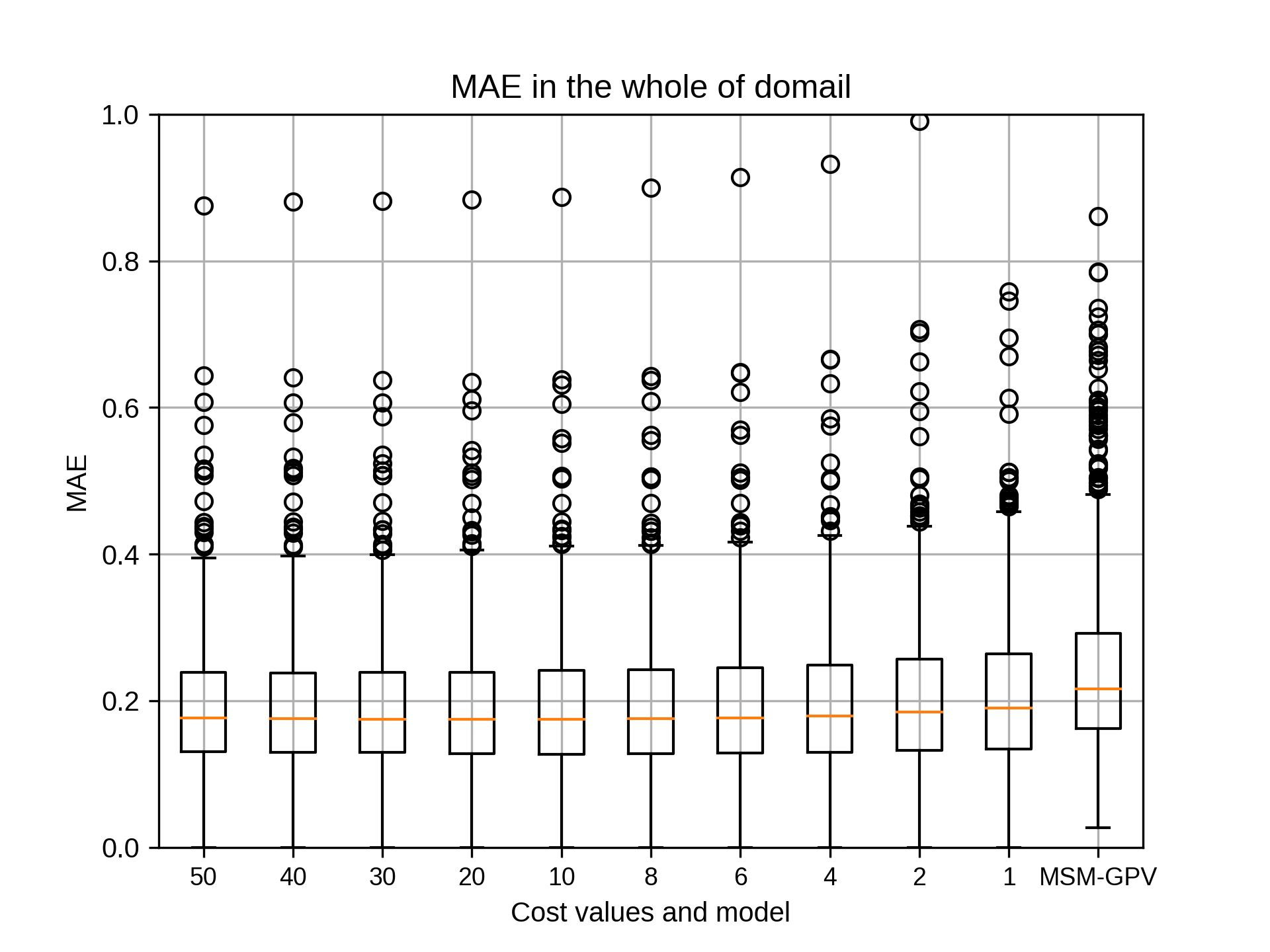

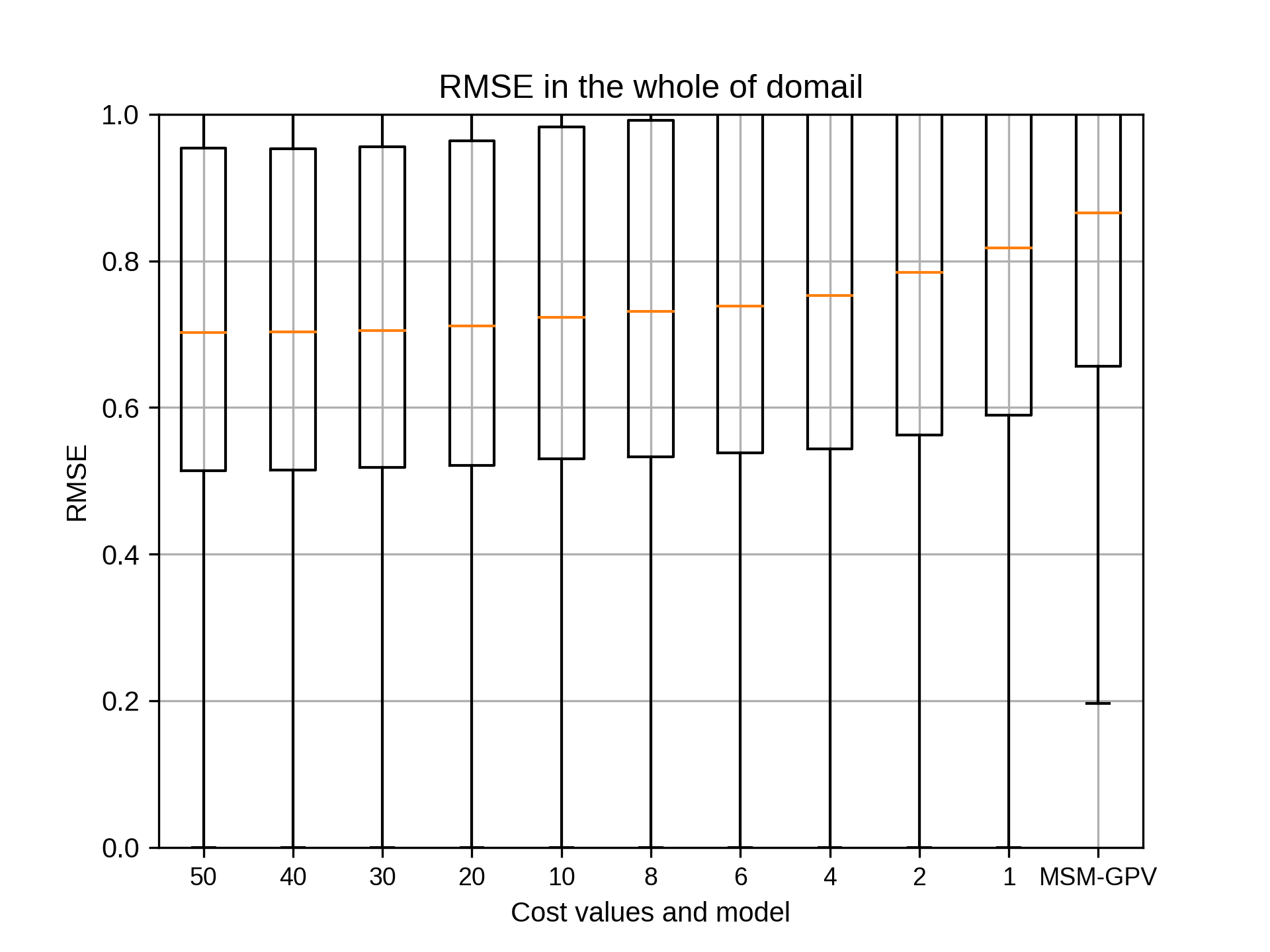

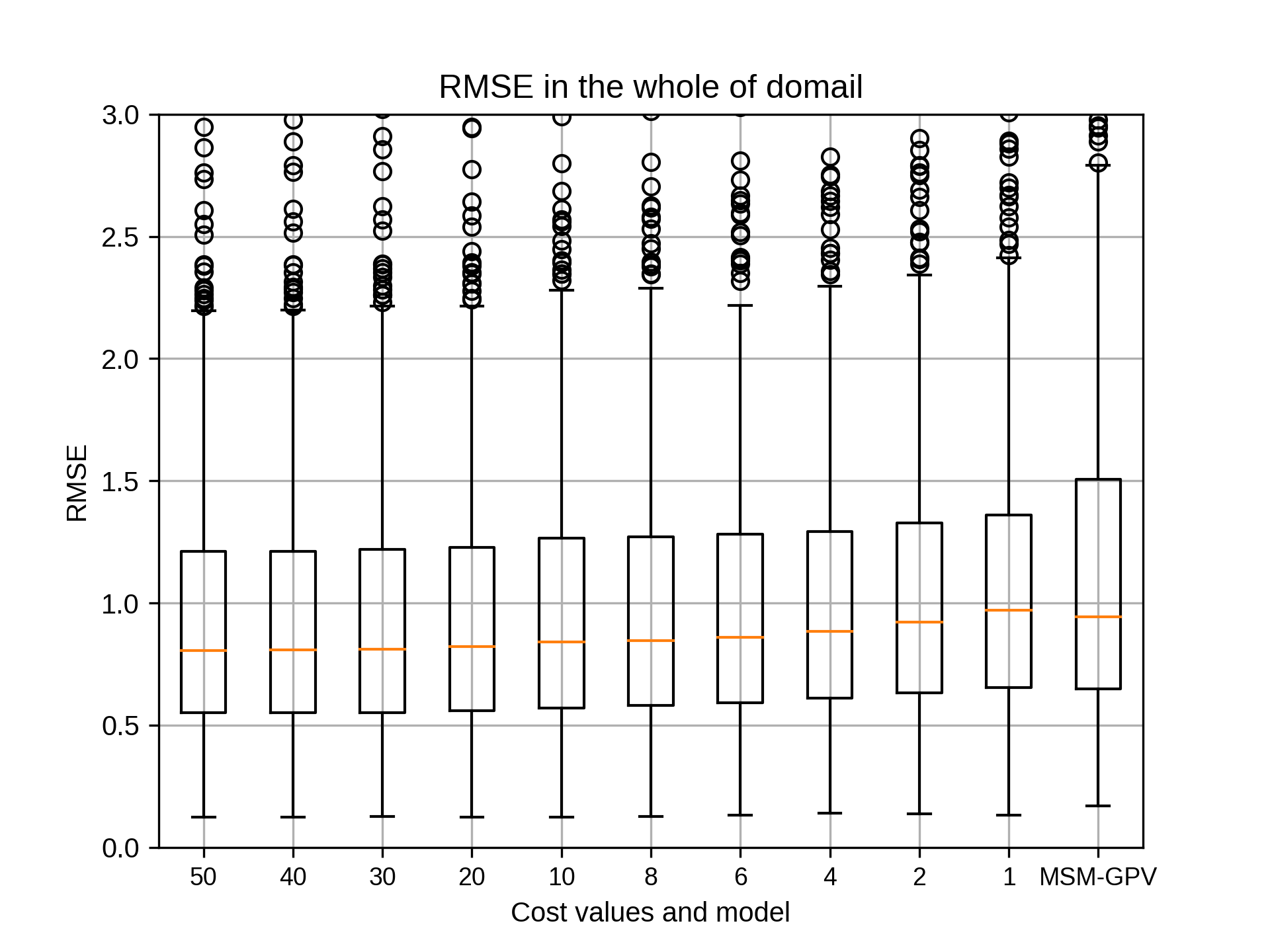

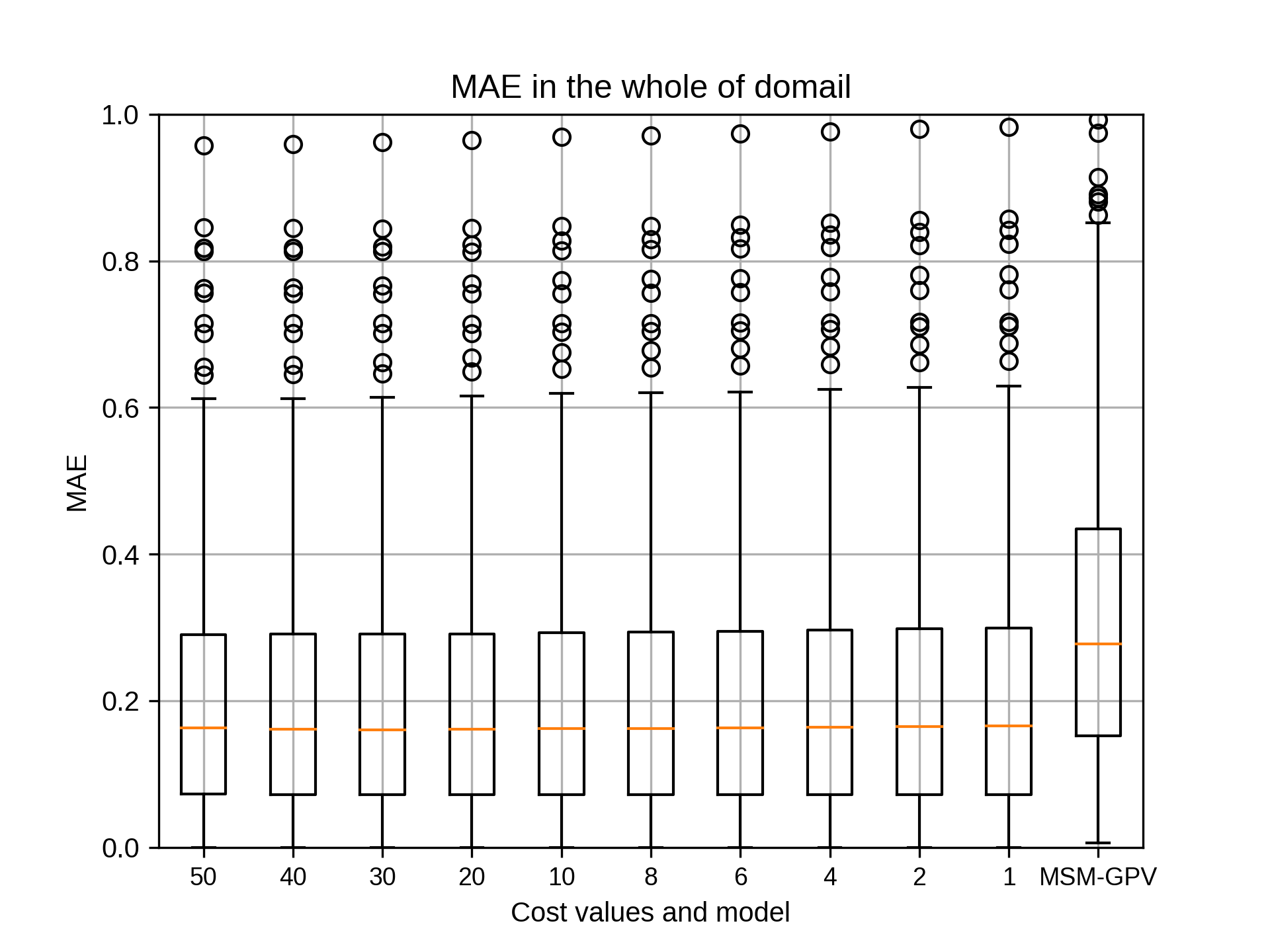

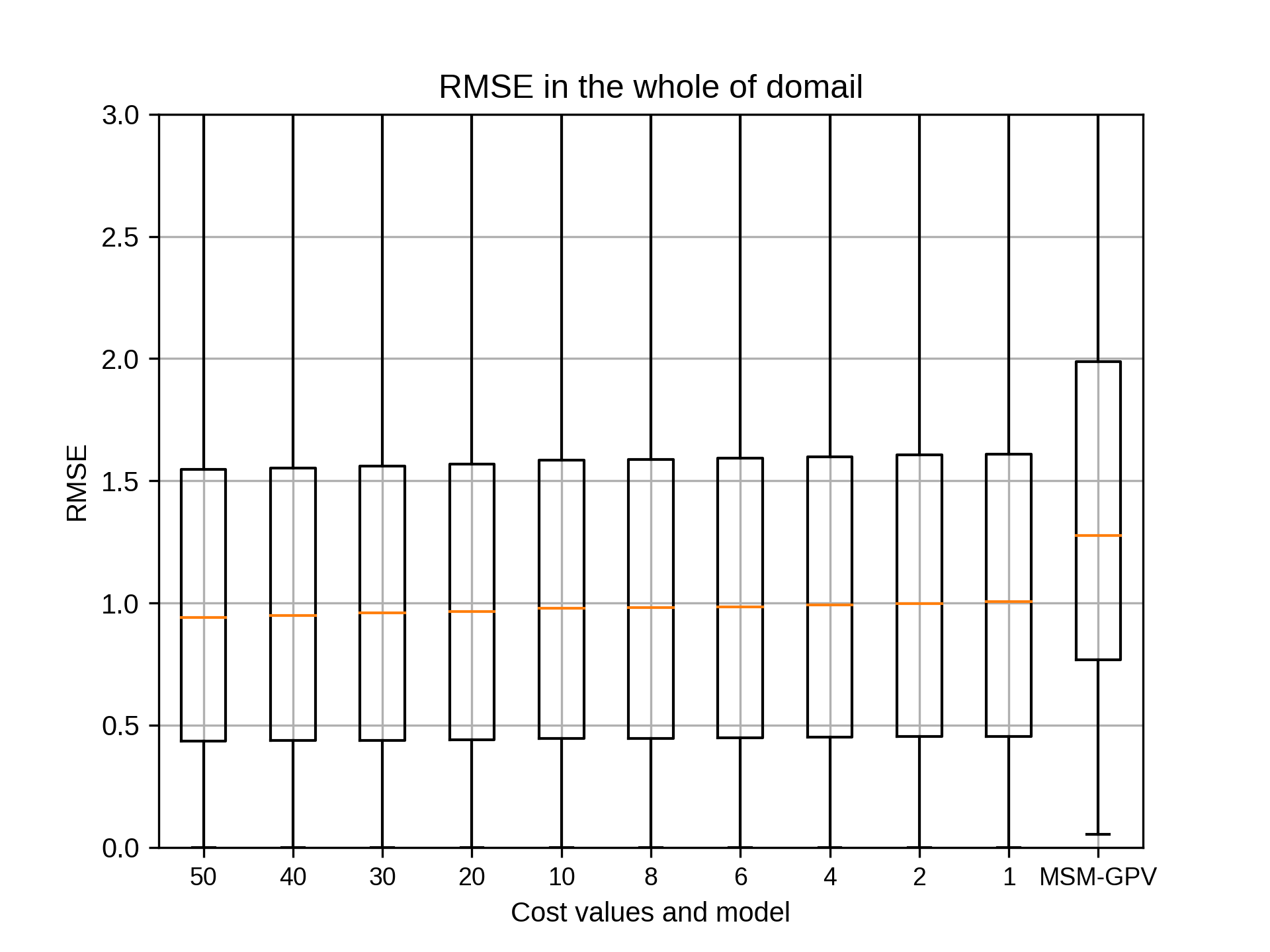

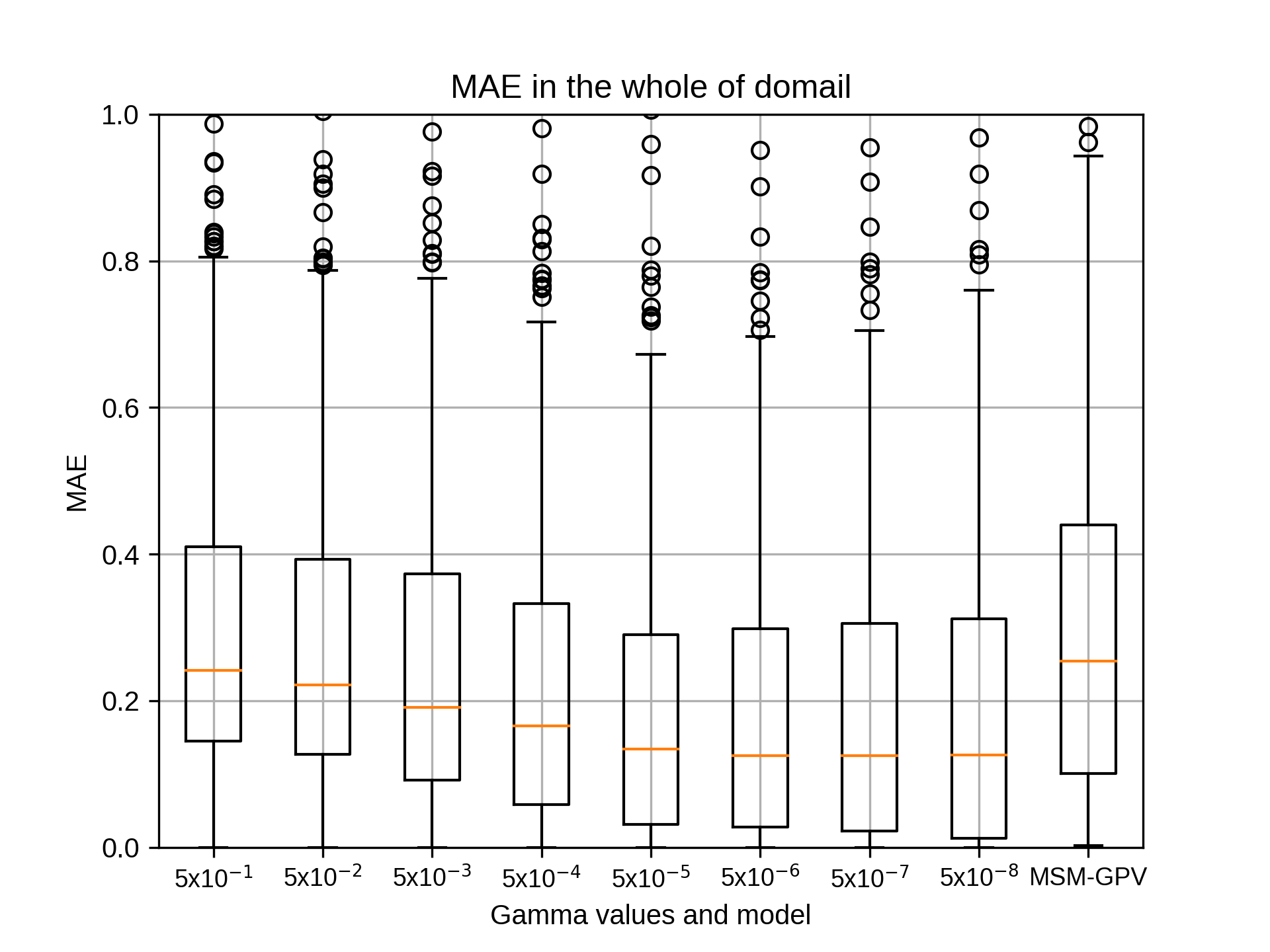

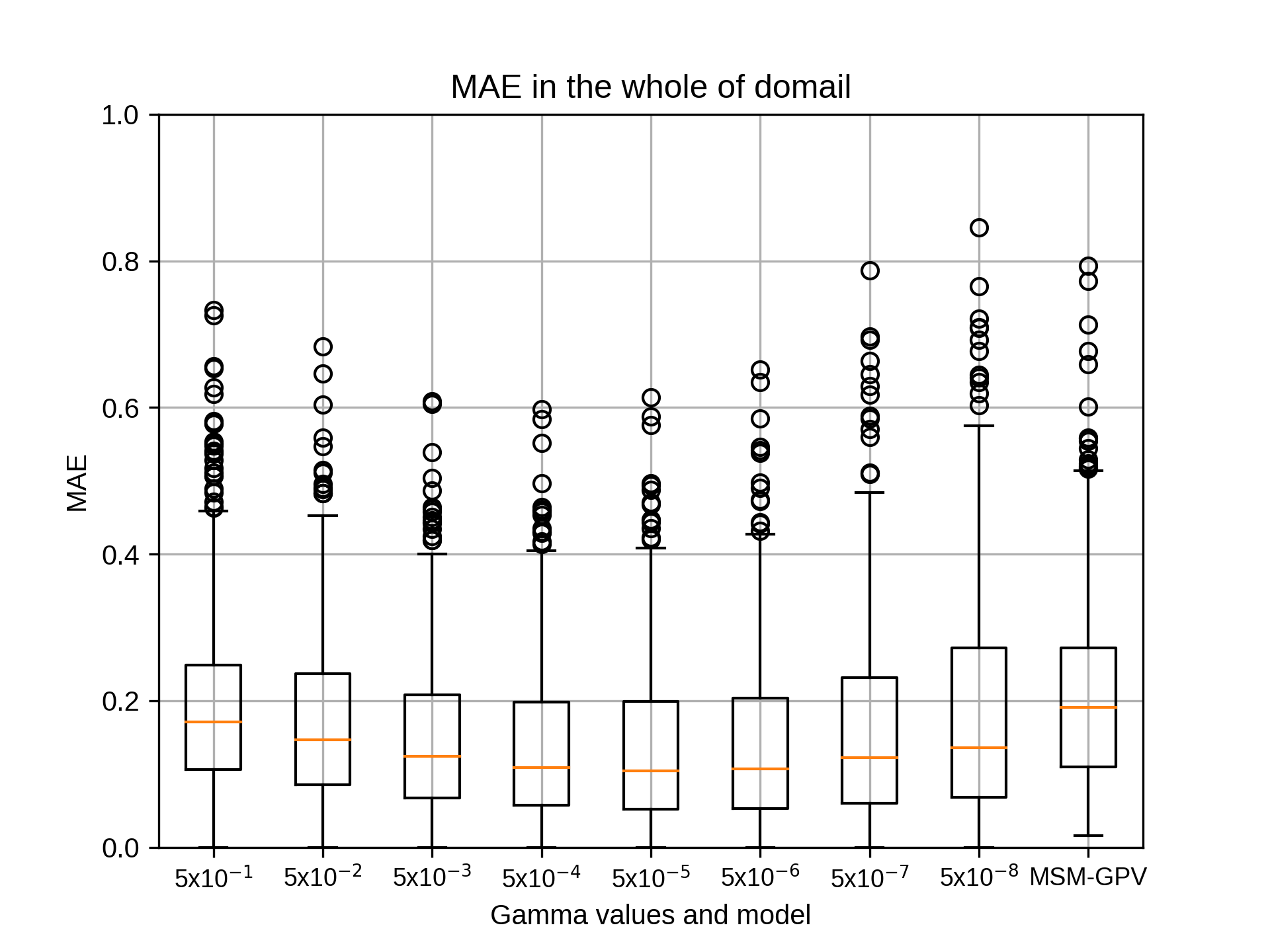

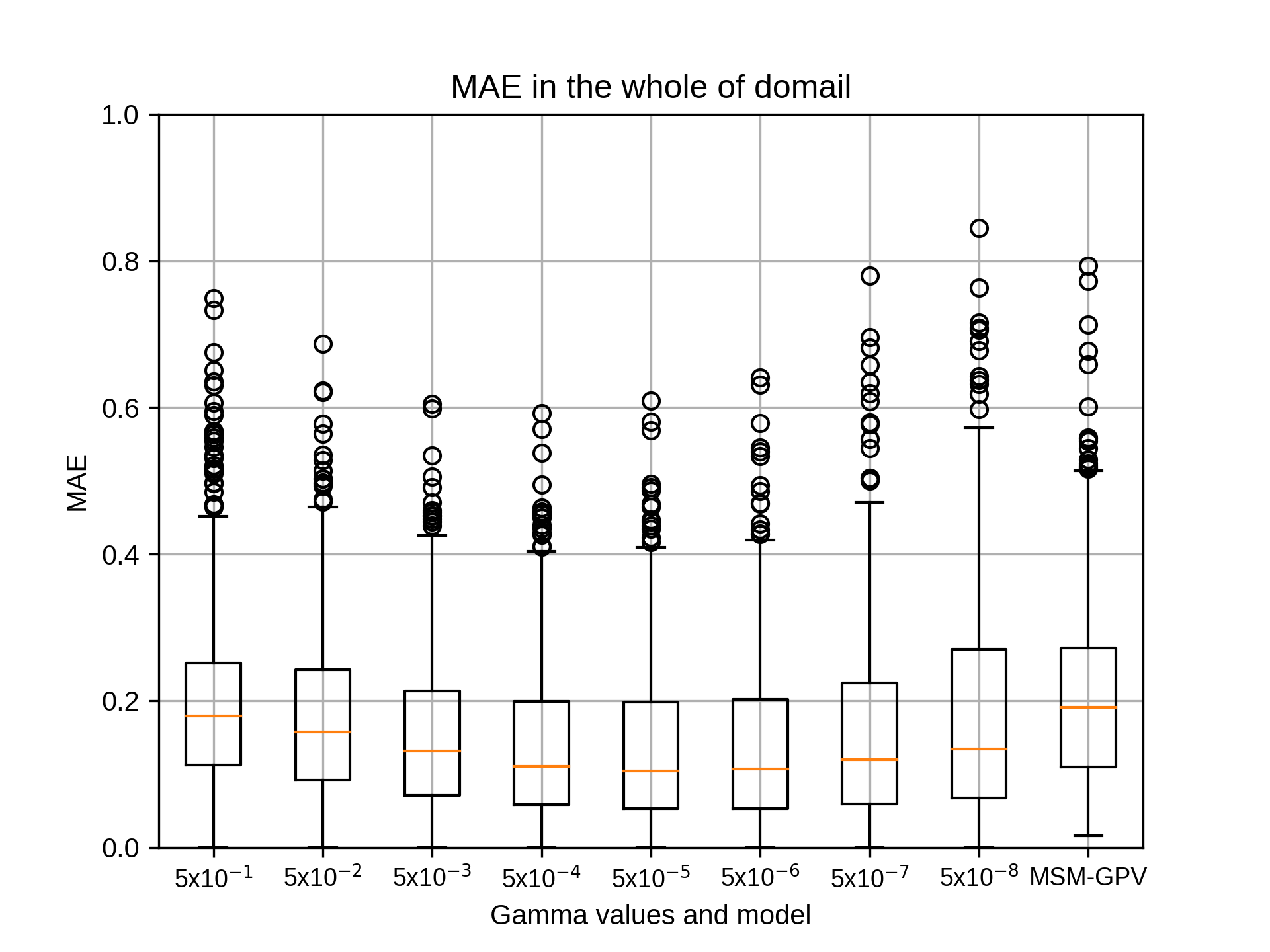

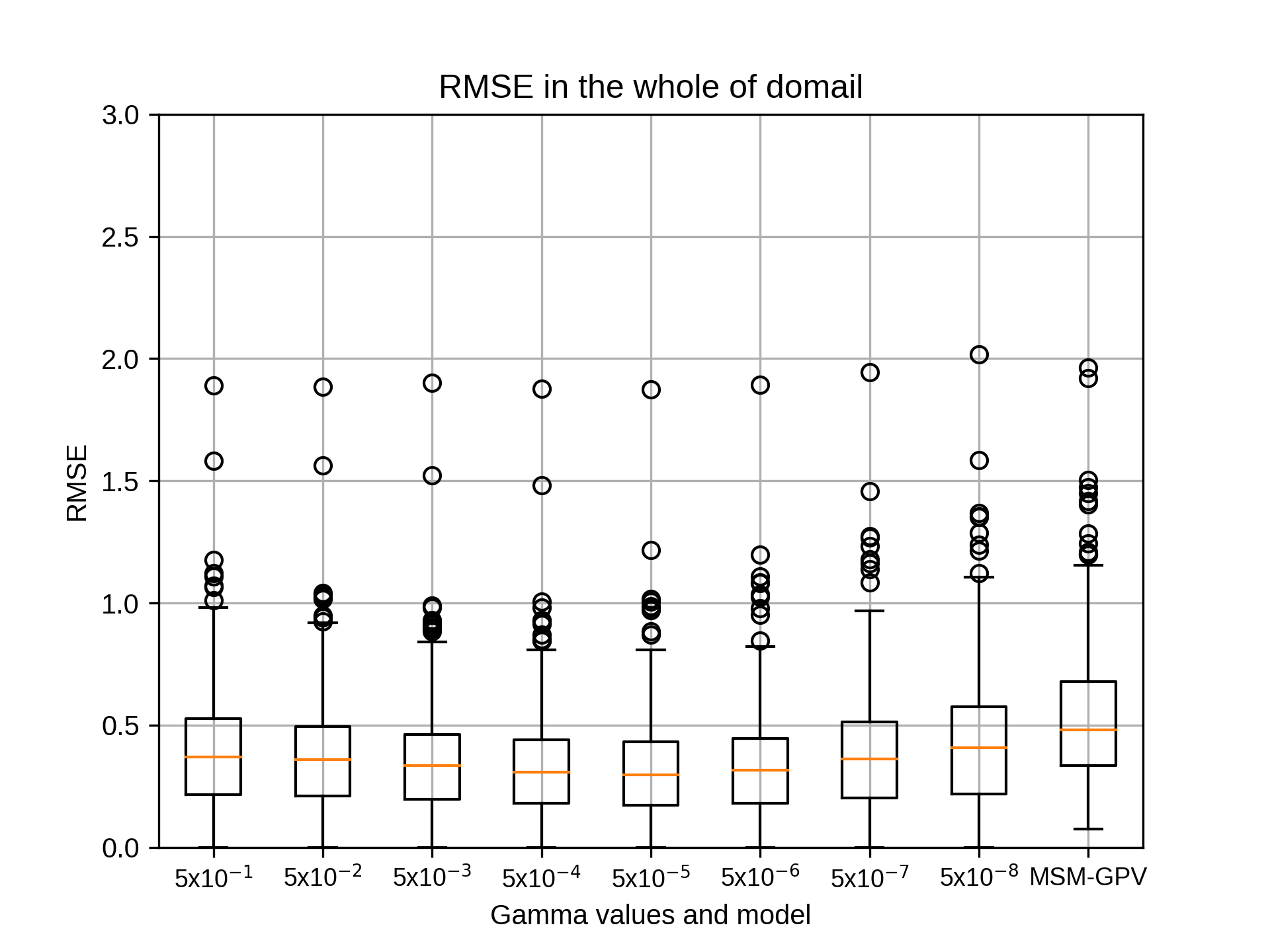

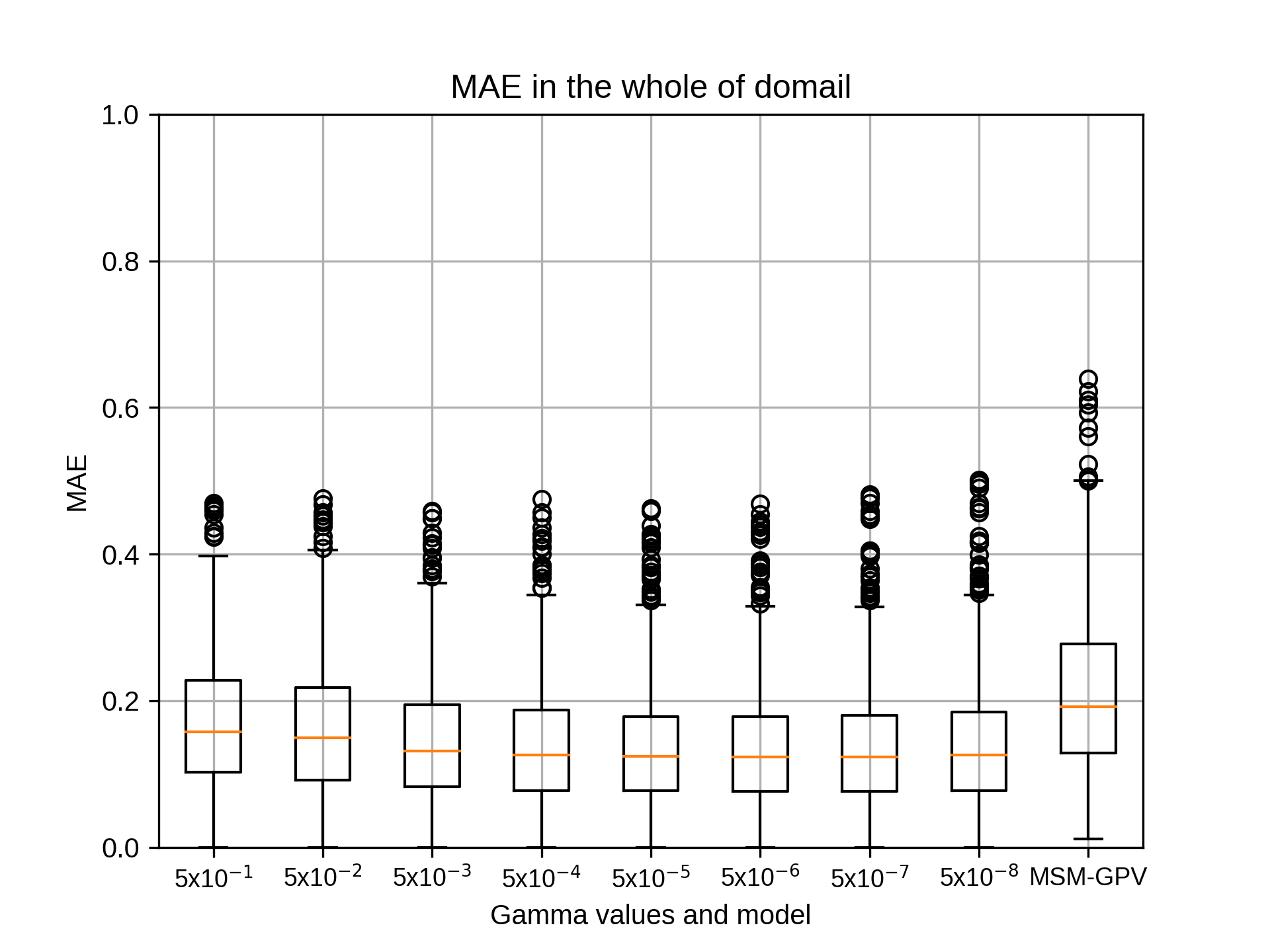

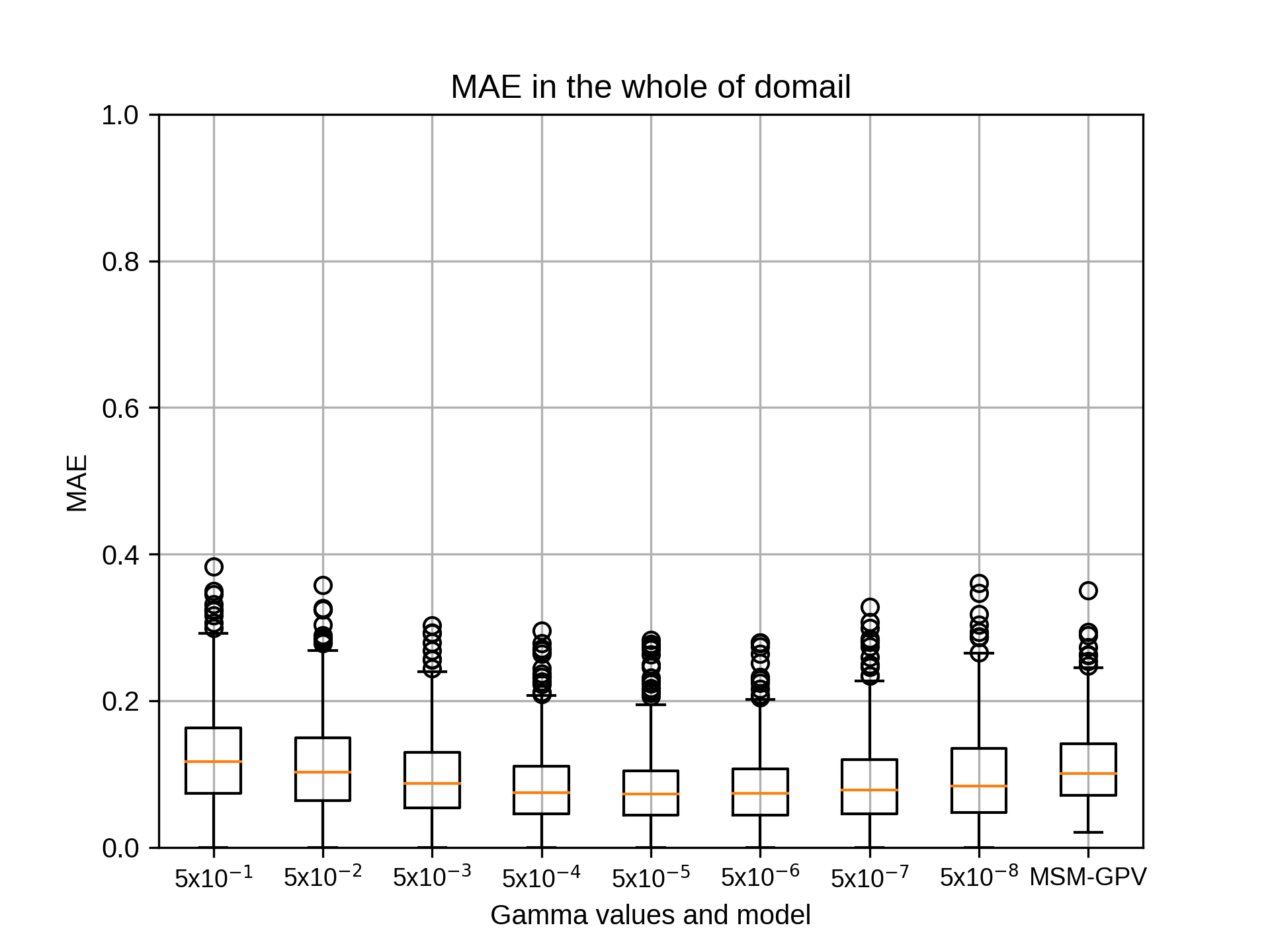

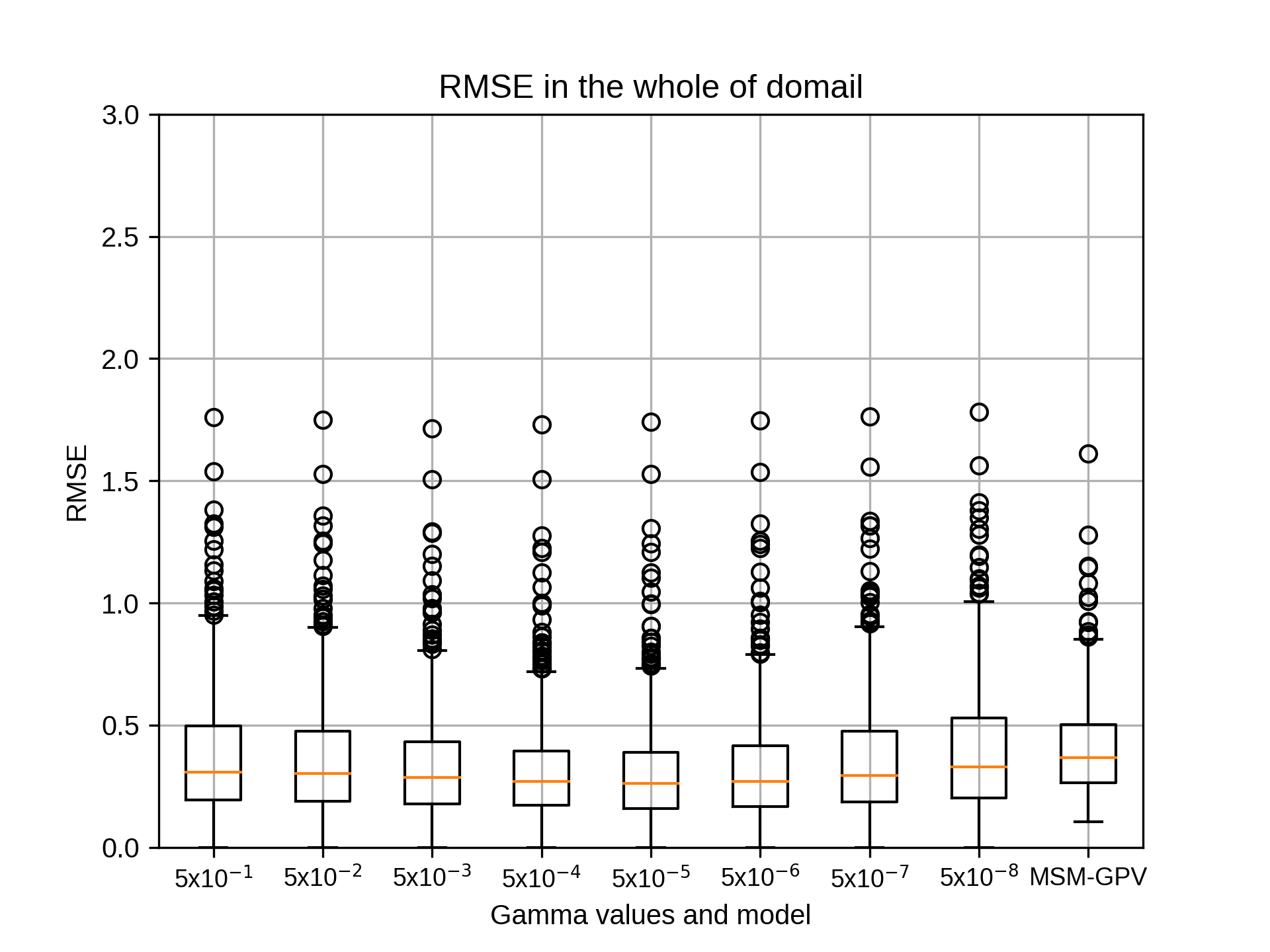

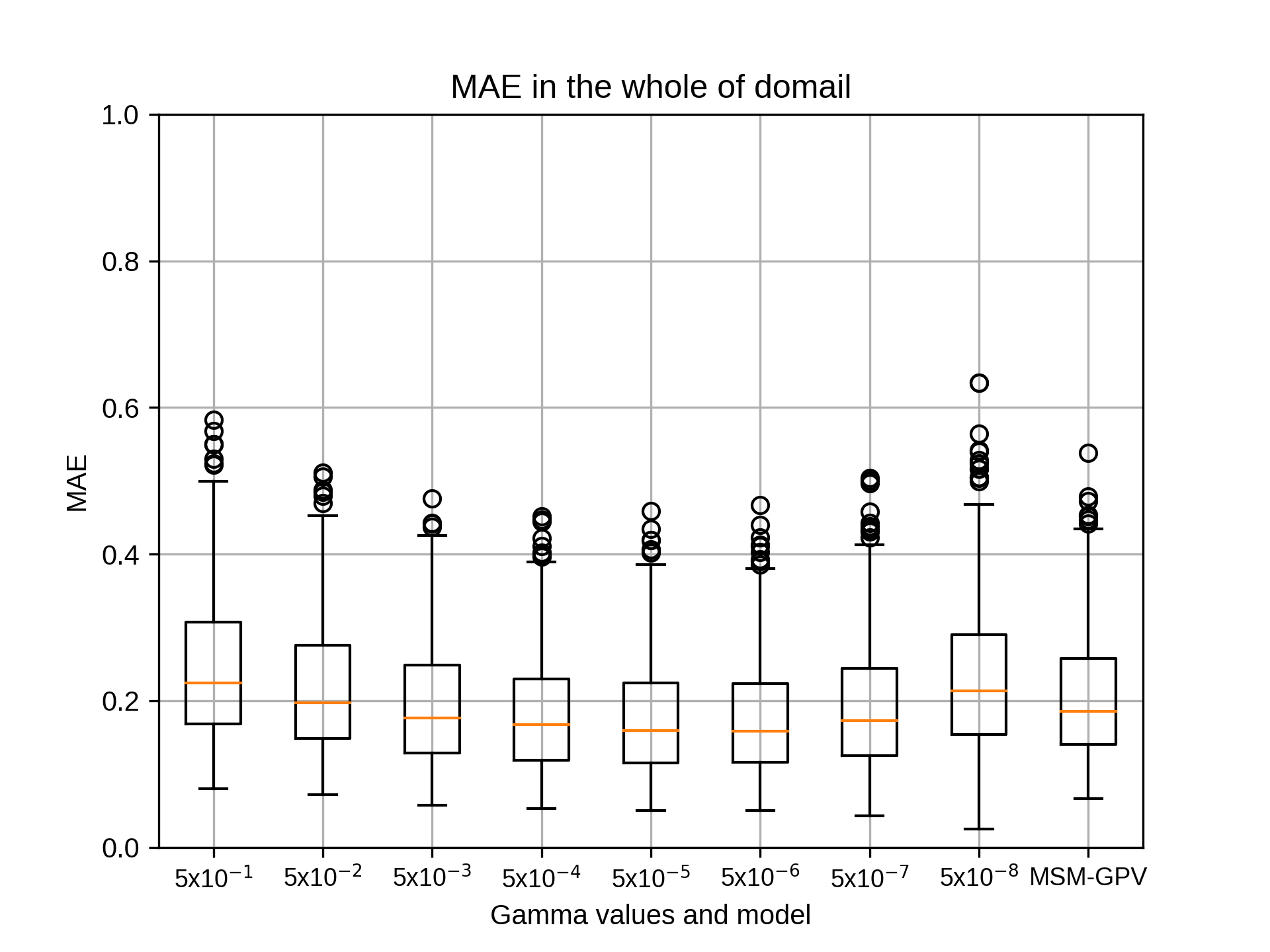

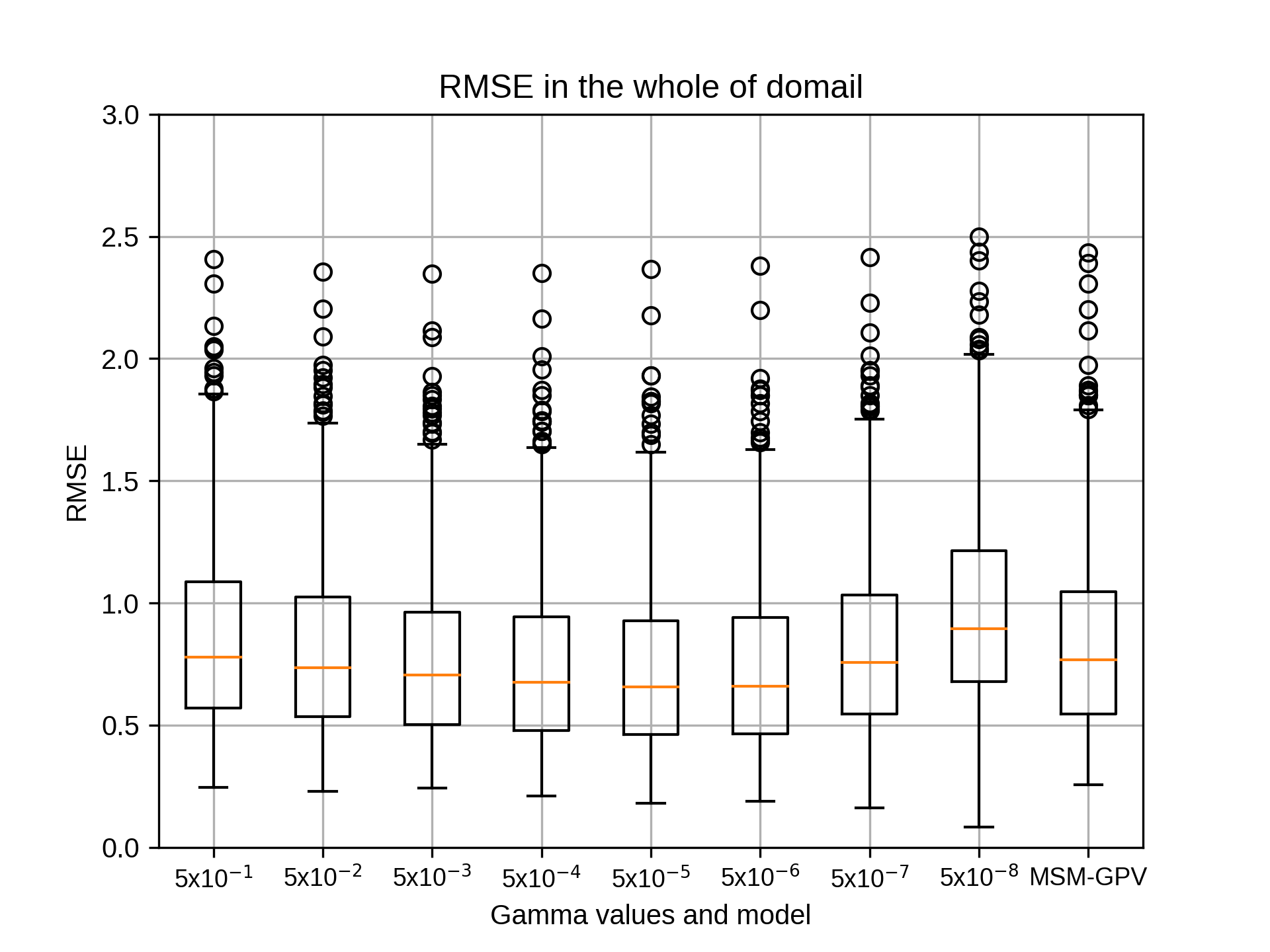

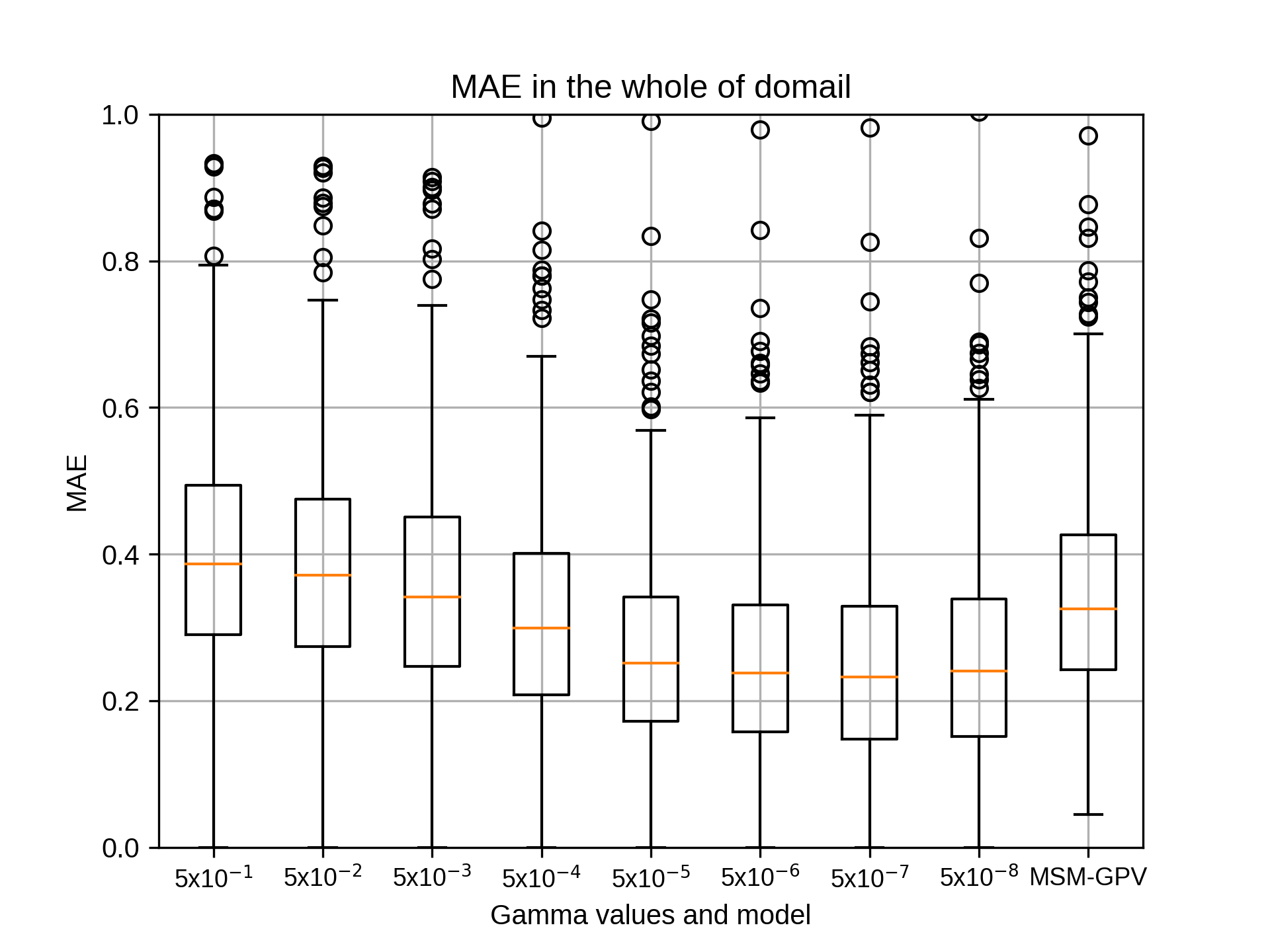

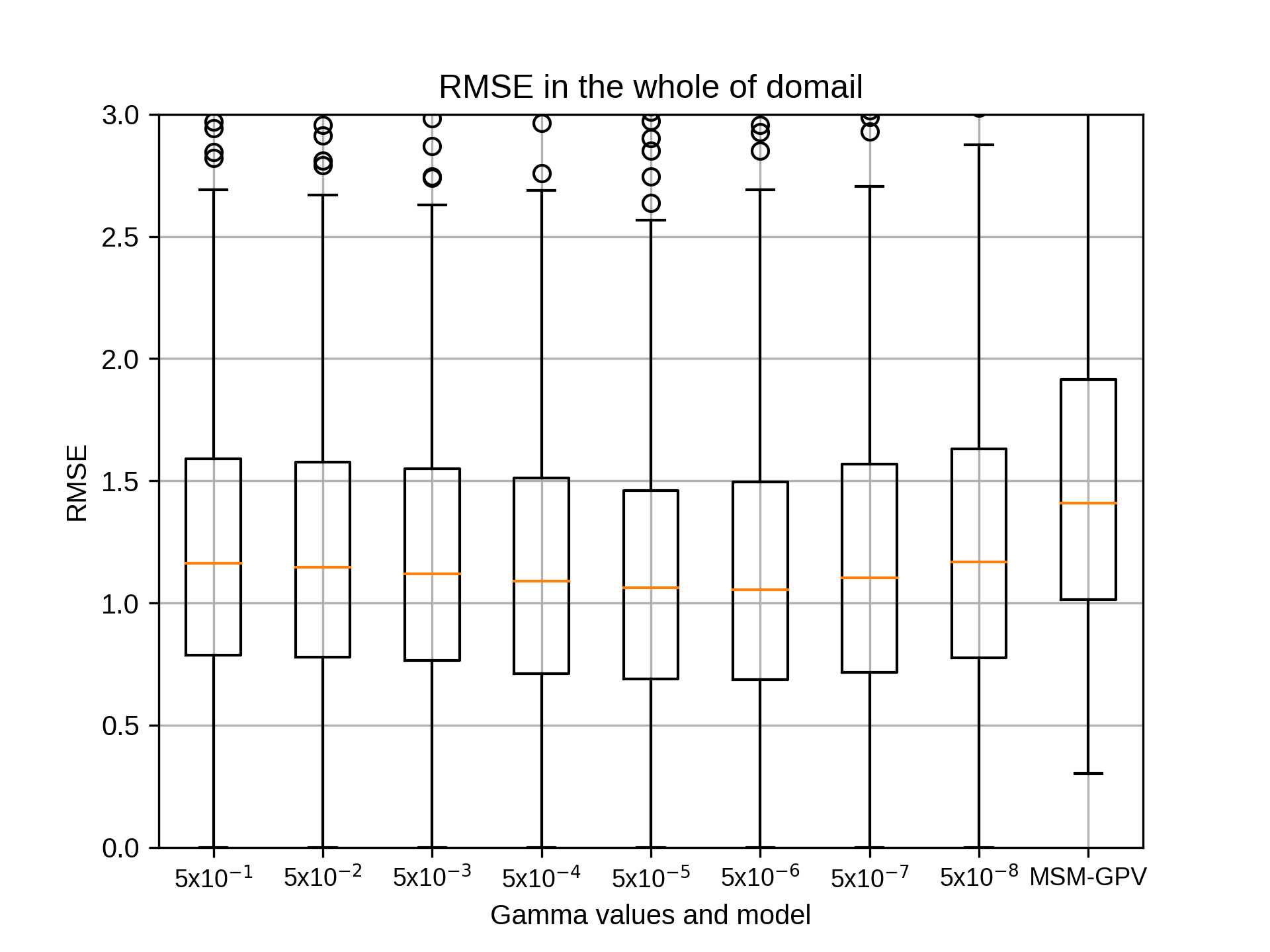

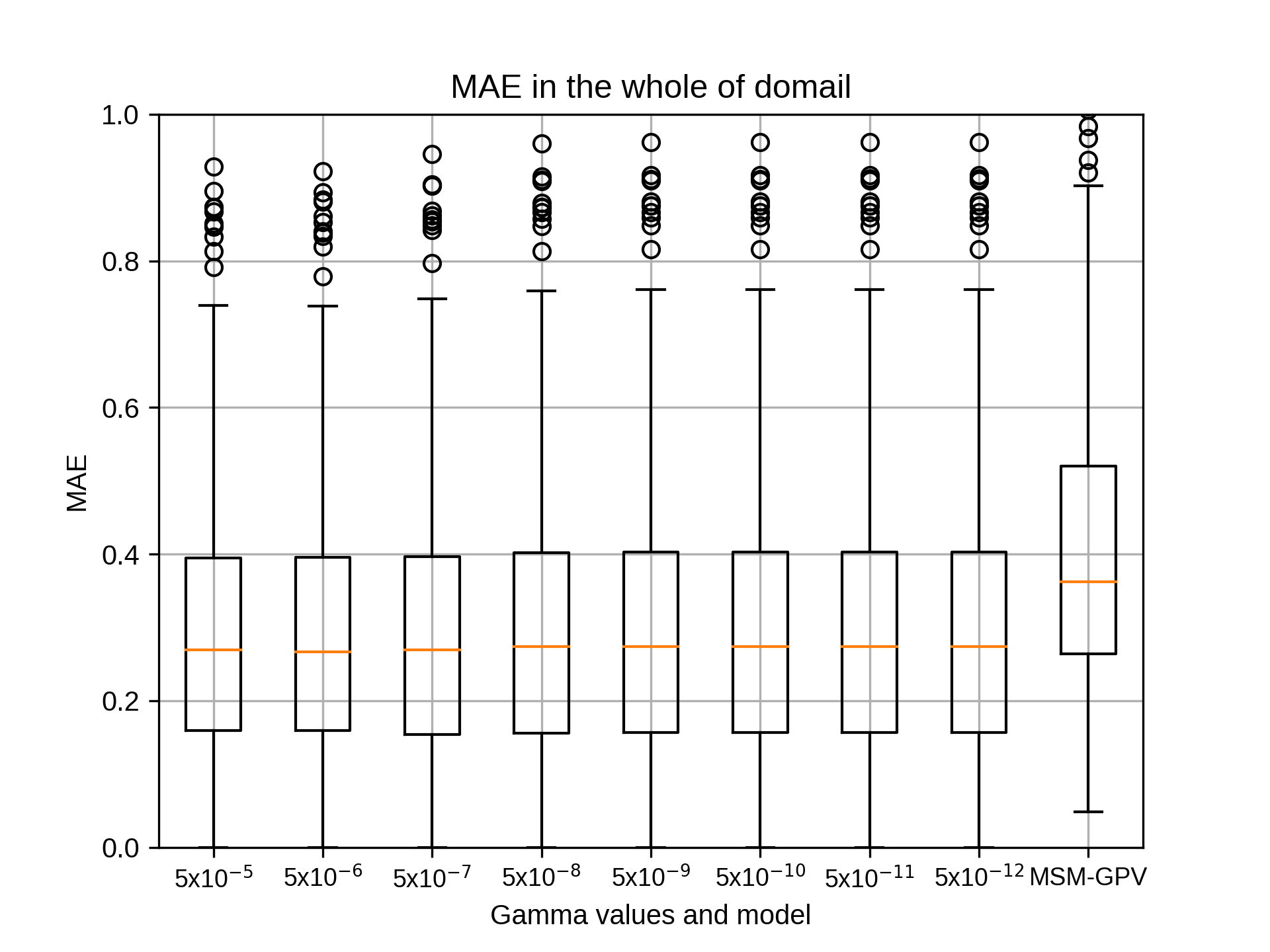

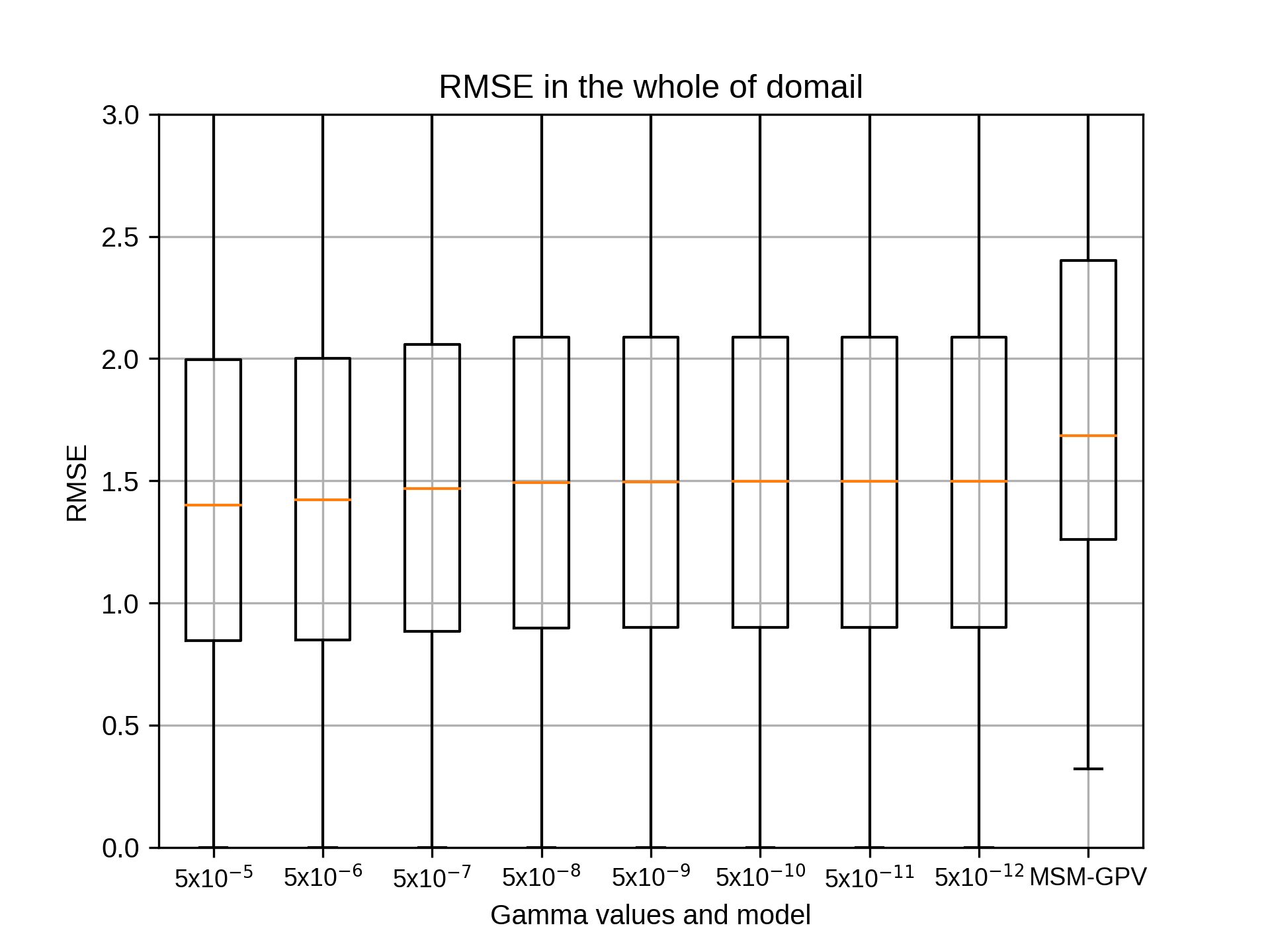

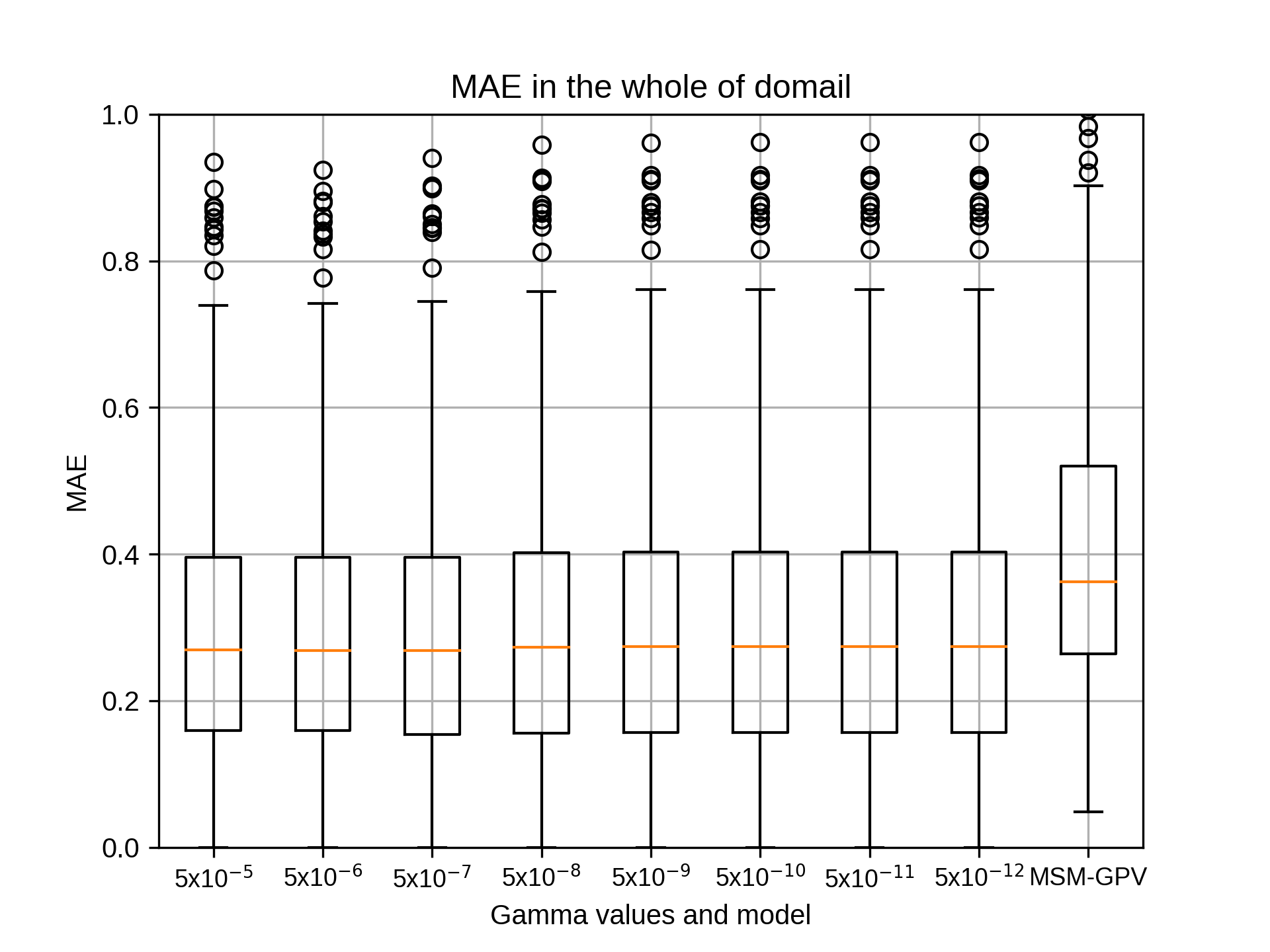

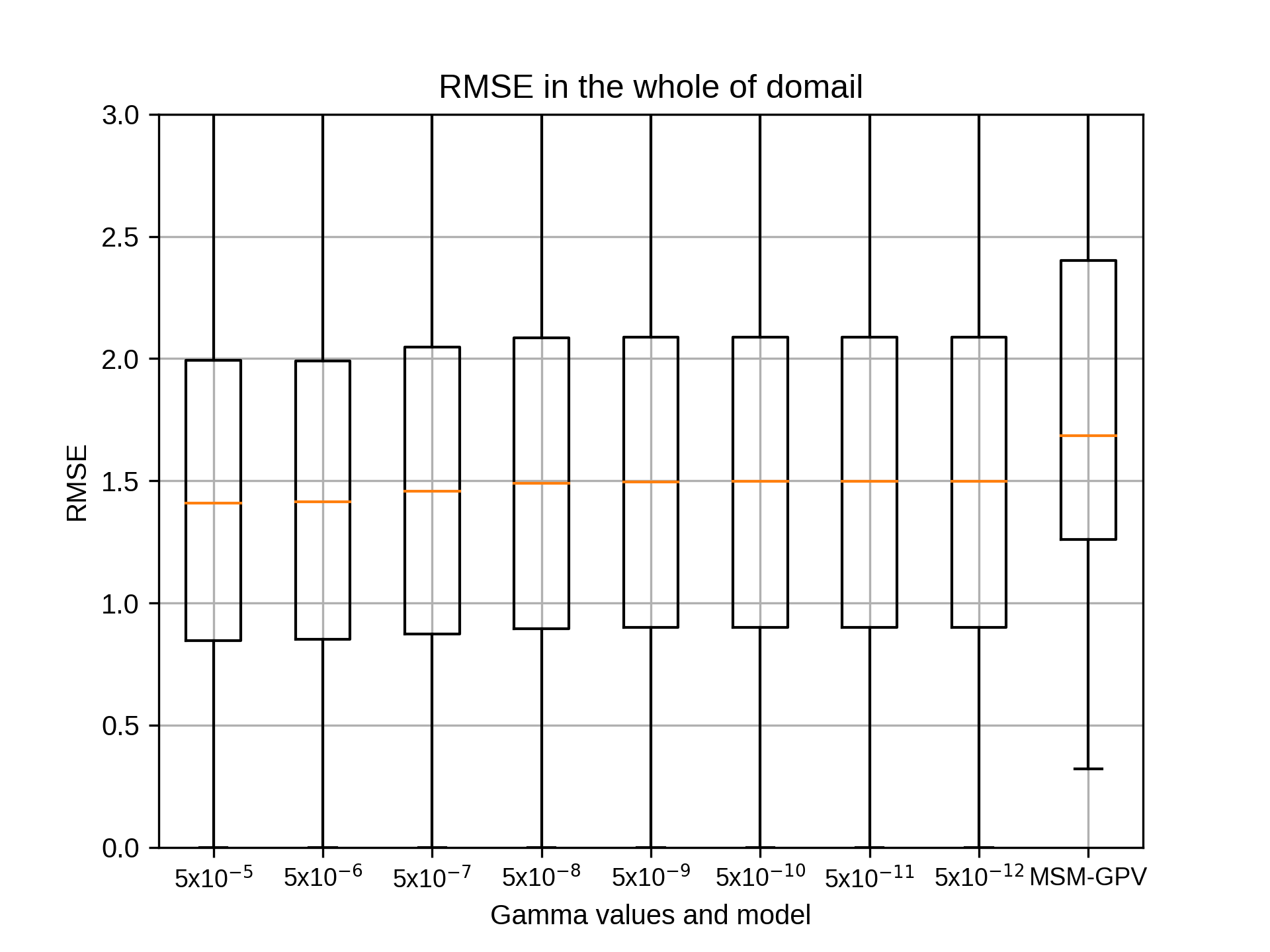

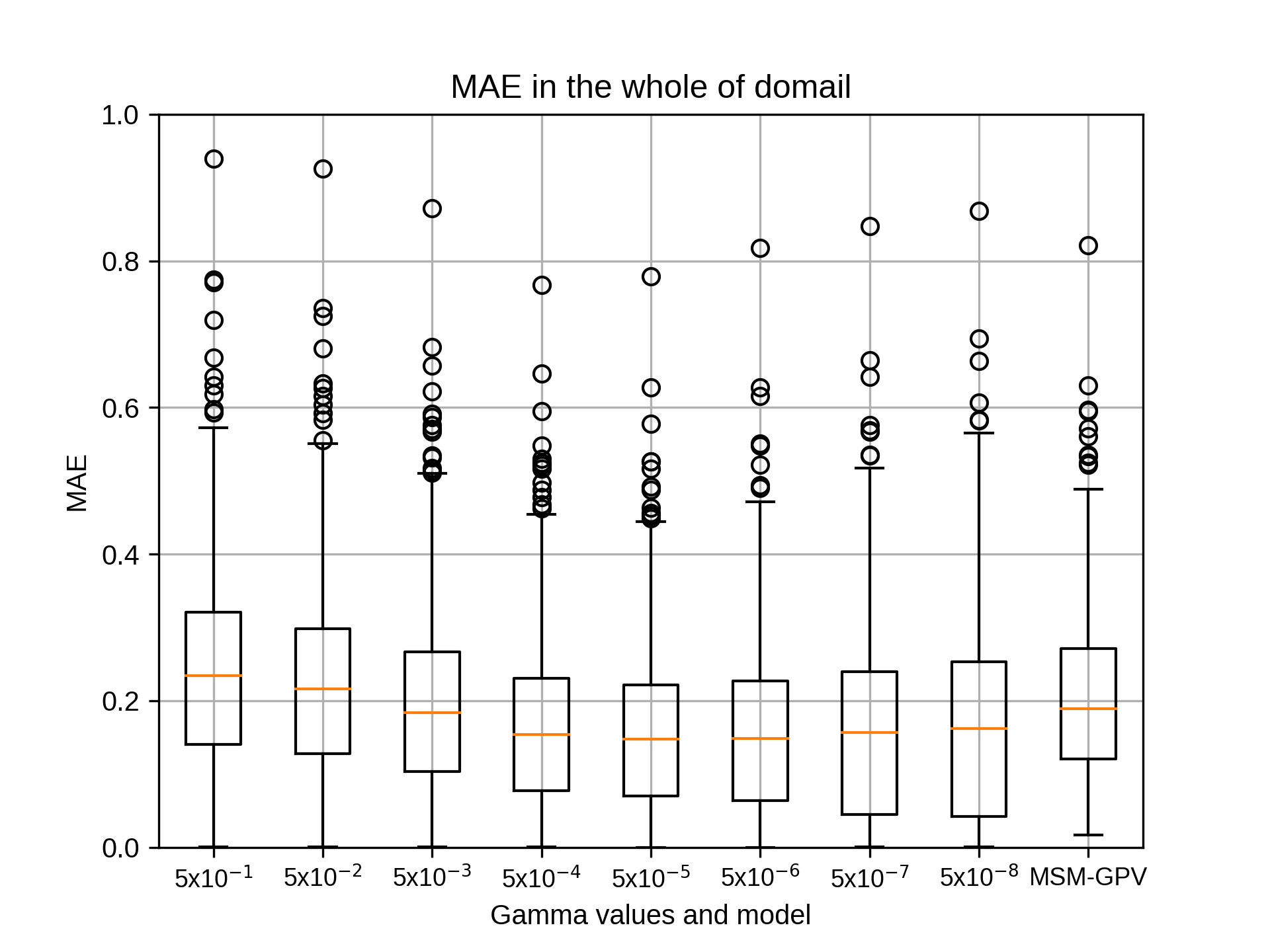

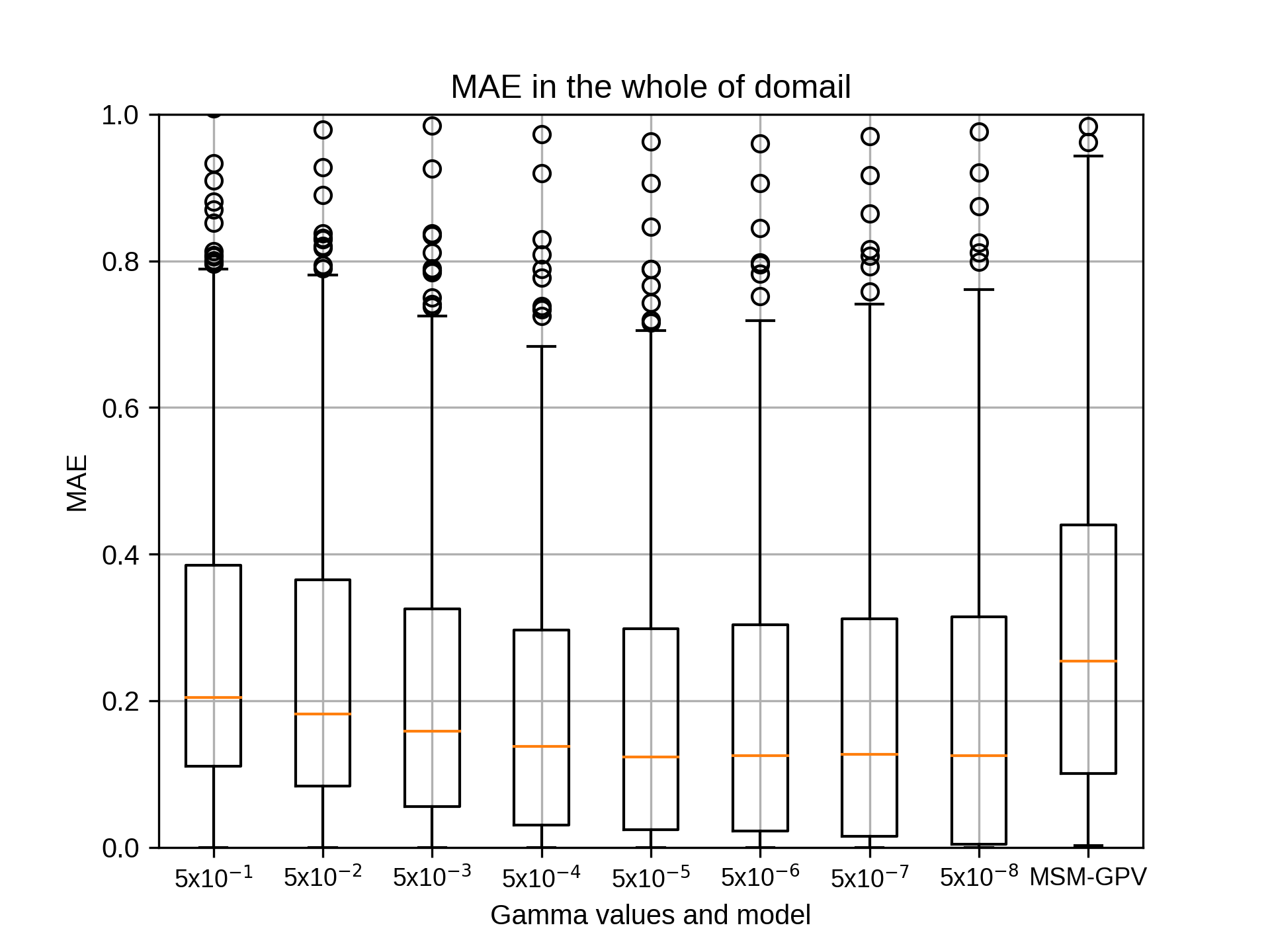

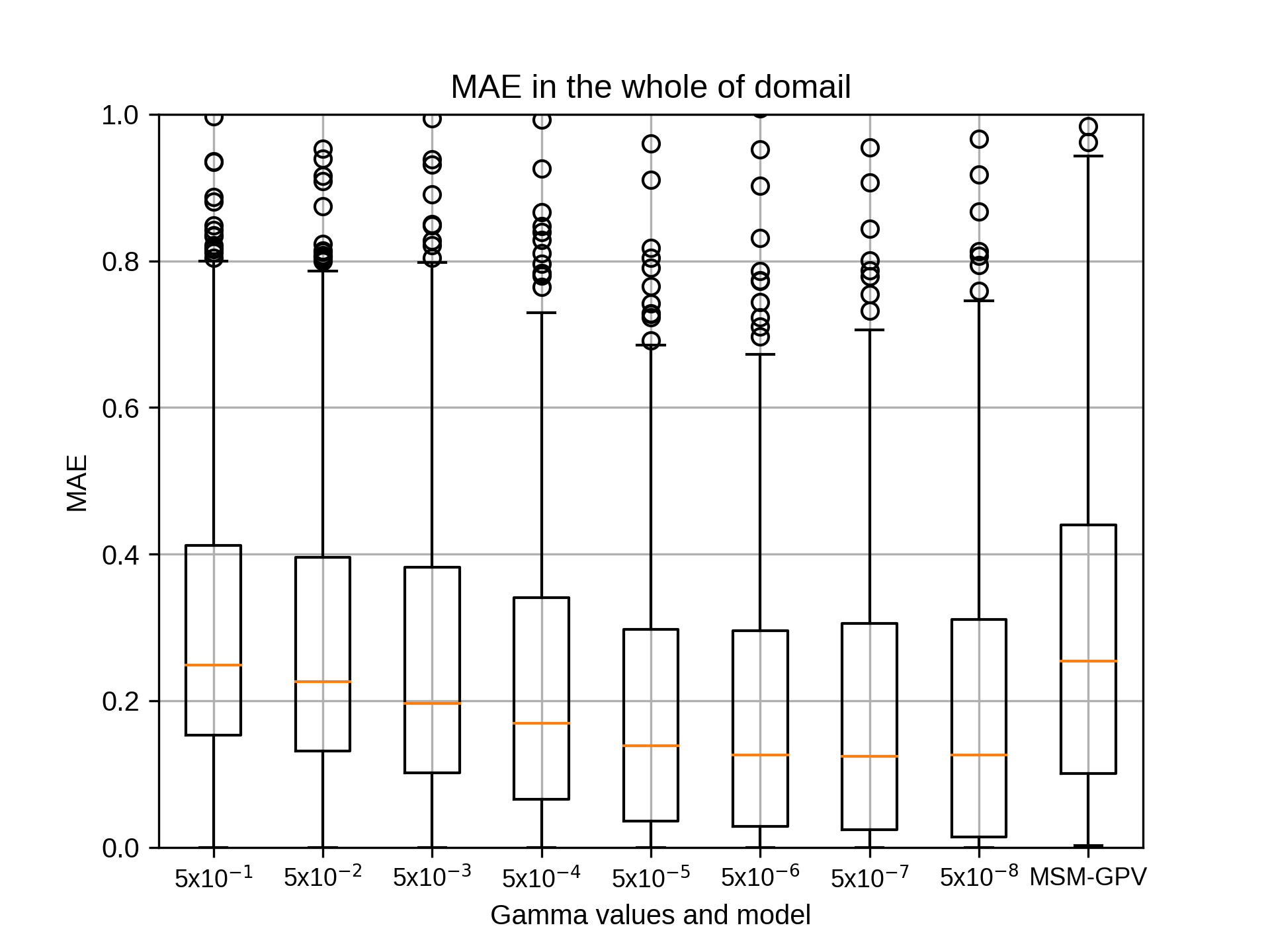

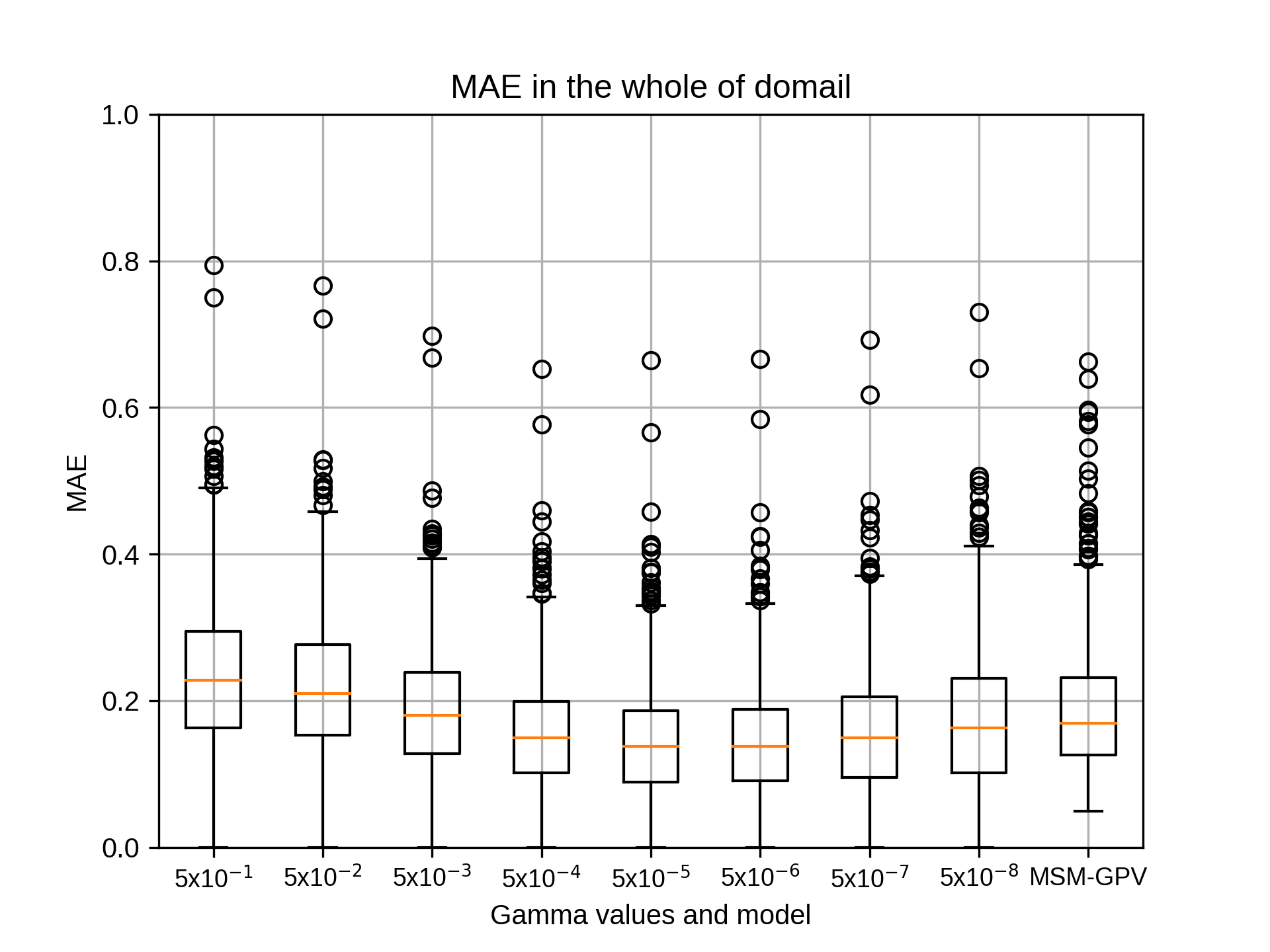

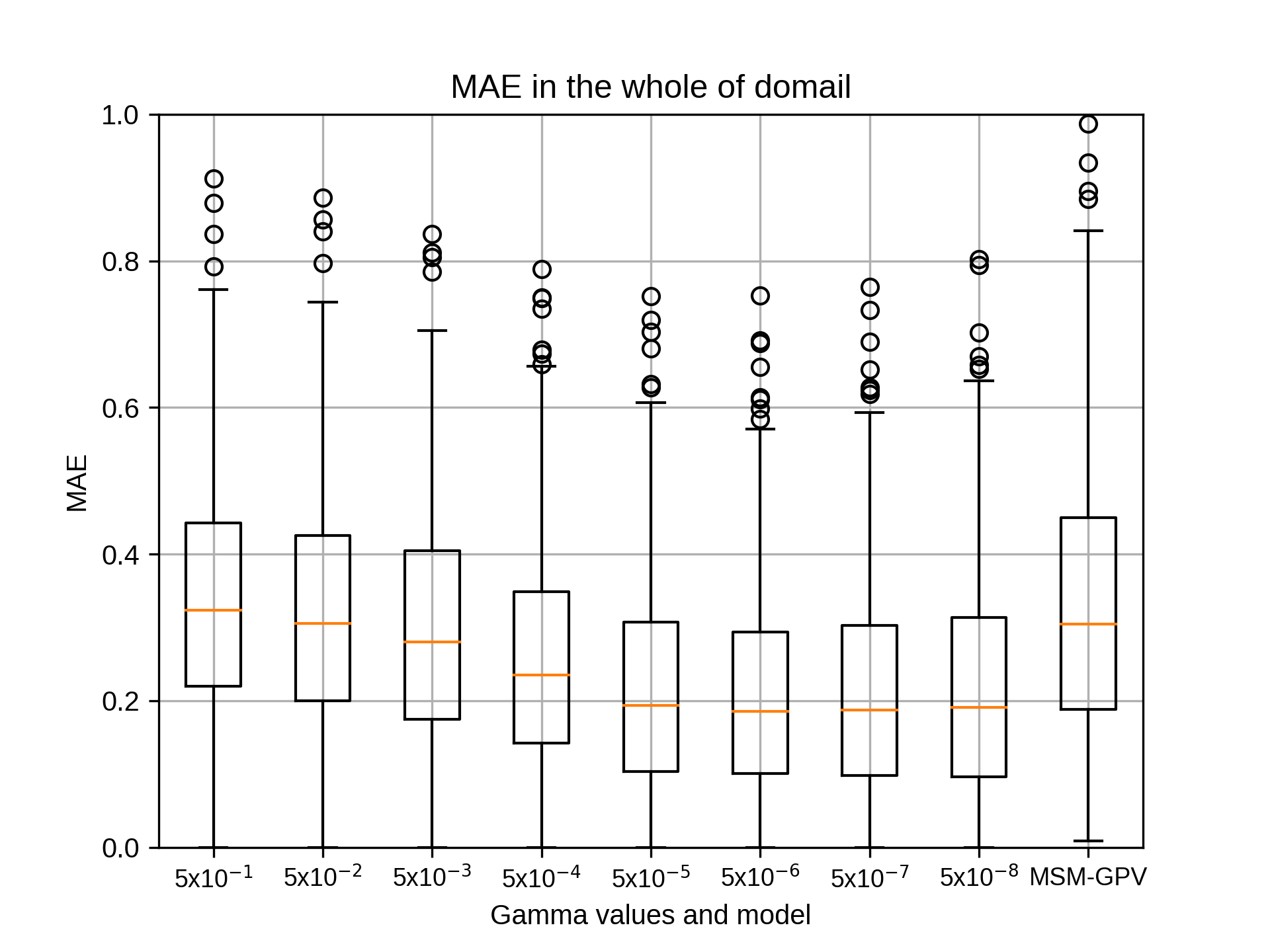

7月のsiteA~siteEのコストの結果が出ました。

コストは、どのパラメータも大きな差はございませんでした。

引き続き、コストの相関係数の中央値が最も大きいものを採用し、エプシロンを行います。

コストの結果は以下の通りです。(siteごとに1つずつ書き込みます)

吉兼先生

7月のsiteA~siteEのコストの結果が出ました。

コストは、どのパラメータも大きな差はございませんでした。

引き続き、コストの相関係数の中央値が最も大きいものを採用し、エプシロンを行います。

コストの結果は以下の通りです。(siteごとに1つずつ書き込みます)

takao-yFriday, September 11th, 2020 at 7:53:54 PM GMT+09:00

@kobayashi_yusuke

小林様。ありがとうございます。epsilonについてもお願いいたします。

小林様。ありがとうございます。epsilonについてもお願いいたします。

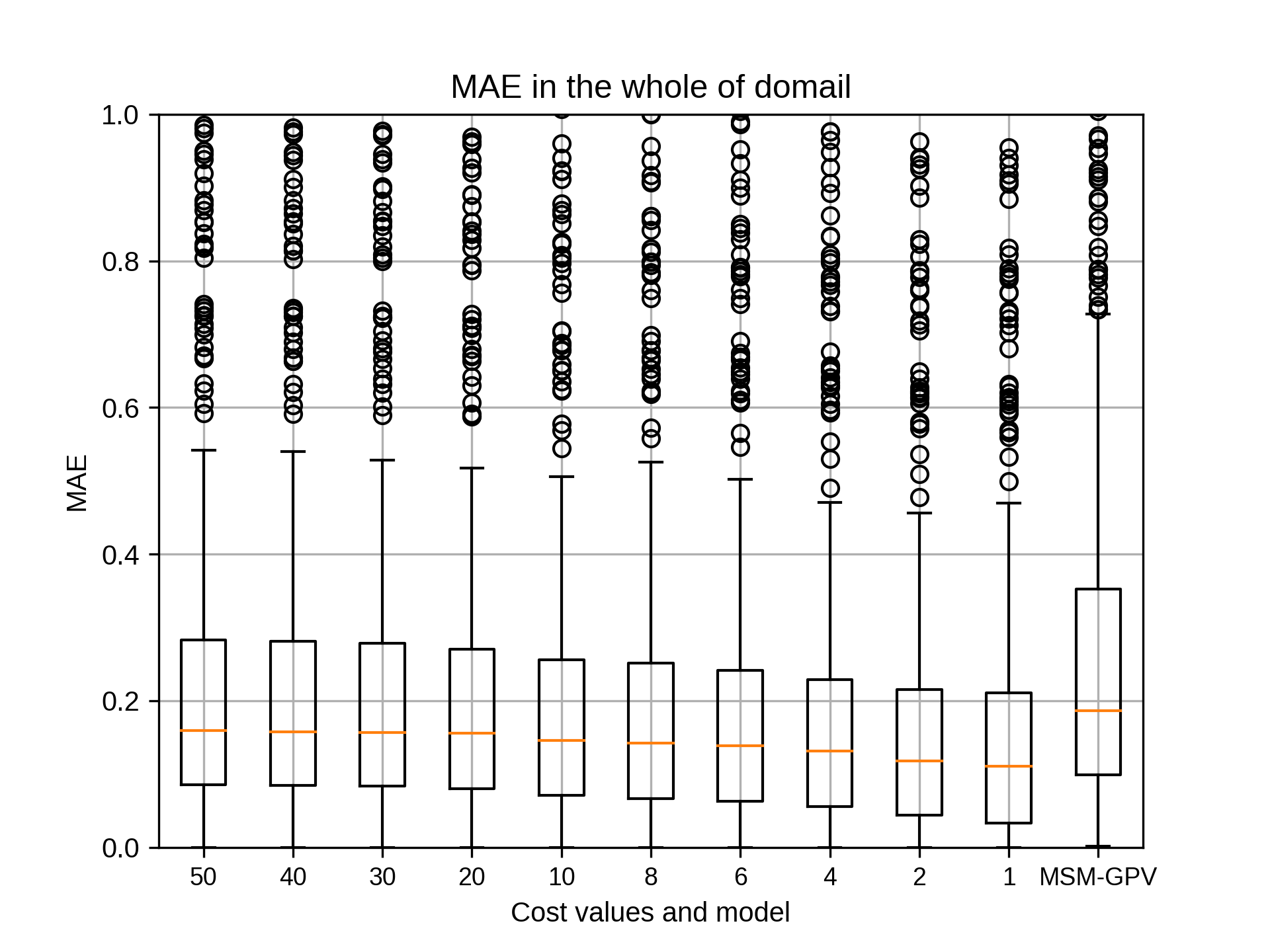

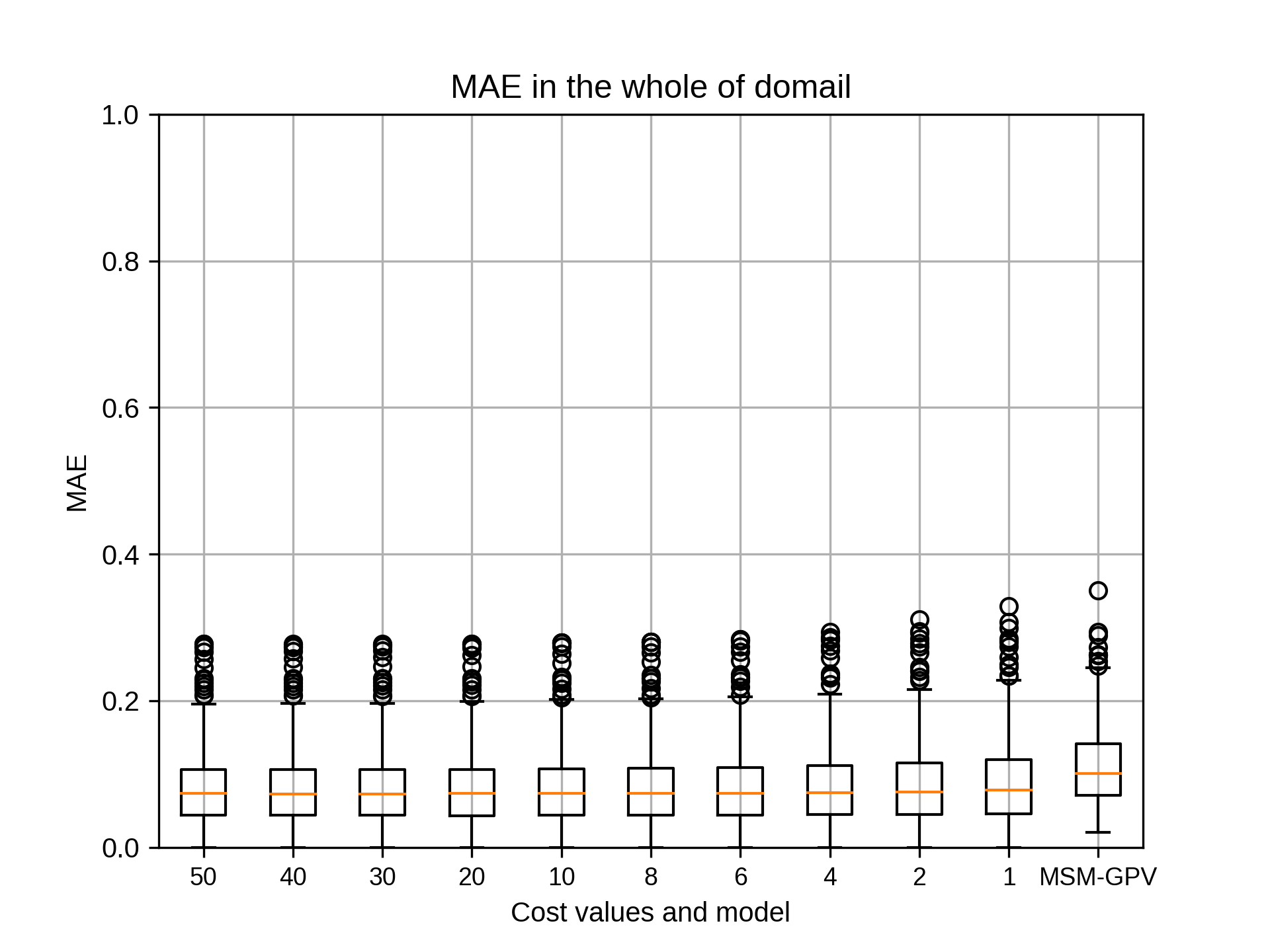

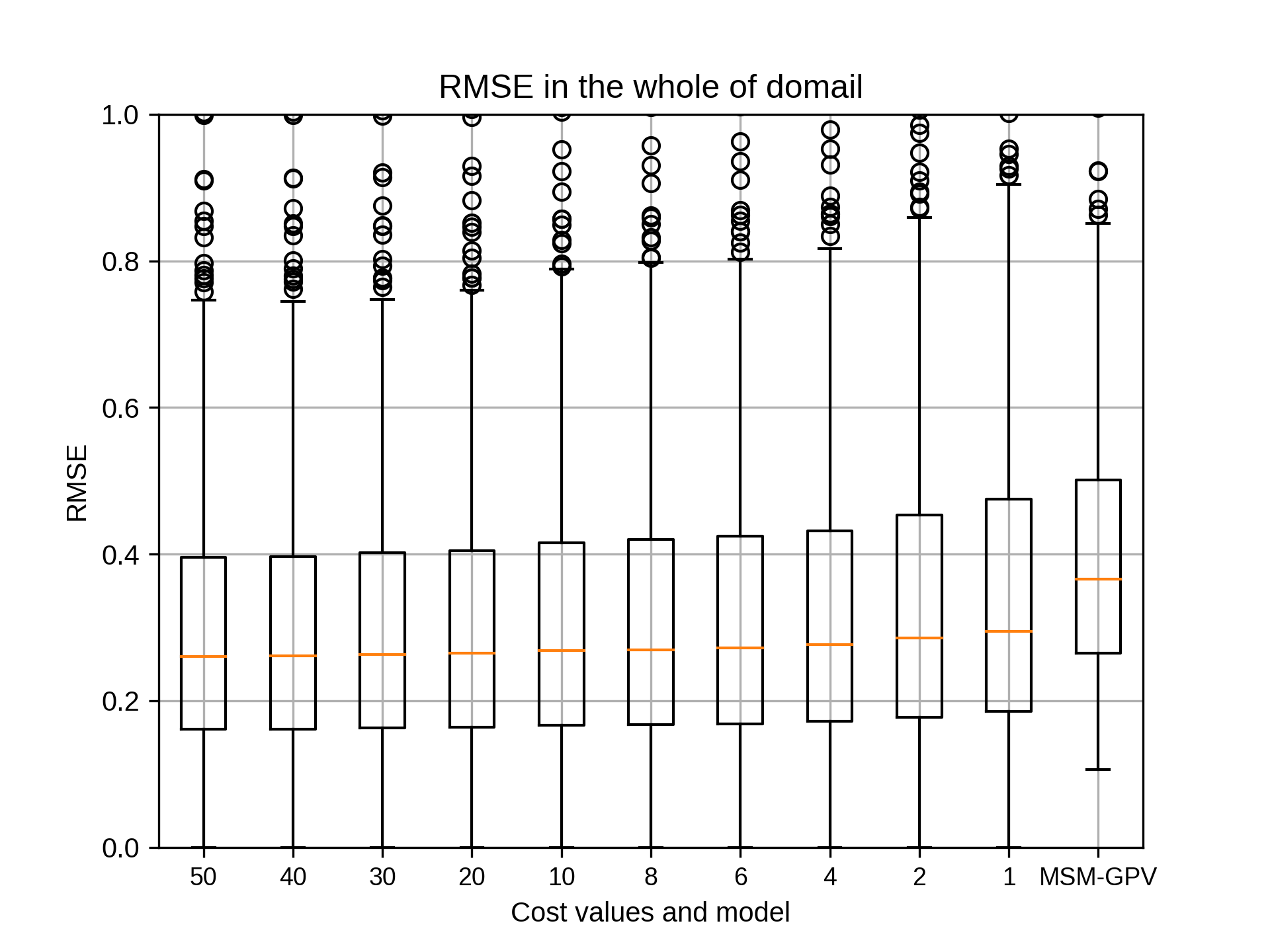

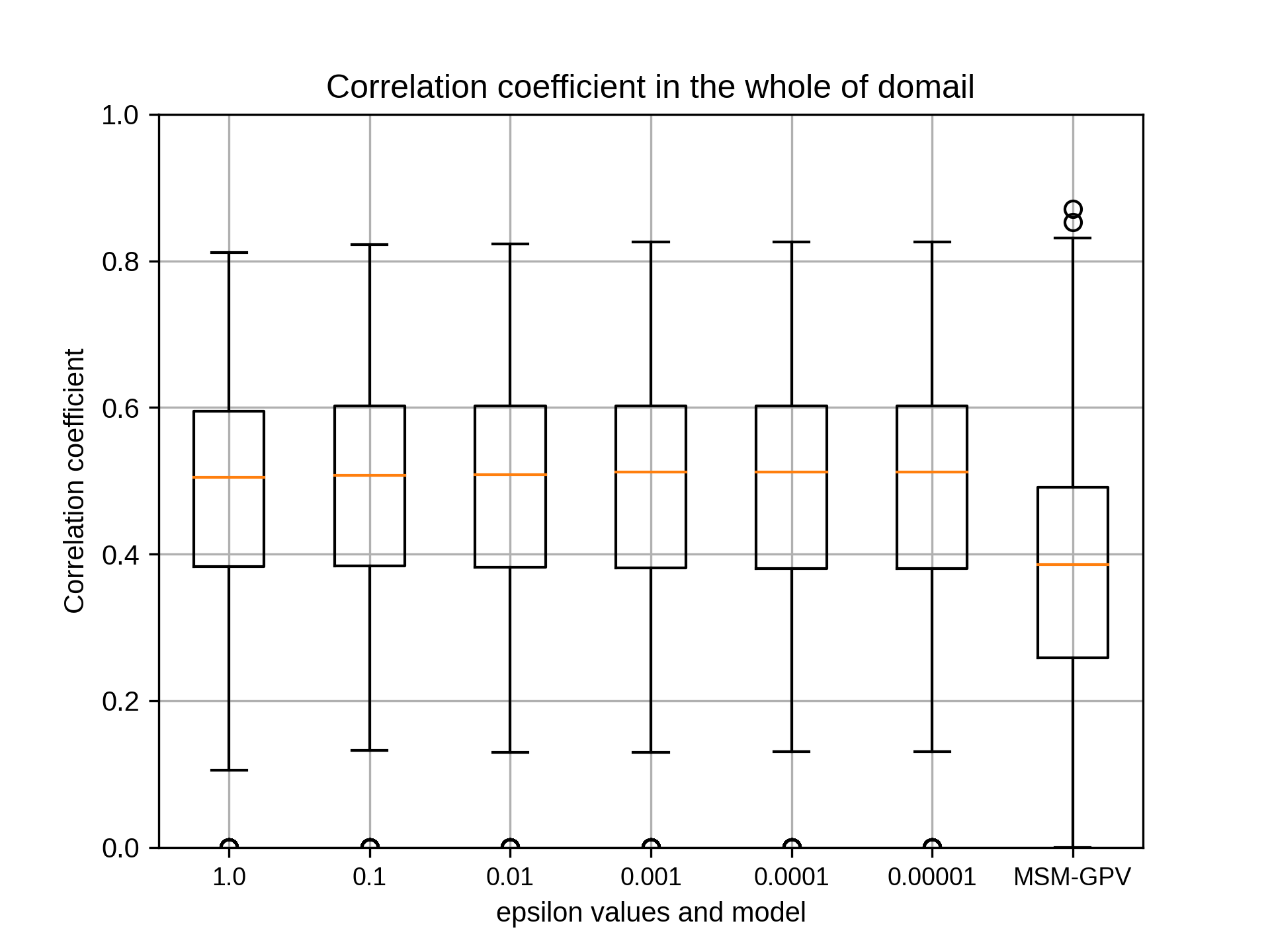

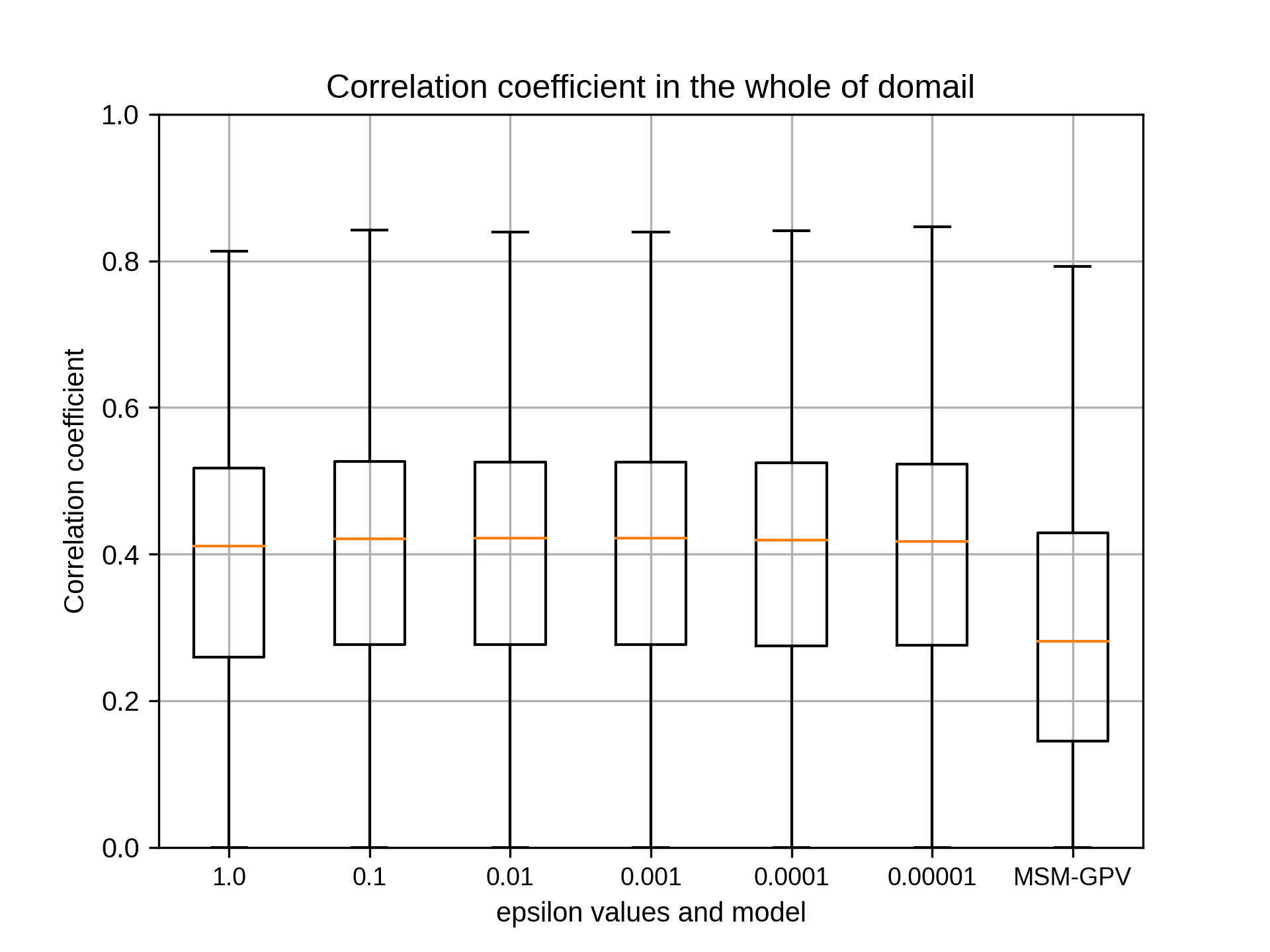

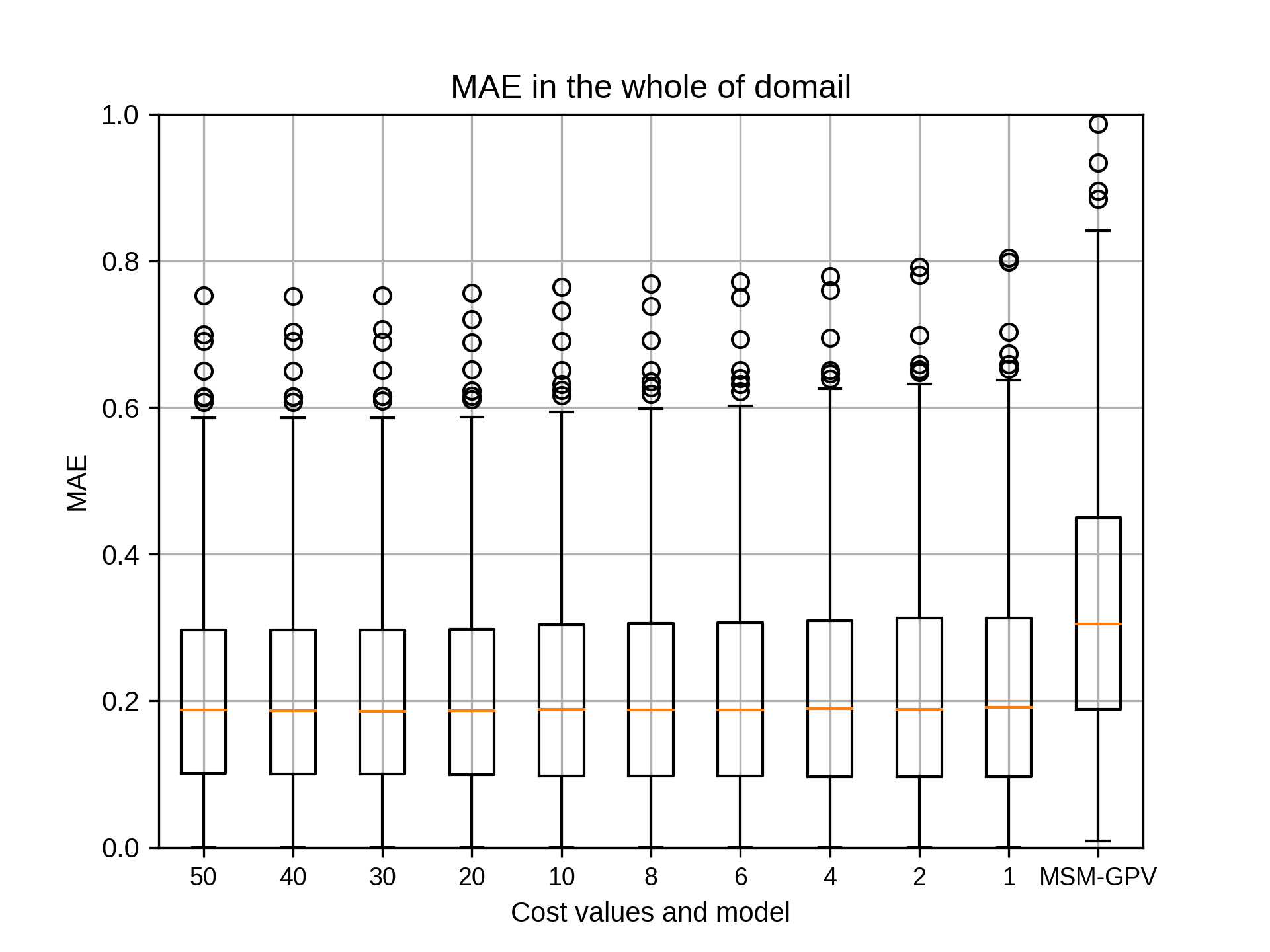

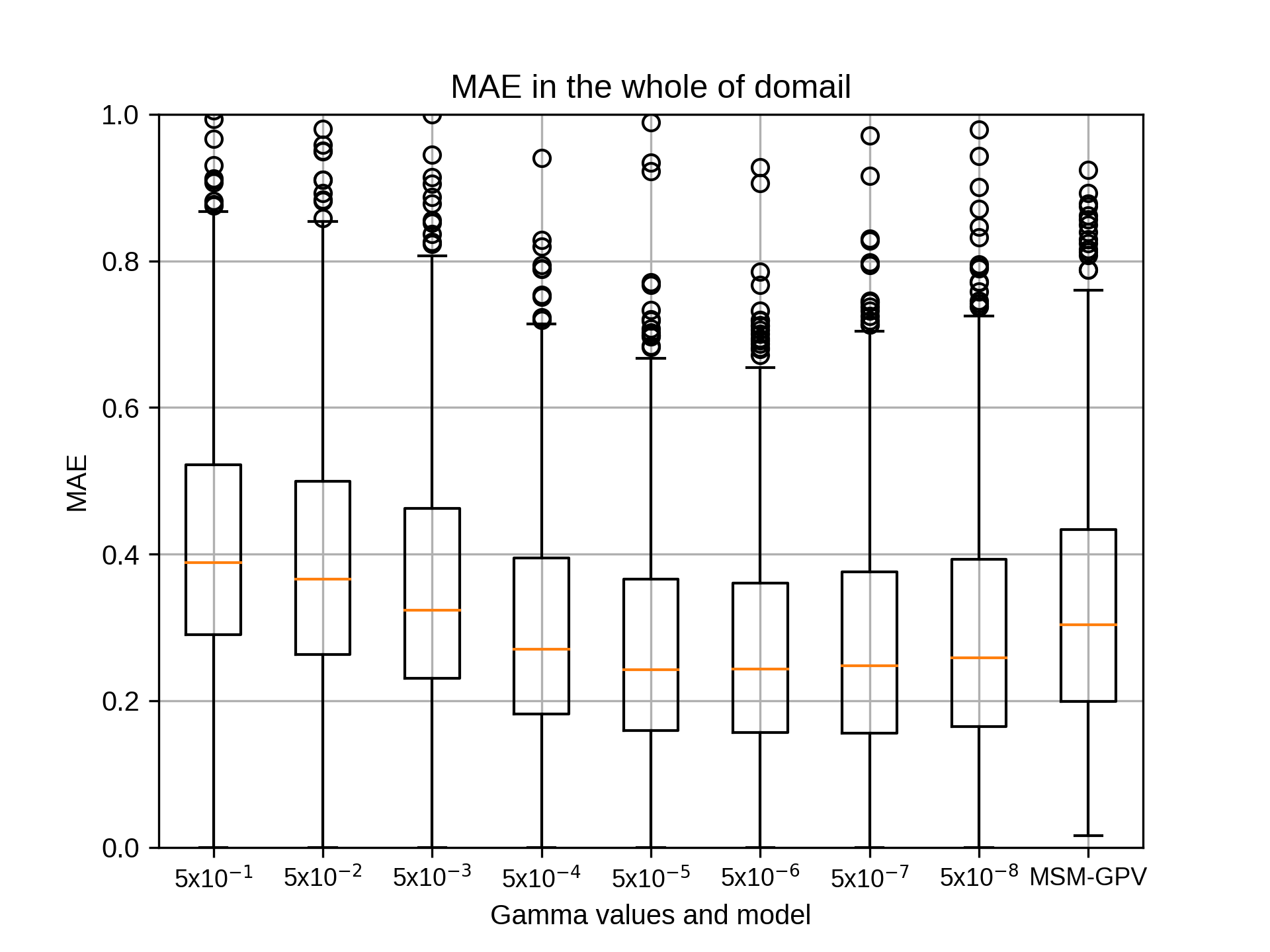

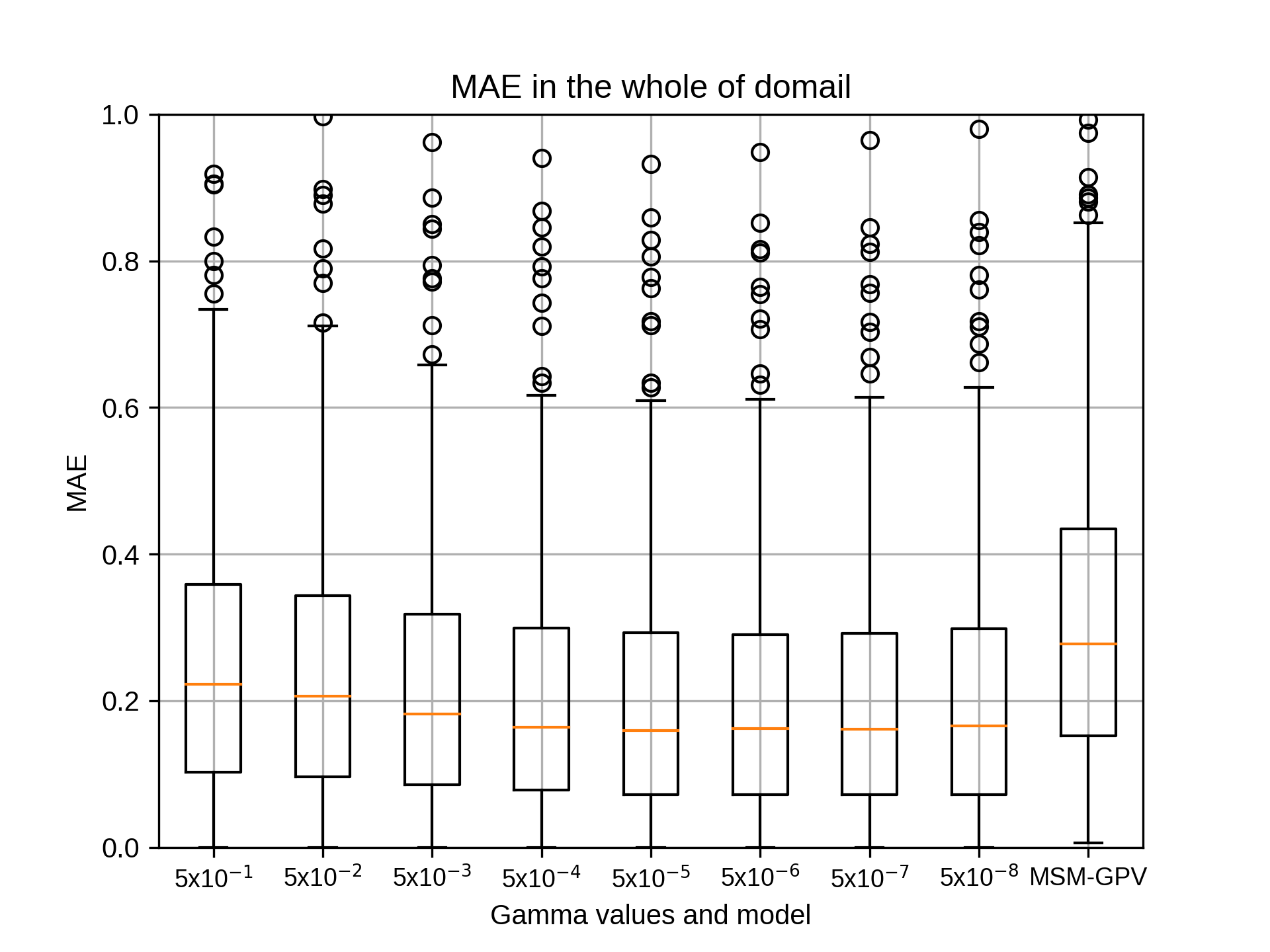

kobayashi_yusukeMonday, September 14th, 2020 at 2:59:38 PM GMT+09:00

@takao-y

吉兼先生

小林です。お世話になっております。

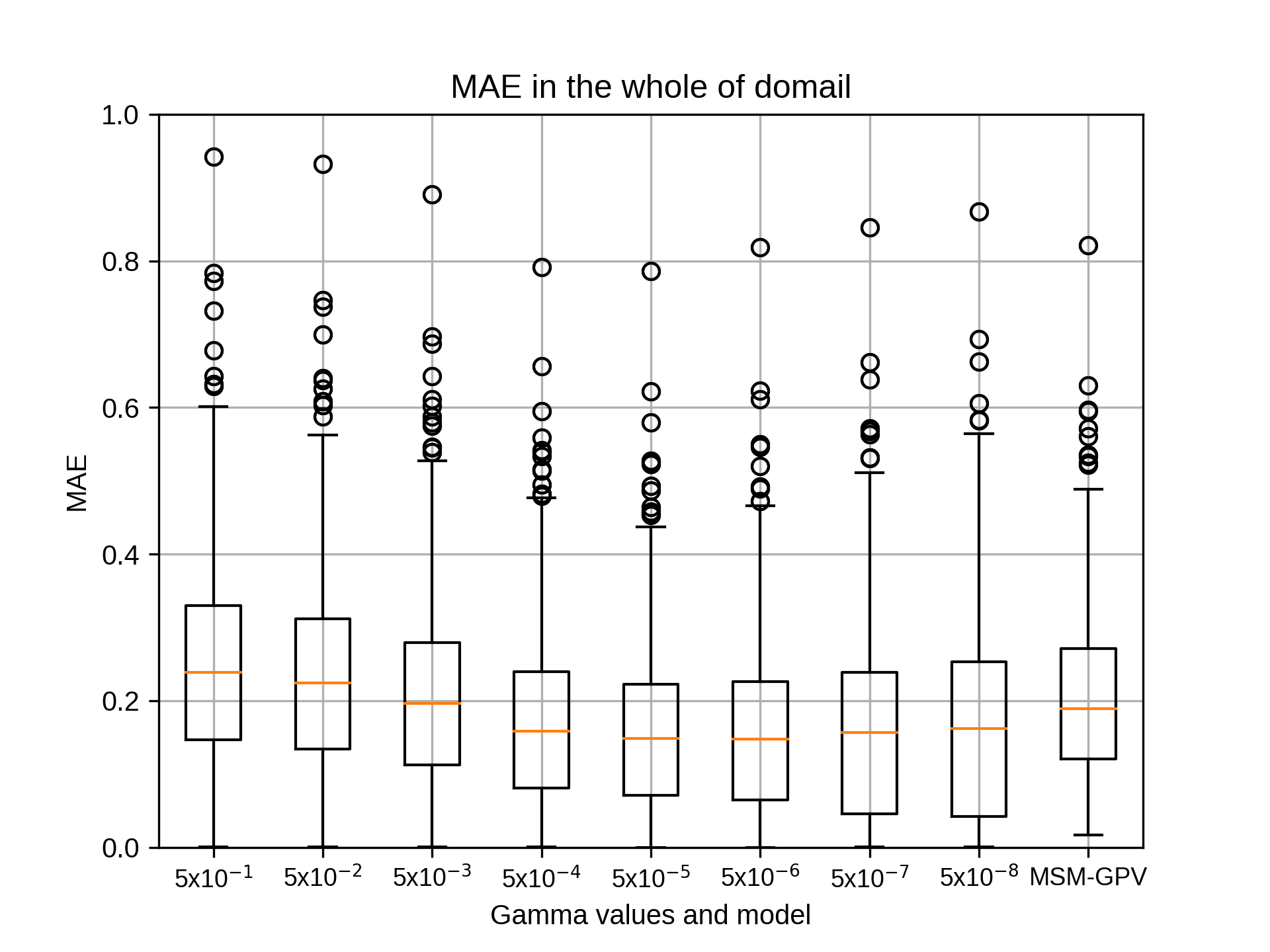

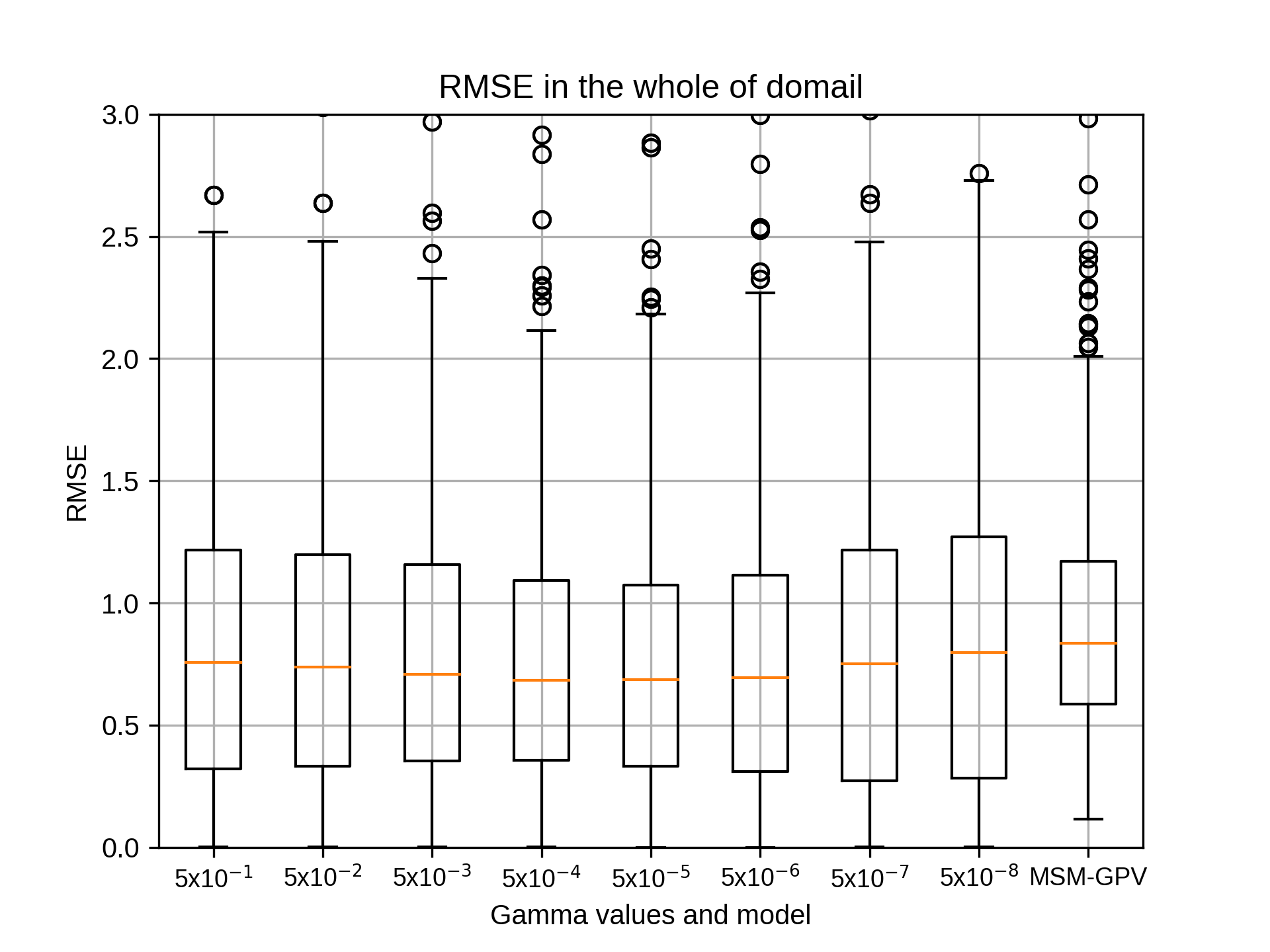

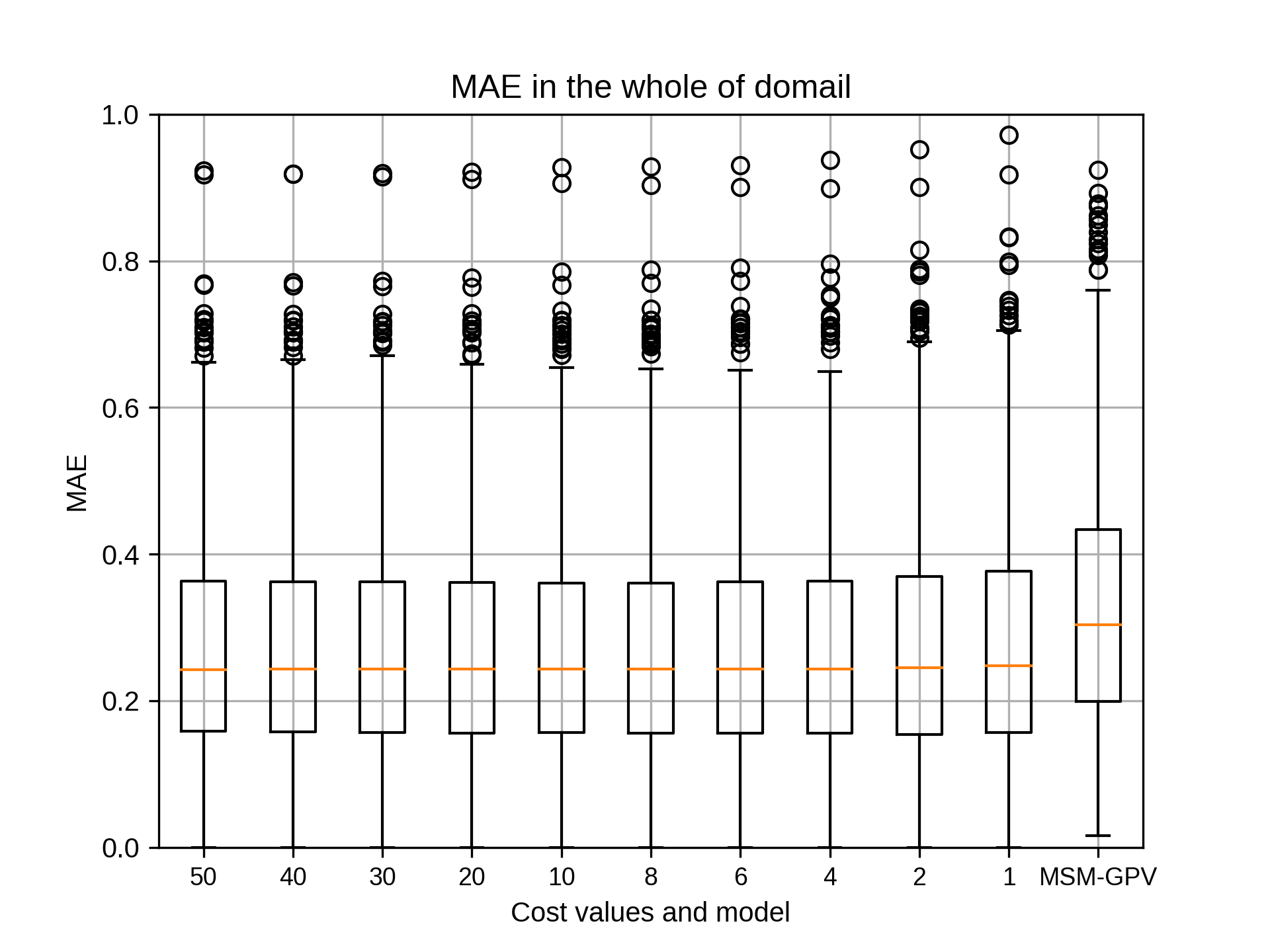

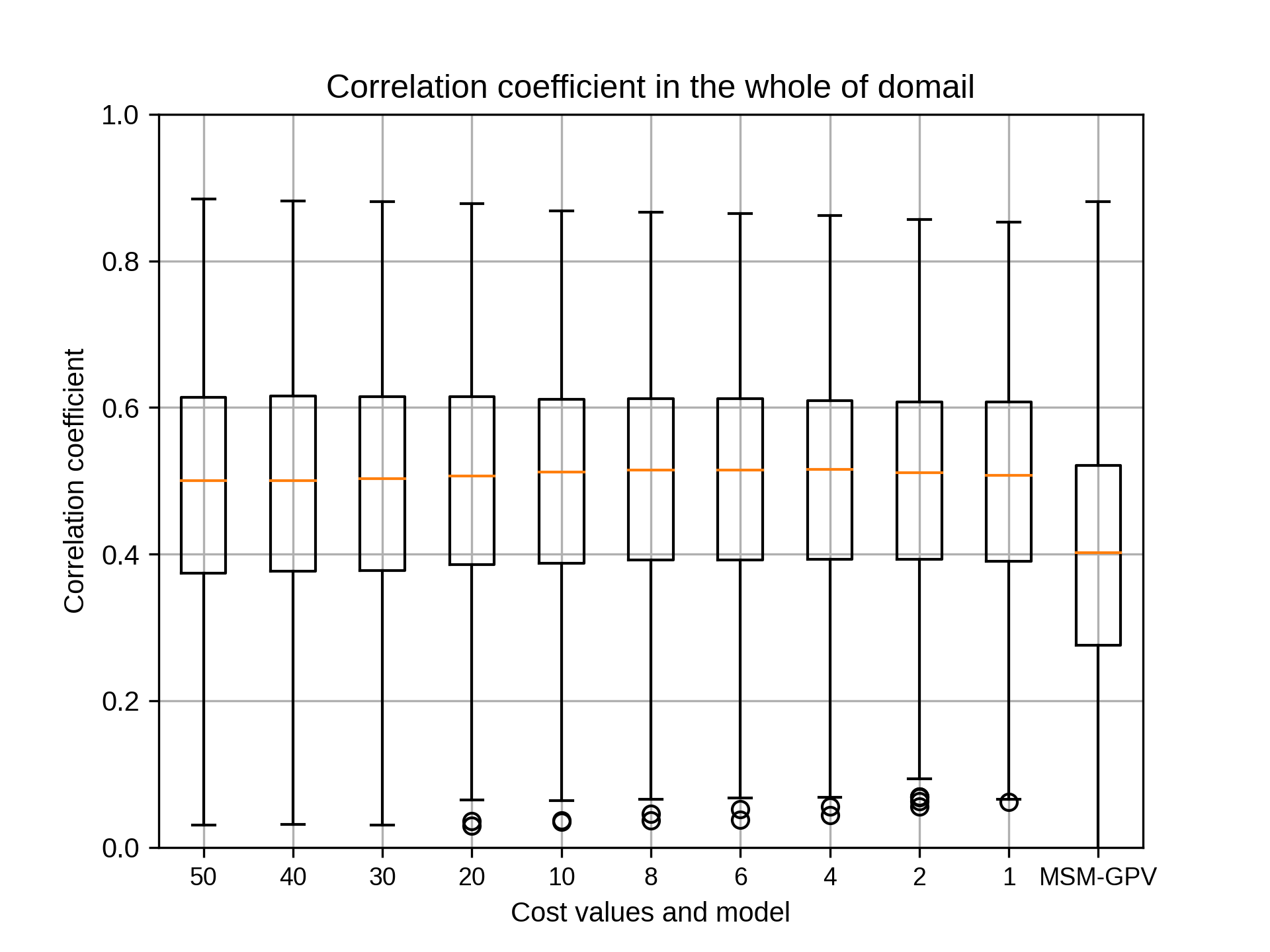

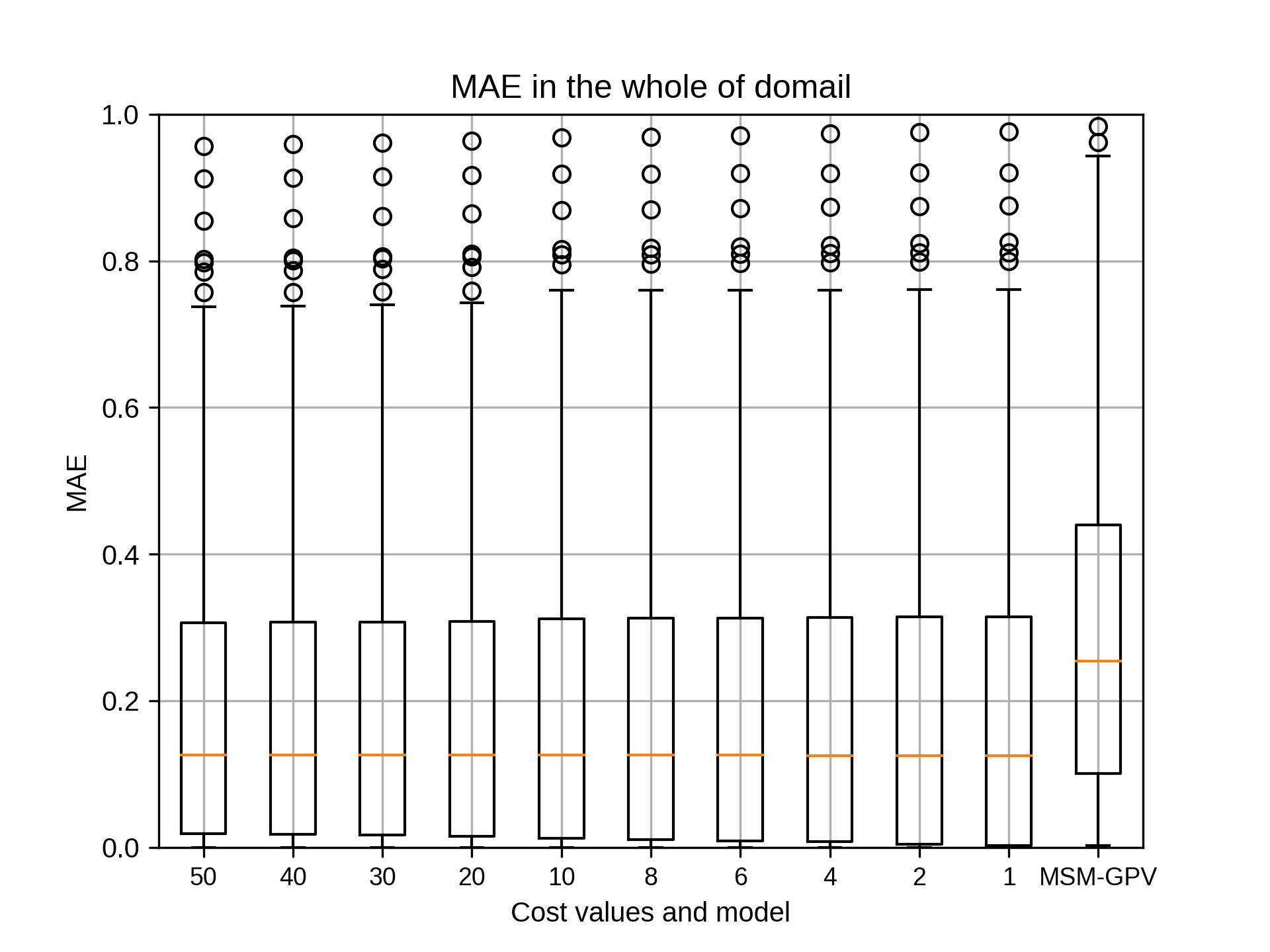

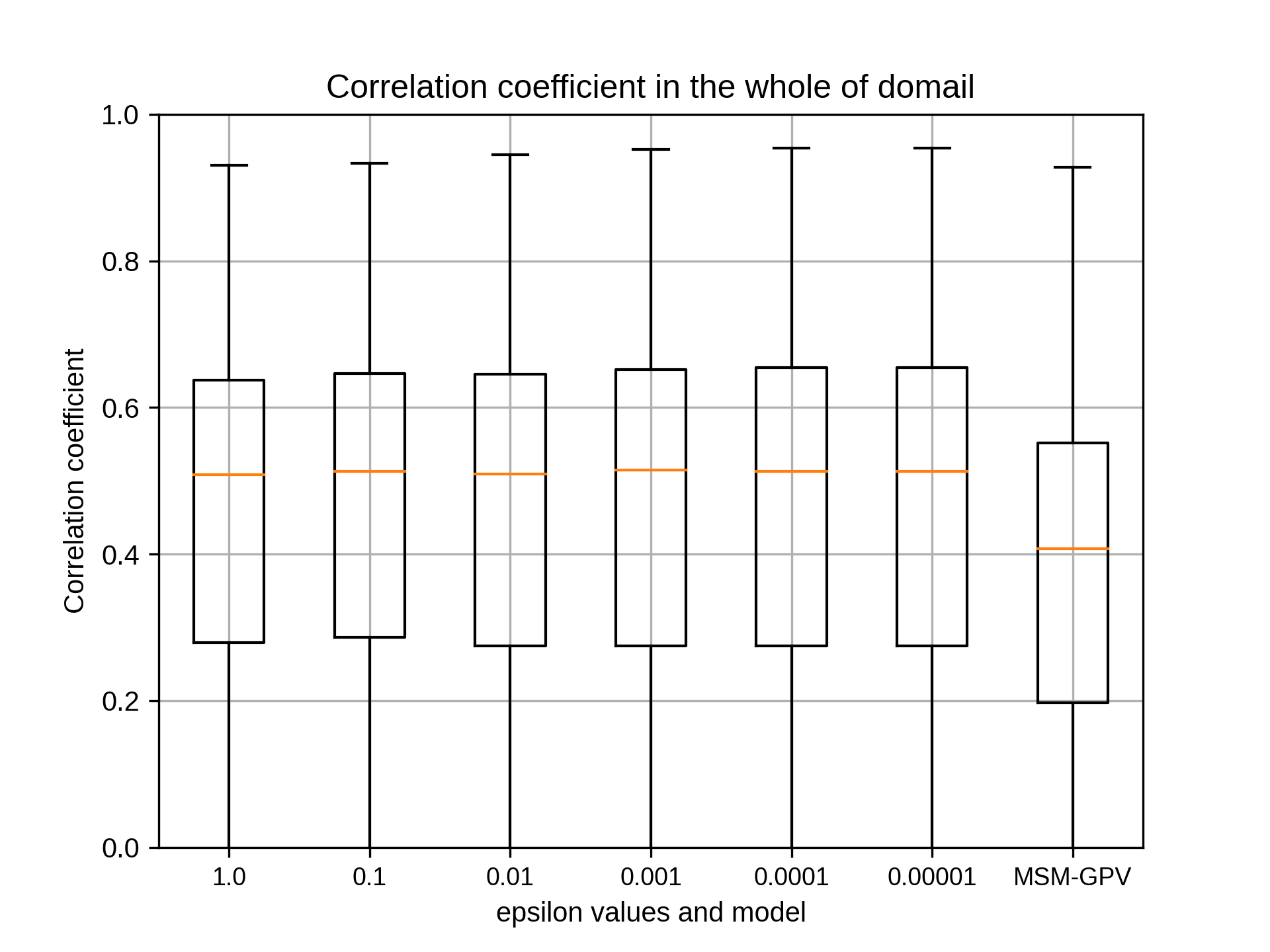

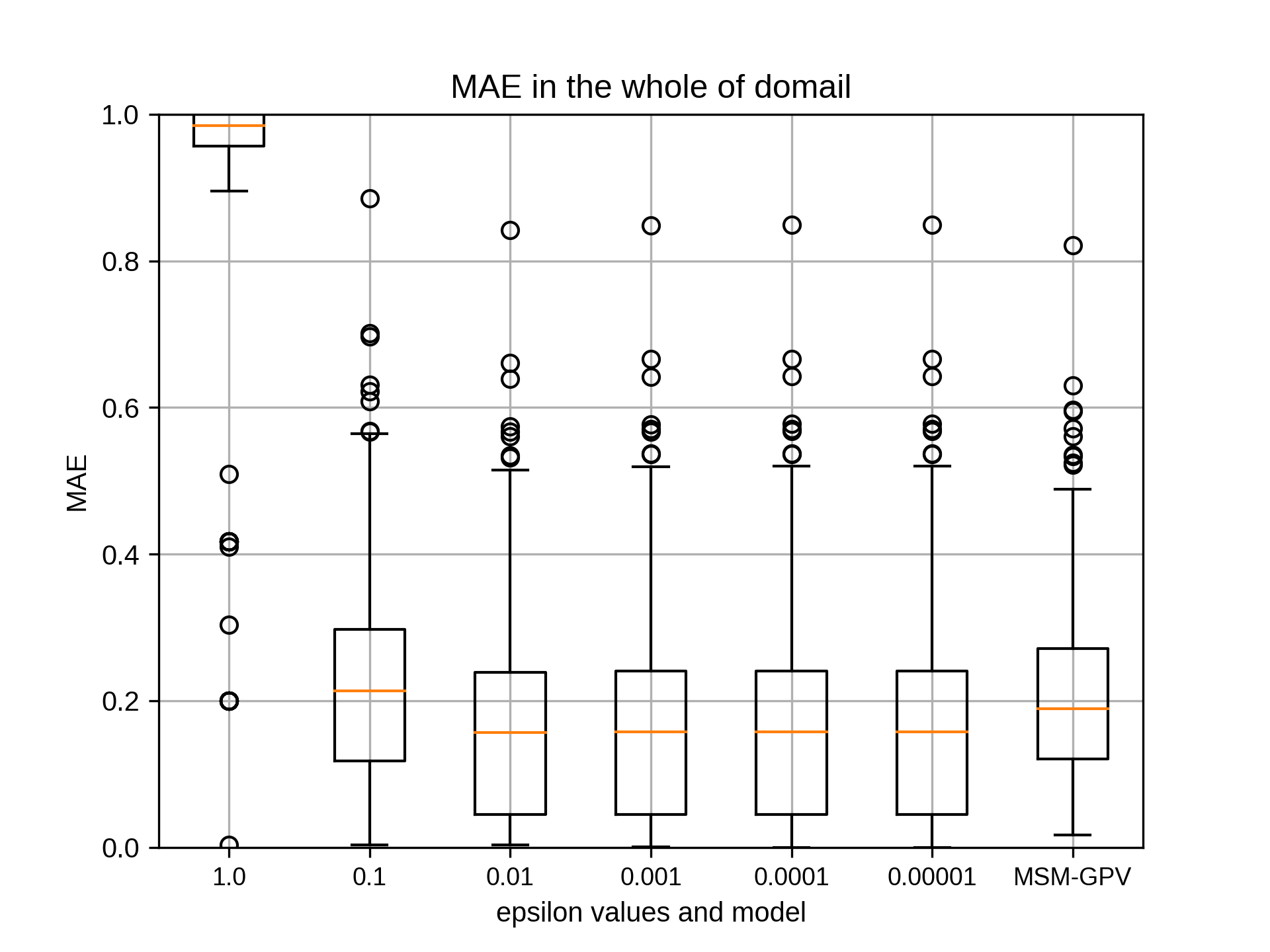

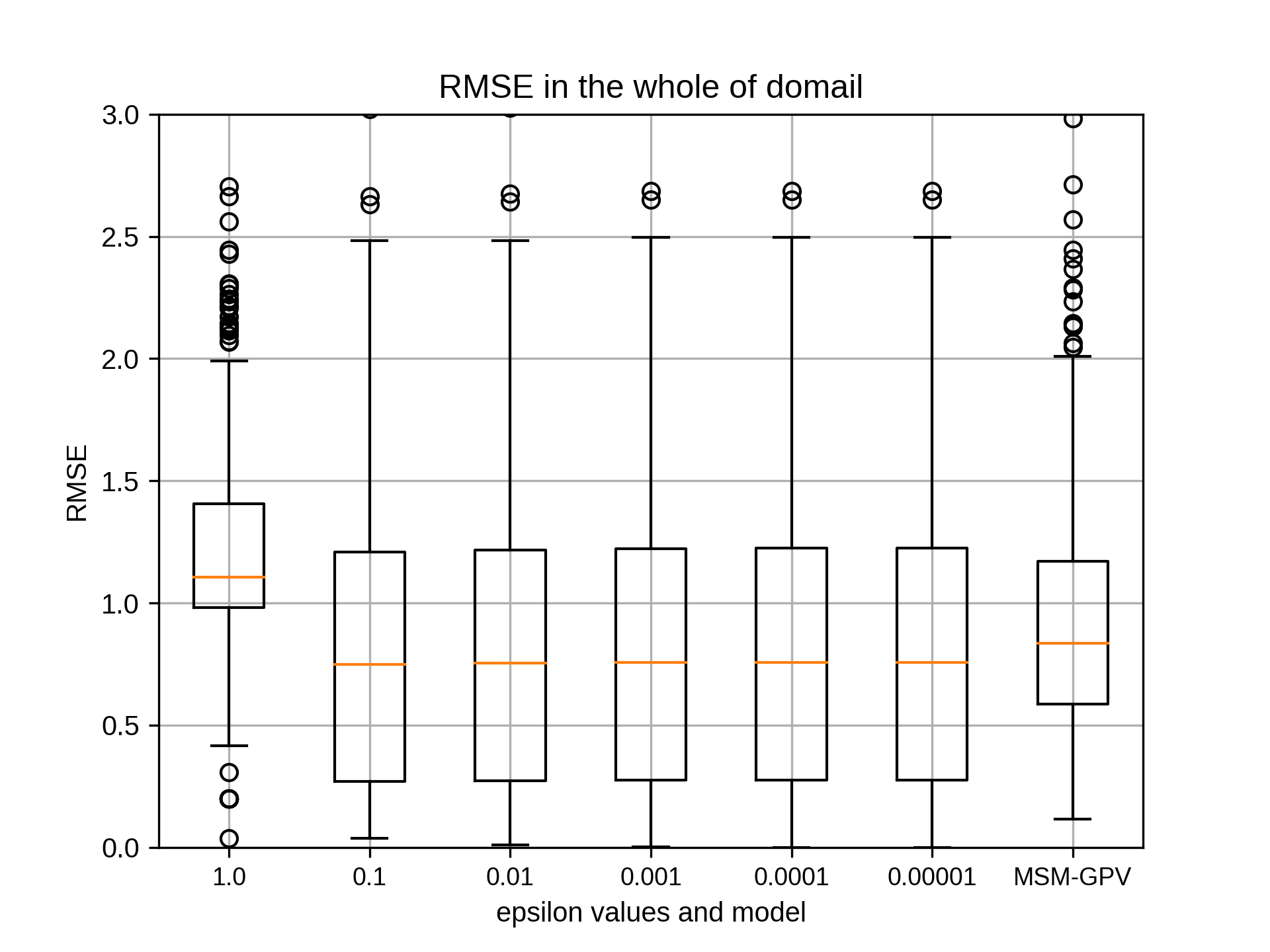

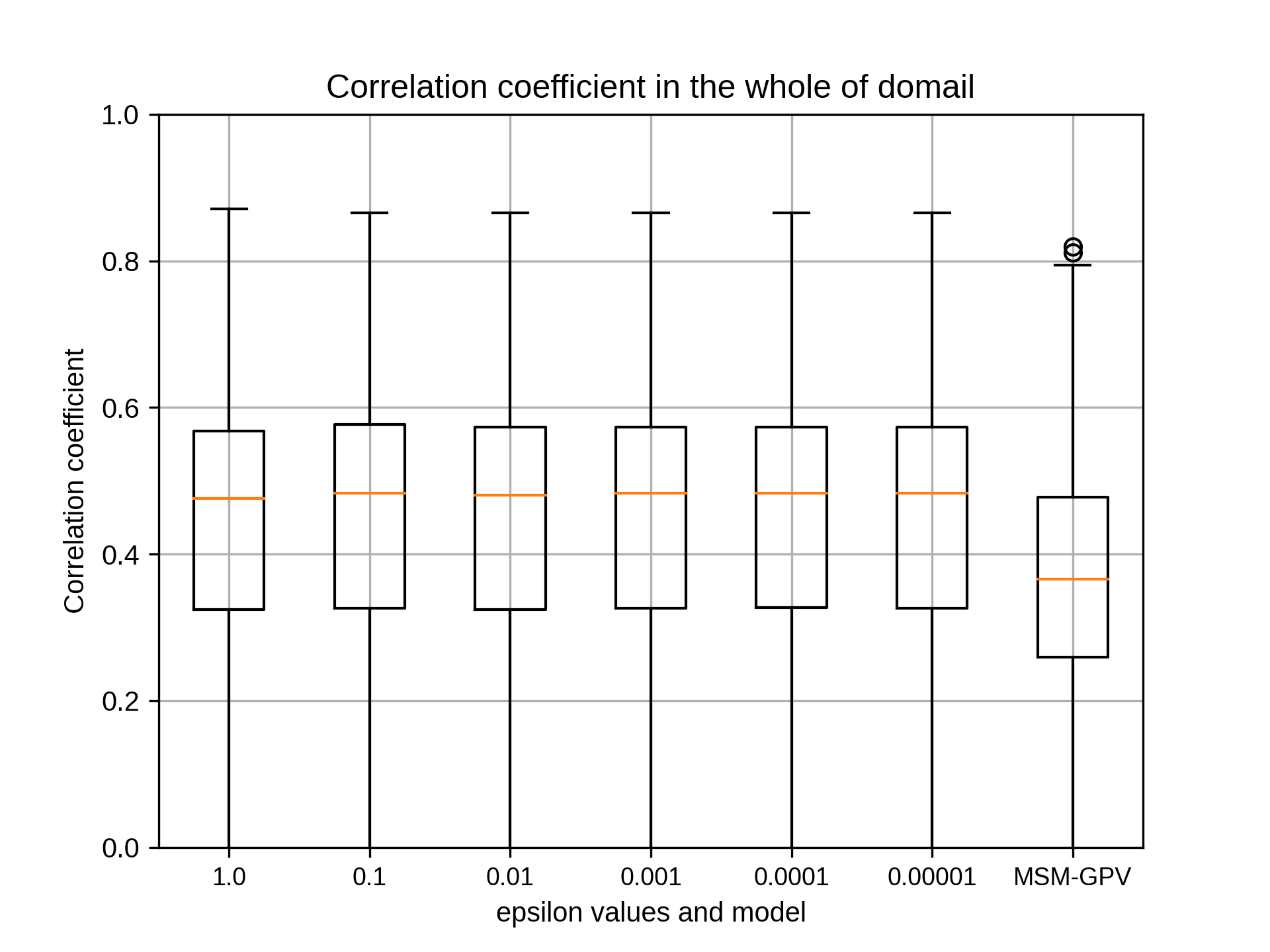

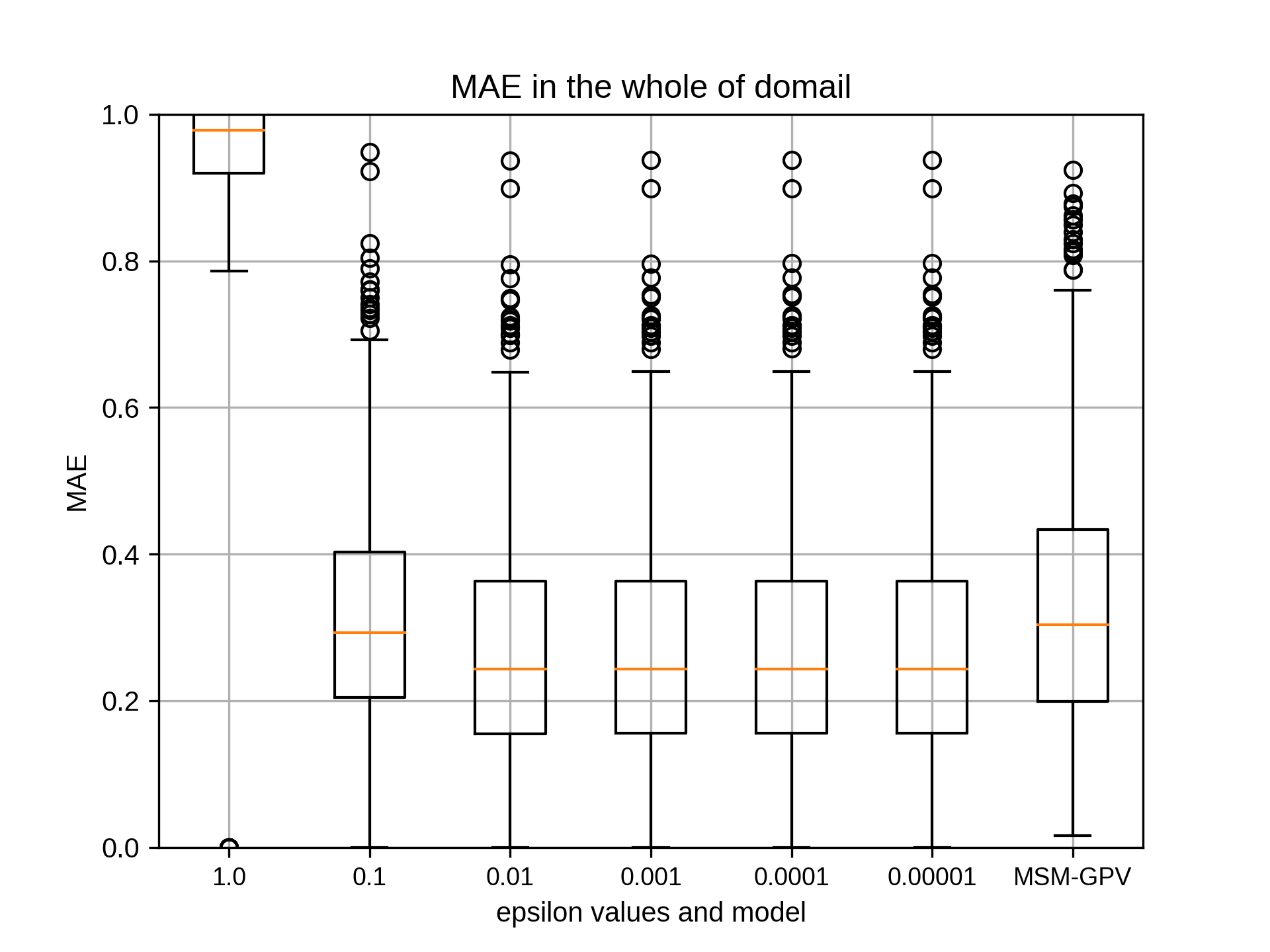

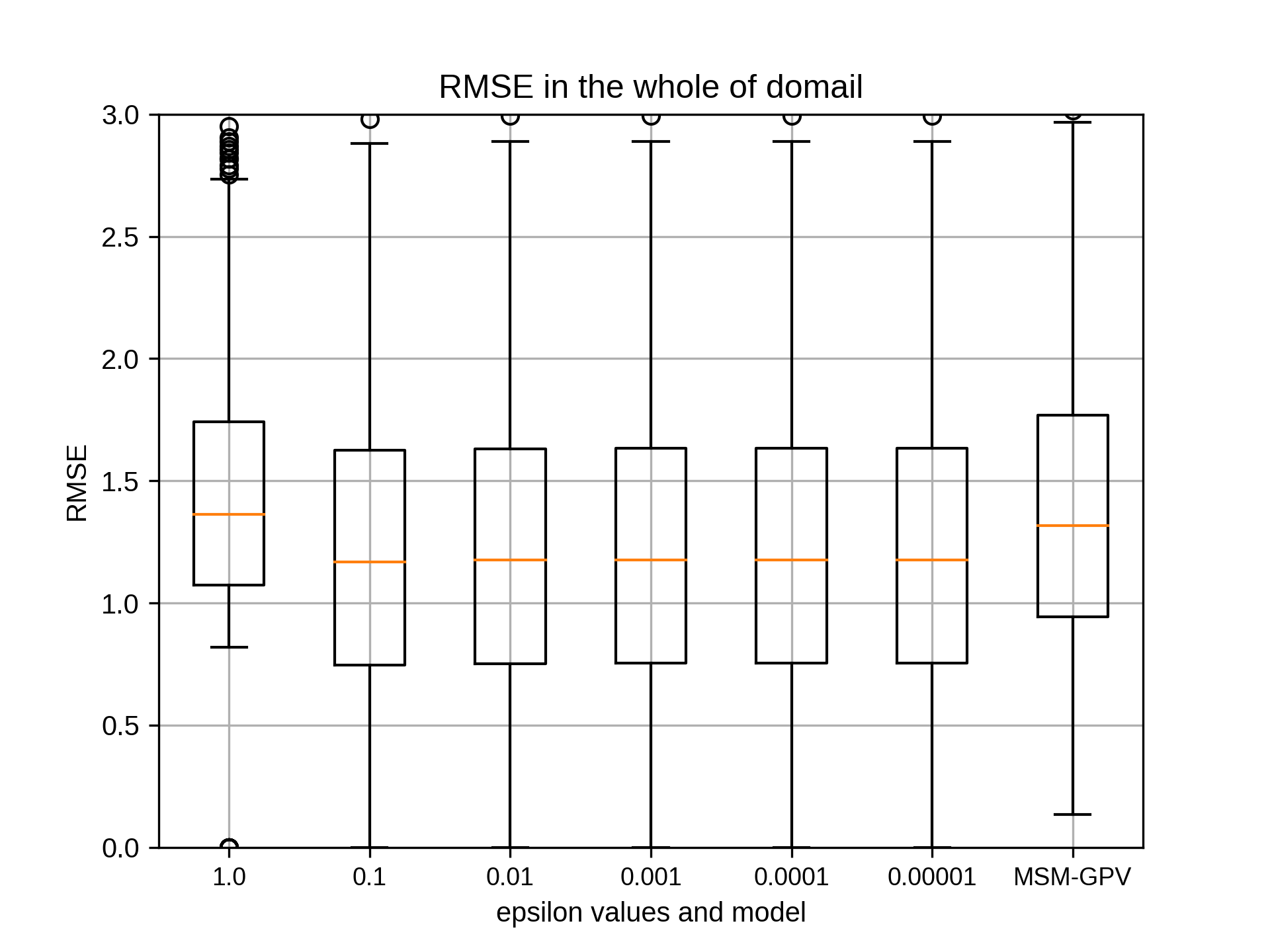

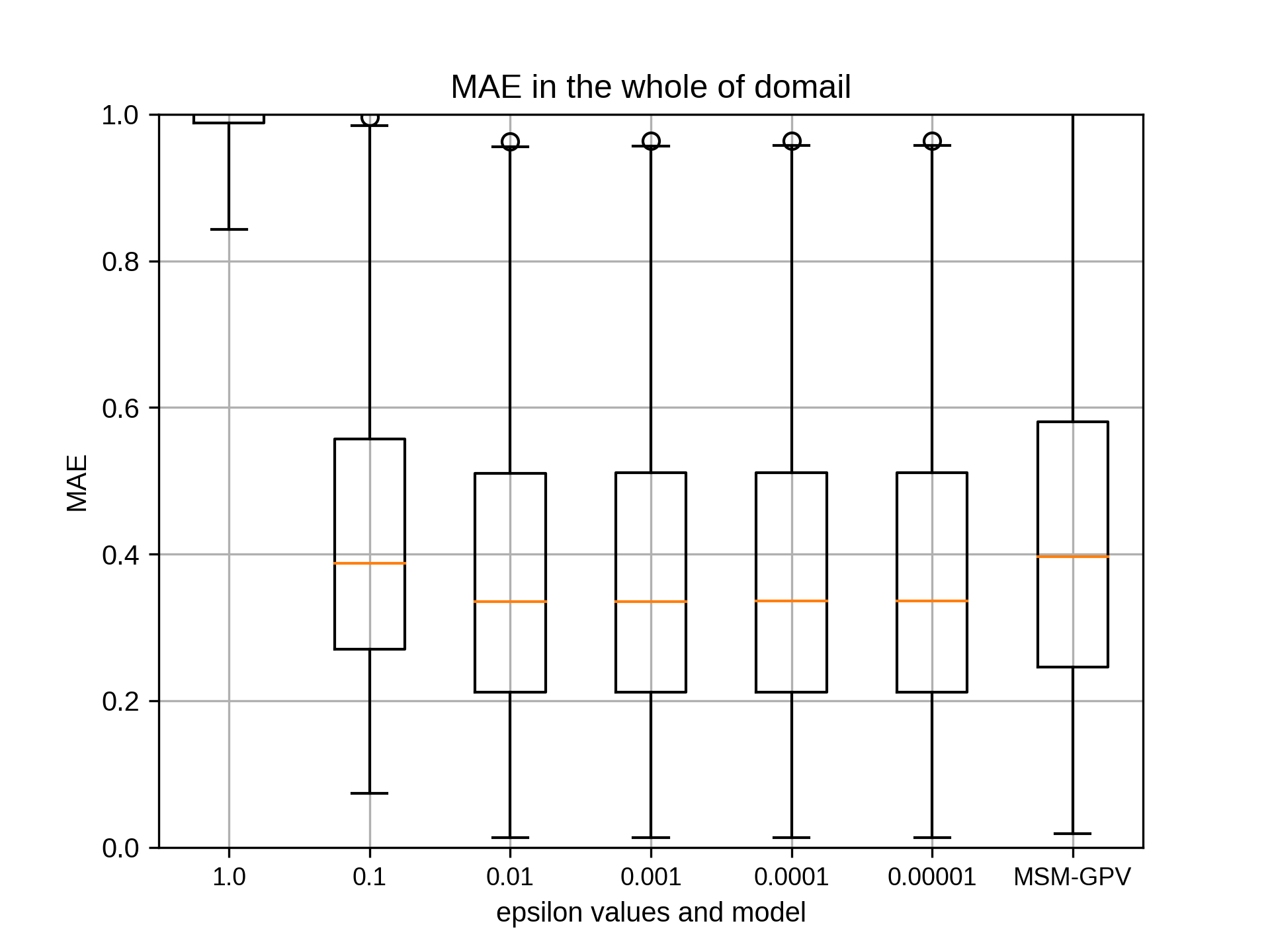

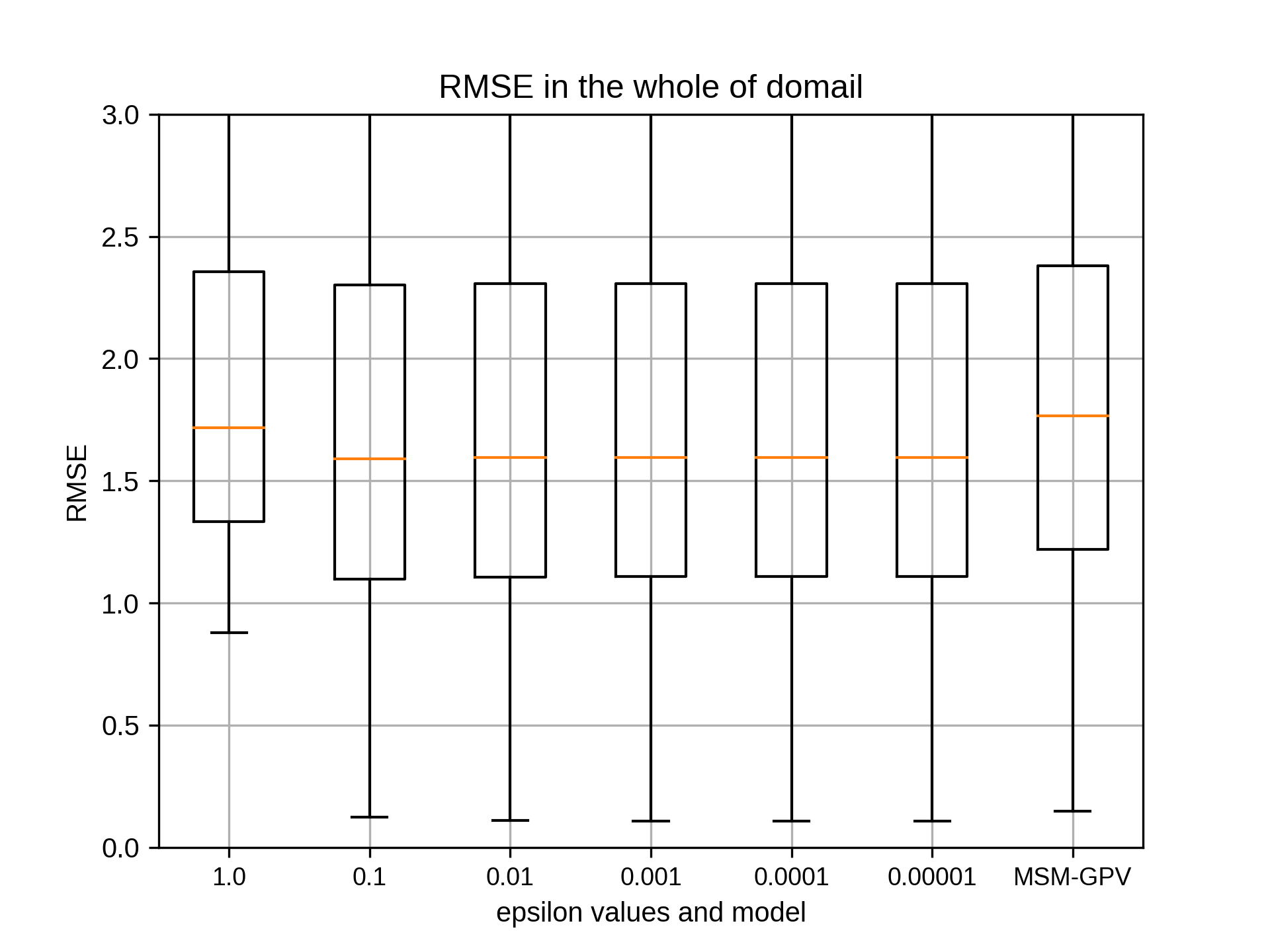

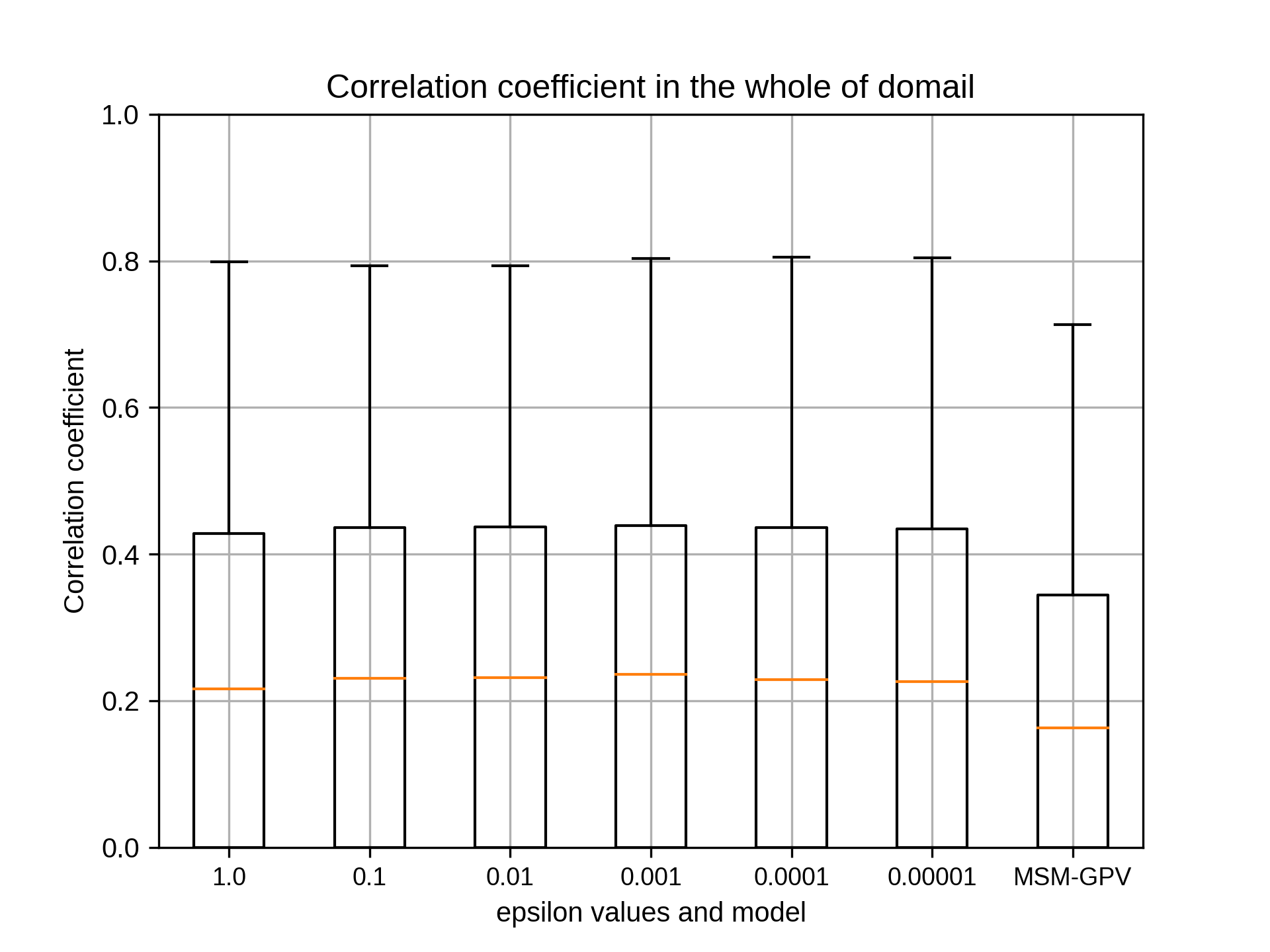

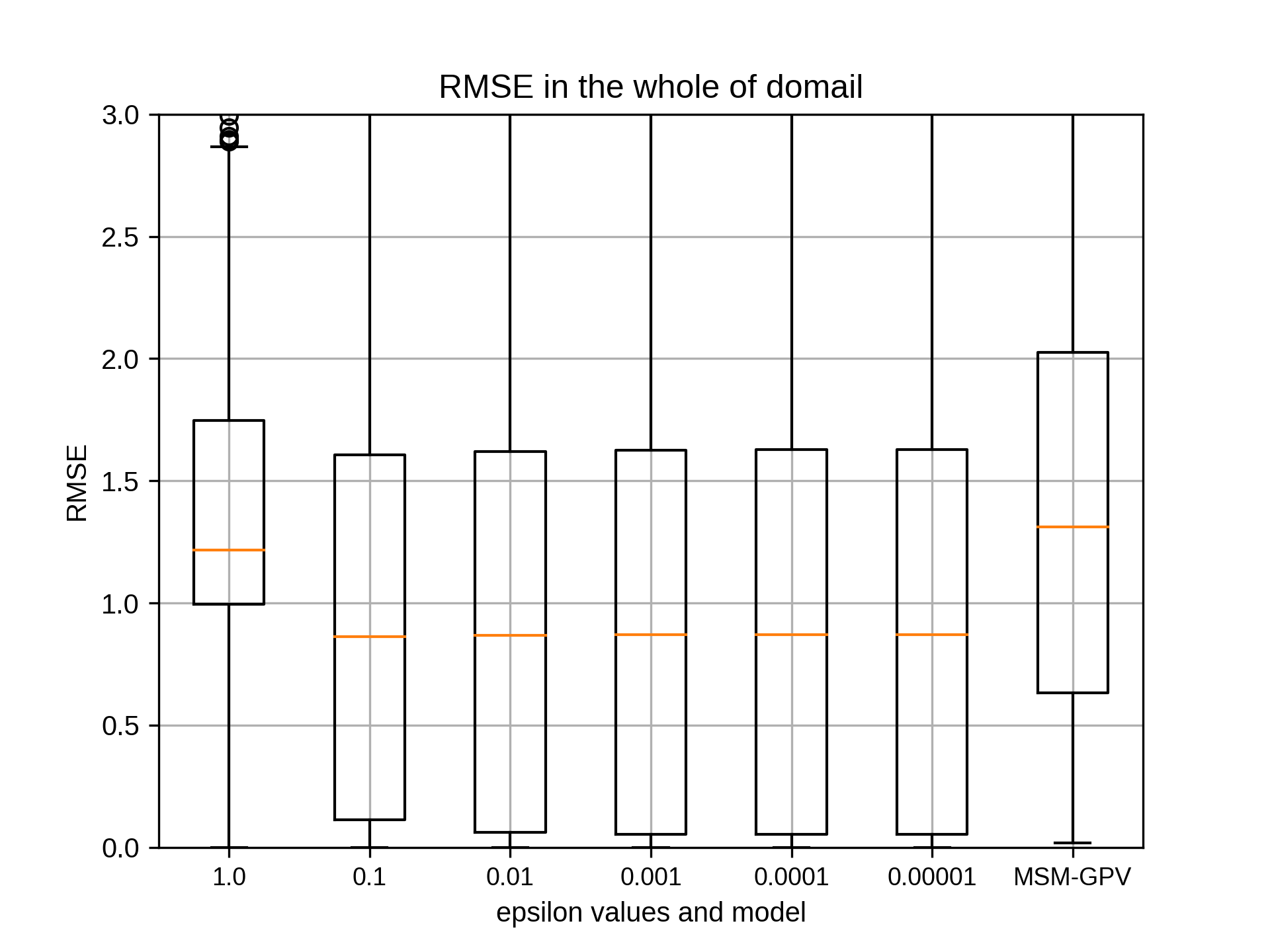

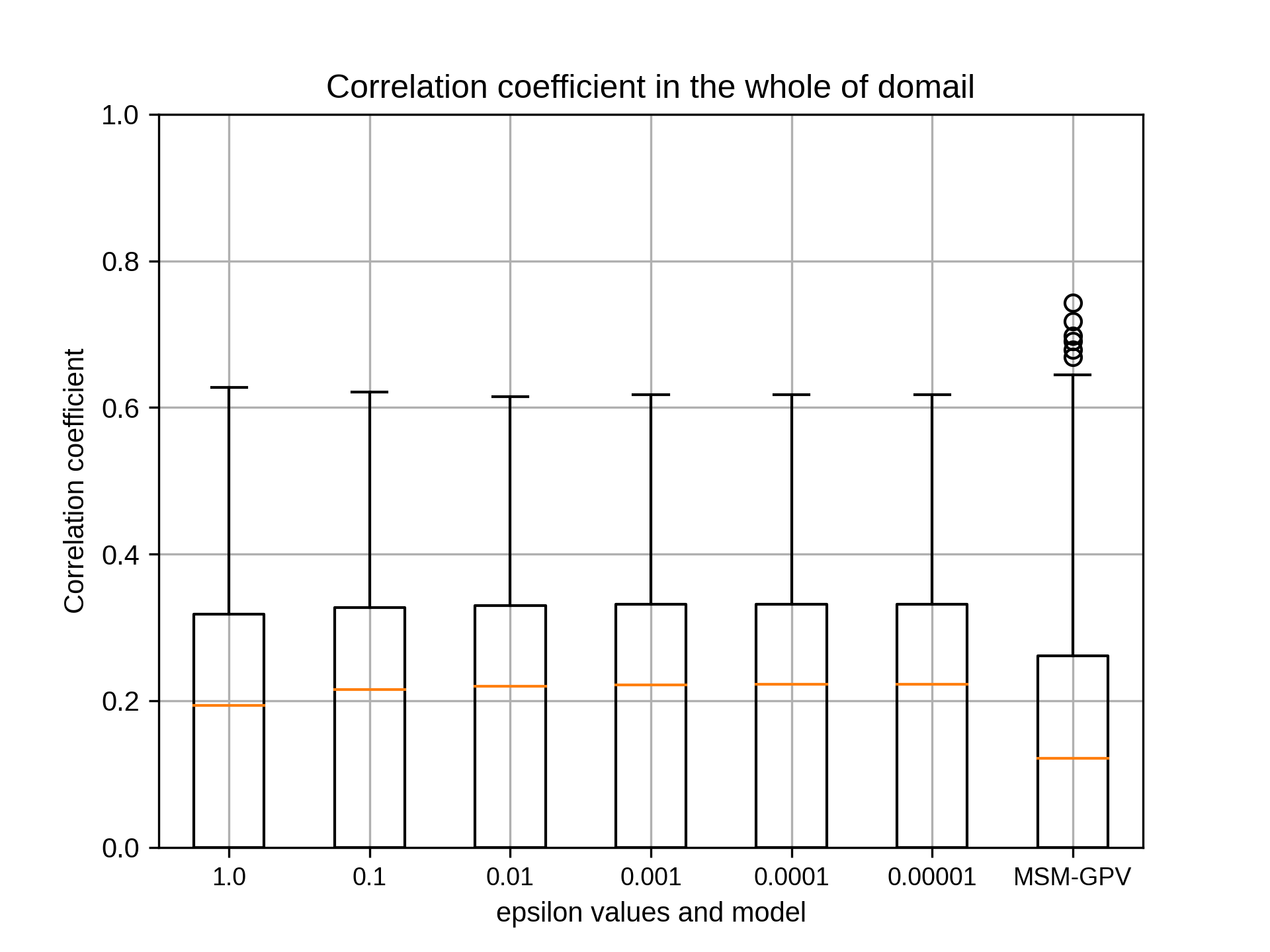

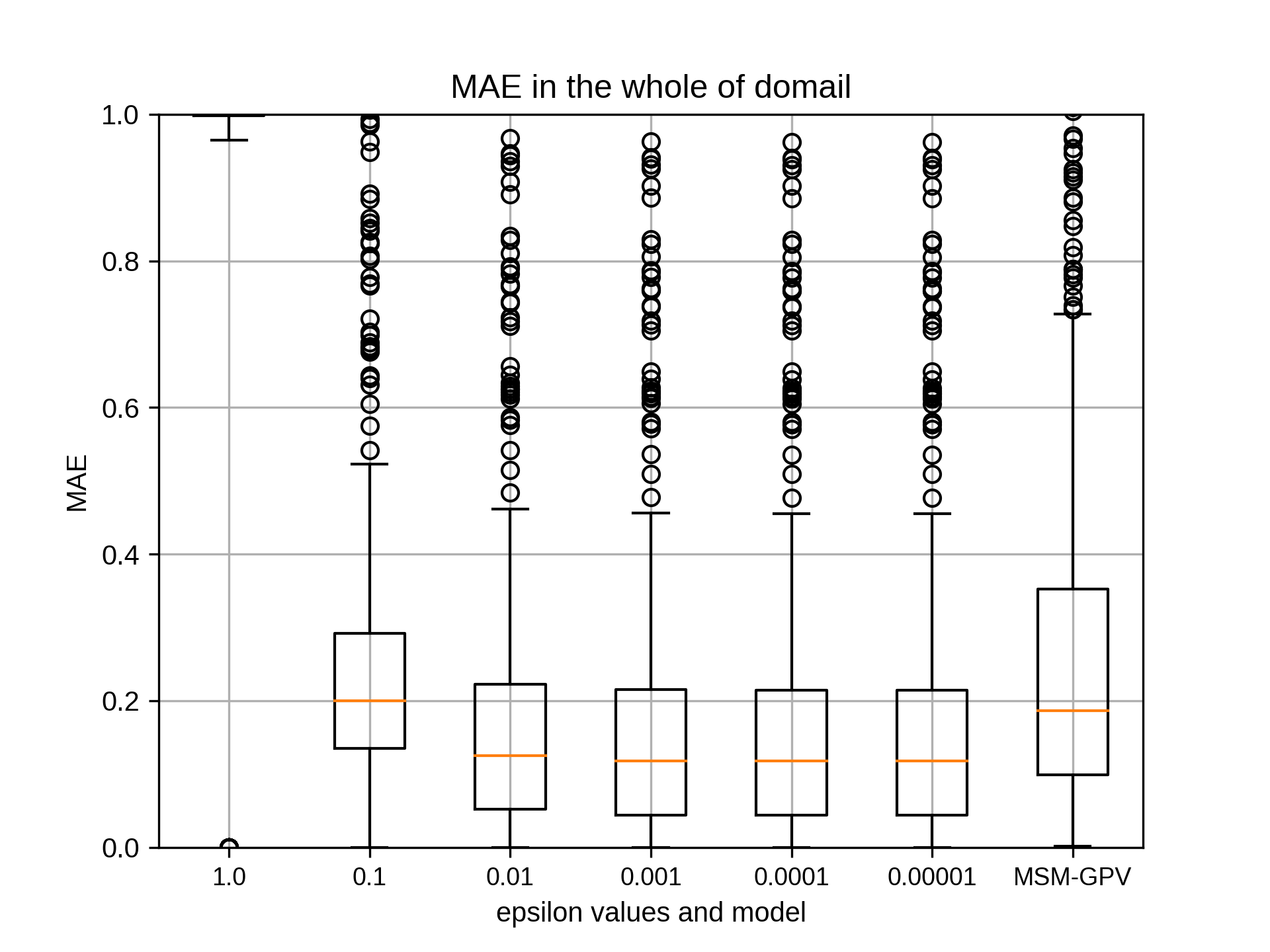

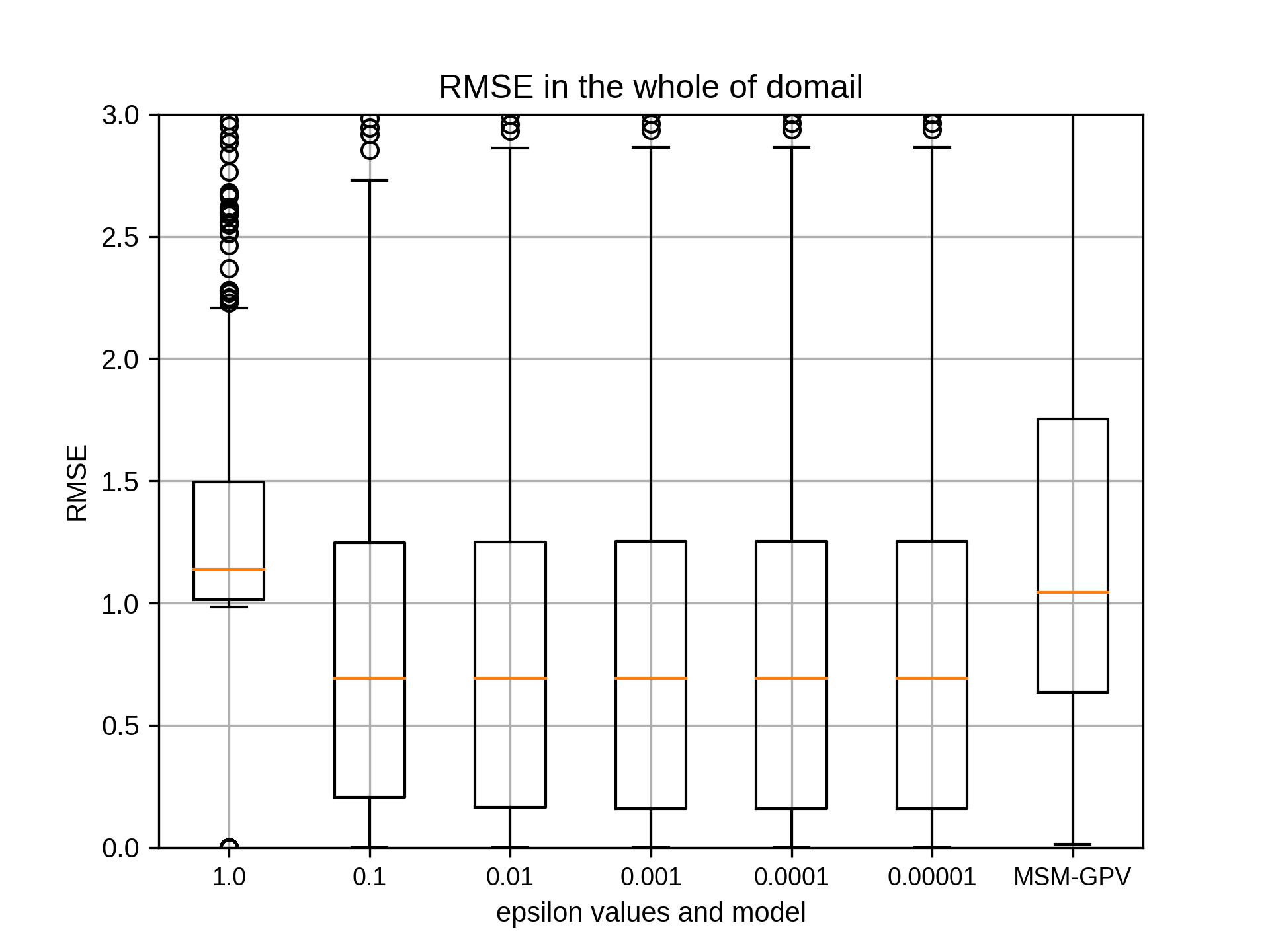

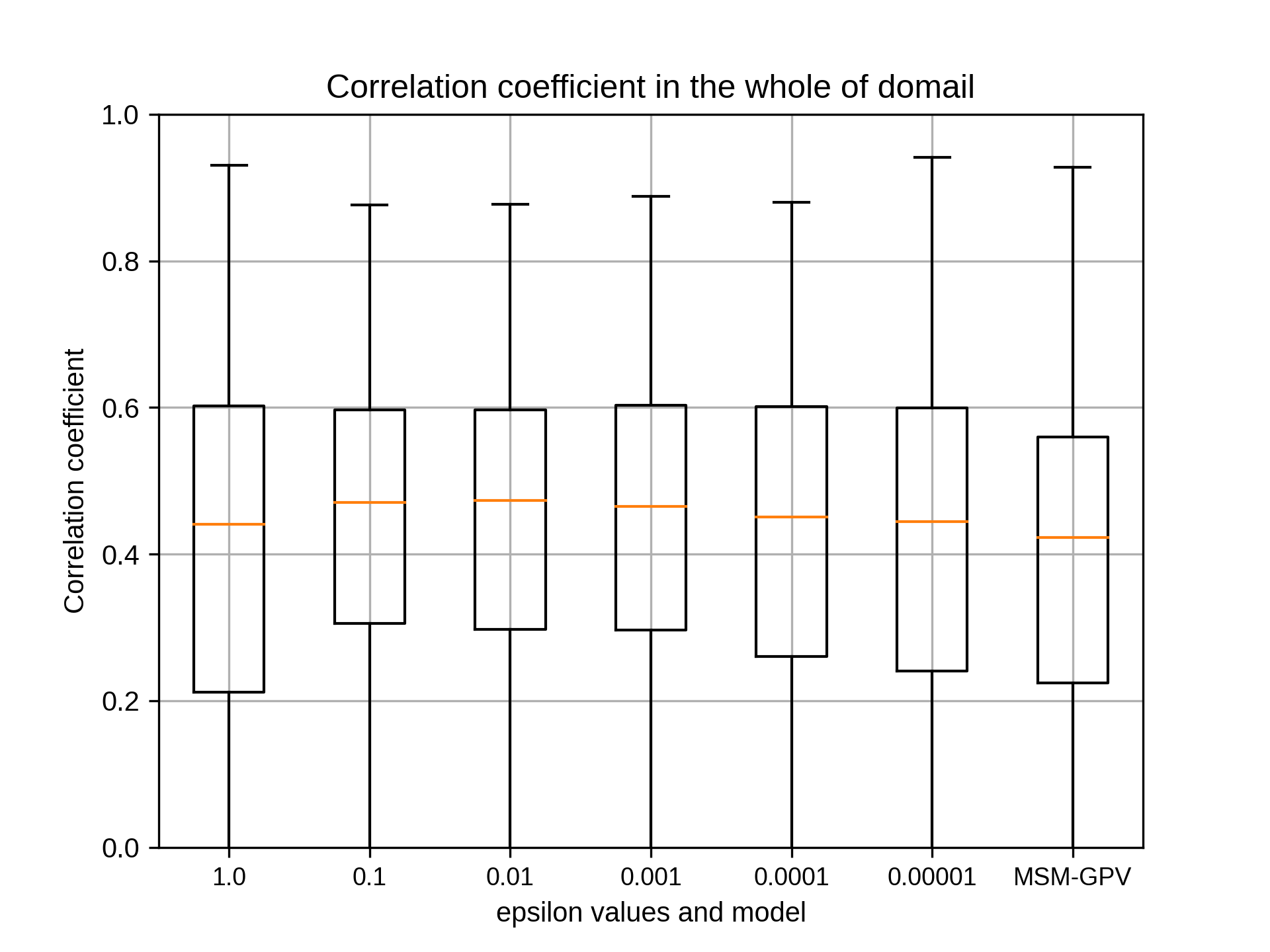

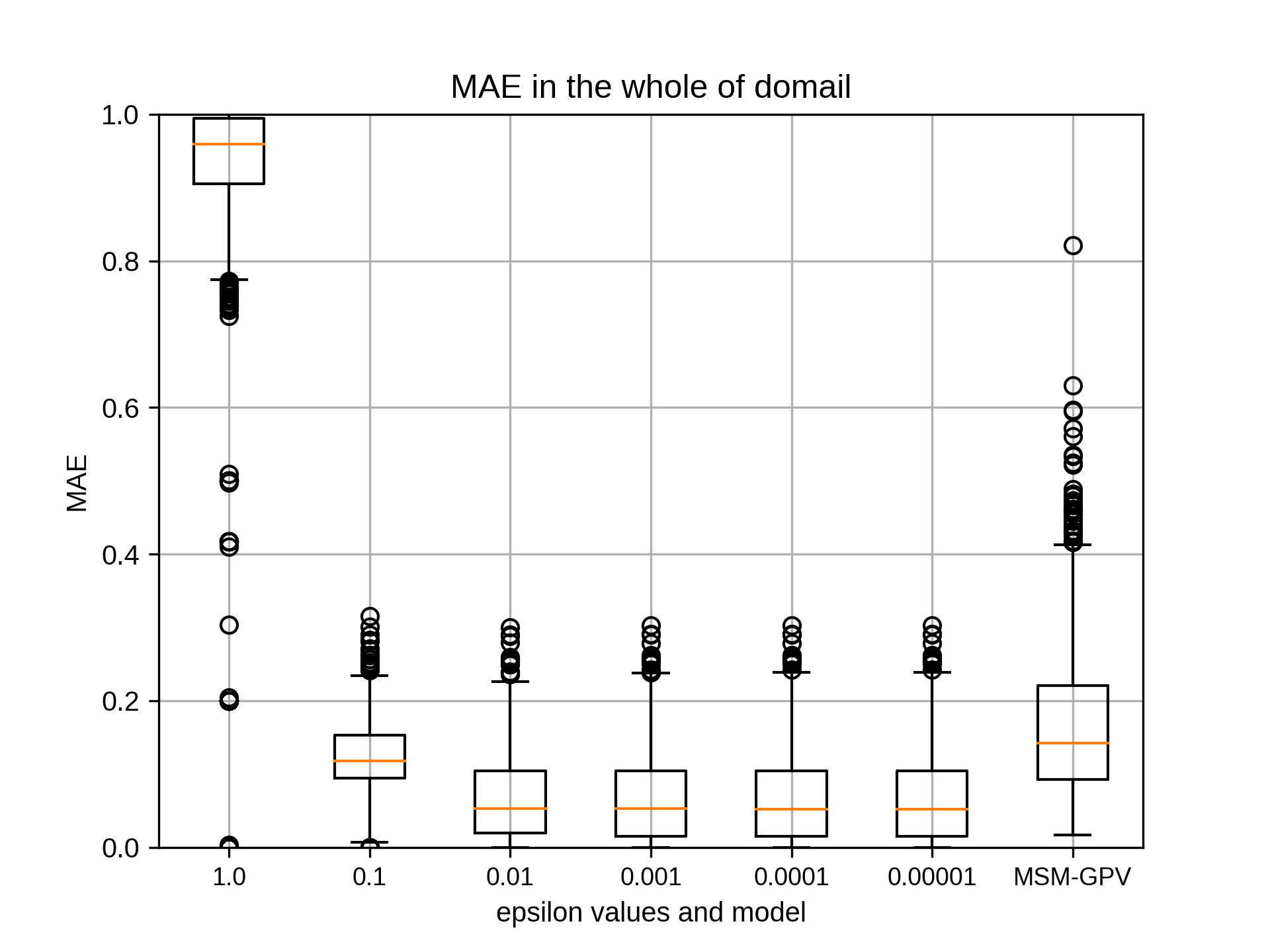

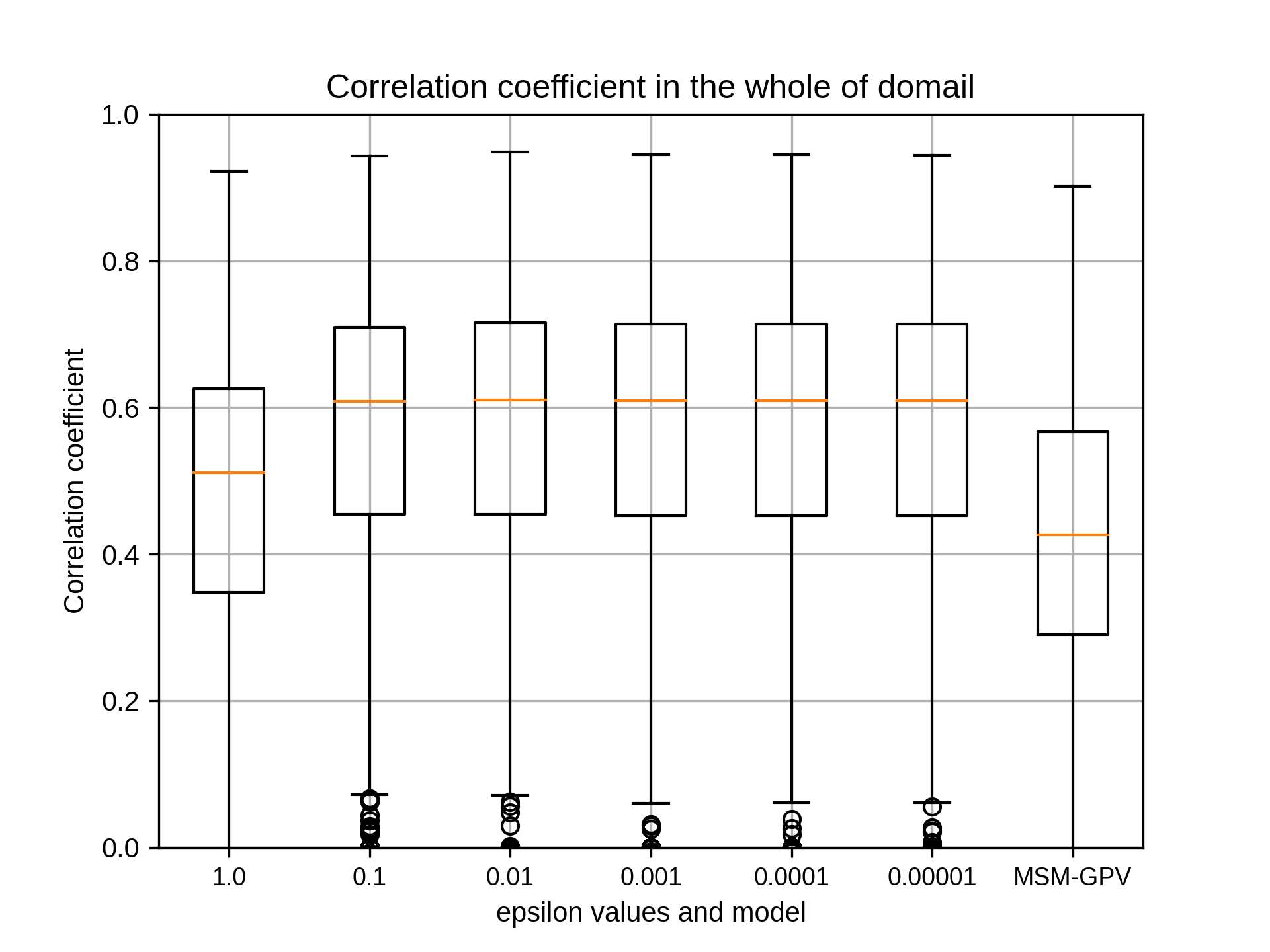

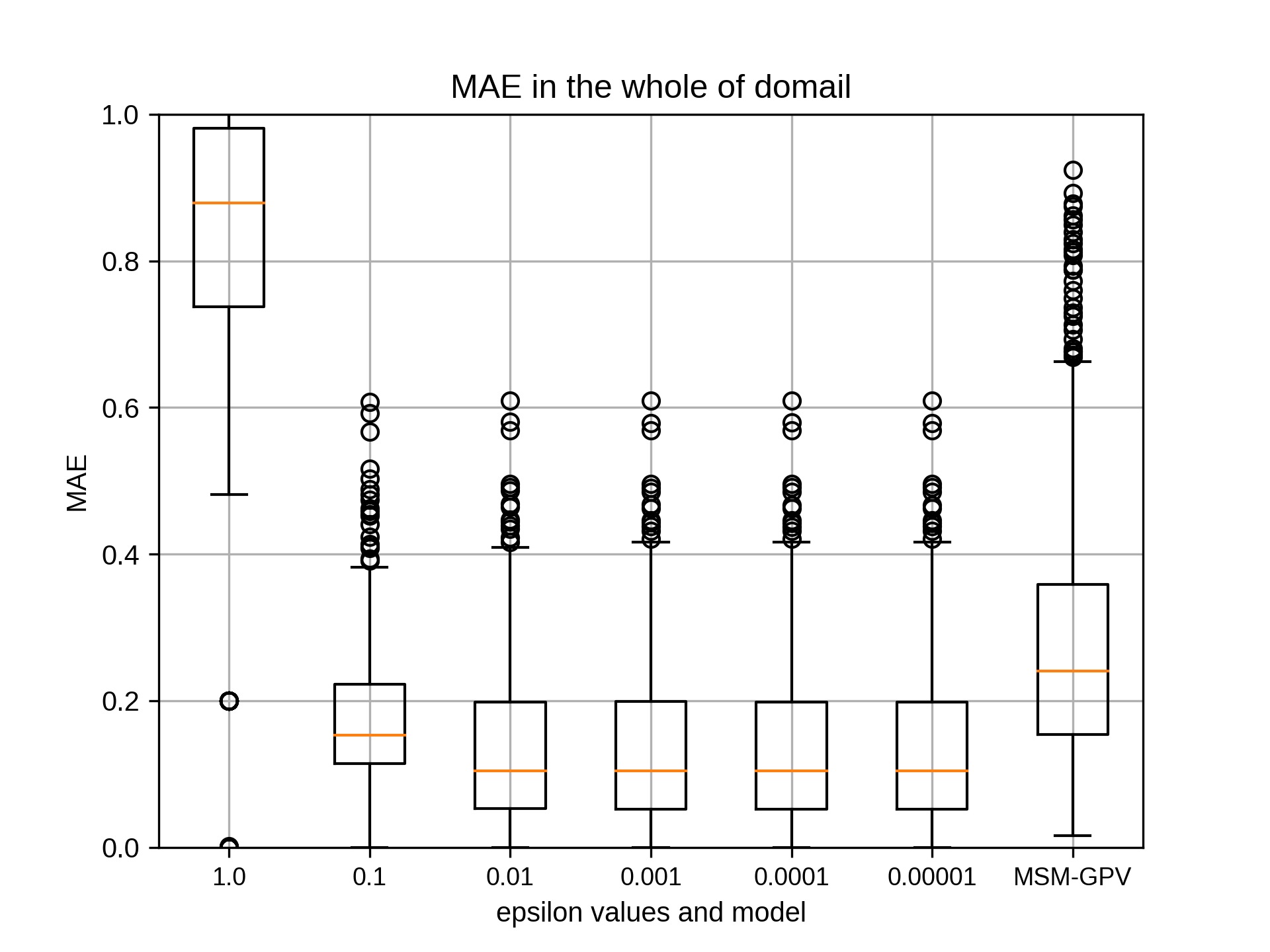

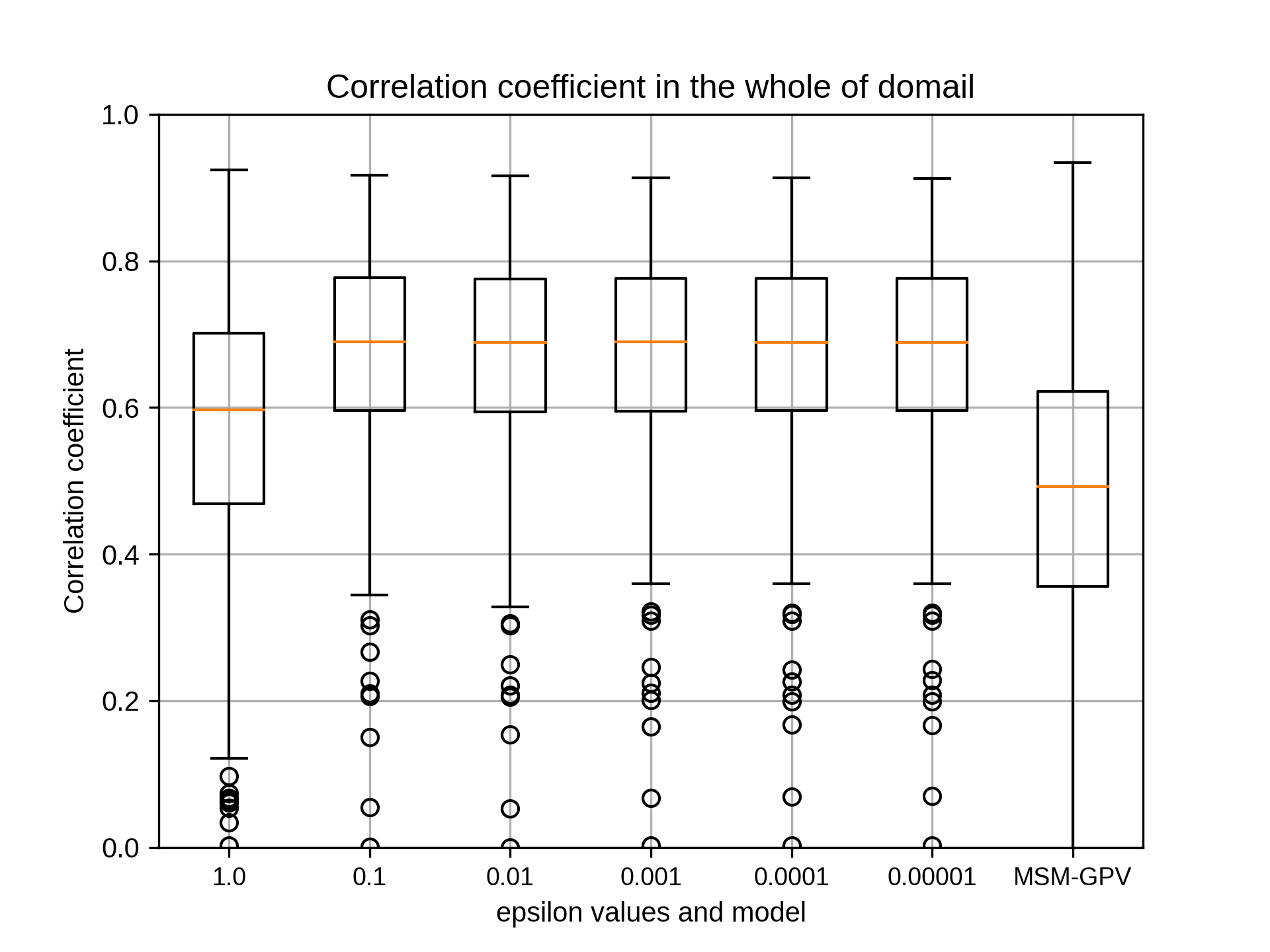

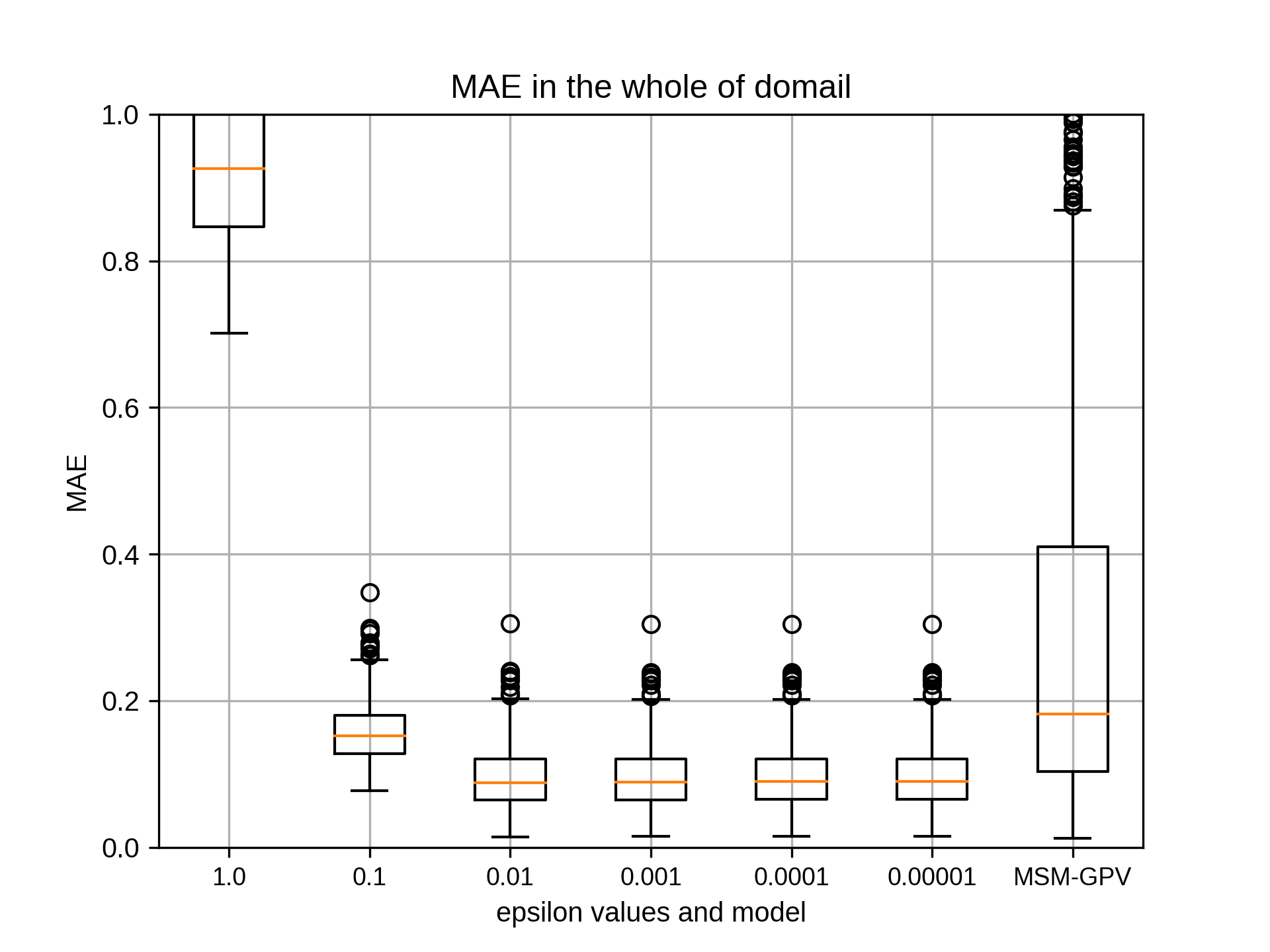

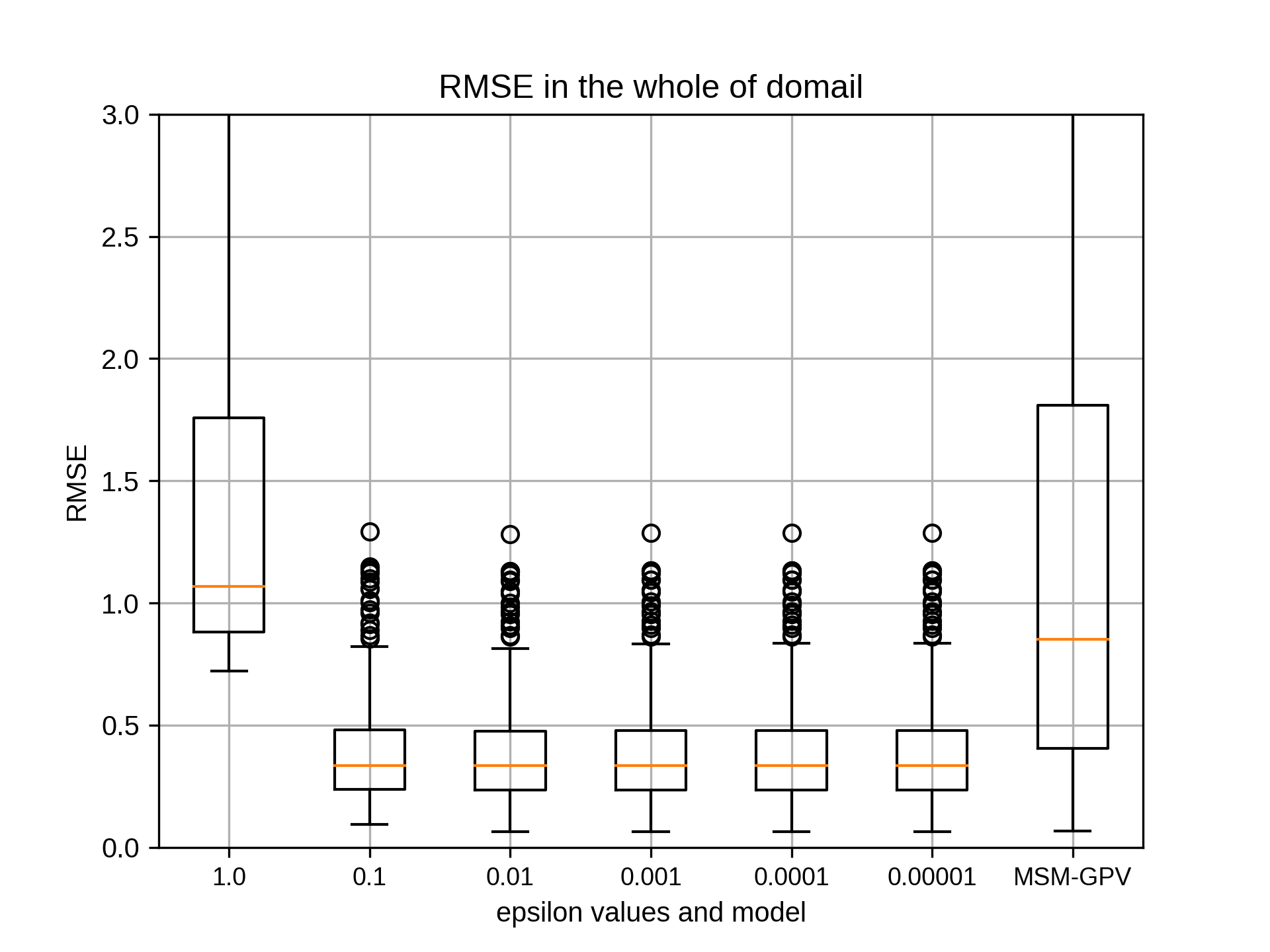

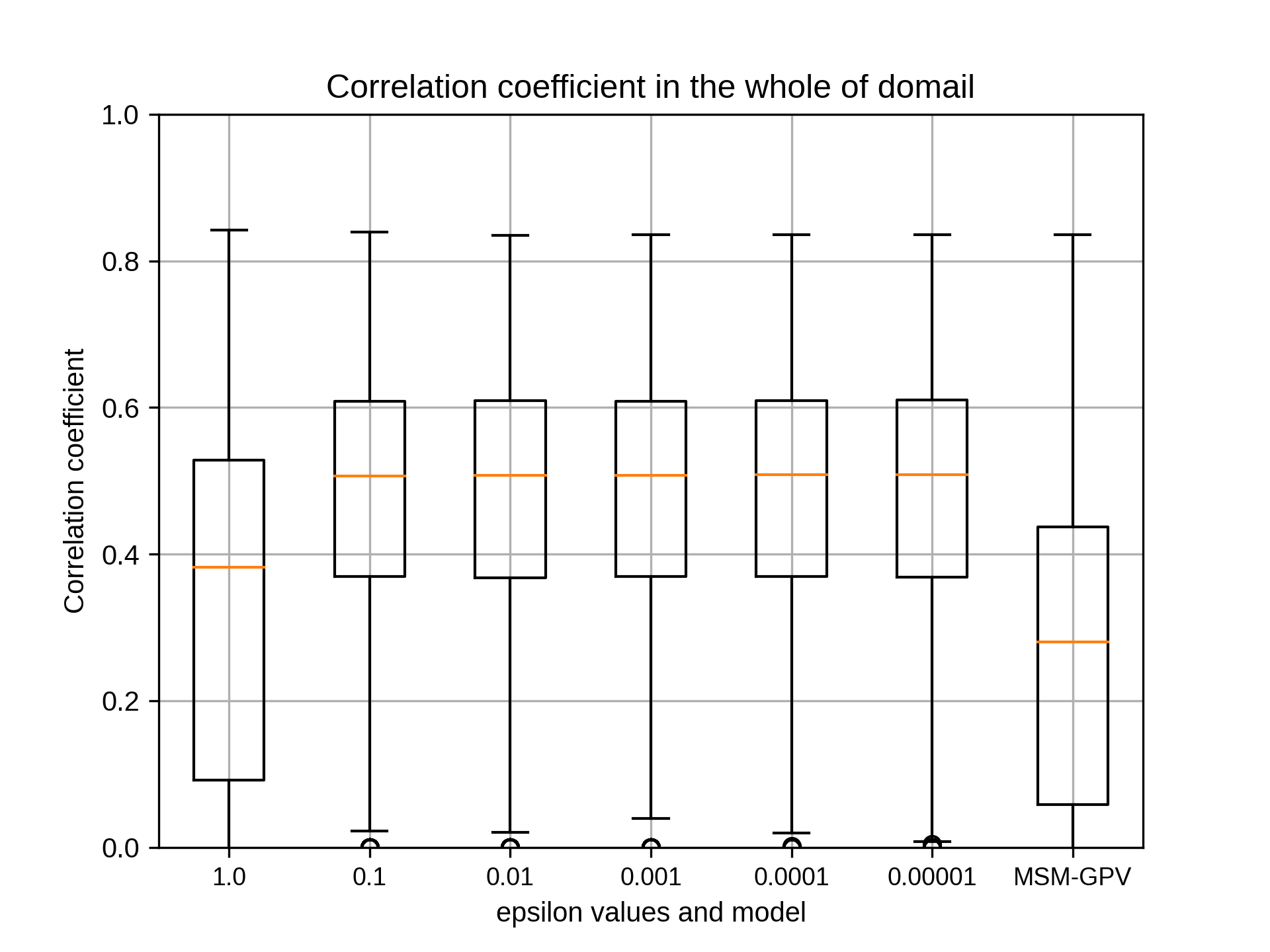

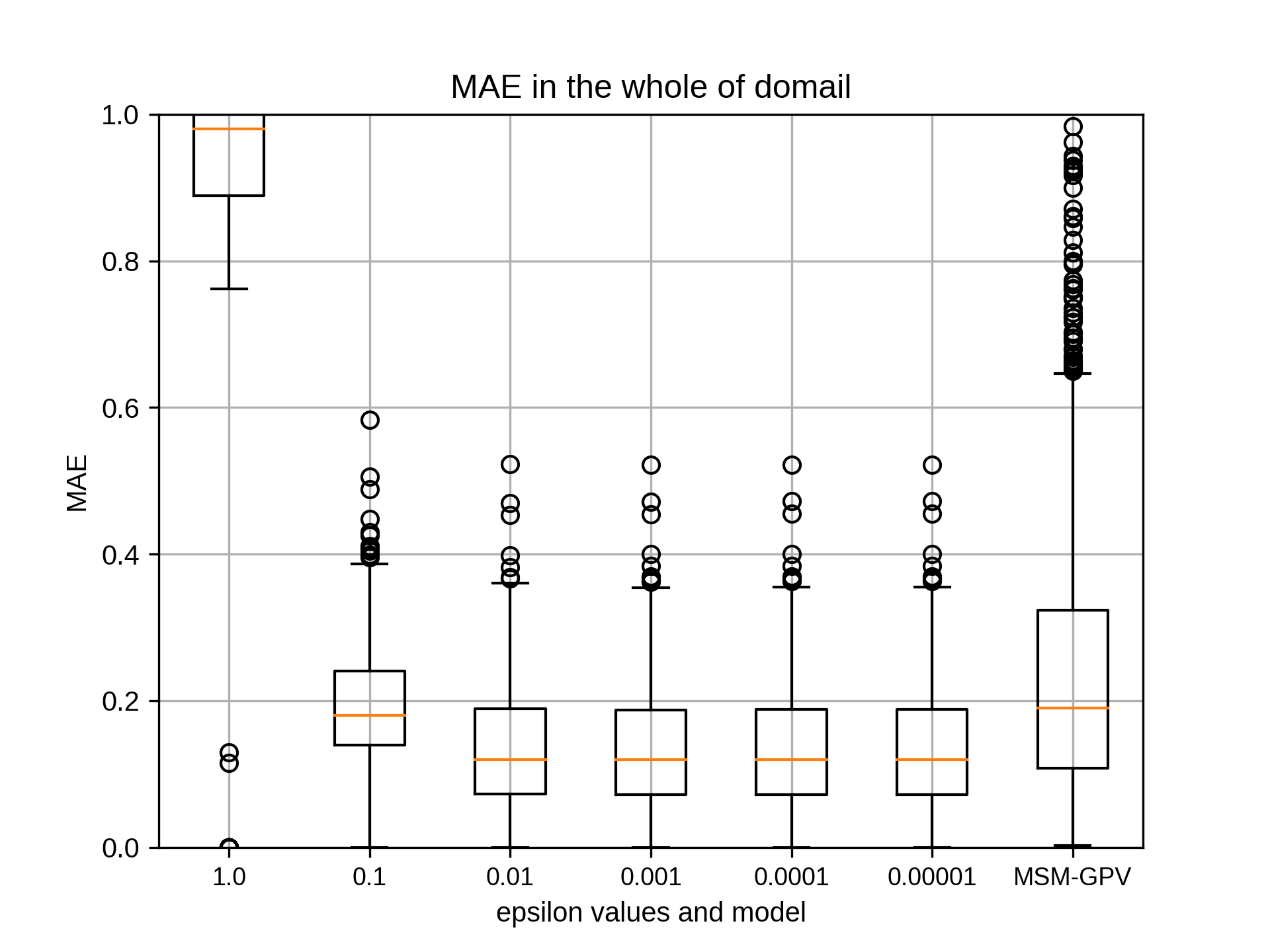

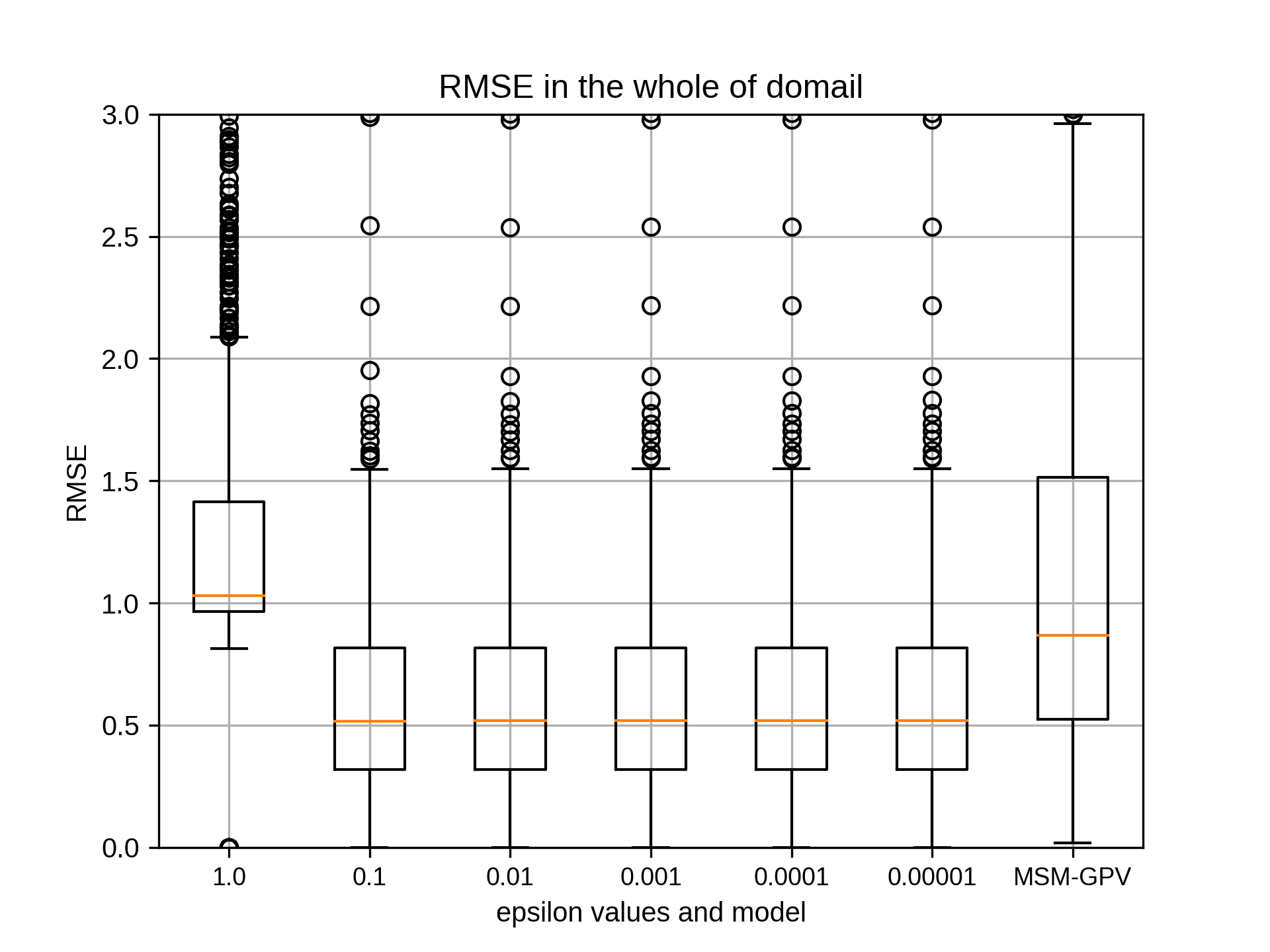

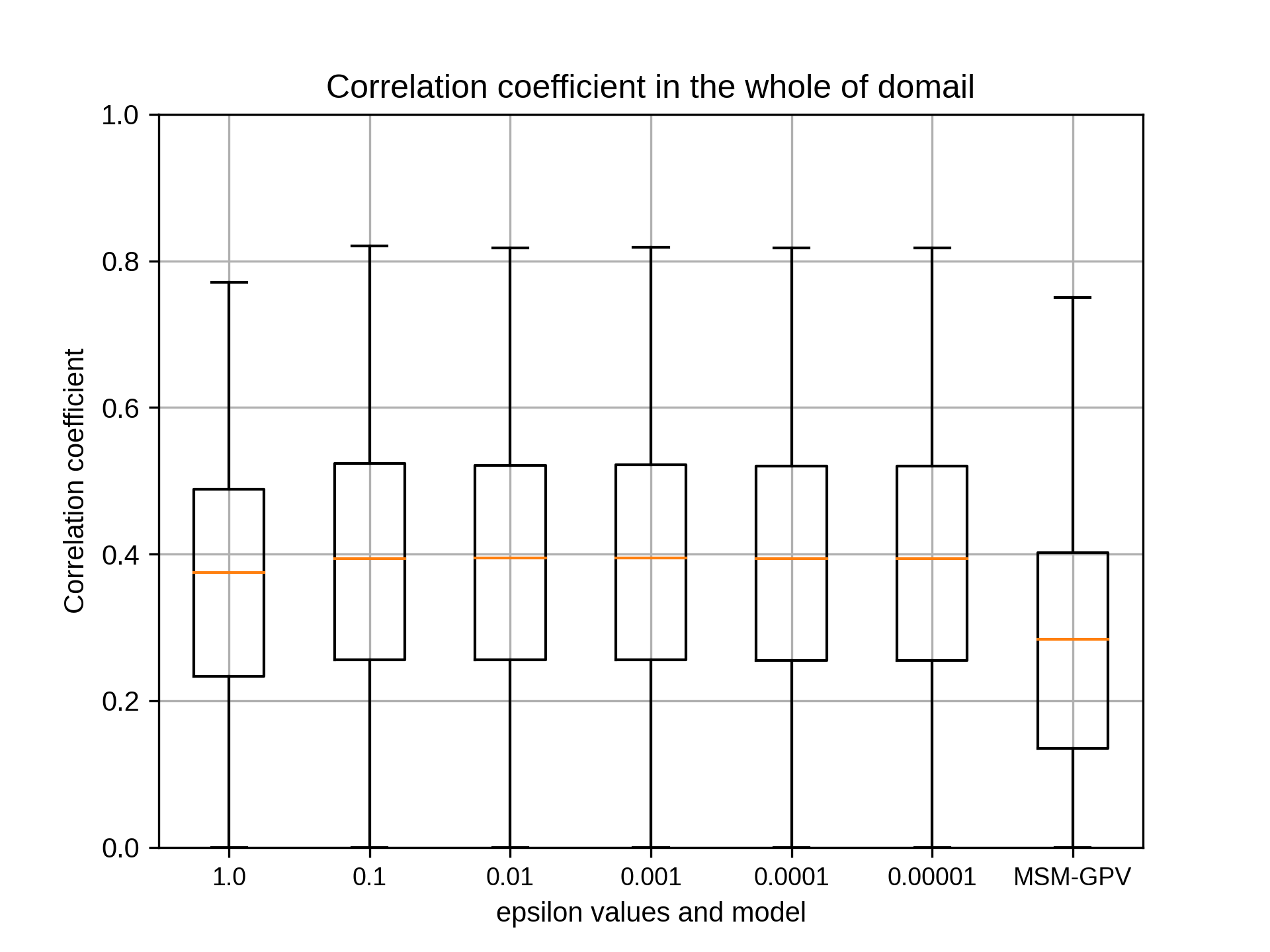

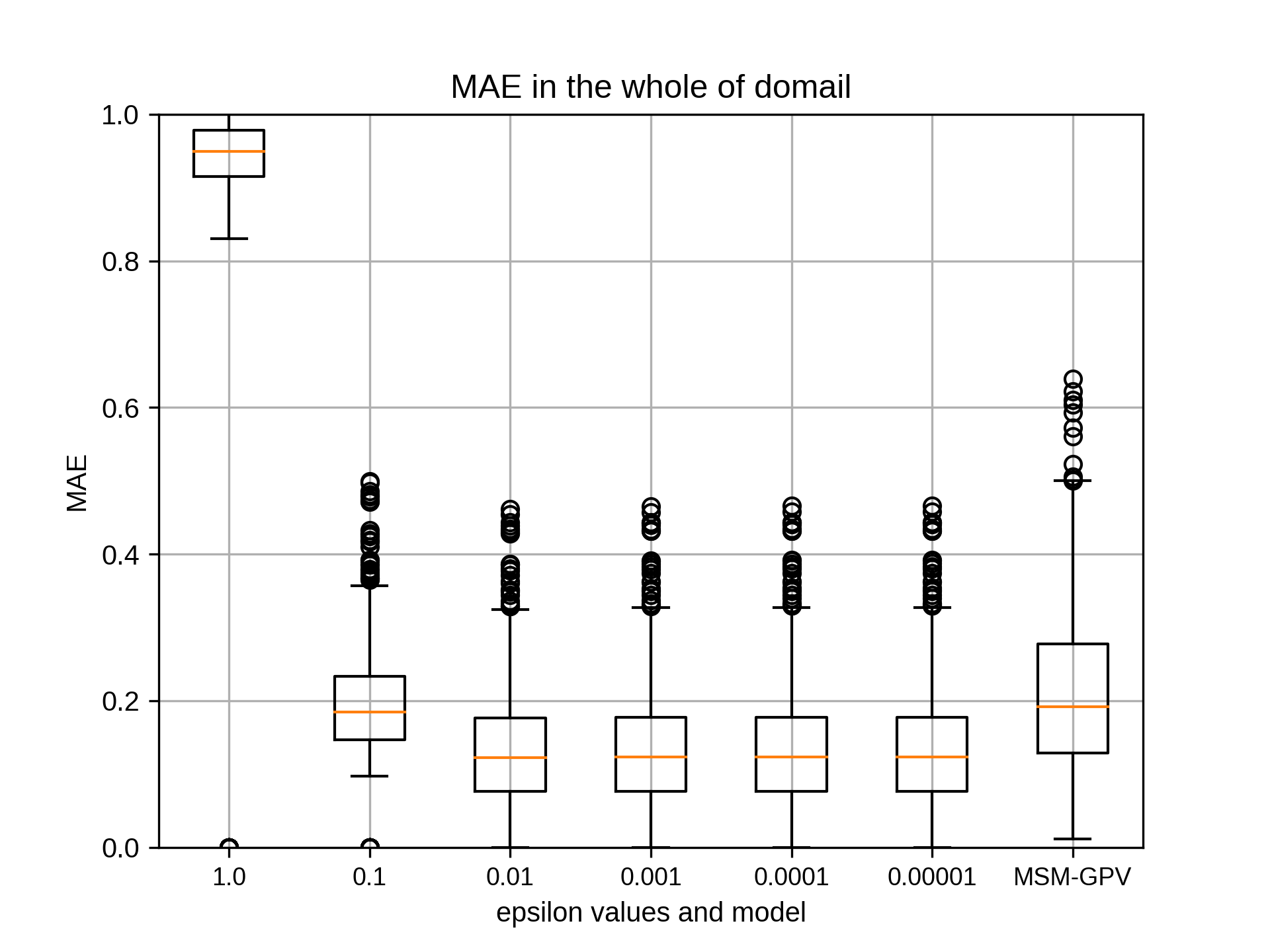

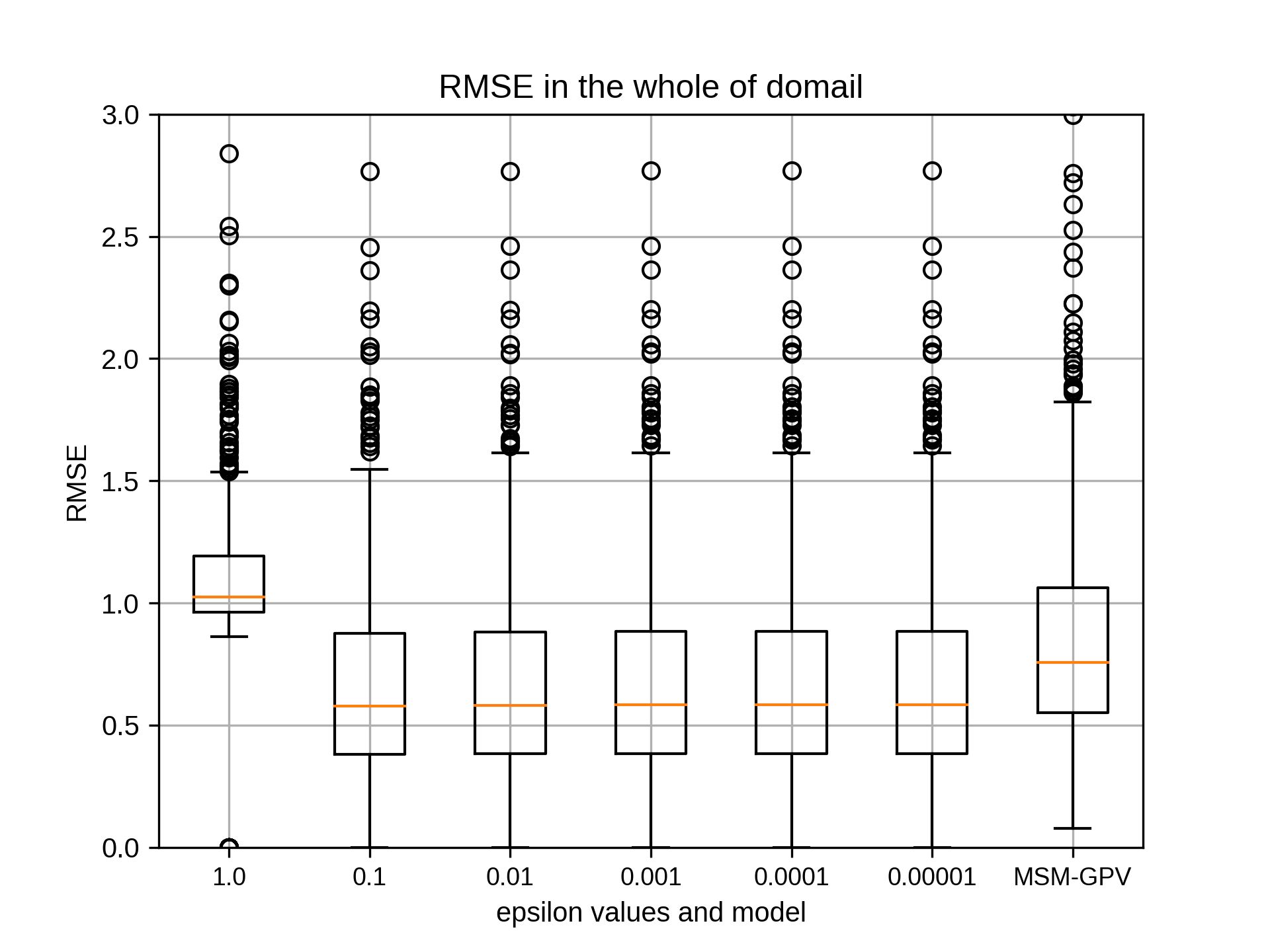

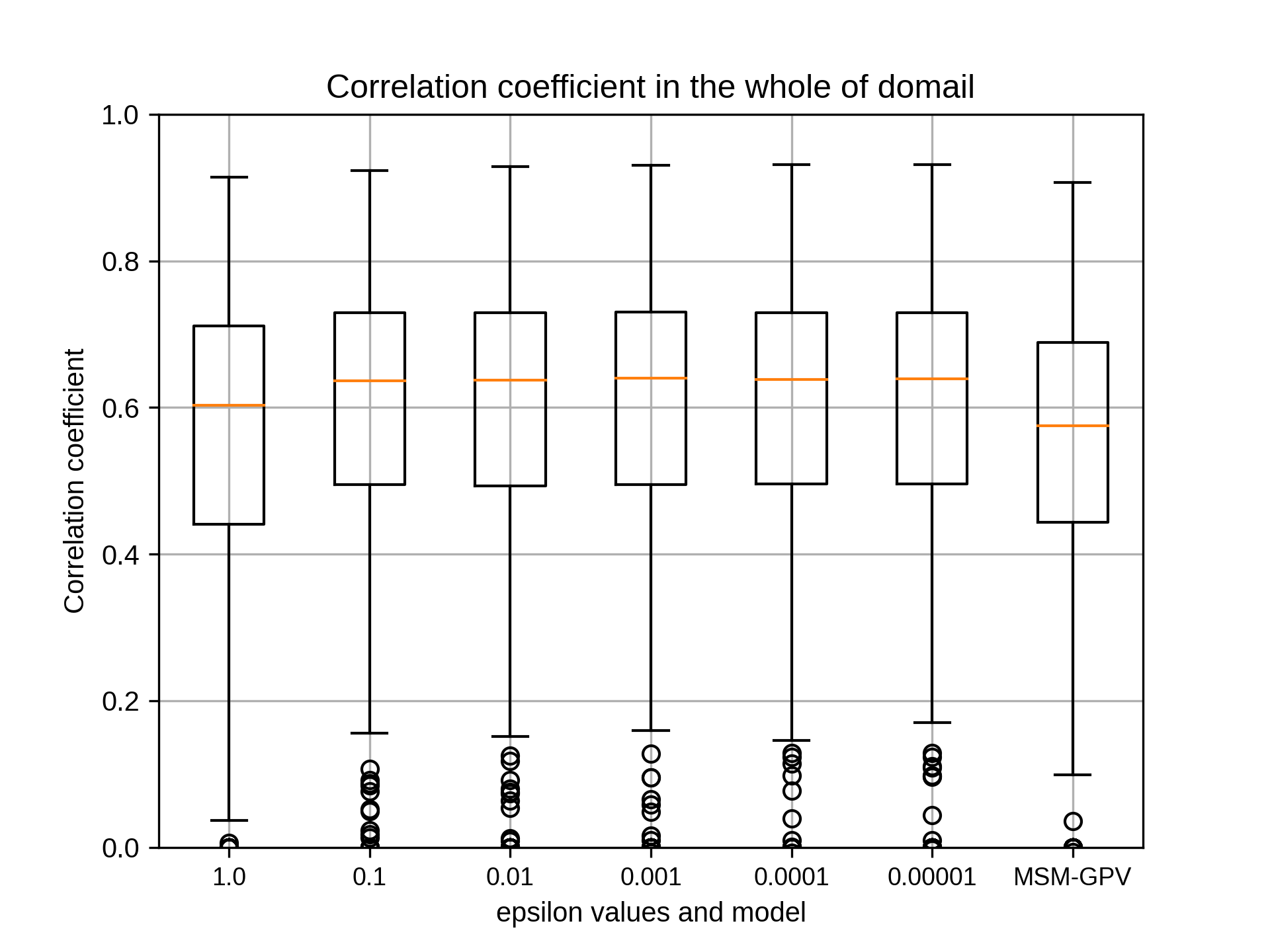

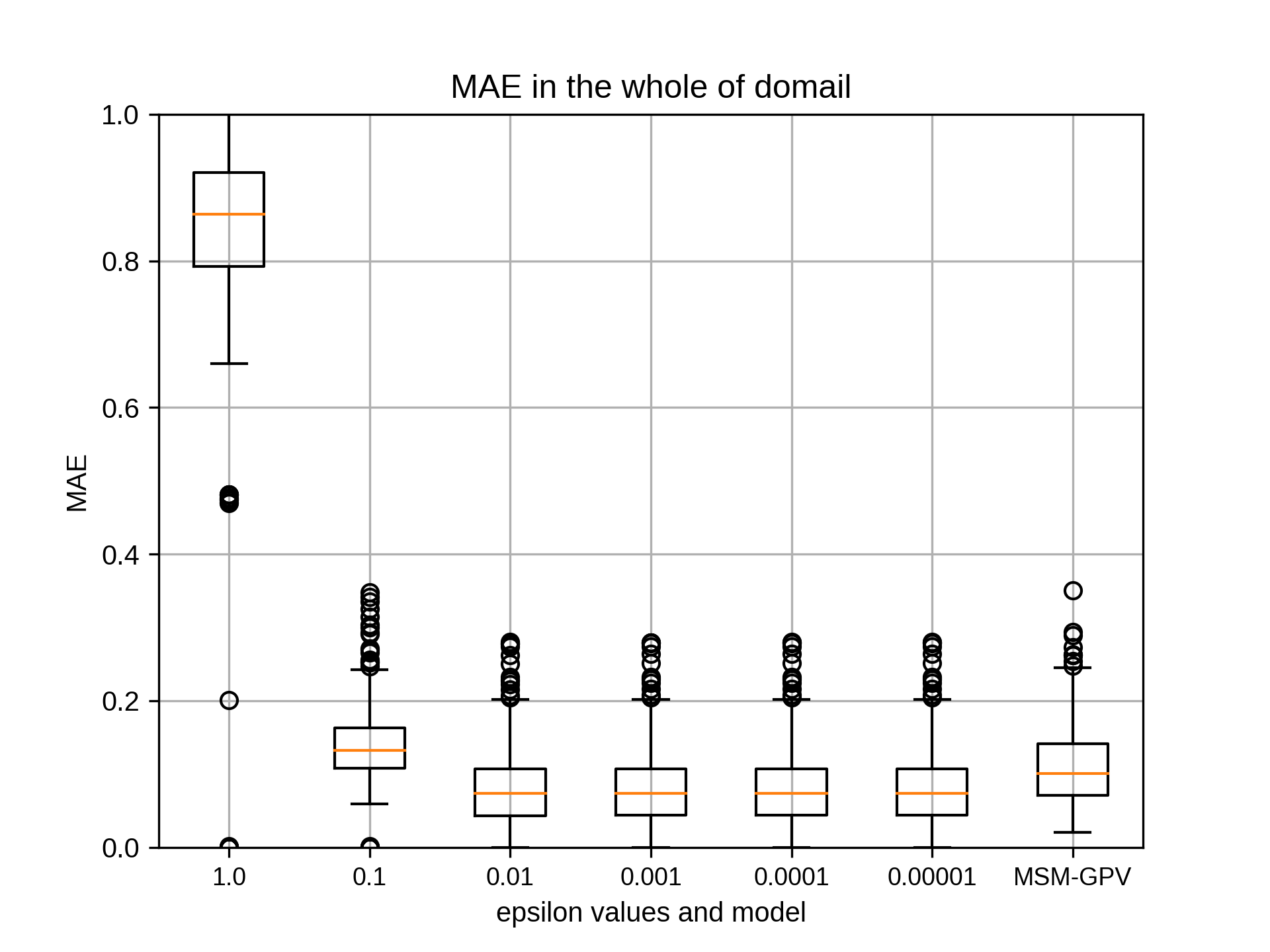

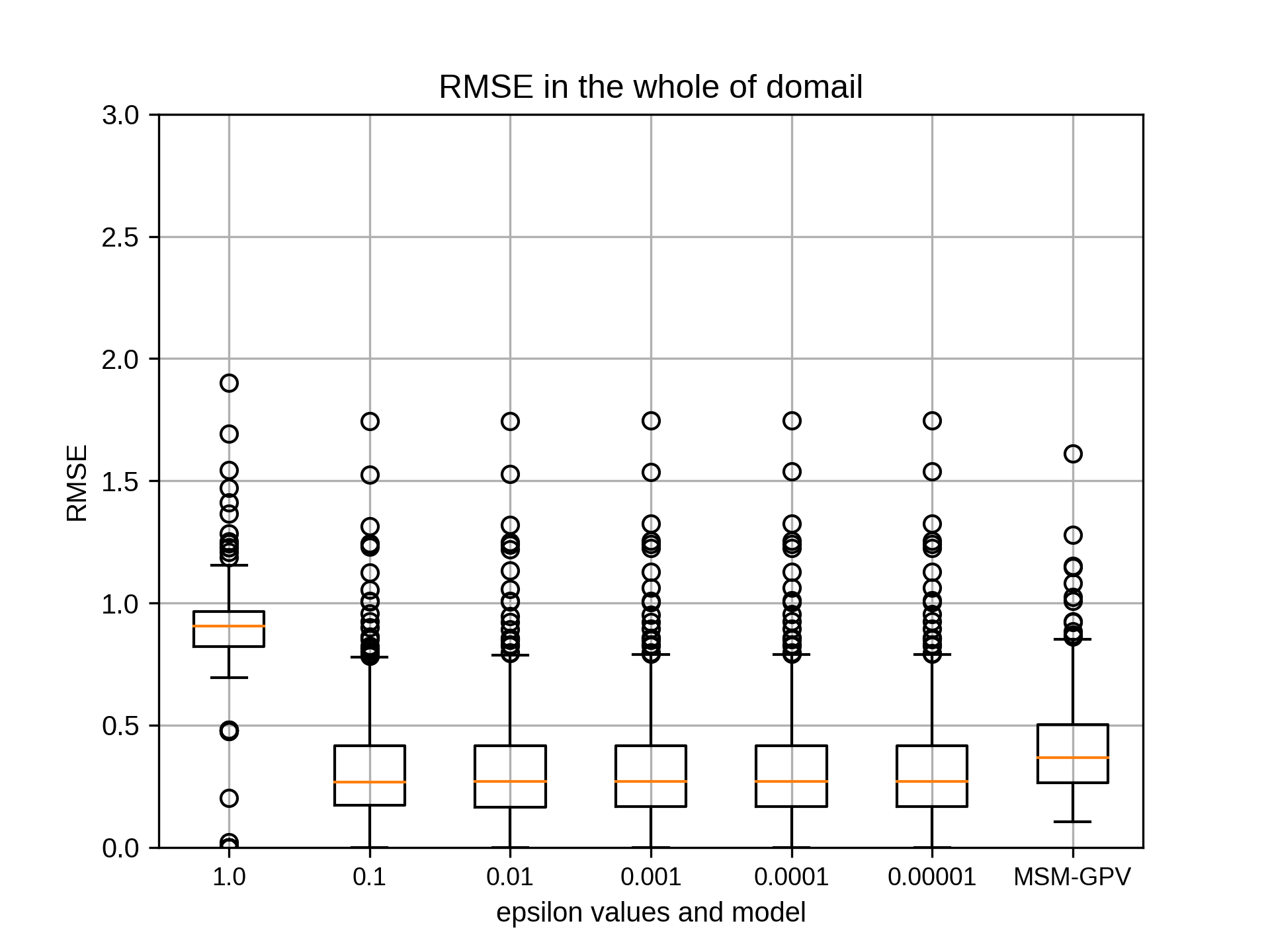

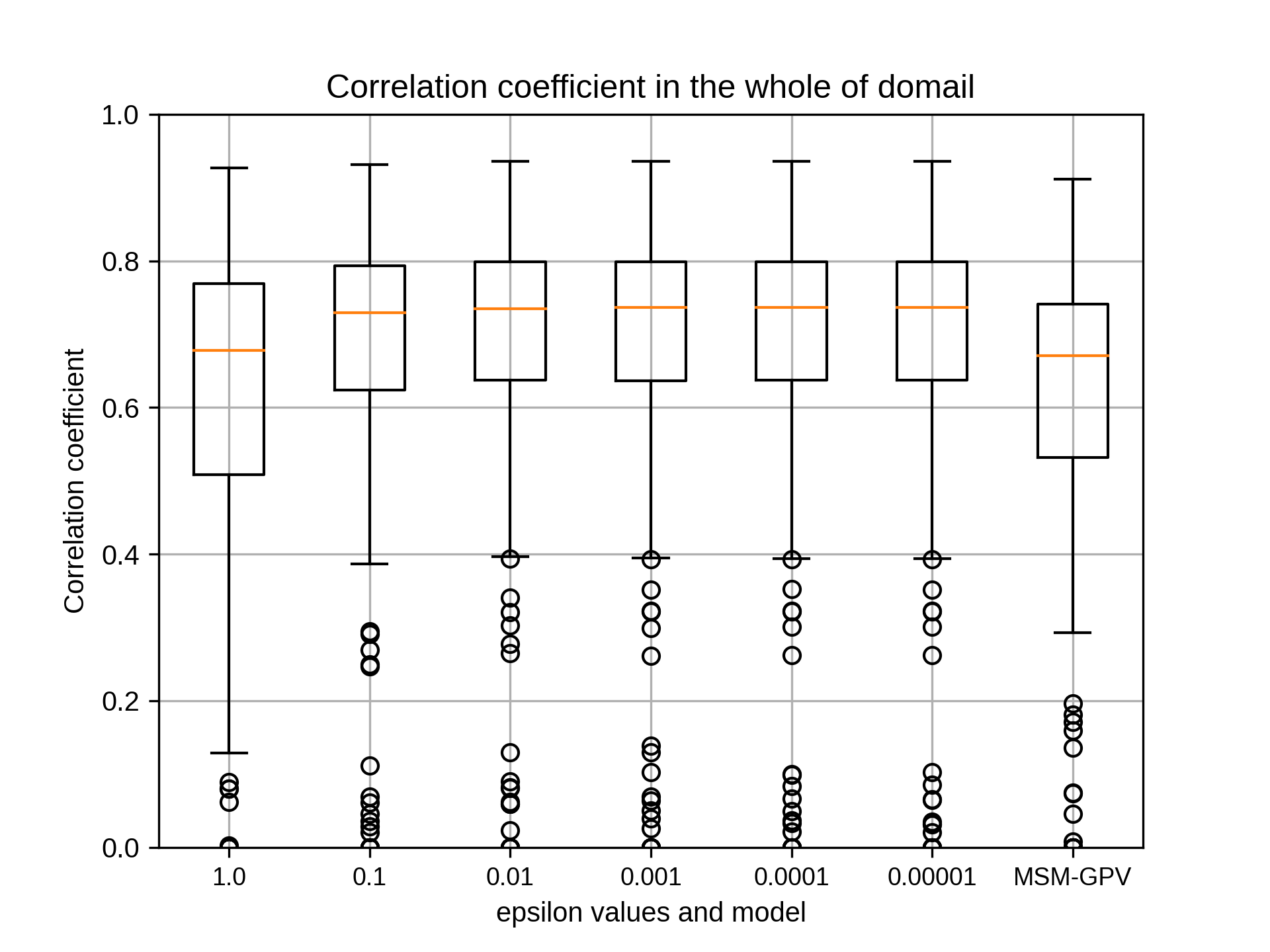

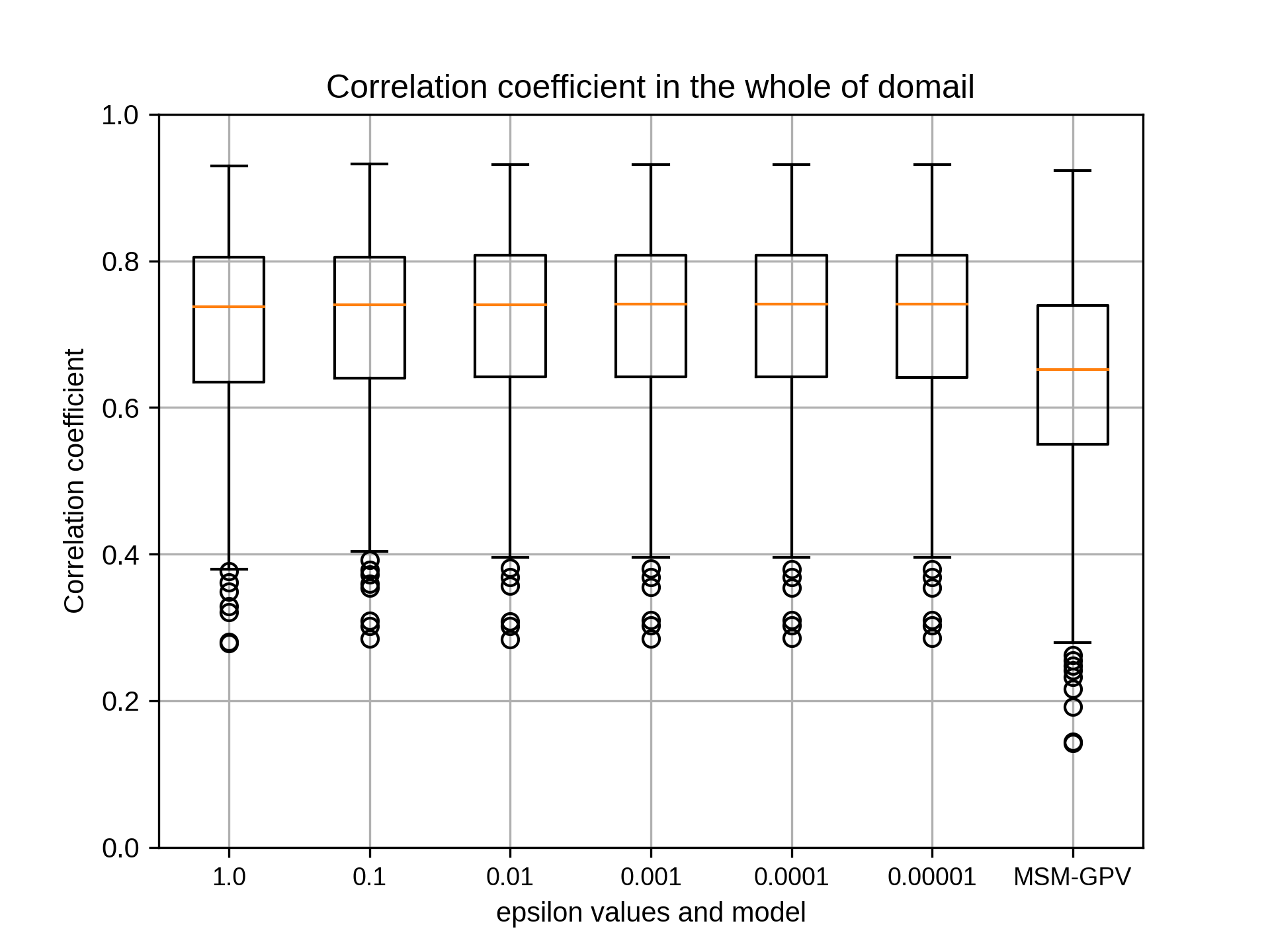

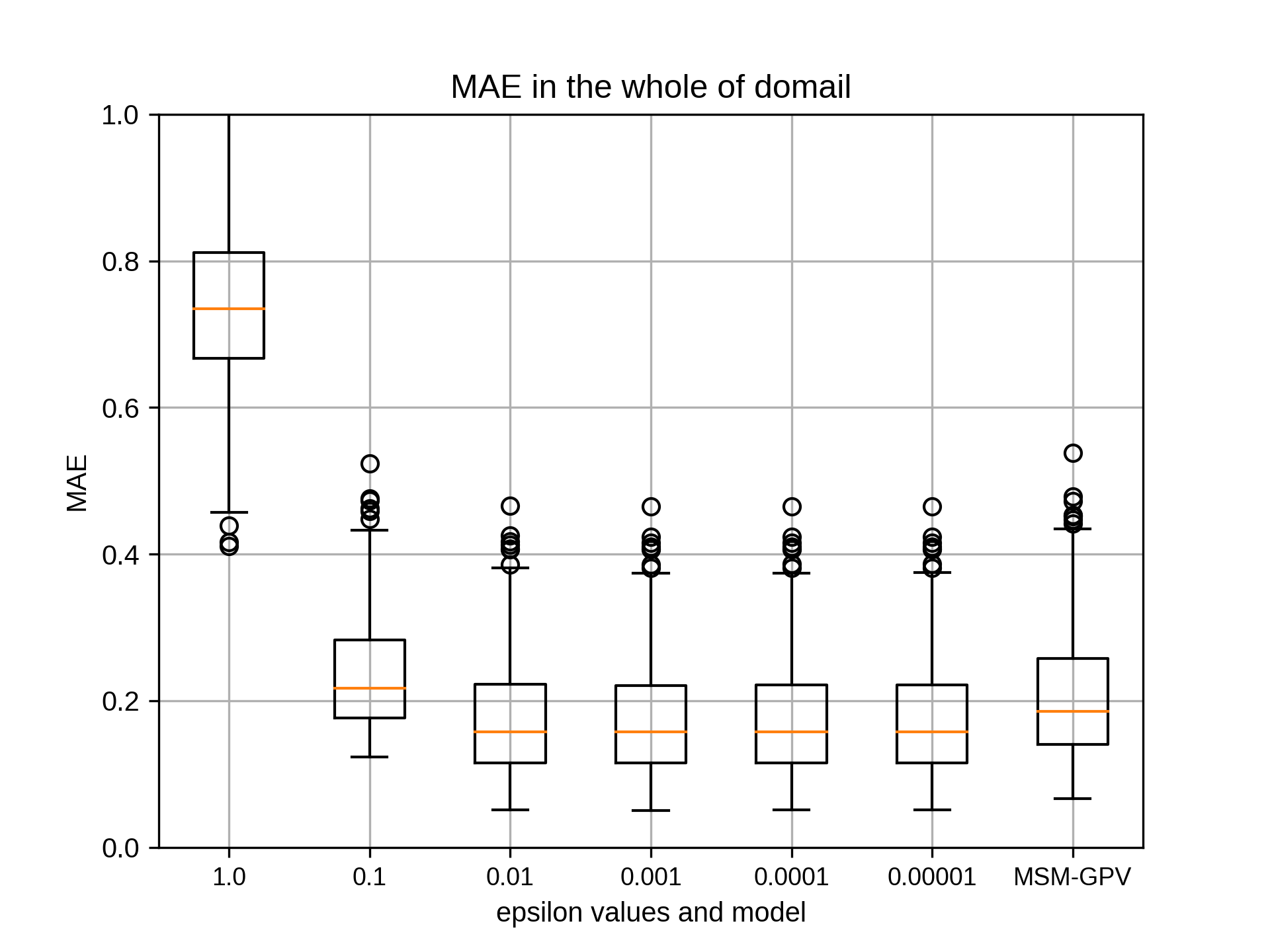

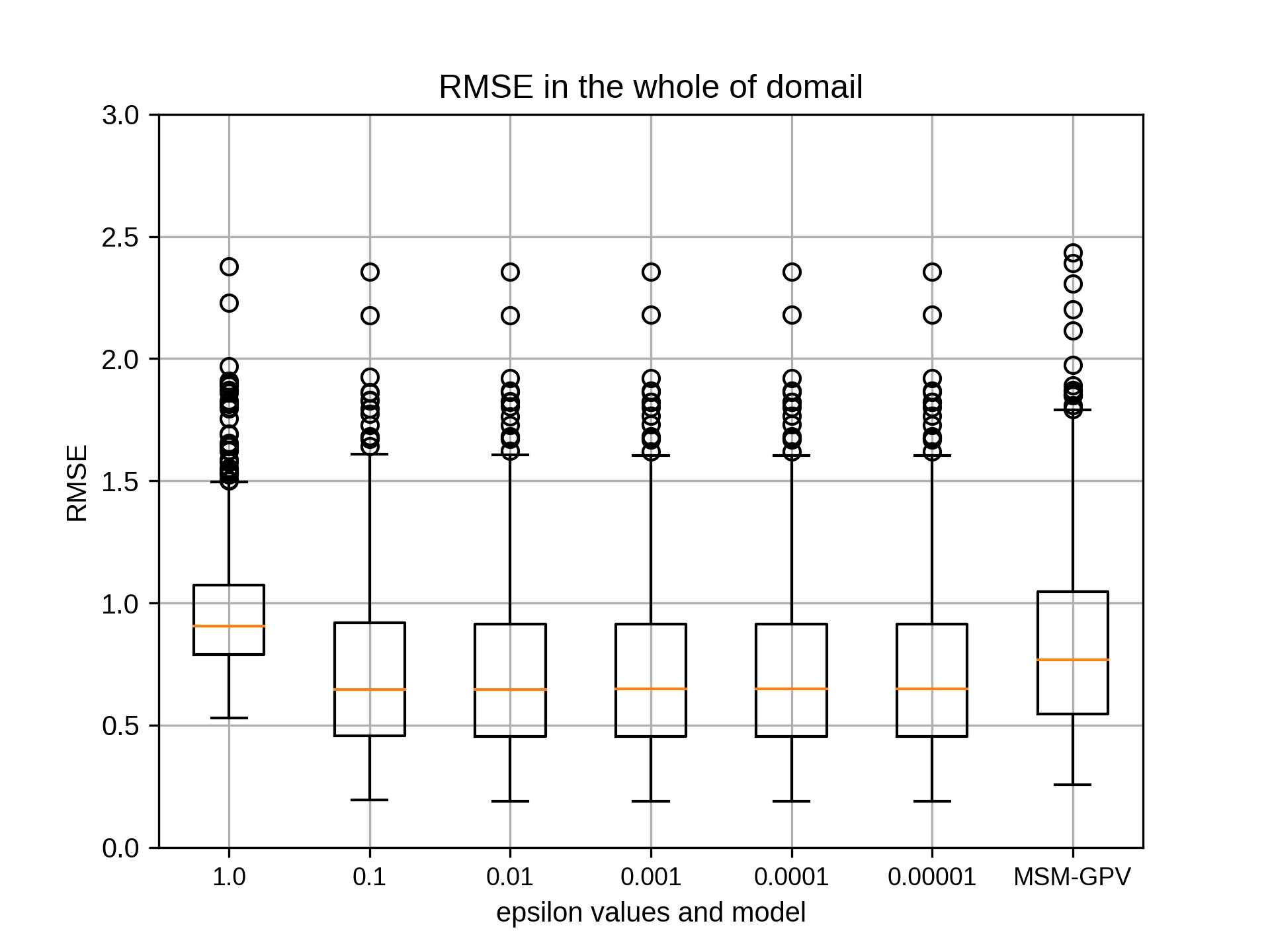

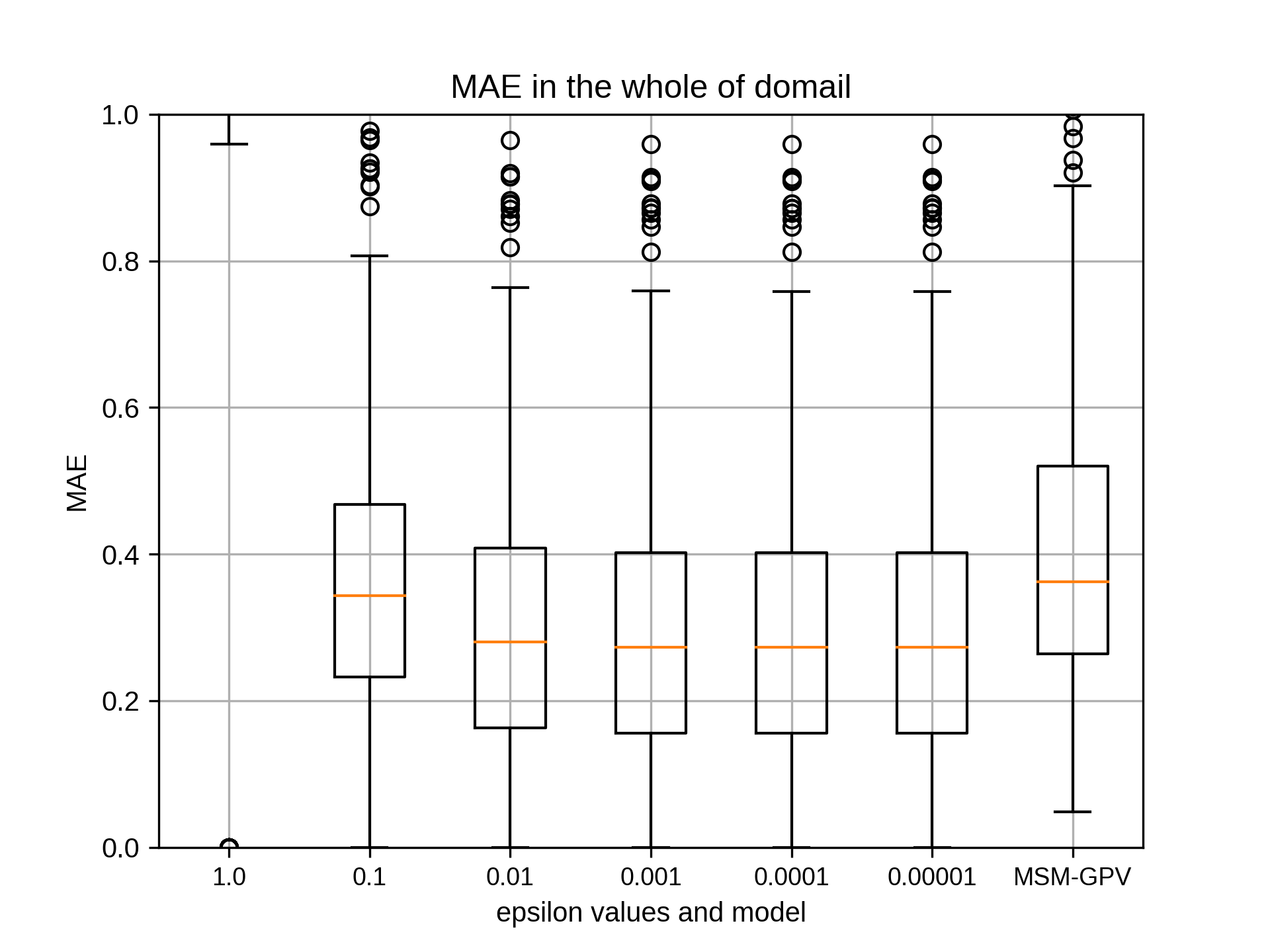

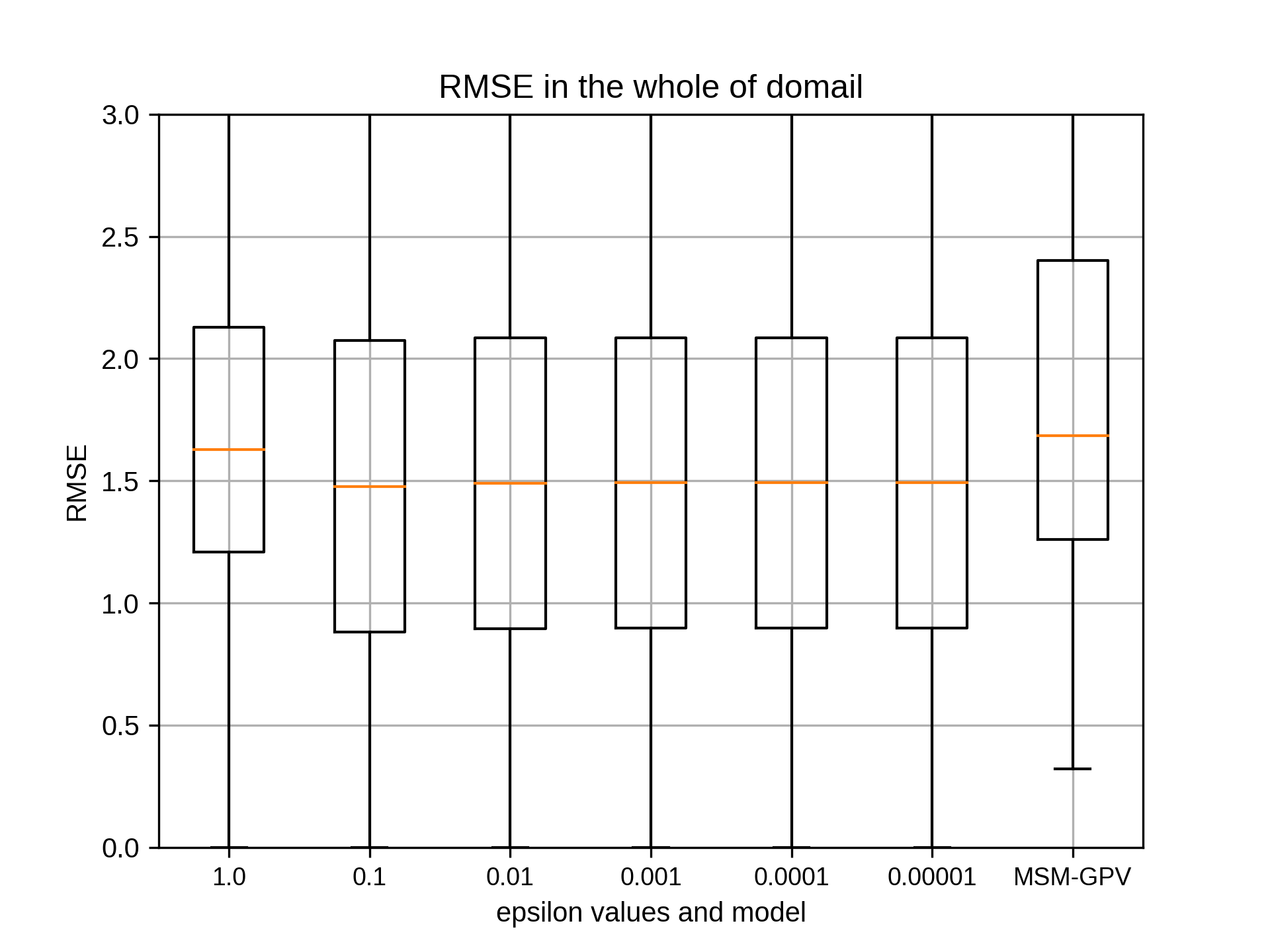

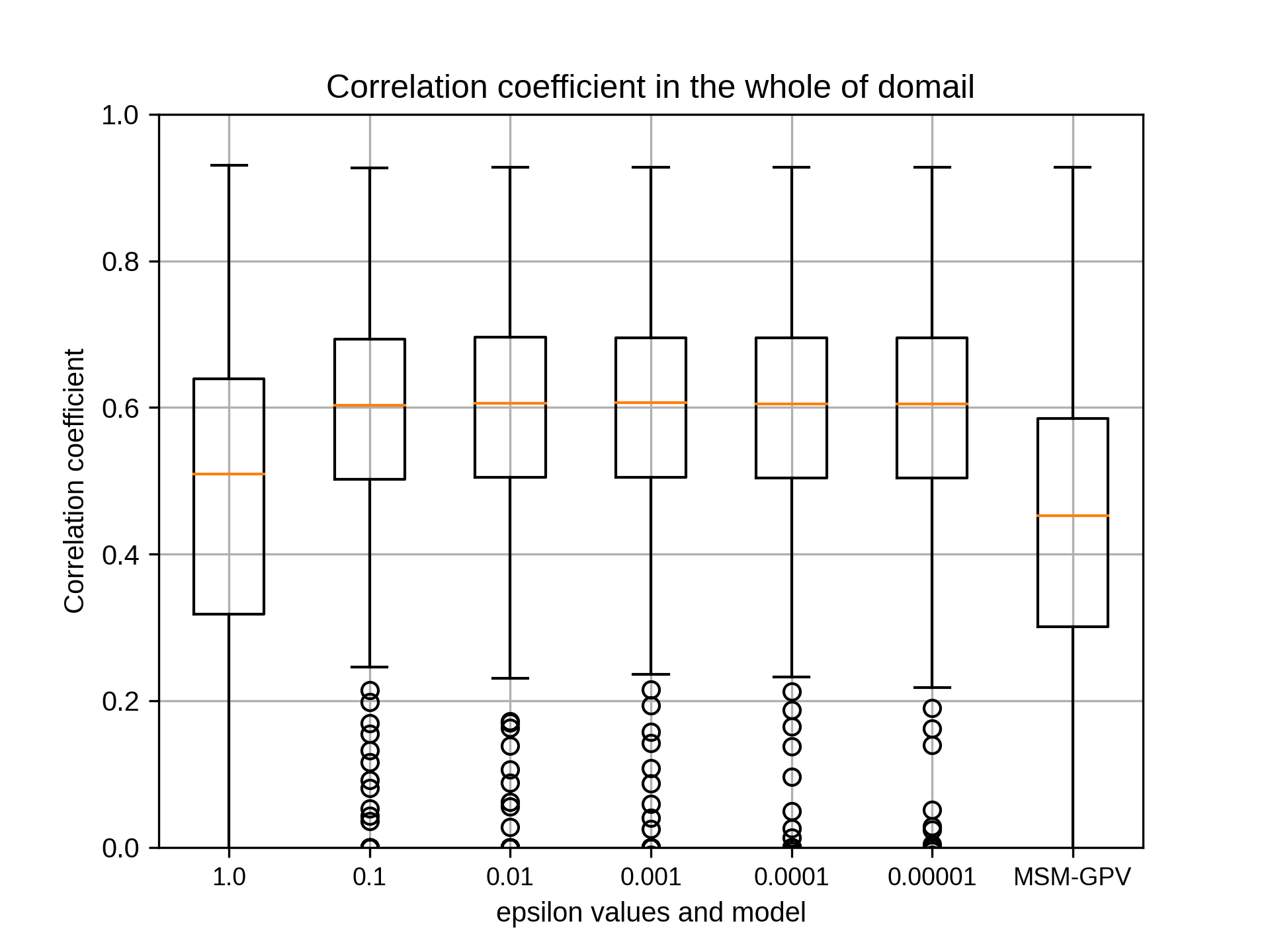

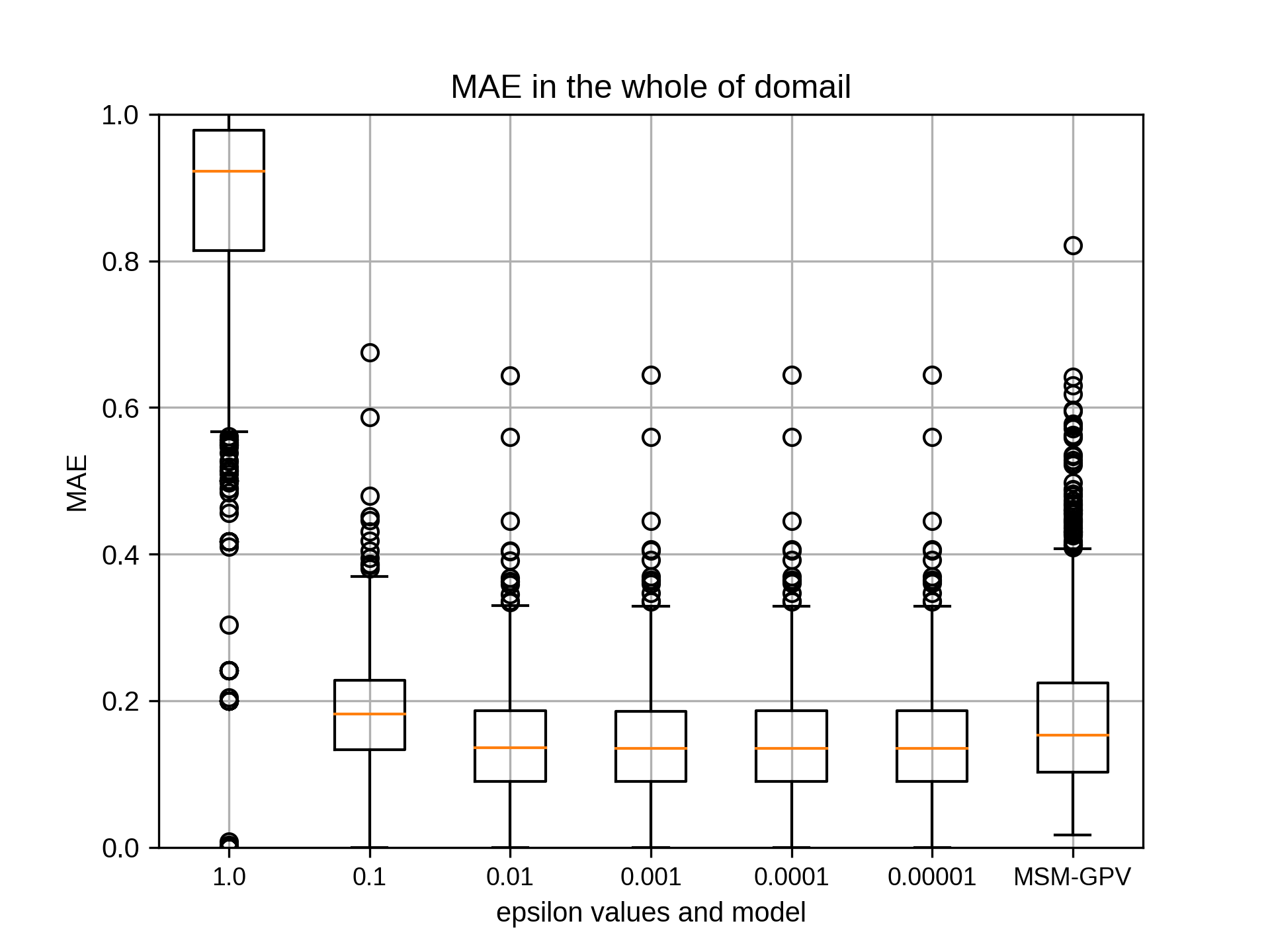

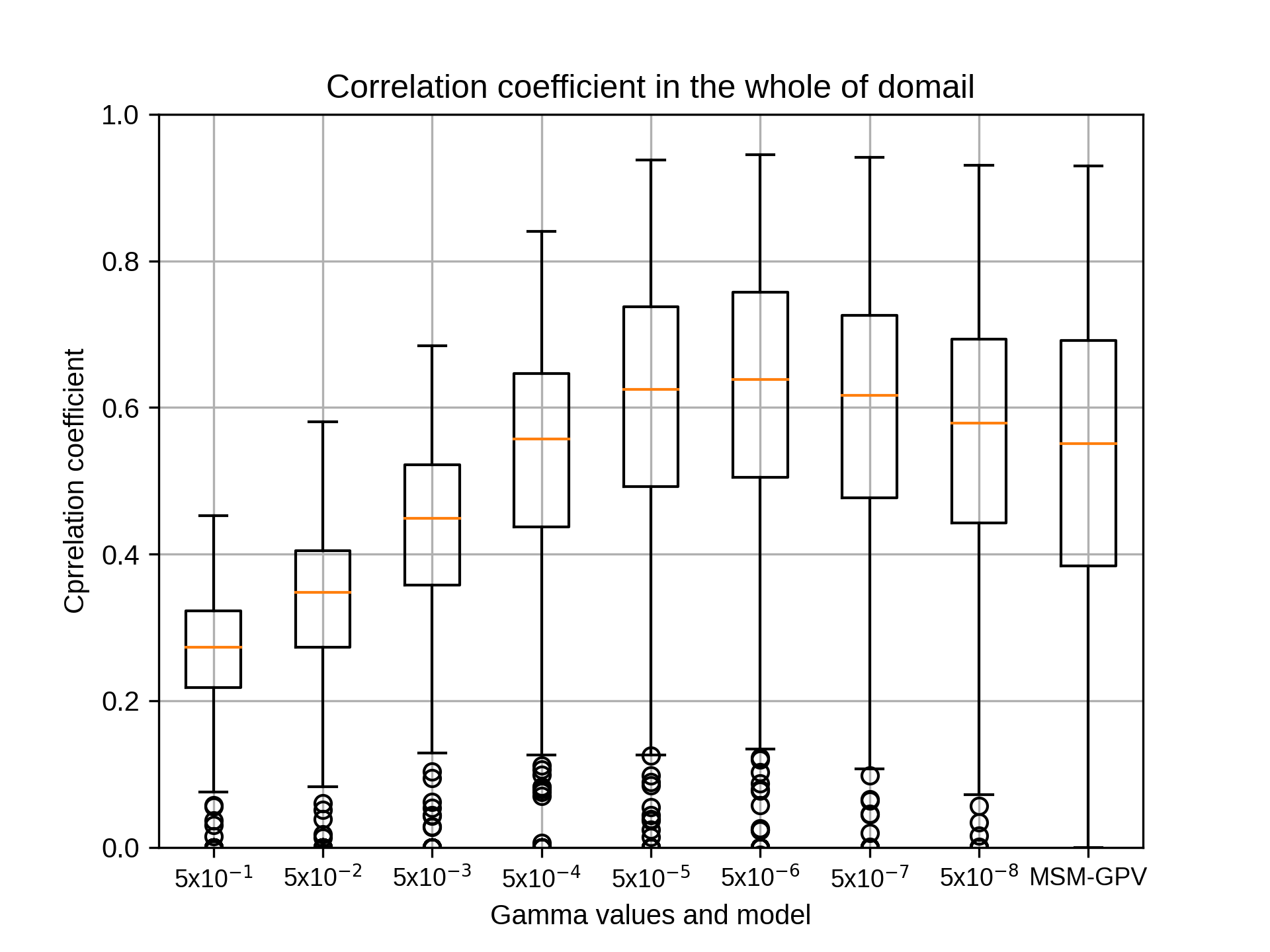

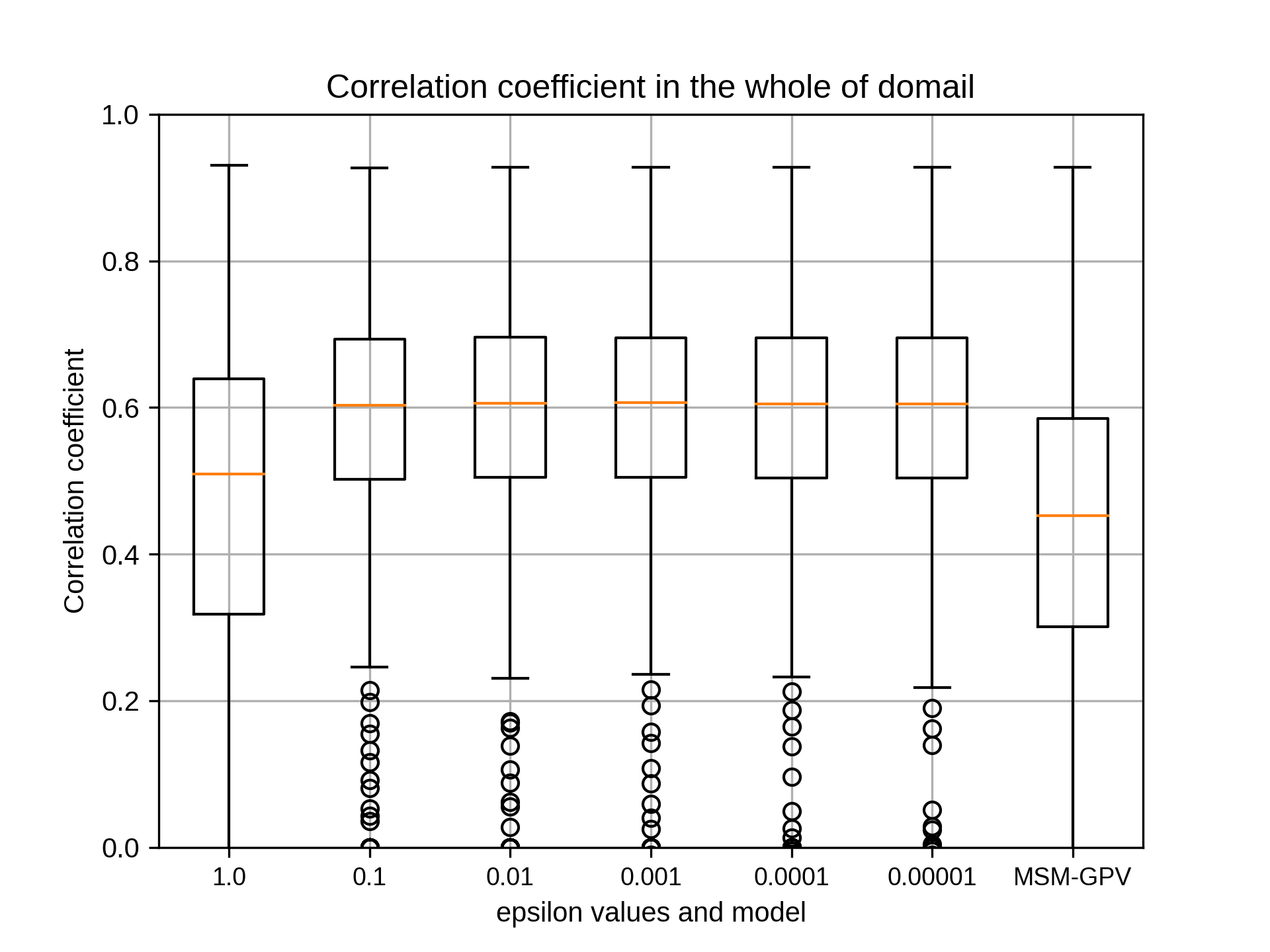

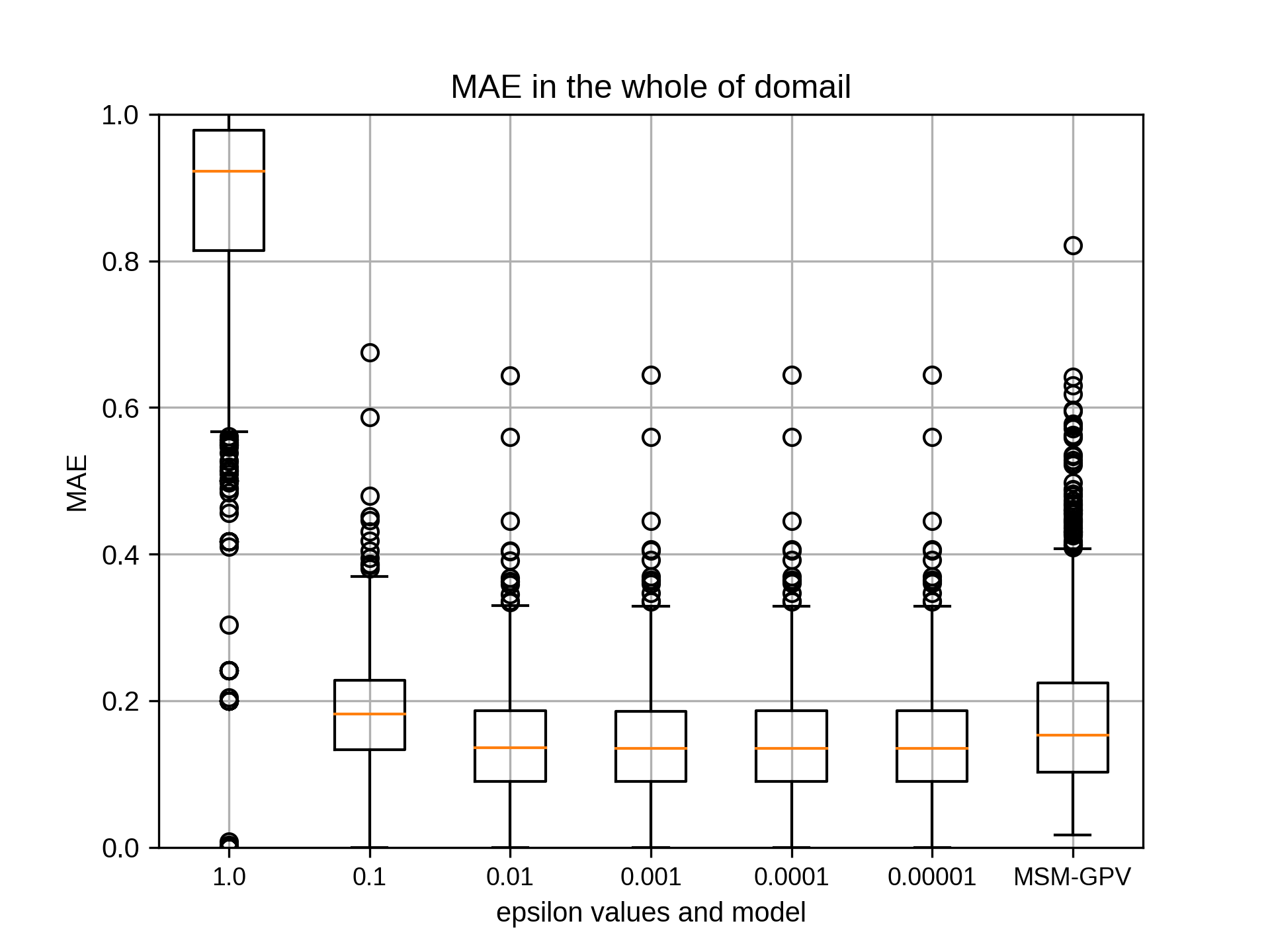

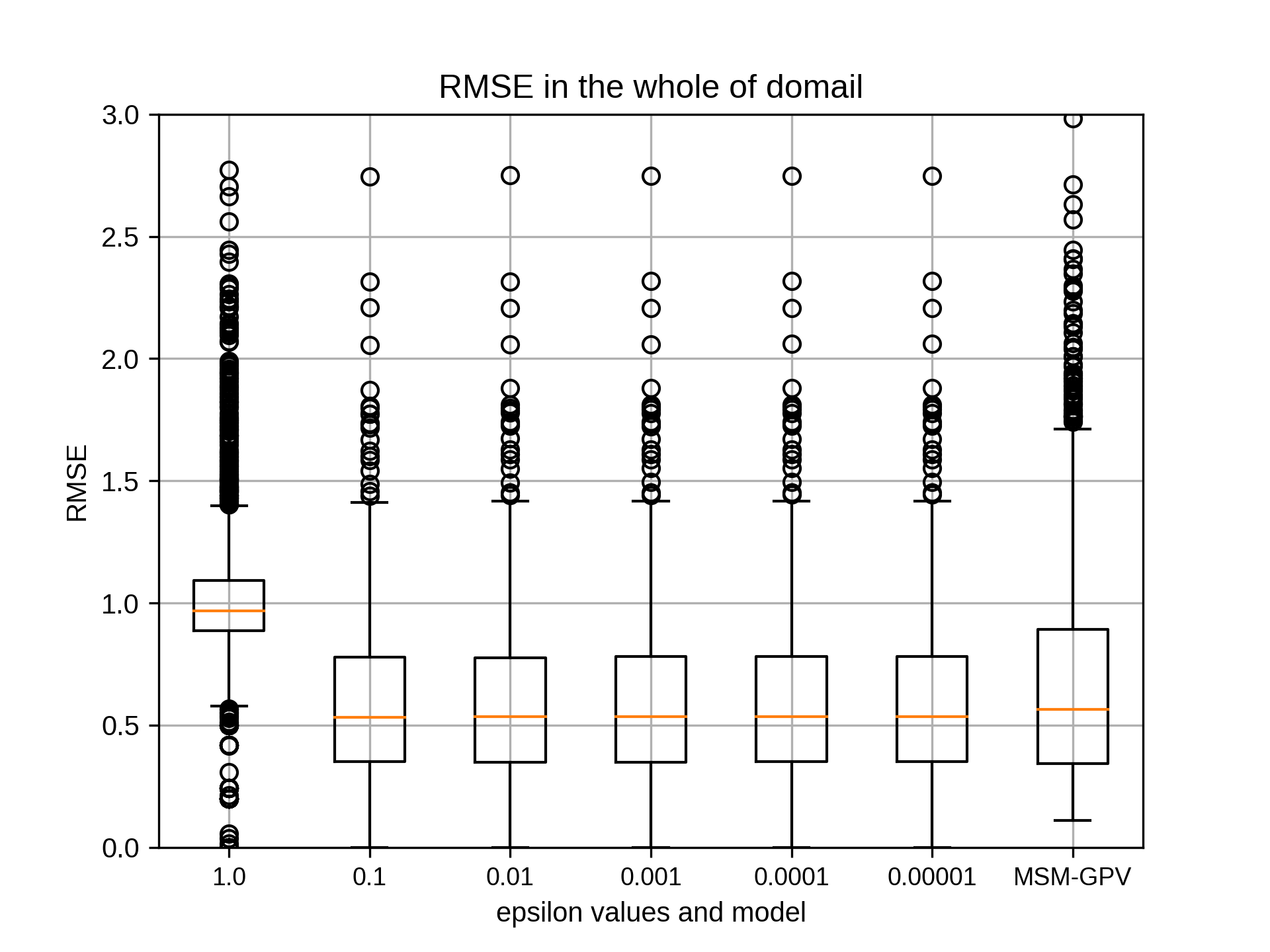

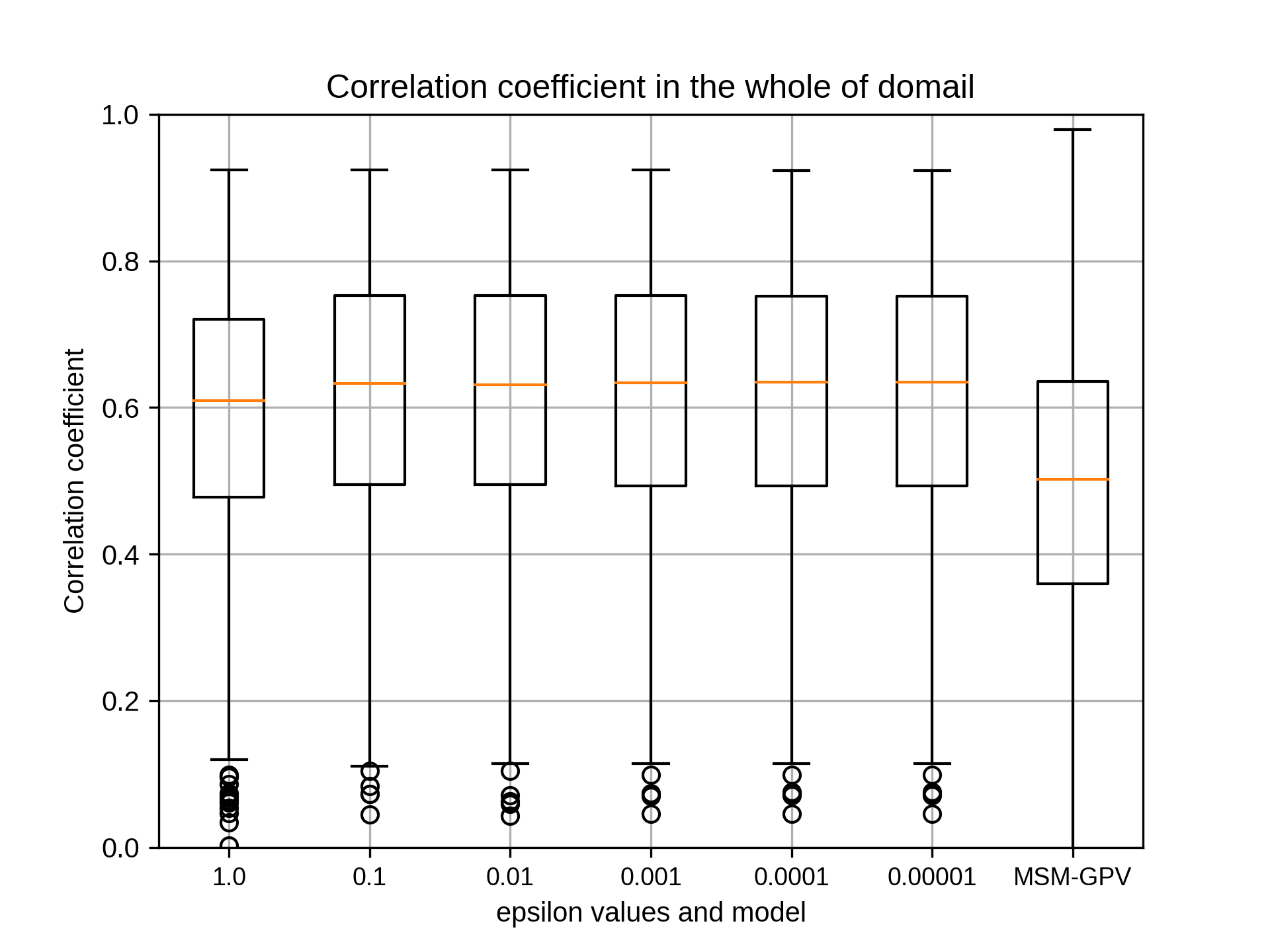

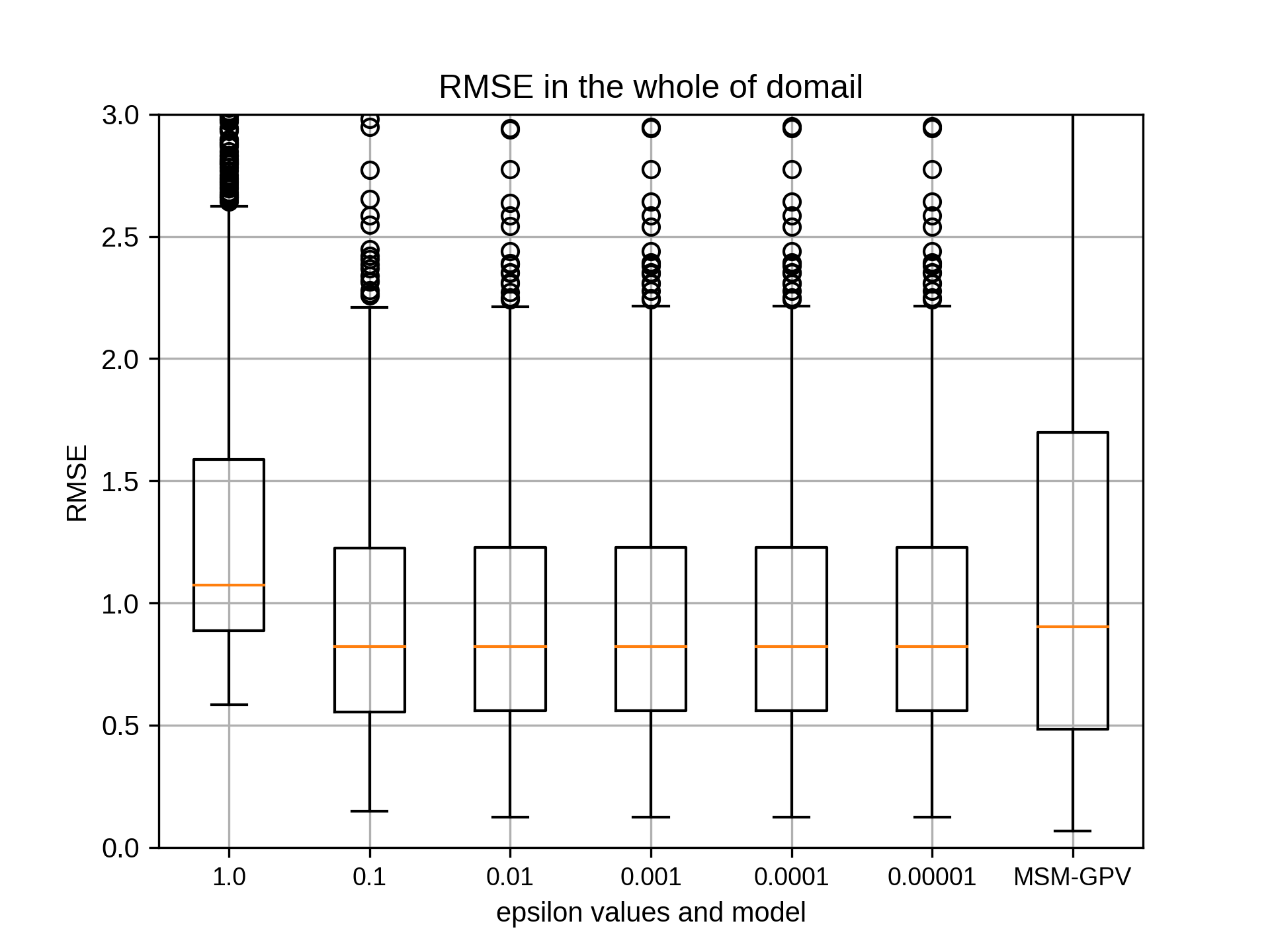

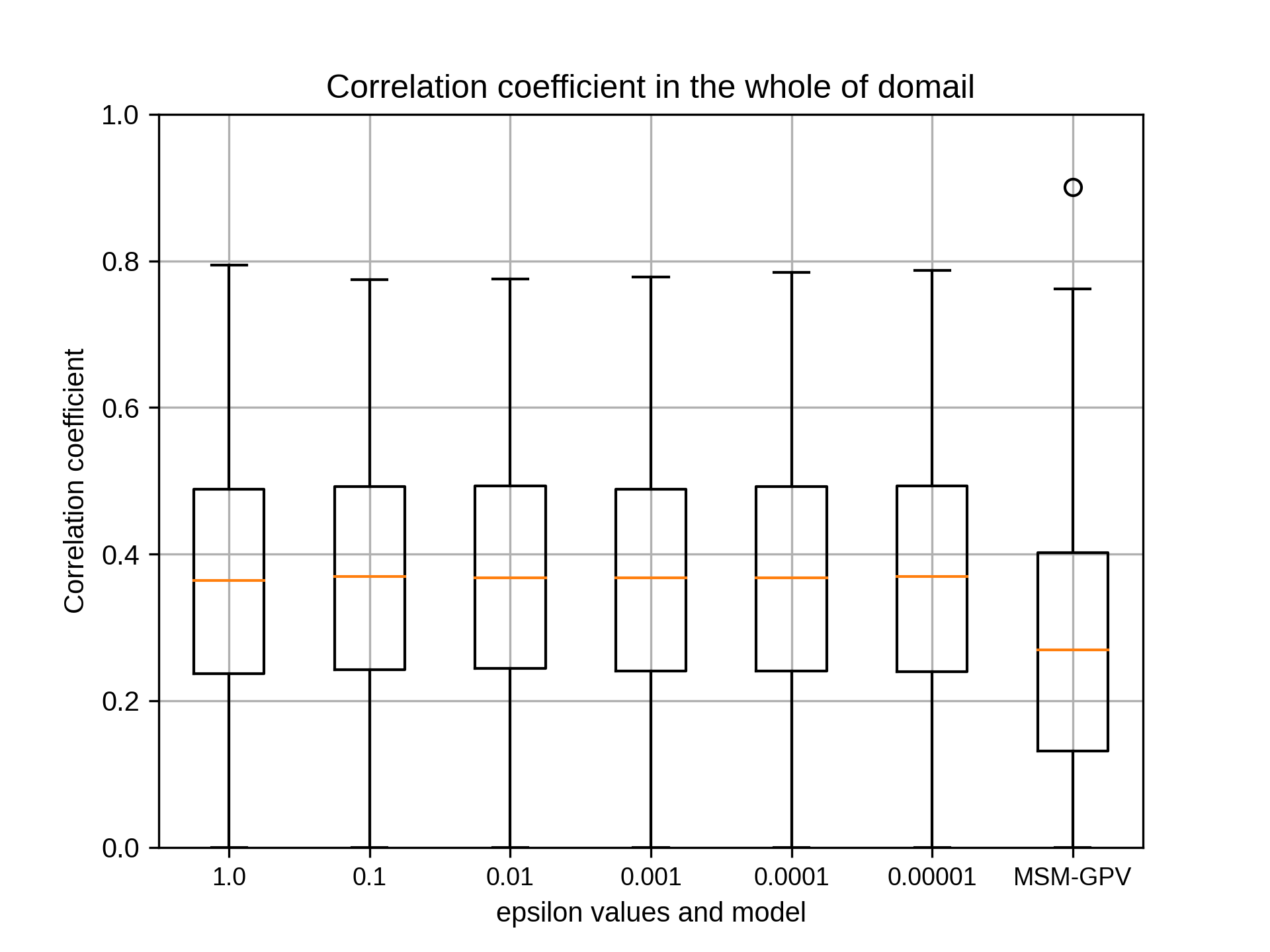

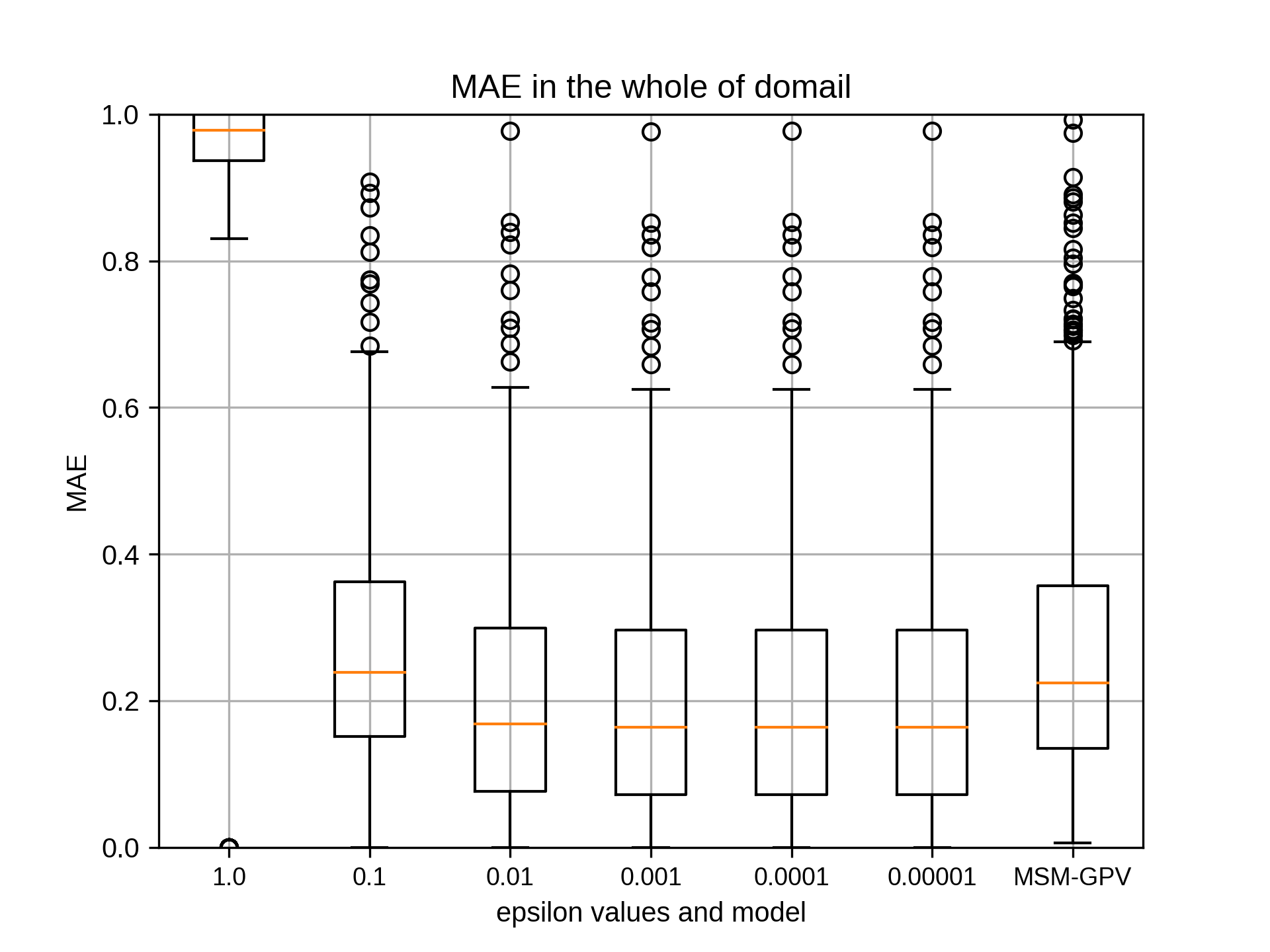

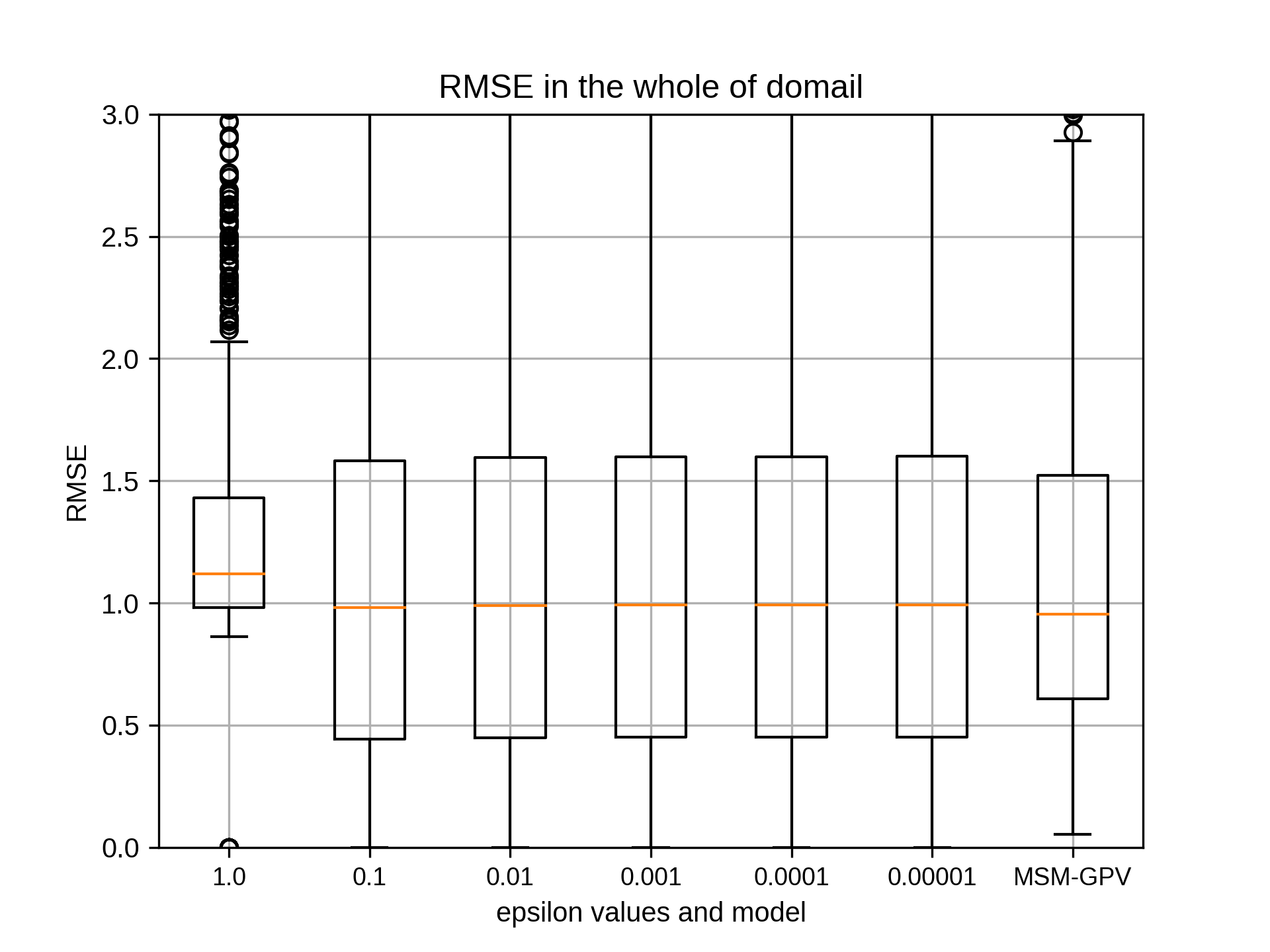

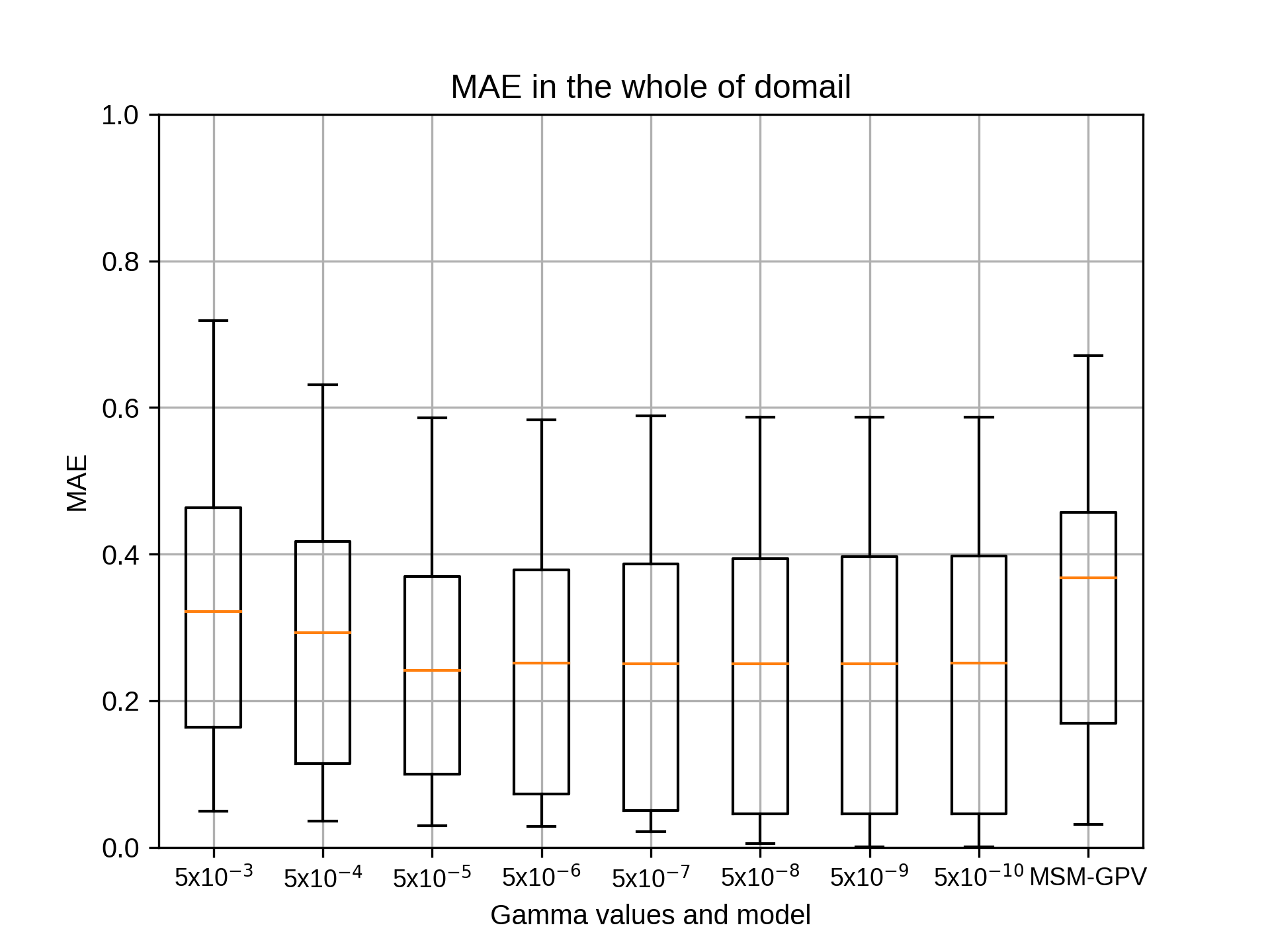

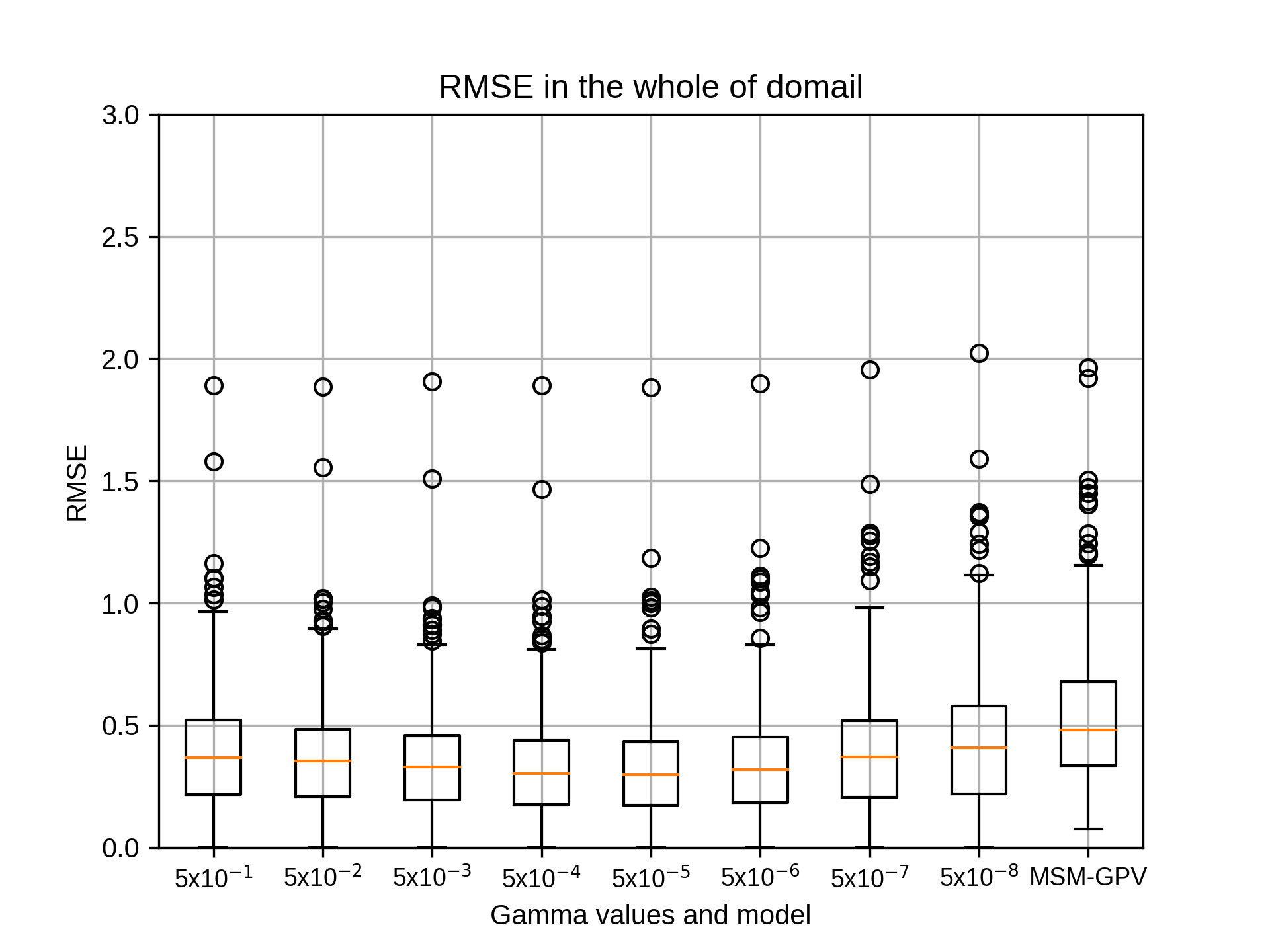

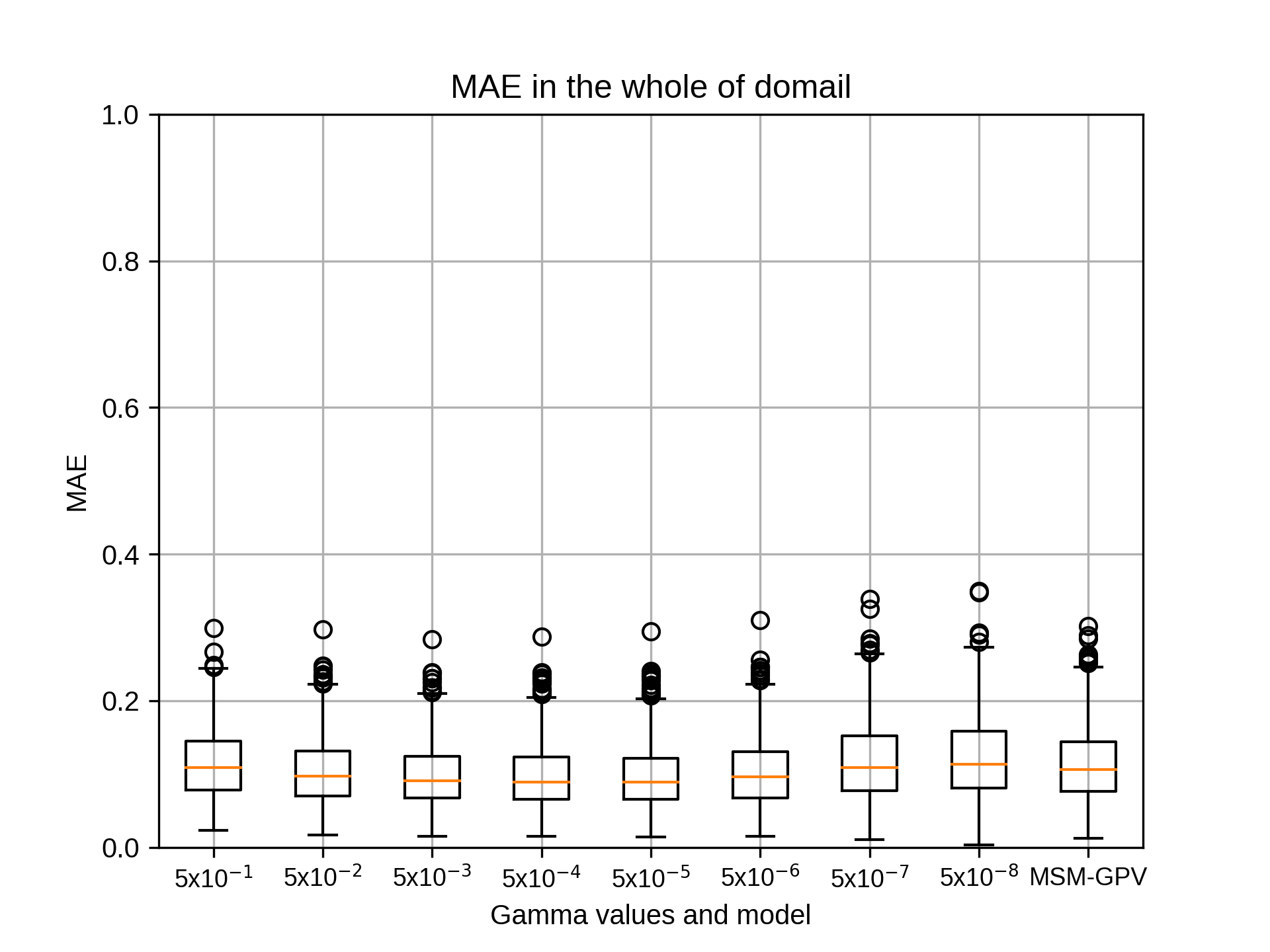

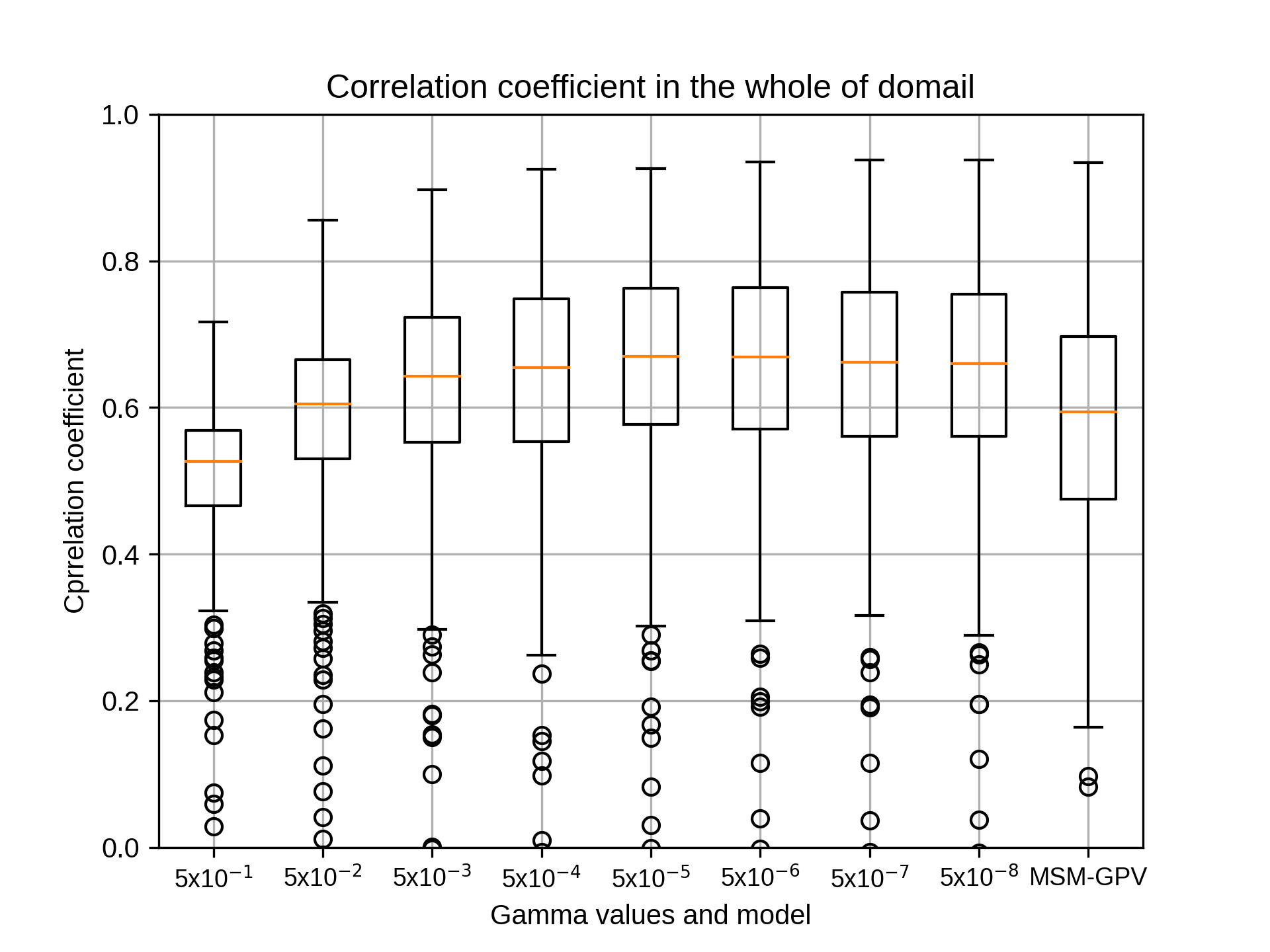

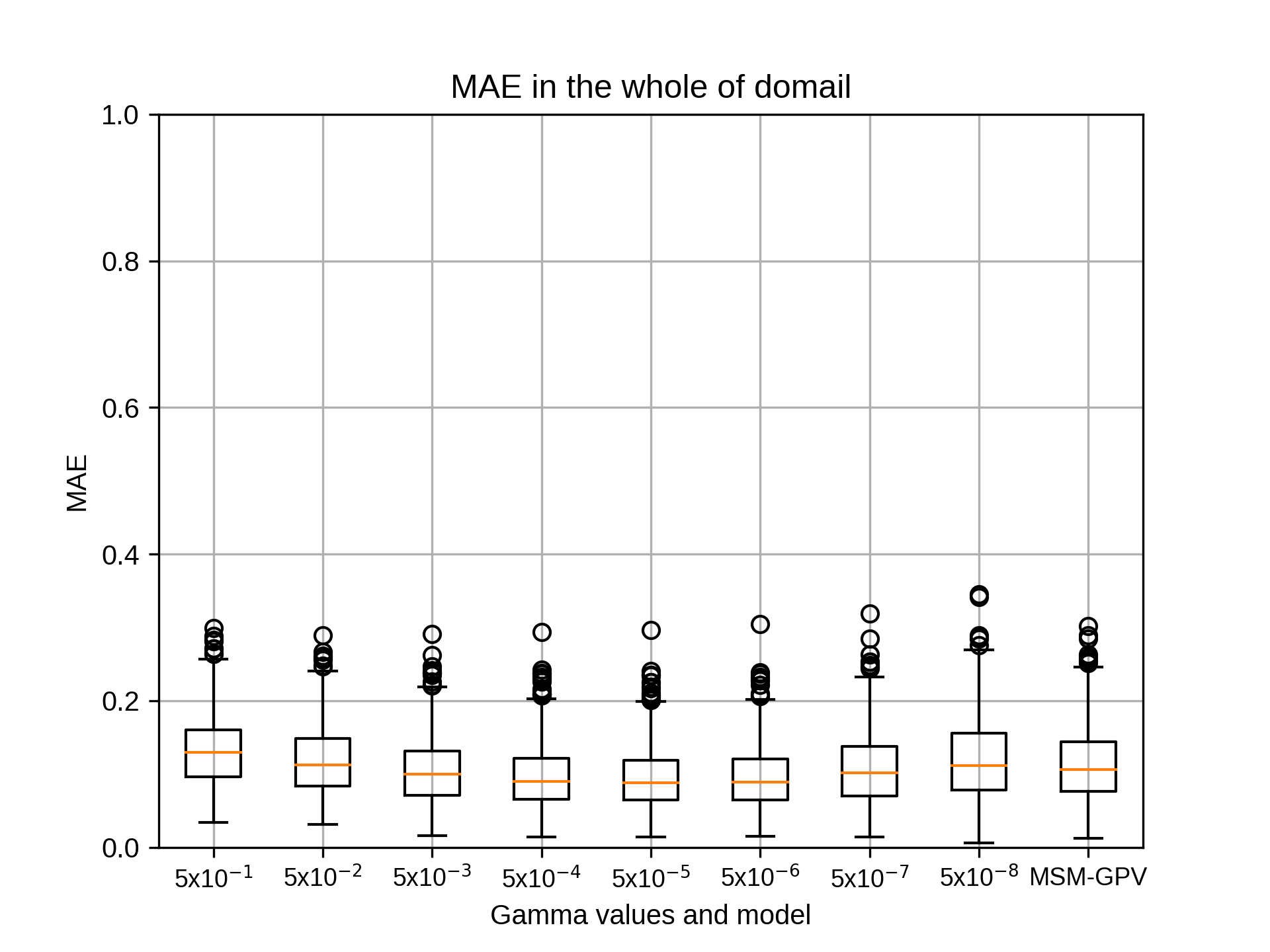

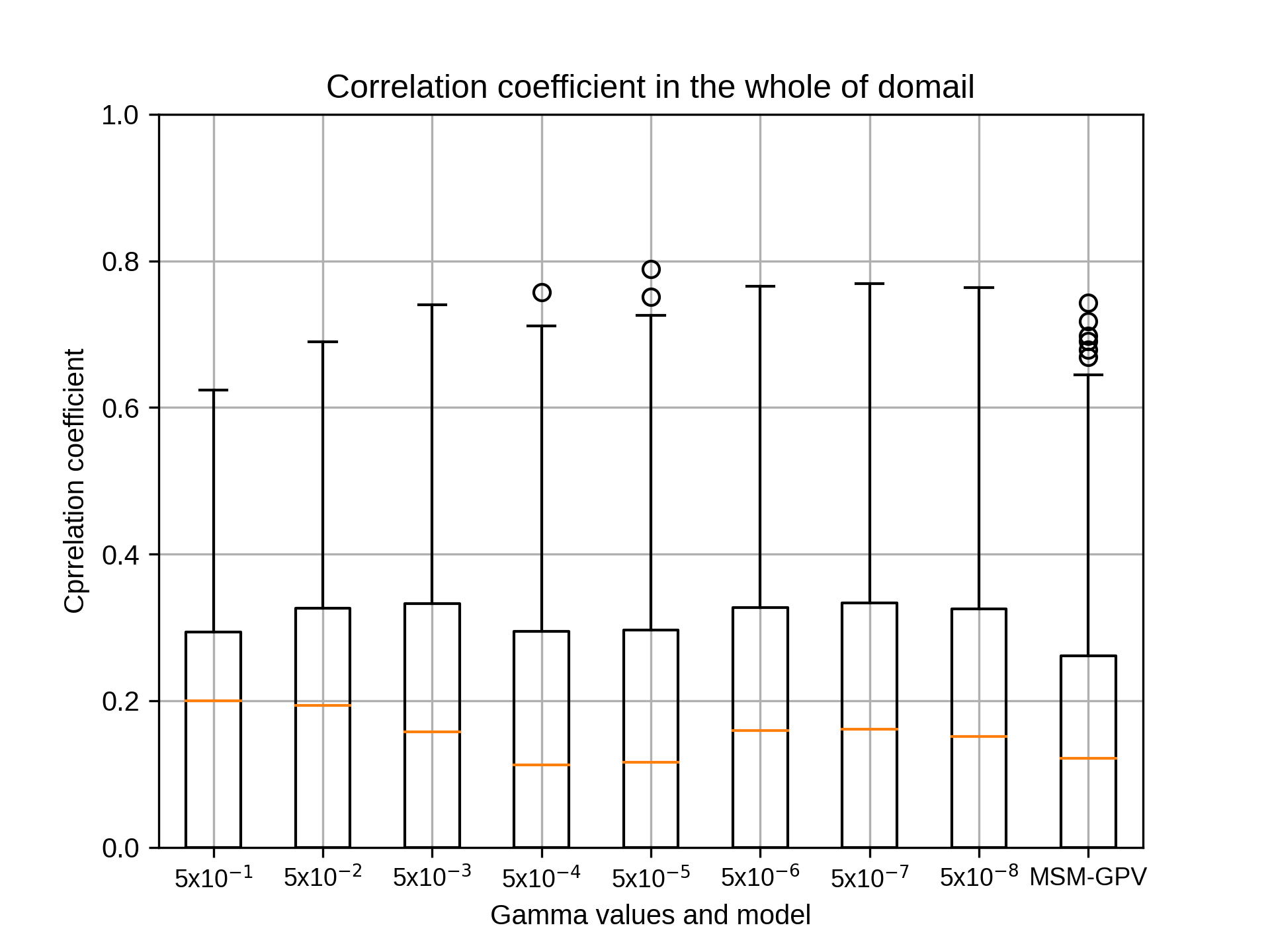

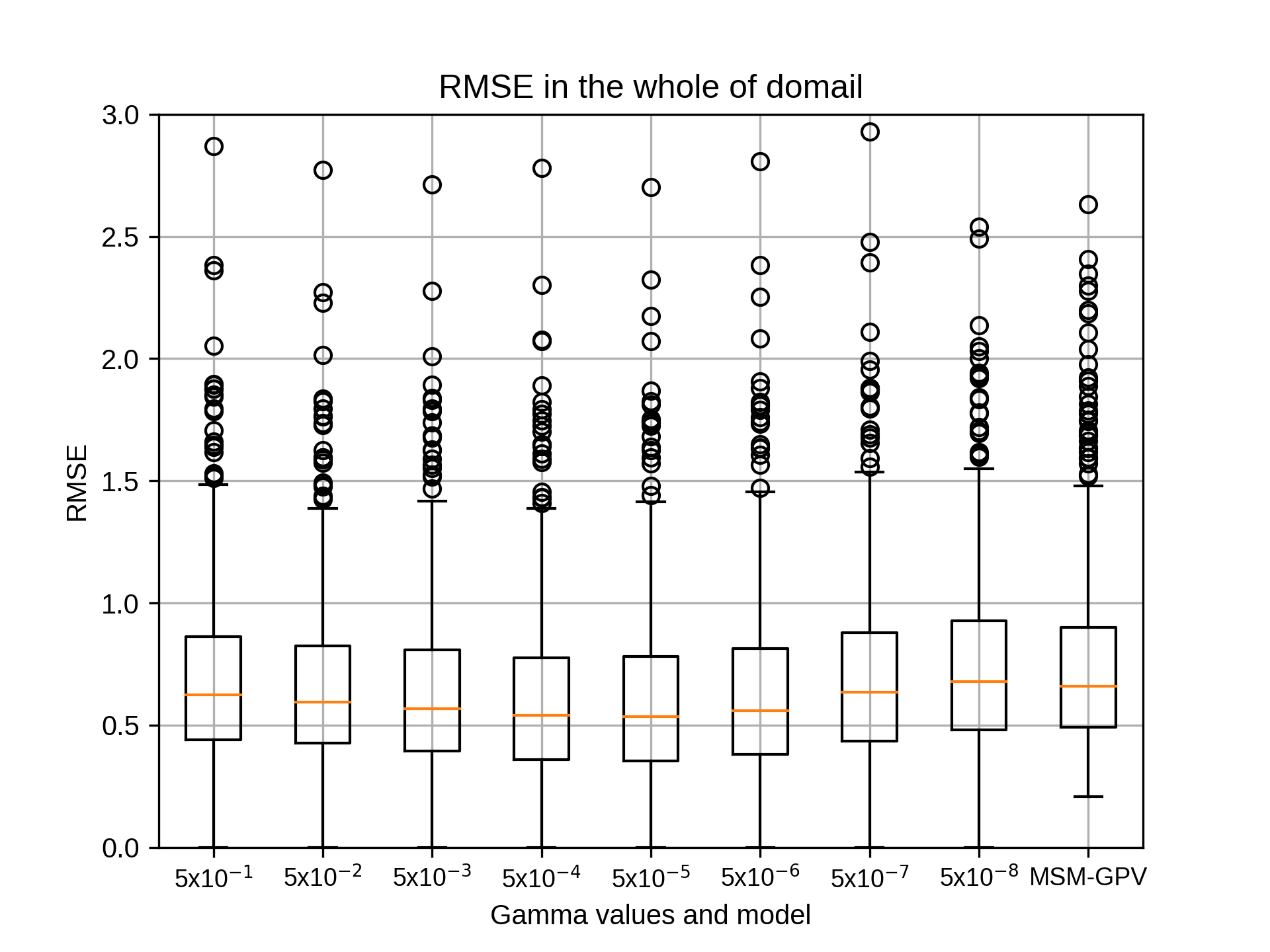

epsilonにつきまして結果が出ましたのでご報告いたします。

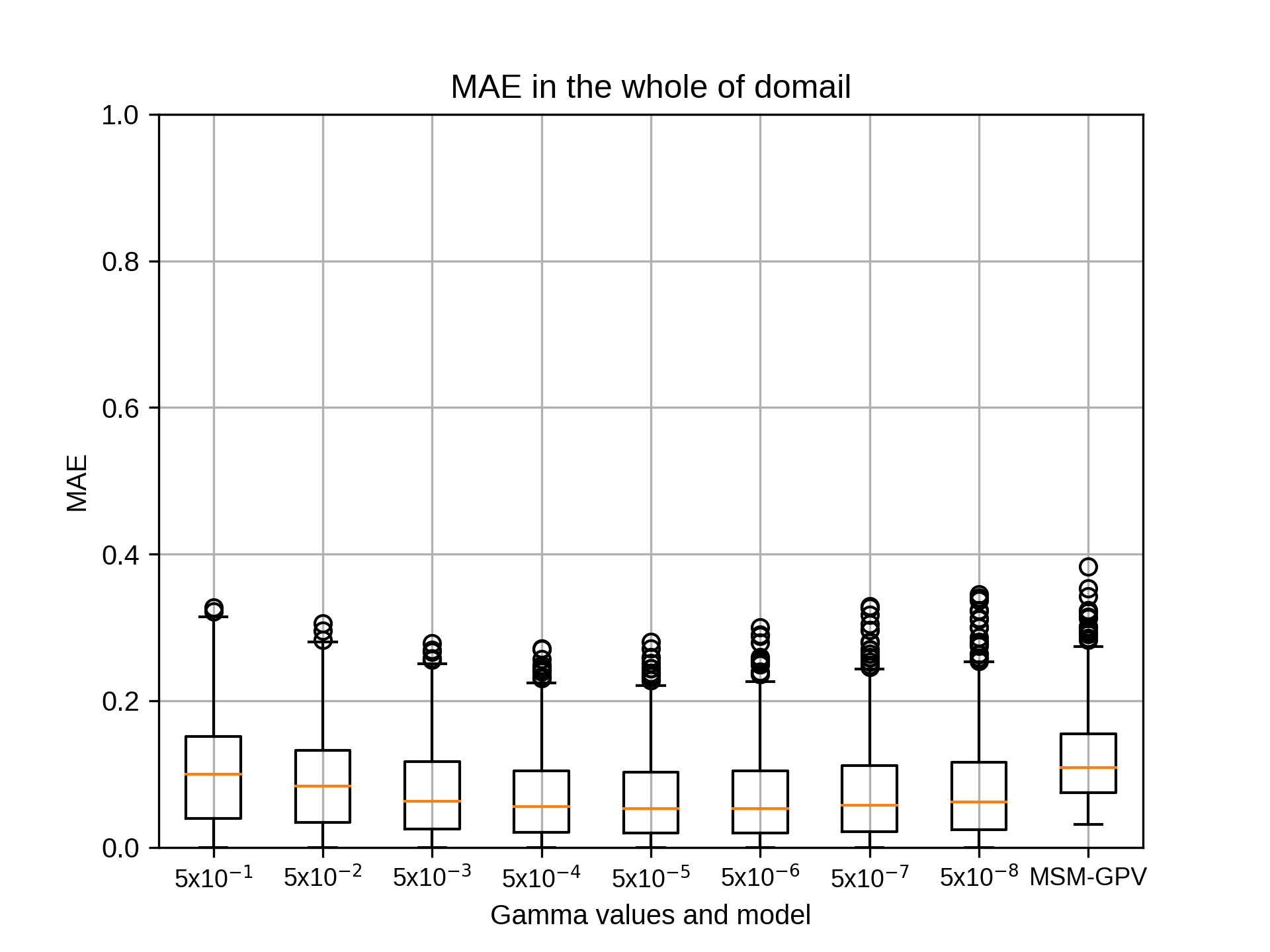

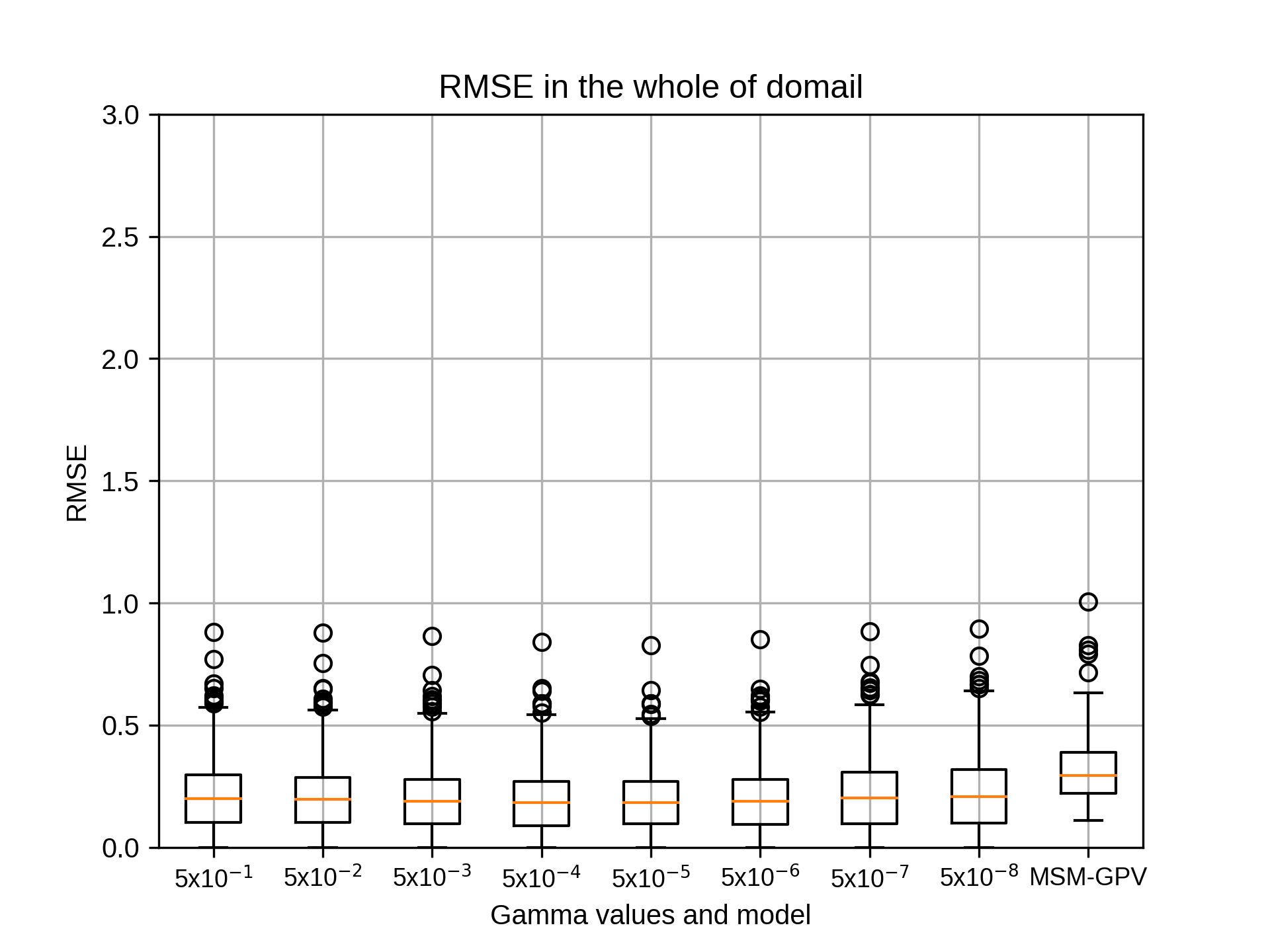

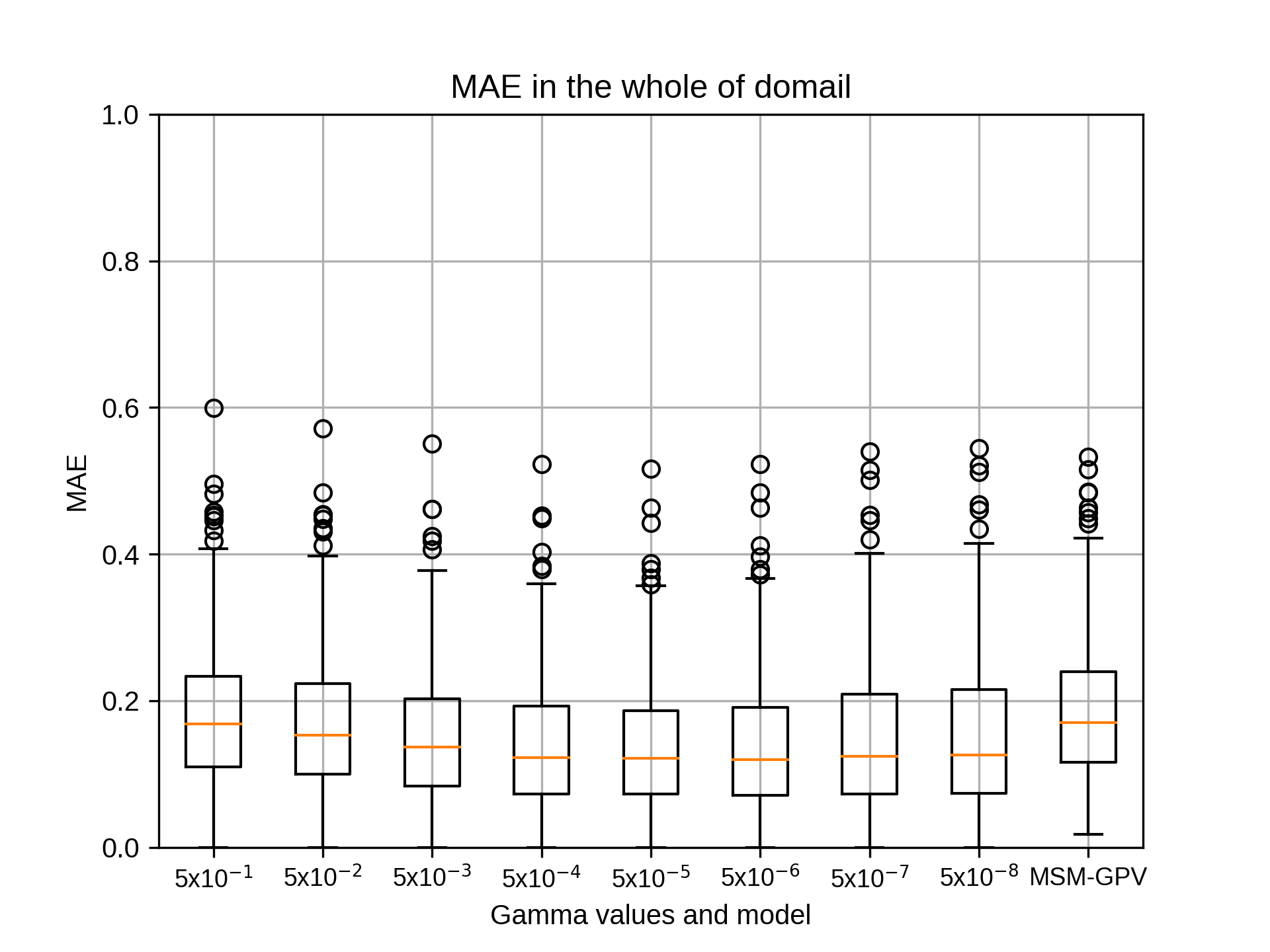

2007~2018年の7月の結果は添付のエクセルファイルのとおりです。

epsilonは変化させても相関係数の中央値はほとんど変わりませんでした。

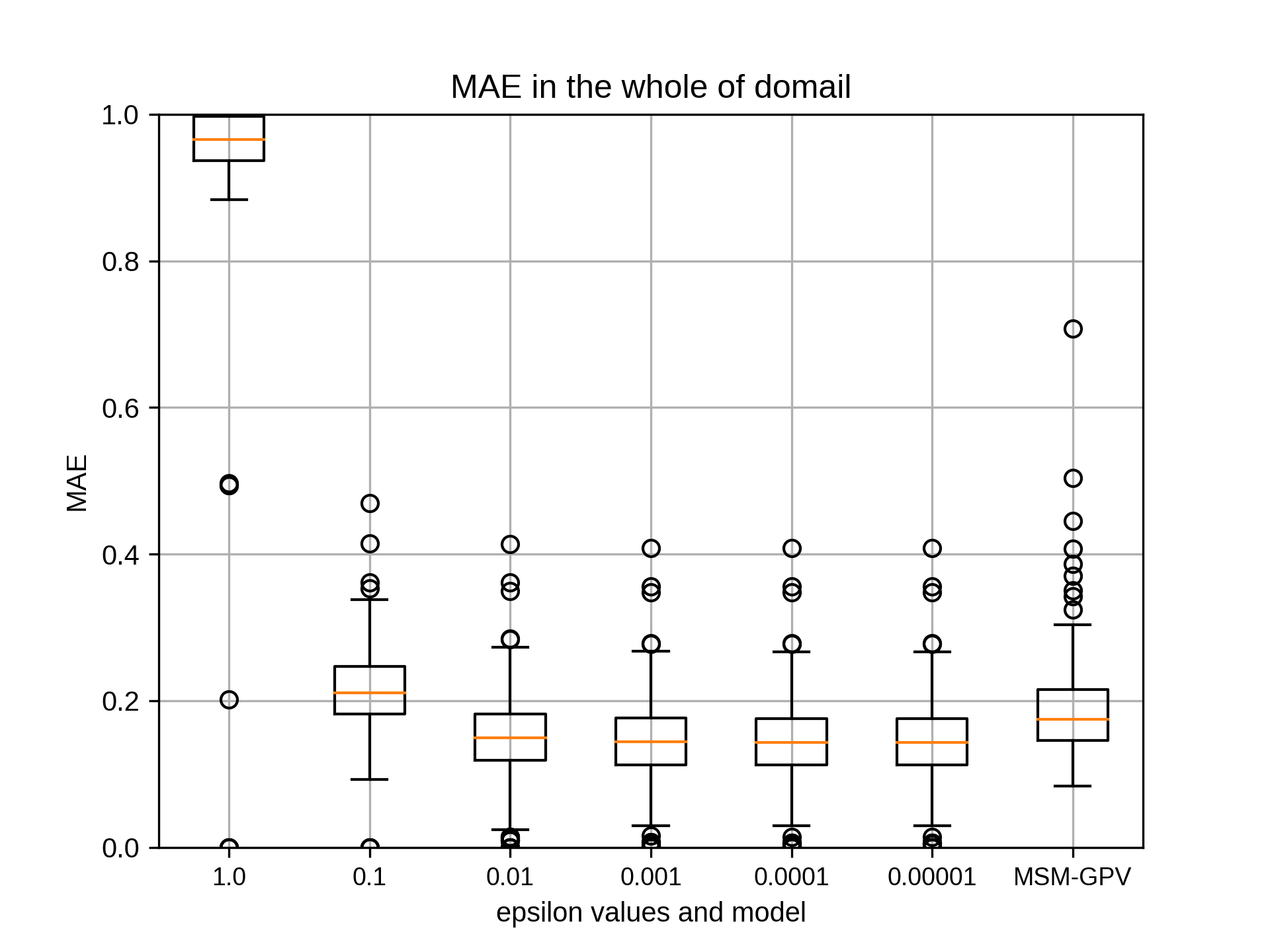

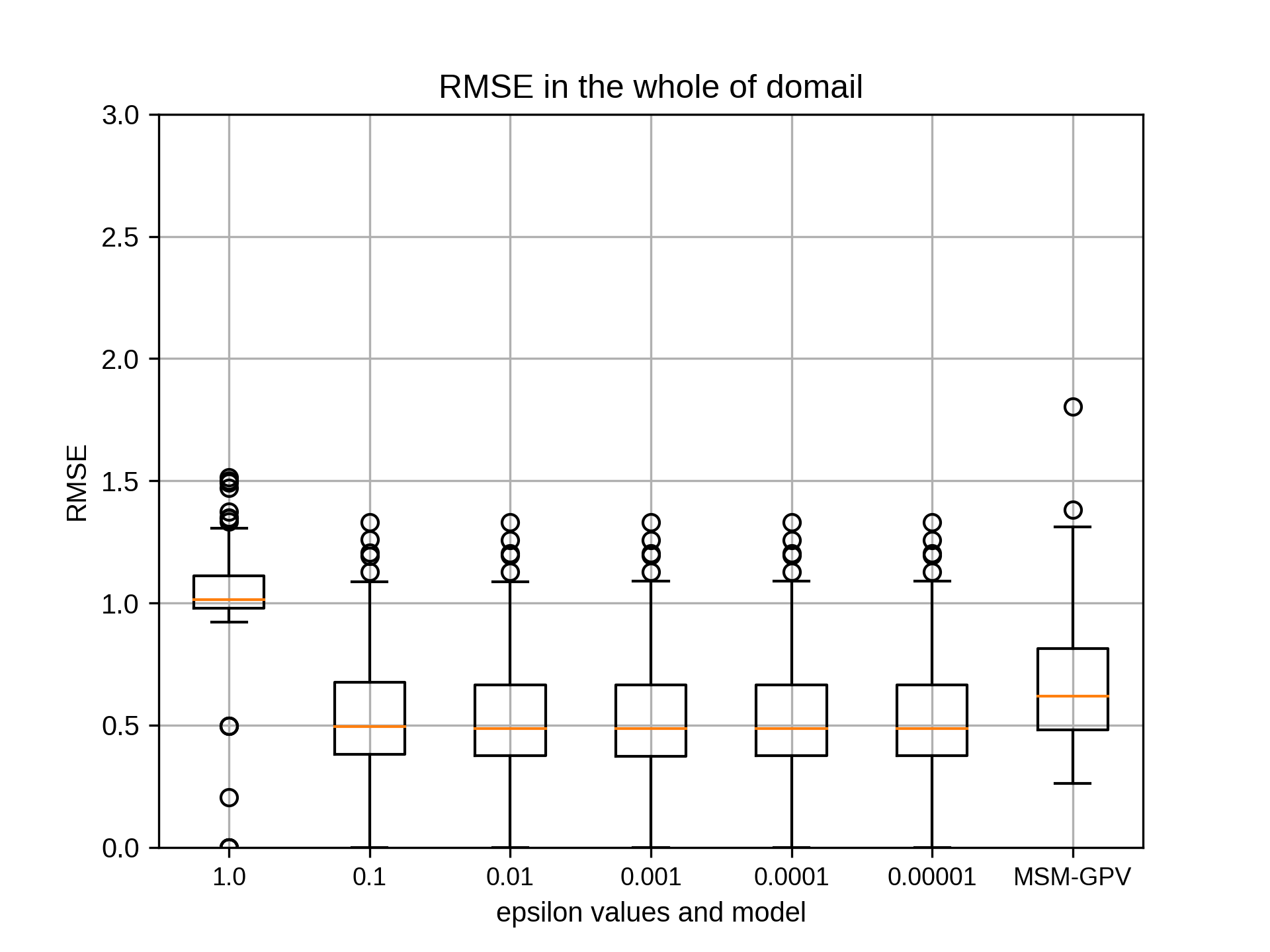

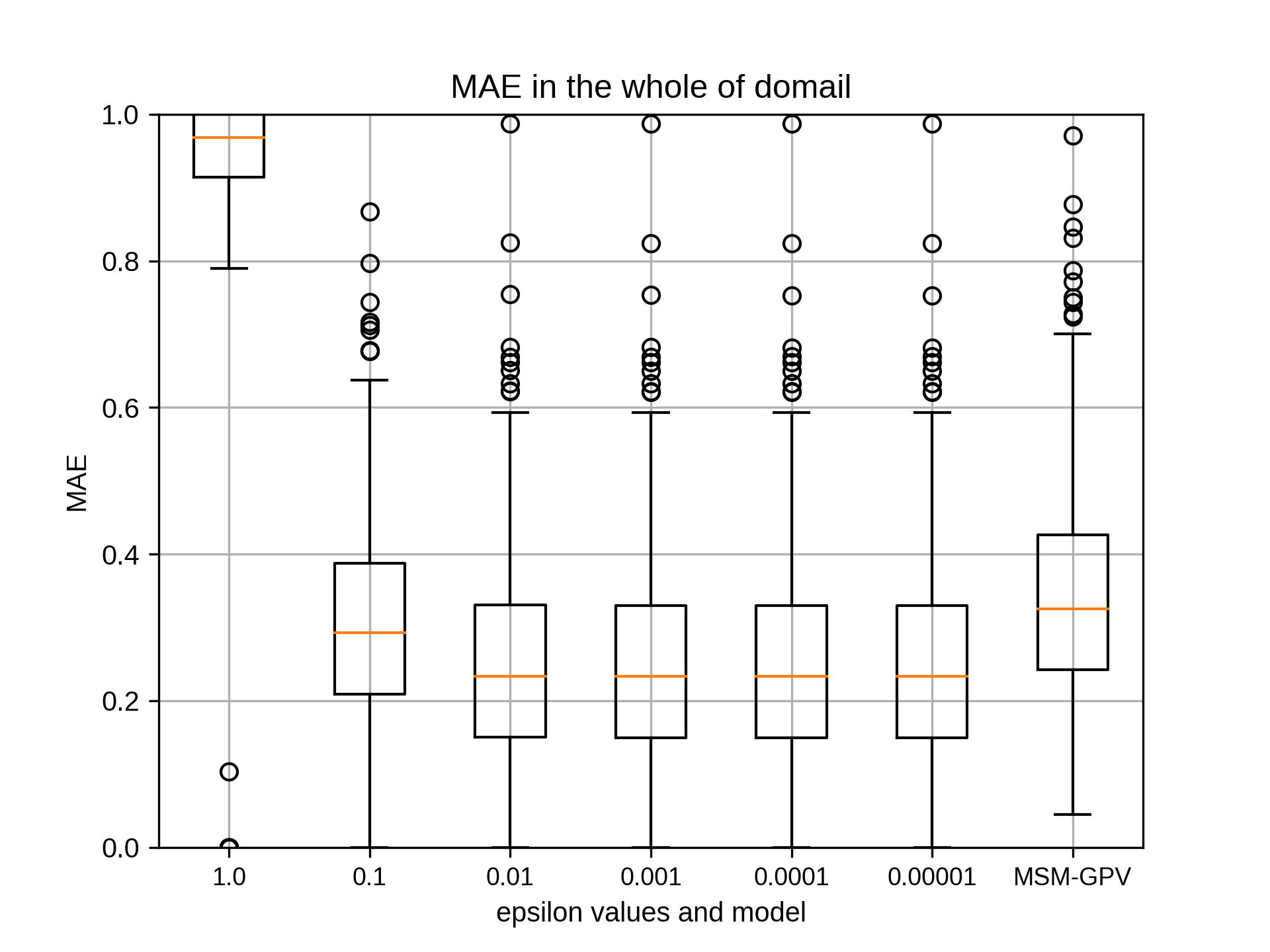

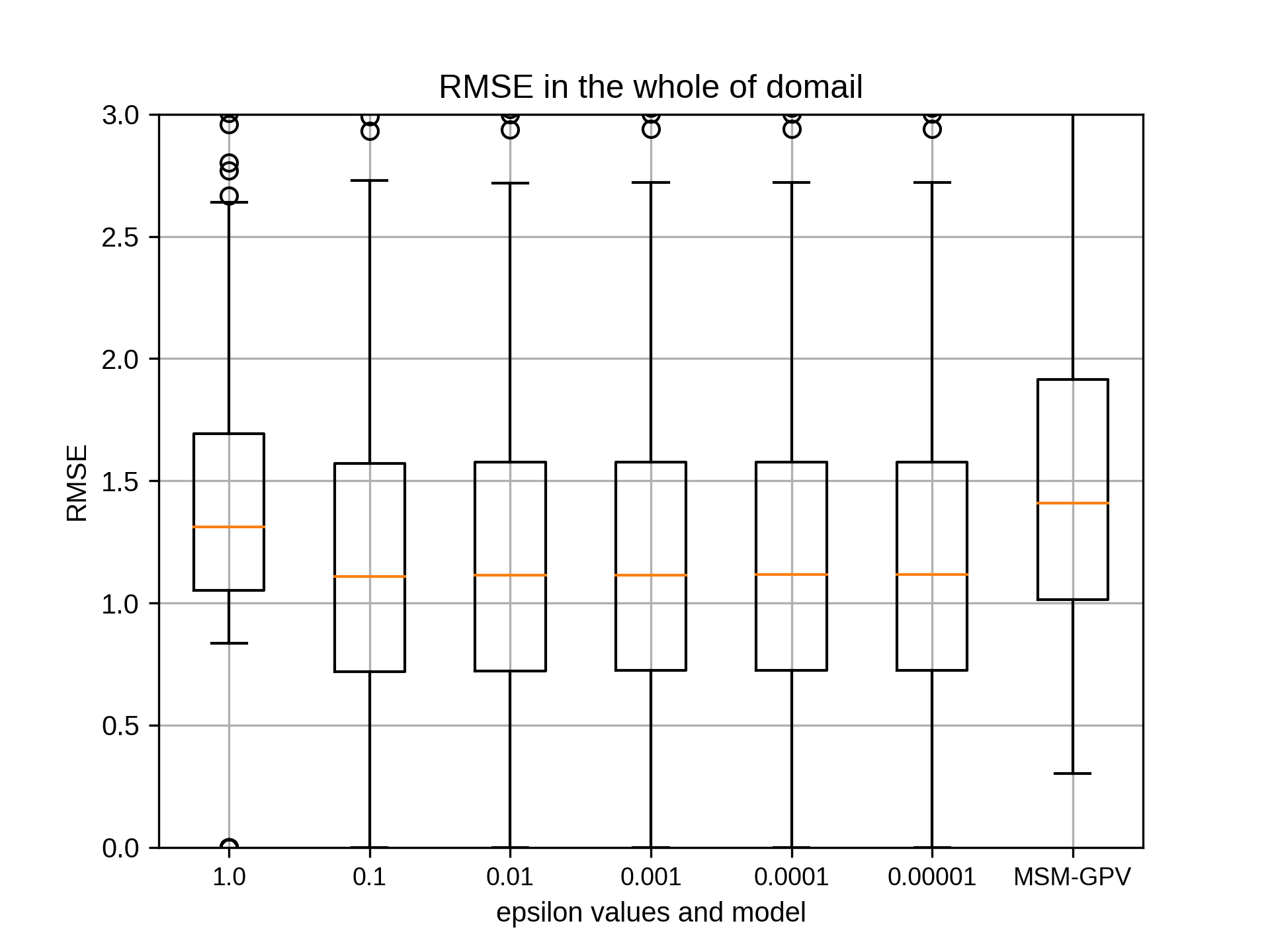

(MAE,RMSEでepsilon=1.0のみ大きい値となっております)

siteA 0.001

siteB 0.001,0.0001,0.00001(同じ)

siteC 0.01,0.001,0.0001,0.00001(同じ)

siteD 0.001

siteE 0.0001,0.00001(同じ)

今回の手法は以下のとおりです。

(1) cost=10, epsilon=0.001に固定し、gammaを'0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'と変化させ、相関係数の中央値が最も高いgammaを採用

(2) gammaを(1)で定めた値、epsilon=0.001に固定し、costを'50 40 30 20 10 8 6 4 2 1'と変化させ、相関係数の中央値が最も高いcostを採用

(3) gammaを(1)で定めた値、costを(2)で定めた値とし、epsilonを'1.0 0.1 0.01 0.001 0.0001 0.00001'と変化させ、相関係数の中央値が最も高いepsilonを採用

それぞれの結果のグラフは以下に示します。

吉兼先生

小林です。お世話になっております。

epsilonにつきまして結果が出ましたのでご報告いたします。

2007~2018年の7月の結果は添付のエクセルファイルのとおりです。

epsilonは変化させても相関係数の中央値はほとんど変わりませんでした。

(MAE,RMSEでepsilon=1.0のみ大きい値となっております)

siteA 0.001

siteB 0.001,0.0001,0.00001(同じ)

siteC 0.01,0.001,0.0001,0.00001(同じ)

siteD 0.001

siteE 0.0001,0.00001(同じ)

今回の手法は以下のとおりです。

(1) cost=10, epsilon=0.001に固定し、gammaを'0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'と変化させ、相関係数の中央値が最も高いgammaを採用

(2) gammaを(1)で定めた値、epsilon=0.001に固定し、costを'50 40 30 20 10 8 6 4 2 1'と変化させ、相関係数の中央値が最も高いcostを採用

(3) gammaを(1)で定めた値、costを(2)で定めた値とし、epsilonを'1.0 0.1 0.01 0.001 0.0001 0.00001'と変化させ、相関係数の中央値が最も高いepsilonを採用

それぞれの結果のグラフは以下に示します。

takao-yMonday, September 14th, 2020 at 3:45:15 PM GMT+09:00

@kobayashi_yusuke

小林様。ありがとうございます。ここで推定されたCとepsilonの最適値を用いて、もう一度gamma値について計算していただけますでしょうか。その結果をみた後で特に大きな変化がなければ、ハイパーパラメータを決定して良いかと思います。

小林様。ありがとうございます。ここで推定されたCとepsilonの最適値を用いて、もう一度gamma値について計算していただけますでしょうか。その結果をみた後で特に大きな変化がなければ、ハイパーパラメータを決定して良いかと思います。

kobayashi_yusukeMonday, September 14th, 2020 at 4:08:11 PM GMT+09:00

@takao-y

吉兼先生

お返事ありがとうございます。今回推定されたCとepsilonを用いて、再度gamma値を計算いたします。その際のepsilonにつきまして、siteB,C,Eで最大が同値のため、以下のようにさせていただきます。

siteB:0.0001 (0.001,0.0001,0.00001で同じ)

siteC: 0.001 (0.01,0.001,0.0001,0.00001で同じ)

siteE 0.0001 (0.0001,0.00001で同じ)

結果が出ましたらご連絡いたします。

よろしくお願いいたします。

吉兼先生

お返事ありがとうございます。今回推定されたCとepsilonを用いて、再度gamma値を計算いたします。その際のepsilonにつきまして、siteB,C,Eで最大が同値のため、以下のようにさせていただきます。

siteB:0.0001 (0.001,0.0001,0.00001で同じ)

siteC: 0.001 (0.01,0.001,0.0001,0.00001で同じ)

siteE 0.0001 (0.0001,0.00001で同じ)

結果が出ましたらご連絡いたします。

よろしくお願いいたします。

takao-yTuesday, September 15th, 2020 at 12:31:40 PM GMT+09:00

機械学習の入出力のバイナリ化ですが、概要図を添付します。

バイナリ化の前後でI/Oのアクセス数が1/nlat(緯度方向のグリッド数)になっており、書き込み遅延などによるサーバーへの負担を大幅に軽減できると思います。実行時間に関しては、今回70x70の領域で実施した結果、以前よりも10~20%程度早くなっていました。実行時間の大半が、識別機の作成であることを考慮すると、それほど時間短縮にはなっていません。ただ、同時並行数を増やすことによって、結果的に時間を短縮になるのではと考えています。

とりあえず、ソースコードを以下に置きました。時間があるときに試していただければ幸いです。

https://www.dropbox.com/s/x7r62s6z5960kkc/ml-region1-all-20200915.tar.gz?dl=0

バイナリ化の前後でI/Oのアクセス数が1/nlat(緯度方向のグリッド数)になっており、書き込み遅延などによるサーバーへの負担を大幅に軽減できると思います。実行時間に関しては、今回70x70の領域で実施した結果、以前よりも10~20%程度早くなっていました。実行時間の大半が、識別機の作成であることを考慮すると、それほど時間短縮にはなっていません。ただ、同時並行数を増やすことによって、結果的に時間を短縮になるのではと考えています。

とりあえず、ソースコードを以下に置きました。時間があるときに試していただければ幸いです。

https://www.dropbox.com/s/x7r62s6z5960kkc/ml-region1-all-20200915.tar.gz?dl=0

kobayashi_yusukeTuesday, September 15th, 2020 at 7:49:47 PM GMT+09:00

@takao-y

吉兼先生

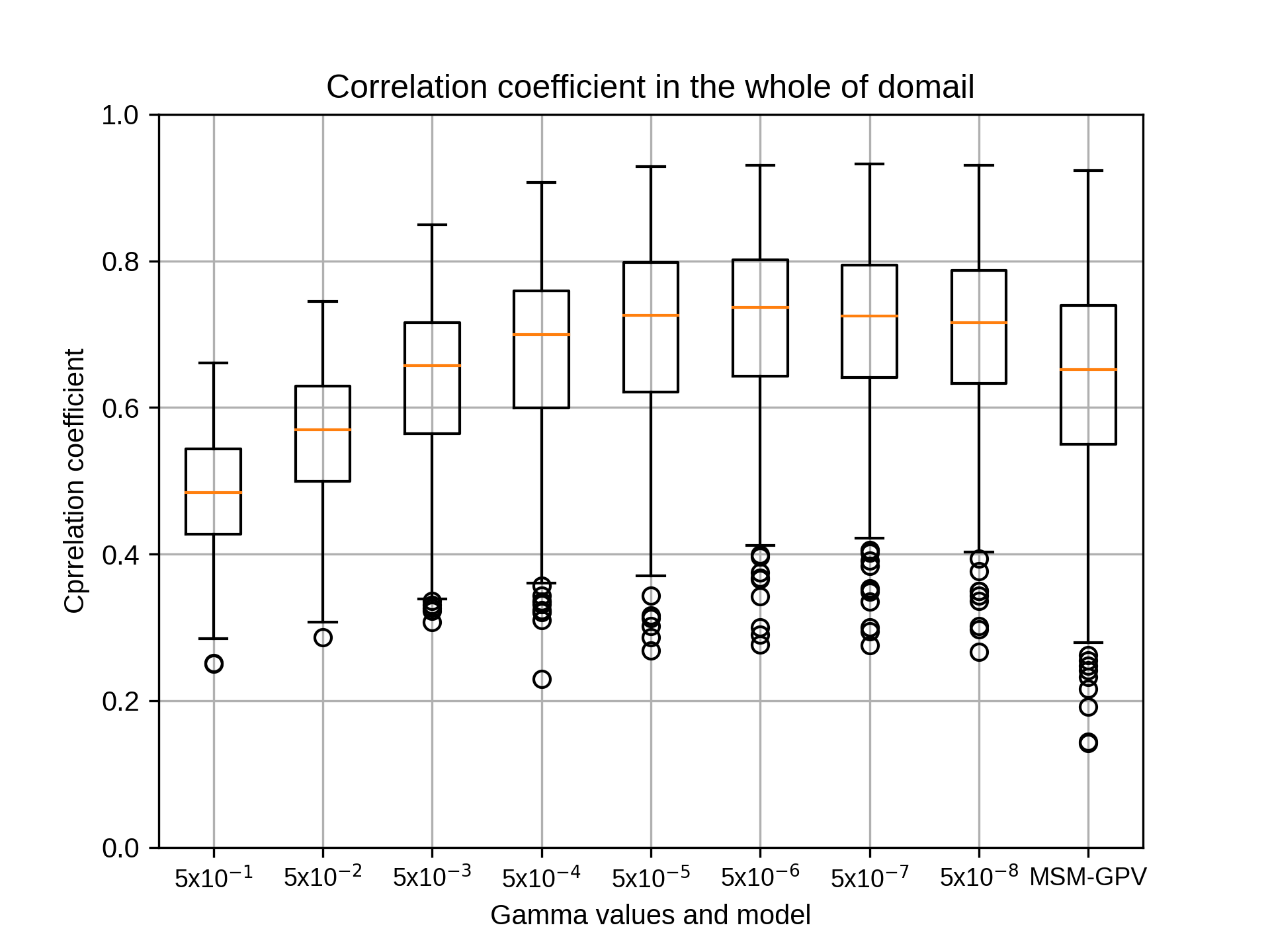

小林です。お世話になっております。

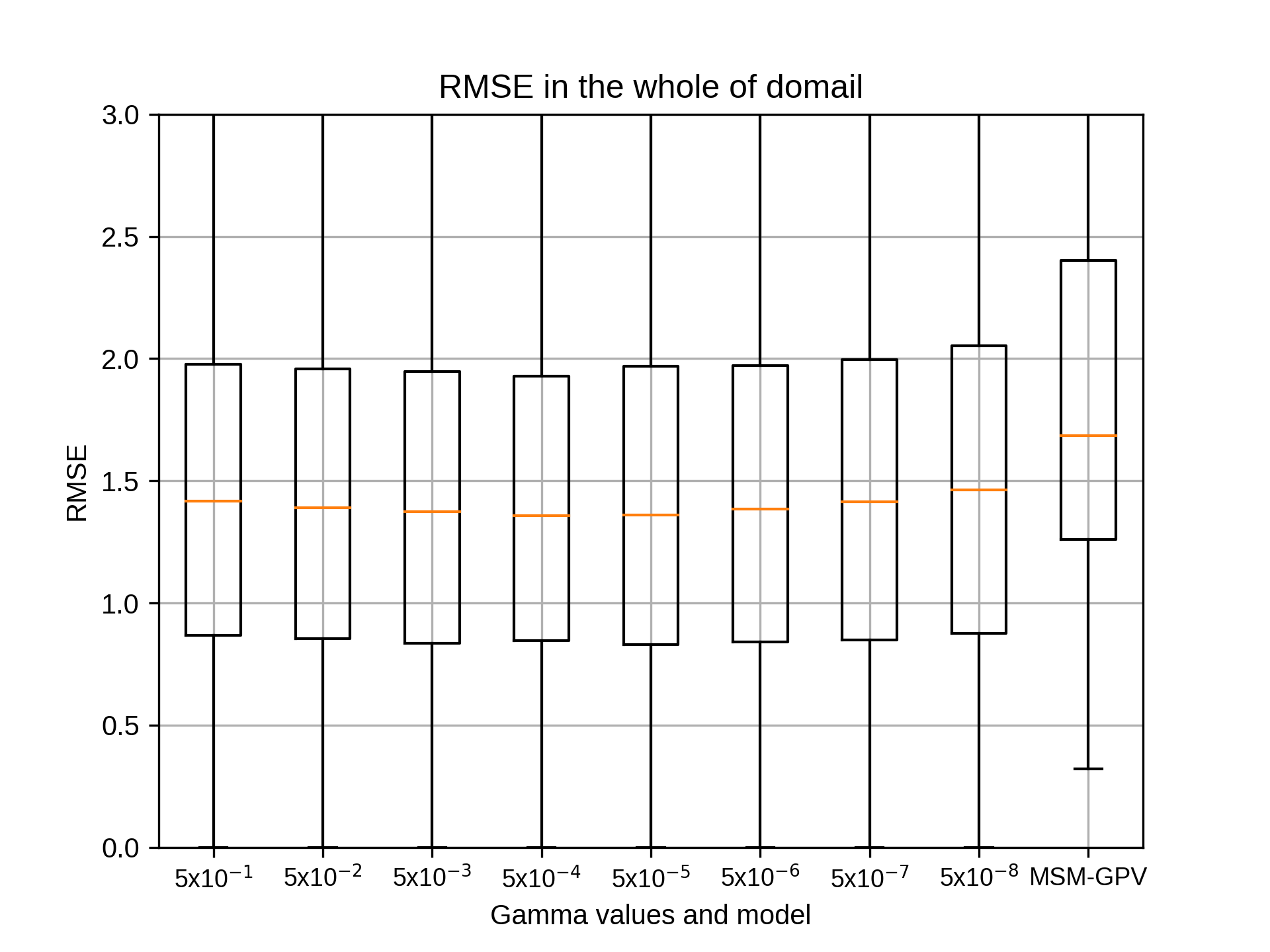

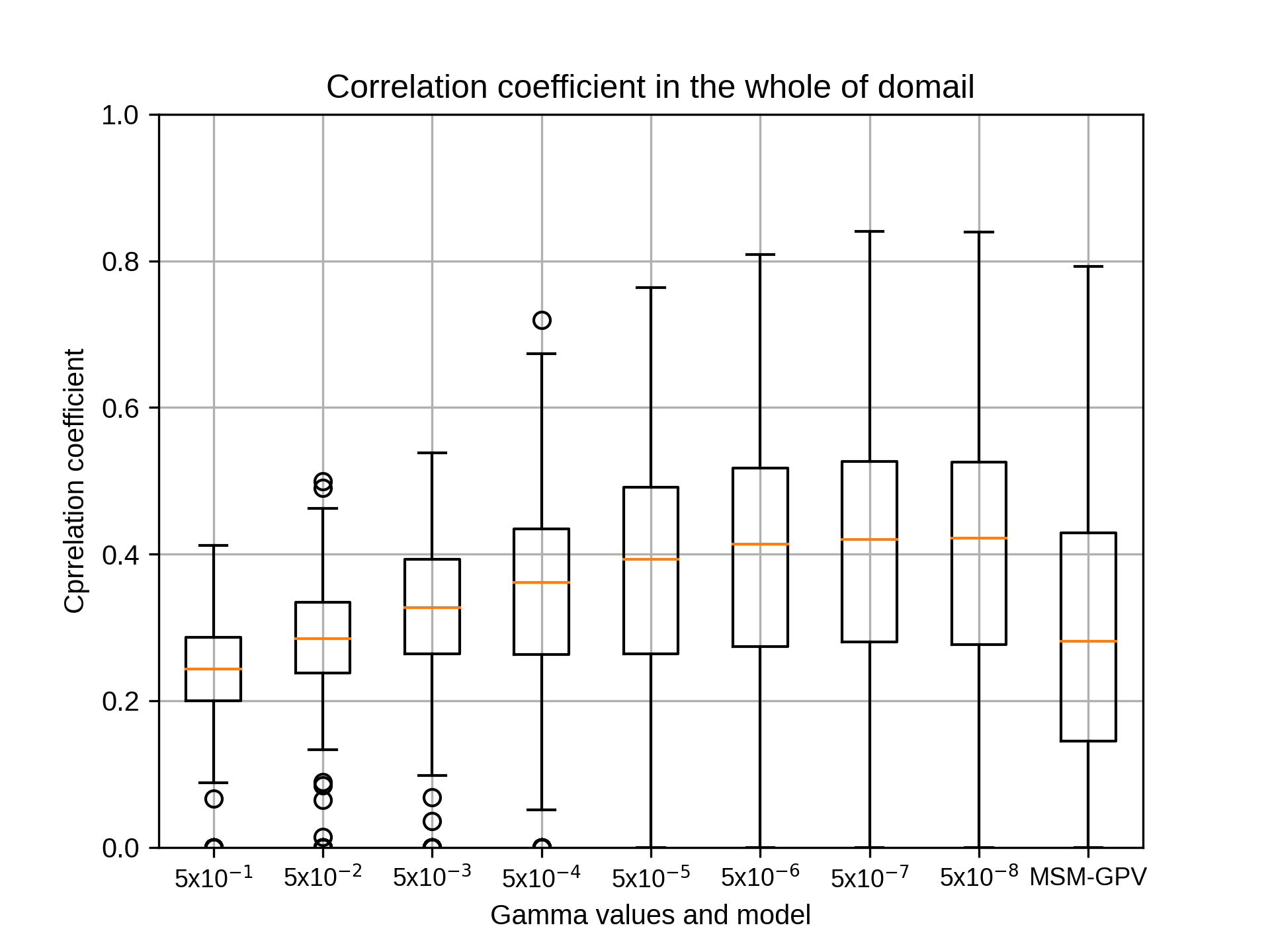

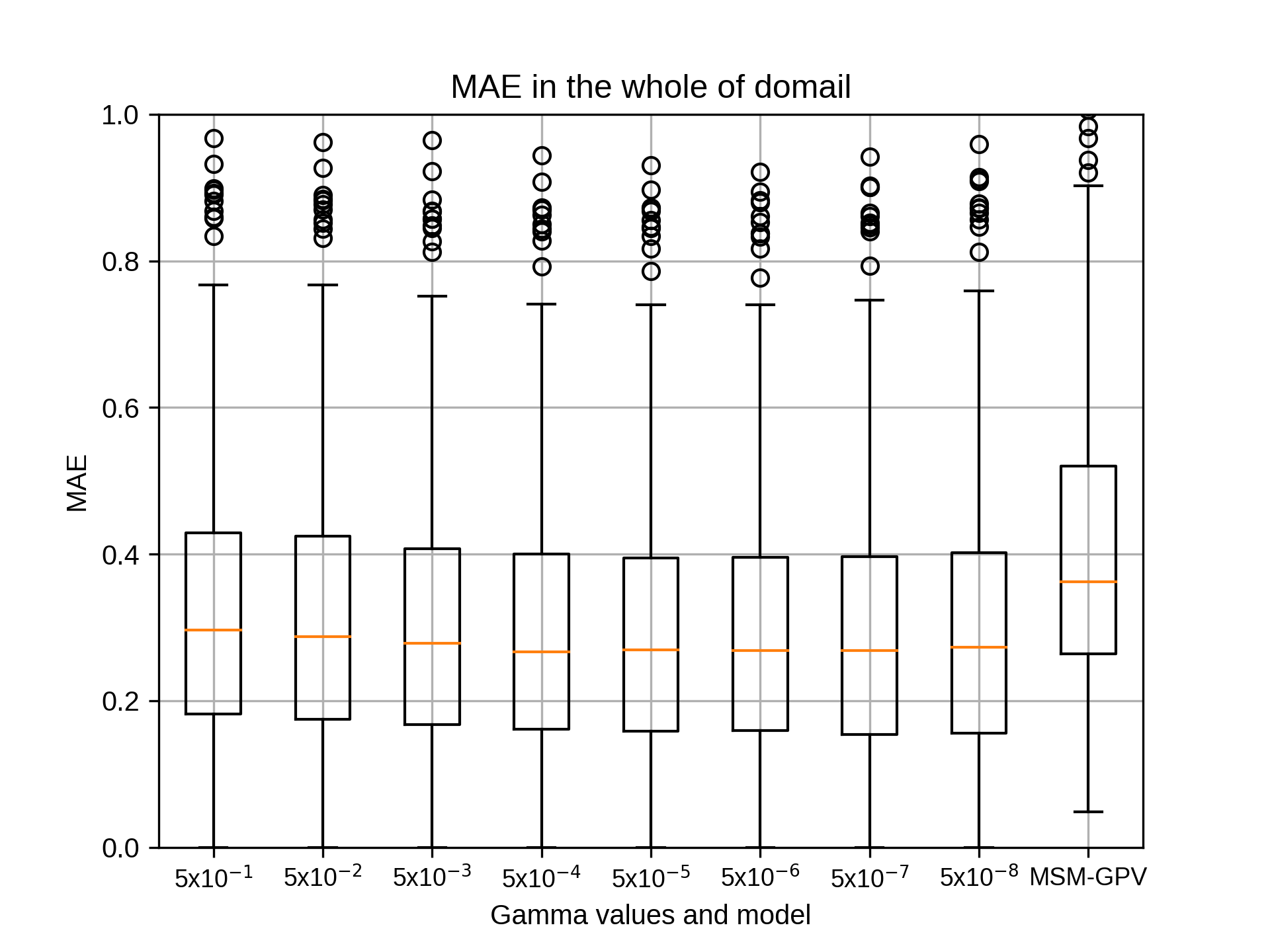

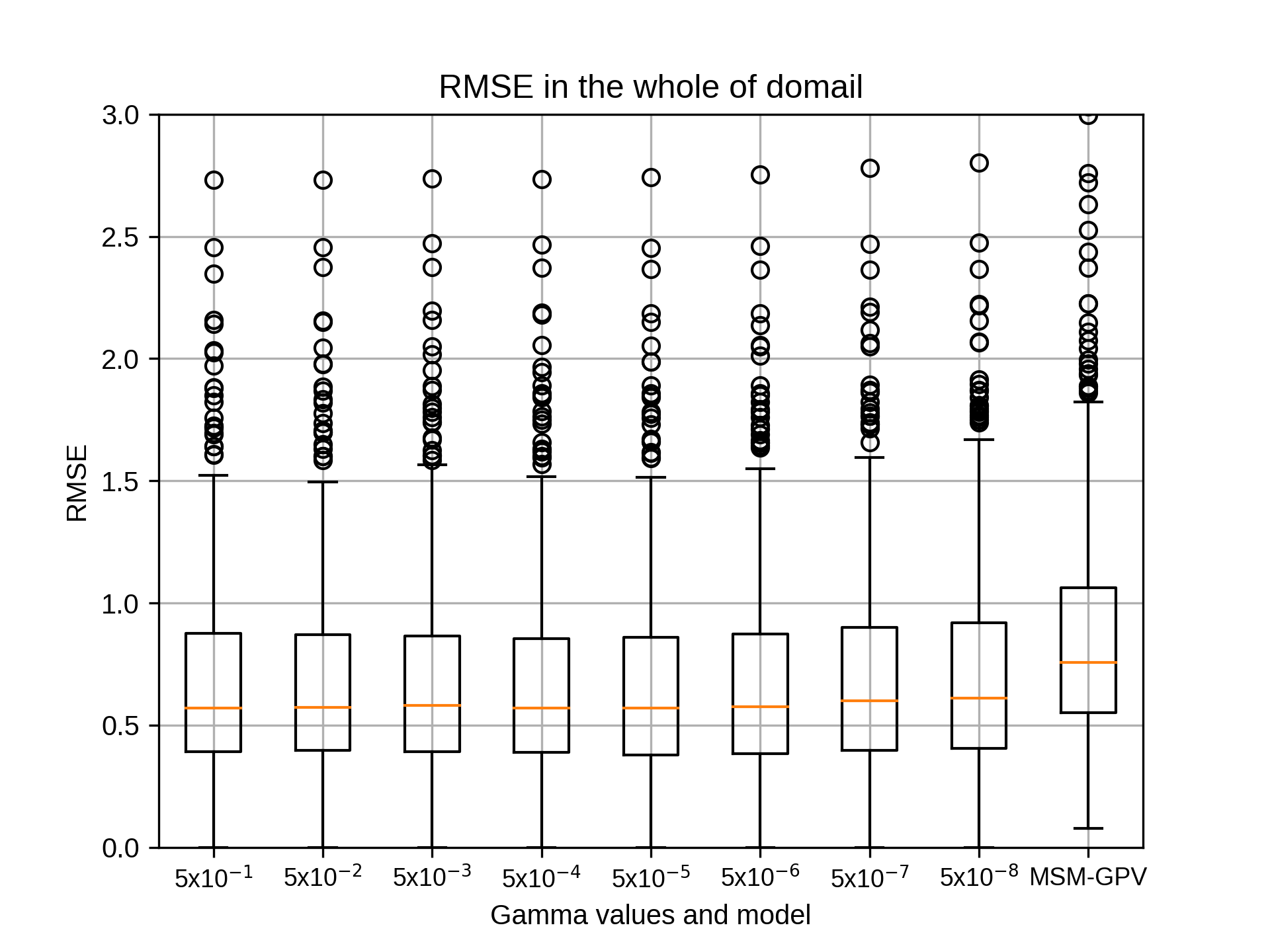

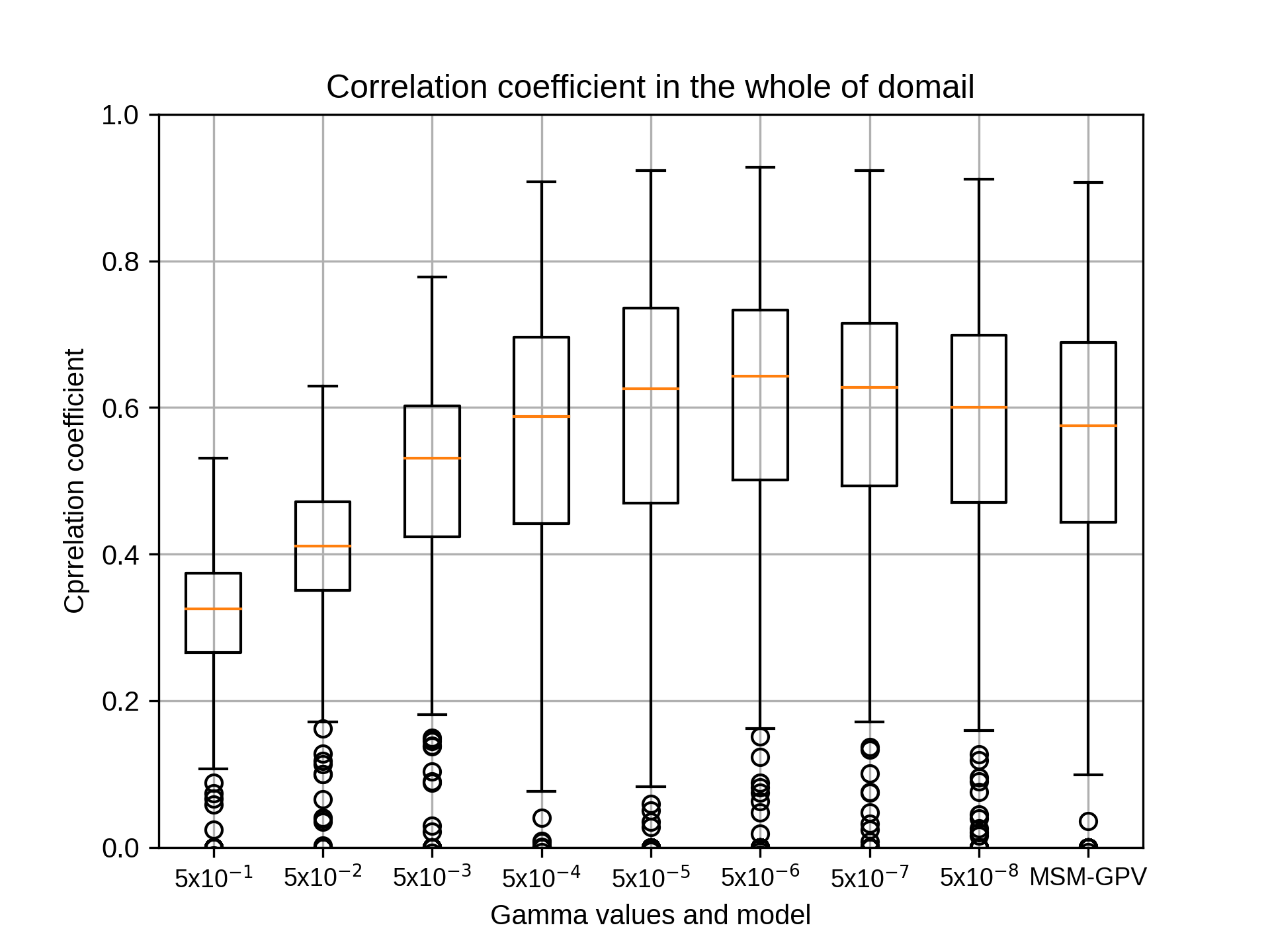

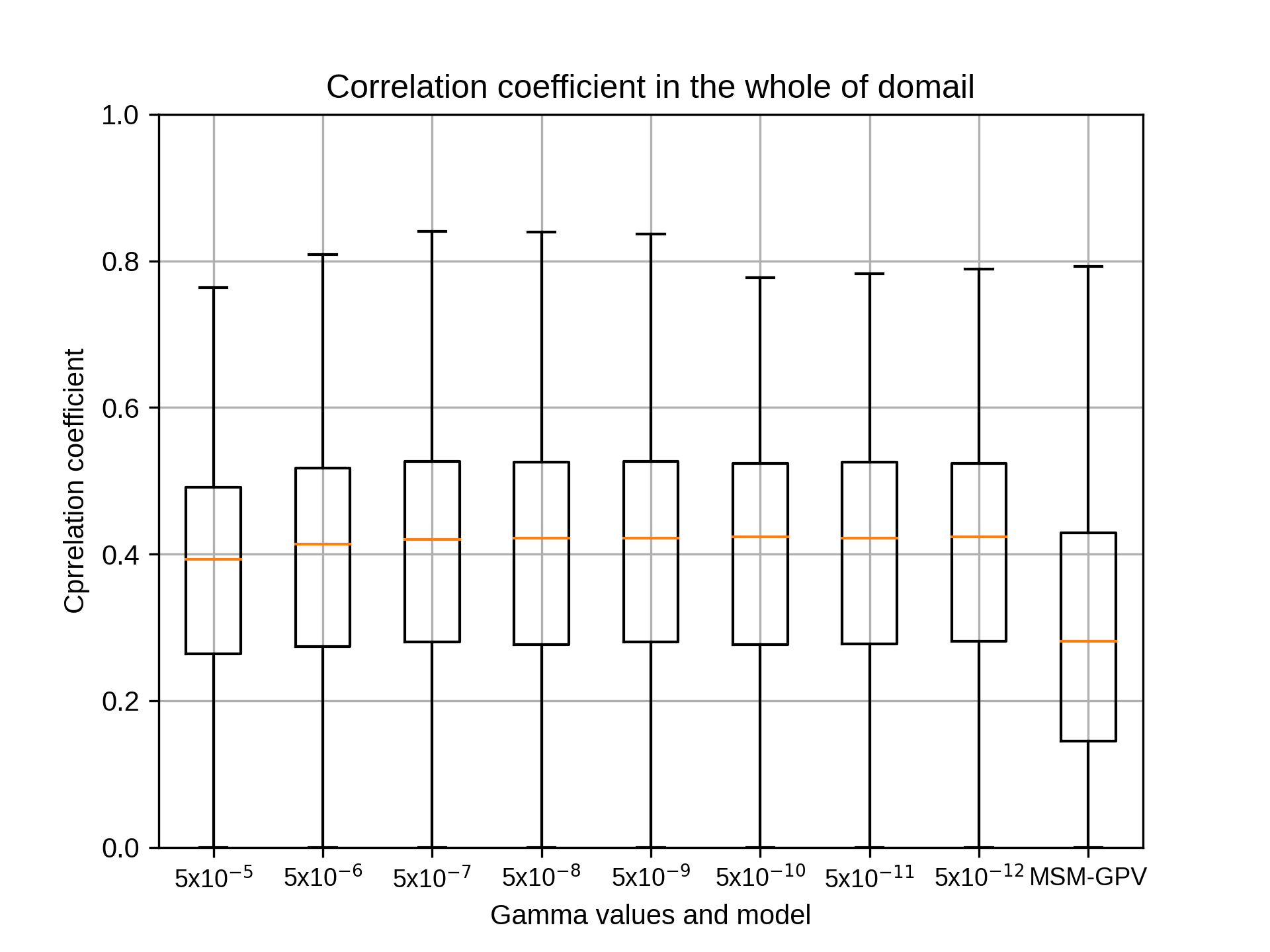

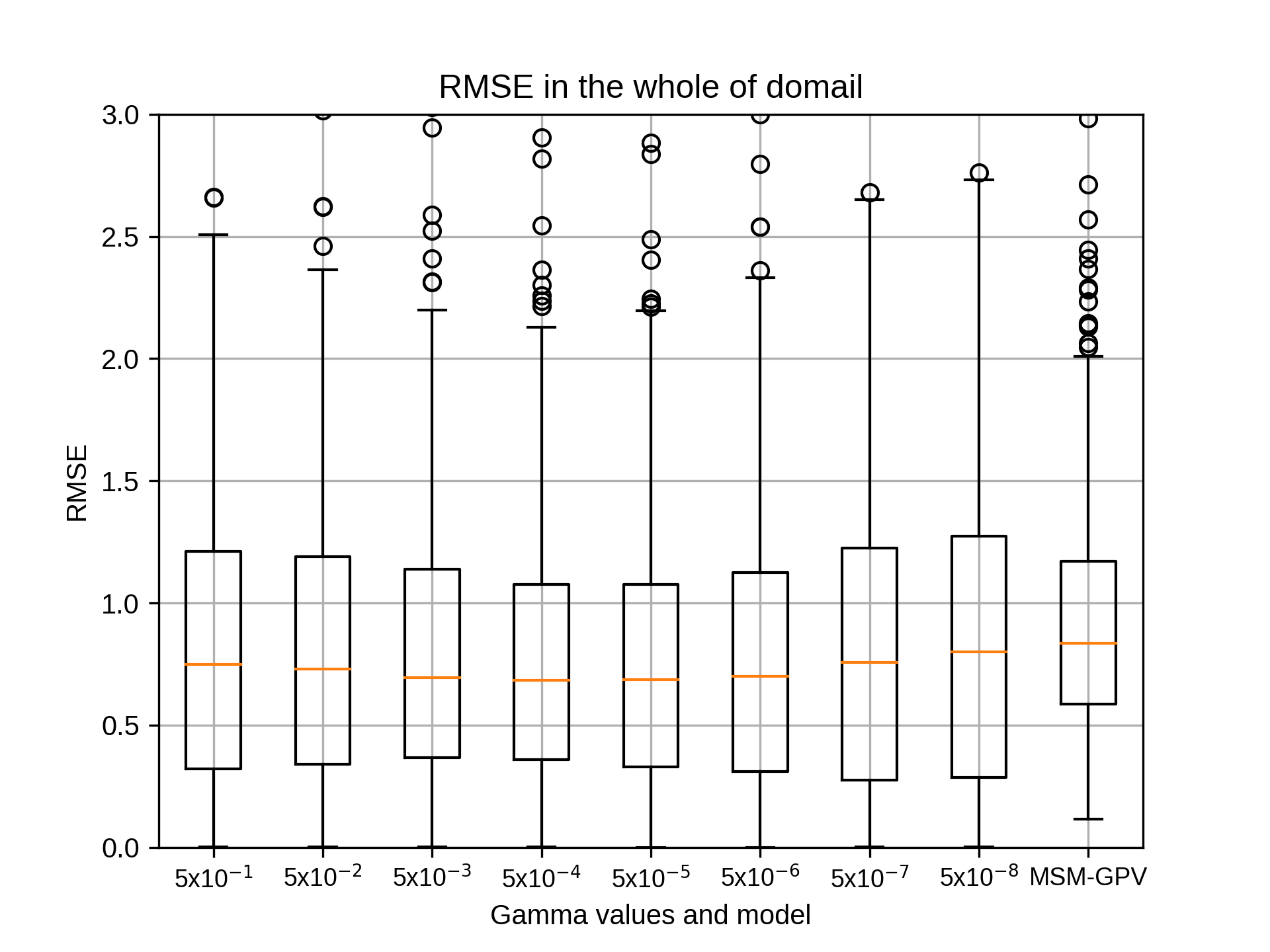

gammaにつきまして再解析した結果が出ましたのでご報告いたします。

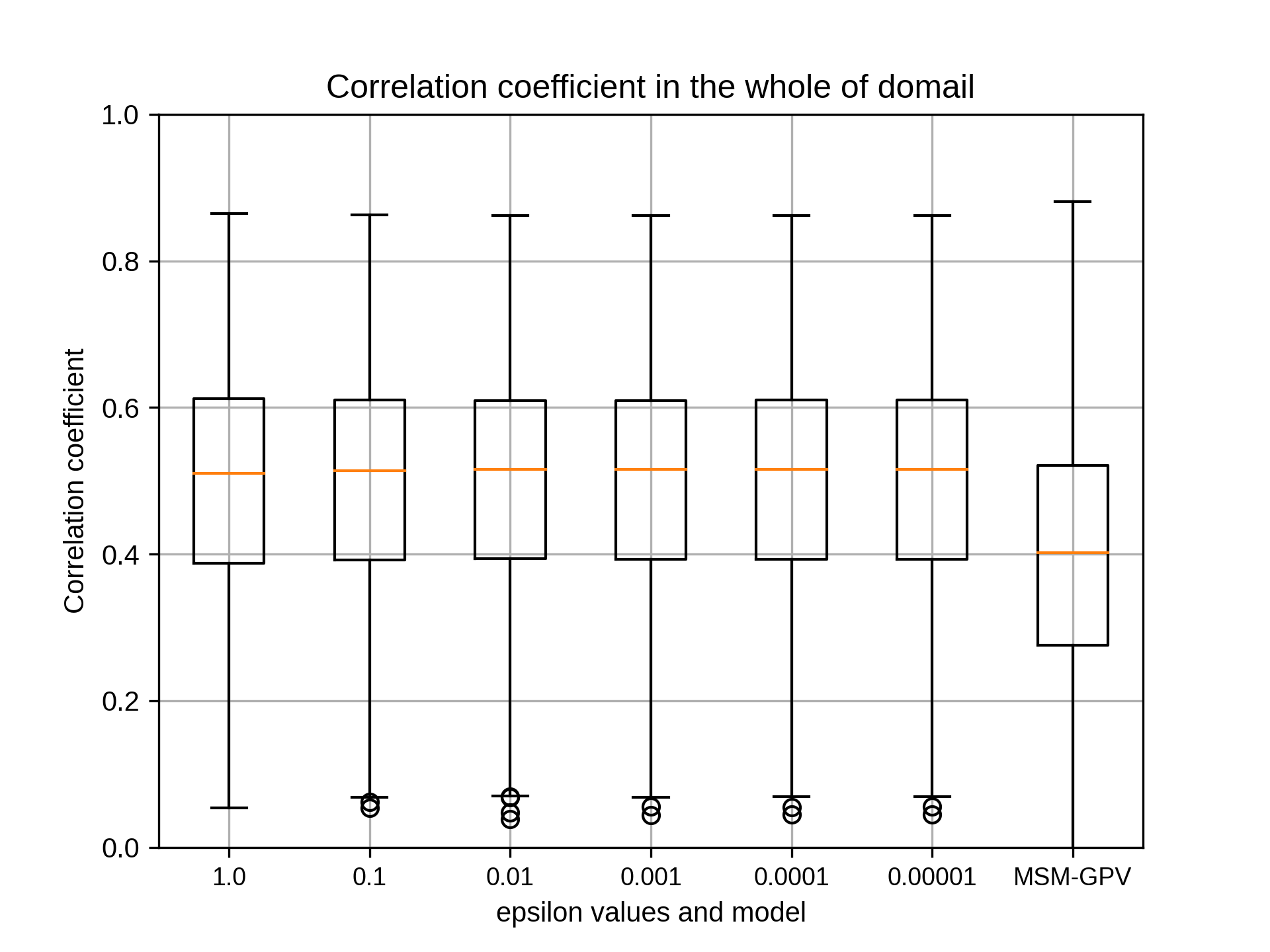

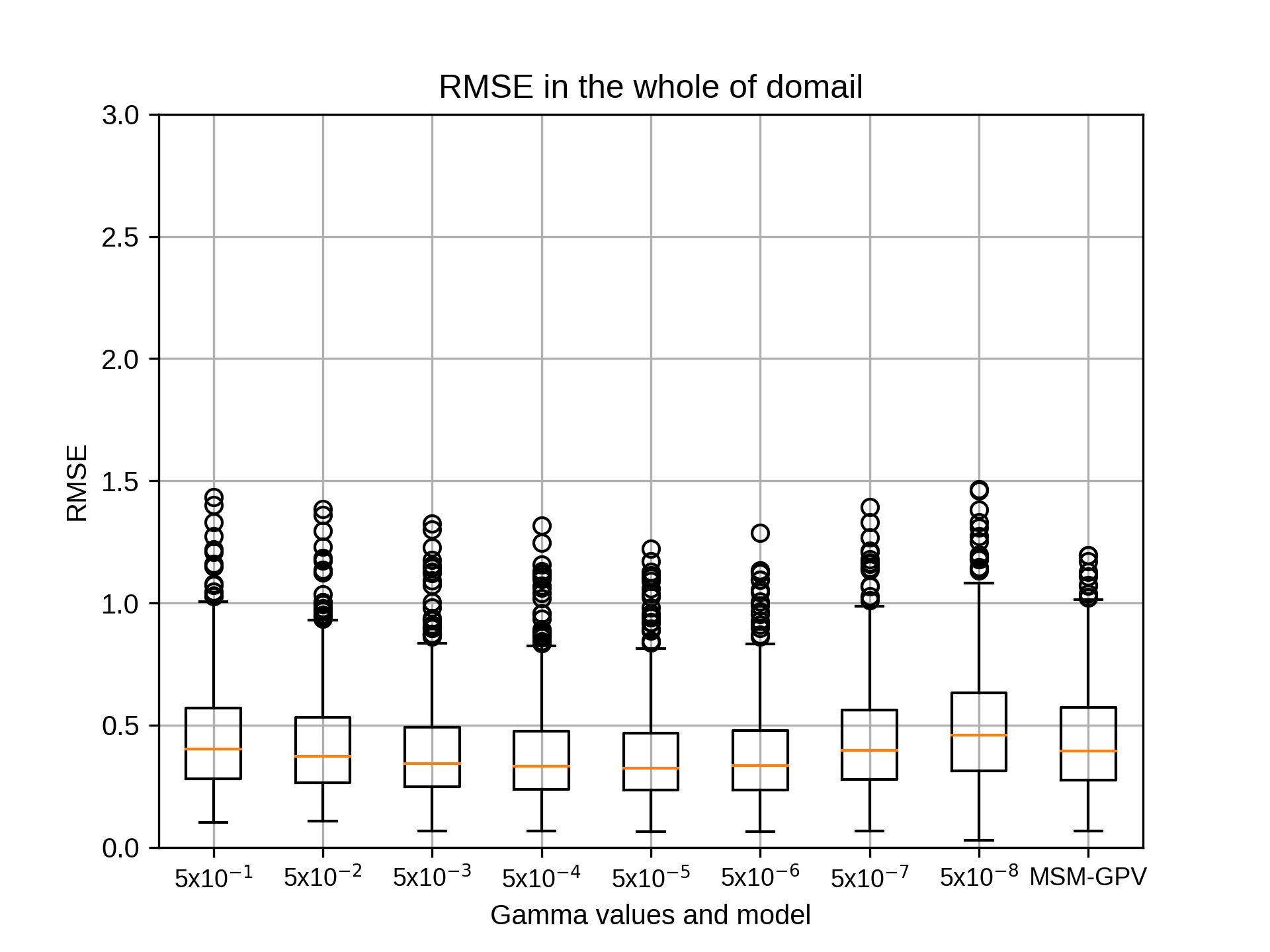

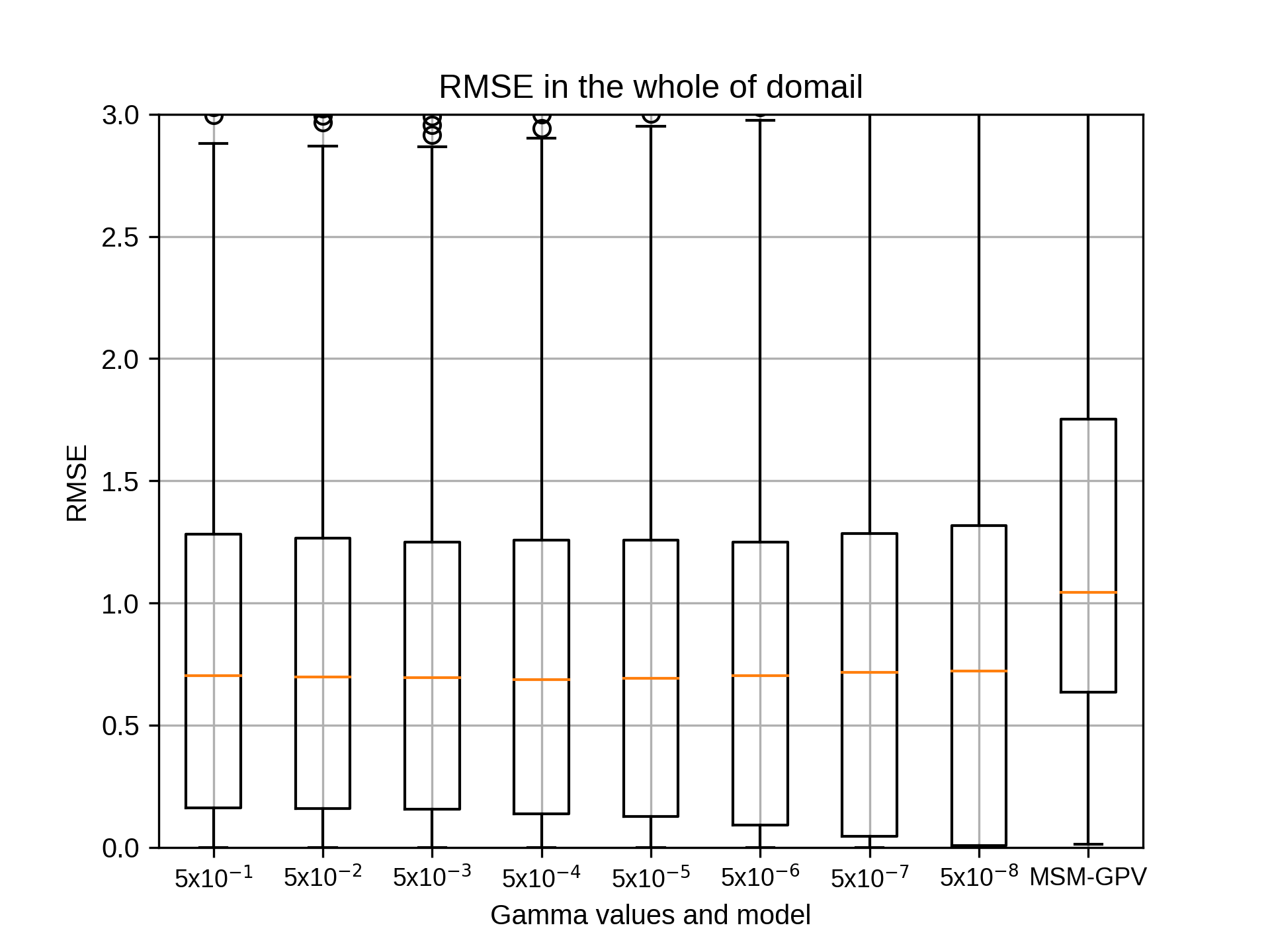

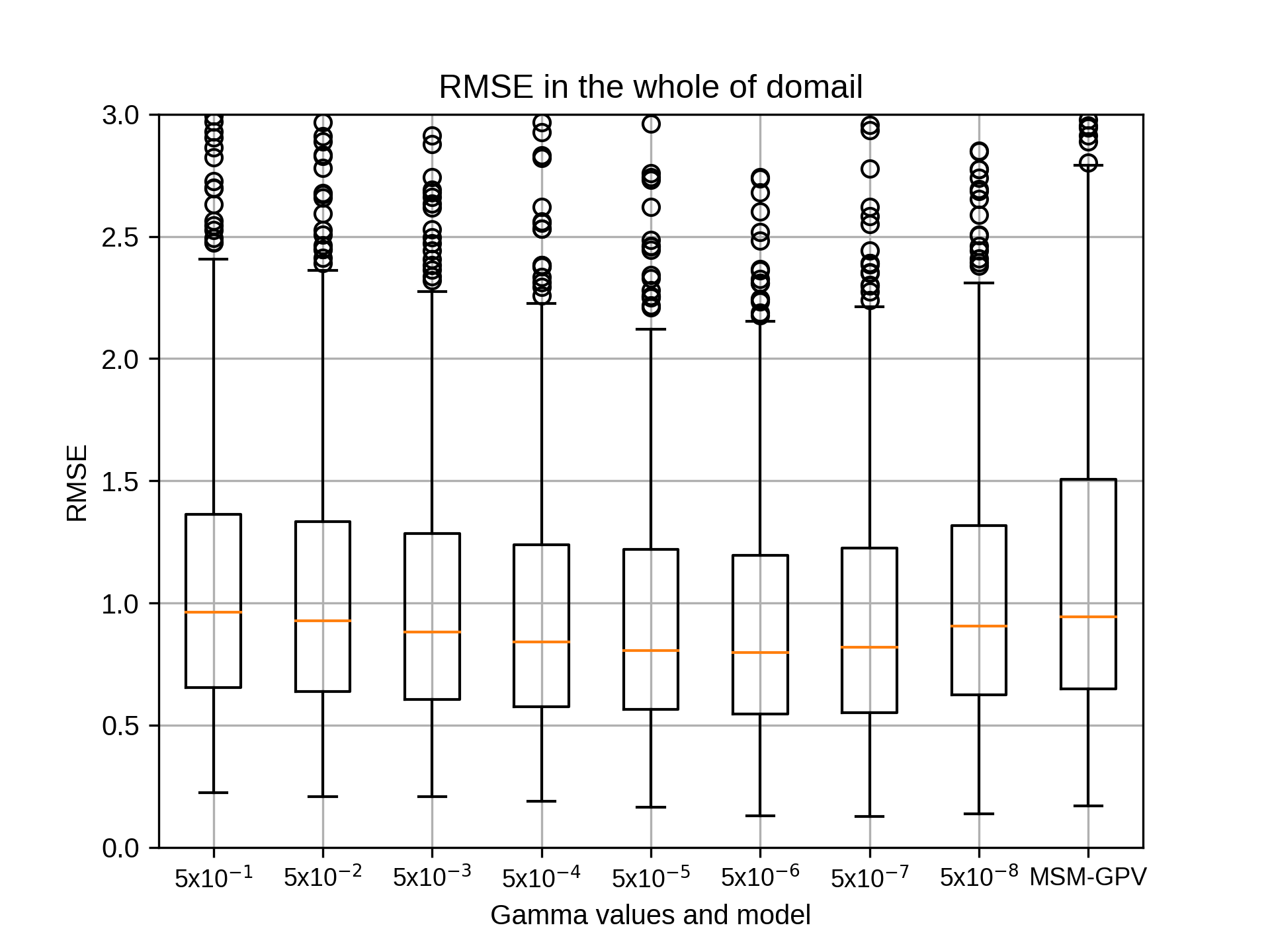

結果はsiteA~siteEまですべて当初採用したgamma値が相関係数の中央値の最大でした。

cost,epsilon値等詳細は添付のエクセルファイルをご参照ください。

対象は、2007~2018年の7月です。

手法は以下のとおりです。

(1) cost=10, epsilon=0.001に固定し、gammaを'0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'と変化させ、相関係数の中央値が最も高いgammaを採用

(2) gammaを(1)で定めた値、epsilon=0.001に固定し、costを'50 40 30 20 10 8 6 4 2 1'と変化させ、相関係数の中央値が最も高いcostを採用

(3) gammaを(1)で定めた値、costを(2)で定めた値とし、epsilonを'1.0 0.1 0.01 0.001 0.0001 0.00001'と変化させ、相関係数の中央値が最も高いepsilonを採用

(4) costを(2)で定めた値、epsilonを(3)で定めた値とし、gammaを'0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'と変化させて再計算を行い、相関係数の中央値が最も高いgammaを確認

gammaの結果は結果は以下の通りです。(siteごとに1つずつ書き込みます)

吉兼先生

小林です。お世話になっております。

gammaにつきまして再解析した結果が出ましたのでご報告いたします。

結果はsiteA~siteEまですべて当初採用したgamma値が相関係数の中央値の最大でした。

cost,epsilon値等詳細は添付のエクセルファイルをご参照ください。

対象は、2007~2018年の7月です。

手法は以下のとおりです。

(1) cost=10, epsilon=0.001に固定し、gammaを'0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'と変化させ、相関係数の中央値が最も高いgammaを採用

(2) gammaを(1)で定めた値、epsilon=0.001に固定し、costを'50 40 30 20 10 8 6 4 2 1'と変化させ、相関係数の中央値が最も高いcostを採用

(3) gammaを(1)で定めた値、costを(2)で定めた値とし、epsilonを'1.0 0.1 0.01 0.001 0.0001 0.00001'と変化させ、相関係数の中央値が最も高いepsilonを採用

(4) costを(2)で定めた値、epsilonを(3)で定めた値とし、gammaを'0.5 0.05 0.005 0.0005 0.00005 0.000005 0.0000005 0.00000005'と変化させて再計算を行い、相関係数の中央値が最も高いgammaを確認

gammaの結果は結果は以下の通りです。(siteごとに1つずつ書き込みます)

takao-yWednesday, September 16th, 2020 at 7:51:40 AM GMT+09:00

@kobayashi_yusuke

小林様。ありがとうございます。結果を見る限りは大きな違いはなさそうです。D,E領域については、もともとMSMの海上での再現性が良くないこともあるのでしょうか。もし時間がありましたら、D,Eについて島嶼領域(陸上)のみをピックアップして試していただけますでしょうか。琉球、八重山諸島の標高は高くてもせいぜい500m程度ですので、地形性降水の効果は小さいかもしれませんが。

小林様。ありがとうございます。結果を見る限りは大きな違いはなさそうです。D,E領域については、もともとMSMの海上での再現性が良くないこともあるのでしょうか。もし時間がありましたら、D,Eについて島嶼領域(陸上)のみをピックアップして試していただけますでしょうか。琉球、八重山諸島の標高は高くてもせいぜい500m程度ですので、地形性降水の効果は小さいかもしれませんが。

kobayashi_yusukeThursday, September 17th, 2020 at 1:16:44 PM GMT+09:00

@takao-y

吉兼先生

ご意見ありがとうございます。結果を見る限りは大きな違いはないとのご意見をいただき、ありがたく思います。時間がございましたら、D,Eについて島嶼領域(陸上)のみをピックアップして試したいと考えております。

ありがとうございました。

吉兼先生

ご意見ありがとうございます。結果を見る限りは大きな違いはないとのご意見をいただき、ありがたく思います。時間がございましたら、D,Eについて島嶼領域(陸上)のみをピックアップして試したいと考えております。

ありがとうございました。

takao-yWednesday, September 23rd, 2020 at 7:42:58 AM GMT+09:00

@kobayashi_yusuke

小林様。D,Eについてはいかがでしょうか。もし可能でしたら、1月、4月, 10月についても並行してお願いできますでしょうか。

小林様。D,Eについてはいかがでしょうか。もし可能でしたら、1月、4月, 10月についても並行してお願いできますでしょうか。

takao-yWednesday, September 23rd, 2020 at 11:36:25 AM GMT+09:00

皆様。吉兼です。

現在、小林さんに簡易実験を実施していただいていますが、以下の2点について検討できればと考えています。

1. 特徴量の範囲の季節による違い

2. バイナリ化した改良版での複数CPU実験

1.について、現在21x21(約105kmx105km)の特徴量の範囲を設定していますが、冬季と夏季で降水特性が異なることから、範囲を変更することによりパフォーマンスが変わってくる可能性があります。本件とは別のd4PDFの推定実験で気づいたことですが、夏季の場合、範囲を広げすぎると結果的に過大評価になる傾向があることが分かりました。夏季は線状降水帯のような狭い範囲で形成される降水が多く、特徴量を広く設定するとノイズも大きくなりあまり関係性のない降水まで関係があるかのように認識し、結果的に降水頻度自体が多くなってCDFを適用したあとで過大評価になるようです。もちろん、MSM-GPV自体の線状降水帯の再現性も影響するのですが、あまり広く取りすぎると、MSM-GPVの再現性の悪さがAIでの推定に影響を与えてしまうようです。d4PDFの実験結果から、60kmx60km程度が良さそうですので、特徴量の範囲を変えた調査もいくつか実施してみても良いのではと考えています。季節以外に地域による違いもありそうです。

2. は技術的な課題ですが、現在は5つの領域で実施していますが、実用面を考えるともっと細かく分割して並行処理を実施し、日本全域を同時に出力できるようになればと考えています。入力データのバイナリ化の改良版により、同時並行処理が可能と思いますので、例えば、陸域を中心に32分割して、32コアで同時並行処理を試していただくのは難しいでしょうか。バイナリ化によりメモリ消費も低減されていると思いますので、多分実行できるのではと考えています。さらにコア数を増やして64分割64コア同時並行ができればさらに実行時間は短縮されるのではないかと考えています。日本全域のバイアス補正データを統合できれば、TE-Japanへ入力も比較的容易になると思います。1kmでの運用を見据えて、さらに128コア, 256コア同時並行処理もできればと思いますが。深層学習に移行してGPUを活かした手法を開発した方が良いかなとも考えています。(個人的には今後は発展性のある深層学習に力を入れていきたいと考えています)

ご意見いただければ幸いです。

現在、小林さんに簡易実験を実施していただいていますが、以下の2点について検討できればと考えています。

1. 特徴量の範囲の季節による違い

2. バイナリ化した改良版での複数CPU実験

1.について、現在21x21(約105kmx105km)の特徴量の範囲を設定していますが、冬季と夏季で降水特性が異なることから、範囲を変更することによりパフォーマンスが変わってくる可能性があります。本件とは別のd4PDFの推定実験で気づいたことですが、夏季の場合、範囲を広げすぎると結果的に過大評価になる傾向があることが分かりました。夏季は線状降水帯のような狭い範囲で形成される降水が多く、特徴量を広く設定するとノイズも大きくなりあまり関係性のない降水まで関係があるかのように認識し、結果的に降水頻度自体が多くなってCDFを適用したあとで過大評価になるようです。もちろん、MSM-GPV自体の線状降水帯の再現性も影響するのですが、あまり広く取りすぎると、MSM-GPVの再現性の悪さがAIでの推定に影響を与えてしまうようです。d4PDFの実験結果から、60kmx60km程度が良さそうですので、特徴量の範囲を変えた調査もいくつか実施してみても良いのではと考えています。季節以外に地域による違いもありそうです。

2. は技術的な課題ですが、現在は5つの領域で実施していますが、実用面を考えるともっと細かく分割して並行処理を実施し、日本全域を同時に出力できるようになればと考えています。入力データのバイナリ化の改良版により、同時並行処理が可能と思いますので、例えば、陸域を中心に32分割して、32コアで同時並行処理を試していただくのは難しいでしょうか。バイナリ化によりメモリ消費も低減されていると思いますので、多分実行できるのではと考えています。さらにコア数を増やして64分割64コア同時並行ができればさらに実行時間は短縮されるのではないかと考えています。日本全域のバイアス補正データを統合できれば、TE-Japanへ入力も比較的容易になると思います。1kmでの運用を見据えて、さらに128コア, 256コア同時並行処理もできればと思いますが。深層学習に移行してGPUを活かした手法を開発した方が良いかなとも考えています。(個人的には今後は発展性のある深層学習に力を入れていきたいと考えています)

ご意見いただければ幸いです。

kubota.takujiFriday, September 25th, 2020 at 2:36:28 PM GMT+09:00

@kubota.takujiさんがチャンネルに参加しました

kobayashi_yusukeMonday, September 28th, 2020 at 9:52:42 AM GMT+09:00

@takao-y

吉兼先生

お世話になっております。D,Eの件はまだ着手出来ておりません。申し訳ございません。

できあがりましたらご連絡いたします。

吉兼先生

お世話になっております。D,Eの件はまだ着手出来ておりません。申し訳ございません。

できあがりましたらご連絡いたします。

takao-yMonday, September 28th, 2020 at 11:22:38 AM GMT+09:00

@kobayashi_yusuke

小林様。ご連絡ありがとうございます。もし難しいようでしたら後回しにして、1月,4月,10月を実施していただけますでしょうか。

小林様。ご連絡ありがとうございます。もし難しいようでしたら後回しにして、1月,4月,10月を実施していただけますでしょうか。

kobayashi_yusukeMonday, September 28th, 2020 at 6:18:20 PM GMT+09:00

@takao-y

吉兼先生

承知しました。1月、4月、10月を行います。結果が出ましたらご連絡いたします。

吉兼先生

承知しました。1月、4月、10月を行います。結果が出ましたらご連絡いたします。

takao-yFriday, October 2nd, 2020 at 7:03:27 PM GMT+09:00

@kobayashi_yusuke

小林様。進捗はいかがでしょうか。もし問題などありましたら、遠慮せずにご連絡ください。

小林様。進捗はいかがでしょうか。もし問題などありましたら、遠慮せずにご連絡ください。

kobayashi_yusukeFriday, October 2nd, 2020 at 7:18:36 PM GMT+09:00

@takao-y

吉兼先生 ご連絡ありがとうございます。経過報告をせずに申し訳ございません。解析は順次進めております。結果が出ましたら改めてご連絡いたします。以上、よろしくお願いいたします。

吉兼先生 ご連絡ありがとうございます。経過報告をせずに申し訳ございません。解析は順次進めております。結果が出ましたら改めてご連絡いたします。以上、よろしくお願いいたします。

kobayashi_yusukeMonday, October 5th, 2020 at 12:09:01 PM GMT+09:00

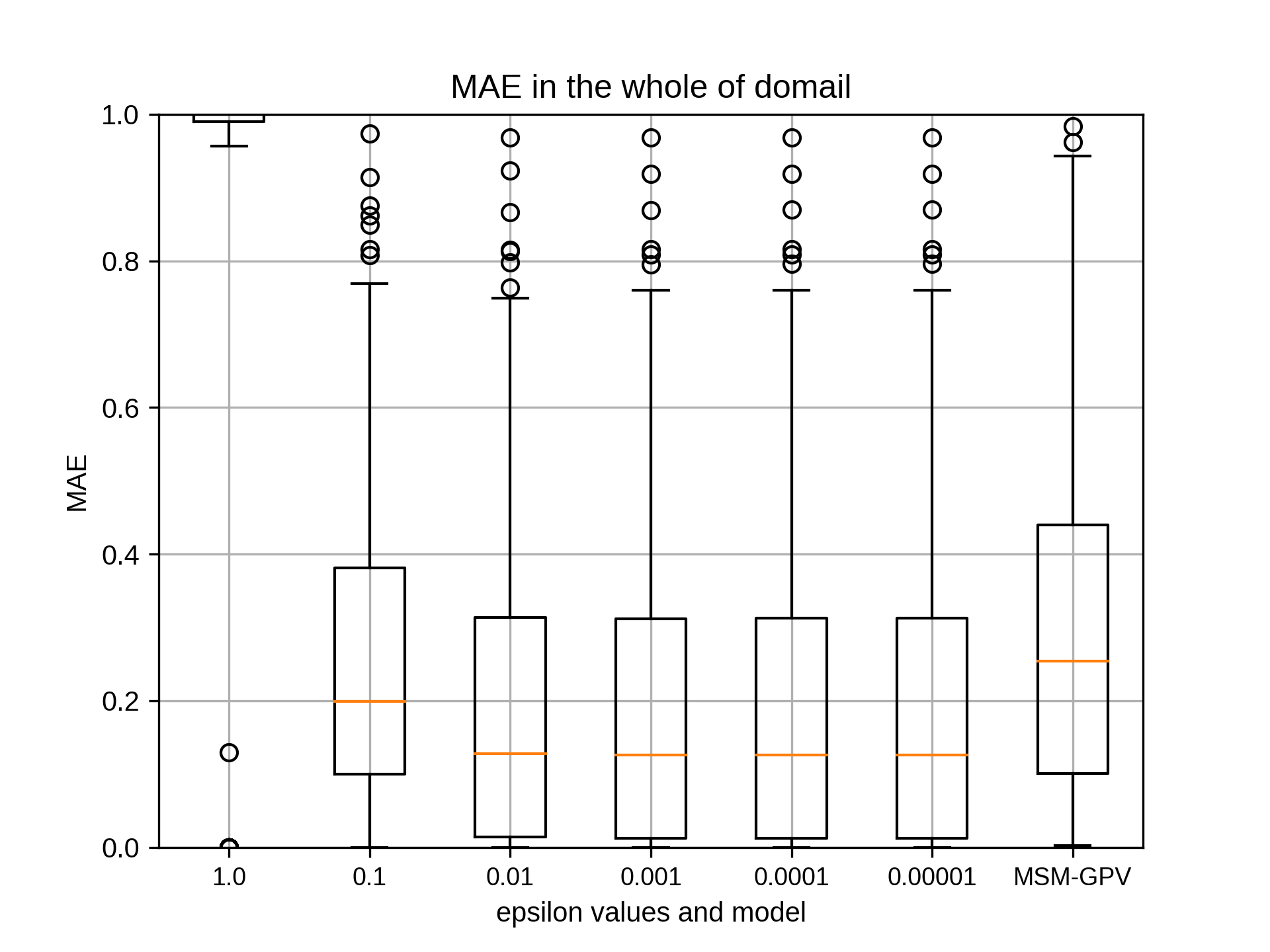

これにて、1月、4月、7月、10月のハイパーパラメータの設定は終わります。

全体的な傾向として、gammaは影響しますが、cost、epsilon(1.0を除く)のパラメータは変化させてもほとんど変わらないことがわかりました。

残りとしまして、7月のsiteD,siteEにおける陸上につきまして行いたいと考えております。

以上、よろしくお願いいたします。

全体的な傾向として、gammaは影響しますが、cost、epsilon(1.0を除く)のパラメータは変化させてもほとんど変わらないことがわかりました。

残りとしまして、7月のsiteD,siteEにおける陸上につきまして行いたいと考えております。

以上、よろしくお願いいたします。

takao-yMonday, October 5th, 2020 at 3:42:11 PM GMT+09:00

小林様。ありがとうございます。5x10-8で最も相関係数が高いケースについて、5x10-9, 5x10-10を追加して(5x10-1, 5x10-2の代わりに)、再度実施してもらえますでしょうか。

kobayashi_yusukeMonday, October 5th, 2020 at 5:08:25 PM GMT+09:00

@takao-y

吉兼先生

小林です。お世話になっております。

5x10-8で最も相関係数が高いケースにつきまして、5x10-9, 5x10-10を追加して(5x10-1, 5x10-2の代わりに)、再度gammaを実施いたします。この際のcost, epsilonのパラメータはこれまでで最も相関が高い値を利用します。結果が出ましたらお伝えいたします。

以上、よろしくお願いいたします。

吉兼先生

小林です。お世話になっております。

5x10-8で最も相関係数が高いケースにつきまして、5x10-9, 5x10-10を追加して(5x10-1, 5x10-2の代わりに)、再度gammaを実施いたします。この際のcost, epsilonのパラメータはこれまでで最も相関が高い値を利用します。結果が出ましたらお伝えいたします。

以上、よろしくお願いいたします。

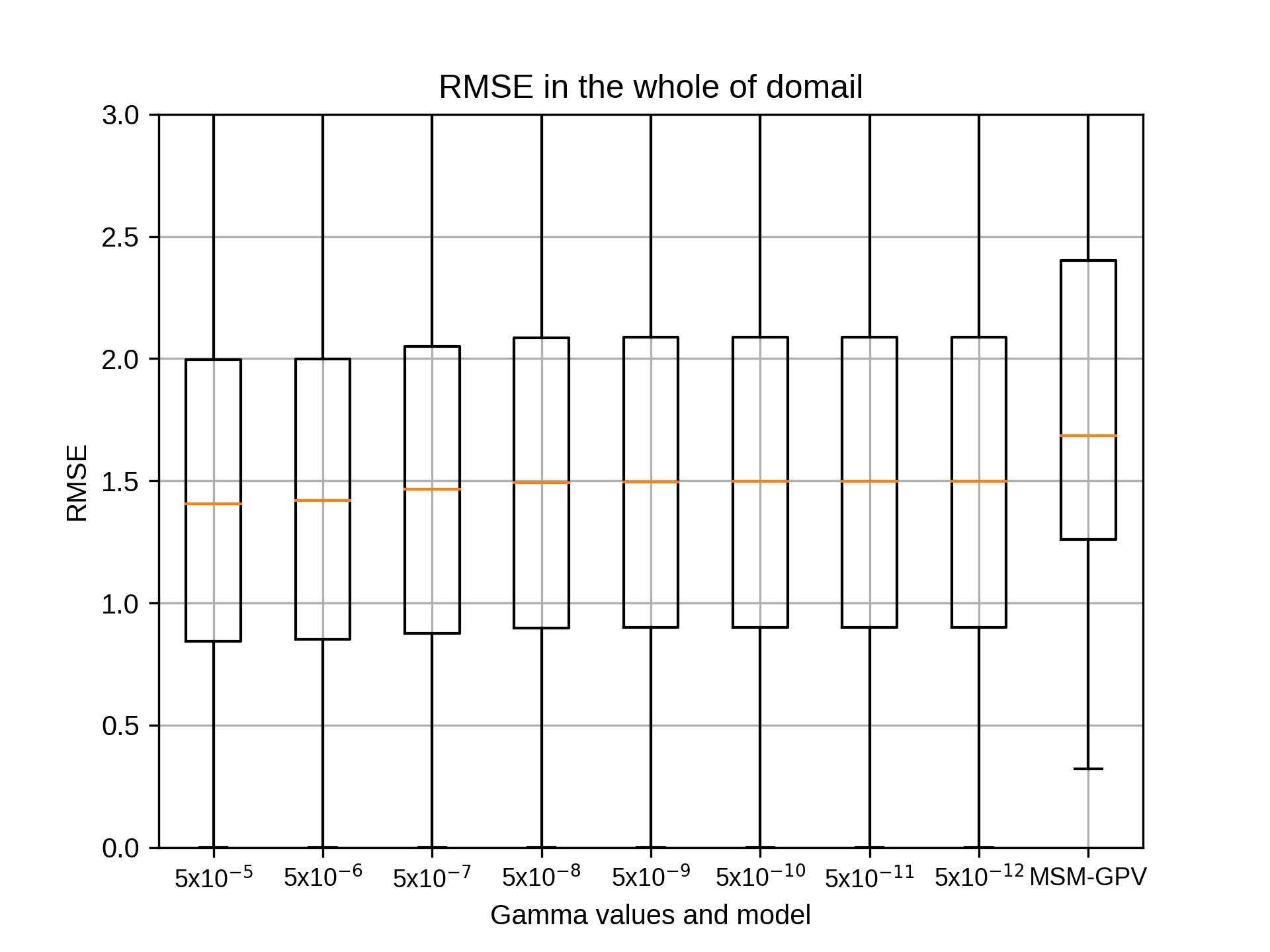

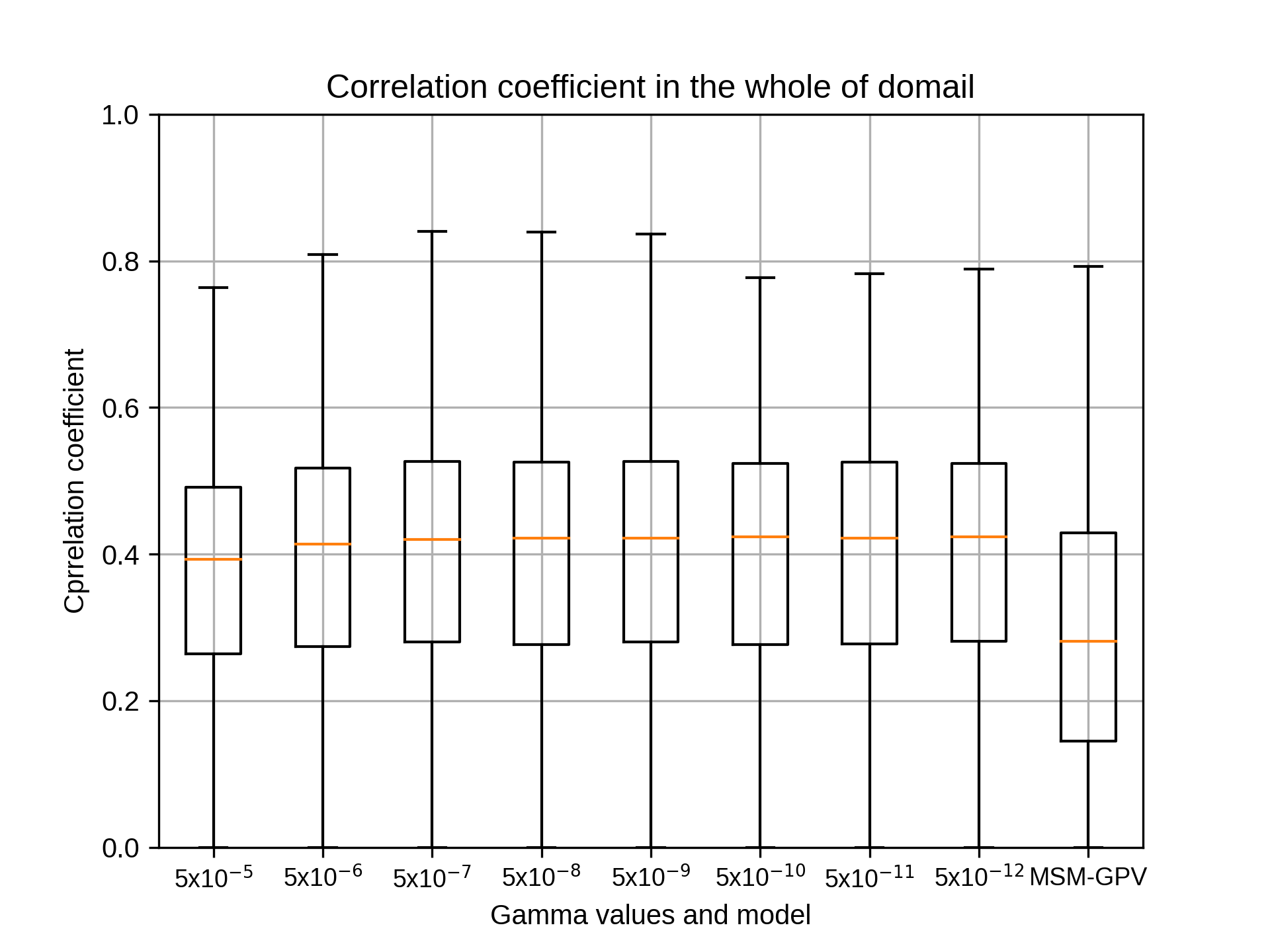

kobayashi_yusukeWednesday, October 7th, 2020 at 2:07:12 PM GMT+09:00

@takao-y

吉兼先生

小林です。お世話になっております。

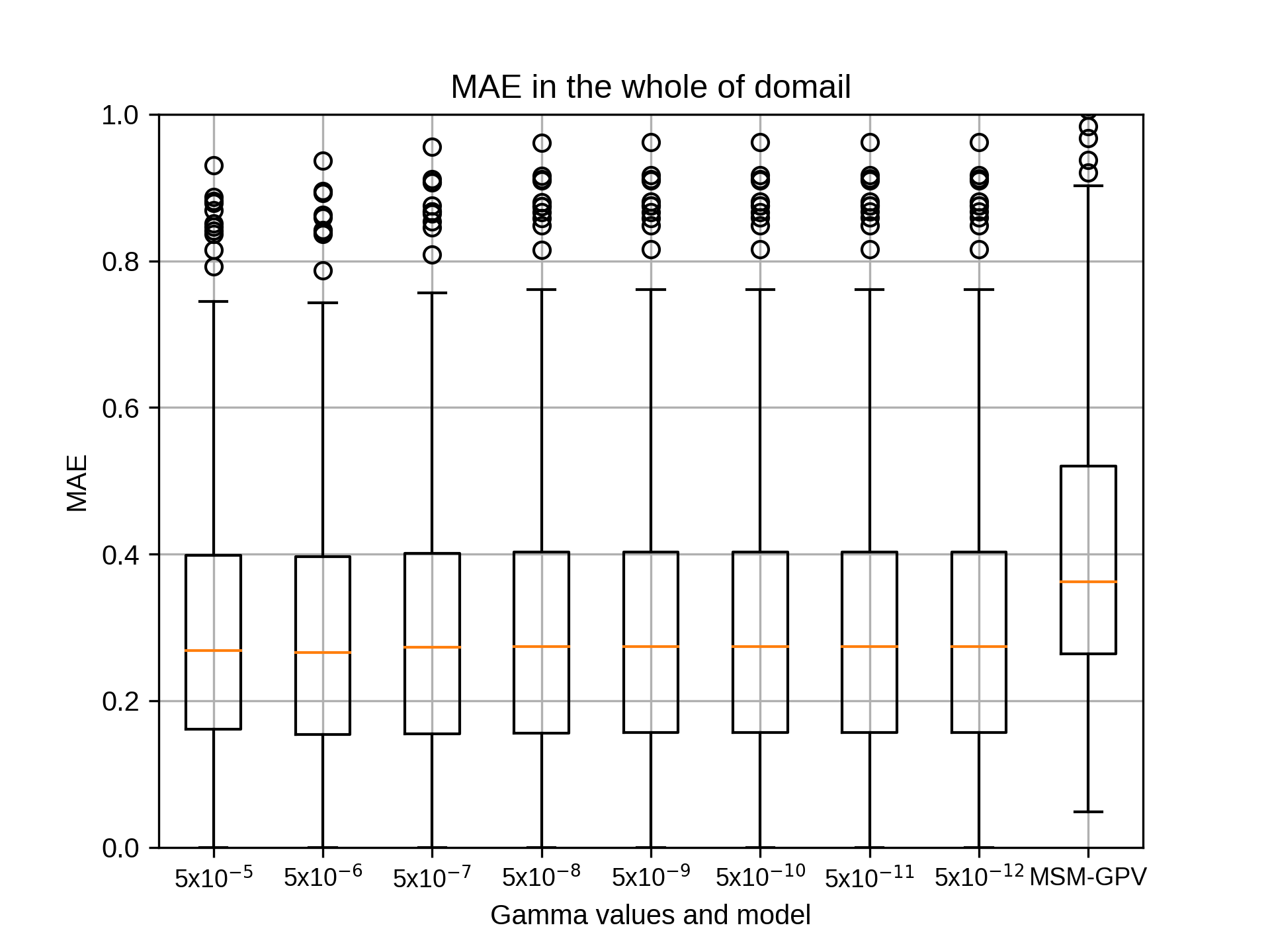

5x10-8で最も相関係数が高いケースにつきまして、5x10-9, 5x10-10を追加して(5x10-1, 5x10-2の代わりに)、gammaを再計算しました。

5x10-8で最も相関係数が高くなったのは、

(1) 4月のsiteE, (2)7月 siteD (3)10月 siteEでした。

この結果、(1) 4月のsiteEは5x10-10で最大、(2)7月 siteDは5x10-8で最大、(3)10月 siteEは5x10-8で最大となりました。

(1) 4月のsiteEは5x10-10で最大となったため、5x10-11, 5x10-12を追加して(5x10-3, 5x10-4の代わりに)、gammaを再計算しました。

この結果、(1) 4月のsiteEは5x10-10で最大となりました。なお、5x10-10と5x10-12で相関係数の中央値は同値でした。

以下にグラフを載せます。

吉兼先生

小林です。お世話になっております。

5x10-8で最も相関係数が高いケースにつきまして、5x10-9, 5x10-10を追加して(5x10-1, 5x10-2の代わりに)、gammaを再計算しました。

5x10-8で最も相関係数が高くなったのは、

(1) 4月のsiteE, (2)7月 siteD (3)10月 siteEでした。

この結果、(1) 4月のsiteEは5x10-10で最大、(2)7月 siteDは5x10-8で最大、(3)10月 siteEは5x10-8で最大となりました。

(1) 4月のsiteEは5x10-10で最大となったため、5x10-11, 5x10-12を追加して(5x10-3, 5x10-4の代わりに)、gammaを再計算しました。

この結果、(1) 4月のsiteEは5x10-10で最大となりました。なお、5x10-10と5x10-12で相関係数の中央値は同値でした。

以下にグラフを載せます。

kobayashi_yusukeWednesday, October 7th, 2020 at 2:10:34 PM GMT+09:00

これで残りはsiteD,siteEの陸上での結果のみとなりました。

こちらも改めて結果をご連絡いたします。

以上、よろしくお願いいたします。

こちらも改めて結果をご連絡いたします。

以上、よろしくお願いいたします。

takao-yWednesday, October 7th, 2020 at 2:15:53 PM GMT+09:00

小林様。ありがとうございます。D,Eの陸上での実験と平行して、ここで算出したハイパーパラメータを用いて全グリッドでの推定をお願いできますでしょうか。プログラムは以下の場所にあります。python用に一部書き換えが必要ですが、もし問題などありましたらご連絡ください。

takao-yWednesday, October 7th, 2020 at 2:17:42 PM GMT+09:00

小林様。すみません。dropboxのアドレスを忘れていました。

https://www.dropbox.com/s/x7r62s6z5960kkc/ml-region1-all-20200915.tar.gz?dl=0

よろしくお願いいたします。

https://www.dropbox.com/s/x7r62s6z5960kkc/ml-region1-all-20200915.tar.gz?dl=0

よろしくお願いいたします。

kobayashi_yusukeWednesday, October 7th, 2020 at 5:28:05 PM GMT+09:00

@takao-y

吉兼先生

お返事ありがとうございます。D,Eの陸上の結果につきましては改めてご連絡いたします。

そして、pythonの書き換えを含む新たなプログラムを用いた全グリッド推定の件につきましては、現在弊財団はJAXA様との契約で動いておりますので、一旦確認させていただいたのちに引き受けの可否をご回答させていただけると幸いです。

以上、よろしくお願いいたします。

吉兼先生

お返事ありがとうございます。D,Eの陸上の結果につきましては改めてご連絡いたします。

そして、pythonの書き換えを含む新たなプログラムを用いた全グリッド推定の件につきましては、現在弊財団はJAXA様との契約で動いておりますので、一旦確認させていただいたのちに引き受けの可否をご回答させていただけると幸いです。

以上、よろしくお願いいたします。

takao-yThursday, October 8th, 2020 at 10:05:20 AM GMT+09:00

小林様。すみません。あまり契約を理解していないのですが、pythonへの書き換えが問題でしたら、その部分については私の方で実施しますので、早めにご連絡いただければと思います。よろしくお願いいたします。

kobayashi_yusukeMonday, October 12th, 2020 at 2:43:51 PM GMT+09:00

吉兼先生

お返事ありがとうございます。pythonの書き換えだけでなく全体的な問題でございますので一旦確認させてください。以上、よろしくお願いいたします。

お返事ありがとうございます。pythonの書き換えだけでなく全体的な問題でございますので一旦確認させてください。以上、よろしくお願いいたします。

takao-yWednesday, October 7th, 2020 at 8:12:32 PM GMT+09:00

小林様。ありがとうございます。何となく陸上ではよくなっているようですが、もし可能であれば、多少海上が入っても良いので間隔を開けないで複数地点で実施してもらうことはできますでしょうか。

takao-yThursday, October 8th, 2020 at 10:01:33 AM GMT+09:00

小林様。少し説明不足だったかもしれません。例えば、沖縄本島が収まる(長方形の)領域を設定し、10グリッド毎ではなく, 1グリッド毎で評価することにより、島嶼全体としての特性が見えてくるのではないかと考えています。

yamamoto.kosukeTuesday, October 13th, 2020 at 10:54:43 AM GMT+09:00

@takao-y 様、@kobayashi_yusuke様

きちんと追いついておらず、確認が遅れまして申し訳ありません。再計算や確認等で小林さんの負担が少し重くなってしまっているようで恐縮です。RESTECさんにお願いしている作業量の問題もあり、具体的な今後の作業方針は明後日の会議で相談させていただければと思いますが、取りそぎ以下の点について確認させてください。

・現状、すべてのサイトで1,4,7,10月のガンマ、コスト、イプシロンの最適値が求まっていると思います。ただ、前回の打ち合わせでは、「5領域毎、月毎で最も精度の高いもの見つける」と認識合わせをしたつもりですので、全期間推定の前にまずは1~12月の各月でパラメータの最適値を決定する必要があると考えていますが、如何でしょうか。

・今年度中には最適パラメータで全期間推定を終わらせて、CDF補正までかけた状態での精度評価を行い、TE-Japanへの入力試験までできればよいと考えています(この結果をもとに定常運用システム構築に着手できればベストです)。なので、前年からRESTECさんにお願いしている作業量を減らしていることを考えると、現在吉兼先生からお願いされているsite D,Eでの再実験は、重要度がそれほど高くなければスキップしてもよいかと考えているのですが、如何でしょうか(もしどうしても必要であれば、先生にJAXA計算機で直接作業いただくか、私が作業するかで対応したいと思っています)。

きちんと追いついておらず、確認が遅れまして申し訳ありません。再計算や確認等で小林さんの負担が少し重くなってしまっているようで恐縮です。RESTECさんにお願いしている作業量の問題もあり、具体的な今後の作業方針は明後日の会議で相談させていただければと思いますが、取りそぎ以下の点について確認させてください。

・現状、すべてのサイトで1,4,7,10月のガンマ、コスト、イプシロンの最適値が求まっていると思います。ただ、前回の打ち合わせでは、「5領域毎、月毎で最も精度の高いもの見つける」と認識合わせをしたつもりですので、全期間推定の前にまずは1~12月の各月でパラメータの最適値を決定する必要があると考えていますが、如何でしょうか。

・今年度中には最適パラメータで全期間推定を終わらせて、CDF補正までかけた状態での精度評価を行い、TE-Japanへの入力試験までできればよいと考えています(この結果をもとに定常運用システム構築に着手できればベストです)。なので、前年からRESTECさんにお願いしている作業量を減らしていることを考えると、現在吉兼先生からお願いされているsite D,Eでの再実験は、重要度がそれほど高くなければスキップしてもよいかと考えているのですが、如何でしょうか(もしどうしても必要であれば、先生にJAXA計算機で直接作業いただくか、私が作業するかで対応したいと思っています)。

kobayashi_yusukeTuesday, October 13th, 2020 at 11:48:37 AM GMT+09:00

@yamamoto.kosuke

山本様

いつも大変お世話になっております。

今回は弊財団が環境構築を行い、解析は東京大学様がJAXA環境に入って行う、という認識でおりました。

その中で前回の打合せで、パラメータの最適値を弊財団で行うことになり、5領域ごとにガンマ、コスト、エプシロン、そしてガンマの再計算を行うことになりました。5領域ごとに行うことは認識しておりましたが、月につきましては認識しておりませんでしたので、各月ごとに行うのではなく7月を行い、追加で1,4,10月を行ったという認識でおりました。もともと環境構築が弊財団の担当と認識しておりましたので、パラメータの最適値作業は(契約内で)追加作業で行っているという認識でおります。そのため、新たなお願いに対してはJAXA様と協議した次第です。

今年度の目標に向けて、JAXA様との契約の範囲内で進めさせていただけると幸いです。

以上、よろしくお願いいたします。

山本様

いつも大変お世話になっております。

今回は弊財団が環境構築を行い、解析は東京大学様がJAXA環境に入って行う、という認識でおりました。

その中で前回の打合せで、パラメータの最適値を弊財団で行うことになり、5領域ごとにガンマ、コスト、エプシロン、そしてガンマの再計算を行うことになりました。5領域ごとに行うことは認識しておりましたが、月につきましては認識しておりませんでしたので、各月ごとに行うのではなく7月を行い、追加で1,4,10月を行ったという認識でおりました。もともと環境構築が弊財団の担当と認識しておりましたので、パラメータの最適値作業は(契約内で)追加作業で行っているという認識でおります。そのため、新たなお願いに対してはJAXA様と協議した次第です。

今年度の目標に向けて、JAXA様との契約の範囲内で進めさせていただけると幸いです。

以上、よろしくお願いいたします。

yamamoto.kosukeTuesday, October 13th, 2020 at 1:35:46 PM GMT+09:00

@kobayashi_yusuke様

「弊財団が環境構築を行い、解析は東京大学様がJAXA環境に入って行う」についてはご認識のとおりです。パラメータ最適値決定は、環境構築の一環として、吉兼先生のツールを使用して簡単に決定できればと考えていましたが、作業量の読みが甘く失礼しました(各月での推定実施は、共有させていただいている前回打合せのメモに記載させてただいていたのですが、ここはそもそも私の方に誤認があったのかもしれません)。

今後の方針としては、11月より東大側にPDが新たに加わられるので、その方にこういった作業の続きをお願いしていくことになるかと思います。ひとまず明後日は現状までの成果をご報告いただければと思います。よろしくお願いいたします。

「弊財団が環境構築を行い、解析は東京大学様がJAXA環境に入って行う」についてはご認識のとおりです。パラメータ最適値決定は、環境構築の一環として、吉兼先生のツールを使用して簡単に決定できればと考えていましたが、作業量の読みが甘く失礼しました(各月での推定実施は、共有させていただいている前回打合せのメモに記載させてただいていたのですが、ここはそもそも私の方に誤認があったのかもしれません)。

今後の方針としては、11月より東大側にPDが新たに加わられるので、その方にこういった作業の続きをお願いしていくことになるかと思います。ひとまず明後日は現状までの成果をご報告いただければと思います。よろしくお願いいたします。

kobayashi_yusukeTuesday, October 13th, 2020 at 4:07:05 PM GMT+09:00

@yamamoto.kosuke

山本様

いつも大変お世話になっております。

お返事ありがとうございます。

ご確認させていただきありがとうございました。環境構築の一環として、今回は5領域のパラメータ作業を行わせていただいております。1~12月の各月行うとなりますと、環境構築の範囲を超えますので、そこまでは引き受けていないという認識でおります。

明後日の打合せでは、5領域につきまして、7月に加え1月、4月、10月のパラメータの結果報告をさせていただきます。

ご連絡ありがとうございました。

以上、よろしくお願いいたします。

山本様

いつも大変お世話になっております。

お返事ありがとうございます。

ご確認させていただきありがとうございました。環境構築の一環として、今回は5領域のパラメータ作業を行わせていただいております。1~12月の各月行うとなりますと、環境構築の範囲を超えますので、そこまでは引き受けていないという認識でおります。

明後日の打合せでは、5領域につきまして、7月に加え1月、4月、10月のパラメータの結果報告をさせていただきます。

ご連絡ありがとうございました。

以上、よろしくお願いいたします。

takao-yThursday, October 15th, 2020 at 9:07:22 AM GMT+09:00

山本様、小林様

吉兼です。ご連絡ありがとうございます。連絡が遅くなり申し訳ありません。小林さんの負担が大きくなっているとのこと承知いたしました。この件については、本日の会議でご相談させていただければと思います。

小林さんのおっしゃっている契約というのは、恐らく私が関与できないものだと思いますので正直なところよく理解できていないのですが、可能な範囲で契約内容について教えていただければありがたいです。

前回の打ち合わせでは、特に1,4,7,10月とは決めておらず、私の方で勝手にお願いしてしまったのですが、これもよくなかったでしょうか。とりあえず季節を代表する月からどの程度違いがあるのかを確認したかったので、1,4,7,10月を先に実施していただきました。

前回の打ち合わせでは、今年度の予定として、以下を決定しています。

1.[RESTEC] 2007年から2018年の11年間(テスト年を含む)でRadar-AMeDAS解析雨量を学習する(1時間毎、5km)

•識別器は保存する

•将来的には学習・予測を1kmで行うため、1kmでどれくらいの計算コストになるか試算しておく

2.[東大] SVMの推定値に対してCDF手法を適用、精度評価

3.MSMGPV39時間予報値を用いた推定(5㎞)を実施、定常運用システムを構築(MEPS利用も検討)

今までの経験から、実行可能と判断して提案させていただいたのですが、もし負担が大きすぎるなどありましたらご意見いただければ幸いです。11月1日からYinさんが参加されますので、連携して行っていただければと作業効率もよくなり、小林さんの負担も軽減するのではないかと考えています。

吉兼です。ご連絡ありがとうございます。連絡が遅くなり申し訳ありません。小林さんの負担が大きくなっているとのこと承知いたしました。この件については、本日の会議でご相談させていただければと思います。

小林さんのおっしゃっている契約というのは、恐らく私が関与できないものだと思いますので正直なところよく理解できていないのですが、可能な範囲で契約内容について教えていただければありがたいです。

前回の打ち合わせでは、特に1,4,7,10月とは決めておらず、私の方で勝手にお願いしてしまったのですが、これもよくなかったでしょうか。とりあえず季節を代表する月からどの程度違いがあるのかを確認したかったので、1,4,7,10月を先に実施していただきました。

前回の打ち合わせでは、今年度の予定として、以下を決定しています。

1.[RESTEC] 2007年から2018年の11年間(テスト年を含む)でRadar-AMeDAS解析雨量を学習する(1時間毎、5km)

•識別器は保存する

•将来的には学習・予測を1kmで行うため、1kmでどれくらいの計算コストになるか試算しておく

2.[東大] SVMの推定値に対してCDF手法を適用、精度評価

3.MSMGPV39時間予報値を用いた推定(5㎞)を実施、定常運用システムを構築(MEPS利用も検討)

今までの経験から、実行可能と判断して提案させていただいたのですが、もし負担が大きすぎるなどありましたらご意見いただければ幸いです。11月1日からYinさんが参加されますので、連携して行っていただければと作業効率もよくなり、小林さんの負担も軽減するのではないかと考えています。

gyinThursday, October 15th, 2020 at 9:54:13 AM GMT+09:00

@gyinさんがチャンネルに参加しました

kobayashi_yusukeThursday, October 15th, 2020 at 12:06:25 PM GMT+09:00

@takao-y

吉兼先生

本日は打合せをさせていただきありがとうございました。そして早速ですが特徴量ベクトルにつきまして相談させていただきたく思います。

吉兼先生から受領したプログラムのうち、auto-check.shに以下の記述がございます。

-----

## Range of feature vectors (2xRG+1)x (2xRG+1) : e.g. RG=15: 31x31 grids =961 grids (almost 180km x180km) resolution: 0.6 deg

#nums='961'

#rg2='15'

nums='441'

rg2='10'

-----

いただいたファイルではrg2='10'となっており、(10+1)x(10+1)で現在は行っているものと考えております。

こちらのrg2を変えることでよろしいのでしょうか。

また、その変える値につきましてご教授いただけると幸いです。

siteA~siteEの5領域に対し、1,4,7,10月でcost,epsilonは決まった値で固定し、gammaでグラフを作成することを考えております。

教えていただけると幸いです。

以上、よろしくお願いいたします。

吉兼先生

本日は打合せをさせていただきありがとうございました。そして早速ですが特徴量ベクトルにつきまして相談させていただきたく思います。

吉兼先生から受領したプログラムのうち、auto-check.shに以下の記述がございます。

-----

## Range of feature vectors (2xRG+1)x (2xRG+1) : e.g. RG=15: 31x31 grids =961 grids (almost 180km x180km) resolution: 0.6 deg

#nums='961'

#rg2='15'

nums='441'

rg2='10'

-----

いただいたファイルではrg2='10'となっており、(10+1)x(10+1)で現在は行っているものと考えております。

こちらのrg2を変えることでよろしいのでしょうか。

また、その変える値につきましてご教授いただけると幸いです。

siteA~siteEの5領域に対し、1,4,7,10月でcost,epsilonは決まった値で固定し、gammaでグラフを作成することを考えております。

教えていただけると幸いです。

以上、よろしくお願いいたします。

takao-yThursday, October 15th, 2020 at 12:09:34 PM GMT+09:00

小林様

吉兼です。auto-check.shのnumsとrg2を変更して特徴ベクトルの範囲を変更します。numsとrg2の関係は(rg2x2+1)(rg2x2+1)=numsです。

今はnums=441, rg2=10となっていますが、これを

1. rg2=4, nums=81

2. rg2=6, nums=161

3. rg2=8,nums=289

4. rg2=12,nums=625

で実施していただけますでしょうか。

よろしくお願いいたします。

吉兼です。auto-check.shのnumsとrg2を変更して特徴ベクトルの範囲を変更します。numsとrg2の関係は(rg2x2+1)(rg2x2+1)=numsです。

今はnums=441, rg2=10となっていますが、これを

1. rg2=4, nums=81

2. rg2=6, nums=161

3. rg2=8,nums=289

4. rg2=12,nums=625

で実施していただけますでしょうか。

よろしくお願いいたします。

kobayashi_yusukeThursday, October 15th, 2020 at 12:15:22 PM GMT+09:00

吉兼先生

リモート・センシング技術センターの小林です。いつもお世話になっております。

さっそくのお返事ありがとうございます。

以下の4通りで順次行ってまいります。

1. rg2=4, nums=81

2. rg2=6, nums=161

3. rg2=8,nums=289

4. rg2=12,nums=625

以上、よろしくお願いいたします。

リモート・センシング技術センターの小林です。いつもお世話になっております。

さっそくのお返事ありがとうございます。

以下の4通りで順次行ってまいります。

1. rg2=4, nums=81

2. rg2=6, nums=161

3. rg2=8,nums=289

4. rg2=12,nums=625

以上、よろしくお願いいたします。

takao-yFriday, October 16th, 2020 at 7:32:29 AM GMT+09:00

小林様

計算間違えていました。2.ng2=6,nums=169ですね。

計算間違えていました。2.ng2=6,nums=169ですね。

kobayashi_yusukeFriday, October 16th, 2020 at 1:15:28 PM GMT+09:00

@takao-y

吉兼先生

ご連絡ありがとうございます。2.はng2=6,nums=169で承知しました。結果が出ましたらご連絡いたします。

吉兼先生

ご連絡ありがとうございます。2.はng2=6,nums=169で承知しました。結果が出ましたらご連絡いたします。

yamamoto.kosukeWednesday, October 21st, 2020 at 8:18:23 PM GMT+09:00

@takao-y さま

お世話になります。先日の打ち合わせで整理させていただいた今後の作業項目のうち、

「3.全格子・各月毎で識別機作成+CDF補正」

の作業に備えて、JAXAの計算機スペックの情報をお伝えすることになっていた点ですが、以下の通りお知らせします。

計算機名:zico-n, pele-n

・物理CPU数:2

・コア数:24

・スレッド数:2

・論理CPU数:96

・メモリ:131[GB]

・クロック周波数:3000[MHz]

こちら、二台ともほぼ機械学習占有で使えるはずですが、全格子・各月毎での計算に耐えられそうか、情報頂ければ幸いです。よろしくお願いいたします。

お世話になります。先日の打ち合わせで整理させていただいた今後の作業項目のうち、

「3.全格子・各月毎で識別機作成+CDF補正」

の作業に備えて、JAXAの計算機スペックの情報をお伝えすることになっていた点ですが、以下の通りお知らせします。

計算機名:zico-n, pele-n

・物理CPU数:2

・コア数:24

・スレッド数:2

・論理CPU数:96

・メモリ:131[GB]

・クロック周波数:3000[MHz]

こちら、二台ともほぼ機械学習占有で使えるはずですが、全格子・各月毎での計算に耐えられそうか、情報頂ければ幸いです。よろしくお願いいたします。

takao-yThursday, October 22nd, 2020 at 7:29:15 AM GMT+09:00

山本様

ありがとうございます。24コア同時計算できればかなり早くなるかと思いますが、バイナリ化されていないとI/Oでエラーが起こる可能性があります。もし時間がありましたら、とりあえず10コア同時計算を実施してもらえますでしょうか。よろしくお願いいたします。

ありがとうございます。24コア同時計算できればかなり早くなるかと思いますが、バイナリ化されていないとI/Oでエラーが起こる可能性があります。もし時間がありましたら、とりあえず10コア同時計算を実施してもらえますでしょうか。よろしくお願いいたします。

takao-yThursday, October 22nd, 2020 at 7:33:14 AM GMT+09:00

山本様。現状ではマシントラブルが起こる可能性が高いので、バイナリ化したシステムができるまで待っていただけますでしょうか。近日中にお渡しできると思います。

kobayashi_yusukeThursday, October 22nd, 2020 at 4:38:16 PM GMT+09:00

1,4,7月をまとめますと、特徴量ベクトルは10もしくは12のときに相関係数の中央値が最も高くなりましたが。8,10,12でほとんど差はございませんでした。

gammaの値はすべて当初のgamma値と同じ値で最大になりました。

途中のエクセルファイルにまとめておりますのでご参照ください。

引き続き、10月の処理を行ってまいります。

以上、よろしくお願いいたします。

gammaの値はすべて当初のgamma値と同じ値で最大になりました。

途中のエクセルファイルにまとめておりますのでご参照ください。

引き続き、10月の処理を行ってまいります。

以上、よろしくお願いいたします。

takao-yFriday, October 23rd, 2020 at 2:21:26 PM GMT+09:00

小林様。ありがとうございます。7月などは特に領域Cで梅雨前線による降水が多くなるため、領域を狭めた方がパフォーマンスが良いかと思ったのですが、必ずしもそうではなさそうですね。計算機のパフォーマンスも含めて考えた場合に、どの設定がベストでしょうか?

kobayashi_yusukeFriday, October 23rd, 2020 at 2:46:51 PM GMT+09:00

@takao-y

吉兼先生

ご連絡ありがとうございます。

パフォーマンスは10もしくは12がほぼ同じくらいで高くなっております。その際のsiteCでかかった時間は、

10のとき、8時間4分

12のとき、11時間39分

となりました。なお、ともに並列で複数計算しているため単純比較はできませんが、10より12のほうが多く時間がかかることは確かです。

まだ10月を計算中ですが、1月,4月,7月で計算機のパフォーマンスも含めて考えた場合には10がベストと考えております。

以上、よろしくお願いいたします。

吉兼先生

ご連絡ありがとうございます。

パフォーマンスは10もしくは12がほぼ同じくらいで高くなっております。その際のsiteCでかかった時間は、

10のとき、8時間4分

12のとき、11時間39分

となりました。なお、ともに並列で複数計算しているため単純比較はできませんが、10より12のほうが多く時間がかかることは確かです。

まだ10月を計算中ですが、1月,4月,7月で計算機のパフォーマンスも含めて考えた場合には10がベストと考えております。

以上、よろしくお願いいたします。

takao-yFriday, October 30th, 2020 at 8:56:46 AM GMT+09:00

山本様、小林様

お世話になっております。吉兼です。

pythonバイナリ化版を作成しました。

https://www.dropbox.com/s/om2co27l0wadx64/ml-bin2.tar.gz?dl=0

よりダウンロードして動作確認をお願いできますでしょうか。

(以前は接続できたのですが、今回久しぶりに実行するとVPN: Pulse Secureの接続でエラーとなり、今の所解決できていません。私のPCに問題があるのかも。)

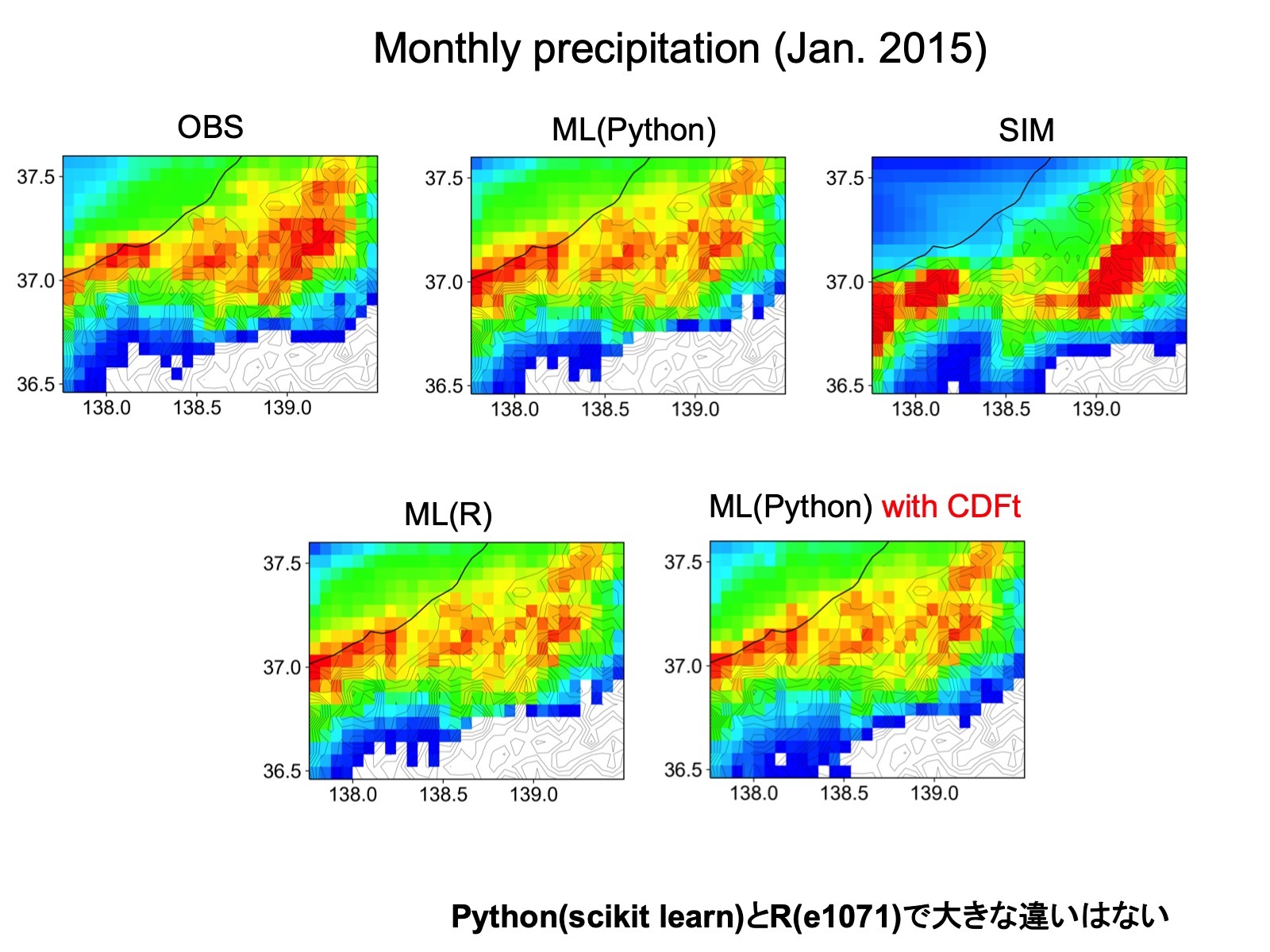

python化によって、Rを使っていたよりも大幅に(77%)計算時間が削減されました。結果も図で確認する限りほとんど同じです。(水曜日のY-labでの結果は図を間違えていました)

I/Oへの負担も大幅に軽減されていると思いますので、複数コア同時実行でも問題はないかなと思います。差し当たり12コア程度で試していただければと思います。

よろしくお願いいたします。

お世話になっております。吉兼です。

pythonバイナリ化版を作成しました。

https://www.dropbox.com/s/om2co27l0wadx64/ml-bin2.tar.gz?dl=0

よりダウンロードして動作確認をお願いできますでしょうか。

(以前は接続できたのですが、今回久しぶりに実行するとVPN: Pulse Secureの接続でエラーとなり、今の所解決できていません。私のPCに問題があるのかも。)

python化によって、Rを使っていたよりも大幅に(77%)計算時間が削減されました。結果も図で確認する限りほとんど同じです。(水曜日のY-labでの結果は図を間違えていました)

I/Oへの負担も大幅に軽減されていると思いますので、複数コア同時実行でも問題はないかなと思います。差し当たり12コア程度で試していただければと思います。

よろしくお願いいたします。

yamamoto.kosukeWednesday, November 4th, 2020 at 1:25:38 PM GMT+09:00

@takao-y さま

ご連絡ありがとうございます。次回打合せまでに間に合えば私の方で確認してみます。取り急ぎご連絡まで。

ご連絡ありがとうございます。次回打合せまでに間に合えば私の方で確認してみます。取り急ぎご連絡まで。

takao-yFriday, October 30th, 2020 at 9:40:43 AM GMT+09:00

Yin-san,

I think you are also going to work on JAXA’s server (lili?) from the next month. The system is different from that in isotope2/3. If you have any questions about JAXA’s server, please ask Yamamoto-san and Kobayashi-san. Kobayashi-san is a specialist of machine learning system.

----

You can use the machine learning system in the python virtual environment (python venv) on isotope3. (It does not work on isotope2 so far.) I put the system in the following directory. Please copy the system to your directory.

isotope3: /data28/yoshikane/pub/ml-bin.tar.gz

I think you can also use the system on your PC. If you have time, please try it.

The details (how to use and how to make the python venv) are written in README file.

Please refer to README-R.txt and README-python.txt.

If you have any questions, please let us know.

T. Yoshikane

I think you are also going to work on JAXA’s server (lili?) from the next month. The system is different from that in isotope2/3. If you have any questions about JAXA’s server, please ask Yamamoto-san and Kobayashi-san. Kobayashi-san is a specialist of machine learning system.

----

You can use the machine learning system in the python virtual environment (python venv) on isotope3. (It does not work on isotope2 so far.) I put the system in the following directory. Please copy the system to your directory.

isotope3: /data28/yoshikane/pub/ml-bin.tar.gz

I think you can also use the system on your PC. If you have time, please try it.

The details (how to use and how to make the python venv) are written in README file.

Please refer to README-R.txt and README-python.txt.

If you have any questions, please let us know.

T. Yoshikane

gyinFriday, October 30th, 2020 at 3:19:13 PM GMT+09:00

Dear Yoshikane-sensei,

Thank you for your guidance! I have copied the system to my directory and I will start exploring it. I will let you know if I meet any problem.

As for the JAXA's server, am I supposed to have an account on it later?

Best regards,

Gaohong

Thank you for your guidance! I have copied the system to my directory and I will start exploring it. I will let you know if I meet any problem.

As for the JAXA's server, am I supposed to have an account on it later?

Best regards,

Gaohong

yamamoto.kosukeWednesday, November 4th, 2020 at 1:32:32 PM GMT+09:00

@gyin -san,

I will prepare your account in JAXA server and let you know when it is ready.

I will prepare your account in JAXA server and let you know when it is ready.

gyinWednesday, November 4th, 2020 at 1:38:02 PM GMT+09:00

Yamamoto-san,

Thank you very much for your help!

Best regards,

Gaohong

Thank you very much for your help!

Best regards,

Gaohong

yamamoto.kosukeWednesday, November 4th, 2020 at 5:44:30 PM GMT+09:00

@gyin -san,

Do you have a preferred account name? If you do, please let me know :-)

Do you have a preferred account name? If you do, please let me know :-)

gyinWednesday, November 4th, 2020 at 11:10:38 PM GMT+09:00

Yamamoto-san,

I am sorry for the late reply. If you have not yet created the account, can I use the name "gyin"? If you have already made it, I will just use the one you created for me. Thank you very much!

Best regards,

Gaohong

I am sorry for the late reply. If you have not yet created the account, can I use the name "gyin"? If you have already made it, I will just use the one you created for me. Thank you very much!

Best regards,

Gaohong

yamamoto.kosukeThursday, November 5th, 2020 at 7:50:43 PM GMT+09:00

@gyin -san,

Thank you for the reply! I have just sent the access information to your e-mail. Please check it!

Thank you for the reply! I have just sent the access information to your e-mail. Please check it!

takao-yWednesday, November 4th, 2020 at 12:04:31 PM GMT+09:00

Yin-san, Kobayashi-san,

I uploaded the PPT file of our research plans.

https://www.dropbox.com/s/etpjmji8agvewzc/20201104-yoshikane.pptx?dl=0

We are trying to investigate the applicability of the machine learning method in Japan area and will provide the estimated data to TE-Japan (Flood forecasting system) in this business year (by the end of March in 2021). For the time being, we want you to try to use the machine learning system include the simple evaluation method for parameter setting (hyper-parameters and range of feature vector). And we wish you could summarize the research (1) in PPT (verification of the method applying to the Japan area every season) as a scientific paper. I think you will take over a part of Kobayashi-san’s work in JAXA’s server. Kobayashi-san, please tell her how to use the system. I think your system is optimized in the server. (If possible, could you replace the system by the new one including binary data conversion?)

If you have any questions, please let me know.

T. Yoshikane

I uploaded the PPT file of our research plans.

https://www.dropbox.com/s/etpjmji8agvewzc/20201104-yoshikane.pptx?dl=0

We are trying to investigate the applicability of the machine learning method in Japan area and will provide the estimated data to TE-Japan (Flood forecasting system) in this business year (by the end of March in 2021). For the time being, we want you to try to use the machine learning system include the simple evaluation method for parameter setting (hyper-parameters and range of feature vector). And we wish you could summarize the research (1) in PPT (verification of the method applying to the Japan area every season) as a scientific paper. I think you will take over a part of Kobayashi-san’s work in JAXA’s server. Kobayashi-san, please tell her how to use the system. I think your system is optimized in the server. (If possible, could you replace the system by the new one including binary data conversion?)

If you have any questions, please let me know.

T. Yoshikane

yamamoto.kosukeWednesday, November 4th, 2020 at 1:33:19 PM GMT+09:00

チャンネル名を「機械学習」から「machine-learning」に変更しました

takao-yMonday, November 9th, 2020 at 3:41:29 PM GMT+09:00

Yin-san,

Were you able to login to JAXA’s server?

By the way, I uploaded my presentation file about our study. If you would like, please check it.

https://www.dropbox.com/s/m66s004p96nalfd/20201005.pptx?dl=0

This presentation is written in Japanese but I added the explanations in English in note flame in PowerPoint.

If you have any questions, please let us know.

T. Yoshikane

Were you able to login to JAXA’s server?

By the way, I uploaded my presentation file about our study. If you would like, please check it.

https://www.dropbox.com/s/m66s004p96nalfd/20201005.pptx?dl=0

This presentation is written in Japanese but I added the explanations in English in note flame in PowerPoint.

If you have any questions, please let us know.

T. Yoshikane

gyinMonday, November 9th, 2020 at 5:28:19 PM GMT+09:00

Dear Yoshikane-sensei,

Yes, I can login to the JAXA's server now. I will go through the slides carefully and let you know if I have any questions!

Thank you!

Best regards,

Gaohong

Yes, I can login to the JAXA's server now. I will go through the slides carefully and let you know if I have any questions!

Thank you!

Best regards,

Gaohong

takao-yThursday, November 12th, 2020 at 11:48:20 AM GMT+09:00

吉兼です。現在までと今後のワークフローをまとめてみました。step 3はYinさんと私が担当いたします。JAXAのサーバでの実行環境の詳細について教えていただければ幸いです。もし可能であれば、一度引き継ぎの打ち合わせを作業担当者(小林さん、Yinさん、私、その他?)だけで行えればと考えていますが、いかがでしょうか。step 4(小林さん担当?)との関係もあると思いますので、細かい作業内容について確認ができればと思います。よろしくお願いいたします。

Workflow

Restec

1. Obtain the optimal values of hyper-parameters

We have to investigate the following four factors such as hyper-parameters and the size of feature vector (simulated precipitation distribution) before estimating the precipitation in all grids.

Hyper-prameters: Gamma (Gm), Cost (C), Epsilon (Ep)

The size of feature (Fv) initial 21x21 (rg2=10) rg2: the number of grid points from the center of FV

Initial valuese and assumed ranges are obtained from random search at some points.

Step 1: For hyper parameters

1.1 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (Fixed)

If the minimum or maximum values are selected, please extend the range and try it again.

1.2 Gm (Fixed), C (Change), Ep (Fixed), Fv (Fixed)

If the minimum or maximum values are selected, please extend the range and try it again.

1.3 Gm (Fixed), C (Fixed), Ep (Change), Fv (Fixed)

If the minimum or maximum values are selected, please extend the range and try it again.

1.4 Gm (Change), C (Fixed), Ep (Fixed), Fv (Fixed)

If the Gm values are not largely different from the values of 1.1, the oprtimal values are determined.

If not, please repeat the cycle from 1.2 to 1.4

We confirm the sensitivity of C and Ep is not large.

For the reason, we fixed the C and Ep by optimal values obtained in the step1.

Step 2: For the size of FV

2.1 Gm (Change the values), C (Fixed by Optimal values), Ep (Fixed by Optimal values), Fv (rg2=4)

If the minimum or maximum values are selected, please extend the range and try it again.

2.2 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=6)

If the minimum or maximum values are selected, please extend the range and try it again.

2.3 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=8)

If the minimum or maximum values are selected, please extend the range and try it again.

2.4 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=12)

If the minimum or maximum values are selected, please extend the range and try it again.

If the performance does not largely improved, the size of FV (rg2=10) is determined.

2.5 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=14)

If the minimum or maximum values are selected, please extend the range and try it again.

If the performance does not largely improved, the size of FV (rg2=12) is determined.

We confirmed the performance in the case of rg2=12 does not largely change as those of rg2=10 in all cases.

For the reason, we determined the rg2 as 10.

It is necessary to obtain the optimal values in January, April, July, and October in all regions (A,B,C,D, and E).

----- Almost finished? (2020.11.12)

Step 3 Estimate the precipitation in all grid points by ML + CDF (transform?) using optimal values

( Yin-san and I are in charge.)

This process will be conducted on the JAXA’s server.

We’d appreciate it if you could tell us about the environmental setting on JAXA’s server.

3.1 Need to modify the “ml-bin” according to the environment of JAXA’s server.

How can we get the Input data and adjust the domains?

3.2 Check the server performance.

Is the concurrent execution (e.g. using 10 cores) of the machine learning system possible?

3.3 Execute the ML system using analysis data of MSM-GPV from 2007 to 2018.

Estimation of precipitation in all months

From December to February using optimal parameters in January.

From March to May using optimal parameters in April.

From June to August using optimal parameters in July.

From September to November using optimal parameters in October.

3.4 Execute the ML system using forecast data of MSM-GPV in 2019?

Estimation of precipitation in all months by ML with the classifiers produced by the training form 2007 to 2018.

(CDF-transform method would be applied.)

From December to February using optimal parameters in January.

From March to May using optimal parameters in April.

From June to August using optimal parameters in July.

From September to November using optimal parameters in October.

3.5 Check the performance

Advantages and disadvantages of this method

Which month is the best? And why?

How can we improve the problems?

3.6 Submit a paper to a scientific journal (Yin-san).

Step 4 Construction of ML system for TE-Japan

( Kobayashi-san is in charge?)

4.1 Construction of ML system using the classifiers of old version.

4.2 ML system is improved using the classifiers produced by step 3.4.

The classifiers are produced by using the data of MSMGPV and Radar_AMeDAS from 2007 to 2018.

4.3 ML system is improved by applying the CDF-transform method?

Workflow

Restec

1. Obtain the optimal values of hyper-parameters

We have to investigate the following four factors such as hyper-parameters and the size of feature vector (simulated precipitation distribution) before estimating the precipitation in all grids.

Hyper-prameters: Gamma (Gm), Cost (C), Epsilon (Ep)

The size of feature (Fv) initial 21x21 (rg2=10) rg2: the number of grid points from the center of FV

Initial valuese and assumed ranges are obtained from random search at some points.

Step 1: For hyper parameters

1.1 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (Fixed)

If the minimum or maximum values are selected, please extend the range and try it again.

1.2 Gm (Fixed), C (Change), Ep (Fixed), Fv (Fixed)

If the minimum or maximum values are selected, please extend the range and try it again.

1.3 Gm (Fixed), C (Fixed), Ep (Change), Fv (Fixed)

If the minimum or maximum values are selected, please extend the range and try it again.

1.4 Gm (Change), C (Fixed), Ep (Fixed), Fv (Fixed)

If the Gm values are not largely different from the values of 1.1, the oprtimal values are determined.

If not, please repeat the cycle from 1.2 to 1.4

We confirm the sensitivity of C and Ep is not large.

For the reason, we fixed the C and Ep by optimal values obtained in the step1.

Step 2: For the size of FV

2.1 Gm (Change the values), C (Fixed by Optimal values), Ep (Fixed by Optimal values), Fv (rg2=4)

If the minimum or maximum values are selected, please extend the range and try it again.

2.2 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=6)

If the minimum or maximum values are selected, please extend the range and try it again.

2.3 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=8)

If the minimum or maximum values are selected, please extend the range and try it again.

2.4 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=12)

If the minimum or maximum values are selected, please extend the range and try it again.

If the performance does not largely improved, the size of FV (rg2=10) is determined.

2.5 Gm (Change the values), C (Fixed), Ep (Fixed), Fv (rg2=14)

If the minimum or maximum values are selected, please extend the range and try it again.

If the performance does not largely improved, the size of FV (rg2=12) is determined.

We confirmed the performance in the case of rg2=12 does not largely change as those of rg2=10 in all cases.

For the reason, we determined the rg2 as 10.

It is necessary to obtain the optimal values in January, April, July, and October in all regions (A,B,C,D, and E).

----- Almost finished? (2020.11.12)

Step 3 Estimate the precipitation in all grid points by ML + CDF (transform?) using optimal values

( Yin-san and I are in charge.)

This process will be conducted on the JAXA’s server.

We’d appreciate it if you could tell us about the environmental setting on JAXA’s server.

3.1 Need to modify the “ml-bin” according to the environment of JAXA’s server.

How can we get the Input data and adjust the domains?

3.2 Check the server performance.

Is the concurrent execution (e.g. using 10 cores) of the machine learning system possible?

3.3 Execute the ML system using analysis data of MSM-GPV from 2007 to 2018.

Estimation of precipitation in all months

From December to February using optimal parameters in January.

From March to May using optimal parameters in April.

From June to August using optimal parameters in July.

From September to November using optimal parameters in October.

3.4 Execute the ML system using forecast data of MSM-GPV in 2019?

Estimation of precipitation in all months by ML with the classifiers produced by the training form 2007 to 2018.

(CDF-transform method would be applied.)

From December to February using optimal parameters in January.

From March to May using optimal parameters in April.

From June to August using optimal parameters in July.

From September to November using optimal parameters in October.

3.5 Check the performance

Advantages and disadvantages of this method

Which month is the best? And why?

How can we improve the problems?

3.6 Submit a paper to a scientific journal (Yin-san).

Step 4 Construction of ML system for TE-Japan

( Kobayashi-san is in charge?)

4.1 Construction of ML system using the classifiers of old version.

4.2 ML system is improved using the classifiers produced by step 3.4.

The classifiers are produced by using the data of MSMGPV and Radar_AMeDAS from 2007 to 2018.

4.3 ML system is improved by applying the CDF-transform method?

kobayashi_yusukeThursday, November 12th, 2020 at 7:48:22 PM GMT+09:00

吉兼先生

小林です。お世話になっております。

打合せにつきまして承知しました。可能ならJAXAの山本様にもご参加いただいたほうがよろしいかと考えております。山本様を含めた形で日程調整させていただけると幸いです。

Step4につきましては弊財団で担当しますが、詳細は私からですとご説明が難しいため、

Step2からStep3の引継ぎのみ打合せさせていただけると幸いです。

なお、Step2につきまして10月が残っておりますが、解析は完了しましたが整理できておらず、

ご報告できておりません。

整理が完了し、ご報告できるかたちになりましたらこちらでご報告いたします。

以上、よろしくお願いいたします。

小林です。お世話になっております。

打合せにつきまして承知しました。可能ならJAXAの山本様にもご参加いただいたほうがよろしいかと考えております。山本様を含めた形で日程調整させていただけると幸いです。

Step4につきましては弊財団で担当しますが、詳細は私からですとご説明が難しいため、

Step2からStep3の引継ぎのみ打合せさせていただけると幸いです。

なお、Step2につきまして10月が残っておりますが、解析は完了しましたが整理できておらず、

ご報告できておりません。

整理が完了し、ご報告できるかたちになりましたらこちらでご報告いたします。

以上、よろしくお願いいたします。

takao-ySaturday, November 14th, 2020 at 8:27:19 AM GMT+09:00

小林様

吉兼です。ご連絡ありがとうございます。承知いたしました。Step4については別の機会に打ち合わせができればと思います。(基本的には、Step3で作成した識別器をStep4で用いることを想定して進めていきたいと考えています。)よろしくお願いいたします。

吉兼です。ご連絡ありがとうございます。承知いたしました。Step4については別の機会に打ち合わせができればと思います。(基本的には、Step3で作成した識別器をStep4で用いることを想定して進めていきたいと考えています。)よろしくお願いいたします。

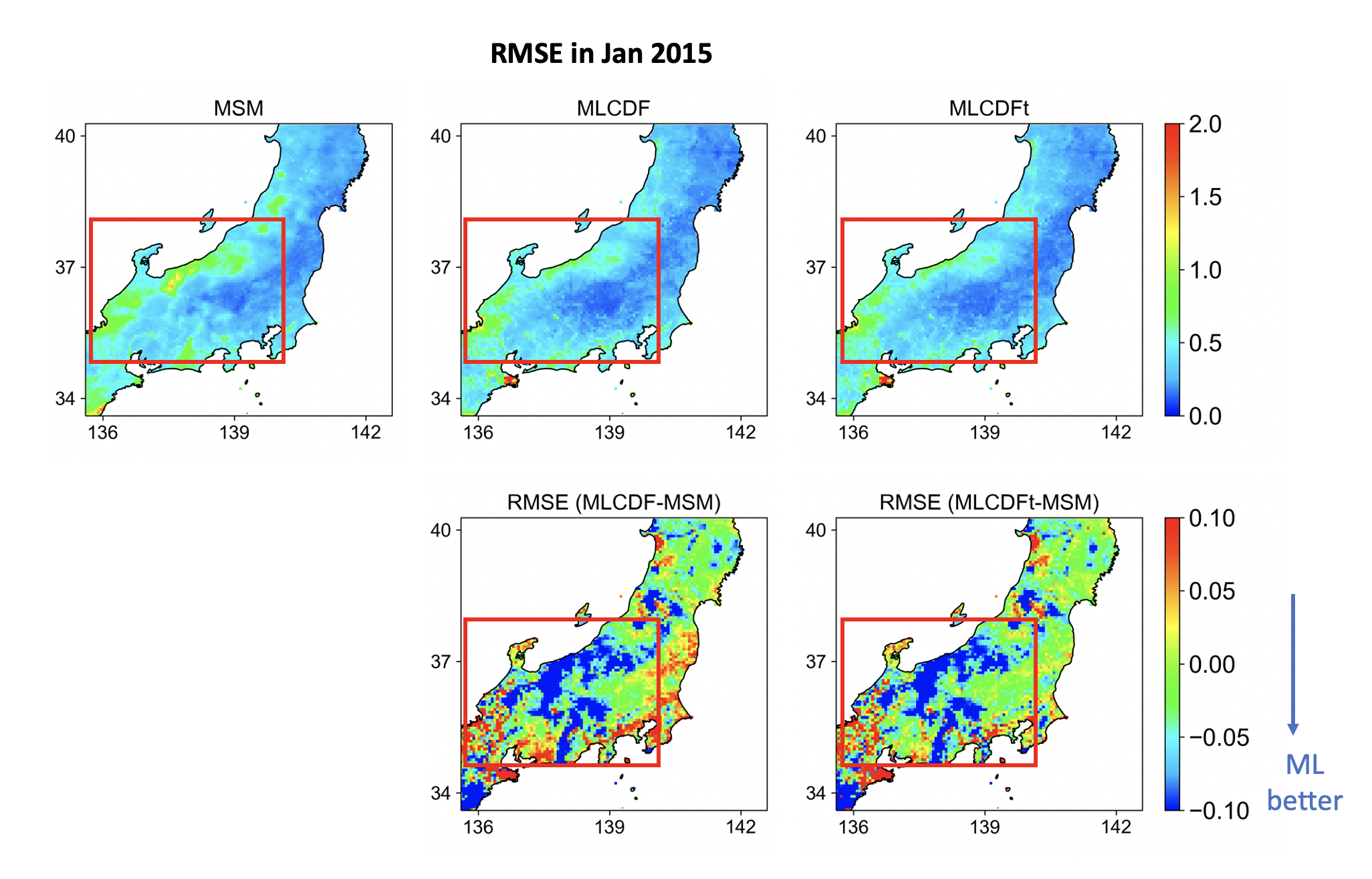

takao-ySaturday, November 14th, 2020 at 9:24:55 AM GMT+09:00

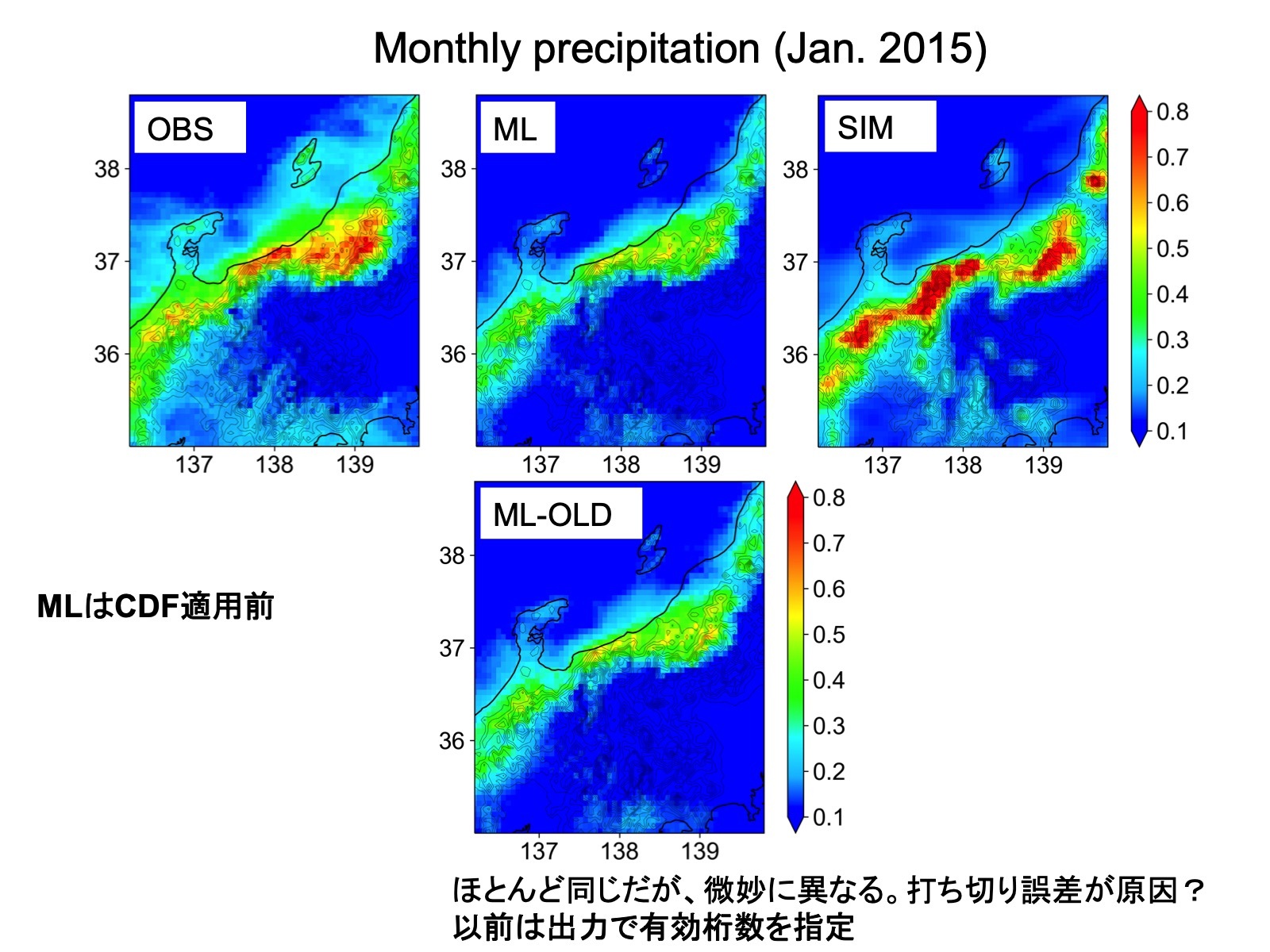

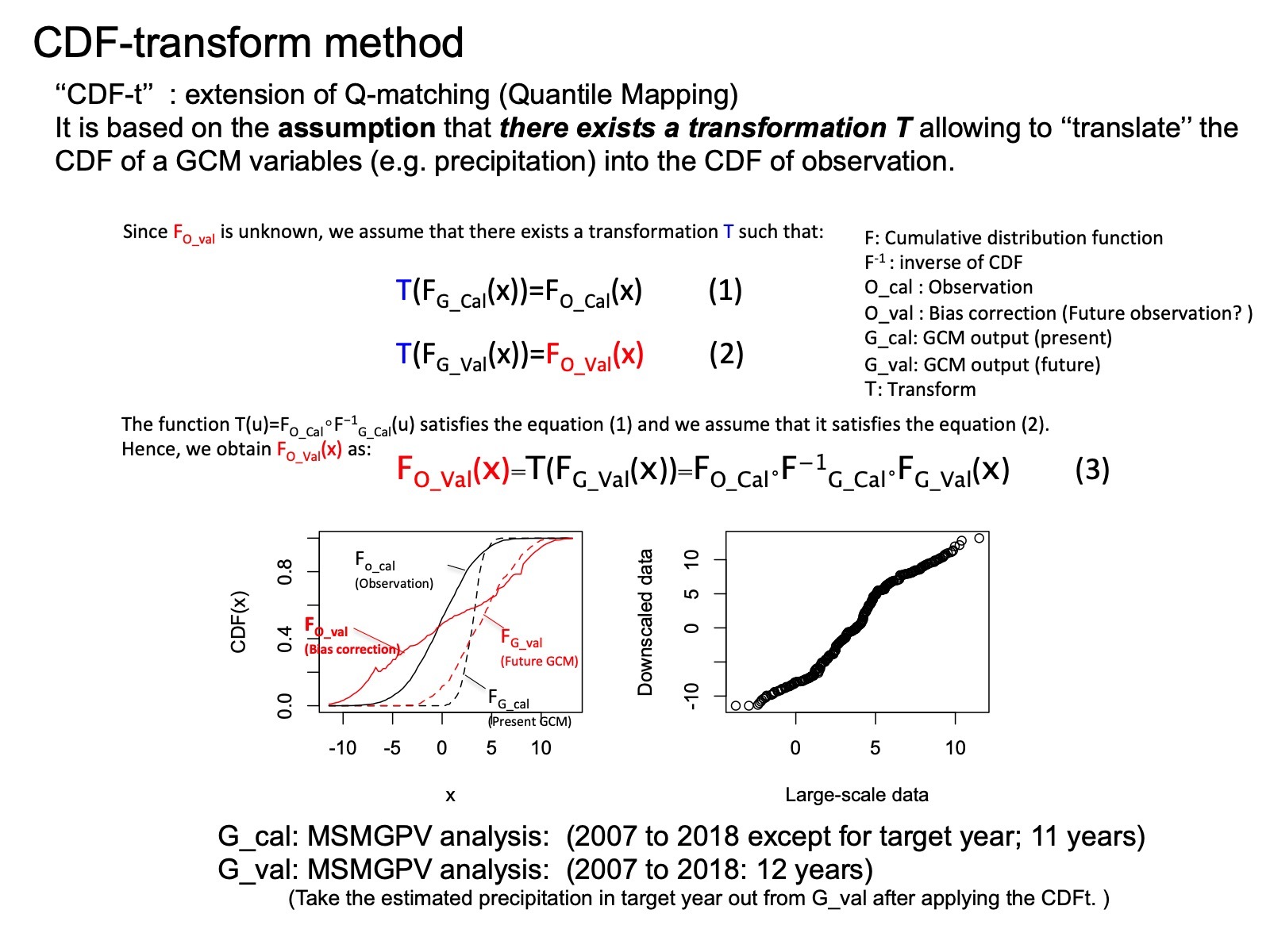

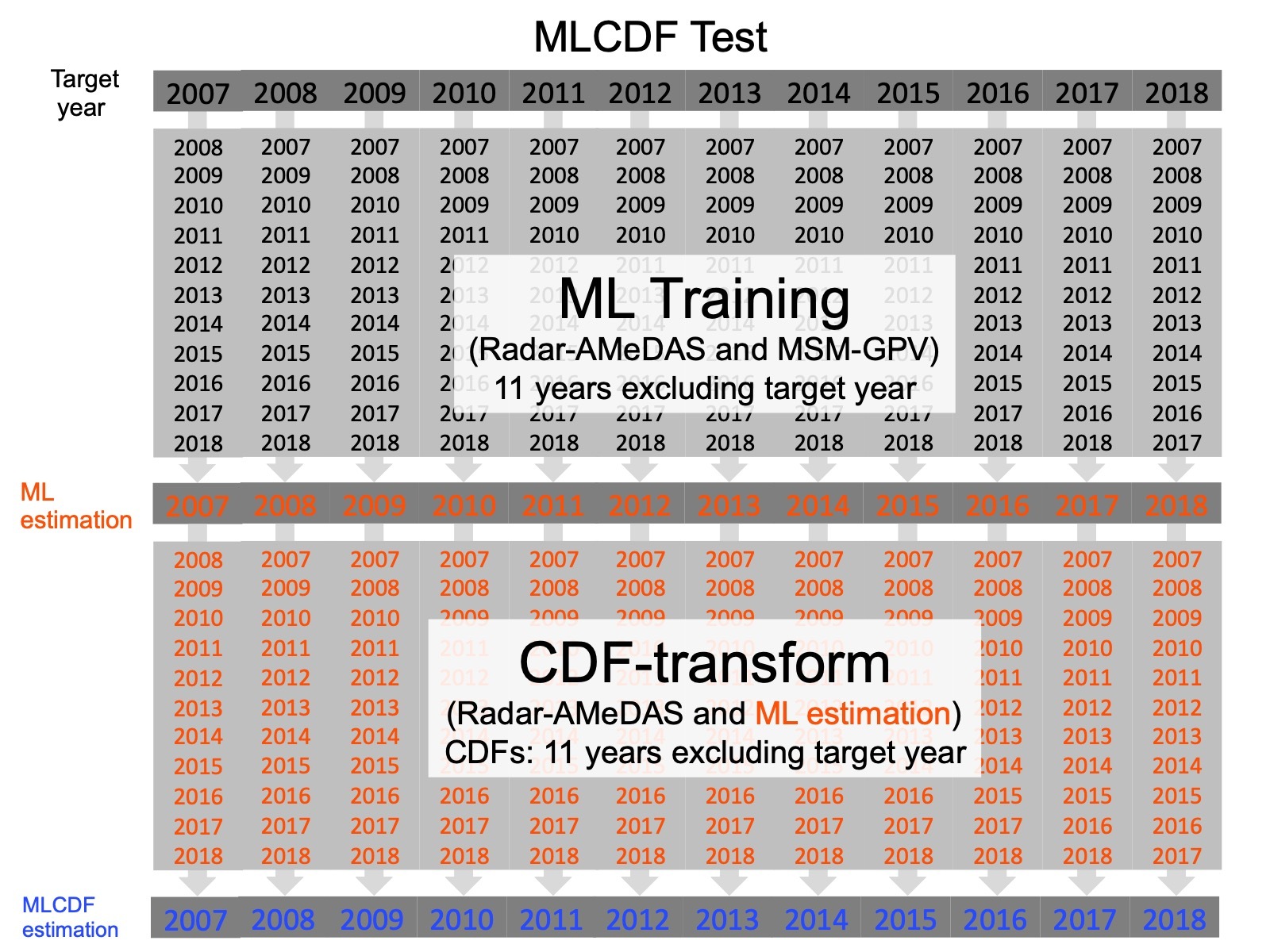

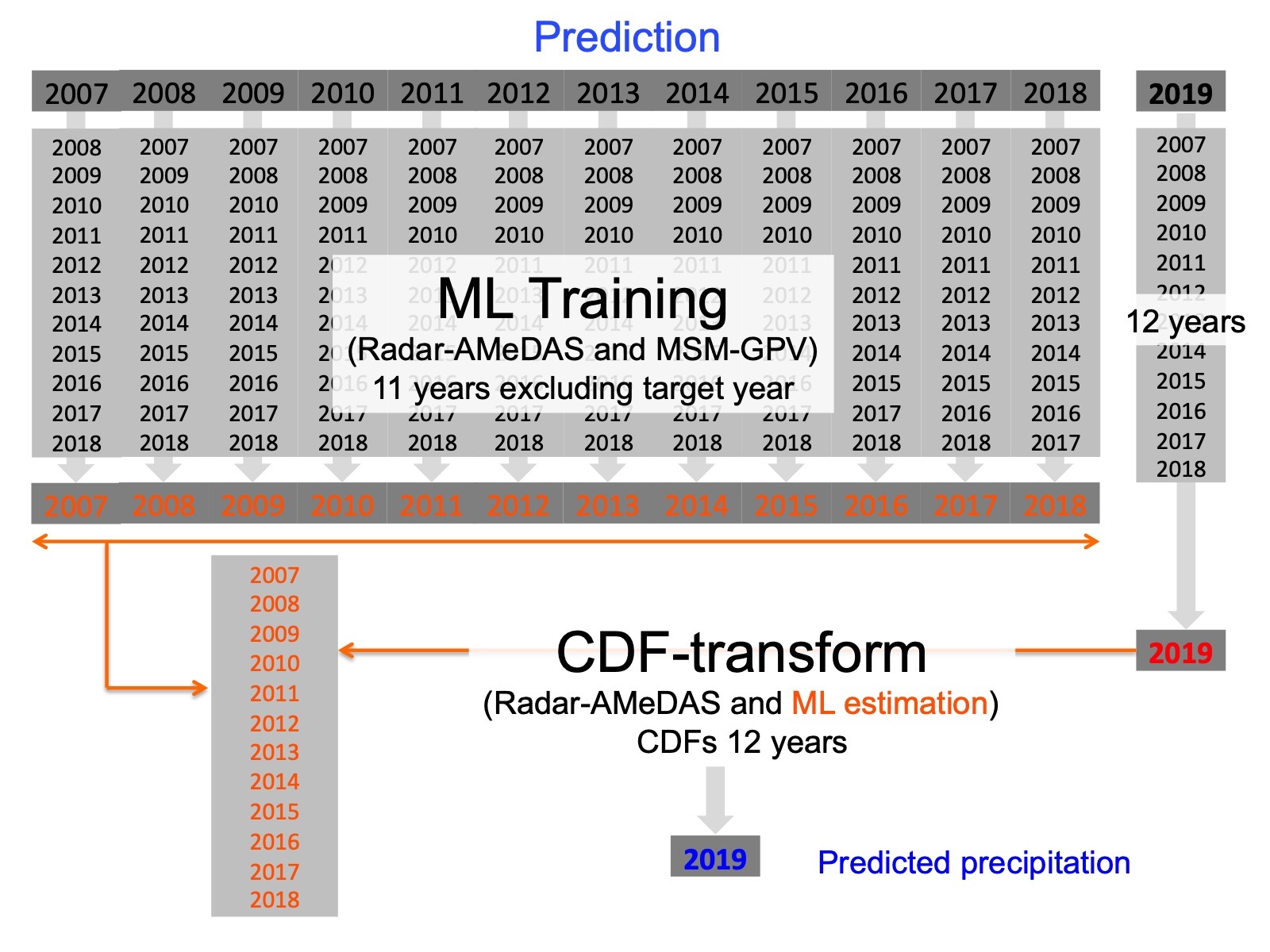

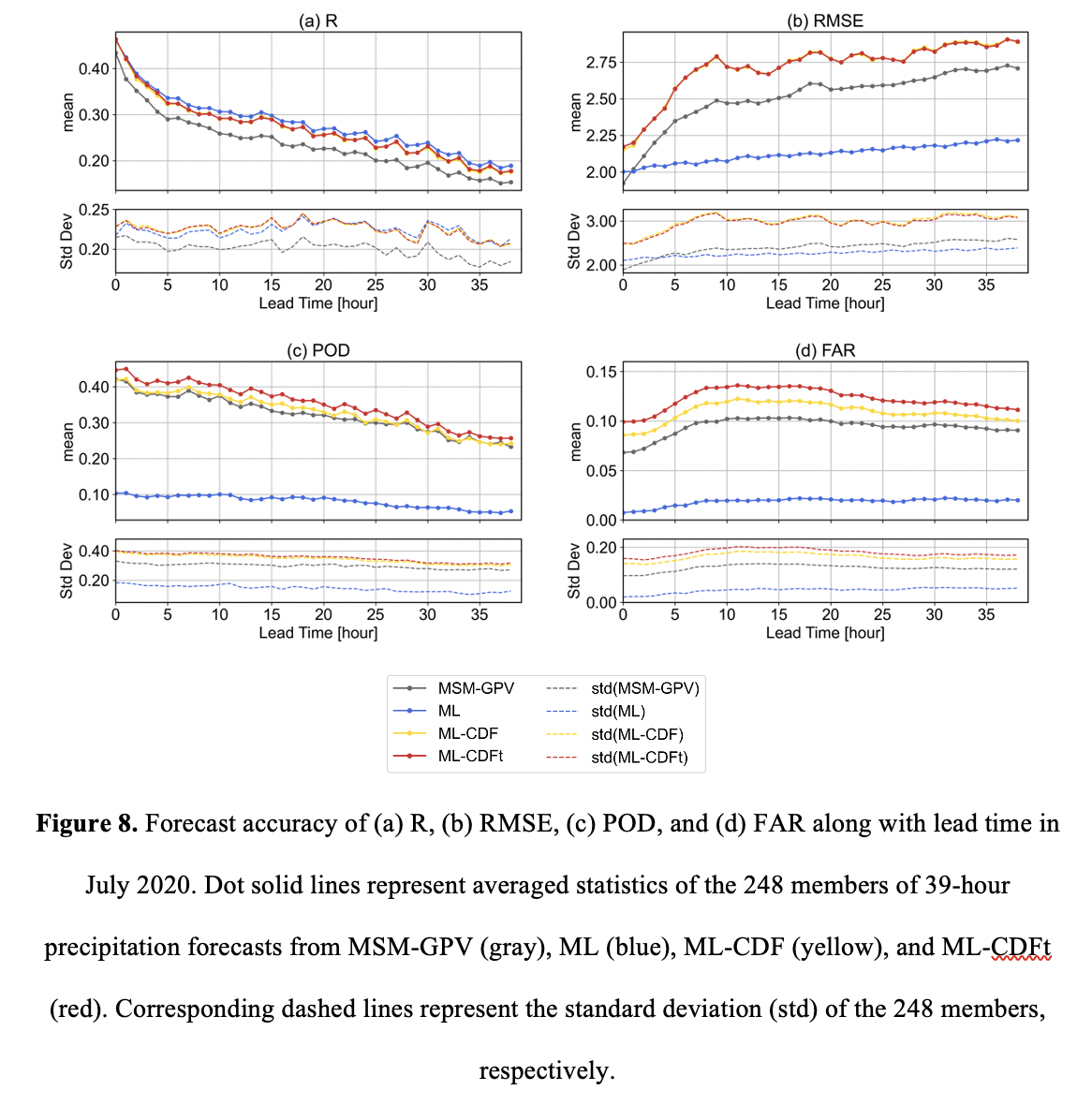

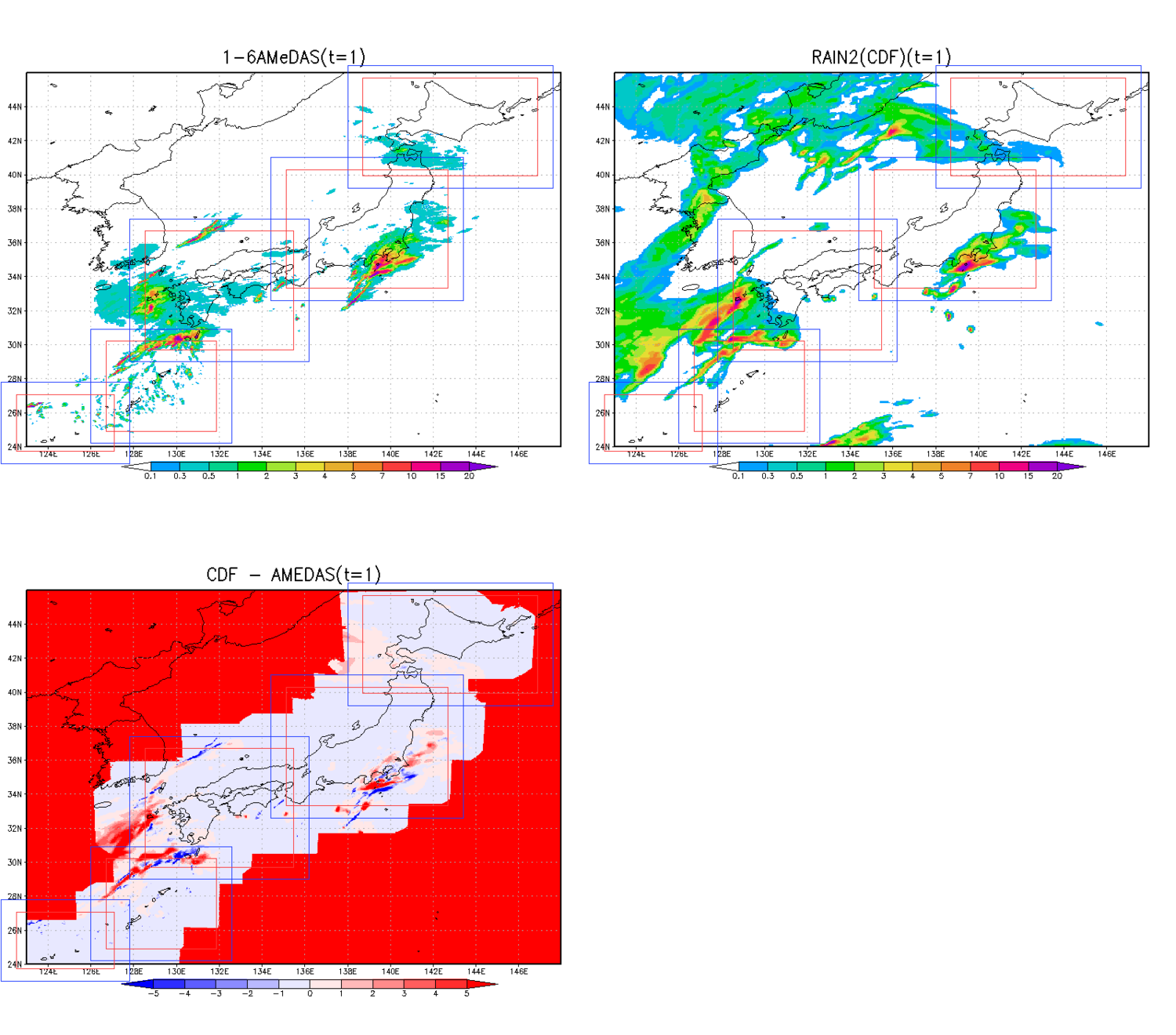

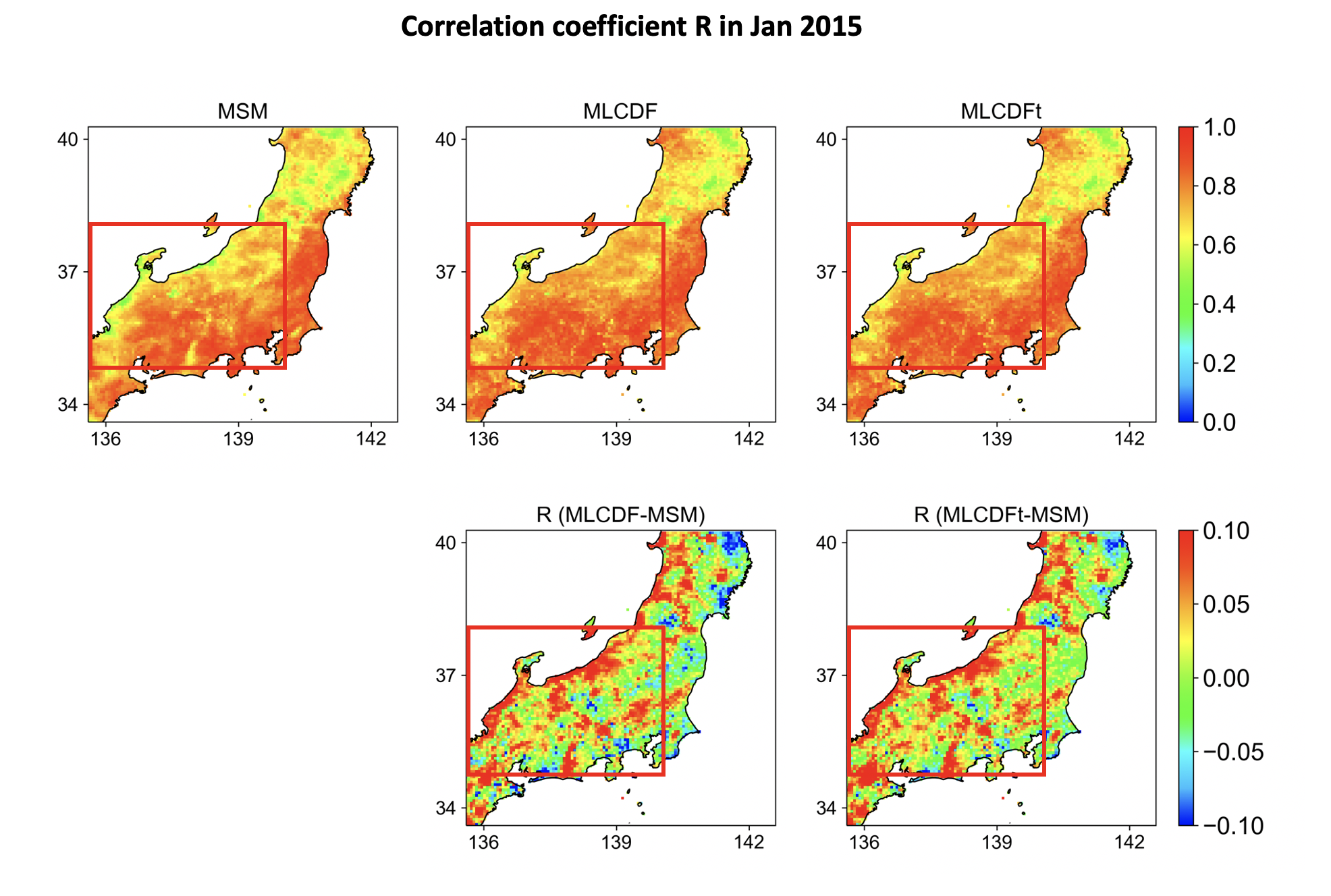

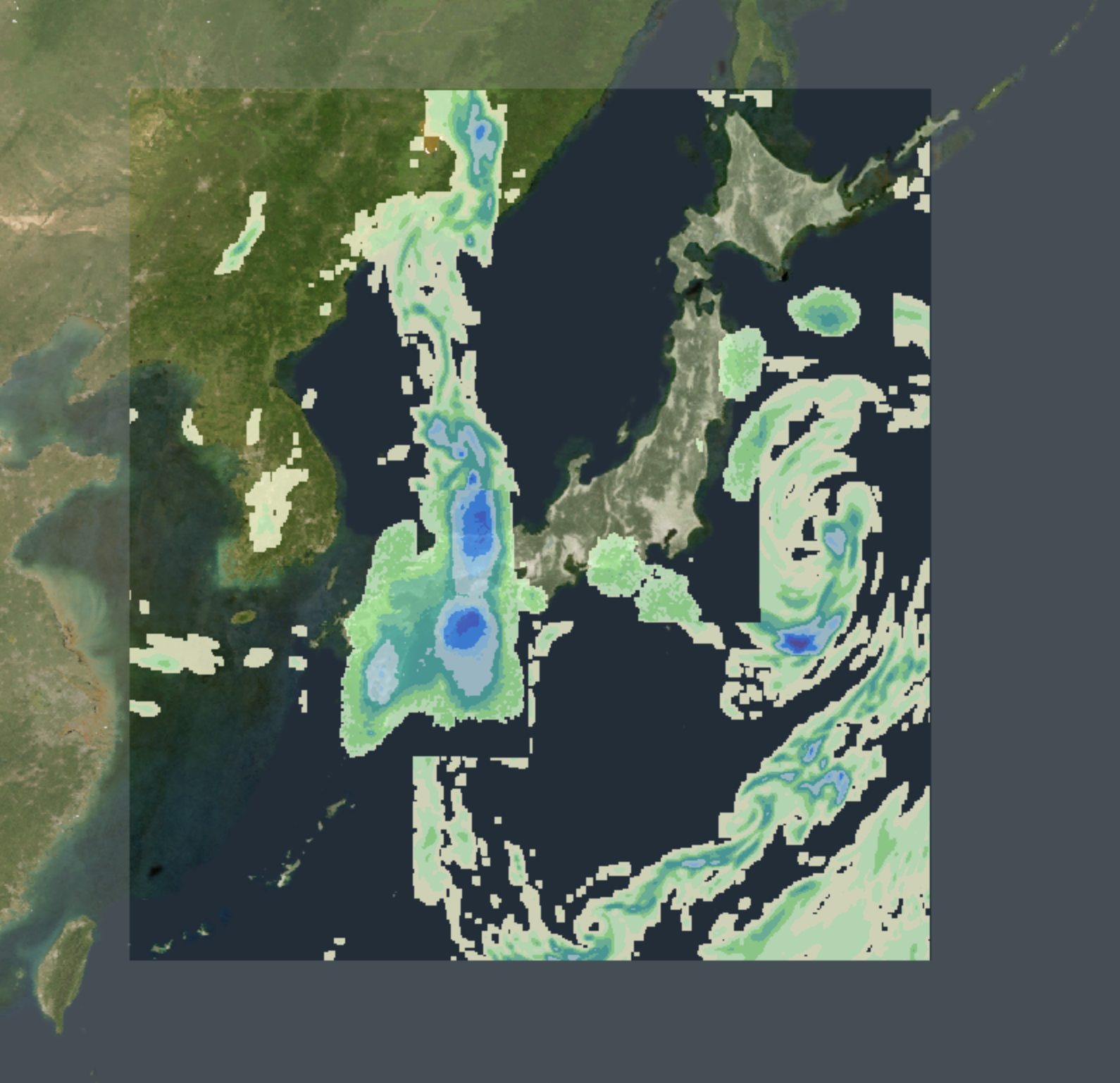

吉兼です。

バイナリ化版のCDF-transform法適用版を以下に置きました。

https://www.dropbox.com/s/wkfq13qeh44utkz/mlcdft-bin.tar.gz?dl=0

これにより、観測最大値で頭打ちになる問題に対応できると考えています。(例えば、昨年の台風19号のケースなどで降水量ピークが頭打ちとなる問題の改善を確認)これにより、山本さんの結果にもみられた2018年7月の西日本豪雨での河川流量の過小評価についてもある程度改善できるのではないかと考えています。CDF-transformの概要図と2015年1月の降水量推定値の結果を添付します。観測とシミュレーションの現在のCDFを評価対象年を除く11年間として、将来CDFに相当するものを評価対象年を含む12年間で与えています。(これにより、CDFでは評価が難しかった年々変動の議論もできるのではないかと期待しています。)このケースでは問題なさそうですが、他の数事例に適用して問題ないことを確認した後で、正式に採用できればと考えています。よろしくお願いいたします。

Yin-san, I produced another version of the ML system. You can get the system from the following site. This works on Mac. If you have time, please try it on your Mac.

https://www.dropbox.com/s/wkfq13qeh44utkz/mlcdft-bin.tar.gz?dl=0